6cf8b65112328bd8a2d10c83d50796de.ppt

- Количество слайдов: 22

ХАРЬКОВСКИЙ НАЦИОНАЛЬНЫЙ МЕДИЦИНСКИЙ УНИВЕРСИТЕТ КАФЕДРА МЕДИЦИНСКОЙ И БИОЛОГИЧЕСКОЙ ФИЗИКИ И МЕДИЦИНСКОЙ ИНФОРМАТИКИ

Разработчики: n n n n Проф. Книгавко В. Г. Доц. Радзишевская Е. Б. Асс. Гранкина С. С. Асс. Лад С. Н. Асс. Полетова Н. П. Асс. Рисованая Л. М. Асс. Шуба И. В.

Основы медицинской информатики

ПЛАН ЛЕКЦИИ n n n Цель и задачи медицинской информатики. Информация как ключевое понятие информатики. Основные понятия информатики. Структура информатики. Структурная схема ЭВМ. Принципы функционирования персональных компьютеров (ПК). Программное обеспечение ПК. Классификация ПО.

Информатика – n n область человеческой деятельности, связанная с процессами преобразования информации с помощью компьютеров и их взаимодействием со средой применения. В узком смысле информатику рассматривают как совокупность средств преобразования информации, которая включает технические средства, программные продукты, математические методы, модели и типовые алгоритмы.

Медицинская информатика – это научная дисциплина, занимающаяся исследованием процессов получения, передачи, обработки, распространения и представления информации с использованием информационной техники и технологии в медицине и здравоохранении.

Цели медицинской информатики: оптимизация информационных процессов в медицине за счет использования компьютерных технологий, обеспечивающая повышение качества охраны здоровья населения. НАПРИМЕР: nсоздание банков данных; nсоздание скрининговых систем; nсоздание консультативно-диагностических систем; nразработка приборно-компьютерных систем.

Основные понятия общей информатики ИНФОРМАЦИЯэто новые знания о данных, описывающих наблюдаемое явление и представления об окружающем мире в виде знаков и символов.

Структурная схема получения информации Сбор сведений Переработка данных Получение информации Принятие решений

С понятием информации связаны такие понятия: n n Сообщение – информация предназначенная для передачи; Данные – информация предназначенная для обработки с помощью технических средств; Сигнал – процесс несущий информацию; Канал связи – среда передачи сигнала

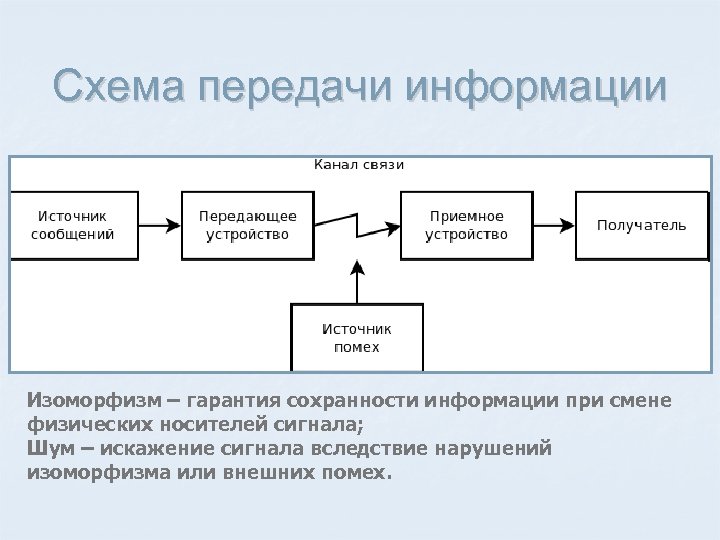

Схема передачи информации Изоморфизм – гарантия сохранности информации при смене физических носителей сигнала; Шум – искажение сигнала вследствие нарушений изоморфизма или внешних помех.

Кодирование n n n Любое сообщение состоит из комбинации простых сигналов определенной физической природы Полный набор сигналов алфавит. Отдельный сигнал – буква алфавита.

n n n Кодирование – описание сообщения с помощью определенного алфавита. Перекодирование – изменение алфавита кодировки. Декодирование – расшифровка (раскодирование) сообщения.

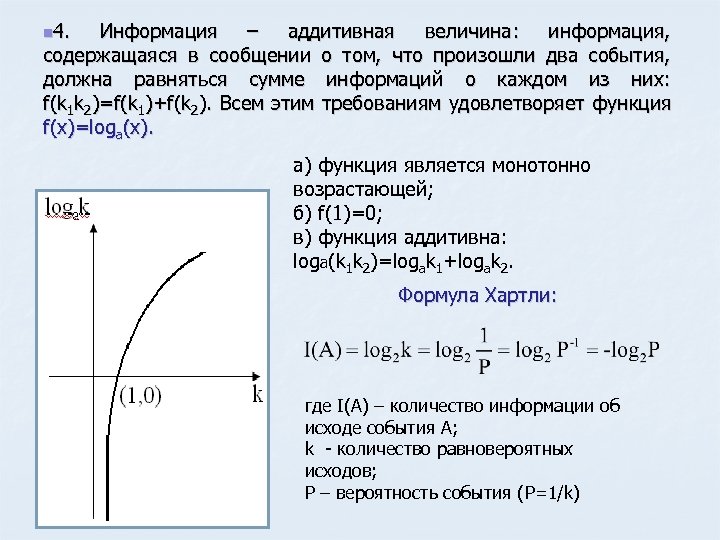

Как измерить количество информации? Для подбора математической функции f(x), измеряющей количество информации необходимо знать свойства информации. Рассмотрим событие, которое имеет k равновозможных исходов. Тогда: n 1). f(x) P=1/k

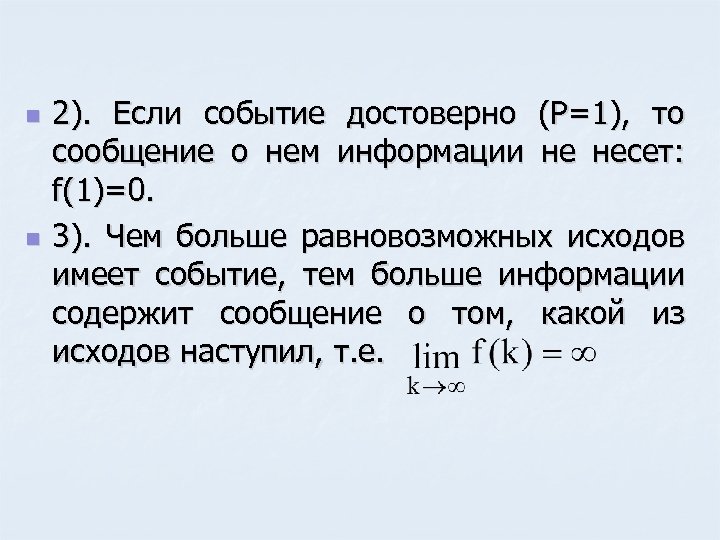

n n 2). Если событие достоверно (Р=1), то сообщение о нем информации не несет: f(1)=0. 3). Чем больше равновозможных исходов имеет событие, тем больше информации содержит сообщение о том, какой из исходов наступил, т. е.

n 4. Информация – аддитивная величина: информация, содержащаяся в сообщении о том, что произошли два события, должна равняться сумме информаций о каждом из них: f(k 1 k 2)=f(k 1)+f(k 2). Всем этим требованиям удовлетворяет функция f(x)=loga(x). а) функция является монотонно возрастающей; б) f(1)=0; в) функция аддитивна: loga(k 1 k 2)=logak 1+logak 2. Формула Хартли: где I(А) – количество информации об исходе события А; k - количество равновероятных исходов; P – вероятность события (P=1/k)

Единицы измерения количества информации Если событие имеет два равновероятных исхода, то количество информации в сообщении равняется 1 бит: k=2; I=log 22=1 бит n Ральф Хартли американский инженер, 1888 г- 1970 г n n Бит – наименьшая единица измерения информации; Байт – основная единица измерения информации (1 байт = 8 бит); Для измерения информации используются также и такие единицы: 1 кбайт = 1024 байт; 1 Мбайт = 1024 кбайт, 1 Гбайт = 1024 Мбайт.

Если события не равновероятные, а имеют вероятности , р1, р2 … рn, то количество информации, которое в среднем содержится в сообщении об исходе события вычисляется по формуле Шеннона: Клод Шеннон американский учёный, 1916 - 2001 где n – число всех возможных исходов события, о которых приходят сообщения; pi – вероятность i–го исхода (i=1; 2; …; n) I – информационная энтропия (мера неопределенности ситуации).

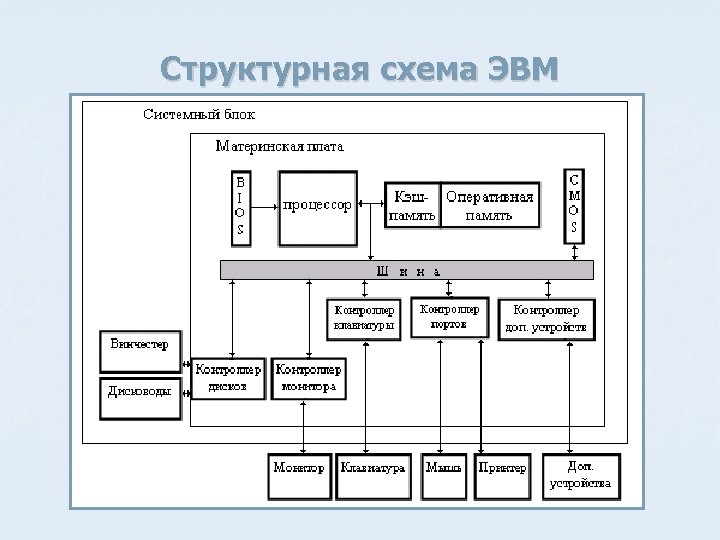

Структурная схема ЭВМ

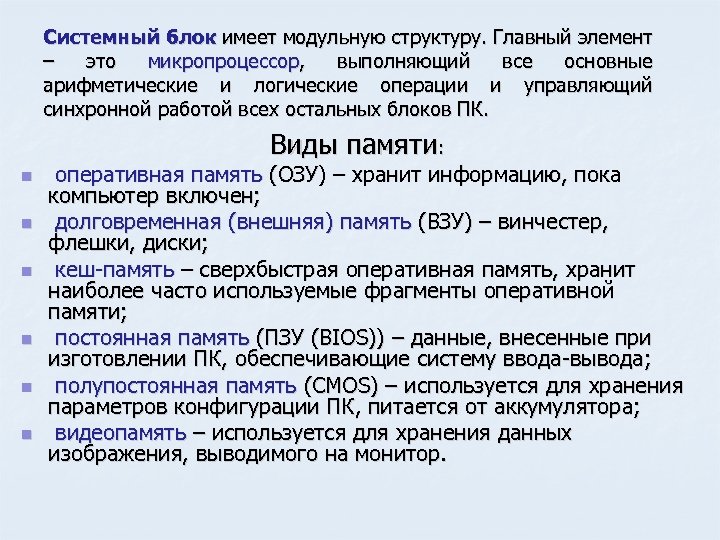

Системный блок имеет модульную структуру. Главный элемент – это микропроцессор, выполняющий все основные арифметические и логические операции и управляющий синхронной работой всех остальных блоков ПК. Виды памяти: n n n оперативная память (ОЗУ) – хранит информацию, пока компьютер включен; долговременная (внешняя) память (ВЗУ) – винчестер, флешки, диски; кеш-память – сверхбыстрая оперативная память, хранит наиболее часто используемые фрагменты оперативной памяти; постоянная память (ПЗУ (BIOS)) – данные, внесенные при изготовлении ПК, обеспечивающие систему ввода-вывода; полупостоянная память (CMOS) – используется для хранения параметров конфигурации ПК, питается от аккумулятора; видеопамять – используется для хранения данных изображения, выводимого на монитор.

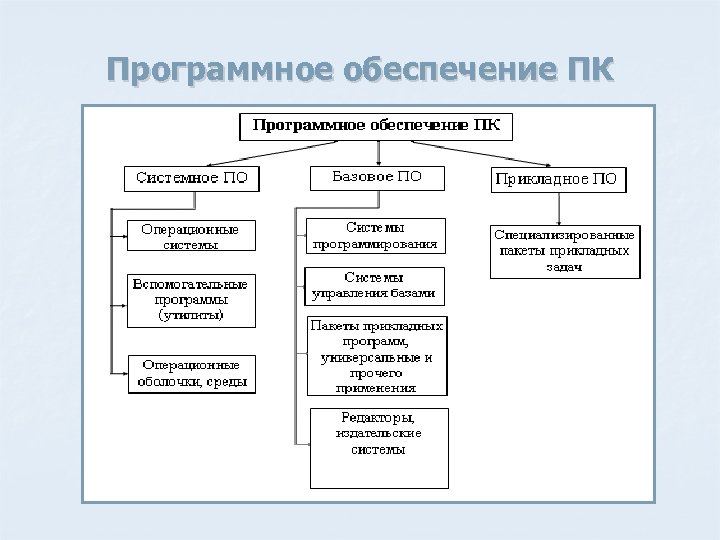

Программное обеспечение ПК

Спасибо за внимание!

6cf8b65112328bd8a2d10c83d50796de.ppt