ee458159b89475c39eff410f2e87a8a3.ppt

- Количество слайдов: 34

Текущее состояние и перспективы развития ЦИВК ОИЯИ Кореньков В. В Конференция пользователей ЦИВК ОИЯИ 6 февраля, 2008

Текущее состояние и перспективы развития ЦИВК ОИЯИ Кореньков В. В Конференция пользователей ЦИВК ОИЯИ 6 февраля, 2008

Статус внешних коомуникаций ОИЯИ

Статус внешних коомуникаций ОИЯИ

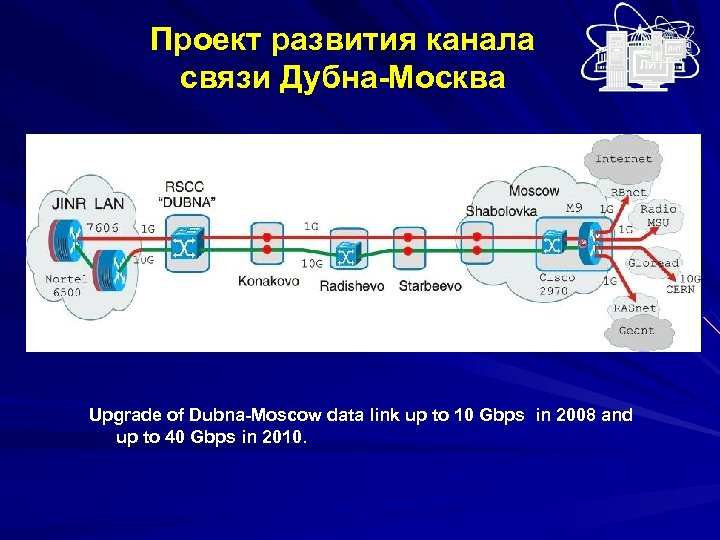

Проект развития канала связи Дубна-Москва Upgrade of Dubna-Moscow data link up to 10 Gbps in 2008 and up to 40 Gbps in 2010.

Проект развития канала связи Дубна-Москва Upgrade of Dubna-Moscow data link up to 10 Gbps in 2008 and up to 40 Gbps in 2010.

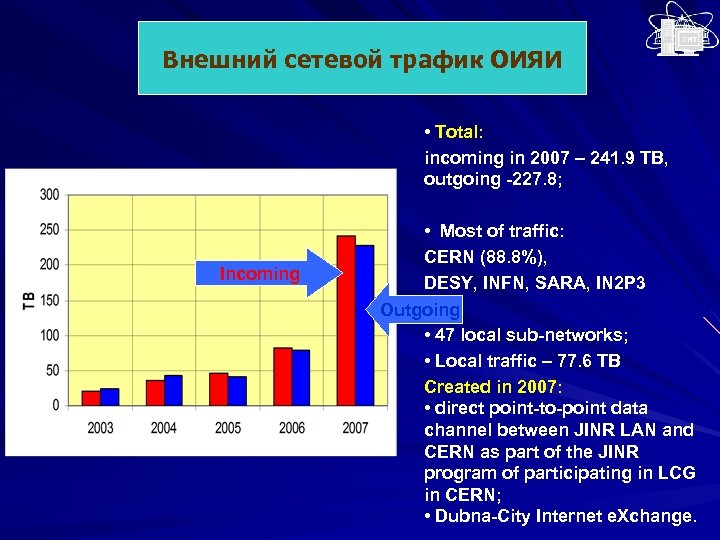

Внешний сетевой трафик ОИЯИ • Total: incoming in 2007 – 241. 9 TB, outgoing -227. 8; Incoming • Most of traffic: CERN (88. 8%), DESY, INFN, SARA, IN 2 P 3 Outgoing • 47 local sub-networks; • Local traffic – 77. 6 TB Created in 2007: • direct point-to-point data channel between JINR LAN and CERN as part of the JINR program of participating in LCG in CERN; • Dubna-City Internet e. Xchange.

Внешний сетевой трафик ОИЯИ • Total: incoming in 2007 – 241. 9 TB, outgoing -227. 8; Incoming • Most of traffic: CERN (88. 8%), DESY, INFN, SARA, IN 2 P 3 Outgoing • 47 local sub-networks; • Local traffic – 77. 6 TB Created in 2007: • direct point-to-point data channel between JINR LAN and CERN as part of the JINR program of participating in LCG in CERN; • Dubna-City Internet e. Xchange.

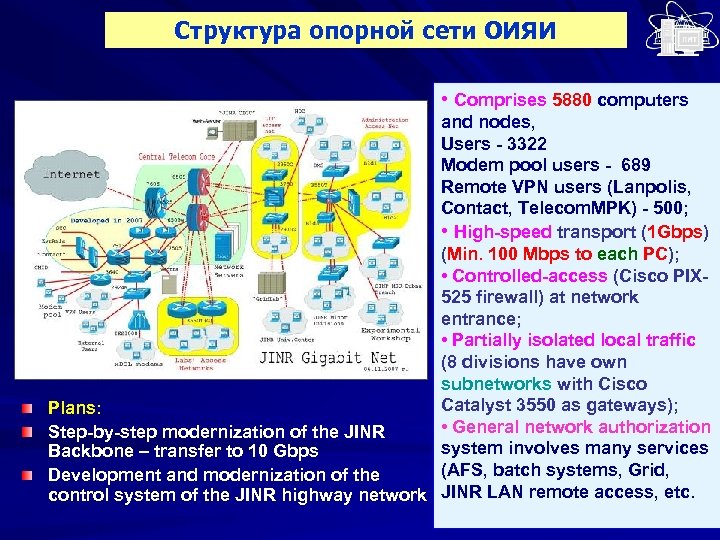

Структура опорной сети ОИЯИ • Comprises 5880 computers and nodes, Users - 3322 Modem pool users - 689 Remote VPN users (Lanpolis, Contact, Telecom. MPK) - 500; • High-speed transport (1 Gbps) (Min. 100 Mbps to each PC); • Controlled-access (Cisco PIX 525 firewall) at network entrance; • Partially isolated local traffic (8 divisions have own subnetworks with Cisco Catalyst 3550 as gateways); Plans: • General network authorization Step-by-step modernization of the JINR system involves many services Backbone – transfer to 10 Gbps (AFS, batch systems, Grid, Development and modernization of the control system of the JINR highway network JINR LAN remote access, etc.

Структура опорной сети ОИЯИ • Comprises 5880 computers and nodes, Users - 3322 Modem pool users - 689 Remote VPN users (Lanpolis, Contact, Telecom. MPK) - 500; • High-speed transport (1 Gbps) (Min. 100 Mbps to each PC); • Controlled-access (Cisco PIX 525 firewall) at network entrance; • Partially isolated local traffic (8 divisions have own subnetworks with Cisco Catalyst 3550 as gateways); Plans: • General network authorization Step-by-step modernization of the JINR system involves many services Backbone – transfer to 10 Gbps (AFS, batch systems, Grid, Development and modernization of the control system of the JINR highway network JINR LAN remote access, etc.

Структура ЦИВК ОИЯИ 670 k. Si 2 K 100 TB Disk Contract prepared in Dec 2007: Super. Blade – 2 BOX 40 CPU Xenon 5430 2. 66 GHz Quad Core ~400 k. Si 2 K Total expected in March, 2008 - 1070 k. Si 2 K

Структура ЦИВК ОИЯИ 670 k. Si 2 K 100 TB Disk Contract prepared in Dec 2007: Super. Blade – 2 BOX 40 CPU Xenon 5430 2. 66 GHz Quad Core ~400 k. Si 2 K Total expected in March, 2008 - 1070 k. Si 2 K

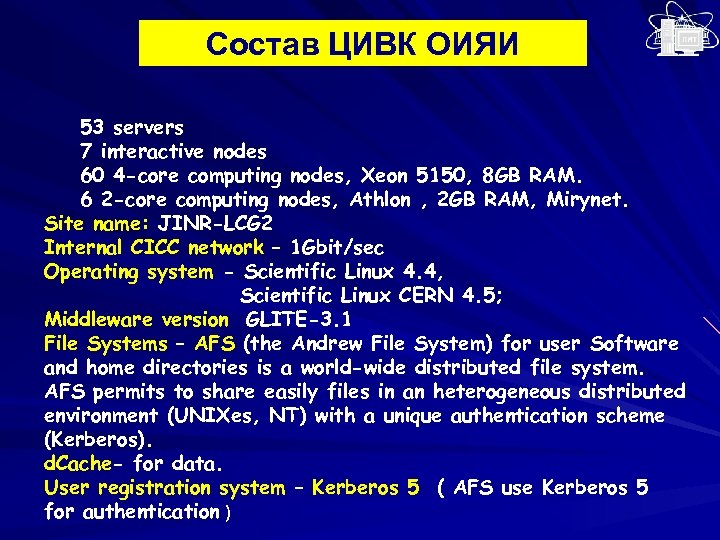

Состав ЦИВК ОИЯИ 53 servers 7 interactive nodes 60 4 -core computing nodes, Xeon 5150, 8 GB RAM. 6 2 -core computing nodes, Athlon , 2 GB RAM, Mirynet. Site name: JINR-LCG 2 Internal CICC network – 1 Gbit/sec Operating system - Scientific Linux 4. 4, Scientific Linux CERN 4. 5; Middleware version GLITE-3. 1 File Systems – AFS (the Andrew File System) for user Software and home directories is a world-wide distributed file system. AFS permits to share easily files in an heterogeneous distributed environment (UNIXes, NT) with a unique authentication scheme (Kerberos). d. Cache- for data. User registration system – Kerberos 5 ( AFS use Kerberos 5 for authentication )

Состав ЦИВК ОИЯИ 53 servers 7 interactive nodes 60 4 -core computing nodes, Xeon 5150, 8 GB RAM. 6 2 -core computing nodes, Athlon , 2 GB RAM, Mirynet. Site name: JINR-LCG 2 Internal CICC network – 1 Gbit/sec Operating system - Scientific Linux 4. 4, Scientific Linux CERN 4. 5; Middleware version GLITE-3. 1 File Systems – AFS (the Andrew File System) for user Software and home directories is a world-wide distributed file system. AFS permits to share easily files in an heterogeneous distributed environment (UNIXes, NT) with a unique authentication scheme (Kerberos). d. Cache- for data. User registration system – Kerberos 5 ( AFS use Kerberos 5 for authentication )

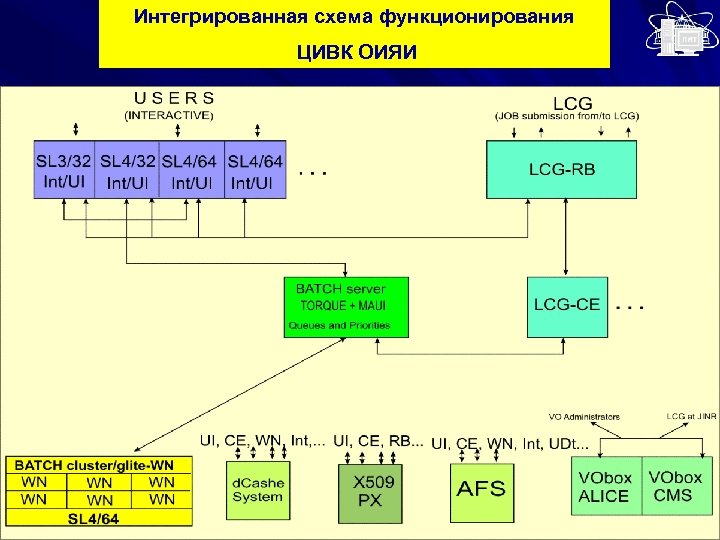

Интегрированная схема функционирования ЦИВК ОИЯИ

Интегрированная схема функционирования ЦИВК ОИЯИ

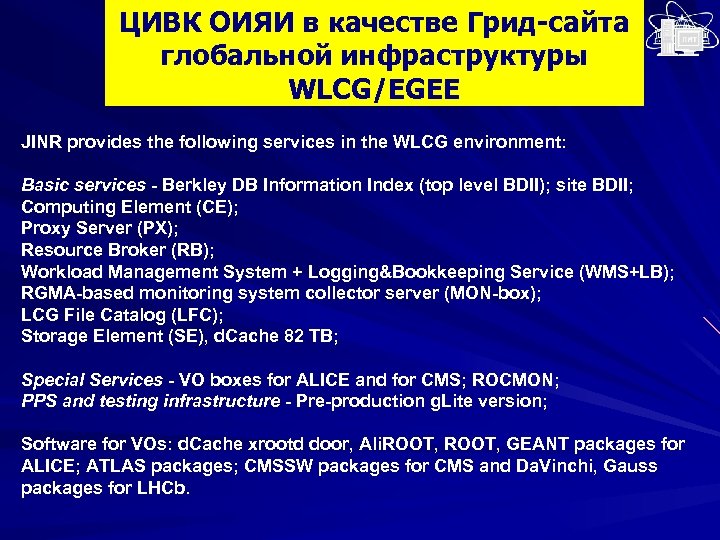

ЦИВК ОИЯИ в качестве Грид-сайта глобальной инфраструктуры WLCG/EGEE JINR provides the following services in the WLCG environment: Basic services - Berkley DB Information Index (top level BDII); site BDII; Computing Element (CE); Proxy Server (PX); Resource Broker (RB); Workload Management System + Logging&Bookkeeping Service (WMS+LB); RGMA-based monitoring system collector server (MON-box); LCG File Catalog (LFC); Storage Element (SE), d. Cache 82 TB; Special Services - VO boxes for ALICE and for CMS; ROCMON; PPS and testing infrastructure - Pre-production g. Lite version; Software for VOs: d. Cache xrootd door, Ali. ROOT, GEANT packages for ALICE; ATLAS packages; CMSSW packages for CMS and Da. Vinchi, Gauss packages for LHCb.

ЦИВК ОИЯИ в качестве Грид-сайта глобальной инфраструктуры WLCG/EGEE JINR provides the following services in the WLCG environment: Basic services - Berkley DB Information Index (top level BDII); site BDII; Computing Element (CE); Proxy Server (PX); Resource Broker (RB); Workload Management System + Logging&Bookkeeping Service (WMS+LB); RGMA-based monitoring system collector server (MON-box); LCG File Catalog (LFC); Storage Element (SE), d. Cache 82 TB; Special Services - VO boxes for ALICE and for CMS; ROCMON; PPS and testing infrastructure - Pre-production g. Lite version; Software for VOs: d. Cache xrootd door, Ali. ROOT, GEANT packages for ALICE; ATLAS packages; CMSSW packages for CMS and Da. Vinchi, Gauss packages for LHCb.

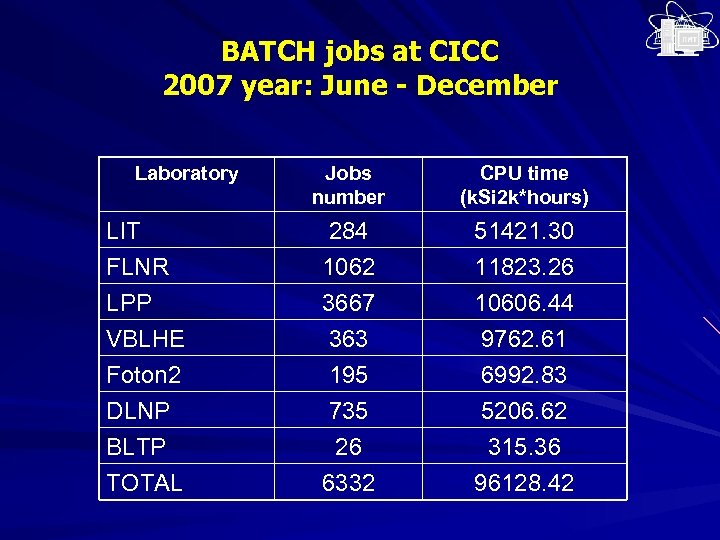

BATCH jobs at CICC 2007 year: June - December Laboratory Jobs number CPU time (k. Si 2 k*hours) LIT FLNR 284 1062 51421. 30 11823. 26 LPP VBLHE Foton 2 DLNP BLTP TOTAL 3667 363 195 735 26 6332 10606. 44 9762. 61 6992. 83 5206. 62 315. 36 96128. 42

BATCH jobs at CICC 2007 year: June - December Laboratory Jobs number CPU time (k. Si 2 k*hours) LIT FLNR 284 1062 51421. 30 11823. 26 LPP VBLHE Foton 2 DLNP BLTP TOTAL 3667 363 195 735 26 6332 10606. 44 9762. 61 6992. 83 5206. 62 315. 36 96128. 42

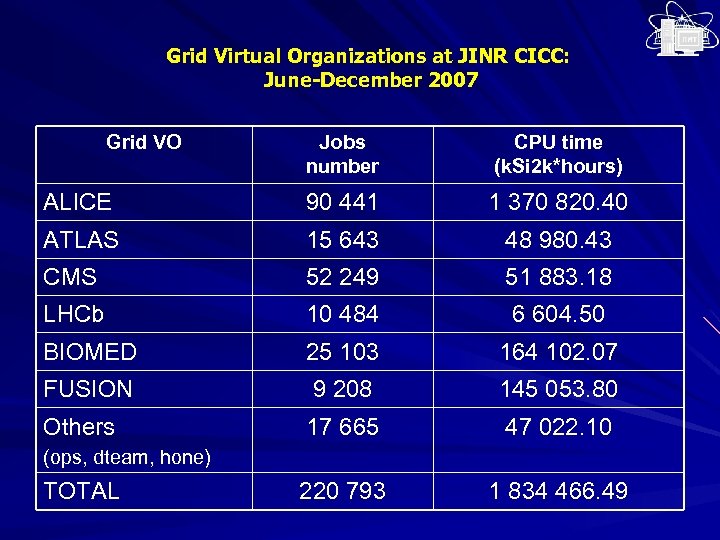

Grid Virtual Organizations at JINR CICC: June-December 2007 Grid VO Jobs number CPU time (k. Si 2 k*hours) ALICE 90 441 1 370 820. 40 ATLAS 15 643 48 980. 43 CMS 52 249 51 883. 18 LHCb 10 484 6 604. 50 BIOMED 25 103 164 102. 07 FUSION 9 208 145 053. 80 Others 17 665 47 022. 10 220 793 1 834 466. 49 (ops, dteam, hone) TOTAL

Grid Virtual Organizations at JINR CICC: June-December 2007 Grid VO Jobs number CPU time (k. Si 2 k*hours) ALICE 90 441 1 370 820. 40 ATLAS 15 643 48 980. 43 CMS 52 249 51 883. 18 LHCb 10 484 6 604. 50 BIOMED 25 103 164 102. 07 FUSION 9 208 145 053. 80 Others 17 665 47 022. 10 220 793 1 834 466. 49 (ops, dteam, hone) TOTAL

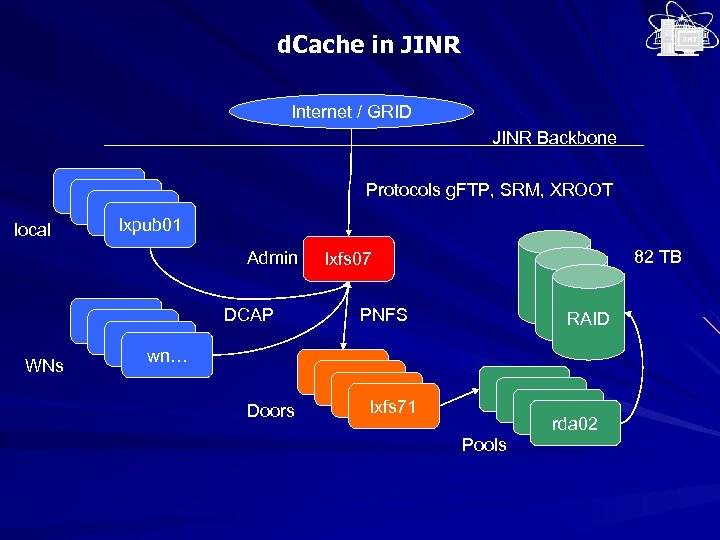

d. Cache in JINR Internet / GRID JINR Backbone local Protocols g. FTP, SRM, XROOT lxfs 07 lxpub 01 Admin WNs lxfs 07 wn… DCAP Doors 82 TB lxfs 07 PNFS lxfs 07 lxfs 71 RAID lxfs 07 rda 02 Pools

d. Cache in JINR Internet / GRID JINR Backbone local Protocols g. FTP, SRM, XROOT lxfs 07 lxpub 01 Admin WNs lxfs 07 wn… DCAP Doors 82 TB lxfs 07 PNFS lxfs 07 lxfs 71 RAID lxfs 07 rda 02 Pools

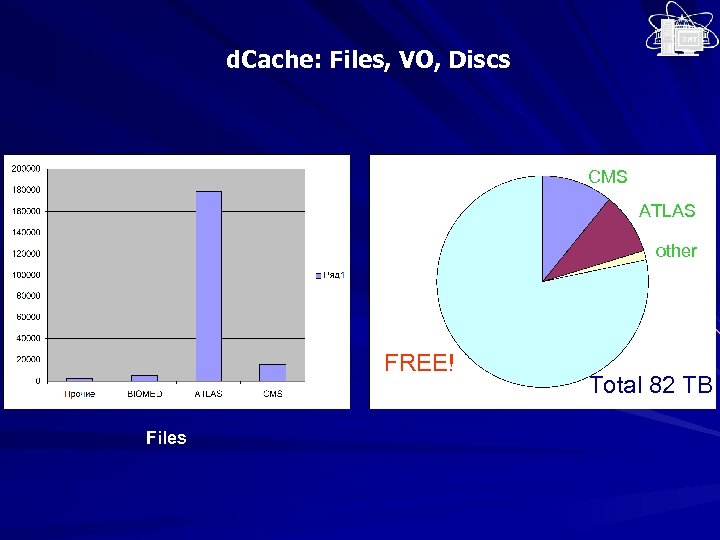

d. Cache: Files, VO, Discs CMS ATLAS other FREE! Files Total 82 ТВ

d. Cache: Files, VO, Discs CMS ATLAS other FREE! Files Total 82 ТВ

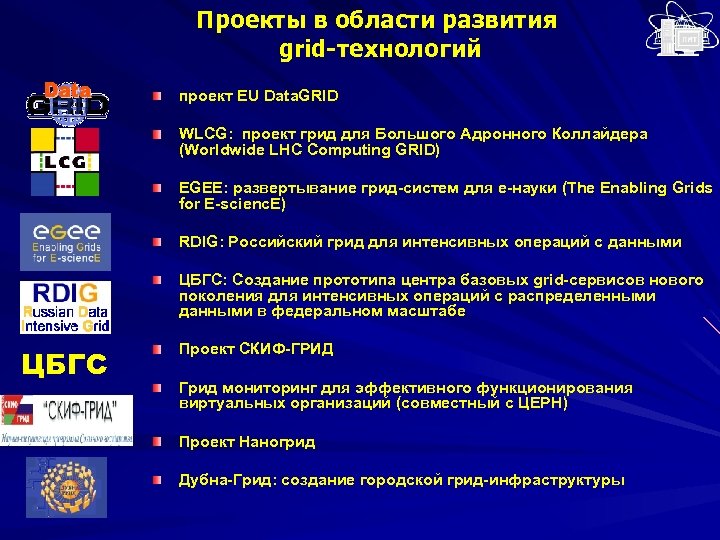

Проекты в области развития grid-технологий проект EU Data. GRID WLCG: проект грид для Большого Адронного Коллайдера (Worldwide LHC Computing GRID) EGEE: развертывание грид-систем для e-науки (The Enabling Grids for E-scienc. E) RDIG: Российский грид для интенсивных операций с данными ЦБГС: Создание прототипа центра базовых grid-сервисов нового поколения для интенсивных операций с распределенными данными в федеральном масштабе ЦБГС Проект СКИФ-ГРИД Грид мониторинг для эффективного функционирования виртуальных организаций (совместный с ЦЕРН) Проект Наногрид Дубна-Грид: создание городской грид-инфраструктуры

Проекты в области развития grid-технологий проект EU Data. GRID WLCG: проект грид для Большого Адронного Коллайдера (Worldwide LHC Computing GRID) EGEE: развертывание грид-систем для e-науки (The Enabling Grids for E-scienc. E) RDIG: Российский грид для интенсивных операций с данными ЦБГС: Создание прототипа центра базовых grid-сервисов нового поколения для интенсивных операций с распределенными данными в федеральном масштабе ЦБГС Проект СКИФ-ГРИД Грид мониторинг для эффективного функционирования виртуальных организаций (совместный с ЦЕРН) Проект Наногрид Дубна-Грид: создание городской грид-инфраструктуры

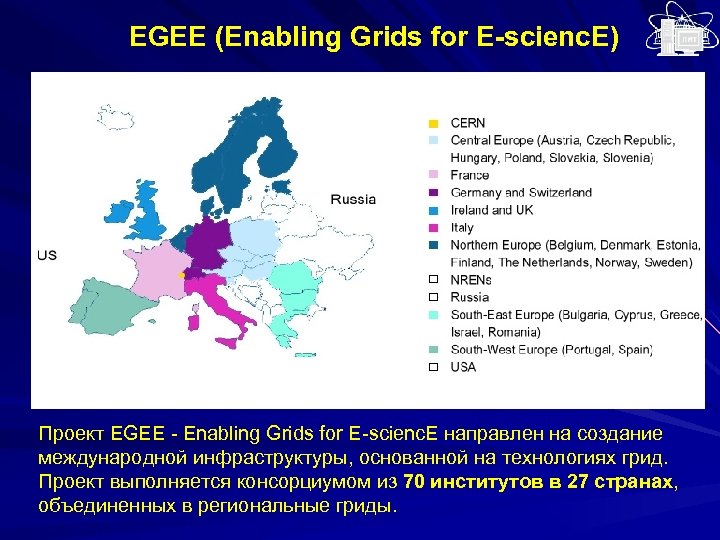

EGEE (Enabling Grids for E-scienc. E) Проект EGEE - Enabling Grids for E-scienc. E направлен на создание международной инфраструктуры, основанной на технологиях грид. Проект выполняется консорциумом из 70 институтов в 27 странах, объединенных в региональные гриды.

EGEE (Enabling Grids for E-scienc. E) Проект EGEE - Enabling Grids for E-scienc. E направлен на создание международной инфраструктуры, основанной на технологиях грид. Проект выполняется консорциумом из 70 институтов в 27 странах, объединенных в региональные гриды.

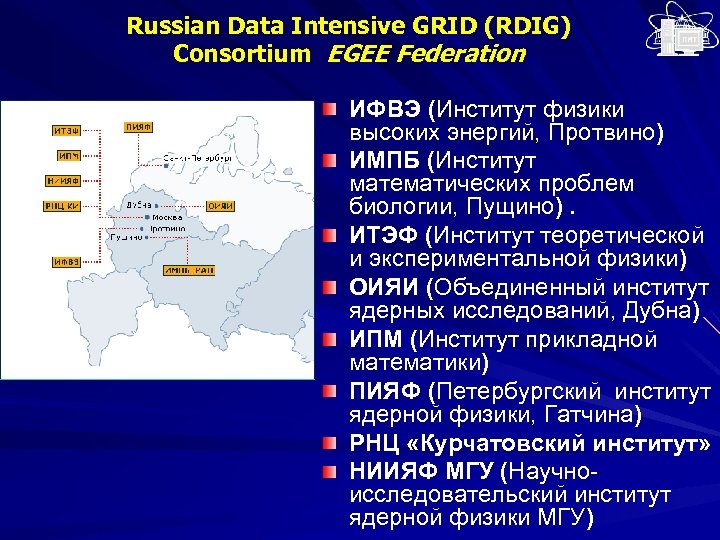

Russian Data Intensive GRID (RDIG) Consortium EGEE Federation ИФВЭ (Институт физики высоких энергий, Протвино) ИМПБ (Институт математических проблем биологии, Пущино). ИТЭФ (Институт теоретической и экспериментальной физики) ОИЯИ (Объединенный институт ядерных исследований, Дубна) ИПМ (Институт прикладной математики) ПИЯФ (Петербургский институт ядерной физики, Гатчина) РНЦ «Курчатовский институт» НИИЯФ МГУ (Научноисследовательский институт ядерной физики МГУ)

Russian Data Intensive GRID (RDIG) Consortium EGEE Federation ИФВЭ (Институт физики высоких энергий, Протвино) ИМПБ (Институт математических проблем биологии, Пущино). ИТЭФ (Институт теоретической и экспериментальной физики) ОИЯИ (Объединенный институт ядерных исследований, Дубна) ИПМ (Институт прикладной математики) ПИЯФ (Петербургский институт ядерной физики, Гатчина) РНЦ «Курчатовский институт» НИИЯФ МГУ (Научноисследовательский институт ядерной физики МГУ)

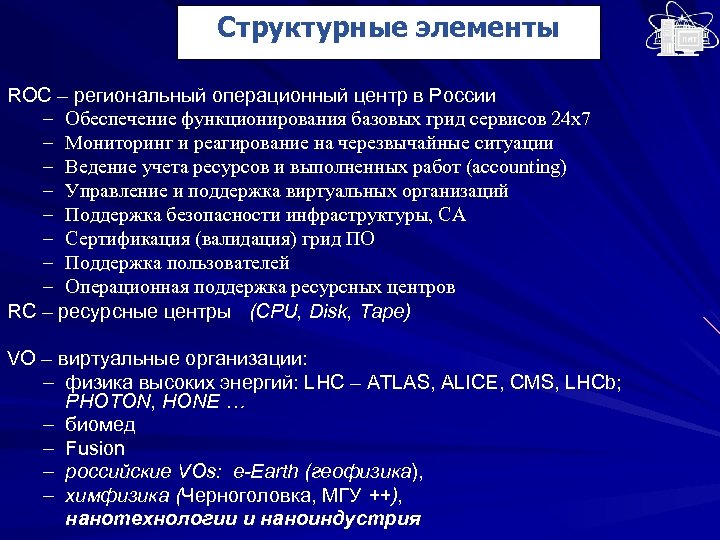

Структурные элементы ROC – региональный операционный центр в России – Обеспечение функционирования базовых грид сервисов 24 х7 – Мониторинг и реагирование на черезвычайные ситуации – Ведение учета ресурсов и выполненных работ (accounting) – Управление и поддержка виртуальных организаций – Поддержка безопасности инфраструктуры, CA – Сертификация (валидация) грид ПО – Поддержка пользователей – Операционная поддержка ресурсных центров RC – ресурсные центры (CPU, Disk, Tape) VO – виртуальные организации: – физика высоких энергий: LHC – ATLAS, ALICE, CMS, LHCb; PHOTON, HONE … – биомед – Fusion – российские VOs: e-Earth (геофизика), – химфизика (Черноголовка, МГУ ++), нанотехнологии и наноиндустрия

Структурные элементы ROC – региональный операционный центр в России – Обеспечение функционирования базовых грид сервисов 24 х7 – Мониторинг и реагирование на черезвычайные ситуации – Ведение учета ресурсов и выполненных работ (accounting) – Управление и поддержка виртуальных организаций – Поддержка безопасности инфраструктуры, CA – Сертификация (валидация) грид ПО – Поддержка пользователей – Операционная поддержка ресурсных центров RC – ресурсные центры (CPU, Disk, Tape) VO – виртуальные организации: – физика высоких энергий: LHC – ATLAS, ALICE, CMS, LHCb; PHOTON, HONE … – биомед – Fusion – российские VOs: e-Earth (геофизика), – химфизика (Черноголовка, МГУ ++), нанотехнологии и наноиндустрия

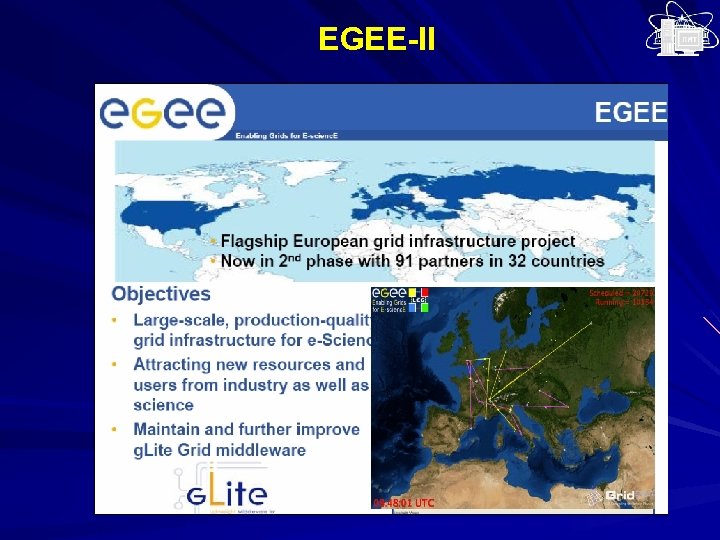

EGEE-II

EGEE-II

Основные направления EGEE-II >200 ВО из различных областей науки – Астрономия и астрофизика – Безопасность населения – Вычислительная химия – Вычислительные науки/Программирование – Физика конденсированного состояния – Науки о Земле – Синтез – Физика высоких энергий – Науки о жизни –. . 98 k заданий/день Приложения перешли со стадии тестирования на стадию рутинного и ежедневного использования с эффективностью ~80 -90%

Основные направления EGEE-II >200 ВО из различных областей науки – Астрономия и астрофизика – Безопасность населения – Вычислительная химия – Вычислительные науки/Программирование – Физика конденсированного состояния – Науки о Земле – Синтез – Физика высоких энергий – Науки о жизни –. . 98 k заданий/день Приложения перешли со стадии тестирования на стадию рутинного и ежедневного использования с эффективностью ~80 -90%

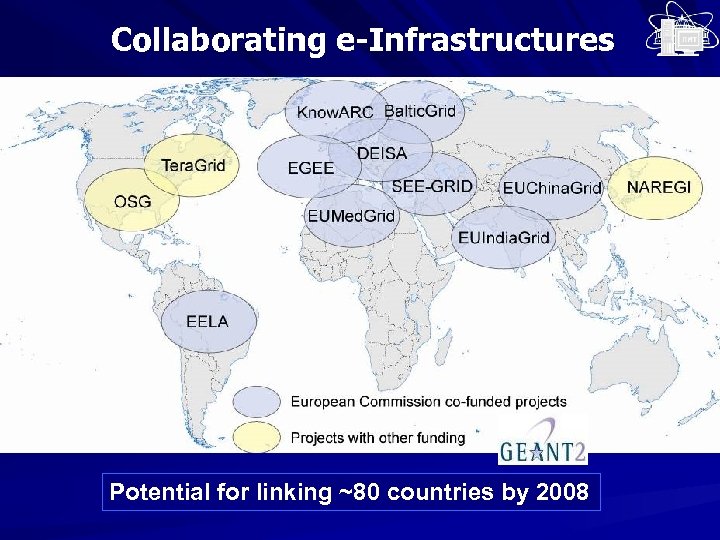

Collaborating e-Infrastructures Potential for linking ~80 countries by 2008

Collaborating e-Infrastructures Potential for linking ~80 countries by 2008

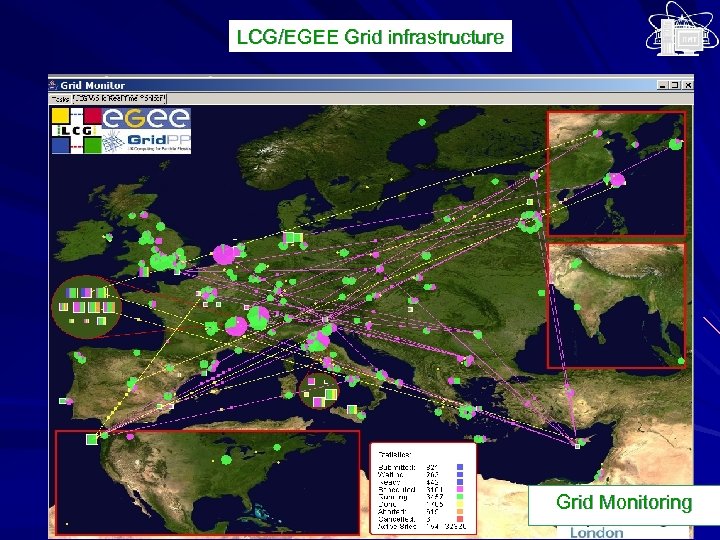

LCG/EGEE Grid infrastructure Grid Monitoring

LCG/EGEE Grid infrastructure Grid Monitoring

RDIG инфраструктура В настоящее время RDIG –инфраструктура состоит из 15 ресурсных центров, в которых доступно около 1500 CPU и 500 TB дискового пространства. . RDIG Resource Centres: – ITEP – JINR-LCG 2 – Kharkov-KIPT – RRC-KI – RU-Moscow-KIAM – RU-Phys-SPb. SU – RU-Protvino-IHEP – RU-SPb. SU – Ru-Troitsk-INR – ru-IMPB-LCG 2 – ru-Moscow-FIAN – ru-Moscow-GCRAS – ru-Moscow-MEPHI – ru-PNPI-LCG 2 – ru-Moscow-SINP

RDIG инфраструктура В настоящее время RDIG –инфраструктура состоит из 15 ресурсных центров, в которых доступно около 1500 CPU и 500 TB дискового пространства. . RDIG Resource Centres: – ITEP – JINR-LCG 2 – Kharkov-KIPT – RRC-KI – RU-Moscow-KIAM – RU-Phys-SPb. SU – RU-Protvino-IHEP – RU-SPb. SU – Ru-Troitsk-INR – ru-IMPB-LCG 2 – ru-Moscow-FIAN – ru-Moscow-GCRAS – ru-Moscow-MEPHI – ru-PNPI-LCG 2 – ru-Moscow-SINP

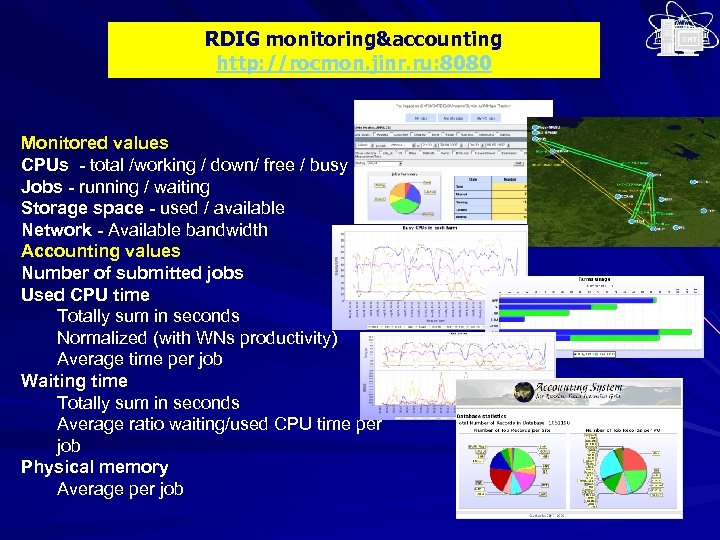

RDIG monitoring&accounting http: //rocmon. jinr. ru: 8080 Monitored values CPUs - total /working / down/ free / busy Jobs - running / waiting Storage space - used / available Network - Available bandwidth Accounting values Number of submitted jobs Used CPU time Totally sum in seconds Normalized (with WNs productivity) Average time per job Waiting time Totally sum in seconds Average ratio waiting/used CPU time per job Physical memory Average per job

RDIG monitoring&accounting http: //rocmon. jinr. ru: 8080 Monitored values CPUs - total /working / down/ free / busy Jobs - running / waiting Storage space - used / available Network - Available bandwidth Accounting values Number of submitted jobs Used CPU time Totally sum in seconds Normalized (with WNs productivity) Average time per job Waiting time Totally sum in seconds Average ratio waiting/used CPU time per job Physical memory Average per job

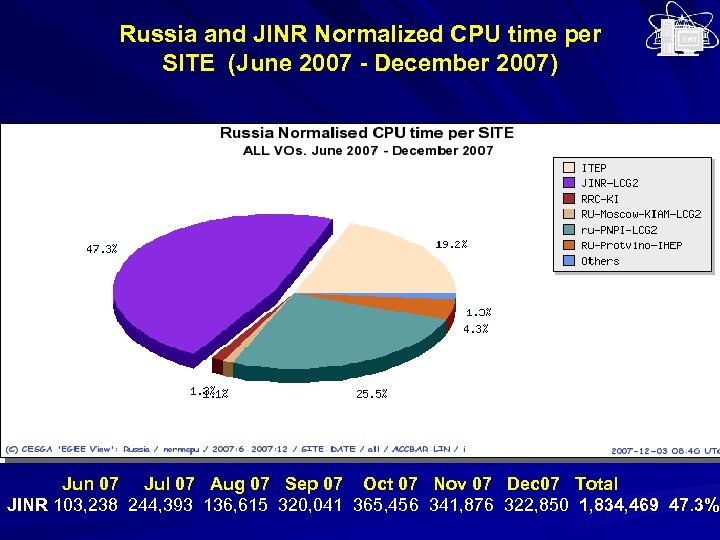

Russia and JINR Normalized CPU time per SITE (June 2007 - December 2007) Jun 07 Jul 07 Aug 07 Sep 07 Oct 07 Nov 07 Dec 07 Total Dec JINR 103, 238 244, 393 136, 615 320, 041 365, 456 341, 876 322, 850 1, 834, 469 47. 3%

Russia and JINR Normalized CPU time per SITE (June 2007 - December 2007) Jun 07 Jul 07 Aug 07 Sep 07 Oct 07 Nov 07 Dec 07 Total Dec JINR 103, 238 244, 393 136, 615 320, 041 365, 456 341, 876 322, 850 1, 834, 469 47. 3%

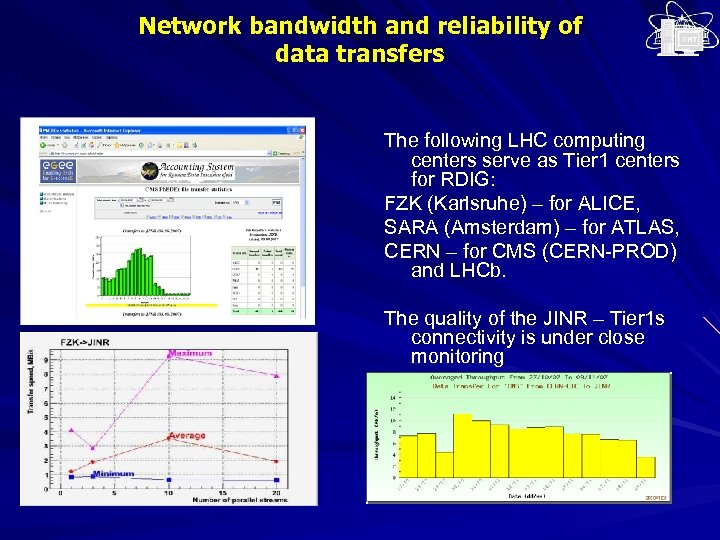

Network bandwidth and reliability of data transfers The following LHC computing centers serve as Tier 1 centers for RDIG: FZK (Karlsruhe) – for ALICE, SARA (Amsterdam) – for ATLAS, CERN – for CMS (CERN-PROD) and LHCb. The quality of the JINR – Tier 1 s connectivity is under close monitoring

Network bandwidth and reliability of data transfers The following LHC computing centers serve as Tier 1 centers for RDIG: FZK (Karlsruhe) – for ALICE, SARA (Amsterdam) – for ATLAS, CERN – for CMS (CERN-PROD) and LHCb. The quality of the JINR – Tier 1 s connectivity is under close monitoring

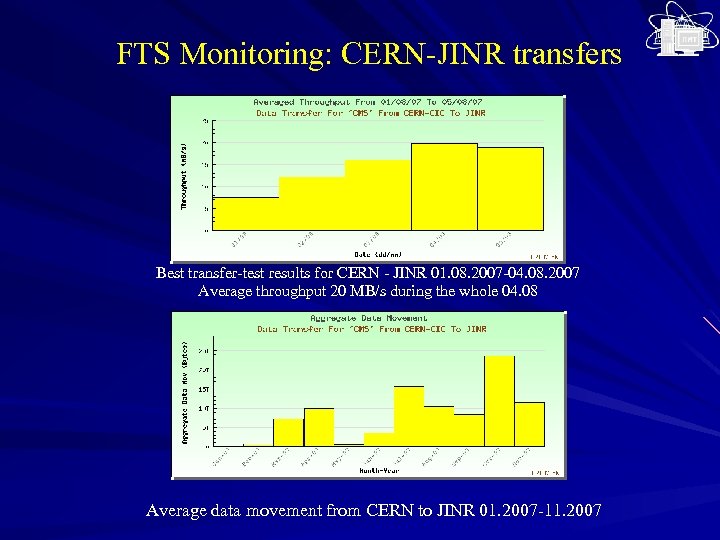

FTS Monitoring: CERN-JINR transfers Best transfer-test results for CERN - JINR 01. 08. 2007 -04. 08. 2007 Average throughput 20 MB/s during the whole 04. 08 Average data movement from CERN to JINR 01. 2007 -11. 2007

FTS Monitoring: CERN-JINR transfers Best transfer-test results for CERN - JINR 01. 08. 2007 -04. 08. 2007 Average throughput 20 MB/s during the whole 04. 08 Average data movement from CERN to JINR 01. 2007 -11. 2007

Эффективность RDIG-сайтов RDIG SITES CPU Usage KSI 2 K Oct. 2007 – Jan. 2008 Reliability Oct. 2007 Nov. 2007 Dec. 2007 Jan. 2008 Data transfers from CERN (Tera. Bytes) Oct. - Jan FIAN 462 51 94 43 98 - IHEP 99396 71 72 84 68 38. 5 INR 52339 79 93 35 93 - ITEP 462364 63 93 84 96 31. 6 JINR 1082327 93 93 94 99 62 479 92 95 44 98 - - 96 97 92 96 - 366723 44 85 0 0 5 120 86 0 0 0 6 110611 25 0 49 58 11. 2 83 88 95 - MEPHI Phys. SPb. SU PNPI RRC-KI SINP SPb. SU Totals Average 3556 86 2 178 377 154. 3 71 73 56 73

Эффективность RDIG-сайтов RDIG SITES CPU Usage KSI 2 K Oct. 2007 – Jan. 2008 Reliability Oct. 2007 Nov. 2007 Dec. 2007 Jan. 2008 Data transfers from CERN (Tera. Bytes) Oct. - Jan FIAN 462 51 94 43 98 - IHEP 99396 71 72 84 68 38. 5 INR 52339 79 93 35 93 - ITEP 462364 63 93 84 96 31. 6 JINR 1082327 93 93 94 99 62 479 92 95 44 98 - - 96 97 92 96 - 366723 44 85 0 0 5 120 86 0 0 0 6 110611 25 0 49 58 11. 2 83 88 95 - MEPHI Phys. SPb. SU PNPI RRC-KI SINP SPb. SU Totals Average 3556 86 2 178 377 154. 3 71 73 56 73

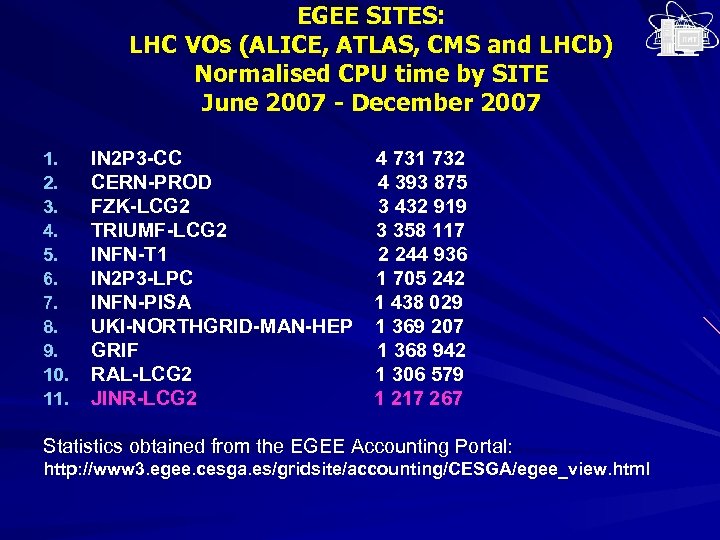

EGEE SITES: LHC VOs (ALICE, ATLAS, CMS and LHCb) Normalised CPU time by SITE June 2007 - December 2007 1. 2. 3. 4. 5. 6. 7. 8. 9. 10. 11. IN 2 P 3 -CC 4 731 732 CERN-PROD 4 393 875 FZK-LCG 2 3 432 919 TRIUMF-LCG 2 3 358 117 INFN-T 1 2 244 936 IN 2 P 3 -LPC 1 705 242 INFN-PISA 1 438 029 UKI-NORTHGRID-MAN-HEP 1 369 207 GRIF 1 368 942 RAL-LCG 2 1 306 579 JINR-LCG 2 1 217 267 Statistics obtained from the EGEE Accounting Portal: http: //www 3. egee. cesga. es/gridsite/accounting/CESGA/egee_view. html

EGEE SITES: LHC VOs (ALICE, ATLAS, CMS and LHCb) Normalised CPU time by SITE June 2007 - December 2007 1. 2. 3. 4. 5. 6. 7. 8. 9. 10. 11. IN 2 P 3 -CC 4 731 732 CERN-PROD 4 393 875 FZK-LCG 2 3 432 919 TRIUMF-LCG 2 3 358 117 INFN-T 1 2 244 936 IN 2 P 3 -LPC 1 705 242 INFN-PISA 1 438 029 UKI-NORTHGRID-MAN-HEP 1 369 207 GRIF 1 368 942 RAL-LCG 2 1 306 579 JINR-LCG 2 1 217 267 Statistics obtained from the EGEE Accounting Portal: http: //www 3. egee. cesga. es/gridsite/accounting/CESGA/egee_view. html

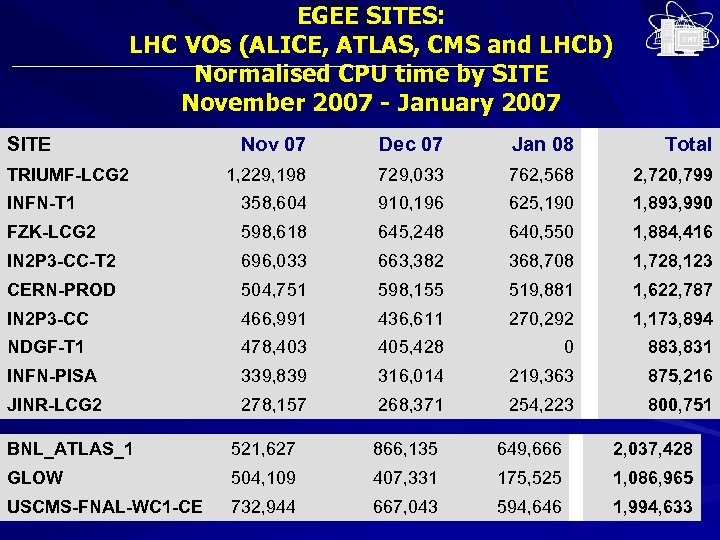

EGEE SITES: LHC VOs (ALICE, ATLAS, CMS and LHCb) Normalised CPU time by SITE November 2007 - January 2007 SITE Nov 07 Dec 07 Jan 08 Total 1, 229, 198 729, 033 762, 568 2, 720, 799 INFN-T 1 358, 604 910, 196 625, 190 1, 893, 990 FZK-LCG 2 598, 618 645, 248 640, 550 1, 884, 416 IN 2 P 3 -CC-T 2 696, 033 663, 382 368, 708 1, 728, 123 CERN-PROD 504, 751 598, 155 519, 881 1, 622, 787 IN 2 P 3 -CC 466, 991 436, 611 270, 292 1, 173, 894 NDGF-T 1 478, 403 405, 428 0 883, 831 INFN-PISA 339, 839 316, 014 219, 363 875, 216 JINR-LCG 2 278, 157 268, 371 254, 223 800, 751 TRIUMF-LCG 2 BNL_ATLAS_1 521, 627 866, 135 649, 666 2, 037, 428 GLOW 504, 109 407, 331 175, 525 1, 086, 965 USCMS-FNAL-WC 1 -CE 732, 944 667, 043 594, 646 1, 994, 633

EGEE SITES: LHC VOs (ALICE, ATLAS, CMS and LHCb) Normalised CPU time by SITE November 2007 - January 2007 SITE Nov 07 Dec 07 Jan 08 Total 1, 229, 198 729, 033 762, 568 2, 720, 799 INFN-T 1 358, 604 910, 196 625, 190 1, 893, 990 FZK-LCG 2 598, 618 645, 248 640, 550 1, 884, 416 IN 2 P 3 -CC-T 2 696, 033 663, 382 368, 708 1, 728, 123 CERN-PROD 504, 751 598, 155 519, 881 1, 622, 787 IN 2 P 3 -CC 466, 991 436, 611 270, 292 1, 173, 894 NDGF-T 1 478, 403 405, 428 0 883, 831 INFN-PISA 339, 839 316, 014 219, 363 875, 216 JINR-LCG 2 278, 157 268, 371 254, 223 800, 751 TRIUMF-LCG 2 BNL_ATLAS_1 521, 627 866, 135 649, 666 2, 037, 428 GLOW 504, 109 407, 331 175, 525 1, 086, 965 USCMS-FNAL-WC 1 -CE 732, 944 667, 043 594, 646 1, 994, 633

Планы развития ЦИВК ОИЯИ 2007 2008 2009 2010 CPU (k. SI 2 K) 670 (1070) 1250 1750 2500 Disk (Tbytes) 100 400 800 1200 Active Tapes (Tbytes) 0 0 100 200

Планы развития ЦИВК ОИЯИ 2007 2008 2009 2010 CPU (k. SI 2 K) 670 (1070) 1250 1750 2500 Disk (Tbytes) 100 400 800 1200 Active Tapes (Tbytes) 0 0 100 200

Тор 500 Site Computer DOE/NNSA/LLNL Blue. Gene/L United States IBM Juelich (FZJ) Blue Gene/P Germany IBM New Mexico (NMCAC) United States SGI CRL India Hewlett-Packard Government Agency Sweden Hewlett-Packard NNSA/Sandia United States Cray Inc. Oak Ridge National Laboratory United States Cray XT 4/XT 3 IBM Thomas J. Watson Research Center United States Blue Gene/L IBM NERSC/LBNL United States Cray XT 4 Stony Brook/BNL, United States Blue Gene/L IBM Processors Year Rmax Rpeak 1 212992 2007 478200 5963782 65536 2007 167300 2228223 14336 2007 126900 1720324 14240 2007 117900 1708805 13728 2007 102800 1464306 26569 2007 102200 1275317 23016 2006 101700 1193508 40960 2005 91290 1146889 19320 2007 85368 1004641 36864 2007 82161 103219

Тор 500 Site Computer DOE/NNSA/LLNL Blue. Gene/L United States IBM Juelich (FZJ) Blue Gene/P Germany IBM New Mexico (NMCAC) United States SGI CRL India Hewlett-Packard Government Agency Sweden Hewlett-Packard NNSA/Sandia United States Cray Inc. Oak Ridge National Laboratory United States Cray XT 4/XT 3 IBM Thomas J. Watson Research Center United States Blue Gene/L IBM NERSC/LBNL United States Cray XT 4 Stony Brook/BNL, United States Blue Gene/L IBM Processors Year Rmax Rpeak 1 212992 2007 478200 5963782 65536 2007 167300 2228223 14336 2007 126900 1720324 14240 2007 117900 1708805 13728 2007 102800 1464306 26569 2007 102200 1275317 23016 2006 101700 1193508 40960 2005 91290 1146889 19320 2007 85368 1004641 36864 2007 82161 103219

Россия в TOP 500 В данной редакции списка Россия представлена 7 системами, что является максимальным количеством за время существования Top 500. На рекордном для России 33 месте оказался суперкомпьютер Hewlett-Packard Cluster Platform 3000 BL 460 c, установленный в МСЦ РАН, 33. 885 TFlop/s. На 181 месте списка суперкомпьютер IBM Blade. Center HS 21 Cluster, в Уфимском государственном авиационном техническом университете, 9. 287 TFlop/s. IBM Blade. Center HS 21 Cluster с производительностью 9. 287 TFlop/s, установленный в Сибирском федеральном университете (Красноярск), оказался на 183 месте. На 199 место со 105 опустился суперкомпьютер "СКИФ Cyberia", установленный в Томском Государственном Университете, с производительностью 9. 01 TFlop/s. На 242 месте списка оказался суперкомпьютер Hewlett-Packard Cluster Platform 3000 BL 460 c, в Вятском государственном университете (Киров), 8. 160 TFlop/s. Со 187 на 408 место в новой редакции списка опустился российский суперкомпьютер MVS-15000 BM, установленный в МСЦ РАН, 6. 646 TFlop/s. Наконец, на 430 месте списка оказался суперкомпьютер IBM Blade. Center HS 21 Cluster, к "Industrial Company", с производительностью 6. 341 TFlop/s.

Россия в TOP 500 В данной редакции списка Россия представлена 7 системами, что является максимальным количеством за время существования Top 500. На рекордном для России 33 месте оказался суперкомпьютер Hewlett-Packard Cluster Platform 3000 BL 460 c, установленный в МСЦ РАН, 33. 885 TFlop/s. На 181 месте списка суперкомпьютер IBM Blade. Center HS 21 Cluster, в Уфимском государственном авиационном техническом университете, 9. 287 TFlop/s. IBM Blade. Center HS 21 Cluster с производительностью 9. 287 TFlop/s, установленный в Сибирском федеральном университете (Красноярск), оказался на 183 месте. На 199 место со 105 опустился суперкомпьютер "СКИФ Cyberia", установленный в Томском Государственном Университете, с производительностью 9. 01 TFlop/s. На 242 месте списка оказался суперкомпьютер Hewlett-Packard Cluster Platform 3000 BL 460 c, в Вятском государственном университете (Киров), 8. 160 TFlop/s. Со 187 на 408 место в новой редакции списка опустился российский суперкомпьютер MVS-15000 BM, установленный в МСЦ РАН, 6. 646 TFlop/s. Наконец, на 430 месте списка оказался суперкомпьютер IBM Blade. Center HS 21 Cluster, к "Industrial Company", с производительностью 6. 341 TFlop/s.

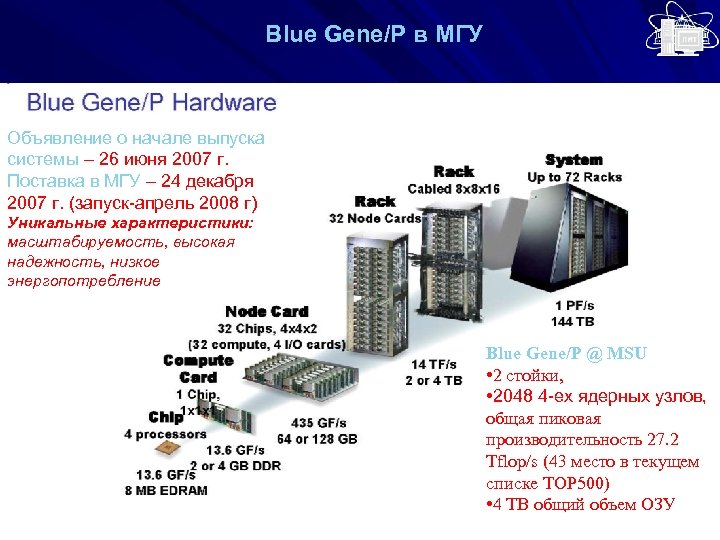

Blue Gene/P в MГУ Объявление о начале выпуска системы – 26 июня 2007 г. Поставка в МГУ – 24 декабря 2007 г. (запуск-апрель 2008 г) Уникальные характеристики: масштабируемость, высокая надежность, низкое энергопотребление Blue Gene/P @ MSU • 2 стойки, • 2048 4 -ех ядерных узлов, общая пиковая производительность 27. 2 Tflop/s (43 место в текущем списке TOP 500) • 4 TB общий объем ОЗУ

Blue Gene/P в MГУ Объявление о начале выпуска системы – 26 июня 2007 г. Поставка в МГУ – 24 декабря 2007 г. (запуск-апрель 2008 г) Уникальные характеристики: масштабируемость, высокая надежность, низкое энергопотребление Blue Gene/P @ MSU • 2 стойки, • 2048 4 -ех ядерных узлов, общая пиковая производительность 27. 2 Tflop/s (43 место в текущем списке TOP 500) • 4 TB общий объем ОЗУ

Полезные ссылки и информация LCG: //lcg. web. cern. ch/LCG/ EGEE: //www. eu-egee. org EGEE-RDIG: //www. egee-rdig. ru GRIDCLUB: //www. gridclub. ru Параллельные вычисления //parallel. ru Инструкции, документация, сайты, информационные бюллетени, публикации, обзоры, курсы и т. д. Новые возможности для проектов и групп пользователей: Новые возможности для пользователей ЦИВК ОИЯИ Использование ГРИД-инфраструктуры для различных ВО Развитие системы суперкомпьютеров в России

Полезные ссылки и информация LCG: //lcg. web. cern. ch/LCG/ EGEE: //www. eu-egee. org EGEE-RDIG: //www. egee-rdig. ru GRIDCLUB: //www. gridclub. ru Параллельные вычисления //parallel. ru Инструкции, документация, сайты, информационные бюллетени, публикации, обзоры, курсы и т. д. Новые возможности для проектов и групп пользователей: Новые возможности для пользователей ЦИВК ОИЯИ Использование ГРИД-инфраструктуры для различных ВО Развитие системы суперкомпьютеров в России