Свойства коэффициентов регрессии

![Ø Действительно, можно показать, что математическое ожидание var(e) при одной независимой переменной равно М(var(e))=[(n-2)/n]δ Ø Действительно, можно показать, что математическое ожидание var(e) при одной независимой переменной равно М(var(e))=[(n-2)/n]δ](https://present5.com/presentation/3/17016912_171746727.pdf-img/17016912_171746727.pdf-28.jpg)

5 Свойства коэффициентов регрессии.ppt

- Количество слайдов: 31

Свойства коэффициентов регрессии

Свойства коэффициентов регрессии

Случайные составляющие коэффициентов регрессии Ø Коэффициент регрессии, вычисленный методом наименьших квадратов — это особая форма случайной величины, свойства которой зависят от свойств остаточного члена в уравнении.

Случайные составляющие коэффициентов регрессии Ø Коэффициент регрессии, вычисленный методом наименьших квадратов — это особая форма случайной величины, свойства которой зависят от свойств остаточного члена в уравнении.

Ø Будем предполагать, что х — это неслучайная экзогенная переменная в уравнении y=α+βx+u. Ø Значения x во всех наблюдениях можно считать заранее заданными и никак не связанными с исследуемой зависимостью.

Ø Будем предполагать, что х — это неслучайная экзогенная переменная в уравнении y=α+βx+u. Ø Значения x во всех наблюдениях можно считать заранее заданными и никак не связанными с исследуемой зависимостью.

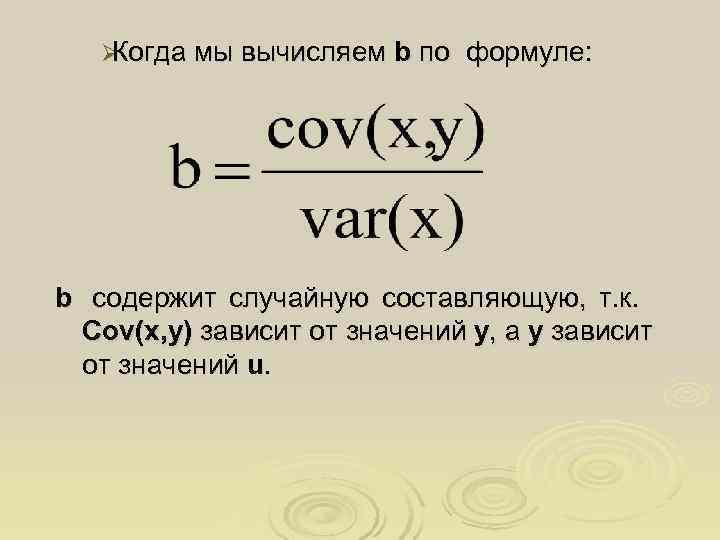

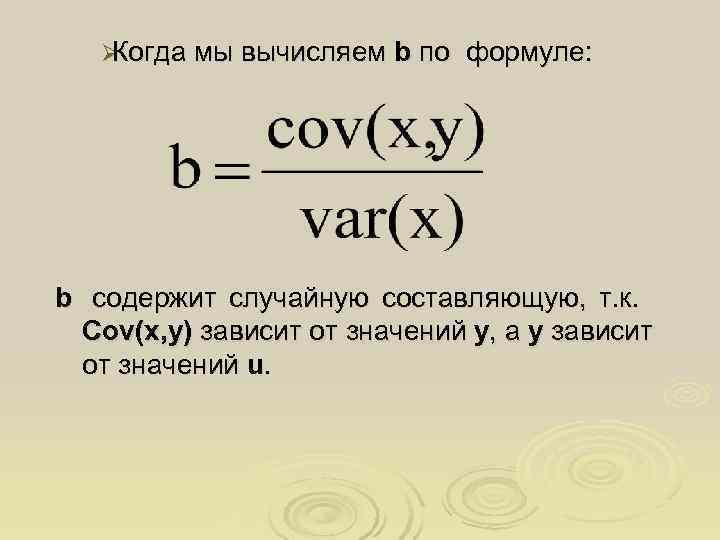

ØКогда мы вычисляем b по формуле: b содержит случайную составляющую, т. к. Cov(x, у) зависит от значений у, а у зависит от значений u.

ØКогда мы вычисляем b по формуле: b содержит случайную составляющую, т. к. Cov(x, у) зависит от значений у, а у зависит от значений u.

Ø Если случайная составляющая принимает разные значения в n наблюдениях, то мы получаем различные значения у и, следовательно, разные величины Cov(x, у) и b.

Ø Если случайная составляющая принимает разные значения в n наблюдениях, то мы получаем различные значения у и, следовательно, разные величины Cov(x, у) и b.

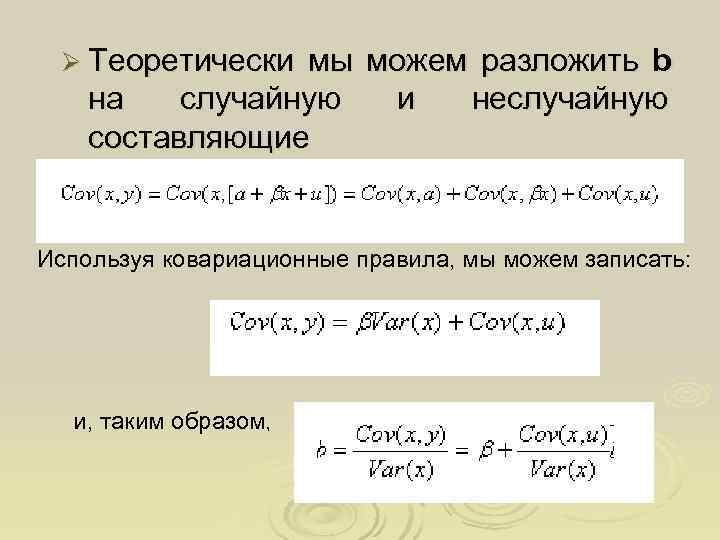

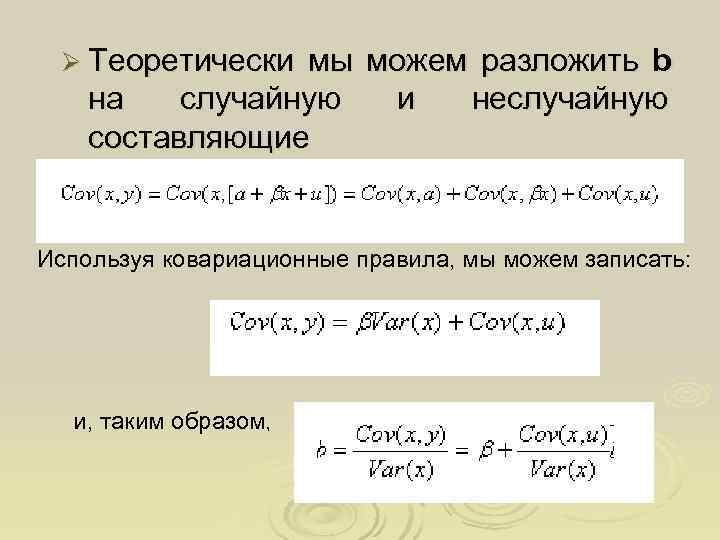

Ø Теоретически мы можем разложить b на случайную и неслучайную составляющие Используя ковариационные правила, мы можем записать: и, таким образом,

Ø Теоретически мы можем разложить b на случайную и неслучайную составляющие Используя ковариационные правила, мы можем записать: и, таким образом,

Ø Т. е. коэффициент регрессии b , полученный по любой выборке, представляется в виде суммы двух слагаемых: 1)постоянной величины , равной истинному значению коэффициента β; 2)случайной составляющей , зависящей от Cov(x, u), которой обусловлены отклонения коэффициента b от константы.

Ø Т. е. коэффициент регрессии b , полученный по любой выборке, представляется в виде суммы двух слагаемых: 1)постоянной величины , равной истинному значению коэффициента β; 2)случайной составляющей , зависящей от Cov(x, u), которой обусловлены отклонения коэффициента b от константы.

Ø Аналогичным образом можно показать, что a имеет постоянную составляющую, равную истинному значению α , плюс случайную составляющую, которая зависит от случайного фактора u.

Ø Аналогичным образом можно показать, что a имеет постоянную составляющую, равную истинному значению α , плюс случайную составляющую, которая зависит от случайного фактора u.

Условия Гаусса-Маркова Ø Свойства коэффициентов регрессии зависят от свойств случайной составляющей. Ø Для того чтобы регрессионный анализ, основанный на МНК, давал наилучшие из всех возможных результаты, случайный член должен удовлетворять четырем условиям, известным как условия Гаусса—Маркова.

Условия Гаусса-Маркова Ø Свойства коэффициентов регрессии зависят от свойств случайной составляющей. Ø Для того чтобы регрессионный анализ, основанный на МНК, давал наилучшие из всех возможных результаты, случайный член должен удовлетворять четырем условиям, известным как условия Гаусса—Маркова.

Ø 1 -е условие Гаусса—Маркова : математическое ожидание случайного члена в любом наблюдении должно быть равно нулю M(ui)=0 для всех наблюдений Ø Иногда случайный член будет положительным, иногда отрицательным, но он не должен иметь систематического смещения ни в одном из возможных направлений.

Ø 1 -е условие Гаусса—Маркова : математическое ожидание случайного члена в любом наблюдении должно быть равно нулю M(ui)=0 для всех наблюдений Ø Иногда случайный член будет положительным, иногда отрицательным, но он не должен иметь систематического смещения ни в одном из возможных направлений.

Ø 2 -е условие Гаусса—Маркова : дисперсия случайного члена должна быть постоянна для всех наблюдений δu 2=const Ø Иногда случайный член будет больше, иногда меньше, однако не должно быть априорной причины для того, чтобы он порождал большую ошибку в одних наблюдениях, чем в других.

Ø 2 -е условие Гаусса—Маркова : дисперсия случайного члена должна быть постоянна для всех наблюдений δu 2=const Ø Иногда случайный член будет больше, иногда меньше, однако не должно быть априорной причины для того, чтобы он порождал большую ошибку в одних наблюдениях, чем в других.

Ø Если рассматриваемое условие не выполняется, то коэффициенты регрессии, найденные по обычному методу наименьших квадратов, будут неэффективны , и можно получить более надежные результаты путем применения модифицированного метода регрессии.

Ø Если рассматриваемое условие не выполняется, то коэффициенты регрессии, найденные по обычному методу наименьших квадратов, будут неэффективны , и можно получить более надежные результаты путем применения модифицированного метода регрессии.

Ø 3 -е условие Гаусса—Маркова : предполагает отсутствие систематической связи между значениями случайного члена в любых двух наблюдениях cov(ui, uj)=0 при i≠j

Ø 3 -е условие Гаусса—Маркова : предполагает отсутствие систематической связи между значениями случайного члена в любых двух наблюдениях cov(ui, uj)=0 при i≠j

Ø Например, если случайный член велик и положителен в одном наблюдении, это не должно обусловливать, что он будет большим и положительным в следующем наблюдении Ø или большим и отрицательным, или малым и положительным, или малым и отрицательным.

Ø Например, если случайный член велик и положителен в одном наблюдении, это не должно обусловливать, что он будет большим и положительным в следующем наблюдении Ø или большим и отрицательным, или малым и положительным, или малым и отрицательным.

Ø Случайные члены должны быть абсолютно независимы друг от друга. Ø Если это условие не будет выполнено, то регрессия, оцененная по обычному методу наименьших квадратов, вновь даст неэффективные результаты.

Ø Случайные члены должны быть абсолютно независимы друг от друга. Ø Если это условие не будет выполнено, то регрессия, оцененная по обычному методу наименьших квадратов, вновь даст неэффективные результаты.

Ø 4 -е условие Гаусса—Маркова : случайный член должен быть распределен независимо от объясняющих переменных cov(xk, uk)=0

Ø 4 -е условие Гаусса—Маркова : случайный член должен быть распределен независимо от объясняющих переменных cov(xk, uk)=0

Ø Будем использовать более сильное предположение о том, что объясняющие переменные не являются стохастическими, т. е. не имеют случайной составляющей. Ø Значение любой независимой переменной в каждом наблюдении можно считать экзогенным, полностью определяемым внешними причинами, не учитываемыми в уравнении регрессии.

Ø Будем использовать более сильное предположение о том, что объясняющие переменные не являются стохастическими, т. е. не имеют случайной составляющей. Ø Значение любой независимой переменной в каждом наблюдении можно считать экзогенным, полностью определяемым внешними причинами, не учитываемыми в уравнении регрессии.

Предположение о нормальности Ø Наряду с условиями Гаусса—Маркова обычно также предполагается нормальность распределения случайного члена. Ø Дело в том, что если случайный член u нормально распределен, то так же будут распределены и коэффициенты регрессии.

Предположение о нормальности Ø Наряду с условиями Гаусса—Маркова обычно также предполагается нормальность распределения случайного члена. Ø Дело в том, что если случайный член u нормально распределен, то так же будут распределены и коэффициенты регрессии.

Ø Предположение о нормальности основывается на центральной предельной теореме. Ø Теорема Ø Если случайная величина является общим результатом взаимодействия большого числа других случайных величин, ни одна из которых не является доминирующей, то она будет иметь приблизительно нормальное распределение, даже если отдельные составляющие не имеют нормального распределения.

Ø Предположение о нормальности основывается на центральной предельной теореме. Ø Теорема Ø Если случайная величина является общим результатом взаимодействия большого числа других случайных величин, ни одна из которых не является доминирующей, то она будет иметь приблизительно нормальное распределение, даже если отдельные составляющие не имеют нормального распределения.

Ø Случайный член u определяется несколькими факторами, которые не входят в явной форме в уравнение регрессии. Ø Поэтому даже если ничего не известно о распределении этих факторов мы имеем право предположить, что они нормально распределены.

Ø Случайный член u определяется несколькими факторами, которые не входят в явной форме в уравнение регрессии. Ø Поэтому даже если ничего не известно о распределении этих факторов мы имеем право предположить, что они нормально распределены.

Теорема Гаусса-Маркова Ø Оценки по обычному методу наименьших квадратов являются не только несмещенными оценками коэффициентов регрессии, но и наиболее эффективными в том случае, если выполнены условия Гаусса— Маркова.

Теорема Гаусса-Маркова Ø Оценки по обычному методу наименьших квадратов являются не только несмещенными оценками коэффициентов регрессии, но и наиболее эффективными в том случае, если выполнены условия Гаусса— Маркова.

ØС другой стороны, если условия Гаусса —Маркова не выполнены, то, вообще говоря, можно найти оценки, которые будут более эффективными по сравнению с оценками, полученными обычным методом наименьших квадратов.

ØС другой стороны, если условия Гаусса —Маркова не выполнены, то, вообще говоря, можно найти оценки, которые будут более эффективными по сравнению с оценками, полученными обычным методом наименьших квадратов.

Теорема Гаусса—Маркова Ø В случае, если условия Гаусса—Маркова для остаточного члена выполнены, коэффициенты регрессии, построенной обычным методом наименьших квадратов, будут наилучшими линейными несмещенными оценками: несмещенными, линейными, так как они являются линейными функциями значений у; наилучшими, так как они являются наиболее эффективными в классе всех несмещенных линейных оценок. .

Теорема Гаусса—Маркова Ø В случае, если условия Гаусса—Маркова для остаточного члена выполнены, коэффициенты регрессии, построенной обычным методом наименьших квадратов, будут наилучшими линейными несмещенными оценками: несмещенными, линейными, так как они являются линейными функциями значений у; наилучшими, так как они являются наиболее эффективными в классе всех несмещенных линейных оценок. .

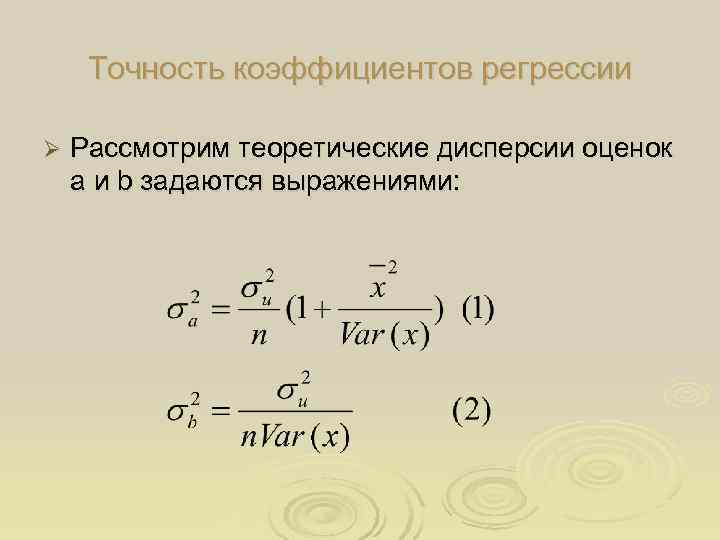

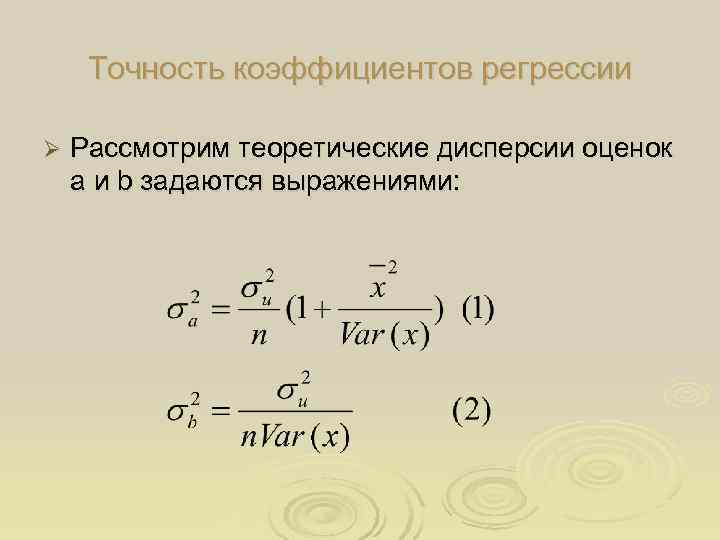

Точность коэффициентов регрессии Ø Рассмотрим теоретические дисперсии оценок а и b задаются выражениями:

Точность коэффициентов регрессии Ø Рассмотрим теоретические дисперсии оценок а и b задаются выражениями:

Ø Из уравнений можно сделать 3 заключения: 1. Дисперсия a и b прямо пропорциональны дисперсии остаточного члена δ 2 u. Чем больше фактор случайности, тем хуже будут оценки прочих равных условиях. 2. Чем больше число наблюдений, тем меньше дисперсии оценок. 3. Чем больше дисперсия x , тем меньше дисперсия коэффициентов регрессии.

Ø Из уравнений можно сделать 3 заключения: 1. Дисперсия a и b прямо пропорциональны дисперсии остаточного члена δ 2 u. Чем больше фактор случайности, тем хуже будут оценки прочих равных условиях. 2. Чем больше число наблюдений, тем меньше дисперсии оценок. 3. Чем больше дисперсия x , тем меньше дисперсия коэффициентов регрессии.

Ø На практике невозможно вычислить теоретические дисперсии коэффициентов. Ø Однако мы можем получить ее оценку на основе остатков. Ø Разброс остатков вокруг оинии регрессии будет отражать неизвестный разброс u , следовательно, выборочная дисперсия остатков var(e) , может быть использована как оценка δu 2.

Ø На практике невозможно вычислить теоретические дисперсии коэффициентов. Ø Однако мы можем получить ее оценку на основе остатков. Ø Разброс остатков вокруг оинии регрессии будет отражать неизвестный разброс u , следовательно, выборочная дисперсия остатков var(e) , может быть использована как оценка δu 2.

Ø Какая прямая ближе к точкам выборки наблюдений x y? Ø Истинная прямая y= α + β x или линия регрессии ŷ=a+bx ? Ø Ответ- линия регрессии, потому что она строится таким образом, чтобы свести к минимуму сумму квадратов растояний между ней и значениями наблюдений. Ø Следовательно, разброс остатков у нее меньше, чем разброс значений u, и Var(e) имеет тенденцию занижать оценку δu 2

Ø Какая прямая ближе к точкам выборки наблюдений x y? Ø Истинная прямая y= α + β x или линия регрессии ŷ=a+bx ? Ø Ответ- линия регрессии, потому что она строится таким образом, чтобы свести к минимуму сумму квадратов растояний между ней и значениями наблюдений. Ø Следовательно, разброс остатков у нее меньше, чем разброс значений u, и Var(e) имеет тенденцию занижать оценку δu 2

![>Ø Действительно, можно показать, что математическое ожидание var(e) при одной независимой переменной равно М(var(e))=[(n-2)/n]δ >Ø Действительно, можно показать, что математическое ожидание var(e) при одной независимой переменной равно М(var(e))=[(n-2)/n]δ](https://present5.com/presentation/3/17016912_171746727.pdf-img/17016912_171746727.pdf-28.jpg) Ø Действительно, можно показать, что математическое ожидание var(e) при одной независимой переменной равно М(var(e))=[(n-2)/n]δ 2 u

Ø Действительно, можно показать, что математическое ожидание var(e) при одной независимой переменной равно М(var(e))=[(n-2)/n]δ 2 u

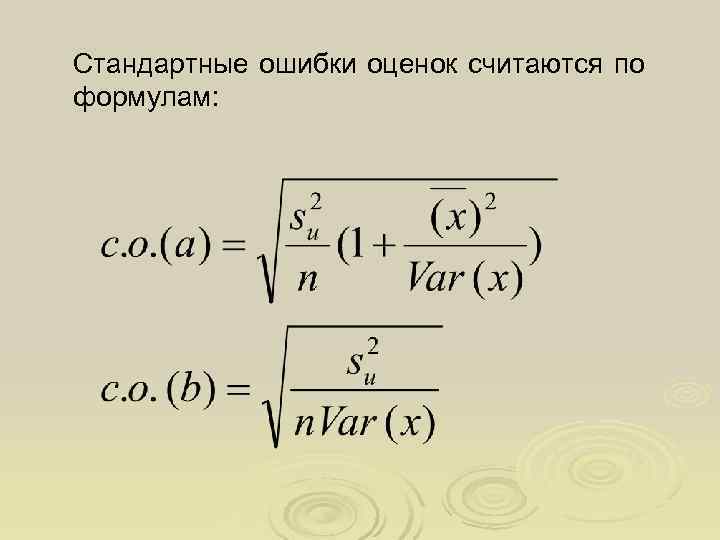

Ø Используя (1), (2), (3) можно получить оценки теоретических дисперсий для a и b и после извлечения квадратного корня – оценки их стандартных отклонений. Ø Обычно используют другой термин – стандартная ошибка коэффициента регрессии «с. о. »

Ø Используя (1), (2), (3) можно получить оценки теоретических дисперсий для a и b и после извлечения квадратного корня – оценки их стандартных отклонений. Ø Обычно используют другой термин – стандартная ошибка коэффициента регрессии «с. о. »

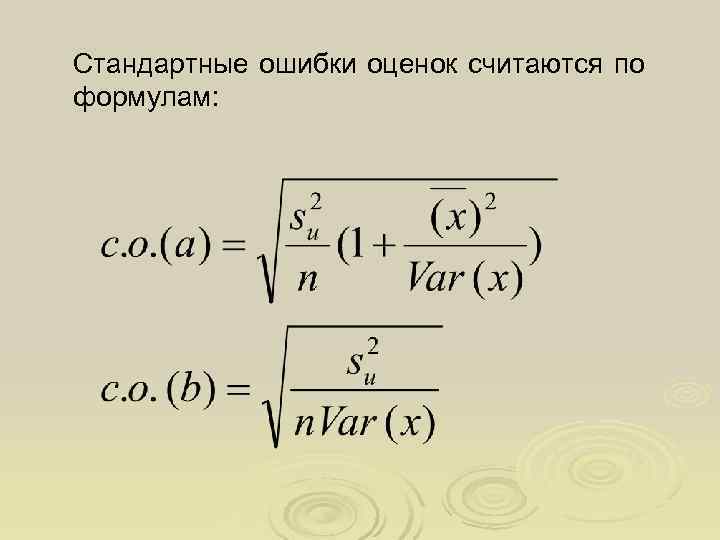

Стандартные ошибки оценок считаются по формулам:

Стандартные ошибки оценок считаются по формулам:

Ø Для улучшения точности оценок по МНК можно увеличивать количество наблюдений в выборке, увеличивать диапазон наблюдений Var(x) или уменьшить S 2 (u) (например, увеличить точность измерений)

Ø Для улучшения точности оценок по МНК можно увеличивать количество наблюдений в выборке, увеличивать диапазон наблюдений Var(x) или уменьшить S 2 (u) (например, увеличить точность измерений)