Лекция 8 Отказоустойчивые технологии.ppt

- Количество слайдов: 37

Современные отказоустойчивые технологии в компьютерных системах

Современные отказоустойчивые технологии в компьютерных системах

Кластерные системы класса HA (High Available) Кластер – несколько компьютеров, соединенных коммуникационным каналом и разделяющих общие ресурсы. Основные виды кластеров: 1) отказоустойчивые кластеры (High-availability clusters, HA, кластеры высокой доступности) 2) кластеры с балансировкой нагрузки (Load balancing clusters) 3)вычислительные кластеры (High perfomance computing clusters) 4) grid-системы Компании, выпускающие НА - системы : HP, Digital, IBM 2

Кластерные системы класса HA (High Available) Кластер – несколько компьютеров, соединенных коммуникационным каналом и разделяющих общие ресурсы. Основные виды кластеров: 1) отказоустойчивые кластеры (High-availability clusters, HA, кластеры высокой доступности) 2) кластеры с балансировкой нагрузки (Load balancing clusters) 3)вычислительные кластеры (High perfomance computing clusters) 4) grid-системы Компании, выпускающие НА - системы : HP, Digital, IBM 2

Большой Linux кластер в Хемницком техническом университете, Германия 3

Большой Linux кластер в Хемницком техническом университете, Германия 3

Принципы построения отказоустойчивых кластеров 1) с холодным активный/пассивный. резервом или 2) с горячим резервом или активный/активный. Все узлы выполняют запросы, в случае отказа одного нагрузка перераспределяется между оставшимися ( кластер распределения нагрузки с поддержкой перераспределения запросов при отказе) Пример: Microsoft Cluster Server. Open. Source проект Open. Mosix. 4

Принципы построения отказоустойчивых кластеров 1) с холодным активный/пассивный. резервом или 2) с горячим резервом или активный/активный. Все узлы выполняют запросы, в случае отказа одного нагрузка перераспределяется между оставшимися ( кластер распределения нагрузки с поддержкой перераспределения запросов при отказе) Пример: Microsoft Cluster Server. Open. Source проект Open. Mosix. 4

Принципы построения отказоустойчивых кластеров 3) с модульной избыточностью. Применяется только в случае, когда простой системы совершенно недопустим. Все узлы одновременно выполняют один и тот же запрос (либо части его, но так, что результат достижим и при отказе любого узла), из результатов берется любой. Необходимо гарантировать, что результаты разных узлов всегда будут одинаковы (либо различия гарантированно не повлияют на дальнейшую работу). Примеры — redundancy. технологии RAID и Triple modular 5

Принципы построения отказоустойчивых кластеров 3) с модульной избыточностью. Применяется только в случае, когда простой системы совершенно недопустим. Все узлы одновременно выполняют один и тот же запрос (либо части его, но так, что результат достижим и при отказе любого узла), из результатов берется любой. Необходимо гарантировать, что результаты разных узлов всегда будут одинаковы (либо различия гарантированно не повлияют на дальнейшую работу). Примеры — redundancy. технологии RAID и Triple modular 5

Принципы построения отказоустойчивых кластеров Конкретная технология может принципы в любой комбинации. сочетать данные Например, Linux-HA поддерживает режим обоюдной поглощающей конфигурации (англ. takeover), в котором критические запросы выполняются всеми узлами вместе, прочие же равномерно распределяются между ними. 6

Принципы построения отказоустойчивых кластеров Конкретная технология может принципы в любой комбинации. сочетать данные Например, Linux-HA поддерживает режим обоюдной поглощающей конфигурации (англ. takeover), в котором критические запросы выполняются всеми узлами вместе, прочие же равномерно распределяются между ними. 6

Отказоустойчивые многопроцессорные сервера (Fault tolerant – FT архитектура). В основе FT - архитектуры – использование резервных элементов, число которых в различных серверах может отличаться Компании, выпускающие FT - сервера : Stratus Technologies и Tandem Computer. 7

Отказоустойчивые многопроцессорные сервера (Fault tolerant – FT архитектура). В основе FT - архитектуры – использование резервных элементов, число которых в различных серверах может отличаться Компании, выпускающие FT - сервера : Stratus Technologies и Tandem Computer. 7

Архитектура FT – сервер 8

Архитектура FT – сервер 8

Сервер Stratus ft. Server 4500 Цена 40 672 долл. ВБР 0, 99999 (время простоя – 5 минут в год) Предустановленные ОС Windows Server 2008 R 2 x 64 Enterprise Edition VMware v. Sphere 4 Red Hat Enterprise Linux (RHEL) 5. 9

Сервер Stratus ft. Server 4500 Цена 40 672 долл. ВБР 0, 99999 (время простоя – 5 минут в год) Предустановленные ОС Windows Server 2008 R 2 x 64 Enterprise Edition VMware v. Sphere 4 Red Hat Enterprise Linux (RHEL) 5. 9

Сервер Stratus ft. Server 4500 • два логических четырехъядерных процессора Intel Xeon E 5504, работающих на частоте 2 Ггц • набор микросхем Intel 5500 • оперативная память 16 Гбайт • дисковая подсистема объемом 136 Гбайт, жесткие диски с интерфейсом Serial Attached SCSI (SAS), вращающиеся со скоростью 15000 оборотов в минуту. 10

Сервер Stratus ft. Server 4500 • два логических четырехъядерных процессора Intel Xeon E 5504, работающих на частоте 2 Ггц • набор микросхем Intel 5500 • оперативная память 16 Гбайт • дисковая подсистема объемом 136 Гбайт, жесткие диски с интерфейсом Serial Attached SCSI (SAS), вращающиеся со скоростью 15000 оборотов в минуту. 10

Сервер Stratus ft. Server 4500 • Каждый модуль CPU-I/O может поддерживать до 96 Гбайт оперативной памяти, работающей на частоте 800 МГц, и общий объем дисковой подсистемы вплоть до 4, 8 Тбайт на жестких дисках с интерфейсом SAS. • Два модуля CPU-I/O имеют восемь сетевых портов, которые настроены как группа с помощью технологии Advanced Network Services (ANS) компании Intel ( Обеспечение сетевой отказоустойчивости). 11

Сервер Stratus ft. Server 4500 • Каждый модуль CPU-I/O может поддерживать до 96 Гбайт оперативной памяти, работающей на частоте 800 МГц, и общий объем дисковой подсистемы вплоть до 4, 8 Тбайт на жестких дисках с интерфейсом SAS. • Два модуля CPU-I/O имеют восемь сетевых портов, которые настроены как группа с помощью технологии Advanced Network Services (ANS) компании Intel ( Обеспечение сетевой отказоустойчивости). 11

Сравнительный анализ FT – серверов и НА -систем Особенности системы и требования к ней НА-кластер FT – сервер Определение максимальной длительности неплановых и плановых простоев необходимо не необходимо Разработка сценариев поведения системы и управления ей при неисправностях (с привлечением консультантов) необходима не необходима Выбор и разработка способов тестирования для обеспечения заданного уровня надежности необходимы встроенный контроль и диагностика 12

Сравнительный анализ FT – серверов и НА -систем Особенности системы и требования к ней НА-кластер FT – сервер Определение максимальной длительности неплановых и плановых простоев необходимо не необходимо Разработка сценариев поведения системы и управления ей при неисправностях (с привлечением консультантов) необходима не необходима Выбор и разработка способов тестирования для обеспечения заданного уровня надежности необходимы встроенный контроль и диагностика 12

Сравнительный анализ FT – серверов и НА - систем Особенности системы и требования к ней Специальный персонал для поддержки системы во время эксплуатации, обучение персонала НАкластер Необходимо FT – сервер Дополнительное системное программное обеспечение для данной платформы, включая специальные средства администрирования системы, сети и базы данных Необходима не необходимо 13

Сравнительный анализ FT – серверов и НА - систем Особенности системы и требования к ней Специальный персонал для поддержки системы во время эксплуатации, обучение персонала НАкластер Необходимо FT – сервер Дополнительное системное программное обеспечение для данной платформы, включая специальные средства администрирования системы, сети и базы данных Необходима не необходимо 13

Сравнительный анализ FT – серверов и НА - систем Особенности системы и требования к ней Переносимость приложений с одной платформы на другие НАкластер не гарантируется FT – сервер Возможность защиты от катастрофических отказов оборудования существует отсутствует Защита от сбоев программных средств существует отсутствует гарантирует ся 14

Сравнительный анализ FT – серверов и НА - систем Особенности системы и требования к ней Переносимость приложений с одной платформы на другие НАкластер не гарантируется FT – сервер Возможность защиты от катастрофических отказов оборудования существует отсутствует Защита от сбоев программных средств существует отсутствует гарантирует ся 14

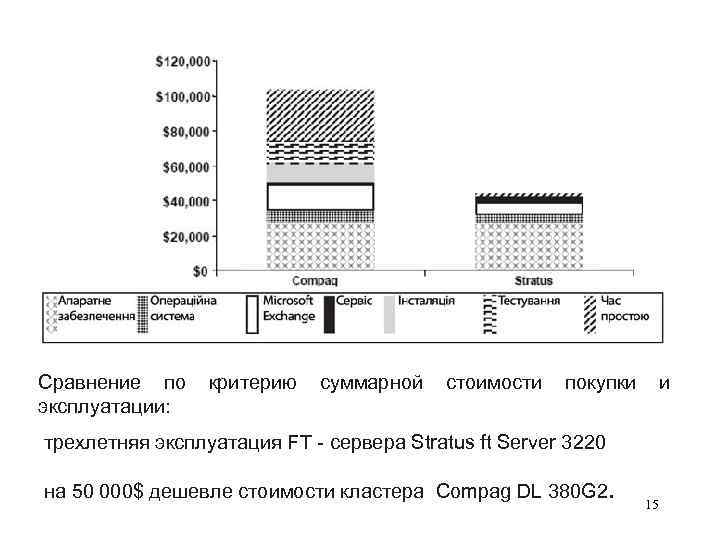

Сравнение по эксплуатации: критерию суммарной стоимости покупки и трехлетняя эксплуатация FT - сервера Stratus ft Server 3220 на 50 000$ дешевле стоимости кластера Compag DL 380 G 2. 15

Сравнение по эксплуатации: критерию суммарной стоимости покупки и трехлетняя эксплуатация FT - сервера Stratus ft Server 3220 на 50 000$ дешевле стоимости кластера Compag DL 380 G 2. 15

Особенности технологии Stratus FTServer Отсутствует необходимость • писать восстановительные скрипты, • локализовать приложения, • выполнять сложное администрирование Нет потерь времени на восстановление после сбоя Принцип обеспечения отказоустойчивости: дублирование и троирование аппаратных компонентов (Dual. Modular Redundancy - DMR, Triple Modular Redundancy - TMR). 16

Особенности технологии Stratus FTServer Отсутствует необходимость • писать восстановительные скрипты, • локализовать приложения, • выполнять сложное администрирование Нет потерь времени на восстановление после сбоя Принцип обеспечения отказоустойчивости: дублирование и троирование аппаратных компонентов (Dual. Modular Redundancy - DMR, Triple Modular Redundancy - TMR). 16

В режиме DMR (ТMR ) сервер включает • две (три) процессорные платы, каждая из которых может содержать до четырех процессоров • память • автономные источники питания На уровне обнаружения ошибок происходит сравнение выходной информации каждой подсистемы процессор – память для каждой операции ввода-вывода. В DMR – системе при возникновении ошибки, обнаруживаемой при сравнении, не сопровождаемой сигналом неисправности с системных плат (нештатное событие) для вывода неисправной системной платы используется программные алгоритмы, основанные на слежении за историей событий. В ТMR – системе для идентификации и изолирования неисправностей применяется логика мажоритарного 17 голосования.

В режиме DMR (ТMR ) сервер включает • две (три) процессорные платы, каждая из которых может содержать до четырех процессоров • память • автономные источники питания На уровне обнаружения ошибок происходит сравнение выходной информации каждой подсистемы процессор – память для каждой операции ввода-вывода. В DMR – системе при возникновении ошибки, обнаруживаемой при сравнении, не сопровождаемой сигналом неисправности с системных плат (нештатное событие) для вывода неисправной системной платы используется программные алгоритмы, основанные на слежении за историей событий. В ТMR – системе для идентификации и изолирования неисправностей применяется логика мажоритарного 17 голосования.

Особенности технологии Stratus FTServer • процесс обработки информации не прерывается • производительность системы не снижается • весь цикл обнаружения ошибок и локализации неисправностей занимает несколько миллисекунд Клиенты Stratus: • банки • правительственные учреждения • промышленные предприятия • телефонные компании www. stratus. com. 18

Особенности технологии Stratus FTServer • процесс обработки информации не прерывается • производительность системы не снижается • весь цикл обнаружения ошибок и локализации неисправностей занимает несколько миллисекунд Клиенты Stratus: • банки • правительственные учреждения • промышленные предприятия • телефонные компании www. stratus. com. 18

Отказоустойчивые структуры на ПЛИС - программируемые логические интегральные схемы – большие интегральные микросхемы матричного типа, позволяющие программно создать в одном корпусе схему, эквивалентную схеме из десятков и сотен схем стандартной логики. ПЛИС – наиболее перспективная технология, позволяющая создавать схемные решения различной сложности на одном кристалле микросхемы. С точки зрения внутреннего строения микросхемы ПЛИС – это набор вентилей, которые программист может использовать для реализации проекта. С помощью САПР, поставляющейся вместе с ПЛИС, есть возможность реализовать на кристалле часть системы либо систему в целом. 19

Отказоустойчивые структуры на ПЛИС - программируемые логические интегральные схемы – большие интегральные микросхемы матричного типа, позволяющие программно создать в одном корпусе схему, эквивалентную схеме из десятков и сотен схем стандартной логики. ПЛИС – наиболее перспективная технология, позволяющая создавать схемные решения различной сложности на одном кристалле микросхемы. С точки зрения внутреннего строения микросхемы ПЛИС – это набор вентилей, которые программист может использовать для реализации проекта. С помощью САПР, поставляющейся вместе с ПЛИС, есть возможность реализовать на кристалле часть системы либо систему в целом. 19

Преимущества ПЛИС при повышении отказоустойчивости 1) резервирование (дублирование, мажоритирование и др. ) внутреннее (внутри кристалла) и внешнее (для микросхемы в целом). Пример: внутри кристалла используется дублирование каналов, для микросхемы в целом – мажоритирование « 2 из 3» 2) Только для ПЛИС - возможность динамической реконфигурации – изменения внутренней структуры кристалла ПЛИС во время ее работы – парируются кластерные отказы – за счет развитой системы избыточных трассировочных ресурсов определяются отказавшие ячейки, выводится из конфигурации функциональный блок с отказавшими элементами и заменяется другим блоком в обход отказа. 20

Преимущества ПЛИС при повышении отказоустойчивости 1) резервирование (дублирование, мажоритирование и др. ) внутреннее (внутри кристалла) и внешнее (для микросхемы в целом). Пример: внутри кристалла используется дублирование каналов, для микросхемы в целом – мажоритирование « 2 из 3» 2) Только для ПЛИС - возможность динамической реконфигурации – изменения внутренней структуры кристалла ПЛИС во время ее работы – парируются кластерные отказы – за счет развитой системы избыточных трассировочных ресурсов определяются отказавшие ячейки, выводится из конфигурации функциональный блок с отказавшими элементами и заменяется другим блоком в обход отказа. 20

21

21

Преимущества ПЛИС- систем по сравнению с системами на СБИС 1) Малые весогабаритные показатели 2) Более высокая производительность за счет высокого быстродействия внутренних линий связи 3) Увеличение помехоустойчивости за счет уменьшения внутренних емкостных связей 4) Мощные средства разработки (САПР) позволяют вести отладку и тестирование структуры ПЛИС на этапе разработки, что существенно снижает временные затраты на проектирование, количество дефектов проектирования 5) Сокращение времени отработки оборудования и денежных затраты на верификацию и внедрение объектов 6) Для внесения изменений в систему на кристалле ПЛИС нужно в несколько раз меньше времени (несколько часов или дней по сравнению с неделями или месяцами) 22 7) Более высокая отказоустойчивость

Преимущества ПЛИС- систем по сравнению с системами на СБИС 1) Малые весогабаритные показатели 2) Более высокая производительность за счет высокого быстродействия внутренних линий связи 3) Увеличение помехоустойчивости за счет уменьшения внутренних емкостных связей 4) Мощные средства разработки (САПР) позволяют вести отладку и тестирование структуры ПЛИС на этапе разработки, что существенно снижает временные затраты на проектирование, количество дефектов проектирования 5) Сокращение времени отработки оборудования и денежных затраты на верификацию и внедрение объектов 6) Для внесения изменений в систему на кристалле ПЛИС нужно в несколько раз меньше времени (несколько часов или дней по сравнению с неделями или месяцами) 22 7) Более высокая отказоустойчивость

Технология Зеркалирования (Mirroring) 1) Зеркалирование портов (трафика) – дублирование трафика от одного или нескольких портов иили ВЛВС(VLAN) на отдельно взятый порт применяется для мониторинга трафика в целях безопасности, либо оценки производительностизагрузки сетевого оборудования с применением аппаратных средств. 2) Зеркалирование оперативной памяти используется для повышения устойчивости памяти к сбоям. • контроллер памяти одновременно работает с двумя портами доступа к памяти, • горячая замена и добавление обеспечивают возможность изменять конфигурацию памяти сервера и устранять неисправности модулей памяти без остановки системы. • Замена модуля памяти допускается только на эквивалентный по объёму, типу и скорости. Такая замена незаметна для операционной системы и может быть выполнена только если включено 23 зеркалирование.

Технология Зеркалирования (Mirroring) 1) Зеркалирование портов (трафика) – дублирование трафика от одного или нескольких портов иили ВЛВС(VLAN) на отдельно взятый порт применяется для мониторинга трафика в целях безопасности, либо оценки производительностизагрузки сетевого оборудования с применением аппаратных средств. 2) Зеркалирование оперативной памяти используется для повышения устойчивости памяти к сбоям. • контроллер памяти одновременно работает с двумя портами доступа к памяти, • горячая замена и добавление обеспечивают возможность изменять конфигурацию памяти сервера и устранять неисправности модулей памяти без остановки системы. • Замена модуля памяти допускается только на эквивалентный по объёму, типу и скорости. Такая замена незаметна для операционной системы и может быть выполнена только если включено 23 зеркалирование.

Технология Зеркалирования (Mirroring) 3) Зеркалирование информации (в том числе БД) Суть: дублирование информации • информация может быть восстановлена и/или сохранена как резервная копия без остановки системы 3) Зеркалирование сайтов Наиболее часто зеркала сайтов используются для предоставления нескольких источников одной и той же информации. Часто большие или популярные файлы располагают на нескольких зеркалах для ускорения скачивания и распределения нагрузки. В случаях, когда внешний трафик значительно дороже внутреннего, целесообразно создавать зеркала популярных внешних ресурсов в собственной зоне Интернет. 24

Технология Зеркалирования (Mirroring) 3) Зеркалирование информации (в том числе БД) Суть: дублирование информации • информация может быть восстановлена и/или сохранена как резервная копия без остановки системы 3) Зеркалирование сайтов Наиболее часто зеркала сайтов используются для предоставления нескольких источников одной и той же информации. Часто большие или популярные файлы располагают на нескольких зеркалах для ускорения скачивания и распределения нагрузки. В случаях, когда внешний трафик значительно дороже внутреннего, целесообразно создавать зеркала популярных внешних ресурсов в собственной зоне Интернет. 24

Технология RAID • RAID (англ. redundant array of independent disks — избыточный массив независимых жёстких дисков) — массив из нескольких дисков, управляемых контроллером, взаимосвязанных скоростными каналами и воспринимаемых внешней системой как единое целое. • В зависимости от типа используемого массива может обеспечивать различные степени отказоустойчивости и быстродействия. • Служит для повышения надёжности хранения данных и/или для повышения скорости чтения/записи информации (RAID 0). • Аппаратный RAID контроллер может поддерживать несколько разных RAID массивов одновременно, суммарное количество жёстких дисков которых не превышает количество разъёмов для них. 25

Технология RAID • RAID (англ. redundant array of independent disks — избыточный массив независимых жёстких дисков) — массив из нескольких дисков, управляемых контроллером, взаимосвязанных скоростными каналами и воспринимаемых внешней системой как единое целое. • В зависимости от типа используемого массива может обеспечивать различные степени отказоустойчивости и быстродействия. • Служит для повышения надёжности хранения данных и/или для повышения скорости чтения/записи информации (RAID 0). • Аппаратный RAID контроллер может поддерживать несколько разных RAID массивов одновременно, суммарное количество жёстких дисков которых не превышает количество разъёмов для них. 25

Стандарты (уровни) RAID • RAID 0 - дисковый массив повышенной производительности, с чередованием, без отказоустойчивости. • RAID 1 - зеркальный дисковый массив. • RAID 2 – массив с применением кода Хемминга. • RAID 3 и 4 - массив дисков с чередованием и выделенным диском чётности. • RAID 5 - массив дисков с чередованием и "невыделенным диском чётности". • RAID 6 массив дисков с чередованием и двумя независимыми "чётностями" блоков. • RAID 10 — RAID 0, построенный из RAID 1 массивов • RAID 50 — RAID 0, построенный из RAID 5 • RAID 60 — RAID 0, построенный из RAID 6 26

Стандарты (уровни) RAID • RAID 0 - дисковый массив повышенной производительности, с чередованием, без отказоустойчивости. • RAID 1 - зеркальный дисковый массив. • RAID 2 – массив с применением кода Хемминга. • RAID 3 и 4 - массив дисков с чередованием и выделенным диском чётности. • RAID 5 - массив дисков с чередованием и "невыделенным диском чётности". • RAID 6 массив дисков с чередованием и двумя независимыми "чётностями" блоков. • RAID 10 — RAID 0, построенный из RAID 1 массивов • RAID 50 — RAID 0, построенный из RAID 5 • RAID 60 — RAID 0, построенный из RAID 6 26

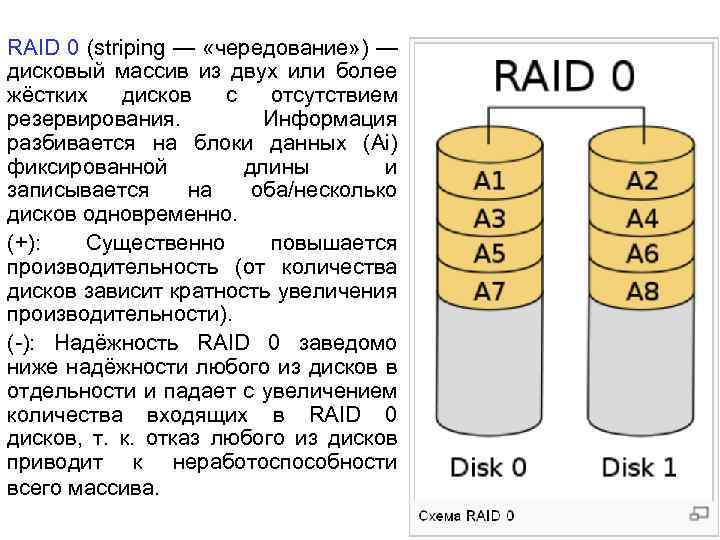

RAID 0 (striping — «чередование» ) — дисковый массив из двух или более жёстких дисков с отсутствием резервирования. Информация разбивается на блоки данных (Аi) фиксированной длины и записывается на оба/несколько дисков одновременно. (+): Cущественно повышается производительность (от количества дисков зависит кратность увеличения производительности). (-): Надёжность RAID 0 заведомо ниже надёжности любого из дисков в отдельности и падает с увеличением количества входящих в RAID 0 дисков, т. к. отказ любого из дисков приводит к неработоспособности всего массива. 27

RAID 0 (striping — «чередование» ) — дисковый массив из двух или более жёстких дисков с отсутствием резервирования. Информация разбивается на блоки данных (Аi) фиксированной длины и записывается на оба/несколько дисков одновременно. (+): Cущественно повышается производительность (от количества дисков зависит кратность увеличения производительности). (-): Надёжность RAID 0 заведомо ниже надёжности любого из дисков в отдельности и падает с увеличением количества входящих в RAID 0 дисков, т. к. отказ любого из дисков приводит к неработоспособности всего массива. 27

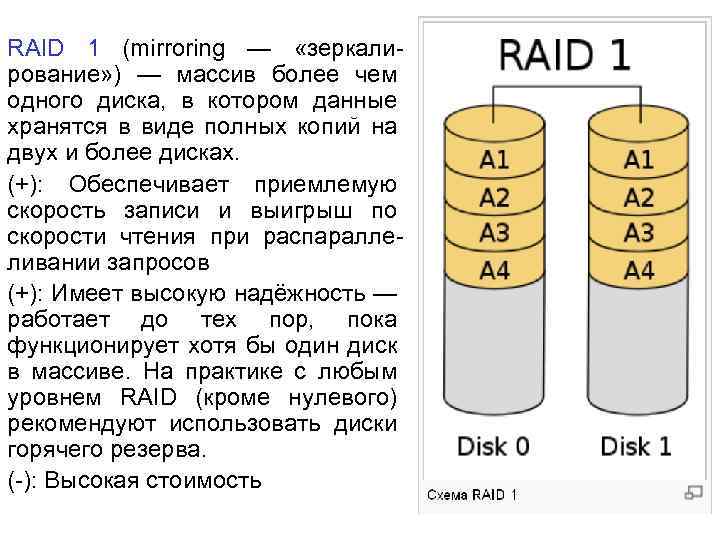

RAID 1 (mirroring — «зеркалирование» ) — массив более чем одного диска, в котором данные хранятся в виде полных копий на двух и более дисках. (+): Обеспечивает приемлемую скорость записи и выигрыш по скорости чтения при распараллеливании запросов (+): Имеет высокую надёжность — работает до тех пор, пока функционирует хотя бы один диск в массиве. На практике с любым уровнем RAID (кроме нулевого) рекомендуют использовать диски горячего резерва. (-): Высокая стоимость 28

RAID 1 (mirroring — «зеркалирование» ) — массив более чем одного диска, в котором данные хранятся в виде полных копий на двух и более дисках. (+): Обеспечивает приемлемую скорость записи и выигрыш по скорости чтения при распараллеливании запросов (+): Имеет высокую надёжность — работает до тех пор, пока функционирует хотя бы один диск в массиве. На практике с любым уровнем RAID (кроме нулевого) рекомендуют использовать диски горячего резерва. (-): Высокая стоимость 28

RAID 1 (mirroring — «зеркалирование» ) Зеркало на многих дисках RAID 1+0 ( RAID 10) - два или более RAID 1 объединяются в RAID 0+1 ( RAID 01) - два RAID 0 объединяются в RAID 1. Рекомендуется включать в массив диски горячего резерва из расчёта один резервный на пять рабочих. 29

RAID 1 (mirroring — «зеркалирование» ) Зеркало на многих дисках RAID 1+0 ( RAID 10) - два или более RAID 1 объединяются в RAID 0+1 ( RAID 01) - два RAID 0 объединяются в RAID 1. Рекомендуется включать в массив диски горячего резерва из расчёта один резервный на пять рабочих. 29

RAID 2 ( Код Хемминга) • диски делятся на две группы — для данных и для кодов коррекции ошибок, • если данные хранятся на 2 n – n - 1 дисках, то для хранения кодов коррекции необходимо n дисков • данные записываются на соответствующие диски так же, как и в RAID 0 • Оставшиеся диски хранят коды коррекции ошибок, по которым в случае выхода какого-либо жёсткого диска из строя возможно восстановление информации. (-): структура из почти двойного количества дисков, RAID 2 не получил распространения. 30

RAID 2 ( Код Хемминга) • диски делятся на две группы — для данных и для кодов коррекции ошибок, • если данные хранятся на 2 n – n - 1 дисках, то для хранения кодов коррекции необходимо n дисков • данные записываются на соответствующие диски так же, как и в RAID 0 • Оставшиеся диски хранят коды коррекции ошибок, по которым в случае выхода какого-либо жёсткого диска из строя возможно восстановление информации. (-): структура из почти двойного количества дисков, RAID 2 не получил распространения. 30

RAID 3 ( 4 ) – информация разбивается на байты (блоки), используется один дополнительный дисковый накопитель, обеспечивающий хранение информации о четности (контрольной суммы) данных, записываемых на остальные диски. (+): высокая скорость чтения и записи данных; (-): большая нагрузка на контрольный диск. 31

RAID 3 ( 4 ) – информация разбивается на байты (блоки), используется один дополнительный дисковый накопитель, обеспечивающий хранение информации о четности (контрольной суммы) данных, записываемых на остальные диски. (+): высокая скорость чтения и записи данных; (-): большая нагрузка на контрольный диск. 31

RAID 5 – Блоки данных и контрольные суммы циклически записываются на все диски массива, нет асимметричности конфигурации дисков. (+): экономичность, повышение производительности при чтении (-): падение производительности при записи на операциях типа Random Write (записи в произвольном порядке), 10 -25% от производительности RAID 1 (или RAID 10) 32

RAID 5 – Блоки данных и контрольные суммы циклически записываются на все диски массива, нет асимметричности конфигурации дисков. (+): экономичность, повышение производительности при чтении (-): падение производительности при записи на операциях типа Random Write (записи в произвольном порядке), 10 -25% от производительности RAID 1 (или RAID 10) 32

RAID 6 - под контрольные суммы выделяется ёмкость 2 -х дисков, рассчитываются 2 суммы по разным алгоритмам. Требует более мощный RAID-контроллер. Обеспечивает работоспособность после одновременного выхода из строя двух дисков — защита от кратного отказа. Для организации массива требуется минимум 4 диска. 33

RAID 6 - под контрольные суммы выделяется ёмкость 2 -х дисков, рассчитываются 2 суммы по разным алгоритмам. Требует более мощный RAID-контроллер. Обеспечивает работоспособность после одновременного выхода из строя двух дисков — защита от кратного отказа. Для организации массива требуется минимум 4 диска. 33

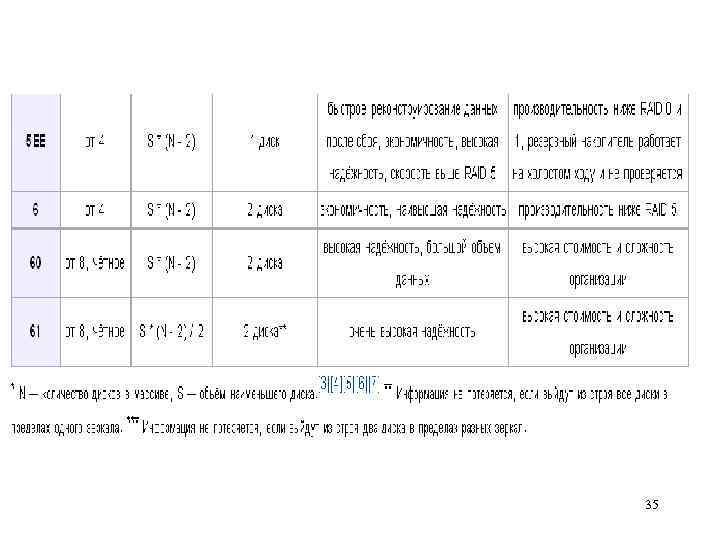

34

34

35

35

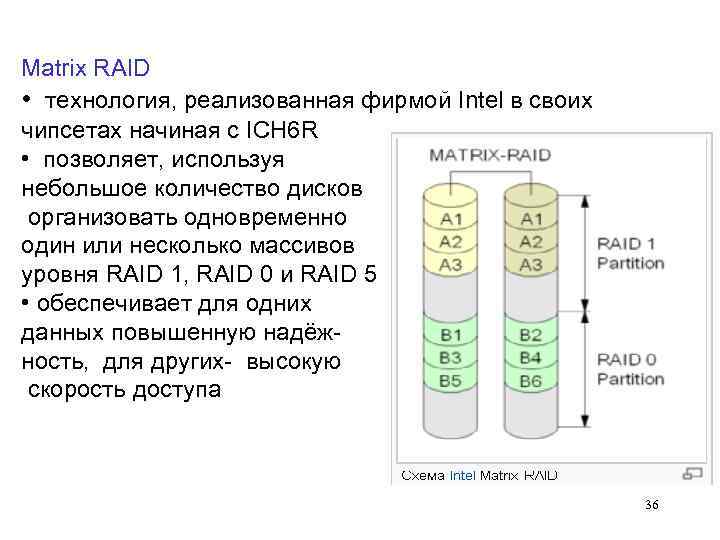

Matrix RAID • технология, реализованная фирмой Intel в своих чипсетах начиная с ICH 6 R • позволяет, используя небольшое количество дисков организовать одновременно один или несколько массивов уровня RAID 1, RAID 0 и RAID 5. • обеспечивает для одних данных повышенную надёжность, для других- высокую скорость доступа 36

Matrix RAID • технология, реализованная фирмой Intel в своих чипсетах начиная с ICH 6 R • позволяет, используя небольшое количество дисков организовать одновременно один или несколько массивов уровня RAID 1, RAID 0 и RAID 5. • обеспечивает для одних данных повышенную надёжность, для других- высокую скорость доступа 36

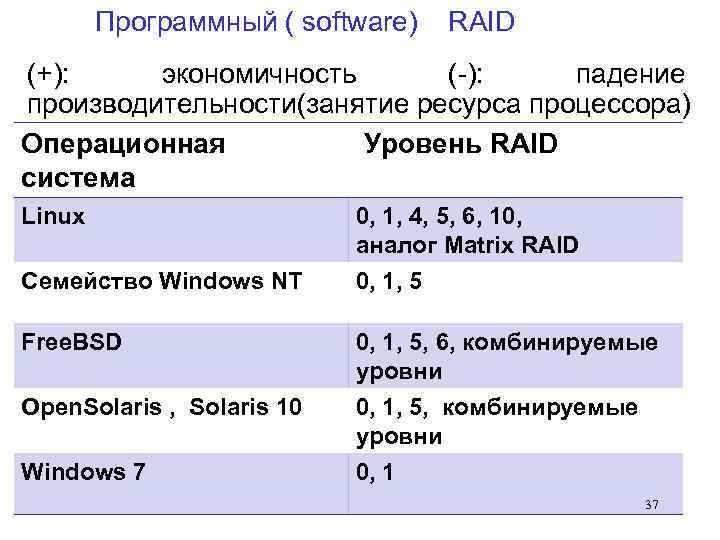

Программный ( software) RAID (+): экономичность (-): падение производительности(занятие ресурса процессора) Операционная Уровень RAID система Linux Семейство Windows NT 0, 1, 4, 5, 6, 10, аналог Matrix RAID 0, 1, 5 Free. BSD 0, 1, 5, 6, комбинируемые уровни Open. Solaris , Solaris 10 0, 1, 5, комбинируемые уровни 0, 1 Windows 7 37

Программный ( software) RAID (+): экономичность (-): падение производительности(занятие ресурса процессора) Операционная Уровень RAID система Linux Семейство Windows NT 0, 1, 4, 5, 6, 10, аналог Matrix RAID 0, 1, 5 Free. BSD 0, 1, 5, 6, комбинируемые уровни Open. Solaris , Solaris 10 0, 1, 5, комбинируемые уровни 0, 1 Windows 7 37