Основы распознавания речи 6.pptx

- Количество слайдов: 12

Системы распознавания речи: базовые принципы и алгоритмы Распознавание слитной речи

На прошлом занятии Every time I fire a linguist, the performance of the speech recognizer goes up Frederick Jelinek Для распознавания изолированных слов используются два типа СММ: смм для аллофонов с тремя состояниями (инициаль – вершина – финаль) и модель слов с n состояниями для слова длины n (каждое состояние соответствует аллофону) Для моделирования вероятностей наблюдений в настоящий момент используются модели гауссовых смесей (GMM) Для обучения модели GMM в общем случае необходимо оценить матрицу ковариации для всех компонент наблюдаемого вектора Чтобы избежать этого можно преобразовать вектор наблюдений так, чтобы компоненты были некоррелированны. В этом случае матрица ковариации становится диагональной (на диагонали дисперсии). Для диагонализации в распознавании речи принято использовать ДКТ Для обучения СММ для распознавания речи используется алгоритм Баума. Велша Алгоритм Баума-Велша является частным случаем алгоритма максимизации ожидания (EM) Доказано, что EM сходится к локальному минимуму

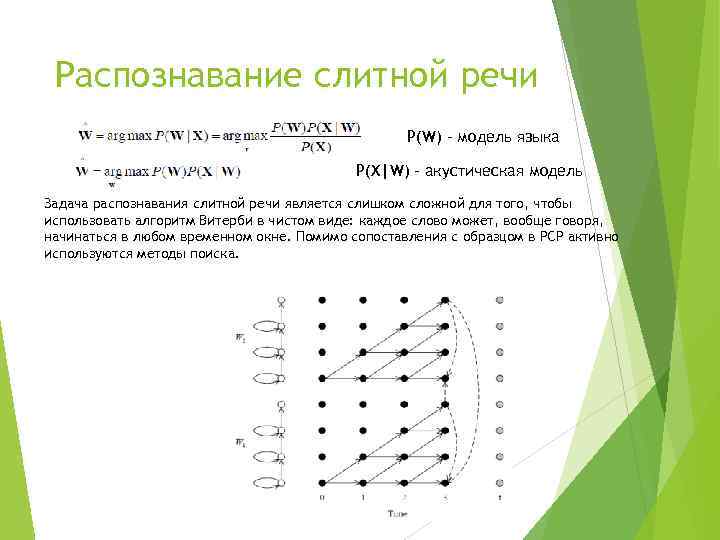

Распознавание слитной речи P(W) – модель языка P(X|W) – акустическая модель Задача распознавания слитной речи является слишком сложной для того, чтобы использовать алгоритм Витерби в чистом виде: каждое слово может, вообще говоря, начинаться в любом временном окне. Помимо сопоставления с образцом в РСР активно используются методы поиска.

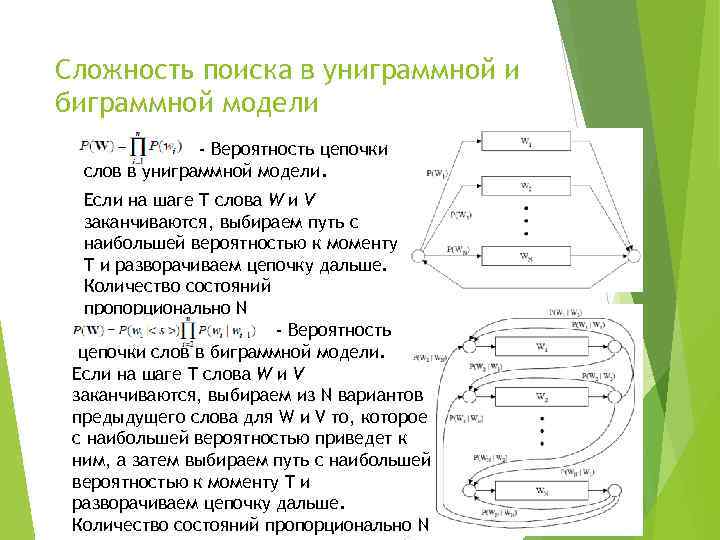

Сложность поиска в униграммной и биграммной модели - Вероятность цепочки слов в униграммной модели. Если на шаге T слова W и V заканчиваются, выбираем путь с наибольшей вероятностью к моменту T и разворачиваем цепочку дальше. Количество состояний пропорционально N - Вероятность цепочки слов в биграммной модели. Если на шаге T слова W и V заканчиваются, выбираем из N вариантов предыдущего слова для W и V то, которое с наибольшей вероятностью приведет к ним, а затем выбираем путь с наибольшей вероятностью к моменту T и разворачиваем цепочку дальше. Количество состояний пропорционально N

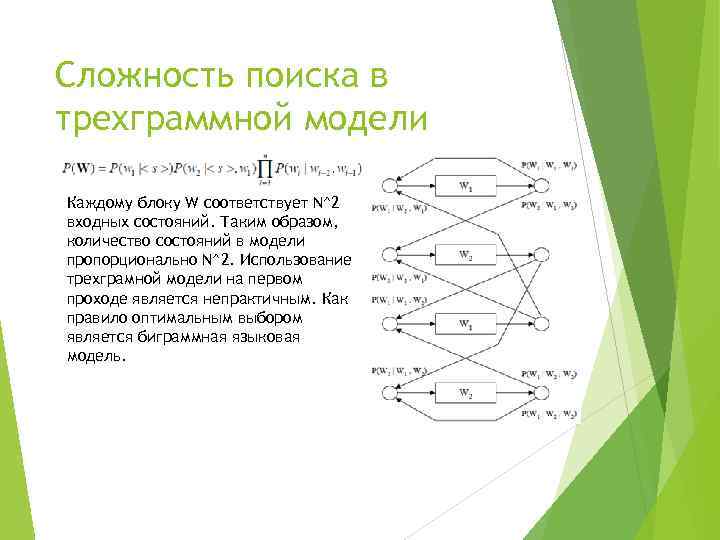

Сложность поиска в трехграммной модели Каждому блоку W соответствует N^2 входных состояний. Таким образом, количество состояний в модели пропорционально N^2. Использование трехграмной модели на первом проходе является непрактичным. Как правило оптимальным выбором является биграммная языковая модель.

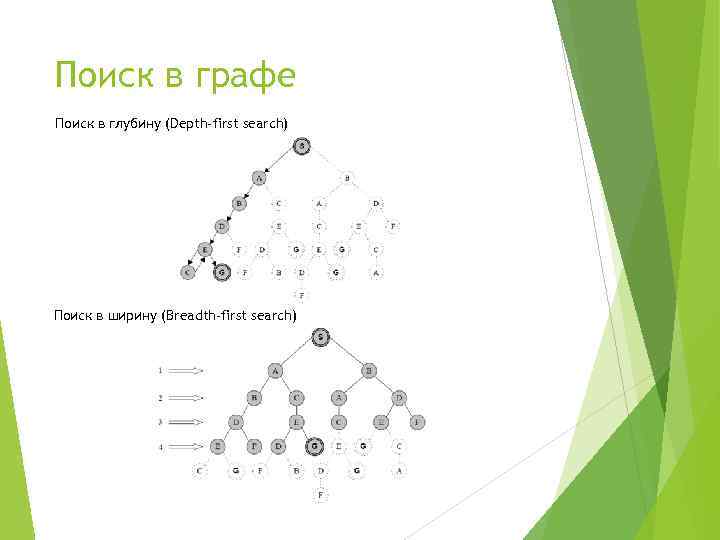

Поиск в графе Поиск в глубину (Depth-first search) Поиск в ширину (Breadth-first search)

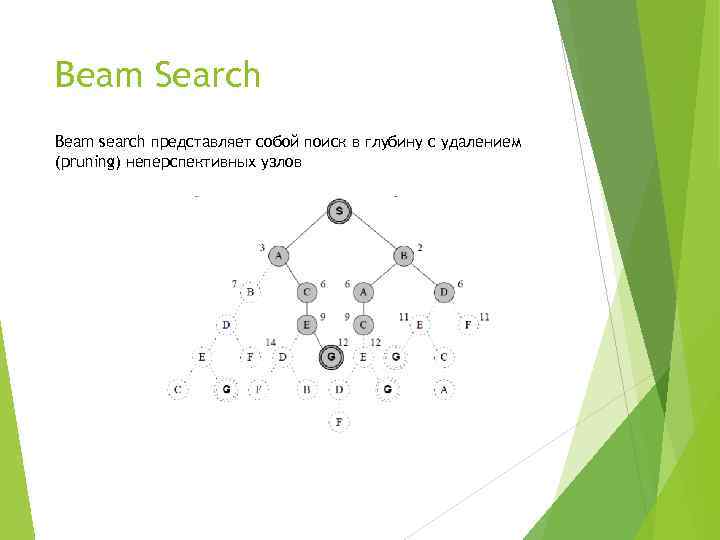

Beam Search Beam search представляет собой поиск в глубину с удалением (pruning) неперспективных узлов

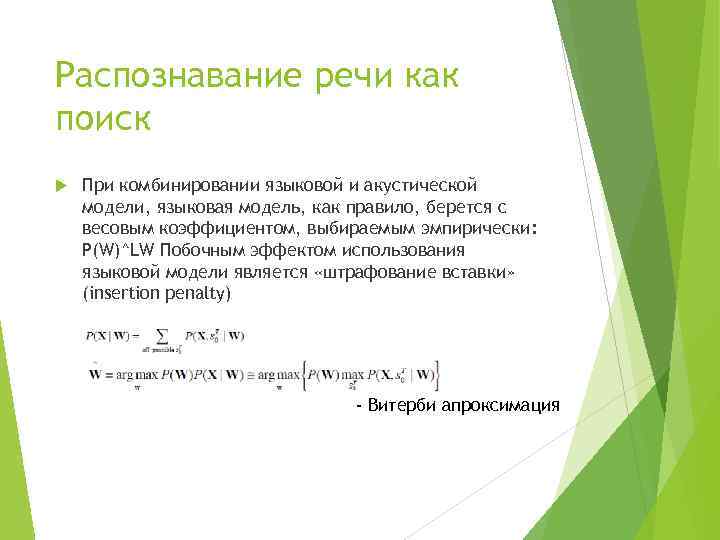

Распознавание речи как поиск При комбинировании языковой и акустической модели, языковая модель, как правило, берется с весовым коэффициентом, выбираемым эмпирически: P(W)^LW Побочным эффектом использования языковой модели является «штрафование вставки» (insertion penalty) - Витерби апроксимация

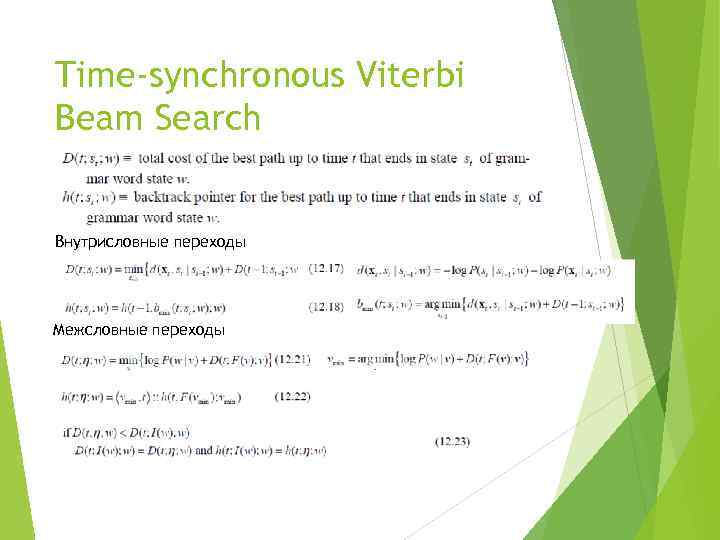

Time-synchronous Viterbi Beam Search Внутрисловные переходы Межсловные переходы

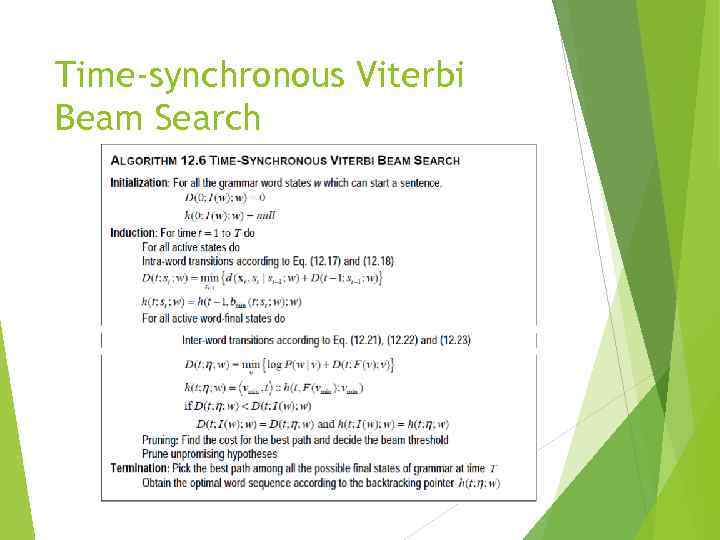

Time-synchronous Viterbi Beam Search

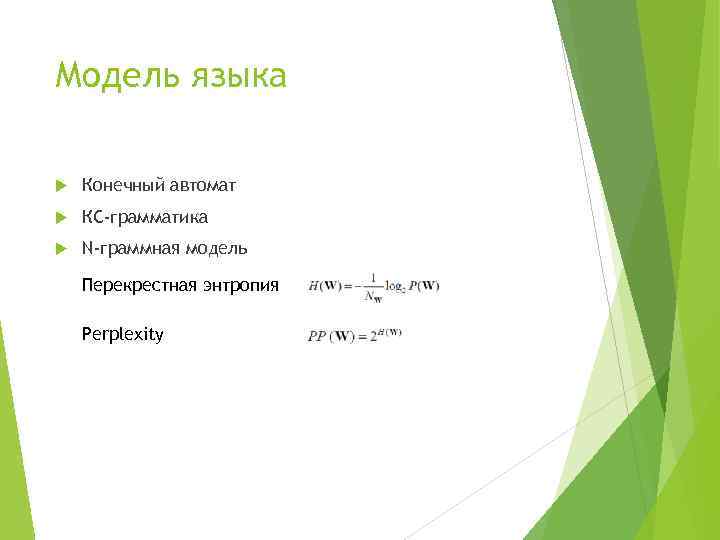

Модель языка Конечный автомат КС-грамматика N-граммная модель Перекрестная энтропия Perplexity

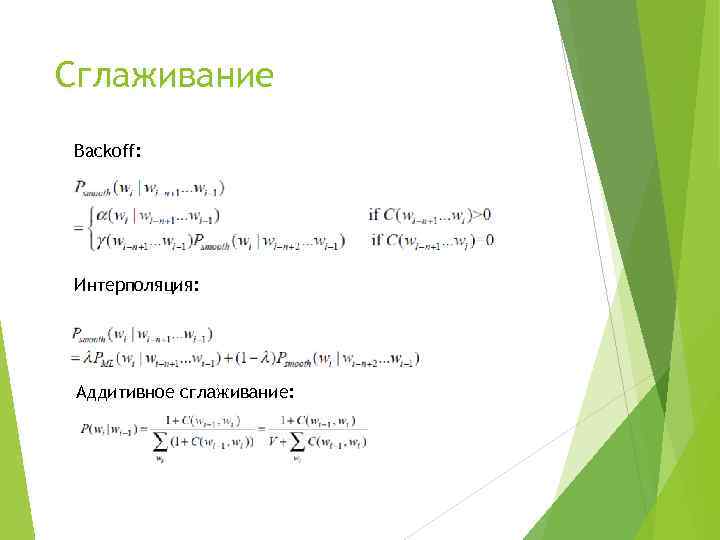

Сглаживание Backoff: Интерполяция: Аддитивное сглаживание:

Основы распознавания речи 6.pptx