888afafe8849dc722c7c68082718312f.ppt

- Количество слайдов: 54

Семантика в автоматической обработке текста Выделение ключевых слов

План Методы оценки тематического веса слова (языкового выражения) векторная модель вероятностная модель некоторые другие весовые функции

Методы оценки тематического веса слова С точки зрения словаря / стиля / жанра: значимость для всей коллекции / общеупотребительность / распространенность распределенность по коллекции, но: информативность для коллекции С точки зрения текста: специфичность для текста – тематический вес

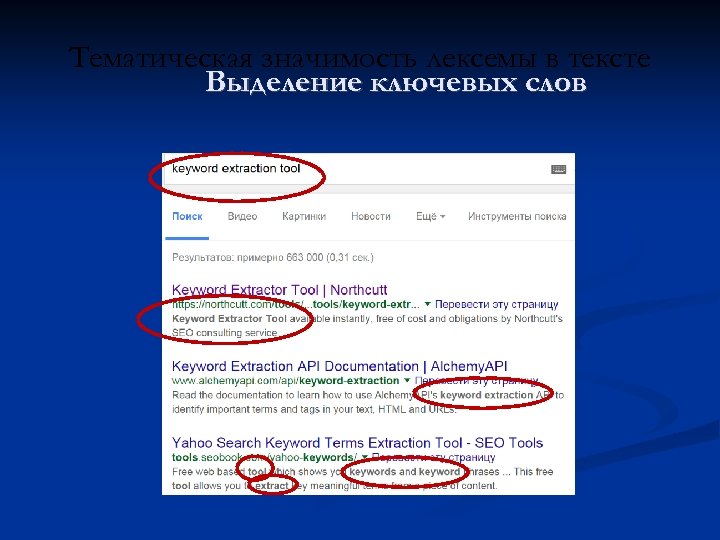

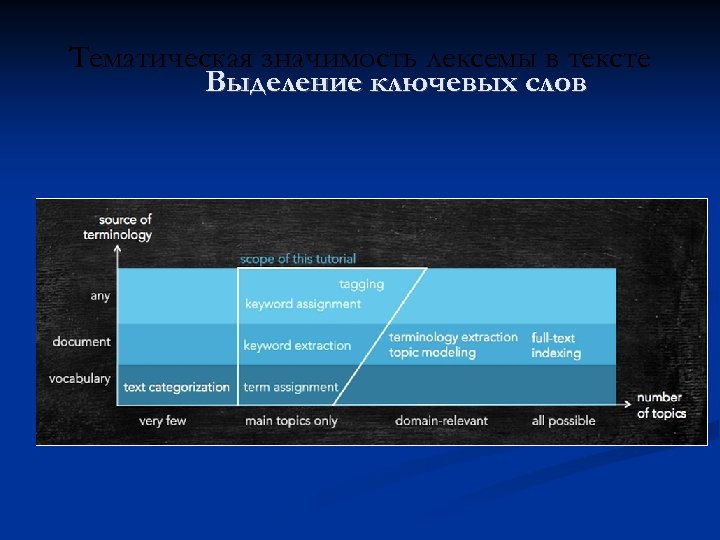

Тематическая значимость лексемы в тексте Выделение ключевых слов

Выделение ключевых слов In statistics and information theory, a maximum entropy probability distribution has entropy that is at least as great as that of all other members of a specified class of probability distributions. According to the principle of maximum entropy, if nothing is known about a distribution except that it belongs to a certain class (usually defined in terms of specified properties or measures), then the distribution with the largest entropy should be chosen as the least informative default. The motivation is twofold: first, maximizing entropy minimizes the amount of prior information built into the distribution; second, many physical systems tend to move towards maximal entropy configurations over time.

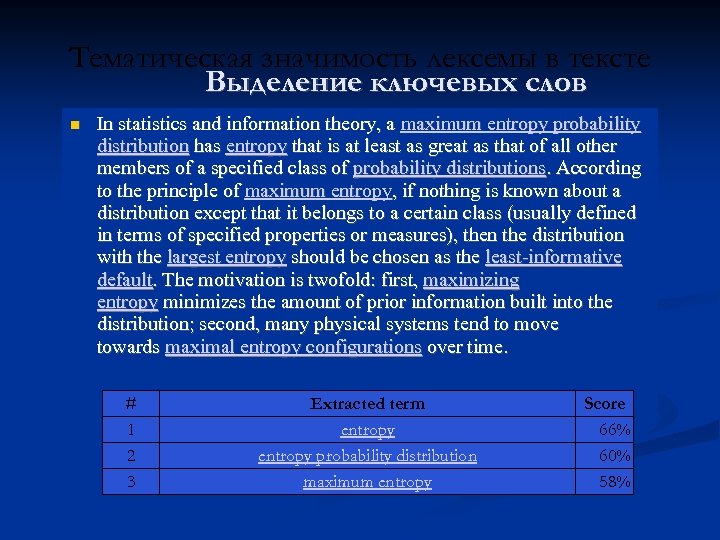

Тематическая значимость лексемы в тексте Выделение ключевых слов In statistics and information theory, a maximum entropy probability distribution has entropy that is at least as great as that of all other members of a specified class of probability distributions. According to the principle of maximum entropy, if nothing is known about a distribution except that it belongs to a certain class (usually defined in terms of specified properties or measures), then the distribution with the largest entropy should be chosen as the least informative default. The motivation is twofold: first, maximizing entropy minimizes the amount of prior information built into the distribution; second, many physical systems tend to move towards maximal entropy configurations over time. # 1 2 3 Extracted term entropy probability distribution maximum entropy Score 66% 60% 58%

Тематическая значимость лексемы в тексте Выделение ключевых слов

Тематическая значимость лексемы в тексте Выделение ключевых слов Текст – тематически значимые элементы текста информационный поиск Ø СЕО продвижение Ø семантическое тегирование документов (topic modelling) Ø быстрое «чтение» документа Ø МП Ø

Тематическая значимость лексемы в тексте Выделение ключевых слов

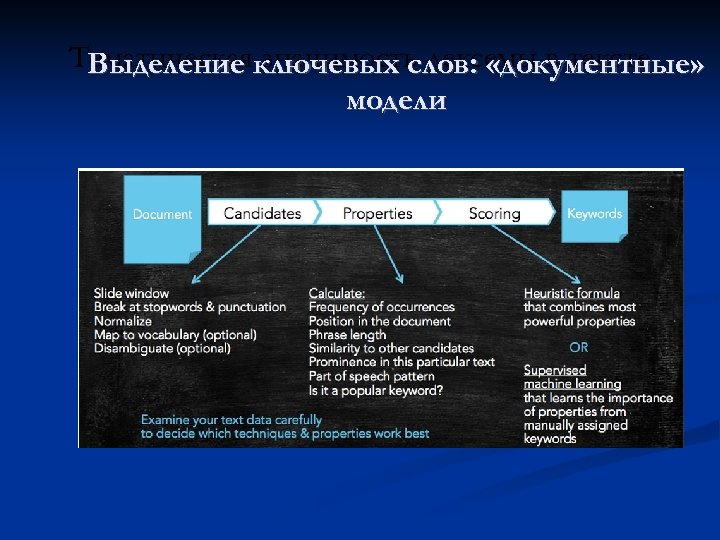

Тематическаяключевых слов: «документные» Выделение значимость лексемы в тексте модели Модели ключевые выражения из ограниченного множества; «адрес» ; ручное тегирование модели “распознавания образов”

Тематическаяключевых слов: «документные» Выделение значимость лексемы в тексте модели

Методы оценки тематического веса слова Используемые модели Векторное пространство Вероятностные модели «Языковые» модели (марковские модели) Энтропийные модели

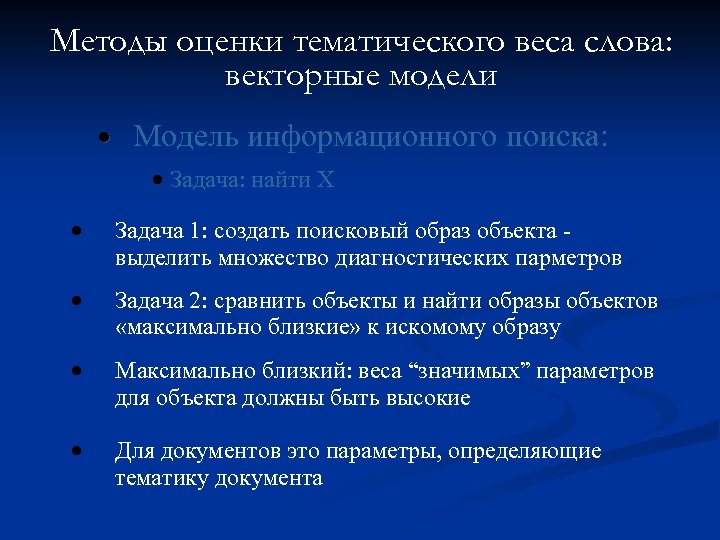

Методы оценки тематического веса слова: векторные модели • Модель информационного поиска: • Задача: найти Х • Задача 1: создать поисковый образ объекта выделить множество диагностических парметров • Задача 2: сравнить объекты и найти образы объектов «максимально близкие» к искомому образу • Максимально близкий: веса “значимых” параметров для объекта должны быть высокие • Для документов это параметры, определяющие тематику документа

Векторная модель Признаки: координаты в пространстве Близость (подобие): близость в пространстве Поисковый образ: вектор в пространстве признаков

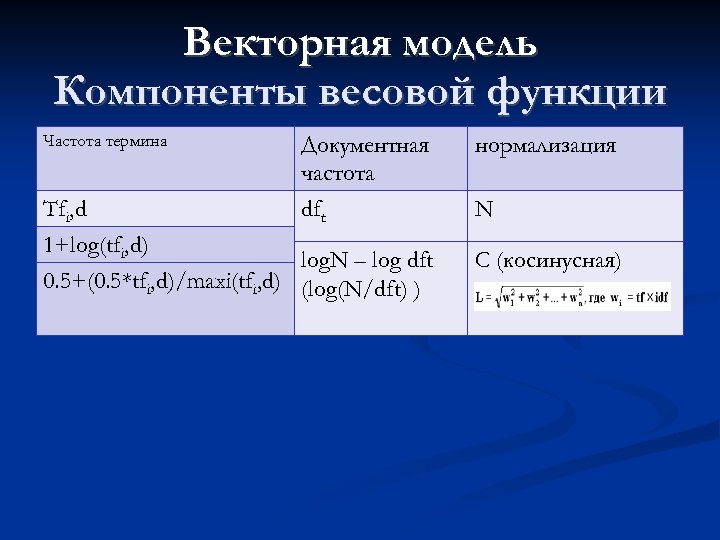

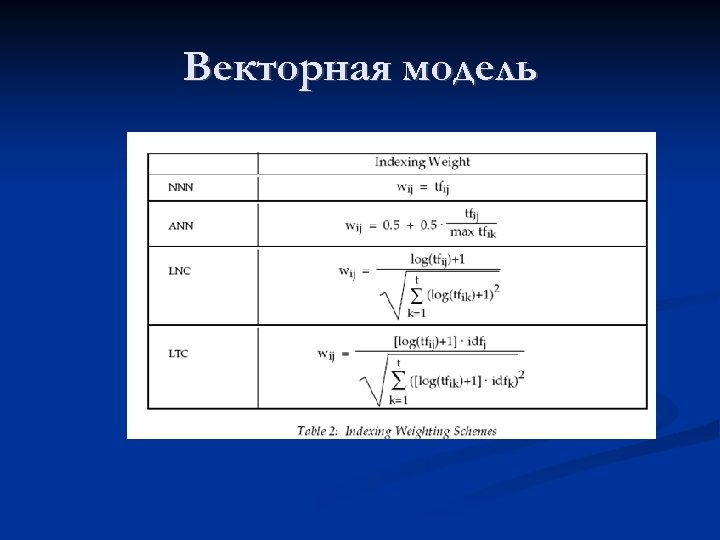

Векторная модель Компоненты весовой функции Частота термина Документная частота Tfi, d dft 1+log(tfi, d) log. N – log dft 0. 5+(0. 5*tfi, d)/maxi(tfi, d) (log(N/dft) ) нормализация N C (косинусная)

Векторная модель

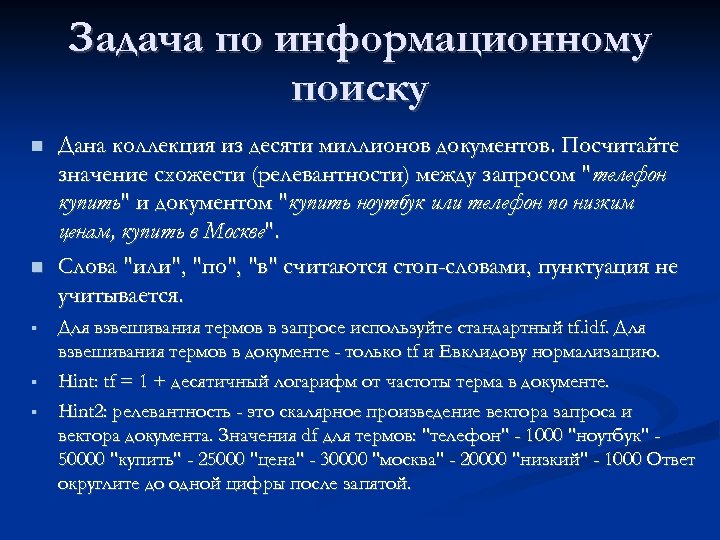

Задача по информационному поиску § § § Дана коллекция из десяти миллионов документов. Посчитайте значение схожести (релевантности) между запросом "телефон купить" и документом "купить ноутбук или телефон по низким ценам, купить в Москве". Слова "или", "по", "в" считаются стоп-словами, пунктуация не учитывается. Для взвешивания термов в запросе используйте стандартный tf. idf. Для взвешивания термов в документе - только tf и Евклидову нормализацию. Hint: tf = 1 + десятичный логарифм от частоты терма в документе. Hint 2: релевантность - это скалярное произведение вектора запроса и вектора документа. Значения df для термов: "телефон" - 1000 "ноутбук" 50000 "купить" - 25000 "цена" - 30000 "москва" - 20000 "низкий" - 1000 Ответ округлите до одной цифры после запятой.

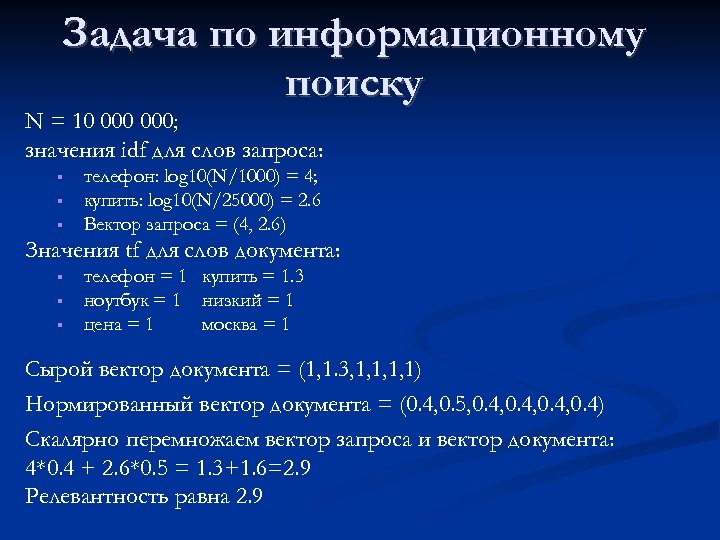

Задача по информационному поиску N = 10 000; значения idf для слов запроса: § § § телефон: log 10(N/1000) = 4; купить: log 10(N/25000) = 2. 6 Вектор запроса = (4, 2. 6) Значения tf для слов документа: § § § телефон = 1 купить = 1. 3 ноутбук = 1 низкий = 1 цена = 1 москва = 1 Сырой вектор документа = (1, 1. 3, 1, 1) Нормированный вектор документа = (0. 4, 0. 5, 0. 4, 0. 4) Скалярно перемножаем вектор запроса и вектор документа: 4*0. 4 + 2. 6*0. 5 = 1. 3+1. 6=2. 9 Релевантность равна 2. 9

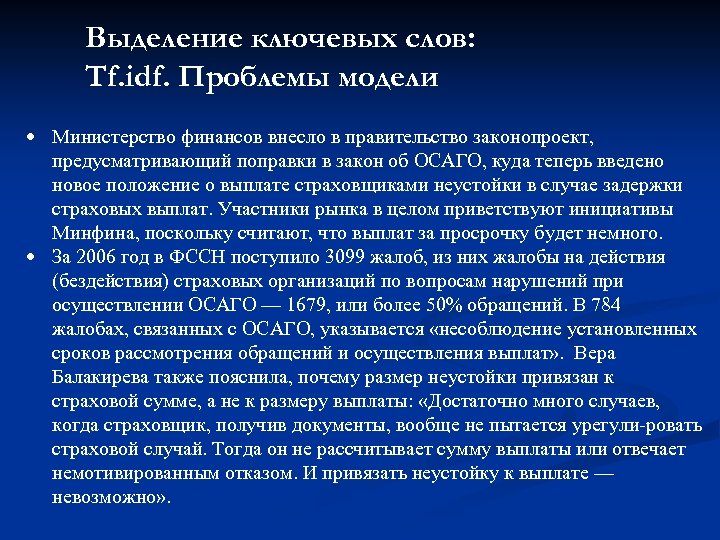

Выделение ключевых слов: Tf. idf. Проблемы модели • Министерство финансов внесло в правительство законопроект, предусматривающий поправки в закон об ОСАГО, куда теперь введено новое положение о выплате страховщиками неустойки в случае задержки страховых выплат. Участники рынка в целом приветствуют инициативы Минфина, поскольку считают, что выплат за просрочку будет немного. • За 2006 год в ФССН поступило 3099 жалоб, из них жалобы на действия (бездействия) страховых организаций по вопросам нарушений при осуществлении ОСАГО — 1679, или более 50% обращений. В 784 жалобах, связанных с ОСАГО, указывается «несоблюдение установленных сроков рассмотрения обращений и осуществления выплат» . Вера Балакирева также пояснила, почему размер неустойки привязан к страховой сумме, а не к размеру выплаты: «Достаточно много случаев, когда страховщик, получив документы, вообще не пытается урегули ровать страховой случай. Тогда он не рассчитывает сумму выплаты или отвечает немотивированным отказом. И привязать неустойку к выплате — невозможно» .

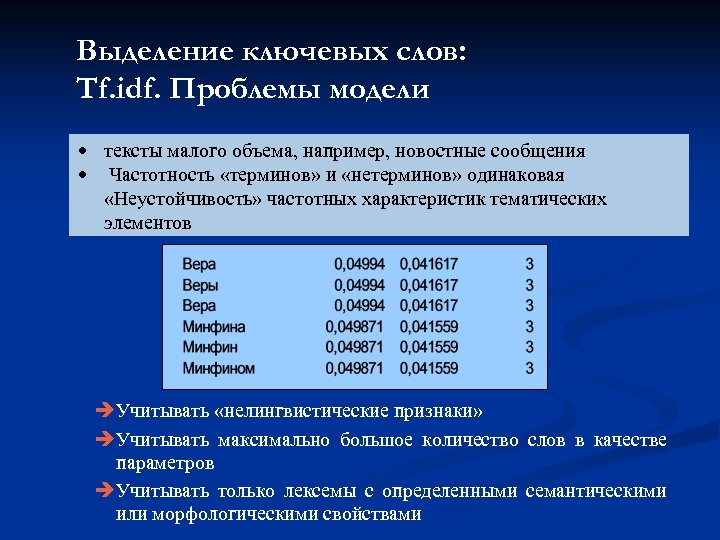

Выделение ключевых слов: Tf. idf. Проблемы модели • тексты малого объема, например, новостные сообщения • Частотность «терминов» и «нетерминов» одинаковая «Неустойчивость» частотных характеристик тематических элементов Учитывать «нелингвистические признаки» Учитывать максимально большое количество слов в качестве параметров Учитывать только лексемы с определенными семантическими или морфологическими свойствами

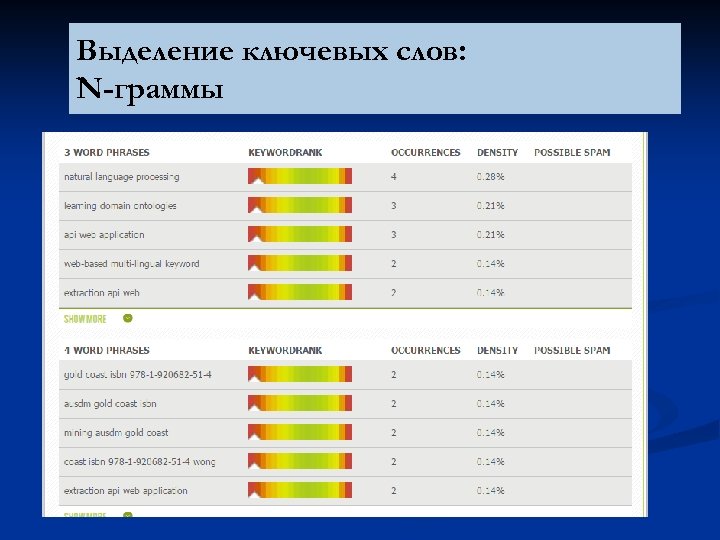

Выделение ключевых слов: N-граммы

Выделение ключевых слов: N-граммы

Выделение ключевых слов: Уменьшение признакового пространства Отсечение редких слов Отсечение высокочастотных слов Стоп-список

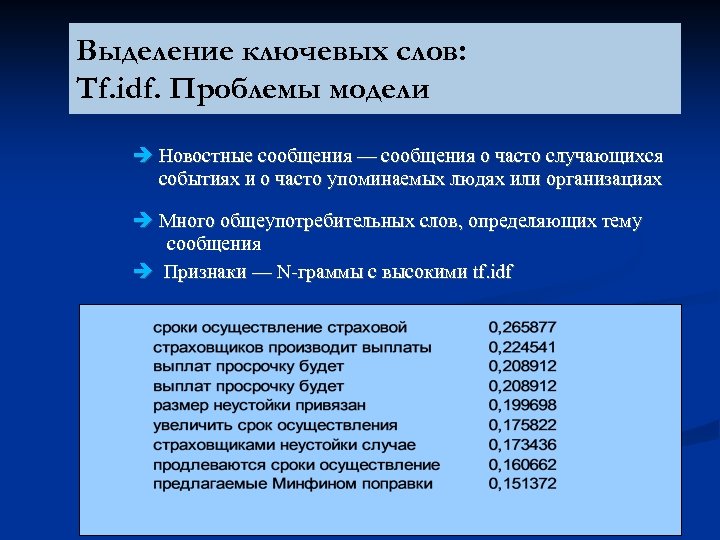

Выделение ключевых слов: Tf. idf. Проблемы модели Новостные сообщения — сообщения о часто случающихся событиях и о часто упоминаемых людях или организациях Много общеупотребительных слов, определяющих тему сообщения Признаки — N граммы с высокими tf. idf

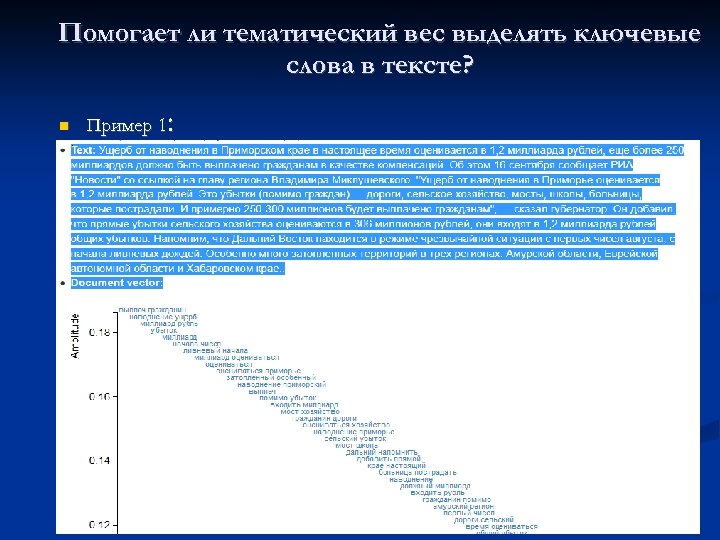

Помогает ли тематический вес выделять ключевые слова в тексте? : Пример 1

Помогает ли тематический вес выделять ключевые слова в тексте? : Пример 1

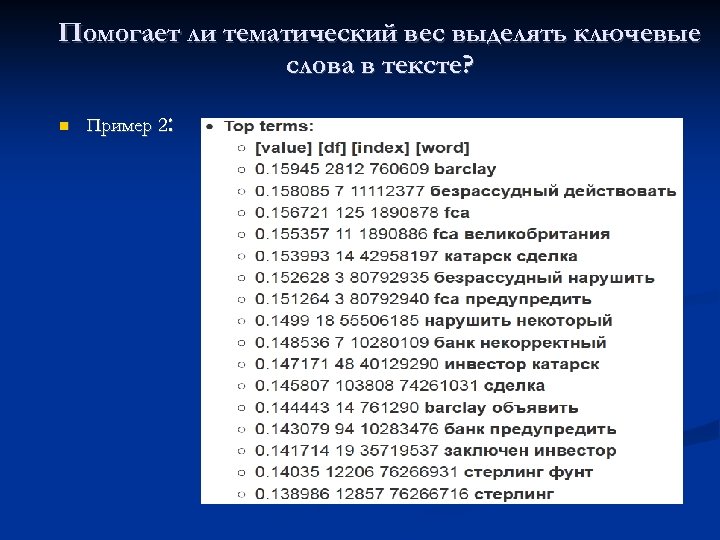

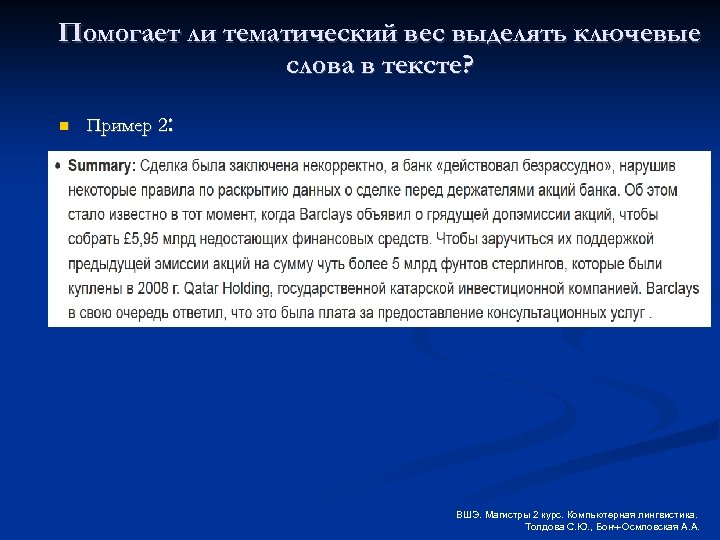

Помогает ли тематический вес выделять ключевые слова в тексте? : Пример 2

Помогает ли тематический вес выделять ключевые слова в тексте? : Пример 2 ВШЭ. Магистры 2 курс. Компьютерная лингвистика. Толдова С. Ю. , Бонч-Осмловская А. А.

Вероятностная модель Слова в тексте – редкие явления распределение Пуассона с некоторыми параметрами Если термин становится темой в некоторой подколлекции документов или в документе, его распределение резко меняется и сильно отличается от теоретического. Задача: определить те тексты, в которых распределение элемента в тексте существенно отклоняется от предстказанного (теоретического) (см. , например, Manning, Christopher D. , and Hinrich Schütze. 1999. Foundations of Statistical Natural) и др. )

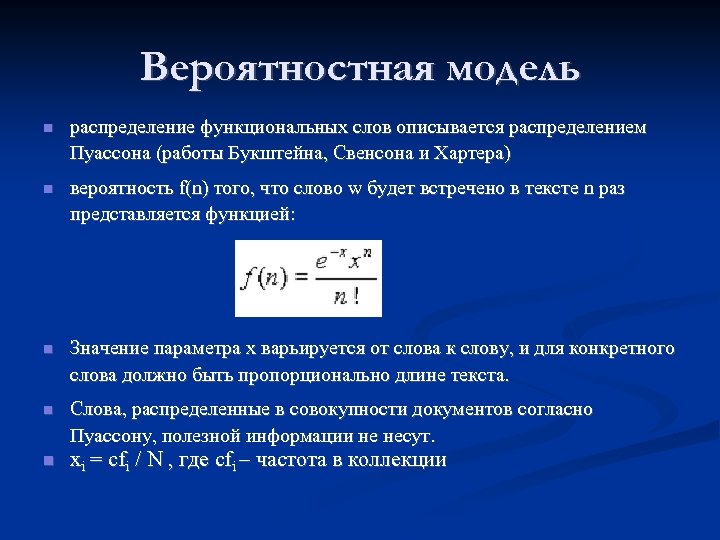

Вероятностная модель распределение функциональных слов описывается распределением Пуассона (работы Букштейна, Свенсона и Хартера) вероятность f(n) того, что слово w будет встречено в тексте n раз представляется функцией: Значение параметра x варьируется от слова к слову, и для конкретного слова должно быть пропорционально длине текста. Слова, распределенные в совокупности документов согласно Пуассону, полезной информации не несут. xi = cfi / N , где cfi – частота в коллекции

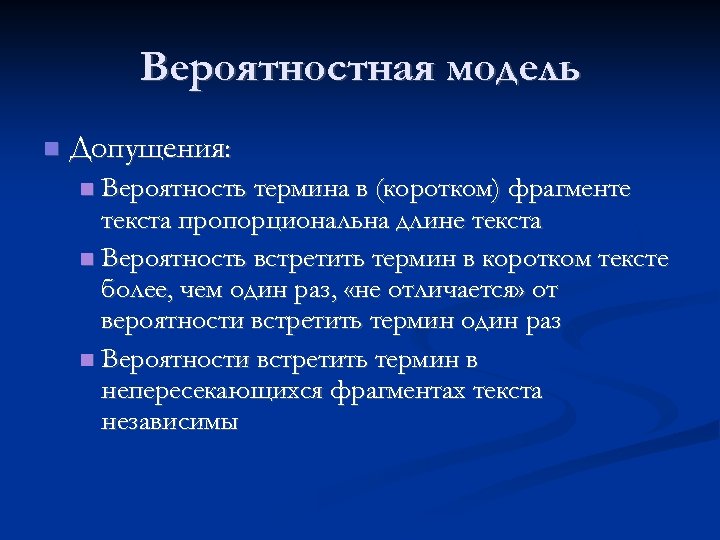

Вероятностная модель Допущения: Вероятность термина в (коротком) фрагменте текста пропорциональна длине текста Вероятность встретить термин в коротком тексте более, чем один раз, «не отличается» от вероятности встретить термин один раз Вероятности встретить термин в непересекающихся фрагментах текста независимы

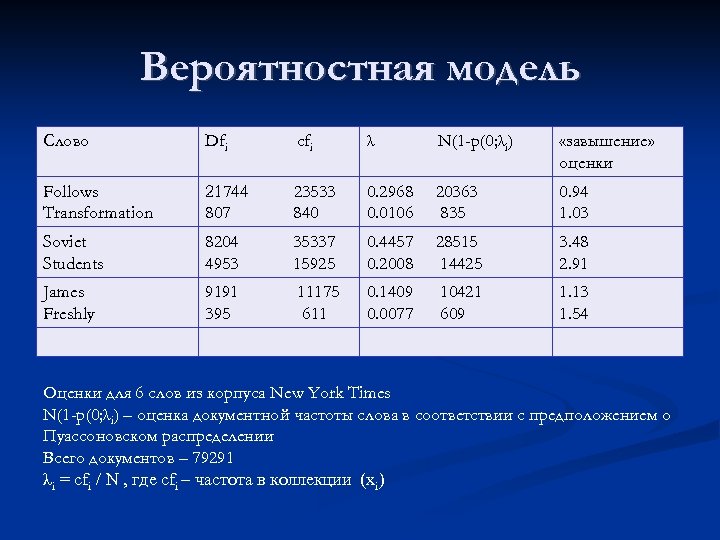

Вероятностная модель Слово Dfi cfi λ N(1 -p(0; λi) «завышение» оценки Follows Transformation 21744 807 23533 840 0. 2968 0. 0106 20363 835 0. 94 1. 03 Soviet Students 8204 4953 35337 15925 0. 4457 0. 2008 28515 14425 3. 48 2. 91 James Freshly 9191 395 11175 611 0. 1409 0. 0077 10421 609 1. 13 1. 54 Оценки для 6 слов из корпуса New York Times N(1 -p(0; λi) – оценка документной частоты слова в соответствии с предположением о Пуассоновском распределении Всего документов – 79291 λi = cfi / N , где cfi – частота в коллекции (xi)

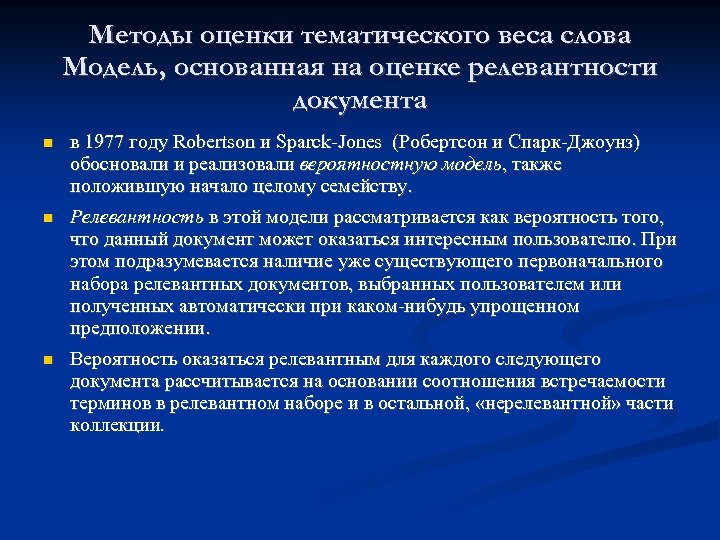

Методы оценки тематического веса слова Модель, основанная на оценке релевантности документа в 1977 году Robertson и Sparck Jones (Робертсон и Спарк Джоунз) обосновали и реализовали вероятностную модель, также положившую начало целому семейству. Релевантность в этой модели рассматривается как вероятность того, что данный документ может оказаться интересным пользователю. При этом подразумевается наличие уже существующего первоначального набора релевантных документов, выбранных пользователем или полученных автоматически при каком нибудь упрощенном предположении. Вероятность оказаться релевантным для каждого следующего документа рассчитывается на основании соотношения встречаемости терминов в релевантном наборе и в остальной, «нерелевантной» части коллекции.

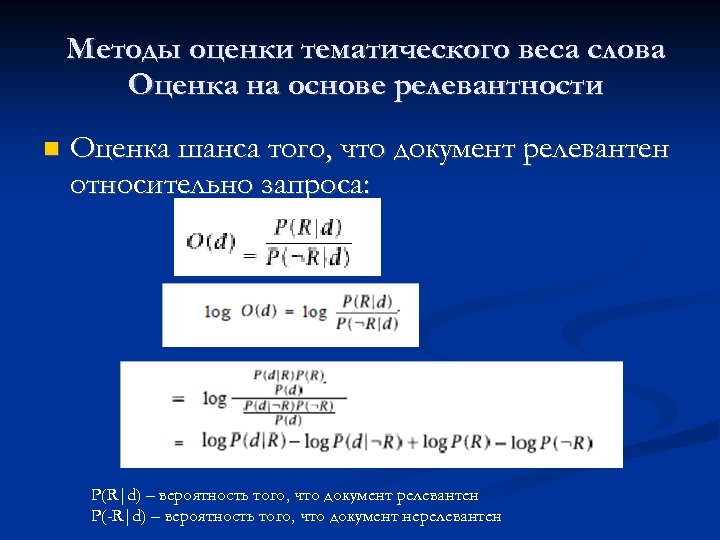

Методы оценки тематического веса слова Оценка на основе релевантности Оценка шанса того, что документ релевантен относительно запроса: P(R|d) – вероятность того, что документ релевантен P(-R|d) – вероятность того, что документ нерелевантен

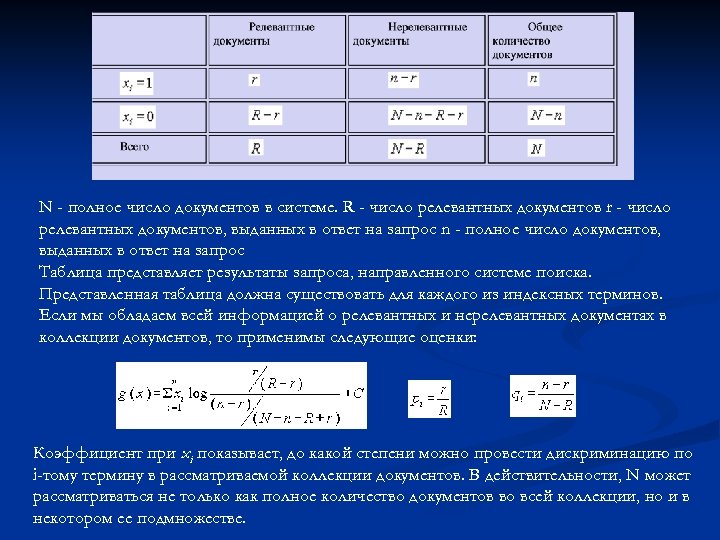

N - полное число документов в системе. R - число релевантных документов r - число релевантных документов, выданных в ответ на запрос n - полное число документов, выданных в ответ на запрос Таблица представляет результаты запроса, направленного системе поиска. Представленная таблица должна существовать для каждого из индексных терминов. Если мы обладаем всей информацией о релевантных и нерелевантных документах в коллекции документов, то применимы следующие оценки: Коэффициент при xi показывает, до какой степени можно провести дискриминацию по i-тому термину в рассматриваемой коллекции документов. В действительности, N может рассматриваться не только как полное количество документов во всей коллекции, но и в некотором ее подмножестве.

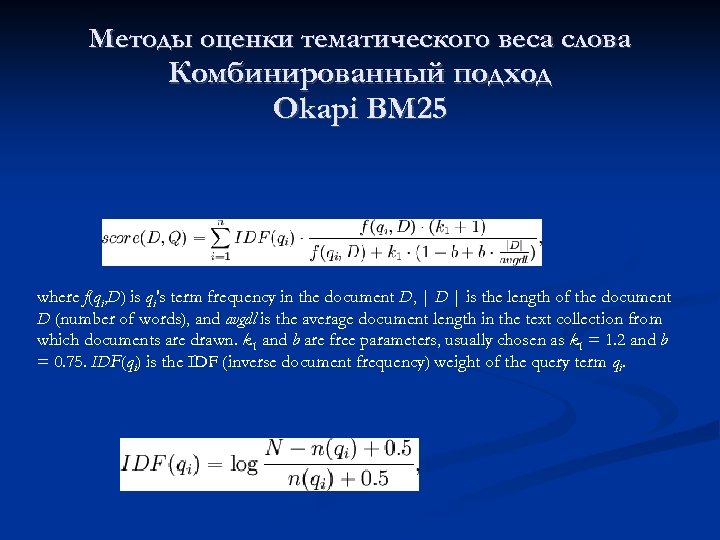

Методы оценки тематического веса слова Комбинированный подход Okapi BM 25 where f(qi, D) is qi's term frequency in the document D, | D | is the length of the document D (number of words), and avgdl is the average document length in the text collection from which documents are drawn. k 1 and b are free parameters, usually chosen as k 1 = 1. 2 and b = 0. 75. IDF(qi) is the IDF (inverse document frequency) weight of the query term qi.

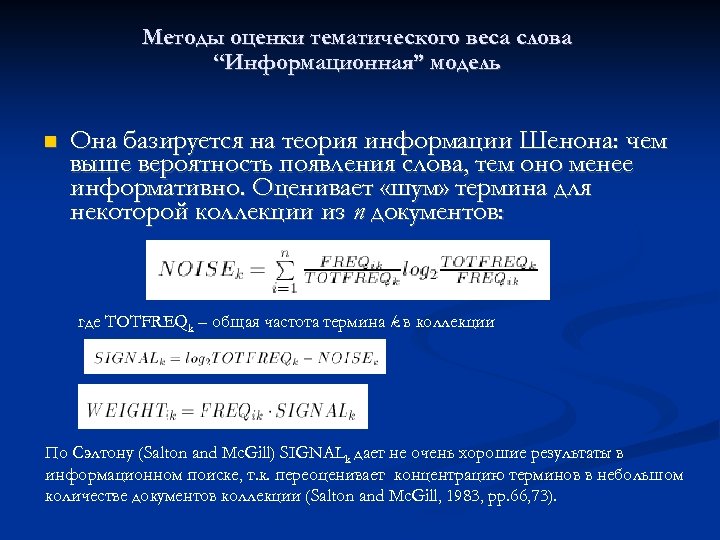

Методы оценки тематического веса слова “Информационная” модель Она базируется на теория информации Шенона: чем выше вероятность появления слова, тем оно менее информативно. Оценивает «шум» термина для некоторой коллекции из n документов: где TOTFREQk – общая частота термина k в коллекции По Сэлтону (Salton and Mc. Gill) SIGNALk дает не очень хорошие результаты в информационном поиске, т. к. переоценивает концентрацию терминов в небольшом количестве документов коллекции (Salton and Mc. Gill, 1983, pp. 66, 73).

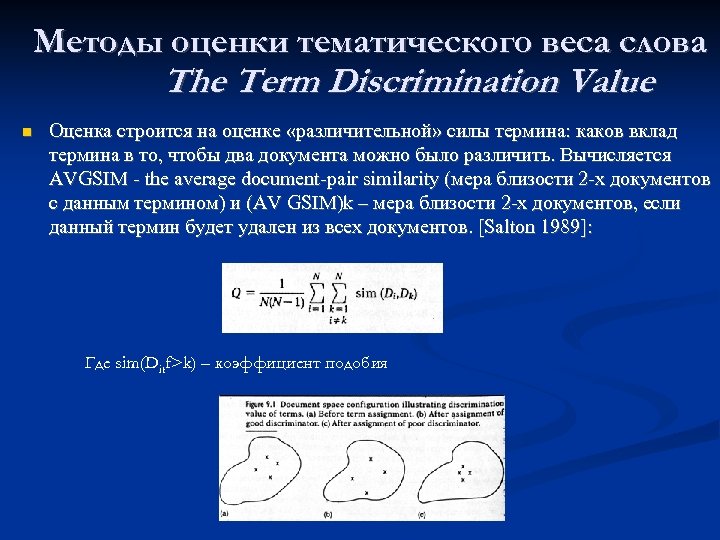

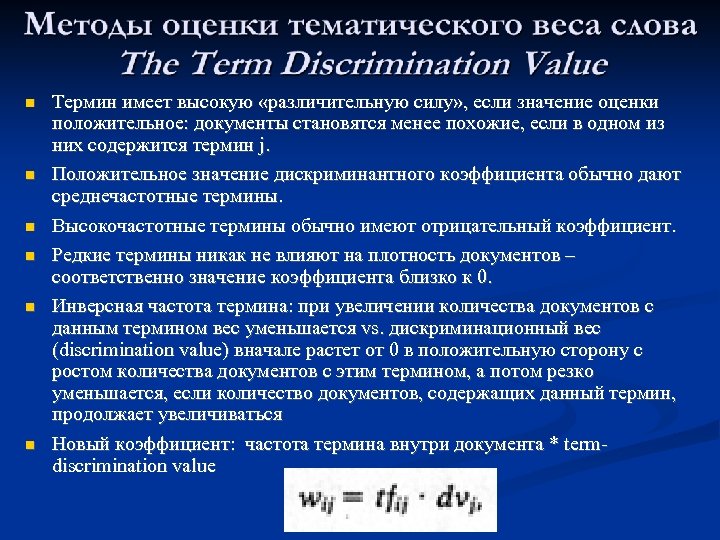

Методы оценки тематического веса слова The Term Discrimination Value Оценка строится на оценке «различительной» силы термина: каков вклад термина в то, чтобы два документа можно было различить. Вычисляется AVGSIM the average document pair similarity (мера близости 2 х документов с данным термином) и (AV GSIM)k – мера близости 2 х документов, если данный термин будет удален из всех документов. [Salton 1989]: Где sim(Ditf>k) – коэффициент подобия

Термин имеет высокую «различительную силу» , если значение оценки положительное: документы становятся менее похожие, если в одном из них содержится термин j. Положительное значение дискриминантного коэффициента обычно дают среднечастотные термины. Высокочастотные термины обычно имеют отрицательный коэффициент. Редкие термины никак не влияют на плотность документов – соответственно значение коэффициента близко к 0. Инверсная частота термина: при увеличении количества документов с данным термином вес уменьшается vs. дискриминационный вес (discrimination value) вначале растет от 0 в положительную сторону с ростом количества документов с этим термином, а потом резко уменьшается, если количество документов, содержащих данный термин, продолжает увеличиваться Новый коэффициент: частота термина внутри документа * term discrimination value

Системы выделения ключевых слов http: //www. seomoz. org/term-extractor http: //www. alchemyapi. com/api/keyword/ http: //www. nactem. ac. uk/software/termine/#f orm http: //labs. translated. net/terminologyextraction/ http: //extractkeyword. com/

Задача Возьмите коллекцию текстов (100 текстов и более) Выберите текст и выделите в нем 10 ключевых слов Вычислите tf. idf для слов (биграм) текста Сравните топ 10 по tf. idf слов с выделенными Вами словами Сравните tf. idf для самых частотных слов коллекции, среднечастотных и слов, встретившихся не более 2 -х раз

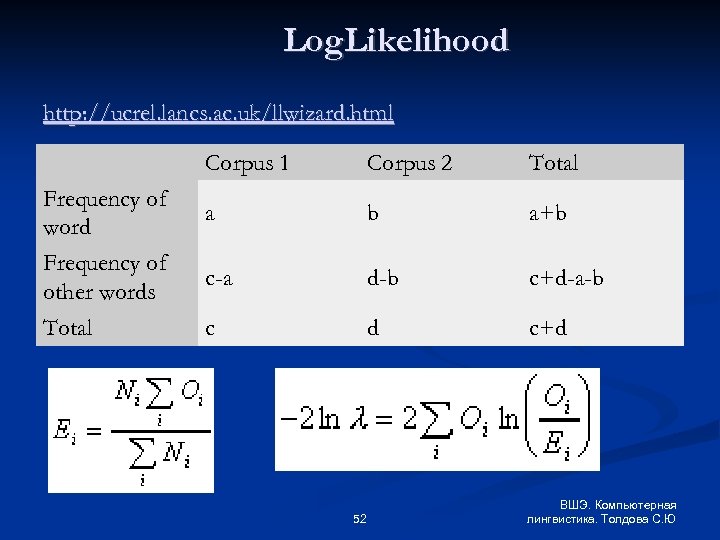

Сравнение двух корпусов Выявление специфической для корпуса лексики Log. Likelihood Задание: Сравнить 4 слова по специфичности (keyness) для корпуса

Литература Christopher D. Manning, Prabhakar Raghavan & Hinrich Schütze. An introduction to Information retrieval

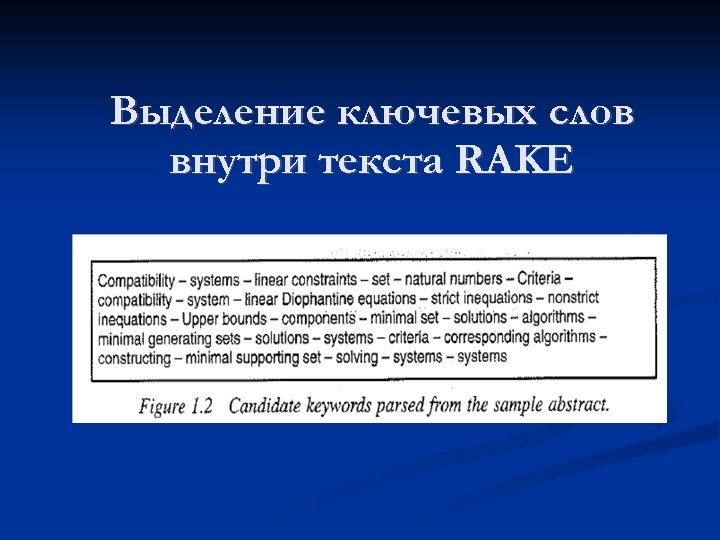

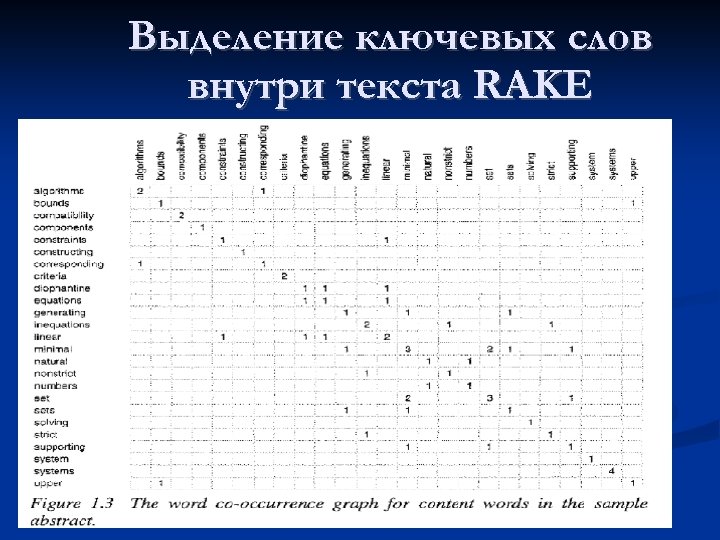

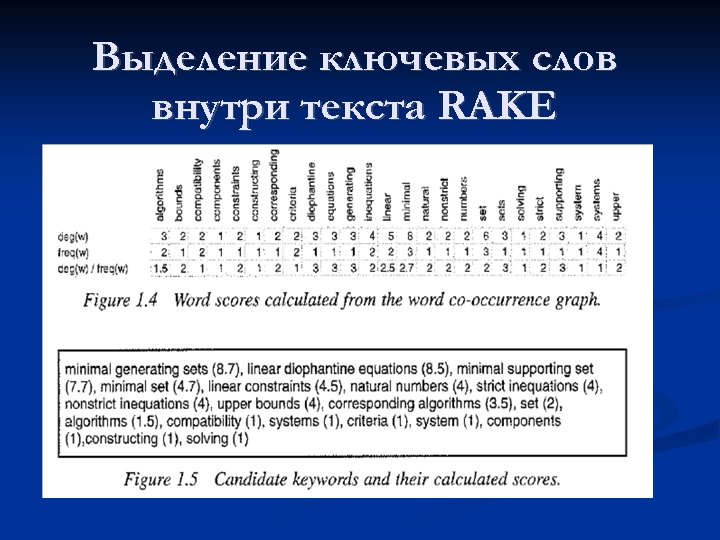

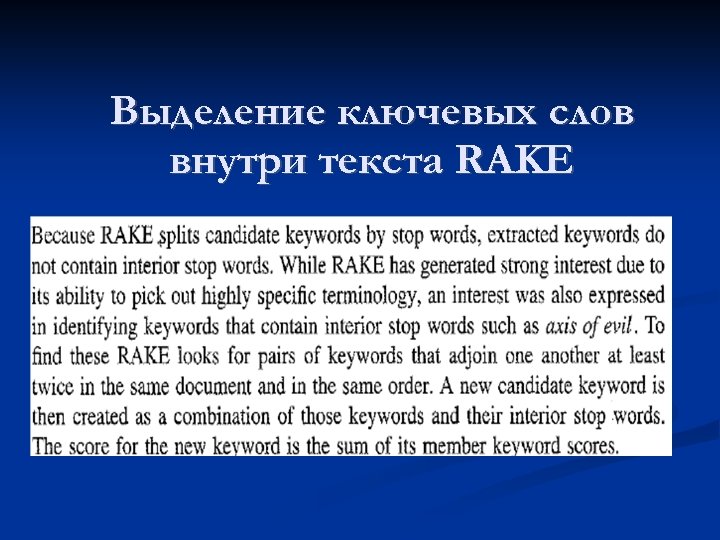

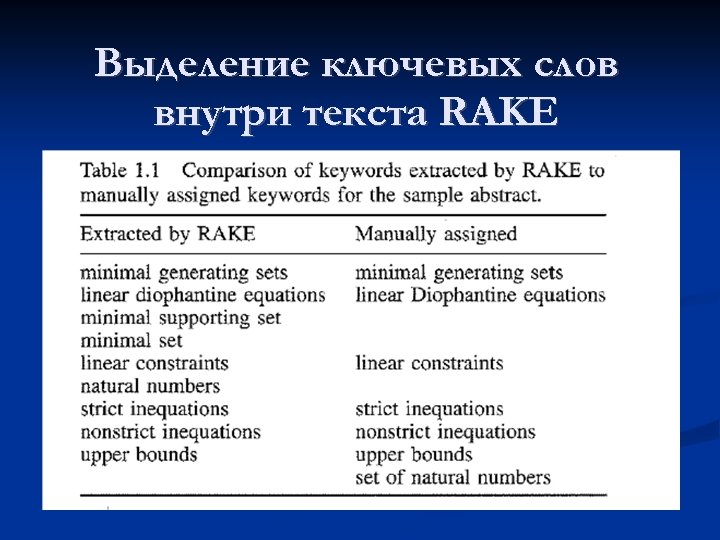

Выделение ключевых слов внутри текста RAKE

Выделение ключевых слов внутри текста RAKE

Выделение ключевых слов внутри текста RAKE

Выделение ключевых слов внутри текста RAKE

Выделение ключевых слов внутри текста RAKE

Выделение ключевых слов внутри текста RAKE

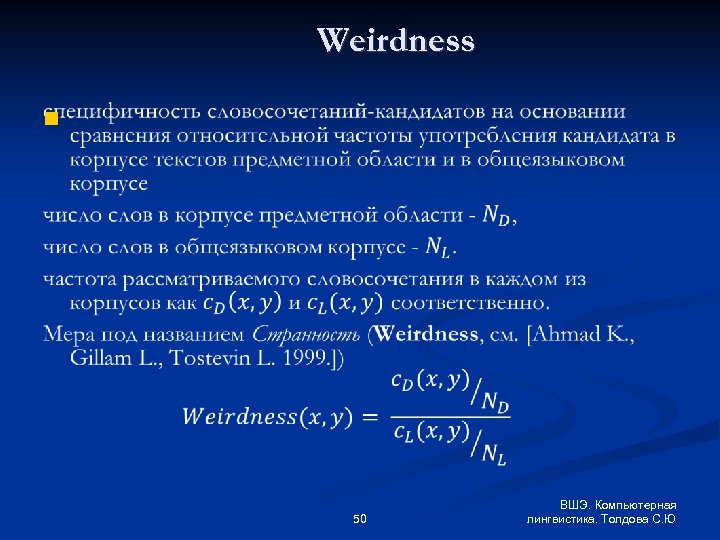

Weirdness 50 ВШЭ. Компьютерная лингвистика. Толдова С. Ю

Weirdness 51 ВШЭ. Компьютерная лингвистика. Толдова С. Ю

Log. Likelihood http: //ucrel. lancs. ac. uk/llwizard. html Corpus 1 Corpus 2 Total Frequency of word a b a+b Frequency of other words c-a d-b c+d-a-b Total c d c+d 52 ВШЭ. Компьютерная лингвистика. Толдова С. Ю

Выделение ключевых слов. Резюме Информационный поиск: булева модель vs. мера «сходства» Задачи: признаки, веса, меры для определения сходства/различия (близости/дальности по признаку/признакам), правила принятия решения Закон Ципфа Выделение «значимых» в языке / подъязыке слов Выделение ключевых слов текста 53 ВШЭ. Компьютерная лингвистика. Толдова С. Ю

Выделение ключевых слов Методы определения тематического веса слова/словосочетания в тексте по отношению к коллекции текстов tf. idf, варианты нормализации tf. idf вероятностная модель (Пуассон) Okapi BM 25 модель: сигнал/шум другие модели Методы выделения ключевых слов в пределах одного текста Алгоритм RAKE (http: //www. airpair. com/nlp/keyword extraction tutorial) 54 ВШЭ. Компьютерная лингвистика. Толдова С. Ю

888afafe8849dc722c7c68082718312f.ppt