562c350a6bdbfa7f02ecc448b45a93b4.ppt

- Количество слайдов: 46

Распределенные вычисления и большие данные (лекция 2) Кореньков Владимир Васильевич директор Лаборатории информационных технологий ОИЯИ зав. кафедрой «Распределенные информационновычислительные системы» Университета Дубна Руководитель лаборатории облачных технологий и аналитики больших данных РЭУ им. Г. В. Плеханова Лекция в РЭУ им. Г. В. Плеханова 18 октября 2016 года

Industry Journey Old World New World Static Dynamic Silo Shared Physical Virtual Manual Automated Application Service

Система Condor Cистема распределенных вычислений на основе пакета Condor, в которой процессорное время и другие ресурсы серверов и рабочих станций, расположенных по всему миру, предоставляются всем участникам в те моменты, когда эти ресурсы локально не используются или используются незначительно. При этом администратор каждого из компьютеров может сформулировать свое собственное понимание «загруженности» . В результате участники этой динамически развивающейся системы приобретают возможность резко ускорить обработку своих заданий без расширения своих локальных ресурсов. В 1994 году пул из трех SUN SPARC-станций ОИЯИ был включен в европейский пул ресурсов с центром администрирования в Амстердаме (Голландия). Этот пул, в свою очередь, был составной частью объединенного пула с центром администрирования в университете штата Висконсин (США). Это был первый в России опыт участия в крупном международном проекте, который продемонстрировал новый архитектурный подход к реализации глобальной системы распределенных вычислений на невыделенных ресурсах.

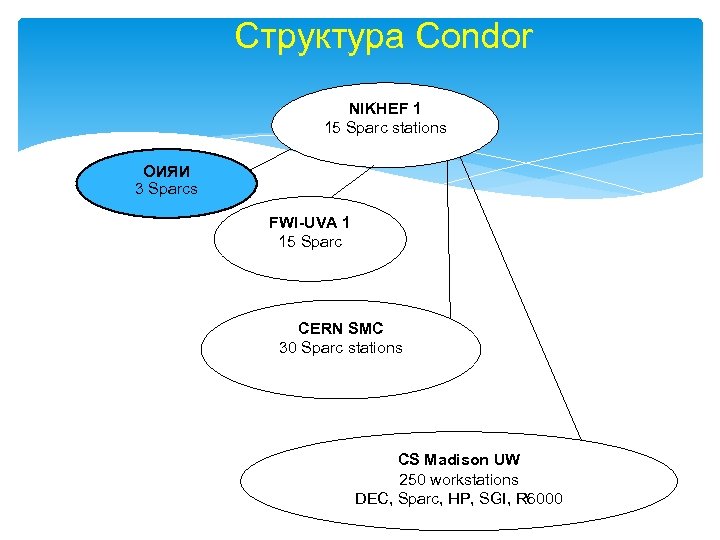

Структура Condor NIKHEF 1 15 Sparc stations ОИЯИ 3 Sparcs FWI-UVA 1 15 Sparc CERN SMC 30 Sparc stations CS Madison UW 250 workstations DEC, Sparc, HP, SGI, R 6000

Система управления пакетной обработкой

Концепция Грид «Грид - это система, которая: · координирует использование ресурсов при отсутствии централизованного управления этими ресурсами · использует стандартные, открытые, универсальные протоколы и интерфейсы. · обеспечивает высококачественное обслуживание» (Ian Foster: "What is the grid? ", 2002 г. ) Модели грид: v v v Distributed Computing High-Throughput Computing On-Demand Computing Data-Intensive Computing Collaborative Computing Междисциплинарный характер грид: развиваемые технологии применяются в физике высоких энергий, космофизике, микробиологии, экологии, метеорологии, различных инженерных и бизнес приложениях. Виртуальные организации (VO)

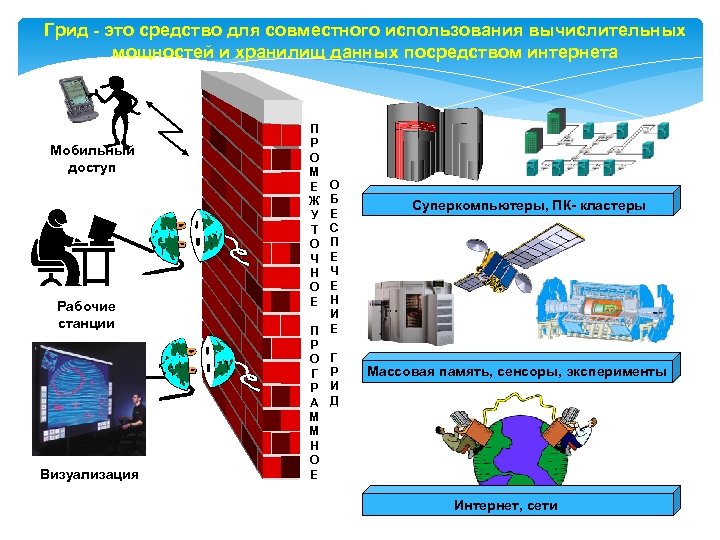

Грид - это средство для совместного использования вычислительных мощностей и хранилищ данных посредством интернета Мобильный доступ Рабочие станции Визуализация П Р О М Е Ж У Т О Ч Н О Е О Б Е С П Е Ч Е Н И П Е Р О Г Г Р Р И А Д М М Н О Е Суперкомпьютеры, ПК- кластеры Массовая память, сенсоры, эксперименты Интернет, сети

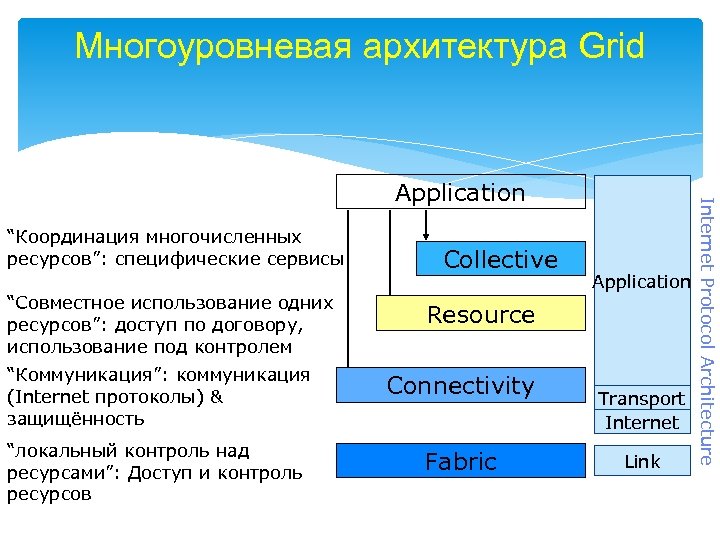

Многоуровневая архитектура Grid “Координация многочисленных ресурсов”: специфические сервисы “Совместное использование одних ресурсов”: доступ по договору, использование под контролем Collective Application Resource “Коммуникация”: коммуникация (Internet протоколы) & защищённость Connectivity “локальный контроль над ресурсами”: Доступ и контроль ресурсов Fabric Transport Internet Link Internet Protocol Architecture Application

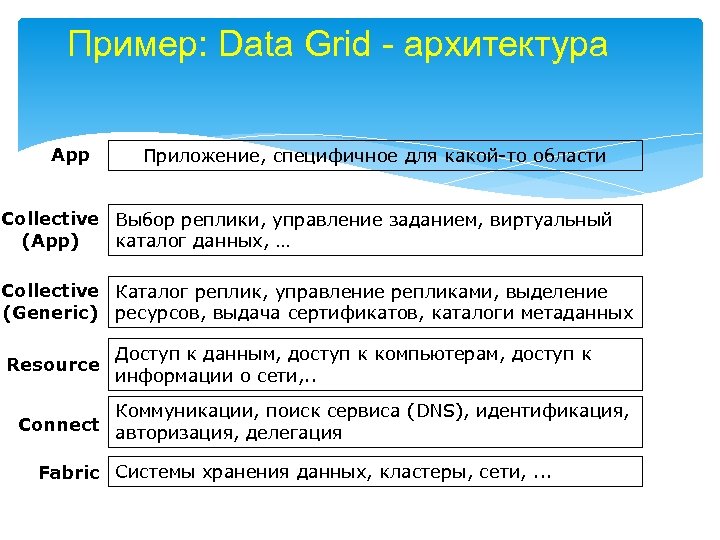

Пример: Data Grid - архитектура App Приложение, специфичное для какой-то области Collective Выбор реплики, управление заданием, виртуальный (App) каталог данных, … Collective Каталог реплик, управление репликами, выделение (Generic) ресурсов, выдача сертификатов, каталоги метаданных Resource Доступ к данным, доступ к компьютерам, доступ к информации о сети, . . Коммуникации, поиск сервиса (DNS), идентификация, Connect авторизация, делегация Fabric Системы хранения данных, кластеры, сети, . . .

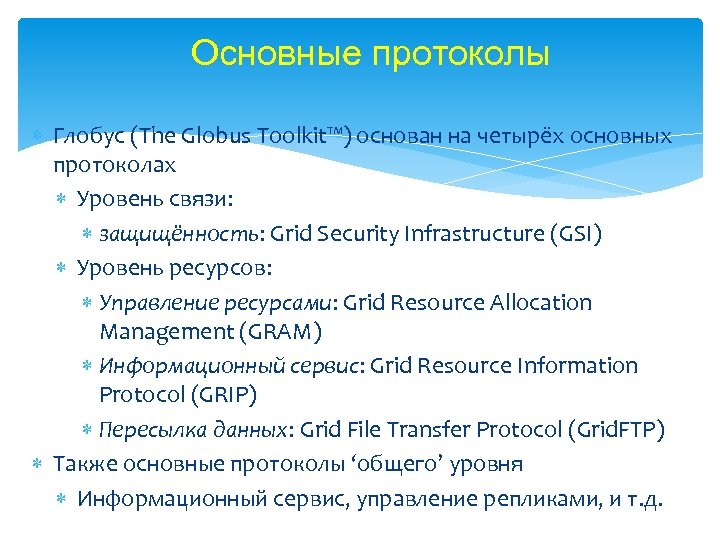

Основные протоколы Глобус (The Globus Toolkit™) основан на четырёх основных протоколах Уровень связи: защищённость: Grid Security Infrastructure (GSI) Уровень ресурсов: Управление ресурсами: Grid Resource Allocation Management (GRAM) Информационный сервис: Grid Resource Information Protocol (GRIP) Пересылка данных: Grid File Transfer Protocol (Grid. FTP) Также основные протоколы ‘общего’ уровня Информационный сервис, управление репликами, и т. д.

Grid Security Infrastructure (GSI) Глобус использует протоколы и APIs GSI для создания защищённости GSI протоколы расширяют стандартные протоколы public key Стандарты: X. 509 & SSL/TLS Расширения: X. 509 Proxy Certificates & Delegation GSI расширяет стандартное GSS-API

Управление ресурсами The Grid Resource Allocation Management (GRAM) протокол и API позволяет запуск программ на удалённых компьютерах, управление этими программами – несмотря на локальные особенности и неоднородность Resource Specification Language (RSL) используется для передачи информации/требований на удалённый ресурс Многоуровневая архитектура позволяет конкретным приложениям специфицировать требования выделения ресурсов в терминах GRAM Используется в Кондоре, PBS, MPICH-G 2, …

Доступ к данным и их пересылка Grid. FTP: расширенная версия популярного FTP протокола для доступа к данным на Grid Надёжный, эффективный, гибкий, параллельный, одновременный, и т. д. : Пересылка данных третьими лицами, пересылка неполных файлов Параллельность, striping (e. g. , на параллельных файловых системах PVFS) Надёжная, возобновляемая пересылка данных

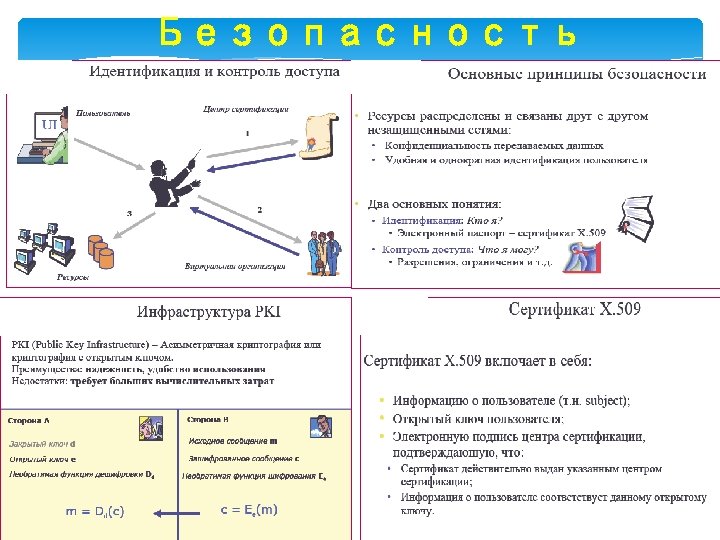

Безопасность

Что такое UI, CE, WN, SE? UI (User Interface) – cервис, обеспечивающий доступ к ресурсам Grid; c UI-компьютера пользователь может запускать или прерывать свои задачи, получать информацию о статусе выполняемых задач, находить ресурсы, необходимые для исполнения конкретной задачи, получать учетную информацию о своей задаче: а также копировать, реплицировать или уничтожать файлы в инфрастуктуре Grid. CE (Computing Element) – очередь в системе пакетной обработки инфраструктуры Grid WN (Working Node) – вычислительный узел кластера в инфраструктуре Grid SE (Storage Element) –cервис, обеспечивающий унифицированный доступ к ресурсам памяти инфраструктуры Grid (ресурсами памяти при этом могут быть как простые дисковые серверы, так и дисковые массивы или системы массовой памяти (MSS)).

Система управления загрузкой (WMS) Запуск задачи пользователя осуществляется через систему управления загрузкой (WMS, Workload Management System) Задачей WMS является планирование и управление ресурсами в распределенной среде Grid. При этом пользователю предоставляются следующие возможности : - запускать и исполнять свои задачи - получать информацию о статусе состояния своей задачи - получать результат выполнения задачи Назначение WMS - как оптимизировать использование ресурсов, так и способствовать скорейшему выполнению задачи пользователя

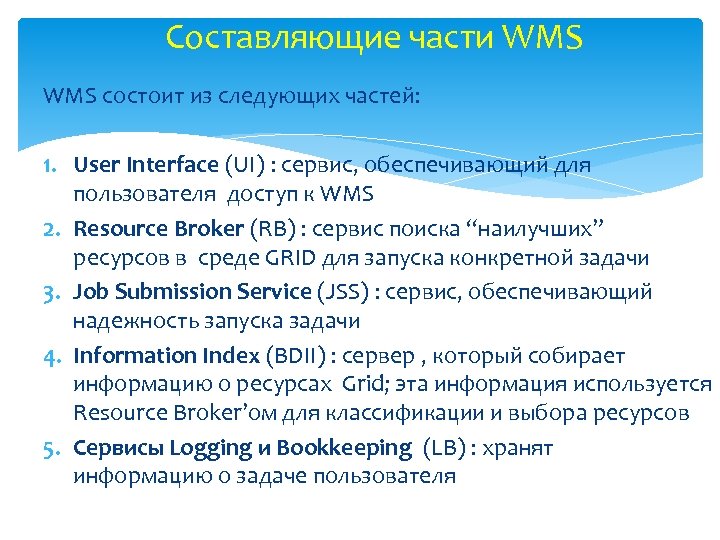

Составляющие части WMS состоит из следующих частей: 1. User Interface (UI) : сервис, обеспечивающий для пользователя доступ к WMS 2. Resource Broker (RB) : сервис поиска “наилучших” ресурсов в среде GRID для запуска конкретной задачи 3. Job Submission Service (JSS) : сервис, обеспечивающий надежность запуска задачи 4. Information Index (BDII) : сервер , который собирает информацию о ресурсах Grid; эта информация используется Resource Broker’ом для классификации и выбора ресурсов 5. Сервисы Logging и Bookkeeping (LB) : хранят информацию о задаче пользователя

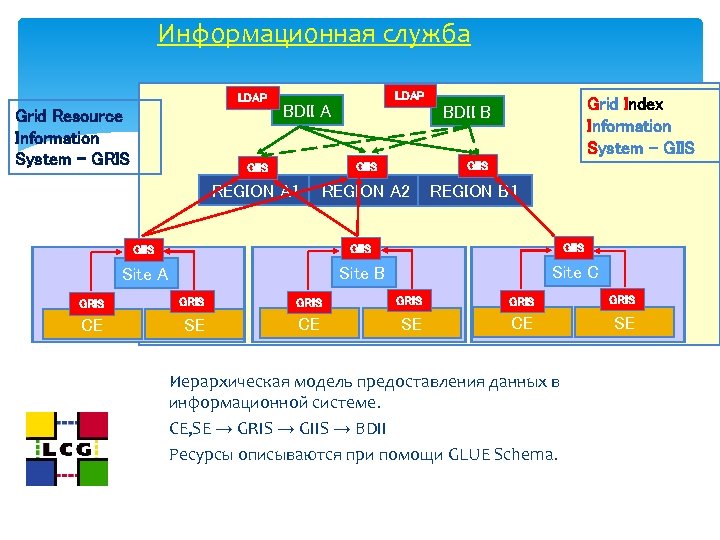

Информационная служба LDAP Grid Resource Information System - GRIS LDAP BDII A Grid Index Information System - GIIS BDII B GIIS REGION A 1 REGION A 2 REGION B 1 GIIS Site A Site B Site C GRIS GRIS CE SE Иерархическая модель предоставления данных в информационной системе. CE, SE → GRIS → GIIS → BDII Ресурсы описываются при помощи GLUE Schema.

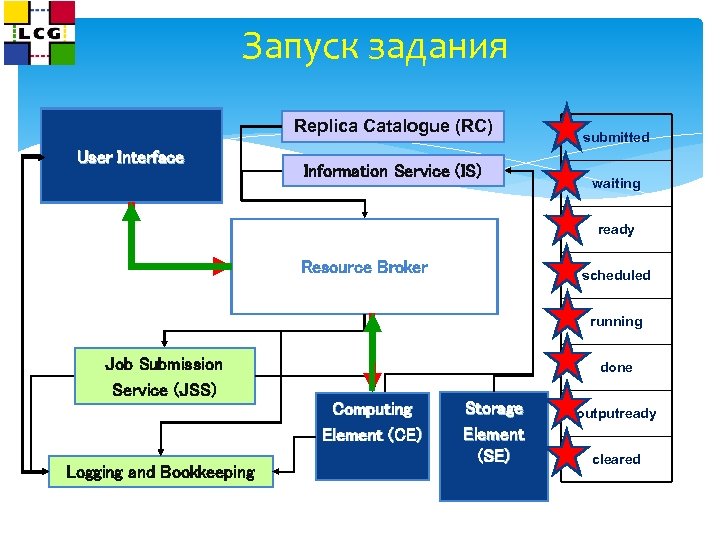

Запуск задания Replica Catalogue (RC) User Interface Information Service (IS) submitted waiting ready Resource Broker scheduled running Job Submission Service (JSS) done Computing Element (CE) Logging and Bookkeeping Storage Element (SE) outputready cleared

Система управления данными осуществляется при помощи Replica Management System (RMS). • Grid Unique IDentifier (GUID) • Logical File Name (LFN) • Storage URL (SURL) • Transport URL (TURL) Ссылаются на файл Нет информации о местоположении Ссылаются на реплики Есть информация о местоположении RMC – Replica Metadata Catalog LRC – Local Replica Catalog

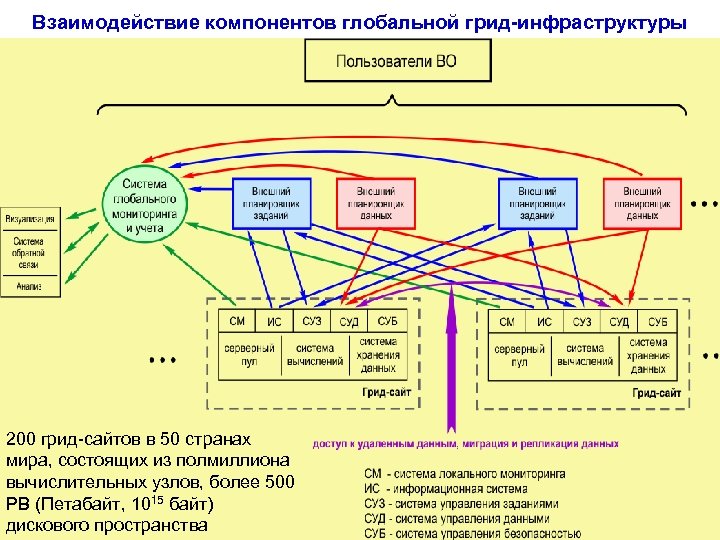

Взаимодействие компонентов глобальной грид-инфраструктуры 200 грид-сайтов в 50 странах мира, состоящих из полмиллиона вычислительных узлов, более 500 PB (Петабайт, 1015 байт) дискового пространства

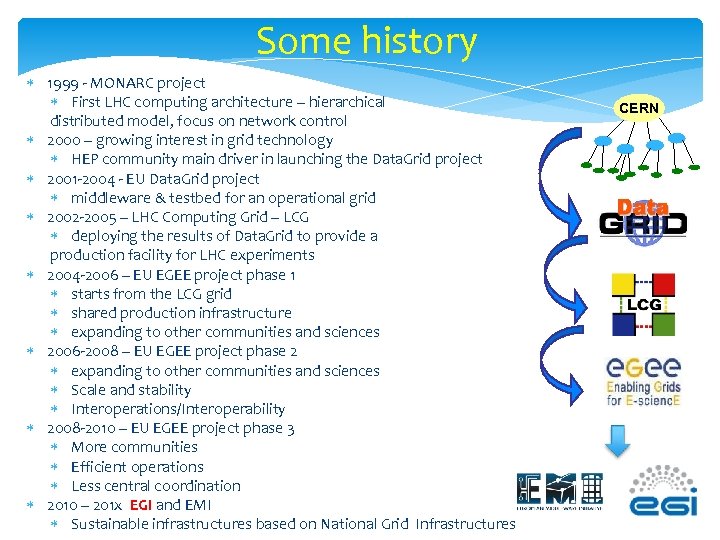

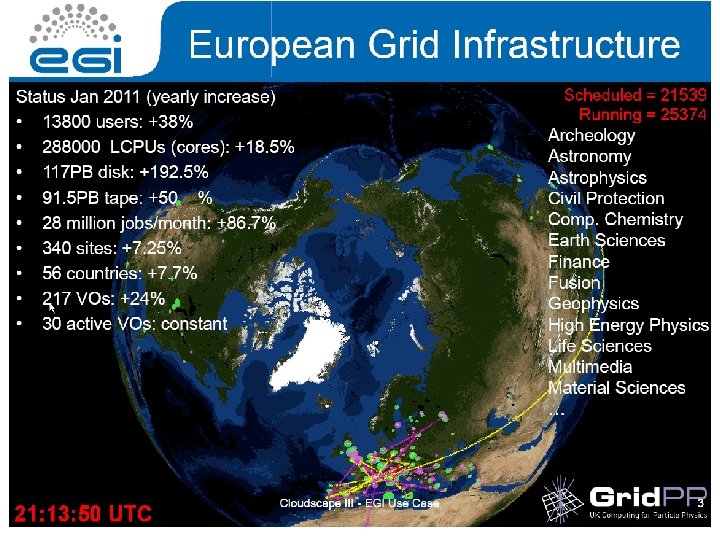

Some history 1999 - MONARC project First LHC computing architecture – hierarchical distributed model, focus on network control 2000 – growing interest in grid technology HEP community main driver in launching the Data. Grid project 2001 -2004 - EU Data. Grid project middleware & testbed for an operational grid 2002 -2005 – LHC Computing Grid – LCG deploying the results of Data. Grid to provide a production facility for LHC experiments 2004 -2006 – EU EGEE project phase 1 starts from the LCG grid shared production infrastructure expanding to other communities and sciences 2006 -2008 – EU EGEE project phase 2 expanding to other communities and sciences Scale and stability Interoperations/Interoperability 2008 -2010 – EU EGEE project phase 3 More communities Efficient operations Less central coordination 2010 – 201 x EGI and EMI Sustainable infrastructures based on National Grid Infrastructures CERN

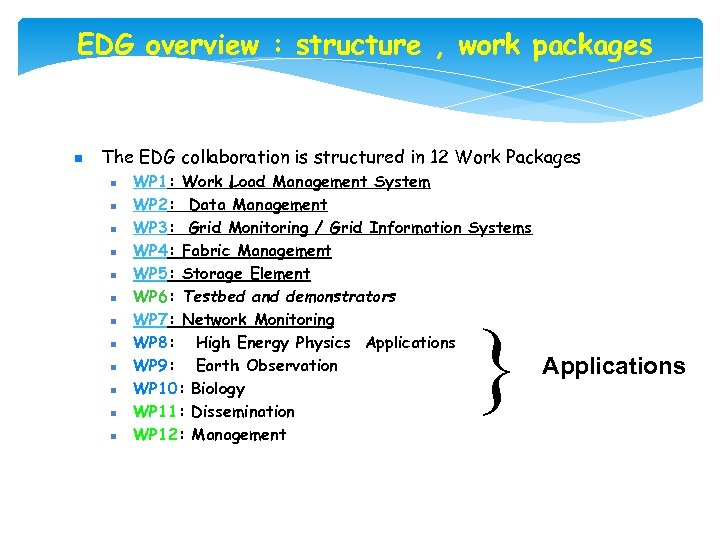

EDG overview : structure , work packages n The EDG collaboration is structured in 12 Work Packages n n n WP 1: Work Load Management System WP 2: Data Management WP 3: Grid Monitoring / Grid Information Systems WP 4: Fabric Management WP 5: Storage Element WP 6: Testbed and demonstrators WP 7: Network Monitoring WP 8: High Energy Physics Applications WP 9: Earth Observation WP 10: Biology WP 11: Dissemination WP 12: Management } Applications

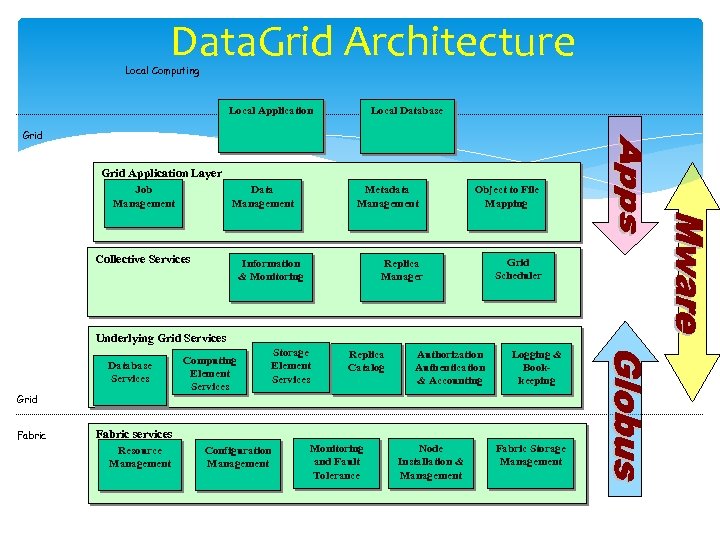

Data. Grid Architecture Local Computing Local Application Local Database Grid Application Layer Job Management Data Management Collective Services Metadata Management Information & Monitoring Object to File Mapping Replica Manager Grid Scheduler Underlying Grid Services Database Services Grid Fabric Computing Element Services Storage Element Services Replica Catalog Authorization Authentication & Accounting Logging & Bookkeeping Fabric services Resource Management Configuration Management Monitoring and Fault Tolerance Node Installation & Management Fabric Storage Management

Участие российских центров в проекте EU Data. GRID Участники: НИИЯФ МГУ, ИТЭФ, ИПМ им. Келдыша, ИФВЭ (Протвино), ОИЯИ (Дубна), ПИЯФ (Гатчина), ТЦ «Наука и общество» Пакеты WP 6, WP 8, WP 10 Основные результаты: Создана информационная служба GRIS-GIIS Создан сертификационный центр (Certification authority, СА) Опыт создания распределенных баз данных (пакет GDMP), совместное использование системы массовой памяти в Дубне Развитие средств Monitoring and Fault Tolerance Создан программный продукт Metadispetcher Участие в сеансах массовой генерации событий для экспериментов CMS, ATLAS; создание пакета DOLLY Главный результат - получение опыта работы с новейшим программным обеспечением GRID, включение российского сегмента в европейскую инфраструктуру EU Data. GRID

EGEE (Enabling Grids for E-scienc. E) Цель проекта EGEE - создание Грид инфраструктуры по всей Европе, доступной 24 часа в сутки. Ключевые направления проекта: - формирование согласованной, устойчивой и защищённой вычислительной сети; - совершенствование программных средств middleware с целью обеспечения надежного обслуживания пользователей; - привлечение новых пользователей из других сфер деятельности и обеспечение им высокого стандарта обучения и поддержки.

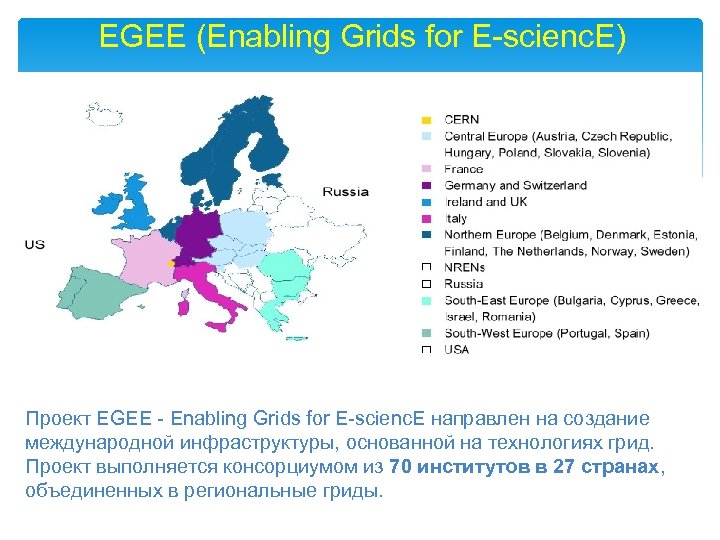

EGEE (Enabling Grids for E-scienc. E) Проект EGEE - Enabling Grids for E-scienc. E направлен на создание международной инфраструктуры, основанной на технологиях грид. Проект выполняется консорциумом из 70 институтов в 27 странах, объединенных в региональные гриды.

g. Lite http: //www. glite. org

Основные подсистемы g. Lite Вычислительный элемент (Computing Element – CE) – это служба, представляющая ресурсный узел грид и выполняющая на нем функции управления заданиями (запуск, удаление и т. д. ). Обращения к CE могут исходить либо от интерфейса пользователя, либо от Менеджера загрузки (Workload Manager –WM), который распределяет задания по множеству CE. В g. Lite функциональность CE расширена по сравнению с аналогичной службой LCG-2. Если в LCG-2 CE может работать только в соответствие с Push моделью (WM самостоятельно принимает решение о посылке задания на CE), то в g. Lite возможен режим работы CE также и в Pull модели, когда CE запрашивает задание у WM. Помимо функций управления заданиями CE также вырабатывает информацию о состоянии ресурсов. В Push модели ее публикует информационная служба, и она используется WM для выбора CE, на котором будет запускаться задание. В Pull модели информация встраивается в посылаемое WM сообщение "CE доступен".

Основные подсистемы g. Lite Подсистема управления данными (Data Management Subsystem - DM) включает три службы, поддерживающие доступ к файлам: элемент памяти (Storage Element – SE), службы каталога (Catalog Services – CS) и диспетчер данных (Data Scheduling –DS). Все службы работают с данными на файловом уровне, в противоположность, например, системам баз данных, которые оперируют такими элементами как записи и поля. В распределенной среде грид пользовательские файлы могут храниться во множестве экземпляров – реплик, размещенных в разных местах, и задача CS и DS состоит в том, чтобы сделать процесс управления репликами прозрачным для пользователя, так чтобы приложения получали доступ к файлам по их именам или дескрипторам метаданных. Доступ к данным файлов реально происходит через SE, но DM поддерживает также концепцию виртуальных наборов данных. Это открывает новые интересные возможности, основанные на абстракции глобальной файловой системы: при навигации по файлам клиентское приложение может быть устроено как командная оболочка Unix, используя команды смены директорий, просмотра файлов и т. п. Защита файлов обеспечивается в DM списками контроля доступа ACL (Access Control Lists).

Основные подсистемы g. Lite Подсистема учета (Accounting Subsystem - DGAS) аккумулирует информацию об использовании ресурсов грид отдельными пользователями, группами пользователей и виртуальными организациями. Собранная информация позволяет построить общую картину деятельности в грид, на основе которой может формироваться политика распределения ресурсов и взиматься плата за их использование. Подсистема протоколирования (Logging and Bookkeeping - LB) отслеживает выполняющиеся в разных точных грид шаги обработки задания, фиксируя происходящие с ним события (запуск, распределение на подходящий CE, начало выполнения и т. д. ) и запоминая их. Информация о событиях (протокол) поставляется компонентами WM и CE, для чего в эти компоненты встраиваются обращения к LB. Протоколы собираются в два приема. Вначале события передаются в локальную службу (Locallogger) и записываются в файл на диске. Locallogger отвечает за передачу протокола одному из серверов хранения (Bookkeeper), который "укрупняет" события, давая общую картину изменения состояний задания (Submitted, Running, Done…). Помимо того, Bookkeeper сохраняет различные атрибуты задания: его описание (JDL); CE, на котором оно выполнялось; коды завершения и т. д. Как протокол состояний, так и протокол событий можно получить либо с помощью специального интерфейса WM, либо через уведомления при определенных изменениях состояния, например, при окончании задания.

Основные подсистемы g. Lite Подсистема информационного обслуживания и мониторинга грид (Relational Grid Monitoring Architecture - R-GMA) решает задачу сбора и управления данными о состоянии грид, получая информацию от множества распределенных источников – поставщиков. В ее основе лежит разработанная одной из групп Global Grid Forum (GGF-PERF) схема "Потребитель-Поставщик", описывающая способ взаимодействия этих компонентов. Поскольку схема достаточно общая, она применима как для хранения данных о грид (какие ресурсы и службы доступны, каковы их характеристики), так и для мониторинга приложений. R-GMA представляет собой реляционную реализацию этого общего подхода. При наличии множества распределенных поставщиков с точки зрения информационных запросов R-GMA действует как одна большая реляционная база данных.

Основные подсистемы g. Lite Подсистема управления загрузкой (Workload Management System - WMS) состоит из ряда компонентов, ответственных за распределение заданий между ресурсами грид, а также обеспечивающих управление заданиями. Центральной компонентой является Менеджер загрузки (WM), который получает от своих клиентов запросы по управлению заданиями. В частности, обрабатывая запрос типа "запуск" WM определяет подходящий для выполнения CE, принимая во внимание требования и предпочтения, указанные в описании задания. Система безопасности рассматривается как средство защиты Web-служб и будет реализовываться в виде дополнительных модулей, размещаемых в контейнерах (Apache Axis, Tomcat). Разработаны предложения по архитектуре безопасности: https: //edms. cern. ch/document/487004/ и сформулированы основные цели: модульность, расширяемость, соответствие развивающимся стандартам Web-служб (WS-Security).

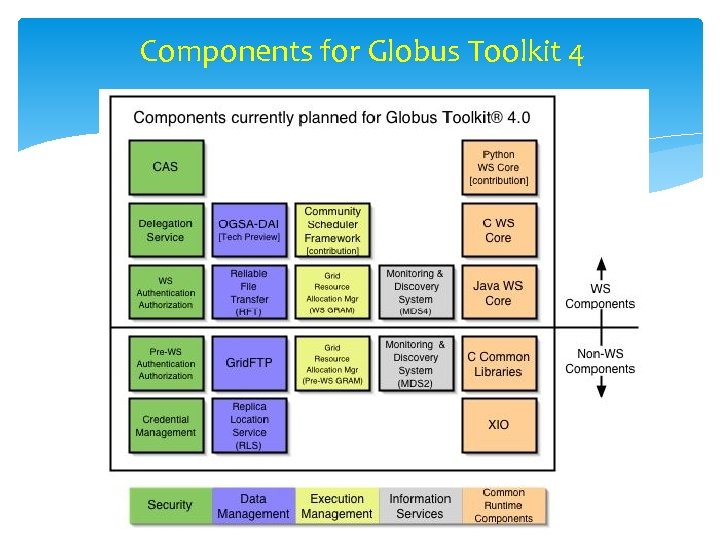

Components for Globus Toolkit 4

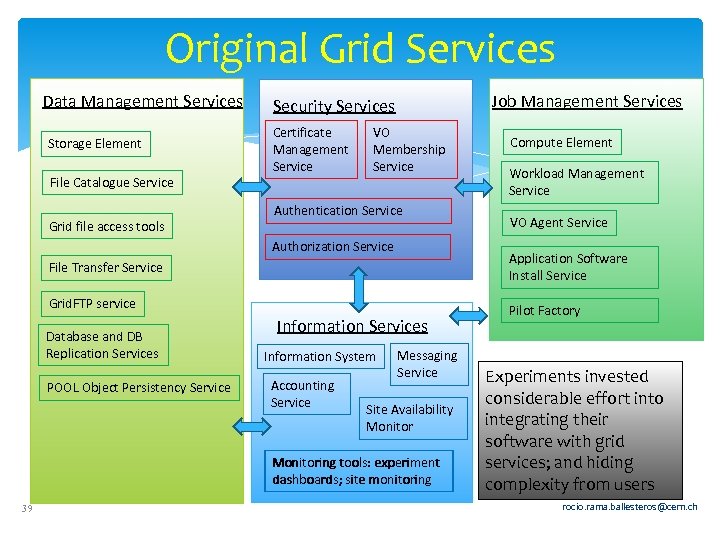

Original Grid Services Data Management Services Storage Element File Catalogue Service Grid file access tools Job Management Services Security Services Certificate Management Service VO Membership Service Authentication Service Authorization Service Grid. FTP service POOL Object Persistency Service Information Services Information System Accounting Service Messaging Service Site Availability Monitoring tools: experiment dashboards; site monitoring 39 Workload Management Service VO Agent Service Application Software Install Service File Transfer Service Database and DB Replication Services Compute Element Pilot Factory Experiments invested considerable effort into integrating their software with grid services; and hiding complexity from users rocio. rama. ballesteros@cern. ch

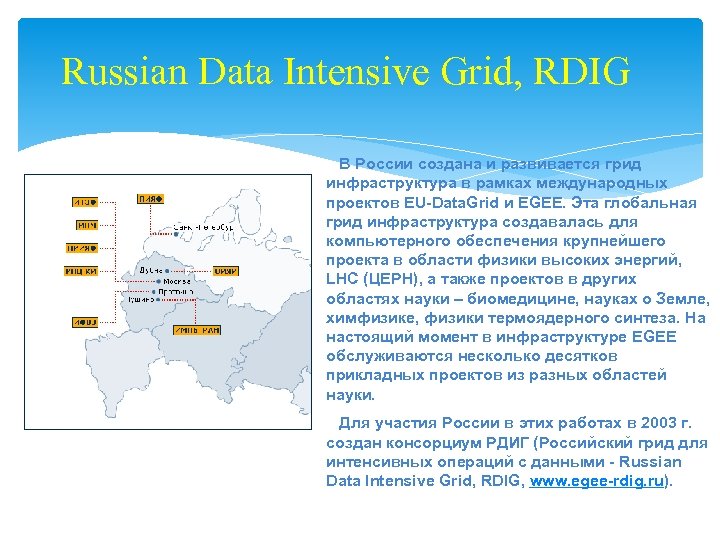

Russian Data Intensive Grid, RDIG В России создана и развивается грид инфраструктура в рамках международных проектов EU-Data. Grid и EGEE. Эта глобальная грид инфраструктура создавалась для компьютерного обеспечения крупнейшего проекта в области физики высоких энергий, LHC (ЦЕРН), а также проектов в других областях науки – биомедицине, науках о Земле, химфизике, физики термоядерного синтеза. На настоящий момент в инфраструктуре EGEE обслуживаются несколько десятков прикладных проектов из разных областей науки. Для участия России в этих работах в 2003 г. создан консорциум РДИГ (Российский грид для интенсивных операций с данными - Russian Data Intensive Grid, RDIG, www. egee-rdig. ru).

Russian Data Intensive GRID (RDIG) Consortium EGEE Federation ИФВЭ (Институт физики высоких энергий, Протвино) ИМПБ (Институт математических проблем биологии, Пущино). ИТЭФ (Институт теоретической и экспериментальной физики) ОИЯИ (Объединенный институт ядерных исследований, Дубна). ИПМ (Институт прикладной математики) ПИЯФ (Петербургский институт ядерной физики, Гатчина) РНЦ «Курчатовский институт» НИИЯФ МГУ (Научно-исследовательский институт ядерной физики МГУ)

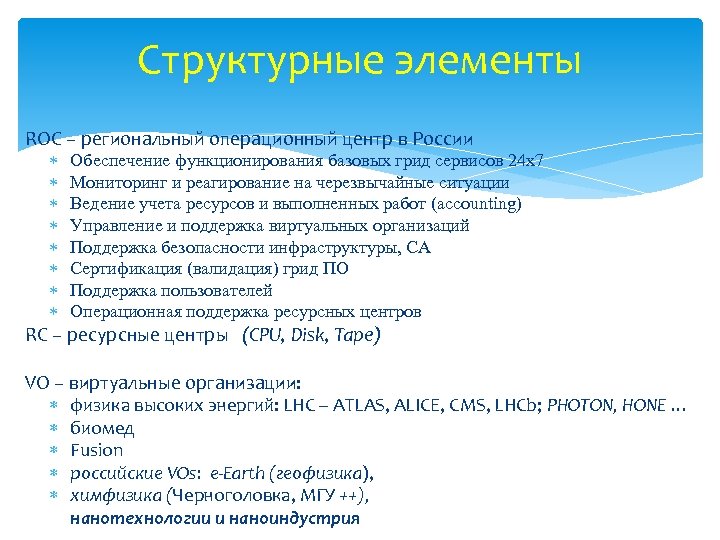

Структурные элементы ROC – региональный операционный центр в России Обеспечение функционирования базовых грид сервисов 24 х7 Мониторинг и реагирование на черезвычайные ситуации Ведение учета ресурсов и выполненных работ (accounting) Управление и поддержка виртуальных организаций Поддержка безопасности инфраструктуры, CA Сертификация (валидация) грид ПО Поддержка пользователей Операционная поддержка ресурсных центров RC – ресурсные центры (CPU, Disk, Tape) VO – виртуальные организации: физика высоких энергий: LHC – ATLAS, ALICE, CMS, LHCb; PHOTON, HONE … биомед Fusion российские VOs: e-Earth (геофизика), химфизика (Черноголовка, МГУ ++), нанотехнологии и наноиндустрия

Портал www. egee-rdig. ru

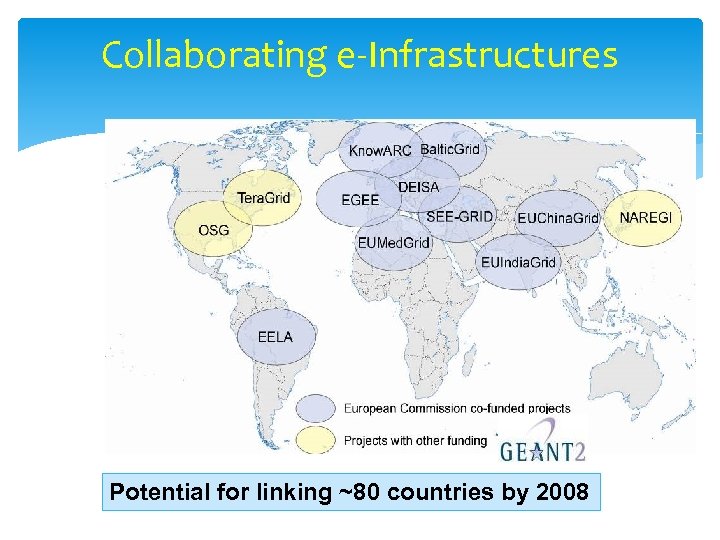

Collaborating e-Infrastructures Potential for linking ~80 countries by 2008

T. Strizh

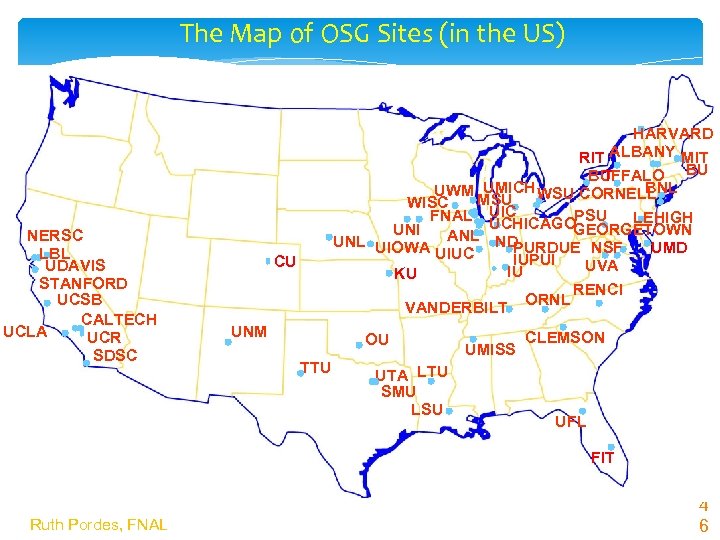

The Map of OSG Sites (in the US) NERSC LBL UDAVIS STANFORD UCSB CALTECH UCLA UCR SDSC HARVARD RIT ALBANY MIT BUFFALO BU T UMICH WSU CORNELL BNL UWM MSU WISC PSU FNAL UIC LEHIGH UCHICAGOGEORGETOWN UNI UNL UIOWA ANL ND PURDUE NSF UMD UIUC IUPUI UVA IU KU CU VANDERBILT UNM OU TTU UTA LTU SMU LSU UMISS ORNL RENCI CLEMSON UFL FIT Ruth Pordes, FNAL 4 6

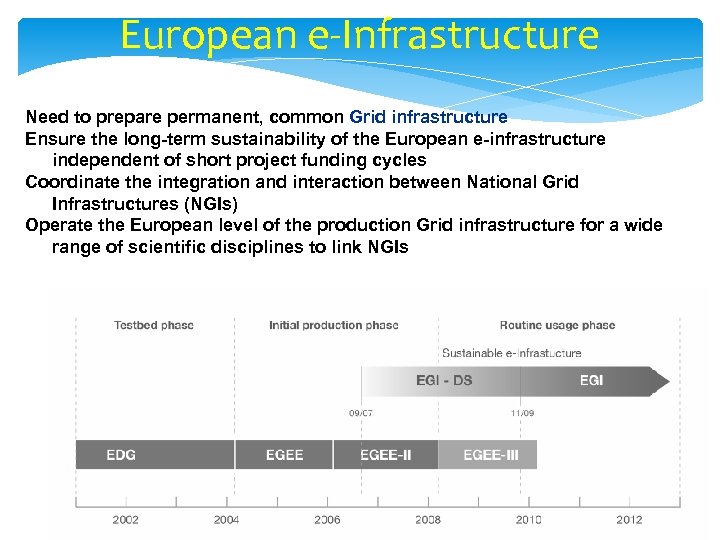

European e-Infrastructure Need to prepare permanent, common Grid infrastructure Ensure the long-term sustainability of the European e-infrastructure independent of short project funding cycles Coordinate the integration and interaction between National Grid Infrastructures (NGIs) Operate the European level of the production Grid infrastructure for a wide range of scientific disciplines to link NGIs 47 47

EGI-In. SPIRE The EGI-In. SPIRE project (Integrated Sustainable Pan. European Infrastructure for Researchers in Europe) started on 1 May 2010, co-funded by the European Commission (contract number: RI-261323) for four years, as a collaborative effort involving more than 50 institutions in over 40 countries. Its mission is to establish a sustainable European Grid Infrastructure (EGI). EGI-In. SPIRE is ideally placed to join together the new Distributed Computing Infrastructures (DCIs) such as clouds, supercomputing networks and desktop grids, for the benefit of user communities within the European Research Area. 48

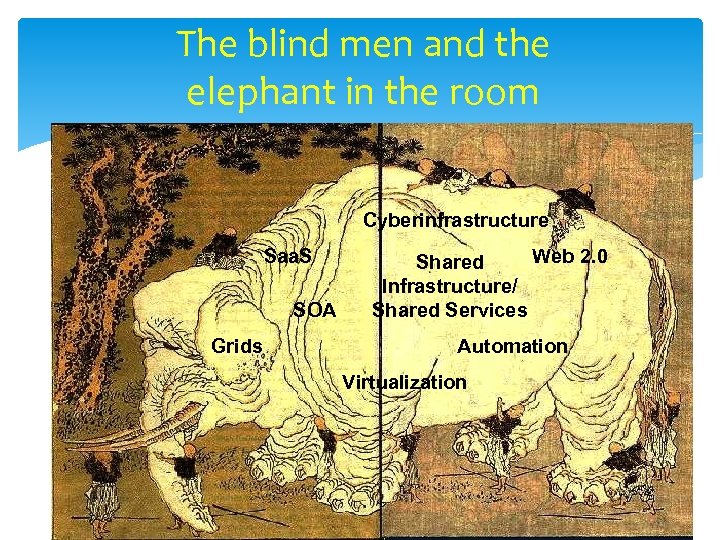

The blind men and the elephant in the room Cyberinfrastructure Saa. S SOA Grids Web 2. 0 Shared Infrastructure/ Shared Services Automation Virtualization

562c350a6bdbfa7f02ecc448b45a93b4.ppt