6. Принципы работы поисковиков.pptx

- Количество слайдов: 14

* Принципы работы поиска и SEO

* Способы «попадания» на сайт: * ввести URL страницы вашего сайта в адресную строку браузера; * перейти по ссылке. В зависимости от способа источники трафика делятся на: * * type-in; * ссылающиеся ресурсы. навигационные сервисы — поисковые системы и каталоги;

* Способы для поиска нужной страницы: * * * Оглавление – интернет-каталоги, ссылки - гипертекстовые ссылки, предметный указатель - индекс. Этапы составления индекса в Интернете: * сбор адресов страниц (задаётся каталог, все ссылки с каждой из заданных страниц в него добавляются) * * выкачивание страниц поисковым роботом индексирование

* Конверсия в чистый текст – очистка от всех нетекстовых элементов — графики, разметки (тегов) языка HTML и др. Выборка слов - все слова выбираются из текста и располагаются по алфавиту. Лингвистическая обработка - приведение слов к их начальным грамматическим формам, или основам согласно машинной морфологии. Составление индекса - своеобразного словаря, в котором основы упорядочены по алфавиту, а при каждой основе записано, с какой страницы она взята (номер страницы) и на каком месте на этой странице данная основа стояла (номер вхождения).

Инвертированный или инверсный индекс представляет собой вывернутую "наизнанку" копию всех страниц Интернета. Если в обычном тексте мы идем от страни цы к словам, то в индексе поисковая машина идет от слов к страницам. Для показа цитат хранить еще и второй индекс, так называемый прямой – тексты всех веб-страниц, очищенные от всех нетекстовых элементов, сжатые и упакованные, является текстовой копией всего Интернета *

* Это решается разработчиками каждой поисковой машины по-своему. Не индексируются: * * Разделители (знаки препинания, пробелы) * Графический текст. Стоп-слова (раньше это были предлоги, союзы, чис ла. . ) Машинная морфология. Google записывает в индекс все словоформы отдельно, а при обработке запроса применяет так называемое расширение запроса: слова запроса превращаются в веер словоформ и все словоформы ищутся в индексе.

* * Согласно домену * поисковик старается не погружаться слиш ком глубоко по ссылкам внутрь сайта. * большие базы данных с единственным способом доступа к их содержимому в виде окна поиска не индексируются Сначала HTML Плохо индексируются тексты, которые выводятся на экран пользователя динамически разными программными средствами наподо бие сценариев на языке Java. Script.

Из ста человек, просматривающих первую страницу с результатами поиска: * на вторую переходят чуть меньше половины, * дальше третьей зайдут всего лишь пятеро. *

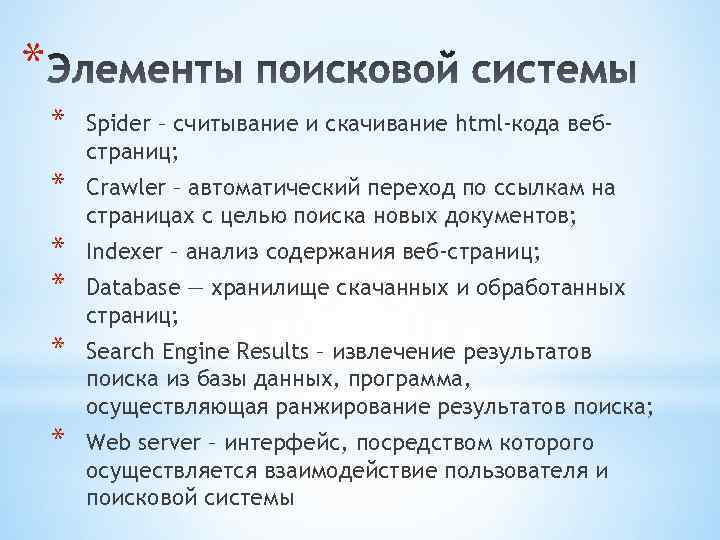

* * Spider – считывание и скачивание html-кода вебстраниц; * Crawler – автоматический переход по ссылкам на страницах с целью поиска новых документов; * * Indexer – анализ содержания веб-страниц; * Search Engine Results – извлечение результатов поиска из базы данных, программа, осуществляющая ранжирование результатов поиска; * Web server – интерфейс, посредством которого осуществляется взаимодействие пользователя и поисковой системы Database — хранилище скачанных и обработанных страниц;

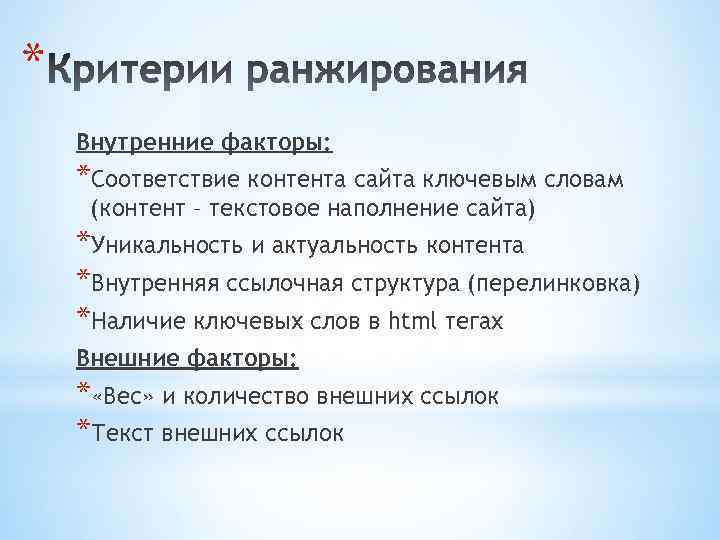

* Внутренние факторы: *Соответствие контента сайта ключевым словам (контент – текстовое наполнение сайта) *Уникальность и актуальность контента *Внутренняя ссылочная структура (перелинковка) *Наличие ключевых слов в html тегах Внешние факторы: * «Вес» и количество внешних ссылок *Текст внешних ссылок

Распределение кликов в выдаче результатов Яндексом № строки сверху % кликов 1 10, 62 2 10, 28 3 6, 62 4 3, 86 5 4, 38 6 4, 31 7 4, 43 8 2, 79 9 2, 67 10 2, 82 Всего: 52, 78 *

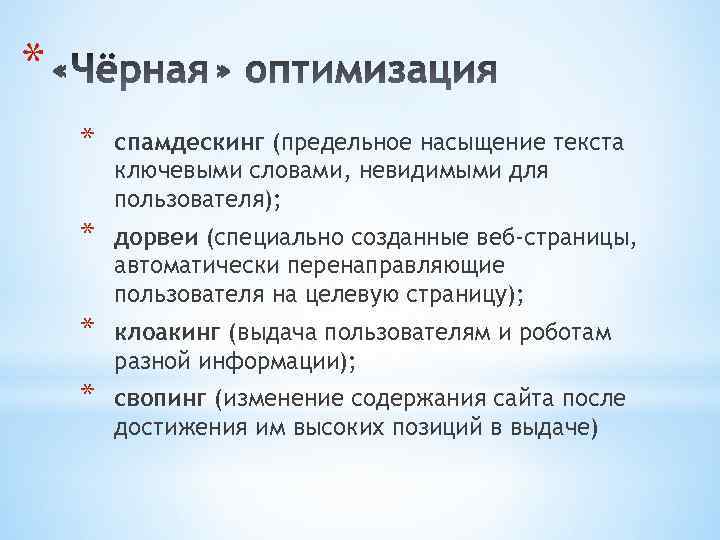

* * спамдескинг (предельное насыщение текста ключевыми словами, невидимыми для пользователя); * дорвеи (специально созданные веб-страницы, автоматически перенаправляющие пользователя на целевую страницу); * клоакинг (выдача пользователям и роботам разной информации); * свопинг (изменение содержания сайта после достижения им высоких позиций в выдаче)

* * использование большого количества ключевых слов * чрезмерное использование html-тегов. Перенасыщение страницы ключевыми фразами повышает так называемую «тошноту» страницы и, как правило, снижает ее информационную ценность для пользователя. Противодействие: алгоритмы поисковых систем меняются

* 1. Разработка семантического ядра (подбор ключевых слов) 2. Разработка карты (структуры) сайта. 3. Оптимизация html-кода сайта. 4. Технический аудит сайта. 5. Оптимизация текстов сайта. 6. Составление файла robots. txt 7. Увеличение количества внешних ссылок

6. Принципы работы поисковиков.pptx