Пример.ppt

- Количество слайдов: 30

Пример: Классификация семей по анализируемой структуре расходов По данным, представленным в таблице провести классификацию n=5 семей по двум показателям: х1 - уровень расходов (млн. руб. ) за летние месяцы на культурные нужды, спорт и отдых х2 – уровень расходов (млн. руб. ) за летние месяцы на питание. n n Классификацию провести по иерархическому агломеративному алгоритму с использованием обычного евклидова расстояния, а также принципов: “ближнего соседа”, “дальнего соседа”, центра тяжести и средней связи. Сравнить полученные результаты и обосновать выбор окончательного варианта классификации.

Пример: Классификация семей по анализируемой структуре расходов По данным, представленным в таблице провести классификацию n=5 семей по двум показателям: х1 - уровень расходов (млн. руб. ) за летние месяцы на культурные нужды, спорт и отдых х2 – уровень расходов (млн. руб. ) за летние месяцы на питание. n n Классификацию провести по иерархическому агломеративному алгоритму с использованием обычного евклидова расстояния, а также принципов: “ближнего соседа”, “дальнего соседа”, центра тяжести и средней связи. Сравнить полученные результаты и обосновать выбор окончательного варианта классификации.

Пример № семьи (i) 1 2 3 4 5 хi 1 2 4 8 12 13 xi 2 10 7 6 11 9

Пример № семьи (i) 1 2 3 4 5 хi 1 2 4 8 12 13 xi 2 10 7 6 11 9

Предварительный анализ На основании предварительного качественного анализа было выдвинуто предположение, что по потребительскому поведению три первые семьи принадлежат одной типологической группе, а две последние (4 и 5) - другой, что согласуется с расположением пяти наблюдений на плоскости n Исходные данные для классификации

Предварительный анализ На основании предварительного качественного анализа было выдвинуто предположение, что по потребительскому поведению три первые семьи принадлежат одной типологической группе, а две последние (4 и 5) - другой, что согласуется с расположением пяти наблюдений на плоскости n Исходные данные для классификации

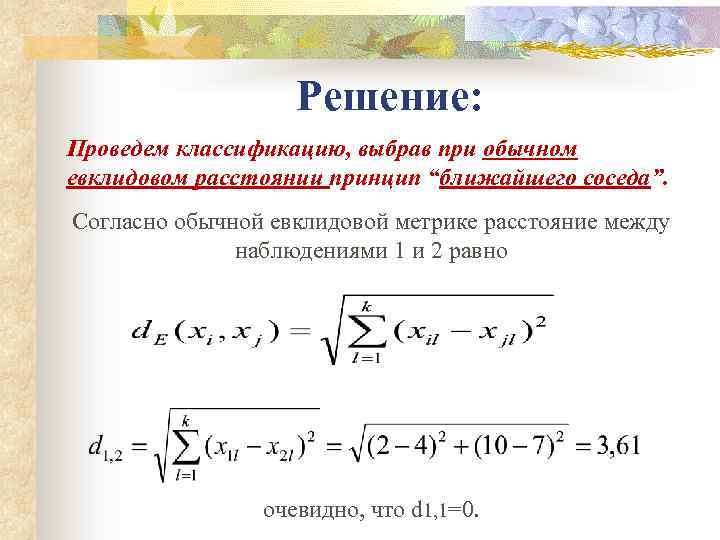

Решение: Проведем классификацию, выбрав при обычном евклидовом расстоянии принцип “ближайшего соседа”. Согласно обычной евклидовой метрике расстояние между наблюдениями 1 и 2 равно очевидно, что d 1, 1=0.

Решение: Проведем классификацию, выбрав при обычном евклидовом расстоянии принцип “ближайшего соседа”. Согласно обычной евклидовой метрике расстояние между наблюдениями 1 и 2 равно очевидно, что d 1, 1=0.

Матрица расстояний n Имеет вид

Матрица расстояний n Имеет вид

Принцип «ближнего соседа» Из матрицы расстояний следует, что объекты 4 и 5 наиболее близки d 4, 5=2, 24 и поэтому объединим их в один кластер. После объединения объектов имеем четыре кластера: S 1, S 2, S 3, S(4, 5).

Принцип «ближнего соседа» Из матрицы расстояний следует, что объекты 4 и 5 наиболее близки d 4, 5=2, 24 и поэтому объединим их в один кластер. После объединения объектов имеем четыре кластера: S 1, S 2, S 3, S(4, 5).

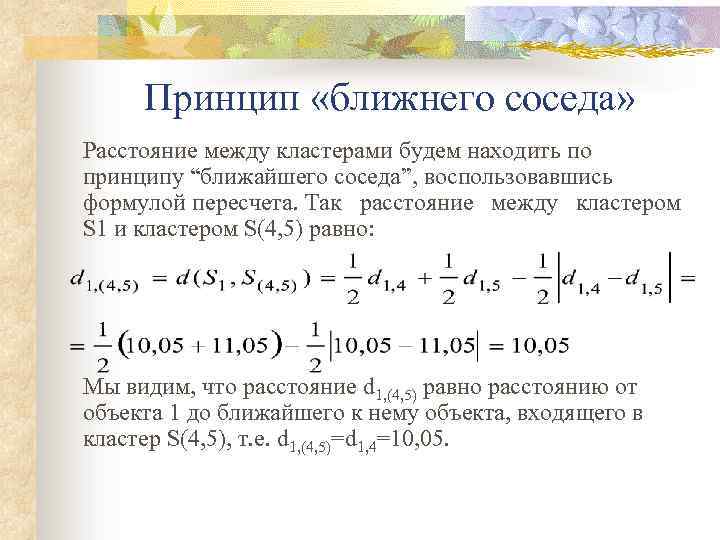

Принцип «ближнего соседа» Расстояние между кластерами будем находить по принципу “ближайшего соседа”, воспользовавшись формулой пересчета. Так расстояние между кластером S 1 и кластером S(4, 5) равно: Мы видим, что расстояние d 1, (4, 5) равно расстоянию от объекта 1 до ближайшего к нему объекта, входящего в кластер S(4, 5), т. е. d 1, (4, 5)=d 1, 4=10, 05.

Принцип «ближнего соседа» Расстояние между кластерами будем находить по принципу “ближайшего соседа”, воспользовавшись формулой пересчета. Так расстояние между кластером S 1 и кластером S(4, 5) равно: Мы видим, что расстояние d 1, (4, 5) равно расстоянию от объекта 1 до ближайшего к нему объекта, входящего в кластер S(4, 5), т. е. d 1, (4, 5)=d 1, 4=10, 05.

Принцип «ближнего соседа» n Проводя аналогичные расчеты, получим матрицу расстояний n Объединим наблюдения 1 и 2, имеющие наименьшее расстояние d 1, 2=3, 61. После объединения имеем три кластера S(1, 2), S 3 и S(4, 5).

Принцип «ближнего соседа» n Проводя аналогичные расчеты, получим матрицу расстояний n Объединим наблюдения 1 и 2, имеющие наименьшее расстояние d 1, 2=3, 61. После объединения имеем три кластера S(1, 2), S 3 и S(4, 5).

Расчет матрицы расстояний n n n Вновь строим матрицу расстояний. Для этого необходимо рассчитать расстояние до кластера S(1, 2). Воспользуемся матрицей расстояний D 2. Например, расстояние между кластерами S(4, 5) и S(1, 2) равно: Как видим, оно равно расстоянию от кластера S(4, 5) до ближайшего объекта, входящего в кластер S(1, 2), то есть d(4, 5), (1, 2)=d(4, 5), 2=8, 94.

Расчет матрицы расстояний n n n Вновь строим матрицу расстояний. Для этого необходимо рассчитать расстояние до кластера S(1, 2). Воспользуемся матрицей расстояний D 2. Например, расстояние между кластерами S(4, 5) и S(1, 2) равно: Как видим, оно равно расстоянию от кластера S(4, 5) до ближайшего объекта, входящего в кластер S(1, 2), то есть d(4, 5), (1, 2)=d(4, 5), 2=8, 94.

Матрица расстояний n Имеет вид

Матрица расстояний n Имеет вид

Матрица расстояний n Объединим кластеры S(1, 2) и S(3), расстояние между которыми, согласно матрице D 3, минимально d(1, 2), 3=4, 12. В результате этого получим два кластера: S(1, 2, 3) и S(4, 5). Матрица расстояний будет иметь вид: n Из матрицы D 4 следует, что на расстоянии d(1, 2, 3), (4, 5)=5, 83 все пять наблюдений объединяются в один кластер.

Матрица расстояний n Объединим кластеры S(1, 2) и S(3), расстояние между которыми, согласно матрице D 3, минимально d(1, 2), 3=4, 12. В результате этого получим два кластера: S(1, 2, 3) и S(4, 5). Матрица расстояний будет иметь вид: n Из матрицы D 4 следует, что на расстоянии d(1, 2, 3), (4, 5)=5, 83 все пять наблюдений объединяются в один кластер.

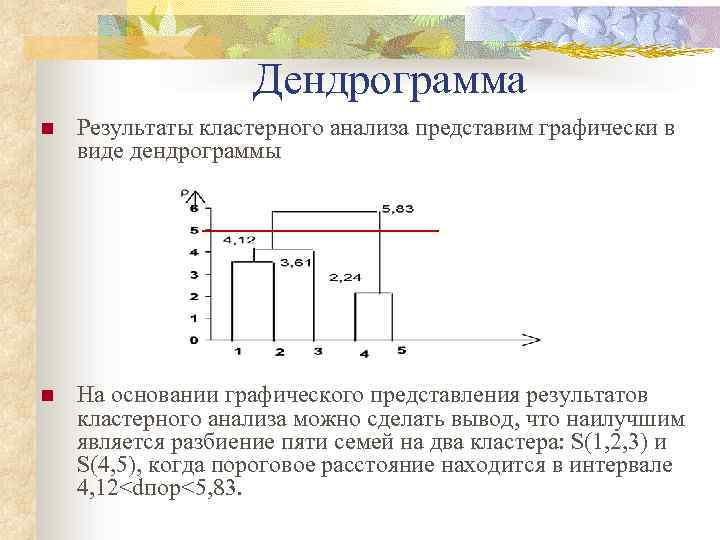

Дендрограмма n Результаты кластерного анализа представим графически в виде дендрограммы n На основании графического представления результатов кластерного анализа можно сделать вывод, что наилучшим является разбиение пяти семей на два кластера: S(1, 2, 3) и S(4, 5), когда пороговое расстояние находится в интервале 4, 12

Дендрограмма n Результаты кластерного анализа представим графически в виде дендрограммы n На основании графического представления результатов кластерного анализа можно сделать вывод, что наилучшим является разбиение пяти семей на два кластера: S(1, 2, 3) и S(4, 5), когда пороговое расстояние находится в интервале 4, 12

Принцип “дальнего соседа” n n n Проведем классификацию, выбрав при обычном евклидовом расстоянии принцип “дальнего соседа”. Как и в случае (1) используем обычное евклидово расстояние, поэтому матрица D 1 остается без изменения. Согласно агломеративному алгоритму объединяются в один кластер объекты 4 и 5, как наиболее близкие d 4, 5=2, 24. После объединения имеем четыре кластера: S 1, S 2, S 3 и S(4, 5).

Принцип “дальнего соседа” n n n Проведем классификацию, выбрав при обычном евклидовом расстоянии принцип “дальнего соседа”. Как и в случае (1) используем обычное евклидово расстояние, поэтому матрица D 1 остается без изменения. Согласно агломеративному алгоритму объединяются в один кластер объекты 4 и 5, как наиболее близкие d 4, 5=2, 24. После объединения имеем четыре кластера: S 1, S 2, S 3 и S(4, 5).

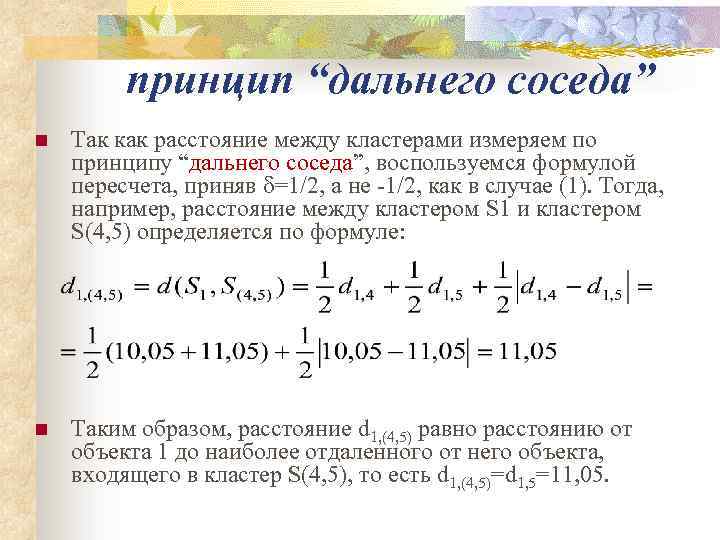

принцип “дальнего соседа” n Так как расстояние между кластерами измеряем по принципу “дальнего соседа”, воспользуемся формулой пересчета, приняв =1/2, а не ‑ 1/2, как в случае (1). Тогда, например, расстояние между кластером S 1 и кластером S(4, 5) определяется по формуле: n Таким образом, расстояние d 1, (4, 5) равно расстоянию от объекта 1 до наиболее отдаленного от него объекта, входящего в кластер S(4, 5), то есть d 1, (4, 5)=d 1, 5=11, 05.

принцип “дальнего соседа” n Так как расстояние между кластерами измеряем по принципу “дальнего соседа”, воспользуемся формулой пересчета, приняв =1/2, а не ‑ 1/2, как в случае (1). Тогда, например, расстояние между кластером S 1 и кластером S(4, 5) определяется по формуле: n Таким образом, расстояние d 1, (4, 5) равно расстоянию от объекта 1 до наиболее отдаленного от него объекта, входящего в кластер S(4, 5), то есть d 1, (4, 5)=d 1, 5=11, 05.

Матрица расстояний n Аналогично рассматриваются все остальные элементы матрицы расстояния n Объединим объекты 1 и 2 в один кластер, как наиболее близкие (согласно матрице D 2), d 1, 2=3, 61. После объединения имеем три кластера: S(1, 2), S 3 и S(4, 5). n

Матрица расстояний n Аналогично рассматриваются все остальные элементы матрицы расстояния n Объединим объекты 1 и 2 в один кластер, как наиболее близкие (согласно матрице D 2), d 1, 2=3, 61. После объединения имеем три кластера: S(1, 2), S 3 и S(4, 5). n

Матрицы расстояний D 3 и D 4 n Строим матрицу расстояний D 3, воспользовавшись принципом “дальнего соседа”. n Объединим кластеры S 3 и S(4, 5), расстояние между которыми d 3, (4, 5)=6, 40 минимально, и получим два кластера: S(1, 2) и S(3, 4, 5), расстояние между которыми определяется по матрице n и равно d(1, 2), (3, 4, 5)=11, 05.

Матрицы расстояний D 3 и D 4 n Строим матрицу расстояний D 3, воспользовавшись принципом “дальнего соседа”. n Объединим кластеры S 3 и S(4, 5), расстояние между которыми d 3, (4, 5)=6, 40 минимально, и получим два кластера: S(1, 2) и S(3, 4, 5), расстояние между которыми определяется по матрице n и равно d(1, 2), (3, 4, 5)=11, 05.

Дендрограмма (обычное евклидово расстояние, дальний сосед) n Графические результаты классификации представлены на рисунке

Дендрограмма (обычное евклидово расстояние, дальний сосед) n Графические результаты классификации представлены на рисунке

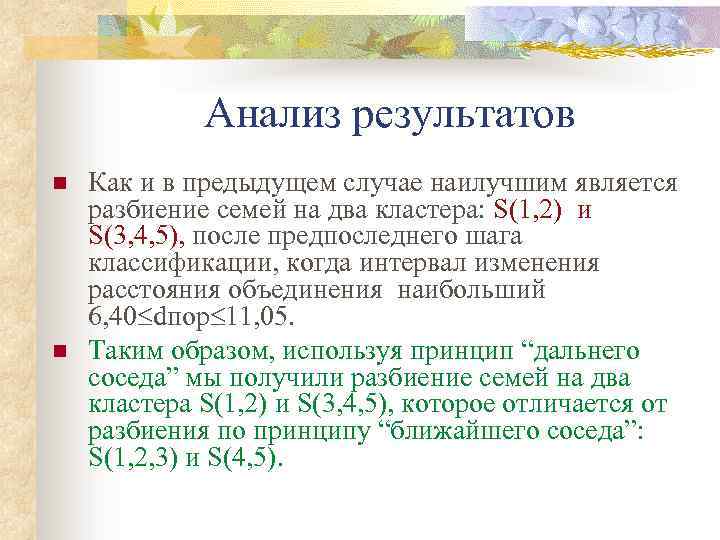

Анализ результатов n n Как и в предыдущем случае наилучшим является разбиение семей на два кластера: S(1, 2) и S(3, 4, 5), после предпоследнего шага классификации, когда интервал изменения расстояния объединения наибольший 6, 40 dпор 11, 05. Таким образом, используя принцип “дальнего соседа” мы получили разбиение семей на два кластера S(1, 2) и S(3, 4, 5), которое отличается от разбиения по принципу “ближайшего соседа”: S(1, 2, 3) и S(4, 5).

Анализ результатов n n Как и в предыдущем случае наилучшим является разбиение семей на два кластера: S(1, 2) и S(3, 4, 5), после предпоследнего шага классификации, когда интервал изменения расстояния объединения наибольший 6, 40 dпор 11, 05. Таким образом, используя принцип “дальнего соседа” мы получили разбиение семей на два кластера S(1, 2) и S(3, 4, 5), которое отличается от разбиения по принципу “ближайшего соседа”: S(1, 2, 3) и S(4, 5).

Классификация на основе обычного евклидова расстояния и принципа “ центра тяжести” n n n Матрица D 1 остается без изменения. Согласно агломеративному алгоритму объединяются в кластер S(4, 5) объекты 4 и 5, как наиболее близкие d 4, 5=2, 24. Кластер S(4, 5) характеризуется в дальнейшем его центром тяжести, определяемым вектором средних. Расстояние от этого кластера до первого наблюдения равно:

Классификация на основе обычного евклидова расстояния и принципа “ центра тяжести” n n n Матрица D 1 остается без изменения. Согласно агломеративному алгоритму объединяются в кластер S(4, 5) объекты 4 и 5, как наиболее близкие d 4, 5=2, 24. Кластер S(4, 5) характеризуется в дальнейшем его центром тяжести, определяемым вектором средних. Расстояние от этого кластера до первого наблюдения равно:

Матрица расстояний n Матрица расстояний примет вид:

Матрица расстояний n Матрица расстояний примет вид:

Принцип “ центра тяжести” n Объединим объекты 1 и 2, расстояние между которыми d 1, 2=3, 61 минимальное. Кластер характеризуется центром тяжести

Принцип “ центра тяжести” n Объединим объекты 1 и 2, расстояние между которыми d 1, 2=3, 61 минимальное. Кластер характеризуется центром тяжести

Матрица расстояний n Тогда матрица расстояний примет вид: n В матрице D 3 минимальное расстояние d(1, 2), 3=5, 59, поэтому образуем кластер S(1, 2, 3) и определим его вектор средних

Матрица расстояний n Тогда матрица расстояний примет вид: n В матрице D 3 минимальное расстояние d(1, 2), 3=5, 59, поэтому образуем кластер S(1, 2, 3) и определим его вектор средних

Принцип “ центра тяжести” n Найдем расстояние между S(1, 2, 3) и S(4, 5) n на котором все пять объектов объединяются в один кластер.

Принцип “ центра тяжести” n Найдем расстояние между S(1, 2, 3) и S(4, 5) n на котором все пять объектов объединяются в один кластер.

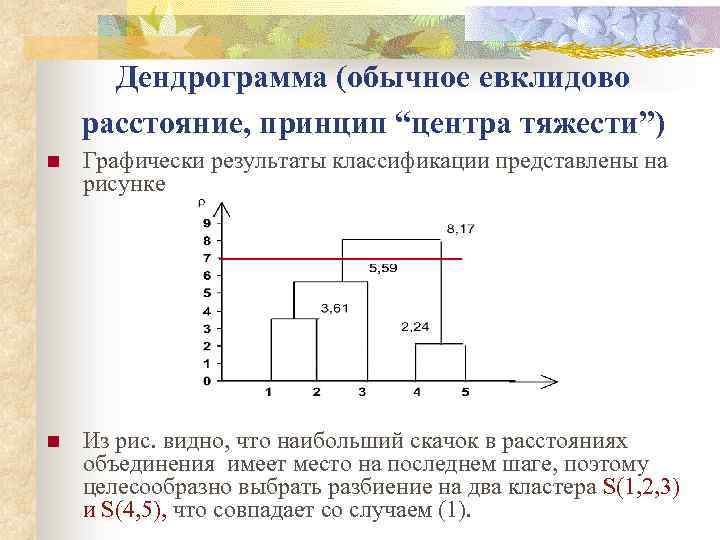

Дендрограмма (обычное евклидово расстояние, принцип “центра тяжести”) n Графически результаты классификации представлены на рисунке n Из рис. видно, что наибольший скачок в расстояниях объединения имеет место на последнем шаге, поэтому целесообразно выбрать разбиение на два кластера S(1, 2, 3) и S(4, 5), что совпадает со случаем (1).

Дендрограмма (обычное евклидово расстояние, принцип “центра тяжести”) n Графически результаты классификации представлены на рисунке n Из рис. видно, что наибольший скачок в расстояниях объединения имеет место на последнем шаге, поэтому целесообразно выбрать разбиение на два кластера S(1, 2, 3) и S(4, 5), что совпадает со случаем (1).

Классификация на основе обычного евклидова расстояния и принципа “средней связи” n n Используя матрицу D 1, согласно агломеративному алгоритму объединим кластеры S 4 и S 5 в один S(4, 5), так как расстояние между ними d 4, 5 =2, 24 минимально. Расстояние от кластера S(4, 5) до остальных кластеров определим по принципу “средней связи” на основе матрицы D 1. Например:

Классификация на основе обычного евклидова расстояния и принципа “средней связи” n n Используя матрицу D 1, согласно агломеративному алгоритму объединим кластеры S 4 и S 5 в один S(4, 5), так как расстояние между ними d 4, 5 =2, 24 минимально. Расстояние от кластера S(4, 5) до остальных кластеров определим по принципу “средней связи” на основе матрицы D 1. Например:

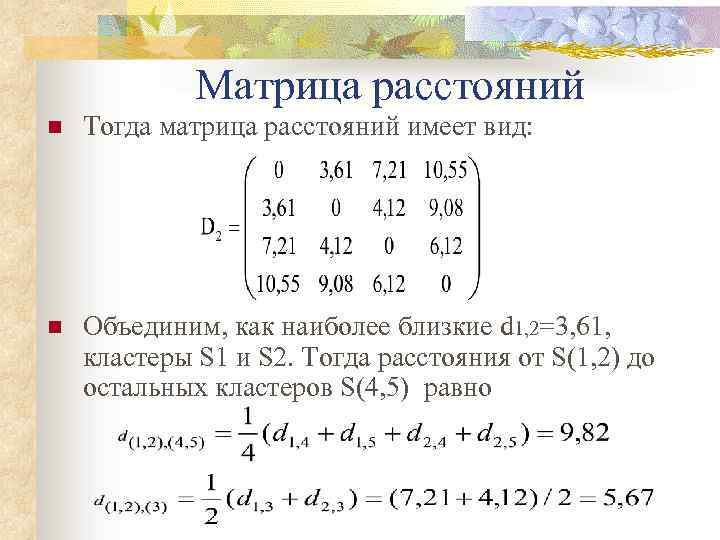

Матрица расстояний n Тогда матрица расстояний имеет вид: n Объединим, как наиболее близкие d 1, 2=3, 61, кластеры S 1 и S 2. Тогда расстояния от S(1, 2) до остальных кластеров S(4, 5) равно

Матрица расстояний n Тогда матрица расстояний имеет вид: n Объединим, как наиболее близкие d 1, 2=3, 61, кластеры S 1 и S 2. Тогда расстояния от S(1, 2) до остальных кластеров S(4, 5) равно

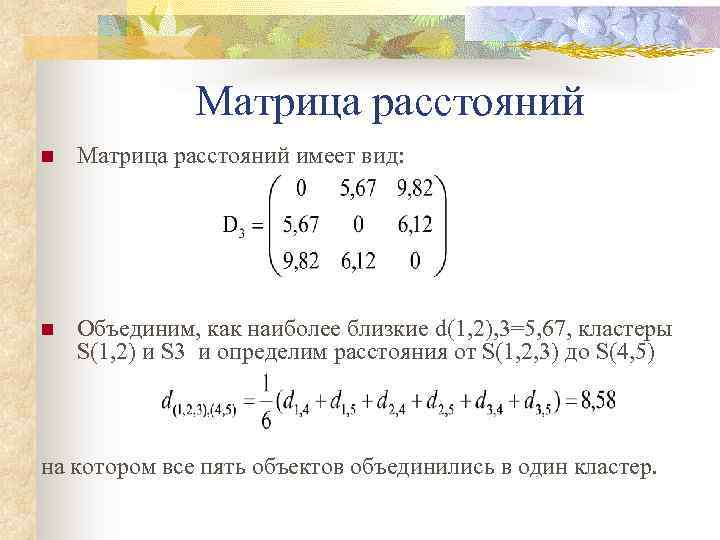

Матрица расстояний n Матрица расстояний имеет вид: n Объединим, как наиболее близкие d(1, 2), 3=5, 67, кластеры S(1, 2) и S 3 и определим расстояния от S(1, 2, 3) до S(4, 5) на котором все пять объектов объединились в один кластер.

Матрица расстояний n Матрица расстояний имеет вид: n Объединим, как наиболее близкие d(1, 2), 3=5, 67, кластеры S(1, 2) и S 3 и определим расстояния от S(1, 2, 3) до S(4, 5) на котором все пять объектов объединились в один кластер.

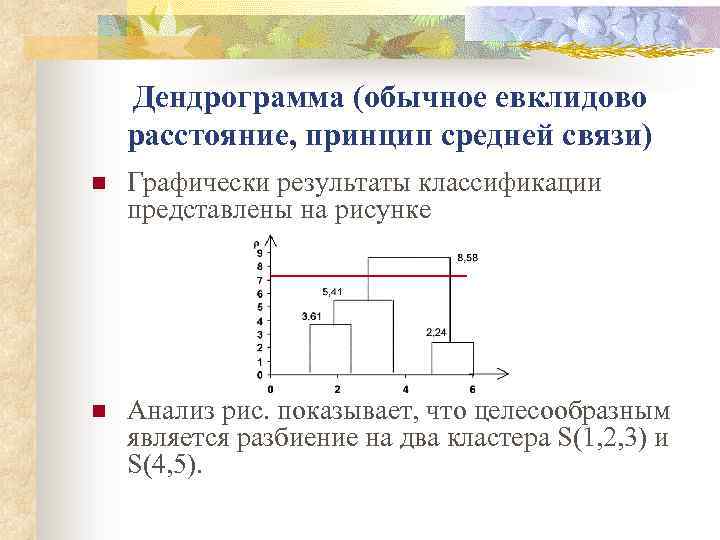

Дендрограмма (обычное евклидово расстояние, принцип средней связи) n Графически результаты классификации представлены на рисунке n Анализ рис. показывает, что целесообразным является разбиение на два кластера S(1, 2, 3) и S(4, 5).

Дендрограмма (обычное евклидово расстояние, принцип средней связи) n Графически результаты классификации представлены на рисунке n Анализ рис. показывает, что целесообразным является разбиение на два кластера S(1, 2, 3) и S(4, 5).

Выводы Таким образом, сравнивая результаты 4 -х разбиений пяти семей на однородные группы, можно отметить, что наиболее устойчивым, а отсюда и предпочтительным, является разбиение на два кластера S(1, 2, 3) и S(4, 5), что согласуется с рис. 1. Только в одном случае из четырех, при использовании принципа “дальнего соседа” получено разбиение S(1, 2) и S(3, 4, 5).

Выводы Таким образом, сравнивая результаты 4 -х разбиений пяти семей на однородные группы, можно отметить, что наиболее устойчивым, а отсюда и предпочтительным, является разбиение на два кластера S(1, 2, 3) и S(4, 5), что согласуется с рис. 1. Только в одном случае из четырех, при использовании принципа “дальнего соседа” получено разбиение S(1, 2) и S(3, 4, 5).

3. Взвешенное Евклидово расстояние n n Взвешенное евклидово расстояние получается из метрики Махаланобиса в предположении, что элементы Xij вектора наблюдений Xi взаимно независимы, то есть матрица - диагональная. Часто веса выбирают пропорционально Величине среднеквадратического отклонения признака xj Обратной величине

3. Взвешенное Евклидово расстояние n n Взвешенное евклидово расстояние получается из метрики Махаланобиса в предположении, что элементы Xij вектора наблюдений Xi взаимно независимы, то есть матрица - диагональная. Часто веса выбирают пропорционально Величине среднеквадратического отклонения признака xj Обратной величине