Презентация Лекция 06 Алгоритм C4.5 для Data Mining

lekciya_06_algoritm_c4.5_dlya_data_mining.ppt

- Размер: 194.5 Кб

- Количество слайдов: 12

Описание презентации Презентация Лекция 06 Алгоритм C4.5 для Data Mining по слайдам

Системы искусственного интеллекта Бондаренко Иван Юрьевич, ассистент каф. ПМИ

Системы искусственного интеллекта Бондаренко Иван Юрьевич, ассистент каф. ПМИ

2 Алгоритм C 4. 5 Усовершенствование простого алгоритма индуцирования знаний. Основнoе отличие: следующий условный атрибут, по которому проводится разбиение, определяется по критерию минимизации энтропии. Теперь алгоритм не зависит от порядка следования атрибутов таблицы данных.

2 Алгоритм C 4. 5 Усовершенствование простого алгоритма индуцирования знаний. Основнoе отличие: следующий условный атрибут, по которому проводится разбиение, определяется по критерию минимизации энтропии. Теперь алгоритм не зависит от порядка следования атрибутов таблицы данных.

3 Общее описание алгоритма C 4. 5 Алгоритм работает для таких таблиц данных, в которых атрибут класса (целевой атрибут) может иметь конечное множество значений. Обозначения T — множество примеров (таблица или подтаблица данных); m — количество условных атрибутов (столбцов таблицы)

3 Общее описание алгоритма C 4. 5 Алгоритм работает для таких таблиц данных, в которых атрибут класса (целевой атрибут) может иметь конечное множество значений. Обозначения T — множество примеров (таблица или подтаблица данных); m — количество условных атрибутов (столбцов таблицы)

4 Общее описание алгоритма C 4. 5 (продолжение) Обозначения (продолжение) | T | — мощность множества примеров (количество строк в таблице или подтаблице данных); C 1 , C 2 , …, C k — значения, принима-емые атрибутом класса; X — текущий условный атрибут, по которому мы хотим провести разбиение

4 Общее описание алгоритма C 4. 5 (продолжение) Обозначения (продолжение) | T | — мощность множества примеров (количество строк в таблице или подтаблице данных); C 1 , C 2 , …, C k — значения, принима-емые атрибутом класса; X — текущий условный атрибут, по которому мы хотим провести разбиение

5 Общее описание алгоритма C 4. 5 (окончание) Обозначения (окончание) A 1 , A 2 , …, AN — значения, принима-емые текущим условным атрибутом;

5 Общее описание алгоритма C 4. 5 (окончание) Обозначения (окончание) A 1 , A 2 , …, AN — значения, принима-емые текущим условным атрибутом;

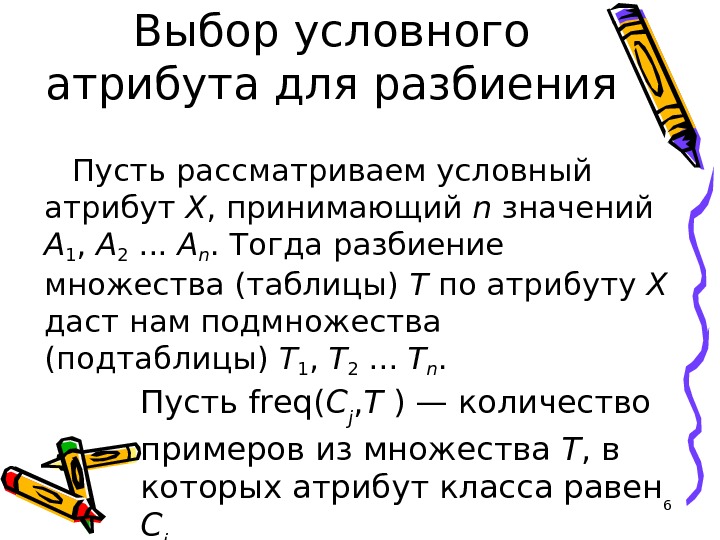

6 Выбор условного атрибута для разбиения Пусть рассматриваем условный атрибут X , принимающий n значений A 1 , A 2 . . . A n. Тогда разбиение множества (таблицы) T по атрибуту X даст нам подмножества (подтаблицы) T 1 , T 2 . . . T n. Пусть freq( C j , T ) — количество примеров из множества T , в которых атрибут класса равен C j

6 Выбор условного атрибута для разбиения Пусть рассматриваем условный атрибут X , принимающий n значений A 1 , A 2 . . . A n. Тогда разбиение множества (таблицы) T по атрибуту X даст нам подмножества (подтаблицы) T 1 , T 2 . . . T n. Пусть freq( C j , T ) — количество примеров из множества T , в которых атрибут класса равен C j

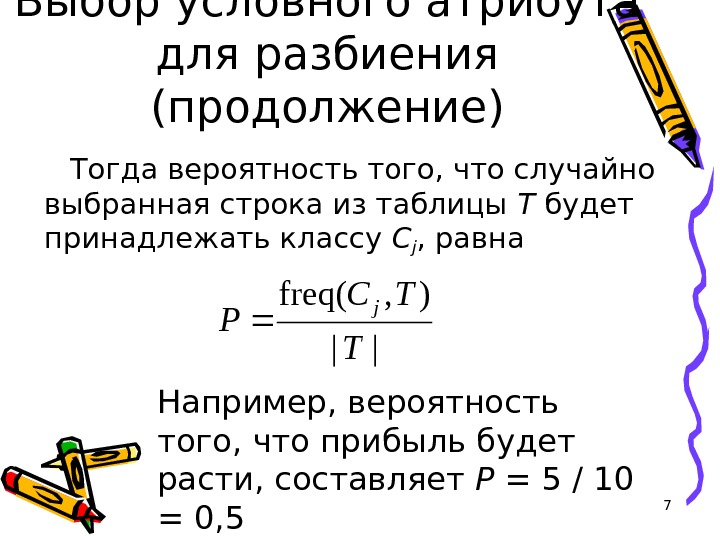

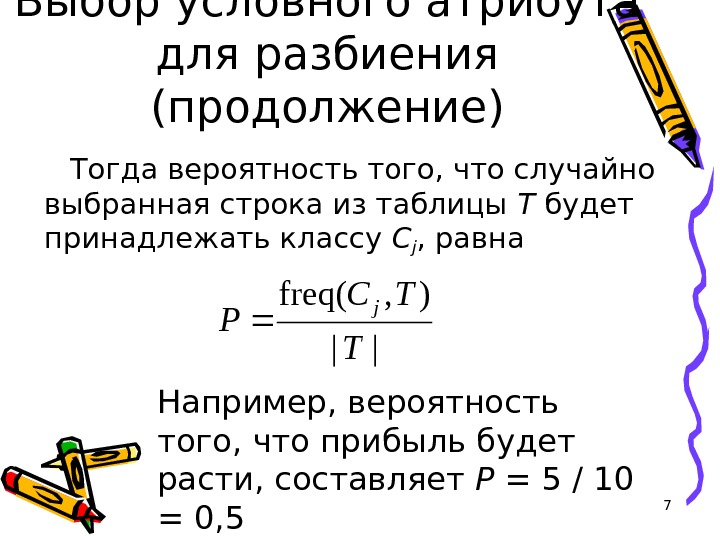

7 Выбор условного атрибута для разбиения (продолжение) Тогда вероятность того, что случайно выбранная строка из таблицы T будет принадлежать классу C j , равна || ), freq( T TC P j Например, вероятность того, что прибыль будет расти, составляет P = 5 / 10 = 0,

7 Выбор условного атрибута для разбиения (продолжение) Тогда вероятность того, что случайно выбранная строка из таблицы T будет принадлежать классу C j , равна || ), freq( T TC P j Например, вероятность того, что прибыль будет расти, составляет P = 5 / 10 = 0,

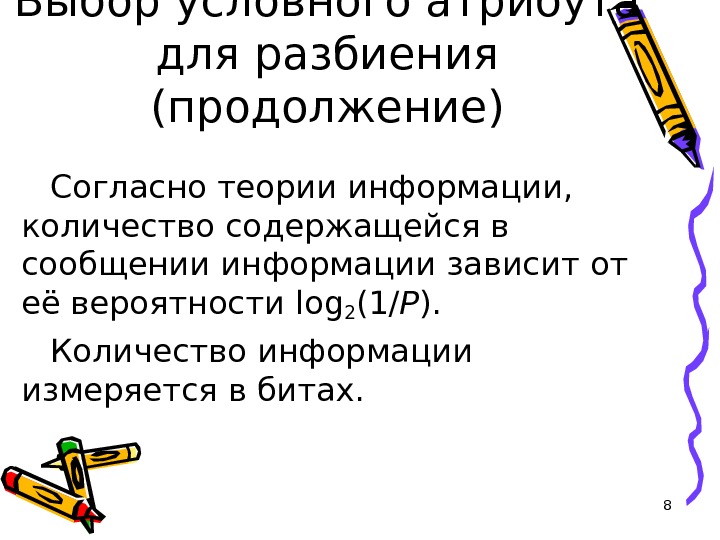

8 Выбор условного атрибута для разбиения (продолжение) Согласно теории информации, количество содержащейся в сообщении информации зависит от её вероятности log 2 (1/ P ). Количество информации измеряется в битах.

8 Выбор условного атрибута для разбиения (продолжение) Согласно теории информации, количество содержащейся в сообщении информации зависит от её вероятности log 2 (1/ P ). Количество информации измеряется в битах.

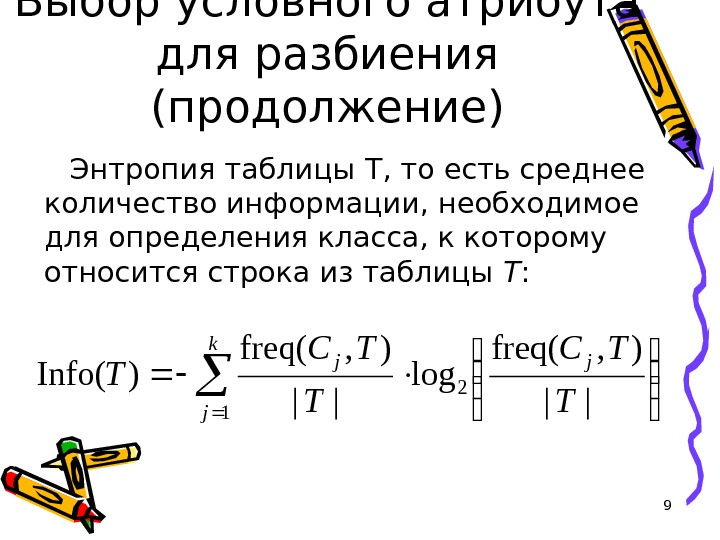

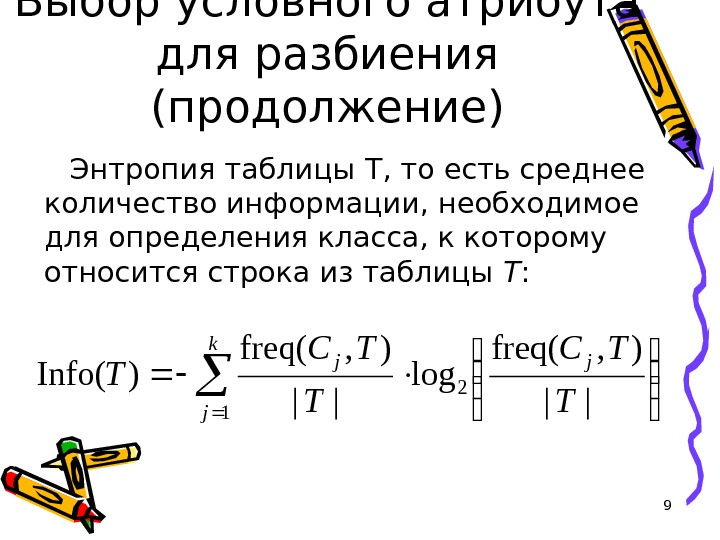

9 Выбор условного атрибута для разбиения (продолжение) Энтропия таблицы T, то есть среднее количество информации, необходимое для определения класса, к которому относится строка из таблицы T : k j jj T TC T 1 2 || ), freq( log || ), freq( )Info(

9 Выбор условного атрибута для разбиения (продолжение) Энтропия таблицы T, то есть среднее количество информации, необходимое для определения класса, к которому относится строка из таблицы T : k j jj T TC T 1 2 || ), freq( log || ), freq( )Info(

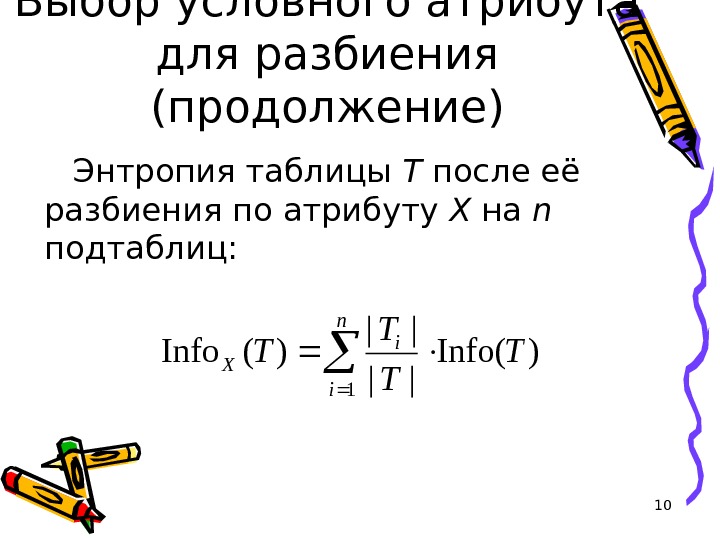

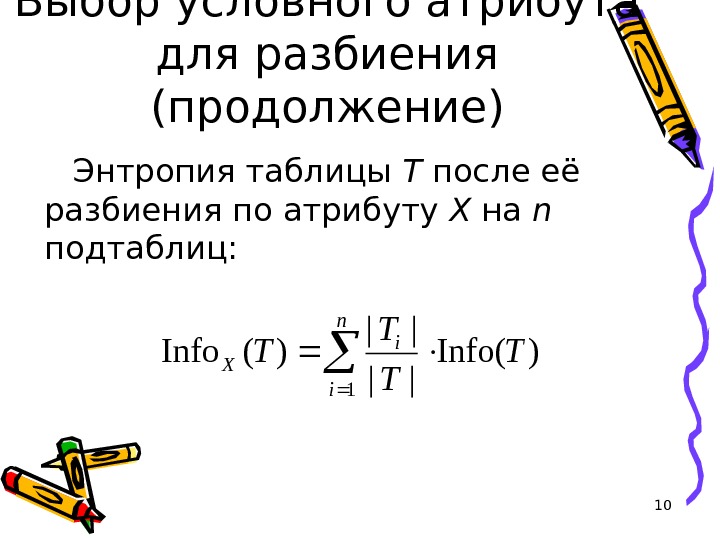

10 Выбор условного атрибута для разбиения (продолжение) Энтропия таблицы T после её разбиения по атрибуту X на n подтаблиц: n i i XT T 1)Info( || || )(Info

10 Выбор условного атрибута для разбиения (продолжение) Энтропия таблицы T после её разбиения по атрибуту X на n подтаблиц: n i i XT T 1)Info( || || )(Info

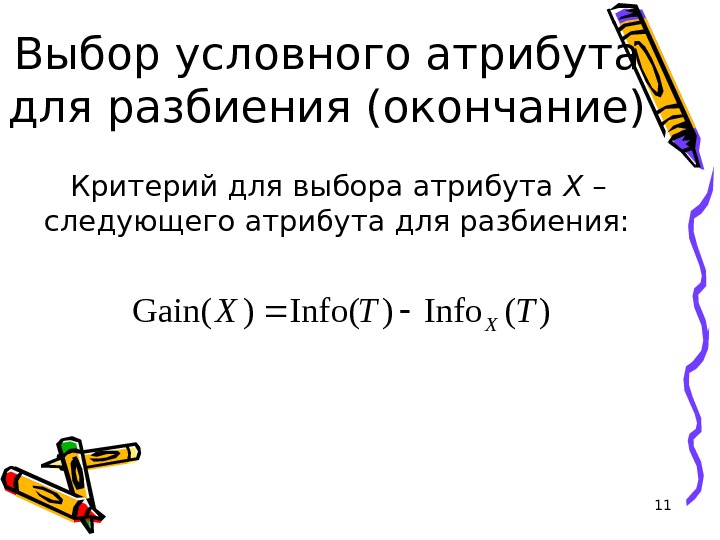

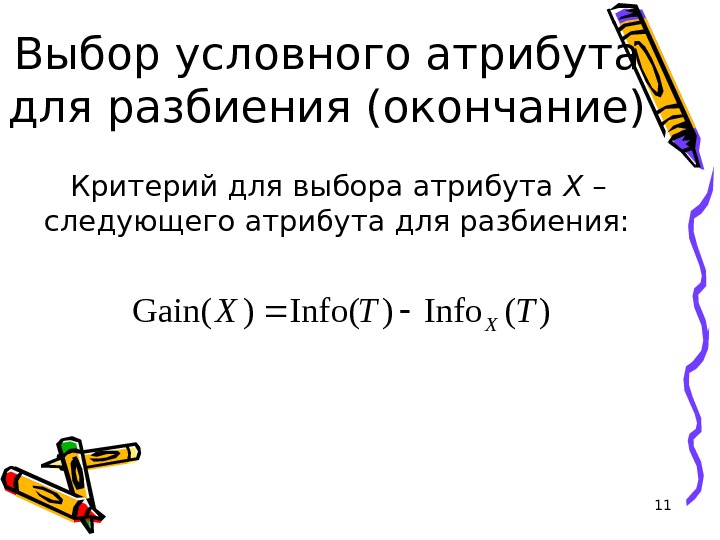

11 Выбор условного атрибута для разбиения (окончание) Критерий для выбора атрибута X – следующего атрибута для разбиения: )(Info)Info()Gain(TTX X

11 Выбор условного атрибута для разбиения (окончание) Критерий для выбора атрибута X – следующего атрибута для разбиения: )(Info)Info()Gain(TTX X

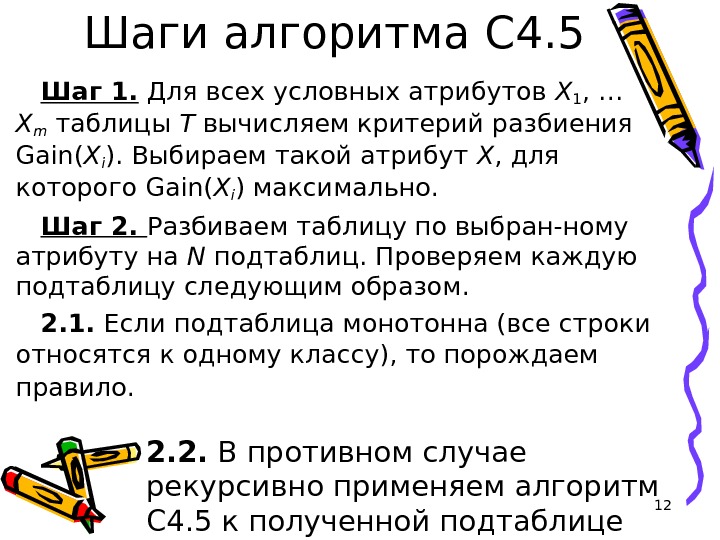

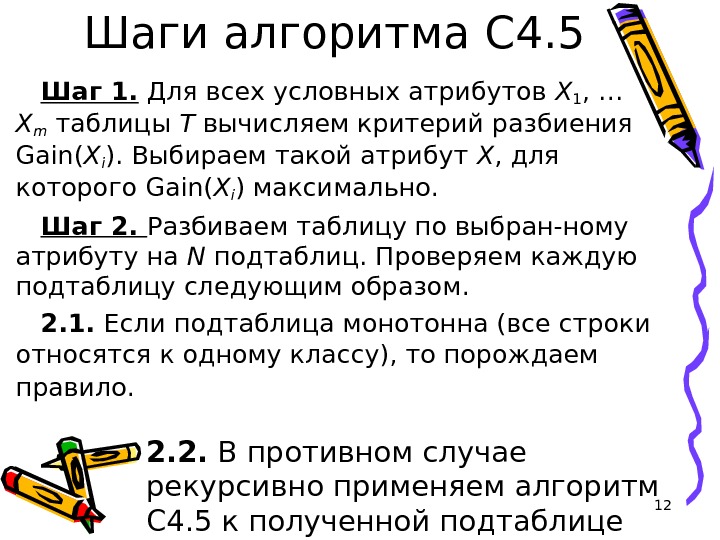

12 Шаги алгоритма C 4. 5 Шаг 1. Для всех условных атрибутов X 1 , … X m таблицы T вычисляем критерий разбиения Gain( X i ). Выбираем такой атрибут X , для которого Gain( X i ) максимально. Шаг 2. Разбиваем таблицу по выбран-ному атрибуту на N подтаблиц. Проверяем каждую подтаблицу следующим образом. 2. 1. Если подтаблица монотонна (все строки относятся к одному классу), то порождаем правило. 2. 2. В противном случае рекурсивно применяем алгоритм C 4. 5 к полученной подтаблице

12 Шаги алгоритма C 4. 5 Шаг 1. Для всех условных атрибутов X 1 , … X m таблицы T вычисляем критерий разбиения Gain( X i ). Выбираем такой атрибут X , для которого Gain( X i ) максимально. Шаг 2. Разбиваем таблицу по выбран-ному атрибуту на N подтаблиц. Проверяем каждую подтаблицу следующим образом. 2. 1. Если подтаблица монотонна (все строки относятся к одному классу), то порождаем правило. 2. 2. В противном случае рекурсивно применяем алгоритм C 4. 5 к полученной подтаблице