Поиск дублей

План доклада • • Виды дублей Чем опасны Поиск дублей Как бороться с дублями

Виды дублей Дубли – страницы с частично либо полностью идентичным контентом доступные по разным адресам внутри сайта. Четкие Полные / Явные Нечеткие Частичные / Неполные

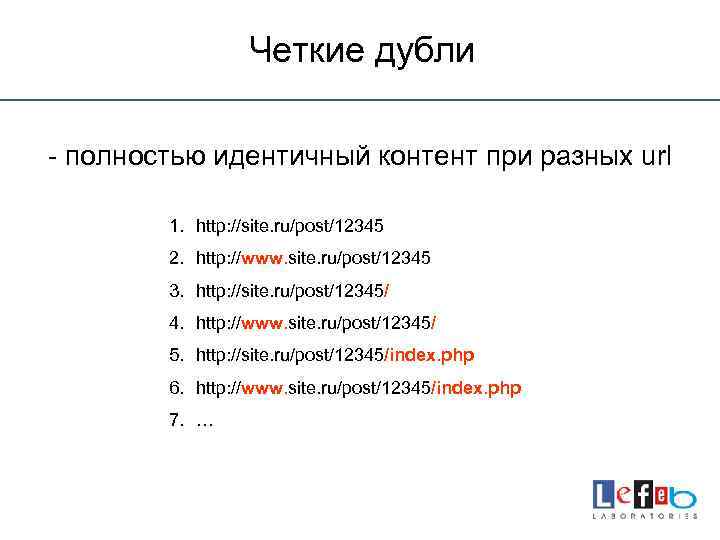

Четкие дубли - полностью идентичный контент при разных url 1. http: //site. ru/post/12345 2. http: //www. site. ru/post/12345 3. http: //site. ru/post/12345/ 4. http: //www. site. ru/post/12345/ 5. http: //site. ru/post/12345/index. php 6. http: //www. site. ru/post/12345/index. php 7. …

Нечеткие дубли - повторение одинакового контента на разных url

Причины появления дублей 1. Недоработки CMS (генерация копий страниц) 2. Технические ошибки 3. Наполнение сайта идентичной информацией 4. Служебные страницы 5. Контент представлен разными способами (. doc, . pdf)

Чем опасны дубли 1. Смена релевантных страниц 2. Размывается внутренний ссылочный вес 3. Потеря уникализации контента внутри сайта 4. Требуется больше времени роботам на сканирования сайта 5. Санкции и пессимизация

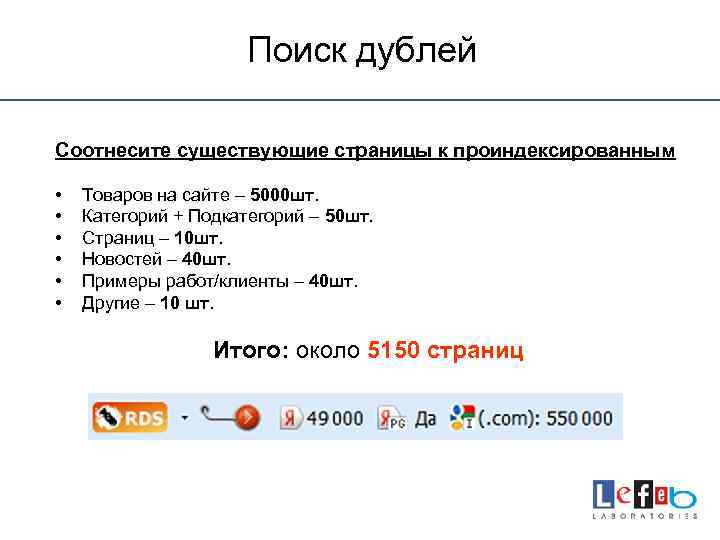

Поиск дублей Соотнесите существующие страницы к проиндексированным • • • Товаров на сайте – 5000 шт. Категорий + Подкатегорий – 50 шт. Страниц – 10 шт. Новостей – 40 шт. Примеры работ/клиенты – 40 шт. Другие – 10 шт. Итого: около 5150 страниц

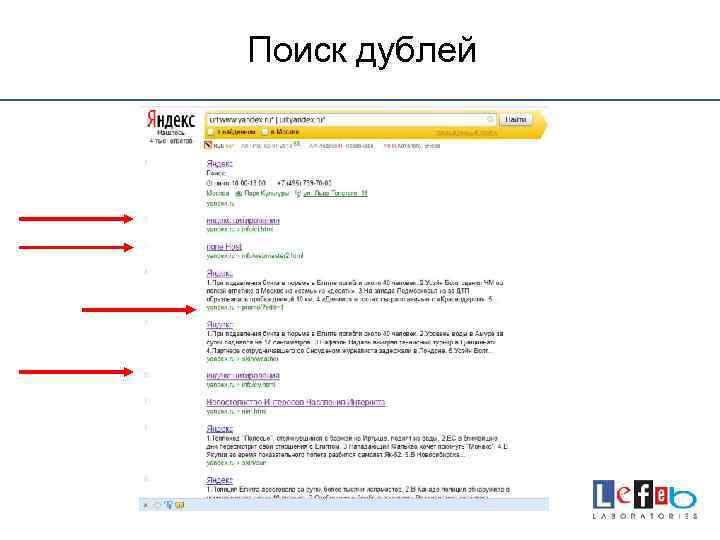

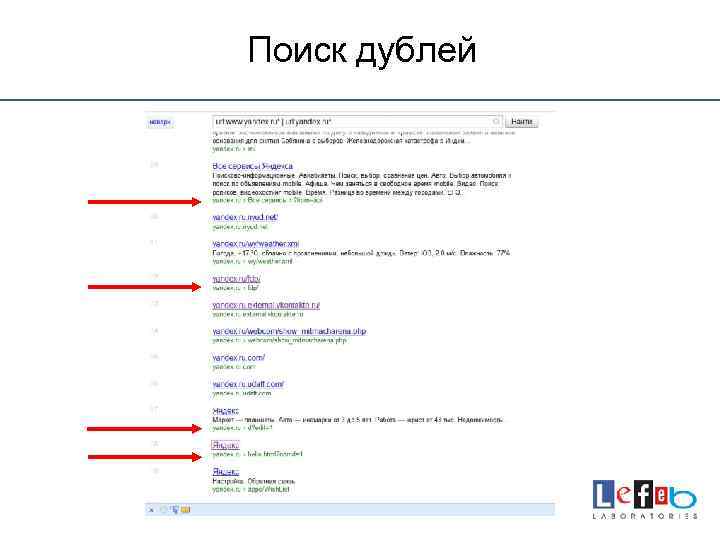

Поиск дублей Просматриваем выдачу вручную 1. Одинаковые сниппеты 2. Отсутствие информации в сниппетах 3. Подозрительные символы и конструкции в структуре url

Поиск дублей

Поиск дублей

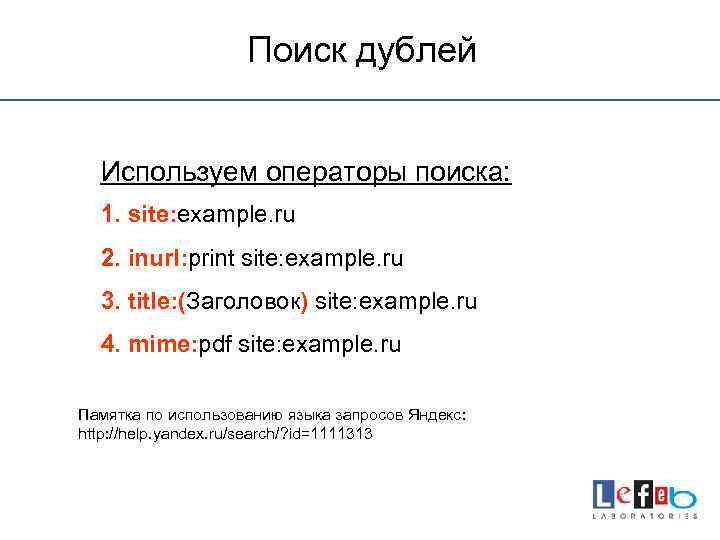

Поиск дублей Используем операторы поиска: 1. site: example. ru 2. inurl: print site: example. ru 3. title: (Заголовок) site: example. ru 4. mime: pdf site: example. ru Памятка по использованию языка запросов Яндекс: http: //help. yandex. ru/search/? id=1111313

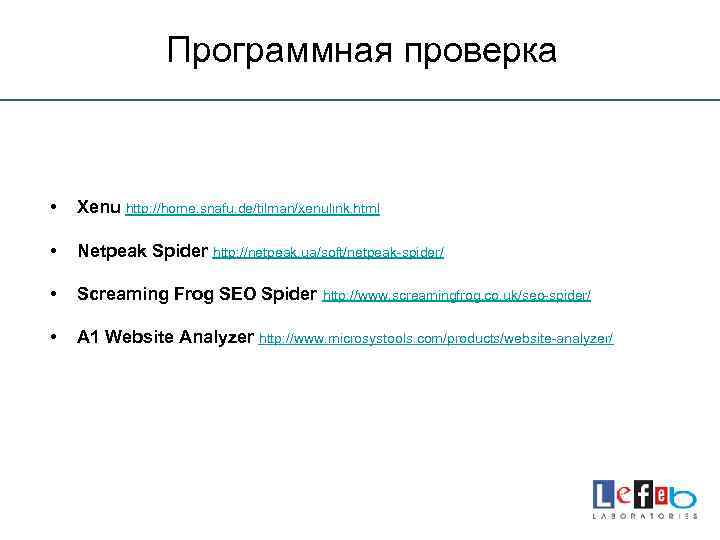

Программная проверка • Xenu http: //home. snafu. de/tilman/xenulink. html • Netpeak Spider http: //netpeak. ua/soft/netpeak-spider/ • Screaming Frog SEO Spider http: //www. screamingfrog. co. uk/seo-spider/ • A 1 Website Analyzer http: //www. microsystools. com/products/website-analyzer/

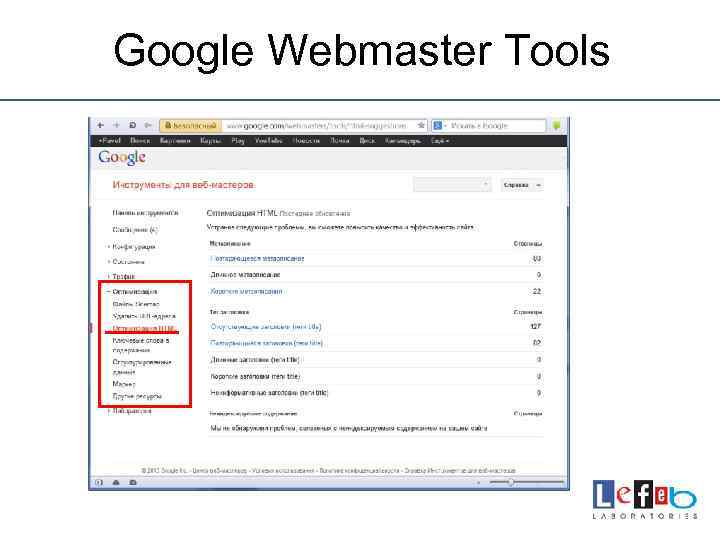

Google Webmaster Tools

Сторонние сервисы • audit. megaindex. ru • сайтрепорт. рф • rooletka. ru

Как бороться с дублями? • • • Ручное удаление 301 редирект meta name="robots" robots. txt link rel="canonical"

301 Редирект 301 редирект с домена без WWW на домен с WWW: Options +Follow. Sym. Links Rewrite. Engine On Rewrite. Cond %{HTTP_HOST} ^site. ru$ [NC] Rewrite. Rule ^(. *)$ http: //www. site. ru/$1 [R=301, L] 301 редирект с домена с WWW на домен без WWW: Options +Follow. Sym. Links Rewrite. Engine On Rewrite. Cond %{HTTP_HOST} ^www. site. ru$ [NC] Rewrite. Rule ^(. *)$ http: //site. ru/$1 [R=301, L]

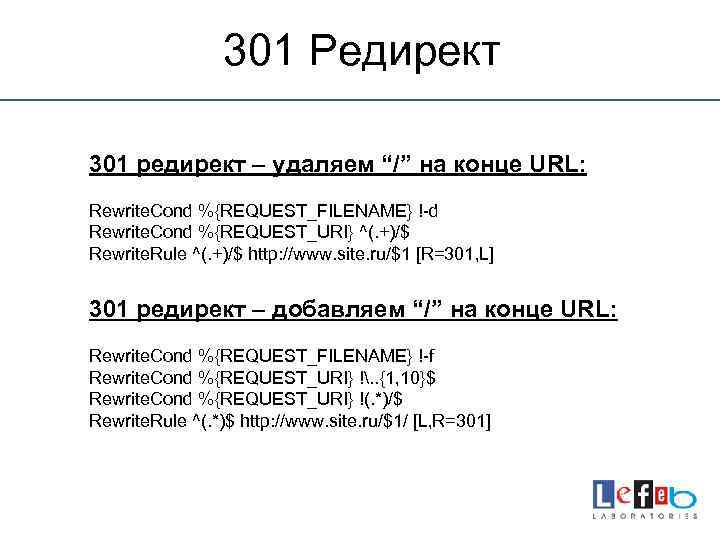

301 Редирект 301 редирект – удаляем “/” на конце URL: Rewrite. Cond %{REQUEST_FILENAME} !-d Rewrite. Cond %{REQUEST_URI} ^(. +)/$ Rewrite. Rule ^(. +)/$ http: //www. site. ru/$1 [R=301, L] 301 редирект – добавляем “/” на конце URL: Rewrite. Cond %{REQUEST_FILENAME} !-f Rewrite. Cond %{REQUEST_URI} !. . {1, 10}$ Rewrite. Cond %{REQUEST_URI} !(. *)/$ Rewrite. Rule ^(. *)$ http: //www. site. ru/$1/ [L, R=301]

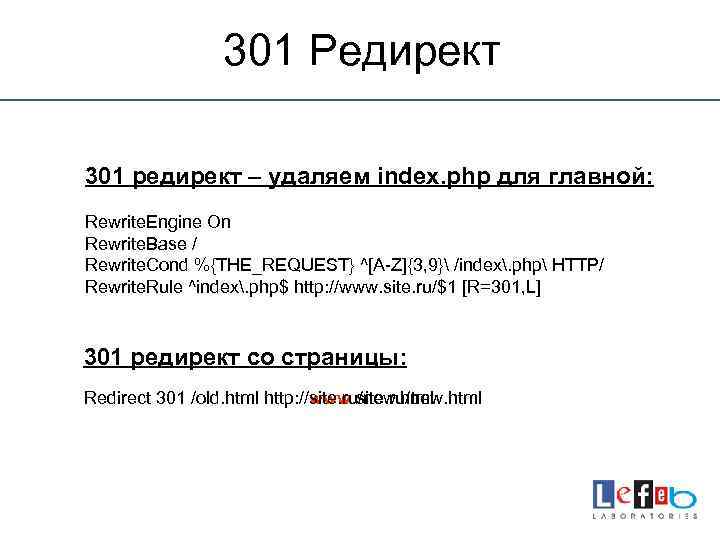

301 Редирект 301 редирект – удаляем index. php для главной: Rewrite. Engine On Rewrite. Base / Rewrite. Cond %{THE_REQUEST} ^[A-Z]{3, 9} /index. php HTTP/ Rewrite. Rule ^index. php$ http: //www. site. ru/$1 [R=301, L] 301 редирект со страницы: Redirect 301 /old. html http: //site. ru/new. html http: //www. site. ru/new. html

Атрибут rel="canonical" Каноническая страница – это рекомендуемый экземпляр из набора страниц с очень похожим содержанием. <link rel="canonical" href="http: //www. site. ru/best"/> Для сортировок вида: &sort=price &sort=date &sort= При принадлежности разным категориям: http: //site. ru/sumki/black/ch-051 http: //site. ru/sumki/leather/ch-051 http: //site. ru/sumki/2013/ch-051 Робот считает ссылку с атрибутом rel="canonical" не строгой директивой, а предлагаемым вариантом, который учитывается, но может быть проигнорирован.

Meta name="robots" <meta name="robots" content=“ЗНАЧЕНИЕ”/> Варианты значений: index — индексировать страницу. noindex — не индексировать страницу. follow — переходить дальше по ссылкам с этой страницы. nofollow — не переходить по ссылкам с этой страницы all — аналог одновременного использования index и follow. Разрешено индексировать и переходить по ссылкам. none — аналог одновременного использования noindex и nofollow. Индексация полностью запрещена, по ссылкам не ходить. <meta name="robots" content="noindex, nofollow"/> - запрещено индексировать текст и переходить по ссылкам на странице. <meta name="robots" content="noindex, follow"/> - запрещено индексировать текст, но можно переходить по ссылкам.

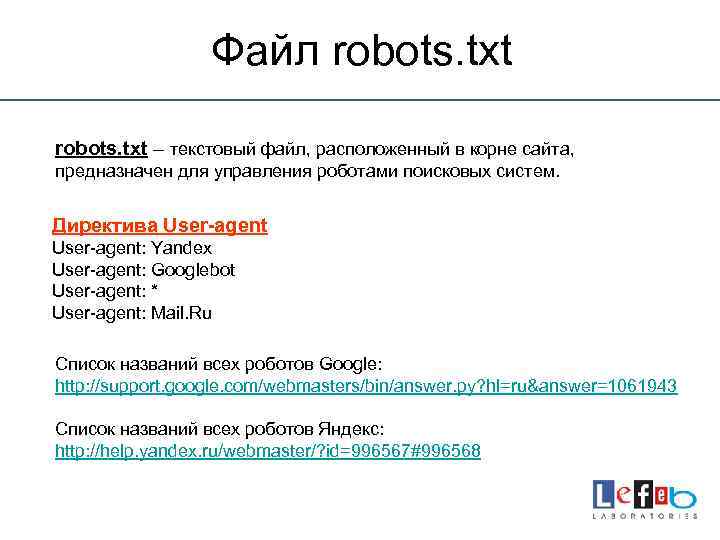

Файл robots. txt – текстовый файл, расположенный в корне сайта, предназначен для управления роботами поисковых систем. Директива User-agent: Yandex User-agent: Googlebot User-agent: * User-agent: Mail. Ru Список названий всех роботов Google: http: //support. google. com/webmasters/bin/answer. py? hl=ru&answer=1061943 Список названий всех роботов Яндекс: http: //help. yandex. ru/webmaster/? id=996567#996568

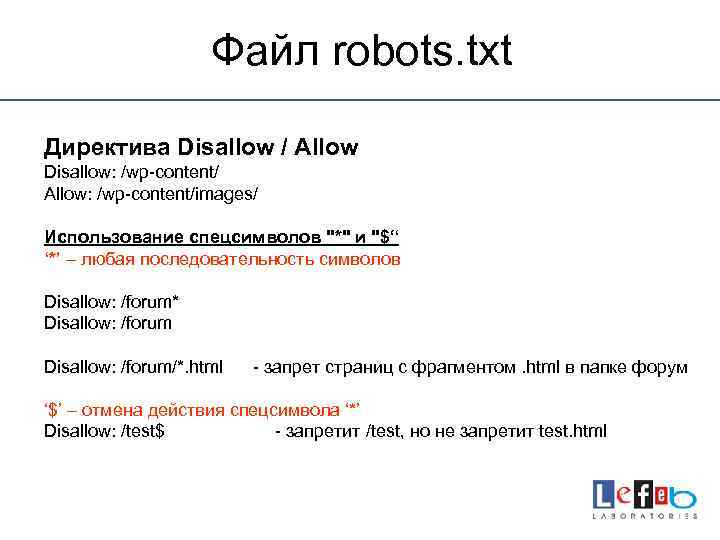

Файл robots. txt Директива Disallow / Allow Disallow: /wp-content/ Allow: /wp-content/images/ Использование спецсимволов "*" и "$“ ‘*’ – любая последовательность символов Disallow: /forum* Disallow: /forum/*. html - запрет страниц с фрагментом. html в папке форум ‘$’ – отмена действия спецсимвола ‘*’ Disallow: /test$ - запретит /test, но не запретит test. html

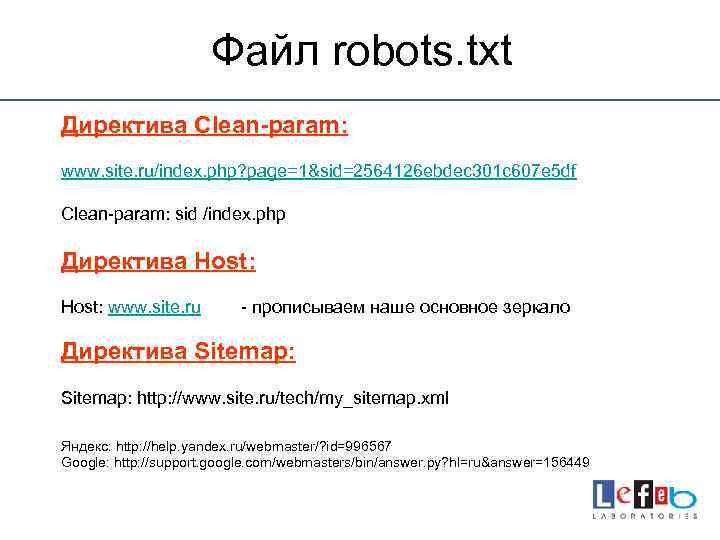

Файл robots. txt Директива Clean-param: www. site. ru/index. php? page=1&sid=2564126 ebdec 301 c 607 e 5 df Clean-param: sid /index. php Директива Host: www. site. ru - прописываем наше основное зеркало Директива Sitemap: http: //www. site. ru/tech/my_sitemap. xml Яндекс: http: //help. yandex. ru/webmaster/? id=996567 Google: http: //support. google. com/webmasters/bin/answer. py? hl=ru&answer=156449

Для 1 С-Битрикс - CMS Disallow: /club/$ User-agent: * Disallow: /club/messages/ Disallow: /bitrix/ Disallow: /club/log/ Disallow: /auth/ Disallow: /content/board/my/ Disallow: /personal/ Disallow: /content/links/my/ Disallow: /search/ Disallow: /*register=yes Disallow: /*/search/ Disallow: /*forgot_password=yes Disallow: /*/slide_show/ Disallow: /*change_password=yes Disallow: /*/gallery/*order=* Disallow: /*login=yes Disallow: /*? print= Disallow: /*logout=yes Disallow: /*&print= Disallow: /*auth=yes Disallow: /*register= Disallow: /*logout=yes Disallow: /*forgot_password= Disallow: /*change_password= Disallow: /*login= Disallow: /*logout= Disallow: /*auth= Disallow: /*? action= Disallow: /*action=ADD_TO_COMPARE_LIST Disallow: /*action=DELETE_FROM_COMPARE_LIST Disallow: /*action=ADD 2 BASKET Disallow: /*action=BUY Disallow: /*? display= Disallow: /*bitrix_*= Disallow: /examples/my-components/ Disallow: /examples/download_private/ Disallow: /*backurl=* Disallow: /*back_url_admin=* Disallow: /*print_course=Y Disallow: /*show_all= Disallow: /*. swf$ Disallow: /club/search/ Disallow: /club/group/search/ Disallow: /club/forum/search/ Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*PAGE_NAME=search Disallow: /communication/forum/search/ Disallow: /communication/blog/search. php Disallow: /club/gallery/tags/ Disallow: /auth. php Disallow: /communication/forum/user/ Disallow: /e-store/paid/detail. php Disallow: /e-store/affiliates/ Host: www. site. ru Sitemap: http: //www. site. ru/sitemap_000. xml

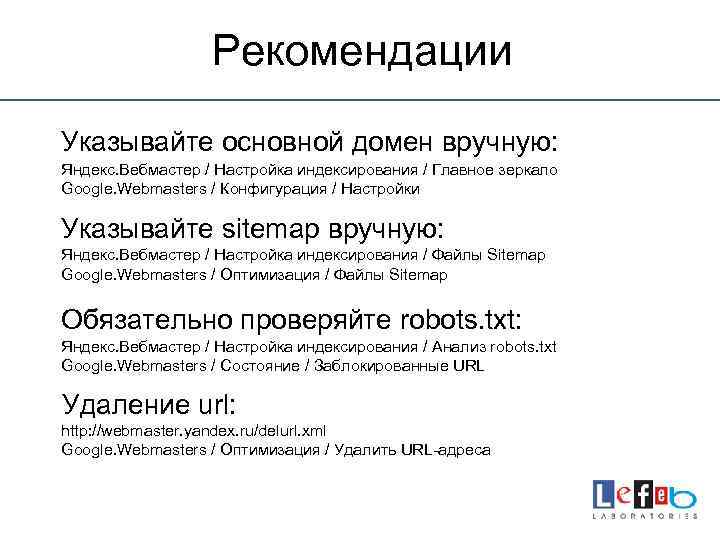

Рекомендации Указывайте основной домен вручную: Яндекс. Вебмастер / Настройка индексирования / Главное зеркало Google. Webmasters / Конфигурация / Настройки Указывайте sitemap вручную: Яндекс. Вебмастер / Настройка индексирования / Файлы Sitemap Google. Webmasters / Оптимизация / Файлы Sitemap Обязательно проверяйте robots. txt: Яндекс. Вебмастер / Настройка индексирования / Анализ robots. txt Google. Webmasters / Состояние / Заблокированные URL Удаление url: http: //webmaster. yandex. ru/delurl. xml Google. Webmasters / Оптимизация / Удалить URL-адреса

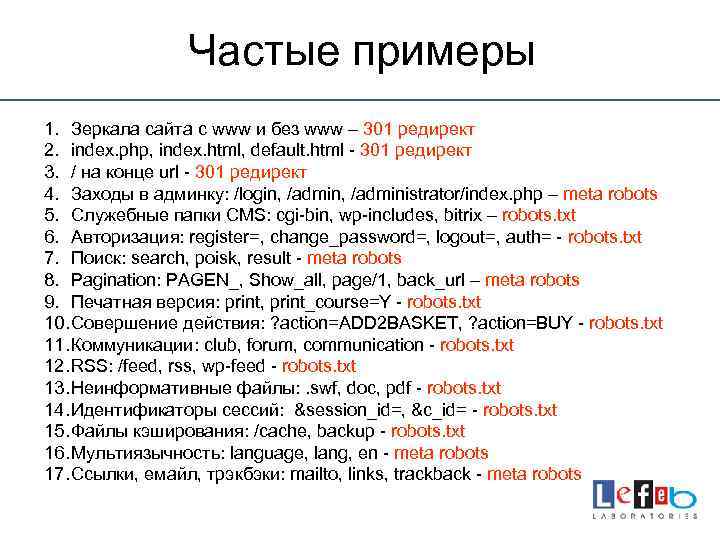

Частые примеры 1. Зеркала сайта с www и без www – 301 редирект 2. index. php, index. html, default. html - 301 редирект 3. / на конце url - 301 редирект 4. Заходы в админку: /login, /administrator/index. php – meta robots 5. Служебные папки CMS: cgi-bin, wp-includеs, bitrix – robots. txt 6. Авторизация: register=, change_password=, logout=, auth= - robots. txt 7. Поиск: search, poisk, result - meta robots 8. Pagination: PAGEN_, Show_all, page/1, back_url – meta robots 9. Печатная версия: print, print_course=Y - robots. txt 10. Совершение действия: ? action=ADD 2 BASKET, ? action=BUY - robots. txt 11. Коммуникации: club, forum, communication - robots. txt 12. RSS: /feed, rss, wp-feed - robots. txt 13. Неинформативные файлы: . swf, doc, pdf - robots. txt 14. Идентификаторы сеcсий: &session_id=, &c_id= - robots. txt 15. Файлы кэширования: /cache, backup - robots. txt 16. Мультиязычность: language, lang, en - meta robots 17. Ссылки, емайл, трэкбэки: mailto, links, trackback - meta robots

Вопросы Тимошин Павел +7 (916) 990 -33 -76 p. timoshin@lefeb. ru Соц. сети: http: //vk. com/latest http: //twitter. com/artist_art http: //www. facebook. com/profile. php? id=100002397474758