Анализ.pptx

- Количество слайдов: 122

Материалы к лекциям АНАЛИЗ ПРОСТРАНСТВЕННЫХ ИНФОРМАЦИОННЫХ ПОЛЕЙ Лектор: Лысенко Н. В. , д. т. н. , профессор кафедры Телевидения и видеотехники СПб. ГЭТУ «ЛЭТИ» © 2008 Лысенко Н. В. , Федорова И. А.

Материалы к лекциям АНАЛИЗ ПРОСТРАНСТВЕННЫХ ИНФОРМАЦИОННЫХ ПОЛЕЙ Лектор: Лысенко Н. В. , д. т. н. , профессор кафедры Телевидения и видеотехники СПб. ГЭТУ «ЛЭТИ» © 2008 Лысенко Н. В. , Федорова И. А.

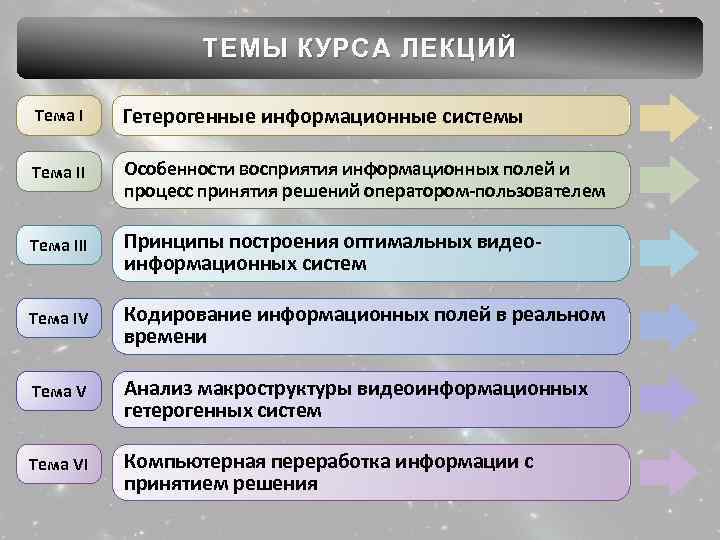

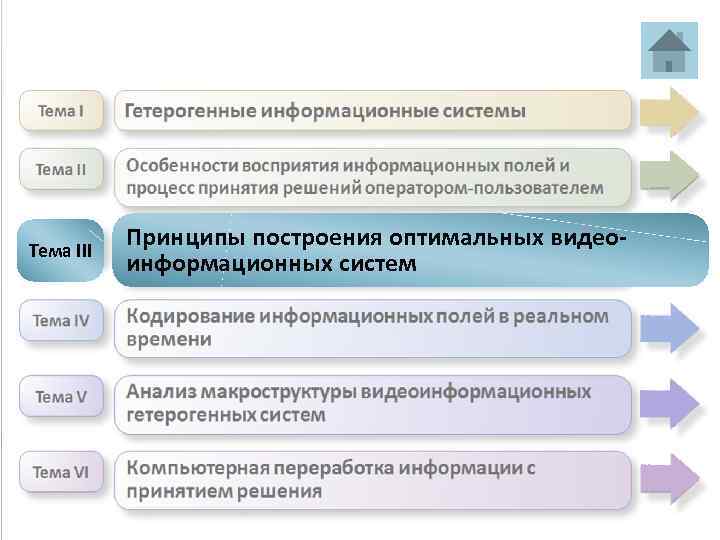

ТЕМЫ КУРСА ЛЕКЦИЙ Тема I Гетерогенные информационные системы Тема II Особенности восприятия информационных полей и процесс принятия решений оператором-пользователем Тема III Принципы построения оптимальных видеоинформационных систем Тема IV Кодирование информационных полей в реальном времени Тема V Анализ макроструктуры видеоинформационных гетерогенных систем Тема VI Компьютерная переработка информации с принятием решения

ТЕМЫ КУРСА ЛЕКЦИЙ Тема I Гетерогенные информационные системы Тема II Особенности восприятия информационных полей и процесс принятия решений оператором-пользователем Тема III Принципы построения оптимальных видеоинформационных систем Тема IV Кодирование информационных полей в реальном времени Тема V Анализ макроструктуры видеоинформационных гетерогенных систем Тема VI Компьютерная переработка информации с принятием решения

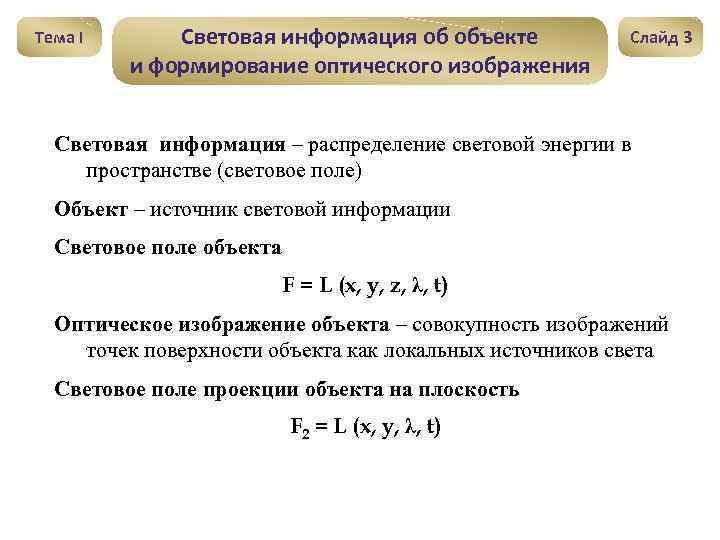

Тема I Световая информация об объекте и формирование оптического изображения Слайд 3 Световая информация – распределение световой энергии в пространстве (световое поле) Объект – источник световой информации Световое поле объекта F = L (x, y, z, λ, t) Оптическое изображение объекта – совокупность изображений точек поверхности объекта как локальных источников света Световое поле проекции объекта на плоскость F 2 = L (x, y, λ, t)

Тема I Световая информация об объекте и формирование оптического изображения Слайд 3 Световая информация – распределение световой энергии в пространстве (световое поле) Объект – источник световой информации Световое поле объекта F = L (x, y, z, λ, t) Оптическое изображение объекта – совокупность изображений точек поверхности объекта как локальных источников света Световое поле проекции объекта на плоскость F 2 = L (x, y, λ, t)

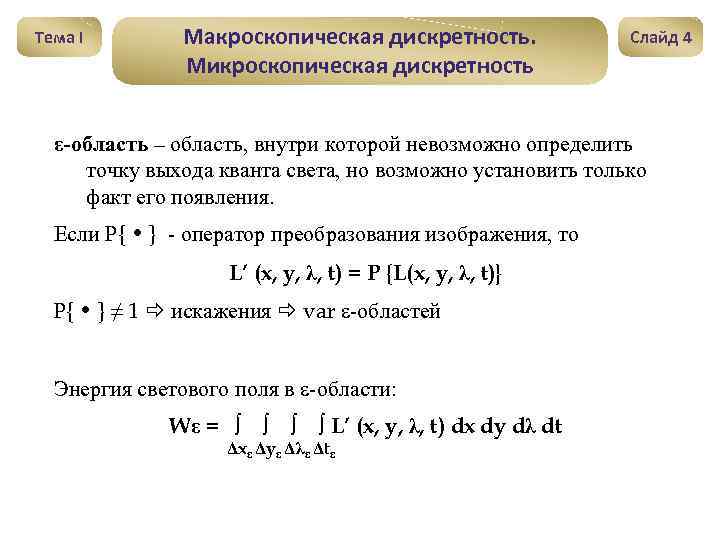

Тема I Макроскопическая дискретность. Микроскопическая дискретность Слайд 4 ε-область – область, внутри которой невозможно определить точку выхода кванта света, но возможно установить только факт его появления. Если Р{ • } - оператор преобразования изображения, то L’ (x, y, λ, t) = P {L(x, y, λ, t)} Р{ • } ≠ 1 искажения var ε-областей Энергия светового поля в ε-области: Wε = ∫ ∫ L’ (x, y, λ, t) dx dy dλ dt Δxε Δyε Δλε Δtε

Тема I Макроскопическая дискретность. Микроскопическая дискретность Слайд 4 ε-область – область, внутри которой невозможно определить точку выхода кванта света, но возможно установить только факт его появления. Если Р{ • } - оператор преобразования изображения, то L’ (x, y, λ, t) = P {L(x, y, λ, t)} Р{ • } ≠ 1 искажения var ε-областей Энергия светового поля в ε-области: Wε = ∫ ∫ L’ (x, y, λ, t) dx dy dλ dt Δxε Δyε Δλε Δtε

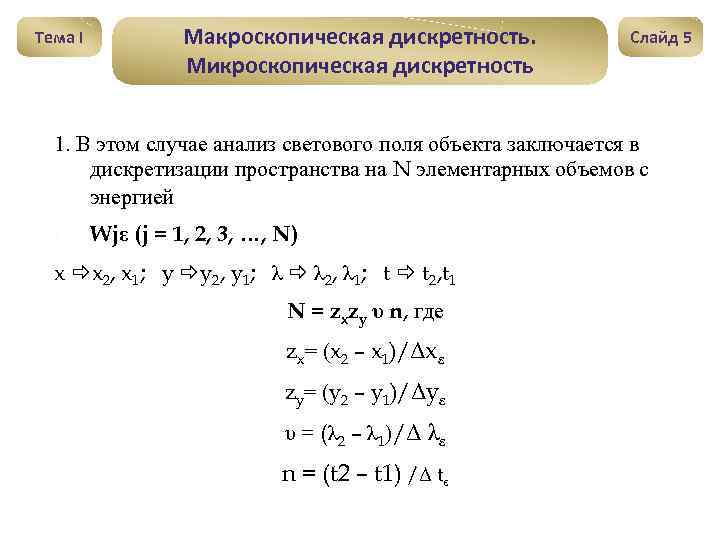

Тема I Макроскопическая дискретность. Микроскопическая дискретность Слайд 5 1. В этом случае анализ светового поля объекта заключается в дискретизации пространства на N элементарных объемов с энергией 1. Wjε (j = 1, 2, 3, …, N) x x 2, x 1; y y 2, y 1; λ λ 2, λ 1; t t 2, t 1 N = zxzy υ n, где zx= (x 2 – x 1)/Δxε zy= (y 2 – y 1)/Δyε υ = (λ 2 – λ 1)/Δ λε n = (t 2 – t 1) /Δ tε

Тема I Макроскопическая дискретность. Микроскопическая дискретность Слайд 5 1. В этом случае анализ светового поля объекта заключается в дискретизации пространства на N элементарных объемов с энергией 1. Wjε (j = 1, 2, 3, …, N) x x 2, x 1; y y 2, y 1; λ λ 2, λ 1; t t 2, t 1 N = zxzy υ n, где zx= (x 2 – x 1)/Δxε zy= (y 2 – y 1)/Δyε υ = (λ 2 – λ 1)/Δ λε n = (t 2 – t 1) /Δ tε

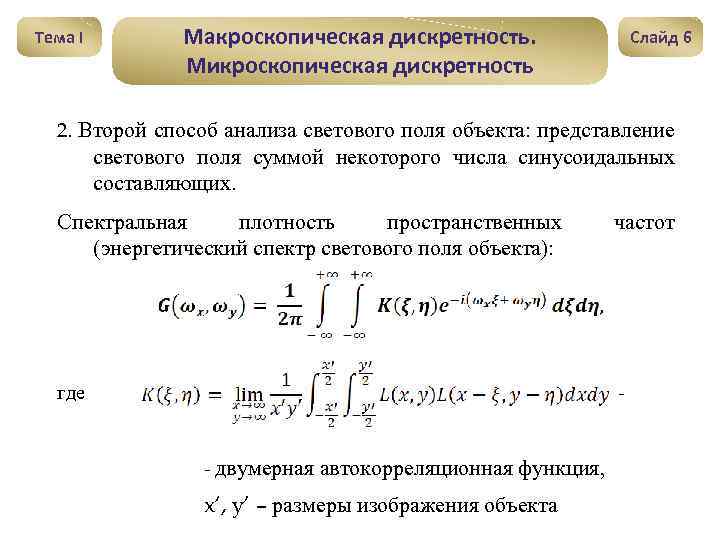

Тема I Макроскопическая дискретность. Микроскопическая дискретность Слайд 6 2. Второй способ анализа светового поля объекта: представление светового поля суммой некоторого числа синусоидальных составляющих. Спектральная плотность пространственных (энергетический спектр светового поля объекта): частот где - - двумерная автокорреляционная функция, x‘, y’ – размеры изображения объекта

Тема I Макроскопическая дискретность. Микроскопическая дискретность Слайд 6 2. Второй способ анализа светового поля объекта: представление светового поля суммой некоторого числа синусоидальных составляющих. Спектральная плотность пространственных (энергетический спектр светового поля объекта): частот где - - двумерная автокорреляционная функция, x‘, y’ – размеры изображения объекта

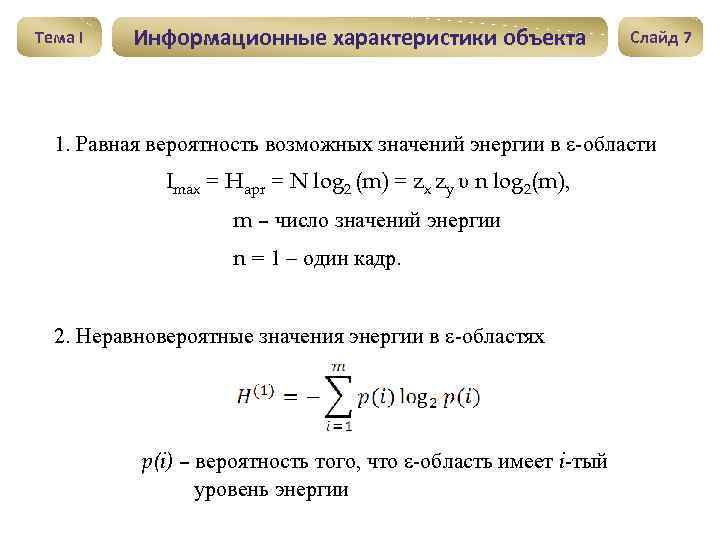

Тема I Информационные характеристики объекта Слайд 7 1. Равная вероятность возможных значений энергии в ε-области Imax = Hapr = N log 2 (m) = zx zy υ n log 2(m), m – число значений энергии n = 1 – один кадр. 2. Неравновероятные значения энергии в ε-областях p(i) – вероятность того, что ε-область имеет i-тый уровень энергии

Тема I Информационные характеристики объекта Слайд 7 1. Равная вероятность возможных значений энергии в ε-области Imax = Hapr = N log 2 (m) = zx zy υ n log 2(m), m – число значений энергии n = 1 – один кадр. 2. Неравновероятные значения энергии в ε-областях p(i) – вероятность того, что ε-область имеет i-тый уровень энергии

Тема I Потери информации в ТВС Источники потерь информации Статистические Апертурные Слайд 8

Тема I Потери информации в ТВС Источники потерь информации Статистические Апертурные Слайд 8

Тема I Общие особенности телевизионных изображений как первичных информационных моделей Слайд 9 1. Определенная условность информации за счет проективных, масштабных и других преобразований в системе. 2. Загрубленность элементов изображения в зависимости от размера ε-областей. 3. Искажения структурного содержания изображения за счет действия шумов. 4. Отсутствие взаимнооднозначного соответствия между элементами изображения и реальных объектов.

Тема I Общие особенности телевизионных изображений как первичных информационных моделей Слайд 9 1. Определенная условность информации за счет проективных, масштабных и других преобразований в системе. 2. Загрубленность элементов изображения в зависимости от размера ε-областей. 3. Искажения структурного содержания изображения за счет действия шумов. 4. Отсутствие взаимнооднозначного соответствия между элементами изображения и реальных объектов.

Тема I Общие особенности телевизионных изображений как первичных информационных моделей Слайд 10 В основе ТВ-передачи лежат следующие физические процессы: § преобразование световой энергии от объекта передачи в электрические сигналы; § передача и прием электрических сигналов; § преобразование электрических сигналов в исходное световое поле объекта. А. Г. Столетов, 1888 – 1890 гг. – внешний фотоэффект А. С. Попов, 1895 г. – беспроволочный телеграф (радио) Б. Л. Розинг, 1907 г. – катодная телескопия

Тема I Общие особенности телевизионных изображений как первичных информационных моделей Слайд 10 В основе ТВ-передачи лежат следующие физические процессы: § преобразование световой энергии от объекта передачи в электрические сигналы; § передача и прием электрических сигналов; § преобразование электрических сигналов в исходное световое поле объекта. А. Г. Столетов, 1888 – 1890 гг. – внешний фотоэффект А. С. Попов, 1895 г. – беспроволочный телеграф (радио) Б. Л. Розинг, 1907 г. – катодная телескопия

Тема I Общие особенности телевизионных изображений как первичных информационных моделей Слайд 11 П. Нипков, 1895 г. – оптико-механическая ТВС А. А. Полумордвинов, 1899 г. – механическая цветная ТВС с последовательной передачей информации о цвете Я. А. Рыфтин, А. А. Чернышов, 1929 г. – оптико-механическая ТВС на 40 строк 01. 10. 1931 – регулярное ТВ-вещание Я. А. Рыфтин, 1934 – электронная ТВС 1938 – опытный Ленинградский ТВ-центр (240 строк, 25 кадров)

Тема I Общие особенности телевизионных изображений как первичных информационных моделей Слайд 11 П. Нипков, 1895 г. – оптико-механическая ТВС А. А. Полумордвинов, 1899 г. – механическая цветная ТВС с последовательной передачей информации о цвете Я. А. Рыфтин, А. А. Чернышов, 1929 г. – оптико-механическая ТВС на 40 строк 01. 10. 1931 – регулярное ТВ-вещание Я. А. Рыфтин, 1934 – электронная ТВС 1938 – опытный Ленинградский ТВ-центр (240 строк, 25 кадров)

Основные принципы построения ТВС Тема I • • Слайд 12 Последовательная передача изображения по элементам (Де-Пайва, 1879 г. , П. И. Бахметьев, 1880 г. ) Точный синхронизм процесса воспроизведения изображения с процессом образования сигналов изображения Принцип алгоритмической избыточности Принцип информационного соответствия Периоды развития ТВС • • • Зарождение идей – 1890 – 1920 гг. Механическое ТВ – 1920 -1935 гг. Электронное черно-белое ТВ – 1936 – 1966 гг. Цветное ТВ – 1967 г. Цифровое ТВ – 1990 г. Телевидение высокой четкости (ТВЧ) – 1992 г.

Основные принципы построения ТВС Тема I • • Слайд 12 Последовательная передача изображения по элементам (Де-Пайва, 1879 г. , П. И. Бахметьев, 1880 г. ) Точный синхронизм процесса воспроизведения изображения с процессом образования сигналов изображения Принцип алгоритмической избыточности Принцип информационного соответствия Периоды развития ТВС • • • Зарождение идей – 1890 – 1920 гг. Механическое ТВ – 1920 -1935 гг. Электронное черно-белое ТВ – 1936 – 1966 гг. Цветное ТВ – 1967 г. Цифровое ТВ – 1990 г. Телевидение высокой четкости (ТВЧ) – 1992 г.

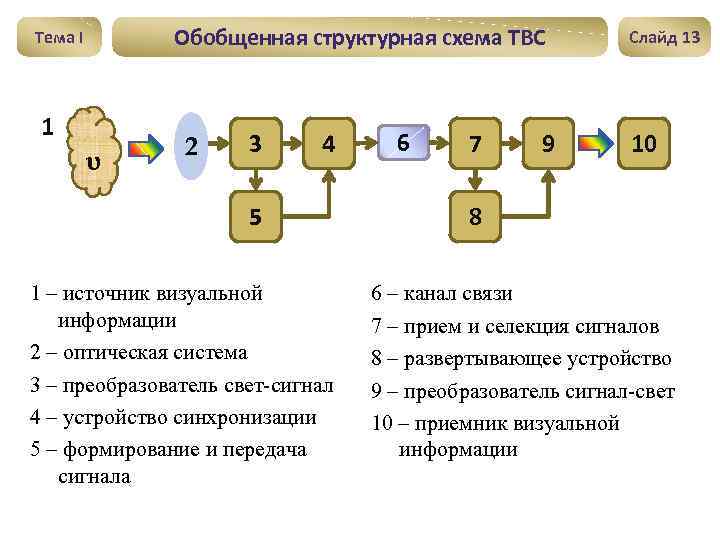

Обобщенная структурная схема ТВС Тема I 1 υ 2 3 4 5 1 – источник визуальной информации 2 – оптическая система 3 – преобразователь свет-сигнал 4 – устройство синхронизации 5 – формирование и передача сигнала 6 7 9 Слайд 13 10 8 6 – канал связи 7 – прием и селекция сигналов 8 – развертывающее устройство 9 – преобразователь сигнал-свет 10 – приемник визуальной информации

Обобщенная структурная схема ТВС Тема I 1 υ 2 3 4 5 1 – источник визуальной информации 2 – оптическая система 3 – преобразователь свет-сигнал 4 – устройство синхронизации 5 – формирование и передача сигнала 6 7 9 Слайд 13 10 8 6 – канал связи 7 – прием и селекция сигналов 8 – развертывающее устройство 9 – преобразователь сигнал-свет 10 – приемник визуальной информации

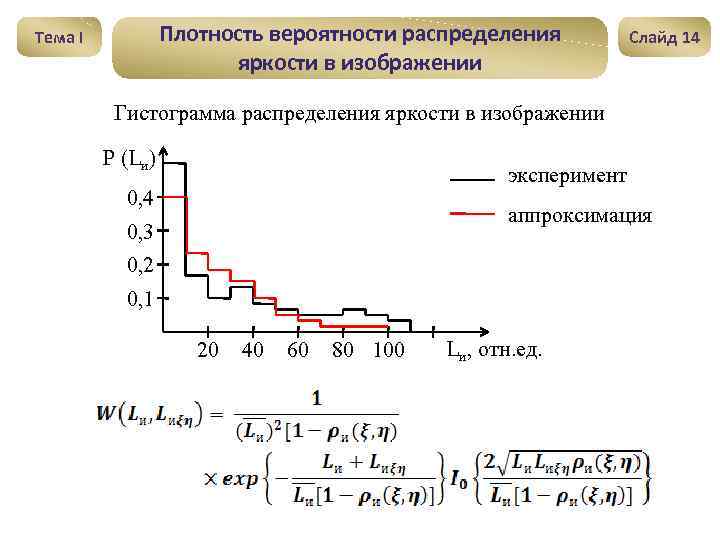

Плотность вероятности распределения яркости в изображении Тема I Слайд 14 Гистограмма распределения яркости в изображении Р (Lи) эксперимент 0, 4 аппроксимация 0, 3 0, 2 0, 1 20 40 60 80 100 Lи, отн. ед.

Плотность вероятности распределения яркости в изображении Тема I Слайд 14 Гистограмма распределения яркости в изображении Р (Lи) эксперимент 0, 4 аппроксимация 0, 3 0, 2 0, 1 20 40 60 80 100 Lи, отн. ед.

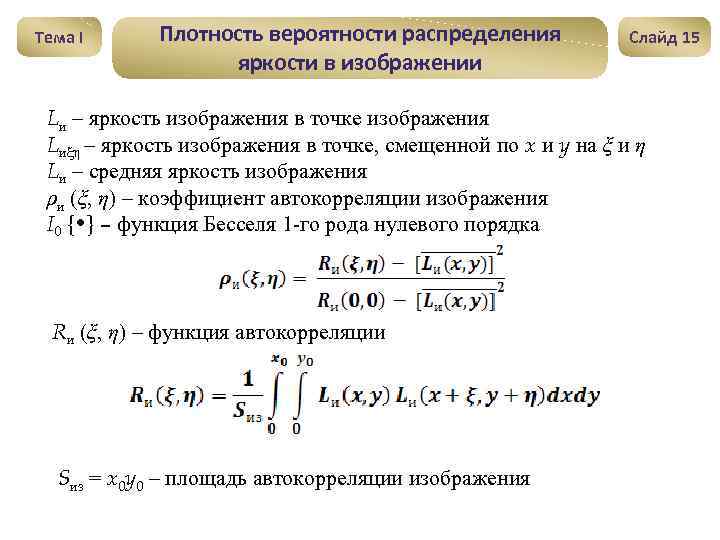

Тема I Плотность вероятности распределения яркости в изображении Слайд 15 Lи – яркость изображения в точке изображения Lиξη – яркость изображения в точке, смещенной по x и y на ξ и η Lи – средняя яркость изображения ρи (ξ, η) – коэффициент автокорреляции изображения I 0 { • } – функция Бесселя 1 -го рода нулевого порядка Rи (ξ, η) – функция автокорреляции Sиз = x 0 y 0 – площадь автокорреляции изображения

Тема I Плотность вероятности распределения яркости в изображении Слайд 15 Lи – яркость изображения в точке изображения Lиξη – яркость изображения в точке, смещенной по x и y на ξ и η Lи – средняя яркость изображения ρи (ξ, η) – коэффициент автокорреляции изображения I 0 { • } – функция Бесселя 1 -го рода нулевого порядка Rи (ξ, η) – функция автокорреляции Sиз = x 0 y 0 – площадь автокорреляции изображения

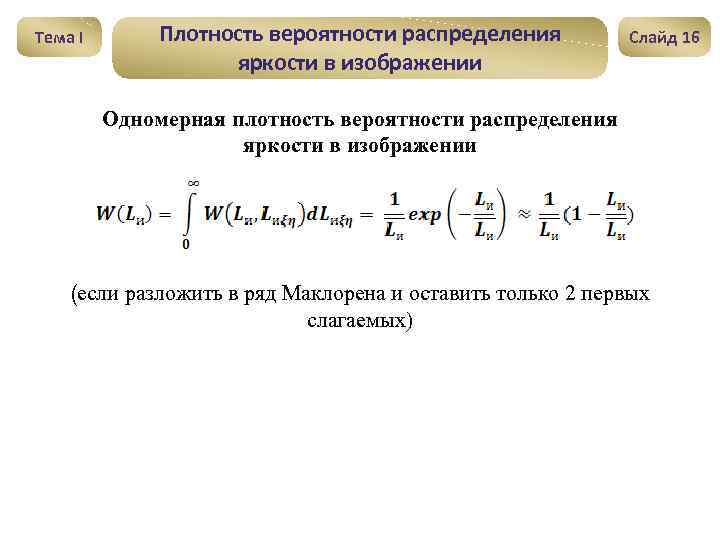

Тема I Плотность вероятности распределения яркости в изображении Слайд 16 Одномерная плотность вероятности распределения яркости в изображении (если разложить в ряд Маклорена и оставить только 2 первых слагаемых)

Тема I Плотность вероятности распределения яркости в изображении Слайд 16 Одномерная плотность вероятности распределения яркости в изображении (если разложить в ряд Маклорена и оставить только 2 первых слагаемых)

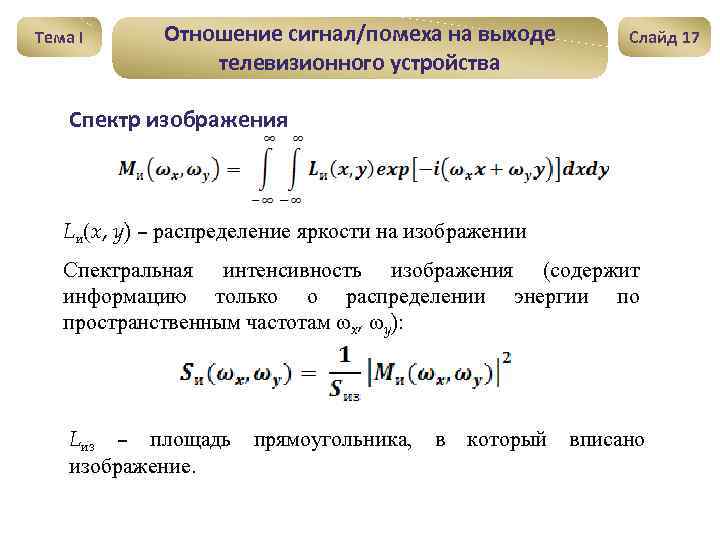

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Слайд 17 Спектр изображения Lи(x, y) – распределение яркости на изображении Спектральная интенсивность изображения (содержит информацию только о распределении энергии по пространственным частотам ωx, ωy): Lиз – площадь изображение. прямоугольника, в который вписано

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Слайд 17 Спектр изображения Lи(x, y) – распределение яркости на изображении Спектральная интенсивность изображения (содержит информацию только о распределении энергии по пространственным частотам ωx, ωy): Lиз – площадь изображение. прямоугольника, в который вписано

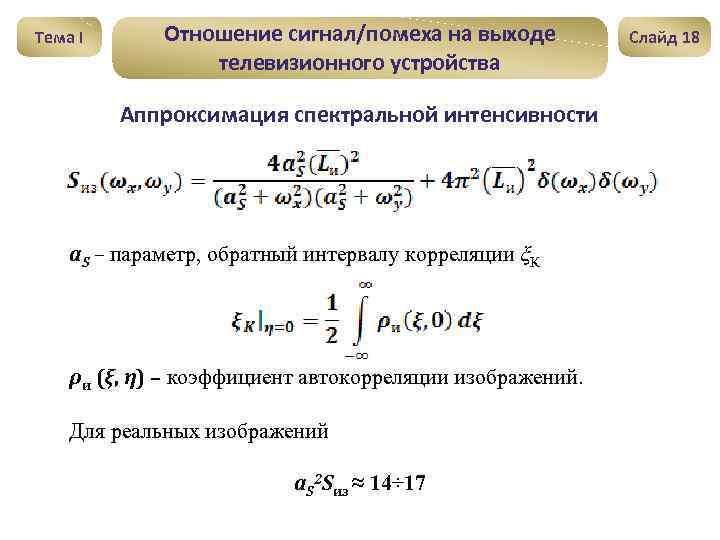

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Аппроксимация спектральной интенсивности a. S – параметр, обратный интервалу корреляции ξК ρи (ξ, η) – коэффициент автокорреляции изображений. Для реальных изображений a. S 2 Sиз ≈ 14÷ 17 Слайд 18

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Аппроксимация спектральной интенсивности a. S – параметр, обратный интервалу корреляции ξК ρи (ξ, η) – коэффициент автокорреляции изображений. Для реальных изображений a. S 2 Sиз ≈ 14÷ 17 Слайд 18

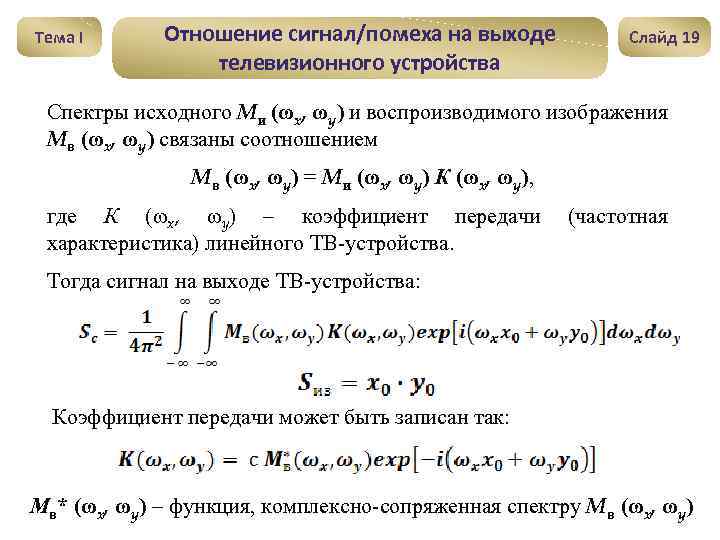

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Слайд 19 Спектры исходного Mи (ωx, ωy) и воспроизводимого изображения Mв (ωx, ωy) связаны соотношением Mв (ωx, ωy) = Mи (ωx, ωy) К (ωx, ωy), где К (ωx, ωy) – коэффициент передачи характеристика) линейного ТВ-устройства. (частотная Тогда сигнал на выходе ТВ-устройства: Коэффициент передачи может быть записан так: Мв* (ωx, ωy) – функция, комплексно-сопряженная спектру Mв (ωx, ωy)

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Слайд 19 Спектры исходного Mи (ωx, ωy) и воспроизводимого изображения Mв (ωx, ωy) связаны соотношением Mв (ωx, ωy) = Mи (ωx, ωy) К (ωx, ωy), где К (ωx, ωy) – коэффициент передачи характеристика) линейного ТВ-устройства. (частотная Тогда сигнал на выходе ТВ-устройства: Коэффициент передачи может быть записан так: Мв* (ωx, ωy) – функция, комплексно-сопряженная спектру Mв (ωx, ωy)

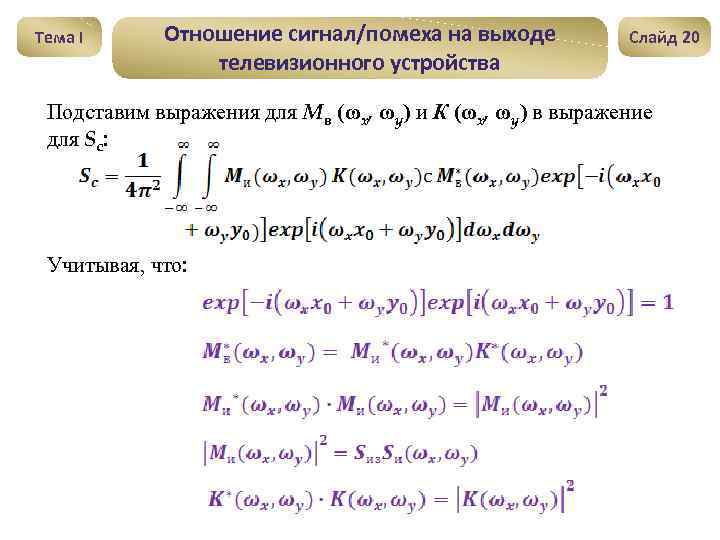

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Слайд 20 Подставим выражения для Mв (ωx, ωy) и К (ωx, ωy) в выражение для Sc: Учитывая, что:

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Слайд 20 Подставим выражения для Mв (ωx, ωy) и К (ωx, ωy) в выражение для Sc: Учитывая, что:

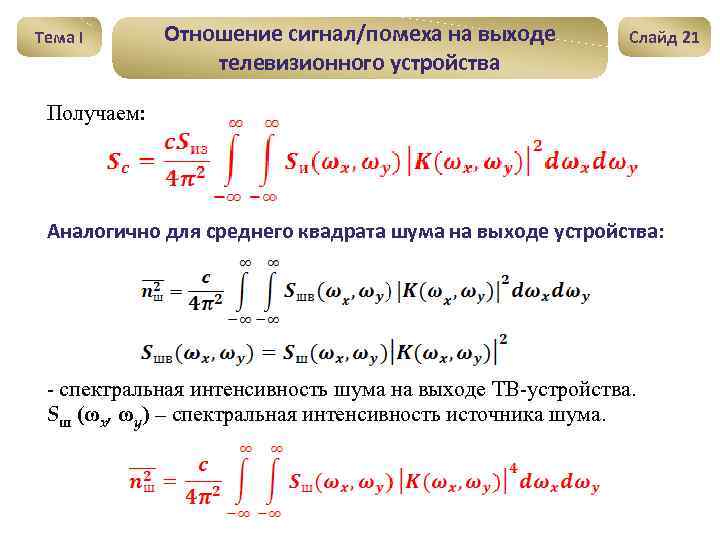

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Слайд 21 Получаем: Аналогично для среднего квадрата шума на выходе устройства: - спектральная интенсивность шума на выходе ТВ-устройства. Sш (ωx, ωy) – спектральная интенсивность источника шума.

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Слайд 21 Получаем: Аналогично для среднего квадрата шума на выходе устройства: - спектральная интенсивность шума на выходе ТВ-устройства. Sш (ωx, ωy) – спектральная интенсивность источника шума.

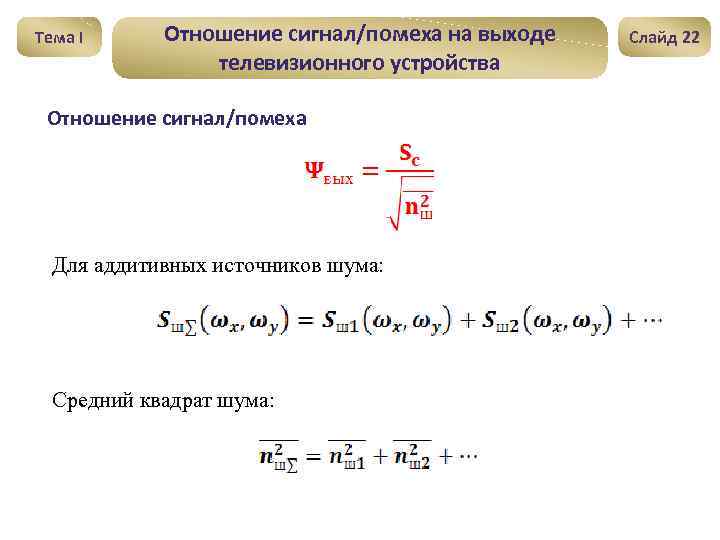

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Отношение сигнал/помеха Для аддитивных источников шума: Средний квадрат шума: Слайд 22

Тема I Отношение сигнал/помеха на выходе телевизионного устройства Отношение сигнал/помеха Для аддитивных источников шума: Средний квадрат шума: Слайд 22

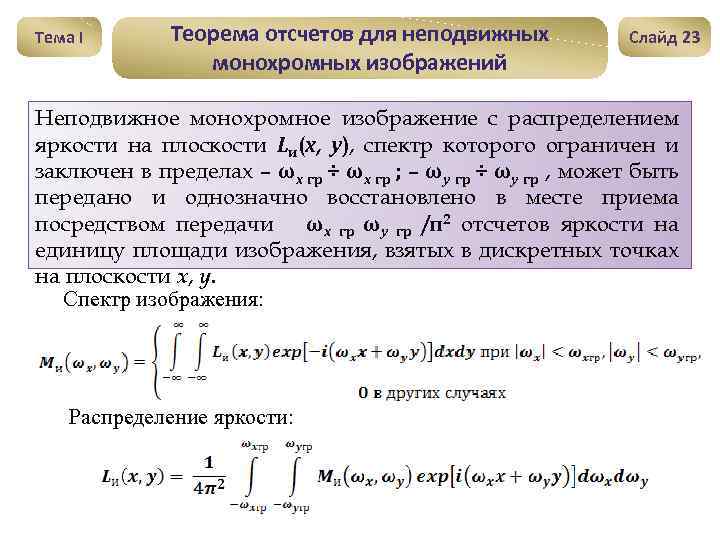

Тема I Теорема отсчетов для неподвижных монохромных изображений Слайд 23 Неподвижное монохромное изображение с распределением яркости на плоскости Lи(x, y), спектр которого ограничен и заключен в пределах – ωx гр ÷ ωx гр ; – ωy гр ÷ ωy гр , может быть передано и однозначно восстановлено в месте приема посредством передачи ωx гр ωy гр /π2 отсчетов яркости на единицу площади изображения, взятых в дискретных точках на плоскости x, y. Спектр изображения: Распределение яркости:

Тема I Теорема отсчетов для неподвижных монохромных изображений Слайд 23 Неподвижное монохромное изображение с распределением яркости на плоскости Lи(x, y), спектр которого ограничен и заключен в пределах – ωx гр ÷ ωx гр ; – ωy гр ÷ ωy гр , может быть передано и однозначно восстановлено в месте приема посредством передачи ωx гр ωy гр /π2 отсчетов яркости на единицу площади изображения, взятых в дискретных точках на плоскости x, y. Спектр изображения: Распределение яркости:

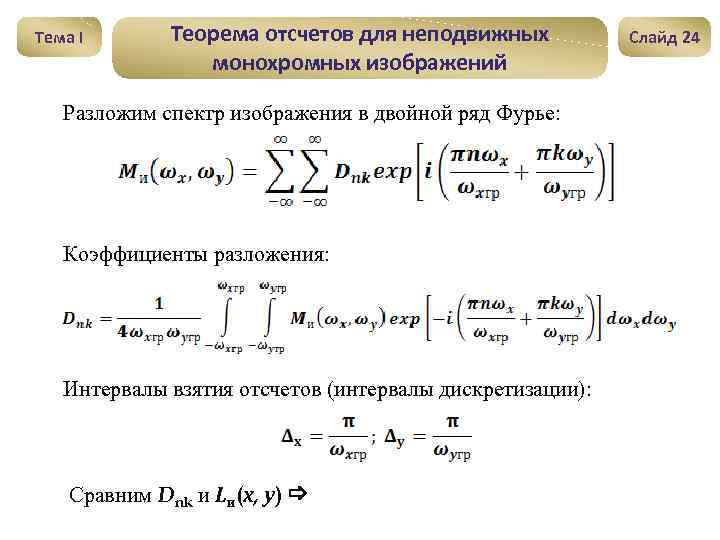

Тема I Теорема отсчетов для неподвижных монохромных изображений Разложим спектр изображения в двойной ряд Фурье: Коэффициенты разложения: Интервалы взятия отсчетов (интервалы дискретизации): Сравним Dnk и Lи(x, y) Слайд 24

Тема I Теорема отсчетов для неподвижных монохромных изображений Разложим спектр изображения в двойной ряд Фурье: Коэффициенты разложения: Интервалы взятия отсчетов (интервалы дискретизации): Сравним Dnk и Lи(x, y) Слайд 24

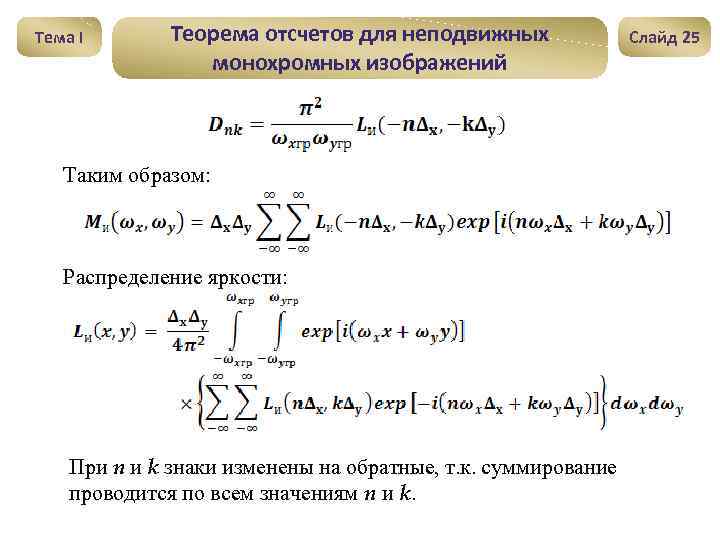

Тема I Теорема отсчетов для неподвижных монохромных изображений Таким образом: Распределение яркости: При n и k знаки изменены на обратные, т. к. суммирование проводится по всем значениям n и k. Слайд 25

Тема I Теорема отсчетов для неподвижных монохромных изображений Таким образом: Распределение яркости: При n и k знаки изменены на обратные, т. к. суммирование проводится по всем значениям n и k. Слайд 25

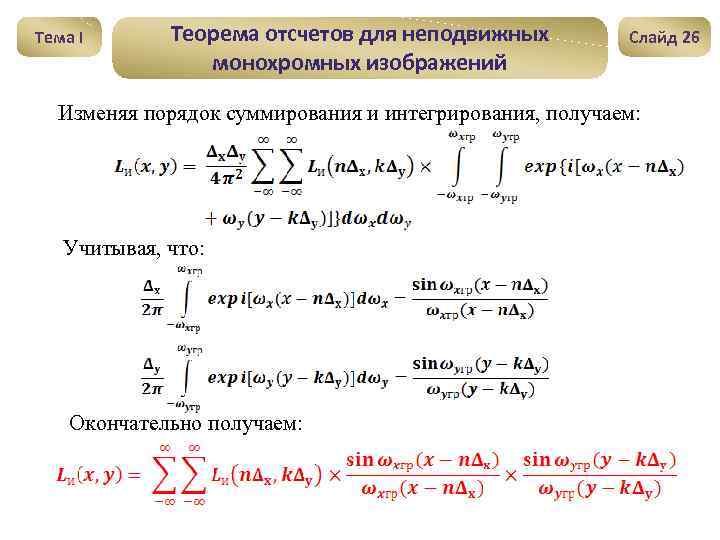

Тема I Теорема отсчетов для неподвижных монохромных изображений Слайд 26 Изменяя порядок суммирования и интегрирования, получаем: Учитывая, что: Окончательно получаем:

Тема I Теорема отсчетов для неподвижных монохромных изображений Слайд 26 Изменяя порядок суммирования и интегрирования, получаем: Учитывая, что: Окончательно получаем:

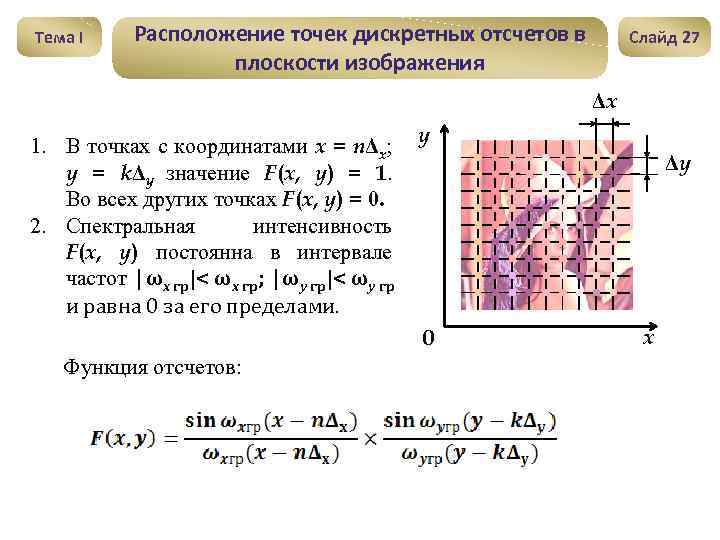

Тема I Расположение точек дискретных отсчетов в плоскости изображения Слайд 27 Δx 1. В точках с координатами x = nΔx; y = kΔy значение F(x, y) = 1. Во всех других точках F(x, y) = 0. 2. Спектральная интенсивность F(x, y) постоянна в интервале частот |ωx гр|< ωx гр; |ωy гр|< ωy гр и равна 0 за его пределами. y Δy 0 Функция отсчетов: x

Тема I Расположение точек дискретных отсчетов в плоскости изображения Слайд 27 Δx 1. В точках с координатами x = nΔx; y = kΔy значение F(x, y) = 1. Во всех других точках F(x, y) = 0. 2. Спектральная интенсивность F(x, y) постоянна в интервале частот |ωx гр|< ωx гр; |ωy гр|< ωy гр и равна 0 за его пределами. y Δy 0 Функция отсчетов: x

Тема II Особенности восприятия информационных полей и процесс принятия решений оператором-пользователем

Тема II Особенности восприятия информационных полей и процесс принятия решений оператором-пользователем

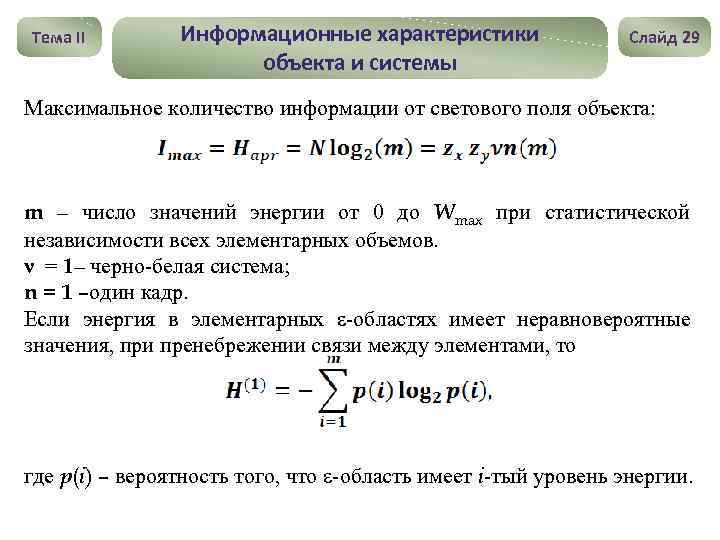

Тема II Информационные характеристики объекта и системы Слайд 29 Максимальное количество информации от светового поля объекта: m – число значений энергии от 0 до Wmax при статистической независимости всех элементарных объемов. ν = 1– черно-белая система; n = 1 –один кадр. Если энергия в элементарных ε-областях имеет неравновероятные значения, при пренебрежении связи между элементами, то где p(i) – вероятность того, что ε-область имеет i-тый уровень энергии.

Тема II Информационные характеристики объекта и системы Слайд 29 Максимальное количество информации от светового поля объекта: m – число значений энергии от 0 до Wmax при статистической независимости всех элементарных объемов. ν = 1– черно-белая система; n = 1 –один кадр. Если энергия в элементарных ε-областях имеет неравновероятные значения, при пренебрежении связи между элементами, то где p(i) – вероятность того, что ε-область имеет i-тый уровень энергии.

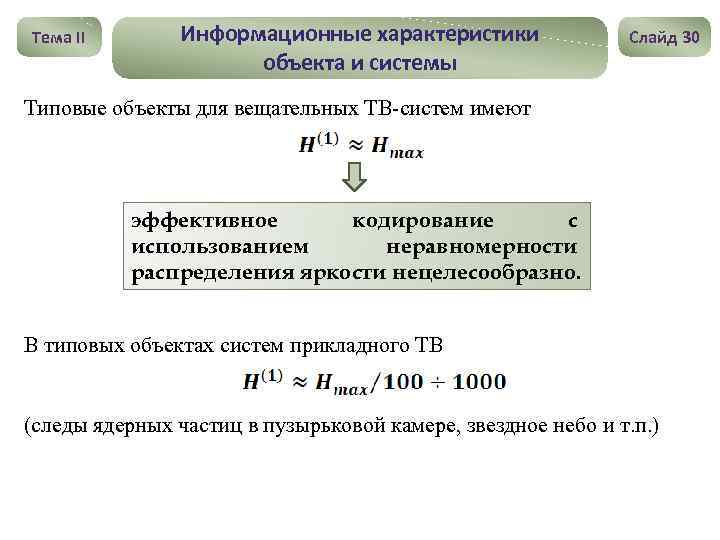

Тема II Информационные характеристики объекта и системы Слайд 30 Типовые объекты для вещательных ТВ-систем имеют эффективное кодирование с использованием неравномерности распределения яркости нецелесообразно. В типовых объектах систем прикладного ТВ (следы ядерных частиц в пузырьковой камере, звездное небо и т. п. )

Тема II Информационные характеристики объекта и системы Слайд 30 Типовые объекты для вещательных ТВ-систем имеют эффективное кодирование с использованием неравномерности распределения яркости нецелесообразно. В типовых объектах систем прикладного ТВ (следы ядерных частиц в пузырьковой камере, звездное небо и т. п. )

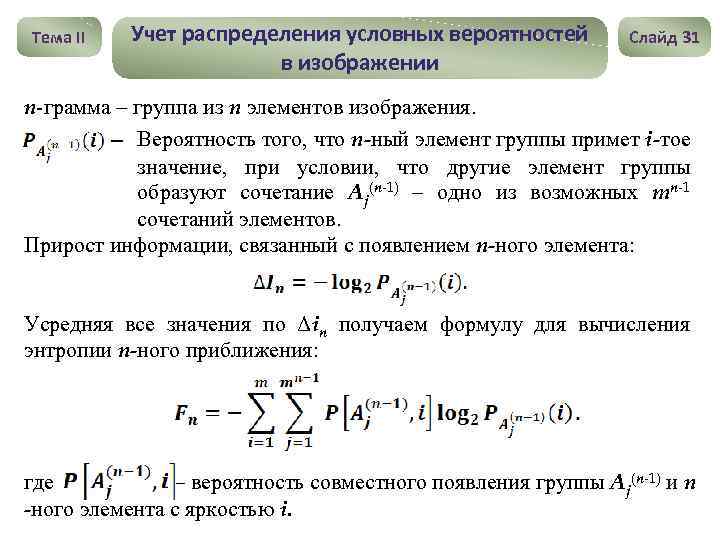

Тема II Учет распределения условных вероятностей в изображении Слайд 31 n-грамма – группа из n элементов изображения. Вероятность того, что n-ный элемент группы примет i-тое значение, при условии, что другие элемент группы образуют сочетание Aj(n-1) – одно из возможных mn-1 сочетаний элементов. Прирост информации, связанный с появлением n-ного элемента: Усредняя все значения по Δin получаем формулу для вычисления энтропии n-ного приближения: где – вероятность совместного появления группы Aj(n-1) и n -ного элемента с яркостью i.

Тема II Учет распределения условных вероятностей в изображении Слайд 31 n-грамма – группа из n элементов изображения. Вероятность того, что n-ный элемент группы примет i-тое значение, при условии, что другие элемент группы образуют сочетание Aj(n-1) – одно из возможных mn-1 сочетаний элементов. Прирост информации, связанный с появлением n-ного элемента: Усредняя все значения по Δin получаем формулу для вычисления энтропии n-ного приближения: где – вероятность совместного появления группы Aj(n-1) и n -ного элемента с яркостью i.

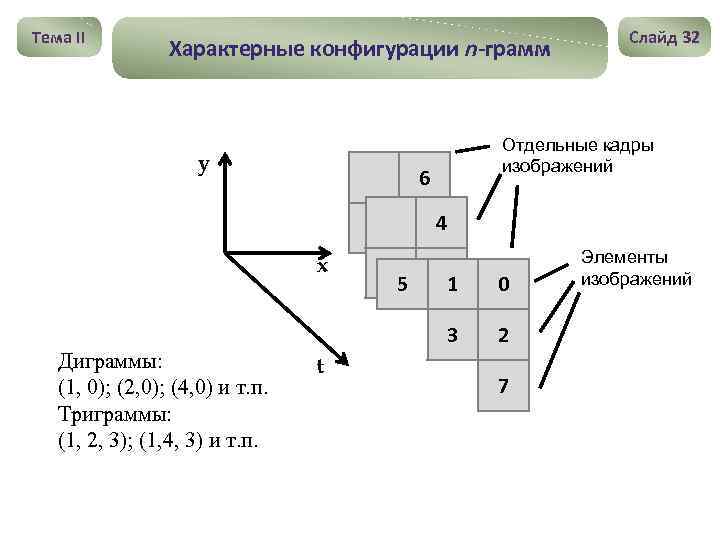

Тема II Характерные конфигурации n-грамм y Слайд 32 Отдельные кадры изображений 6 4 x t 1 0 3 Диграммы: (1, 0); (2, 0); (4, 0) и т. п. Триграммы: (1, 2, 3); (1, 4, 3) и т. п. 5 2 7 Элементы изображений

Тема II Характерные конфигурации n-грамм y Слайд 32 Отдельные кадры изображений 6 4 x t 1 0 3 Диграммы: (1, 0); (2, 0); (4, 0) и т. п. Триграммы: (1, 2, 3); (1, 4, 3) и т. п. 5 2 7 Элементы изображений

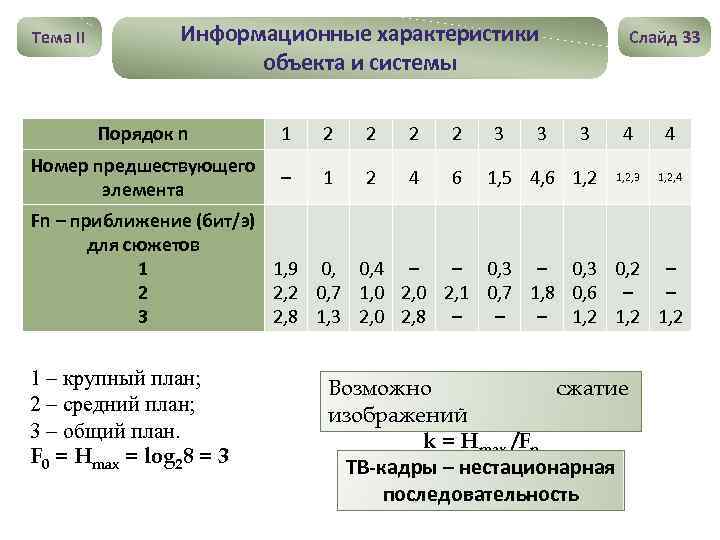

Тема II Информационные характеристики объекта и системы Порядок n 1 2 2 Номер предшествующего элемента – 1 2 4 6 3 3 Слайд 33 3 1, 5 4, 6 1, 2 4 4 1, 2, 3 1, 2, 4 Fn – приближение (бит/э) для сюжетов 1 1, 9 0, 0, 4 – – 0, 3 0, 2 – 2 2, 2 0, 7 1, 0 2, 1 0, 7 1, 8 0, 6 – – 3 2, 8 1, 3 2, 0 2, 8 – – – 1, 2 1 – крупный план; 2 – средний план; 3 – общий план. F 0 = Hmax = log 28 = 3 Возможно сжатие изображений k = Hmax /Fn ТВ-кадры – нестационарная последовательность

Тема II Информационные характеристики объекта и системы Порядок n 1 2 2 Номер предшествующего элемента – 1 2 4 6 3 3 Слайд 33 3 1, 5 4, 6 1, 2 4 4 1, 2, 3 1, 2, 4 Fn – приближение (бит/э) для сюжетов 1 1, 9 0, 0, 4 – – 0, 3 0, 2 – 2 2, 2 0, 7 1, 0 2, 1 0, 7 1, 8 0, 6 – – 3 2, 8 1, 3 2, 0 2, 8 – – – 1, 2 1 – крупный план; 2 – средний план; 3 – общий план. F 0 = Hmax = log 28 = 3 Возможно сжатие изображений k = Hmax /Fn ТВ-кадры – нестационарная последовательность

Тема II Особенности зрительного восприятия изображений и процесса принятия решений оператором Слайд 34 Функционирование зрительной системы при восприятии информации 1 Особенности деятельности оператора принятии решения на основе первичных информационных моделей (сенсорноинтеллектуальная деятельность эвристического типа) 1. Опосредованный характер отражения элементов реальных объектов; 2. Последовательное решение иерархической многоуровневой задачи; 3. Циклический характер перцептивно-опознавательных процессов информационного поиска; 4. Высокая значимость точностных параметров при опознавании объектов и выполнении операции принятия решений; 5. Значительный уровень психической напряженности, связанной с ответственностью принятии решений.

Тема II Особенности зрительного восприятия изображений и процесса принятия решений оператором Слайд 34 Функционирование зрительной системы при восприятии информации 1 Особенности деятельности оператора принятии решения на основе первичных информационных моделей (сенсорноинтеллектуальная деятельность эвристического типа) 1. Опосредованный характер отражения элементов реальных объектов; 2. Последовательное решение иерархической многоуровневой задачи; 3. Циклический характер перцептивно-опознавательных процессов информационного поиска; 4. Высокая значимость точностных параметров при опознавании объектов и выполнении операции принятия решений; 5. Значительный уровень психической напряженности, связанной с ответственностью принятии решений.

Тема II Структурная теория восприятия информационных моделей Основные принципы • Активность и избирательность информационных моделей; отражения • Иерархическая обработка информации и ее последовательное перекодирование; • Структурно-элементный анализ воспринимаемых моделей; • Модель определяет перцептивно-опознавательный процесс. Слайд 35

Тема II Структурная теория восприятия информационных моделей Основные принципы • Активность и избирательность информационных моделей; отражения • Иерархическая обработка информации и ее последовательное перекодирование; • Структурно-элементный анализ воспринимаемых моделей; • Модель определяет перцептивно-опознавательный процесс. Слайд 35

Тема II Общая схема восприятия информационной модели и принятия решения Объект Эталонный образ Стимул Информационная модель Слайд 36 Принятие решения Обнаружение Различение Идентификация Декодирование Итоговый образ Оценка и учет априорной информации

Тема II Общая схема восприятия информационной модели и принятия решения Объект Эталонный образ Стимул Информационная модель Слайд 36 Принятие решения Обнаружение Различение Идентификация Декодирование Итоговый образ Оценка и учет априорной информации

Тема II Качество телевизионного изображения • Тождественное воспроизведение; • Физически точное воспроизведение; • Физиологически точное воспроизведение; • Психологически точное воспроизведение; • Визуализация; • Виртуальная реальность. Слайд 37

Тема II Качество телевизионного изображения • Тождественное воспроизведение; • Физически точное воспроизведение; • Физиологически точное воспроизведение; • Психологически точное воспроизведение; • Визуализация; • Виртуальная реальность. Слайд 37

Тема II Психометрические методы субъективной оценки качества изображений 1. Метод эквивалентности (уравнивание качества двух изображений). 2. Метод сравнения (сопоставление качества двух изображений). 3. Метод различения (определение абсолютного или разностного порога заметности искажений). 4. Метод оценок (оценка качества изображения в баллах по определенной шкале). 5. Метод определения сенсорных функций (определение интенсивности ощущений от варьируемого стимула в долях стандартного). Слайд 38

Тема II Психометрические методы субъективной оценки качества изображений 1. Метод эквивалентности (уравнивание качества двух изображений). 2. Метод сравнения (сопоставление качества двух изображений). 3. Метод различения (определение абсолютного или разностного порога заметности искажений). 4. Метод оценок (оценка качества изображения в баллах по определенной шкале). 5. Метод определения сенсорных функций (определение интенсивности ощущений от варьируемого стимула в долях стандартного). Слайд 38

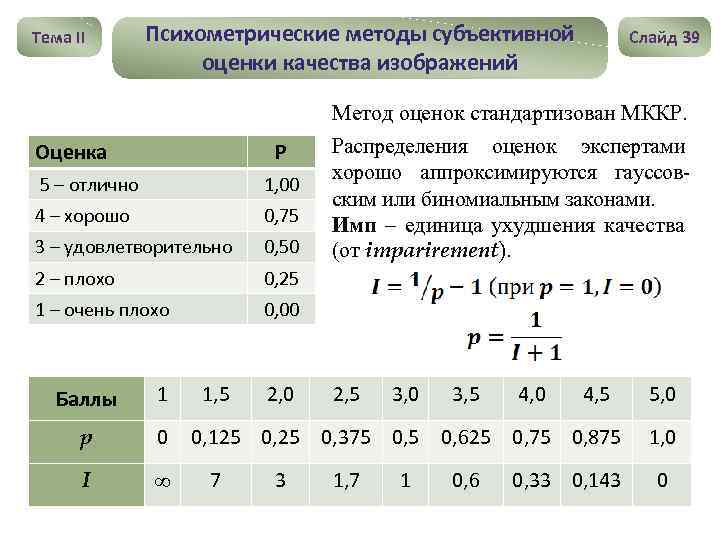

Тема II Психометрические методы субъективной оценки качества изображений Оценка Р 5 – отлично 1, 00 4 – хорошо 0, 75 3 – удовлетворительно 0, 50 2 – плохо Метод оценок стандартизован МККР. Распределения оценок экспертами хорошо аппроксимируются гауссовским или биномиальным законами. Имп – единица ухудшения качества (от imparirement). 0, 25 1 – очень плохо Слайд 39 0, 00 Баллы 1 p 0 I 1, 5 2, 0 2, 5 3, 0 3, 5 4, 0 4, 5 0, 125 0, 375 0, 625 0, 75 0, 875 7 3 1, 7 1 0, 6 0, 33 0, 143 5, 0 1, 0 0

Тема II Психометрические методы субъективной оценки качества изображений Оценка Р 5 – отлично 1, 00 4 – хорошо 0, 75 3 – удовлетворительно 0, 50 2 – плохо Метод оценок стандартизован МККР. Распределения оценок экспертами хорошо аппроксимируются гауссовским или биномиальным законами. Имп – единица ухудшения качества (от imparirement). 0, 25 1 – очень плохо Слайд 39 0, 00 Баллы 1 p 0 I 1, 5 2, 0 2, 5 3, 0 3, 5 4, 0 4, 5 0, 125 0, 375 0, 625 0, 75 0, 875 7 3 1, 7 1 0, 6 0, 33 0, 143 5, 0 1, 0 0

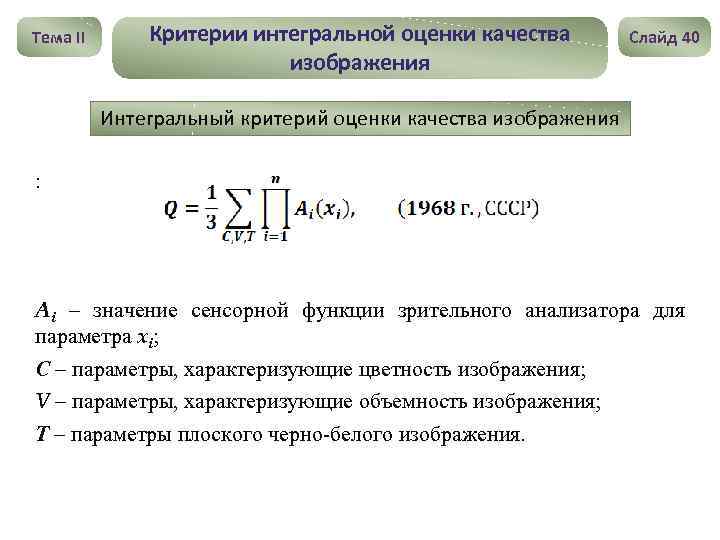

Тема II Критерии интегральной оценки качества изображения Слайд 40 Интегральный критерий оценки качества изображения : Ai – значение сенсорной функции зрительного анализатора для параметра xi; С – параметры, характеризующие цветность изображения; V – параметры, характеризующие объемность изображения; Т – параметры плоского черно-белого изображения.

Тема II Критерии интегральной оценки качества изображения Слайд 40 Интегральный критерий оценки качества изображения : Ai – значение сенсорной функции зрительного анализатора для параметра xi; С – параметры, характеризующие цветность изображения; V – параметры, характеризующие объемность изображения; Т – параметры плоского черно-белого изображения.

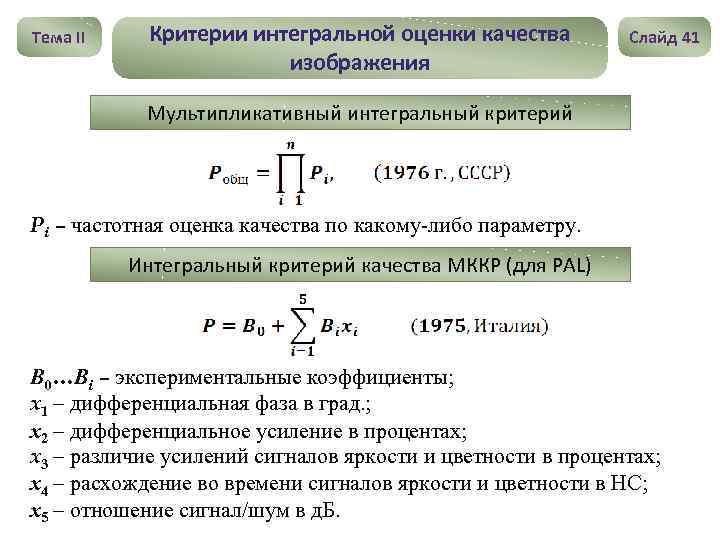

Тема II Критерии интегральной оценки качества изображения Слайд 41 Мультипликативный интегральный критерий Pi – частотная оценка качества по какому-либо параметру. Интегральный критерий качества МККР (для PAL) В 0…Вi – экспериментальные коэффициенты; x 1 – дифференциальная фаза в град. ; х2 – дифференциальное усиление в процентах; x 3 – различие усилений сигналов яркости и цветности в процентах; х4 – расхождение во времени сигналов яркости и цветности в НС; х5 – отношение сигнал/шум в д. Б.

Тема II Критерии интегральной оценки качества изображения Слайд 41 Мультипликативный интегральный критерий Pi – частотная оценка качества по какому-либо параметру. Интегральный критерий качества МККР (для PAL) В 0…Вi – экспериментальные коэффициенты; x 1 – дифференциальная фаза в град. ; х2 – дифференциальное усиление в процентах; x 3 – различие усилений сигналов яркости и цветности в процентах; х4 – расхождение во времени сигналов яркости и цветности в НС; х5 – отношение сигнал/шум в д. Б.

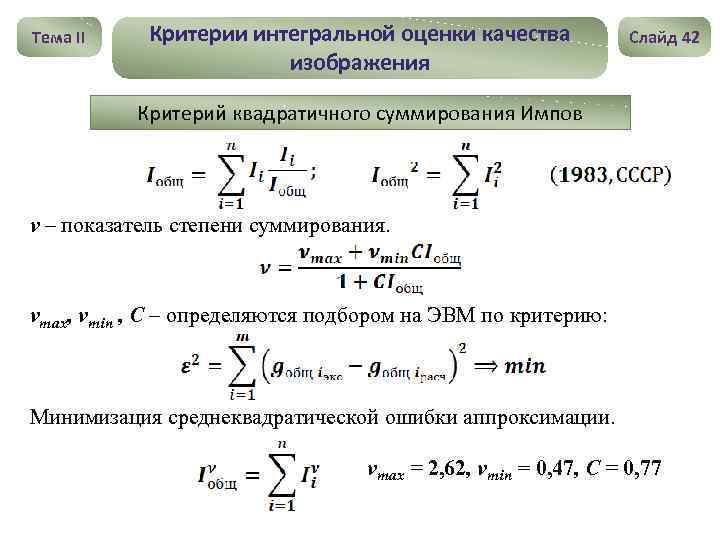

Тема II Критерии интегральной оценки качества изображения Слайд 42 Критерий квадратичного суммирования Импов ν – показатель степени суммирования. νmax, νmin , С – определяются подбором на ЭВМ по критерию: Минимизация среднеквадратической ошибки аппроксимации. νmax = 2, 62, νmin = 0, 47, С = 0, 77

Тема II Критерии интегральной оценки качества изображения Слайд 42 Критерий квадратичного суммирования Импов ν – показатель степени суммирования. νmax, νmin , С – определяются подбором на ЭВМ по критерию: Минимизация среднеквадратической ошибки аппроксимации. νmax = 2, 62, νmin = 0, 47, С = 0, 77

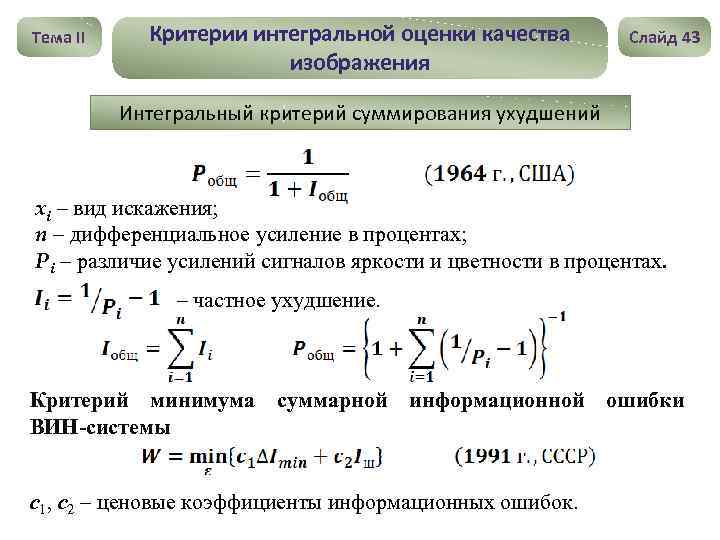

Тема II Критерии интегральной оценки качества изображения Слайд 43 Интегральный критерий суммирования ухудшений xi – вид искажения; n – дифференциальное усиление в процентах; Pi – различие усилений сигналов яркости и цветности в процентах. – частное ухудшение. Критерий минимума суммарной информационной ошибки ВИН-системы с1, с2 – ценовые коэффициенты информационных ошибок.

Тема II Критерии интегральной оценки качества изображения Слайд 43 Интегральный критерий суммирования ухудшений xi – вид искажения; n – дифференциальное усиление в процентах; Pi – различие усилений сигналов яркости и цветности в процентах. – частное ухудшение. Критерий минимума суммарной информационной ошибки ВИН-системы с1, с2 – ценовые коэффициенты информационных ошибок.

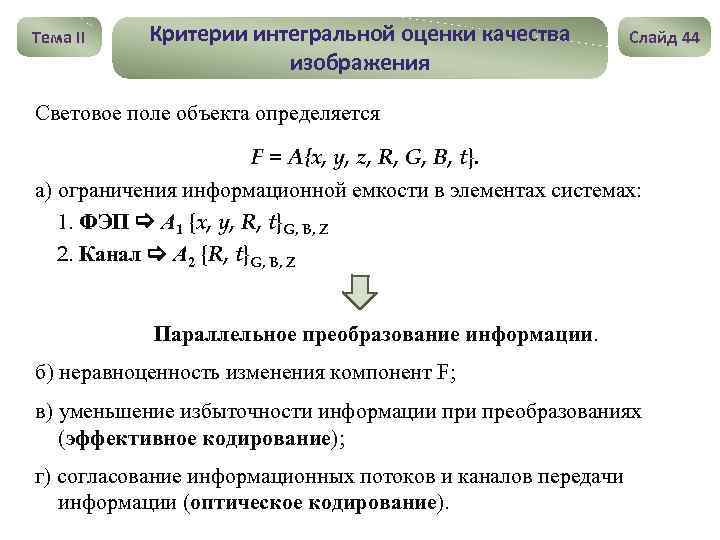

Тема II Критерии интегральной оценки качества изображения Слайд 44 Световое поле объекта определяется F = A{x, y, z, R, G, B, t}. а) ограничения информационной емкости в элементах системах: 1. ФЭП А 1 {x, y, R, t}G, B, Z 2. Канал А 2 {R, t}G, B, Z Параллельное преобразование информации. б) неравноценность изменения компонент F; в) уменьшение избыточности информации преобразованиях (эффективное кодирование); г) согласование информационных потоков и каналов передачи информации (оптическое кодирование).

Тема II Критерии интегральной оценки качества изображения Слайд 44 Световое поле объекта определяется F = A{x, y, z, R, G, B, t}. а) ограничения информационной емкости в элементах системах: 1. ФЭП А 1 {x, y, R, t}G, B, Z 2. Канал А 2 {R, t}G, B, Z Параллельное преобразование информации. б) неравноценность изменения компонент F; в) уменьшение избыточности информации преобразованиях (эффективное кодирование); г) согласование информационных потоков и каналов передачи информации (оптическое кодирование).

Тема III Принципы построения оптимальных видеоинформационных систем

Тема III Принципы построения оптимальных видеоинформационных систем

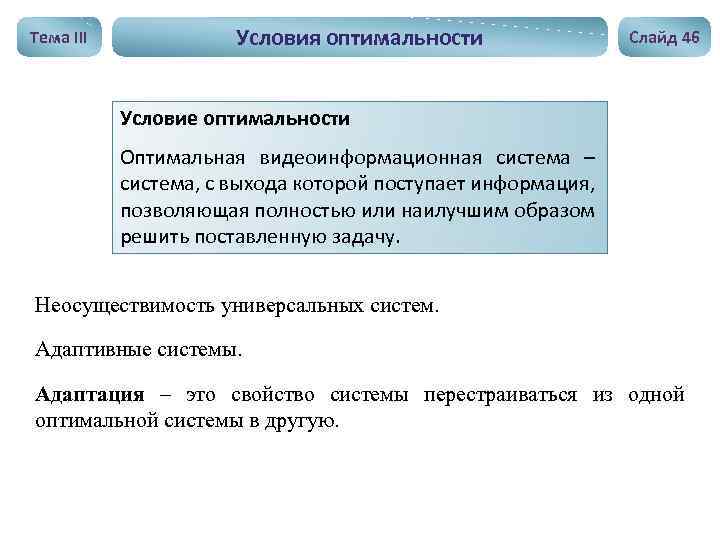

Тема III Условия оптимальности Слайд 46 Условие оптимальности Оптимальная видеоинформационная система – система, с выхода которой поступает информация, позволяющая полностью или наилучшим образом решить поставленную задачу. Неосуществимость универсальных систем. Адаптивные системы. Адаптация – это свойство системы перестраиваться из одной оптимальной системы в другую.

Тема III Условия оптимальности Слайд 46 Условие оптимальности Оптимальная видеоинформационная система – система, с выхода которой поступает информация, позволяющая полностью или наилучшим образом решить поставленную задачу. Неосуществимость универсальных систем. Адаптивные системы. Адаптация – это свойство системы перестраиваться из одной оптимальной системы в другую.

Тема III Условия оптимальности Слайд 47 Условия оптимальности ВИН-систем 1. Максимальная при заданных ограничениях информационная емкость. Сведение потерь информации к минимуму. 2. Минимальная информационная избыточность. Передача минимального количества информации, не способствующего решению поставленной задачи. 3. Минимальные затраты технических средств при обеспечении надежности.

Тема III Условия оптимальности Слайд 47 Условия оптимальности ВИН-систем 1. Максимальная при заданных ограничениях информационная емкость. Сведение потерь информации к минимуму. 2. Минимальная информационная избыточность. Передача минимального количества информации, не способствующего решению поставленной задачи. 3. Минимальные затраты технических средств при обеспечении надежности.

Тема III Характеристика информации перед принятием решения Слайд 48 1. Минимальные угловые или линейные размеры детали, различаемой на объекте в направлении x, y; 2. Число пространственных элементов, охватываемых системой; 3. Минимальный интервал времени, различаемый в системе; 4. Количество спектральных интервалов и их размеры; 5. Число градаций, различимое на всем динамическом диапазоне передаточной характеристики системы; 6. Минимальная величина входной световой энергии, позволяющая принять правильное решение; 7. Вид выходных данных (для оператора, для видеопроцессора).

Тема III Характеристика информации перед принятием решения Слайд 48 1. Минимальные угловые или линейные размеры детали, различаемой на объекте в направлении x, y; 2. Число пространственных элементов, охватываемых системой; 3. Минимальный интервал времени, различаемый в системе; 4. Количество спектральных интервалов и их размеры; 5. Число градаций, различимое на всем динамическом диапазоне передаточной характеристики системы; 6. Минимальная величина входной световой энергии, позволяющая принять правильное решение; 7. Вид выходных данных (для оператора, для видеопроцессора).

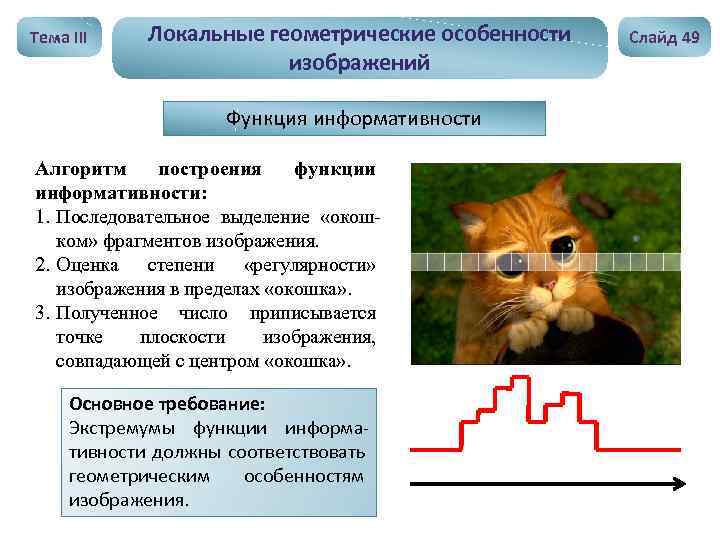

Тема III Локальные геометрические особенности изображений Функция информативности Алгоритм построения функции информативности: 1. Последовательное выделение «окошком» фрагментов изображения. 2. Оценка степени «регулярности» изображения в пределах «окошка» . 3. Полученное число приписывается точке плоскости изображения, совпадающей с центром «окошка» . Основное требование: Экстремумы функции информативности должны соответствовать геометрическим особенностям изображения. Слайд 49

Тема III Локальные геометрические особенности изображений Функция информативности Алгоритм построения функции информативности: 1. Последовательное выделение «окошком» фрагментов изображения. 2. Оценка степени «регулярности» изображения в пределах «окошка» . 3. Полученное число приписывается точке плоскости изображения, совпадающей с центром «окошка» . Основное требование: Экстремумы функции информативности должны соответствовать геометрическим особенностям изображения. Слайд 49

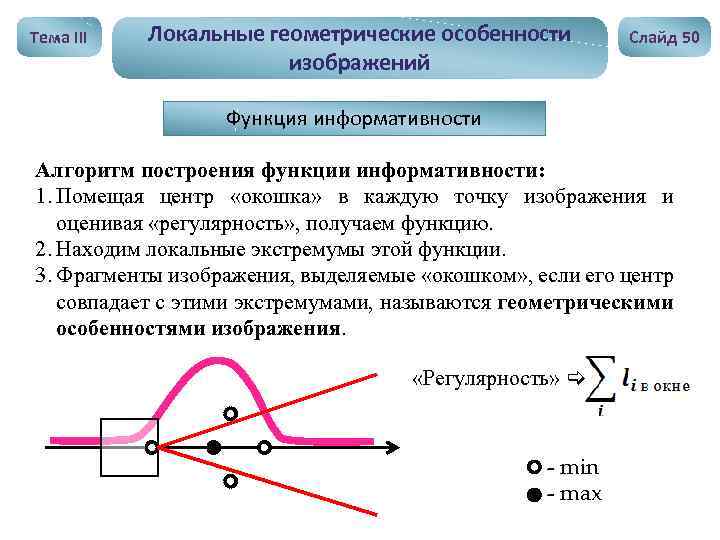

Тема III Локальные геометрические особенности изображений Слайд 50 Функция информативности Алгоритм построения функции информативности: 1. Помещая центр «окошка» в каждую точку изображения и оценивая «регулярность» , получаем функцию. 2. Находим локальные экстремумы этой функции. 3. Фрагменты изображения, выделяемые «окошком» , если его центр совпадает с этими экстремумами, называются геометрическими особенностями изображения. «Регулярность» - min - max

Тема III Локальные геометрические особенности изображений Слайд 50 Функция информативности Алгоритм построения функции информативности: 1. Помещая центр «окошка» в каждую точку изображения и оценивая «регулярность» , получаем функцию. 2. Находим локальные экстремумы этой функции. 3. Фрагменты изображения, выделяемые «окошком» , если его центр совпадает с этими экстремумами, называются геометрическими особенностями изображения. «Регулярность» - min - max

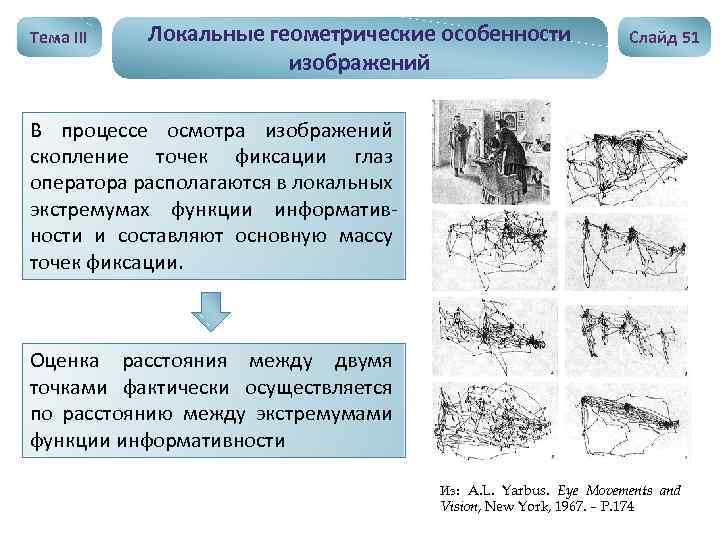

Тема III Локальные геометрические особенности изображений Слайд 51 В процессе осмотра изображений скопление точек фиксации глаз оператора располагаются в локальных экстремумах функции информативности и составляют основную массу точек фиксации. Оценка расстояния между двумя точками фактически осуществляется по расстоянию между экстремумами функции информативности Из: A. L. Yarbus. Eye Movements and Vision, New York, 1967. – P. 174

Тема III Локальные геометрические особенности изображений Слайд 51 В процессе осмотра изображений скопление точек фиксации глаз оператора располагаются в локальных экстремумах функции информативности и составляют основную массу точек фиксации. Оценка расстояния между двумя точками фактически осуществляется по расстоянию между экстремумами функции информативности Из: A. L. Yarbus. Eye Movements and Vision, New York, 1967. – P. 174

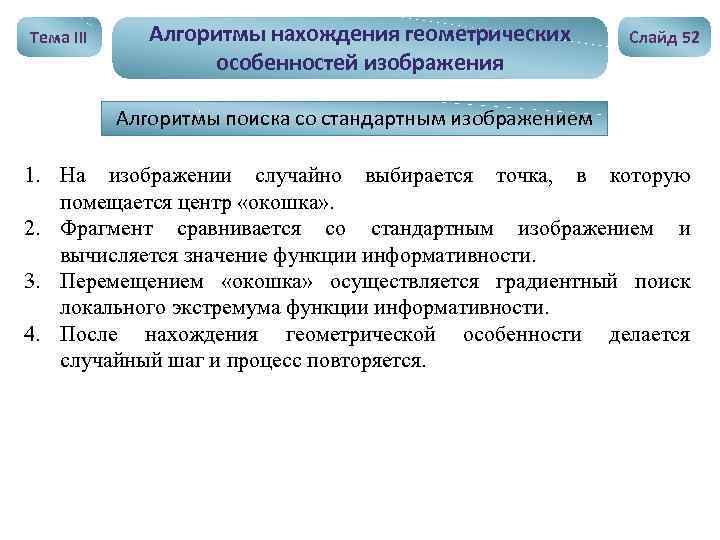

Тема III Алгоритмы нахождения геометрических особенностей изображения Слайд 52 Алгоритмы поиска со стандартным изображением 1. На изображении случайно выбирается точка, в которую помещается центр «окошка» . 2. Фрагмент сравнивается со стандартным изображением и вычисляется значение функции информативности. 3. Перемещением «окошка» осуществляется градиентный поиск локального экстремума функции информативности. 4. После нахождения геометрической особенности делается случайный шаг и процесс повторяется.

Тема III Алгоритмы нахождения геометрических особенностей изображения Слайд 52 Алгоритмы поиска со стандартным изображением 1. На изображении случайно выбирается точка, в которую помещается центр «окошка» . 2. Фрагмент сравнивается со стандартным изображением и вычисляется значение функции информативности. 3. Перемещением «окошка» осуществляется градиентный поиск локального экстремума функции информативности. 4. После нахождения геометрической особенности делается случайный шаг и процесс повторяется.

Тема III Алгоритмы нахождения геометрических особенностей изображения Алгоритм, основанный на определении сходства соседних фрагментов Алгоритм поиска с «декорреляцией» изображения Алгоритм поиска с расфокусировкой изображения Слайд 53

Тема III Алгоритмы нахождения геометрических особенностей изображения Алгоритм, основанный на определении сходства соседних фрагментов Алгоритм поиска с «декорреляцией» изображения Алгоритм поиска с расфокусировкой изображения Слайд 53

Тема IV Кодирование информационных полей в реальном времени

Тема IV Кодирование информационных полей в реальном времени

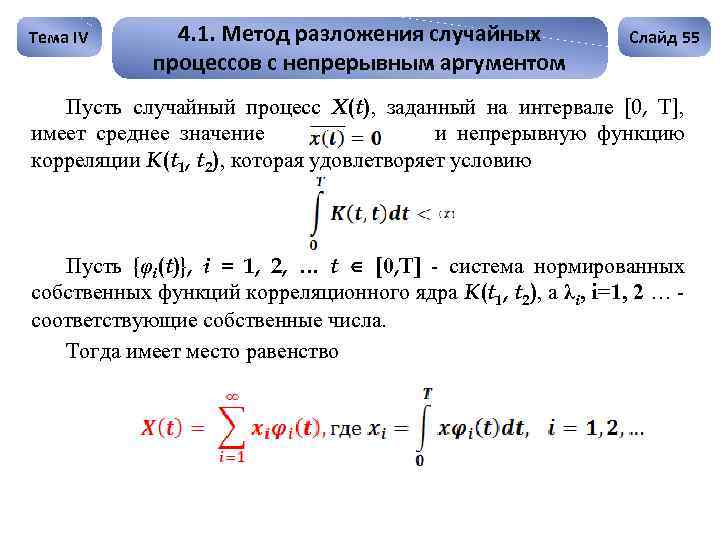

Тема IV 4. 1. Метод разложения случайных процессов с непрерывным аргументом Слайд 55 Пусть случайный процесс X(t), заданный на интервале [0, T], имеет среднее значение и непрерывную функцию корреляции K(t 1, t 2), которая удовлетворяет условию Пусть {φi(t)}, i = 1, 2, … t [0, T] - система нормированных собственных функций корреляционного ядра K(t 1, t 2), а λi, i=1, 2 … соответствующие собственные числа. Тогда имеет место равенство

Тема IV 4. 1. Метод разложения случайных процессов с непрерывным аргументом Слайд 55 Пусть случайный процесс X(t), заданный на интервале [0, T], имеет среднее значение и непрерывную функцию корреляции K(t 1, t 2), которая удовлетворяет условию Пусть {φi(t)}, i = 1, 2, … t [0, T] - система нормированных собственных функций корреляционного ядра K(t 1, t 2), а λi, i=1, 2 … соответствующие собственные числа. Тогда имеет место равенство

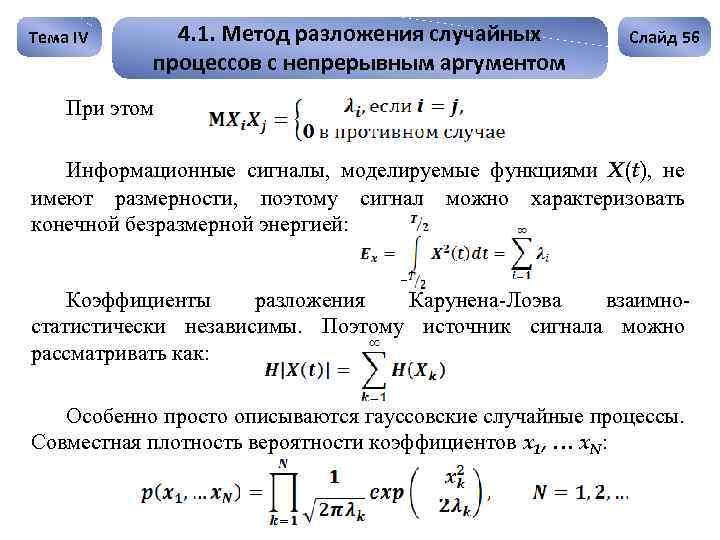

Тема IV 4. 1. Метод разложения случайных процессов с непрерывным аргументом Слайд 56 При этом Информационные сигналы, моделируемые функциями X(t), не имеют размерности, поэтому сигнал можно характеризовать конечной безразмерной энергией: Коэффициенты разложения Карунена-Лоэва взаимностатистически независимы. Поэтому источник сигнала можно рассматривать как: Особенно просто описываются гауссовские случайные процессы. Совместная плотность вероятности коэффициентов x 1, … x. N:

Тема IV 4. 1. Метод разложения случайных процессов с непрерывным аргументом Слайд 56 При этом Информационные сигналы, моделируемые функциями X(t), не имеют размерности, поэтому сигнал можно характеризовать конечной безразмерной энергией: Коэффициенты разложения Карунена-Лоэва взаимностатистически независимы. Поэтому источник сигнала можно рассматривать как: Особенно просто описываются гауссовские случайные процессы. Совместная плотность вероятности коэффициентов x 1, … x. N:

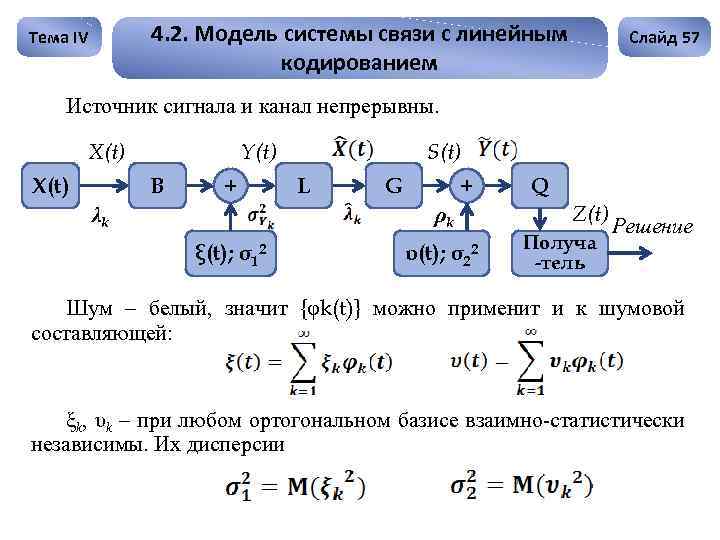

4. 2. Модель системы связи с линейным кодированием Тема IV Слайд 57 Источник сигнала и канал непрерывны. X(t) Y(t) B + λk S(t) L G + ρk ξ(t); σ12 υ(t); σ22 Q Z(t) Получа -тель Решение Шум – белый, значит {φk(t)} можно применит и к шумовой составляющей: ξk, υk – при любом ортогональном базисе взаимно-статистически независимы. Их дисперсии

4. 2. Модель системы связи с линейным кодированием Тема IV Слайд 57 Источник сигнала и канал непрерывны. X(t) Y(t) B + λk S(t) L G + ρk ξ(t); σ12 υ(t); σ22 Q Z(t) Получа -тель Решение Шум – белый, значит {φk(t)} можно применит и к шумовой составляющей: ξk, υk – при любом ортогональном базисе взаимно-статистически независимы. Их дисперсии

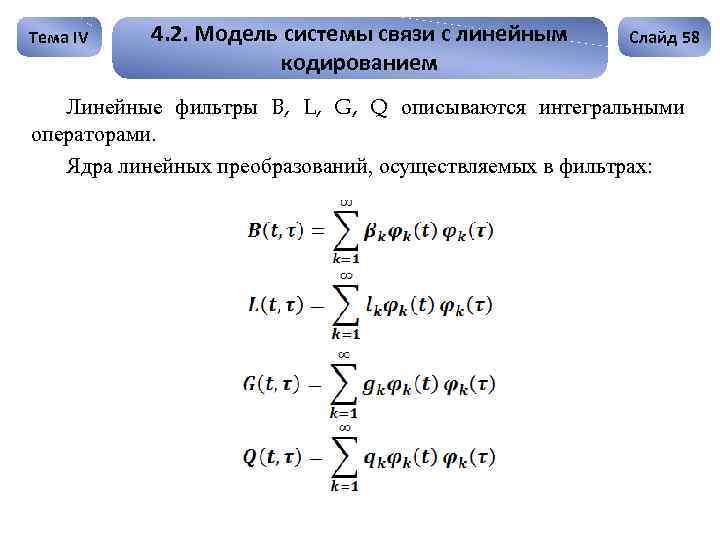

Тема IV 4. 2. Модель системы связи с линейным кодированием Слайд 58 Линейные фильтры B, L, G, Q описываются интегральными операторами. Ядра линейных преобразований, осуществляемых в фильтрах:

Тема IV 4. 2. Модель системы связи с линейным кодированием Слайд 58 Линейные фильтры B, L, G, Q описываются интегральными операторами. Ядра линейных преобразований, осуществляемых в фильтрах:

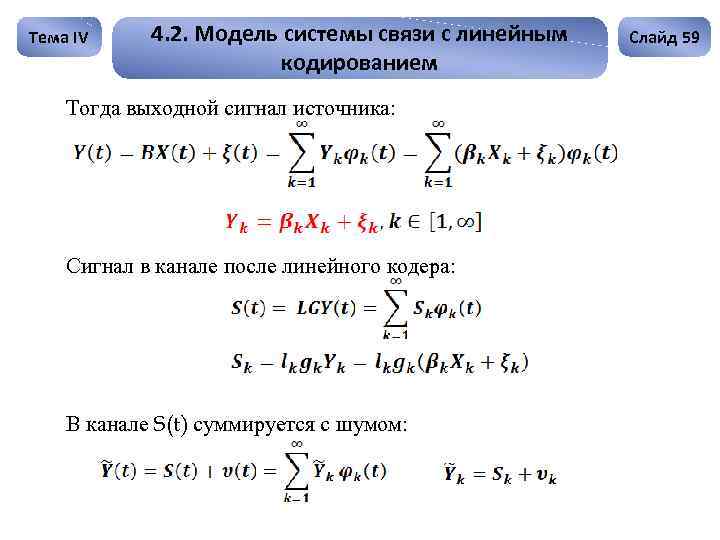

Тема IV 4. 2. Модель системы связи с линейным кодированием Тогда выходной сигнал источника: Сигнал в канале после линейного кодера: В канале S(t) суммируется с шумом: Слайд 59

Тема IV 4. 2. Модель системы связи с линейным кодированием Тогда выходной сигнал источника: Сигнал в канале после линейного кодера: В канале S(t) суммируется с шумом: Слайд 59

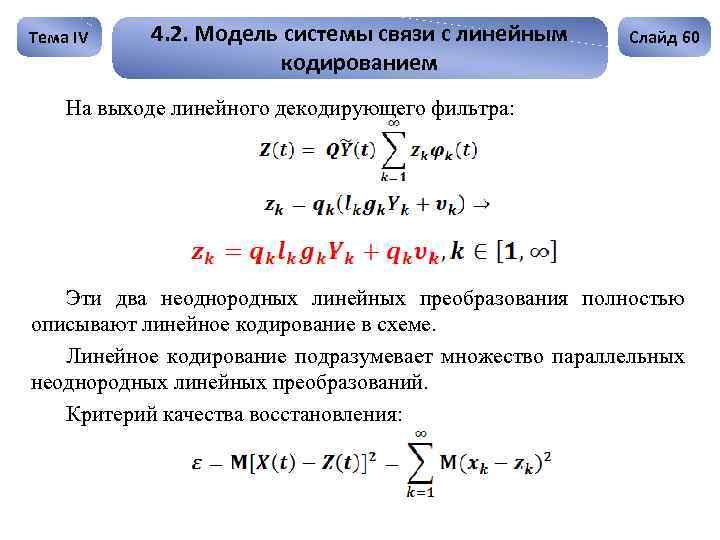

Тема IV 4. 2. Модель системы связи с линейным кодированием Слайд 60 На выходе линейного декодирующего фильтра: Эти два неоднородных линейных преобразования полностью описывают линейное кодирование в схеме. Линейное кодирование подразумевает множество параллельных неоднородных линейных преобразований. Критерий качества восстановления:

Тема IV 4. 2. Модель системы связи с линейным кодированием Слайд 60 На выходе линейного декодирующего фильтра: Эти два неоднородных линейных преобразования полностью описывают линейное кодирование в схеме. Линейное кодирование подразумевает множество параллельных неоднородных линейных преобразований. Критерий качества восстановления:

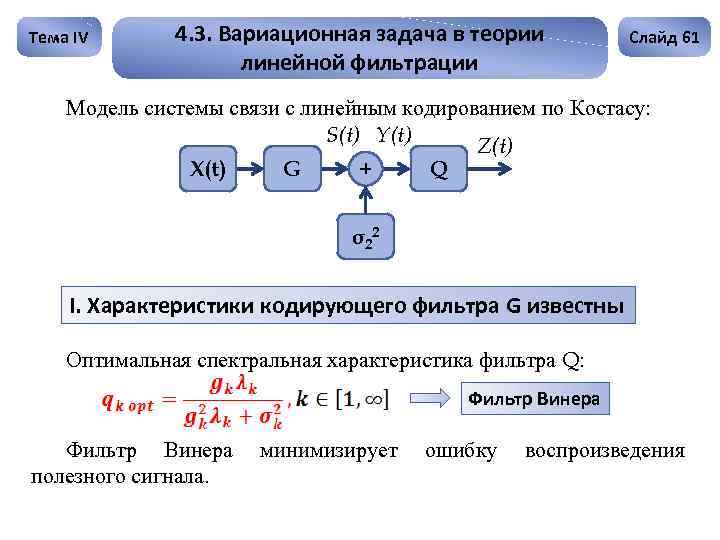

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации Слайд 61 Модель системы связи с линейным кодированием по Костасу: S(t) Y(t) Z(t) X(t) G Q + σ 22 I. Характеристики кодирующего фильтра G известны Оптимальная спектральная характеристика фильтра Q: Фильтр Винера полезного сигнала. минимизирует ошибку воспроизведения

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации Слайд 61 Модель системы связи с линейным кодированием по Костасу: S(t) Y(t) Z(t) X(t) G Q + σ 22 I. Характеристики кодирующего фильтра G известны Оптимальная спектральная характеристика фильтра Q: Фильтр Винера полезного сигнала. минимизирует ошибку воспроизведения

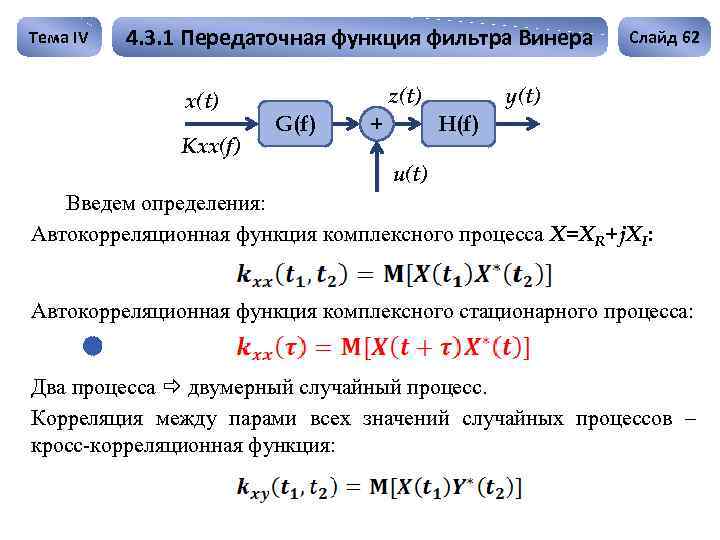

Тема IV 4. 3. 1 Передаточная функция фильтра Винера x(t) Kxx(f) z(t) G(f) Слайд 62 y(t) H(f) + u(t) Введем определения: Автокорреляционная функция комплексного процесса X=XR+j. XI: Автокорреляционная функция комплексного стационарного процесса: Два процесса двумерный случайный процесс. Корреляция между парами всех значений случайных процессов – кросс-корреляционная функция:

Тема IV 4. 3. 1 Передаточная функция фильтра Винера x(t) Kxx(f) z(t) G(f) Слайд 62 y(t) H(f) + u(t) Введем определения: Автокорреляционная функция комплексного процесса X=XR+j. XI: Автокорреляционная функция комплексного стационарного процесса: Два процесса двумерный случайный процесс. Корреляция между парами всех значений случайных процессов – кросс-корреляционная функция:

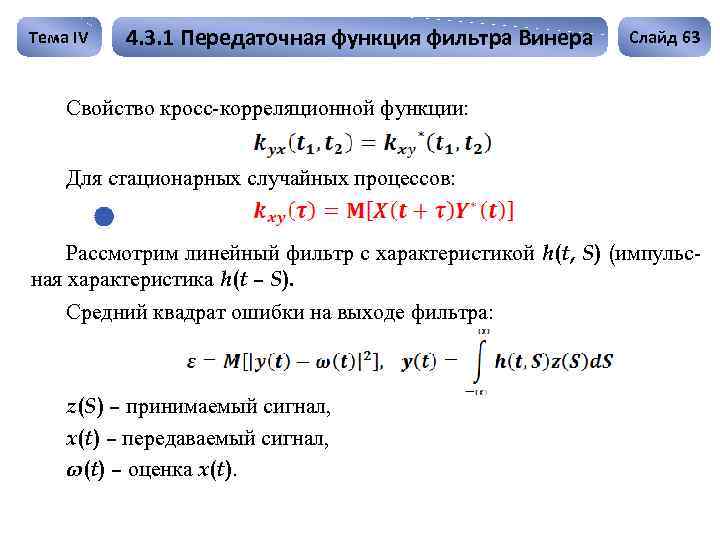

Тема IV 4. 3. 1 Передаточная функция фильтра Винера Слайд 63 Свойство кросс-корреляционной функции: Для стационарных случайных процессов: Рассмотрим линейный фильтр с характеристикой h(t, S) (импульсная характеристика h(t – S). Средний квадрат ошибки на выходе фильтра: z(S) – принимаемый сигнал, x(t) – передаваемый сигнал, ω(t) – оценка x(t).

Тема IV 4. 3. 1 Передаточная функция фильтра Винера Слайд 63 Свойство кросс-корреляционной функции: Для стационарных случайных процессов: Рассмотрим линейный фильтр с характеристикой h(t, S) (импульсная характеристика h(t – S). Средний квадрат ошибки на выходе фильтра: z(S) – принимаемый сигнал, x(t) – передаваемый сигнал, ω(t) – оценка x(t).

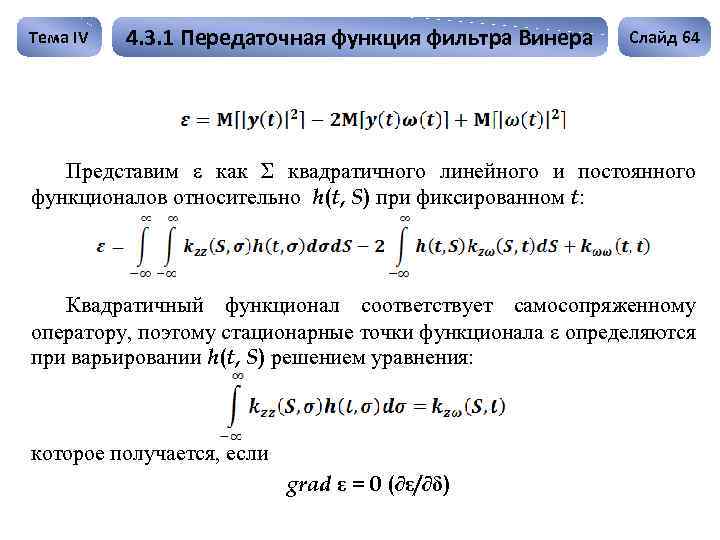

Тема IV 4. 3. 1 Передаточная функция фильтра Винера Слайд 64 Представим ε как Σ квадратичного линейного и постоянного функционалов относительно h(t, S) при фиксированном t: Квадратичный функционал соответствует самосопряженному оператору, поэтому стационарные точки функционала ε определяются при варьировании h(t, S) решением уравнения: которое получается, если grad ε = 0 (∂ε/∂δ)

Тема IV 4. 3. 1 Передаточная функция фильтра Винера Слайд 64 Представим ε как Σ квадратичного линейного и постоянного функционалов относительно h(t, S) при фиксированном t: Квадратичный функционал соответствует самосопряженному оператору, поэтому стационарные точки функционала ε определяются при варьировании h(t, S) решением уравнения: которое получается, если grad ε = 0 (∂ε/∂δ)

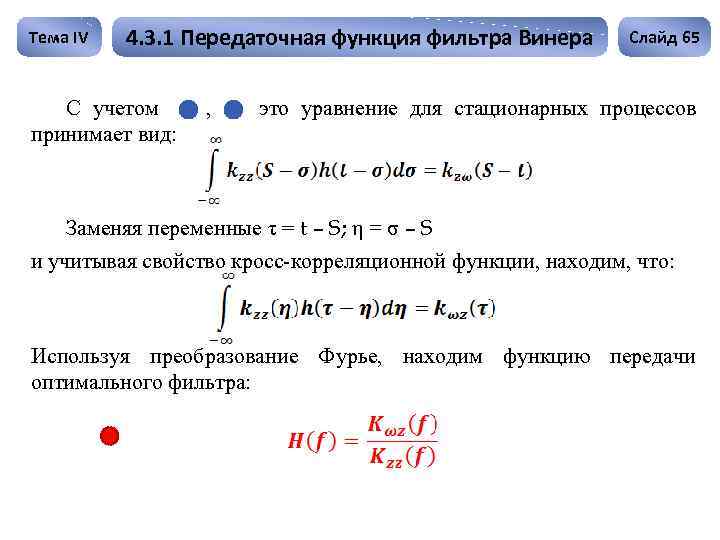

Тема IV 4. 3. 1 Передаточная функция фильтра Винера С учетом принимает вид: , Слайд 65 это уравнение для стационарных процессов Заменяя переменные τ = t – S; η = σ – S и учитывая свойство кросс-корреляционной функции, находим, что: Используя преобразование Фурье, находим функцию передачи оптимального фильтра:

Тема IV 4. 3. 1 Передаточная функция фильтра Винера С учетом принимает вид: , Слайд 65 это уравнение для стационарных процессов Заменяя переменные τ = t – S; η = σ – S и учитывая свойство кросс-корреляционной функции, находим, что: Используя преобразование Фурье, находим функцию передачи оптимального фильтра:

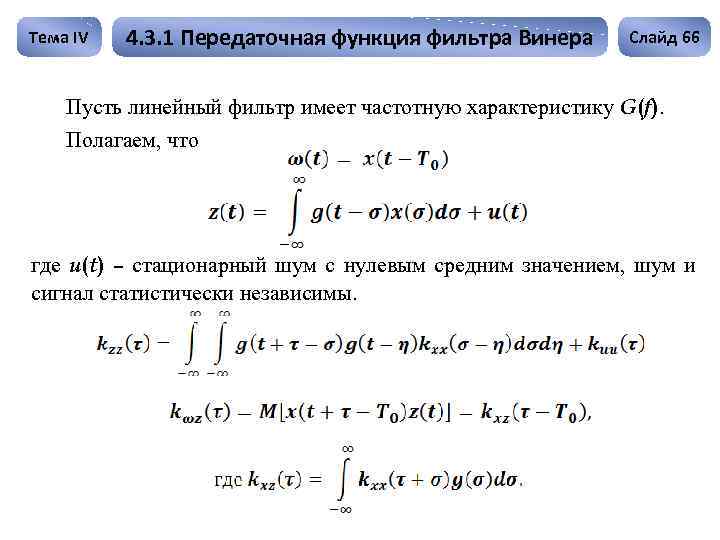

Тема IV 4. 3. 1 Передаточная функция фильтра Винера Слайд 66 Пусть линейный фильтр имеет частотную характеристику G(f). Полагаем, что где u(t) – стационарный шум с нулевым средним значением, шум и сигнал статистически независимы.

Тема IV 4. 3. 1 Передаточная функция фильтра Винера Слайд 66 Пусть линейный фильтр имеет частотную характеристику G(f). Полагаем, что где u(t) – стационарный шум с нулевым средним значением, шум и сигнал статистически независимы.

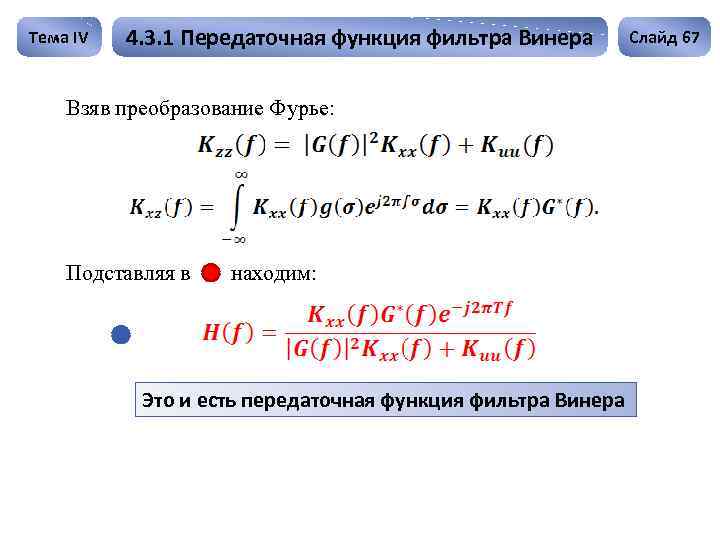

Тема IV 4. 3. 1 Передаточная функция фильтра Винера Взяв преобразование Фурье: Подставляя в находим: Это и есть передаточная функция фильтра Винера Слайд 67

Тема IV 4. 3. 1 Передаточная функция фильтра Винера Взяв преобразование Фурье: Подставляя в находим: Это и есть передаточная функция фильтра Винера Слайд 67

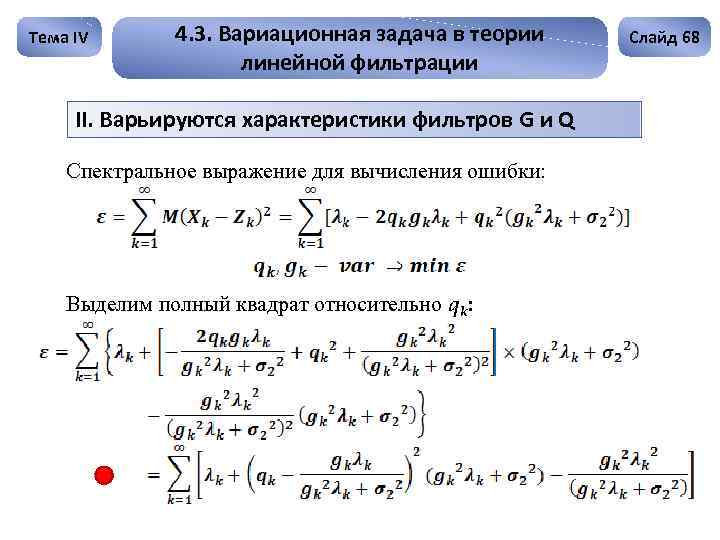

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации II. Варьируются характеристики фильтров G и Q Спектральное выражение для вычисления ошибки: Выделим полный квадрат относительно qk: Слайд 68

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации II. Варьируются характеристики фильтров G и Q Спектральное выражение для вычисления ошибки: Выделим полный квадрат относительно qk: Слайд 68

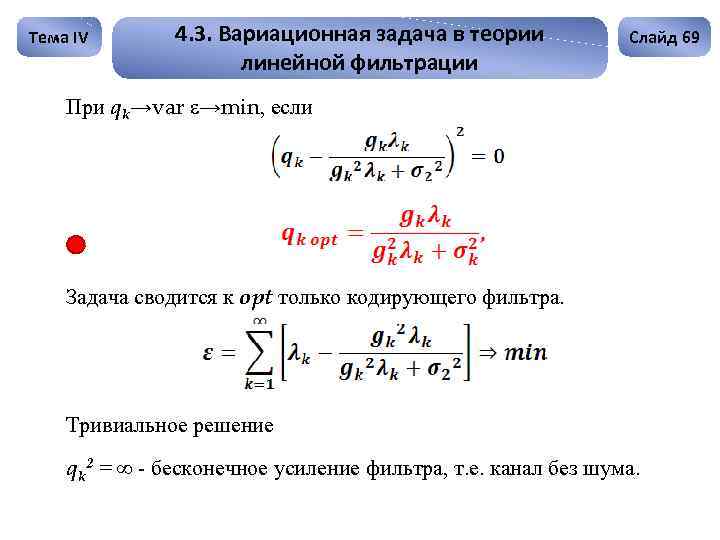

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации Слайд 69 При qk→var ε→min, если Задача сводится к opt только кодирующего фильтра. Тривиальное решение qk 2 = ∞ - бесконечное усиление фильтра, т. е. канал без шума.

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации Слайд 69 При qk→var ε→min, если Задача сводится к opt только кодирующего фильтра. Тривиальное решение qk 2 = ∞ - бесконечное усиление фильтра, т. е. канал без шума.

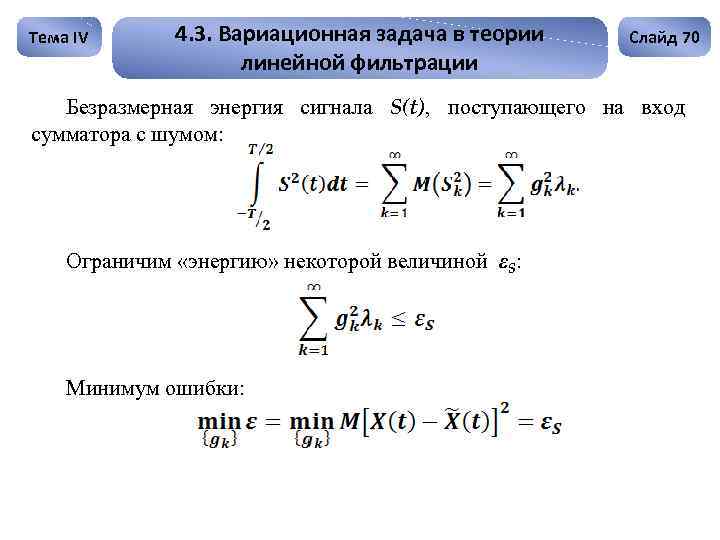

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации Слайд 70 Безразмерная энергия сигнала S(t), поступающего на вход сумматора с шумом: Ограничим «энергию» некоторой величиной εS: Минимум ошибки:

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации Слайд 70 Безразмерная энергия сигнала S(t), поступающего на вход сумматора с шумом: Ограничим «энергию» некоторой величиной εS: Минимум ошибки:

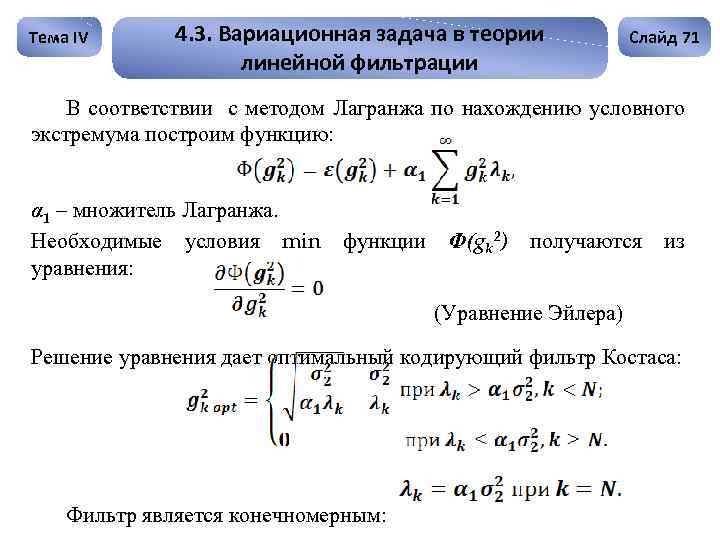

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации Слайд 71 В соответствии с методом Лагранжа по нахождению условного экстремума построим функцию: α 1 – множитель Лагранжа. Необходимые условия min уравнения: функции Ф(gk 2) получаются из (Уравнение Эйлера) Решение уравнения дает оптимальный кодирующий фильтр Костаса: Фильтр является конечномерным:

Тема IV 4. 3. Вариационная задача в теории линейной фильтрации Слайд 71 В соответствии с методом Лагранжа по нахождению условного экстремума построим функцию: α 1 – множитель Лагранжа. Необходимые условия min уравнения: функции Ф(gk 2) получаются из (Уравнение Эйлера) Решение уравнения дает оптимальный кодирующий фильтр Костаса: Фильтр является конечномерным:

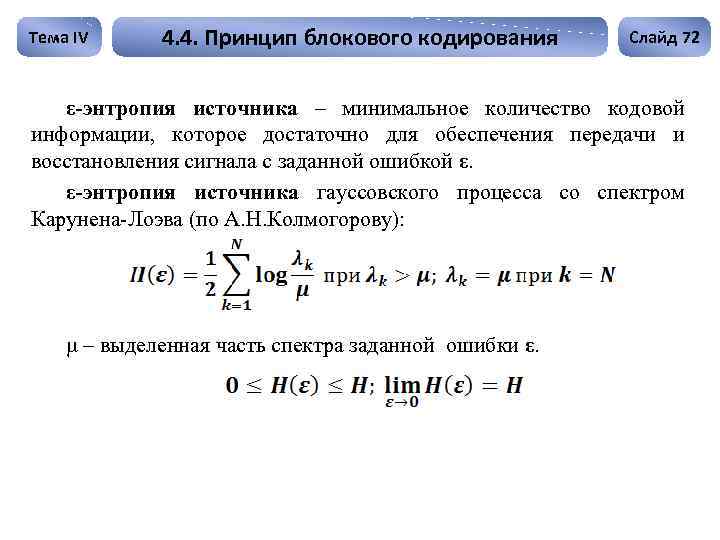

Тема IV 4. 4. Принцип блокового кодирования Слайд 72 ε-энтропия источника – минимальное количество кодовой информации, которое достаточно для обеспечения передачи и восстановления сигнала с заданной ошибкой ε. ε-энтропия источника гауссовского процесса со спектром Карунена-Лоэва (по А. Н. Колмогорову): μ – выделенная часть спектра заданной ошибки ε.

Тема IV 4. 4. Принцип блокового кодирования Слайд 72 ε-энтропия источника – минимальное количество кодовой информации, которое достаточно для обеспечения передачи и восстановления сигнала с заданной ошибкой ε. ε-энтропия источника гауссовского процесса со спектром Карунена-Лоэва (по А. Н. Колмогорову): μ – выделенная часть спектра заданной ошибки ε.

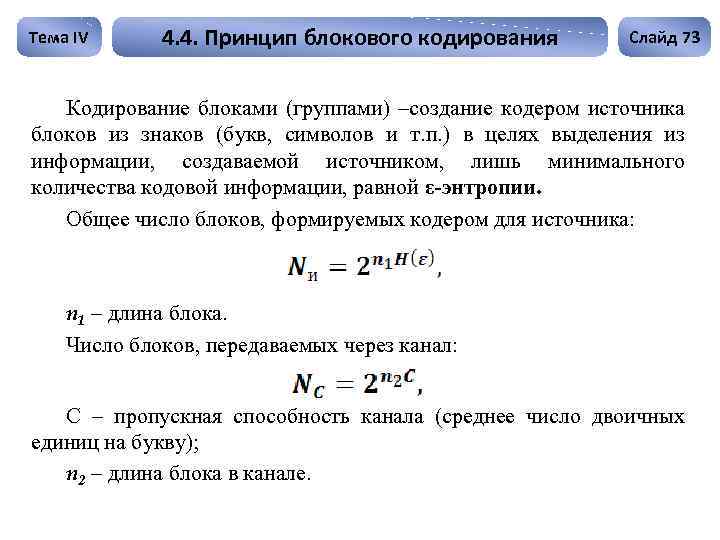

Тема IV 4. 4. Принцип блокового кодирования Слайд 73 Кодирование блоками (группами) –создание кодером источника блоков из знаков (букв, символов и т. п. ) в целях выделения из информации, создаваемой источником, лишь минимального количества кодовой информации, равной ε-энтропии. Общее число блоков, формируемых кодером для источника: n 1 – длина блока. Число блоков, передаваемых через канал: С – пропускная способность канала (среднее число двоичных единиц на букву); n 2 – длина блока в канале.

Тема IV 4. 4. Принцип блокового кодирования Слайд 73 Кодирование блоками (группами) –создание кодером источника блоков из знаков (букв, символов и т. п. ) в целях выделения из информации, создаваемой источником, лишь минимального количества кодовой информации, равной ε-энтропии. Общее число блоков, формируемых кодером для источника: n 1 – длина блока. Число блоков, передаваемых через канал: С – пропускная способность канала (среднее число двоичных единиц на букву); n 2 – длина блока в канале.

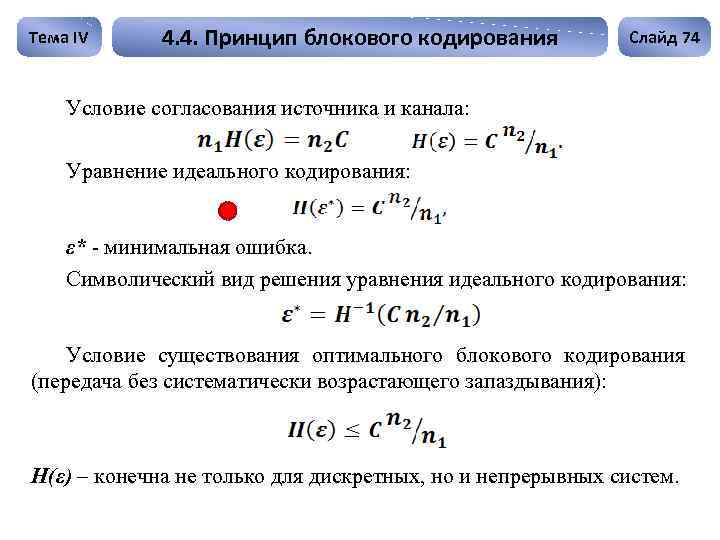

Тема IV 4. 4. Принцип блокового кодирования Слайд 74 Условие согласования источника и канала: Уравнение идеального кодирования: ε* - минимальная ошибка. Символический вид решения уравнения идеального кодирования: Условие существования оптимального блокового кодирования (передача без систематически возрастающего запаздывания): Н(ε) – конечна не только для дискретных, но и непрерывных систем.

Тема IV 4. 4. Принцип блокового кодирования Слайд 74 Условие согласования источника и канала: Уравнение идеального кодирования: ε* - минимальная ошибка. Символический вид решения уравнения идеального кодирования: Условие существования оптимального блокового кодирования (передача без систематически возрастающего запаздывания): Н(ε) – конечна не только для дискретных, но и непрерывных систем.

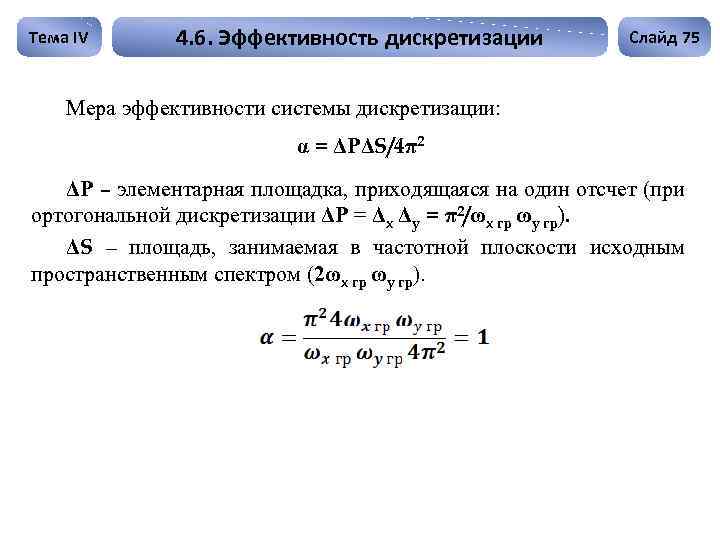

Тема IV 4. 6. Эффективность дискретизации Слайд 75 Мера эффективности системы дискретизации: α = ΔРΔS/4π2 ΔР – элементарная площадка, приходящаяся на один отсчет (при ортогональной дискретизации ΔР = Δx Δy = π2/ωx гр ωy гр). ΔS – площадь, занимаемая в частотной плоскости исходным пространственным спектром (2ωx гр ωy гр).

Тема IV 4. 6. Эффективность дискретизации Слайд 75 Мера эффективности системы дискретизации: α = ΔРΔS/4π2 ΔР – элементарная площадка, приходящаяся на один отсчет (при ортогональной дискретизации ΔР = Δx Δy = π2/ωx гр ωy гр). ΔS – площадь, занимаемая в частотной плоскости исходным пространственным спектром (2ωx гр ωy гр).

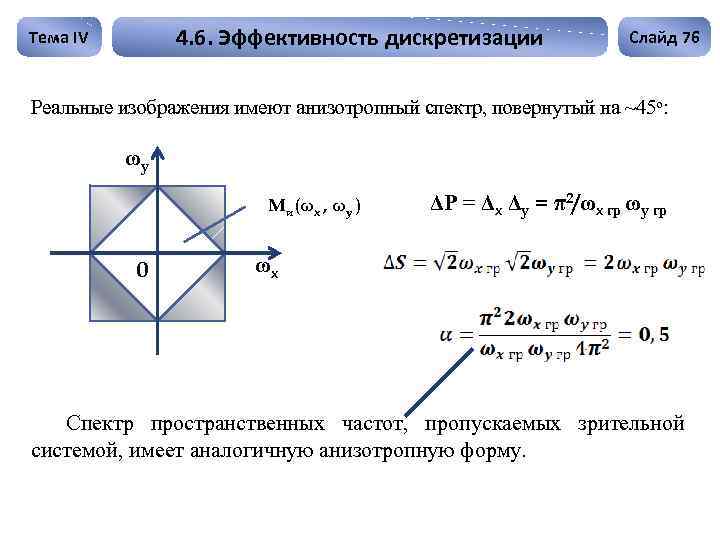

4. 6. Эффективность дискретизации Тема IV Слайд 76 Реальные изображения имеют анизотропный спектр, повернутый на ~45 о: ωy Mи(ωx , ωy ) 0 ΔР = Δx Δy = π2/ωx гр ωy гр ωx Спектр пространственных частот, пропускаемых зрительной системой, имеет аналогичную анизотропную форму.

4. 6. Эффективность дискретизации Тема IV Слайд 76 Реальные изображения имеют анизотропный спектр, повернутый на ~45 о: ωy Mи(ωx , ωy ) 0 ΔР = Δx Δy = π2/ωx гр ωy гр ωx Спектр пространственных частот, пропускаемых зрительной системой, имеет аналогичную анизотропную форму.

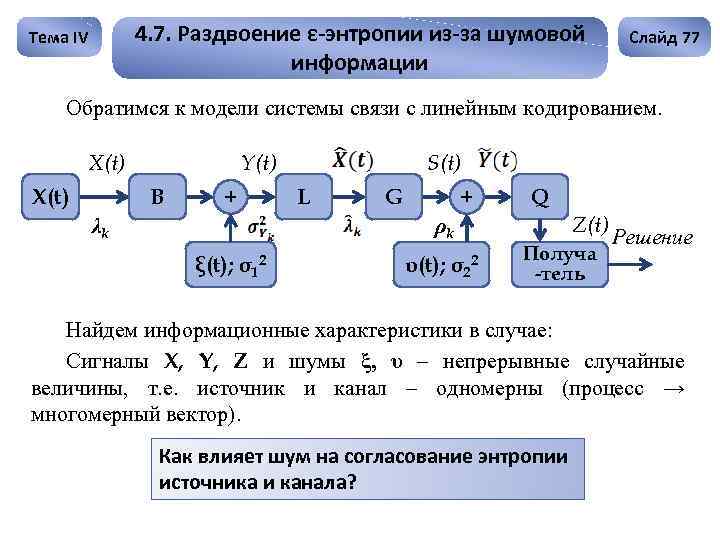

4. 7. Раздвоение ε-энтропии из-за шумовой информации Тема IV Слайд 77 Обратимся к модели системы связи с линейным кодированием. X(t) Y(t) B + λk S(t) L G + ρk ξ(t); σ12 υ(t); σ22 Q Z(t) Получа -тель Решение Найдем информационные характеристики в случае: Сигналы X, Y, Z и шумы ξ, υ – непрерывные случайные величины, т. е. источник и канал – одномерны (процесс → многомерный вектор). Как влияет шум на согласование энтропии источника и канала?

4. 7. Раздвоение ε-энтропии из-за шумовой информации Тема IV Слайд 77 Обратимся к модели системы связи с линейным кодированием. X(t) Y(t) B + λk S(t) L G + ρk ξ(t); σ12 υ(t); σ22 Q Z(t) Получа -тель Решение Найдем информационные характеристики в случае: Сигналы X, Y, Z и шумы ξ, υ – непрерывные случайные величины, т. е. источник и канал – одномерны (процесс → многомерный вектор). Как влияет шум на согласование энтропии источника и канала?

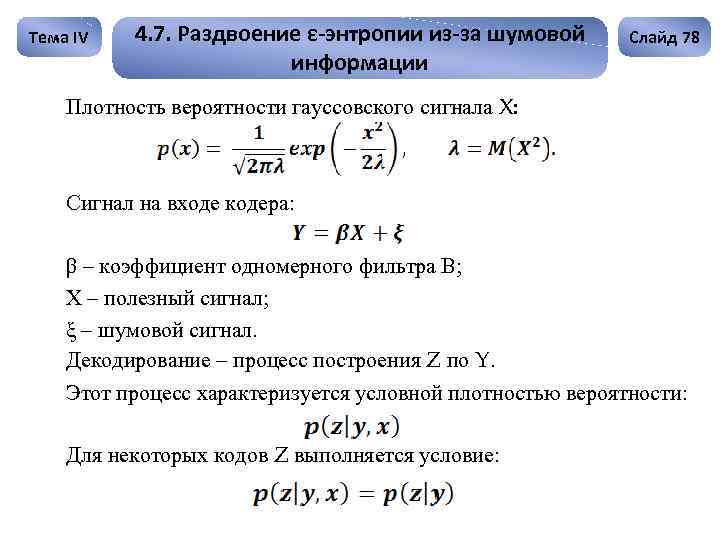

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 78 Плотность вероятности гауссовского сигнала X: Сигнал на входе кодера: β – коэффициент одномерного фильтра В; Х – полезный сигнал; ξ – шумовой сигнал. Декодирование – процесс построения Z по Y. Этот процесс характеризуется условной плотностью вероятности: Для некоторых кодов Z выполняется условие:

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 78 Плотность вероятности гауссовского сигнала X: Сигнал на входе кодера: β – коэффициент одномерного фильтра В; Х – полезный сигнал; ξ – шумовой сигнал. Декодирование – процесс построения Z по Y. Этот процесс характеризуется условной плотностью вероятности: Для некоторых кодов Z выполняется условие:

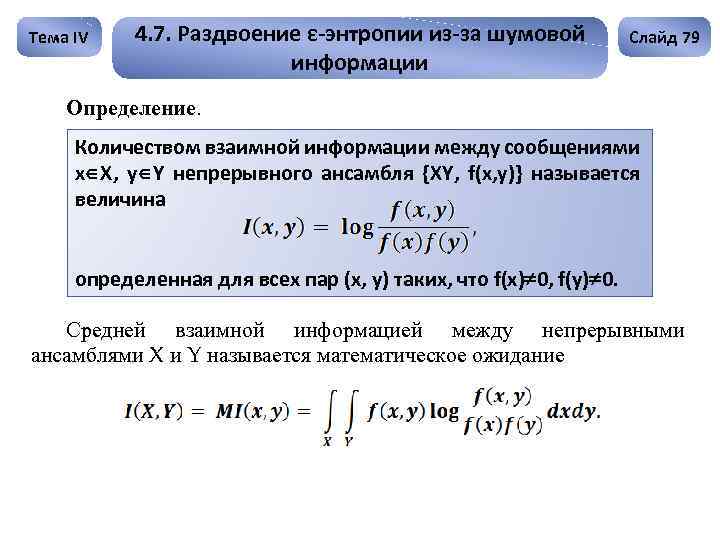

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 79 Определение. Количеством взаимной информации между сообщениями x X, y Y непрерывного ансамбля {XY, f(x, y)} называется величина определенная для всех пар (x, y) таких, что f(x) 0, f(y) 0. Средней взаимной информацией между непрерывными ансамблями X и Y называется математическое ожидание

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 79 Определение. Количеством взаимной информации между сообщениями x X, y Y непрерывного ансамбля {XY, f(x, y)} называется величина определенная для всех пар (x, y) таких, что f(x) 0, f(y) 0. Средней взаимной информацией между непрерывными ансамблями X и Y называется математическое ожидание

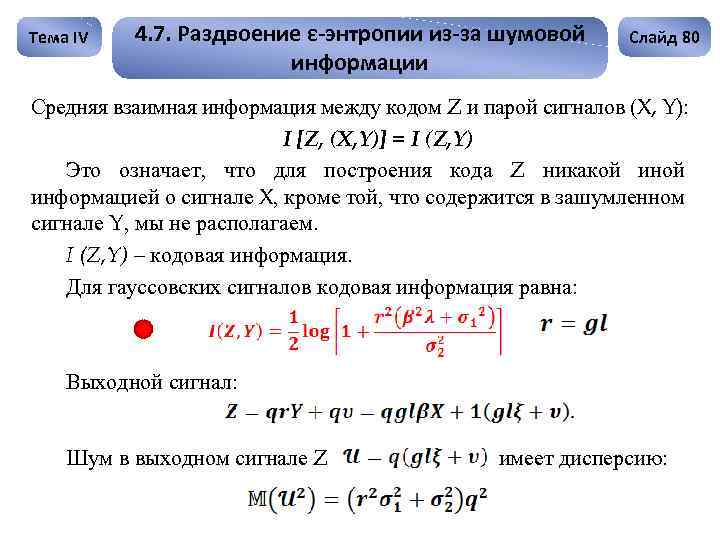

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 80 Средняя взаимная информация между кодом Z и парой сигналов (X, Y): I [Z, (X, Y)] = I (Z, Y) Это означает, что для построения кода Z никакой информацией о сигнале X, кроме той, что содержится в зашумленном сигнале Y, мы не располагаем. I (Z, Y) – кодовая информация. Для гауссовских сигналов кодовая информация равна: Выходной сигнал: Шум в выходном сигнале Z имеет дисперсию:

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 80 Средняя взаимная информация между кодом Z и парой сигналов (X, Y): I [Z, (X, Y)] = I (Z, Y) Это означает, что для построения кода Z никакой информацией о сигнале X, кроме той, что содержится в зашумленном сигнале Y, мы не располагаем. I (Z, Y) – кодовая информация. Для гауссовских сигналов кодовая информация равна: Выходной сигнал: Шум в выходном сигнале Z имеет дисперсию:

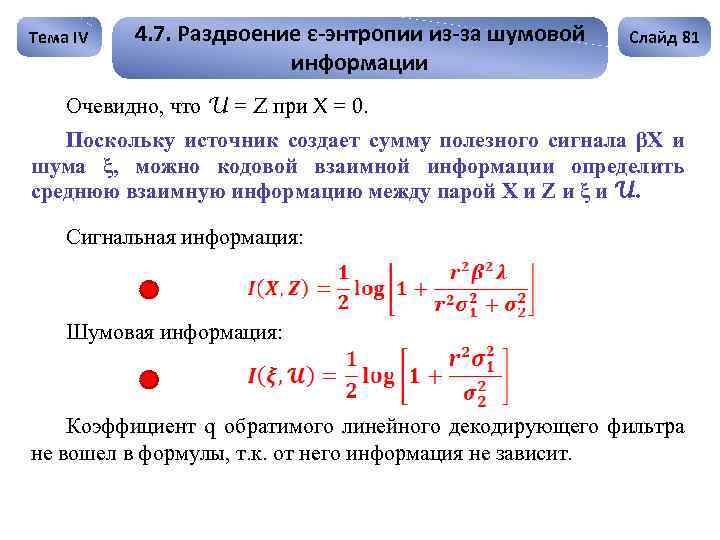

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 81 Очевидно, что U = Z при X = 0. Поскольку источник создает сумму полезного сигнала βХ и шума ξ, можно кодовой взаимной информации определить среднюю взаимную информацию между парой Х и Z и ξ и U. Сигнальная информация: Шумовая информация: Коэффициент q обратимого линейного декодирующего фильтра не вошел в формулы, т. к. от него информация не зависит.

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 81 Очевидно, что U = Z при X = 0. Поскольку источник создает сумму полезного сигнала βХ и шума ξ, можно кодовой взаимной информации определить среднюю взаимную информацию между парой Х и Z и ξ и U. Сигнальная информация: Шумовая информация: Коэффициент q обратимого линейного декодирующего фильтра не вошел в формулы, т. к. от него информация не зависит.

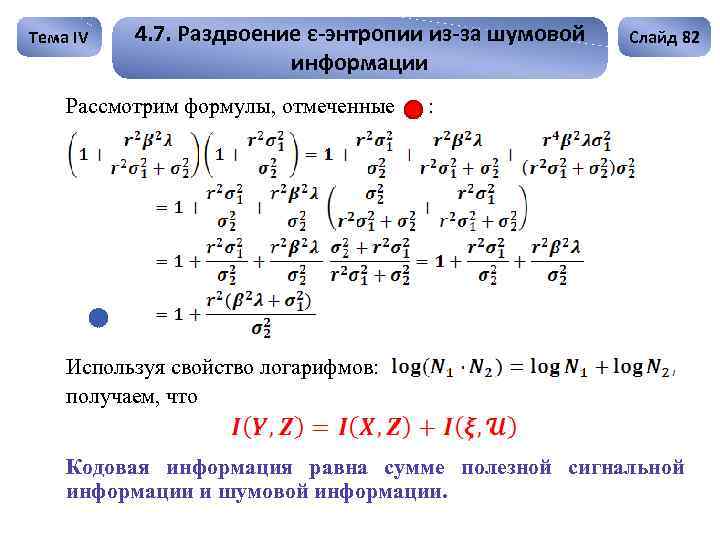

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Рассмотрим формулы, отмеченные Слайд 82 : Используя свойство логарифмов: получаем, что Кодовая информация равна сумме полезной сигнальной информации и шумовой информации.

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Рассмотрим формулы, отмеченные Слайд 82 : Используя свойство логарифмов: получаем, что Кодовая информация равна сумме полезной сигнальной информации и шумовой информации.

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 83 Таким образом: 1. Шум источника лимитирует полезную сигнальную информацию; 2. Шум источника сам является источником «ложной» (шумовой) информации. Если I(X, Z) = 0; X = 0, то т. е. шумовая информация трактуется как кодовая. Кодер должен перерабатывать как I(X, Z), так и I(ξ , U). Поэтому источник информации нельзя характеризовать одной εэнтропией. Кодовая ε-энтропия: HY(ευ) = HX(ε) + I(ξ , U).

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 83 Таким образом: 1. Шум источника лимитирует полезную сигнальную информацию; 2. Шум источника сам является источником «ложной» (шумовой) информации. Если I(X, Z) = 0; X = 0, то т. е. шумовая информация трактуется как кодовая. Кодер должен перерабатывать как I(X, Z), так и I(ξ , U). Поэтому источник информации нельзя характеризовать одной εэнтропией. Кодовая ε-энтропия: HY(ευ) = HX(ε) + I(ξ , U).

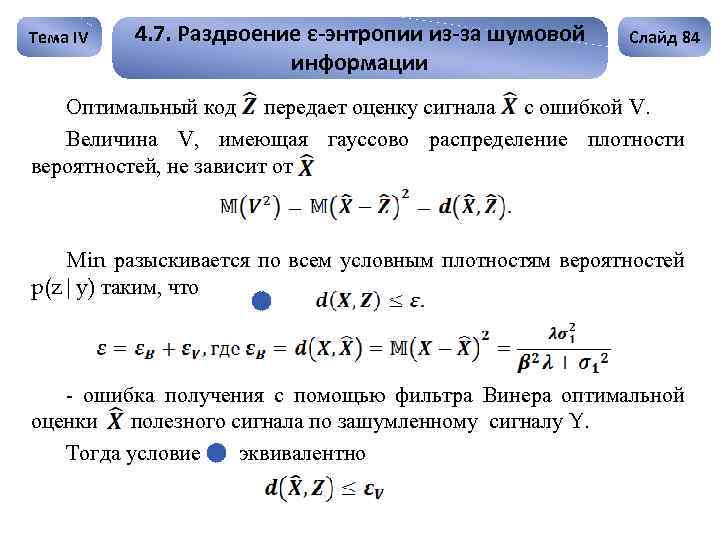

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 84 Оптимальный код передает оценку сигнала с ошибкой V. Величина V, имеющая гауссово распределение плотности вероятностей, не зависит от Min разыскивается по всем условным плотностям вероятностей p(z|y) таким, что - ошибка получения с помощью фильтра Винера оптимальной оценки полезного сигнала по зашумленному сигналу Y. Тогда условие эквивалентно

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 84 Оптимальный код передает оценку сигнала с ошибкой V. Величина V, имеющая гауссово распределение плотности вероятностей, не зависит от Min разыскивается по всем условным плотностям вероятностей p(z|y) таким, что - ошибка получения с помощью фильтра Винера оптимальной оценки полезного сигнала по зашумленному сигналу Y. Тогда условие эквивалентно

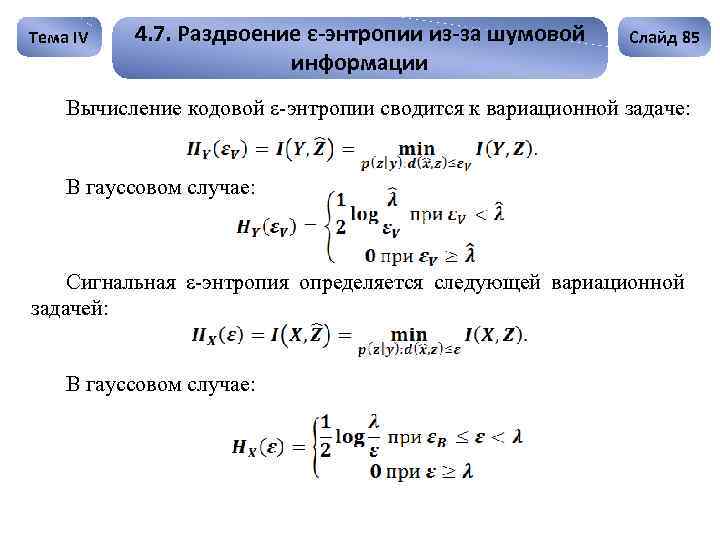

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 85 Вычисление кодовой ε-энтропии сводится к вариационной задаче: В гауссовом случае: Сигнальная ε-энтропия определяется следующей вариационной задачей: В гауссовом случае:

Тема IV 4. 7. Раздвоение ε-энтропии из-за шумовой информации Слайд 85 Вычисление кодовой ε-энтропии сводится к вариационной задаче: В гауссовом случае: Сигнальная ε-энтропия определяется следующей вариационной задачей: В гауссовом случае:

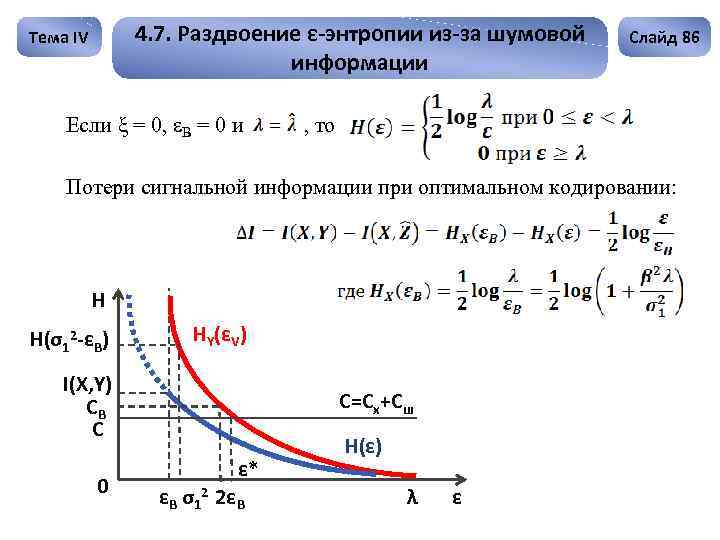

4. 7. Раздвоение ε-энтропии из-за шумовой информации Тема IV Если ξ = 0, εВ = 0 и Слайд 86 , то Потери сигнальной информации при оптимальном кодировании: H H(σ12 -εB) HY(εV) I(X, Y) CB C 0 C=Cx+Cш ε* εB σ12 2εB H(ε) λ ε

4. 7. Раздвоение ε-энтропии из-за шумовой информации Тема IV Если ξ = 0, εВ = 0 и Слайд 86 , то Потери сигнальной информации при оптимальном кодировании: H H(σ12 -εB) HY(εV) I(X, Y) CB C 0 C=Cx+Cш ε* εB σ12 2εB H(ε) λ ε

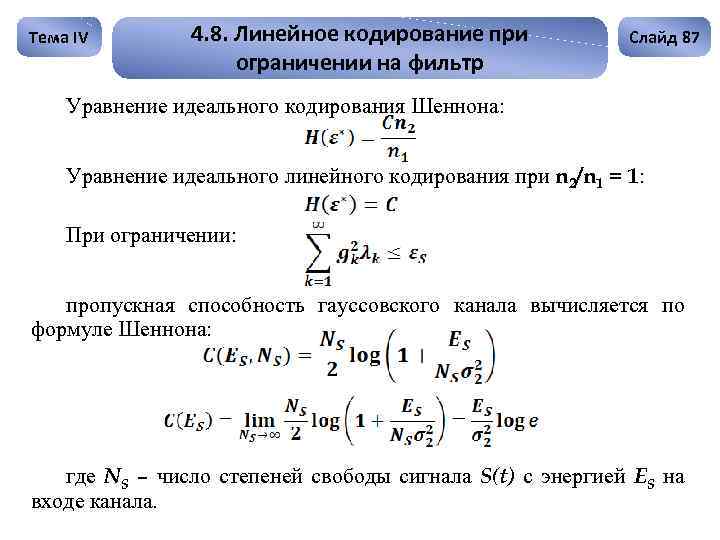

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 87 Уравнение идеального кодирования Шеннона: Уравнение идеального линейного кодирования при n 2/n 1 = 1: При ограничении: пропускная способность гауссовского канала вычисляется по формуле Шеннона: где NS – число степеней свободы сигнала S(t) с энергией ES на входе канала.

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 87 Уравнение идеального кодирования Шеннона: Уравнение идеального линейного кодирования при n 2/n 1 = 1: При ограничении: пропускная способность гауссовского канала вычисляется по формуле Шеннона: где NS – число степеней свободы сигнала S(t) с энергией ES на входе канала.

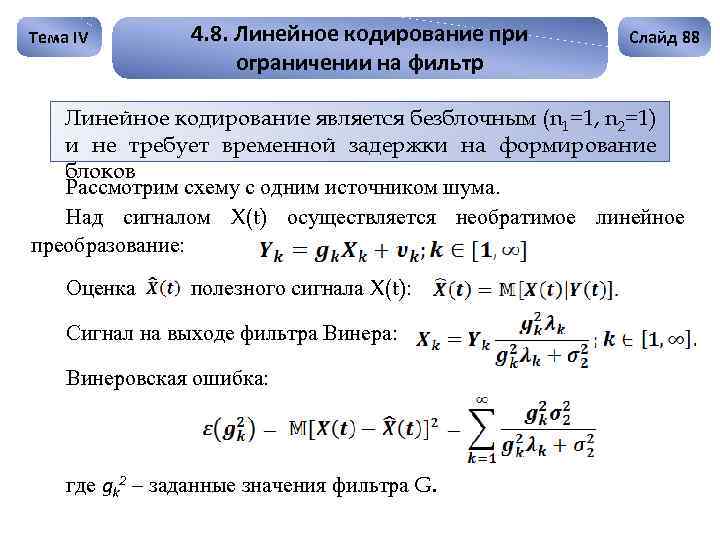

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 88 Линейное кодирование является безблочным (n 1=1, n 2=1) и не требует временной задержки на формирование блоков Рассмотрим схему с одним источником шума. Над сигналом X(t) осуществляется необратимое линейное преобразование: Оценка полезного сигнала X(t): Сигнал на выходе фильтра Винера: Винеровская ошибка: где gk 2 – заданные значения фильтра G.

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 88 Линейное кодирование является безблочным (n 1=1, n 2=1) и не требует временной задержки на формирование блоков Рассмотрим схему с одним источником шума. Над сигналом X(t) осуществляется необратимое линейное преобразование: Оценка полезного сигнала X(t): Сигнал на выходе фильтра Винера: Винеровская ошибка: где gk 2 – заданные значения фильтра G.

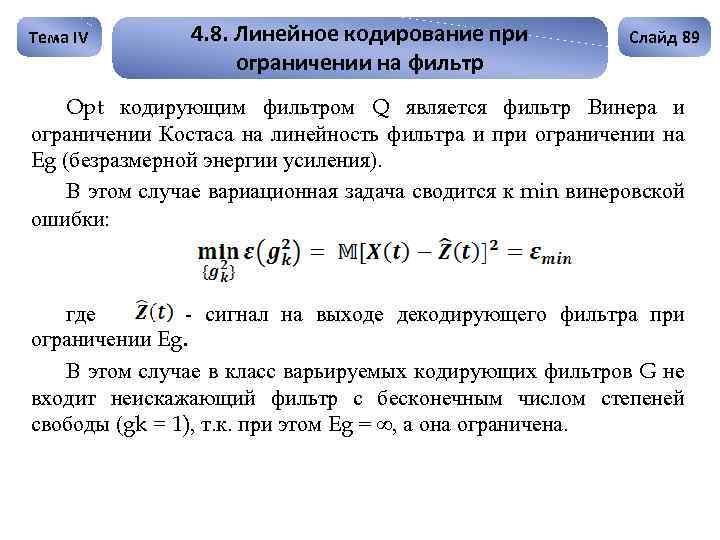

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 89 Opt кодирующим фильтром Q является фильтр Винера и ограничении Костаса на линейность фильтра и при ограничении на Eg (безразмерной энергии усиления). В этом случае вариационная задача сводится к min винеровской ошибки: где - сигнал на выходе декодирующего фильтра при ограничении Eg. В этом случае в класс варьируемых кодирующих фильтров G не входит неискажающий фильтр с бесконечным числом степеней свободы (gk = 1), т. к. при этом Eg = ∞, а она ограничена. -

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 89 Opt кодирующим фильтром Q является фильтр Винера и ограничении Костаса на линейность фильтра и при ограничении на Eg (безразмерной энергии усиления). В этом случае вариационная задача сводится к min винеровской ошибки: где - сигнал на выходе декодирующего фильтра при ограничении Eg. В этом случае в класс варьируемых кодирующих фильтров G не входит неискажающий фильтр с бесконечным числом степеней свободы (gk = 1), т. к. при этом Eg = ∞, а она ограничена. -

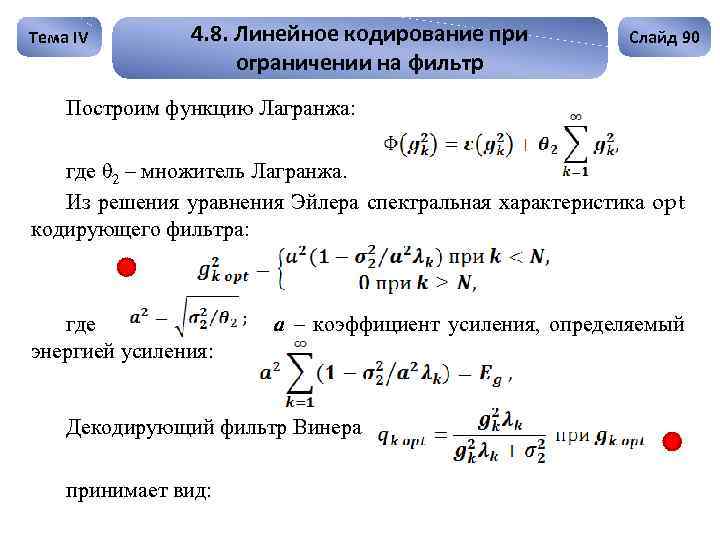

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 90 Построим функцию Лагранжа: где θ 2 – множитель Лагранжа. Из решения уравнения Эйлера спектральная характеристика opt кодирующего фильтра: где энергией усиления: а – коэффициент усиления, определяемый Декодирующий фильтр Винера принимает вид:

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 90 Построим функцию Лагранжа: где θ 2 – множитель Лагранжа. Из решения уравнения Эйлера спектральная характеристика opt кодирующего фильтра: где энергией усиления: а – коэффициент усиления, определяемый Декодирующий фильтр Винера принимает вид:

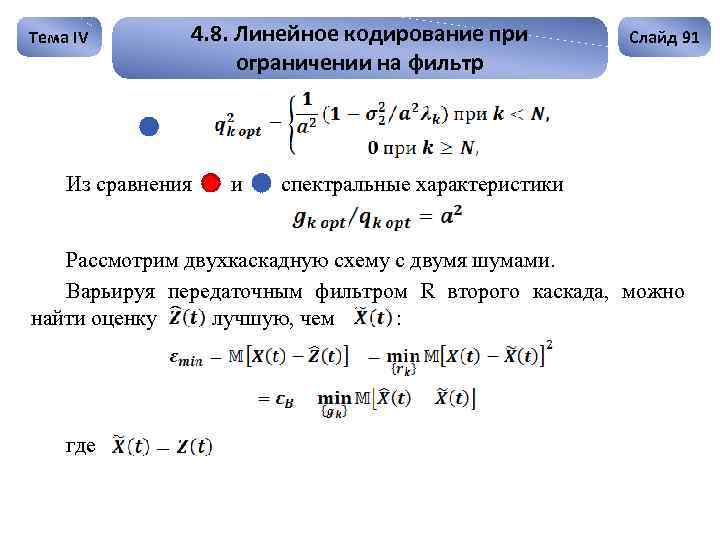

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Из сравнения и Слайд 91 спектральные характеристики Рассмотрим двухкаскадную схему с двумя шумами. Варьируя передаточным фильтром R второго каскада, можно найти оценку лучшую, чем : где

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Из сравнения и Слайд 91 спектральные характеристики Рассмотрим двухкаскадную схему с двумя шумами. Варьируя передаточным фильтром R второго каскада, можно найти оценку лучшую, чем : где

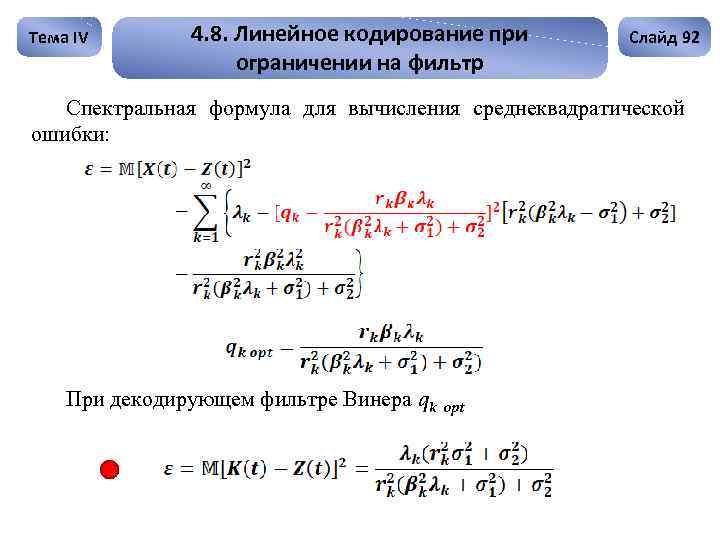

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 92 Спектральная формула для вычисления среднеквадратической ошибки: При декодирующем фильтре Винера qk opt

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 92 Спектральная формула для вычисления среднеквадратической ошибки: При декодирующем фильтре Винера qk opt

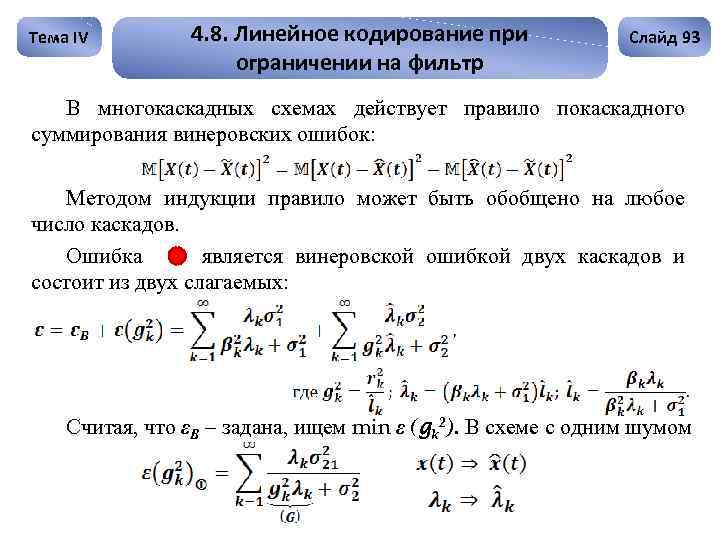

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 93 В многокаскадных схемах действует правило покаскадного суммирования винеровских ошибок: Методом индукции правило может быть обобщено на любое число каскадов. Ошибка является винеровской ошибкой двух каскадов и состоит из двух слагаемых: Считая, что εВ – задана, ищем min ε (gk 2). В схеме с одним шумом

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 93 В многокаскадных схемах действует правило покаскадного суммирования винеровских ошибок: Методом индукции правило может быть обобщено на любое число каскадов. Ошибка является винеровской ошибкой двух каскадов и состоит из двух слагаемых: Считая, что εВ – задана, ищем min ε (gk 2). В схеме с одним шумом

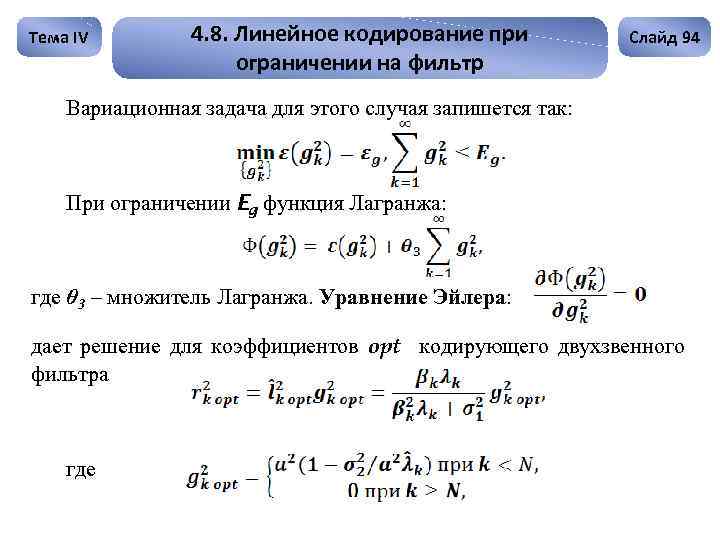

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 94 Вариационная задача для этого случая запишется так: При ограничении Eg функция Лагранжа: где θ 3 – множитель Лагранжа. Уравнение Эйлера: дает решение для коэффициентов opt кодирующего двухзвенного фильтра где

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 94 Вариационная задача для этого случая запишется так: При ограничении Eg функция Лагранжа: где θ 3 – множитель Лагранжа. Уравнение Эйлера: дает решение для коэффициентов opt кодирующего двухзвенного фильтра где

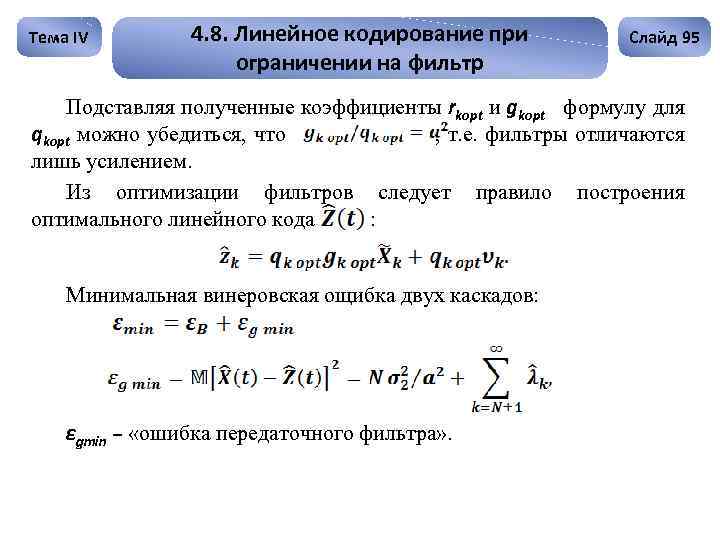

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 95 Подставляя полученные коэффициенты rkopt и gkopt формулу для qkopt можно убедиться, что , т. е. фильтры отличаются лишь усилением. Из оптимизации фильтров следует правило построения оптимального линейного кода : Минимальная винеровская ощибка двух каскадов: εgmin – «ошибка передаточного фильтра» .

Тема IV 4. 8. Линейное кодирование при ограничении на фильтр Слайд 95 Подставляя полученные коэффициенты rkopt и gkopt формулу для qkopt можно убедиться, что , т. е. фильтры отличаются лишь усилением. Из оптимизации фильтров следует правило построения оптимального линейного кода : Минимальная винеровская ощибка двух каскадов: εgmin – «ошибка передаточного фильтра» .

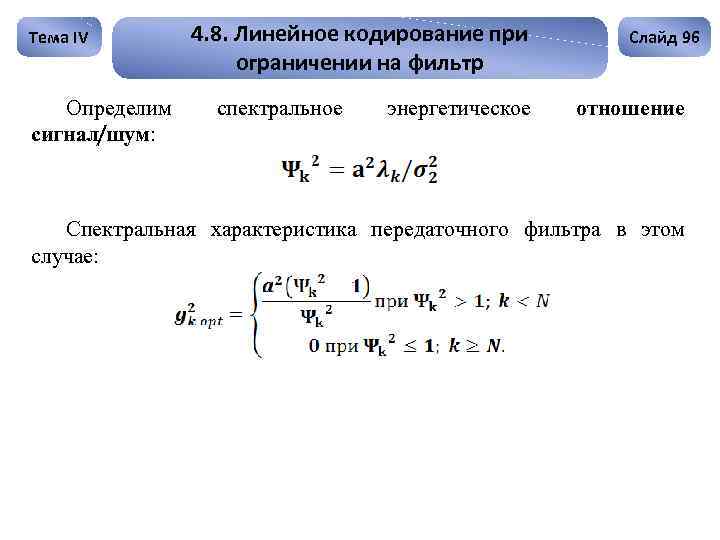

Тема IV Определим сигнал/шум: 4. 8. Линейное кодирование при ограничении на фильтр спектральное энергетическое Слайд 96 отношение Спектральная характеристика передаточного фильтра в этом случае:

Тема IV Определим сигнал/шум: 4. 8. Линейное кодирование при ограничении на фильтр спектральное энергетическое Слайд 96 отношение Спектральная характеристика передаточного фильтра в этом случае:

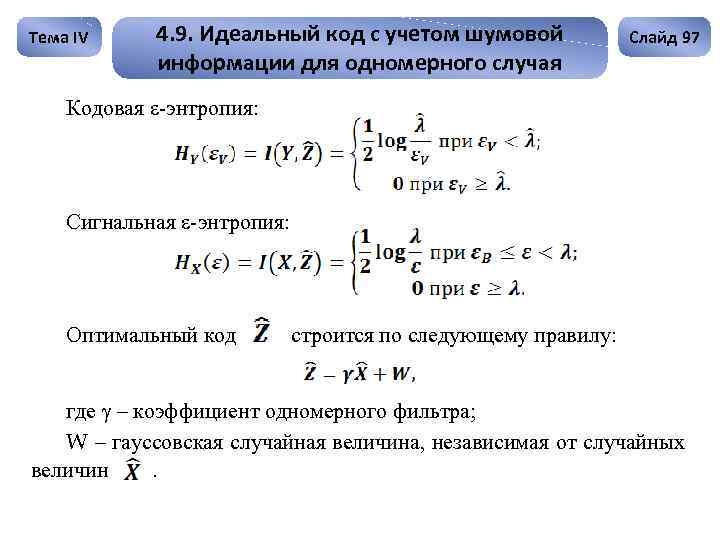

Тема IV 4. 9. Идеальный код с учетом шумовой информации для одномерного случая Слайд 97 Кодовая ε-энтропия: Сигнальная ε-энтропия: Оптимальный код строится по следующему правилу: где γ – коэффициент одномерного фильтра; W – гауссовская случайная величина, независимая от случайных величин.

Тема IV 4. 9. Идеальный код с учетом шумовой информации для одномерного случая Слайд 97 Кодовая ε-энтропия: Сигнальная ε-энтропия: Оптимальный код строится по следующему правилу: где γ – коэффициент одномерного фильтра; W – гауссовская случайная величина, независимая от случайных величин.

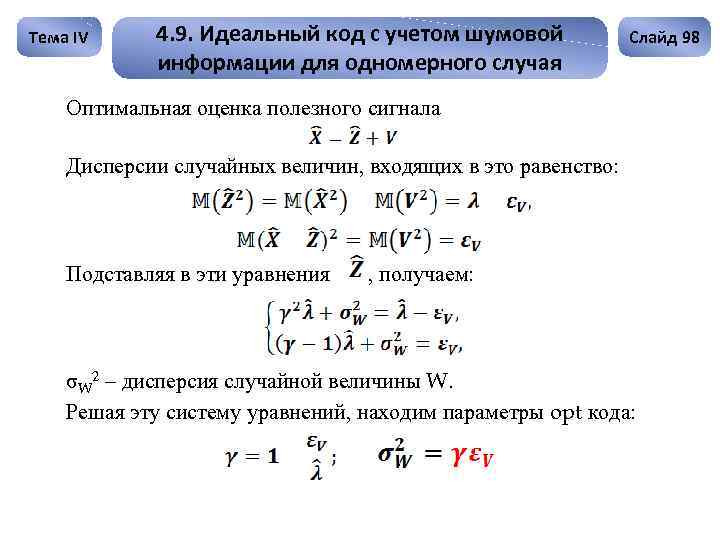

Тема IV 4. 9. Идеальный код с учетом шумовой информации для одномерного случая Слайд 98 Оптимальная оценка полезного сигнала Дисперсии случайных величин, входящих в это равенство: Подставляя в эти уравнения , получаем: σW 2 – дисперсия случайной величины W. Решая эту систему уравнений, находим параметры opt кода:

Тема IV 4. 9. Идеальный код с учетом шумовой информации для одномерного случая Слайд 98 Оптимальная оценка полезного сигнала Дисперсии случайных величин, входящих в это равенство: Подставляя в эти уравнения , получаем: σW 2 – дисперсия случайной величины W. Решая эту систему уравнений, находим параметры opt кода:

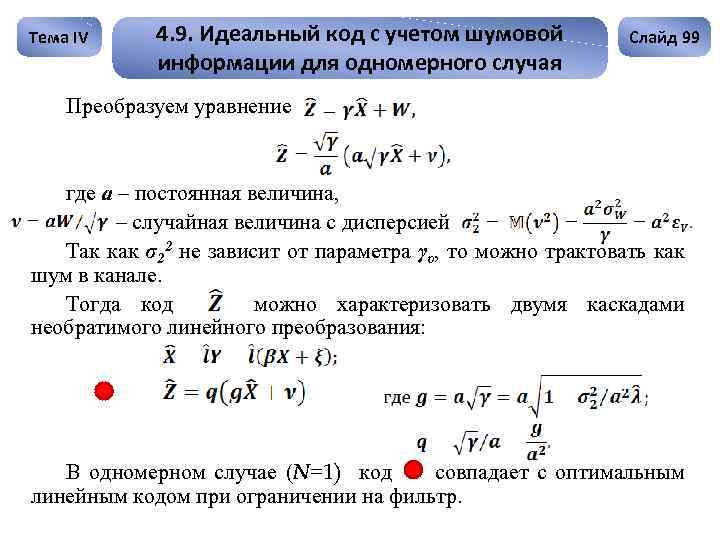

Тема IV 4. 9. Идеальный код с учетом шумовой информации для одномерного случая Слайд 99 Преобразуем уравнение где а – постоянная величина, – случайная величина с дисперсией Так как σ22 не зависит от параметра γυ, то можно трактовать как шум в канале. Тогда код можно характеризовать двумя каскадами необратимого линейного преобразования: В одномерном случае (N=1) код совпадает с оптимальным линейным кодом при ограничении на фильтр.

Тема IV 4. 9. Идеальный код с учетом шумовой информации для одномерного случая Слайд 99 Преобразуем уравнение где а – постоянная величина, – случайная величина с дисперсией Так как σ22 не зависит от параметра γυ, то можно трактовать как шум в канале. Тогда код можно характеризовать двумя каскадами необратимого линейного преобразования: В одномерном случае (N=1) код совпадает с оптимальным линейным кодом при ограничении на фильтр.

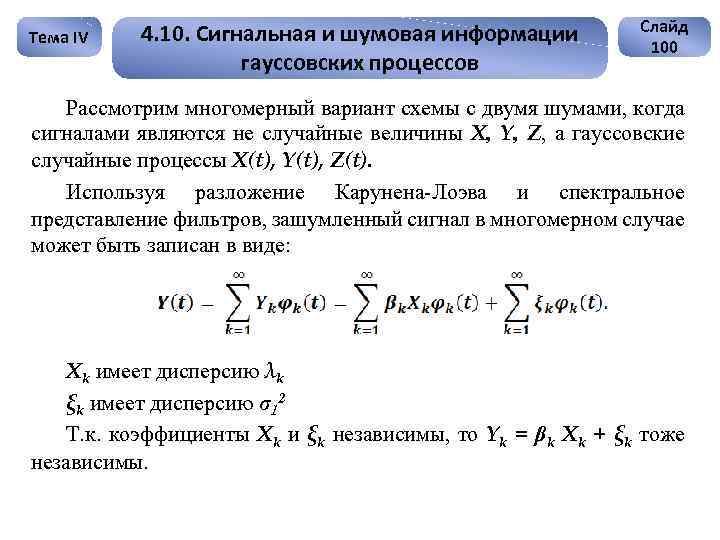

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов Слайд 100 Рассмотрим многомерный вариант схемы с двумя шумами, когда сигналами являются не случайные величины X, Y, Z, а гауссовские случайные процессы X(t), Y(t), Z(t). Используя разложение Карунена-Лоэва и спектральное представление фильтров, зашумленный сигнал в многомерном случае может быть записан в виде: Xk имеет дисперсию λk ξk имеет дисперсию σ12 Т. к. коэффициенты Xk и ξk независимы, то Yk = βk Xk + ξk тоже независимы.

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов Слайд 100 Рассмотрим многомерный вариант схемы с двумя шумами, когда сигналами являются не случайные величины X, Y, Z, а гауссовские случайные процессы X(t), Y(t), Z(t). Используя разложение Карунена-Лоэва и спектральное представление фильтров, зашумленный сигнал в многомерном случае может быть записан в виде: Xk имеет дисперсию λk ξk имеет дисперсию σ12 Т. к. коэффициенты Xk и ξk независимы, то Yk = βk Xk + ξk тоже независимы.

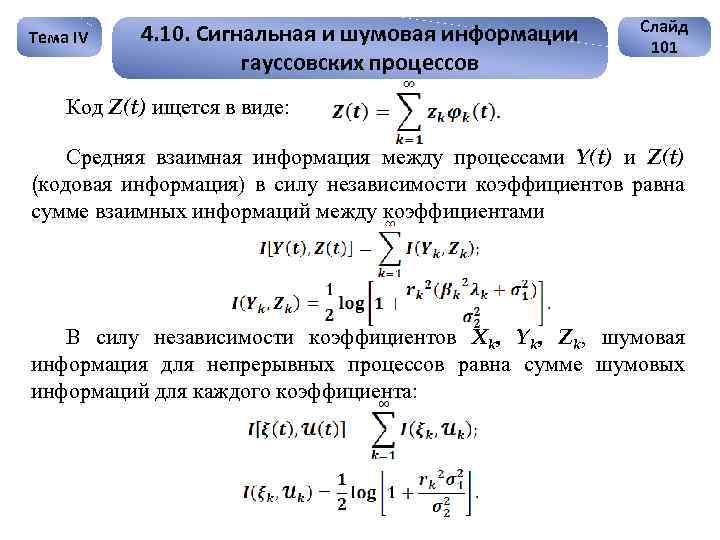

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов Слайд 101 Код Z(t) ищется в виде: Средняя взаимная информация между процессами Y(t) и Z(t) (кодовая информация) в силу независимости коэффициентов равна сумме взаимных информаций между коэффициентами В силу независимости коэффициентов Xk, Yk, Zk, шумовая информация для непрерывных процессов равна сумме шумовых информаций для каждого коэффициента:

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов Слайд 101 Код Z(t) ищется в виде: Средняя взаимная информация между процессами Y(t) и Z(t) (кодовая информация) в силу независимости коэффициентов равна сумме взаимных информаций между коэффициентами В силу независимости коэффициентов Xk, Yk, Zk, шумовая информация для непрерывных процессов равна сумме шумовых информаций для каждого коэффициента:

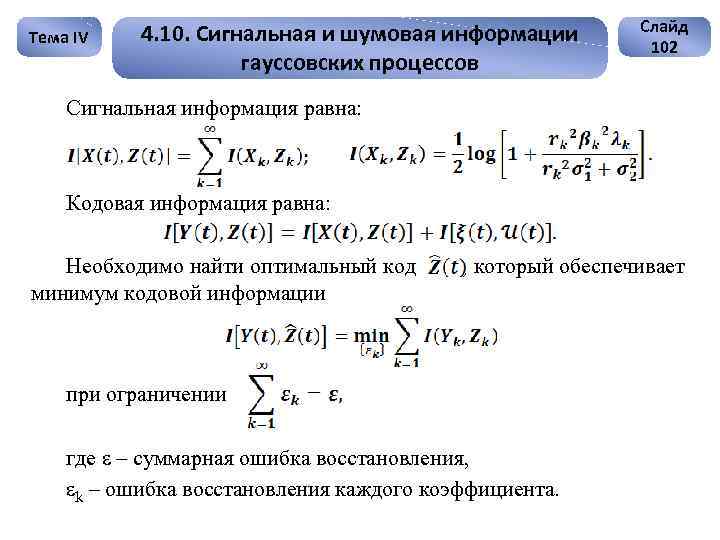

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов Слайд 102 Сигнальная информация равна: Кодовая информация равна: Необходимо найти оптимальный код минимум кодовой информации , который обеспечивает при ограничении где ε – суммарная ошибка восстановления, εk – ошибка восстановления каждого коэффициента.

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов Слайд 102 Сигнальная информация равна: Кодовая информация равна: Необходимо найти оптимальный код минимум кодовой информации , который обеспечивает при ограничении где ε – суммарная ошибка восстановления, εk – ошибка восстановления каждого коэффициента.

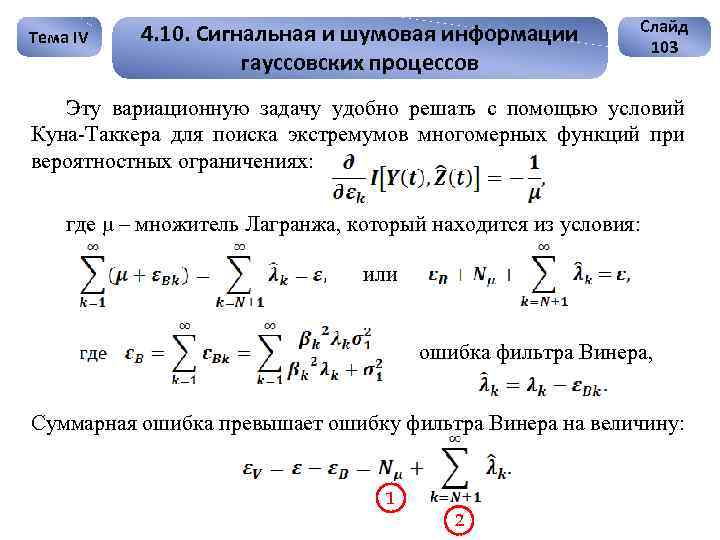

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов Слайд 103 Эту вариационную задачу удобно решать с помощью условий Куна-Таккера для поиска экстремумов многомерных функций при вероятностных ограничениях: где μ – множитель Лагранжа, который находится из условия: или ошибка фильтра Винера, Суммарная ошибка превышает ошибку фильтра Винера на величину: 1 2

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов Слайд 103 Эту вариационную задачу удобно решать с помощью условий Куна-Таккера для поиска экстремумов многомерных функций при вероятностных ограничениях: где μ – множитель Лагранжа, который находится из условия: или ошибка фильтра Винера, Суммарная ошибка превышает ошибку фильтра Винера на величину: 1 2

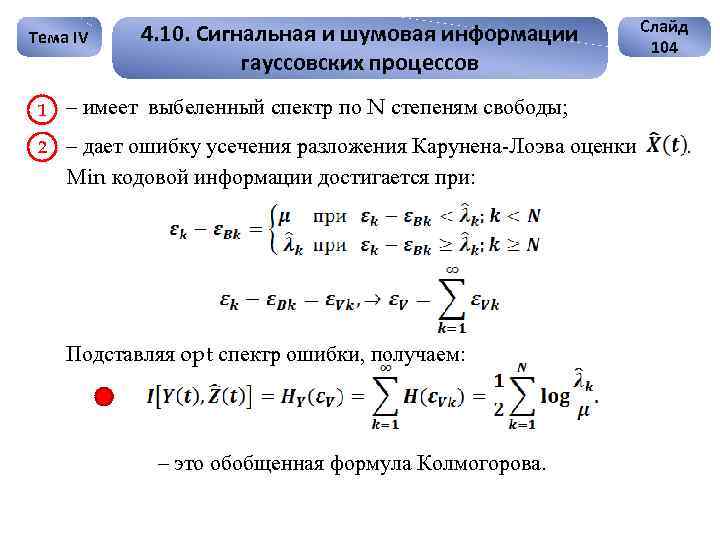

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов -1 – имеет выбеленный спектр по N степеням свободы; -2 - – дает ошибку усечения разложения Карунена-Лоэва оценки Min кодовой информации достигается при: - Подставляя opt спектр ошибки, получаем: Слайд 104 - – это обобщенная формула Колмогорова. .

Тема IV 4. 10. Сигнальная и шумовая информации гауссовских процессов -1 – имеет выбеленный спектр по N степеням свободы; -2 - – дает ошибку усечения разложения Карунена-Лоэва оценки Min кодовой информации достигается при: - Подставляя opt спектр ошибки, получаем: Слайд 104 - – это обобщенная формула Колмогорова. .

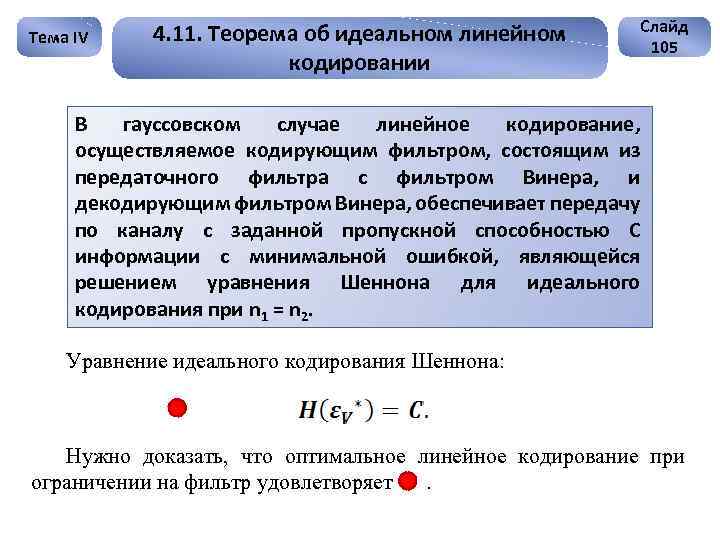

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 105 В гауссовском случае линейное кодирование, осуществляемое кодирующим фильтром, состоящим из передаточного фильтра с фильтром Винера, и декодирующим фильтром Винера, обеспечивает передачу по каналу с заданной пропускной способностью С информации с минимальной ошибкой, являющейся решением уравнения Шеннона для идеального кодирования при n 1 = n 2. Уравнение идеального кодирования Шеннона: Нужно доказать, что оптимальное линейное кодирование при ограничении на фильтр удовлетворяет.

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 105 В гауссовском случае линейное кодирование, осуществляемое кодирующим фильтром, состоящим из передаточного фильтра с фильтром Винера, и декодирующим фильтром Винера, обеспечивает передачу по каналу с заданной пропускной способностью С информации с минимальной ошибкой, являющейся решением уравнения Шеннона для идеального кодирования при n 1 = n 2. Уравнение идеального кодирования Шеннона: Нужно доказать, что оптимальное линейное кодирование при ограничении на фильтр удовлетворяет.

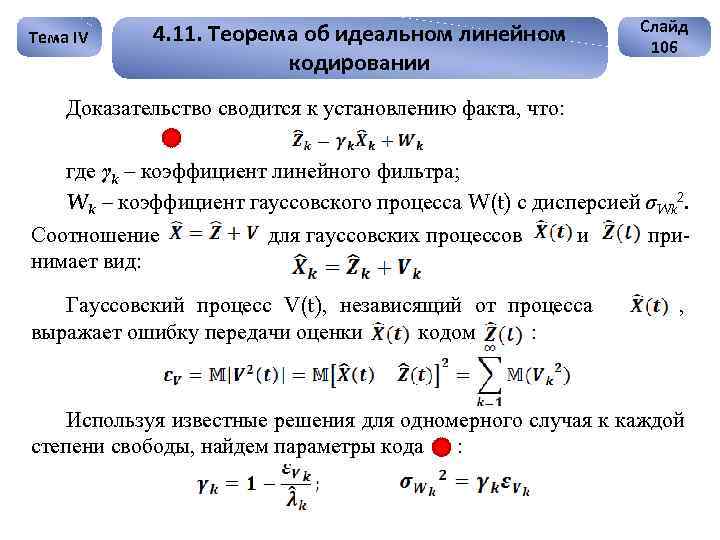

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 106 Доказательство сводится к установлению факта, что: где γk – коэффициент линейного фильтра; Wk – коэффициент гауссовского процесса W(t) с дисперсией σWk 2. Соотношение для гауссовских процессов и принимает вид: Гауссовский процесс V(t), независящий от процесса выражает ошибку передачи оценки кодом : , Используя известные решения для одномерного случая к каждой степени свободы, найдем параметры кода :

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 106 Доказательство сводится к установлению факта, что: где γk – коэффициент линейного фильтра; Wk – коэффициент гауссовского процесса W(t) с дисперсией σWk 2. Соотношение для гауссовских процессов и принимает вид: Гауссовский процесс V(t), независящий от процесса выражает ошибку передачи оценки кодом : , Используя известные решения для одномерного случая к каждой степени свободы, найдем параметры кода :

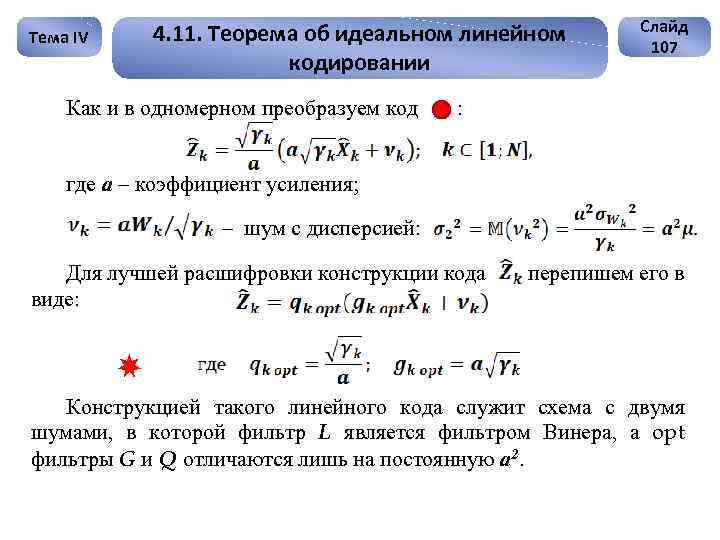

Тема IV 4. 11. Теорема об идеальном линейном кодировании Как и в одномерном преобразуем код Слайд 107 : где а – коэффициент усиления; - – шум с дисперсией: Для лучшей расшифровки конструкции кода виде: - перепишем его в Конструкцией такого линейного кода служит схема с двумя шумами, в которой фильтр L является фильтром Винера, а opt фильтры G и Q отличаются лишь на постоянную а 2. -

Тема IV 4. 11. Теорема об идеальном линейном кодировании Как и в одномерном преобразуем код Слайд 107 : где а – коэффициент усиления; - – шум с дисперсией: Для лучшей расшифровки конструкции кода виде: - перепишем его в Конструкцией такого линейного кода служит схема с двумя шумами, в которой фильтр L является фильтром Винера, а opt фильтры G и Q отличаются лишь на постоянную а 2. -

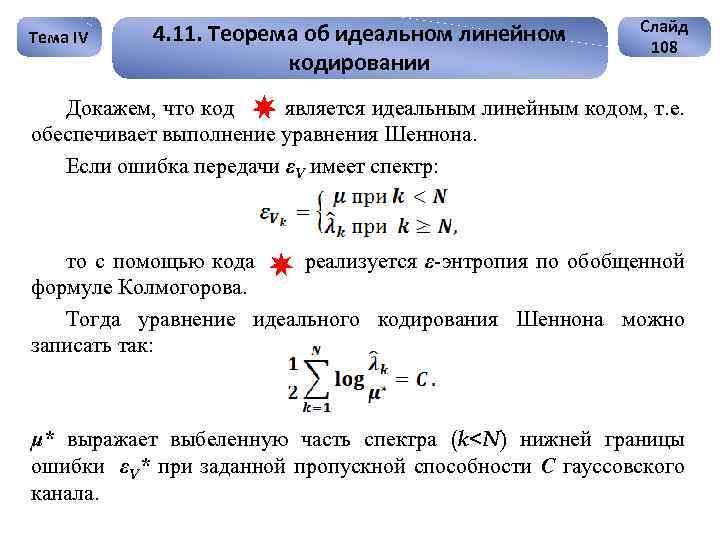

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 108 Докажем, что код является идеальным линейным кодом, т. е. обеспечивает выполнение уравнения Шеннона. Если ошибка передачи εV имеет спектр: то с помощью кода реализуется ε-энтропия по обобщенной формуле Колмогорова. Тогда уравнение идеального кодирования Шеннона можно записать так: μ* выражает выбеленную часть спектра (k

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 108 Докажем, что код является идеальным линейным кодом, т. е. обеспечивает выполнение уравнения Шеннона. Если ошибка передачи εV имеет спектр: то с помощью кода реализуется ε-энтропия по обобщенной формуле Колмогорова. Тогда уравнение идеального кодирования Шеннона можно записать так: μ* выражает выбеленную часть спектра (k

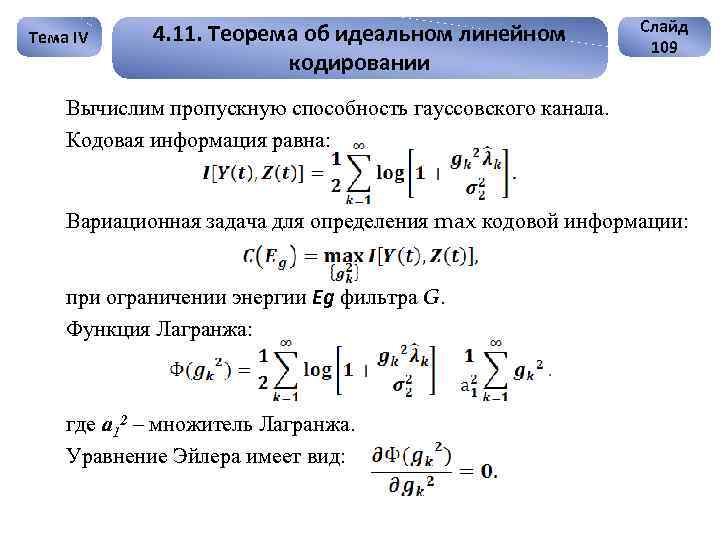

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 109 Вычислим пропускную способность гауссовского канала. Кодовая информация равна: Вариационная задача для определения max кодовой информации: при ограничении энергии Eg фильтра G. Функция Лагранжа: где а 12 – множитель Лагранжа. Уравнение Эйлера имеет вид:

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 109 Вычислим пропускную способность гауссовского канала. Кодовая информация равна: Вариационная задача для определения max кодовой информации: при ограничении энергии Eg фильтра G. Функция Лагранжа: где а 12 – множитель Лагранжа. Уравнение Эйлера имеет вид:

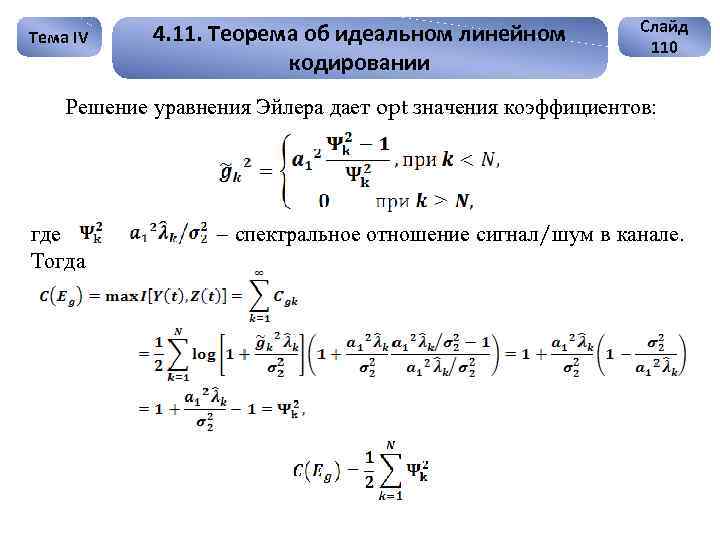

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 110 Решение уравнения Эйлера дает opt значения коэффициентов: где Тогда – спектральное отношение сигнал/шум в канале.

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 110 Решение уравнения Эйлера дает opt значения коэффициентов: где Тогда – спектральное отношение сигнал/шум в канале.

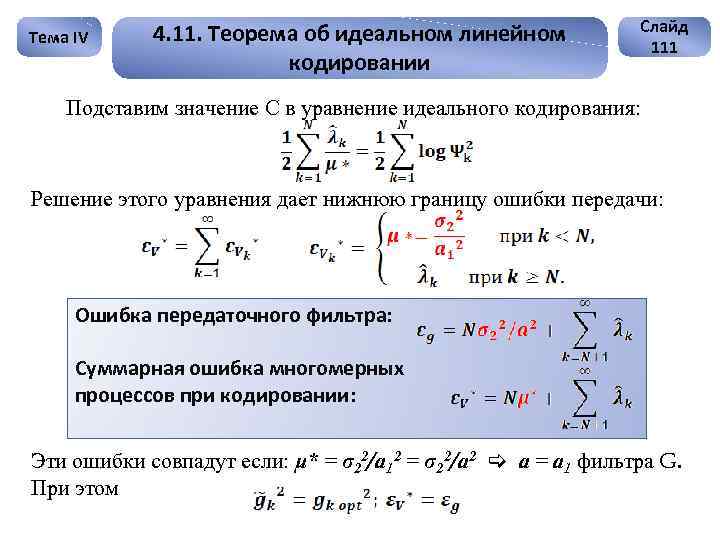

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 111 Подставим значение С в уравнение идеального кодирования: Решение этого уравнения дает нижнюю границу ошибки передачи: Ошибка передаточного фильтра: Суммарная ошибка многомерных процессов при кодировании: Эти ошибки совпадут если: μ* = σ22/а 12 = σ22/а 2 а = а 1 фильтра G. При этом

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 111 Подставим значение С в уравнение идеального кодирования: Решение этого уравнения дает нижнюю границу ошибки передачи: Ошибка передаточного фильтра: Суммарная ошибка многомерных процессов при кодировании: Эти ошибки совпадут если: μ* = σ22/а 12 = σ22/а 2 а = а 1 фильтра G. При этом

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 112 Таким образом, решения трех вариационных задач совпали → декодирующий фильтр при opt коде относится к типу фильтров Винера. Идеальный код реализуется с помощью простых линейных фильтров. Структурная схема кодирования с преобразованием Карунена-Лоэва Гауссовс. канал Y(t) Источник Блок прямого преобразо вания Карунена. Лоэва Ropt (t, τ) {Yk} Фильтр Винера LВ Шум Передаточный фильтр Gopt Блок обратного преобразования Карунена-Лоэва + Gopt

Тема IV 4. 11. Теорема об идеальном линейном кодировании Слайд 112 Таким образом, решения трех вариационных задач совпали → декодирующий фильтр при opt коде относится к типу фильтров Винера. Идеальный код реализуется с помощью простых линейных фильтров. Структурная схема кодирования с преобразованием Карунена-Лоэва Гауссовс. канал Y(t) Источник Блок прямого преобразо вания Карунена. Лоэва Ropt (t, τ) {Yk} Фильтр Винера LВ Шум Передаточный фильтр Gopt Блок обратного преобразования Карунена-Лоэва + Gopt

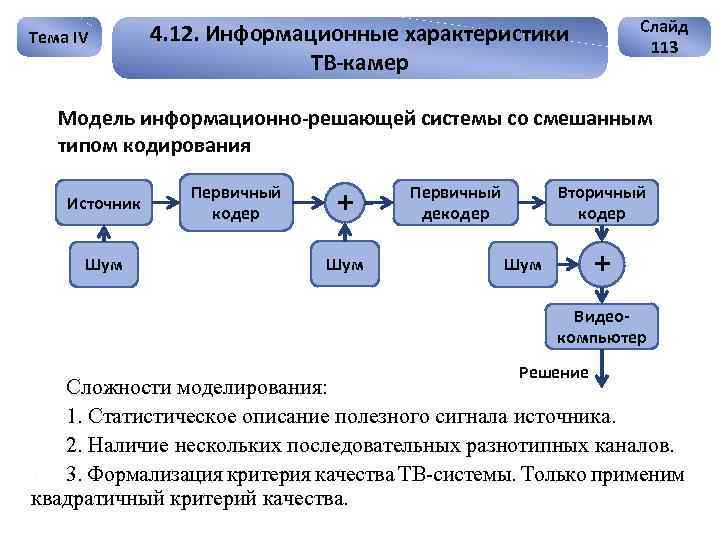

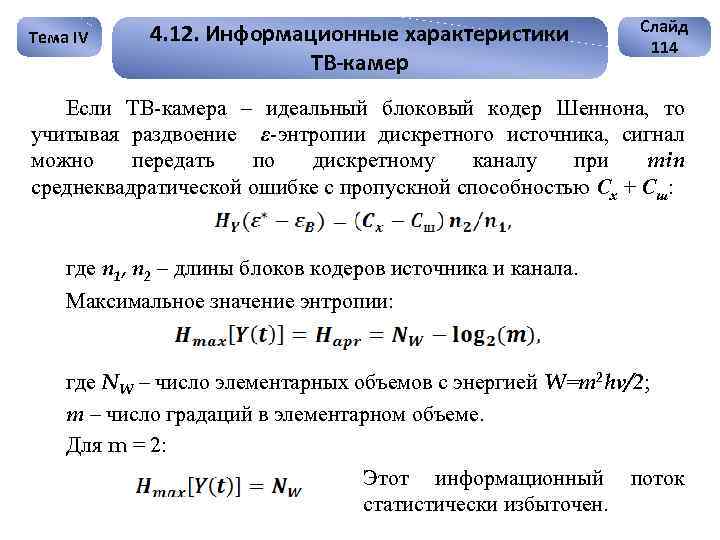

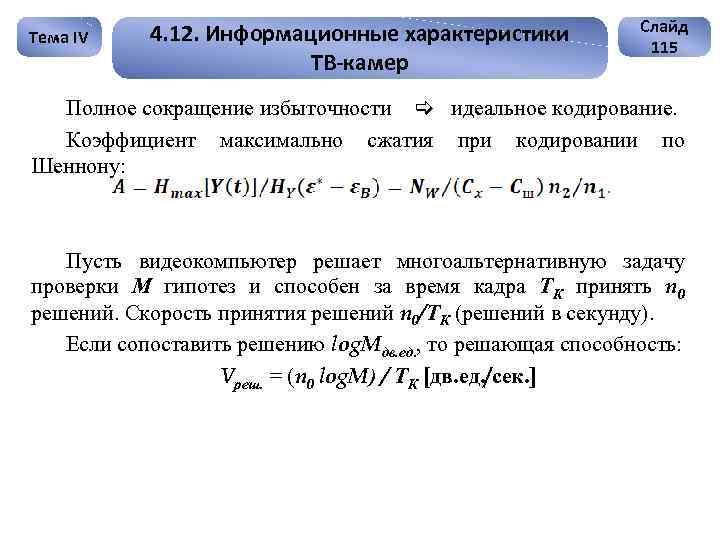

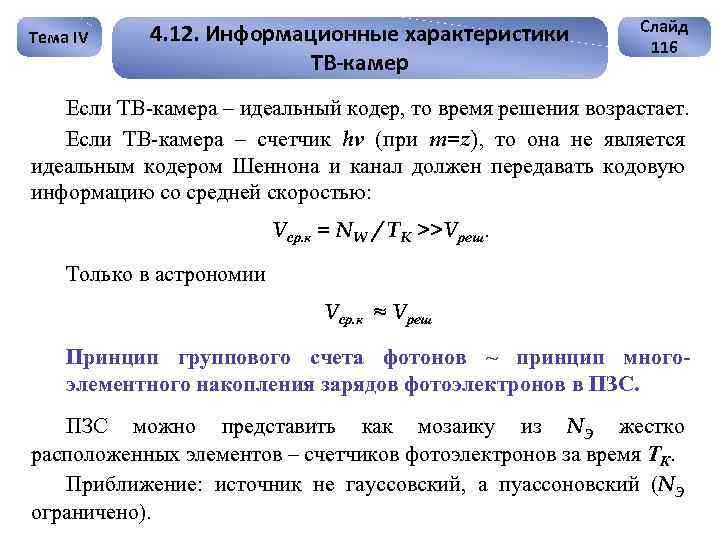

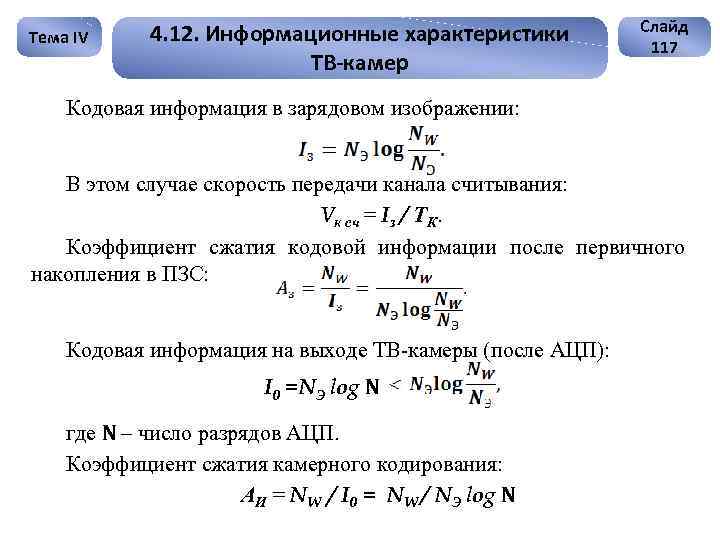

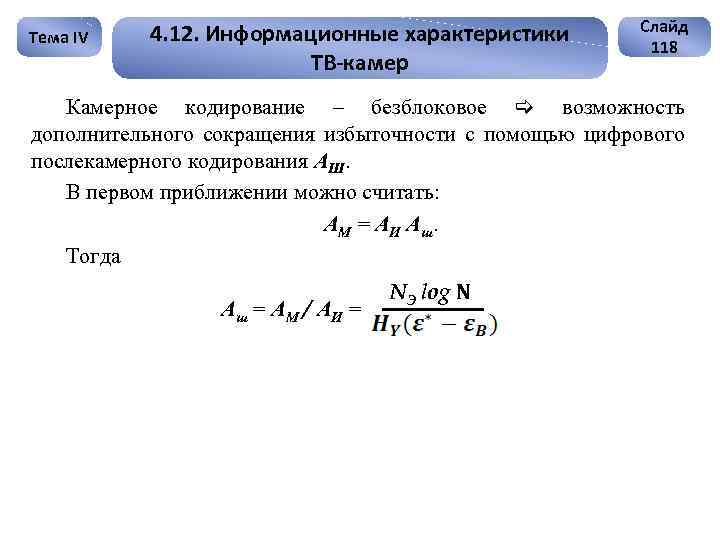

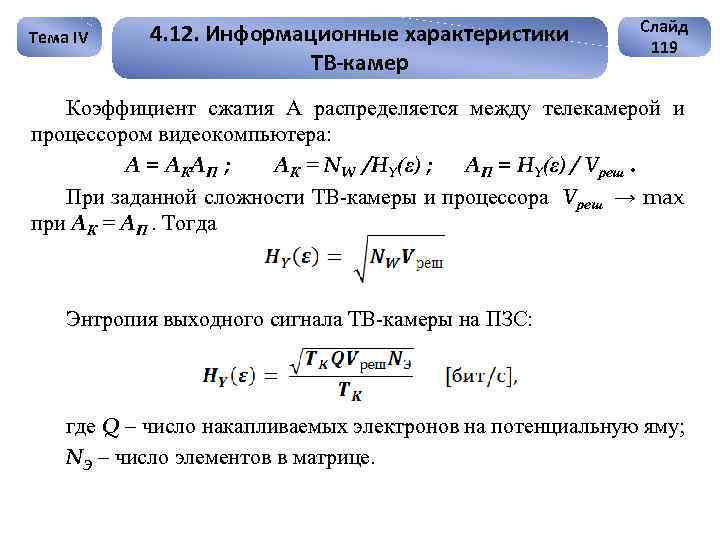

Тема IV Слайд 113 4. 12. Информационные характеристики ТВ-камер Модель информационно-решающей системы со смешанным типом кодирования Источник Шум Первичный кодер + Шум Первичный декодер Вторичный кодер + Шум Видеокомпьютер Решение Сложности моделирования: 1. 1. Статистическое описание полезного сигнала источника. 2. 2. Наличие нескольких последовательных разнотипных каналов. 3. 3. Формализация критерия качества ТВ-системы. Только применим квадратичный критерий качества.