18bc222474aeccabd6e611d619f0a3c3.ppt

- Количество слайдов: 75

Машинное обучение Введение Владимир Вежневец, Антон Конушин Александр Вежневец Компьютерное зрение МГУ ВМК, Осень 2006

План Лекции n n n Машинное обучение и его применение в машинном зрении; Формальное определение и основные понятия; Феномен переобучения; Состоятельность метода обучения; Элементы теории Вапника-Червоненкиса; Методы экспериментальной оценки и сравнения классификаторов;

Зачем нужно обучение? n n n Машинное обучение – настройка работы программы на данных-примерах или на предшествующем опыте. Обучение не требуется для того, чтобы отсортировать массив. Обучение требуется когда: n n n Опыт отсутствует или трудно формулируется (распознавание речи) Решение меняется со временем или решение должно легко адаптироваться к частным случаем (биометрия, маршрутизация в сетях) Точная, строго вычислимая модель слишком сложна для построения (шахматы)

Обучение подразумевает n Построение общей модели на основе конкретных примеров; n Нужно построить модель, которая является хорошим и практичным приближением данных.

Применение n Медицина: диагностика; Финансы: скоринг, обнаружение подделок; Сети: поисковые системы; Маркетинг: прогнозы продаж, связь с потребителем; Производство: дефектоскопия, оптимизация; Телекоммуникации: оптимизация качества сервиса; n Машинное зрение. n n n

Машинное обучение n С учителем n n n Без учителя n n n Есть объекты и «правильные ответы» на них – построить «связь» Например, есть гистограммы цветов ночных и дневных изображений, требуется построить правило по которым их можно отличать Есть данные, нужно сделать о них какие-то выводы Например, есть гистограмма цветов изображения, требуется выделить несколько основных цветов изображения «На лету» n Обучение происходит во время работы

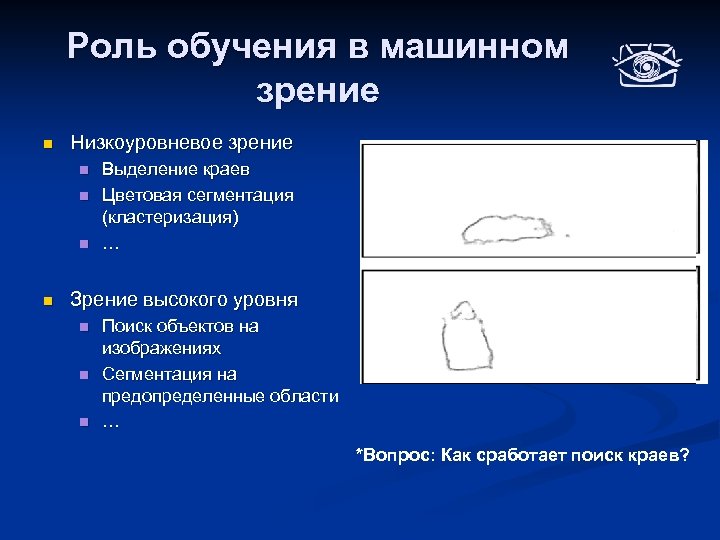

Роль обучения в машинном зрение n Низкоуровневое зрение n n Выделение краев Цветовая сегментация (кластеризация) … Зрение высокого уровня n n n Поиск объектов на изображениях Сегментация на предопределенные области … *Вопрос: Как сработает поиск краев?

Пример: Auto Pop. Up n Система автоматической сегментации и реконструкции сцены по одному изображению

Auto Pop. Up Пересегментированное Исходное изображение *Материал предыдущих лекций

Auto Pop. Up *Вопрос: какие могут быть дескрипторы областей? Высокая размерность! Множество векторов дескрипторов областей Пересегментированное изображение *Материал предыдущих лекций

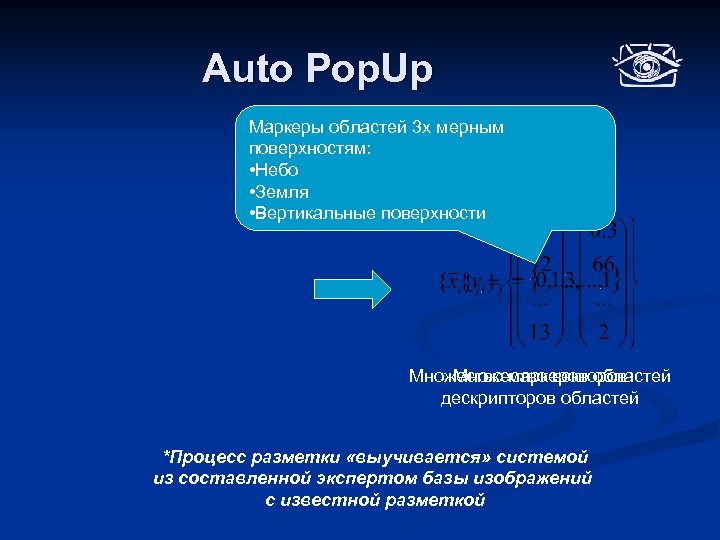

Auto Pop. Up Маркеры областей 3 х мерным поверхностям: • Небо • Земля • Вертикальные поверхности Множество векторов Множество маркеров областей дескрипторов областей *Процесс разметки «выучивается» системой из составленной экспертом базы изображений с известной разметкой

Auto Pop. Up Множество маркеров областей Перенос разметки на изображение и её анализ *Анализ разметки проводится алгоритмами о которых пойдёт речь в третьей части курса

Auto Pop. Up Трехмерная модель!

Auto Pop. Up n Почему здесь потребовалось именно обучение и можно ли было обойтись без него? n Данные: n n Высокая размерность – десятки признаков; Огромное количество – на каждом изображении порядка сотни регионов; Сложная, неочевидная для человека связь между описанием региона и его маркером; Подбор правила вручную (экспертом) занял бы очень много времени и не мог бы гарантировать желаемый результат!

Auto Pop. Up n Обучение дало: n n n Автоматизированный рабочий процесс; Четкие количественные оценки качества; Гарантированный результат;

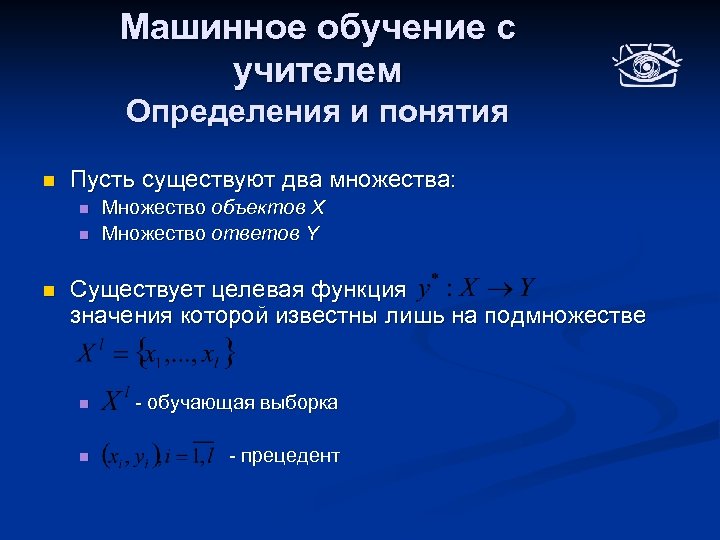

Машинное обучение с учителем Определения и понятия n Пусть существуют два множества: n n n Множество объектов X Множество ответов Y Существует целевая функция значения которой известны лишь на подмножестве n - обучающая выборка n - прецедент

Машинное обучение Постановка задачи n Требуется построить отображение (гипотезу) такое что: n a – допускает эффективную программную реализацию; n n n Отображение воспроизводит на обучающей выборке требуемые ответы (возможно, с некоторой вероятностью) Отображение способно к обобщению – совпадает с целевым не только на обучающей выборке. Возможны дополнительные ограничения – гладкость, монотонность и т. д. (определяется задачей)

Машинное обучение Различные частные задачи n Классификация: Y – конечное множество n n Multiclass - n n Бинарная - Multilabel - Регрессия: , действительные числа

Замечание n В данной постановке задача является некорректно поставленной и сама по себе ставит множество вопросов: n В каком виде искать гипотезу а? n Ясно, что решений будет существовать бесконечное число, как выбрать из них одно единственное? n Какой математический аппарат применять? n …

Модель алгоритма n Пусть А – параметрическое семейство отображений n n Г – пространство допустимых значений параметра (пространство поиска) Будем выбирать отображение для решение задачи из А n Процесс выбора назовём обучением

Метод обучения n Отображение , строящее отображение по обучающей выборке назовём методом обучения n Метод должен допускать эффективную программную реализацию; n Обучение сводится к поиску точки в пространстве поиска Г

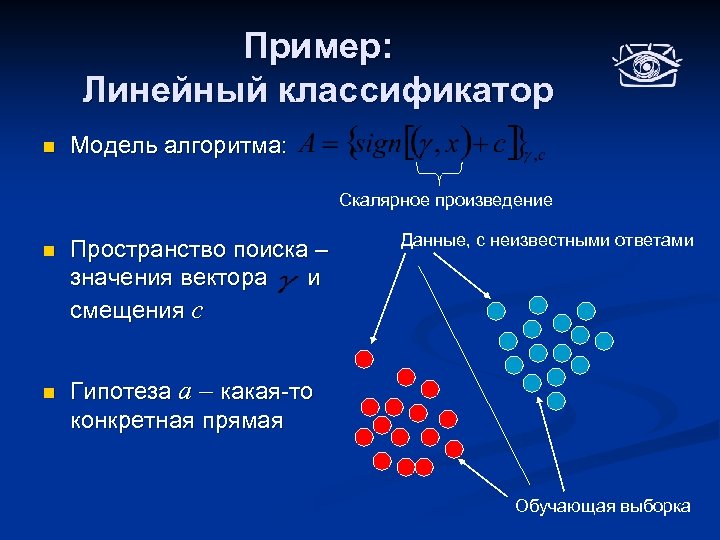

Пример: Линейный классификатор n Модель алгоритма: Скалярное произведение n n Пространство поиска – значения вектора и смещения с Данные, с неизвестными ответами Гипотеза a – какая-то конкретная прямая Обучающая выборка

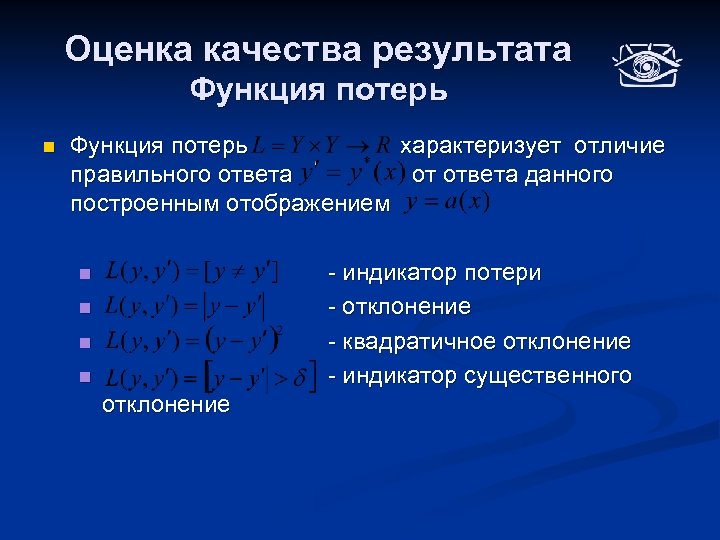

Оценка качества результата Функция потерь n Функция потерь характеризует отличие правильного ответа от ответа данного построенным отображением - индикатор потери - отклонение - квадратичное отклонение - индикатор существенного n n отклонение

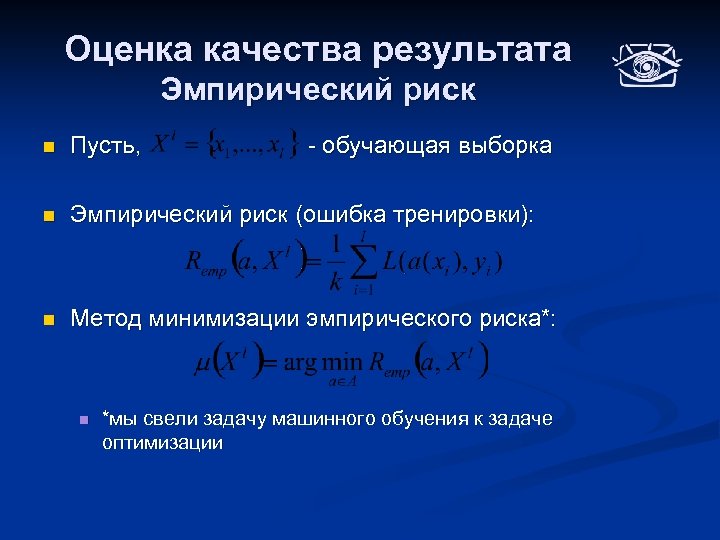

Оценка качества результата Эмпирический риск n Пусть, n Эмпирический риск (ошибка тренировки): n Метод минимизации эмпирического риска*: n - обучающая выборка *мы свели задачу машинного обучения к задаче оптимизации

Замечание n Гипотез, имеющих нулевой эмпирический риск может так же существовать неограниченное количество: Наиболее частная гипотеза Золотая середина? Вопрос: Какова здесь модель? Наиболее общая гипотеза

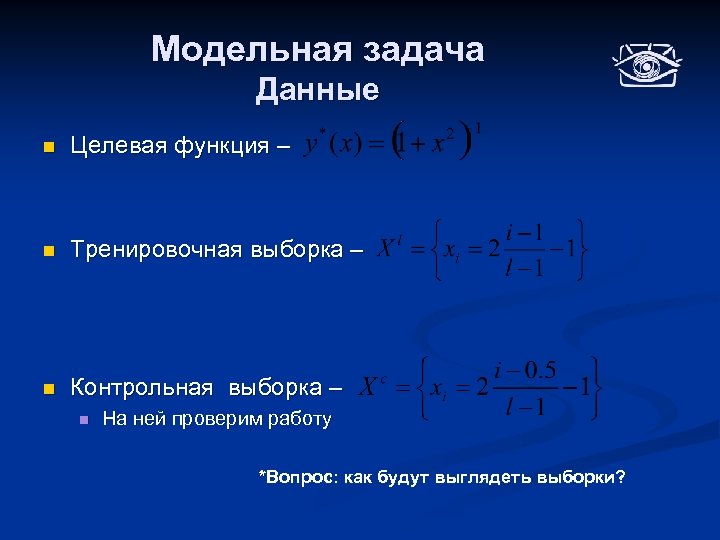

Модельная задача Данные n Целевая функция – n Тренировочная выборка – n Контрольная выборка – n На ней проверим работу *Вопрос: как будут выглядеть выборки?

Модельная задача Модель алгоритма и метод обучения n Модель алгоритма – n Полиномы степени n n Метод обучения – n Минимизация эмпирического риска *Методы аппроксимации полиномами известны из курса численных методов

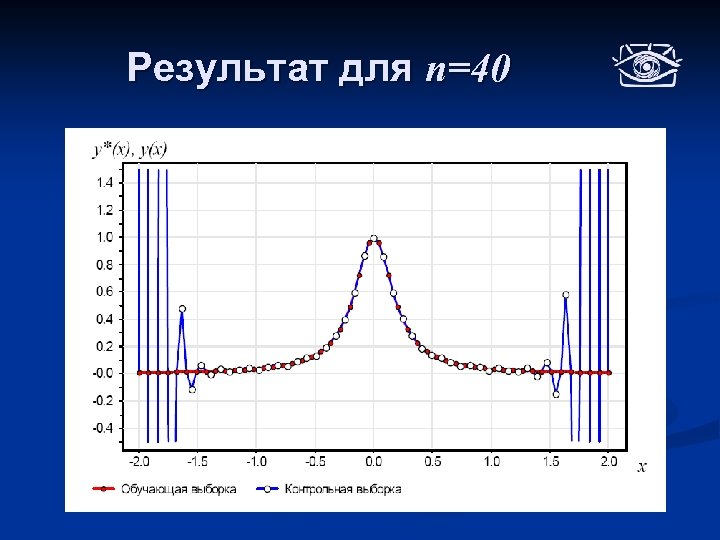

Результат для n=40

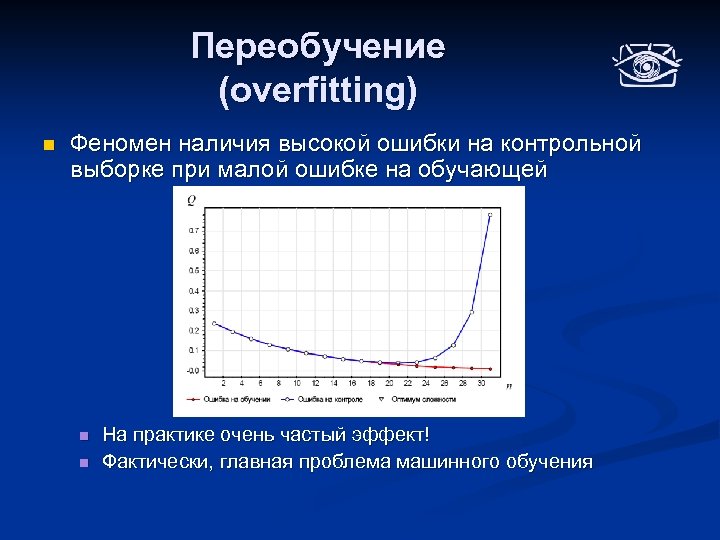

Переобучение (overfitting) n Феномен наличия высокой ошибки на контрольной выборке при малой ошибке на обучающей n n На практике очень частый эффект! Фактически, главная проблема машинного обучения

Переобучение n Причина – гипотеза хорошо описывает свойства не объектов в целом, но только лишь объектов из обучающей выборки: n n Слишком много степеней свободы параметров модели алгоритма (слишком сложная модель) Шум в данных Плохая обучающая выборка Как формализовать и оценить склонность алгоритма к переобучению?

Состоятельность метода На пальцах n Метод состоятелен, если он с большой вероятностью делает маленькую ошибку на данных не присутствовавших в обучающей выборке n n Мы говорим «с большой вероятностью» потому что точно мы не сможем сказать никогда Требуется вероятностная формулировка обучения

Вероятностная формулировка n n Пусть – вероятностное пространство Пусть мера пространства P n Множество прецедентов выбрано случайно и независимо согласно распределению P (случайная выборка); для них известны ответы n Требуется построить отображение

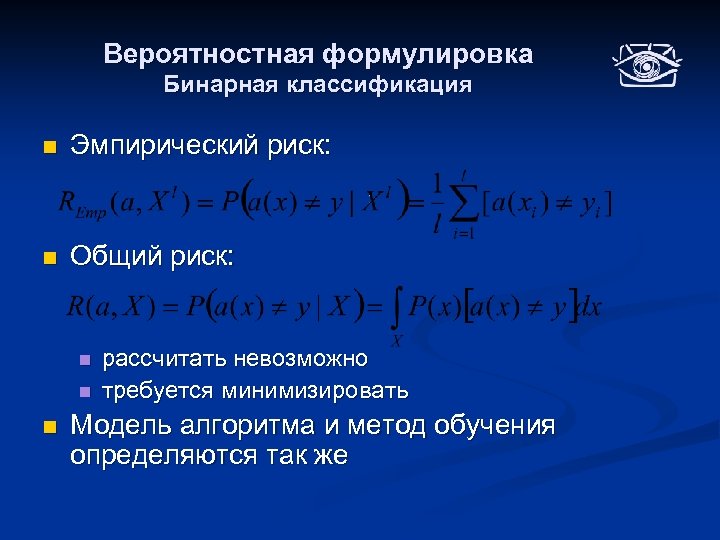

Вероятностная формулировка Бинарная классификация n Эмпирический риск: n Общий риск: n n n рассчитать невозможно требуется минимизировать Модель алгоритма и метод обучения определяются так же

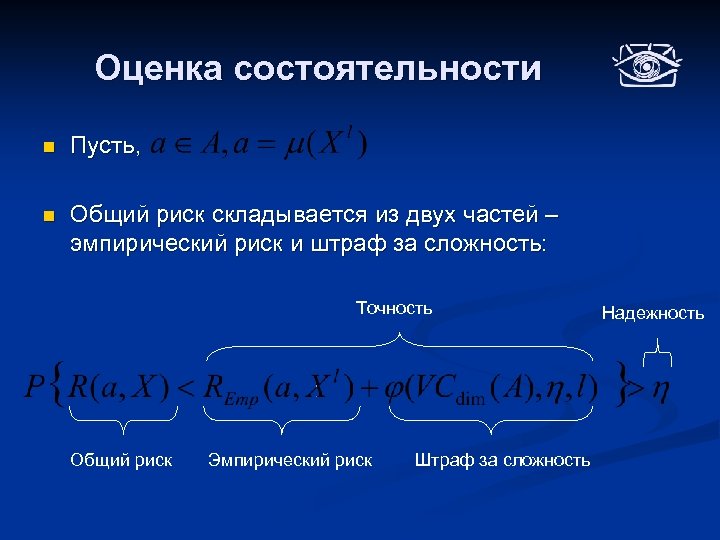

Состоятельность метода n Метод обучения называется состоятельным, если Точность Надежность Общий риск n Для достаточно малых значений точности и больших значений надёжности

Вопросы n Как оценить состоятельность метода? n Как выбрать оптимальный, с точки зрения общего риска, алгоритм?

Теория Вапника-Червоненкиса n Теория, предложенная русским математиком Владимиром Вапником, для оценки способности к обучению различных моделей алгоритмов n Основные результаты теории: n n Оценка сложности (емкости) модели алгоритма Оценка состоятельности через эмпирический риск и сложность модели

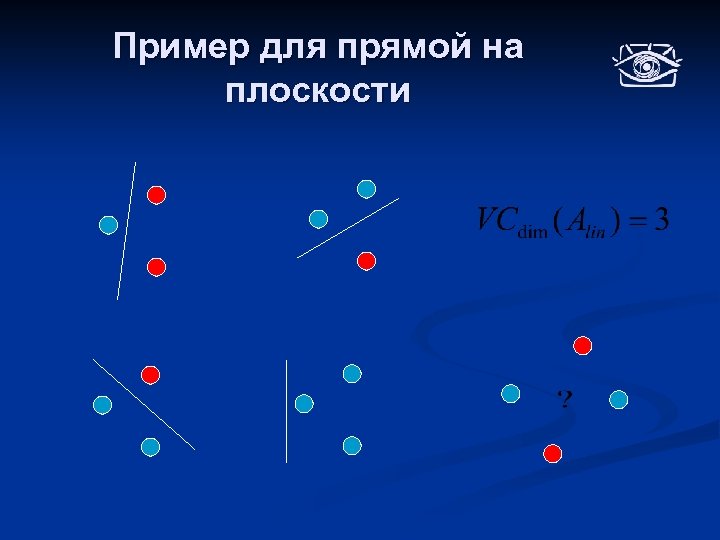

Размерность Вапника-Червоненкиса n Пусть: n А – модель алгоритма (бинарной классификации) n n Пример – A – все прямые, a – конкретная прямая X – исходное пространство объектов n Тогда, размерностью Вапника-Червоненкиса модели алгоритма А, назовем число равное максимальному числу точек из X, которые алгоритмы из А могут разбить на два класса всеми возможными способами n Обозначение:

Пример для прямой на плоскости

Оценка состоятельности n Пусть, n Общий риск складывается из двух частей – эмпирический риск и штраф за сложность: Точность Общий риск Эмпирический риск Штраф за сложность Надежность

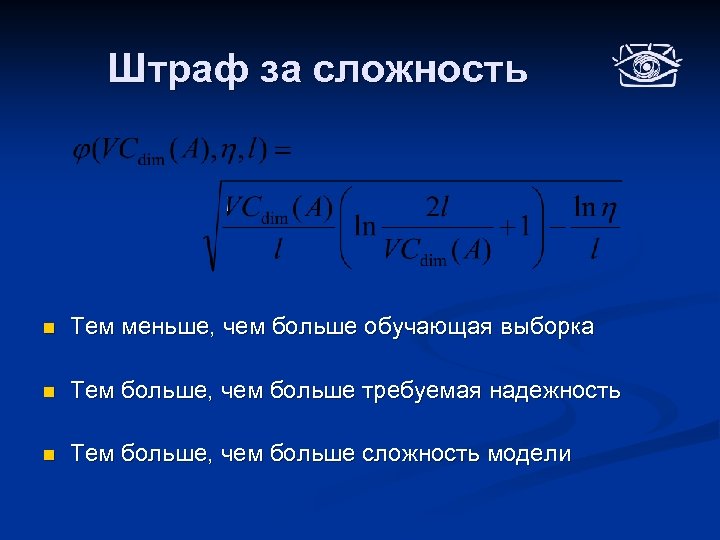

Штраф за сложность n Тем меньше, чем больше обучающая выборка n Тем больше, чем больше требуемая надежность n Тем больше, чем больше сложность модели

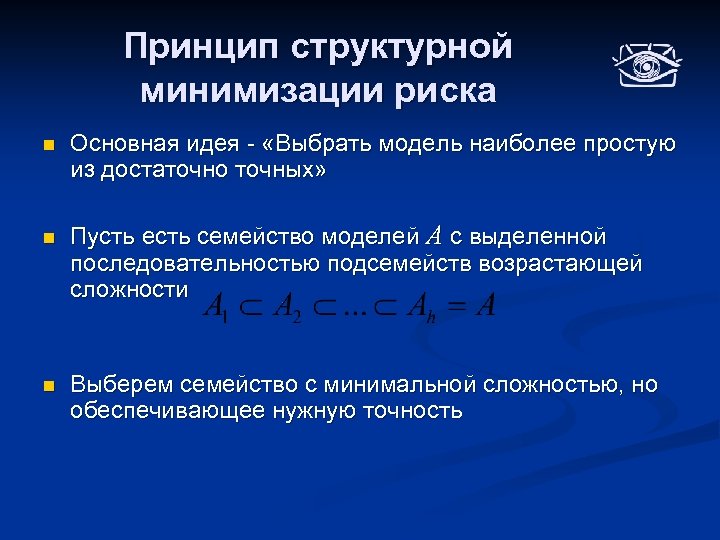

Принцип структурной минимизации риска n n n Основная идея - «Выбрать модель наиболее простую из достаточно точных» Пусть есть семейство моделей А с выделенной последовательностью подсемейств возрастающей сложности Выберем семейство с минимальной сложностью, но обеспечивающее нужную точность

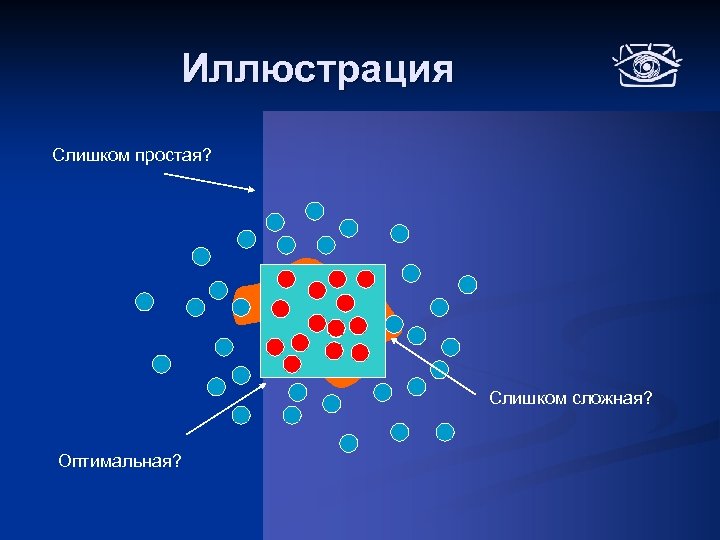

Иллюстрация Слишком простая? Слишком сложная? Оптимальная?

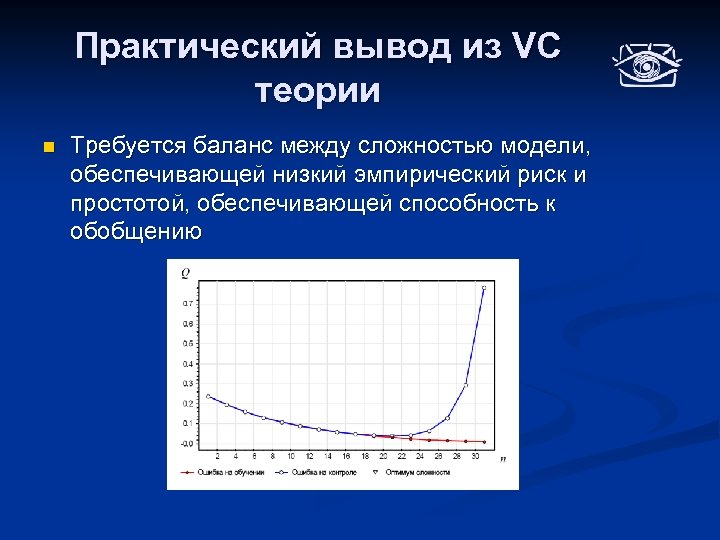

Практический вывод из VC теории n Требуется баланс между сложностью модели, обеспечивающей низкий эмпирический риск и простотой, обеспечивающей способность к обобщению

Проблема теоретических оценок общего риска n Нетривиально рассчитываются для конкретных алгоритмов n Сильно завышены n Как следствие, для практической задачи малоинформативны

Методы экспериментальной оценки качества алгоритмов n Для конкретной задачи, желательно получить точные количественные оценки качества работы n Используются экспериментальные методы: n n Удерживание Скользящий контроль 5 -2 контроль …

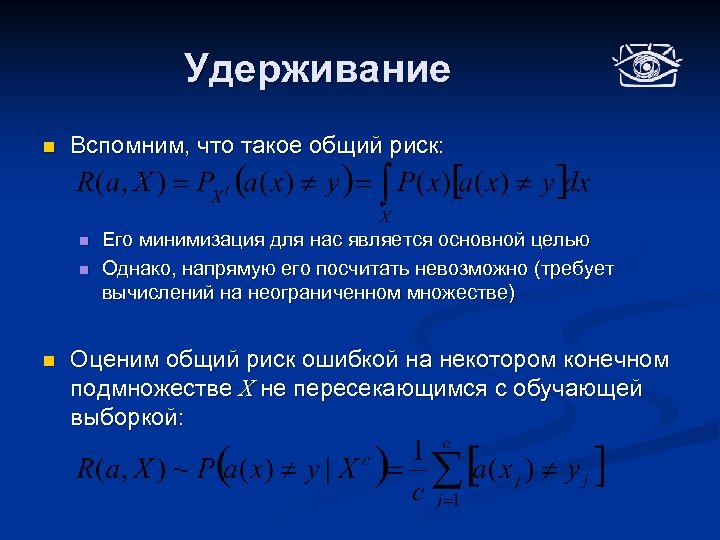

Удерживание n Вспомним, что такое общий риск: n n n Его минимизация для нас является основной целью Однако, напрямую его посчитать невозможно (требует вычислений на неограниченном множестве) Оценим общий риск ошибкой на некотором конечном подмножестве X не пересекающимся с обучающей выборкой:

Удерживание n Пусть, имеется набор данных известными ответами n Разобьем n Будем использовать для обучения контроля n То есть: с , а для

Недостатки удерживания n Быстро и просто рассчитывается n Обучение Некоторые «сложные» прецеденты могут полностью попасть в только одну из выборок и тогда оценка ошибки будет смещенной Ошибка произойдет не по вине классификатора, а из -за разбиения! *возможна и обратная ситуация Контроль

Повторное удерживание n Если разбиение на контроль и обучение может быть не устойчивым, то почему бы не провести его много раз и не усреднить? n n n Такой методикой мы частично избавимся от проблемы «сложных прецедентов» ; НО, вероятность того, что какие-то прецеденты ни разу не попадут в контрольную выборку всё равно велика; Процесс становиться сильно рандомизированным;

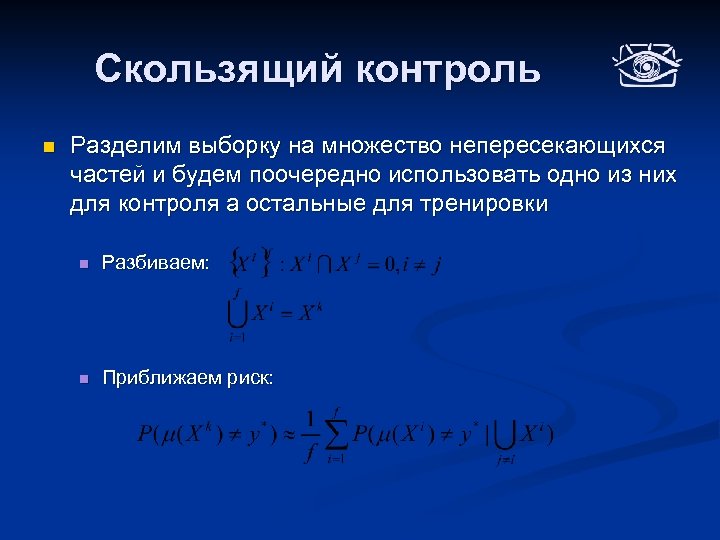

Скользящий контроль n Разделим выборку на множество непересекающихся частей и будем поочередно использовать одно из них для контроля а остальные для тренировки n Разбиваем: n Приближаем риск:

Иллюстрация Контроль Обучение Результат считается как средняя ошибка по всем итерациям

Свойства n В пределе равен общему риску n Каждый прецедент будет один раз присутствовать в контрольной выборке n Обучающие выборки будут сильно перекрываться (чем больше сегментов, тем больше перекрытие) n Если один группа «сложных прецедентов» попала полностью в один сегмент, то оценка будет смещенной

5 -2 контроль (5 -2 cross validation) n Некоторый компромисс: n n n Проведем замер ошибки методом скользящего контроля с двумя сегментами Повторим этот эксперимент пять раз и усредним результат Свойства: n n Каждый из прецедентов будет учувствовать в контрольных выборках на каждом из 5 этапов; Из-за малого числа сегментов и множества испытаний вероятность того, что какая-то группа прецедентов всегда будет в одном сегменте становится очень мала

Почему так? n Мы привели лишь эвристическое обоснование данных методик, НО для этого всего есть строгое обоснование основанное на мат-статистике

Виды ошибок n Измерения ошибки как «вероятности выдать неверный ответ» может быть не всегда достаточно n n 15% ошибки при постановке диагноза может означать как и то что, 15 % больных будут признаны здоровыми (и возможно умрут от отсутствия лечения), так и то, что 15% здоровых больными (и деньги на лечение будут потрачены зря) При неравнозначности ошибок для разных классов вводят понятие ошибки первого и второго рода и замеряют их по отдельности

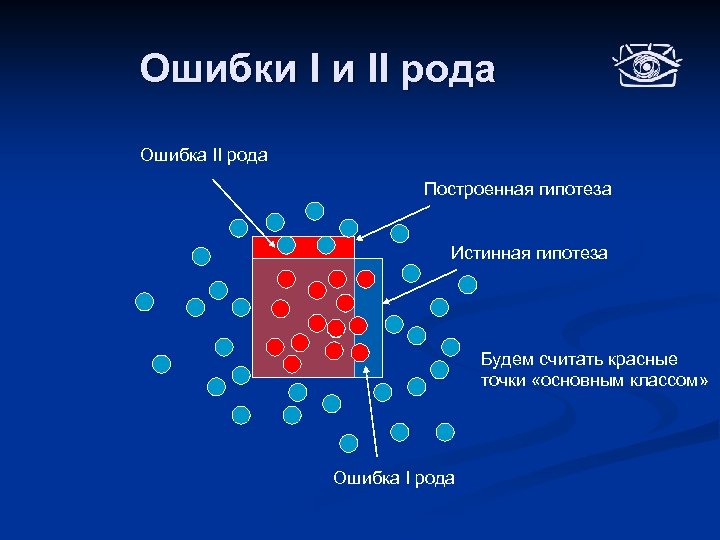

Ошибки I и II рода n Пусть, существует «основной класс» n n n Ошибка первого рода равна вероятности принять основной класс за вторичный n n Обычно, это класс, при обнаружении которого, предпринимается какое-либо действие; Например, при постановке диагноза основным классом будет «болен» , а вторичным классом «здоров» . Вероятность «промаха» , когда искомый объект будет пропущен Ошибка второго рода равна вероятности принять вторичный класс за основной n Вероятность «ложной тревоги» , когда за искомый объект будет принят «фон»

Ошибки I и II рода Ошибка II рода Построенная гипотеза Истинная гипотеза Будем считать красные точки «основным классом» Ошибка I рода

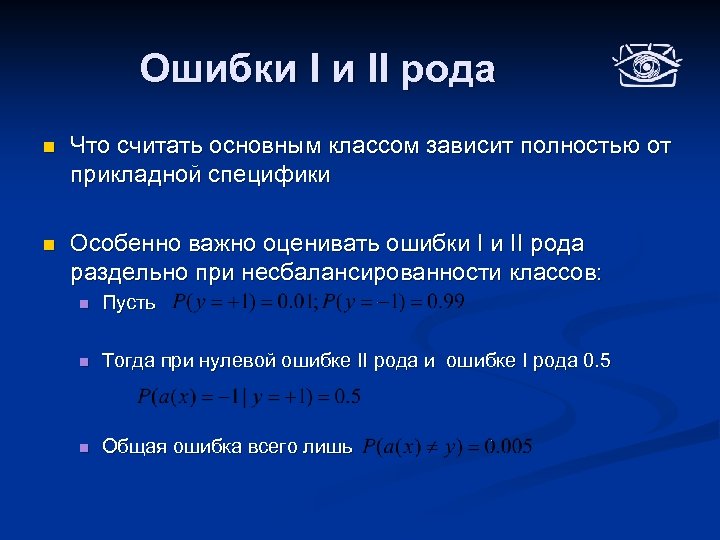

Ошибки I и II рода n Что считать основным классом зависит полностью от прикладной специфики n Особенно важно оценивать ошибки I и II рода раздельно при несбалансированности классов: n Пусть n Тогда при нулевой ошибке II рода и ошибке I рода 0. 5 n Общая ошибка всего лишь

Чувствительность vs Избирательность n Чувствительность – вероятность дать правильный ответ на пример основного класса n Избирательность – вероятность дать правильный ответ на пример вторичного класса *Вопрос – как связаны данные понятия и ошибки I и II рода?

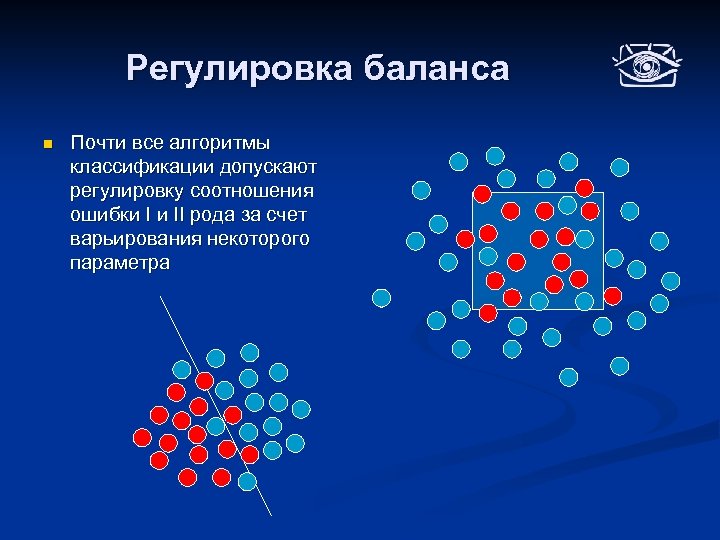

Регулировка баланса n Почти все алгоритмы классификации допускают регулировку соотношения ошибки I и II рода за счет варьирования некоторого параметра

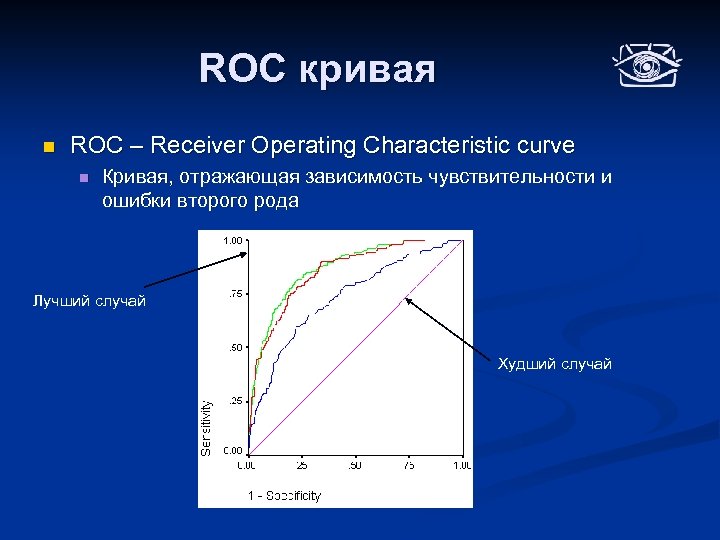

ROC кривая n ROC – Receiver Operating Characteristic curve n Кривая, отражающая зависимость чувствительности и ошибки второго рода Лучший случай Худший случай

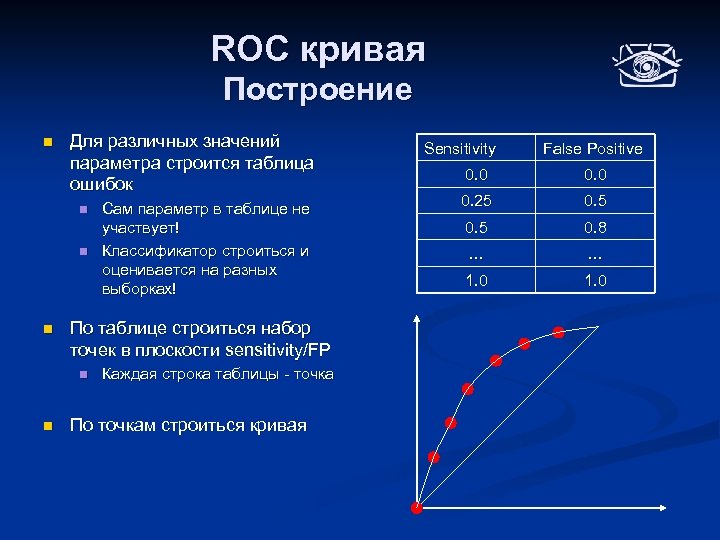

ROC кривая Построение n Для различных значений параметра строится таблица ошибок n n n По таблице строиться набор точек в плоскости sensitivity/FP n n Сам параметр в таблице не участвует! Классификатор строиться и оценивается на разных выборках! Каждая строка таблицы - точка По точкам строиться кривая Sensitivity False Positive 0. 0 0. 25 0. 8 … … 1. 0

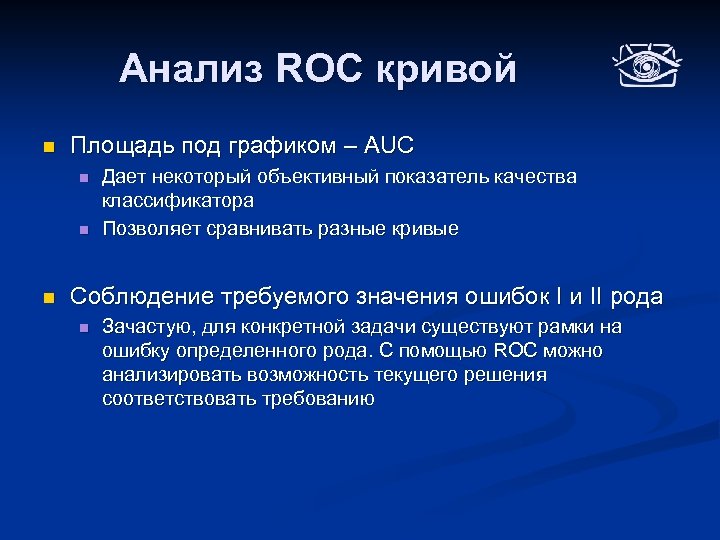

Анализ ROC кривой n Площадь под графиком – AUC n n n Дает некоторый объективный показатель качества классификатора Позволяет сравнивать разные кривые Соблюдение требуемого значения ошибок I и II рода n Зачастую, для конкретной задачи существуют рамки на ошибку определенного рода. С помощью ROC можно анализировать возможность текущего решения соответствовать требованию

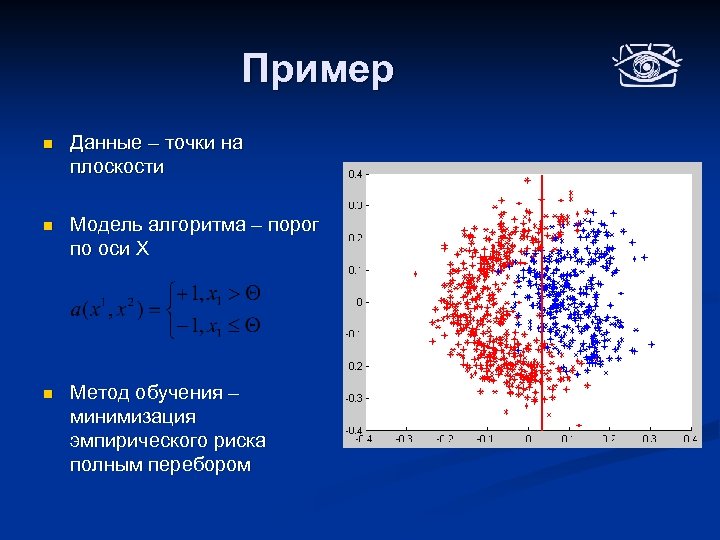

Пример n Данные – точки на плоскости n Модель алгоритма – порог по оси X n Метод обучения – минимизация эмпирического риска полным перебором

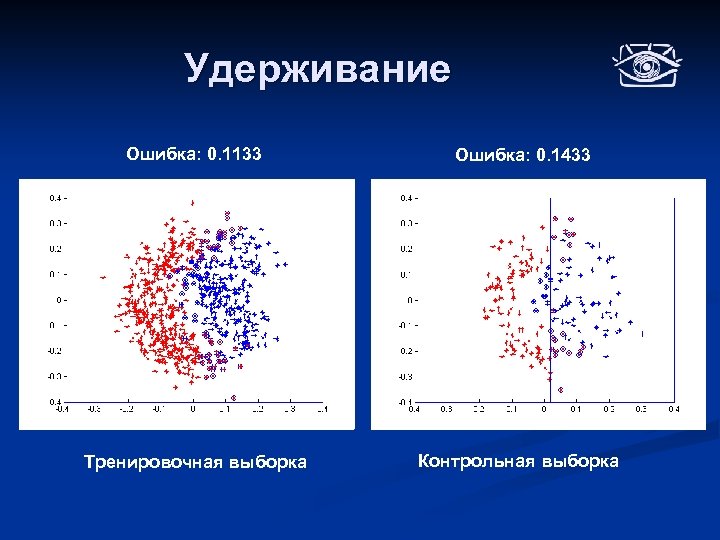

Удерживание Ошибка: 0. 1133 Ошибка: 0. 1433 Тренировочная выборка Контрольная выборка

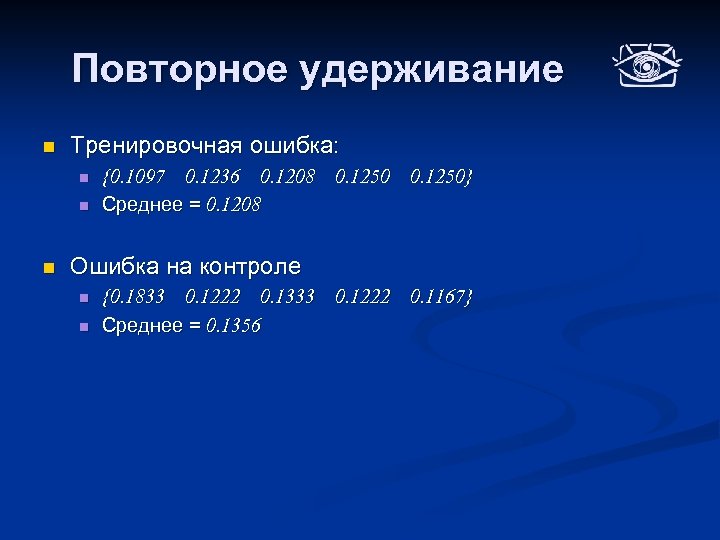

Повторное удерживание n Тренировочная ошибка: n n n {0. 1097 0. 1236 0. 1208 0. 1250} Среднее = 0. 1208 Ошибка на контроле n n {0. 1833 0. 1222 0. 1333 0. 1222 0. 1167} Среднее = 0. 1356

Скользящий контроль Разбиваем на множества

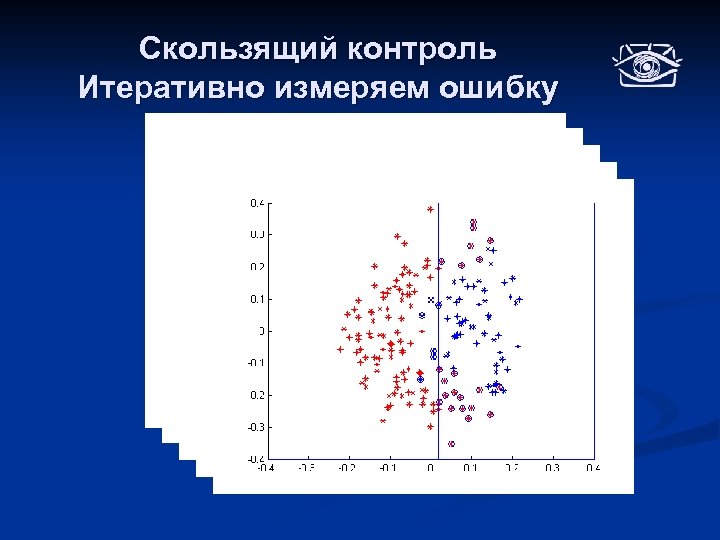

Скользящий контроль Итеративно измеряем ошибку

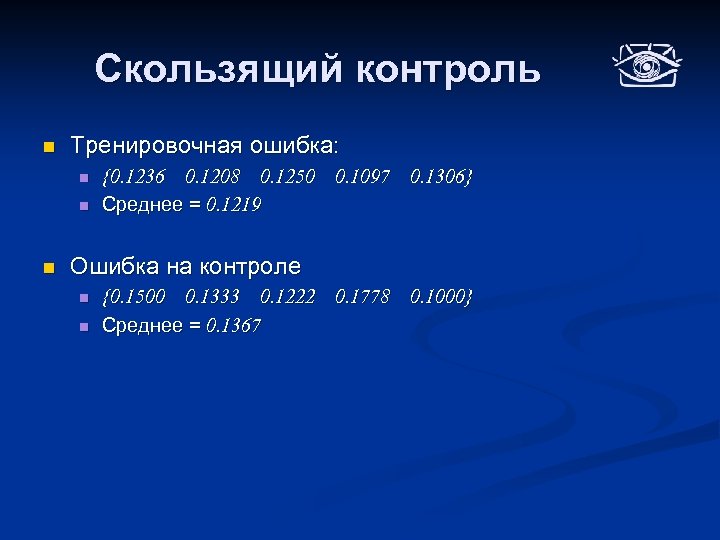

Скользящий контроль n Тренировочная ошибка: n n n {0. 1236 0. 1208 0. 1250 0. 1097 0. 1306} Среднее = 0. 1219 Ошибка на контроле n n {0. 1500 0. 1333 0. 1222 0. 1778 0. 1000} Среднее = 0. 1367

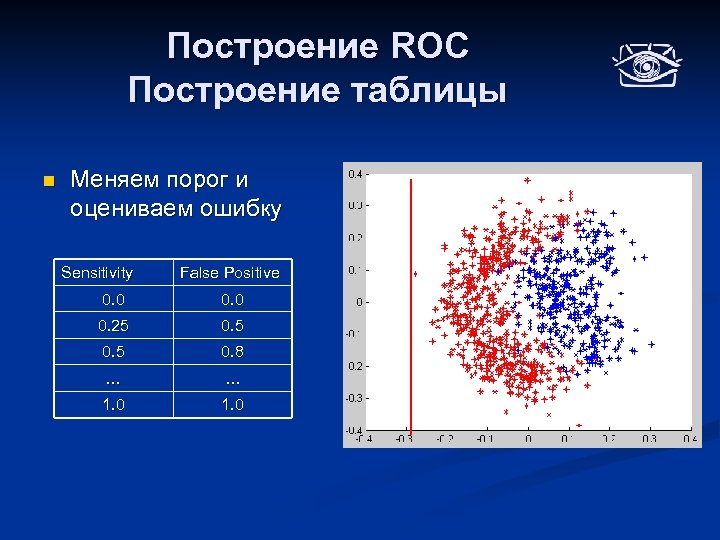

Построение ROC Построение таблицы n Меняем порог и оцениваем ошибку Sensitivity False Positive 0. 0 0. 25 0. 8 … … 1. 0

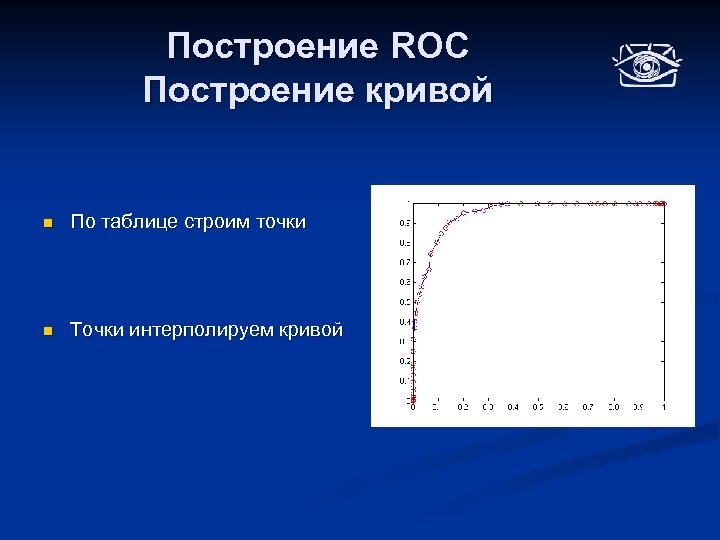

Построение ROC Построение кривой n По таблице строим точки n Точки интерполируем кривой

Итоги лекции Возможные вопросы на экзамене! n n Постановка задачи машинного обучения с учителем Основные определения: n n n n Принцип минимизации эмпирического риска и проблема переобучения Состоятельность метода обучения Размерность Вапника-Червоненкиса семейства моделей Оценка состоятельности семейства моделей Принцип структурной минимизации риска Экспериментальные методы оценки классификаторов n n n Модель алгоритма, метод обучения, гипотеза, общий и эмпирический риск Удерживание, скользящий контроль Ошибка I и II рода ROC кривая

Следующая лекция n Обзор методов обучения n Вероятно, будет выдано второе задание

Сдайте e-mail!

Использованы материалы n Слайды доклада «Supervised Learning of Edges and Object Boundaries» Piotr Dollár Zhuowen Tu Serge Belongie n Черновики лекций «Математические методы обучения по прецедентам» Константин Воронцов

18bc222474aeccabd6e611d619f0a3c3.ppt