Лк3_Линейная множественная регрессия.ppt

- Количество слайдов: 33

Линейная множественная регрессия лекция № 3

Линейная множественная регрессия лекция № 3

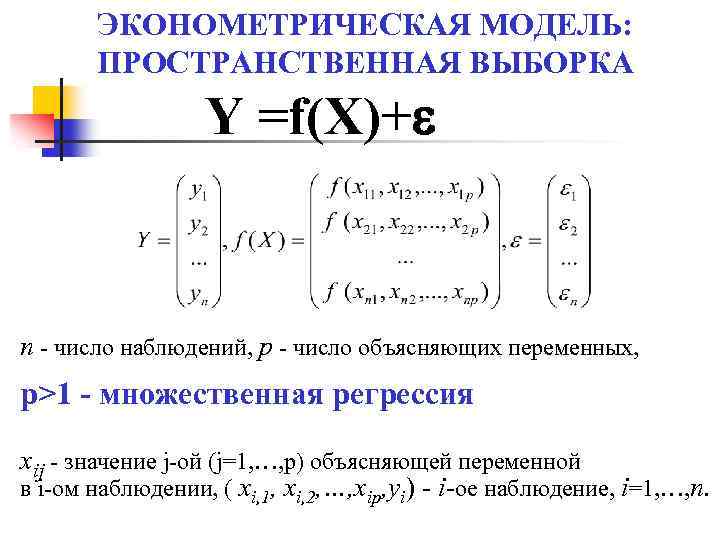

ЭКОНОМЕТРИЧЕСКАЯ МОДЕЛЬ: ПРОСТРАНСТВЕННАЯ ВЫБОРКА Y =f(X)+ n - число наблюдений, р - число объясняющих переменных, p>1 - множественная регрессия xij - значение j-ой (j=1, …, p) объясняющей переменной в i-ом наблюдении, ( xi, 1, xi, 2, …, xip, yi) - i-oe наблюдение, i=1, …, n.

ЭКОНОМЕТРИЧЕСКАЯ МОДЕЛЬ: ПРОСТРАНСТВЕННАЯ ВЫБОРКА Y =f(X)+ n - число наблюдений, р - число объясняющих переменных, p>1 - множественная регрессия xij - значение j-ой (j=1, …, p) объясняющей переменной в i-ом наблюдении, ( xi, 1, xi, 2, …, xip, yi) - i-oe наблюдение, i=1, …, n.

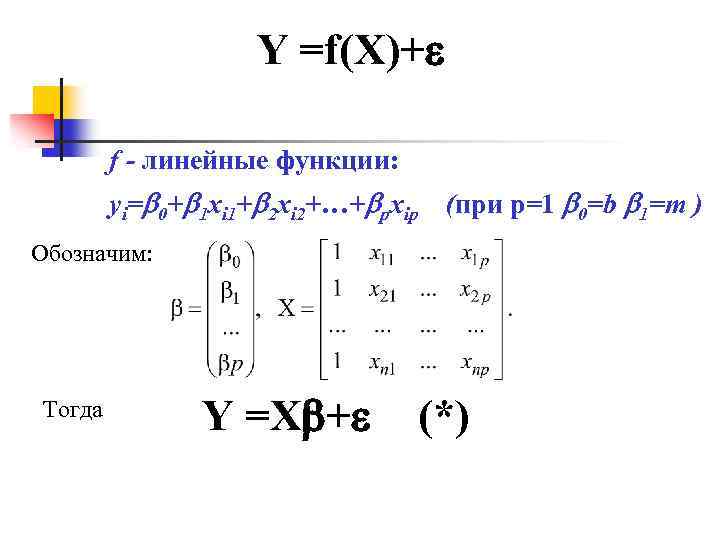

Y =f(X)+ f - линейные функции: yi= 0+ 1 xi 1+ 2 xi 2+…+ pxip (при р=1 0=b 1=m ) Обозначим: Тогда Y =X + (*)

Y =f(X)+ f - линейные функции: yi= 0+ 1 xi 1+ 2 xi 2+…+ pxip (при р=1 0=b 1=m ) Обозначим: Тогда Y =X + (*)

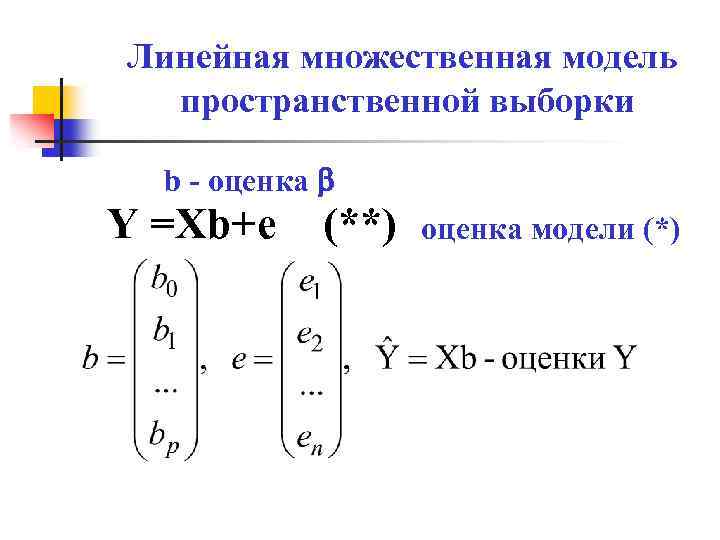

Линейная множественная модель пространственной выборки b - оценка Y =Xb+e (**) оценка модели (*)

Линейная множественная модель пространственной выборки b - оценка Y =Xb+e (**) оценка модели (*)

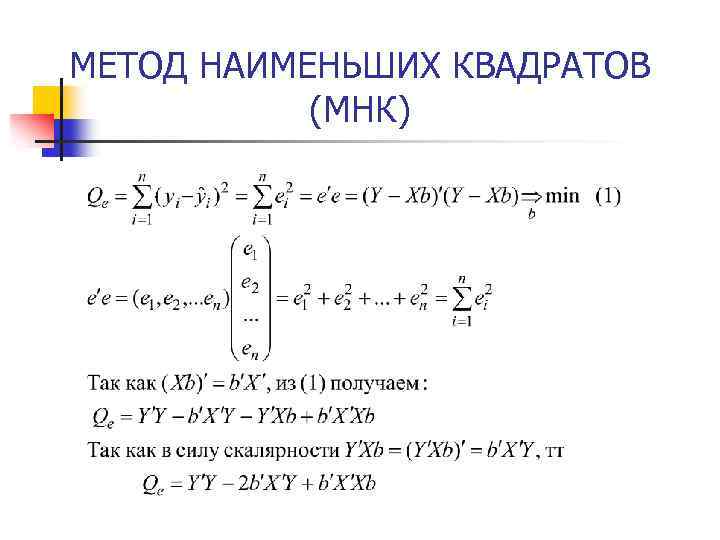

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ (МНК)

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ (МНК)

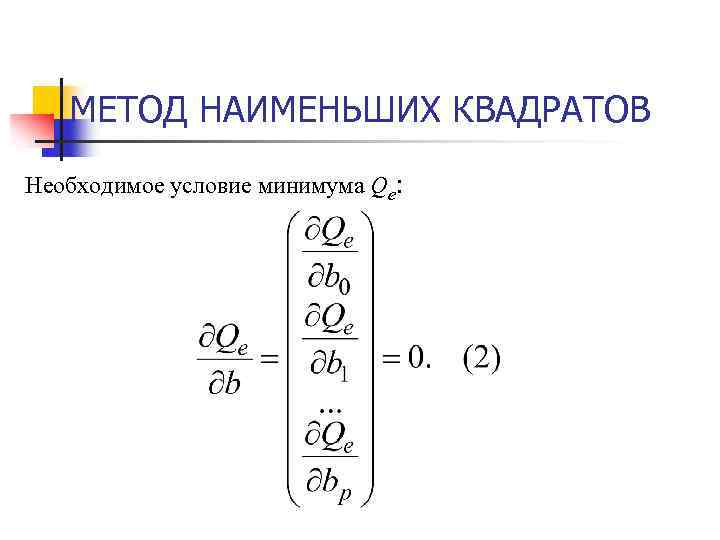

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ Необходимое условие минимума Qe:

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ Необходимое условие минимума Qe:

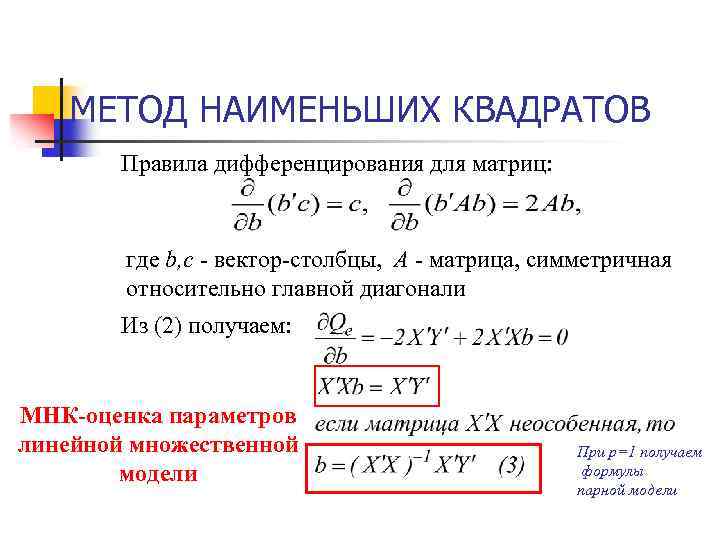

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ Правила дифференцирования для матриц: где b, c - вектор-столбцы, А - матрица, симметричная относительно главной диагонали Из (2) получаем: МНК-оценка параметров линейной множественной модели При р=1 получаем формулы парной модели

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ Правила дифференцирования для матриц: где b, c - вектор-столбцы, А - матрица, симметричная относительно главной диагонали Из (2) получаем: МНК-оценка параметров линейной множественной модели При р=1 получаем формулы парной модели

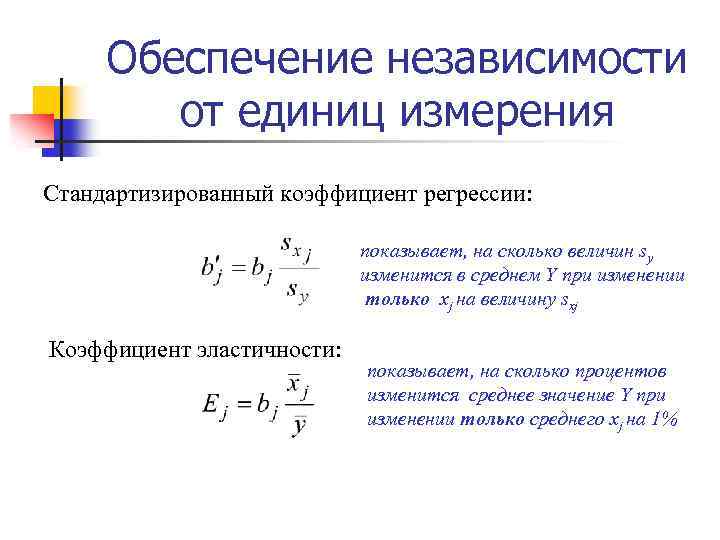

Обеспечение независимости от единиц измерения Стандартизированный коэффициент регрессии: показывает, на сколько величин sy изменится в среднем Y при изменении только xj на величину sxj Коэффициент эластичности: показывает, на сколько процентов изменится среднее значение Y при изменении только среднего xj на 1%

Обеспечение независимости от единиц измерения Стандартизированный коэффициент регрессии: показывает, на сколько величин sy изменится в среднем Y при изменении только xj на величину sxj Коэффициент эластичности: показывает, на сколько процентов изменится среднее значение Y при изменении только среднего xj на 1%

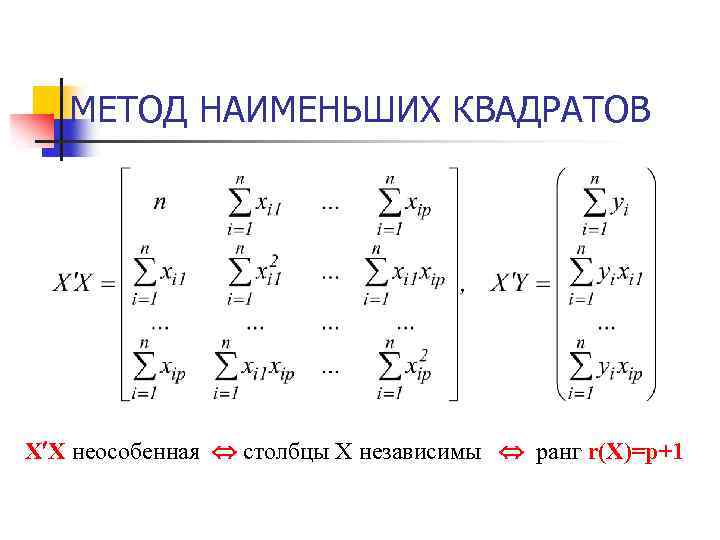

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ X X неособенная столбцы Х независимы ранг r(X)=p+1

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ X X неособенная столбцы Х независимы ранг r(X)=p+1

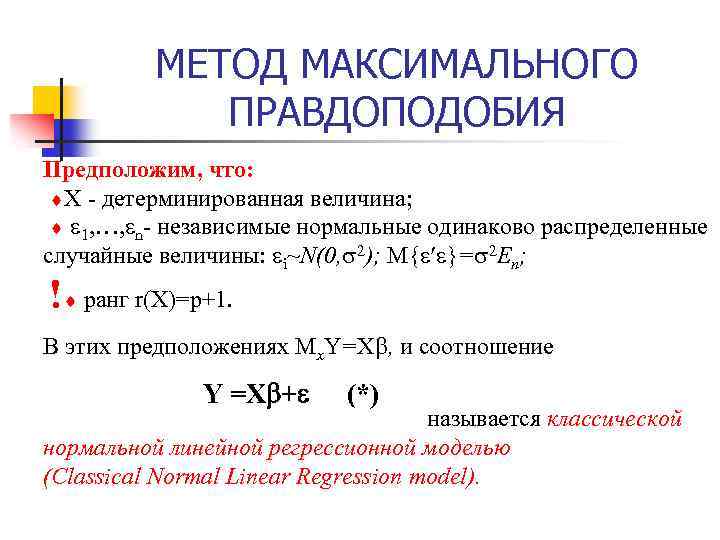

МЕТОД МАКСИМАЛЬНОГО ПРАВДОПОДОБИЯ Предположим, что: X - детерминированная величина; 1, …, n- независимые нормальные одинаково распределенные случайные величины: i~N(0, 2); M{ }= 2 En; ! ранг r(X)=p+1. В этих предположениях Mx. Y=X , и соотношение Y =X + (*) называется классической нормальной линейной регрессионной моделью (Classical Normal Linear Regression model).

МЕТОД МАКСИМАЛЬНОГО ПРАВДОПОДОБИЯ Предположим, что: X - детерминированная величина; 1, …, n- независимые нормальные одинаково распределенные случайные величины: i~N(0, 2); M{ }= 2 En; ! ранг r(X)=p+1. В этих предположениях Mx. Y=X , и соотношение Y =X + (*) называется классической нормальной линейной регрессионной моделью (Classical Normal Linear Regression model).

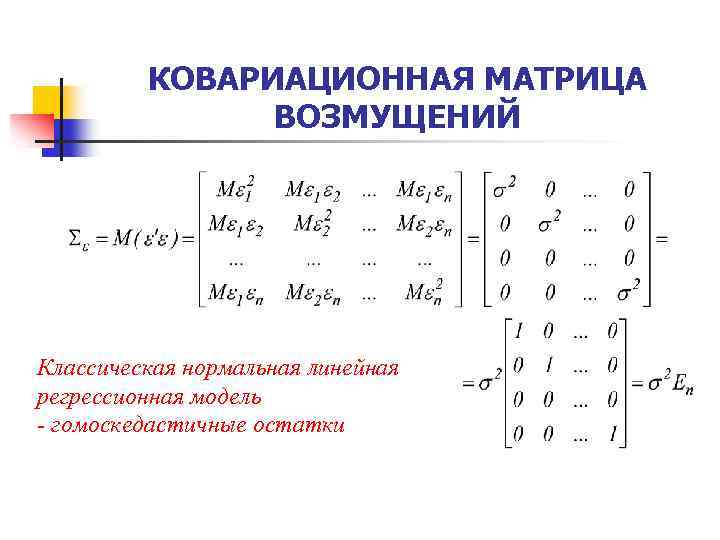

КОВАРИАЦИОННАЯ МАТРИЦА ВОЗМУЩЕНИЙ Классическая нормальная линейная регрессионная модель - гомоскедастичные остатки

КОВАРИАЦИОННАЯ МАТРИЦА ВОЗМУЩЕНИЙ Классическая нормальная линейная регрессионная модель - гомоскедастичные остатки

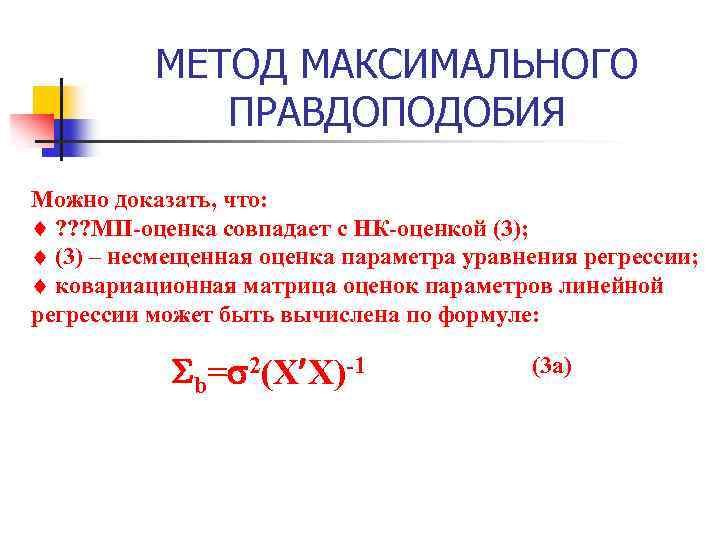

МЕТОД МАКСИМАЛЬНОГО ПРАВДОПОДОБИЯ Можно доказать, что: ? ? ? МП-оценка совпадает с НК-оценкой (3); (3) – несмещенная оценка параметра уравнения регрессии; ковариационная матрица оценок параметров линейной регрессии может быть вычислена по формуле: b= 2(X X)-1 (3 a)

МЕТОД МАКСИМАЛЬНОГО ПРАВДОПОДОБИЯ Можно доказать, что: ? ? ? МП-оценка совпадает с НК-оценкой (3); (3) – несмещенная оценка параметра уравнения регрессии; ковариационная матрица оценок параметров линейной регрессии может быть вычислена по формуле: b= 2(X X)-1 (3 a)

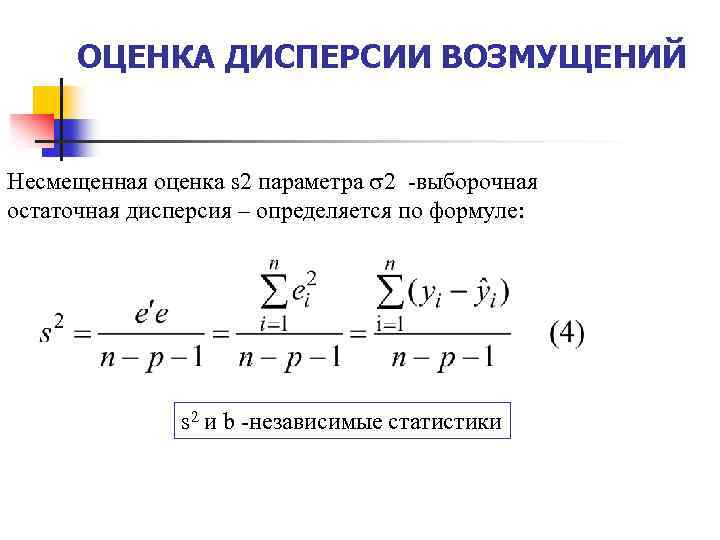

ОЦЕНКА ДИСПЕРСИИ ВОЗМУЩЕНИЙ Несмещенная оценка s 2 параметра 2 -выборочная остаточная дисперсия – определяется по формуле: s 2 и b -независимые статистики

ОЦЕНКА ДИСПЕРСИИ ВОЗМУЩЕНИЙ Несмещенная оценка s 2 параметра 2 -выборочная остаточная дисперсия – определяется по формуле: s 2 и b -независимые статистики

Теорема Гаусса-Маркова В условиях классической нормальной линейной регрессионной модели оценки (3) имеют наименьшую дисперсию в классе всех линейных несмещенных оценок. (3) - самые эффективные оценки Best Linear Unbiased Estimates (BLUE)

Теорема Гаусса-Маркова В условиях классической нормальной линейной регрессионной модели оценки (3) имеют наименьшую дисперсию в классе всех линейных несмещенных оценок. (3) - самые эффективные оценки Best Linear Unbiased Estimates (BLUE)

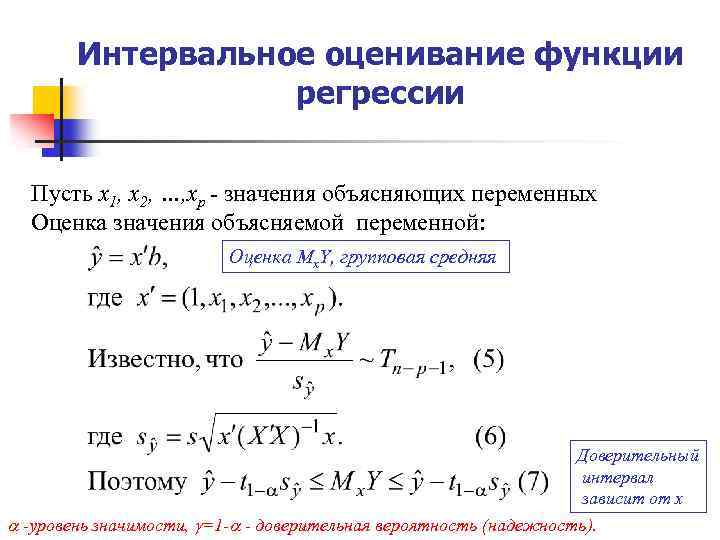

Интервальное оценивание функции регрессии Пусть х1, х2, …, хр - значения объясняющих переменных Оценка значения объясняемой переменной: Оценка Mx. Y, групповая средняя Доверительный интервал зависит от х -уровень значимости, =1 - - доверительная вероятность (надежность).

Интервальное оценивание функции регрессии Пусть х1, х2, …, хр - значения объясняющих переменных Оценка значения объясняемой переменной: Оценка Mx. Y, групповая средняя Доверительный интервал зависит от х -уровень значимости, =1 - - доверительная вероятность (надежность).

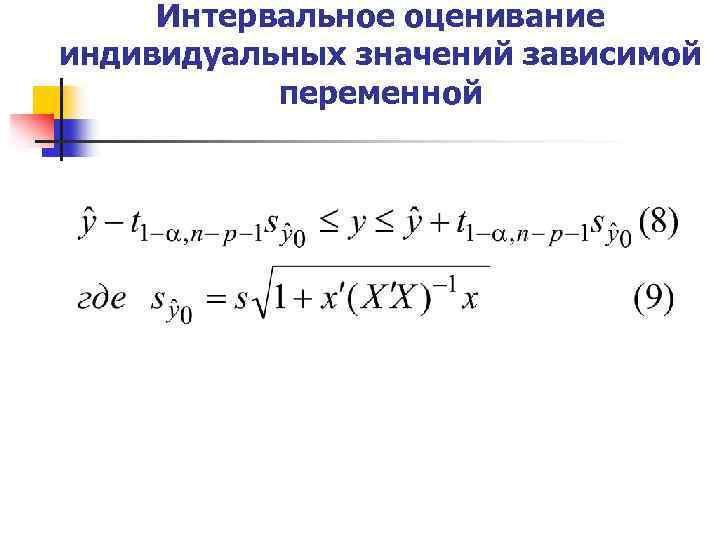

Интервальное оценивание индивидуальных значений зависимой переменной

Интервальное оценивание индивидуальных значений зависимой переменной

Интервальное оценивание коэффициентов уравнения регрессии

Интервальное оценивание коэффициентов уравнения регрессии

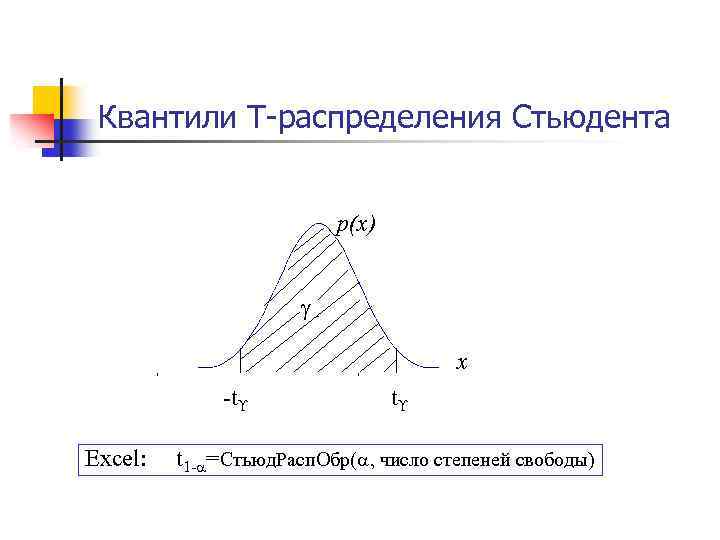

Квантили T-распределения Стьюдента p(x) x -t Excel: t t 1 - =Стьюд. Расп. Обр( , число степеней свободы)

Квантили T-распределения Стьюдента p(x) x -t Excel: t t 1 - =Стьюд. Расп. Обр( , число степеней свободы)

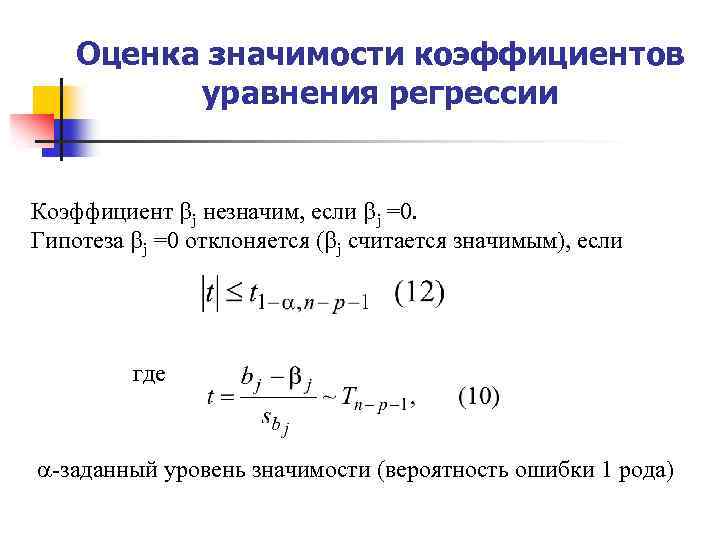

Оценка значимости коэффициентов уравнения регрессии Коэффициент j незначим, если j =0. Гипотеза j =0 отклоняется ( j считается значимым), если где -заданный уровень значимости (вероятность ошибки 1 рода)

Оценка значимости коэффициентов уравнения регрессии Коэффициент j незначим, если j =0. Гипотеза j =0 отклоняется ( j считается значимым), если где -заданный уровень значимости (вероятность ошибки 1 рода)

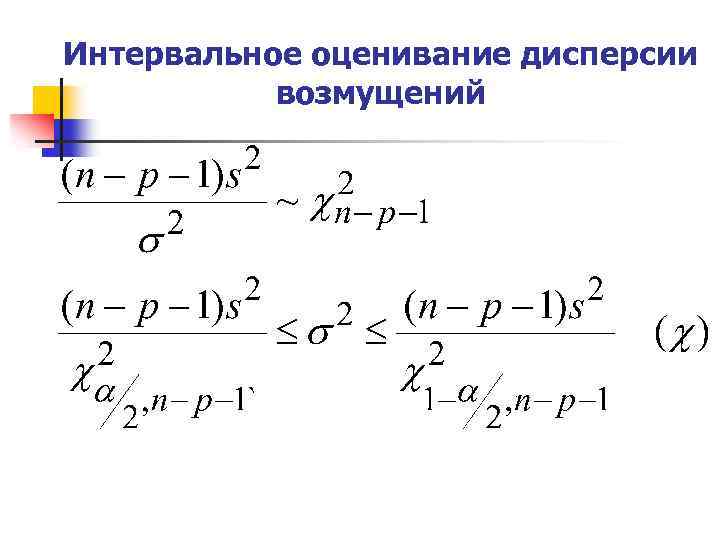

Интервальное оценивание дисперсии возмущений

Интервальное оценивание дисперсии возмущений

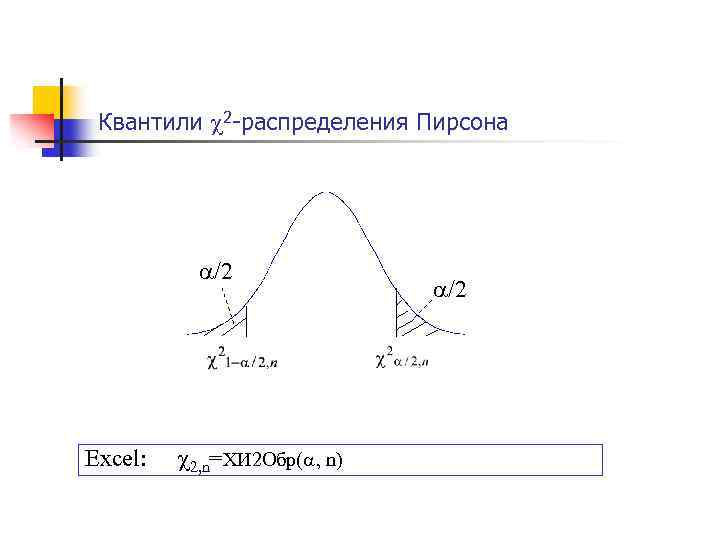

Квантили 2 -распределения Пирсона /2 Excel: 2, n=ХИ 2 Обр( , n) /2

Квантили 2 -распределения Пирсона /2 Excel: 2, n=ХИ 2 Обр( , n) /2

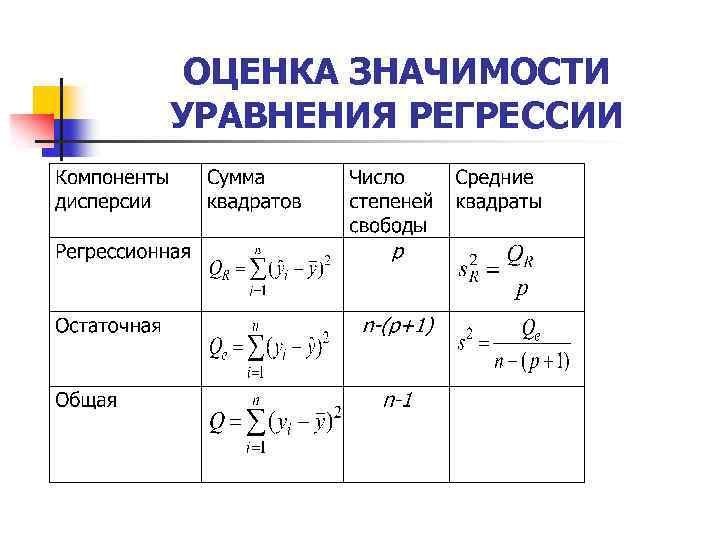

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ

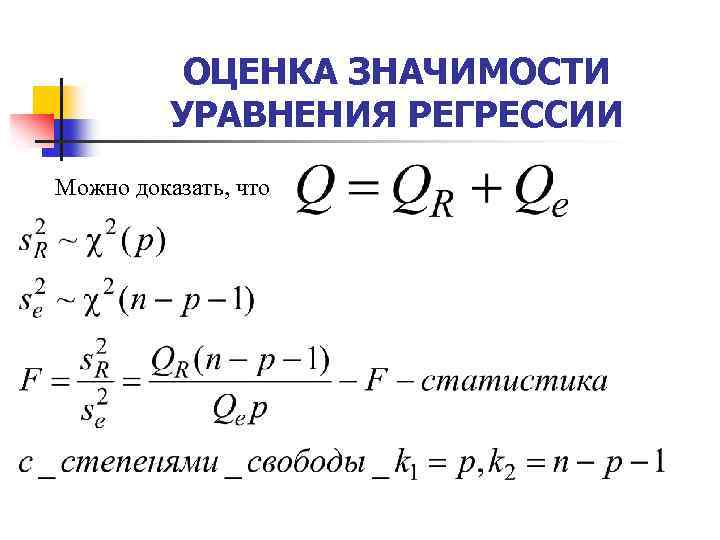

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ Можно доказать, что

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ Можно доказать, что

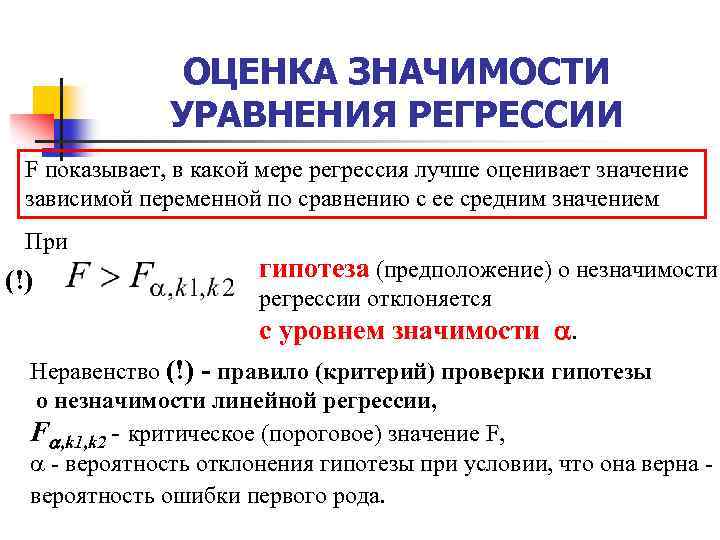

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ F показывает, в какой мере регрессия лучше оценивает значение зависимой переменной по сравнению с ее средним значением При (!) гипотеза (предположение) о незначимости регрессии отклоняется с уровнем значимости . Неравенство (!) - правило (критерий) проверки гипотезы о незначимости линейной регрессии, F , k 1, k 2 - критическое (пороговое) значение F, - вероятность отклонения гипотезы при условии, что она вероятность ошибки первого рода.

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ F показывает, в какой мере регрессия лучше оценивает значение зависимой переменной по сравнению с ее средним значением При (!) гипотеза (предположение) о незначимости регрессии отклоняется с уровнем значимости . Неравенство (!) - правило (критерий) проверки гипотезы о незначимости линейной регрессии, F , k 1, k 2 - критическое (пороговое) значение F, - вероятность отклонения гипотезы при условии, что она вероятность ошибки первого рода.

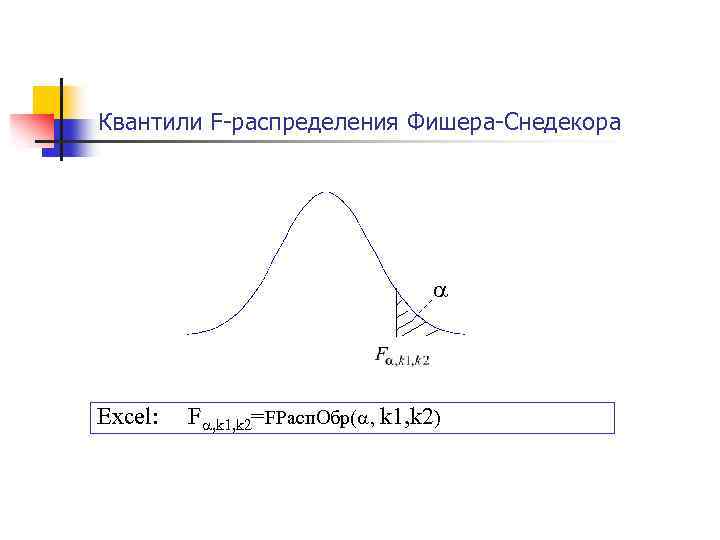

Квантили F-распределения Фишера-Снедекора Excel: F , k 1, k 2=FРасп. Обр( , k 1, k 2)

Квантили F-распределения Фишера-Снедекора Excel: F , k 1, k 2=FРасп. Обр( , k 1, k 2)

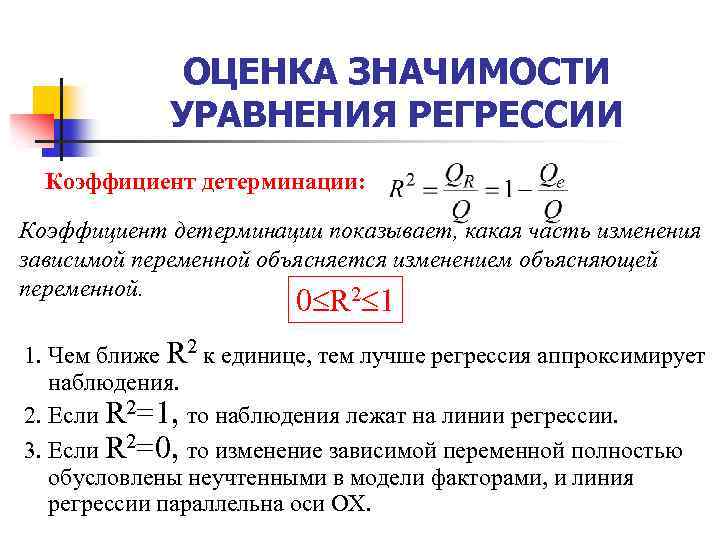

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ Коэффициент детерминации: Коэффициент детерминации показывает, какая часть изменения зависимой переменной объясняется изменением объясняющей переменной. 2 0 R 1 1. Чем ближе R 2 к единице, тем лучше регрессия аппроксимирует наблюдения. 2. Если R 2=1, то наблюдения лежат на линии регрессии. 3. Если R 2=0, то изменение зависимой переменной полностью обусловлены неучтенными в модели факторами, и линия регрессии параллельна оси ОХ.

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ Коэффициент детерминации: Коэффициент детерминации показывает, какая часть изменения зависимой переменной объясняется изменением объясняющей переменной. 2 0 R 1 1. Чем ближе R 2 к единице, тем лучше регрессия аппроксимирует наблюдения. 2. Если R 2=1, то наблюдения лежат на линии регрессии. 3. Если R 2=0, то изменение зависимой переменной полностью обусловлены неучтенными в модели факторами, и линия регрессии параллельна оси ОХ.

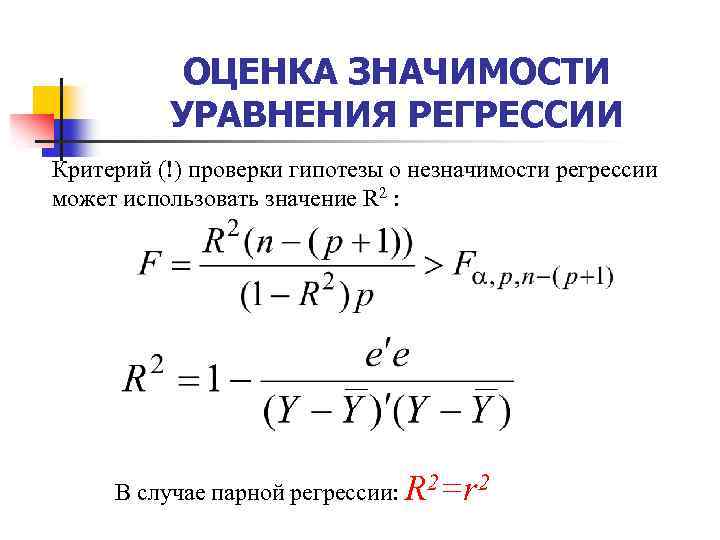

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ Критерий (!) проверки гипотезы о незначимости регрессии может использовать значение R 2 : В случае парной регрессии: R 2=r 2

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ Критерий (!) проверки гипотезы о незначимости регрессии может использовать значение R 2 : В случае парной регрессии: R 2=r 2

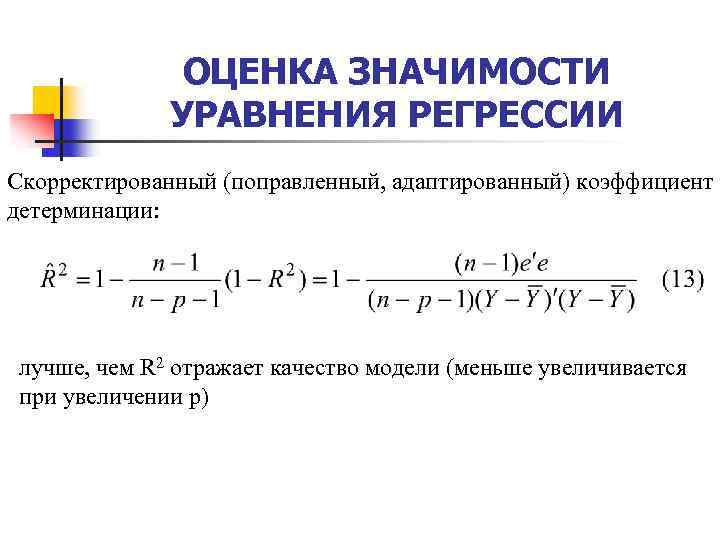

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ Скорректированный (поправленный, адаптированный) коэффициент детерминации: лучше, чем R 2 отражает качество модели (меньше увеличивается при увеличении p)

ОЦЕНКА ЗНАЧИМОСТИ УРАВНЕНИЯ РЕГРЕССИИ Скорректированный (поправленный, адаптированный) коэффициент детерминации: лучше, чем R 2 отражает качество модели (меньше увеличивается при увеличении p)

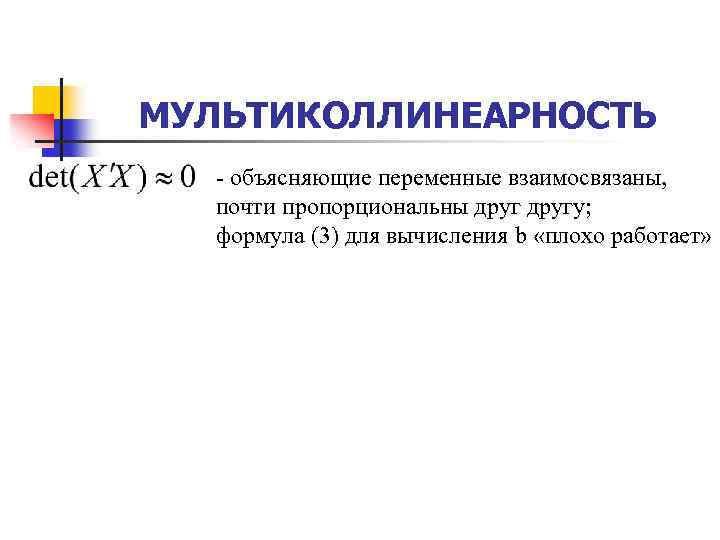

МУЛЬТИКОЛЛИНЕАРНОСТЬ - объясняющие переменные взаимосвязаны, почти пропорциональны другу; формула (3) для вычисления b «плохо работает»

МУЛЬТИКОЛЛИНЕАРНОСТЬ - объясняющие переменные взаимосвязаны, почти пропорциональны другу; формула (3) для вычисления b «плохо работает»

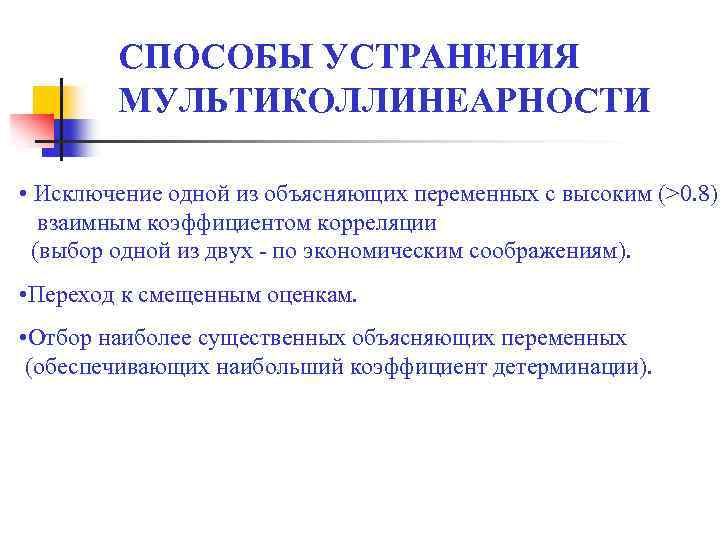

СПОСОБЫ УСТРАНЕНИЯ МУЛЬТИКОЛЛИНЕАРНОСТИ • Исключение одной из объясняющих переменных с высоким (>0. 8) взаимным коэффициентом корреляции (выбор одной из двух - по экономическим соображениям). • Переход к смещенным оценкам. • Отбор наиболее существенных объясняющих переменных (обеспечивающих наибольший коэффициент детерминации).

СПОСОБЫ УСТРАНЕНИЯ МУЛЬТИКОЛЛИНЕАРНОСТИ • Исключение одной из объясняющих переменных с высоким (>0. 8) взаимным коэффициентом корреляции (выбор одной из двух - по экономическим соображениям). • Переход к смещенным оценкам. • Отбор наиболее существенных объясняющих переменных (обеспечивающих наибольший коэффициент детерминации).

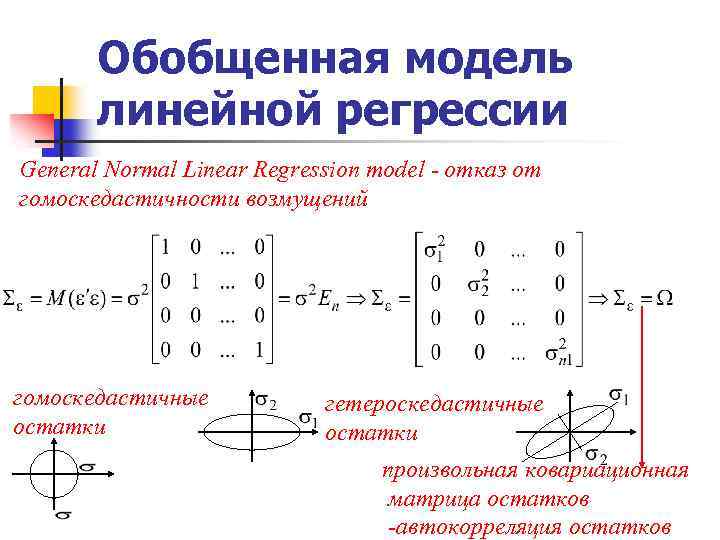

Обобщенная модель линейной регрессии General Normal Linear Regression model - отказ от гомоскедастичности возмущений гомоскедастичные остатки гетероскедастичные остатки произвольная ковариационная матрица остатков -автокорреляция остатков

Обобщенная модель линейной регрессии General Normal Linear Regression model - отказ от гомоскедастичности возмущений гомоскедастичные остатки гетероскедастичные остатки произвольная ковариационная матрица остатков -автокорреляция остатков

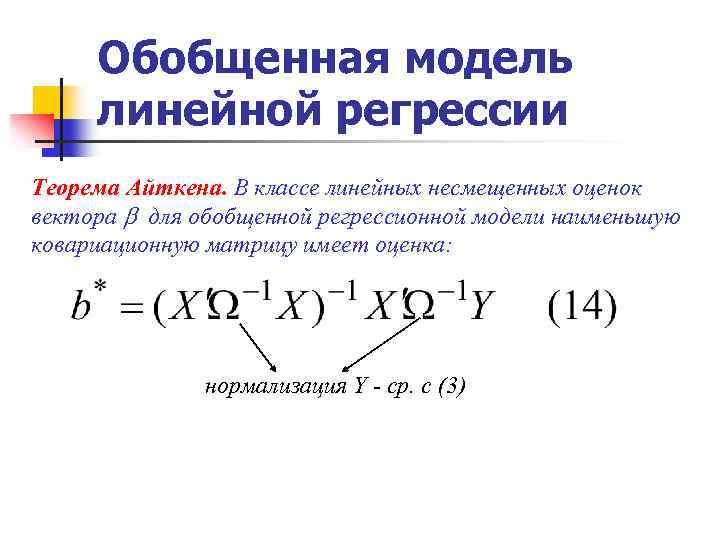

Обобщенная модель линейной регрессии Теорема Айткена. В классе линейных несмещенных оценок вектора для обобщенной регрессионной модели наименьшую ковариационную матрицу имеет оценка: нормализация Y - ср. с (3)

Обобщенная модель линейной регрессии Теорема Айткена. В классе линейных несмещенных оценок вектора для обобщенной регрессионной модели наименьшую ковариационную матрицу имеет оценка: нормализация Y - ср. с (3)

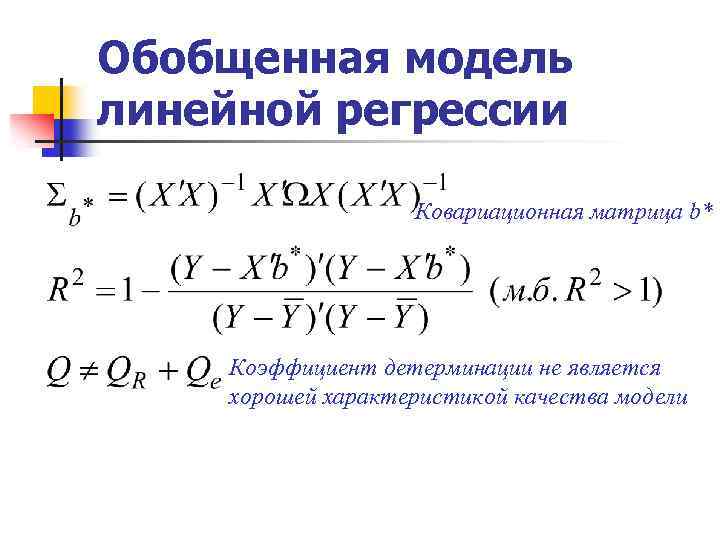

Обобщенная модель линейной регрессии Ковариационная матрица b* Коэффициент детерминации не является хорошей характеристикой качества модели

Обобщенная модель линейной регрессии Ковариационная матрица b* Коэффициент детерминации не является хорошей характеристикой качества модели