Лекция 5 Алгоритм «Дискриминантная функция» Условия применимости: Все

![Коэффициенты ковариации вычисляются следующим образом: Здесь M[ ] – означает среднее от того, что Коэффициенты ковариации вычисляются следующим образом: Здесь M[ ] – означает среднее от того, что](https://present5.com/customparser/175019888_166054982 --- df.ppt/slide_8.jpg)

df.ppt

- Количество слайдов: 14

Лекция 5 Алгоритм «Дискриминантная функция»

Лекция 5 Алгоритм «Дискриминантная функция»

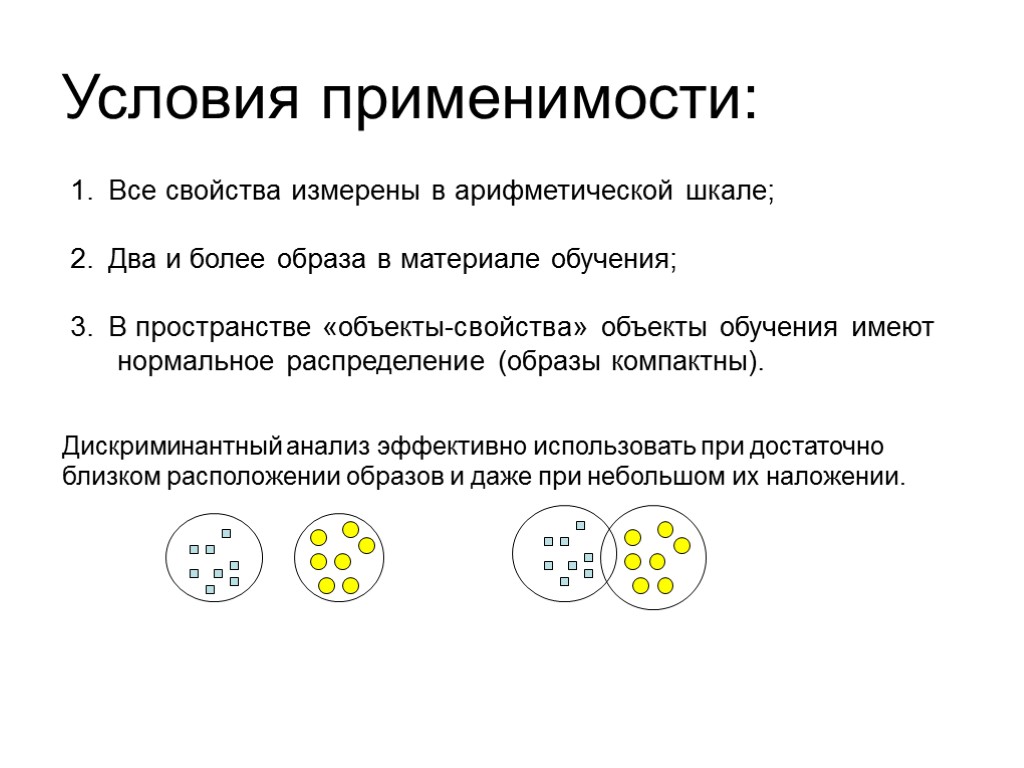

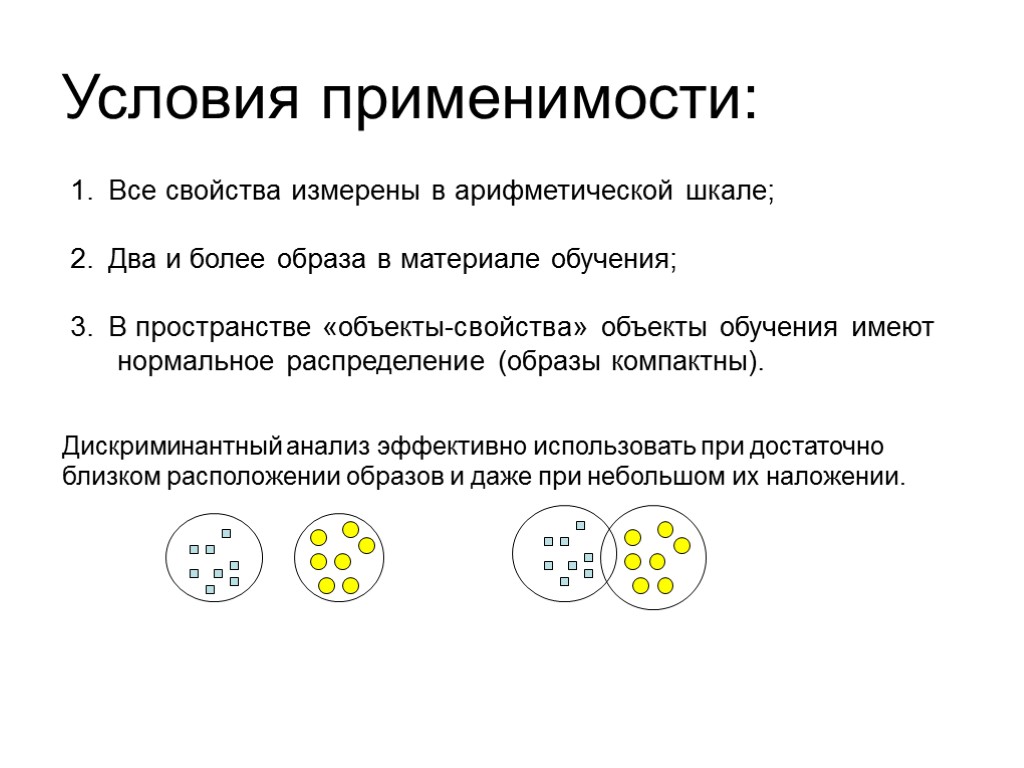

Условия применимости: Все свойства измерены в арифметической шкале; Два и более образа в материале обучения; В пространстве «объекты-свойства» объекты обучения имеют нормальное распределение (образы компактны). Дискриминантный анализ эффективно использовать при достаточно близком расположении образов и даже при небольшом их наложении.

Условия применимости: Все свойства измерены в арифметической шкале; Два и более образа в материале обучения; В пространстве «объекты-свойства» объекты обучения имеют нормальное распределение (образы компактны). Дискриминантный анализ эффективно использовать при достаточно близком расположении образов и даже при небольшом их наложении.

Постановка задачи В исходных данных, представленных в виде ТОС, присутствуют представители всех образов. Для каждого объекта указана его принадлежность к образу. В процессе распознавания определяется принадлежность объектов экзамена к одному из образов.

Постановка задачи В исходных данных, представленных в виде ТОС, присутствуют представители всех образов. Для каждого объекта указана его принадлежность к образу. В процессе распознавания определяется принадлежность объектов экзамена к одному из образов.

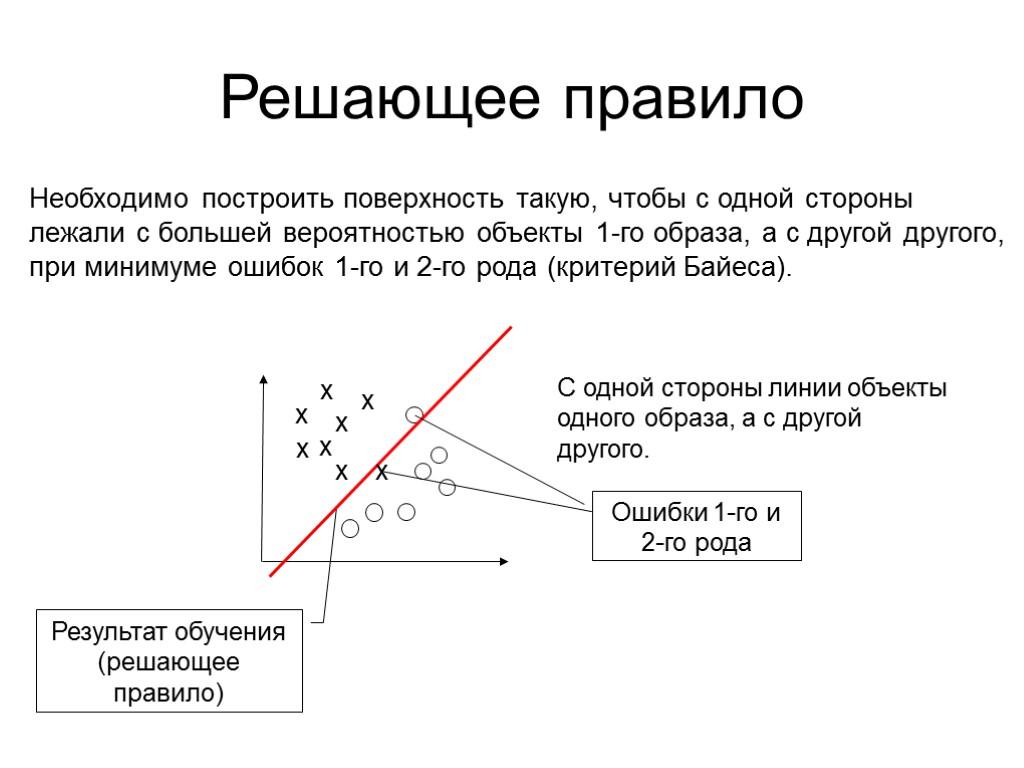

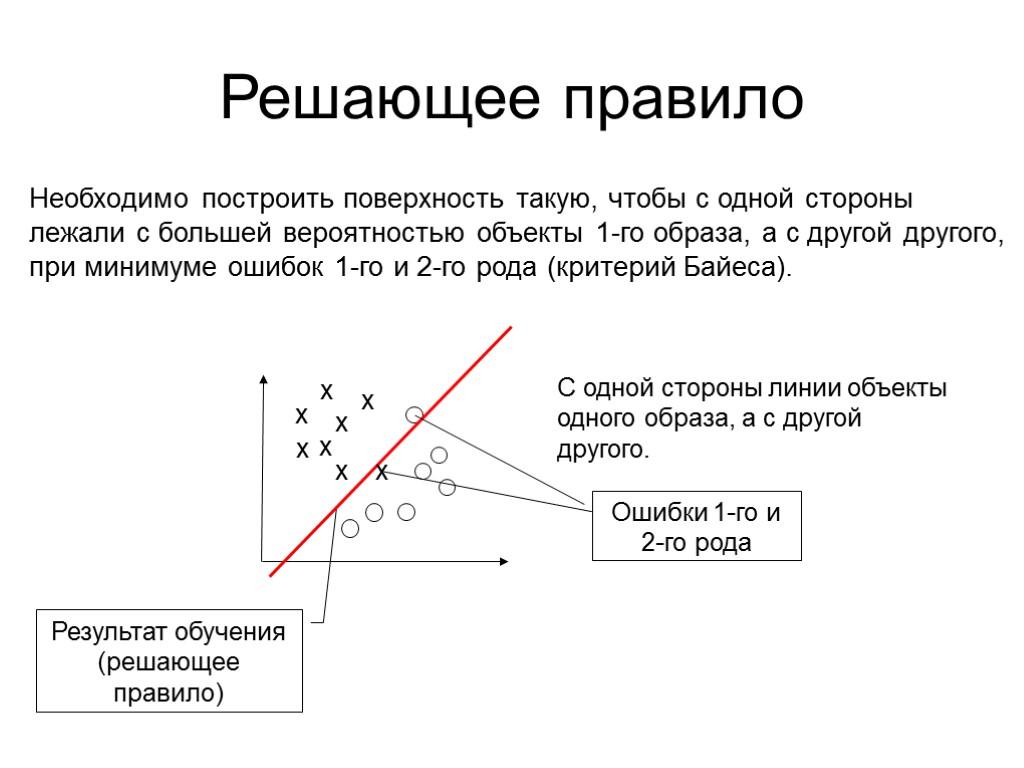

Решающее правило Необходимо построить поверхность такую, чтобы с одной стороны лежали с большей вероятностью объекты 1-го образа, а с другой другого, при минимуме ошибок 1-го и 2-го рода (критерий Байеса). х х х х х х х С одной стороны линии объекты одного образа, а с другой другого. х Результат обучения (решающее правило)

Решающее правило Необходимо построить поверхность такую, чтобы с одной стороны лежали с большей вероятностью объекты 1-го образа, а с другой другого, при минимуме ошибок 1-го и 2-го рода (критерий Байеса). х х х х х х х С одной стороны линии объекты одного образа, а с другой другого. х Результат обучения (решающее правило)

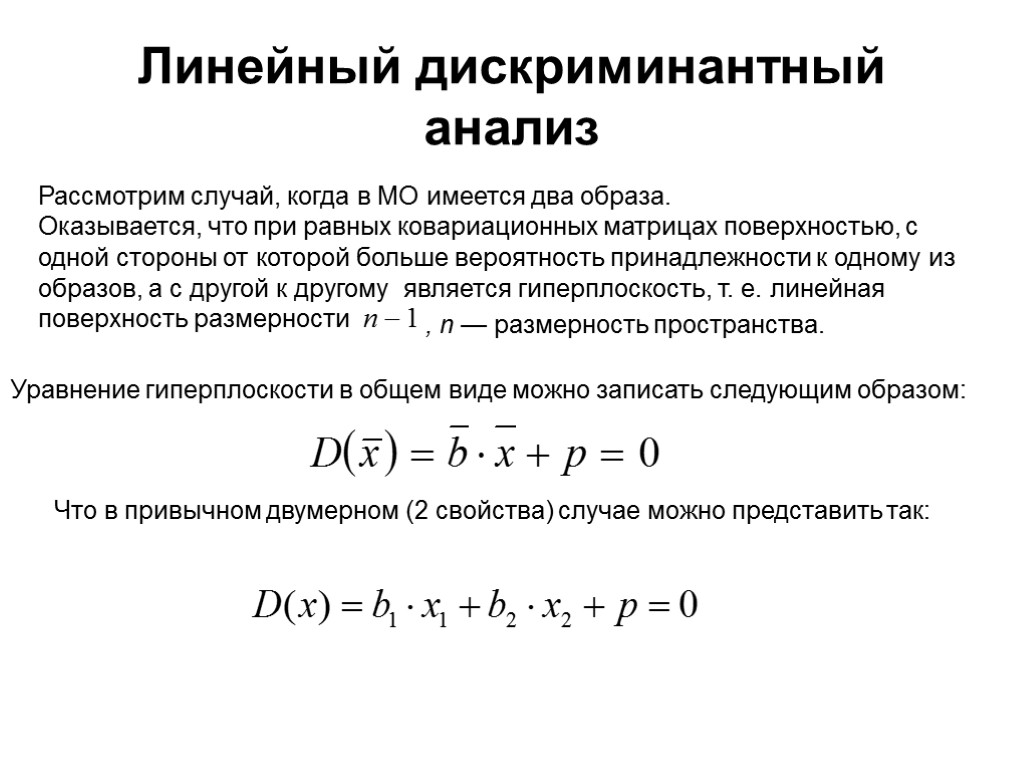

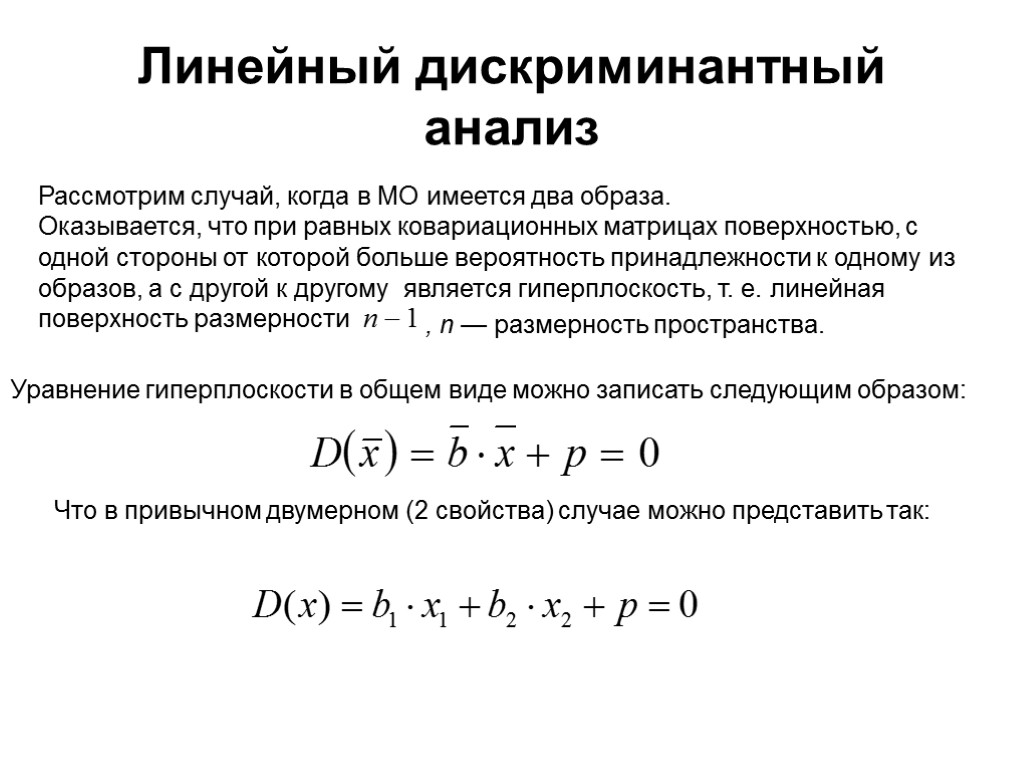

Линейный дискриминантный анализ Рассмотрим случай, когда в МО имеется два образа. Оказывается, что при равных ковариационных матрицах поверхностью, с одной стороны от которой больше вероятность принадлежности к одному из образов, а с другой к другому является гиперплоскость, т. е. линейная поверхность размерности , n — размерность пространства. Уравнение гиперплоскости в общем виде можно записать следующим образом: Что в привычном двумерном (2 свойства) случае можно представить так:

Линейный дискриминантный анализ Рассмотрим случай, когда в МО имеется два образа. Оказывается, что при равных ковариационных матрицах поверхностью, с одной стороны от которой больше вероятность принадлежности к одному из образов, а с другой к другому является гиперплоскость, т. е. линейная поверхность размерности , n — размерность пространства. Уравнение гиперплоскости в общем виде можно записать следующим образом: Что в привычном двумерном (2 свойства) случае можно представить так:

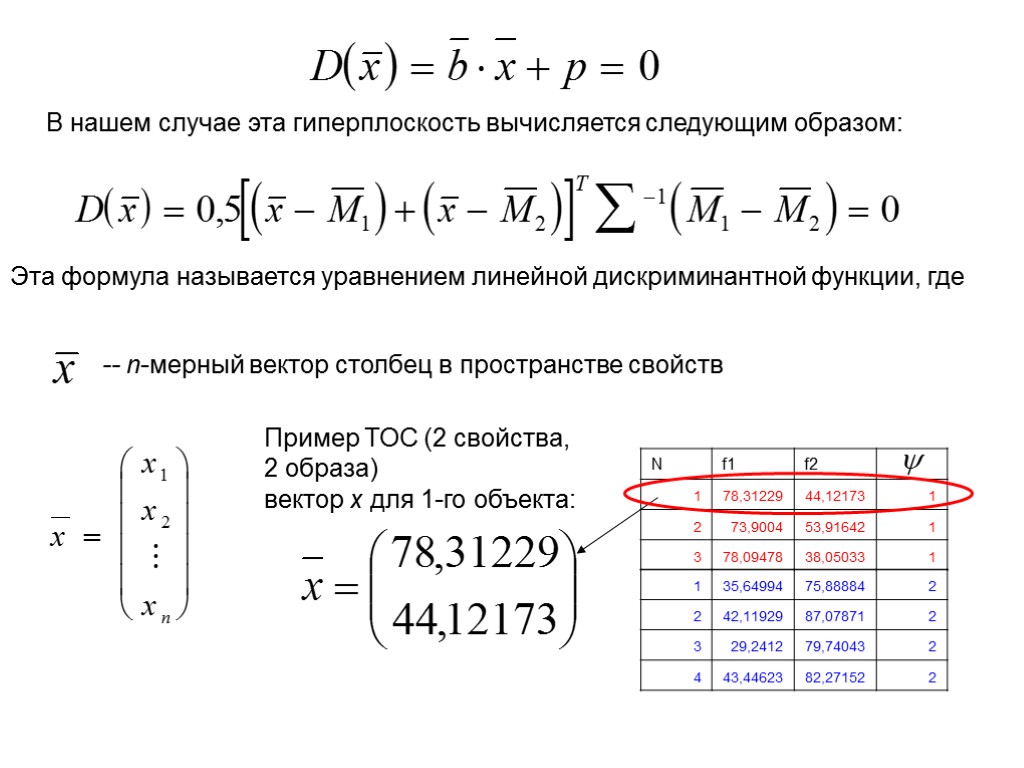

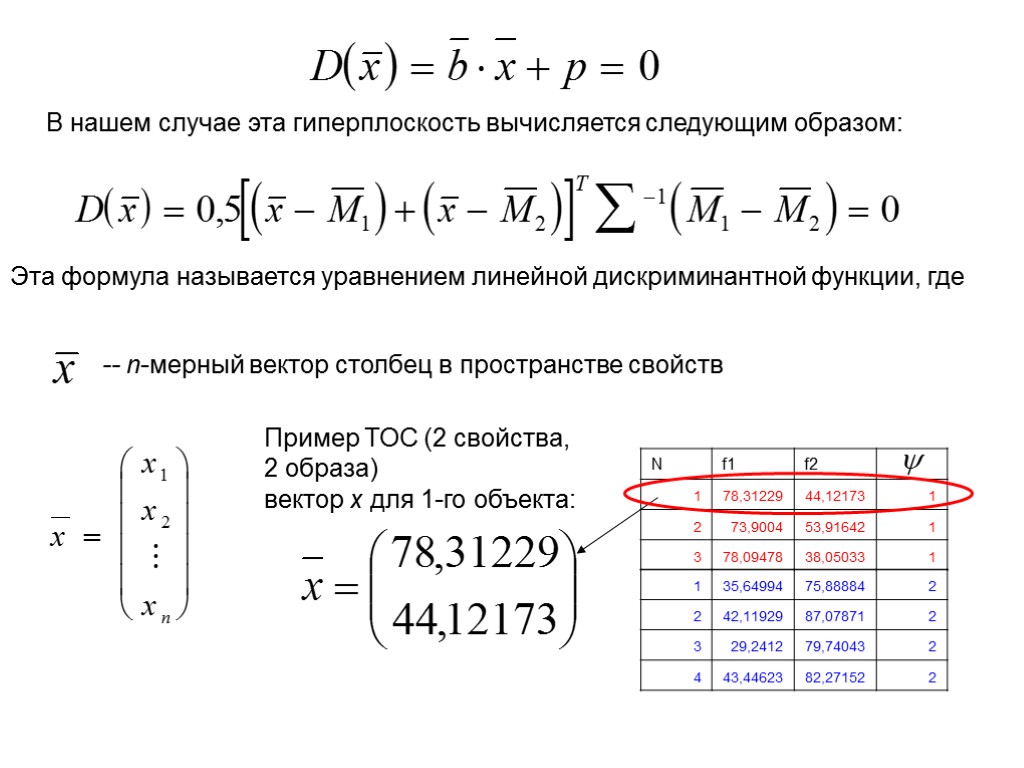

В нашем случае эта гиперплоскость вычисляется следующим образом: Эта формула называется уравнением линейной дискриминантной функции, где -- n-мерный вектор столбец в пространстве свойств Пример ТОС (2 свойства, 2 образа) вектор x для 1-го объекта:

В нашем случае эта гиперплоскость вычисляется следующим образом: Эта формула называется уравнением линейной дискриминантной функции, где -- n-мерный вектор столбец в пространстве свойств Пример ТОС (2 свойства, 2 образа) вектор x для 1-го объекта:

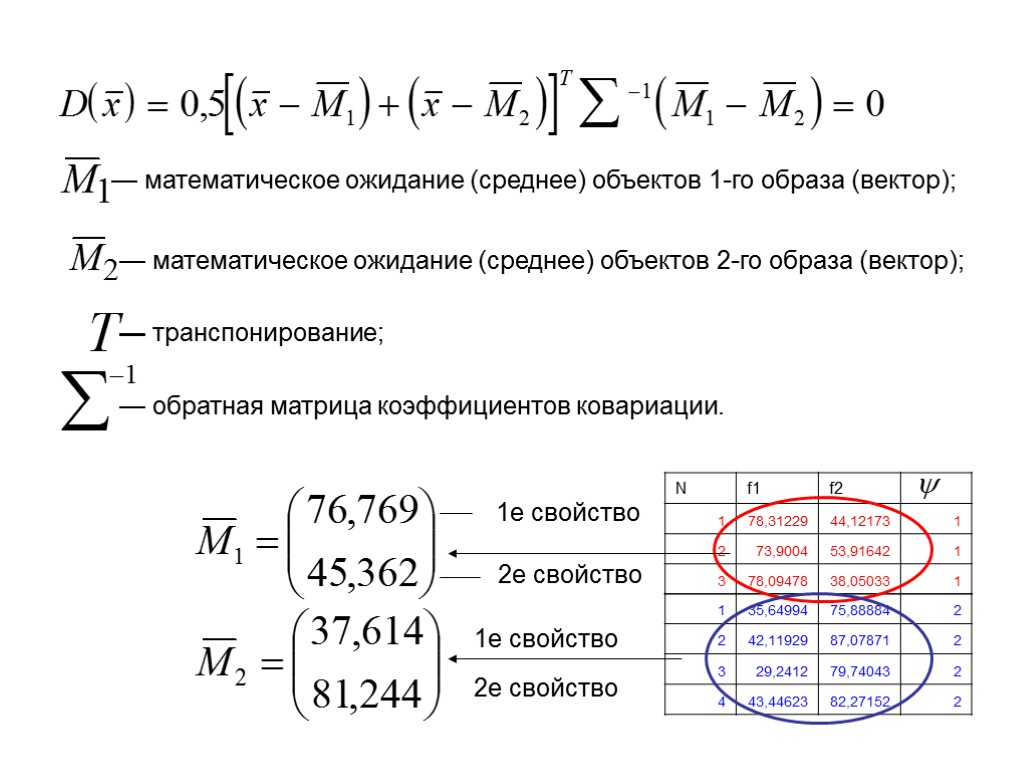

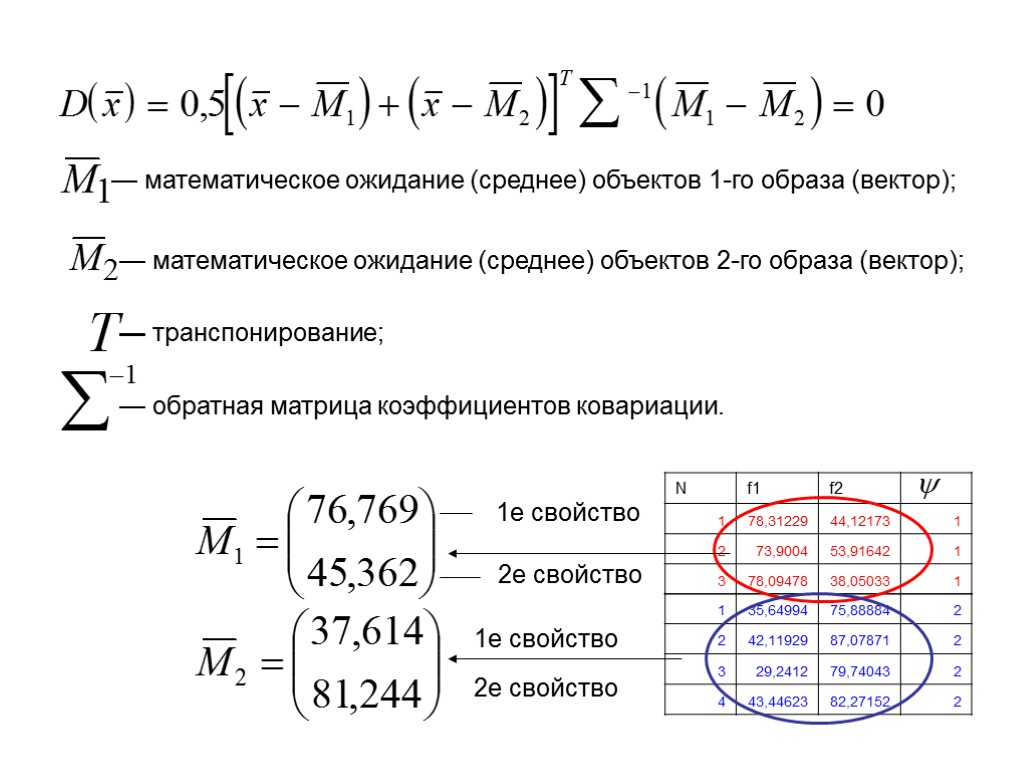

— математическое ожидание (среднее) объектов 1-го образа (вектор); — математическое ожидание (среднее) объектов 2-го образа (вектор); — транспонирование; — обратная матрица коэффициентов ковариации. 1е свойство 2е свойство 1е свойство 2е свойство

— математическое ожидание (среднее) объектов 1-го образа (вектор); — математическое ожидание (среднее) объектов 2-го образа (вектор); — транспонирование; — обратная матрица коэффициентов ковариации. 1е свойство 2е свойство 1е свойство 2е свойство

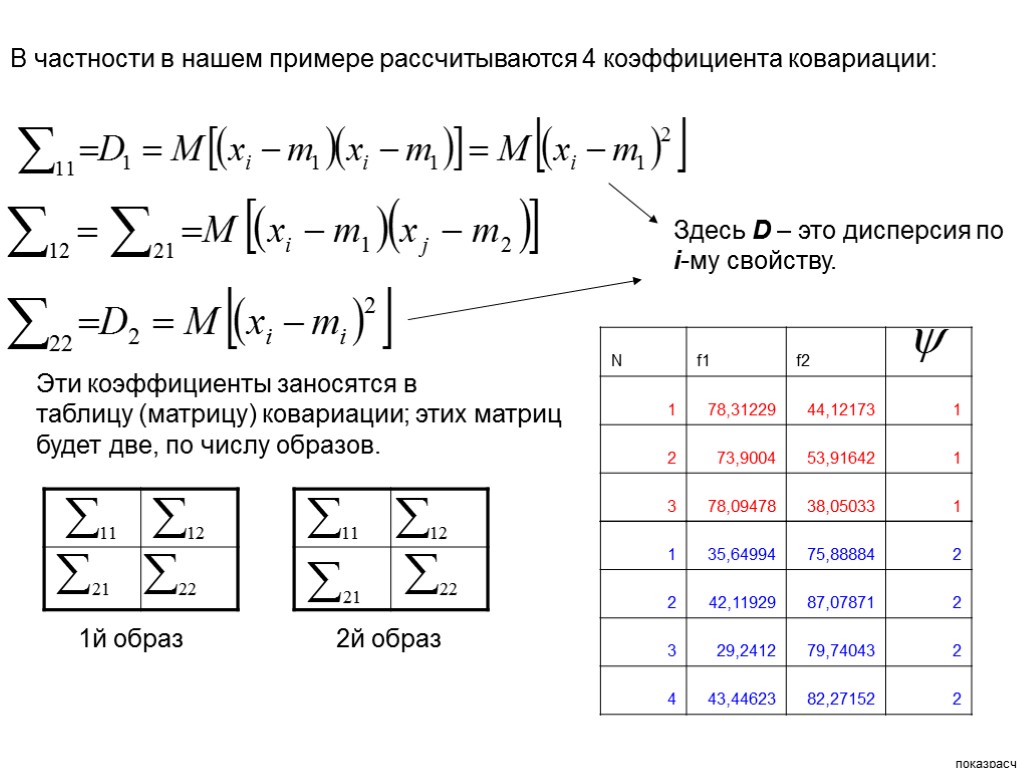

![>Коэффициенты ковариации вычисляются следующим образом: Здесь M[ ] – означает среднее от того, что >Коэффициенты ковариации вычисляются следующим образом: Здесь M[ ] – означает среднее от того, что](https://present5.com/customparser/175019888_166054982 --- df.ppt/slide_8.jpg) Коэффициенты ковариации вычисляются следующим образом: Здесь M[ ] – означает среднее от того, что в квадратных скобках , где n - количество свойств. где — математическое ожидание по к-ому свойству. Коэффициенты ковариации рассчитываются для всех пар свойств отдельно для объектов 1-го и 2-го образов.

Коэффициенты ковариации вычисляются следующим образом: Здесь M[ ] – означает среднее от того, что в квадратных скобках , где n - количество свойств. где — математическое ожидание по к-ому свойству. Коэффициенты ковариации рассчитываются для всех пар свойств отдельно для объектов 1-го и 2-го образов.

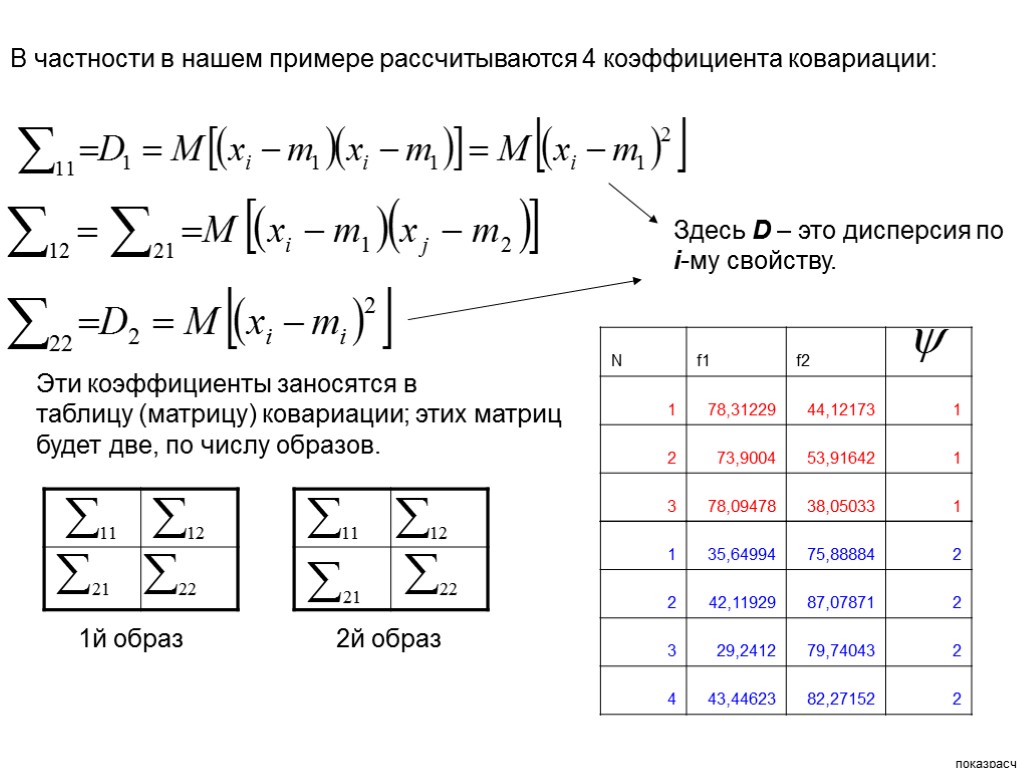

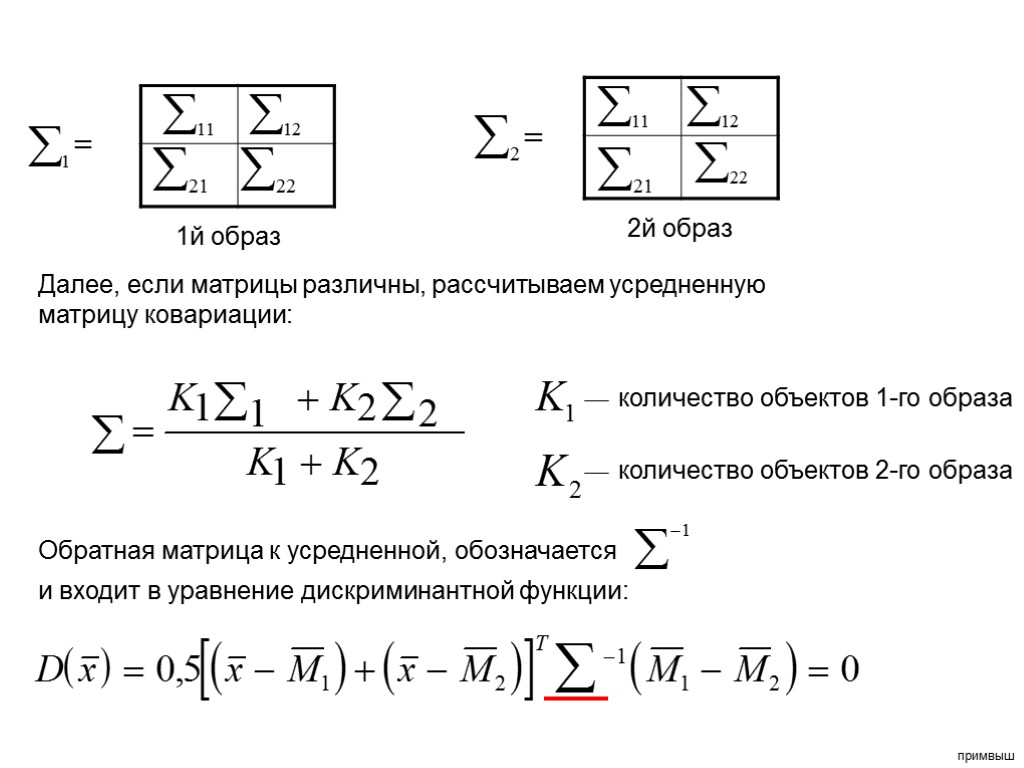

В частности в нашем примере рассчитываются 4 коэффициента ковариации: Эти коэффициенты заносятся в таблицу (матрицу) ковариации; этих матриц будет две, по числу образов. Здесь D – это дисперсия по i-му свойству. 1й образ 2й образ показрасч

В частности в нашем примере рассчитываются 4 коэффициента ковариации: Эти коэффициенты заносятся в таблицу (матрицу) ковариации; этих матриц будет две, по числу образов. Здесь D – это дисперсия по i-му свойству. 1й образ 2й образ показрасч

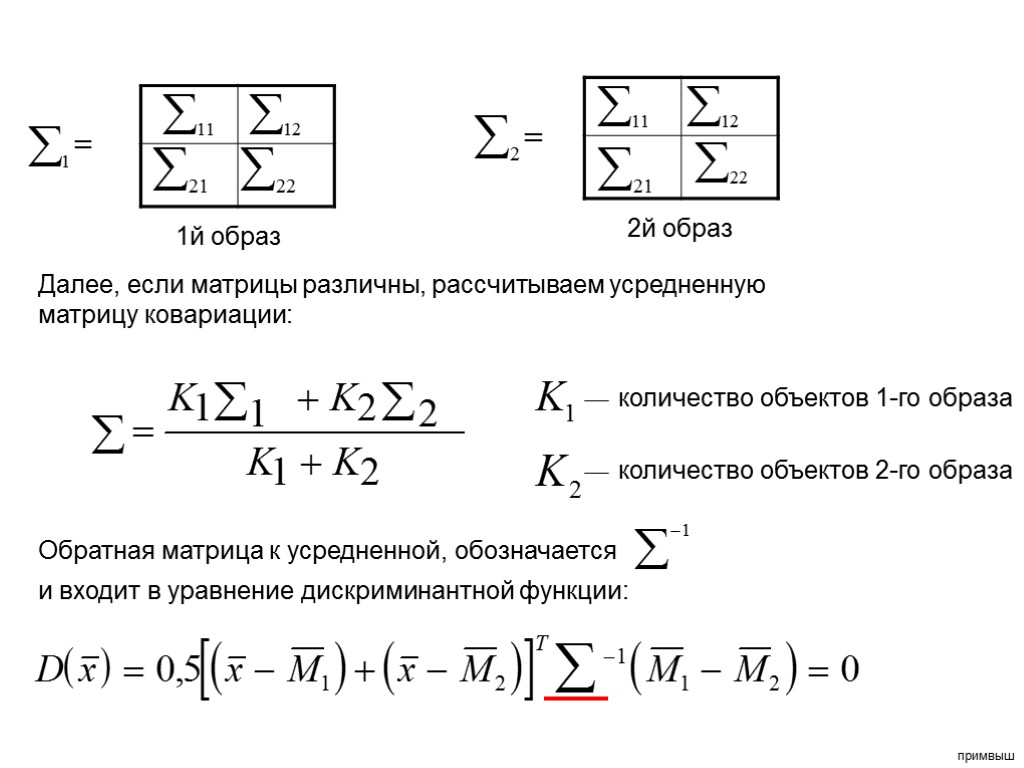

1й образ 2й образ Далее, если матрицы различны, рассчитываем усредненную матрицу ковариации: количество объектов 1-го образа количество объектов 2-го образа Обратная матрица к усредненной, обозначается и входит в уравнение дискриминантной функции: примвыш

1й образ 2й образ Далее, если матрицы различны, рассчитываем усредненную матрицу ковариации: количество объектов 1-го образа количество объектов 2-го образа Обратная матрица к усредненной, обозначается и входит в уравнение дискриминантной функции: примвыш

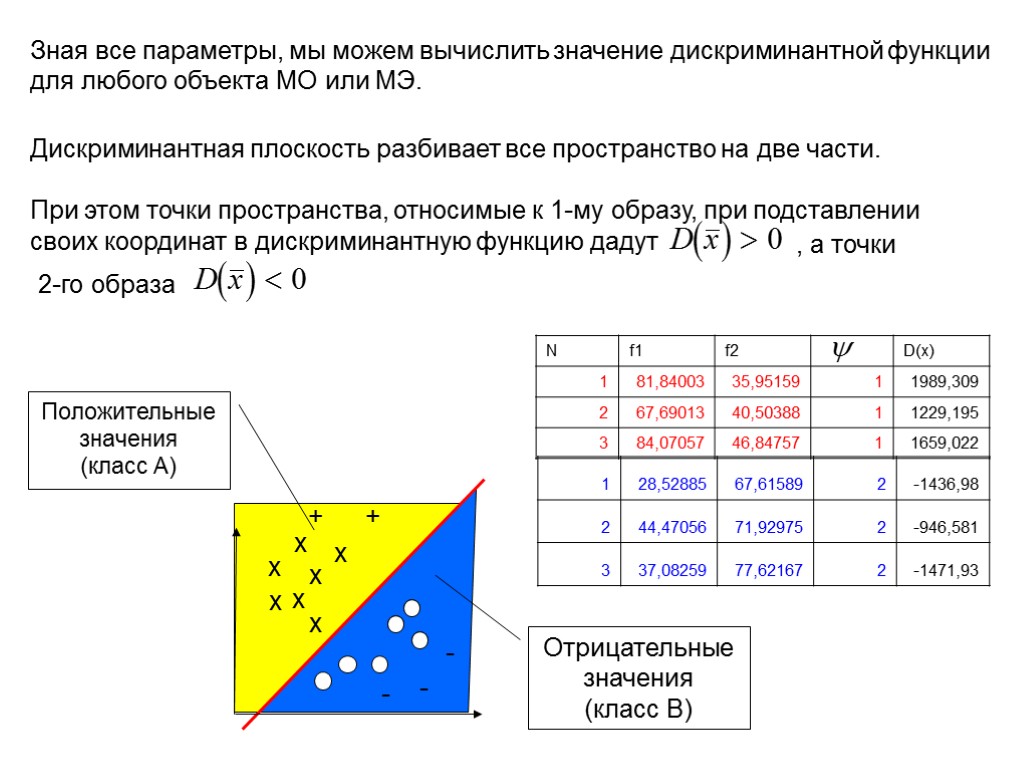

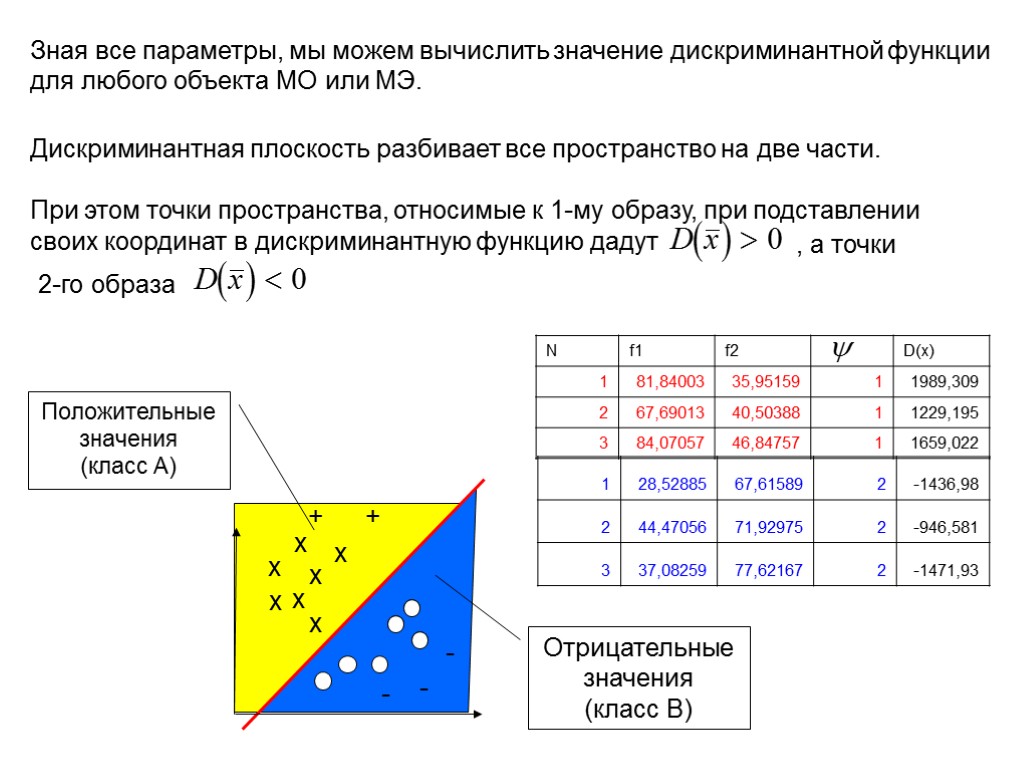

Зная все параметры, мы можем вычислить значение дискриминантной функции для любого объекта МО или МЭ. х х х х х х х + - - - + Положительные значения (класс А) Отрицательные значения (класс В)

Зная все параметры, мы можем вычислить значение дискриминантной функции для любого объекта МО или МЭ. х х х х х х х + - - - + Положительные значения (класс А) Отрицательные значения (класс В)

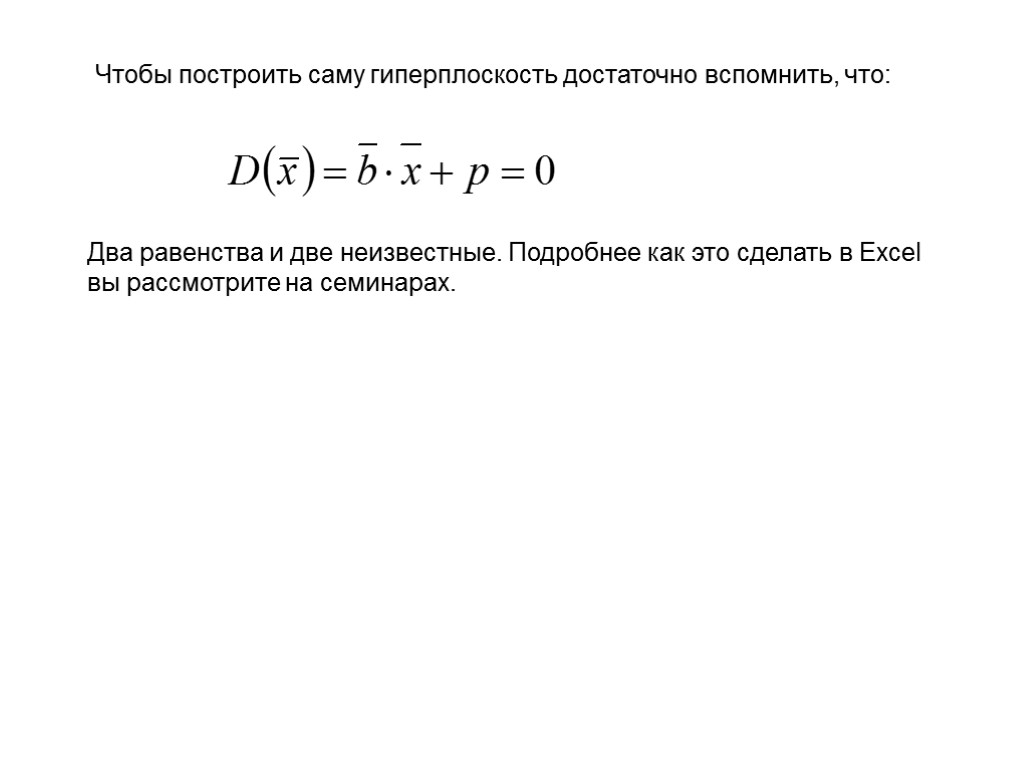

Чтобы построить саму гиперплоскость достаточно вспомнить, что: Два равенства и две неизвестные. Подробнее как это сделать в Excel вы рассмотрите на семинарах.

Чтобы построить саму гиперплоскость достаточно вспомнить, что: Два равенства и две неизвестные. Подробнее как это сделать в Excel вы рассмотрите на семинарах.

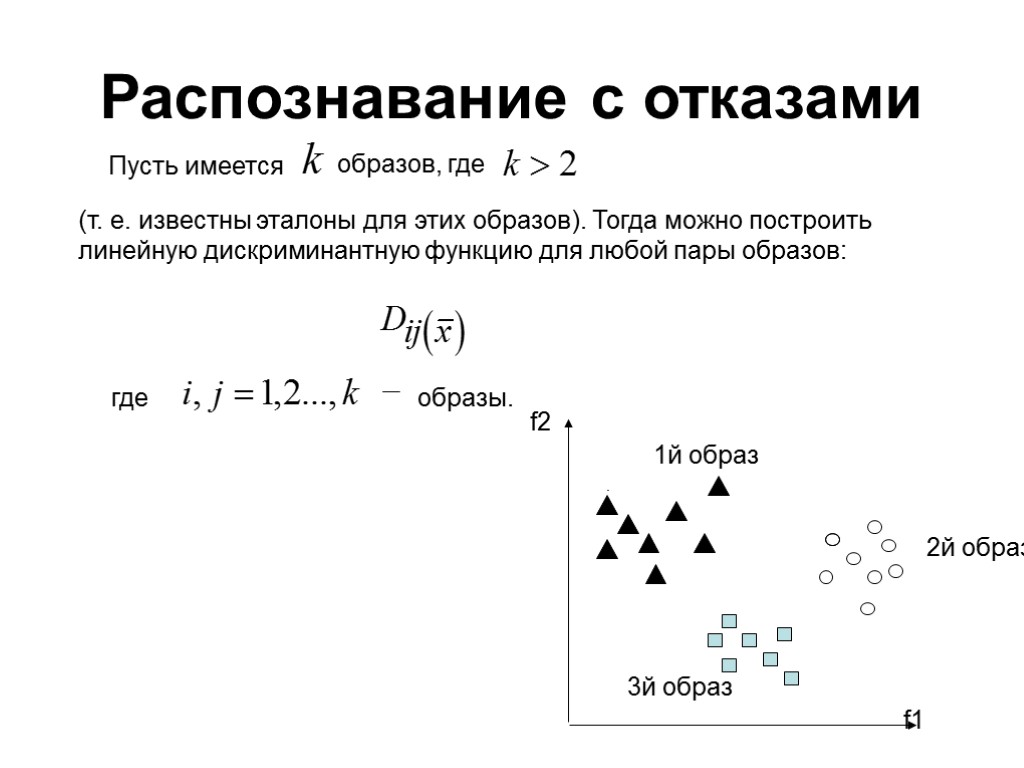

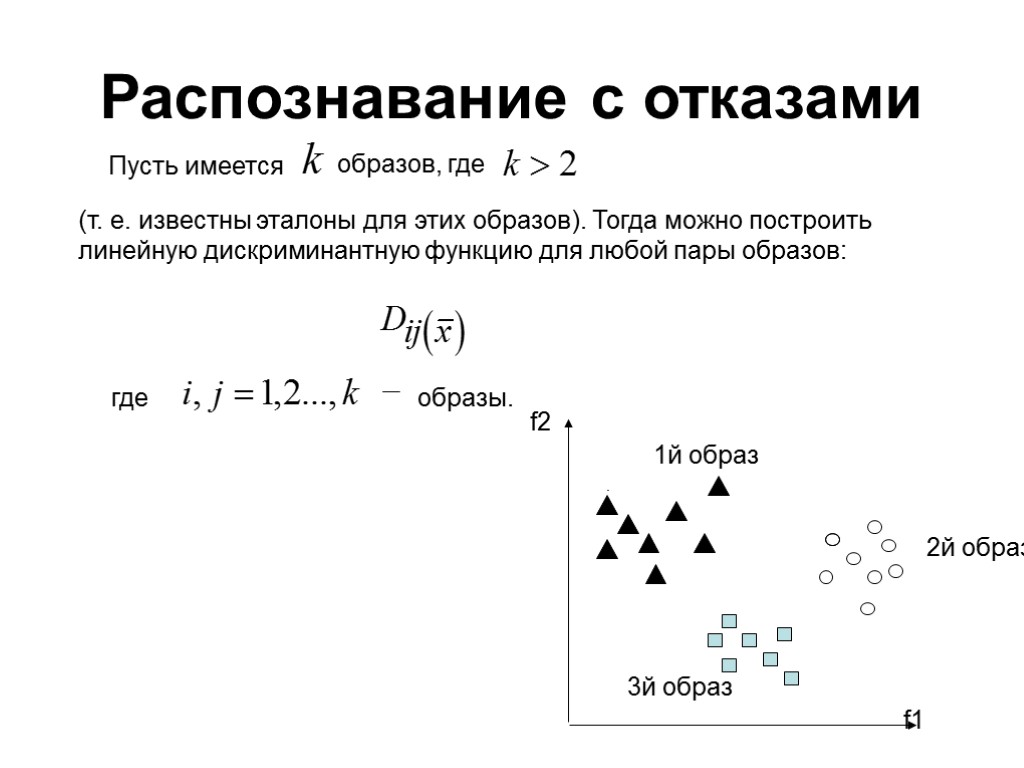

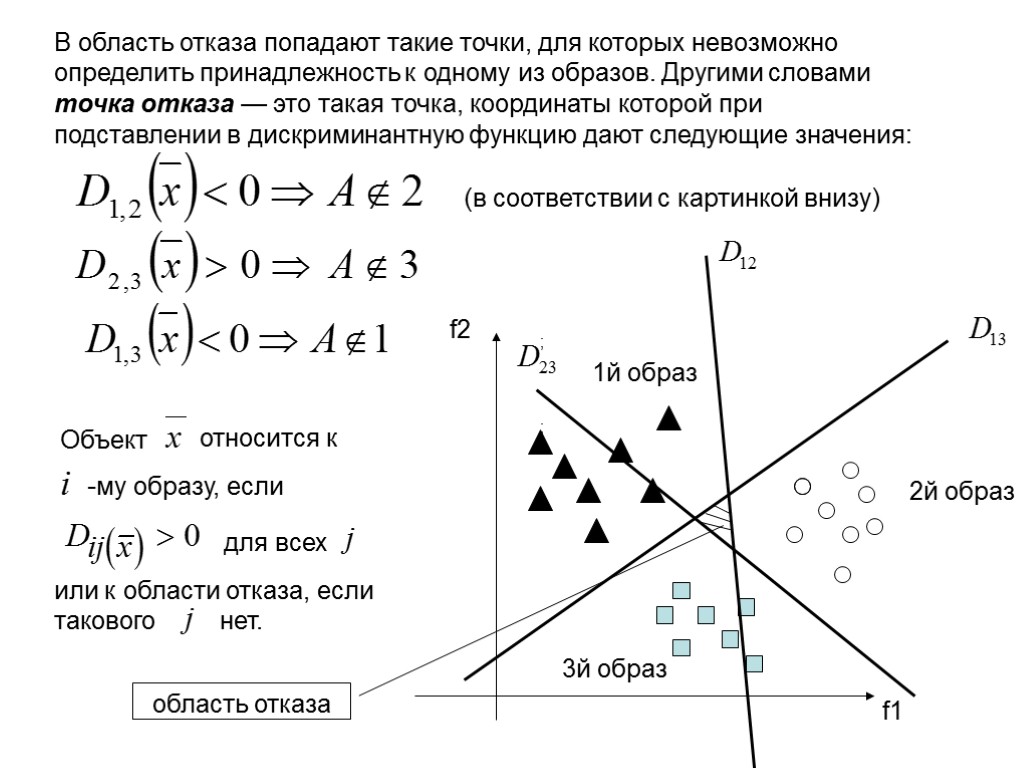

Распознавание с отказами Пусть имеется образов, где (т. е. известны эталоны для этих образов). Тогда можно построить линейную дискриминантную функцию для любой пары образов: где образы.

Распознавание с отказами Пусть имеется образов, где (т. е. известны эталоны для этих образов). Тогда можно построить линейную дискриминантную функцию для любой пары образов: где образы.

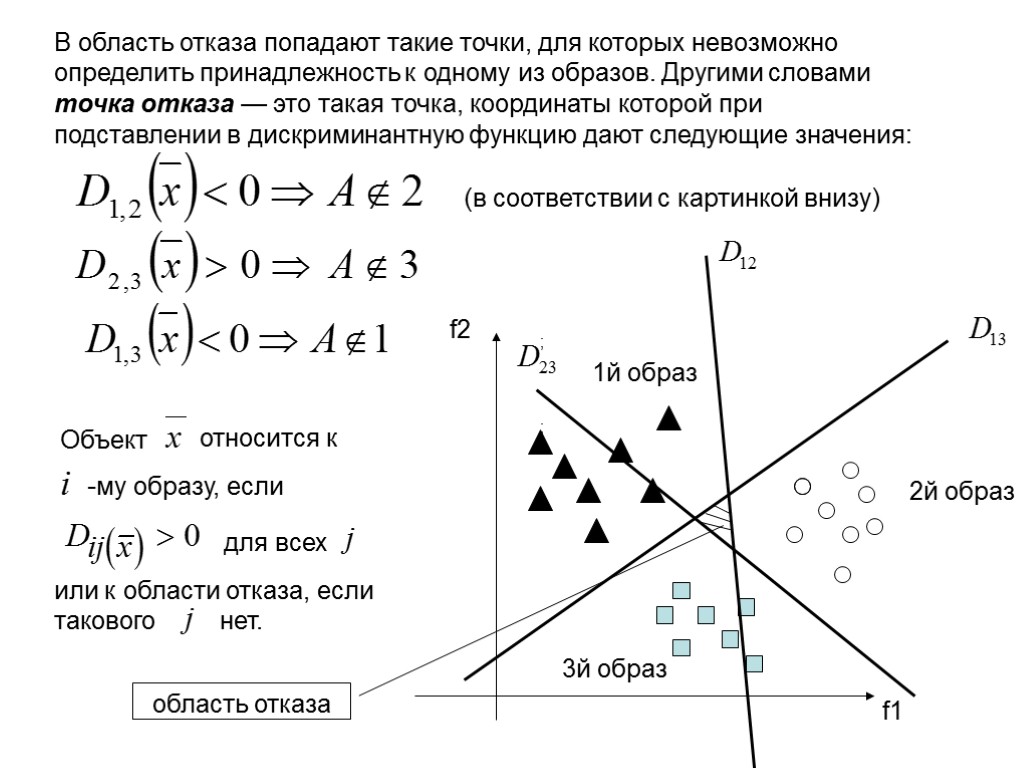

f1 f2 1й образ 3й образ 2й образ Объект относится к -му образу, если для всех или к области отказа, если такового нет. В область отказа попадают такие точки, для которых невозможно определить принадлежность к одному из образов. Другими словами точка отказа — это такая точка, координаты которой при подставлении в дискриминантную функцию дают следующие значения: ; ; (в соответствии с картинкой внизу) область отказа

f1 f2 1й образ 3й образ 2й образ Объект относится к -му образу, если для всех или к области отказа, если такового нет. В область отказа попадают такие точки, для которых невозможно определить принадлежность к одному из образов. Другими словами точка отказа — это такая точка, координаты которой при подставлении в дискриминантную функцию дают следующие значения: ; ; (в соответствии с картинкой внизу) область отказа