МиИ Лекция 4.ppt

- Количество слайдов: 21

Лекция 4 ИНФОРМАЦИОННЫЕ ПРОЦЕССЫ доц. А. В. Штыров, каф. Ти. МОФИ 1

Лекция 4 ИНФОРМАЦИОННЫЕ ПРОЦЕССЫ доц. А. В. Штыров, каф. Ти. МОФИ 1

КОДИРОВАНИЕ ИНФОРМАЦИИ ■ Основные задачи теории кодирования: разработка принципов наиболее экономичного кодирования информации; согласование параметров передаваемой информации с особенностями канала связи; разработка приемов, обеспечивающих надежность передачи информации по каналам связи, т. е. отсутствие потерь информации. 2

КОДИРОВАНИЕ ИНФОРМАЦИИ ■ Основные задачи теории кодирования: разработка принципов наиболее экономичного кодирования информации; согласование параметров передаваемой информации с особенностями канала связи; разработка приемов, обеспечивающих надежность передачи информации по каналам связи, т. е. отсутствие потерь информации. 2

КОДИРОВАНИЕ ИНФОРМАЦИИ ■ Определения: алфавит, с помощью которого представляется информация до преобразования, назовем первичным, или алфавитом А; алфавит конечного представления – вторичным, алфавитом В. Код (1) – правило, описывающее соответствие знаков или их сочетаний одного алфавита знакам или их сочетаниям другого алфавита. Код (2) – знаки алфавита В, используемые для представления знаков или сочетаний знаков алфавита А. Кодирование – перевод информации, представленной посредством алфавита А, в последовательность кодов. Декодирование – операция, обратная кодированию, т. е. восстановление информации в алфавите А по полученной последовательности кодов. 3

КОДИРОВАНИЕ ИНФОРМАЦИИ ■ Определения: алфавит, с помощью которого представляется информация до преобразования, назовем первичным, или алфавитом А; алфавит конечного представления – вторичным, алфавитом В. Код (1) – правило, описывающее соответствие знаков или их сочетаний одного алфавита знакам или их сочетаниям другого алфавита. Код (2) – знаки алфавита В, используемые для представления знаков или сочетаний знаков алфавита А. Кодирование – перевод информации, представленной посредством алфавита А, в последовательность кодов. Декодирование – операция, обратная кодированию, т. е. восстановление информации в алфавите А по полученной последовательности кодов. 3

КОДИРОВАНИЕ ИНФОРМАЦИИ Постановка задачи кодирования. Пусть: первичный алфавит A содержит N знаков со средней информацией на знак, определенной с учетом вероятностей их появления I(A); вторичный алфавит B содержит M знаков со средней информационной емкостью I(В); исходное сообщение, представленное в первичном алфавите, содержит n знаков, а закодированное сообщение – m знаков. Тогда: количество информации в исходном сообщении составит n·I(A), а в закодированном сообщении – m·I(В). Очевидно, что: n·I(A)≤m·I(В), то есть операция обратимого кодирования может увеличить количество формальной информации в сообщении, но не может его уменьшить. 4

КОДИРОВАНИЕ ИНФОРМАЦИИ Постановка задачи кодирования. Пусть: первичный алфавит A содержит N знаков со средней информацией на знак, определенной с учетом вероятностей их появления I(A); вторичный алфавит B содержит M знаков со средней информационной емкостью I(В); исходное сообщение, представленное в первичном алфавите, содержит n знаков, а закодированное сообщение – m знаков. Тогда: количество информации в исходном сообщении составит n·I(A), а в закодированном сообщении – m·I(В). Очевидно, что: n·I(A)≤m·I(В), то есть операция обратимого кодирования может увеличить количество формальной информации в сообщении, но не может его уменьшить. 4

КОДИРОВАНИЕ ИНФОРМАЦИИ Постановка задачи кодирования. Отсюда следует: I(A) ≤m/n·I(В) Отношение m/n характеризует среднее число знаков вторичного алфавита, которое приходится использовать для кодирования одного знака первичного алфавита. Назовем его длиной кода, или длиной кодовой цепочки: K(B)= m/n. В случае, когда появление любых знаков вторичного алфавита равновероятно, согласно формуле Хартли I(B)=log 2 M. Значит: I(A)/ log 2 M ≤ K(B) 5

КОДИРОВАНИЕ ИНФОРМАЦИИ Постановка задачи кодирования. Отсюда следует: I(A) ≤m/n·I(В) Отношение m/n характеризует среднее число знаков вторичного алфавита, которое приходится использовать для кодирования одного знака первичного алфавита. Назовем его длиной кода, или длиной кодовой цепочки: K(B)= m/n. В случае, когда появление любых знаков вторичного алфавита равновероятно, согласно формуле Хартли I(B)=log 2 M. Значит: I(A)/ log 2 M ≤ K(B) 5

КОДИРОВАНИЕ ИНФОРМАЦИИ Постановка задачи кодирования. Чем ближе значение I(В) к I(A), то есть чем меньше избыточность кода, тем более выгодным оказывается код и более эффективной операция кодирования. Избыточность кода определяется по формуле: Q=1 -I(A)/I(В) Первая теорема Шеннона о кодировании утверждает, что При отсутствии помех передачи всегда возможен такой вариант кодирования сообщения, при котором избыточность кода будет сколь угодно близкой к нулю. В случае двоичного кодирования (когда алфавит В состоит из двух символов), это означает, что При отсутствии помех передачи средняя длина двоичного кода может быть сколь угодно близкой к средней информации, приходящейся на знак первичного алфавита. 6

КОДИРОВАНИЕ ИНФОРМАЦИИ Постановка задачи кодирования. Чем ближе значение I(В) к I(A), то есть чем меньше избыточность кода, тем более выгодным оказывается код и более эффективной операция кодирования. Избыточность кода определяется по формуле: Q=1 -I(A)/I(В) Первая теорема Шеннона о кодировании утверждает, что При отсутствии помех передачи всегда возможен такой вариант кодирования сообщения, при котором избыточность кода будет сколь угодно близкой к нулю. В случае двоичного кодирования (когда алфавит В состоит из двух символов), это означает, что При отсутствии помех передачи средняя длина двоичного кода может быть сколь угодно близкой к средней информации, приходящейся на знак первичного алфавита. 6

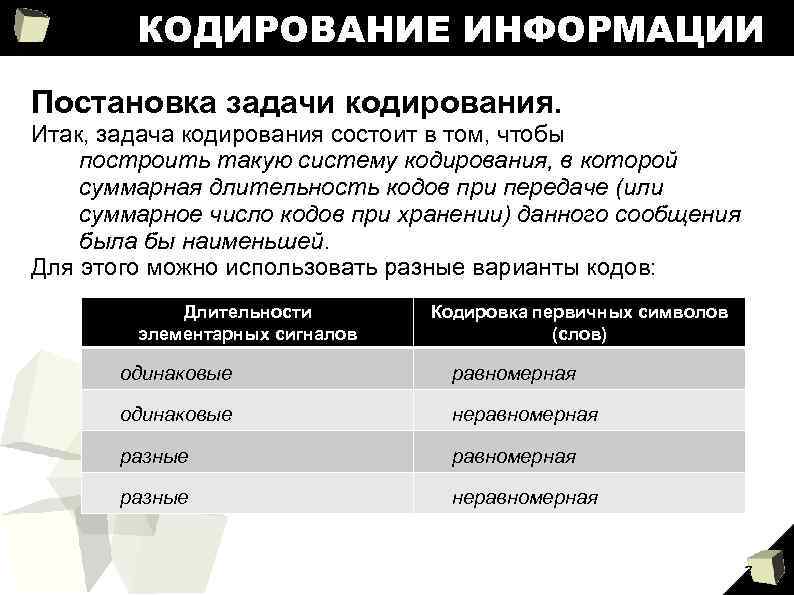

КОДИРОВАНИЕ ИНФОРМАЦИИ Постановка задачи кодирования. Итак, задача кодирования состоит в том, чтобы построить такую систему кодирования, в которой суммарная длительность кодов при передаче (или суммарное число кодов при хранении) данного сообщения была бы наименьшей. Для этого можно использовать разные варианты кодов: Длительности элементарных сигналов Кодировка первичных символов (слов) одинаковые равномерная одинаковые неравномерная разные неравномерная 7

КОДИРОВАНИЕ ИНФОРМАЦИИ Постановка задачи кодирования. Итак, задача кодирования состоит в том, чтобы построить такую систему кодирования, в которой суммарная длительность кодов при передаче (или суммарное число кодов при хранении) данного сообщения была бы наименьшей. Для этого можно использовать разные варианты кодов: Длительности элементарных сигналов Кодировка первичных символов (слов) одинаковые равномерная одинаковые неравномерная разные неравномерная 7

КОДИРОВАНИЕ ИНФОРМАЦИИ Рассмотрим наиболее простой и широко распространенный случай – двоичное равномерное кодирование. В этом случае для определения длины кодовой цепочки можно воспользоваться формулой: K(2)≥log 2 N. 8

КОДИРОВАНИЕ ИНФОРМАЦИИ Рассмотрим наиболее простой и широко распространенный случай – двоичное равномерное кодирование. В этом случае для определения длины кодовой цепочки можно воспользоваться формулой: K(2)≥log 2 N. 8

КОДИРОВАНИЕ ИНФОРМАЦИИ Один из первых вариантов двоичного равномерного кода – телеграфный код Бодо, разработанный в 1870 гг. В этом коде K 2= log 232 = 5, т. е. код 5 -битный, для кодировки каждого знака первичного алфавита используется 5 двоичных символов. Этот код и его модификации использовался при передаче данных на телеграфе более ста лет. Эмиль Бодо 1845 -1903 9

КОДИРОВАНИЕ ИНФОРМАЦИИ Один из первых вариантов двоичного равномерного кода – телеграфный код Бодо, разработанный в 1870 гг. В этом коде K 2= log 232 = 5, т. е. код 5 -битный, для кодировки каждого знака первичного алфавита используется 5 двоичных символов. Этот код и его модификации использовался при передаче данных на телеграфе более ста лет. Эмиль Бодо 1845 -1903 9

КОДИРОВАНИЕ ИНФОРМАЦИИ Другой вариант равномерного двоичного кодирования – байтовый код, применяющийся в компьютерной технике. Байтом называется последовательность бит, достаточных для кодирования одного символа первичного алфавита. С начала 1970 -х гг. в качестве международного стандарта приняты 8 -битные байты (в более ранних компьютерах для кодирования символов использовались последовательности из 6 или 9 бит). 10

КОДИРОВАНИЕ ИНФОРМАЦИИ Другой вариант равномерного двоичного кодирования – байтовый код, применяющийся в компьютерной технике. Байтом называется последовательность бит, достаточных для кодирования одного символа первичного алфавита. С начала 1970 -х гг. в качестве международного стандарта приняты 8 -битные байты (в более ранних компьютерах для кодирования символов использовались последовательности из 6 или 9 бит). 10

КОДИРОВАНИЕ ИНФОРМАЦИИ Оптимальный размер байта можно вычислить следующим образом: Компьютерный алфавит должен включать: 26∙ 2=52 букв латинского алфавита (с учетом прописных и строчных); цифры 0… 9 – всего 10; знаки математических операций, знаки препинания, управляющие символы – около 30. Итого – 92 знака. K(2)≥log 292≈6, 523. Округлив получившееся значение до ближайшего целого, получим 7 – длину байта согласно ASCII (Американскому стандартному коду информационного обмена). НО: 11

КОДИРОВАНИЕ ИНФОРМАЦИИ Оптимальный размер байта можно вычислить следующим образом: Компьютерный алфавит должен включать: 26∙ 2=52 букв латинского алфавита (с учетом прописных и строчных); цифры 0… 9 – всего 10; знаки математических операций, знаки препинания, управляющие символы – около 30. Итого – 92 знака. K(2)≥log 292≈6, 523. Округлив получившееся значение до ближайшего целого, получим 7 – длину байта согласно ASCII (Американскому стандартному коду информационного обмена). НО: 11

КОДИРОВАНИЕ ИНФОРМАЦИИ Кроме указанных символов, необходимо оказалось предусмотреть также кодирование символов других алфавитов – кириллического, греческого, восточных и т. п. Следующее целое число бит, которое может содержаться в байте – 8. Отсюда – 8 -битный стандарт. Он позволяет закодировать 28=256 символов. Дальнейшее развитие байтового кода – принятый в 1991 г. стандарт Unicode, в котором для кодирования одного символа используется два и более байтов (существует несколько стандартов). Он позволяет закодировать до 231=2 147 483 648 символов, пространство которых разбито на группы по 65 536 (216) символов. На практике сегодня используются около 100 000 кодовых позиций. 12

КОДИРОВАНИЕ ИНФОРМАЦИИ Кроме указанных символов, необходимо оказалось предусмотреть также кодирование символов других алфавитов – кириллического, греческого, восточных и т. п. Следующее целое число бит, которое может содержаться в байте – 8. Отсюда – 8 -битный стандарт. Он позволяет закодировать 28=256 символов. Дальнейшее развитие байтового кода – принятый в 1991 г. стандарт Unicode, в котором для кодирования одного символа используется два и более байтов (существует несколько стандартов). Он позволяет закодировать до 231=2 147 483 648 символов, пространство которых разбито на группы по 65 536 (216) символов. На практике сегодня используются около 100 000 кодовых позиций. 12

ПЕРЕДАЧА ИНФОРМАЦИИ Средства связи – совокупность устройств, обеспечивающих преобразование первичного сообщения от источника информации в сигналы заданной физической природы, их передачу, прием и представление в форме, удобной потребителю. Канал связи – материальная среда, а также физический или иной процесс, посредством которого осуществляется передача сообщения, т. е. распространение сигналов в пространстве с течением времени. Линия связи – совокупность средств связи и канала связи, посредством которых осуществляется передача информации от источника к приемнику. 13

ПЕРЕДАЧА ИНФОРМАЦИИ Средства связи – совокупность устройств, обеспечивающих преобразование первичного сообщения от источника информации в сигналы заданной физической природы, их передачу, прием и представление в форме, удобной потребителю. Канал связи – материальная среда, а также физический или иной процесс, посредством которого осуществляется передача сообщения, т. е. распространение сигналов в пространстве с течением времени. Линия связи – совокупность средств связи и канала связи, посредством которых осуществляется передача информации от источника к приемнику. 13

ПЕРЕДАЧА ИНФОРМАЦИИ Общая схема передачи информации: Источник информации Приемник сообщения Защита от помех Канал связи Защита от помехи Передатчик сообщения Кодер помехи Декодер Приемник информации 14

ПЕРЕДАЧА ИНФОРМАЦИИ Общая схема передачи информации: Источник информации Приемник сообщения Защита от помех Канал связи Защита от помехи Передатчик сообщения Кодер помехи Декодер Приемник информации 14

ПЕРЕДАЧА ИНФОРМАЦИИ Дискретный канал – канал связи, используемый для передачи дискретных сообщений. Источник ДС Кодер Сообщение в первичном алфавите {А} помехи Коды знаков {А}, представленные алфавитом входных сигналов {а} Декодер Коды знаков {А’}, представленные алфавитом сигналов {а’} Приемник ДС Сообщение в алфавите {А’} Действие помех искажает входные сигналы; в результате на выходе канала появляются такие комбинации элементарных сигналов, которые не могут быть интерпретированы как коды знаков первичного алфавита {А}. Можно сказать, что возникает некий новый кодовый алфавит {а’}, отличающийся от {a} как количеством знаков, так и их кодами, и конечный алфавит {А’}, возникающий в результате обработки алфавита {а’} декодером. 15

ПЕРЕДАЧА ИНФОРМАЦИИ Дискретный канал – канал связи, используемый для передачи дискретных сообщений. Источник ДС Кодер Сообщение в первичном алфавите {А} помехи Коды знаков {А}, представленные алфавитом входных сигналов {а} Декодер Коды знаков {А’}, представленные алфавитом сигналов {а’} Приемник ДС Сообщение в алфавите {А’} Действие помех искажает входные сигналы; в результате на выходе канала появляются такие комбинации элементарных сигналов, которые не могут быть интерпретированы как коды знаков первичного алфавита {А}. Можно сказать, что возникает некий новый кодовый алфавит {а’}, отличающийся от {a} как количеством знаков, так и их кодами, и конечный алфавит {А’}, возникающий в результате обработки алфавита {а’} декодером. 15

ПЕРЕДАЧА ИНФОРМАЦИИ Основные параметры дискретного канала: • время передачи одного элементарного сигнала τ. • исходный алфавит элементарных сигналов {a}, т. е. все его знаки ai (i=1…n, где n – число знаков алфавита {a}); • n значений вероятностей появления элементарных сигналов на входе p(ai); эти вероятности называются априорными, поскольку определяются не свойствами канала, а источником сообщения; • алфавит сигналов на выходе канала {а’}, т. е. все знаки a’j (j = 1…m, где m – число знаков алфавита {а’}; в общем случае n≠m; • значения некоторых условных вероятностей, характеризующих вероятность появления на выходе канала сигнала a’j при условии, что на вход был послан сигнал ai; поскольку эти вероятности определяются свойствами самого канала передачи, они называются апостериорными; количество таких вероятностей равно n·m. Все остальные характеристики дискретного канала могут быть определены через перечисленные параметры. 16

ПЕРЕДАЧА ИНФОРМАЦИИ Основные параметры дискретного канала: • время передачи одного элементарного сигнала τ. • исходный алфавит элементарных сигналов {a}, т. е. все его знаки ai (i=1…n, где n – число знаков алфавита {a}); • n значений вероятностей появления элементарных сигналов на входе p(ai); эти вероятности называются априорными, поскольку определяются не свойствами канала, а источником сообщения; • алфавит сигналов на выходе канала {а’}, т. е. все знаки a’j (j = 1…m, где m – число знаков алфавита {а’}; в общем случае n≠m; • значения некоторых условных вероятностей, характеризующих вероятность появления на выходе канала сигнала a’j при условии, что на вход был послан сигнал ai; поскольку эти вероятности определяются свойствами самого канала передачи, они называются апостериорными; количество таких вероятностей равно n·m. Все остальные характеристики дискретного канала могут быть определены через перечисленные параметры. 16

ПЕРЕДАЧА ИНФОРМАЦИИ Основные характеристики дискретного канала: • Ширина полосы пропускания – интервал частот, используемый данным каналом связи для передачи сигналов. Важна не сама ширина полосы пропускания, а максимальное значение частоты из данной полосы νmax, поскольку именно им определяется длительность элементарного импульса τ: τ=1/νmax По дискретному каналу за единицу времени можно передавать не более νmax элементарных сигналов. Зная τ, можно найти количество элементарных сигналов, передаваемое по каналу за единицу времени: L=1/τ. Если код знака первичного алфавита состоит из ki элементарных сигналов, то время его передачи по каналу составит ti = ki·τ, а среднее время передачи кодовой комбинации одного знака первичного алфавита будет равно t = K(A, a)·τ. 17

ПЕРЕДАЧА ИНФОРМАЦИИ Основные характеристики дискретного канала: • Ширина полосы пропускания – интервал частот, используемый данным каналом связи для передачи сигналов. Важна не сама ширина полосы пропускания, а максимальное значение частоты из данной полосы νmax, поскольку именно им определяется длительность элементарного импульса τ: τ=1/νmax По дискретному каналу за единицу времени можно передавать не более νmax элементарных сигналов. Зная τ, можно найти количество элементарных сигналов, передаваемое по каналу за единицу времени: L=1/τ. Если код знака первичного алфавита состоит из ki элементарных сигналов, то время его передачи по каналу составит ti = ki·τ, а среднее время передачи кодовой комбинации одного знака первичного алфавита будет равно t = K(A, a)·τ. 17

ПЕРЕДАЧА ИНФОРМАЦИИ Основные характеристики дискретного канала: Пропускная способность канала связи – величина, характеризующая предельную интенсивность информационного потока через канал. Пропускную способность канала связи без помех согласно теореме Шеннона можно рассчитать как произведение количества элементарных сигналов, передаваемых за единицу времени, на максимальную информационную емкость элементарного сигнала: Сmax =L∙Imax или как максимальную информационную емкость элементарного сигнала, разделенную на время его передачи: Сmax =Imax/τ В двоичном канале Imax =log 2 n; следовательно, Сmax=log 2 n /τ =L∙log 2 n= νmax∙log 2 n В реальном канале связи (с помехами) Imax ≤log 2 n, следовательно, С ≤ Сmax 18

ПЕРЕДАЧА ИНФОРМАЦИИ Основные характеристики дискретного канала: Пропускная способность канала связи – величина, характеризующая предельную интенсивность информационного потока через канал. Пропускную способность канала связи без помех согласно теореме Шеннона можно рассчитать как произведение количества элементарных сигналов, передаваемых за единицу времени, на максимальную информационную емкость элементарного сигнала: Сmax =L∙Imax или как максимальную информационную емкость элементарного сигнала, разделенную на время его передачи: Сmax =Imax/τ В двоичном канале Imax =log 2 n; следовательно, Сmax=log 2 n /τ =L∙log 2 n= νmax∙log 2 n В реальном канале связи (с помехами) Imax ≤log 2 n, следовательно, С ≤ Сmax 18

ПЕРЕДАЧА ИНФОРМАЦИИ Основные характеристики дискретного канала: Скорость передачи информации – общее количество информации, передаваемой источником за единицу времени. Ее можно рассчитать как отношение количества элементарных сигналов, выдаваемых источником за единицу времени, к средней длине кода одного знака первичного алфавита, умноженное на информационную емкость элементарного сигнала: J=L/K(A, a)∙Ia или как отношение информационной емкости элементарного сигнала ко времени передачи кода одного знака первичного алфавита: J=Ia/ τ∙K(A, a) Как доказано Шенноном, всегда J≤C, т. е. скорость передачи информации по каналу связи не может превысить его пропускной способности. Это утверждение справедливо как для идеального канала связи, так и, тем более, для канала связи с помехами. 19

ПЕРЕДАЧА ИНФОРМАЦИИ Основные характеристики дискретного канала: Скорость передачи информации – общее количество информации, передаваемой источником за единицу времени. Ее можно рассчитать как отношение количества элементарных сигналов, выдаваемых источником за единицу времени, к средней длине кода одного знака первичного алфавита, умноженное на информационную емкость элементарного сигнала: J=L/K(A, a)∙Ia или как отношение информационной емкости элементарного сигнала ко времени передачи кода одного знака первичного алфавита: J=Ia/ τ∙K(A, a) Как доказано Шенноном, всегда J≤C, т. е. скорость передачи информации по каналу связи не может превысить его пропускной способности. Это утверждение справедливо как для идеального канала связи, так и, тем более, для канала связи с помехами. 19

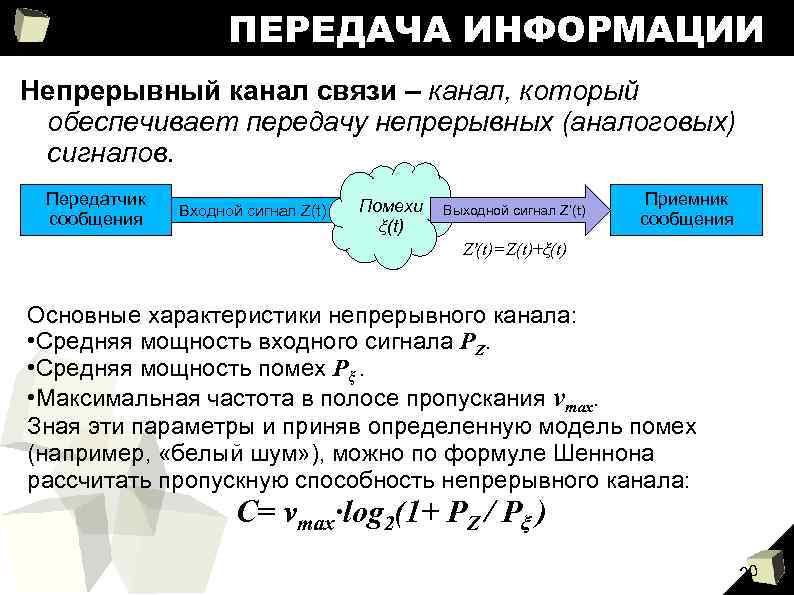

ПЕРЕДАЧА ИНФОРМАЦИИ Непрерывный канал связи – канал, который обеспечивает передачу непрерывных (аналоговых) сигналов. Передатчик сообщения Входной сигнал Z(t) Помехи ξ(t) Выходной сигнал Z’(t) Приемник сообщения Z'(t)=Z(t)+ξ(t) Основные характеристики непрерывного канала: • Средняя мощность входного сигнала PZ. • Средняя мощность помех Pξ. • Максимальная частота в полосе пропускания νmax. Зная эти параметры и приняв определенную модель помех (например, «белый шум» ), можно по формуле Шеннона рассчитать пропускную способность непрерывного канала: С= νmax∙log 2(1+ PZ / Pξ ) 20

ПЕРЕДАЧА ИНФОРМАЦИИ Непрерывный канал связи – канал, который обеспечивает передачу непрерывных (аналоговых) сигналов. Передатчик сообщения Входной сигнал Z(t) Помехи ξ(t) Выходной сигнал Z’(t) Приемник сообщения Z'(t)=Z(t)+ξ(t) Основные характеристики непрерывного канала: • Средняя мощность входного сигнала PZ. • Средняя мощность помех Pξ. • Максимальная частота в полосе пропускания νmax. Зная эти параметры и приняв определенную модель помех (например, «белый шум» ), можно по формуле Шеннона рассчитать пропускную способность непрерывного канала: С= νmax∙log 2(1+ PZ / Pξ ) 20

ПЕРЕДАЧА ИНФОРМАЦИИ Из этой формулы следуют некоторые особенности непрерывного канала связи: • При фиксированной νmax пропускная способность определяется только отношением мощностей сигнала и помех. Ограничение пропускной способности непрерывного канала связано с тем, что любые используемые для связи сигналы имеют конечную мощность. • C=0 только при PZ=0. Т. е. непрерывный канал обеспечивает передачу информации даже в том случае, если уровень шумов превышает уровень сигнала – это используется для скрытой (неперехватываемой) передачи. • Повысить пропускную способность непрерывного канала можно за счет увеличения значения νmax, увеличения значения PZ или снижения значения Pξ. 21

ПЕРЕДАЧА ИНФОРМАЦИИ Из этой формулы следуют некоторые особенности непрерывного канала связи: • При фиксированной νmax пропускная способность определяется только отношением мощностей сигнала и помех. Ограничение пропускной способности непрерывного канала связано с тем, что любые используемые для связи сигналы имеют конечную мощность. • C=0 только при PZ=0. Т. е. непрерывный канал обеспечивает передачу информации даже в том случае, если уровень шумов превышает уровень сигнала – это используется для скрытой (неперехватываемой) передачи. • Повысить пропускную способность непрерывного канала можно за счет увеличения значения νmax, увеличения значения PZ или снижения значения Pξ. 21