МиИ Лекция 3.ppt

- Количество слайдов: 20

Лекция 3 ИНФОРМАЦИЯ: СВОЙСТВА И ИЗМЕРЕНИЕ доц. А. В. Штыров, каф. Ти. МОФИ 1

Лекция 3 ИНФОРМАЦИЯ: СВОЙСТВА И ИЗМЕРЕНИЕ доц. А. В. Штыров, каф. Ти. МОФИ 1

ОПРЕДЕЛЕНИЕ ■ Информация: набор сведений об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают степень неопределенности и неполноты имеющихся о них знаний. 2

ОПРЕДЕЛЕНИЕ ■ Информация: набор сведений об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают степень неопределенности и неполноты имеющихся о них знаний. 2

СВОЙСТВА ИНФОРМАЦИИ • Репрезентативность. Она определяет критерии отбора признаков, адекватно отражающих свойства объекта. Важнейшее значение здесь имеют: – Правильность концепции, на базе которой формируются исходные понятия. – Обоснованность отбора данных признаков и связей отображаемого явления. • Содержательность. Определяет отношение количества семантической, то есть несущей смысловую нагрузку, информации в сообщении к общему объему данных. • Полнота. Характеризует минимально необходимый объем данных, позволяющих принять правильное решение. • Доступность. Информационное сообщение должно быть предоставлено пользователю в максимально понятной для него форме, что достигается выполнением соответствующих процедур его получения и преобразования. • Своевременность. Информация имеет ценность лишь в том случае, если она поступает не позже (а иногда – и не ранее) установленного срока, который определяется исходя из условий решения поставленной задачи. • Точность определяет степень близости полученной информации к реальному состоянию объекта. • Достоверность информации определяется ее свойством отражать реально существующие объекты с необходимой точностью. • Устойчивость информации отражает ее способность реагировать на изменение исходных данных без нарушения необходимой точности. 3

СВОЙСТВА ИНФОРМАЦИИ • Репрезентативность. Она определяет критерии отбора признаков, адекватно отражающих свойства объекта. Важнейшее значение здесь имеют: – Правильность концепции, на базе которой формируются исходные понятия. – Обоснованность отбора данных признаков и связей отображаемого явления. • Содержательность. Определяет отношение количества семантической, то есть несущей смысловую нагрузку, информации в сообщении к общему объему данных. • Полнота. Характеризует минимально необходимый объем данных, позволяющих принять правильное решение. • Доступность. Информационное сообщение должно быть предоставлено пользователю в максимально понятной для него форме, что достигается выполнением соответствующих процедур его получения и преобразования. • Своевременность. Информация имеет ценность лишь в том случае, если она поступает не позже (а иногда – и не ранее) установленного срока, который определяется исходя из условий решения поставленной задачи. • Точность определяет степень близости полученной информации к реальному состоянию объекта. • Достоверность информации определяется ее свойством отражать реально существующие объекты с необходимой точностью. • Устойчивость информации отражает ее способность реагировать на изменение исходных данных без нарушения необходимой точности. 3

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ 1. 2. 3. Эмпирические; Теоретические; Смешанные, или методы построения теорий на основе полученных эмпирических данных об объекте, процессе, явлении. 4

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ 1. 2. 3. Эмпирические; Теоретические; Смешанные, или методы построения теорий на основе полученных эмпирических данных об объекте, процессе, явлении. 4

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ К эмпирическим методам относятся: • Наблюдение – сбор первичной информации об объекте, процессе, явлении. • Сравнение – обнаружение и соотнесение общего и различного. • Измерение – поиск с помощью измерительных приборов эмпирических фактов. • Эксперимент – преобразование, рассмотрение объекта, процесса, явления с целью выявления каких-то новых свойств. • А также опрос, интервью, тестирование и другие. 5

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ К эмпирическим методам относятся: • Наблюдение – сбор первичной информации об объекте, процессе, явлении. • Сравнение – обнаружение и соотнесение общего и различного. • Измерение – поиск с помощью измерительных приборов эмпирических фактов. • Эксперимент – преобразование, рассмотрение объекта, процесса, явления с целью выявления каких-то новых свойств. • А также опрос, интервью, тестирование и другие. 5

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ К теоретическим методам относятся: • • • Восхождение от абстрактного к конкретному – получение знаний о целом или о его частях на основе знаний об абстрактных проявлениях в сознании, в мышлении. Идеализация – получение знаний о целом или его частях путем представления в мышлении целого или частей, не существующих в действительности. Формализация – получение знаний о целом или его частях с помощью языков искусственного происхождения (формальное описание, представление). Аксиоматизация – получение знаний о целом или его частях с помощью некоторых аксиом (не доказываемых в данной теории утверждений) и правил получения из них (и из ранее полученных утверждений) новых верных утверждений. Виртуализация – получение знаний о целом или его частях с помощью искусственной среды, ситуации. 6

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ К теоретическим методам относятся: • • • Восхождение от абстрактного к конкретному – получение знаний о целом или о его частях на основе знаний об абстрактных проявлениях в сознании, в мышлении. Идеализация – получение знаний о целом или его частях путем представления в мышлении целого или частей, не существующих в действительности. Формализация – получение знаний о целом или его частях с помощью языков искусственного происхождения (формальное описание, представление). Аксиоматизация – получение знаний о целом или его частях с помощью некоторых аксиом (не доказываемых в данной теории утверждений) и правил получения из них (и из ранее полученных утверждений) новых верных утверждений. Виртуализация – получение знаний о целом или его частях с помощью искусственной среды, ситуации. 6

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ К смешанным, эмпирико-теоретическим методам относятся: Абстрагирование – выделение наиболее важных для исследования свойств, сторон исследуемого объекта, процесса, явления и игнорирование несущественных и второстепенных. Анализ – разъединение целого на части с целью выявления их связей. Декомпозиция – разъединение целого на части с сохранением их связей с окружением. Синтез – соединение частей в целое с целью выявления их взаимосвязей. Композиция — соединение частей целого с сохранением их взаимосвязей с окружением. Индукция – получение знания о целом по знаниям о частях. Дедукция – получение знания о частях по знаниям о целом. Эвристика – получение знания о целом по знаниям о частях и по наблюдениям, опыту, интуиции, предвидению. Моделирование (простое моделирование), использование приборов – получение знания о целом или о его частях с помощью модели или приборов. 7

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ К смешанным, эмпирико-теоретическим методам относятся: Абстрагирование – выделение наиболее важных для исследования свойств, сторон исследуемого объекта, процесса, явления и игнорирование несущественных и второстепенных. Анализ – разъединение целого на части с целью выявления их связей. Декомпозиция – разъединение целого на части с сохранением их связей с окружением. Синтез – соединение частей в целое с целью выявления их взаимосвязей. Композиция — соединение частей целого с сохранением их взаимосвязей с окружением. Индукция – получение знания о целом по знаниям о частях. Дедукция – получение знания о частях по знаниям о целом. Эвристика – получение знания о целом по знаниям о частях и по наблюдениям, опыту, интуиции, предвидению. Моделирование (простое моделирование), использование приборов – получение знания о целом или о его частях с помощью модели или приборов. 7

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ К смешанным, эмпирико-теоретическим методам относятся: Исторический метод – поиск знаний с использованием предыстории, реально существовавшей или же мыслимой. Логический метод – поиск знаний путем воспроизведения частей, связей или элементов в мышлении. Макетирование – получение информации по макету, представлению частей в упрощенном, но целостном виде. Актуализация – получение информации с помощью перевода целого или его частей (а следовательно, и целого) из статического состояния в динамическое состояние. Визуализация – получение информации с помощью наглядного или визуального представления состояний объекта, процесса, явления. А также мониторинг (система наблюдений и анализа состояний), деловые игры и ситуации, экспертные оценки (экспертное оценивание), имитация (подражание) и другие формы. 8

МЕТОДЫ ПОЛУЧЕНИЯ ИНФОРМАЦИИ К смешанным, эмпирико-теоретическим методам относятся: Исторический метод – поиск знаний с использованием предыстории, реально существовавшей или же мыслимой. Логический метод – поиск знаний путем воспроизведения частей, связей или элементов в мышлении. Макетирование – получение информации по макету, представлению частей в упрощенном, но целостном виде. Актуализация – получение информации с помощью перевода целого или его частей (а следовательно, и целого) из статического состояния в динамическое состояние. Визуализация – получение информации с помощью наглядного или визуального представления состояний объекта, процесса, явления. А также мониторинг (система наблюдений и анализа состояний), деловые игры и ситуации, экспертные оценки (экспертное оценивание), имитация (подражание) и другие формы. 8

ИЗМЕРЕНИЕ ИНФОРМАЦИИ ■ ■ Вероятностный подход Объемный подход Семантический подход Аксиологический подход 9

ИЗМЕРЕНИЕ ИНФОРМАЦИИ ■ ■ Вероятностный подход Объемный подход Семантический подход Аксиологический подход 9

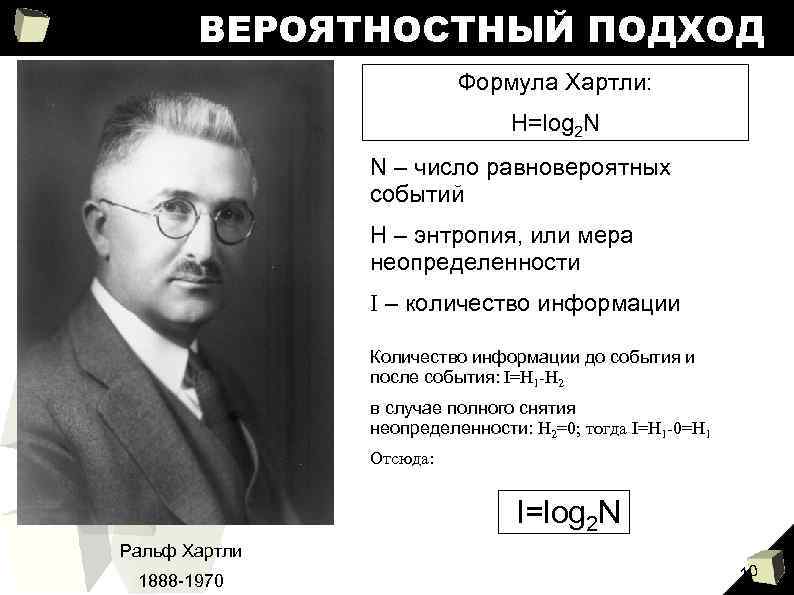

ВЕРОЯТНОСТНЫЙ ПОДХОД Формула Хартли: H=log 2 N N – число равновероятных событий H – энтропия, или мера неопределенности I – количество информации Количество информации до события и после события: I=H 1 -H 2 в случае полного снятия неопределенности: H 2=0; тогда I=H 1 -0=H 1 Отсюда: I=log 2 N Ральф Хартли 1888 -1970 10

ВЕРОЯТНОСТНЫЙ ПОДХОД Формула Хартли: H=log 2 N N – число равновероятных событий H – энтропия, или мера неопределенности I – количество информации Количество информации до события и после события: I=H 1 -H 2 в случае полного снятия неопределенности: H 2=0; тогда I=H 1 -0=H 1 Отсюда: I=log 2 N Ральф Хартли 1888 -1970 10

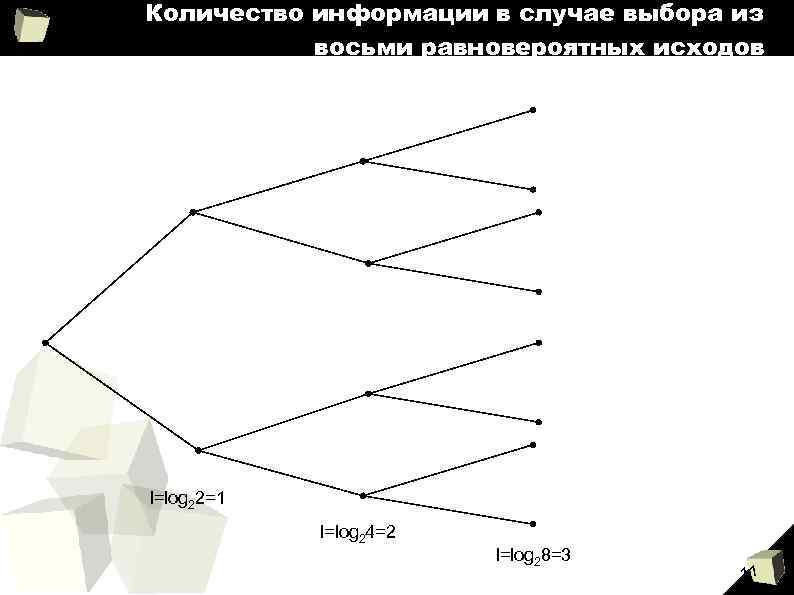

Количество информации в случае выбора из восьми равновероятных исходов I=log 22=1 I=log 24=2 I=log 28=3 11

Количество информации в случае выбора из восьми равновероятных исходов I=log 22=1 I=log 24=2 I=log 28=3 11

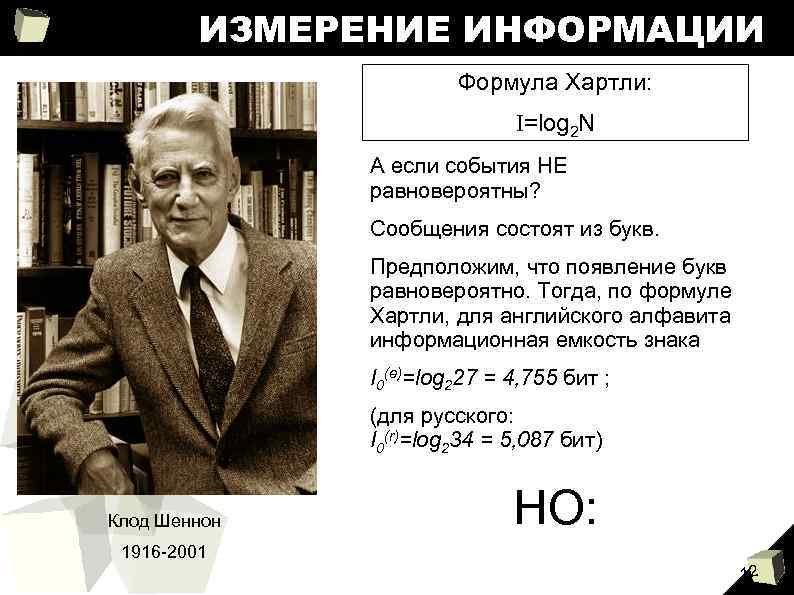

ИЗМЕРЕНИЕ ИНФОРМАЦИИ Формула Хартли: I=log 2 N А если события НЕ равновероятны? Сообщения состоят из букв. Предположим, что появление букв равновероятно. Тогда, по формуле Хартли, для английского алфавита информационная емкость знака I 0(e)=log 227 = 4, 755 бит ; (для русского: I 0(r)=log 234 = 5, 087 бит) Клод Шеннон НО: 1916 -2001 12

ИЗМЕРЕНИЕ ИНФОРМАЦИИ Формула Хартли: I=log 2 N А если события НЕ равновероятны? Сообщения состоят из букв. Предположим, что появление букв равновероятно. Тогда, по формуле Хартли, для английского алфавита информационная емкость знака I 0(e)=log 227 = 4, 755 бит ; (для русского: I 0(r)=log 234 = 5, 087 бит) Клод Шеннон НО: 1916 -2001 12

ПОЯВЛЕНИЕ БУКВ НЕРАВНОВЕРОЯТНО! Буква пробел о Относительная частота 0, 175 Буква р Относительная частота 0, 040 0, 038 Буква я ы Относительная частота 0, 018 0, 016 Буква х Относительная частота 0, 009 0, 090 в ж 0, 007 е, ё 0, 072 л 0, 035 з а 0, 062 к 0, 028 ь, ъ 0, 016 0, 014 ю ш 0, 006 и 0, 062 м 0, 026 б 0, 014 ц 0, 004 т 0, 053 д 0, 025 г 0, 013 щ 0, 003 н 0, 053 п 0, 023 ч 0, 012 э 0, 003 с 0, 045 у 0, 021 й 0, 010 ф 0, 002 13

ПОЯВЛЕНИЕ БУКВ НЕРАВНОВЕРОЯТНО! Буква пробел о Относительная частота 0, 175 Буква р Относительная частота 0, 040 0, 038 Буква я ы Относительная частота 0, 018 0, 016 Буква х Относительная частота 0, 009 0, 090 в ж 0, 007 е, ё 0, 072 л 0, 035 з а 0, 062 к 0, 028 ь, ъ 0, 016 0, 014 ю ш 0, 006 и 0, 062 м 0, 026 б 0, 014 ц 0, 004 т 0, 053 д 0, 025 г 0, 013 щ 0, 003 н 0, 053 п 0, 023 ч 0, 012 э 0, 003 с 0, 045 у 0, 021 й 0, 010 ф 0, 002 13

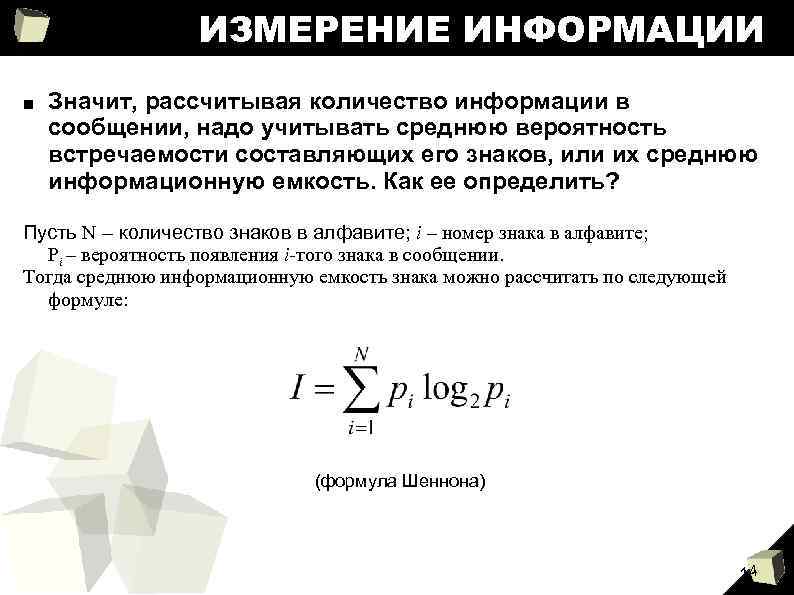

ИЗМЕРЕНИЕ ИНФОРМАЦИИ ■ Значит, рассчитывая количество информации в сообщении, надо учитывать среднюю вероятность встречаемости составляющих его знаков, или их среднюю информационную емкость. Как ее определить? Пусть N – количество знаков в алфавите; i – номер знака в алфавите; Pi – вероятность появления i-того знака в сообщении. Тогда среднюю информационную емкость знака можно рассчитать по следующей формуле: (формула Шеннона) 14

ИЗМЕРЕНИЕ ИНФОРМАЦИИ ■ Значит, рассчитывая количество информации в сообщении, надо учитывать среднюю вероятность встречаемости составляющих его знаков, или их среднюю информационную емкость. Как ее определить? Пусть N – количество знаков в алфавите; i – номер знака в алфавите; Pi – вероятность появления i-того знака в сообщении. Тогда среднюю информационную емкость знака можно рассчитать по следующей формуле: (формула Шеннона) 14

ШЕННОНОНОВСКИЕ ИСТОЧНИКИ Применение данной формулы дает значение средней информации на знак: ■ алфавита русского языка I 1(r) = 4, 36 бит; ■ алфавита английского языка I 1(e) = 4, 04 бит, ■ алфавита французского языка I 1(f) = 3, 96 бит, ■ алфавита немецкого языка I 1(d) = 4, 10 бит. Для всех языков учет вероятностей появления букв в сообщениях приводит к уменьшению среднего информационного содержания буквы. Несовпадение значений средней информации для английского, французского и немецкого языков, основанных на одном алфавите, связано с тем, что частоты появления одинаковых букв в них различаются. 15

ШЕННОНОНОВСКИЕ ИСТОЧНИКИ Применение данной формулы дает значение средней информации на знак: ■ алфавита русского языка I 1(r) = 4, 36 бит; ■ алфавита английского языка I 1(e) = 4, 04 бит, ■ алфавита французского языка I 1(f) = 3, 96 бит, ■ алфавита немецкого языка I 1(d) = 4, 10 бит. Для всех языков учет вероятностей появления букв в сообщениях приводит к уменьшению среднего информационного содержания буквы. Несовпадение значений средней информации для английского, французского и немецкого языков, основанных на одном алфавите, связано с тем, что частоты появления одинаковых букв в них различаются. 15

МАРКОВСКИЕ ИСТОЧНИКИ ■ Кроме вероятности встречаемости буквы, можно учитывать вероятность встречаемости сочетаний букв. ■ Учет в английских словах двухбуквенных сочетаний понижает среднюю информацию на знак до значения I 2(e)=3, 32 бит, учет трехбуквенных – до I 3(e)=3, 10 бит, а для русского языка: I 2(r) = 3, 52 бит; I 3(r)= 3, 01 бит. 16

МАРКОВСКИЕ ИСТОЧНИКИ ■ Кроме вероятности встречаемости буквы, можно учитывать вероятность встречаемости сочетаний букв. ■ Учет в английских словах двухбуквенных сочетаний понижает среднюю информацию на знак до значения I 2(e)=3, 32 бит, учет трехбуквенных – до I 3(e)=3, 10 бит, а для русского языка: I 2(r) = 3, 52 бит; I 3(r)= 3, 01 бит. 16

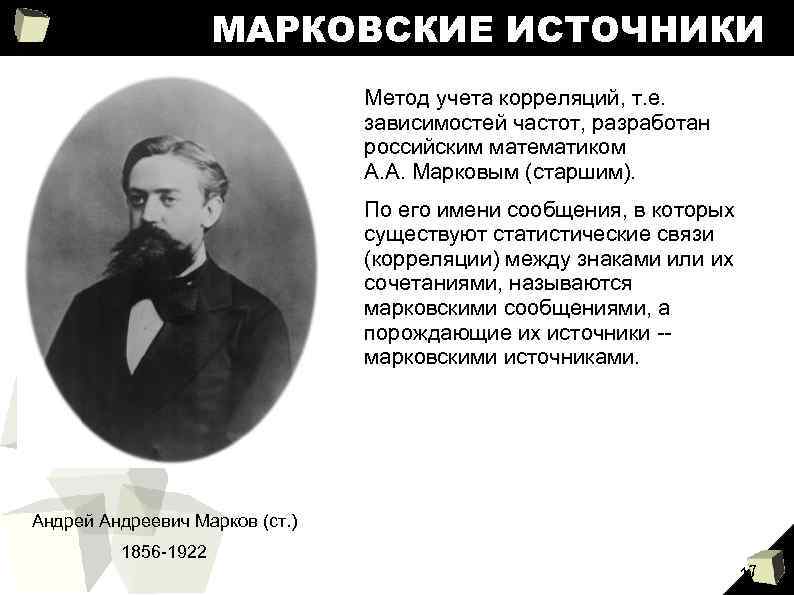

МАРКОВСКИЕ ИСТОЧНИКИ Метод учета корреляций, т. е. зависимостей частот, разработан российским математиком А. А. Марковым (старшим). По его имени сообщения, в которых существуют статистические связи (корреляции) между знаками или их сочетаниями, называются марковскими сообщениями, а порождающие их источники -марковскими источниками. Андрей Андреевич Марков (ст. ) 1856 -1922 17

МАРКОВСКИЕ ИСТОЧНИКИ Метод учета корреляций, т. е. зависимостей частот, разработан российским математиком А. А. Марковым (старшим). По его имени сообщения, в которых существуют статистические связи (корреляции) между знаками или их сочетаниями, называются марковскими сообщениями, а порождающие их источники -марковскими источниками. Андрей Андреевич Марков (ст. ) 1856 -1922 17

ОБЪЕМНЫЙ ПОДХОД Объемный подход к измерению количества информации основывается на простом подсчете количества знаков в сообщении, при том, что все они сведены к единому стандарту – двоичной системе. Эта система удобнее всего для представления информации в технических устройствах, таких как компьютеры, так как гораздо проще различить два противоположных физических состояния системы (например, включено-выключено), чем несколько промежуточных. Знаки в двоичной системе также, как и в общей теории информации, называются битами, но здесь бит действительно – наименьшая возможная величина, а дробное число битов невозможно. 18

ОБЪЕМНЫЙ ПОДХОД Объемный подход к измерению количества информации основывается на простом подсчете количества знаков в сообщении, при том, что все они сведены к единому стандарту – двоичной системе. Эта система удобнее всего для представления информации в технических устройствах, таких как компьютеры, так как гораздо проще различить два противоположных физических состояния системы (например, включено-выключено), чем несколько промежуточных. Знаки в двоичной системе также, как и в общей теории информации, называются битами, но здесь бит действительно – наименьшая возможная величина, а дробное число битов невозможно. 18

ОБЪЕМНЫЙ ПОДХОД Для обозначения одного символа (буквы, цифры и т. д. ) принята комбинация из восьми битов, называемая «двоичным словом» , или «байтом» . Широко используются также производные от байта единицы: ■ ■ килобайт (Кбайт)=210=1024 байта, мегабайт (Мбайт)=210=1024 Кбайта, гигабайт (Гбайт)=210=1024 Мбайта, терабайт (Тбайт)= 210=1024 Гбайта. 19

ОБЪЕМНЫЙ ПОДХОД Для обозначения одного символа (буквы, цифры и т. д. ) принята комбинация из восьми битов, называемая «двоичным словом» , или «байтом» . Широко используются также производные от байта единицы: ■ ■ килобайт (Кбайт)=210=1024 байта, мегабайт (Мбайт)=210=1024 Кбайта, гигабайт (Гбайт)=210=1024 Мбайта, терабайт (Тбайт)= 210=1024 Гбайта. 19

АКСИОЛОГИЧЕСКИЙ И СЕМАНТИЧЕСКИЙ ПОДХОДЫ Предполагают учет цели передачи информации и ее смыслового содержания. Являются исключительно субъективными и не поддающимися точному измерению, т. к. связаны не с сообщением, а непосредственно с самой информацией. 20

АКСИОЛОГИЧЕСКИЙ И СЕМАНТИЧЕСКИЙ ПОДХОДЫ Предполагают учет цели передачи информации и ее смыслового содержания. Являются исключительно субъективными и не поддающимися точному измерению, т. к. связаны не с сообщением, а непосредственно с самой информацией. 20