Лекция 2 Теория информации.pptx

- Количество слайдов: 42

Лекция 2 Теория информации и информационных процессов

Лекция 2 Теория информации и информационных процессов

1. Информация как объект научных исследований.

1. Информация как объект научных исследований.

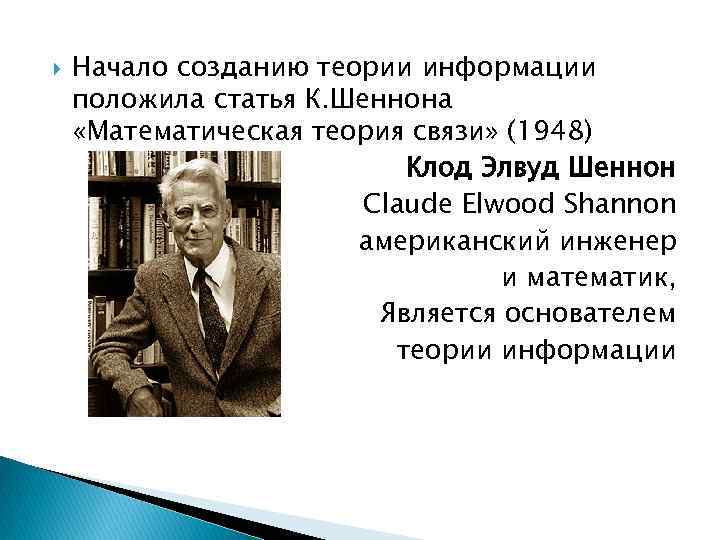

Начало созданию теории информации положила статья К. Шеннона «Математическая теория связи» (1948) Клод Элвуд Шеннон Claude Elwood Shannon американский инженер и математик, Является основателем теории информации

Начало созданию теории информации положила статья К. Шеннона «Математическая теория связи» (1948) Клод Элвуд Шеннон Claude Elwood Shannon американский инженер и математик, Является основателем теории информации

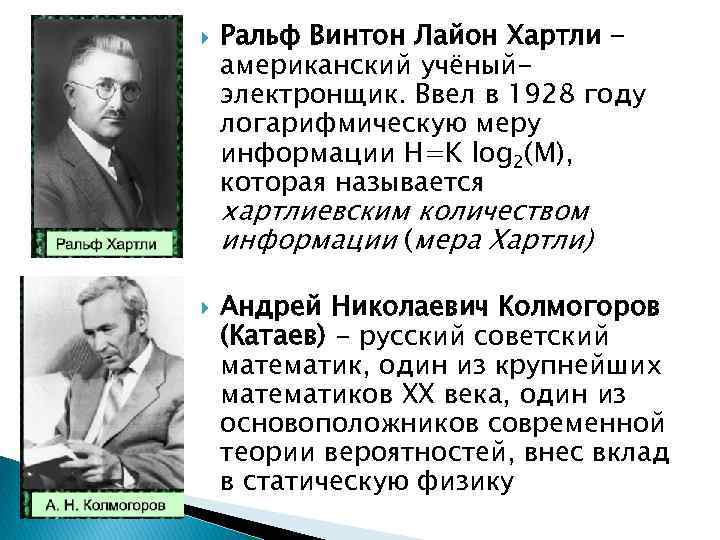

Ральф Винтон Лайон Хартли американский учёныйэлектронщик. Ввел в 1928 году логарифмическую меру информации H=K log 2(M), которая называется хартлиевским количеством информации (мера Хартли) Андрей Николаевич Колмогоров (Катаев) - русский советский математик, один из крупнейших математиков ХХ века, один из основоположников современной теории вероятностей, внес вклад в статическую физику

Ральф Винтон Лайон Хартли американский учёныйэлектронщик. Ввел в 1928 году логарифмическую меру информации H=K log 2(M), которая называется хартлиевским количеством информации (мера Хартли) Андрей Николаевич Колмогоров (Катаев) - русский советский математик, один из крупнейших математиков ХХ века, один из основоположников современной теории вероятностей, внес вклад в статическую физику

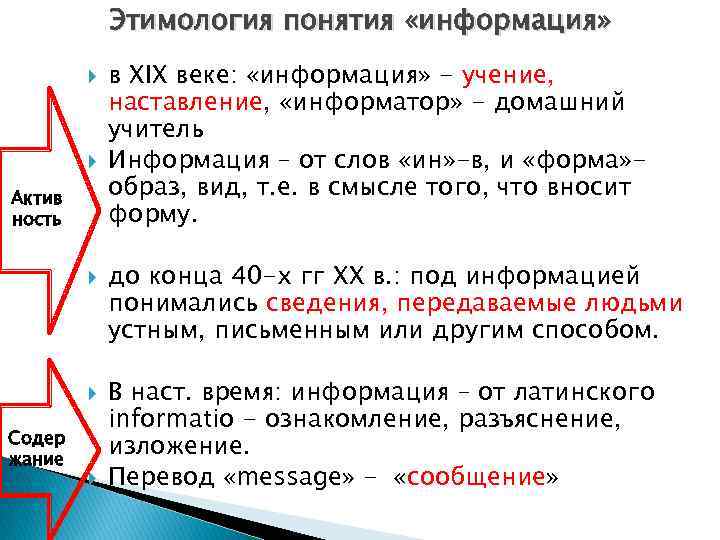

Этимология понятия «информация» Актив ность Содер жание в ХIX веке: «информация» - учение, наставление, «информатор» - домашний учитель Информация – от слов «ин» -в, и «форма» образ, вид, т. е. в смысле того, что вносит форму. до конца 40 -х гг XX в. : под информацией понимались сведения, передаваемые людьми устным, письменным или другим способом. В наст. время: информация – от латинского informatio - ознакомление, разъяснение, изложение. Перевод «message» - «сообщение»

Этимология понятия «информация» Актив ность Содер жание в ХIX веке: «информация» - учение, наставление, «информатор» - домашний учитель Информация – от слов «ин» -в, и «форма» образ, вид, т. е. в смысле того, что вносит форму. до конца 40 -х гг XX в. : под информацией понимались сведения, передаваемые людьми устным, письменным или другим способом. В наст. время: информация – от латинского informatio - ознакомление, разъяснение, изложение. Перевод «message» - «сообщение»

2. Современные подходы к пониманию информации

2. Современные подходы к пониманию информации

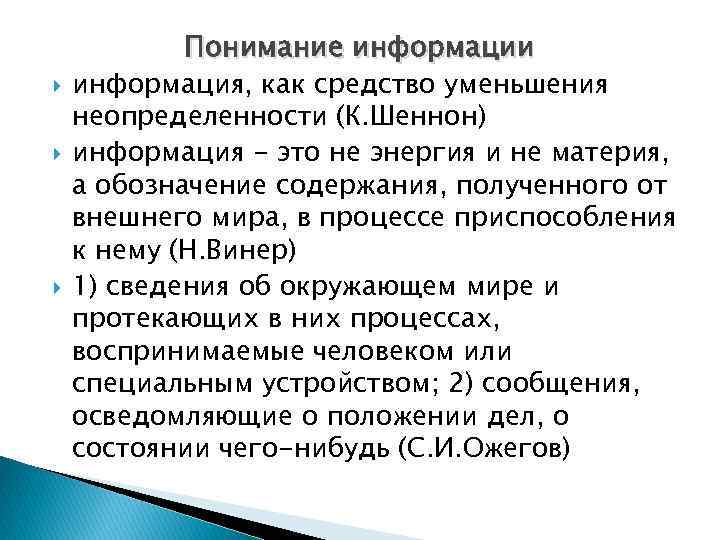

Понимание информации информация, как средство уменьшения неопределенности (К. Шеннон) информация - это не энергия и не материя, а обозначение содержания, полученного от внешнего мира, в процессе приспособления к нему (Н. Винер) 1) сведения об окружающем мире и протекающих в них процессах, воспринимаемые человеком или специальным устройством; 2) сообщения, осведомляющие о положении дел, о состоянии чего-нибудь (С. И. Ожегов)

Понимание информации информация, как средство уменьшения неопределенности (К. Шеннон) информация - это не энергия и не материя, а обозначение содержания, полученного от внешнего мира, в процессе приспособления к нему (Н. Винер) 1) сведения об окружающем мире и протекающих в них процессах, воспринимаемые человеком или специальным устройством; 2) сообщения, осведомляющие о положении дел, о состоянии чего-нибудь (С. И. Ожегов)

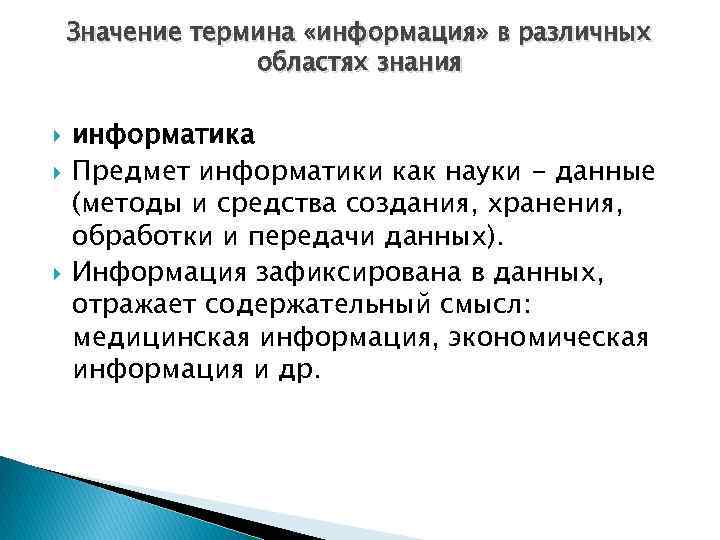

Значение термина «информация» в различных областях знания информатика Предмет информатики как науки - данные (методы и средства создания, хранения, обработки и передачи данных). Информация зафиксирована в данных, отражает содержательный смысл: медицинская информация, экономическая информация и др.

Значение термина «информация» в различных областях знания информатика Предмет информатики как науки - данные (методы и средства создания, хранения, обработки и передачи данных). Информация зафиксирована в данных, отражает содержательный смысл: медицинская информация, экономическая информация и др.

физика Объекты материального мира находятся в состоянии непрерывного изменения, которое характеризуется обменом энергией объекта с окружающей средой. Изменение состояния одного объекта, всегда приводит к изменению состояния, некоторого другого объекта окружающей среды. Это явление, вне зависимости от того, какие именно состояния и каких именно объектов изменились, может рассматриваться, как передача сигнала от одного объекта, другому. Изменение состояния объекта при передаче ему сигнала, называется регистрацией сигнала. Сигнал или последовательность сигналов образуют сообщение, которое может быть воспринято получателем в том или ином виде, а также в том или ином объёме. Информация – обобщение понятий «сигнал» и «сообщение» .

физика Объекты материального мира находятся в состоянии непрерывного изменения, которое характеризуется обменом энергией объекта с окружающей средой. Изменение состояния одного объекта, всегда приводит к изменению состояния, некоторого другого объекта окружающей среды. Это явление, вне зависимости от того, какие именно состояния и каких именно объектов изменились, может рассматриваться, как передача сигнала от одного объекта, другому. Изменение состояния объекта при передаче ему сигнала, называется регистрацией сигнала. Сигнал или последовательность сигналов образуют сообщение, которое может быть воспринято получателем в том или ином виде, а также в том или ином объёме. Информация – обобщение понятий «сигнал» и «сообщение» .

Математика слово «информация» употребляется в математических терминах » собственная информация» и » взаимная информация» статистические функции случайных величин. Связано с энтропией информации (К. Шеннон)

Математика слово «информация» употребляется в математических терминах » собственная информация» и » взаимная информация» статистические функции случайных величин. Связано с энтропией информации (К. Шеннон)

юриспруденция «информация — сведения (сообщения, данные) независимо от формы их представления» . ФЗ от 27 июля 2006 года № 149 -ФЗ «Об информации, информационных технологиях и о защите информации» (Статья 2)

юриспруденция «информация — сведения (сообщения, данные) независимо от формы их представления» . ФЗ от 27 июля 2006 года № 149 -ФЗ «Об информации, информационных технологиях и о защите информации» (Статья 2)

кибернетика В кибернетике (науке об управлении) понятие «информация» связано с процессами управления в сложных системах (в живых организмах или технических устройствах). Жизнедеятельность любого организма или нормальное функционирование технического устройства зависти от процессов управления, благодаря которым поддерживаются в необходимых пределах значения их параметров. Процессы управления включают в себя получение, хранение, преобразование и передачу информации.

кибернетика В кибернетике (науке об управлении) понятие «информация» связано с процессами управления в сложных системах (в живых организмах или технических устройствах). Жизнедеятельность любого организма или нормальное функционирование технического устройства зависти от процессов управления, благодаря которым поддерживаются в необходимых пределах значения их параметров. Процессы управления включают в себя получение, хранение, преобразование и передачу информации.

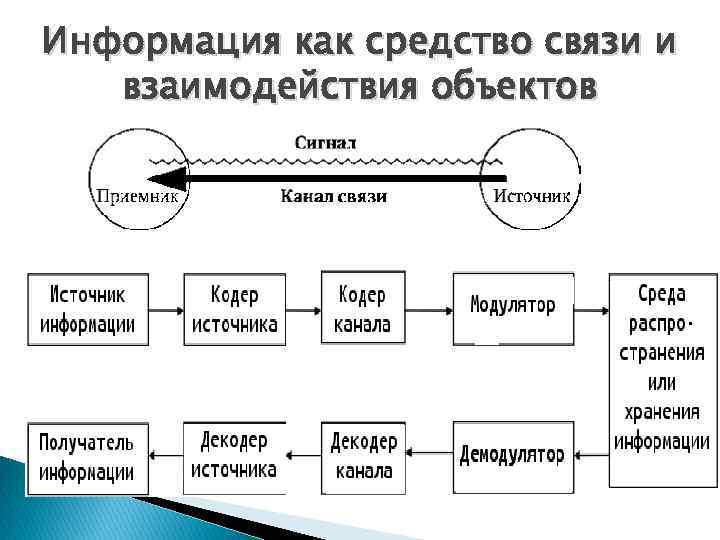

Информация как средство связи и взаимодействия объектов

Информация как средство связи и взаимодействия объектов

Информация как средство связи и взаимодействия объектов Компоненты информационного взаимодействия: 1) физический - для успешного осуществления процесса передачи информации необходимо наличие источника сигнала; 2) сигнальный – например, амплитудно и частотно модулированные акустические колебания; 3) лингвистический (синтаксический) – взаимное понимание источника и приемника (например, знание одного общего языка) 4) семантический – присутствие в передаваемом сообщении содержания (описания объекта или явления), неизвестного получателю информации; 5) прагматический – цель, мотив взаимодействия (например, наличие желания (мотивации) передавать и принимать сообщение)

Информация как средство связи и взаимодействия объектов Компоненты информационного взаимодействия: 1) физический - для успешного осуществления процесса передачи информации необходимо наличие источника сигнала; 2) сигнальный – например, амплитудно и частотно модулированные акустические колебания; 3) лингвистический (синтаксический) – взаимное понимание источника и приемника (например, знание одного общего языка) 4) семантический – присутствие в передаваемом сообщении содержания (описания объекта или явления), неизвестного получателю информации; 5) прагматический – цель, мотив взаимодействия (например, наличие желания (мотивации) передавать и принимать сообщение)

Информация (от лат. Informatio = сведения, разъяснение, ознакомление): любые сведения, данные, сообщения, передаваемые посредством сигналов; уменьшение неопределенности в результате передачи сведений, данных, сообщений (в этом качестве информация противопоставляется энтропии – необратимого рассеяния). характеристика внутренней организованности материальной системы по множеству состояний, которые она может принимать (А. Н. Колмогоров)

Информация (от лат. Informatio = сведения, разъяснение, ознакомление): любые сведения, данные, сообщения, передаваемые посредством сигналов; уменьшение неопределенности в результате передачи сведений, данных, сообщений (в этом качестве информация противопоставляется энтропии – необратимого рассеяния). характеристика внутренней организованности материальной системы по множеству состояний, которые она может принимать (А. Н. Колмогоров)

Подходы к определению информации: традиционный (обыденный) - используется в информатике: Информация – это сведения, знания, сообщения о положении дел, которые человек воспринимает из окружающего мира с помощью органов чувств (зрения, слуха, вкуса, обоняния, осязания). вероятностный - используется в теории информации: Информация – это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределённости и неполноты знаний. Информация - нематериальная сущность, при помощи которой с любой точностью можно описывать реальные (материальные), виртуальные (возможные) и понятийные сущности. Информация - противоположность неопределенности. характеристика объекта, мира – информация существует объективно (вне и независимо от нашего сознания). Информация (наряду с материей и энергией) является субстанцией материального мира. Информация — это «универсальная субстанция, пронизывающая все сферы человеческой деятельности, служащая проводником знаний и мнений, инструментом общения, взаимопонимания и сотрудничества, утверждения стереотипов мышления и поведения» (ЮНЕСКО).

Подходы к определению информации: традиционный (обыденный) - используется в информатике: Информация – это сведения, знания, сообщения о положении дел, которые человек воспринимает из окружающего мира с помощью органов чувств (зрения, слуха, вкуса, обоняния, осязания). вероятностный - используется в теории информации: Информация – это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределённости и неполноты знаний. Информация - нематериальная сущность, при помощи которой с любой точностью можно описывать реальные (материальные), виртуальные (возможные) и понятийные сущности. Информация - противоположность неопределенности. характеристика объекта, мира – информация существует объективно (вне и независимо от нашего сознания). Информация (наряду с материей и энергией) является субстанцией материального мира. Информация — это «универсальная субстанция, пронизывающая все сферы человеческой деятельности, служащая проводником знаний и мнений, инструментом общения, взаимопонимания и сотрудничества, утверждения стереотипов мышления и поведения» (ЮНЕСКО).

Информация – это сведения, являющиеся объектом хранения, передачи и преобразования

Информация – это сведения, являющиеся объектом хранения, передачи и преобразования

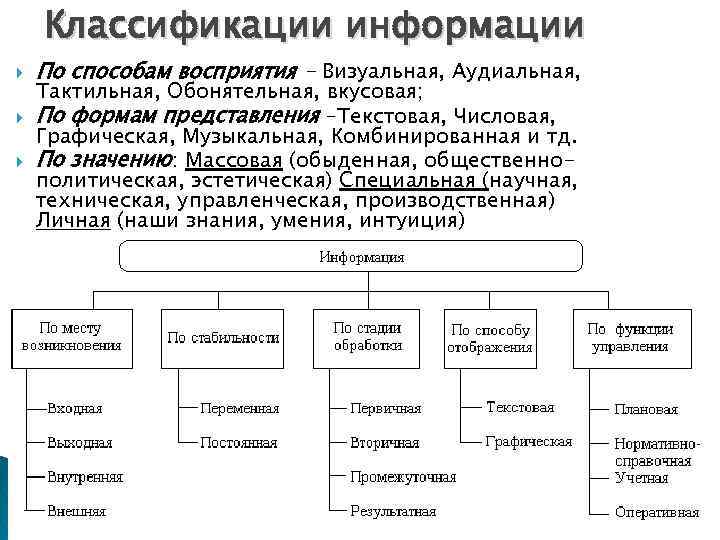

Классификации информации По способам восприятия - Визуальная, Аудиальная, Тактильная, Обонятельная, вкусовая; По формам представления –Текстовая, Числовая, Графическая, Музыкальная, Комбинированная и тд. По значению: Массовая (обыденная, общественнополитическая, эстетическая) Специальная (научная, техническая, управленческая, производственная) Личная (наши знания, умения, интуиция)

Классификации информации По способам восприятия - Визуальная, Аудиальная, Тактильная, Обонятельная, вкусовая; По формам представления –Текстовая, Числовая, Графическая, Музыкальная, Комбинированная и тд. По значению: Массовая (обыденная, общественнополитическая, эстетическая) Специальная (научная, техническая, управленческая, производственная) Личная (наши знания, умения, интуиция)

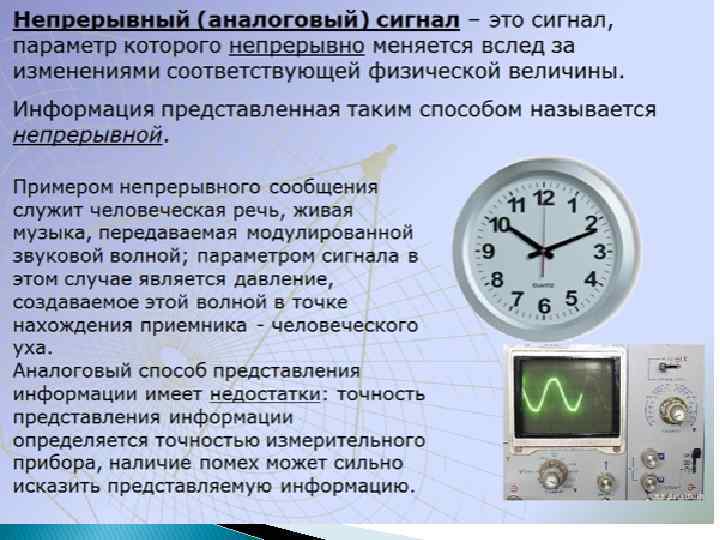

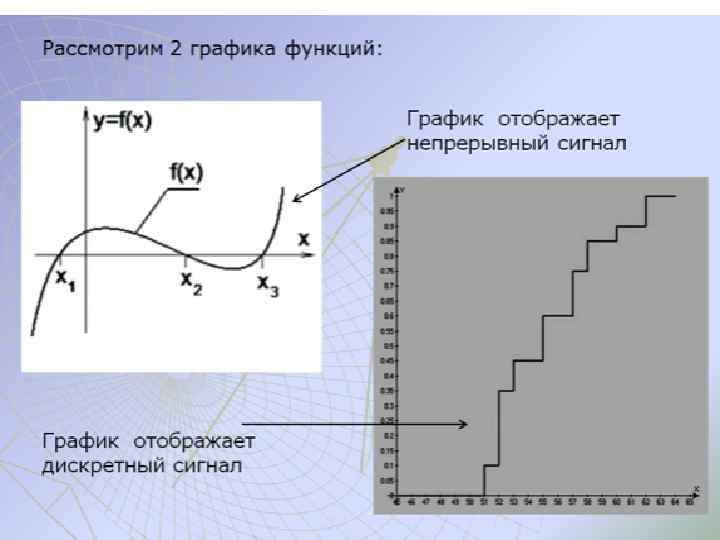

По непрерывности сигнала

По непрерывности сигнала

Основные свойства информации: Объективность – не зависит от чего-либо мнения Достоверность – отражает истинное положение дел Полнота – достаточна для понимания и принятия решения Актуальность – важна и существенна для настоящего времени Ценность (полезность, значимость)- обеспечивает решение поставленной задачи, нужна для того чтобы принимать правильные решения Понятность (ясность)– выражена на языке, доступном получателю Атрибутивные свойства (дискретность (информация состоит из отдельных частей, знаков) и непрерывность (возможность накапливать информацию) Динамические свойства связаны с изменением информации во времени: - копирование – размножение информации - передача от источника к потребителю - перевод с одного языка на другой - перенос на другой носитель - старение (физическое – носителя, моральное – ценностное) Практические свойства - информационный объем и плотность

Основные свойства информации: Объективность – не зависит от чего-либо мнения Достоверность – отражает истинное положение дел Полнота – достаточна для понимания и принятия решения Актуальность – важна и существенна для настоящего времени Ценность (полезность, значимость)- обеспечивает решение поставленной задачи, нужна для того чтобы принимать правильные решения Понятность (ясность)– выражена на языке, доступном получателю Атрибутивные свойства (дискретность (информация состоит из отдельных частей, знаков) и непрерывность (возможность накапливать информацию) Динамические свойства связаны с изменением информации во времени: - копирование – размножение информации - передача от источника к потребителю - перевод с одного языка на другой - перенос на другой носитель - старение (физическое – носителя, моральное – ценностное) Практические свойства - информационный объем и плотность

3. Теория информации как научная дисциплина

3. Теория информации как научная дисциплина

Теория информации — раздел прикладной математики (математическая теория связи) , радиотехники (теория обработки сигналов) и информатики, определяющий понятие информации, её свойства и количество, и устанавливающий предельные соотношения для систем передачи данных.

Теория информации — раздел прикладной математики (математическая теория связи) , радиотехники (теория обработки сигналов) и информатики, определяющий понятие информации, её свойства и количество, и устанавливающий предельные соотношения для систем передачи данных.

Содержание теории информации: 1) анализ сигналов, как средства передачи информации; 2) анализ информационных характеристик источников сообщения и каналов связи; 3) теория кодирования; 4) методы приема и обработки информации.

Содержание теории информации: 1) анализ сигналов, как средства передачи информации; 2) анализ информационных характеристик источников сообщения и каналов связи; 3) теория кодирования; 4) методы приема и обработки информации.

Основные разделы теории информации: кодирование источника (сжимающее кодирование) канальное (помехоустойчивое) кодирование.

Основные разделы теории информации: кодирование источника (сжимающее кодирование) канальное (помехоустойчивое) кодирование.

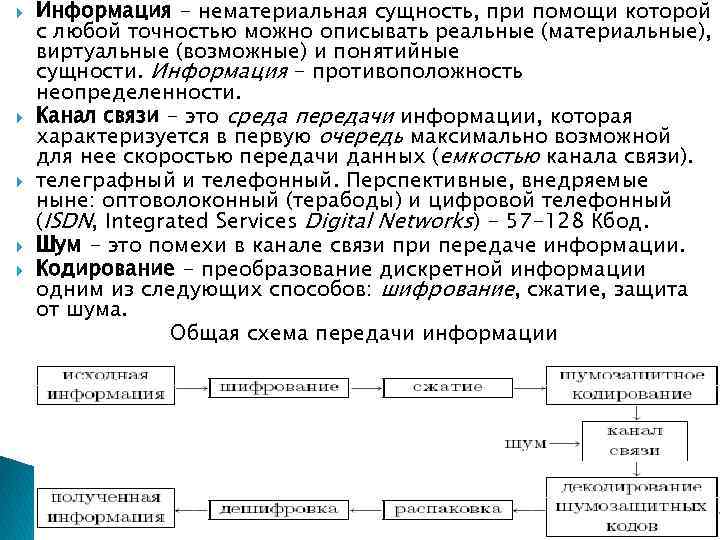

Информация - нематериальная сущность, при помощи которой с любой точностью можно описывать реальные (материальные), виртуальные (возможные) и понятийные сущности. Информация - противоположность неопределенности. Канал связи - это среда передачи информации, которая характеризуется в первую очередь максимально возможной для нее скоростью передачи данных (емкостью канала связи). телеграфный и телефонный. Перспективные, внедряемые ныне: оптоволоконный (терабоды) и цифровой телефонный (ISDN, Integrated Services Digital Networks) - 57 -128 Кбод. Шум - это помехи в канале связи при передаче информации. Кодирование - преобразование дискретной информации одним из следующих способов: шифрование, сжатие, защита от шума. Общая схема передачи информации

Информация - нематериальная сущность, при помощи которой с любой точностью можно описывать реальные (материальные), виртуальные (возможные) и понятийные сущности. Информация - противоположность неопределенности. Канал связи - это среда передачи информации, которая характеризуется в первую очередь максимально возможной для нее скоростью передачи данных (емкостью канала связи). телеграфный и телефонный. Перспективные, внедряемые ныне: оптоволоконный (терабоды) и цифровой телефонный (ISDN, Integrated Services Digital Networks) - 57 -128 Кбод. Шум - это помехи в канале связи при передаче информации. Кодирование - преобразование дискретной информации одним из следующих способов: шифрование, сжатие, защита от шума. Общая схема передачи информации

4 Количество информации

4 Количество информации

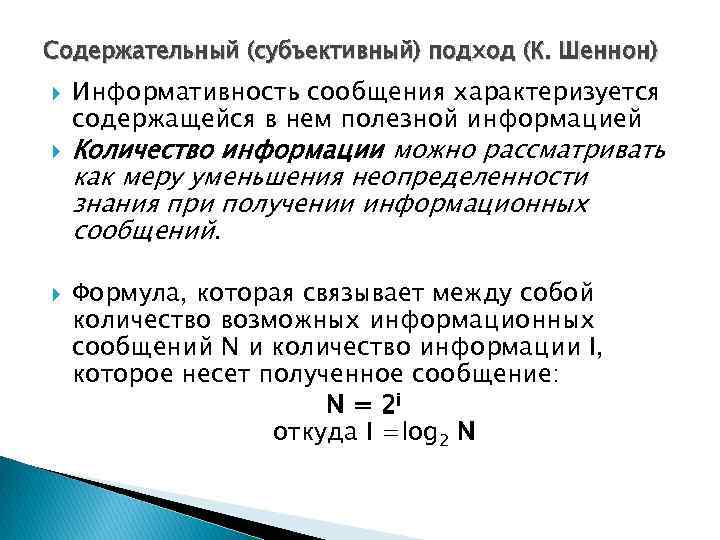

Содержательный (субъективный) подход (К. Шеннон) Информативность сообщения характеризуется содержащейся в нем полезной информацией Количество информации можно рассматривать как меру уменьшения неопределенности знания при получении информационных сообщений. Формула, которая связывает между собой количество возможных информационных сообщений N и количество информации I, которое несет полученное сообщение: N = 2 i откуда I =log 2 N

Содержательный (субъективный) подход (К. Шеннон) Информативность сообщения характеризуется содержащейся в нем полезной информацией Количество информации можно рассматривать как меру уменьшения неопределенности знания при получении информационных сообщений. Формула, которая связывает между собой количество возможных информационных сообщений N и количество информации I, которое несет полученное сообщение: N = 2 i откуда I =log 2 N

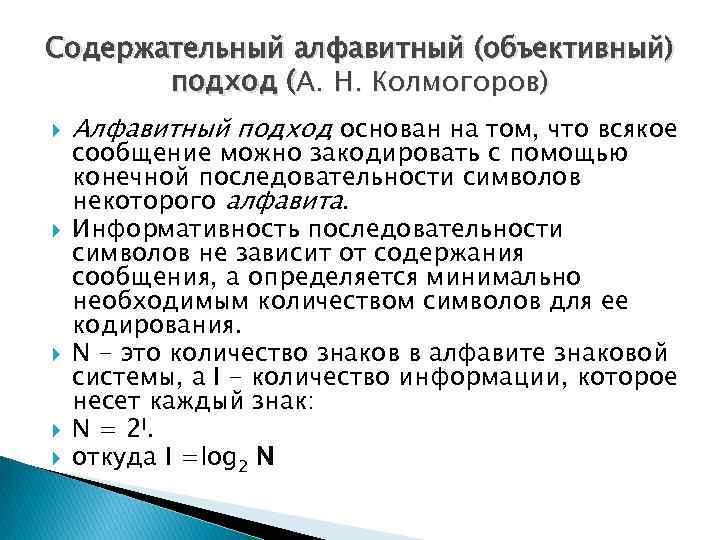

Содержательный алфавитный (объективный) подход (А. Н. Колмогоров) Алфавитный подход основан на том, что всякое сообщение можно закодировать с помощью конечной последовательности символов некоторого алфавита. Информативность последовательности символов не зависит от содержания сообщения, а определяется минимально необходимым количеством символов для ее кодирования. N - это количество знаков в алфавите знаковой системы, а I - количество информации, которое несет каждый знак: N = 2 I. откуда I =log 2 N

Содержательный алфавитный (объективный) подход (А. Н. Колмогоров) Алфавитный подход основан на том, что всякое сообщение можно закодировать с помощью конечной последовательности символов некоторого алфавита. Информативность последовательности символов не зависит от содержания сообщения, а определяется минимально необходимым количеством символов для ее кодирования. N - это количество знаков в алфавите знаковой системы, а I - количество информации, которое несет каждый знак: N = 2 I. откуда I =log 2 N

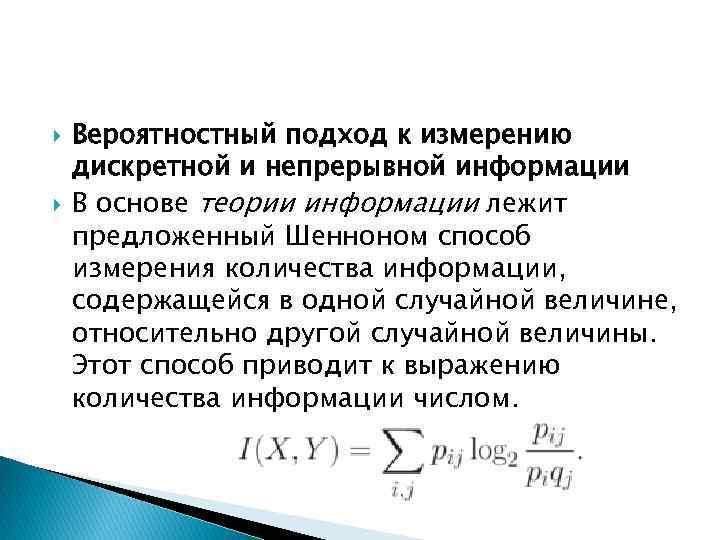

Вероятностный подход к измерению дискретной и непрерывной информации В основе теории информации лежит предложенный Шенноном способ измерения количества информации, содержащейся в одной случайной величине, относительно другой случайной величины. Этот способ приводит к выражению количества информации числом.

Вероятностный подход к измерению дискретной и непрерывной информации В основе теории информации лежит предложенный Шенноном способ измерения количества информации, содержащейся в одной случайной величине, относительно другой случайной величины. Этот способ приводит к выражению количества информации числом.

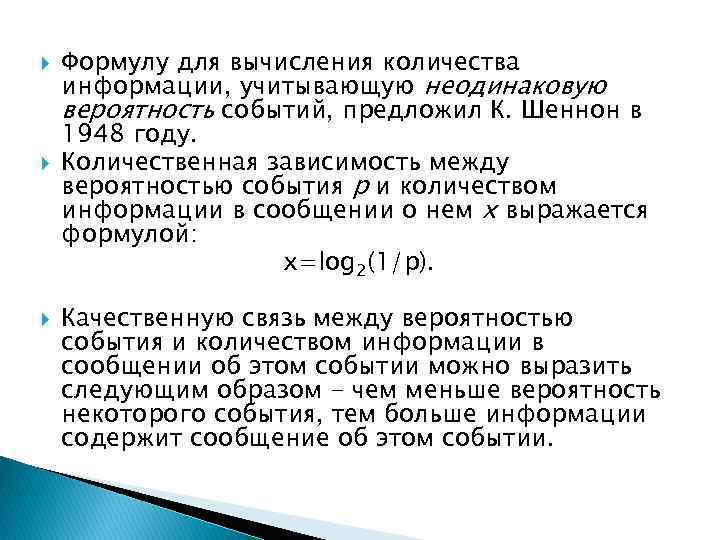

Формулу для вычисления количества информации, учитывающую неодинаковую вероятность событий, предложил К. Шеннон в 1948 году. Количественная зависимость между вероятностью события р и количеством информации в сообщении о нем x выражается формулой: x=log 2(1/p). Качественную связь между вероятностью события и количеством информации в сообщении об этом событии можно выразить следующим образом - чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

Формулу для вычисления количества информации, учитывающую неодинаковую вероятность событий, предложил К. Шеннон в 1948 году. Количественная зависимость между вероятностью события р и количеством информации в сообщении о нем x выражается формулой: x=log 2(1/p). Качественную связь между вероятностью события и количеством информации в сообщении об этом событии можно выразить следующим образом - чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

За единицу количества информации принимается такое количество информации, которое содержится в информационном сообщении, уменьшающем неопределенность знания в два раза. Такая единица названа битом. Производные единицы измерения количества информации. 1 байт = 8 битов = 23 битов. 1 килобайт (Кбайт) = 210 байт = 1024 байт; 1 мегабайт (Мбайт) = 210 Кбайт = 1024 Кбайт; 1 гигабайт (Гбайт) = 210 Мбайт = 1024 Мбайт.

За единицу количества информации принимается такое количество информации, которое содержится в информационном сообщении, уменьшающем неопределенность знания в два раза. Такая единица названа битом. Производные единицы измерения количества информации. 1 байт = 8 битов = 23 битов. 1 килобайт (Кбайт) = 210 байт = 1024 байт; 1 мегабайт (Мбайт) = 210 Кбайт = 1024 Кбайт; 1 гигабайт (Гбайт) = 210 Мбайт = 1024 Мбайт.

5. Дискретная и аналоговая информация

5. Дискретная и аналоговая информация

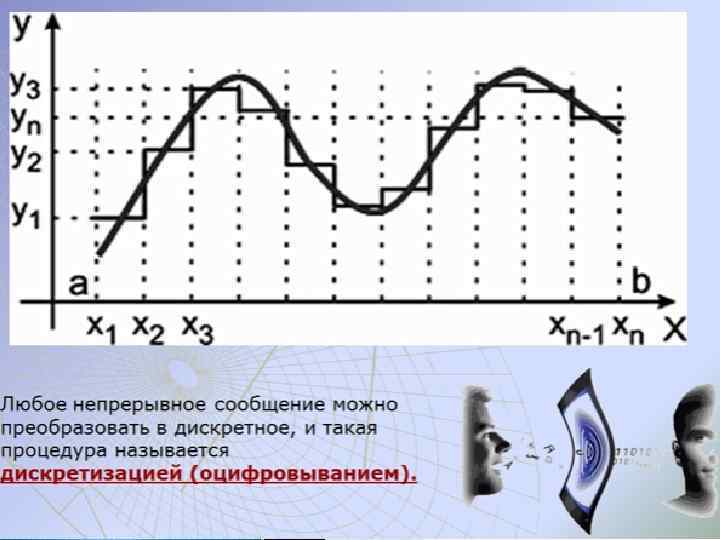

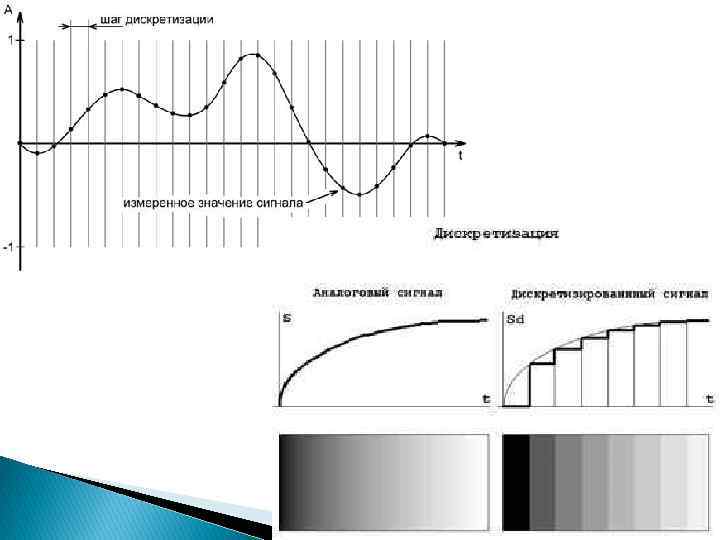

Дискретизация (от лат. discretio — «различать» , «распознавать» ) — преобразование непрерывной функции в дискретную. Дискретизация (квантование по уровню) преобразование непрерывного информационного множества аналоговых сигналов в дискретное множество. Квантова ние (англ. quantization) — в информатике — разбиение диапазона значений непрерывной или дискретной величины на конечное число интервалов.

Дискретизация (от лат. discretio — «различать» , «распознавать» ) — преобразование непрерывной функции в дискретную. Дискретизация (квантование по уровню) преобразование непрерывного информационного множества аналоговых сигналов в дискретное множество. Квантова ние (англ. quantization) — в информатике — разбиение диапазона значений непрерывной или дискретной величины на конечное число интервалов.

Теоре ма Коте льникова (в англоязычной литературе - теорема Найквиста — Шеннона, теорема отсчётов) — фундаментальное утверждение в области цифровой обработки сигналов, связывает непрерывные и дискретные сигналы. Теорема: любую функцию F(t), состоящую из частот от 0 до f 1, можно непрерывно передавать с любой точностью при помощи чисел, следующих друг за другом через 1/(2 f 1) секунд.

Теоре ма Коте льникова (в англоязычной литературе - теорема Найквиста — Шеннона, теорема отсчётов) — фундаментальное утверждение в области цифровой обработки сигналов, связывает непрерывные и дискретные сигналы. Теорема: любую функцию F(t), состоящую из частот от 0 до f 1, можно непрерывно передавать с любой точностью при помощи чисел, следующих друг за другом через 1/(2 f 1) секунд.

Следствия из теоремы Котельникова: любой аналоговый сигнал может быть восстановлен с какой угодно точностью по своим дискретным отсчётам, взятым с частотой f>2 fc, где fc — максимальная частота, которой ограничен спектр реального сигнала; если максимальная частота в сигнале равна или превышает половину частоты дискретизации (наложение спектра), то способа восстановить сигнал из дискретного в аналоговый без искажений не существует

Следствия из теоремы Котельникова: любой аналоговый сигнал может быть восстановлен с какой угодно точностью по своим дискретным отсчётам, взятым с частотой f>2 fc, где fc — максимальная частота, которой ограничен спектр реального сигнала; если максимальная частота в сигнале равна или превышает половину частоты дискретизации (наложение спектра), то способа восстановить сигнал из дискретного в аналоговый без искажений не существует