Informatika__1semestr_chast1.ppt

- Количество слайдов: 100

Лекции по информатике Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

представляет Сергей Борисович Луковкин, к. филос. н. , доцент кафедры «Автоматика и вычислительная техника» МГТУ 2008 г. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 2

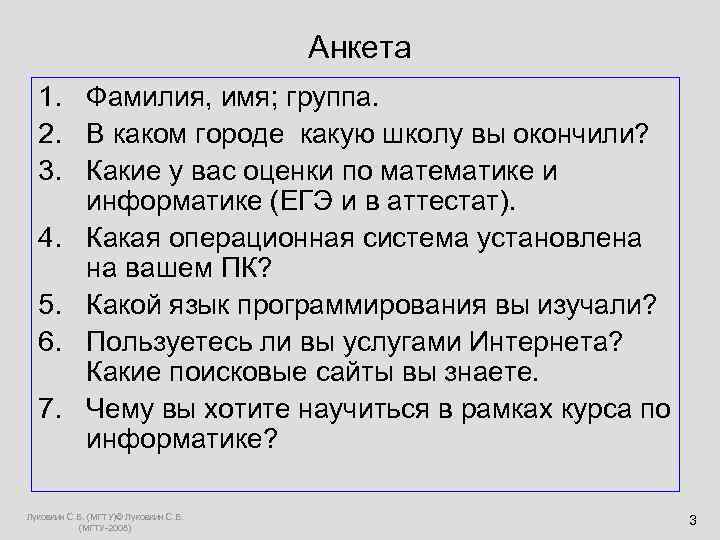

Анкета 1. Фамилия, имя; группа. 2. В каком городе какую школу вы окончили? 3. Какие у вас оценки по математике и информатике (ЕГЭ и в аттестат). 4. Какая операционная система установлена на вашем ПК? 5. Какой язык программирования вы изучали? 6. Пользуетесь ли вы услугами Интернета? Какие поисковые сайты вы знаете. 7. Чему вы хотите научиться в рамках курса по информатике? Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 3

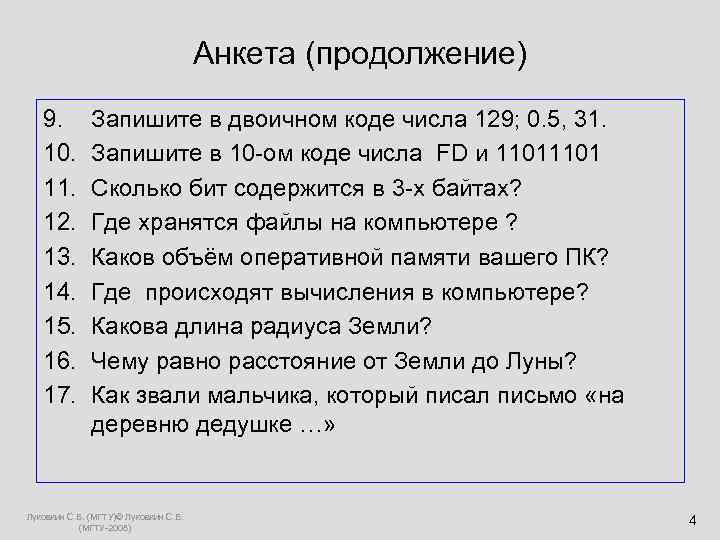

Анкета (продолжение) 9. Запишите в двоичном коде числа 129; 0. 5, 31. 10. Запишите в 10 -ом коде числа FD и 1101 11. Сколько бит содержится в 3 -х байтах? 12. Где хранятся файлы на компьютере ? 13. Каков объём оперативной памяти вашего ПК? 14. Где происходят вычисления в компьютере? 15. Какова длина радиуса Земли? 16. Чему равно расстояние от Земли до Луны? 17. Как звали мальчика, который писал письмо «на деревню дедушке …» Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 4

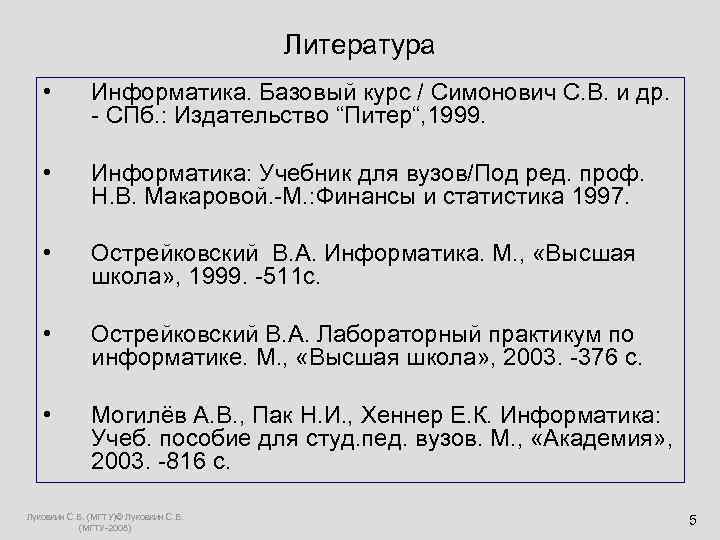

Литература • Информатика. Базовый курс / Симонович С. В. и др. - СПб. : Издательство “Питер“, 1999. • Информатика: Учебник для вузов/Под ред. проф. Н. В. Макаровой. -М. : Финансы и статистика 1997. • Острейковский В. А. Информатика. М. , «Высшая школа» , 1999. -511 с. • Острейковский В. А. Лабораторный практикум по информатике. М. , «Высшая школа» , 2003. -376 с. • Могилёв А. В. , Пак Н. И. , Хеннер Е. К. Информатика: Учеб. пособие для студ. пед. вузов. М. , «Академия» , 2003. -816 с. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 5

Литература (продолжение) • Сетевые технологии. Соловьёва Л. Ф. СПб. : «БХВ- Петербург» , 2004. • Паскаль. Павловская Т. А. СПб, «Питер» , 2007. • Turbo Pascal 7. 0 Начальный курс. Учебное пособие. Фаронов В. В. М. : «Высшая школа» . 2001. • Луковкин С. Б. Теоретические основы информатики. Учебное пособие для студенов МГТУ. - Издательсво МГТУ, Мурманск. 2009 г. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 6

Лекция 1. Основные понятия: Информация, данные, информатика, информационные технологии. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 7

Коэволюция технологий формирования, распространения, воплощения знаний и общества Развитие общества определяют два процесса: - Создание новых знаний - Применение новых знаний (повышение качества продуктов труда) Одна эпоха, отличается от другой, технологиями создания, распространения и применения новых знаний (не зависимо от типа экономики или политической системы) Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 8

Эволюция технологий распространения знаний Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

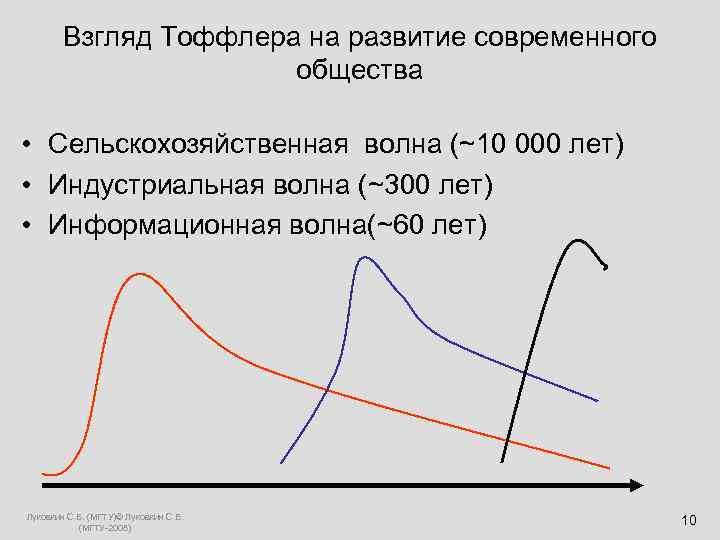

Взгляд Тоффлера на развитие современного общества • Сельскохозяйственная волна (~10 000 лет) • Индустриальная волна (~300 лет) • Информационная волна(~60 лет) Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 10

Стратегии развития ХХ - ХХI Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

Информация (1) • Нет общепринятого определения информации. • В повседневной жизни информация - это разъяснение, сообщение, изложение, какие-либо сведения, данные, объявление. • В обычном, «житейском» смысле - информация это сумма сведений, которую получает некоторый субъект, человек, группа людей или животных , об окружающем мире, о самом себе, о другом субъекте или изучаемом явлении. Используя эти сведения человек может прогнозировать результаты своих действий, выбирать различные способы для достижения поставленных целей. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 12

Информация (2) • Определение СЭС: 1) информация – это сведения, передаваемые людьми устным, письменным или как-либо другим способом ( с помощью условных знаков, сигналов, технических средств и т. д. ) ; 2) с середины ХХ века информация – это обмен сведениями между людьми, человеком и автоматом, автоматом и автоматом, обмен сигналами в живом и растительном мире, передача признаков от клетки к клетке, от организма к организму. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 13

Информация(3) • Информация – сведения, уменьшающие неопределённость нашего знания об окружающем нас мире, которые являются объектом хранения, преобразования, передачи и использования. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 14

Менее удачные определения данных: • Данные - это информация, представленная в виде, позволяющем запоминать, хранить, передавать или обрабатывать её с помощью технических средств. • Данные – это информация об объекте или отношениях объектов, выраженная в знаковой форме. (circulus vitiosus ) Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 15

Как возникает(генерируется) информация? • Определение Генри Кастлера: • Информация – случайный и запомненный выбор одного из нескольких возможных и равноправных вариантов. • Если выбор не случаен, то мы имеем дело с рецепцией информации. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 16

Данные. 1. Данные - это зарегистрированные сигналы. 2. Сигнал – изменяющийся во времени физический процесс. Это условный знак, физ. процесс или явление, несущие сообщение о каком либо событии, состоянии объекта и режиме его работы или передающие команды управления, оповещения. Примеры: Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 17

Связь данных и информации. • Понятия «данные» и «информация» близки, но не тождественны. • Любые данные несут какую-то информацию • Любая информация должна быть представлена в виде данных. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 18

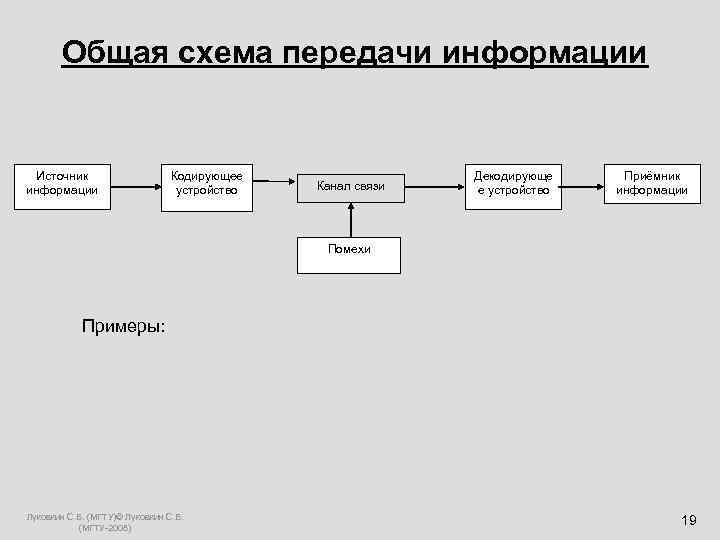

Общая схема передачи информации Источник Кодирующее Декодирующе Приёмник информации устройство Канал связи е устройство информации Помехи Примеры: Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 19

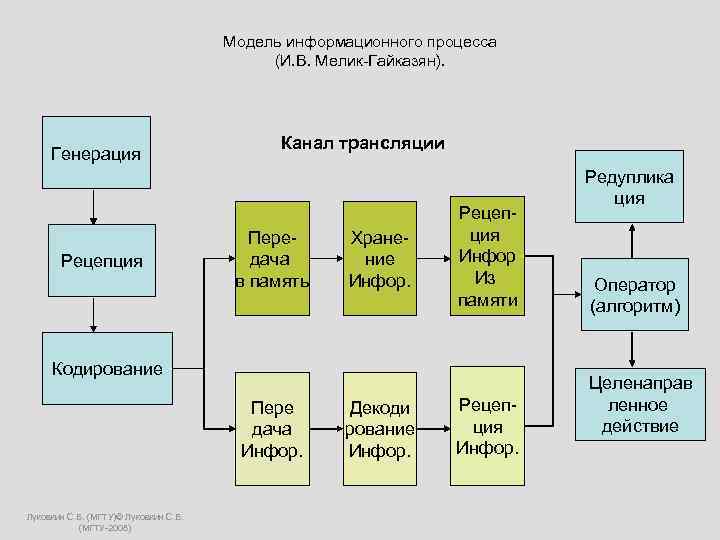

Модель информационного процесса (И. В. Мелик-Гайказян). Канал трансляции Генерация Редуплика ция Рецеп- Пере- Хране- ция Рецепция дача ние Инфор в память Инфор. Из Оператор памяти (алгоритм) Кодирование Целенаправ Пере Декоди Рецеп- ленное дача рование ция действие Инфор. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

Информация - • Это необратимый процесс в многомерном, нелинейном мире. • Генерация необратима • Рецепция необратима Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 21

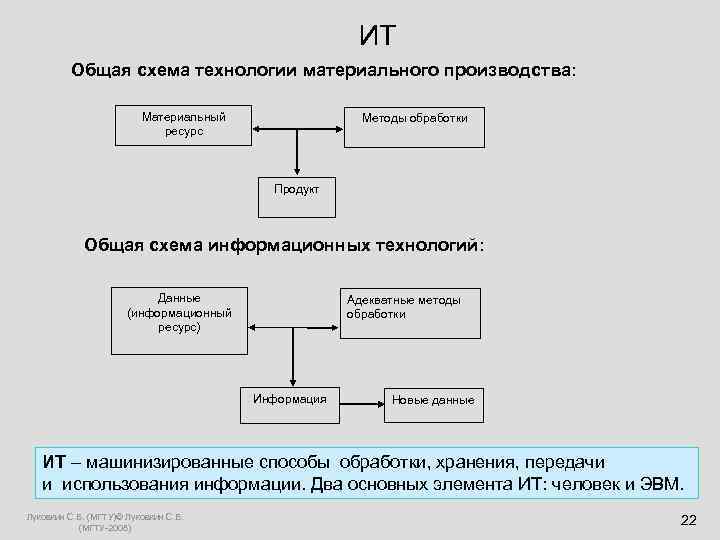

ИТ Общая схема технологии материального производства: Материальный Методы обработки ресурс Продукт Общая схема информационных технологий: Данные Адекватные методы (информационный обработки ресурс) Информация Новые данные ИТ – машинизированные способы обработки, хранения, передачи и использования информации. Два основных элемента ИТ: человек и ЭВМ. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 22

Свойства информации: 1. Информация невоспроизводима. 2. Информация эмерджентна (от английского “emergency”). 3. Информация операциональна (информация побуждает к действию). Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 23

Свойства информации(Мелик-Гайказян) • Фиксируемость инвариантность, бренность( недолговечность), изменчивость (мутации), транслируемость ( с одного носителя на другой); • Действенность ( используется для достижения цели) семантика, полипотентность; полезность; истинность; Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 24

Свойства информации (1): 4. Объективность 5. Полнота 6. Достоверность 7. Адекватность 8. Доступность 9. Актуальность 10. Коммерческая ценность Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 25

Информатика • Термин информатика (Informatik)впервые был предложен в 1957 немецким инженером Штейнбухом. С 1962 термин стал использоваться во французском и английском языках. • в 1963 г. в журнале «Известия вузов» была опубликована статья Ф. Е. Темникова «Информатика» • - наука об информации, состоящая из трёх разделов: теории информационных элементов, теории информационных систем и теории информационных процессов. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 26

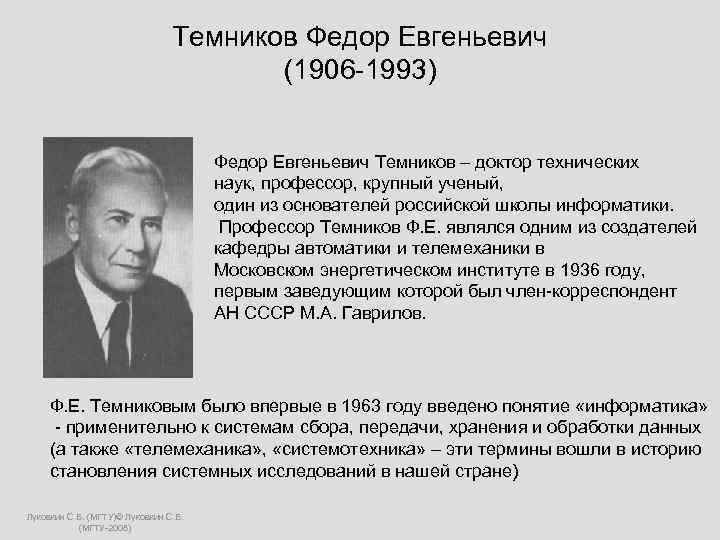

Темников Федор Евгеньевич (1906 -1993) Федор Евгеньевич Темников – доктор технических наук, профессор, крупный ученый, один из основателей российской школы информатики. Профессор Темников Ф. Е. являлся одним из создателей кафедры автоматики и телемеханики в Московском энергетическом институте в 1936 году, первым заведующим которой был член-корреспондент АН СССР М. А. Гаврилов. Ф. Е. Темниковым было впервые в 1963 году введено понятие «информатика» - применительно к системам сбора, передачи, хранения и обработки данных (а также «телемеханика» , «системотехника» – эти термины вошли в историю становления системных исследований в нашей стране) Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

Информатика (1) • устоялось французское толкование термина «informatique» , которым обозначили науку об электронно вычислительных машинах (ЭВМ) и их применении. • США вместо термина информатика используют термин «computer science» . Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 28

Информатика (2) • Информатика – наука, изучающая структуру и общие свойства информации, а также вопросы связанные с её сбором, хранением, поиском, преобразованием, распространением, использованием в различных сферах человеческой деятельности. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 29

Информатика (3) • Д. С. Чернавский даёт следующее определение информатики: «Информатика - наука о процессах передачи, возникновения, рецепции, хранения и обработки информации» • Выделяет три направления: техническое, прикладное, теоретическое Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 30

Лекция 2. Количество информации: формула Хартли, формула Шеннона. Задачи. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 31

История вопроса. • Р. Хартли в 1928, а затем К. Шеннон в 1948 предложили формулы для вычисления количества информации, однако на вопрос о том, что такое информация они так и не ответили. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 32

Ральф Хартли Клод Шеннон • Клод Шеннон, американский инженер (1888 – 1970) • и математика (1916 – 2001). Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 33

Как Хартли понимал «информацию» • Р. Хартли считал, что информация, которую он собирался измерять это «… групп физических символов – слов, точек, тире и т. п. , имеющих по общему соглашению известный смысл для корреспондирующих сторон» . Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 34

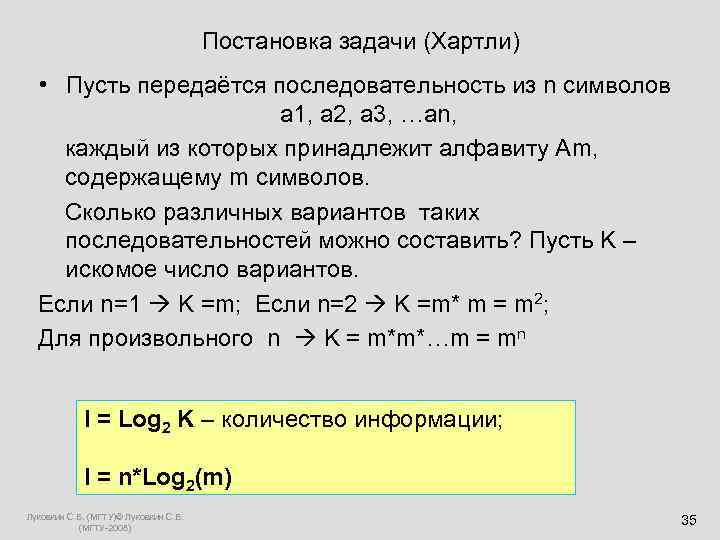

Постановка задачи (Хартли) • Пусть передаётся последовательность из n символов а 1, а 2, а 3, …аn, каждый из которых принадлежит алфавиту Аm, содержащему m символов. Сколько различных вариантов таких последовательностей можно составить? Пусть K – искомое число вариантов. Если n=1 K =m; Если n=2 K =m* m = m 2; Для произвольного n K = m*m*…m = mn I = Log 2 K – количество информации; I = n*Log 2(m) Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 35

Энтропия • Формула внешне напоминает формулу Больцмана для вычисления энтропии системы с N равновероятными микросостояниями: S= - k*Ln(W), • где k - постоянная Больцмана = 1, 38*10 -23; • W=1/ N вероятность спонтанного принятия одного из микросостояний системы в единицу времени t = 10 -13 сек. Информационная энтропия - это мера неопределённости состояния некоторой случайной величины (физической системы) с конечным или счётным числом состояний. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 36

Людвиг Больцман Ludwig Eduard Boltzmann 20 февраля 1844 – 5 сентября 1906 Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

формула Хартли Пусть X – случайная величина, которая может принимать N различных значений x 1, x 2, … x. N ; если все значения с. в. X равновероятны, то энтропия ( мера неопределённости) сл. величины X равна: H(X) = Log 2 N. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 38

Что такое 1 бит ? • 1 бит - это энтропия системы с двумя равновероятными состояниями. • Пусть система X может находиться в двух равновероятных состояниях x 1 и x 2, т. е. N = 2; тогда её энтропия H(X) = Log 2 2 = 1 бит. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 39

Ещё одно определение 1 бита: • Ответ на вопрос любой природы содержит 1 бит информации, если он с равной вероятностью может быть «да» или «нет» . • Пример. Игра в «пусто-густо» . Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 40

Задачи на формулу Хартли: • Правило: Если в заданном множестве M, состоящем из N элементов, выделен некоторый элемент x, о котором ничего более не известно, то для определения этого элемента необходимо получить Log 2 N бит информации. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 41

Задача 1: «Угадать задуманное число» • Некто задумал натуральное число в диапазоне от 1 до 32. Какое минимальное число вопросов надо задать, чтобы гарантированно угадать задуманное (выделенное) число. Ответы могут быть только «да» или «нет» . Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 42

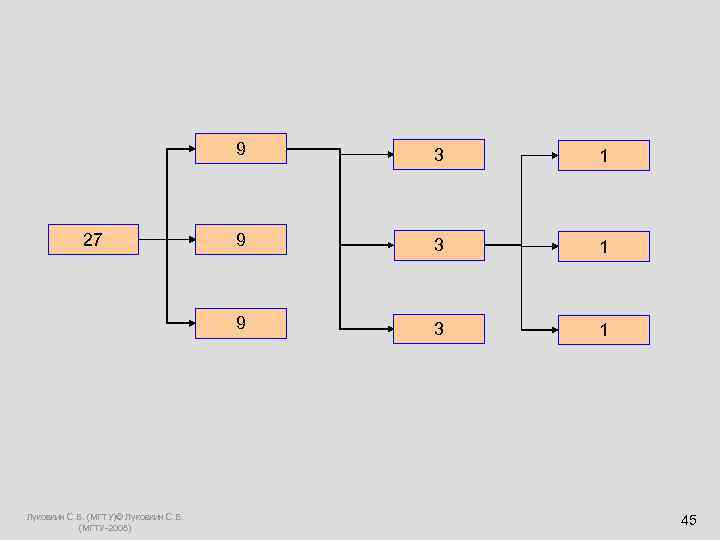

Задача 2: «о фальшивой монете» • Имеется 27 монет, из которых 26 настоящих и одна фальшивая. Определите минимальное число взвешиваний на рычажных весах, за которое можно гарантированно определить одну фальшивую монету из 27. Известно, что фальшивая монета легче настоящей. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 43

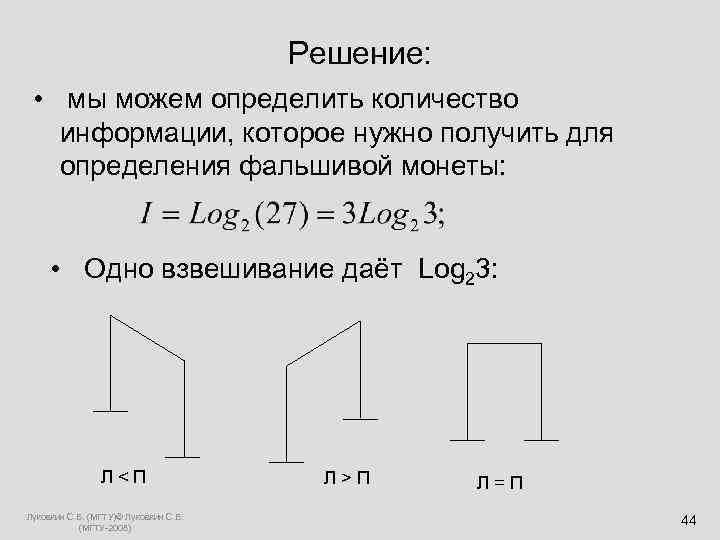

Решение: • мы можем определить количество информации, которое нужно получить для определения фальшивой монеты: • Одно взвешивание даёт Log 23: Л < П Л > П Л = П Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 44

9 3 1 27 9 3 1 Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 45

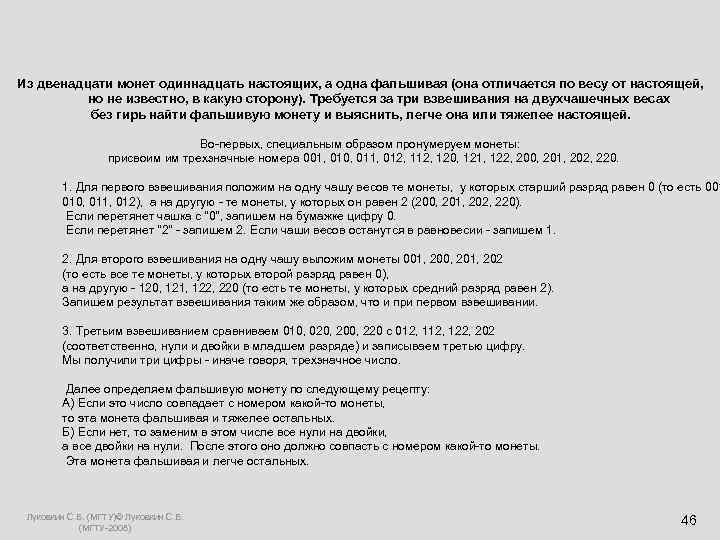

Из двенадцати монет одиннадцать настоящих, а одна фальшивая (она отличается по весу от настоящей, но не известно, в какую сторону). Требуется за три взвешивания на двухчашечных весах без гирь найти фальшивую монету и выяснить, легче она или тяжелее настоящей. Во-первых, специальным образом пронумеруем монеты: присвоим им трехзначные номера 001, 010, 011, 012, 120, 121, 122, 200, 201, 202, 220. 1. Для первого взвешивания положим на одну чашу весов те монеты, у которых старший разряд равен 0 (то есть 001 010, 011, 012), а на другую - те монеты, у которых он равен 2 (200, 201, 202, 220). Если перетянет чашка с "0", запишем на бумажке цифру 0. Если перетянет "2" - запишем 2. Если чаши весов останутся в равновесии - запишем 1. 2. Для второго взвешивания на одну чашу выложим монеты 001, 200, 201, 202 (то есть все те монеты, у которых второй разряд равен 0), а на другую - 120, 121, 122, 220 (то есть те монеты, у которых средний разряд равен 2). Запишем результат взвешивания таким же образом, что и при первом взвешивании. 3. Третьим взвешиванием сравниваем 010, 020, 200, 220 с 012, 122, 202 (соответственно, нули и двойки в младшем разряде) и записываем третью цифру. Мы получили три цифры - иначе говоря, трехзначное число. Далее определяем фальшивую монету по следующему рецепту: А) Если это число совпадает с номером какой-то монеты, то эта монета фальшивая и тяжелее остальных. Б) Если нет, то заменим в этом числе все нули на двойки, а все двойки на нули. После этого оно должно совпасть с номером какой-то монеты. Эта монета фальшивая и легче остальных. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 46

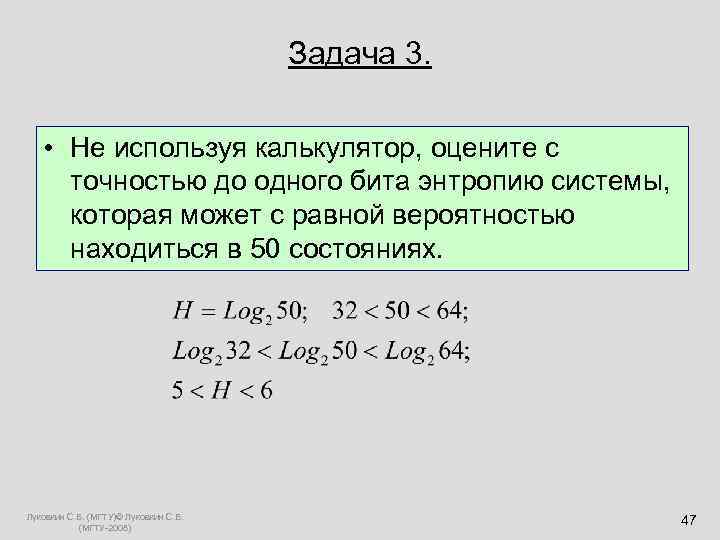

Задача 3. • Не используя калькулятор, оцените с точностью до одного бита энтропию системы, которая может с равной вероятностью находиться в 50 состояниях. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 47

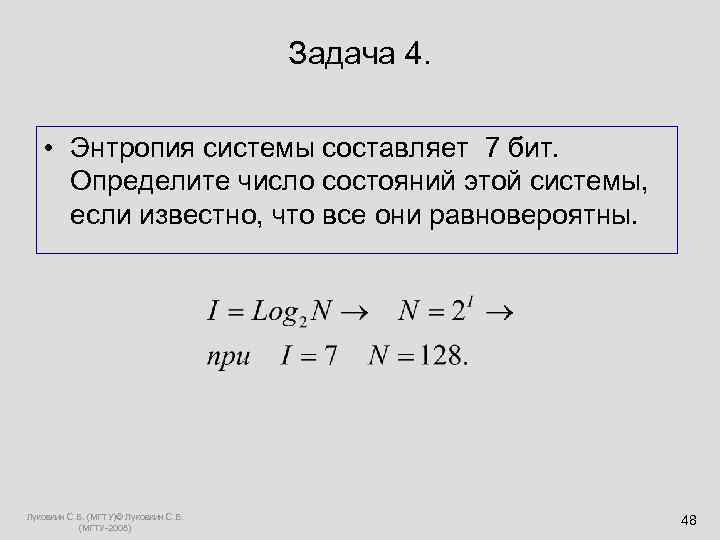

Задача 4. • Энтропия системы составляет 7 бит. Определите число состояний этой системы, если известно, что все они равновероятны. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 48

Количество информации. Формула Шеннона Задача, которую ставил перед собой К. Шеннон, заключалась в том, чтобы определить систему кодирования, позволяющую оптимизировать скорость и достоверность передачи информации. Основные понятия ТВ Опыт; Случайное событие A; вероятность p(A); достоверное событие = Ω; p(Ω) =1; невозможное событие = Ø; p(Ø) =0; для всех остальных событий 0< p(A) <1; Если события A 1 , A 2 … An попарно несовместны и образуют полную группу, то p 1+p 2+ … pn =1. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 49

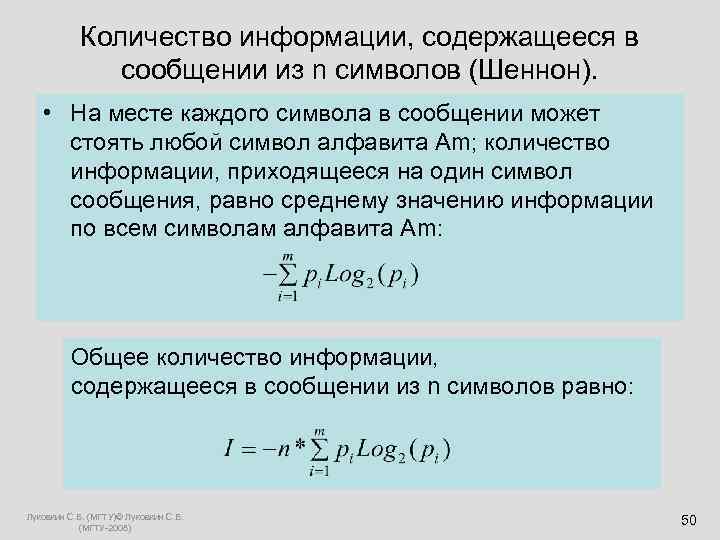

Количество информации, содержащееся в сообщении из n символов (Шеннон). • На месте каждого символа в сообщении может стоять любой символ алфавита Am; количество информации, приходящееся на один символ сообщения, равно среднему значению информации по всем символам алфавита Am: Общее количество информации, содержащееся в сообщении из n символов равно: Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 50

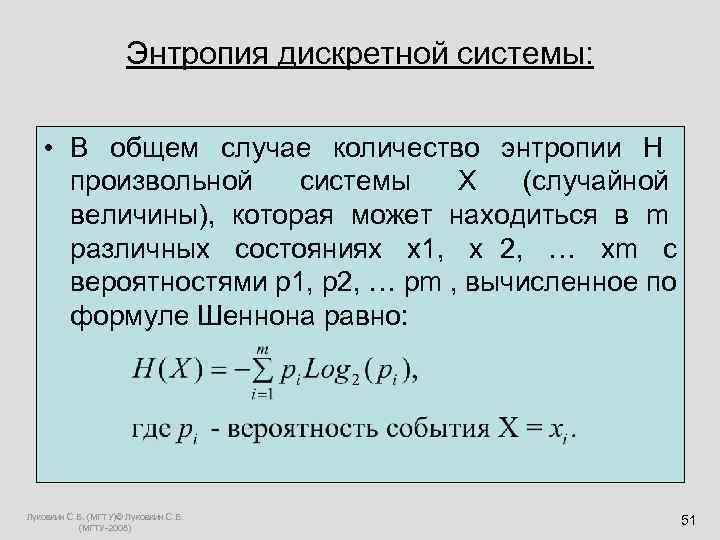

Энтропия дискретной системы: • В общем случае количество энтропии H произвольной системы X (случайной величины), которая может находиться в m различных состояниях x 1, x 2, … xm c вероятностями p 1, p 2, … pm , вычисленное по формуле Шеннона равно: Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 51

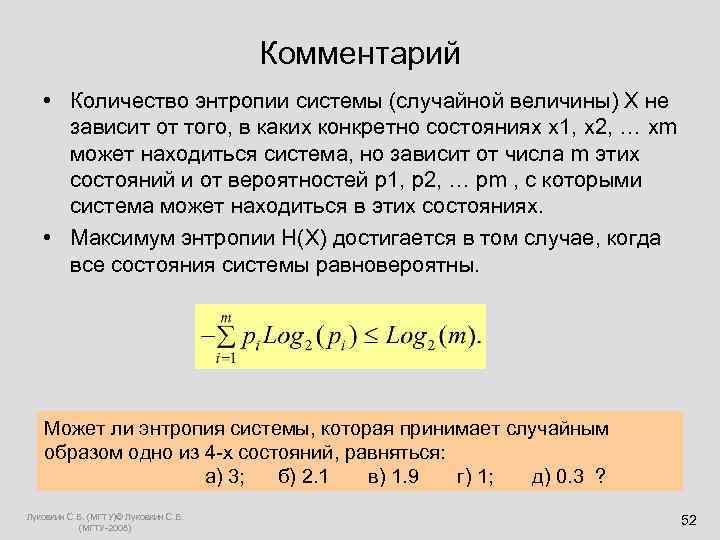

Комментарий • Количество энтропии системы (случайной величины) Х не зависит от того, в каких конкретно состояниях x 1, x 2, … xm может находиться система, но зависит от числа m этих состояний и от вероятностей p 1, p 2, … pm , с которыми система может находиться в этих состояниях. • Максимум энтропии H(X) достигается в том случае, когда все состояния системы равновероятны. Может ли энтропия системы, которая принимает случайным образом одно из 4 -х состояний, равняться: а) 3; б) 2. 1 в) 1. 9 г) 1; д) 0. 3 ? Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 52

Комментарий+ • Количество информации, вычисленное по формуле Шеннона, для осмысленного сообщения, и сообщения полученного из него произвольной перестановкой букв, будет одинаковым. пример: сообщения «начало_в_15: 00» «ачанол_1_в 50: 0» содержат одинаковое количество информации 94 НН 03 С 006 Щ 3 НN 3 П 0 К 43 Ы 8437, К 4 КN 3 У 9 N 8 N 73 ЛЬНЫЕ 83 ЩN М 0 Ж 37 Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 53

Приращение энтропии: • Если после получения некоторого сообщения неопределённость системы X стала меньше, но не исчезла совсем, то количество информации, содержащееся в таком сообщении равно приращению энтропии: I = H 1(X) - H 2(X) Пример: игральный кубик. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 54

Приращение энтропии: • Количество информации, приобретаемое при полном выяснении состояния физической системы, равно энтропии этой системы; если H 2(X) = 0, то I = H 1(X) т. е. Вся энтропия перешла в информацию !!! Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 55

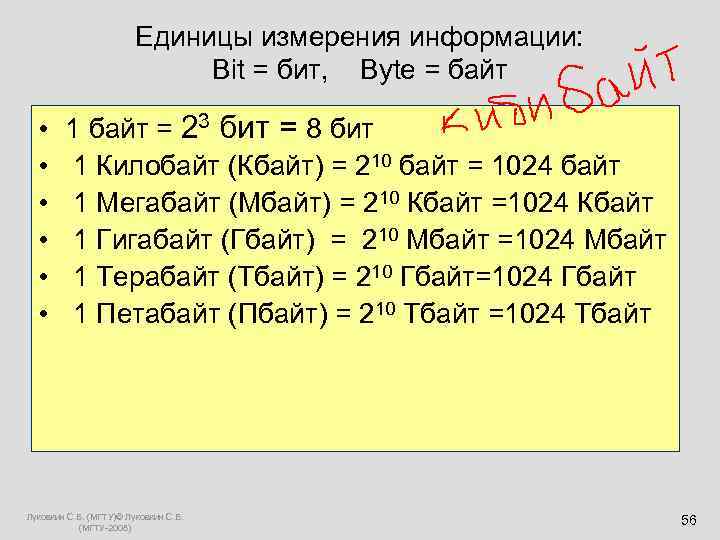

Единицы измерения информации: Bit = бит, Byte = байт • 1 байт = 23 бит = 8 бит • 1 Килобайт (Кбайт) = 210 байт = 1024 байт • 1 Мегабайт (Мбайт) = 210 Кбайт =1024 Кбайт • 1 Гигабайт (Гбайт) = 210 Мбайт =1024 Мбайт • 1 Терабайт (Тбайт) = 210 Гбайт=1024 Гбайт • 1 Петабайт (Пбайт) = 210 Тбайт =1024 Тбайт Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 56

Лекция 3. Кибернетика, кибернетические системы. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 57

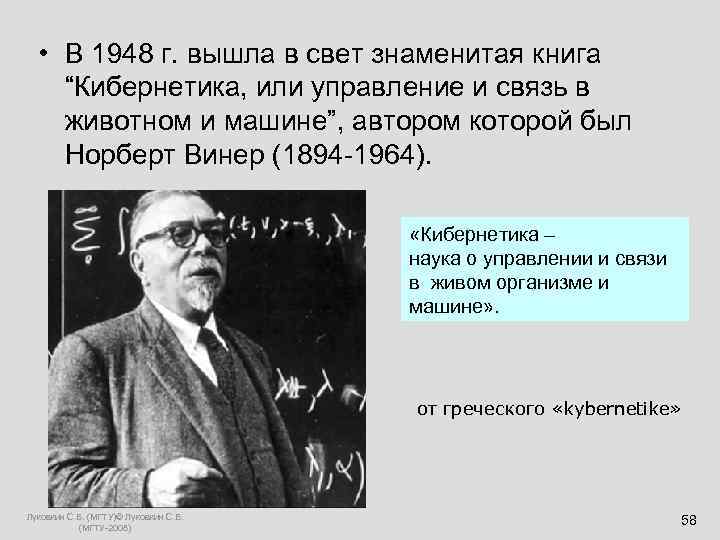

• В 1948 г. вышла в свет знаменитая книга “Кибернетика, или управление и связь в животном и машине”, автором которой был Норберт Винер (1894 -1964). «Кибернетика – наука о управлении и связи в живом организме и машине» . от греческого «kybernetike» Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 58

Основные понятия кибернетики. Основной тезис Винера: подобие процессов управления и связи в машинах, живых организмах и обществах Это прежде всего процессы передачи, хранения и переработки информации. К 70 -ым годам ХХ века кибернетика сложилась как физико-математическая наука со своим собственным предметом исследования – кибернетическими системами. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 59

Система, структура. • Системой называется совокупность элементов, взаимосвязь и взаимодействие которых приводит к возникновению новых интегративных свойств этой совокупности, не сводимых к свойству составляющих её элементов. Под строением системы подразумевают элементы, из которых она состоит и из которых могут быть образованы отдельные её части – подсистемы. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 60

Система, структура (1). • Структура системы - связи и взаимодействия между её элементами, благодаря которым возникают новые интегративные свойства системы, отличные от свойств её элементов. Характер взаимодействия элементов определяет тип систем: химические, физические, биологические, социальные. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 61

Кибернетическая система • Кибернетическая система – множество взаимосвязанных объектов (элементов), способных воспринимать, хранить, перерабатывать и использовать информацию для управления и регулирования системой. • Примеры: • пчелиный рой • государство • компьютер Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 62

определение кибернетики, данное А. Н. Колмогоровым: • Кибернетика изучает машины, живые организмы и их объединения исключительно с точки зрения их способности: • воспринимать определённую «информацию» ; • сохранять эту информацию в «памяти» ; • передавать её по «каналам связи» ; • перерабатывать её в «сигналы» , направляющие их деятельность в соответствующую сторону. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 63

Математическая формализация определения Колмогорова: • Пусть КС состоит только из одного элемента А: где A ={ x, y, z, F, G } • x(t) – входной сигнал элемента A; • y(t) – выходной сигнал элемента A; • z(t) – внутреннее состояние элемента А; • z(t) = F(t, x, z(tпред)); • y(t) = G(t, x, z(tпред)); • надо задать z(0) и y(0) – начальные усл. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 64

Структурная схема одноэлементной КС: Элемент A: X(t) Y(t) Внутреннее состояние Вход Z(t) Выход Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

Структурная схема многоэлементной КС: Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 66

Новый метод исследования в XX веке: • Дедукция (математика) • Индукция (экспериментальные науки) • Машинный эксперимент Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 67

Основные этапы машинного эксперимента: • постановка задачи; • построение математической модели изучаемой системы; • выбор или разработка алгоритма решения задачи; • написание программы на основе предложенного алгоритма; • анализ полученных результатов, сравнение модели и реального объекта; • корректировка модели, алгоритма или программы. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 68

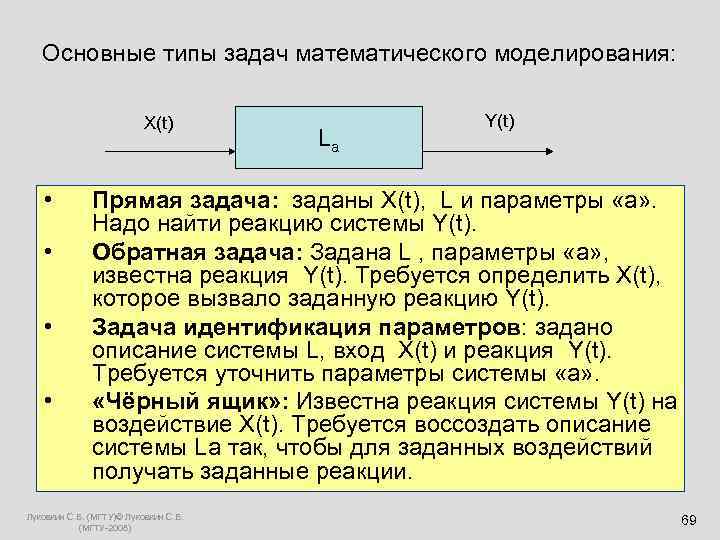

Основные типы задач математического моделирования: X(t) Y(t) La • Прямая задача: заданы X(t), L и параметры «a» . Надо найти реакцию системы Y(t). • Обратная задача: Задана L , параметры «a» , известна реакция Y(t). Требуется определить X(t), которое вызвало заданную реакцию Y(t). • Задача идентификация параметров: задано описание системы L, вход Х(t) и реакция Y(t). Требуется уточнить параметры системы «а» . • «Чёрный ящик» : Известна реакция системы Y(t) на воздействие X(t). Требуется воссоздать описание системы La так, чтобы для заданных воздействий получать заданные реакции. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 69

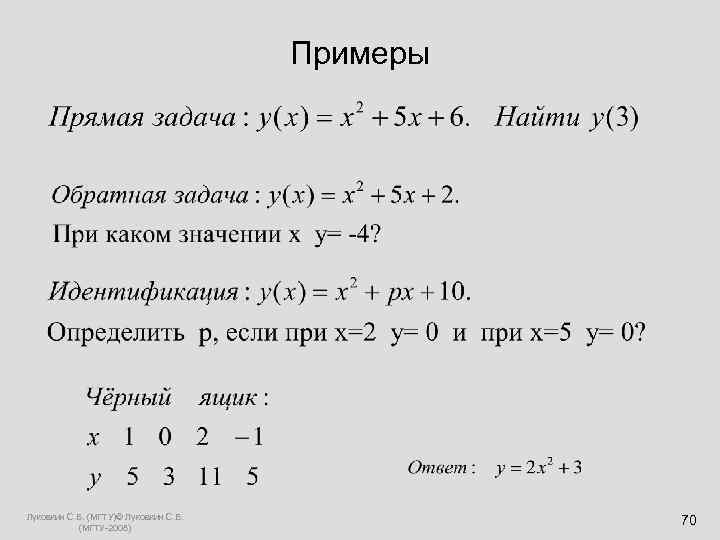

Примеры Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 70

Линейные системы 1. если y = L(x), то L(k*x) = k*y; 2. если y 1 =L(x 1), а y 2 =L(x 2), то L(x 1+x 2) = y 1+y 2. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 71

Обратная связь Обра тная связь в технике — это процесс, приводящий к тому, что результат функционирования какой-либо системы влияет на параметры, от которых зависит функционирование этой системы. Другими словами, на вход системы подаётся сигнал, пропорциональный её выходному сигналу, или, в общем случае, являющийся функцией этого сигнала). Различают положительную и отрицательную обратную связь. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 72

Обратная связь P Q 1. Математический подход; 2. Практический подход. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

Отрицательная обратная связь. Примеры. • Термостат. • Регулятор паровой машины (Уатта). • Гомеостаз Отрицательная обратная связь изменяет входной сигнал таким образом, чтобы противодействовать изменению выходного сигнала. Это делает систему более устойчивой к случайному изменению параметров Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 74

Положительная обратная связь усиливает изменение выходного сигнала. Системы с сильной положительной обратной связью проявляют тенденцию к неустойчивости, в них могут возникать незатухающие колебания, то есть система становится генератором. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 75

Лекция 4. История развития вычислительной техники. ENIAC - первая ЭВМ. Принципы Джона фон Неймана организации ЭВМ. Схема работы УУ. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 76

Основные этапы развития ВТ • Абак. Известен с 3 тыс. до н. э. (Древний Вавилон). Начиная с IV в. до Р. Х абак использовался для выполнения арифметических вычислений. • Антикитерский механизм • Известен эскиз суммирующей машины, сделанный Леонардо да Винчи (15 век). Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 77

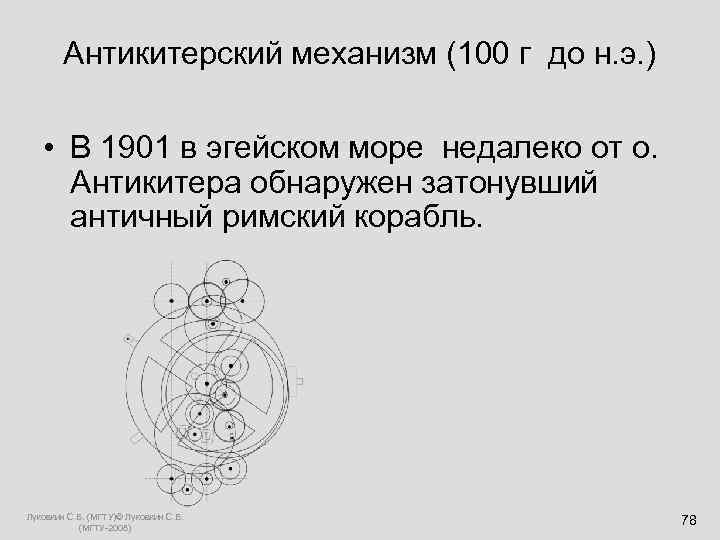

Антикитерский механизм (100 г до н. э. ) • В 1901 в эгейском море недалеко от о. Антикитера обнаружен затонувший античный римский корабль. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 78

Антикитерский механизм Антиките рский механи зм (Μηχανισμός των Αντικυθήρων) — устройство, поднятое в 1901 году с древнего судна, затонувшего недалеко от греческого острова Антикитера (греч. Αντικύθηρα) и обнаруженного греческим водолазом 4 апреля 1900 года. Датируется приблизительно 100 годом до н. э. Хранится в Национальном археологическом музее в Афинах. Механизм содержал 37 бронзовых шестерён в деревянном корпусе, на котором были размещены циферблаты со стрелками и, по реконструкции, использовался для расчёта движения небесных тел. Другие устройства подобной сложности неизвестны в эллинистической культуре. Ориентировочные размеры механизма в сборе 33× 18× 10 см. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

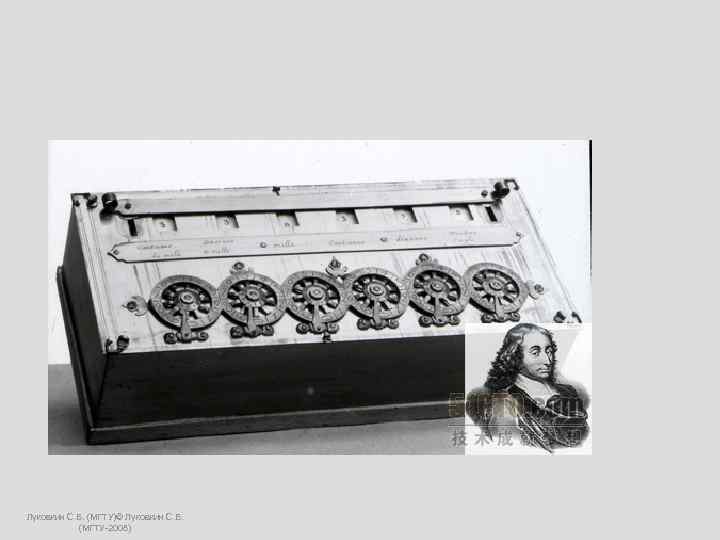

Первую суммирующую 8 – ми разрядную машину построил Блез Паскаль (1641 -1645). 1623 -1662 Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 80

Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

Лейбниц (1673 г. ) создал первый арифмометр (выполнял все 4 -е действия). первым придумал использовать 2 сс для представления чисел и выполнять вычисления в двоичной системе счисления. 1646 -1716 Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 82

Лейбниц В трактате «Об искусстве комбинаторики» (1666) предвосхитил некоторые моменты современной математической логики, он выдвинул идею о применении в логике математической символики и построении логических исчислений, поставил задачу логического обоснования математики. Готфрид Лейбниц сыграл важную роль в истории создания электронно-вычислительных машин: он предложил использовать для целей вычислительной математики бинарную систему счисления, писал о возможности машинного моделирования функций человеческого мозга. Лейбницу принадлежит термин «модель» . Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

Лейбниц призвал к принятию «общего языка, бесконечно отличающегося от всех существовавших до сих пор, поскольку символы и даже слова его должны направлять наш разум, а ошибки, кроме тех, что заложены в исходных фактах, будут просто ошибками вычислений. Построить или изобрести такой язык или такие понятия очень трудно, но зато он будет легко понятен без всяких словарей» . Однако десятилетие спустя он занялся исследованием строгих математических законов применительно к новой области - двоичной системе счисления. На кропотливой работе по переводу чисел из десятичной системы в двоичную его вдохновляла старинная рукопись, случайно попавшаяся ему на глаза. Это был комментарий по поводу знаменитой китайской книги «Ай чинг» (Книга перемен), в которой делалась попытка описать Вселенную во всей ее сложности с помощью ряда философских категорий противоположностей – например, таких понятий, как темнота и свет, мужское и женское начало. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

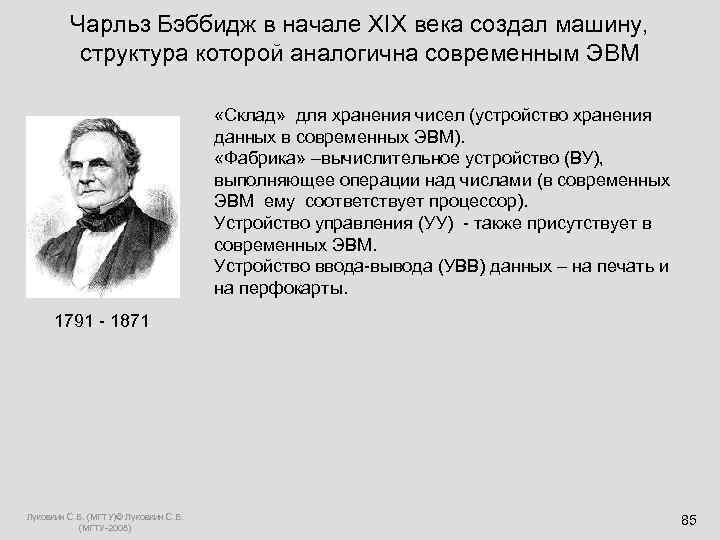

Чарльз Бэббидж в начале XIX века создал машину, структура которой аналогична современным ЭВМ «Склад» для хранения чисел (устройство хранения данных в современных ЭВМ). «Фабрика» –вычислительное устройство (ВУ), выполняющее операции над числами (в современных ЭВМ ему соответствует процессор). Устройство управления (УУ) - также присутствует в современных ЭВМ. Устройство ввода-вывода (УВВ) данных – на печать и на перфокарты. 1791 - 1871 Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 85

Ада Лавлейс – первый программист • Составила описание машины Бэббиджа. • Написала первые алгоритмы и программы для машины Бэббиджа. . 1815 - 1852 Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 86

Конрада Цузе. Он считается создателем первой работающей программируемой ЭВМ и первого языка программирования высокого уровня. В 1934 г. Цузе придумал модель автоматического калькулятора (Z 1), которая состояла из УУ, ВУ, памяти и полностью совпадала с архитектурой современных компьютеров. (1910 -1995). Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 87

Вклад Цузе в развитие ВТ сформулировал шесть принципов работы компьютеров: • должна использоваться двоичная система счисления; • должны использоваться устройства, работающие по принципу да/нет; • должен быть полностью автоматизирован процесс работы ВУ; • процесс вычислений должен управляться программно; • необходима поддержка арифметики с плавающей запятой, а не только с фиксированной; • следует использовать память большой ёмкости. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 88

Вклад Цузе в развитие ВТ(1) • В сентябре 1950 года Цузе сконструировал машину Z 4. Это был единственный работающий компьютер в Европе и первый компьютером в мире, который был продан. • Цузе первым разработал язык программирования, не привязанный к архитектуре ЭВМ (1966 г). Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 89

Первая ЭВМ - ENIAC • Electronic Numerical Integrator and Automatic Calculator • Руководили проектом Дж. Маучли и Преспера Эккерта (Пенсильванский университет). ( начало в 1943 г. ; в 1946 (1945) была продемонстрирована ЭВМ ENIAC ) Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 90

Потребляемая мощность — 150 к. Вт. 300 операций умножения или 5000 операций сложения в секунду. Вес - 27 тонн. Вычисления в 10 системе. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) ENIAC 91

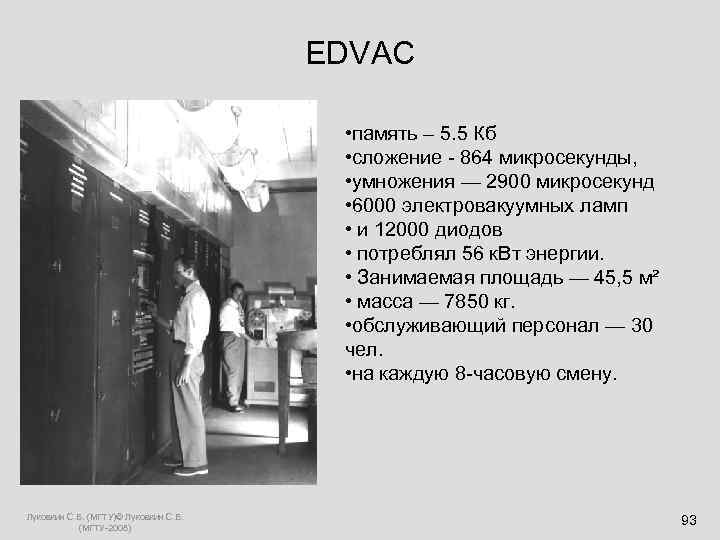

EDVAC – вторая ЭВМ • Electronic Discrete Variable Automatic Computer • первый компьютер с хранимой в памяти программой; работал в двоичной сс. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 92

EDVAC • память – 5. 5 Кб • сложение - 864 микросекунды, • умножения — 2900 микросекунд • 6000 электровакуумных ламп • и 12000 диодов • потреблял 56 к. Вт энергии. • Занимаемая площадь — 45, 5 м² • масса — 7850 кг. • обслуживающий персонал — 30 чел. • на каждую 8 -часовую смену. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 93

Первые ЭВМ в СССР • В СССР первая ЭВМ была запущена в регулярную эксплуатацию в 1951 г. под руководством С. М. Лебедева. • Эта машина известна под названием МЭСМ – малая электронно счётная машина. • В 1953 г. С. М. Лебедевым была запущена самая производительная на тот момент в Европе ЭВМ – БЭСМ (большая электронно счётная машина). Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 94

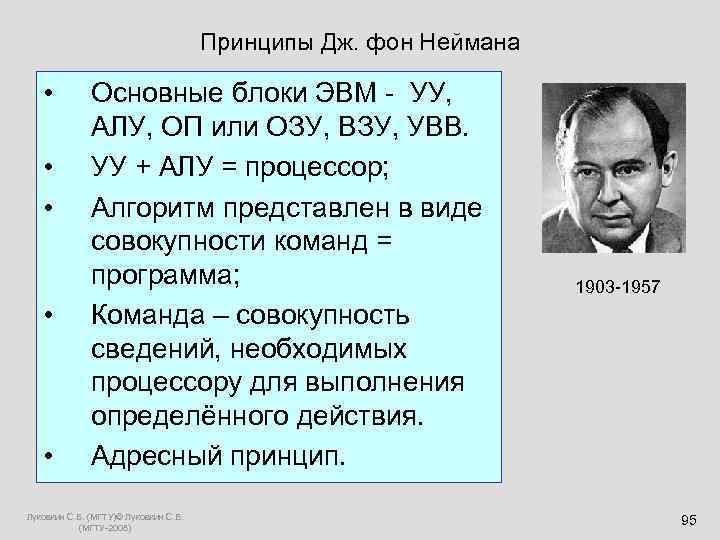

Принципы Дж. фон Неймана • Основные блоки ЭВМ - УУ, АЛУ, ОП или ОЗУ, ВЗУ, УВВ. • УУ + АЛУ = процессор; • Алгоритм представлен в виде совокупности команд = программа; 1903 -1957 • Команда – совокупность сведений, необходимых процессору для выполнения определённого действия. • Адресный принцип. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 95

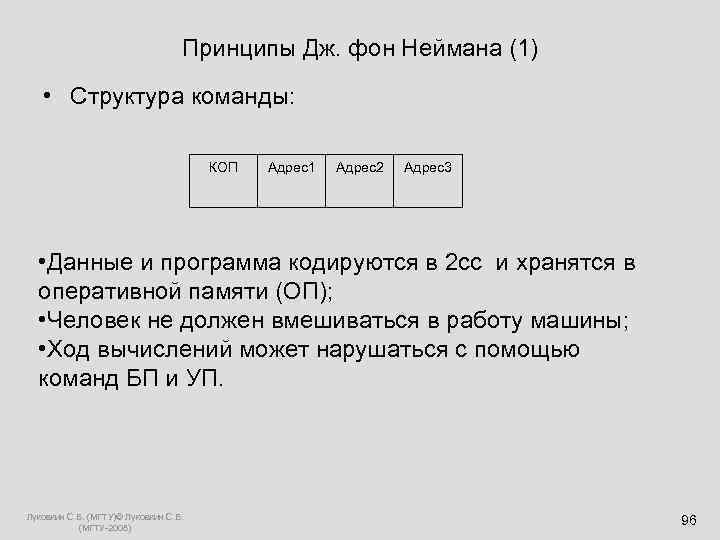

Принципы Дж. фон Неймана (1) • Структура команды: КОП Адрес1 Адрес2 Адрес3 • Данные и программа кодируются в 2 сс и хранятся в оперативной памяти (ОП); • Человек не должен вмешиваться в работу машины; • Ход вычислений может нарушаться с помощью команд БП и УП. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 96

Принципиальная схема ЭВМ Джона фон Неймана. Пульт управления Устройство управления АЛУ ВЗУ ОЗУ (RAM) Ввод Вывод Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

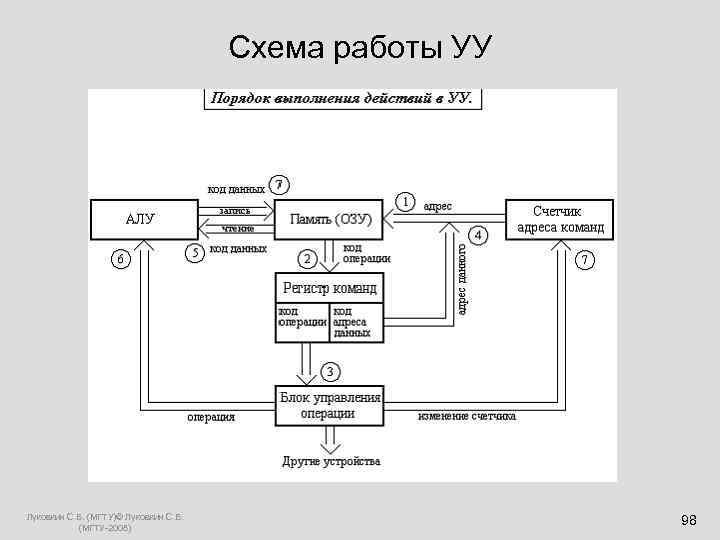

Схема работы УУ Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 98

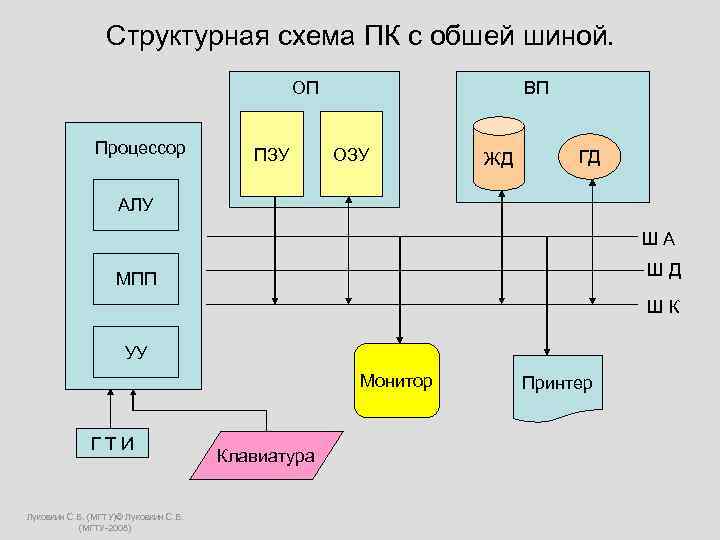

Структурная схема ПК с обшей шиной. ОП ВП Процессор ПЗУ ОЗУ ГД ЖД АЛУ Ш А Ш Д МПП Ш К УУ Монитор Принтер Г Т И Клавиатура Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008)

Лекция 5. Основы математической логики. Основные логические операции Таблицы истинности. Луковкин С. Б. (МГТУ)© Луковкин С. Б. (МГТУ-2008) 100

Informatika__1semestr_chast1.ppt