702e821eaceaf73915119cb0a43c1feb.ppt

- Количество слайдов: 74

Концепция GRID; cоздание российского сегмента глобальной системы распределенных вычислений Кореньков В. В.

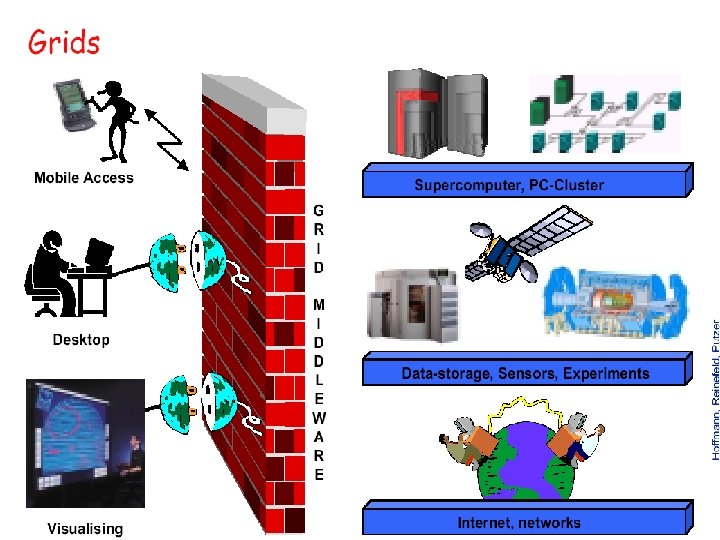

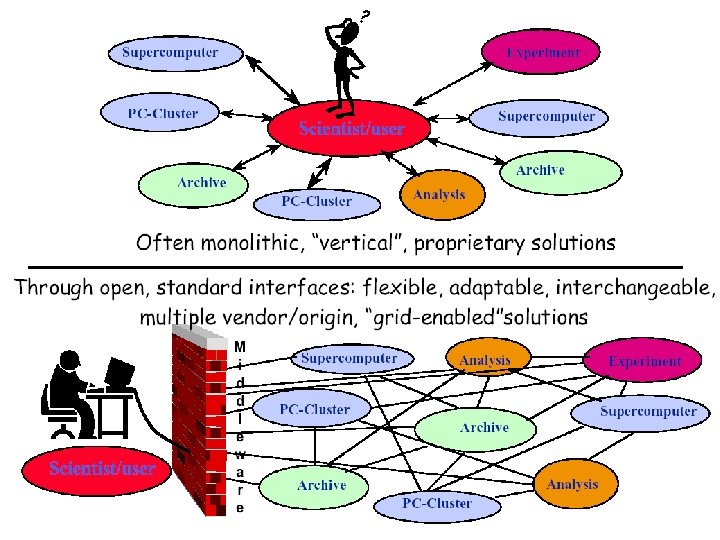

Концепция GRID В настоящее время в мире интенсивно развивается концепция GRID - компьютерной инфраструктуры нового типа, обеспечивающей глобальную интеграцию информационных и вычислительных ресурсов на основе создания и развития промежуточного программного обеспечения (middleware) нового поколения. Основная задача GRID - создание протоколов и сервисов для обеспечения надежного и безопасного доступа к географически распределенным информационным и вычислительным ресурсам - отдельным компьютерам, кластерам, суперкомпьютерным центрам, хранилищам информации, сетям, научному инструментарию и т. д. Благодаря Интернет была создана глобальная система обмена информацией, всемирная паутина WWW стандартизовала поиск и доставку документов, GRID является следующим революционным этапом в развитии высоких технологий – стандартизации и глобализации использования всех видов компьютерных ресурсов.

Five Emerging Models of Networked Computing From The Grid • Distributed Computing – || synchronous processing • High-Throughput Computing – || asynchronous processing • On-Demand Computing – || dynamic resources • Data-Intensive Computing – || databases • Collaborative Computing – || scientists Ian Foster and Carl Kesselman, editors, “The Grid: Blueprint for a New Computing Infrastructure, ” Morgan Kaufmann, 1999, http: //www. mkp. com/grids

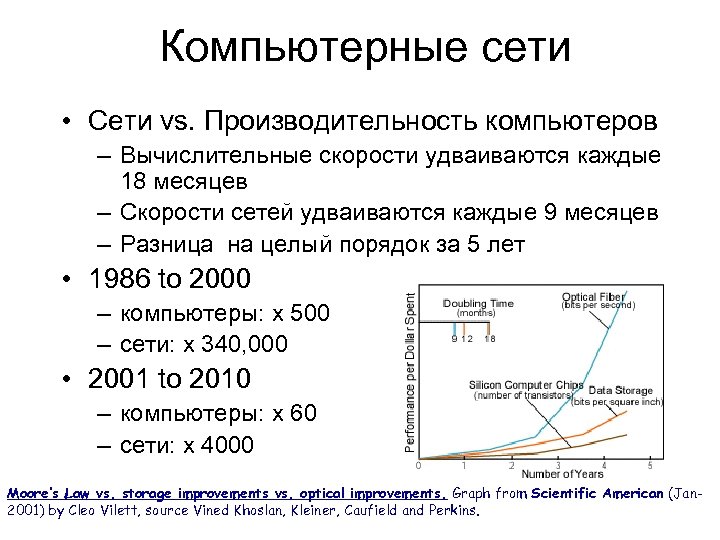

Компьютерные сети • Сети vs. Производительность компьютеров – Вычислительные скорости удваиваются каждые 18 месяцев – Скорости сетей удваиваются каждые 9 месяцев – Разница на целый порядок за 5 лет • 1986 to 2000 – компьютеры: x 500 – сети: x 340, 000 • 2001 to 2010 – компьютеры: x 60 – сети: x 4000 Moore’s Law vs. storage improvements vs. optical improvements. Graph from Scientific American (Jan 2001) by Cleo Vilett, source Vined Khoslan, Kleiner, Caufield and Perkins.

Этапы развития GRID

Приложения GRID Grid служит универсальной эффективной инфраструктурой для высокопроизводительных распределенных вычислений и обработки данных. Grid — практически неограниченно масштабируемый инструмент обработки информации. К приложениям Grid относятся: • сложное моделирование на удаленных суперкомпьютерах; • совместная визуализация очень больших наборов научных данных; • распределенная обработка и анализ данных; • связывание научного инструментария с удаленными компьютерами и архивами данных; • совместное проектирование сложных объектов.

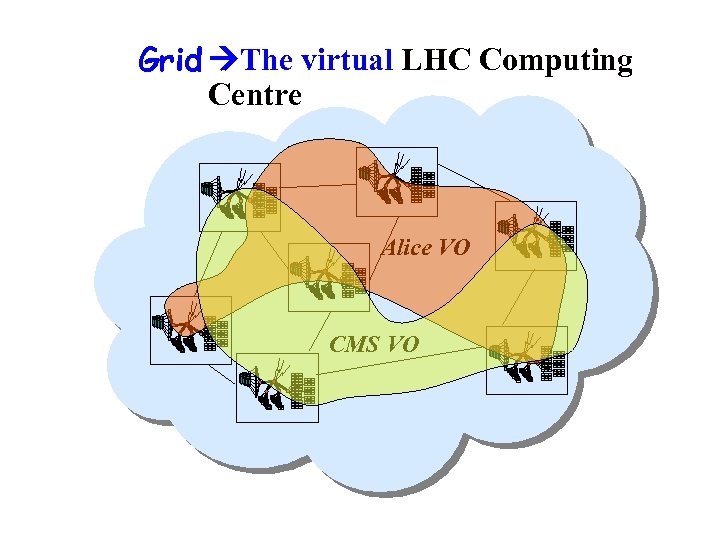

Grid The virtual LHC Computing Building a Grid Centre Collaborating Computer Centres Alice VO CMS VO

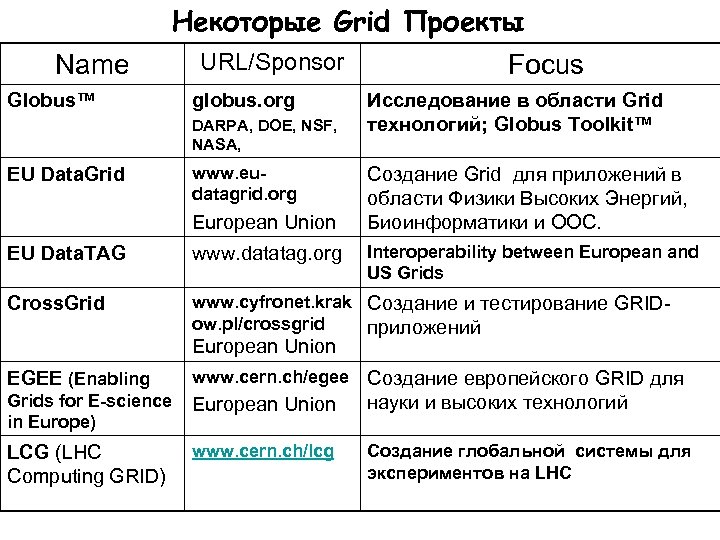

Некоторые Grid Проекты Name Globus™ URL/Sponsor globus. org DARPA, DOE, NSF, NASA, EU Data. Grid www. eudatagrid. org European Union Focus Исследование в области Grid технологий; Globus Toolkit™ Создание Grid для приложений в области Физики Высоких Энергий, Биоинформатики и ООС. Interoperability between European and US Grids EU Data. TAG www. datatag. org Cross. Grid www. cyfronet. krak Создание и тестирование GRIDow. pl/crossgrid приложений European Union EGEE (Enabling www. cern. ch/egee Grids for E-science in Europe) European Union LCG (LHC Computing GRID) www. cern. ch/lcg Создание европейского GRID для науки и высоких технологий Создание глобальной системы для экспериментов на LHC

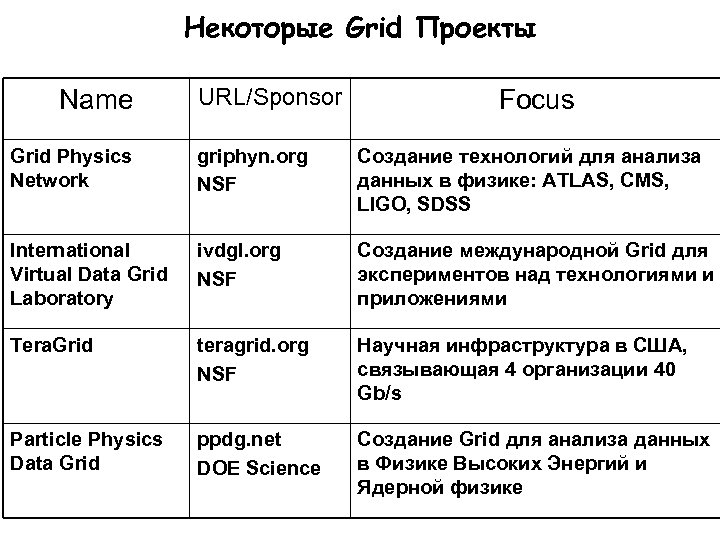

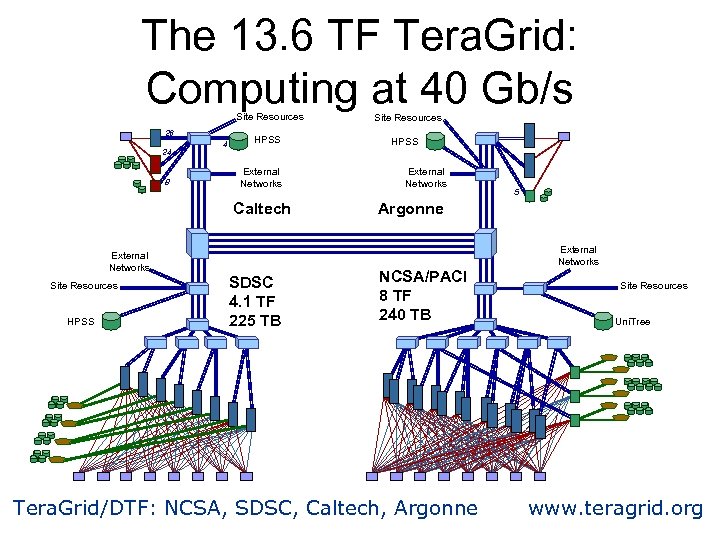

Некоторые Grid Проекты Name URL/Sponsor Focus Grid Physics Network griphyn. org NSF Cоздание технологий для анализа данных в физике: ATLAS, CMS, LIGO, SDSS International Virtual Data Grid Laboratory ivdgl. org NSF Создание международной Grid для экспериментов над технологиями и приложениями Tera. Grid teragrid. org NSF Научная инфраструктура в США, связывающая 4 организации 40 Gb/s Particle Physics Data Grid ppdg. net DOE Science Создание Grid для анализа данных в Физике Высоких Энергий и Ядерной физике

The 13. 6 TF Tera. Grid: Computing at 40 Gb/s Site Resources 26 24 8 4 HPSS External Networks Caltech External Networks Site Resources HPSS SDSC 4. 1 TF 225 TB Site Resources HPSS External Networks 5 Argonne NCSA/PACI 8 TF 240 TB Tera. Grid/DTF: NCSA, SDSC, Caltech, Argonne External Networks Site Resources Uni. Tree www. teragrid. org

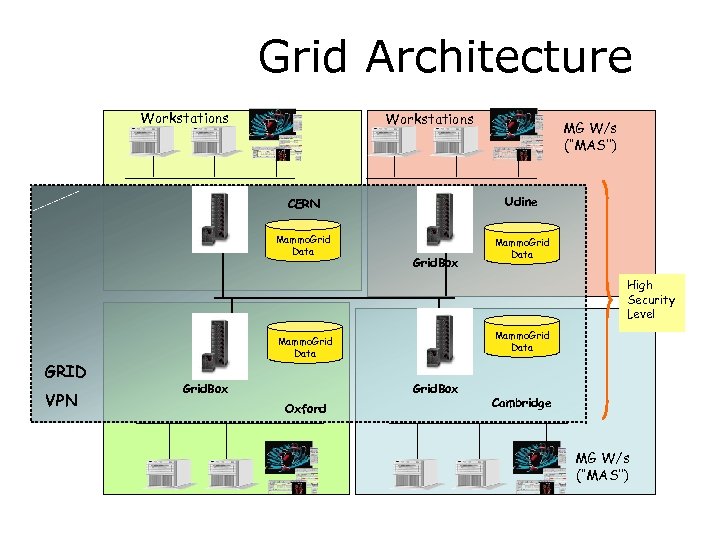

Grid Architecture Workstations MG W/s (‘‘MAS’’) CERN Udine Mammo. Grid Data Grid. Box High Security Level GRID VPN Mammo. Grid Data Grid. Box Oxford Cambridge MG W/s (‘‘MAS’’)

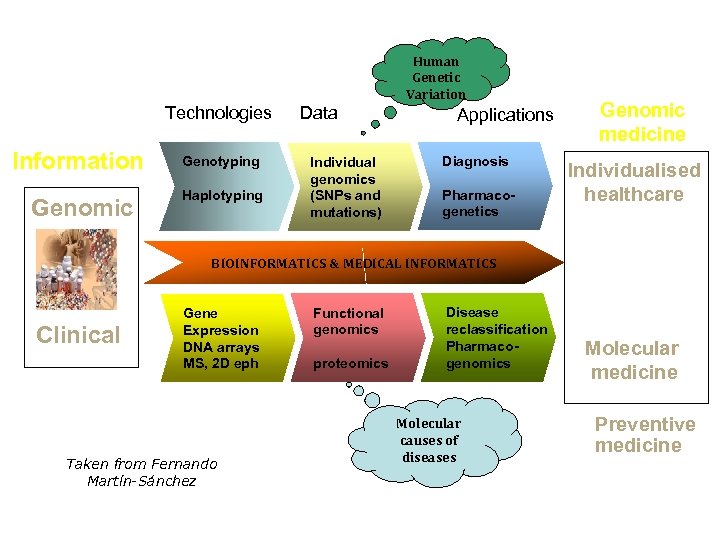

Human Genetic Variation Technologies Information Genomic Genotyping Haplotyping Data Individual genomics (SNPs and mutations) Applications Diagnosis Pharmacogenetics Genomic medicine Individualised healthcare BIOINFORMATICS & MEDICAL INFORMATICS Clinical Gene Expression DNA arrays MS, 2 D eph Taken from Fernando Martín-Sánchez Functional genomics proteomics Disease reclassification Pharmacogenomics Molecular causes of diseases Molecular medicine Preventive medicine

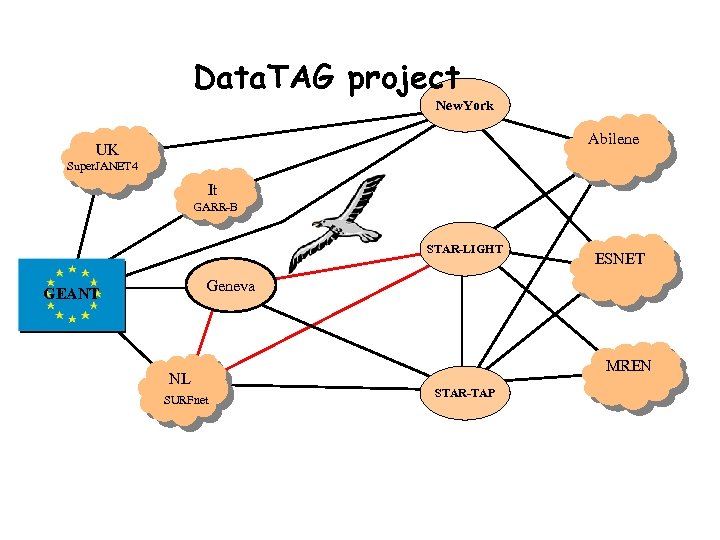

Data. TAG project New. York Abilene UK Super. JANET 4 It GARR-B STAR-LIGHT ESNET Geneva GEANT NL SURFnet MREN STAR-TAP

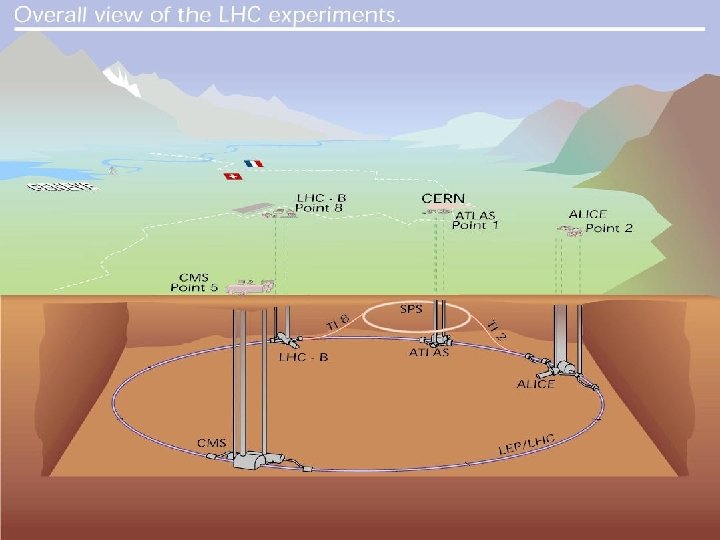

CERN

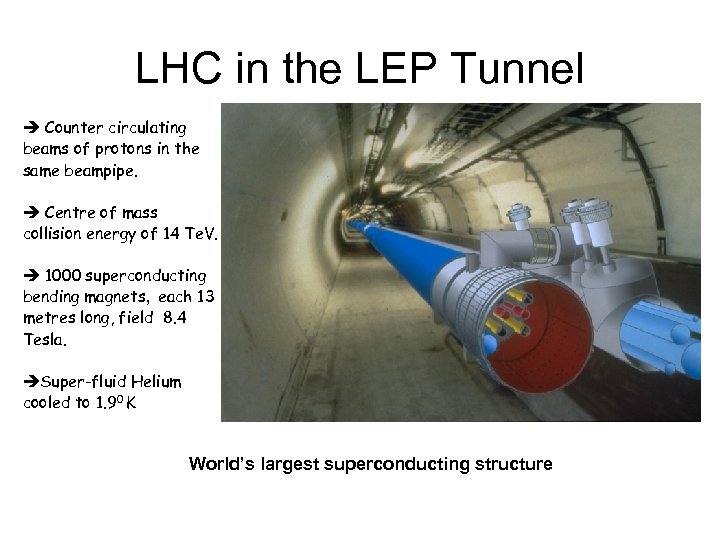

LHC in the LEP Tunnel è Counter circulating beams of protons in the same beampipe. è Centre of mass collision energy of 14 Te. V. è 1000 superconducting bending magnets, each 13 metres long, field 8. 4 Tesla. èSuper-fluid Helium cooled to 1. 90 K World’s largest superconducting structure

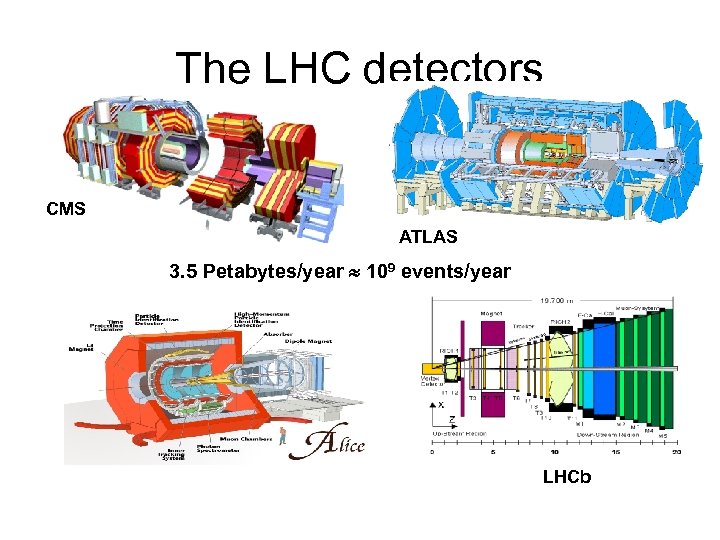

The LHC detectors CMS ATLAS 3. 5 Petabytes/year 109 events/year LHCb

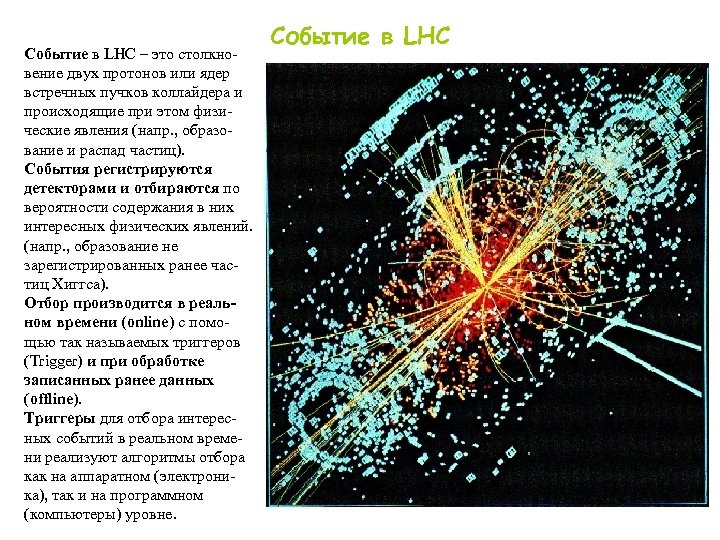

Событие в LHC – это столкновение двух протонов или ядер встречных пучков коллайдера и происходящие при этом физические явления (напр. , образование и распад частиц). События регистрируются детекторами и отбираются по вероятности содержания в них интересных физических явлений. (напр. , образование не зарегистрированных ранее частиц Хиггса). Отбор производится в реальном времени (online) с помощью так называемых триггеров (Trigger) и при обработке записанных ранее данных (offline). Триггеры для отбора интересных событий в реальном времени реализуют алгоритмы отбора как на аппаратном (электроника), так и на программном (компьютеры) уровне. Событие в LHC

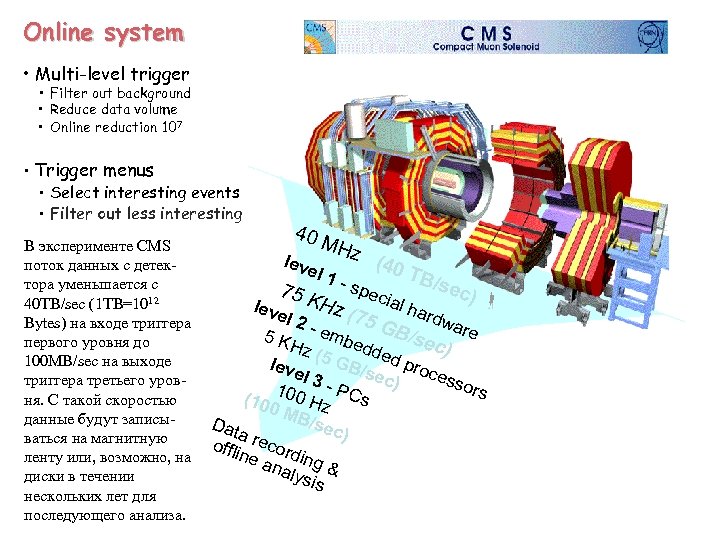

Online system • Multi-level trigger • Filter out background • Reduce data volume • Online reduction 107 • Trigger menus • Select interesting events • Filter out less interesting В эксперименте CMS поток данных с детектора уменьшается с 40 TB/sec (1 TB=1012 Bytes) на входе триггера первого уровня до 100 MB/sec на выходе триггера третьего уровня. С такой скоростью данные будут записываться на магнитную ленту или, возможно, на диски в течении нескольких лет для последующего анализа. 40 M leve Hz l 1 - 75 K (40 spe c TB/ sec ) ial h ar (75 l 2 GB dware emb 5 K /sec edd Hz ) (5 G ed p leve B/s ec) rocess l 3 ors PCs 100 (100 H MB z /sec Dat a re ) cord offli ne a i naly ng & sis leve Hz

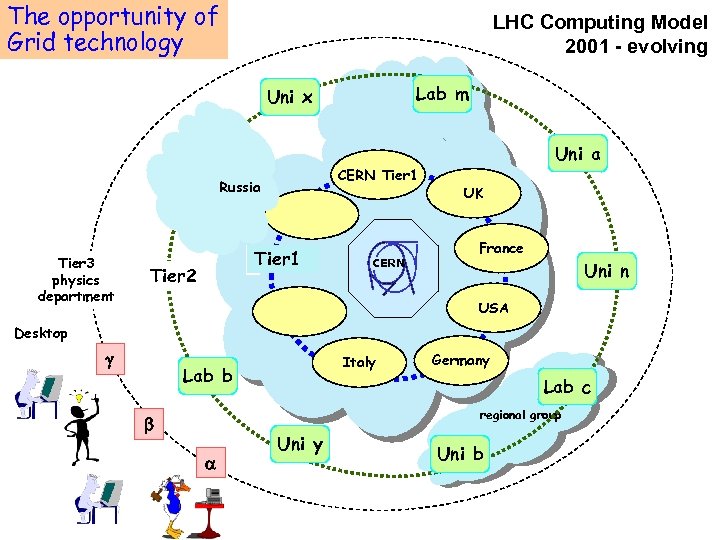

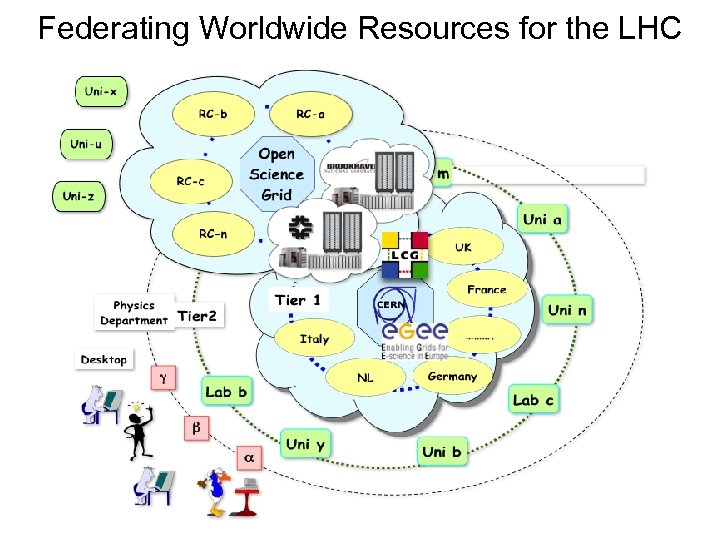

The opportunity of MONARC project Grid technology LHC Computing Model 2001 - evolving Lab m Uni x CERN Tier 1 Russia Tier 3 physics department Tier 1 Tier 2 CERN Uni a UK France Uni n USA Desktop Italy Lab b Germany Lab c regional group Uni y Uni b

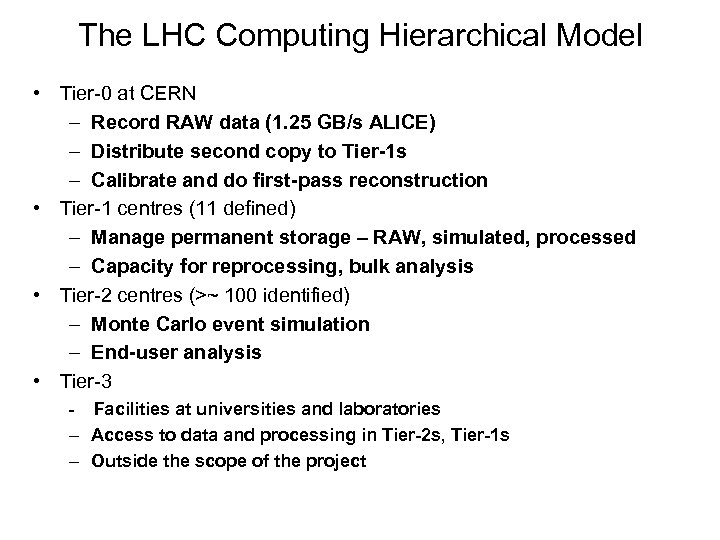

The LHC Computing Hierarchical Model • Tier-0 at CERN – Record RAW data (1. 25 GB/s ALICE) – Distribute second copy to Tier-1 s – Calibrate and do first-pass reconstruction • Tier-1 centres (11 defined) – Manage permanent storage – RAW, simulated, processed – Capacity for reprocessing, bulk analysis • Tier-2 centres (>~ 100 identified) – Monte Carlo event simulation – End-user analysis • Tier-3 - Facilities at universities and laboratories – Access to data and processing in Tier-2 s, Tier-1 s – Outside the scope of the project

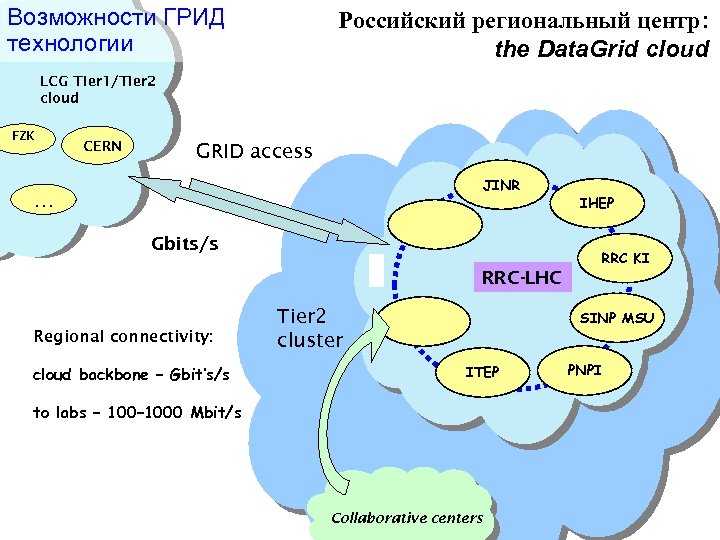

Возможности ГРИД технологии Российский региональный центр: the Data. Grid cloud LCG Tier 1/Tier 2 cloud FZK CERN GRID access JINR … Gbits/s RRC-LHC Regional connectivity: cloud backbone – Gbit’s/s Tier 2 cluster IHEP RRC KI SINP MSU ITEP to labs – 1000 Mbit/s Collaborative centers PNPI

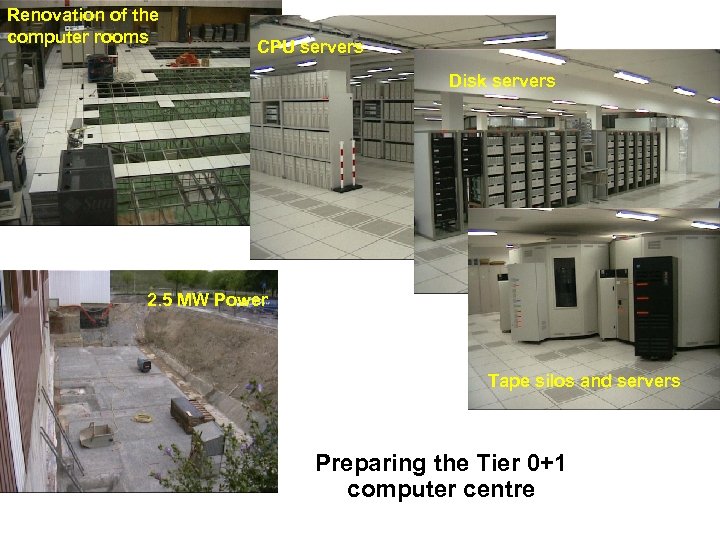

Renovation of the computer rooms CPU servers Disk servers 2. 5 MW Power Tape silos and servers Preparing the Tier 0+1 computer centre

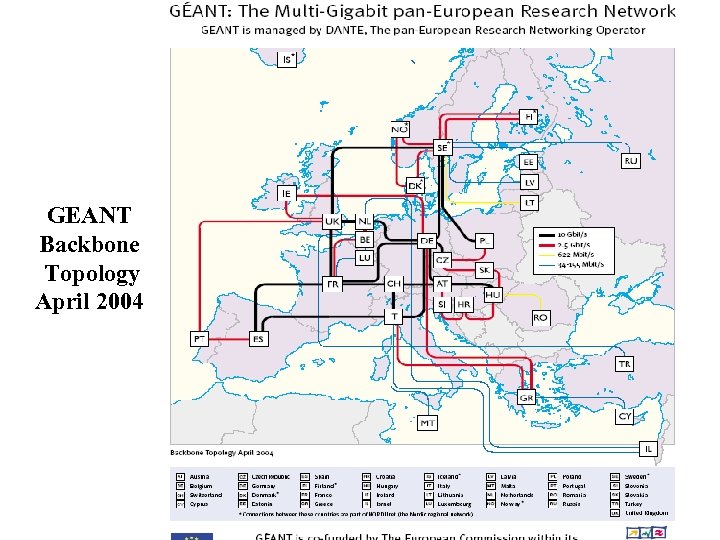

GEANT Backbone Topology April 2004

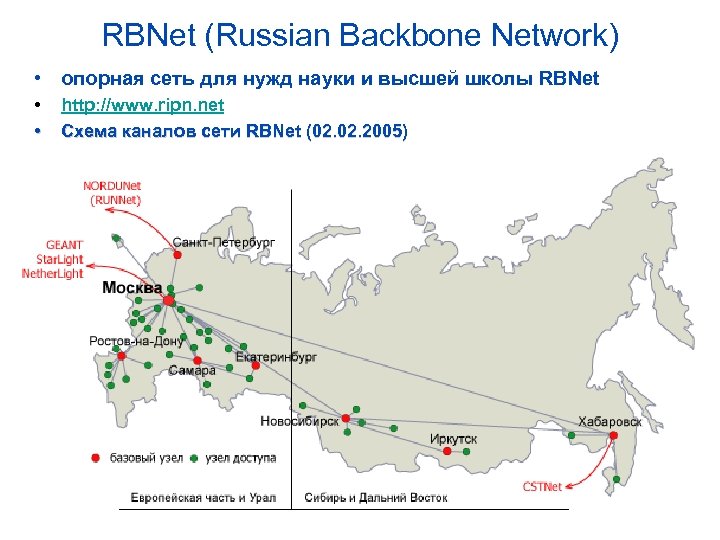

RBNet (Russian Backbone Network) • опоpная сеть для нужд науки и высшей школы RBNet • • http: //www. ripn. net Схема каналов сети RBNet (02. 2005)

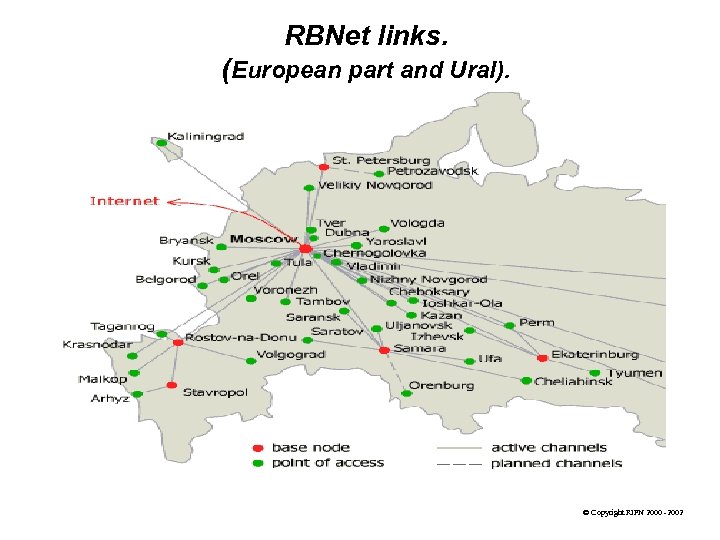

RBNet links. (European part and Ural). © Copyright RIPN 2000 -2002

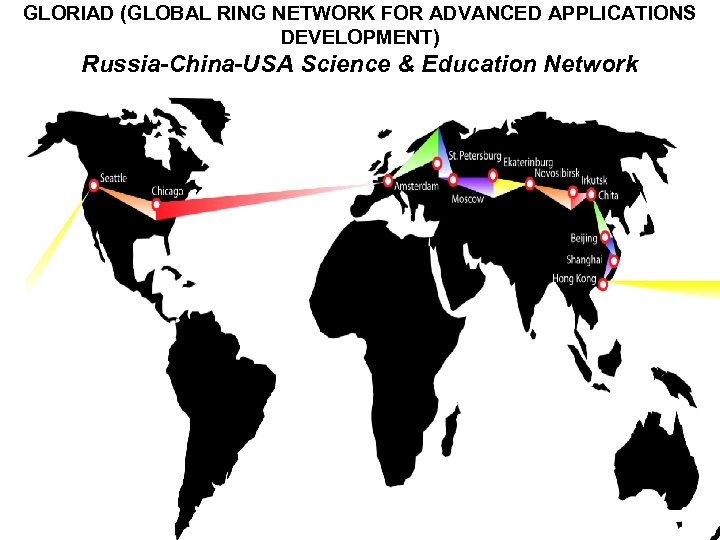

GLORIAD (GLOBAL RING NETWORK FOR ADVANCED APPLICATIONS DEVELOPMENT) Russia-China-USA Science & Education Network

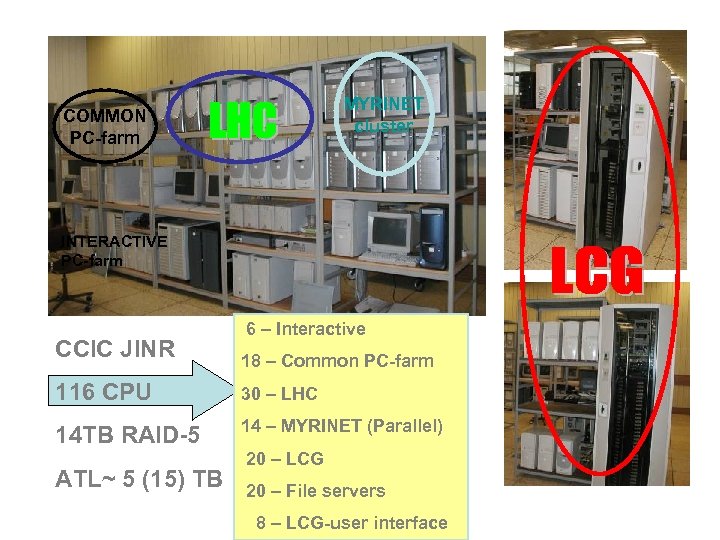

MYRINET cluster COMMON PC-farm INTERACTIVE PC-farm CCIC JINR 6 – Interactive 18 – Common PC-farm 116 CPU 30 – LHC 14 TB RAID-5 14 – MYRINET (Parallel) ATL~ 5 (15) TB 20 – LCG 20 – File servers 8 – LCG-user interface

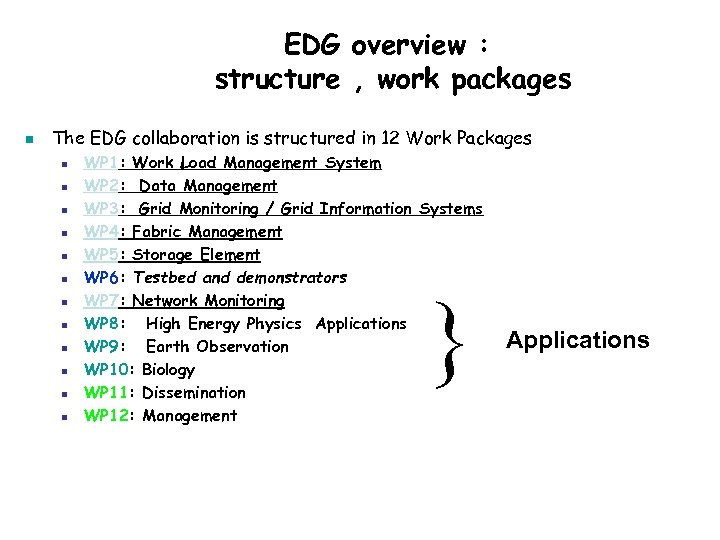

EDG overview : structure , work packages n The EDG collaboration is structured in 12 Work Packages n n n WP 1: Work Load Management System WP 2: Data Management WP 3: Grid Monitoring / Grid Information Systems WP 4: Fabric Management WP 5: Storage Element WP 6: Testbed and demonstrators WP 7: Network Monitoring WP 8: High Energy Physics Applications WP 9: Earth Observation WP 10: Biology WP 11: Dissemination WP 12: Management } Applications

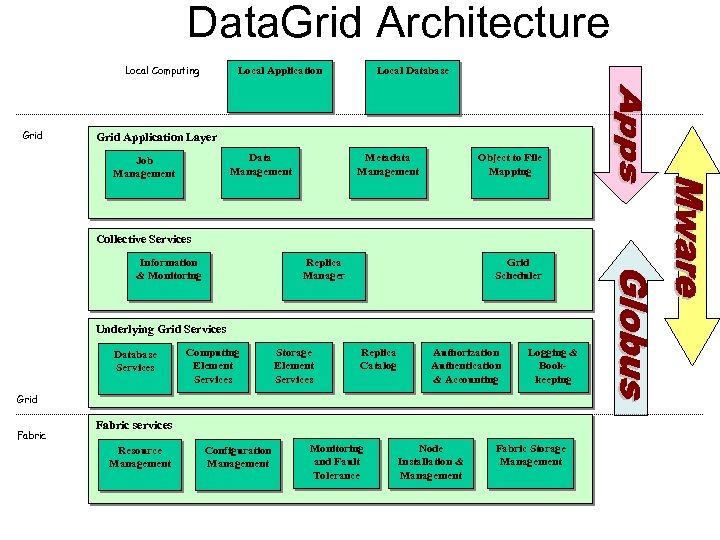

Data. Grid Architecture Local Computing Grid Local Application Local Database Grid Application Layer Data Management Job Management Metadata Management Object to File Mapping Collective Services Information & Monitoring Replica Manager Grid Scheduler Underlying Grid Services Database Services Computing Element Services Storage Element Services Replica Catalog Authorization Authentication & Accounting Logging & Bookkeeping Grid Fabric services Resource Management Configuration Management Monitoring and Fault Tolerance Node Installation & Management Fabric Storage Management

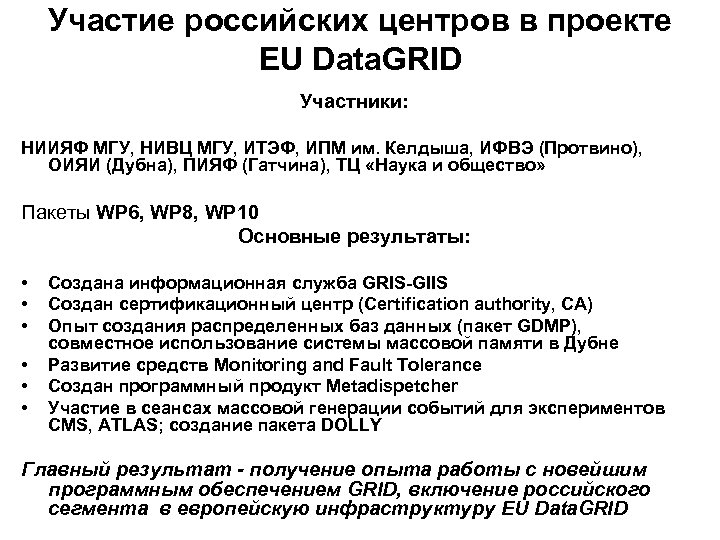

Участие российских центров в проекте EU Data. GRID Участники: НИИЯФ МГУ, НИВЦ МГУ, ИТЭФ, ИПМ им. Келдыша, ИФВЭ (Протвино), ОИЯИ (Дубна), ПИЯФ (Гатчина), ТЦ «Наука и общество» Пакеты WP 6, WP 8, WP 10 Основные результаты: • • • Создана информационная служба GRIS-GIIS Создан сертификационный центр (Certification authority, СА) Опыт создания распределенных баз данных (пакет GDMP), совместное использование системы массовой памяти в Дубне Развитие средств Monitoring and Fault Tolerance Создан программный продукт Metadispetcher Участие в сеансах массовой генерации событий для экспериментов CMS, ATLAS; создание пакета DOLLY Главный результат - получение опыта работы с новейшим программным обеспечением GRID, включение российского сегмента в европейскую инфраструктуру EU Data. GRID

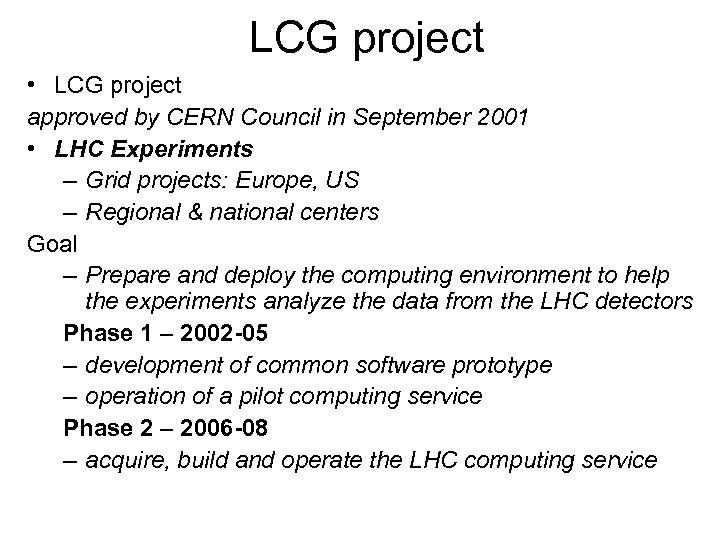

LCG project • LCG project approved by CERN Council in September 2001 • LHC Experiments – Grid projects: Europe, US – Regional & national centers Goal – Prepare and deploy the computing environment to help the experiments analyze the data from the LHC detectors Phase 1 – 2002 -05 – development of common software prototype – operation of a pilot computing service Phase 2 – 2006 -08 – acquire, build and operate the LHC computing service

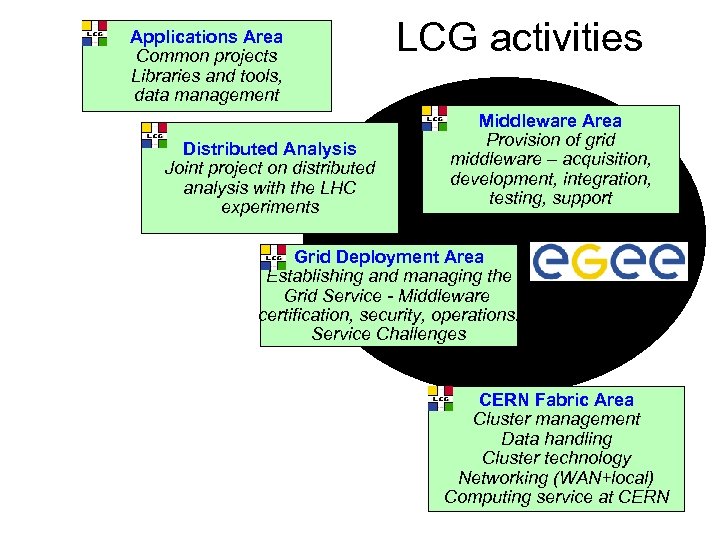

Applications Area Common projects Libraries and tools, data management Distributed Analysis Joint project on distributed analysis with the LHC experiments LCG activities Middleware Area Provision of grid middleware – acquisition, development, integration, testing, support Grid Deployment Area Establishing and managing the Grid Service - Middleware certification, security, operations. Service Challenges CERN Fabric Area Cluster management Data handling Cluster technology Networking (WAN+local) Computing service at CERN

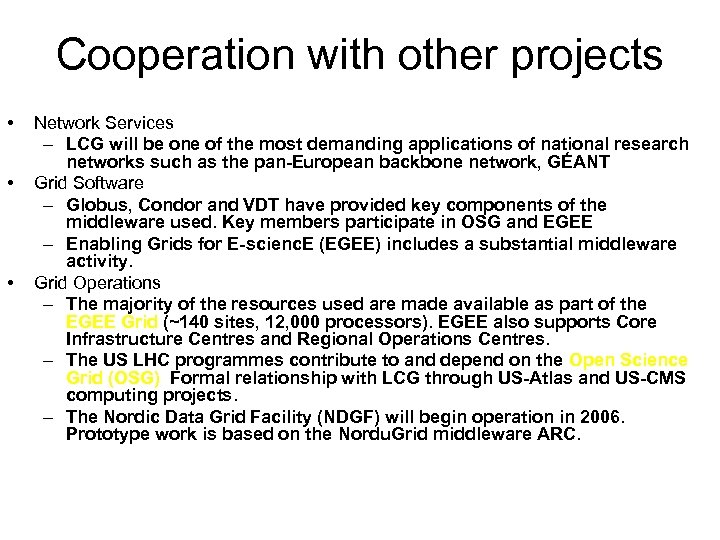

Cooperation with other projects • • • Network Services – LCG will be one of the most demanding applications of national research networks such as the pan-European backbone network, GÉANT Grid Software – Globus, Condor and VDT have provided key components of the middleware used. Key members participate in OSG and EGEE – Enabling Grids for E-scienc. E (EGEE) includes a substantial middleware activity. Grid Operations – The majority of the resources used are made available as part of the EGEE Grid (~140 sites, 12, 000 processors). EGEE also supports Core Infrastructure Centres and Regional Operations Centres. – The US LHC programmes contribute to and depend on the Open Science Grid (OSG). Formal relationship with LCG through US-Atlas and US-CMS computing projects. – The Nordic Data Grid Facility (NDGF) will begin operation in 2006. Prototype work is based on the Nordu. Grid middleware ARC.

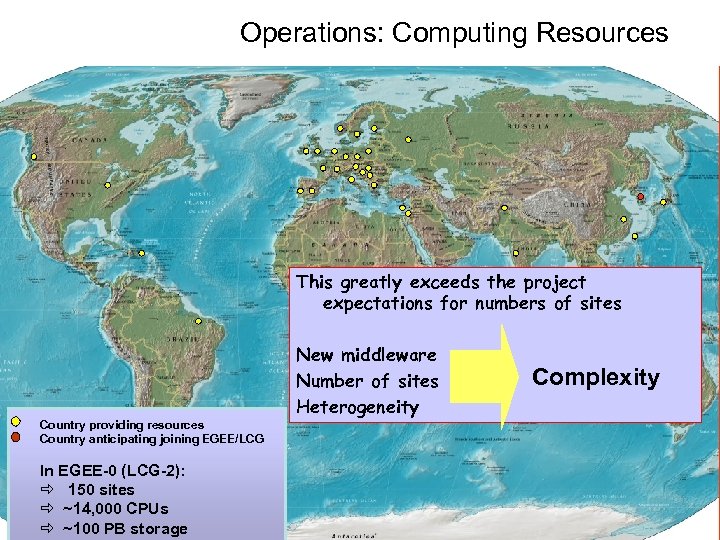

Operations: Computing Resources This greatly exceeds the project expectations for numbers of sites Country providing resources Country anticipating joining EGEE/LCG In EGEE-0 (LCG-2): ð 150 sites ð ~14, 000 CPUs ð ~100 PB storage New middleware Number of sites Heterogeneity Complexity

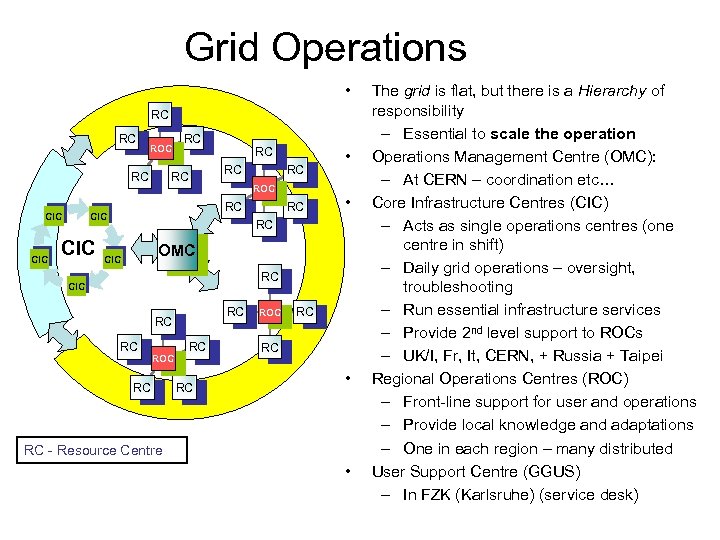

Grid Operations • RC RC ROC RC CIC CIC RC RC • • RC OMC CIC RC RC RC ROC RC RC • RC - Resource Centre • The grid is flat, but there is a Hierarchy of responsibility – Essential to scale the operation Operations Management Centre (OMC): – At CERN – coordination etc… Core Infrastructure Centres (CIC) – Acts as single operations centres (one centre in shift) – Daily grid operations – oversight, troubleshooting – Run essential infrastructure services – Provide 2 nd level support to ROCs – UK/I, Fr, It, CERN, + Russia + Taipei Regional Operations Centres (ROC) – Front-line support for user and operations – Provide local knowledge and adaptations – One in each region – many distributed User Support Centre (GGUS) – In FZK (Karlsruhe) (service desk)

Experiments’ Requirements • Single Virtual Organization (VO) across the Grid • Standard interfaces for Grid access to Storage Elements (SEs) and Computing Elements (CEs) • Need of a reliable Workload Management System (WMS) to efficiently exploit distributed resources. • Non-event data such as calibration and alignment data but also detector construction descriptions will be held in data bases – read/write access to central (Oracle) databases at Tier-0 and read access at Tier-1 s with a local database cache at Tier-2 s • Analysis scenarios and specific requirements are still evolving – Prototype work is in progress (ARDA) • Online requirements are outside of the scope of LCG, but there are connections: – Raw data transfer and buffering – Database management and data export – Some potential use of Event Filter Farms for offline processing

Architecture – Grid services • Storage Element – Mass Storage System (MSS) (CASTOR, Enstore, HPSS, d. Cache, etc. ) – Storage Resource Manager (SRM) provides a common way to access MSS, independent of implementation – File Transfer Services (FTS) provided e. g. by Grid. FTP or srm. Copy • Computing Element – Interface to local batch system e. g. Globus gatekeeper. – Accounting, status query, job monitoring • Virtual Organization Management – Virtual Organization Management Services (VOMS) – Authentication and authorization based on VOMS model. • Grid Catalogue Services – Mapping of Globally Unique Identifiers (GUID) to local file name – Hierarchical namespace, access control • Interoperability – EGEE and OSG both use the Virtual Data Toolkit (VDT) – Different implementations are hidden by common interfaces

Technology - Middleware • Currently, the LCG-2 middleware is deployed in more than 100 sites • It originated from Condor, EDG, Globus, VDT, and other projects. • Will evolve now to include functionalities of the g. Lite middleware provided by the EGEE project which has just been made available. • Site services include security, the Computing Element (CE), the Storage Element (SE), Monitoring and Accounting Services – currently available both form LCG-2 and g. Lite. • VO services such as Workload Management System (WMS), File Catalogues, Information Services, File Transfer Services exist in both flavours (LCG-2 and g. Lite) maintaining close relations with VDT, Condor and Globus.

g. Lite middleware – The 1 st release of g. Lite (v 1. 0) made end March’ 05 • http: //glite. web. cern. ch/glite/packages/R 1. 0/R 20050331 • http: //glite. web. cern. ch/glite/documentation – Lightweight services – Interoperability & Co-existence with deployed infrastructure – Performance & Fault Tolerance – Portable – Service oriented approach – Site autonomy – Open source license

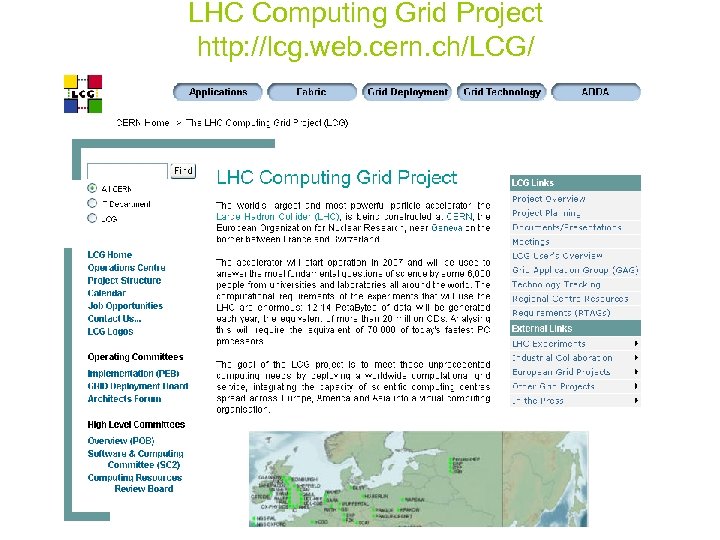

LHC Computing Grid Project http: //lcg. web. cern. ch/LCG/

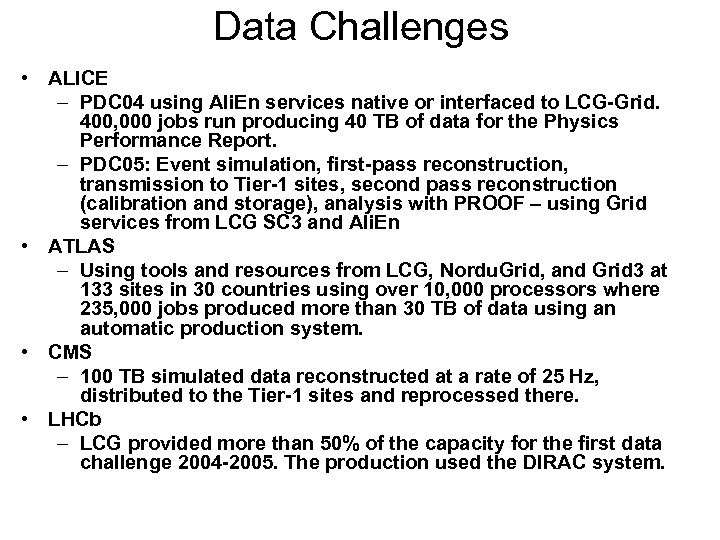

Data Challenges • ALICE – PDC 04 using Ali. En services native or interfaced to LCG-Grid. 400, 000 jobs run producing 40 TB of data for the Physics Performance Report. – PDC 05: Event simulation, first-pass reconstruction, transmission to Tier-1 sites, second pass reconstruction (calibration and storage), analysis with PROOF – using Grid services from LCG SC 3 and Ali. En • ATLAS – Using tools and resources from LCG, Nordu. Grid, and Grid 3 at 133 sites in 30 countries using over 10, 000 processors where 235, 000 jobs produced more than 30 TB of data using an automatic production system. • CMS – 100 TB simulated data reconstructed at a rate of 25 Hz, distributed to the Tier-1 sites and reprocessed there. • LHCb – LCG provided more than 50% of the capacity for the first data challenge 2004 -2005. The production used the DIRAC system.

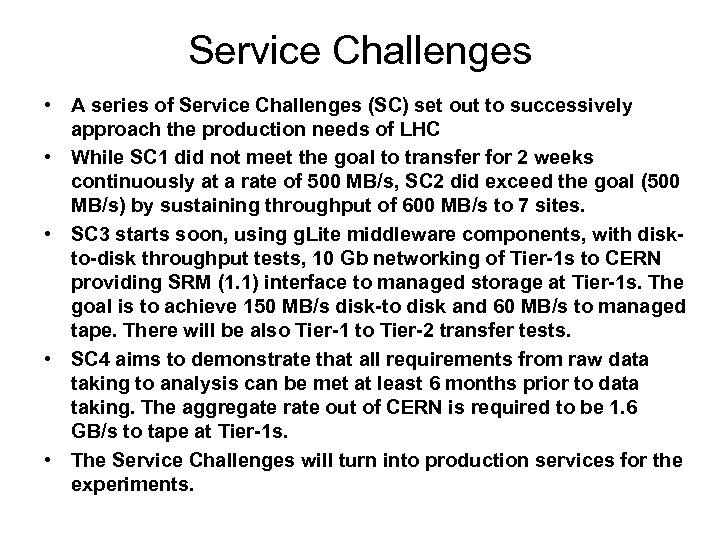

Service Challenges • A series of Service Challenges (SC) set out to successively approach the production needs of LHC • While SC 1 did not meet the goal to transfer for 2 weeks continuously at a rate of 500 MB/s, SC 2 did exceed the goal (500 MB/s) by sustaining throughput of 600 MB/s to 7 sites. • SC 3 starts soon, using g. Lite middleware components, with diskto-disk throughput tests, 10 Gb networking of Tier-1 s to CERN providing SRM (1. 1) interface to managed storage at Tier-1 s. The goal is to achieve 150 MB/s disk-to disk and 60 MB/s to managed tape. There will be also Tier-1 to Tier-2 transfer tests. • SC 4 aims to demonstrate that all requirements from raw data taking to analysis can be met at least 6 months prior to data taking. The aggregate rate out of CERN is required to be 1. 6 GB/s to tape at Tier-1 s. • The Service Challenges will turn into production services for the experiments.

g. Lite http: //www. glite. org

Участие российских институтов в проектах LCG/EGEE

LHC Computing Grid Project (LCG) В 2003 году подписан протокол между правительством России, CERN и ОИЯИ об участии в проекте LCG. По этому соглашению Россия и ОИЯИ берет на себя в ответственность за следующие задачи: - тестирование всех (внешних или разработанных внутри LCG) программных средств GRID, принятых для внедрения в инфраструктуру LCG; - программы запуска, сопровождения, мониторинга, инсталляции генераторов событий (Events Database, Repository of generators); - участие в оценке новых технологий GRID, появляющихся в мире, для использования в LCG (Globus toolkit 3, industrial GRID software)

LHC Computing Grid Project (LCG) Основные результаты: – Создание инструментальных средств, тестовых пакетов и инфраструктуры для испытания программного обеспечения LCG. – Создан тестовый полигон (названный “Beryllium”) для функциональных испытаний базовых компонент EU Data. GRID в архитектурной среде OGSA (Globus Toolkit 3), основанной на технологиях Java и XML с использованием транспортного протокола высшего уровня SOAP. Выполнена работа по созданию инструментов для измерения производительности пакета Globus Toolkit 3 в условиях высокой загрузки и параллелизма. – Разработана концепция и создано программное обеспечение для библиотеки Монте-Карло генераторов, названного GENSER, общего для всех четырех экспериментов LHC (lcgapp. cern. ch/project/simu/generator/).

LHC Computing Grid Project (LCG) Задачи на 2004 год: • LCG Deployment and Operation • LCG Testsuit • Castor • LCG AA- Genser&MCDB • ARDA

JINR in LCG (2004 and 2005 years) • LCG 2 infrastructure was created at JINR • The server for monitoring Russian LCG sites was installed; • LCG web-portal was created in Russia and now its development is in progress: • Tests on data transferring by the Grid. FTP protocol (Globus. Toookit 3) were made. • the toolkit Go. To. Grid on the automatic installation and tuning of the LCG-2 package was developed; • development of the MCDB system; • software for installation and control of Mona. Lisa clients on the base of RMS (Remote Maintenance Shell) was designed. • Works to develop CASTOR 2 system was in progress: development of the control process of the garbage collection module, communication to Oracle DB; • participation in the work to create the TESTBED of the new g. Lite middleware; • Testing of next components g. Lite: Metadata catalog, Fireman catalog • Monitoring of WMS (Workload Management System) g. Lite testbed in INFN site gundam. cnaf. infn. it

EGEE (Enabling Grids for E-science in Europe) Цель проекта EGEE создание Грид инфраструктуры по всей Европе, доступной 24 часа в сутки. Ключевые направления проекта: - формирование согласованной, устойчивой и защищённой вычислительной сети; - совершенствование программных средств middleware с целью обеспечения надежного обслуживания пользователей; привлечение новых пользователей из других сфер деятельности и обеспечение им высокого стандарта обучения и поддержки.

EGEE и другие GRID - проекты Какое отношение имеет EGEE к существующим гридам и исследовательским сетям? Инфраструктура EGEE строится на базе исследовательской сети Европейского союза (ЕС) GEANT и в ней используется опыт, накопленный в таких проектах, как Data. Grid, Datatag, Crossgrid, поддержанных ЕС, в национальных проектах, например, e-Science (Британия), INFN Grid, Nordugrid и американском Trillium. Она обеспечит возможность совместной работы с другими системами во всём мире, включая США и Азию, что будет способствовать установлению всемирной GRID-инфраструктуры.

Функциональность проекта EGEE • Упрощённый доступ. • • EGEE уменьшит издержки, связанные с разнообразием не связанных между собой систем учёта пользователей. Пользователи смогут объединяться в виртуальные организации с доступом к grid – инфраструктуре, содержащей нужные каждому пользователю рабочие ресурсы. Выполнение вычислений по требованию. Эффективно распределяя ресурсы, grid-технологии значительно сокращает время ожидания доступа к ним. Географически распределённый доступ. Инфраструктура будет доступна отовсюду, где обеспечена хороший доступ к сети. Ресурсы становятся широко доступными. • Исключительно большой объём ресурсов. Благодаря согласованности ресурсов и пользовательских групп, в прикладной работе в рамках EGEE будут доступны ресурсы таких объёмов, какие не может предоставить ни один компьютерный центр. • Совместное использование программного обеспечения и данных. Благодаря единой структуре вычислительных средств, в EGEE пользователям будет легко совместно использовать программное обеспечение и базы данных и разрабатывать программное обеспечение. • Высокий уровень поддержки приложений. Компетентность всех участников EGEE обеспечит тщательную, всестороннюю поддержку всех основных приложений.

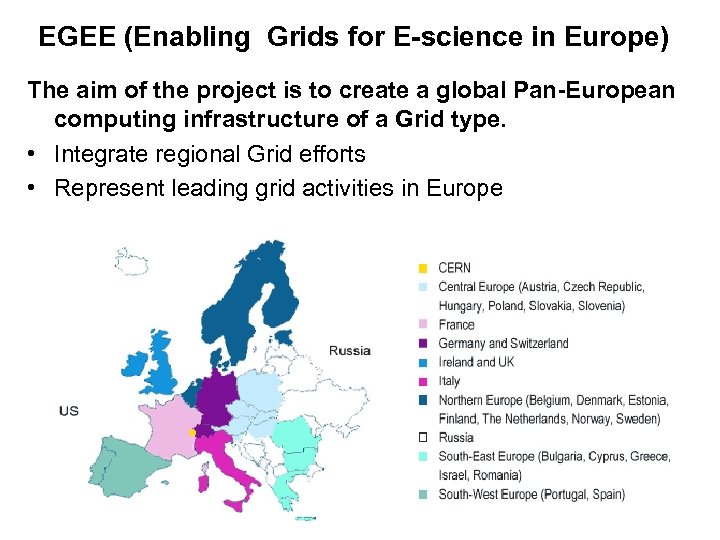

EGEE (Enabling Grids for E-science in Europe) The aim of the project is to create a global Pan-European computing infrastructure of a Grid type. • Integrate regional Grid efforts • Represent leading grid activities in Europe

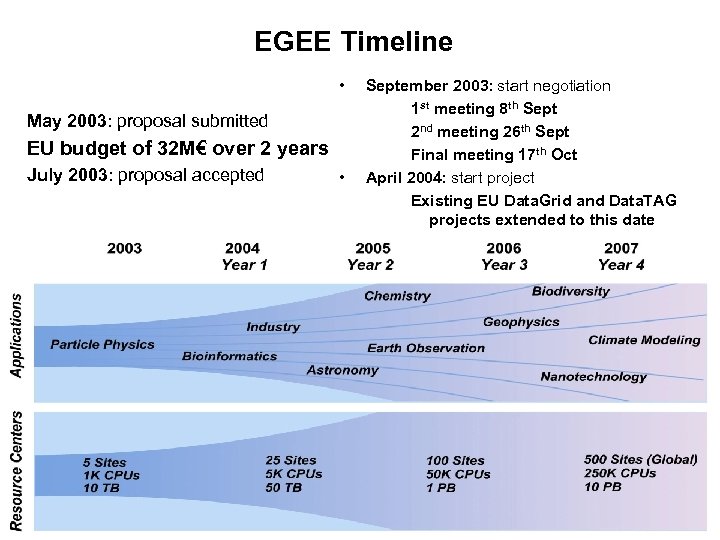

EGEE Timeline • May 2003: proposal submitted EU budget of 32 M€ over 2 years July 2003: proposal accepted • September 2003: start negotiation 1 st meeting 8 th Sept 2 nd meeting 26 th Sept Final meeting 17 th Oct April 2004: start project Existing EU Data. Grid and Data. TAG projects extended to this date

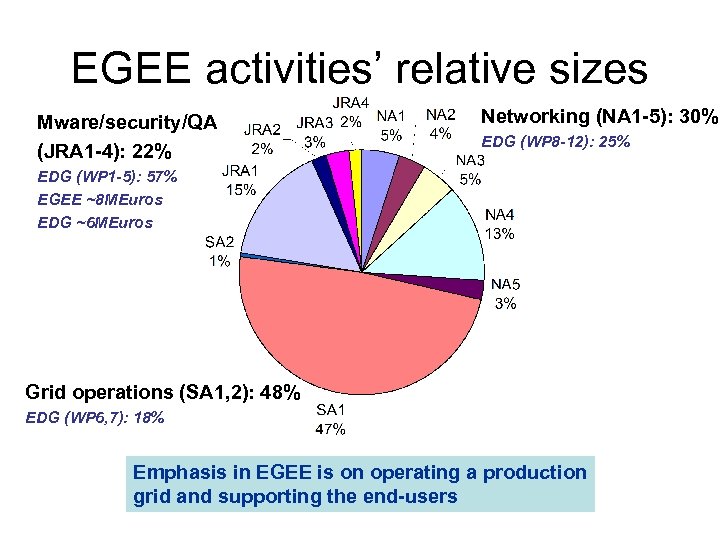

EGEE activities’ relative sizes Mware/security/QA (JRA 1 -4): 22% Networking (NA 1 -5): 30% EDG (WP 8 -12): 25% EDG (WP 1 -5): 57% EGEE ~8 MEuros EDG ~6 MEuros Grid operations (SA 1, 2): 48% EDG (WP 6, 7): 18% Emphasis in EGEE is on operating a production grid and supporting the end-users

Federating Worldwide Resources for the LHC

МЕМОРАНДУМ о создании в России компьютерной инфраструктуры GRID В целях обеспечения полномасштабного участия России в проекте создания глобальной (паневропейской) компьютерной инфраструктуры типа ГРИД – EGEE (Enabling Grids for E-science in Europe), принятом к финансированию летом 2003 года Европейской Комиссией (6 -я Рамочная программа, проект 508833), и реализации отечественных приоритетов в этом международном проекте, нижеподписавшиеся Институты, участвующие в данном проекте, образовали консорциум РДИГ (Российский ГРИД для интенсивных операций с данными – Russian Data Intensive GRID, RDIG) для эффективного выполнения работ по проекту и развитию в России инфраструктуры EGEE, с вовлечением на следующих этапах проекта других организаций из различных областей науки, образования и промышленности…

Russian Data Intensive GRID (RDIG) Consortium EGEE Federation • ИФВЭ (Институт физики высоких энергий, Протвино) – Петухов В. А. • ИМПБ (Институт математических проблем биологии, Пущино) – Лахно В. Д. • ИТЭФ (Институт теоретической и экспериментальной физики) – Гаврилов В. Б. • ОИЯИ (Объединенный институт ядерных исследований, Дубна) – Кореньков В. В. • ИПМ (Институт прикладной математики) – Корягин Д. А. • ПИЯФ (Петербургский институт ядерной физики, Гатчина) – Рябов Ю. Ф. • ИАЭ (Институт атомной энергии) – Солдатов А. А. • НИИЯФ МГУ (Научно-исследовательский институт ядерной физики МГУ) – Ильин В. А.

Russian Contribution to EGEE RDIG as an operational and functional part of EGEE infrastructure (CIC, ROC, RC). Activities: SA 1 - European Grid Operations, Support and Management (A. Kryukov, Y. Lazin) SA 2 – Network Resource Provision (V. Dobrecov) NA 2 – Dissemination and Outreach (T. Strizh) NA 3 – User Training and Induction (E. Slabospitskaya) NA 4 - Application Identification and Support (E. Tikhonenko)

JINR role and work in EGEE • SA 1 - European Grid Operations, Support and Management EGEE-RDIG monitoring and accounting. Middleware deployment and resource induction. Participation in the OMII and GT 4 evaluation and in the g. Lite testing. LCG SC activity coordination in Russia. • NA 2 - Dissemination and Outreach Coordination of this activity in Russia, organization of EGEE RDIG Conference, Creation and run the RDIG Web site (http: //www. egee-rdig. ru), dissemination in JINR Member states. • NA 3 - User Training and Induction Organization of grid tutorials, induction courses and training courses for administrators. • NA 4 - Application Identification and Support Coordination of this activity in Russia, organization of HEP applications in Russia through the EGEE infrastructure.

Russian Data. Grid Certification Authority http: //lhc. sinp. msu. ru/CA/

http: //ussup. itep. ru/

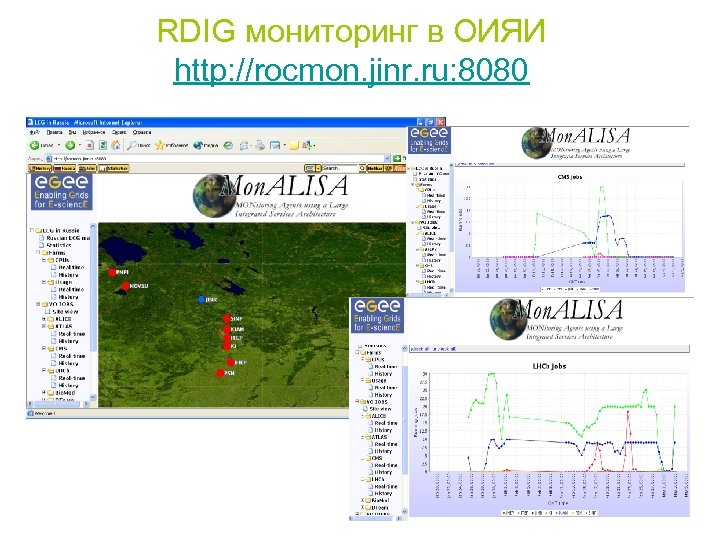

RDIG мониторинг в ОИЯИ http: //rocmon. jinr. ru: 8080

Grid middleware evaluations • The goal of the evaluations is to get a better understanding of the functionality, performance, solidity, interoperability, deployability, management and usability of components in different grid MW distributions • Aid decision about possible usage of components for the EGEE MW and about provision of interoperability between these distributions and the EGEE MW • Evaluation of OMII distribution by JINR and KIAM in February - April 2005 • Evaluation of Globus Toolkit 4 by JINR, KIAM and SINP MSU in May - October 2005

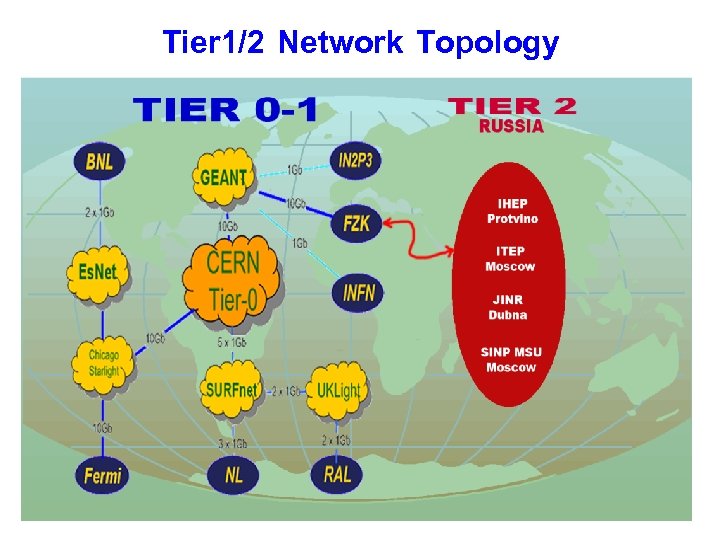

Tier 1/2 Network Topology

RDIG WEB Main web-pages: http: //www. egee-rdig. ru (English/Russian) Dubna, JINR http: //egee. sinp. msu. ru (English/Russian) Moscow, SINP MSU http: //www. gridclub. ru (Russian) Moscow, KIAM RAS http: //www. ihep. su/egee (Russian) Protvino IHEP http: //www. jcbi. ru/prez/egee. shtml Russian www. impb. ru/egee Russian/English (not all) Pushchino, IMPB RAS http: //egee. pnpi. nw. ru Russian, Gatchina, PNPI RAS http: //egee. itep. ru Russian/English, Moscow, ITEP http: //rdig-registrar. sinp. msu. ru Technical site, Russian, Moscow, SINP MSU http: //www. grid. kiae. ru Russian, Moscow, RRC KI

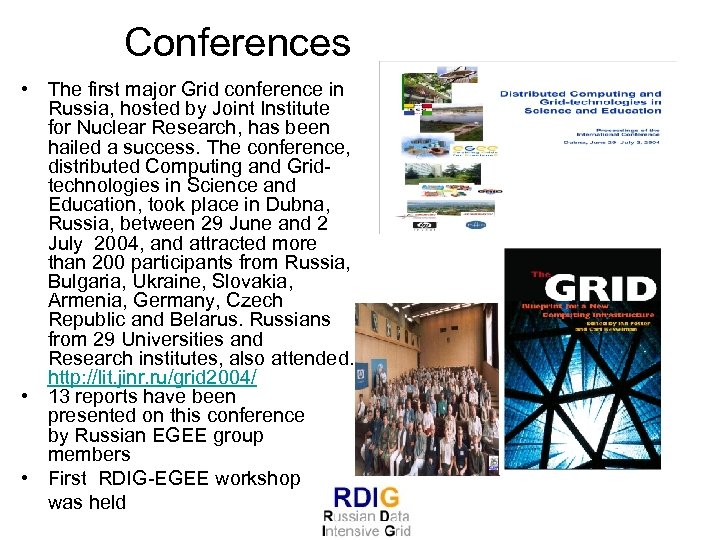

Conferences • The first major Grid conference in Russia, hosted by Joint Institute for Nuclear Research, has been hailed a success. The conference, distributed Computing and Gridtechnologies in Science and Education, took place in Dubna, Russia, between 29 June and 2 July 2004, and attracted more than 200 participants from Russia, Bulgaria, Ukraine, Slovakia, Armenia, Germany, Czech Republic and Belarus. Russians from 29 Universities and Research institutes, also attended. http: //lit. jinr. ru/grid 2004/ • 13 reports have been presented on this conference by Russian EGEE group members • First RDIG-EGEE workshop was held

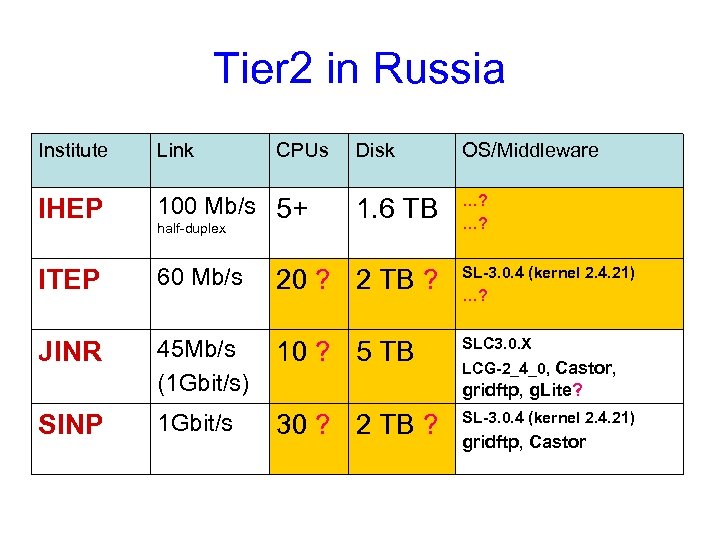

Tier 2 in Russia Institute Link IHEP 100 Mb/s 5+ ITEP 60 Mb/s 20 ? 2 TB ? SL-3. 0. 4 (kernel 2. 4. 21) …? JINR 45 Mb/s (1 Gbit/s) 10 ? 5 TB SLC 3. 0. X 1 Gbit/s 30 ? 2 TB ? SINP half-duplex CPUs Disk OS/Middleware 1. 6 TB …? …? LCG-2_4_0, Castor, gridftp, g. Lite? SL-3. 0. 4 (kernel 2. 4. 21) gridftp, Castor

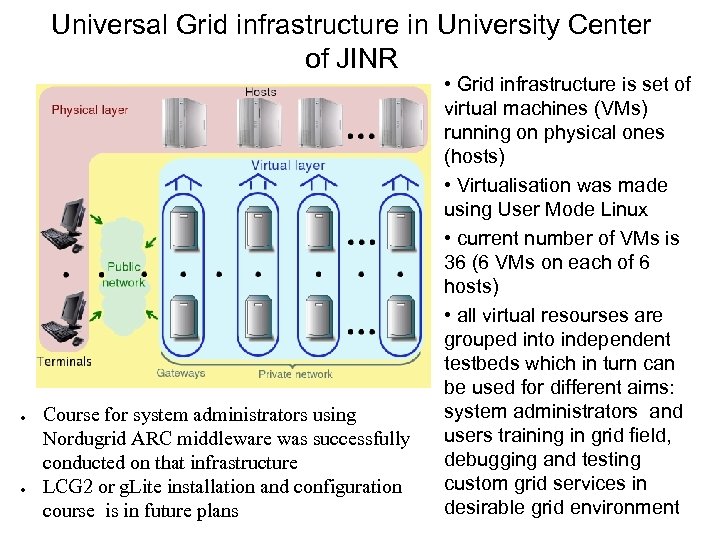

Universal Grid infrastructure in University Center of JINR ● ● Course for system administrators using Nordugrid ARC middleware was successfully conducted on that infrastructure LCG 2 or g. Lite installation and configuration course is in future plans • Grid infrastructure is set of virtual machines (VMs) running on physical ones (hosts) • Virtualisation was made using User Mode Linux • current number of VMs is 36 (6 VMs on each of 6 hosts) • all virtual resourses are grouped into independent testbeds which in turn can be used for different aims: system administrators and users training in grid field, debugging and testing custom grid services in desirable grid environment

Useful References: • • • • GLOBAL GRID FORUM: //www. gridforum. org European GRID FORUM: //www. egrid. org GLOBUS: //www. globus. org PPDG: //www. ppdg. org IVDGL: //www. ivdgl. org OSG: //www. ivdgl. org/osg-int/ Gri. Phyn: //www. griphyn. org Condor: //www. cs. wisc. edu/condor TERAGRID: //www. teragrid. org EU DATAGRID: //www. eu-datagrid. org DATATAG: //www. datatag. org Cross. GRID: //www. crossgrid. org LCG: //lcg. web. cern. ch/LCG/ EGEE: //www. eu-egee. org EGEE-RDIG: //www. egee-rdig. ru GRIDCLUB: //www. gridclub. ru

702e821eaceaf73915119cb0a43c1feb.ppt