123.pptx

- Количество слайдов: 39

КОЛИЧЕСТВЕННЫЕ И КАЧЕСТВЕННЫЕ ХАРАКТЕРИСТИКИ ИНФОРМАЦИИ Лекция 1 -2 1

КОЛИЧЕСТВЕННЫЕ И КАЧЕСТВЕННЫЕ ХАРАКТЕРИСТИКИ ИНФОРМАЦИИ Лекция 1 -2 1

Количество информации рассматривают: • с поведенческой точки зрения создание порции информации осуществляется по некоторой причине, а получение этой информации может привести к некоторому результату (наблюдаемому действию или мыслительной операции); • с математико-лингвистической точки зрения порция информации может быть описана путем соотнесения ее с другой информацией, указания ее смысла и структуры; • с физико-технической точки зрения рассматриваются физические аспекты проявления информации ее материальный носитель, разрешающая способность и точность, с которыми она фиксируется, количество информации, которое производится, передается или Лекция 1 -2 2 принимается и т. д.

Количество информации рассматривают: • с поведенческой точки зрения создание порции информации осуществляется по некоторой причине, а получение этой информации может привести к некоторому результату (наблюдаемому действию или мыслительной операции); • с математико-лингвистической точки зрения порция информации может быть описана путем соотнесения ее с другой информацией, указания ее смысла и структуры; • с физико-технической точки зрения рассматриваются физические аспекты проявления информации ее материальный носитель, разрешающая способность и точность, с которыми она фиксируется, количество информации, которое производится, передается или Лекция 1 -2 2 принимается и т. д.

Подходы к оценке информации: • статистический • семантический • прагматический Лекция 1 -2 3

Подходы к оценке информации: • статистический • семантический • прагматический Лекция 1 -2 3

• Статистический подход представлен в разделе кибернетики теории информации, которая занимается математическим описанием и оценкой методов передачи, хранения, извлечения и классификации информации. • Предполагается, что до получения информации имела место некоторая неопределенность. С получением информации эта неопределенность снимается. • Статистическая количественная характеристика информации это мера снимаемой в процессе получения информации неопределенности системы. • Количественной мерой информации стала энтропия Лекция 1 -2 4

• Статистический подход представлен в разделе кибернетики теории информации, которая занимается математическим описанием и оценкой методов передачи, хранения, извлечения и классификации информации. • Предполагается, что до получения информации имела место некоторая неопределенность. С получением информации эта неопределенность снимается. • Статистическая количественная характеристика информации это мера снимаемой в процессе получения информации неопределенности системы. • Количественной мерой информации стала энтропия Лекция 1 -2 4

• Семантический подход базируется на смысловом содержании информации. • Под семантикой понимают комплекс научных теорий, изучающих свойства знаковых систем, т. е. систем конкретных или абстрактных объектов, с каждым из которых сопоставлено некоторое значение. • Примерами знаковых систем являются естественные языки, а так же искусственные языки, такие как алгоритмические языки, языки программирования, информационные языки и др. Лекция 1 -2 5

• Семантический подход базируется на смысловом содержании информации. • Под семантикой понимают комплекс научных теорий, изучающих свойства знаковых систем, т. е. систем конкретных или абстрактных объектов, с каждым из которых сопоставлено некоторое значение. • Примерами знаковых систем являются естественные языки, а так же искусственные языки, такие как алгоритмические языки, языки программирования, информационные языки и др. Лекция 1 -2 5

• Прагматический подход к информации базируется на анализе ее ценности, с точки зрения потребителя. • Прагматический подход оценивает содержательный аспект информации. • Имеет особое значение при использовании информации для управления, т. к. ее количество тесно связано с эффективностью управления в системе. Лекция 1 -2 6

• Прагматический подход к информации базируется на анализе ее ценности, с точки зрения потребителя. • Прагматический подход оценивает содержательный аспект информации. • Имеет особое значение при использовании информации для управления, т. к. ее количество тесно связано с эффективностью управления в системе. Лекция 1 -2 6

Статистическая мера количества информации Лекция 1 -2 7

Статистическая мера количества информации Лекция 1 -2 7

Информация – совокупность сведений о различных объектах, процессах, ситуациях, которая характеризует их с точки зрения тех или иных параметров, представляющих интерес для пользователя. Любая информация возникает в результате каких либо действий или опытов, которые производит получатель информации. Если после опыта получена информация, система становится более определенной. Исходную неопределенность можно рассматривать как энтропию. Лекция 1 -2 8

Информация – совокупность сведений о различных объектах, процессах, ситуациях, которая характеризует их с точки зрения тех или иных параметров, представляющих интерес для пользователя. Любая информация возникает в результате каких либо действий или опытов, которые производит получатель информации. Если после опыта получена информация, система становится более определенной. Исходную неопределенность можно рассматривать как энтропию. Лекция 1 -2 8

Энтропия (от греч. entropia поворот, превращение) Понятие энтропии мера неопределенности состояния любой системы. Чем больше энтропия системы, тем больше неопределенность ее состояния и тем большую информацию получаем, когда эта неопределенность снимается. Лекция 1 -2 9

Энтропия (от греч. entropia поворот, превращение) Понятие энтропии мера неопределенности состояния любой системы. Чем больше энтропия системы, тем больше неопределенность ее состояния и тем большую информацию получаем, когда эта неопределенность снимается. Лекция 1 -2 9

Информация фиксируется получателем в виде понятных ему сигналов. Сигнал – некоторый материальный переносчик энергии, на который “нанесена” информация так, что она может быть воспринята получателем. Лекция 1 -2 10

Информация фиксируется получателем в виде понятных ему сигналов. Сигнал – некоторый материальный переносчик энергии, на который “нанесена” информация так, что она может быть воспринята получателем. Лекция 1 -2 10

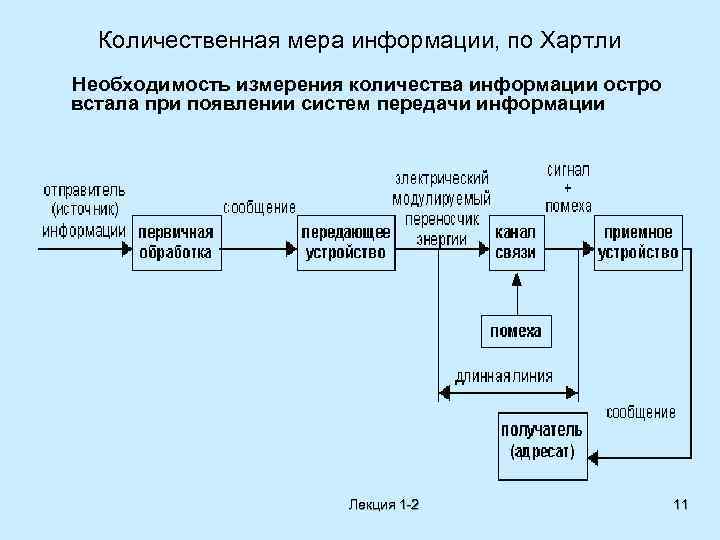

Количественная мера информации, по Хартли Необходимость измерения количества информации остро встала при появлении систем передачи информации Лекция 1 -2 11

Количественная мера информации, по Хартли Необходимость измерения количества информации остро встала при появлении систем передачи информации Лекция 1 -2 11

В любой системе передачи обязательно существует преобразование сообщения в сигнал, которое должно быть взаимно однозначным. Для обеспечения однозначности используются дискретные сигналы из n элементарных (единичных) сигналов. Единичный сигнал занимает, как правило, одну временную позицию. Каждый элементарный сигнал может иметь K различных значений. Величина K зависит от способов модуляции. Лекция 1 -2 12

В любой системе передачи обязательно существует преобразование сообщения в сигнал, которое должно быть взаимно однозначным. Для обеспечения однозначности используются дискретные сигналы из n элементарных (единичных) сигналов. Единичный сигнал занимает, как правило, одну временную позицию. Каждый элементарный сигнал может иметь K различных значений. Величина K зависит от способов модуляции. Лекция 1 -2 12

Если используются дискретные сигналы, характеризуемые длиной сообщения n и основанием системы счисления K (как правило, K = 2), то должно выполняться условие: М ≤ Кn , где M – число сообщений. Можно прийти к заключению, что Кn – количество информации. Лекция 1 -2 13

Если используются дискретные сигналы, характеризуемые длиной сообщения n и основанием системы счисления K (как правило, K = 2), то должно выполняться условие: М ≤ Кn , где M – число сообщений. Можно прийти к заключению, что Кn – количество информации. Лекция 1 -2 13

Пусть имеется два источника сигнала К 1 = К 2 = 2, n 1 = 2, n 2 = 3 Тогда Но для Нужно выбрать такую меру, которая была бы пропорциональна числу элементарных сигналов в сообщении, то есть приращение количества информации составляло бы d. I=Kdn. Лекция 1 -2 14

Пусть имеется два источника сигнала К 1 = К 2 = 2, n 1 = 2, n 2 = 3 Тогда Но для Нужно выбрать такую меру, которая была бы пропорциональна числу элементарных сигналов в сообщении, то есть приращение количества информации составляло бы d. I=Kdn. Лекция 1 -2 14

Можно проделать следующие преобразования: Лекция 1 -2 15

Можно проделать следующие преобразования: Лекция 1 -2 15

• Эта формула была выведена Хартли в 1928 г. и носит название формулы Хартли. • Из формулы следует, что неопределенность в системе тем выше, чем больше M. Основание логарифма a можно выбрать произвольно. Наиболее часто встречаются следующие случаи: Лекция 1 -2 16

• Эта формула была выведена Хартли в 1928 г. и носит название формулы Хартли. • Из формулы следует, что неопределенность в системе тем выше, чем больше M. Основание логарифма a можно выбрать произвольно. Наиболее часто встречаются следующие случаи: Лекция 1 -2 16

Формула Хартли получена при ограничениях. 1. 2. Отсутствие смысловой ценности информации. M возможных состояний равновероятны: 3. 4. P = 1/M – вероятность появления одного сообщения. Между элементарными сигналами отсутствует корреляция, и все значения равновероятны. Утверждение об отсутствии корреляции следует из того, что для передачи сообщений используются все возможные сигналы. Равная вероятность всех K значений сигналов следует из формулы p=1/K – вероятность появления любого значения из K возможных. Лекция 1 -2 17

Формула Хартли получена при ограничениях. 1. 2. Отсутствие смысловой ценности информации. M возможных состояний равновероятны: 3. 4. P = 1/M – вероятность появления одного сообщения. Между элементарными сигналами отсутствует корреляция, и все значения равновероятны. Утверждение об отсутствии корреляции следует из того, что для передачи сообщений используются все возможные сигналы. Равная вероятность всех K значений сигналов следует из формулы p=1/K – вероятность появления любого значения из K возможных. Лекция 1 -2 17

• Возникают ситуации, в которых отмеченные выше ограничения не действуют, по этому для них формула Хартли дает неверные результаты. • Другое представление количества информации было найдено Клодом Шенноном примерно через 20 лет после опубликования формулы Хартли. Лекция 1 -2 18

• Возникают ситуации, в которых отмеченные выше ограничения не действуют, по этому для них формула Хартли дает неверные результаты. • Другое представление количества информации было найдено Клодом Шенноном примерно через 20 лет после опубликования формулы Хартли. Лекция 1 -2 18

Количество информации по Шеннону В ансамбле не указывается конкретное число сообщений, так как оно не имеет особого значения. Указываются только порядковые номера сообщений. Верхняя строка содержит номера поступающих сообщений, нижняя – вероятности их появления. Лекция 1 -2 19

Количество информации по Шеннону В ансамбле не указывается конкретное число сообщений, так как оно не имеет особого значения. Указываются только порядковые номера сообщений. Верхняя строка содержит номера поступающих сообщений, нижняя – вероятности их появления. Лекция 1 -2 19

Количество информации, которое содержится в i-м сообщении равно т. е. , чем менее вероятно сообщение, тем больше информации оно содержит. от частной ситуации равной вероятности сообщений, рассмотренной Хартли, Шеннон перешел к общему случаю Лекция 1 -2 20

Количество информации, которое содержится в i-м сообщении равно т. е. , чем менее вероятно сообщение, тем больше информации оно содержит. от частной ситуации равной вероятности сообщений, рассмотренной Хартли, Шеннон перешел к общему случаю Лекция 1 -2 20

Количество информации, которое содержит в среднем одно сообщение можно рассматривать как математическое ожидание Полученное выражение называется энтропией источника: Энтропия источника – среднее информации в одном сообщении. количество Не путать энтропию с количеством информации в одном конкретном сообщении Ii. Лекция 1 -2 21

Количество информации, которое содержит в среднем одно сообщение можно рассматривать как математическое ожидание Полученное выражение называется энтропией источника: Энтропия источника – среднее информации в одном сообщении. количество Не путать энтропию с количеством информации в одном конкретном сообщении Ii. Лекция 1 -2 21

Энтропия HИ характеризует источник сообщения. Аналогично можно получить и “энтропийную характеристику сигнала”. Каждое сообщение передается n сигналами, каждый из которых может принимать K значений. Будем считать, что в сигнале, которым передается i-е сообщение, содержится элементарных сигналов со значением j. Лекция 1 -2 22

Энтропия HИ характеризует источник сообщения. Аналогично можно получить и “энтропийную характеристику сигнала”. Каждое сообщение передается n сигналами, каждый из которых может принимать K значений. Будем считать, что в сигнале, которым передается i-е сообщение, содержится элементарных сигналов со значением j. Лекция 1 -2 22

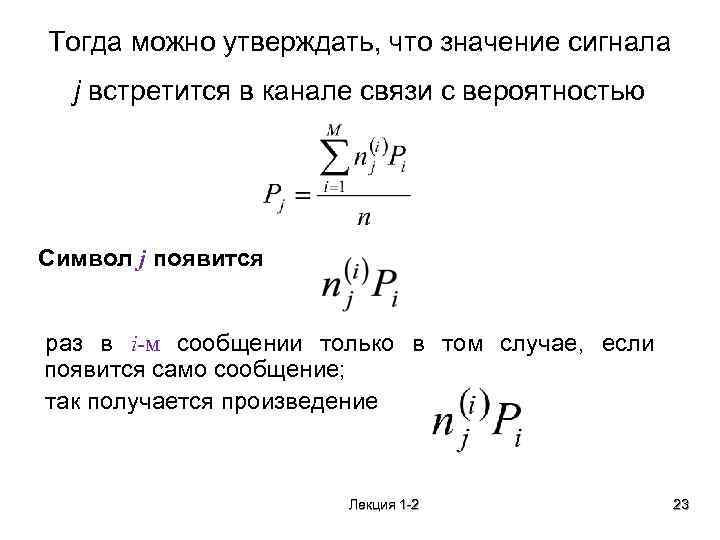

Тогда можно утверждать, что значение сигнала j встретится в канале связи с вероятностью Символ j появится раз в i м сообщении только в том случае, если появится само сообщение; так получается произведение Лекция 1 -2 23

Тогда можно утверждать, что значение сигнала j встретится в канале связи с вероятностью Символ j появится раз в i м сообщении только в том случае, если появится само сообщение; так получается произведение Лекция 1 -2 23

По Хартли информационная емкость сигнала зависит от n и K: где 1/K – вероятность появления любого сообщения из возможных. Лекция 1 -2 24

По Хартли информационная емкость сигнала зависит от n и K: где 1/K – вероятность появления любого сообщения из возможных. Лекция 1 -2 24

Шеннон оценил среднее значение количества информации где HC – энтропия одного элементарного сигнала, который имеет K рабочих значений разной вероятности. Лекция 1 -2 25

Шеннон оценил среднее значение количества информации где HC – энтропия одного элементарного сигнала, который имеет K рабочих значений разной вероятности. Лекция 1 -2 25

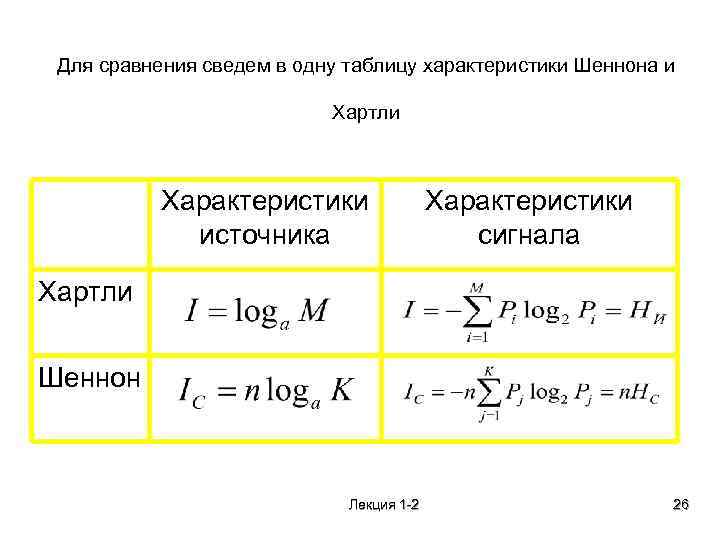

Для сравнения сведем в одну таблицу характеристики Шеннона и Хартли Характеристики источника Характеристики сигнала Хартли Шеннон Лекция 1 -2 26

Для сравнения сведем в одну таблицу характеристики Шеннона и Хартли Характеристики источника Характеристики сигнала Хартли Шеннон Лекция 1 -2 26

Свойства энтропии 1. Энтропия – величина существенно положительная, так как логарифм от величины, меньшей единицы, есть величина отрицательная. Кроме того следует учесть “-” перед знаком суммы в формуле для определения энтропии. Следует также отметить, что информация источника, характеристикой которой является энтропия, полезна, то есть положительна. 2. Если хотя бы одна из вероятностей P равна единице, то HИ = 0, HC = 0. В этом случае: 3. HИ или HC имеют максимум при условии P 1 = P 2 =…= Pn для HИ и P 1 = P 2 =…= PK для HC. Таким образом, формулы Хартли отображают Лекция 1 -2 27

Свойства энтропии 1. Энтропия – величина существенно положительная, так как логарифм от величины, меньшей единицы, есть величина отрицательная. Кроме того следует учесть “-” перед знаком суммы в формуле для определения энтропии. Следует также отметить, что информация источника, характеристикой которой является энтропия, полезна, то есть положительна. 2. Если хотя бы одна из вероятностей P равна единице, то HИ = 0, HC = 0. В этом случае: 3. HИ или HC имеют максимум при условии P 1 = P 2 =…= Pn для HИ и P 1 = P 2 =…= PK для HC. Таким образом, формулы Хартли отображают Лекция 1 -2 27

Доказательство: - функции многих вероятностей. Вычислим частные производные λ – множитель Лагранжа. Лекция 1 -2 28

Доказательство: - функции многих вероятностей. Вычислим частные производные λ – множитель Лагранжа. Лекция 1 -2 28

• При таком значении вероятности, одинаковом для всех сообщений, существует экстремум (максимум либо минимум). Из определения ансамбля • Вероятность • по условию сообщения i, не зависит Лекция 1 -2 от номера 29

• При таком значении вероятности, одинаковом для всех сообщений, существует экстремум (максимум либо минимум). Из определения ансамбля • Вероятность • по условию сообщения i, не зависит Лекция 1 -2 от номера 29

поэтому сумма вероятностей определяется выражением Лекция 1 -2 30

поэтому сумма вероятностей определяется выражением Лекция 1 -2 30

Связь между энтропией источника и энтропией сигнала Очевидно, для возможности передачи информации от источника с помощью сигнала необходимо выполнение соотношения: HИ ≤ n. HC. При этом имеют место два случая: 1. HИ = n. HC – оптимальное согласование источника и сигнала; 2. HИ < n. HC – возможность передачи от источника большего количества информации (избыточный сигнал). Лекция 1 -2 31

Связь между энтропией источника и энтропией сигнала Очевидно, для возможности передачи информации от источника с помощью сигнала необходимо выполнение соотношения: HИ ≤ n. HC. При этом имеют место два случая: 1. HИ = n. HC – оптимальное согласование источника и сигнала; 2. HИ < n. HC – возможность передачи от источника большего количества информации (избыточный сигнал). Лекция 1 -2 31

• Существует возможность выбора другого, более короткого сигнала, так как HC ≠ HCmax. Для этого нужно сократить число единичных элементов в сигнале с n до m: HИ = m. HCmax. Лекция 1 -2 32

• Существует возможность выбора другого, более короткого сигнала, так как HC ≠ HCmax. Для этого нужно сократить число единичных элементов в сигнале с n до m: HИ = m. HCmax. Лекция 1 -2 32

• Такое преобразование возможно и в первом случае. В приведенном выражении m – минимально возможное количество элементарных сигналов, которое можно получить при наличии источника с энтропией HИ, или число информационных элементов. • Если n > m (HC < HCmax), то сигнал обладает избыточностью R: где k – число избыточных элементов Лекция 1 -2 33

• Такое преобразование возможно и в первом случае. В приведенном выражении m – минимально возможное количество элементарных сигналов, которое можно получить при наличии источника с энтропией HИ, или число информационных элементов. • Если n > m (HC < HCmax), то сигнал обладает избыточностью R: где k – число избыточных элементов Лекция 1 -2 33

Относительно избыточности можно сказать следующее: 1. R < 1; 2. избыточность показывает, на какое число элементов (элементарных сигналов) можно сократить (сжать) исходный сигнал. • Всякое укорочение сигнала является важным результатом для любой системы. Чем короче сигнал, тем выше скорость передачи информации, меньше вероятность искажения сигнала, больше его мощность, меньше материальные расходы. • Оптимальное число элементов m получаем при равенстве вероятностей появления различных сообщений. Лекция 1 -2 34

Относительно избыточности можно сказать следующее: 1. R < 1; 2. избыточность показывает, на какое число элементов (элементарных сигналов) можно сократить (сжать) исходный сигнал. • Всякое укорочение сигнала является важным результатом для любой системы. Чем короче сигнал, тем выше скорость передачи информации, меньше вероятность искажения сигнала, больше его мощность, меньше материальные расходы. • Оптимальное число элементов m получаем при равенстве вероятностей появления различных сообщений. Лекция 1 -2 34

• В современных системах обработки информации и управления существенное место занимает подготовка информации для принятия решения и сам процесс принятия решения в системе. • Здесь существенную помощь может оказать семантическая теория, позволяющая понять смысл и содержание информации, выражаемой на естественном языке. • С учетом ошибок, которые могут возникать в информации в связи с действиями оператора, отказами технических средств в др. , избыточность допускается лишь как средство борьбы с ошибками. • В этом смысле можно считать, что избыточность способствует сохранению ценности информации, обеспечивая требуемую верность. Лекция 1 -2 35

• В современных системах обработки информации и управления существенное место занимает подготовка информации для принятия решения и сам процесс принятия решения в системе. • Здесь существенную помощь может оказать семантическая теория, позволяющая понять смысл и содержание информации, выражаемой на естественном языке. • С учетом ошибок, которые могут возникать в информации в связи с действиями оператора, отказами технических средств в др. , избыточность допускается лишь как средство борьбы с ошибками. • В этом смысле можно считать, что избыточность способствует сохранению ценности информации, обеспечивая требуемую верность. Лекция 1 -2 35

В рамках семантического подхода ценность информации можно задать через функцию потерь. Если в процессе подготовки информации исходная величина х отображается через величину у, то минимум потерь можно установить как где Р(х) распределение входной величины х; П (х/у) - потери преобразовании входной величины х в величину у. Отсюда ценность информации определяется как М{П(х/у)} - математическое ожидание потерь при отклонении от входной величины х к величине у. Лекция 1 -2 36

В рамках семантического подхода ценность информации можно задать через функцию потерь. Если в процессе подготовки информации исходная величина х отображается через величину у, то минимум потерь можно установить как где Р(х) распределение входной величины х; П (х/у) - потери преобразовании входной величины х в величину у. Отсюда ценность информации определяется как М{П(х/у)} - математическое ожидание потерь при отклонении от входной величины х к величине у. Лекция 1 -2 36

ПРЕВРАЩЕНИЕ ИНФОРМАЦИИ В РЕСУРС Информационный ресурс концентрация имеющихся фактов, документов, данных и знаний, отражающих реальное изменяющееся во времени состояние общества, и используемых при подготовке кадров, в научных исследованиях и материальном производстве. Лекция 1 -2 37

ПРЕВРАЩЕНИЕ ИНФОРМАЦИИ В РЕСУРС Информационный ресурс концентрация имеющихся фактов, документов, данных и знаний, отражающих реальное изменяющееся во времени состояние общества, и используемых при подготовке кадров, в научных исследованиях и материальном производстве. Лекция 1 -2 37

• Факты результат наблюдения за состоянием предметной области. • Документы часть информации, определенным образом структурированная и занесенная на бумажный носитель. • Данные вид информации, отличающийся высокой степенью форматированности в отличие от более свободных структур, характерных для речевой, текстовой и визуальной информации. • Знания итог теоретической и практической деятельности человека, отражающий накопление предыдущего опыта и отличающийся высокой степенью структурированности. Лекция 1 -2 38

• Факты результат наблюдения за состоянием предметной области. • Документы часть информации, определенным образом структурированная и занесенная на бумажный носитель. • Данные вид информации, отличающийся высокой степенью форматированности в отличие от более свободных структур, характерных для речевой, текстовой и визуальной информации. • Знания итог теоретической и практической деятельности человека, отражающий накопление предыдущего опыта и отличающийся высокой степенью структурированности. Лекция 1 -2 38

Ø Можно выделить три основных вида знаний: üдекларативные (факторальные), представляющие общее описание объекта, что не позволяет использовать их без предварительной структуризации в конкретной предметной области; üпонятийные (системные), содержащие помимо первых, взаимосвязи между понятиями и свойства понятий; üпроцедурные (алгоритмические), позволяющие получить алгоритм решения. Лекция 1 -2 39

Ø Можно выделить три основных вида знаний: üдекларативные (факторальные), представляющие общее описание объекта, что не позволяет использовать их без предварительной структуризации в конкретной предметной области; üпонятийные (системные), содержащие помимо первых, взаимосвязи между понятиями и свойства понятий; üпроцедурные (алгоритмические), позволяющие получить алгоритм решения. Лекция 1 -2 39