ПРвИС-Лек-678.ppt

- Количество слайдов: 72

КЛАССИФИКАЦИЯ Классифици ровать объект — значит, указать номер (или наименование) класса, к которому относится данный объект.

Применение классификации и регрессии • В банковском деле - определение кредитного рейтинга клиентов • В розничной торговле – выделение групп покупателей • В военной технике – распознавать тип цели, обнаруживаемый радиолокатором (пасс. лайнер, бомбардировщик, истребитель и т. д. ) • В медицине – диагностировать заболевания на основе симптомов. • В правоохранительной деятельности – выявления мошенических действий.

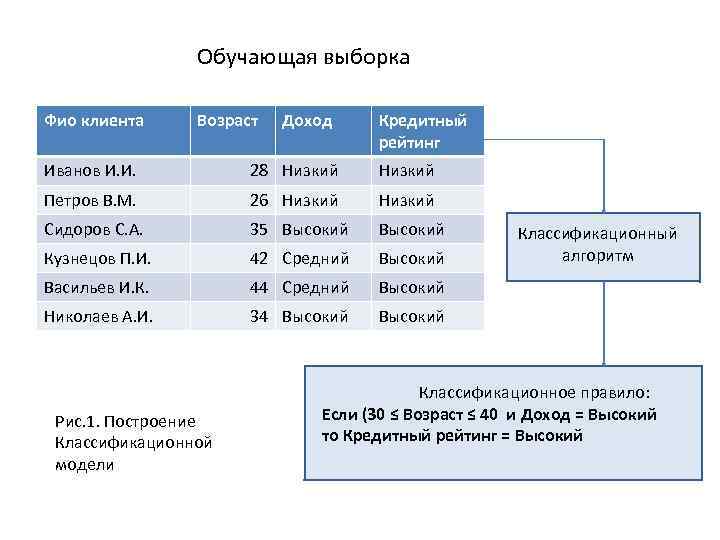

Как классификационная, так и регрессионная модель находят закономерности между входными и выходными переменными. Но если входные и выходные переменные модели непрерывные – перед нами задача регрессии. Классификацию данных можно рассматривать как процесс, состоящий из двух этапов. На первом этапе строится модель, описывающая предварительно определенный набор классов или категорий. Модель строится на основе анализа записей множества данных, содержащих признаки (атрибуты) объектов и соответствующую им метку класса. Такое множество называется обучающей выборкой (рис. 1).

Обучающая выборка Фио клиента Возраст Доход Кредитный рейтинг Иванов И. И. 28 Низкий Петров В. М. 26 Низкий Сидоров С. А. 35 Высокий Кузнецов П. И. 42 Средний Высокий Васильев И. К. 44 Средний Высокий Николаев А. И. 34 Высокий Рис. 1. Построение Классификационной модели Классификационный алгоритм Классификационное правило: Если (30 ≤ Возраст ≤ 40 и Доход = Высокий то Кредитный рейтинг = Высокий

На втором этапе модель применяется для классификации новых, ранее неизвестных объектов и наблюдений. Перед этим оценивается точность построения классификационной модели. Для этого случайным образом выбирается подмножество примеров (5 – 10%) и подаются на вход для проверки результатов обучения. Если установлено, что модель обладает приемлемой точностью и достаточной обобщающей способностью, то ее можно использовать для классификации новых наблюдений или объектов, для которых класс еще неизвестен.

Тестовый набор Фио клиента Возраст Доход Кредитный рейтинг Иванов И. И. 28 Низкий Петров В. М. 26 Низкий Сидоров С. А. 35 Высокий Рис. 2. Классификация новых данных Классификационное правило Новое наблюдение: Возраст = 36 Доход = Высокий, => Кредитный рейтинг = Высокий

Обзор методов классификации и регрессии Статистические методы: • Линейная регрессия • Логистическая регрессия • Байесовская классификация и др. Методы машинного обучения: • Деревья решений, • Решающие правила • Нейронные сети • Метод k ближайших соседей и др.

В основе деревьев решений лежат решающие правила вида «если…то…. » , которые могут быть сформулированы на естественном языке. Табл. 1. Понятия, встречающиеся в теории деревьев решений Название Описание Объект Пример, шаблон, наблюдение, запись Атрибут Признак, свойство Метка класса Переменная Узел дерева Лист Конечный узел дерева Проверка Условие в узле В основе работы ДР лежит процесс рекурсивного разбиения исходного множества наблюдений или объектов на подмножества, ассоциированные с классами.

Для эффективного построения дерева решений должны выполнятся следующие условия: • Описание атрибутов. Анализируемые данные должны быть представлены совокупностью атрибутов. • Предварительное определение классов. Обучение с учителем. • Различимость классов. • Полнота данных. Обучающее множество должно содержать достаточно большое количество примеров.

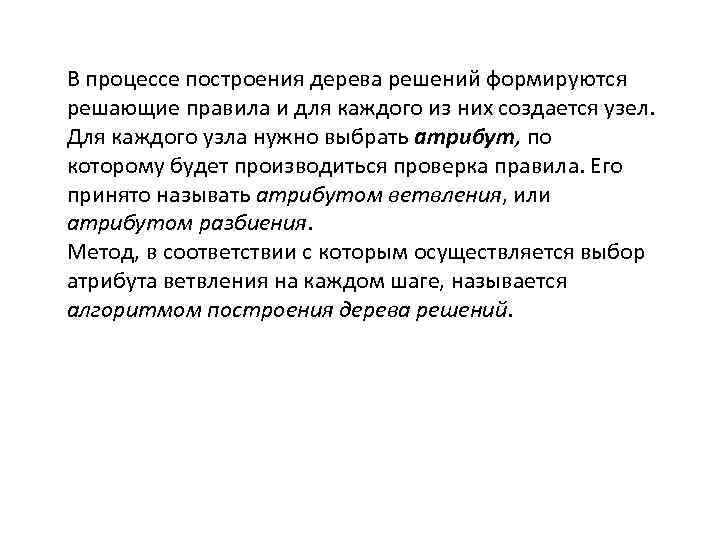

В процессе построения дерева решений формируются решающие правила и для каждого из них создается узел. Для каждого узла нужно выбрать атрибут, по которому будет производиться проверка правила. Его принято называть атрибутом ветвления, или атрибутом разбиения. Метод, в соответствии с которым осуществляется выбор атрибута ветвления на каждом шаге, называется алгоритмом построения дерева решений.

Структура дерева решений Корневой узел Узел Лист Узел Лист Узлы и листья в дереве решений Узлы (node), листья (leaf)

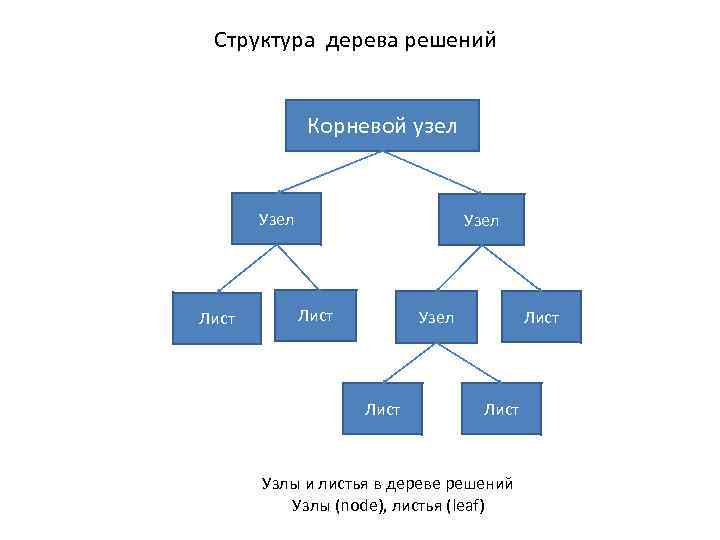

Рис. 4. Различные варианты разбиений Исходное множество Плохое разбиение Хорошее разбиение

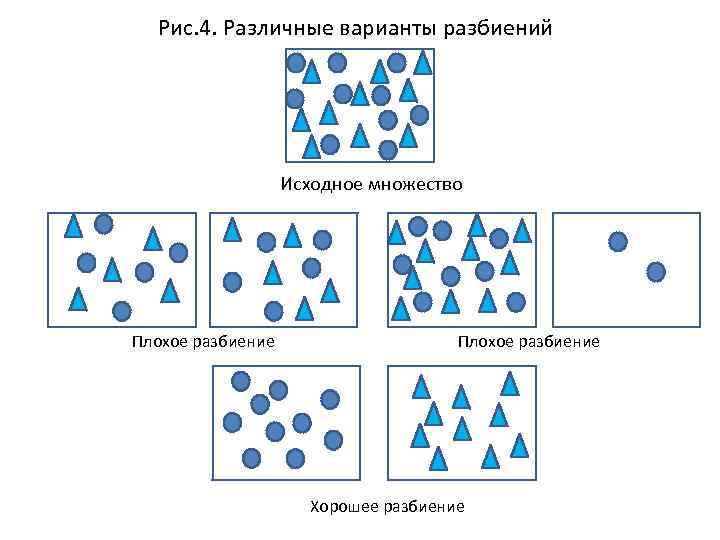

Выходная (целевая) переменная Категориальная Индекс Джини Информационный критерий Критерий хи-квадрат Непрерывная Уменьшение дисперсии F-тест Информационный критерий Рис. 7. Критерии разбиения

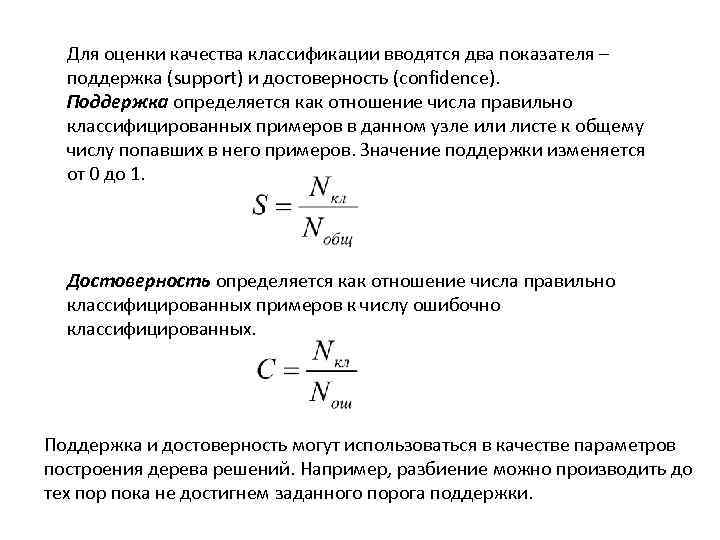

Для оценки качества классификации вводятся два показателя – поддержка (support) и достоверность (confidence). Поддержка определяется как отношение числа правильно классифицированных примеров в данном узле или листе к общему числу попавших в него примеров. Значение поддержки изменяется от 0 до 1. Достоверность определяется как отношение числа правильно классифицированных примеров к числу ошибочно классифицированных. Поддержка и достоверность могут использоваться в качестве параметров построения дерева решений. Например, разбиение можно производить до тех пор пока не достигнем заданного порога поддержки.

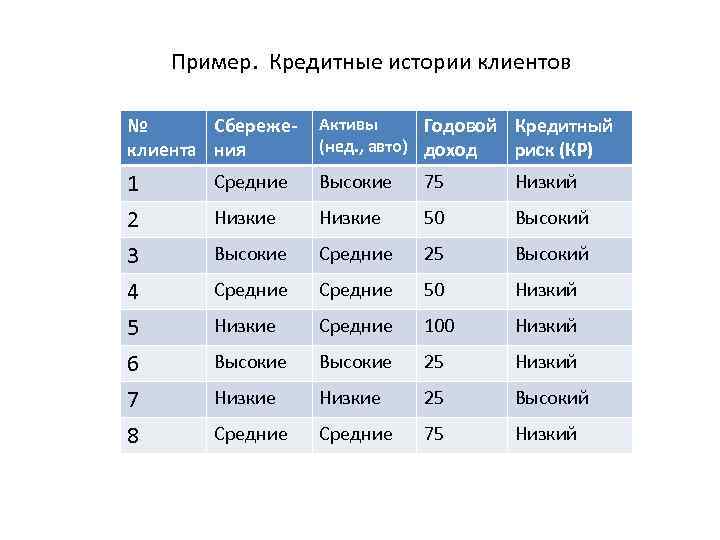

Пример. Кредитные истории клиентов № Сбережеклиента ния Активы Годовой Кредитный (нед. , авто) доход риск (КР) 1 Средние Высокие 75 Низкий 2 Низкие 50 Высокий 3 Высокие Средние 25 Высокий 4 Средние 50 Низкий 5 Низкие Средние 100 Низкий 6 Высокие 25 Низкий 7 Низкие 25 Высокий 8 Средние 75 Низкий

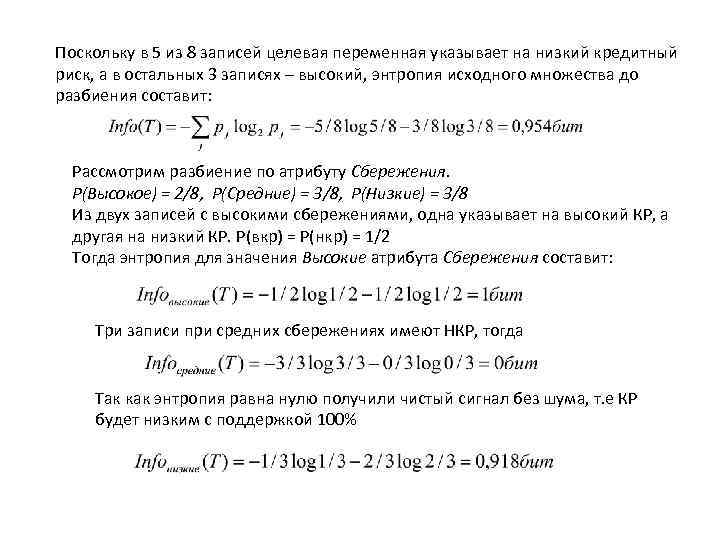

Поскольку в 5 из 8 записей целевая переменная указывает на низкий кредитный риск, а в остальных 3 записях – высокий, энтропия исходного множества до разбиения составит: Рассмотрим разбиение по атрибуту Сбережения. P(Высокое) = 2/8, P(Средние) = 3/8, P(Низкие) = 3/8 Из двух записей с высокими сбережениями, одна указывает на высокий КР, а другая на низкий КР. P(вкр) = P(нкр) = 1/2 Тогда энтропия для значения Высокие атрибута Сбережения составит: Три записи при средних сбережениях имеют НКР, тогда Так как энтропия равна нулю получили чистый сигнал без шума, т. е КР будет низким с поддержкой 100%

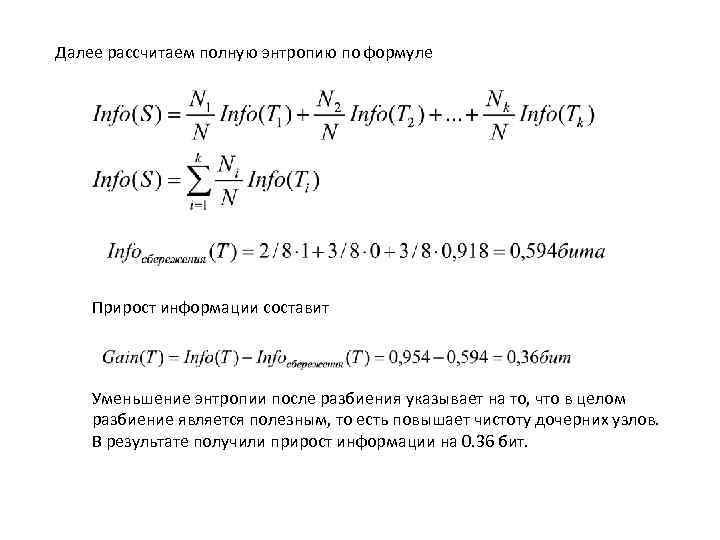

Далее рассчитаем полную энтропию по формуле Прирост информации составит Уменьшение энтропии после разбиения указывает на то, что в целом разбиение является полезным, то есть повышает чистоту дочерних узлов. В результате получили прирост информации на 0. 36 бит.

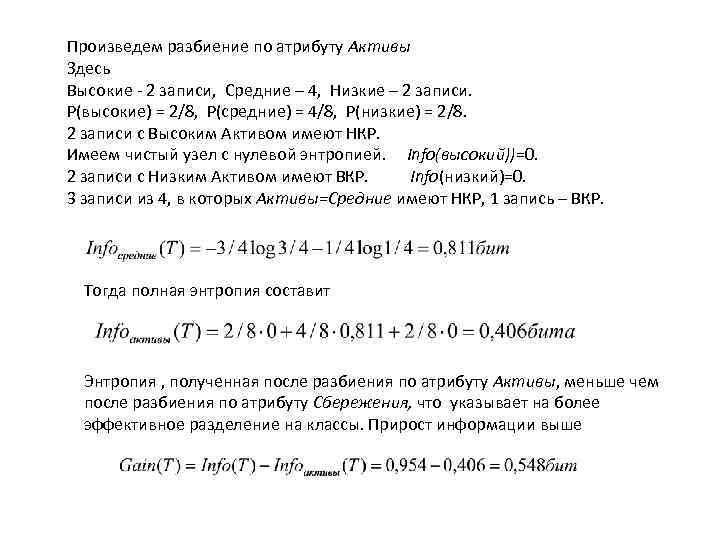

Произведем разбиение по атрибуту Активы Здесь Высокие - 2 записи, Средние – 4, Низкие – 2 записи. P(высокие) = 2/8, P(средние) = 4/8, P(низкие) = 2/8. 2 записи с Высоким Активом имеют НКР. Имеем чистый узел с нулевой энтропией. Info(высокий))=0. 2 записи с Низким Активом имеют ВКР. Info(низкий)=0. 3 записи из 4, в которых Активы=Средние имеют НКР, 1 запись – ВКР. Тогда полная энтропия составит Энтропия , полученная после разбиения по атрибуту Активы, меньше чем после разбиения по атрибуту Сбережения, что указывает на более эффективное разделение на классы. Прирост информации выше

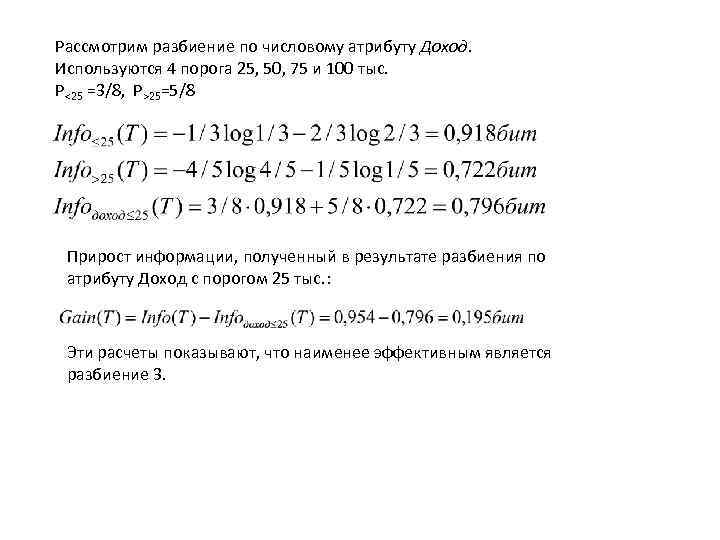

Рассмотрим разбиение по числовому атрибуту Доход. Используются 4 порога 25, 50, 75 и 100 тыс. P<25 =3/8, P>25=5/8 Прирост информации, полученный в результате разбиения по атрибуту Доход с порогом 25 тыс. : Эти расчеты показывают, что наименее эффективным является разбиение 3.

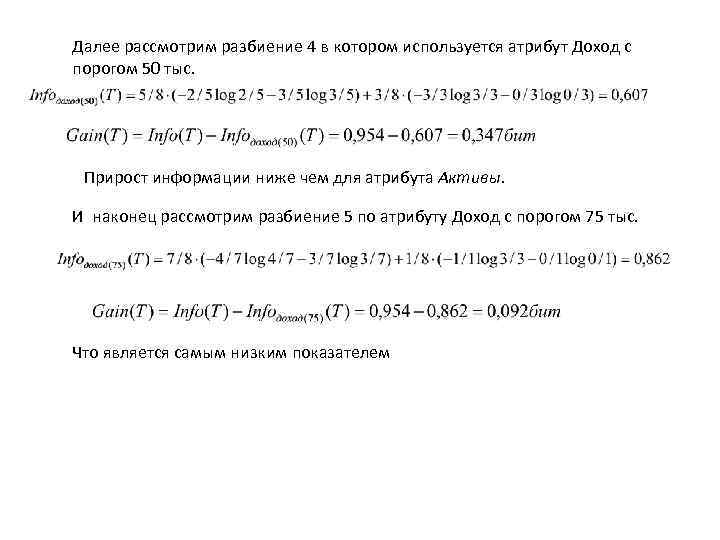

Далее рассмотрим разбиение 4 в котором используется атрибут Доход с порогом 50 тыс. Прирост информации ниже чем для атрибута Активы. И наконец рассмотрим разбиение 5 по атрибуту Доход с порогом 75 тыс. Что является самым низким показателем

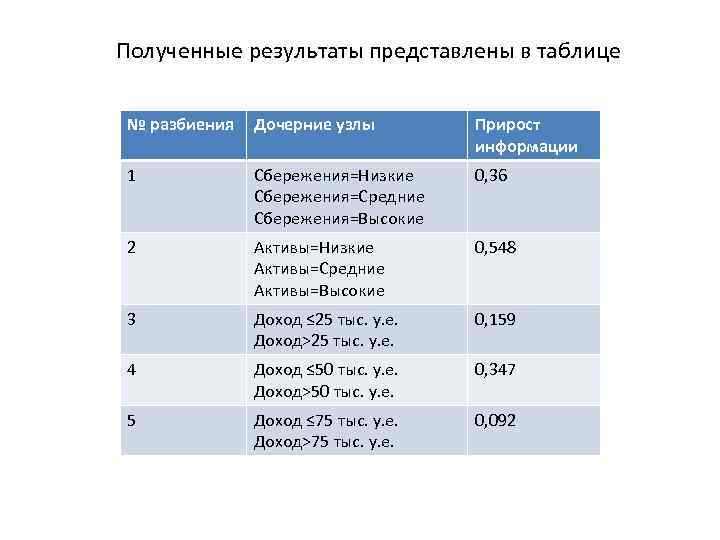

Полученные результаты представлены в таблице № разбиения Дочерние узлы Прирост информации 1 Сбережения=Низкие Сбережения=Средние Сбережения=Высокие 0, 36 2 Активы=Низкие Активы=Средние Активы=Высокие 0, 548 3 Доход ≤ 25 тыс. у. е. Доход>25 тыс. у. е. 0, 159 4 Доход ≤ 50 тыс. у. е. Доход>50 тыс. у. е. 0, 347 5 Доход ≤ 75 тыс. у. е. Доход>75 тыс. у. е. 0, 092

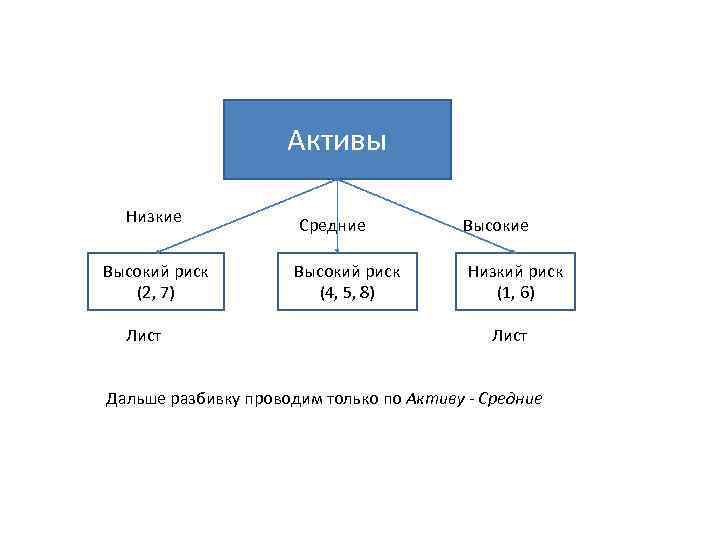

Активы Низкие Высокий риск (2, 7) Лист Средние Высокий риск (4, 5, 8) Низкий риск (1, 6) Лист Дальше разбивку проводим только по Активу - Средние

Множество T 1 № Сбережеклиента ния Активы Годовой Кредитный (нед. , авто) доход риск (КР) 3 Средние 25 Высокий 4 Средние 50 Низкий 5 Средние 100 Низкий 8 Средние 75 Низкий Здесь 1 един. запись с низкими сбережениями имеет и НКР 2 записи со средними сбережениями также имеет НКР 1 запись с высокими сбережениями имеет ВКР. Поэтому энтропия для всех 3 узлов равна 0.

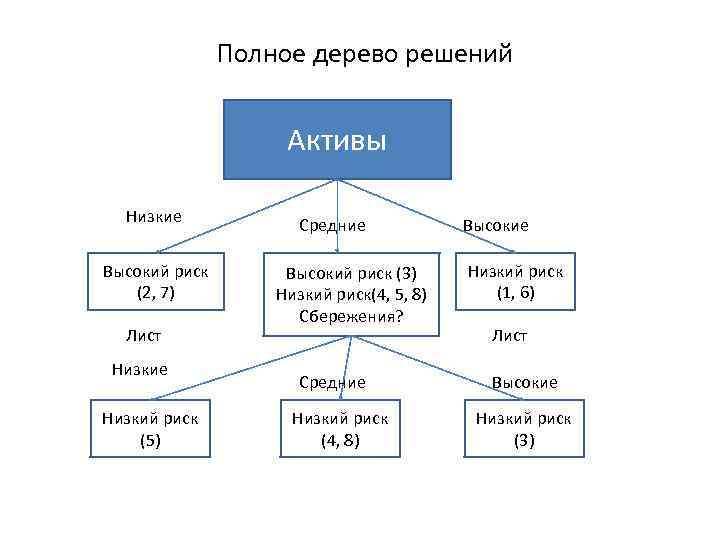

Полное дерево решений Активы Низкие Высокий риск (2, 7) Лист Низкие Низкий риск (5) Средние Высокий риск (3) Низкий риск(4, 5, 8) Сбережения? Средние Низкий риск (4, 8) Высокие Низкий риск (1, 6) Лист Высокие Низкий риск (3)

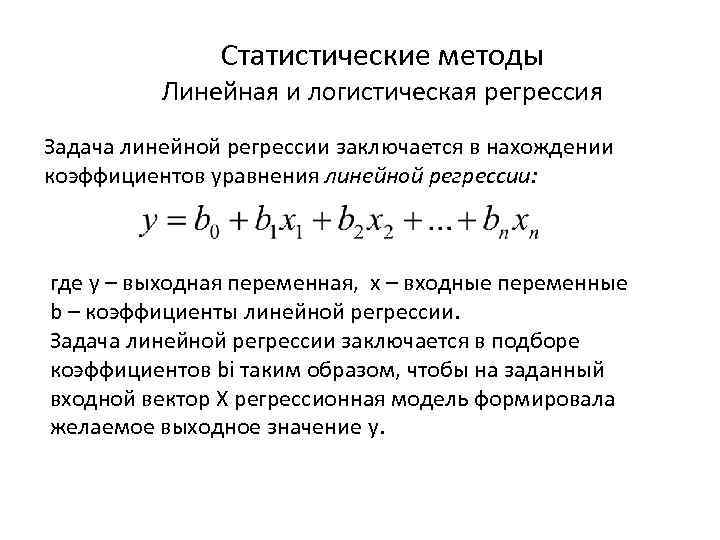

Статистические методы Линейная и логистическая регрессия Задача линейной регрессии заключается в нахождении коэффициентов уравнения линейной регрессии: где y – выходная переменная, x – входные переменные b – коэффициенты линейной регрессии. Задача линейной регрессии заключается в подборе коэффициентов bi таким образом, чтобы на заданный входной вектор X регрессионная модель формировала желаемое выходное значение y.

Одним из наиболее востребованных приложений линейной регрессии является прогнозирование. В этом случае входными переменными модели xi являются наблюдения из прошлого, а y – прогнозируемое значение. Иногда , выходная переменная может быть категориальной или бинарной. В этом случае используется логистическая регрессия, предназначенная для предсказания зависимой переменной, принимающей значения в интервале от 0 до 1. Здесь возможны два варианта. • Выходная переменная бинарная: 1 – успех, 0 – неуспех. • Выходная переменная непрерывная в диапазоне [0, 1]. В этом случае задача будет заключатся в оценке вероятности появления определенного события. Для определения этих вероятностей используется логистическая регрессия.

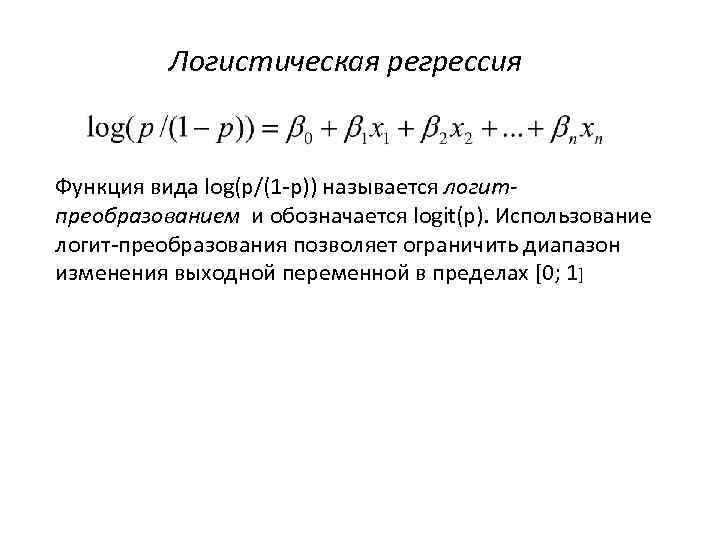

Логистическая регрессия Функция вида log(p/(1 -p)) называется логитпреобразованием и обозначается logit(p). Использование логит-преобразования позволяет ограничить диапазон изменения выходной переменной в пределах [0; 1]

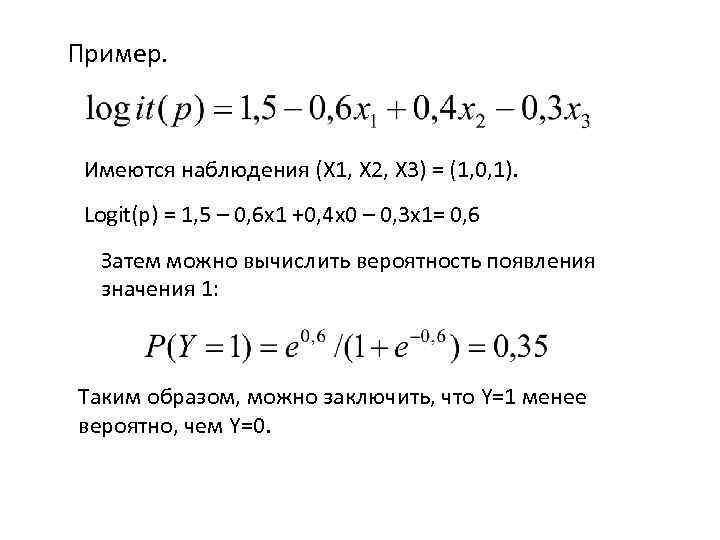

Пример. Имеются наблюдения (X 1, X 2, X 3) = (1, 0, 1). Logit(p) = 1, 5 – 0, 6 x 1 +0, 4 x 0 – 0, 3 x 1= 0, 6 Затем можно вычислить вероятность появления значения 1: Таким образом, можно заключить, что Y=1 менее вероятно, чем Y=0.

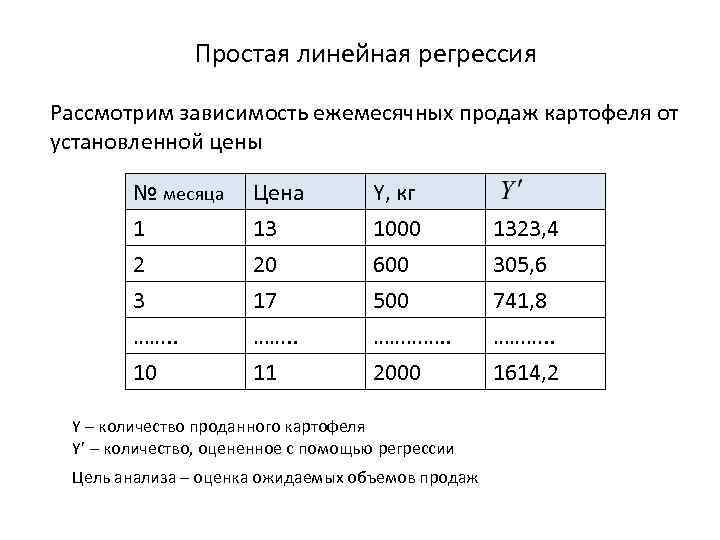

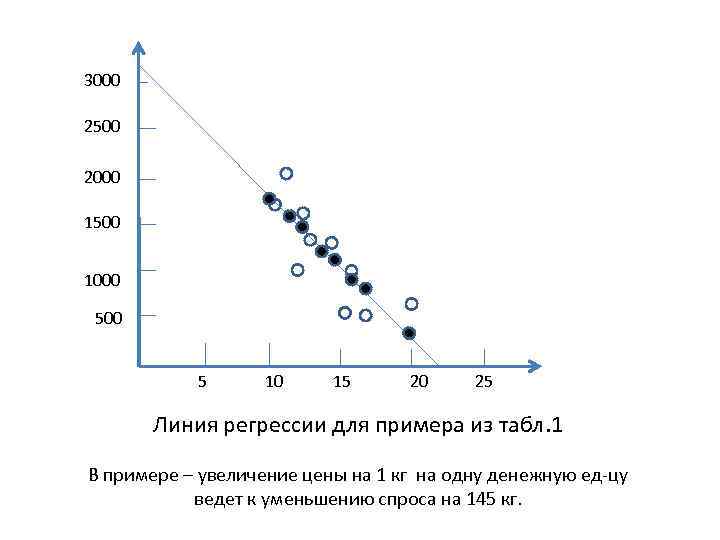

Простая линейная регрессия Рассмотрим зависимость ежемесячных продаж картофеля от установленной цены № месяца 1 2 3 ……. . 10 Цена 13 20 17 ……. . 11 Y, кг 1000 600 500 …………. . 2000 Y – количество проданного картофеля Y’ – количество, оцененное с помощью регрессии Цель анализа – оценка ожидаемых объемов продаж 1323, 4 305, 6 741, 8 ………. . 1614, 2

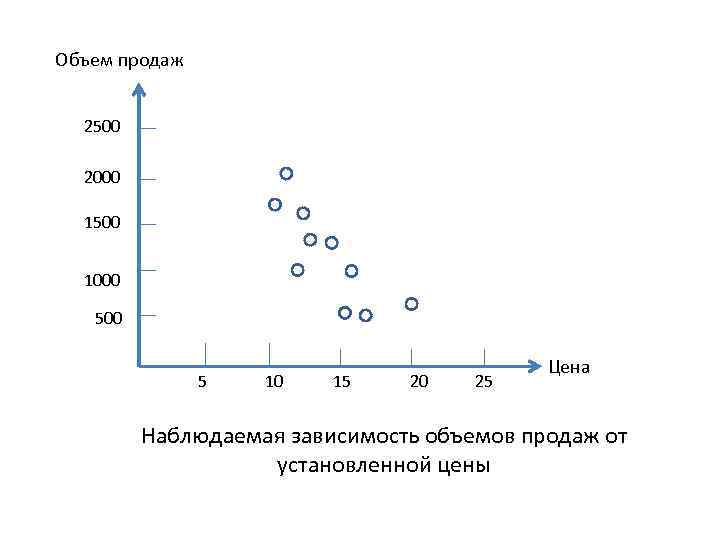

Объем продаж 2500 2000 1500 1000 5 10 15 20 25 Цена Наблюдаемая зависимость объемов продаж от установленной цены

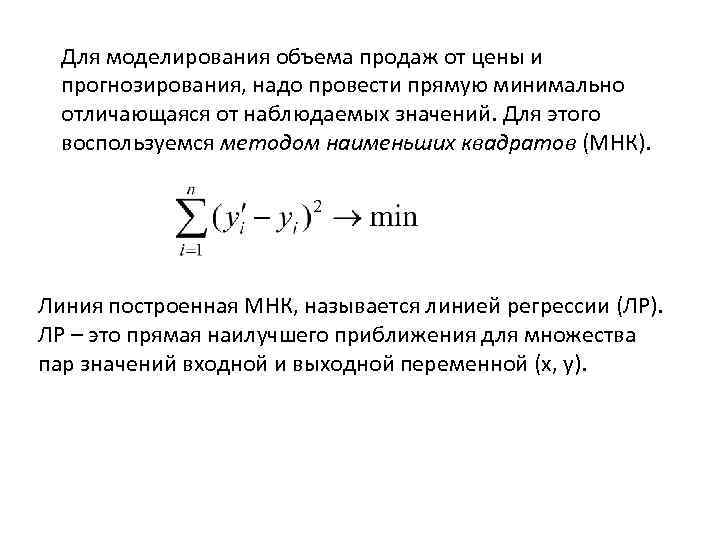

Для моделирования объема продаж от цены и прогнозирования, надо провести прямую минимально отличающаяся от наблюдаемых значений. Для этого воспользуемся методом наименьших квадратов (МНК). Линия построенная МНК, называется линией регрессии (ЛР). ЛР – это прямая наилучшего приближения для множества пар значений входной и выходной переменной (x, y).

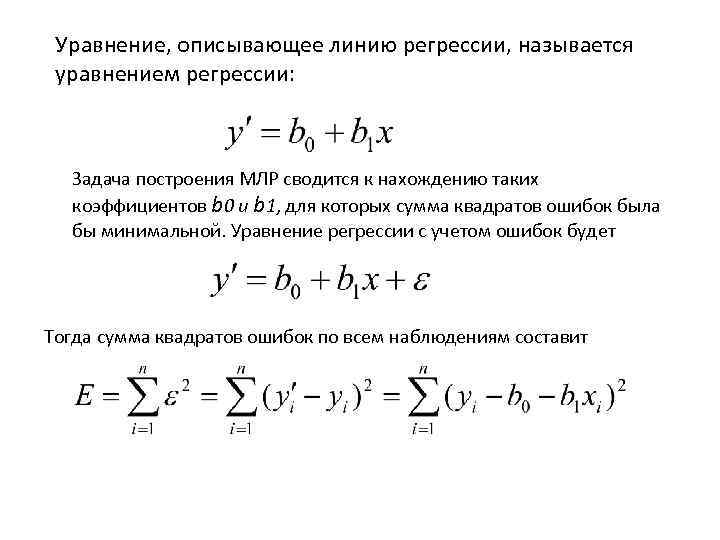

Уравнение, описывающее линию регрессии, называется уравнением регрессии: Задача построения МЛР сводится к нахождению таких коэффициентов b 0 и b 1, для которых сумма квадратов ошибок была бы минимальной. Уравнение регрессии с учетом ошибок будет Тогда сумма квадратов ошибок по всем наблюдениям составит

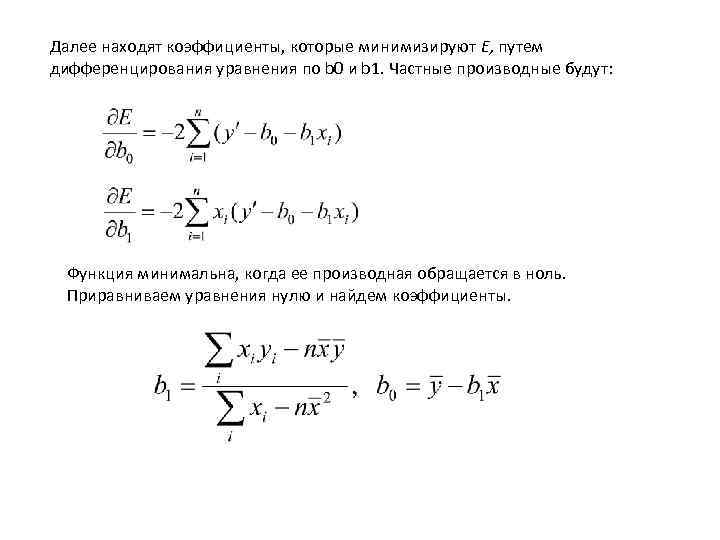

Далее находят коэффициенты, которые минимизируют E, путем дифференцирования уравнения по b 0 и b 1. Частные производные будут: Функция минимальна, когда ее производная обращается в ноль. Приравниваем уравнения нулю и найдем коэффициенты.

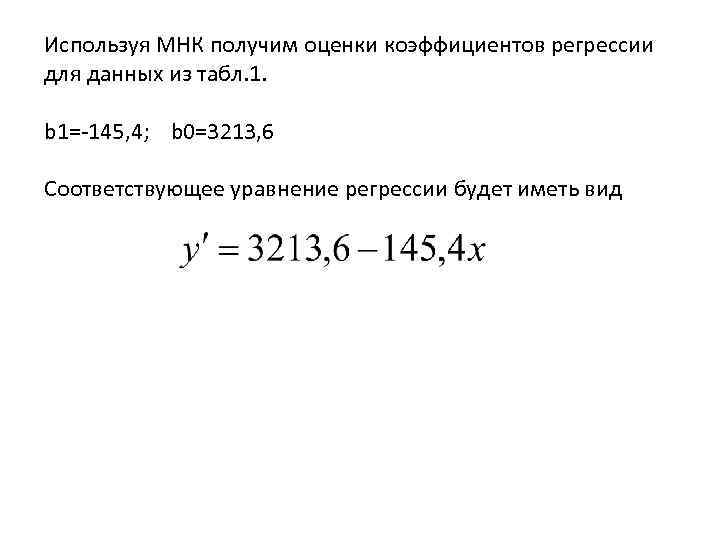

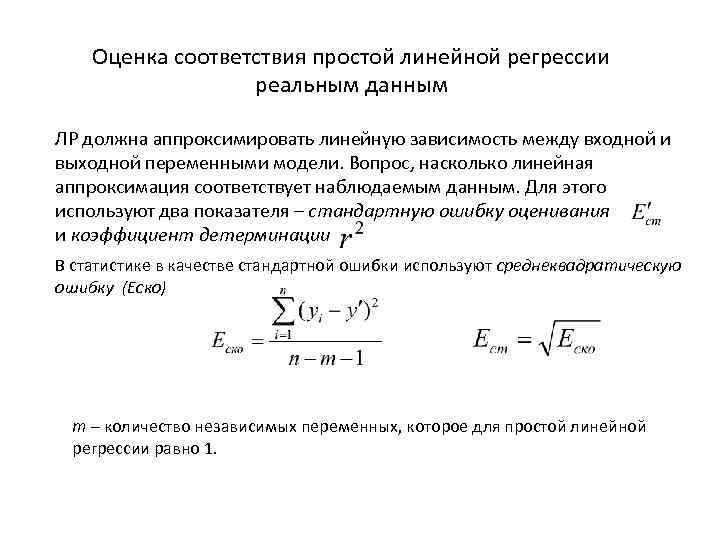

Используя МНК получим оценки коэффициентов регрессии для данных из табл. 1. b 1=-145, 4; b 0=3213, 6 Соответствующее уравнение регрессии будет иметь вид

3000 2500 2000 1500 1000 5 10 15 20 25 Линия регрессии для примера из табл. 1 В примере – увеличение цены на 1 кг на одну денежную ед-цу ведет к уменьшению спроса на 145 кг.

Оценка соответствия простой линейной регрессии реальным данным ЛР должна аппроксимировать линейную зависимость между входной и выходной переменными модели. Вопрос, насколько линейная аппроксимация соответствует наблюдаемым данным. Для этого используют два показателя – стандартную ошибку оценивания и коэффициент детерминации В статистике в качестве стандартной ошибки используют среднеквадратическую ошибку (Eско) m – количество независимых переменных, которое для простой линейной регрессии равно 1.

Кластерный анализ 1. Группировка объектов на основе близости их свойств 2. Процедура, которая любому объекту x X ставит в соответствии метку кластеру y Y

Кластеризация – это группировка объектов (наблюдений, событий) на основе данных, описывающих свойства объектов. Объекты внутри кластера должны быть похожими друг на друга и отличаться от других, которые вошли в другие кластеры. Кластеризацию используют, когда отсутствуют априорные сведения относительно классов, к которым можно отнести объекты исследуемого набора данных, либо когда число объектов велико, что затрудняет их ручной анализ. Постановка задачи кластеризации сложна и неодназначна: • Оптимальное количество кластеров в общем случае неизвестно • Выбор меры похожести или близости свойств объектов между собой часто носит субъективный характер

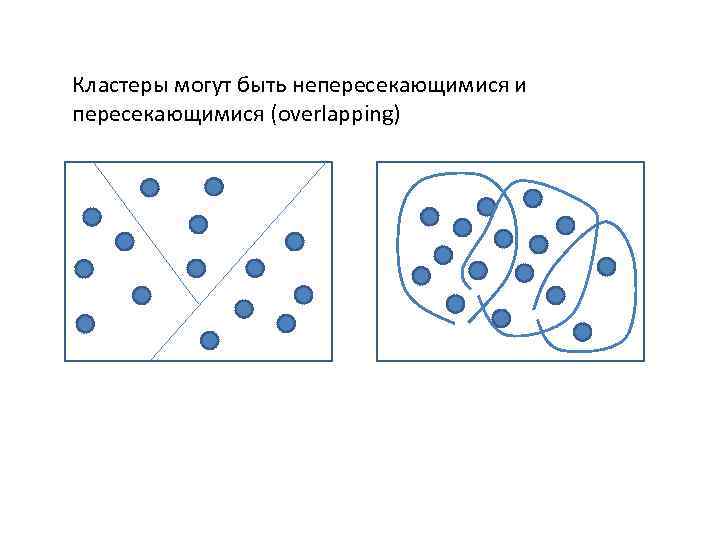

Кластеры могут быть непересекающимися и пересекающимися (overlapping)

Задачи кластеризации • Изучение данных • Облегчение анализа. Позволяет строить модели для каждого кластера в отдельности. • Сжатие данных. При большом объеме можно сократить объем за счет выделения отдельных представителей по каждому кластеру. • Прогнозирование. Позволяет распознавать новые объекты. • Обнаружение аномалий. Выделение нетипичных объектов.

Области применения • Розничная торговля. Облегчение анализа. Разделение покупателей на несколько сегментов. • Банкинг. Изучение профиля клиентов. Прогнозирование кредитоспособностей клиентов. • Телекоммуникациии. Изучение и анализ клиентов сотовой связи. • Страхование. Обнаружение аномалий. (Выявление сговора врачей) • Государственные службы. Выделение слоев населения прибывающих в город (бабушки, демобилизованные солдаты, невесты, гастарбайтеры, мигранты) • Медицина. Анализ заболеваний и их симптомов. • Социология. Разбиение респондентов на однородные группы.

Классификация алгоритмов v. Иерархические • Агломеративные, характеризуются последовательным объединением исходных элементов и соответствующим уменьшением числа кластеров (построение снизу-вверх); • Дивизимные (делимые), в которых число кластеров возрастает, начиная с одного (построение сверху - вниз) v. Неиерархические • Алгоритм k-means • Алгоритм G-means • Сети Кохонена • Адаптивные методы

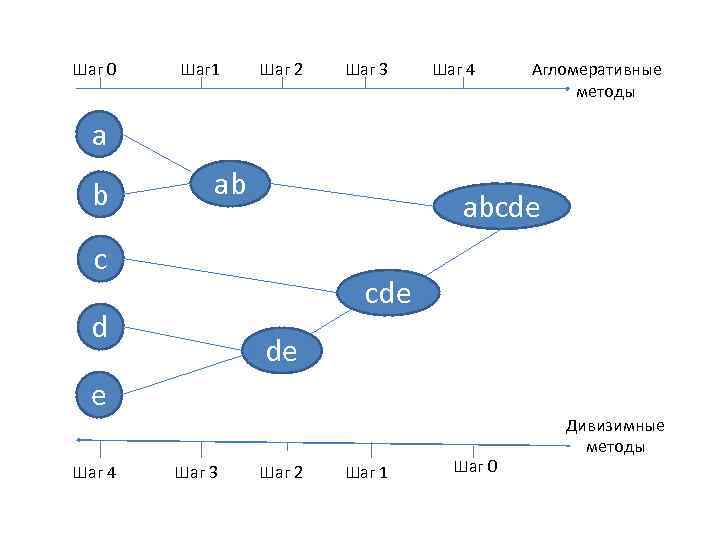

Иерархические методы кластерного анализа Суть иерархической кластеризации состоит в последовательном объединении меньших кластеров в большие или разделении больших кластеров на меньшие. Иерархические агломеративные методы (Agglomerative Nesting, AGNES) Эта группа методов характеризуется последовательным объединением исходных элементов и соответствующим уменьшением числа кластеров. В начале работы алгоритма все объекты являются отдельными кластерами. На первом шаге наиболее похожие объекты объединяются в кластер. На последующих шагах объединение продолжается до тех пор, пока все объекты не будут составлять один кластер. Иерархические дивизимные (делимые) методы (DIvisive ANAlysis, DIANA) Эти методы являются логической противоположностью агломеративным методам. В начале работы алгоритма все объекты принадлежат одному кластеру, который на последующих шагах делится на меньшие кластеры, в результате образуется последовательность расщепляющих групп. Принцип работы описанных выше групп методов в виде дендрограммы показан на рисунке.

Шаг 0 Шаг 1 Шаг 2 Шаг 3 Шаг 4 Агломеративные методы a b ab abcde c cde d de e Шаг 4 Шаг 3 Шаг 2 Шаг 1 Шаг 0 Дивизимные методы

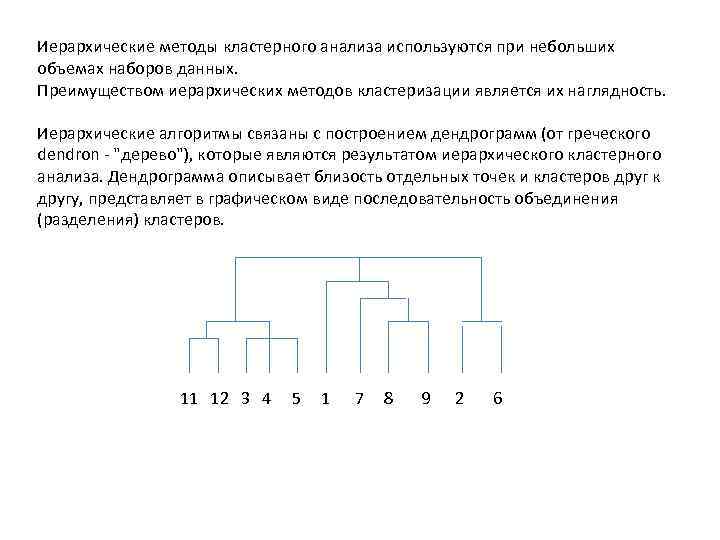

Иерархические методы кластерного анализа используются при небольших объемах наборов данных. Преимуществом иерархических методов кластеризации является их наглядность. Иерархические алгоритмы связаны с построением дендрограмм (от греческого dendron - "дерево"), которые являются результатом иерархического кластерного анализа. Дендрограмма описывает близость отдельных точек и кластеров друг к другу, представляет в графическом виде последовательность объединения (разделения) кластеров. 11 12 3 4 5 1 7 8 9 2 6

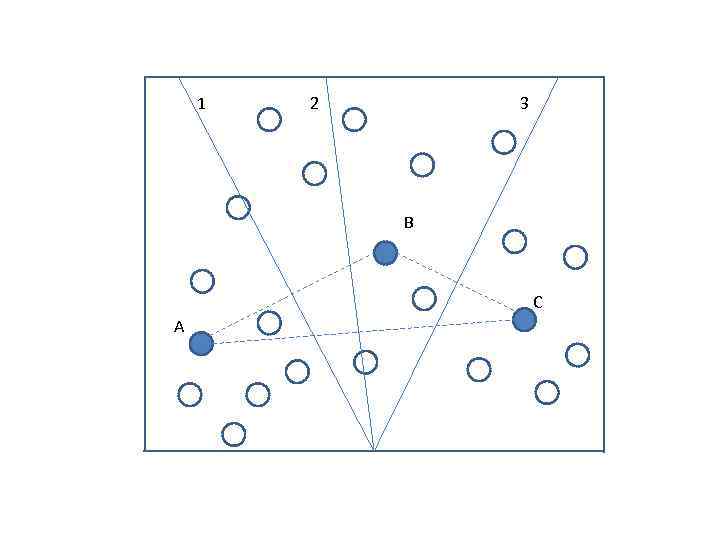

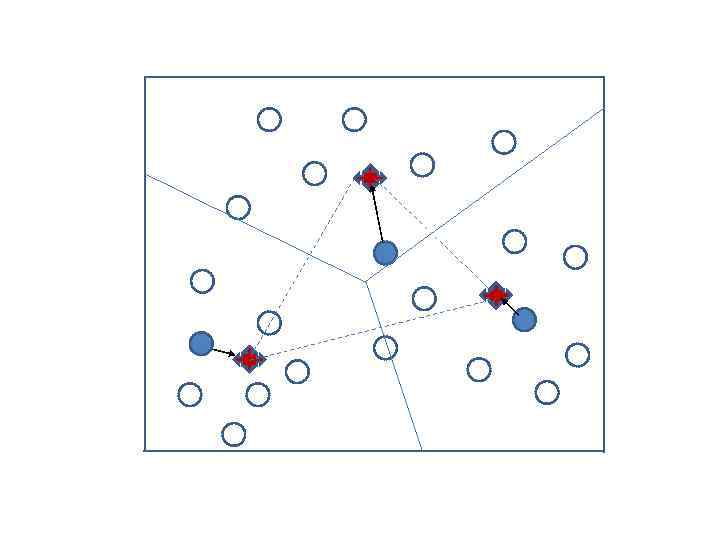

k – means (k – средних) 1. Задается число кластеров k, которое должно быть сформировано из объектов исходной выборки 2. Случайным образом выбирается k записей, которые будут служить начальными центрами кластеров 3. Для каждой записи исходной выборки определяется ближайший к ней центр кластера 4. Производится вычисление центроидов – центров тяжести кластеров, которые затем становятся новыми центрами кластеров. 5. Шаги 3 и 4 повторяются до тех пор, пока не будет выполнено условие сходимости.

1 2 3 B C A

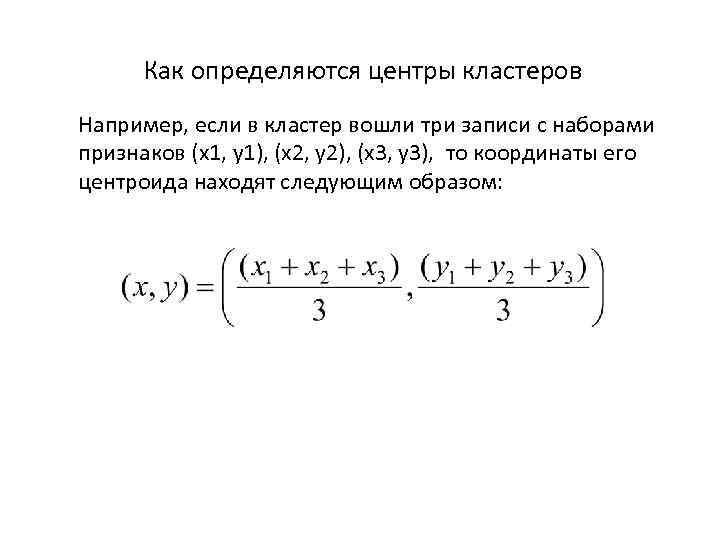

Как определяются центры кластеров Например, если в кластер вошли три записи с наборами признаков (x 1, y 1), (x 2, y 2), (x 3, y 3), то координаты его центроида находят следующим образом:

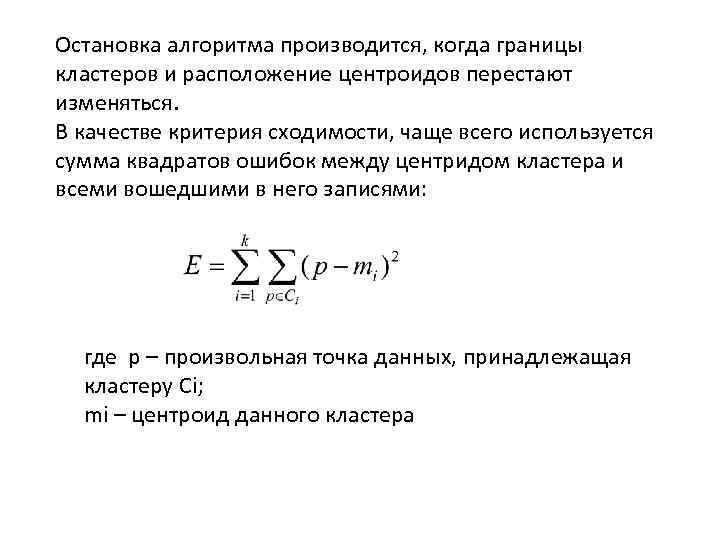

Остановка алгоритма производится, когда границы кластеров и расположение центроидов перестают изменяться. В качестве критерия сходимости, чаще всего используется сумма квадратов ошибок между центридом кластера и всеми вошедшими в него записями: где p – произвольная точка данных, принадлежащая кластеру Ci; mi – центроид данного кластера

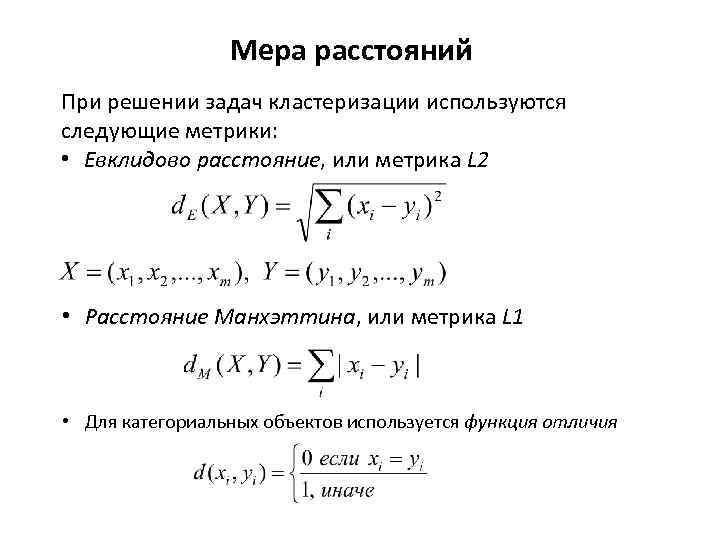

Мера расстояний При решении задач кластеризации используются следующие метрики: • Евклидово расстояние, или метрика L 2 • Расстояние Манхэттина, или метрика L 1 • Для категориальных объектов используется функция отличия

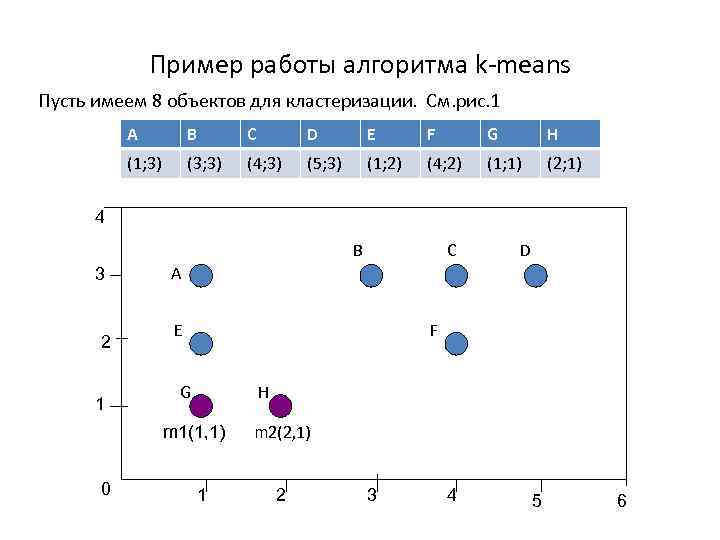

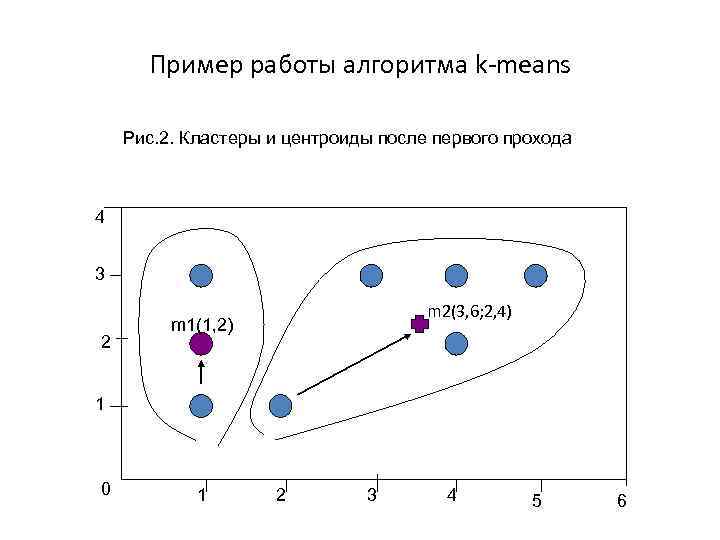

Пример работы алгоритма k-means Пусть имеем 8 объектов для кластеризации. См. рис. 1 A B C D E F G H (1; 3) (3; 3) (4; 3) (5; 3) (1; 2) (4; 2) (1; 1) (2; 1) 4 B 3 2 1 D A E F G H m 1(1, 1) 0 C 1 m 2(2, 1) 2 3 4 5 6

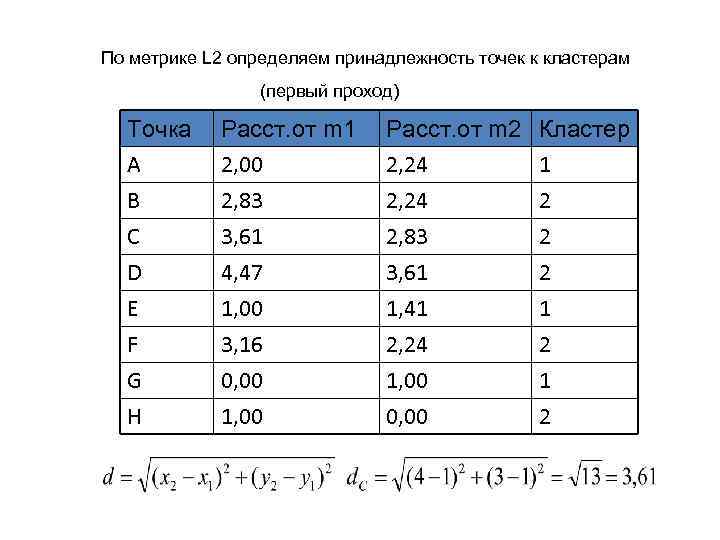

По метрике L 2 определяем принадлежность точек к кластерам (первый проход) Точка A B C Расст. от m 1 2, 00 2, 83 3, 61 Расст. от m 2 2, 24 2, 83 Кластер 1 2 2 D E F G H 4, 47 1, 00 3, 16 0, 00 1, 00 3, 61 1, 41 2, 24 1, 00 0, 00 2 1 2

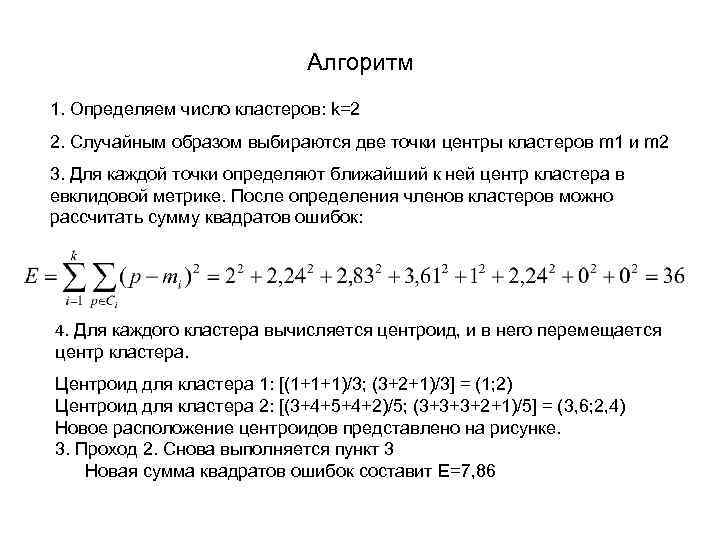

Алгоритм 1. Определяем число кластеров: k=2 2. Случайным образом выбираются две точки центры кластеров m 1 и m 2 3. Для каждой точки определяют ближайший к ней центр кластера в евклидовой метрике. После определения членов кластеров можно расcчитать сумму квадратов ошибок: 4. Для каждого кластера вычисляется центроид, и в него перемещается центр кластера. Центроид для кластера 1: [(1+1+1)/3; (3+2+1)/3] = (1; 2) Центроид для кластера 2: [(3+4+5+4+2)/5; (3+3+3+2+1)/5] = (3, 6; 2, 4) Новое расположение центроидов представлено на рисунке. 3. Проход 2. Снова выполняется пункт 3 Новая сумма квадратов ошибок составит E=7, 86

Пример работы алгоритма k-means Рис. 2. Кластеры и центроиды после первого прохода 4 3 2 m 2(3, 6; 2, 4) m 1(1, 2) 1 0 1 2 3 4 5 6

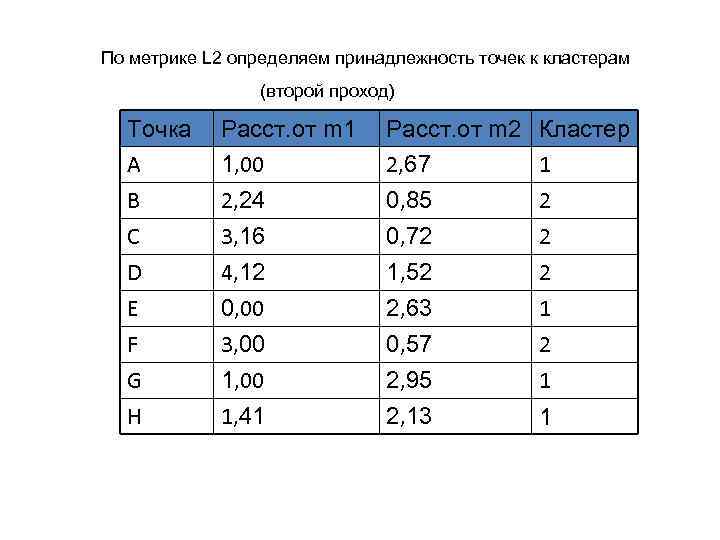

По метрике L 2 определяем принадлежность точек к кластерам (второй проход) Точка A B C Расст. от m 1 1, 00 2, 24 3, 16 Расст. от m 2 2, 67 0, 85 0, 72 Кластер 1 2 2 D E F G H 4, 12 0, 00 3, 00 1, 41 1, 52 2, 63 0, 57 2, 95 2, 13 2 1 1

![Шаг 4, проход 2. Вновь вычисляются центроиды для каждого кластера: Кластер 1: [(1+1+1+2)/4, (3+2+1+1)/4]=(1, Шаг 4, проход 2. Вновь вычисляются центроиды для каждого кластера: Кластер 1: [(1+1+1+2)/4, (3+2+1+1)/4]=(1,](https://present5.com/presentation/14719833_345802537/image-57.jpg)

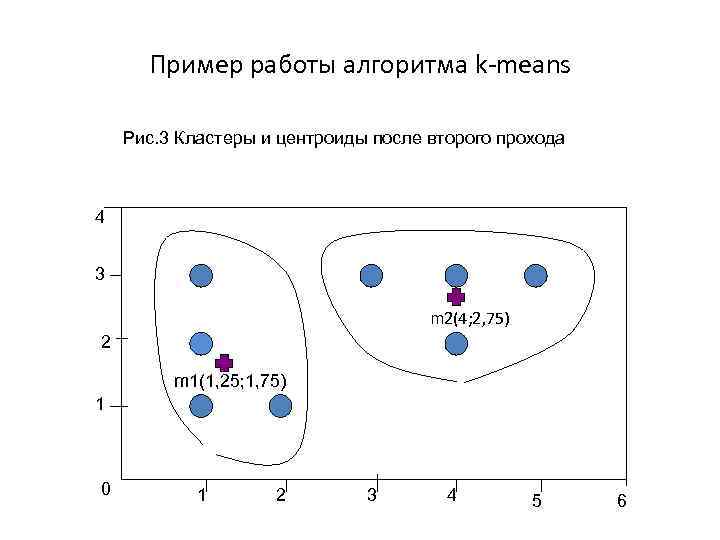

Шаг 4, проход 2. Вновь вычисляются центроиды для каждого кластера: Кластер 1: [(1+1+1+2)/4, (3+2+1+1)/4]=(1, 25; 1, 75) Кластер 2: [(3+4+5+4)/4, (3+3+3+2)/4]=(4; 2, 75) См. рис. 3 Шаг 3, проход 3. Для каждой записи вновь ищется ближайший к ней центр кластера. Новая сумма квадратов ошибок E=6, 23, значение изменилось незначительно по сравнению с предыдущим проходом. Поскольку все записи не изменили своего членства в кластерах и положение центроидов не поменялось алгоритм завершает свою работу.

Пример работы алгоритма k-means Рис. 3 Кластеры и центроиды после второго прохода 4 3 m 2(4; 2, 75) 2 m 1(1, 25; 1, 75) 1 0 1 2 3 4 5 6

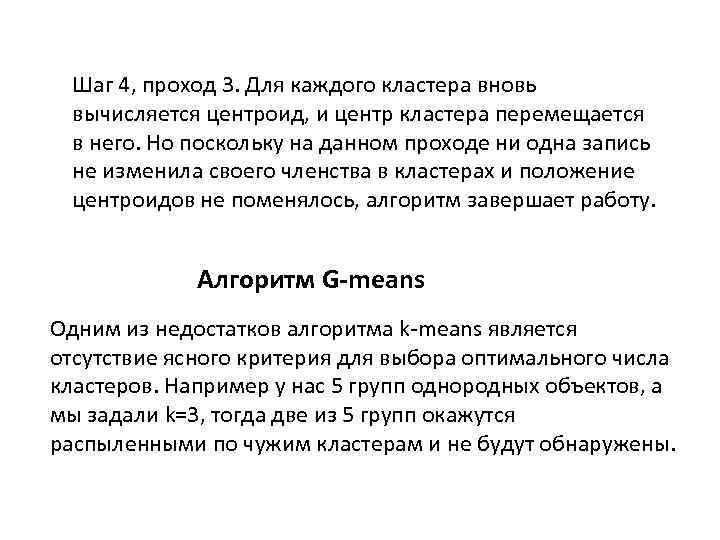

Шаг 4, проход 3. Для каждого кластера вновь вычисляется центроид, и центр кластера перемещается в него. Но поскольку на данном проходе ни одна запись не изменила своего членства в кластерах и положение центроидов не поменялось, алгоритм завершает работу. Алгоритм G-means Одним из недостатков алгоритма k-means является отсутствие ясного критерия для выбора оптимального числа кластеров. Например у нас 5 групп однородных объектов, а мы задали k=3, тогда две из 5 групп окажутся распыленными по чужим кластерам и не будут обнаружены.

Если задать большее число кластеров, то будут сформированы лишние кластеры. Чтобы решить эту проблему разработано большое число алгоритмов.

Одним из популярных является G-means. В его основе лежит предположение, что данные подчиняются некоторому унимодальному закону распределения, например гауссовскому (откуда и название). Тогда центр кластера, определяемый как среднее значение признаков попавших в него объектов, может рассматриваться как мода соответствующего распределения. Если распределение данных не гауссовское, то производят деление на два класса. Если в таких кластерах распределения окажутся гауссовскими, то можно считать, что k=2 явл. оптимальным. Иначе строят новые модели и т. д.

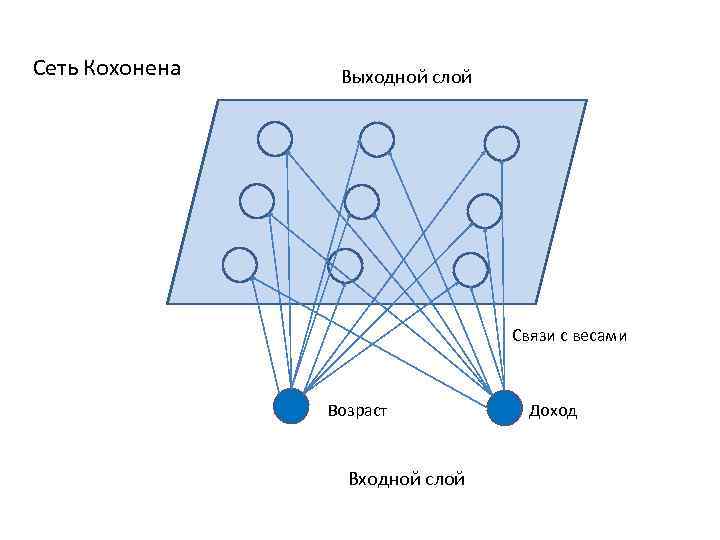

Сети Кохонена Сеть Кохонена состоит из узлов, которые объединяются в кластеры. В основе лежит конкурентное обучение, когда выходные узлы (нейроны) конкурируют между собой за право стать победителем. Задача входных нейронов – передать значения входных полей на нейроны выходного слоя. Каждая связь между нейронами сети имеет определенный вес, который в процессе ее инициализации устанавливается случайным образом в интервале от 0 до 1. Процесс обучения заключается в подстройке весов.

Сеть Кохонена Выходной слой Связи с весами Возраст Входной слой Доход

В процессе обучения и функционирования сеть Кохонена выполняет три процедуры. 1. Конкуренция. Выходные нейроны конкурируют между собой за то, чтобы векторы их весов оказались как можно ближе к вектору признаков объекта. 2. Объединение. Победивший нейрон становится центром некоторой группы соседних нейронов. 3. Подстройка весов. Нейроны, соседствующие с нейроном-победителем, участвуют в подстройке весов, то есть в обучении.

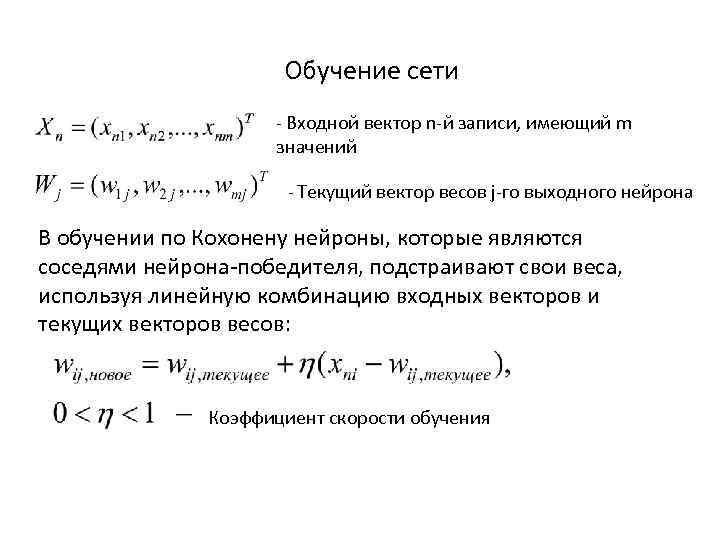

Обучение сети - Входной вектор n-й записи, имеющий m значений - Текущий вектор весов j-го выходного нейрона В обучении по Кохонену нейроны, которые являются соседями нейрона-победителя, подстраивают свои веса, используя линейную комбинацию входных векторов и текущих векторов весов: Коэффициент скорости обучения

Алгоритм сети Кохонена 1. Инициализация. Для нейронов сети устанавливаются начальные веса, а также задаются начальная скорость обучения и радиус обучения R. 2. Возбуждение. На входной слой подается вектор воздействия Xn, содержащий значения входных полей записи обучающей выборки. 3. Конкуренция. Для каждого выходного нейрона вычисляется расстояние D(Wj, Xn) между векторами весов всех нейронов выходного слоя и вектором входного воздействия. Тот нейрон, для которого расстояние окажется наименьшим и будет победителем. 4. Объединение. Определяются все нейроны, расположенные в пределах радиуса обучения относительно нейрона-победителя. 5. Подстройка. Производится подстройка весов нейронов в пределах радиуса обучения

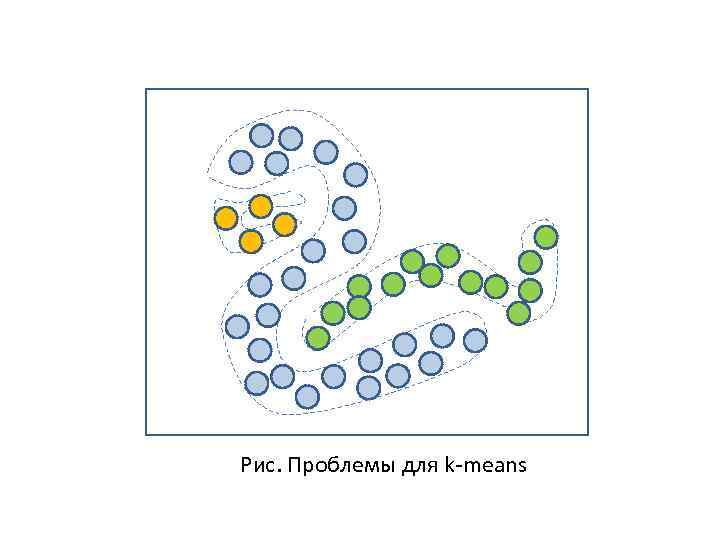

Проблемы алгоритмов кластеризации Из за обилия алгоритмов кластеризации одно и то же множество объектов можно разбить на несколько кластеров по-разному. Например, семейство алгоритмов k-means показывает хорошие результаты, когда данные в пространстве образуют компактные сгустки, четко отличимые друг от друга. Но это получается не всегда. На рисунке приведен пример неуспеха алгоритма k-means. На практике в условиях, когда объекты описываются десятками и сотнями свойств, становится сложно оценить взаимное расположение объектов и подобрать адекватный алгоритм.

Рис. Проблемы для k-means

В таблицах, описывающих свойства объектов могут присутствовать различные типы данных (числовые, строковые). Строковые могут быть упорядоченными и категориальными. Для числовых можно применить евклидову метрику расстояний. Для упорядоченных также можно использовать евклидово расстояние, закодировав значения признака целыми числами.

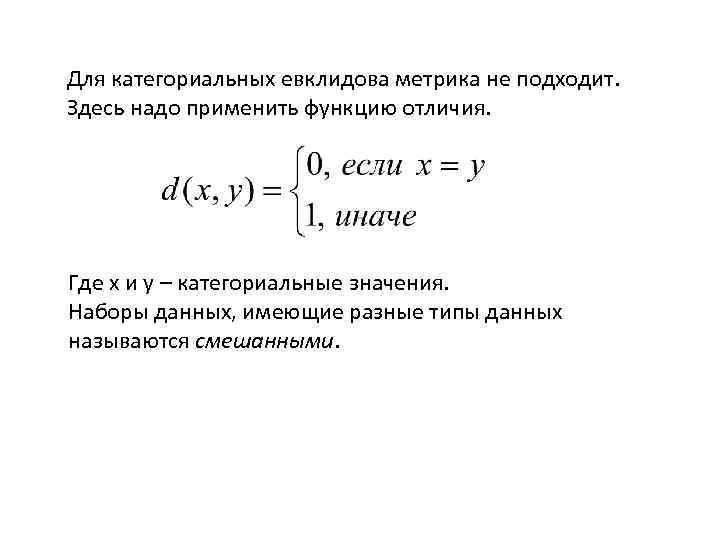

Для категориальных евклидова метрика не подходит. Здесь надо применить функцию отличия. Где x и y – категориальные значения. Наборы данных, имеющие разные типы данных называются смешанными.

Пример смешанных наборов Например: Возраст, Цвет глаз, Образование 1. {23, карий, высшее} 2. {25, зеленый, среднее} 3. {26, серый, среднее} Первый атрибут является числовым, остальные строковыми. Образование является упорядоченным набором. Ему можно задать числовое значение. Необходимость комбинации метрик ухудшает работу алгоритма. На практике не существует единого универсального алгоритма кластеризации.

Thank You

ПРвИС-Лек-678.ppt