Измерение информации.ppt

- Количество слайдов: 33

Измерение информации

Измерение информации

Информация l 1. 2. 3. 4. l Информация является важнейшим понятием и основным объектом изучения в информатике, проблема ее измерения имеет фундаментальное значение Верно ли, что истрепанная книжка, если в ней нет вырванных страниц, несет для Вас ровно столько же информации, сколько такая же новая? Каменная скрижаль весом в три тонны несет для археологов столько же информации, сколько ее хороший фотоснимок в археологическом журнале. Не так ли? Когда московская радиостудия передает последние известия, то одну и ту же информацию получает и подмосковный житель и житель Новосибирска. Но поток энергии радиоволн в Новосибирске намного меньше, чем в Москве. Следовательно, мощность сигнала, также как и размер и вес носителя, не могут служить оценкой количества информации, переносимой сигналом. Как же оценить это количество? Из курса физики вы знаете, что прежде, чем измерять значение какой-либо физической величины, надо ввести единицу измерения. У информации тоже есть такая единица - бит, но смысл ее различен при разных подходах к определению понятия “информация”

Информация l 1. 2. 3. 4. l Информация является важнейшим понятием и основным объектом изучения в информатике, проблема ее измерения имеет фундаментальное значение Верно ли, что истрепанная книжка, если в ней нет вырванных страниц, несет для Вас ровно столько же информации, сколько такая же новая? Каменная скрижаль весом в три тонны несет для археологов столько же информации, сколько ее хороший фотоснимок в археологическом журнале. Не так ли? Когда московская радиостудия передает последние известия, то одну и ту же информацию получает и подмосковный житель и житель Новосибирска. Но поток энергии радиоволн в Новосибирске намного меньше, чем в Москве. Следовательно, мощность сигнала, также как и размер и вес носителя, не могут служить оценкой количества информации, переносимой сигналом. Как же оценить это количество? Из курса физики вы знаете, что прежде, чем измерять значение какой-либо физической величины, надо ввести единицу измерения. У информации тоже есть такая единица - бит, но смысл ее различен при разных подходах к определению понятия “информация”

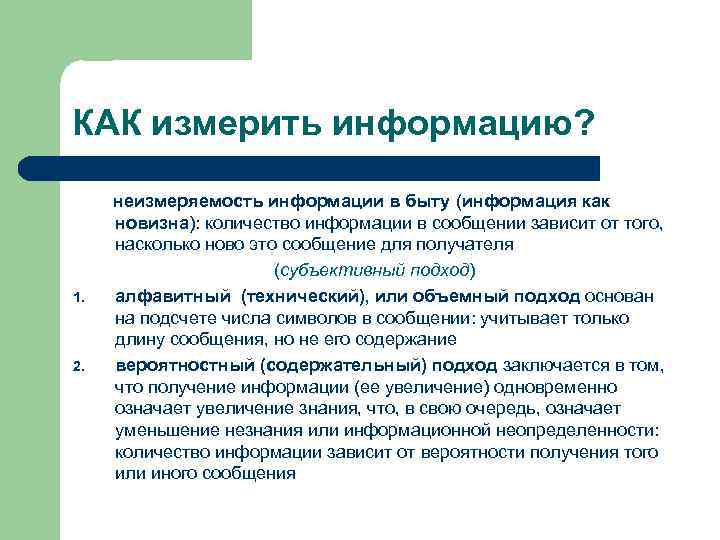

КАК измерить информацию? 1. 2. неизмеряемость информации в быту (информация как новизна): количество информации в сообщении зависит от того, насколько ново это сообщение для получателя (субъективный подход) алфавитный (технический), или объемный подход основан на подсчете числа символов в сообщении: учитывает только длину сообщения, но не его содержание вероятностный (содержательный) подход заключается в том, что получение информации (ее увеличение) одновременно означает увеличение знания, что, в свою очередь, означает уменьшение незнания или информационной неопределенности: количество информации зависит от вероятности получения того или иного сообщения

КАК измерить информацию? 1. 2. неизмеряемость информации в быту (информация как новизна): количество информации в сообщении зависит от того, насколько ново это сообщение для получателя (субъективный подход) алфавитный (технический), или объемный подход основан на подсчете числа символов в сообщении: учитывает только длину сообщения, но не его содержание вероятностный (содержательный) подход заключается в том, что получение информации (ее увеличение) одновременно означает увеличение знания, что, в свою очередь, означает уменьшение незнания или информационной неопределенности: количество информации зависит от вероятности получения того или иного сообщения

Историческая справка Различные подходы к измерению количества информации в сообщении определяются различием подходов к определению самого понятия «информация» l l Содержательный подход: сообщения основан на определении К. Э. Шеннона, что информация – это снятая неопределенность. Неопределенность некоторого события связывают с количеством возможных исходов данного события. Алфавитный подход: любое сообщение можно закодировать конечной последовательностью символов некоторого алфавита. Информативность последовательности символов, согласно А. Н. Колмогорову, определяется минимально необходимым количеством символов для кодирования этого сообщения. Исторически эти подходы возникли почти одновременно К. Шеннон американский инженер и математик, 1916 -2001 А. Н. Колмогоров советский математик, 1903 -1987

Историческая справка Различные подходы к измерению количества информации в сообщении определяются различием подходов к определению самого понятия «информация» l l Содержательный подход: сообщения основан на определении К. Э. Шеннона, что информация – это снятая неопределенность. Неопределенность некоторого события связывают с количеством возможных исходов данного события. Алфавитный подход: любое сообщение можно закодировать конечной последовательностью символов некоторого алфавита. Информативность последовательности символов, согласно А. Н. Колмогорову, определяется минимально необходимым количеством символов для кодирования этого сообщения. Исторически эти подходы возникли почти одновременно К. Шеннон американский инженер и математик, 1916 -2001 А. Н. Колмогоров советский математик, 1903 -1987

Алфавитный (объемный) подход l l в технике: информация - любая хранящаяся, обрабатываемая или передаваемая последовательность знаков, сигналов подход основан на подсчете числа символов в сообщении, записанном знаками некоторого языка русские буквы: МИР КОИ -8: 11101101 11101001 11110010 Азбука Морзе: − − · · · − · ! длина сообщения зависит не только от содержащейся в нем информации (на длину сообщения влияет мощность алфавита используемого языка)

Алфавитный (объемный) подход l l в технике: информация - любая хранящаяся, обрабатываемая или передаваемая последовательность знаков, сигналов подход основан на подсчете числа символов в сообщении, записанном знаками некоторого языка русские буквы: МИР КОИ -8: 11101101 11101001 11110010 Азбука Морзе: − − · · · − · ! длина сообщения зависит не только от содержащейся в нем информации (на длину сообщения влияет мощность алфавита используемого языка)

Алфавитный (объемный) подход Алфавит - все множество используемых в языке символов. АБВГДЕЁЖЗИЙКЛМНОПРСТУФХЦЧШЩЬЪЭЮЯ 0123456789 (). , !? «» : -; (пробел) Мощность алфавита - полное количество символов алфавита (N) N=54 Каждый символ имеет «информационный вес» (i), который зависит от мощности алфавита

Алфавитный (объемный) подход Алфавит - все множество используемых в языке символов. АБВГДЕЁЖЗИЙКЛМНОПРСТУФХЦЧШЩЬЪЭЮЯ 0123456789 (). , !? «» : -; (пробел) Мощность алфавита - полное количество символов алфавита (N) N=54 Каждый символ имеет «информационный вес» (i), который зависит от мощности алфавита

Алфавитный (объемный) подход В компьютере используется алфавит, состоящий из 2 символов, которые обозначаются цифрами « 0» и « 1» Его называют двоичным алфавитом (мощность это алфавита равна 2) Информационный вес символа двоичного алфавита принят за единицу информации и называется 1 бит

Алфавитный (объемный) подход В компьютере используется алфавит, состоящий из 2 символов, которые обозначаются цифрами « 0» и « 1» Его называют двоичным алфавитом (мощность это алфавита равна 2) Информационный вес символа двоичного алфавита принят за единицу информации и называется 1 бит

Алфавитный (объемный) подход 2 -х символьный алфавит (N=2): каждый символ имеет информационный объем (i) 1 бит 4 -х символьный алфавит (N = 4) (все символы такого алфавита можно закодировать всевозможными комбинациями из двух двоичных цифр): каждый символ имеет информационный объем (i) 2 бита Номер символа Двоичный код 1 2 3 4 00 01 10 11

Алфавитный (объемный) подход 2 -х символьный алфавит (N=2): каждый символ имеет информационный объем (i) 1 бит 4 -х символьный алфавит (N = 4) (все символы такого алфавита можно закодировать всевозможными комбинациями из двух двоичных цифр): каждый символ имеет информационный объем (i) 2 бита Номер символа Двоичный код 1 2 3 4 00 01 10 11

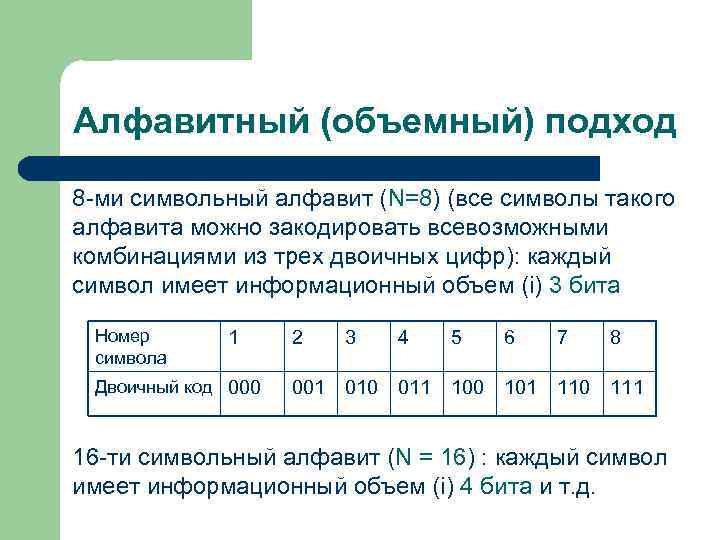

Алфавитный (объемный) подход 8 -ми символьный алфавит (N=8) (все символы такого алфавита можно закодировать всевозможными комбинациями из трех двоичных цифр): каждый символ имеет информационный объем (i) 3 бита Номер символа 1 Двоичный код 000 2 3 4 5 6 7 8 001 010 011 100 101 110 111 16 -ти символьный алфавит (N = 16) : каждый символ имеет информационный объем (i) 4 бита и т. д.

Алфавитный (объемный) подход 8 -ми символьный алфавит (N=8) (все символы такого алфавита можно закодировать всевозможными комбинациями из трех двоичных цифр): каждый символ имеет информационный объем (i) 3 бита Номер символа 1 Двоичный код 000 2 3 4 5 6 7 8 001 010 011 100 101 110 111 16 -ти символьный алфавит (N = 16) : каждый символ имеет информационный объем (i) 4 бита и т. д.

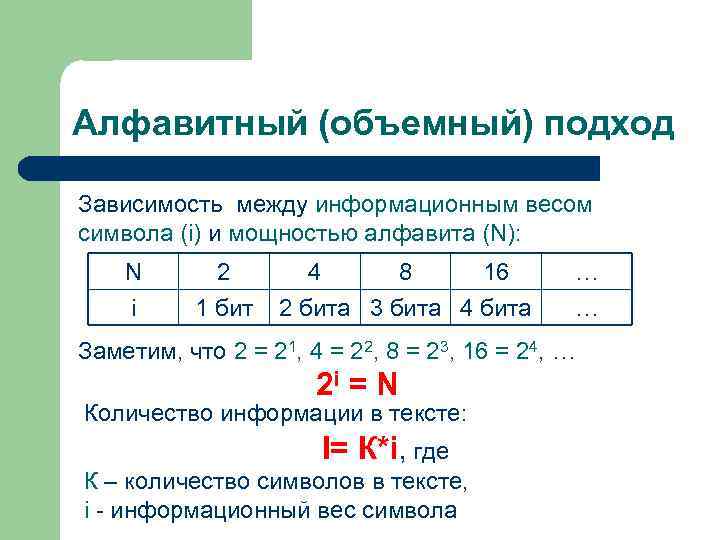

Алфавитный (объемный) подход Зависимость между информационным весом символа (i) и мощностью алфавита (N): N i 2 1 бит 4 8 16 2 бита 3 бита 4 бита … … Заметим, что 2 = 21, 4 = 22, 8 = 23, 16 = 24, … 2 i = N Количество информации в тексте: I= К*i, где К – количество символов в тексте, i - информационный вес символа

Алфавитный (объемный) подход Зависимость между информационным весом символа (i) и мощностью алфавита (N): N i 2 1 бит 4 8 16 2 бита 3 бита 4 бита … … Заметим, что 2 = 21, 4 = 22, 8 = 23, 16 = 24, … 2 i = N Количество информации в тексте: I= К*i, где К – количество символов в тексте, i - информационный вес символа

Алфавитный (объемный) подход 1 бит - это отдельный двоичный разряд компьютерных устройств: в вычислительной технике бит служит конструктивной базой для построения всех цифровых двоичных устройств 1 Байт = 8 бит 1 Байт - минимальная адресуемая информацией в компьютере (все устройства памяти имеют байтовую структуру, внешние устройства также обмениваются информацией байтами или кратными ему порциями) Все типы данных (числа, символы и др. ) представляются в компьютере величинами, кратными байту

Алфавитный (объемный) подход 1 бит - это отдельный двоичный разряд компьютерных устройств: в вычислительной технике бит служит конструктивной базой для построения всех цифровых двоичных устройств 1 Байт = 8 бит 1 Байт - минимальная адресуемая информацией в компьютере (все устройства памяти имеют байтовую структуру, внешние устройства также обмениваются информацией байтами или кратными ему порциями) Все типы данных (числа, символы и др. ) представляются в компьютере величинами, кратными байту

Алфавитный (объемный) подход Бит: двоичная ячейка (разряд) BInary Digit, одно из значений (0/1) Терабайт Петабайт Эксабайт Зеттабайт Йоттабайт

Алфавитный (объемный) подход Бит: двоичная ячейка (разряд) BInary Digit, одно из значений (0/1) Терабайт Петабайт Эксабайт Зеттабайт Йоттабайт

Алфавитный (объемный) подход

Алфавитный (объемный) подход

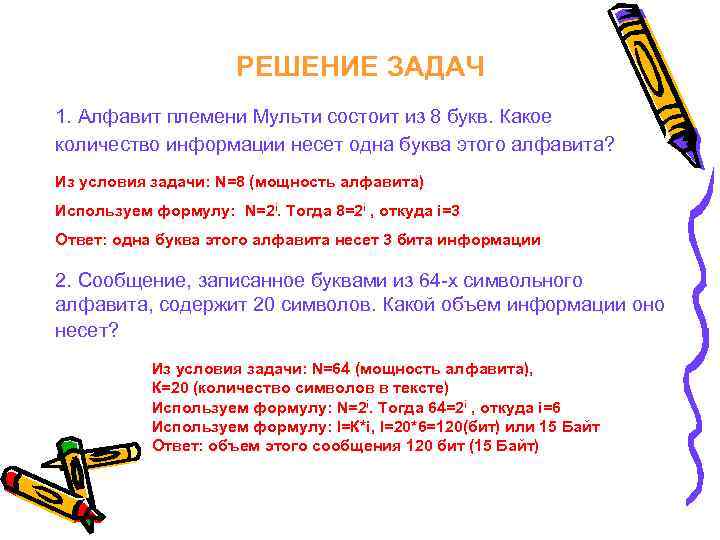

РЕШЕНИЕ ЗАДАЧ 1. Алфавит племени Мульти состоит из 8 букв. Какое количество информации несет одна буква этого алфавита? Из условия задачи: N=8 (мощность алфавита) Используем формулу: N=2 i. Тогда 8=2 i , откуда i=3 Ответ: одна буква этого алфавита несет 3 бита информации 2. Сообщение, записанное буквами из 64 -х символьного алфавита, содержит 20 символов. Какой объем информации оно несет? Из условия задачи: N=64 (мощность алфавита), К=20 (количество символов в тексте) Используем формулу: N=2 i. Тогда 64=2 i , откуда i=6 Используем формулу: I=К*i, I=20*6=120(бит) или 15 Байт Ответ: объем этого сообщения 120 бит (15 Байт)

РЕШЕНИЕ ЗАДАЧ 1. Алфавит племени Мульти состоит из 8 букв. Какое количество информации несет одна буква этого алфавита? Из условия задачи: N=8 (мощность алфавита) Используем формулу: N=2 i. Тогда 8=2 i , откуда i=3 Ответ: одна буква этого алфавита несет 3 бита информации 2. Сообщение, записанное буквами из 64 -х символьного алфавита, содержит 20 символов. Какой объем информации оно несет? Из условия задачи: N=64 (мощность алфавита), К=20 (количество символов в тексте) Используем формулу: N=2 i. Тогда 64=2 i , откуда i=6 Используем формулу: I=К*i, I=20*6=120(бит) или 15 Байт Ответ: объем этого сообщения 120 бит (15 Байт)

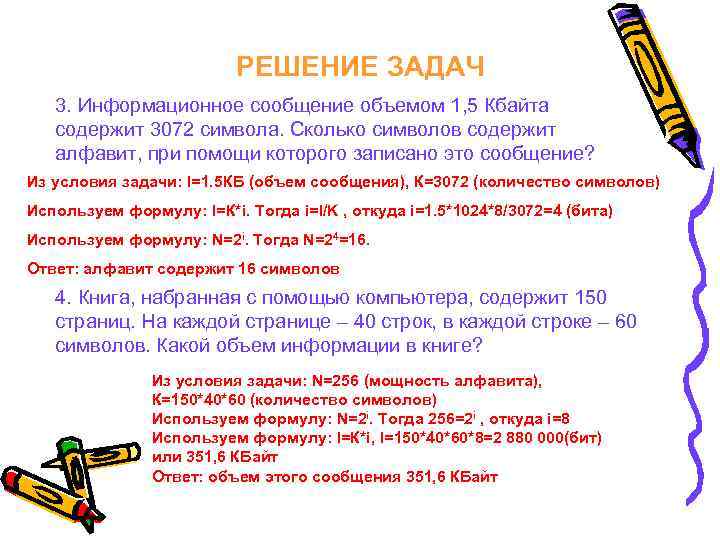

РЕШЕНИЕ ЗАДАЧ 3. Информационное сообщение объемом 1, 5 Кбайта содержит 3072 символа. Сколько символов содержит алфавит, при помощи которого записано это сообщение? Из условия задачи: I=1. 5 КБ (объем сообщения), К=3072 (количество символов) Используем формулу: I=К*i. Тогда i=I/K , откуда i=1. 5*1024*8/3072=4 (бита) Используем формулу: N=2 i. Тогда N=24=16. Ответ: алфавит содержит 16 символов 4. Книга, набранная с помощью компьютера, содержит 150 страниц. На каждой странице – 40 строк, в каждой строке – 60 символов. Какой объем информации в книге? Из условия задачи: N=256 (мощность алфавита), К=150*40*60 (количество символов) Используем формулу: N=2 i. Тогда 256=2 i , откуда i=8 Используем формулу: I=К*i, I=150*40*60*8=2 880 000(бит) или 351, 6 КБайт Ответ: объем этого сообщения 351, 6 КБайт

РЕШЕНИЕ ЗАДАЧ 3. Информационное сообщение объемом 1, 5 Кбайта содержит 3072 символа. Сколько символов содержит алфавит, при помощи которого записано это сообщение? Из условия задачи: I=1. 5 КБ (объем сообщения), К=3072 (количество символов) Используем формулу: I=К*i. Тогда i=I/K , откуда i=1. 5*1024*8/3072=4 (бита) Используем формулу: N=2 i. Тогда N=24=16. Ответ: алфавит содержит 16 символов 4. Книга, набранная с помощью компьютера, содержит 150 страниц. На каждой странице – 40 строк, в каждой строке – 60 символов. Какой объем информации в книге? Из условия задачи: N=256 (мощность алфавита), К=150*40*60 (количество символов) Используем формулу: N=2 i. Тогда 256=2 i , откуда i=8 Используем формулу: I=К*i, I=150*40*60*8=2 880 000(бит) или 351, 6 КБайт Ответ: объем этого сообщения 351, 6 КБайт

РЕШЕНИЕ ЗАДАЧ 5. Для записи сообщения использовался 64 -х символьный алфавит. Каждая страница содержит 30 строк. Все сообщение содержит 8775 байт информации и занимает 6 страниц. Сколько символов в строке? 6. Сообщение занимает 2 страницы и содержит 1/16 Кбайт информации. На каждой странице записано 256 символов. Какова мощность алфавита? 7. Скорость чтения ученика 10 класса составляет приблизительно 250 символов в минуту. Приняв мощность используемого алфавита за 64, определите, какой объем информации в килобайтах получит ученик, если он будет непрерывно читать в течение 40 минут. ! В современной кодировке Unicode заложено гораздо большее количество символов. В ней определено 256 алфавитных страниц по 256 символов в каждой Определим i: 256*256=2 i, 216=2 i; тогда i=16(бит) или 2 байта приходится на 1 символ в такой кодировке

РЕШЕНИЕ ЗАДАЧ 5. Для записи сообщения использовался 64 -х символьный алфавит. Каждая страница содержит 30 строк. Все сообщение содержит 8775 байт информации и занимает 6 страниц. Сколько символов в строке? 6. Сообщение занимает 2 страницы и содержит 1/16 Кбайт информации. На каждой странице записано 256 символов. Какова мощность алфавита? 7. Скорость чтения ученика 10 класса составляет приблизительно 250 символов в минуту. Приняв мощность используемого алфавита за 64, определите, какой объем информации в килобайтах получит ученик, если он будет непрерывно читать в течение 40 минут. ! В современной кодировке Unicode заложено гораздо большее количество символов. В ней определено 256 алфавитных страниц по 256 символов в каждой Определим i: 256*256=2 i, 216=2 i; тогда i=16(бит) или 2 байта приходится на 1 символ в такой кодировке

Вопросы • Что такое «алфавит» ? Что такое «мощность алфавита» ? • Как определяется количество информации в сообщении с алфавитной точки зрения? • Что больше 1 Кбайт или 1000 байт? • Расположите единицы измерения информации в порядке возрастания: – Гигабайт; Байт; Мегабайт; Килобайт. • Сколько информации содержится в сообщении, если для кодирования одного символа использовать 1 байт: – «Компьютер – универсальный прибор. » • Два текста содержат одинаковое количество символов. Первый текст составлен в алфавите мощностью 32 символа, второй – мощностью 64 символа. Во сколько раз отличается количество информации в этих текстах?

Вопросы • Что такое «алфавит» ? Что такое «мощность алфавита» ? • Как определяется количество информации в сообщении с алфавитной точки зрения? • Что больше 1 Кбайт или 1000 байт? • Расположите единицы измерения информации в порядке возрастания: – Гигабайт; Байт; Мегабайт; Килобайт. • Сколько информации содержится в сообщении, если для кодирования одного символа использовать 1 байт: – «Компьютер – универсальный прибор. » • Два текста содержат одинаковое количество символов. Первый текст составлен в алфавите мощностью 32 символа, второй – мощностью 64 символа. Во сколько раз отличается количество информации в этих текстах?

Содержательный (вероятностный ) подход l l l в теории информации: информация - уменьшение неопределенности наших знаний об окружающем мире (информация - это снятая неопределенность) единица измерения информации была определена в теории информации ( «бит» ) Сообщение, уменьшающее неопределенность знаний в два раза, несет 1 бит информации неопределенность знаний о некотором событии - это количество возможных результатов события

Содержательный (вероятностный ) подход l l l в теории информации: информация - уменьшение неопределенности наших знаний об окружающем мире (информация - это снятая неопределенность) единица измерения информации была определена в теории информации ( «бит» ) Сообщение, уменьшающее неопределенность знаний в два раза, несет 1 бит информации неопределенность знаний о некотором событии - это количество возможных результатов события

Содержательный (вероятностный ) подход равновероятные события Пример1: Бросается монета Есть два варианта результата бросания монеты. Причем, ни один из этих вариантов не имеет преимущества перед другим. В таком случае они равновероятны. Неопределенность знаний о результате равна двум. После того, как монета упадет и будет получен результат, количество информации, которое мы получим будет равно 1 биту. l возможные события (равновероятны) произошедшее событие

Содержательный (вероятностный ) подход равновероятные события Пример1: Бросается монета Есть два варианта результата бросания монеты. Причем, ни один из этих вариантов не имеет преимущества перед другим. В таком случае они равновероятны. Неопределенность знаний о результате равна двум. После того, как монета упадет и будет получен результат, количество информации, которое мы получим будет равно 1 биту. l возможные события (равновероятны) произошедшее событие

Содержательный (вероятностный ) подход равновероятные события Пример2: книга лежит на одной из 8 полок Какое количество информации мы получим, если узнаем, что книга лежит на конкретной полке? Вопрос уменьшает неопределенность в 2 раза. l - Книга лежит выше четвертой полки? - Нет. - Книга лежит ниже третьей полки? - Да. - Книга — на второй полке? - Нет. Ну теперь все ясно! Книга лежит на первой полке Три вопроса - 3 бита информации «Книга лежит на первой полке» (3 бита) l

Содержательный (вероятностный ) подход равновероятные события Пример2: книга лежит на одной из 8 полок Какое количество информации мы получим, если узнаем, что книга лежит на конкретной полке? Вопрос уменьшает неопределенность в 2 раза. l - Книга лежит выше четвертой полки? - Нет. - Книга лежит ниже третьей полки? - Да. - Книга — на второй полке? - Нет. Ну теперь все ясно! Книга лежит на первой полке Три вопроса - 3 бита информации «Книга лежит на первой полке» (3 бита) l

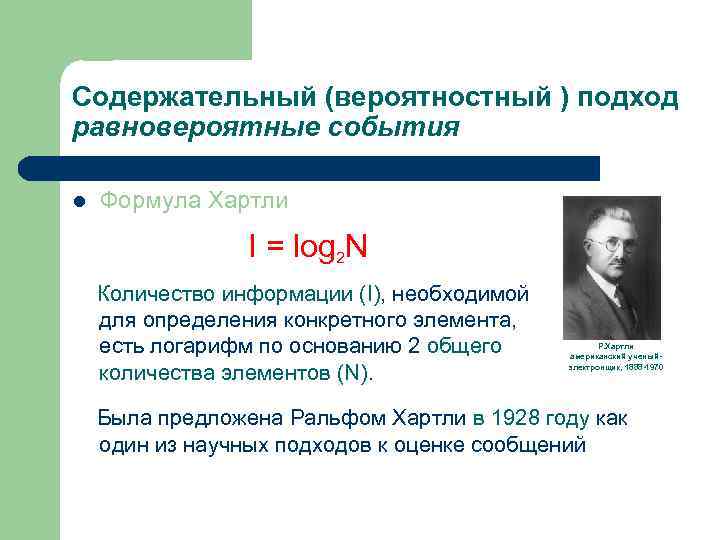

Содержательный (вероятностный ) подход равновероятные события l Формула Хартли I = log 2 N Количество информации (I), необходимой для определения конкретного элемента, есть логарифм по основанию 2 общего количества элементов (N). Р. Хартли американский ученыйэлектронщик, 1888 -1970 Была предложена Ральфом Хартли в 1928 году как один из научных подходов к оценке сообщений

Содержательный (вероятностный ) подход равновероятные события l Формула Хартли I = log 2 N Количество информации (I), необходимой для определения конкретного элемента, есть логарифм по основанию 2 общего количества элементов (N). Р. Хартли американский ученыйэлектронщик, 1888 -1970 Была предложена Ральфом Хартли в 1928 году как один из научных подходов к оценке сообщений

Содержательный (вероятностный ) подход равновероятные события N=2 I • • I = log 2 N N - возможное количество событий, или неопределенность знаний I - количество информации в сообщении о том, что произошло одно из N событий (в битах)

Содержательный (вероятностный ) подход равновероятные события N=2 I • • I = log 2 N N - возможное количество событий, или неопределенность знаний I - количество информации в сообщении о том, что произошло одно из N событий (в битах)

РЕШЕНИЕ ЗАДАЧ 1. В корзине лежат 16 шаров. Все шары разного цвета. Сколько информации несет сообщение о том, что из корзины выкатился красный шар? 1) 8 бит; 2) 1 бит; 3) 4 бита; 4) 16 бит. Из условия задачи: N=16 (возможное число событий) Используем формулу: N=2 i. Тогда 16=2 i , откуда i=4 Ответ: сообщение несет 4 бита информации (ответ 3) 2. Какое количество информации получит второй игрок при игре в крестики-нолики на поле 8 х8 после первого хода первого игрока, играющего крестиками? Из условия задачи: N=8*8=64 (возможное число событий) Используем формулу: N=2 i. Тогда 64=2 i , откуда i=6 Ответ: 6 бит информации

РЕШЕНИЕ ЗАДАЧ 1. В корзине лежат 16 шаров. Все шары разного цвета. Сколько информации несет сообщение о том, что из корзины выкатился красный шар? 1) 8 бит; 2) 1 бит; 3) 4 бита; 4) 16 бит. Из условия задачи: N=16 (возможное число событий) Используем формулу: N=2 i. Тогда 16=2 i , откуда i=4 Ответ: сообщение несет 4 бита информации (ответ 3) 2. Какое количество информации получит второй игрок при игре в крестики-нолики на поле 8 х8 после первого хода первого игрока, играющего крестиками? Из условия задачи: N=8*8=64 (возможное число событий) Используем формулу: N=2 i. Тогда 64=2 i , откуда i=6 Ответ: 6 бит информации

РЕШЕНИЕ ЗАДАЧ 3. Сообщение о том, что ваш друг живет на 4 этаже несет 4 бита информации. Сколько этажей в доме? Из условия задачи: I=4 (количество информации) Используем формулу: N=2 i. Тогда N=24, откуда N=16 Ответ: 16 этажей 4. Какое количество информации несет в себе сообщение о том, что нужная вам программа находится на одной из восьми дискет? Из условия задачи: N=8 (возможное число событий) Используем формулу: N=2 i. Тогда 8=2 i , откуда i=3 Ответ: сообщение несет 3 бита информации

РЕШЕНИЕ ЗАДАЧ 3. Сообщение о том, что ваш друг живет на 4 этаже несет 4 бита информации. Сколько этажей в доме? Из условия задачи: I=4 (количество информации) Используем формулу: N=2 i. Тогда N=24, откуда N=16 Ответ: 16 этажей 4. Какое количество информации несет в себе сообщение о том, что нужная вам программа находится на одной из восьми дискет? Из условия задачи: N=8 (возможное число событий) Используем формулу: N=2 i. Тогда 8=2 i , откуда i=3 Ответ: сообщение несет 3 бита информации

РЕШЕНИЕ ЗАДАЧ 5. В рулетке общее количество лунок равно 128. Какое количество информации мы получим при остановке шарика в одной из лунок? 6. Сообщение о том, что Пети живет во втором подъезде, несет 3 бита информации. Сколько подъездов в доме? 7. В школьной библиотеке 16 стеллажей с книгами. На каждом стеллаже 8 полок. Библиотекарь сообщил Пете, что нужная ему книга находится на пятом стеллаже на третьей сверху полке. Какое количество информации передал библиотекарь Пете? 8. При угадывании целого числа в диапазоне от 1 до N было получено 5 бит информации. Чему равно N?

РЕШЕНИЕ ЗАДАЧ 5. В рулетке общее количество лунок равно 128. Какое количество информации мы получим при остановке шарика в одной из лунок? 6. Сообщение о том, что Пети живет во втором подъезде, несет 3 бита информации. Сколько подъездов в доме? 7. В школьной библиотеке 16 стеллажей с книгами. На каждом стеллаже 8 полок. Библиотекарь сообщил Пете, что нужная ему книга находится на пятом стеллаже на третьей сверху полке. Какое количество информации передал библиотекарь Пете? 8. При угадывании целого числа в диапазоне от 1 до N было получено 5 бит информации. Чему равно N?

Содержательный (вероятностный ) подход разновероятные события l Формула Шеннона I = p 1 log 2 (1/p 1) + p 2 log 2 (1/p 2) +. . . + p. N log 2 (1/p. N) I = -(p 1 log 2 (p 1) + p 2 log 2 (p 2) +. . . + p. N log 2 (p. N)) N – количество возможных событий, I – количество информации, pi – вероятность i-го события Была предложена Клодом Шенноном в 1948 году

Содержательный (вероятностный ) подход разновероятные события l Формула Шеннона I = p 1 log 2 (1/p 1) + p 2 log 2 (1/p 2) +. . . + p. N log 2 (1/p. N) I = -(p 1 log 2 (p 1) + p 2 log 2 (p 2) +. . . + p. N log 2 (p. N)) N – количество возможных событий, I – количество информации, pi – вероятность i-го события Была предложена Клодом Шенноном в 1948 году

РЕШЕНИЕ ЗАДАЧ Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика, если в непрозрачном мешочке находится 50 белых, 25 красных, 25 синих шариков? 1) всего шаров 50+25+25=100 2) вероятности шаров: p 1=50/100=1/2 (белых), p 2=25/100=1/4 (красных), p 3=25/100=1/4 (синих) I = p 1 log 2 (1/p 1) + p 2 log 2 (1/p 2) + p 3 log 2 (1/p 3) 3)I= 1/2 log 2(2) + 1/4 log 2(4) = 1/2*1+1/4*2+ +1/4*2 = 0, 5+0, 5 = 1, 5 (бит) Ответ: 1, 5 бит

РЕШЕНИЕ ЗАДАЧ Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика, если в непрозрачном мешочке находится 50 белых, 25 красных, 25 синих шариков? 1) всего шаров 50+25+25=100 2) вероятности шаров: p 1=50/100=1/2 (белых), p 2=25/100=1/4 (красных), p 3=25/100=1/4 (синих) I = p 1 log 2 (1/p 1) + p 2 log 2 (1/p 2) + p 3 log 2 (1/p 3) 3)I= 1/2 log 2(2) + 1/4 log 2(4) = 1/2*1+1/4*2+ +1/4*2 = 0, 5+0, 5 = 1, 5 (бит) Ответ: 1, 5 бит

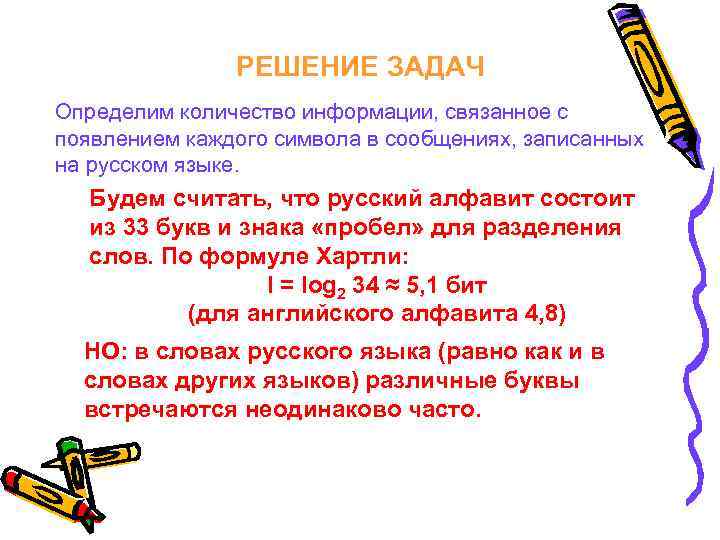

РЕШЕНИЕ ЗАДАЧ Определим количество информации, связанное с появлением каждого символа в сообщениях, записанных на русском языке. Будем считать, что русский алфавит состоит из 33 букв и знака «пробел» для разделения слов. По формуле Хартли: I = log 2 34 ≈ 5, 1 бит (для английского алфавита 4, 8) НО: в словах русского языка (равно как и в словах других языков) различные буквы встречаются неодинаково часто.

РЕШЕНИЕ ЗАДАЧ Определим количество информации, связанное с появлением каждого символа в сообщениях, записанных на русском языке. Будем считать, что русский алфавит состоит из 33 букв и знака «пробел» для разделения слов. По формуле Хартли: I = log 2 34 ≈ 5, 1 бит (для английского алфавита 4, 8) НО: в словах русского языка (равно как и в словах других языков) различные буквы встречаются неодинаково часто.

Частотность букв русского языка Буква Частота пробел 0, 175 o 0, 090 е, ë 0, 072 а 0, 062 и 0, 062 т 0, 053 н 0, 053 с 0, 045 р 0, 040 в 0, 038 л 0, 035 к 0, 028 м 0, 026 д 0, 025 п 0, 023 у 0, 021 я 0, 018 ы 0, 016 з 0, 016 ъ, ь 0, 014 б 0, 014 г 0, 013 ч 0, 012 й 0, 010 х 0, 009 ж 0, 007 ю 0, 006 ш 0, 006 ц 0, 004 щ 0, 003 э 0, 003 ф 0, 002

Частотность букв русского языка Буква Частота пробел 0, 175 o 0, 090 е, ë 0, 072 а 0, 062 и 0, 062 т 0, 053 н 0, 053 с 0, 045 р 0, 040 в 0, 038 л 0, 035 к 0, 028 м 0, 026 д 0, 025 п 0, 023 у 0, 021 я 0, 018 ы 0, 016 з 0, 016 ъ, ь 0, 014 б 0, 014 г 0, 013 ч 0, 012 й 0, 010 х 0, 009 ж 0, 007 ю 0, 006 ш 0, 006 ц 0, 004 щ 0, 003 э 0, 003 ф 0, 002

РЕШЕНИЕ ЗАДАЧ Определим количество информации, связанное с появлением каждого символа в сообщениях, записанных на русском языке. По формуле Шеннона: I ≈ 4, 36 бит (для английского алфавита 4, 04 бита на символ) для русского, и для английского языков учет вероятностей появления букв в сообщениях приводит к уменьшению среднего информационного содержания буквы можно показать, что при любом варианте кодирования: Iвероятностная ≤ Iобъемная

РЕШЕНИЕ ЗАДАЧ Определим количество информации, связанное с появлением каждого символа в сообщениях, записанных на русском языке. По формуле Шеннона: I ≈ 4, 36 бит (для английского алфавита 4, 04 бита на символ) для русского, и для английского языков учет вероятностей появления букв в сообщениях приводит к уменьшению среднего информационного содержания буквы можно показать, что при любом варианте кодирования: Iвероятностная ≤ Iобъемная

Сравнение подходов l l Вероятностный (содержательный) подход позволяет вычислить предельное (минимально возможное) теоретическое значение количества информации, которое несет сообщение о данном исходе события. Алфавитный подход - количество информации на практике с учетом конкретной выбранной кодировки. Очевидно, что первая величина есть однозначная характеристика рассматриваемого события, вторая зависит еще и от способа кодирования: в “идеальном” случае обе величины совпадают. С этой точки зрения вероятностный подход имеет преимущество. Но, с другой стороны, алфавитный способ заметно проще и с некоторых позиций (например, для подсчета требуемого количества памяти) полезнее.

Сравнение подходов l l Вероятностный (содержательный) подход позволяет вычислить предельное (минимально возможное) теоретическое значение количества информации, которое несет сообщение о данном исходе события. Алфавитный подход - количество информации на практике с учетом конкретной выбранной кодировки. Очевидно, что первая величина есть однозначная характеристика рассматриваемого события, вторая зависит еще и от способа кодирования: в “идеальном” случае обе величины совпадают. С этой точки зрения вероятностный подход имеет преимущество. Но, с другой стороны, алфавитный способ заметно проще и с некоторых позиций (например, для подсчета требуемого количества памяти) полезнее.

Сравнение подходов 1 бит – это? ? ? l 1 бит — это информация, которая сокращает неопределенность наших знаний вдвое (ответ на вопрос типа “да”/“нет”, наличие или отсутствие какого-либо свойства, четность числа и т. д. ). l 1 бит — это отдельный двоичный разряд компьютерных устройств (в вычислительной технике бит служит конструктивной базой для построения всех цифровых двоичных устройств: регистров, сумматоров и т. п. ) Отсюда очевидно, что в теории информации количество бит может быть любым, в том числе дробным, в то время как в реальных устройствах оно обязательно целое

Сравнение подходов 1 бит – это? ? ? l 1 бит — это информация, которая сокращает неопределенность наших знаний вдвое (ответ на вопрос типа “да”/“нет”, наличие или отсутствие какого-либо свойства, четность числа и т. д. ). l 1 бит — это отдельный двоичный разряд компьютерных устройств (в вычислительной технике бит служит конструктивной базой для построения всех цифровых двоичных устройств: регистров, сумматоров и т. п. ) Отсюда очевидно, что в теории информации количество бит может быть любым, в том числе дробным, в то время как в реальных устройствах оно обязательно целое

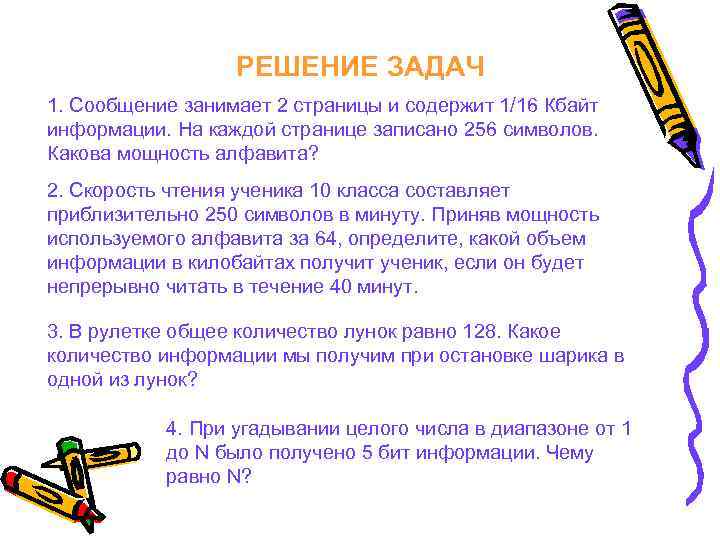

РЕШЕНИЕ ЗАДАЧ 1. Сообщение занимает 2 страницы и содержит 1/16 Кбайт информации. На каждой странице записано 256 символов. Какова мощность алфавита? 2. Скорость чтения ученика 10 класса составляет приблизительно 250 символов в минуту. Приняв мощность используемого алфавита за 64, определите, какой объем информации в килобайтах получит ученик, если он будет непрерывно читать в течение 40 минут. 3. В рулетке общее количество лунок равно 128. Какое количество информации мы получим при остановке шарика в одной из лунок? 4. При угадывании целого числа в диапазоне от 1 до N было получено 5 бит информации. Чему равно N?

РЕШЕНИЕ ЗАДАЧ 1. Сообщение занимает 2 страницы и содержит 1/16 Кбайт информации. На каждой странице записано 256 символов. Какова мощность алфавита? 2. Скорость чтения ученика 10 класса составляет приблизительно 250 символов в минуту. Приняв мощность используемого алфавита за 64, определите, какой объем информации в килобайтах получит ученик, если он будет непрерывно читать в течение 40 минут. 3. В рулетке общее количество лунок равно 128. Какое количество информации мы получим при остановке шарика в одной из лунок? 4. При угадывании целого числа в диапазоне от 1 до N было получено 5 бит информации. Чему равно N?