Лекция информатика 05_09_2012_ХФА.ppt

- Количество слайдов: 67

Информатика КУРС 1 К. т. н. , доцент кафедры Михаил Петрович Белов

Информатика КУРС 1 К. т. н. , доцент кафедры Михаил Петрович Белов

Литература Основной: 1. Информатика. Базовый курс/Сост. : Симонович С. В. и др. - СПб: Питер, 2010. 2. Острейковский В. А. Информатика: Учеб. для вузов. - М. : Высш. школа, 2009 3. Информатика: Учебник /Под. ред. проф. Д. В. Макаровой. - М. : Финансы и статистика, 2008. 4. Шафрин Ю. А. Информационные технологии. – М. : Лаборатория Базовых Знаний, 2009. 5. Кудрявцев Е. М. Mathcad 2000 Pro. – М. : ДМК Пресс, 2001. – 576 с. Дополнительный: 6. Гук М. Аппаратные средства PC: Энциклопедия. – СПб. : Питер, 2009. 7. Пятибратов А. П. , Гудыко Л. П. , Кириченко А. А. Вычислительные системы, сети и телекоммуникации. 2006.

Литература Основной: 1. Информатика. Базовый курс/Сост. : Симонович С. В. и др. - СПб: Питер, 2010. 2. Острейковский В. А. Информатика: Учеб. для вузов. - М. : Высш. школа, 2009 3. Информатика: Учебник /Под. ред. проф. Д. В. Макаровой. - М. : Финансы и статистика, 2008. 4. Шафрин Ю. А. Информационные технологии. – М. : Лаборатория Базовых Знаний, 2009. 5. Кудрявцев Е. М. Mathcad 2000 Pro. – М. : ДМК Пресс, 2001. – 576 с. Дополнительный: 6. Гук М. Аппаратные средства PC: Энциклопедия. – СПб. : Питер, 2009. 7. Пятибратов А. П. , Гудыко Л. П. , Кириченко А. А. Вычислительные системы, сети и телекоммуникации. 2006.

ЦЕЛЬ И ЗАДАЧИ КУРСА ″ИНФОРМАТИКА″ Информатика является естественнонаучной дисциплиной для всех технических направлений и специальностей. В соответствии с требованиями Государственных образовательных стандартов высшего профессионального образования студенты технических направлений и специальностей в результате изучения курса «Информатика» должны: знать и уметь использовать: • базовые понятия информатики и вычислительной техники, • предмет и основные методы информатики, • историю развития информатики, • закономерности протекания информационных процессов в искусственных системах (в том числе в системах управления), • принципы и работу технических и программных средств; иметь опыт: • использования возможностей вычислительной техники и программного обеспечения; иметь представление: • об информатике как особом способе познания мира, • об ИР и его роли в информатизации общества, • о перспективах и этапах перехода к информационному обществу.

ЦЕЛЬ И ЗАДАЧИ КУРСА ″ИНФОРМАТИКА″ Информатика является естественнонаучной дисциплиной для всех технических направлений и специальностей. В соответствии с требованиями Государственных образовательных стандартов высшего профессионального образования студенты технических направлений и специальностей в результате изучения курса «Информатика» должны: знать и уметь использовать: • базовые понятия информатики и вычислительной техники, • предмет и основные методы информатики, • историю развития информатики, • закономерности протекания информационных процессов в искусственных системах (в том числе в системах управления), • принципы и работу технических и программных средств; иметь опыт: • использования возможностей вычислительной техники и программного обеспечения; иметь представление: • об информатике как особом способе познания мира, • об ИР и его роли в информатизации общества, • о перспективах и этапах перехода к информационному обществу.

Государственный образовательный стандарт (ГОС) Основные понятия информатики: информация, информационная технология, участники процесса обработки информации; компьютер как техническое средство реализации технологий, структура компьютера и программного обеспечения с точки зрения конечного пользователя, средства и алгоритмы представления, хранения и обработки текстовой и числовой информации; среды конечного пользователя; opганизация и средства человеко-машинного интерфейса, мультисреды и гиперсреды; назначение и основы использования систем искусственного интеллекта; понятие о сетях ЭВМ, информационных технологиях на сетях; основы телекоммуникаций и распределенной обработки информации, понятие об экономических и правовых аспектах информационных технологий; основы защиты информации и сведений, составляющих государственную тайну; методы защиты информации; компьютерный практикум.

Государственный образовательный стандарт (ГОС) Основные понятия информатики: информация, информационная технология, участники процесса обработки информации; компьютер как техническое средство реализации технологий, структура компьютера и программного обеспечения с точки зрения конечного пользователя, средства и алгоритмы представления, хранения и обработки текстовой и числовой информации; среды конечного пользователя; opганизация и средства человеко-машинного интерфейса, мультисреды и гиперсреды; назначение и основы использования систем искусственного интеллекта; понятие о сетях ЭВМ, информационных технологиях на сетях; основы телекоммуникаций и распределенной обработки информации, понятие об экономических и правовых аспектах информационных технологий; основы защиты информации и сведений, составляющих государственную тайну; методы защиты информации; компьютерный практикум.

Тема 1 Информация и информатика

Тема 1 Информация и информатика

Информационное общество имеет следующие основные признаки: 1. Большинство работающих в информационном обществе (около 80% занято в информационной сфере, т. е. сфере производства информации и информационных услуг. 2. Обеспечены техническая, технологическая и правовая возможности доступа любому члену общества практически в любой точке территории и в приемлемое время к нужной ему информации (за исключением военных и государственных секретов, точно оговоренных в соответствующих законодательных актах). 3. Информация становится важнейшим стратегическим ресурсом общества и занимает ключевое место в экономике, образовании и культуре. Информатизация — необходимое условие научно-технического, социального, экономического и политического прогресса в обществе. Неизбежность информатизации обусловлена следующими причинами: - беспрецедентным усложнением социально-экономических процессов в результате увеличения масштабов и темпов общественного производства, - углубления разделения труда и его специализации в научно-технической революции; - необходимостью адекватно реагировать на возникающие проблемы в динамично меняющейся обстановке, присущей постоянно развивающемуся обществу; - повышением степени самоуправления предприятий, территорий, регионов.

Информационное общество имеет следующие основные признаки: 1. Большинство работающих в информационном обществе (около 80% занято в информационной сфере, т. е. сфере производства информации и информационных услуг. 2. Обеспечены техническая, технологическая и правовая возможности доступа любому члену общества практически в любой точке территории и в приемлемое время к нужной ему информации (за исключением военных и государственных секретов, точно оговоренных в соответствующих законодательных актах). 3. Информация становится важнейшим стратегическим ресурсом общества и занимает ключевое место в экономике, образовании и культуре. Информатизация — необходимое условие научно-технического, социального, экономического и политического прогресса в обществе. Неизбежность информатизации обусловлена следующими причинами: - беспрецедентным усложнением социально-экономических процессов в результате увеличения масштабов и темпов общественного производства, - углубления разделения труда и его специализации в научно-технической революции; - необходимостью адекватно реагировать на возникающие проблемы в динамично меняющейся обстановке, присущей постоянно развивающемуся обществу; - повышением степени самоуправления предприятий, территорий, регионов.

Информатизация прежде всего охватывает все элементы рыночной инфраструктуры экономики: - сеть оптовой и розничной торговли; - товарные, фондовые, валютные биржи, биржи труда, ярмарки; - сети банков и кредитно-финансовых учреждений; - сеть независимых посреднических фирм и контор, оказывающих различные услуги, в том числе и информационные, субъектам рынка; - складское и транспортное хозяйство; - страховые компании; - налоговую службу; - систему подготовки и переквалификации кадров; - аудиторскую службу и т. д. Научным фундаментом процесса информатизации общества является новая научная дисциплина — информатика. В широком смысле информатика — это наука об информационной деятельности, информационных процессах и их организации в человеко-машинных системах. Основными разделами информатики являются исследование и разработка информационных средств и технологий, программных средств и моделирование предметных областей.

Информатизация прежде всего охватывает все элементы рыночной инфраструктуры экономики: - сеть оптовой и розничной торговли; - товарные, фондовые, валютные биржи, биржи труда, ярмарки; - сети банков и кредитно-финансовых учреждений; - сеть независимых посреднических фирм и контор, оказывающих различные услуги, в том числе и информационные, субъектам рынка; - складское и транспортное хозяйство; - страховые компании; - налоговую службу; - систему подготовки и переквалификации кадров; - аудиторскую службу и т. д. Научным фундаментом процесса информатизации общества является новая научная дисциплина — информатика. В широком смысле информатика — это наука об информационной деятельности, информационных процессах и их организации в человеко-машинных системах. Основными разделами информатики являются исследование и разработка информационных средств и технологий, программных средств и моделирование предметных областей.

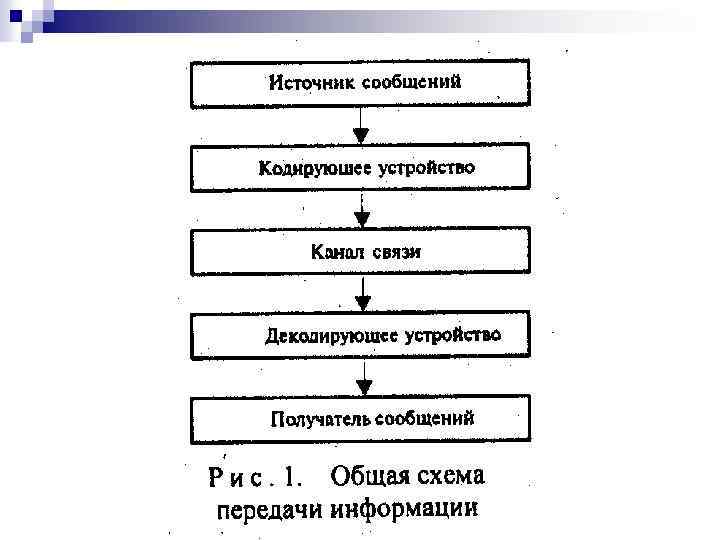

Термин информация имеет множество определений. В «Энциклопедии кибернетики» «информация ( лат. informatio – разъяснение, изложение, осведомленность ) – одно из наиболее общих понятий науки, обозначающее некоторые сведения, совокупность каких-либо данных, знаний и т. п. » . В широком смысле «информация» – это отражение реального мира; в узком , смысла «информация» – это любые сведения, являющиеся объектом хранения, передачи и преобразования. Термин informatique был введен впервые французскими учеными в начале 70 -х годов и означал «наука о преобразовании информации» . информации Информатика – это наука, изучающая процессы сбора, преобразования, хранения, защиты, поиска и передачи всех видов информации, а также средства их автоматизированной обработки. С практической точки зрения информация всегда представляется в виде сообщения. Информационное сообщение связано с источником сообщения, получателем сообщений и каналом связи (рис. 1).

Термин информация имеет множество определений. В «Энциклопедии кибернетики» «информация ( лат. informatio – разъяснение, изложение, осведомленность ) – одно из наиболее общих понятий науки, обозначающее некоторые сведения, совокупность каких-либо данных, знаний и т. п. » . В широком смысле «информация» – это отражение реального мира; в узком , смысла «информация» – это любые сведения, являющиеся объектом хранения, передачи и преобразования. Термин informatique был введен впервые французскими учеными в начале 70 -х годов и означал «наука о преобразовании информации» . информации Информатика – это наука, изучающая процессы сбора, преобразования, хранения, защиты, поиска и передачи всех видов информации, а также средства их автоматизированной обработки. С практической точки зрения информация всегда представляется в виде сообщения. Информационное сообщение связано с источником сообщения, получателем сообщений и каналом связи (рис. 1).

2

2

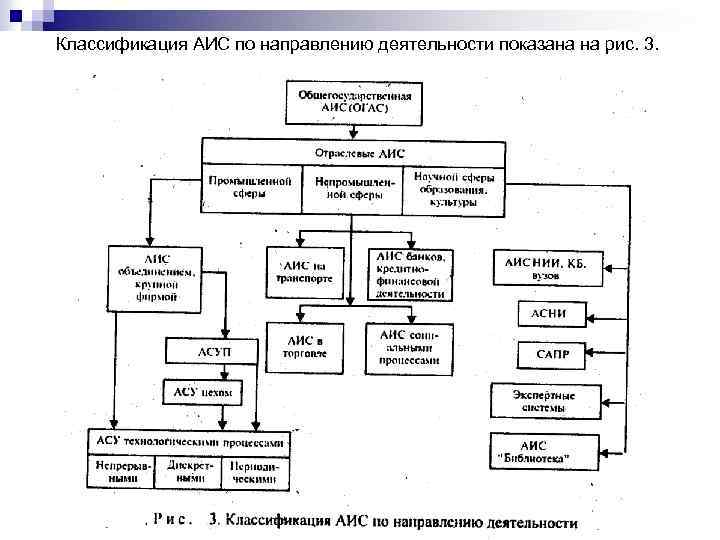

ОБЪЕКТ ИНФОРМАТИКИ Объектом информатики выступают автоматизированные, основанные на ПК и телекоммуникационной технике, информационные системы (ИС) различного класса и назначения. Информатика изучает все стороны их разработки, проектирования, создания, анализа и использования на практике. Информационные технологии (ИТ) – это машинизированные (инженерные) способы обработки семантической информации – данных и знаний, которые реализуются посредством автоматизированных информационных систем (АИС). В настоящее время АИС получили широчайшее распространение. Классификация АИС осуществляется по ряду признаков, и в зависимости от решаемой задачи можно выбрать разные признаки классификации. При этом одна и та же АИС может характеризоваться одним иди несколькими признаками. В качестве признаков классификации АИС используются: область применения, охватываемая территория, организация информационных процессов, направление деятельности, назначения, структура и др.

ОБЪЕКТ ИНФОРМАТИКИ Объектом информатики выступают автоматизированные, основанные на ПК и телекоммуникационной технике, информационные системы (ИС) различного класса и назначения. Информатика изучает все стороны их разработки, проектирования, создания, анализа и использования на практике. Информационные технологии (ИТ) – это машинизированные (инженерные) способы обработки семантической информации – данных и знаний, которые реализуются посредством автоматизированных информационных систем (АИС). В настоящее время АИС получили широчайшее распространение. Классификация АИС осуществляется по ряду признаков, и в зависимости от решаемой задачи можно выбрать разные признаки классификации. При этом одна и та же АИС может характеризоваться одним иди несколькими признаками. В качестве признаков классификации АИС используются: область применения, охватываемая территория, организация информационных процессов, направление деятельности, назначения, структура и др.

Классификация АИС по направлению деятельности показана на рис. 3.

Классификация АИС по направлению деятельности показана на рис. 3.

В промышленной сфере превалирует отраслевой характер иерархии АИС. По территориальному признаку классификация АИС приведена на рис. 4.

В промышленной сфере превалирует отраслевой характер иерархии АИС. По территориальному признаку классификация АИС приведена на рис. 4.

В зависимости от организации информационных процессов АИС делятся на два больших класса: управляющие и информационные. В информационных системах управление исследований – отсутствует АСНИ, (автоматизированные «Библиотека» , системы научных автоматизированного проектирования – САПР, экспертные системы – ЭС и др. ). По сфере применения АИС различаются следующим образом: административные, производственные, учебные, медицинские, военные, метеорологические, экологические, криминалистические и др. Назначение и структура построения АИС характеризуются наличием соответствующих подсистем (рис. 5). Этот класс АИС является исторически одним из первых на производстве. АИС различаются также по уровню развития в зависимости от поколений ЭВМ, на которых они базируются. Разнообразие ИТ и АИС постоянно растет.

В зависимости от организации информационных процессов АИС делятся на два больших класса: управляющие и информационные. В информационных системах управление исследований – отсутствует АСНИ, (автоматизированные «Библиотека» , системы научных автоматизированного проектирования – САПР, экспертные системы – ЭС и др. ). По сфере применения АИС различаются следующим образом: административные, производственные, учебные, медицинские, военные, метеорологические, экологические, криминалистические и др. Назначение и структура построения АИС характеризуются наличием соответствующих подсистем (рис. 5). Этот класс АИС является исторически одним из первых на производстве. АИС различаются также по уровню развития в зависимости от поколений ЭВМ, на которых они базируются. Разнообразие ИТ и АИС постоянно растет.

Информационные технологии – это машинизированные способы обработки, хранения, передачи и использования информации в виде знаний. Они включают два основных элемента – машинный и человеческий (социальный), причем последний выступает главным. Подчеркнем, что объектом информатики выступают не сами по себе ПК как программно-технические комплексы, а ИТ, воплощением которых служат компьютеризированные, или человеко-машинные, точнее, социотехнические системы. В отличие от производственных, энергопреобразующих ИТ (объект информатики) относятся к социальным, знаниепреобразующим технологиям. Понятие технологии включает комплекс научных и инженерных знаний, воплощенных в приемах труда, наборах материальных, технических, энергетических, трудовых факторов производства, способов их соединения для создания продукта или услуги, отвечающих определенным требованиям, стандартам. В таком понимании термин технология неразрывно связан с машинизацией производственного или непроизводственного (социального) процесса. Последнее важно подчеркнуть для обозначения точных исторических границ информатики: информатики не могло быть в домашинный период обработки и представления знаний, когда не было ИТ. Переработка информации с помощью ПК и выработка новых знаний, соотнесенных с целями пользователей, – функциональное назначение ИТ.

Информационные технологии – это машинизированные способы обработки, хранения, передачи и использования информации в виде знаний. Они включают два основных элемента – машинный и человеческий (социальный), причем последний выступает главным. Подчеркнем, что объектом информатики выступают не сами по себе ПК как программно-технические комплексы, а ИТ, воплощением которых служат компьютеризированные, или человеко-машинные, точнее, социотехнические системы. В отличие от производственных, энергопреобразующих ИТ (объект информатики) относятся к социальным, знаниепреобразующим технологиям. Понятие технологии включает комплекс научных и инженерных знаний, воплощенных в приемах труда, наборах материальных, технических, энергетических, трудовых факторов производства, способов их соединения для создания продукта или услуги, отвечающих определенным требованиям, стандартам. В таком понимании термин технология неразрывно связан с машинизацией производственного или непроизводственного (социального) процесса. Последнее важно подчеркнуть для обозначения точных исторических границ информатики: информатики не могло быть в домашинный период обработки и представления знаний, когда не было ИТ. Переработка информации с помощью ПК и выработка новых знаний, соотнесенных с целями пользователей, – функциональное назначение ИТ.

Предметом информатики как новой фундаментальной науки выступает информационный ресурс (ИР) – его сущность, законы функционирования, механизмы взаимодействия с другими ресурсами общества и воздействия на социальный прогресс. Переход на уровень ИР в его содержательной трактовке означает переход к изучению внутренних связей и закономерностей социальной динамики, основанной на использовании ИТ. Информатика как наука о законах получения, передачи и использования ИР в общественной практике подводит теоретический фундамент под использование ПК и автоматизированных систем, которые и предназначены для усиления информационных процессов в обществе использования ИР. Речь идет прежде всего о специальных ИР, основанных на компьютерной технике и реализующих ИТ, т. е. инженерную обработку знаний (Knowledge Engineering). Таким образом, предметом информатики является информационный ресурс как симбиоз знания и информации. Он выступает в качестве предмета новой науки и с содержательной, и с формальноматематической, и с технической стороны.

Предметом информатики как новой фундаментальной науки выступает информационный ресурс (ИР) – его сущность, законы функционирования, механизмы взаимодействия с другими ресурсами общества и воздействия на социальный прогресс. Переход на уровень ИР в его содержательной трактовке означает переход к изучению внутренних связей и закономерностей социальной динамики, основанной на использовании ИТ. Информатика как наука о законах получения, передачи и использования ИР в общественной практике подводит теоретический фундамент под использование ПК и автоматизированных систем, которые и предназначены для усиления информационных процессов в обществе использования ИР. Речь идет прежде всего о специальных ИР, основанных на компьютерной технике и реализующих ИТ, т. е. инженерную обработку знаний (Knowledge Engineering). Таким образом, предметом информатики является информационный ресурс как симбиоз знания и информации. Он выступает в качестве предмета новой науки и с содержательной, и с формальноматематической, и с технической стороны.

Информатика делится на две части: теоретическую и прикладную информатику. Теоретическая информатика рассматривает все аспекты разработки АИС: их проектирования, создания и использования не только с формальнотехнической, но и содержательной стороны, а также комплекс экономического, политического и культурного воздействия на социальную динамику. В анализ теоретической информатики попадают и традиционные системы преобразования информации и распространения знаний: средства и системы массовой информации, система лекционной пропаганды, кино, театры, справочные службы и т. д. Но теоретическая информатика рассматривает их с определенной стороны – с позиций получения и использования ИР, форм и способов воздействия указанных систем на общественный прогресс, возможной их технологизации. Теоретическая информатика изучает ИР, законы его функционирования и использования как движущей силы социального прогресса. Теоретическая информатика изучает общие свойства, присущие всем многочисленным разновидностям конкретных ИТ, процессов и сред их протекания. Всем им характерны такие понятия, как носители информации, каналы связи, информационные контуры, сигналы, прямые и обратные связи, данные, сведения и т. д. Все они делятся на различные фазы и подпроцессы: прием, кодирование, передача, декодирование, хранение, извлечение, отображение информации. Решающее значение для рождения теоретической информатики имеет появление ИТ высшего уровня, основанных на искусственном интеллекте (ИИ).

Информатика делится на две части: теоретическую и прикладную информатику. Теоретическая информатика рассматривает все аспекты разработки АИС: их проектирования, создания и использования не только с формальнотехнической, но и содержательной стороны, а также комплекс экономического, политического и культурного воздействия на социальную динамику. В анализ теоретической информатики попадают и традиционные системы преобразования информации и распространения знаний: средства и системы массовой информации, система лекционной пропаганды, кино, театры, справочные службы и т. д. Но теоретическая информатика рассматривает их с определенной стороны – с позиций получения и использования ИР, форм и способов воздействия указанных систем на общественный прогресс, возможной их технологизации. Теоретическая информатика изучает ИР, законы его функционирования и использования как движущей силы социального прогресса. Теоретическая информатика изучает общие свойства, присущие всем многочисленным разновидностям конкретных ИТ, процессов и сред их протекания. Всем им характерны такие понятия, как носители информации, каналы связи, информационные контуры, сигналы, прямые и обратные связи, данные, сведения и т. д. Все они делятся на различные фазы и подпроцессы: прием, кодирование, передача, декодирование, хранение, извлечение, отображение информации. Решающее значение для рождения теоретической информатики имеет появление ИТ высшего уровня, основанных на искусственном интеллекте (ИИ).

Прикладная информатика изучает конкретные разновидности ИТ, которые формируются с помощью специальных ИС (управленческих, медицинских, обучающих, военных, криминалистических и др. ). Очевидно, что такие ИТ, как, например, управление (АСУП, АСУТП), проектные разработки (САПР) или криминалистика, имея общие черты, в то же время существенно различаются между собой. Разные специализация операции критериев и и процедуры, показателей, различное разная степень оборудование, замкнутости информационных контуров, даже разные информационные носители, т. е. разные информационные среды, – все это становится объектом изучения конкретных функциональных и отраслевых информатик. Так рождаются ветви прикладной информатики, обслуживающие создание проектирующих систем, экспертных систем, диагностических комплексов, управляющих и других функциональных систем. Возникли также отраслевые ветви информатики, обслуживающие информатизацию разных сфер социальной и экономической практики: промышленность, науку, медицину, связь и т. д. Поэтому наряду с теоретической информатикой развиваются ее конкретные ветви: экономическая информатика, медицинская информатика, военная информатика и др.

Прикладная информатика изучает конкретные разновидности ИТ, которые формируются с помощью специальных ИС (управленческих, медицинских, обучающих, военных, криминалистических и др. ). Очевидно, что такие ИТ, как, например, управление (АСУП, АСУТП), проектные разработки (САПР) или криминалистика, имея общие черты, в то же время существенно различаются между собой. Разные специализация операции критериев и и процедуры, показателей, различное разная степень оборудование, замкнутости информационных контуров, даже разные информационные носители, т. е. разные информационные среды, – все это становится объектом изучения конкретных функциональных и отраслевых информатик. Так рождаются ветви прикладной информатики, обслуживающие создание проектирующих систем, экспертных систем, диагностических комплексов, управляющих и других функциональных систем. Возникли также отраслевые ветви информатики, обслуживающие информатизацию разных сфер социальной и экономической практики: промышленность, науку, медицину, связь и т. д. Поэтому наряду с теоретической информатикой развиваются ее конкретные ветви: экономическая информатика, медицинская информатика, военная информатика и др.

КРАТКАЯ ИСТОРИЯ РАЗВИТИЯ ИНФОРМАТИКИ Информатика как наука стала развиваться с середины нашего столетия, что связано с появлением ЭВМ и начинающейся компьютерной революцией. Всю историю информатики принято разбивать на два больших этапа: предыстория и история. Предыстория информатики такая же древняя, как и история развития человеческого общества. В предыстории выделяют (весьма приближенно) ряд этапов. Каждый из этих этапов характеризуется по сравнению с предыдущим резким возрастанием возможностей хранения, передачи и обработки информации. Начальный этап предыстории – освоение человеком развитой устной речи. Членораздельная речь, язык стал специфическим Социальным средством хранения и передачи информации. Второй этап – возникновение письменности. Прежде всего резко возросли (по сравнению с предыдущим этапом) возможности по хранению информации. Человек получил искусственную внешнюю память. Организация почтовых служб позволила использовать письменность и как средство для передачи информации. Кроме того, возникновение письменности было необходимым условием для начала развития наук (вспомним Древнюю Грецию, например). С этим же этапом, по всей видимости, связано и возникновение понятия натуральное число. Все народы, обладавшие письменностью, владели понятием числа и пользовались той или иной системой счисления.

КРАТКАЯ ИСТОРИЯ РАЗВИТИЯ ИНФОРМАТИКИ Информатика как наука стала развиваться с середины нашего столетия, что связано с появлением ЭВМ и начинающейся компьютерной революцией. Всю историю информатики принято разбивать на два больших этапа: предыстория и история. Предыстория информатики такая же древняя, как и история развития человеческого общества. В предыстории выделяют (весьма приближенно) ряд этапов. Каждый из этих этапов характеризуется по сравнению с предыдущим резким возрастанием возможностей хранения, передачи и обработки информации. Начальный этап предыстории – освоение человеком развитой устной речи. Членораздельная речь, язык стал специфическим Социальным средством хранения и передачи информации. Второй этап – возникновение письменности. Прежде всего резко возросли (по сравнению с предыдущим этапом) возможности по хранению информации. Человек получил искусственную внешнюю память. Организация почтовых служб позволила использовать письменность и как средство для передачи информации. Кроме того, возникновение письменности было необходимым условием для начала развития наук (вспомним Древнюю Грецию, например). С этим же этапом, по всей видимости, связано и возникновение понятия натуральное число. Все народы, обладавшие письменностью, владели понятием числа и пользовались той или иной системой счисления.

Третий этап – книгопечатание. Книгопечатание можно смело назвать первой информационной технологией. Воспроизведение информации было поставлено на поток, на промышленную основу. По сравнению с предыдущим этот этап не столько увеличил возможности по хранению (хотя и здесь был выигрыш: письменный источник – часто один единственный экземпляр, печатная книга – целый тираж экземпляров, а следовательно, и малая вероятность потери информации при хранении (вспомним «Слово о полку Игореве» )), сколько повысил доступность информации и точность ее воспроизведения. Четвертый и последний этап предыстории связан с успехами точных наук (прежде всего математики и физики) и начинающейся в то время научнотехнической революцией. Этот этап характеризуется возникновением таких мощных средств связи, как радио, телефон и телеграф, к которым по завершению этапа добавилось и телевидение. Кроме средств связи появились новые возможности по получению и хранению информации – фотография и кино. К ним также очень важно добавить разработку методов записи информации на магнитные носители (магнитные ленты, диски).

Третий этап – книгопечатание. Книгопечатание можно смело назвать первой информационной технологией. Воспроизведение информации было поставлено на поток, на промышленную основу. По сравнению с предыдущим этот этап не столько увеличил возможности по хранению (хотя и здесь был выигрыш: письменный источник – часто один единственный экземпляр, печатная книга – целый тираж экземпляров, а следовательно, и малая вероятность потери информации при хранении (вспомним «Слово о полку Игореве» )), сколько повысил доступность информации и точность ее воспроизведения. Четвертый и последний этап предыстории связан с успехами точных наук (прежде всего математики и физики) и начинающейся в то время научнотехнической революцией. Этот этап характеризуется возникновением таких мощных средств связи, как радио, телефон и телеграф, к которым по завершению этапа добавилось и телевидение. Кроме средств связи появились новые возможности по получению и хранению информации – фотография и кино. К ним также очень важно добавить разработку методов записи информации на магнитные носители (магнитные ленты, диски).

История развития вычислительных средств

История развития вычислительных средств

В V – IV вв. до н. э. созданы древнейшие из известных счётов – «саламинская доска» (по имени острова Саламин в Эгейском море), которая у греков и в Западной Европе назывались «абак» .

В V – IV вв. до н. э. созданы древнейшие из известных счётов – «саламинская доска» (по имени острова Саламин в Эгейском море), которая у греков и в Западной Европе назывались «абак» .

У китайцев – «суан-пан» , у японцев – «серобян» , в России – «щоты» .

У китайцев – «суан-пан» , у японцев – «серобян» , в России – «щоты» .

1614 г. – шотландский математик Джон Непер опубликовал «Описание таблиц логарифмов» . 1617 г. – Непер опубликовал трактат «Счёт с помощью палочек» . 1624 г. – Вильгельм Шиккард в письмах к И. Кеплеру описал устройство «часов для счёта» , в которых было реализовано сложение и вычитание, умножение и деление. В основе конструкции – «палочки Непера» , свёрнутые в цилиндр.

1614 г. – шотландский математик Джон Непер опубликовал «Описание таблиц логарифмов» . 1617 г. – Непер опубликовал трактат «Счёт с помощью палочек» . 1624 г. – Вильгельм Шиккард в письмах к И. Кеплеру описал устройство «часов для счёта» , в которых было реализовано сложение и вычитание, умножение и деление. В основе конструкции – «палочки Непера» , свёрнутые в цилиндр.

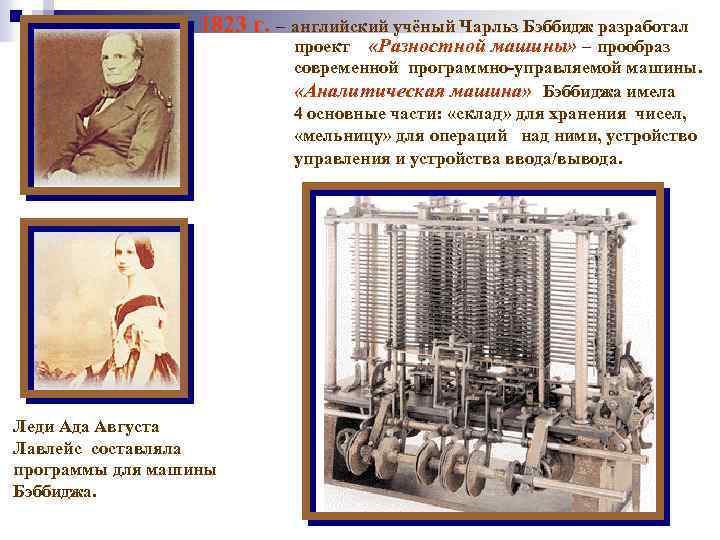

Основы информационной теории и техники были заложены Шиккардом, Паскалем, Лейбницем. В. Шиккард, профессор Тюбингенского университета, в 1623 г, предложил агрегат, состоявший из суммирующего и множительного устройств. Машина Б. Паскаля, построенная в 1642 г. , могла складывать и вычитать; она демонстрировалась в Люксембургском дворце как величайшее достижение человеческой мысли, о ней сочинялись стихи и легенды. А в 1673 г, немецкий математик и философ Г. Лейбниц представил в Парижскую академию вычислитель, выполнявший четыре действия арифметики. Ч. Беббидж, профессор Кембриджского университета, в 1812 - 1823 гг. построил разностную машину. В ее конструкции впервые был реализован принцип программного управления вычислительным процессом. В 1835 г. Беббидж создал проект аналитической машины, в которую предварительно заносились исходные данные, а ход вычислений мог зависеть от промежуточных результатов. Машина состояла из «склада» , «мельницы» и «управляющего» . Фрагмент такого вычислителя построил сын ученого, а программы для него готовила Ада Лавлейс (Байрон).

Основы информационной теории и техники были заложены Шиккардом, Паскалем, Лейбницем. В. Шиккард, профессор Тюбингенского университета, в 1623 г, предложил агрегат, состоявший из суммирующего и множительного устройств. Машина Б. Паскаля, построенная в 1642 г. , могла складывать и вычитать; она демонстрировалась в Люксембургском дворце как величайшее достижение человеческой мысли, о ней сочинялись стихи и легенды. А в 1673 г, немецкий математик и философ Г. Лейбниц представил в Парижскую академию вычислитель, выполнявший четыре действия арифметики. Ч. Беббидж, профессор Кембриджского университета, в 1812 - 1823 гг. построил разностную машину. В ее конструкции впервые был реализован принцип программного управления вычислительным процессом. В 1835 г. Беббидж создал проект аналитической машины, в которую предварительно заносились исходные данные, а ход вычислений мог зависеть от промежуточных результатов. Машина состояла из «склада» , «мельницы» и «управляющего» . Фрагмент такого вычислителя построил сын ученого, а программы для него готовила Ада Лавлейс (Байрон).

1642 г. – 18 -летний французский физик и математик Блез Паскаль создает первую модель вычислительной машины «Паскалину» или «Паскалево колесо» . 1670 г. – Готфрид Вильгельм Лейбниц дал первое описание своей счётной машины, которая механически производила сложение, вычитание, умножение и деление.

1642 г. – 18 -летний французский физик и математик Блез Паскаль создает первую модель вычислительной машины «Паскалину» или «Паскалево колесо» . 1670 г. – Готфрид Вильгельм Лейбниц дал первое описание своей счётной машины, которая механически производила сложение, вычитание, умножение и деление.

1770 г. – в г. Несвеже в Литве Е. Якобсон создаёт суммирующую машину, способную работать с 5 -значными числами. 1770 г. – священник из Вюльтерберга Ган сконструировал несколько машин для астрономических вычислений. 1820 г. – эльзасец Карл Ксавье Томас изобрёл арифмометр и впервые в мире организовал промышленное производство арифмометров.

1770 г. – в г. Несвеже в Литве Е. Якобсон создаёт суммирующую машину, способную работать с 5 -значными числами. 1770 г. – священник из Вюльтерберга Ган сконструировал несколько машин для астрономических вычислений. 1820 г. – эльзасец Карл Ксавье Томас изобрёл арифмометр и впервые в мире организовал промышленное производство арифмометров.

1823 г. – английский учёный Чарльз Бэббидж разработал проект «Разностной машины» – прообраз современной программно-управляемой машины. «Аналитическая машина» Бэббиджа имела 4 основные части: «склад» для хранения чисел, «мельницу» для операций над ними, устройство управления и устройства ввода/вывода. Леди Ада Августа Лавлейс составляла программы для машины Бэббиджа.

1823 г. – английский учёный Чарльз Бэббидж разработал проект «Разностной машины» – прообраз современной программно-управляемой машины. «Аналитическая машина» Бэббиджа имела 4 основные части: «склад» для хранения чисел, «мельницу» для операций над ними, устройство управления и устройства ввода/вывода. Леди Ада Августа Лавлейс составляла программы для машины Бэббиджа.

Перфокарты для «Аналитической машины» . Работы по изготовлению «Аналитической машины» были прерваны смертью Ч. Бэббиджа. Полностью «Разностная машина» Ч. Бэббиджа была достроена только в наше время в 1991 г. двумя инженерами Р. Криком и Б. Холловеем в Лондонском научном музее к 200 -летию со дня рождения её автора. Она состоит из 4000 деталей и может вычислять разности 7 -го порядка.

Перфокарты для «Аналитической машины» . Работы по изготовлению «Аналитической машины» были прерваны смертью Ч. Бэббиджа. Полностью «Разностная машина» Ч. Бэббиджа была достроена только в наше время в 1991 г. двумя инженерами Р. Криком и Б. Холловеем в Лондонском научном музее к 200 -летию со дня рождения её автора. Она состоит из 4000 деталей и может вычислять разности 7 -го порядка.

«Наследниками» первых проектов вычислительной техники во второй половине XIX в. стали арифмометры, в которых числа определялись положением зубчатых колес. Партию таких приборов изготовил немецкий инженер К. Томас, Механизмы арифмометров были исследованы академиком П. Л. Чебышевым. Им же был изобретен эпициклический механизм с плавным Переносом разрядов, впоследствии использованный американской фирмой «Merchent» в серийных вычислителях. Один из арифмометров Чебышева хранится в Музее истории Санкт -Петербурга. В 1880 г. Г. Холлерит сконструировал электромеханический перфокарточный табулятор, применявшийся при обработке результатов переписи населения в США и в России. Первую компанию по производству клавишных арифмометров открыл в 1885 г. У. Берроуз. Известный механик А. Н. Крылов в своих «Лекциях о приближенных вычислениях» привел описание различных механических систем для вычисления интегралов и гармонического анализа. В 1911 г. он построил уникальный аналоговый решатель дифференциальных уравнений, а позднее предложил механический интегратор. В 1919 г. академик Н. Н. Павловский изобрел аналоговую вычислительную машину.

«Наследниками» первых проектов вычислительной техники во второй половине XIX в. стали арифмометры, в которых числа определялись положением зубчатых колес. Партию таких приборов изготовил немецкий инженер К. Томас, Механизмы арифмометров были исследованы академиком П. Л. Чебышевым. Им же был изобретен эпициклический механизм с плавным Переносом разрядов, впоследствии использованный американской фирмой «Merchent» в серийных вычислителях. Один из арифмометров Чебышева хранится в Музее истории Санкт -Петербурга. В 1880 г. Г. Холлерит сконструировал электромеханический перфокарточный табулятор, применявшийся при обработке результатов переписи населения в США и в России. Первую компанию по производству клавишных арифмометров открыл в 1885 г. У. Берроуз. Известный механик А. Н. Крылов в своих «Лекциях о приближенных вычислениях» привел описание различных механических систем для вычисления интегралов и гармонического анализа. В 1911 г. он построил уникальный аналоговый решатель дифференциальных уравнений, а позднее предложил механический интегратор. В 1919 г. академик Н. Н. Павловский изобрел аналоговую вычислительную машину.

1828 г. – генерал-майор русской армии Ф. М. Слободской создаёт счётные приборы, которые вместе со специальными таблицами позволяли сводить арифметические действия к сложению и вычитанию. 1834 г. – французский академик, физик и математик Андре Мари Ампер выпустил книгу, в которой впервые применил термин «кибернетика» . 1847 г. – английский математик-самоучка Джордж Буль в работе «Математический анализ логики» изложил основы булевой алгебры. Д. Буль считается основоположником современной математической логики.

1828 г. – генерал-майор русской армии Ф. М. Слободской создаёт счётные приборы, которые вместе со специальными таблицами позволяли сводить арифметические действия к сложению и вычитанию. 1834 г. – французский академик, физик и математик Андре Мари Ампер выпустил книгу, в которой впервые применил термин «кибернетика» . 1847 г. – английский математик-самоучка Джордж Буль в работе «Математический анализ логики» изложил основы булевой алгебры. Д. Буль считается основоположником современной математической логики.

1867 г. – Владимир Яковлевич Буняковский – вице-президент Российской академии наук создаёт счётный механизм, основанный на принципе действия русских счётов. 1867 г. – американский топограф К. Шоулз изобретает первую пишущую машинку. 1878 г. – русский математик и механик П. Л. Чебышев создаёт суммирующий аппарат. 1880 г. – петербургский инженер Т. Однер конструирует арифмометр. Его модификация «Феликс» выпускалась в СССР до 50 -х годов.

1867 г. – Владимир Яковлевич Буняковский – вице-президент Российской академии наук создаёт счётный механизм, основанный на принципе действия русских счётов. 1867 г. – американский топограф К. Шоулз изобретает первую пишущую машинку. 1878 г. – русский математик и механик П. Л. Чебышев создаёт суммирующий аппарат. 1880 г. – петербургский инженер Т. Однер конструирует арифмометр. Его модификация «Феликс» выпускалась в СССР до 50 -х годов.

1885 г. – американец У. Берроуз создаёт машину, которая печатает исходные цифры и результат вычислений.

1885 г. – американец У. Берроуз создаёт машину, которая печатает исходные цифры и результат вычислений.

1888 г. – в США Г. Холлерит создаёт особое устройство – табулятор, в котором информация, нанесённая на перфокарты, расшифровывалась электрическим током.

1888 г. – в США Г. Холлерит создаёт особое устройство – табулятор, в котором информация, нанесённая на перфокарты, расшифровывалась электрическим током.

1897 г. – английский физик Дж. Томсон сконструировал электронно-лучевую трубку. 1918 г. – учёный М. А. Бонч-Бруевич в России изобретает ламповый триггер.

1897 г. – английский физик Дж. Томсон сконструировал электронно-лучевую трубку. 1918 г. – учёный М. А. Бонч-Бруевич в России изобретает ламповый триггер.

Прогрессом в области компонентов вычислительной техники мир во многом обязан фирме «Motorola» , основанной в США в 1928 г. Ее персоналу удалось создать электронные узлы многих зарубежных вычислителей. В 1936 г. английский математик А. Тьюринг опубликовал доказательство того, что любой алгоритм может быть реализован с помощью дискретного автомата. Он предложил абстрактную схему такого автомата, получившего название «машины Тьюринга» и положившего начало целому поколению моделей в теории автоматов. Этой разработкой была доказана возможность создания универсального цифрового вычислителя. В том же 1936 г. независимо от Тьюринга похожая идея абстрактного автомата была опубликована Э. Постом. Работы по созданию цифровых вычислительных машин были начаты в 1936 - 1938 гг. немецким инженером К. Зюсом, американским физиком Дж. В. Атанасовым и американским математиком К. Шенноном. И уже в 1939 г. их земляком, инженером Дж. Стибницем была создана релейная машина BELL, выполнявшая действия над комплексными числами в двоично-пятеричной системесчисления, а Дж. фон Нейманом – вычислитель MANIAC. Тогда же У. Хьюлетт и Д. Паккард основали компанию для производства компонентов первых вычислителей.

Прогрессом в области компонентов вычислительной техники мир во многом обязан фирме «Motorola» , основанной в США в 1928 г. Ее персоналу удалось создать электронные узлы многих зарубежных вычислителей. В 1936 г. английский математик А. Тьюринг опубликовал доказательство того, что любой алгоритм может быть реализован с помощью дискретного автомата. Он предложил абстрактную схему такого автомата, получившего название «машины Тьюринга» и положившего начало целому поколению моделей в теории автоматов. Этой разработкой была доказана возможность создания универсального цифрового вычислителя. В том же 1936 г. независимо от Тьюринга похожая идея абстрактного автомата была опубликована Э. Постом. Работы по созданию цифровых вычислительных машин были начаты в 1936 - 1938 гг. немецким инженером К. Зюсом, американским физиком Дж. В. Атанасовым и американским математиком К. Шенноном. И уже в 1939 г. их земляком, инженером Дж. Стибницем была создана релейная машина BELL, выполнявшая действия над комплексными числами в двоично-пятеричной системесчисления, а Дж. фон Нейманом – вычислитель MANIAC. Тогда же У. Хьюлетт и Д. Паккард основали компанию для производства компонентов первых вычислителей.

1928 г. – американский математик Дж. Нейман сформулировал основы теории игр, ныне применяемых в практике машинного моделирования. Он сформулировал основные принципы, лежащие в основе архитектуры вычислительной машины. 1936 г. – английский математик А. Тьюринг выдвинул и разработал идею абстрактной вычислительной машины. «Машина Тьюринга» – гипотетический универсальный преобразователь дискретной информации, теоретическая вычислительная система.

1928 г. – американский математик Дж. Нейман сформулировал основы теории игр, ныне применяемых в практике машинного моделирования. Он сформулировал основные принципы, лежащие в основе архитектуры вычислительной машины. 1936 г. – английский математик А. Тьюринг выдвинул и разработал идею абстрактной вычислительной машины. «Машина Тьюринга» – гипотетический универсальный преобразователь дискретной информации, теоретическая вычислительная система.

1936 г. – немецкий инженер-кибернетик К. Зюс начал работу над универсальной автоматической цифровой машиной. 1938 г. – американский математик и инженер Клод Шеннон связал Булеву алгебру (аппарат математической логики), двоичную систему кодирования и релейно-контактные переключательные схемы, заложив основы будущих ЭВМ. 1939 г. – Дж. Стибниц завершил работу над релейной машиной «Белл» , которая выполняла арифметические действия в двоично-пятеричной системе. Управлялась она программной перфолентой.

1936 г. – немецкий инженер-кибернетик К. Зюс начал работу над универсальной автоматической цифровой машиной. 1938 г. – американский математик и инженер Клод Шеннон связал Булеву алгебру (аппарат математической логики), двоичную систему кодирования и релейно-контактные переключательные схемы, заложив основы будущих ЭВМ. 1939 г. – Дж. Стибниц завершил работу над релейной машиной «Белл» , которая выполняла арифметические действия в двоично-пятеричной системе. Управлялась она программной перфолентой.

Значителен вклад в развитие вычислительной техники американской фирмы IBM, основанной еще в 1911 г. на базе фирмы Г. Холлерита для производства весов, регистраторов времени и табуляторов. В 1944 г. по проекту Г. Айткена здесь был собран из 150000 деталей и 35000 м провода дискретный вычислитель. Спустя 12 лет (1956 г. ) этой фирмой был предложен первый алгоритмический язык ФОРТРАН, а к настоящему времени она выросла в ведущую мировую компанию, поставляющую оборудование для обработки информации, системы связи и программное обеспечение более, чем в 30 стран. В 1945 г, В. Буш, руководивший научной работой военных ведомств Америки, привлек внимание общественности к проблеме растущего объема научных исследований. Он указал на то, что научного работника «ошеломляют открытия и заключения, сделанные тысячами других специалистов и появляющиеся с такой скоростью, что их невозможно ни осознать, ни, тем более, запомнить» . Речь шла не просто о накоплении большого объема данных исследовательских работ, а о гораздо более серьезной проблеме, касающейся всего процесса использования накопленных человечеством информационного взрыва. знаний. Это явление получило название

Значителен вклад в развитие вычислительной техники американской фирмы IBM, основанной еще в 1911 г. на базе фирмы Г. Холлерита для производства весов, регистраторов времени и табуляторов. В 1944 г. по проекту Г. Айткена здесь был собран из 150000 деталей и 35000 м провода дискретный вычислитель. Спустя 12 лет (1956 г. ) этой фирмой был предложен первый алгоритмический язык ФОРТРАН, а к настоящему времени она выросла в ведущую мировую компанию, поставляющую оборудование для обработки информации, системы связи и программное обеспечение более, чем в 30 стран. В 1945 г, В. Буш, руководивший научной работой военных ведомств Америки, привлек внимание общественности к проблеме растущего объема научных исследований. Он указал на то, что научного работника «ошеломляют открытия и заключения, сделанные тысячами других специалистов и появляющиеся с такой скоростью, что их невозможно ни осознать, ни, тем более, запомнить» . Речь шла не просто о накоплении большого объема данных исследовательских работ, а о гораздо более серьезной проблеме, касающейся всего процесса использования накопленных человечеством информационного взрыва. знаний. Это явление получило название

Ответом на «взрыв» послужили первые компьютеры (computer), или ЭВМ: электромеханическая ENIGMA в Англии, электронные ENIAC в США и МЭСМ на Украине. Электронный вычислительный интегратор и калькулятор ENIAC сконструировали Д. Моучли и Дж. Эккерт в 1946 г. в Пенсильванском университете. Собранный из 18000 вакуумных приборов, он имел массу 30 тонн и занимал площадь 150 м. Машина использовалась для решения задач, связанных с проектом атомной бомбы, и на Абердинском испытательном полигоне работала до 1955 г. В 1948 г. в Массачусетском университете был построен первый компьютер с памятью. В 1949 г. ламповый компьютер универсального назначения MARK 1 был сконструирован учеными Манчестерского университета, а в 1950 г. коммерческий вычислитель MARK 1 STAR выпустила фирма «Ferranty» . На Украине начало развитию вычислительных машин и электронной промышленности, было положено в 1950 г. малой электронно-счетной машиной МЭСМ С. А. Лебедева. Выполненная на базе 7500 ламп на площади в 64 м , МЭСМ потребляла 25 к. Вт электроэнергии, обеспечивая круглосуточную работу большого коллектива ученых. В 1952 г. в России была выпущена быстродействующая электронно-счетная машина БЭСМ на 4500 лампах, выполнявшая до 10000 операций в секунду.

Ответом на «взрыв» послужили первые компьютеры (computer), или ЭВМ: электромеханическая ENIGMA в Англии, электронные ENIAC в США и МЭСМ на Украине. Электронный вычислительный интегратор и калькулятор ENIAC сконструировали Д. Моучли и Дж. Эккерт в 1946 г. в Пенсильванском университете. Собранный из 18000 вакуумных приборов, он имел массу 30 тонн и занимал площадь 150 м. Машина использовалась для решения задач, связанных с проектом атомной бомбы, и на Абердинском испытательном полигоне работала до 1955 г. В 1948 г. в Массачусетском университете был построен первый компьютер с памятью. В 1949 г. ламповый компьютер универсального назначения MARK 1 был сконструирован учеными Манчестерского университета, а в 1950 г. коммерческий вычислитель MARK 1 STAR выпустила фирма «Ferranty» . На Украине начало развитию вычислительных машин и электронной промышленности, было положено в 1950 г. малой электронно-счетной машиной МЭСМ С. А. Лебедева. Выполненная на базе 7500 ламп на площади в 64 м , МЭСМ потребляла 25 к. Вт электроэнергии, обеспечивая круглосуточную работу большого коллектива ученых. В 1952 г. в России была выпущена быстродействующая электронно-счетная машина БЭСМ на 4500 лампах, выполнявшая до 10000 операций в секунду.

1941 г. – в Германии введены в эксплуатацию первые в мире универсальные цифровые вычислительные машины на электромеханических элементах «Зюс-2» и «Зюс-3» . 1944 г. – американский математик Говард Айкен сконструировал в Гарвардском университете автоматическую вычислительную машину АВМ «Марк-1» с программным управлением на релейных и механических элементах. 1946 г. – американский инженер - электронщик Д. П. Эккерт и физик Д. У. Моучли сконструировали в Пенсильванском университете первую ЭВМ «ENIAC» (Electronic Numerical Integrator and Computer). Она состояла из 20 тыс. электронных ламп.

1941 г. – в Германии введены в эксплуатацию первые в мире универсальные цифровые вычислительные машины на электромеханических элементах «Зюс-2» и «Зюс-3» . 1944 г. – американский математик Говард Айкен сконструировал в Гарвардском университете автоматическую вычислительную машину АВМ «Марк-1» с программным управлением на релейных и механических элементах. 1946 г. – американский инженер - электронщик Д. П. Эккерт и физик Д. У. Моучли сконструировали в Пенсильванском университете первую ЭВМ «ENIAC» (Electronic Numerical Integrator and Computer). Она состояла из 20 тыс. электронных ламп.

1947 – 1948 гг. – академик С. А. Лебедев в Институте электроники АН УССР начинает работу по созданию МЭСМ (Малой Электронной Счётной Машины). 1948 г. – американский математик Норберт Винер выпустил книгу «Кибернетика, или Управление и связь у животных» . Это положило начало развитию теории автоматов и становлению кибернетики – науки об управлении и передаче информации.

1947 – 1948 гг. – академик С. А. Лебедев в Институте электроники АН УССР начинает работу по созданию МЭСМ (Малой Электронной Счётной Машины). 1948 г. – американский математик Норберт Винер выпустил книгу «Кибернетика, или Управление и связь у животных» . Это положило начало развитию теории автоматов и становлению кибернетики – науки об управлении и передаче информации.

1949 г. – в Кембриджском университете под руководством профессора М. Уилкса создана первая в мире вычислительная машина с хранимой программой ЭДСАК. 1949 г. – под руководством Дж. фон Неймана разработан компьютер MANIAC (Mathematical Analyzer Numerical Integrator ntand Computer).

1949 г. – в Кембриджском университете под руководством профессора М. Уилкса создана первая в мире вычислительная машина с хранимой программой ЭДСАК. 1949 г. – под руководством Дж. фон Неймана разработан компьютер MANIAC (Mathematical Analyzer Numerical Integrator ntand Computer).

1952 г. – закончена разработка БЭСМ (Большой Электронной Счётной Машины) с быстродействием около 10 тыс. операций в секунду под руководством Сергея Алексеевича Лебедева. 1958 г. – в СССР создана ЭВМ М-20 со средним быстродействием 20 тыс. операций в секунду – самая мощная ЭВМ 50 -х годов в Европе.

1952 г. – закончена разработка БЭСМ (Большой Электронной Счётной Машины) с быстродействием около 10 тыс. операций в секунду под руководством Сергея Алексеевича Лебедева. 1958 г. – в СССР создана ЭВМ М-20 со средним быстродействием 20 тыс. операций в секунду – самая мощная ЭВМ 50 -х годов в Европе.

Самой быстрой в мире к 1958 г. оказалась ЭВМ М 20, развивавшая скорость вычислений 20000 операций в секунду. А в 1967 г. БЭСМ 6 достигла 1 млн. операций в секунду, благодаря впервые реализованным в ней идеям параллелизма, выходящим за рамки фон-неймановской концепции. Основанная позднее зеленоградская фирма «Квант» продолжила традиции БЭСМ машинами серий ЭЛЬБРУС 1 (12 млн. ) и ЭЛЬБРУС 2 (100 млн. операций в секунду). В 1957 г. Б. Нойс и Г. Мур открыли первую в мире компанию по производству полупроводниковых приборов – ″Fairchild Semiconducton″, а спустя десятилетие ими была создана – «Intel Corp. » – компания, деятельность которой была полностью посвящена изготовлению интегральных микросхем. Здесь в 1971 г. родился коммерческий микропроцессор INTEL 4004. Через три года появились микропроцессоры MOTOROLA 6800. 1975 г. стал датой рождения крупнейшей корпорации «Microsoft Corp. » , имеющей сегодня представительства более чем в 30 странах мира и выпускающей свои программные продукты более чем на 40 языках. Практически одновременно с рождением компьютеров возникла мысль о связи их между собой. В 60 -х гг. появились первые вычислительные сети (network), а в 1979 г. Р. Метклаф, изобретатель сети ETHERNET, основал первую фирму по производству сетевого оборудования – 3 COM.

Самой быстрой в мире к 1958 г. оказалась ЭВМ М 20, развивавшая скорость вычислений 20000 операций в секунду. А в 1967 г. БЭСМ 6 достигла 1 млн. операций в секунду, благодаря впервые реализованным в ней идеям параллелизма, выходящим за рамки фон-неймановской концепции. Основанная позднее зеленоградская фирма «Квант» продолжила традиции БЭСМ машинами серий ЭЛЬБРУС 1 (12 млн. ) и ЭЛЬБРУС 2 (100 млн. операций в секунду). В 1957 г. Б. Нойс и Г. Мур открыли первую в мире компанию по производству полупроводниковых приборов – ″Fairchild Semiconducton″, а спустя десятилетие ими была создана – «Intel Corp. » – компания, деятельность которой была полностью посвящена изготовлению интегральных микросхем. Здесь в 1971 г. родился коммерческий микропроцессор INTEL 4004. Через три года появились микропроцессоры MOTOROLA 6800. 1975 г. стал датой рождения крупнейшей корпорации «Microsoft Corp. » , имеющей сегодня представительства более чем в 30 странах мира и выпускающей свои программные продукты более чем на 40 языках. Практически одновременно с рождением компьютеров возникла мысль о связи их между собой. В 60 -х гг. появились первые вычислительные сети (network), а в 1979 г. Р. Метклаф, изобретатель сети ETHERNET, основал первую фирму по производству сетевого оборудования – 3 COM.

1963 г. – создана первая мышка.

1963 г. – создана первая мышка.

1961 г. – в продажу поступила первая выполненная на пластине кремния интегральная схема (ИС). 1965 г. – начат выпуск семейства машин третьего поколения IBM/360 (США). 1970 -е г. – начат выпуск семейства малых ЭВМ международной системы (СМ ЭВМ). На фотографии ЭВМ СМ 3.

1961 г. – в продажу поступила первая выполненная на пластине кремния интегральная схема (ИС). 1965 г. – начат выпуск семейства машин третьего поколения IBM/360 (США). 1970 -е г. – начат выпуск семейства малых ЭВМ международной системы (СМ ЭВМ). На фотографии ЭВМ СМ 3.

КАТЕГОРИИ ИНФОРМАТИКИ Система оригинальных понятий информатики вырастает из основного понятия – понятия «информационный ресурс» , а именно: - информационный ресурс; - социальная энтропия; - полезная работа (отдача) ЭВМ; - информационная среда; - напряженность информационного поля; - исходный и полный информационные потоки; - автоматизированные информационные системы; - информационные технологии; - искусственный интеллект; - информационно-динамический объект; - творческая система; - ТАС-модели; - квант (единица) знания; - социальный (коллективный) интеллект. Раскроем более подробно понятийный аппарат информатики.

КАТЕГОРИИ ИНФОРМАТИКИ Система оригинальных понятий информатики вырастает из основного понятия – понятия «информационный ресурс» , а именно: - информационный ресурс; - социальная энтропия; - полезная работа (отдача) ЭВМ; - информационная среда; - напряженность информационного поля; - исходный и полный информационные потоки; - автоматизированные информационные системы; - информационные технологии; - искусственный интеллект; - информационно-динамический объект; - творческая система; - ТАС-модели; - квант (единица) знания; - социальный (коллективный) интеллект. Раскроем более подробно понятийный аппарат информатики.

Информационный ресурс (ИР). Это основное понятие» являющееся предметом информатики. ИР имеет две неразделимые стороны: формальнологическую (информационную) и семантическую (когнитивную). Когнитивный (от лат. cognition – знание. Познание) означает познаваемый, соответствующий познанию. Первый аспект этого понятия (формально-логическая сторона) формируется в результате обобщения практики компьютеризации и развития инженерии знаний. Сам термин «инженерия знаний» (Knowledge engineering) появился в США в 1977 г. на ранних этапах создания ИИ. Таким образом, в основе методов использования представления знаний (первый аспект ИР) лежат главным образом математическая формализация и логическая полнота. Напротив, когнитивный подход (второй аспект ИР) основан на понимании процесса осознания чего-либо человеком, поэтому представлению знаний в данном случае свойственно скорее выразительность, чем математические изящество и скорость. В рамках когнитивно-содержательного направления развивается понимание зависимости от коммуникаций, информационных связей. Здесь главным объектом изучения выступает соотношение знания и информации, переход одного во второе, а так же фазовый переход знания в социальную силу. В результате слияния формально-логического и когнитивно-содержательного направлений и рождается фундаментальное понятие информационного ресурса.

Информационный ресурс (ИР). Это основное понятие» являющееся предметом информатики. ИР имеет две неразделимые стороны: формальнологическую (информационную) и семантическую (когнитивную). Когнитивный (от лат. cognition – знание. Познание) означает познаваемый, соответствующий познанию. Первый аспект этого понятия (формально-логическая сторона) формируется в результате обобщения практики компьютеризации и развития инженерии знаний. Сам термин «инженерия знаний» (Knowledge engineering) появился в США в 1977 г. на ранних этапах создания ИИ. Таким образом, в основе методов использования представления знаний (первый аспект ИР) лежат главным образом математическая формализация и логическая полнота. Напротив, когнитивный подход (второй аспект ИР) основан на понимании процесса осознания чего-либо человеком, поэтому представлению знаний в данном случае свойственно скорее выразительность, чем математические изящество и скорость. В рамках когнитивно-содержательного направления развивается понимание зависимости от коммуникаций, информационных связей. Здесь главным объектом изучения выступает соотношение знания и информации, переход одного во второе, а так же фазовый переход знания в социальную силу. В результате слияния формально-логического и когнитивно-содержательного направлений и рождается фундаментальное понятие информационного ресурса.

Социальная энтропия. Вторая фундаментальная категория информатики. Социальная энтропия – это мера отклонения от некоторого состояния, принимаемого за эталонное, оптимальное по критерию недоиспользования ИР. В теории информации Шеннона энтропия – это мера неопределенности случайной. Сказать, что социальная энтропия – это недостаток знаний об объекте, было бы неточно. Недостатком знаний об объекте характеризуется энтропия субъекта, т. е. управляющей подсистемы. Но есть еще энтропия самого объекта как неопределенность его состояния – это не релевантность его структуры, а разброс функций и действий элементов объекта, что связано с недоиспользованием ИР. Итак, социальная энтропия – новая категория информатики для характеристики управленческих процессов, уровня их осуществления. Энтропия – не просто мера упорядоченности организационных систем, а мера соответствия их состояния имеющимся целевым установкам. Полезная работа (отдача) ЭВМ. Чтобы качественно и количественно определить отдачу ЭВМ, необходимо определить, что такое информационная работа вообще.

Социальная энтропия. Вторая фундаментальная категория информатики. Социальная энтропия – это мера отклонения от некоторого состояния, принимаемого за эталонное, оптимальное по критерию недоиспользования ИР. В теории информации Шеннона энтропия – это мера неопределенности случайной. Сказать, что социальная энтропия – это недостаток знаний об объекте, было бы неточно. Недостатком знаний об объекте характеризуется энтропия субъекта, т. е. управляющей подсистемы. Но есть еще энтропия самого объекта как неопределенность его состояния – это не релевантность его структуры, а разброс функций и действий элементов объекта, что связано с недоиспользованием ИР. Итак, социальная энтропия – новая категория информатики для характеристики управленческих процессов, уровня их осуществления. Энтропия – не просто мера упорядоченности организационных систем, а мера соответствия их состояния имеющимся целевым установкам. Полезная работа (отдача) ЭВМ. Чтобы качественно и количественно определить отдачу ЭВМ, необходимо определить, что такое информационная работа вообще.

Информационная работа в полном цикле – это воздействие наблюдателя (управляющей подсистемы) на объект путем выработки и передачи сообщений, обусловливающих удержание объекта в имеющемся исходном состоянии, а также перевод его в новое состояние – достижение новой цели. Информационная работа имеет неэнтропийную природу. Информационную работу необходимо рассматривать в ее полном цикле. Полный информационный цикл включает рождение информации, ее накопление, обработку, прием и использование для целей развития системы. Информационная среда. Это понятие связано с понятием информационной работы в ее полном цикле. Информационная среда – это весь набор условий для технологической переработки и эффективного использования знаний в виде информационного ресурса. К информационной среде относятся аппаратные средства, программное обеспечение, телекоммуникации, уровень подготовки кадров – специалистов и пользователей, формы стимулирования, контроля, методы и формы управления, документопотоки, процедуры, регламенты, юридические нормы и т. д. Причем в информационную среду входит не только управляющая подсистема, но и объект. В информационную среду входят рассматриваемые как элементы единой системы все факторы, воздействующие на информационные процессы и информационные системы в течение всего жизненного цикла от проектирования до использования. Категория информационной среды означает новое понимание информационноуправленческого процесса и самой информации.

Информационная работа в полном цикле – это воздействие наблюдателя (управляющей подсистемы) на объект путем выработки и передачи сообщений, обусловливающих удержание объекта в имеющемся исходном состоянии, а также перевод его в новое состояние – достижение новой цели. Информационная работа имеет неэнтропийную природу. Информационную работу необходимо рассматривать в ее полном цикле. Полный информационный цикл включает рождение информации, ее накопление, обработку, прием и использование для целей развития системы. Информационная среда. Это понятие связано с понятием информационной работы в ее полном цикле. Информационная среда – это весь набор условий для технологической переработки и эффективного использования знаний в виде информационного ресурса. К информационной среде относятся аппаратные средства, программное обеспечение, телекоммуникации, уровень подготовки кадров – специалистов и пользователей, формы стимулирования, контроля, методы и формы управления, документопотоки, процедуры, регламенты, юридические нормы и т. д. Причем в информационную среду входит не только управляющая подсистема, но и объект. В информационную среду входят рассматриваемые как элементы единой системы все факторы, воздействующие на информационные процессы и информационные системы в течение всего жизненного цикла от проектирования до использования. Категория информационной среды означает новое понимание информационноуправленческого процесса и самой информации.

Информационно-управленческий процесс в его полном виде – не просто сообщение данных, а функционирование ИР – информационной динамики, связанной с функционированием всей информационной среды, всех ее элементов, среди которых активными являются люди, а пассивными – технические средства и другие материальные ресурсы. Такой подход очень важен при создании интегрированных АСУ. С позиций понятия информационной среды удобно дать понятия информационного процесса и информационной технологии. Под информационным процессом понимается функционирование всех элементов информационной среды и всех факторов, обеспечивающих появление новых знаний, их передачу, переработку, использование и воздействие на объект рассматриваемой системы. В соответствии с этим под информационной технологией следует понимать не только основанную на ЭВМ вычислительную систему, но и всю автоматизированную среду получения, передачи, переработки, использования знаний в виде информации и их воздействия на объект.

Информационно-управленческий процесс в его полном виде – не просто сообщение данных, а функционирование ИР – информационной динамики, связанной с функционированием всей информационной среды, всех ее элементов, среди которых активными являются люди, а пассивными – технические средства и другие материальные ресурсы. Такой подход очень важен при создании интегрированных АСУ. С позиций понятия информационной среды удобно дать понятия информационного процесса и информационной технологии. Под информационным процессом понимается функционирование всех элементов информационной среды и всех факторов, обеспечивающих появление новых знаний, их передачу, переработку, использование и воздействие на объект рассматриваемой системы. В соответствии с этим под информационной технологией следует понимать не только основанную на ЭВМ вычислительную систему, но и всю автоматизированную среду получения, передачи, переработки, использования знаний в виде информации и их воздействия на объект.

Существуют понятия социальной, экономической, производственной, интеллектуальной, информационной и вычислительной сред. Все это среды социальных систем, разные ракурсы их рассмотрения. Если понятие интеллектуальной среды характеризует условия функционирования всего потенциала знаний (овеществленной информации), то понятие информационной среды более узкое и относится только к условиям функционирования социальной информации, знаний в виде сообщений. Что касается вычислительной или программно-вычислительной среды, то она является элементом информационной среды. Следующими фундаментальными понятиями информатики как науки о движущей силе информации в социальных системах являются понятия информационного поля и его напряженности. В кибернетической самоорганизующейся системе управляющая подсистема осуществляет целеполагание для объекта и удерживает его в заданием целевом русле функционирования и развития. Взаимодействие целевого, проектируемого и исходного состояний кибернетической системы, а также ее элементов осуществляется посредством информационных полей, напряженности которых создаются либо постановкой объекту цели, либо ухудшением исходного состояния системы, т. е. появлением дополнительных ограничений в ее динамике.

Существуют понятия социальной, экономической, производственной, интеллектуальной, информационной и вычислительной сред. Все это среды социальных систем, разные ракурсы их рассмотрения. Если понятие интеллектуальной среды характеризует условия функционирования всего потенциала знаний (овеществленной информации), то понятие информационной среды более узкое и относится только к условиям функционирования социальной информации, знаний в виде сообщений. Что касается вычислительной или программно-вычислительной среды, то она является элементом информационной среды. Следующими фундаментальными понятиями информатики как науки о движущей силе информации в социальных системах являются понятия информационного поля и его напряженности. В кибернетической самоорганизующейся системе управляющая подсистема осуществляет целеполагание для объекта и удерживает его в заданием целевом русле функционирования и развития. Взаимодействие целевого, проектируемого и исходного состояний кибернетической системы, а также ее элементов осуществляется посредством информационных полей, напряженности которых создаются либо постановкой объекту цели, либо ухудшением исходного состояния системы, т. е. появлением дополнительных ограничений в ее динамике.

Напряженность информационного поля – это та сила, побудительный мотив, с которым объект и его среда действуют на управляющую подсистему, вызывая ее действия по снятию возникшей новой энтропии, обеспечению достижения объектом новой цели или перевода всей системы в новое целевое состояние в течение определенного времени. Сила и степень напряженности информационного поля зависят от двух факторов: разницы энтропии целевого и исходного состояний системы (энтропийного пространства) и времени достижения новой цели (энтропийного времени). С напряженностью информационного поля связаны другие понятия информатики, такие, как исходный информационный поток – импульс, полный информационный поток, информационная цепная реакция и др. Исходным информационным потоком называется поток от главного, верхнего элемента управляющей подсистемы (наблюдателя) к каждому элементу управляющей подсистемы. Полный информационный поток – это поток, воздействующий на объект за период его перехода в новое целевое состояние.

Напряженность информационного поля – это та сила, побудительный мотив, с которым объект и его среда действуют на управляющую подсистему, вызывая ее действия по снятию возникшей новой энтропии, обеспечению достижения объектом новой цели или перевода всей системы в новое целевое состояние в течение определенного времени. Сила и степень напряженности информационного поля зависят от двух факторов: разницы энтропии целевого и исходного состояний системы (энтропийного пространства) и времени достижения новой цели (энтропийного времени). С напряженностью информационного поля связаны другие понятия информатики, такие, как исходный информационный поток – импульс, полный информационный поток, информационная цепная реакция и др. Исходным информационным потоком называется поток от главного, верхнего элемента управляющей подсистемы (наблюдателя) к каждому элементу управляющей подсистемы. Полный информационный поток – это поток, воздействующий на объект за период его перехода в новое целевое состояние.

Очень важно отметить такую фундаментальную категорию, как информационно-динамический объект (ИДО), который представляет собой АИС, управляющая подсистема которой выступает в виде творческой системы, создающей новые состояния объекта. То есть ИДО – это системы социальной природы, в которых осуществляется обмен энергетическими (трудовыми) затратами в виде информационной работы и в виде физической работы. Речь идет о соотношении «силовых» и «мозговых» усилий в рамках какого-либо образования: будь то организация, предприятие, технология. Таким образом, ИДО можно определить как целенаправленные системы, в которых осуществляется обмен энергией (вещественно-энергетическими трудовыми затратами) в виде информационной и физической работы. и

Очень важно отметить такую фундаментальную категорию, как информационно-динамический объект (ИДО), который представляет собой АИС, управляющая подсистема которой выступает в виде творческой системы, создающей новые состояния объекта. То есть ИДО – это системы социальной природы, в которых осуществляется обмен энергетическими (трудовыми) затратами в виде информационной работы и в виде физической работы. Речь идет о соотношении «силовых» и «мозговых» усилий в рамках какого-либо образования: будь то организация, предприятие, технология. Таким образом, ИДО можно определить как целенаправленные системы, в которых осуществляется обмен энергией (вещественно-энергетическими трудовыми затратами) в виде информационной и физической работы. и

Искусственный интеллект (ИИ). Слово «интеллект» (от лат. Tntellectus) означает ум, рассудок, разум, мыслительная способность человека. Учение об интеллекте развивается по трем направлениям. Первое из них, приведшее к появлению самого термина «искусственный интеллект» , связано с теорией эвристического поиска и созданием машинных «решателей задач» , относящихся к разряду творческих. Второе направление связано с разработкой роботов, автономно действующих в реальной среде и решающих нетривиальные задачи, поставленные человеком. Третье – главное – направление связано с коренной интеллектуализацией ЭВМ путем оснащения их программно-техническими средствами высокого уровня, способными делать логические выводы. Инструментарием, носителем искусственного интеллекта являются ЭВМ, роботы, экспертные системы, телекоммуникации. Творческая система. Интеллектуальные системы – это Информационные комплексы, оснащенные ИИ. Они могут быть полного и неполного информационного цикла, т. е. могут творить новое состояние объекта, а могут выполнять и усеченные функции – связи, обработки знаний и т. д. Творческими системами называются интеллектуальные системы полного цикла, обеспечивающие фазовый переход знаний в силу, творящие объект. Творческие системы – это высшая форма информационных систем полного цикла. АСУ сложными системами, объединяющие АСУП, АСУТП, САПР, АСНИ, т. е. интегрированные АСУ, можно назвать прообразами творческих систем.

Искусственный интеллект (ИИ). Слово «интеллект» (от лат. Tntellectus) означает ум, рассудок, разум, мыслительная способность человека. Учение об интеллекте развивается по трем направлениям. Первое из них, приведшее к появлению самого термина «искусственный интеллект» , связано с теорией эвристического поиска и созданием машинных «решателей задач» , относящихся к разряду творческих. Второе направление связано с разработкой роботов, автономно действующих в реальной среде и решающих нетривиальные задачи, поставленные человеком. Третье – главное – направление связано с коренной интеллектуализацией ЭВМ путем оснащения их программно-техническими средствами высокого уровня, способными делать логические выводы. Инструментарием, носителем искусственного интеллекта являются ЭВМ, роботы, экспертные системы, телекоммуникации. Творческая система. Интеллектуальные системы – это Информационные комплексы, оснащенные ИИ. Они могут быть полного и неполного информационного цикла, т. е. могут творить новое состояние объекта, а могут выполнять и усеченные функции – связи, обработки знаний и т. д. Творческими системами называются интеллектуальные системы полного цикла, обеспечивающие фазовый переход знаний в силу, творящие объект. Творческие системы – это высшая форма информационных систем полного цикла. АСУ сложными системами, объединяющие АСУП, АСУТП, САПР, АСНИ, т. е. интегрированные АСУ, можно назвать прообразами творческих систем.

Квантификация знаний. Умственная (интеллектуальная) деятельность всегда была областью, где нет метрики, где фигурируют лишь качественные, трудно определимые понятия. Фундаментальное значение информатики состоит в том, что она позволяет ввести количественно определимые понятия в умственную (познавательную и организационную) деятельность, т. е. позволяет квантифицировать знания. Сама по себе возможность квантификации знаний имеет огромное значение для человеческой цивилизации. Для квантификации знаний, если они представлены в виде информации, применим весь арсенал статистической теории связи – ее понятия, соотношения и такие информационные единицы, как бит и байт. Содержательный аспект знаний в виде информации можно учесть с помощью единицы семантической информации – ранжированного бита. Ранжированный бит – это информационная единица, отражающая величину системной, социальной ценности конкретного сообщения. Различие знаний (весов) информационных единиц количественно можно установить экспертным путем.

Квантификация знаний. Умственная (интеллектуальная) деятельность всегда была областью, где нет метрики, где фигурируют лишь качественные, трудно определимые понятия. Фундаментальное значение информатики состоит в том, что она позволяет ввести количественно определимые понятия в умственную (познавательную и организационную) деятельность, т. е. позволяет квантифицировать знания. Сама по себе возможность квантификации знаний имеет огромное значение для человеческой цивилизации. Для квантификации знаний, если они представлены в виде информации, применим весь арсенал статистической теории связи – ее понятия, соотношения и такие информационные единицы, как бит и байт. Содержательный аспект знаний в виде информации можно учесть с помощью единицы семантической информации – ранжированного бита. Ранжированный бит – это информационная единица, отражающая величину системной, социальной ценности конкретного сообщения. Различие знаний (весов) информационных единиц количественно можно установить экспертным путем.

Информационный ресурс – это отчуждаемые знания, становящиеся сообщениями, – выступает в пассивной и активной формах. К пассивной относятся такие формы существования знаний, когда они не связаны или слабо связаны с конкретными предметными областями (книги, статьи, патенты, банки данных). Активные формы существования ИР : модель, алгоритм, программа, проект. Каждая из этих четырех активных форм ИР может иметь разные степени общности, научно-технический уровень и завершенность (комплектность). В функциональном отношении модели представления знаний делятся на три вида: тезисные, аналитические и синтетические. Эти три вида моделей представления знаний получили название ТАС-модели.