обзор.ppt

- Количество слайдов: 92

Информационные технологии в лингвистике Обзор

Информационные технологии в лингвистике - это совокупность методов и средств получения, хранения, передачи, распространения, преобразования информации о языке и законах его функционирования с помощью компьютерных технологий.

Компьютерная лингвистика (также: математическая или вычислительная лингвистика, англ. computational linguistics) - направление искусственного интеллекта, которое ставит своей целью использование математических моделей для описания естественных языков; - направление в прикладной лингвистике, ориентированное на использование компьютерных инструментов – программ, компьютерных технологий организации и обработки данных – для моделирования функционирования языка.

Задача компьютерной лингвистики - использование математических моделей для описания лингвистических закономерностей: 1. Применение известных математических подходов (например, статистической обработки) для выявления закономерностей. 2. Создание моделей для решения лингвистических задач и разработка программ. Natural Language Processing (NLP)

Основные понятия лингвистики с точки зрения информатики Словоупотребление - цепочка буквенных символов, находящаяся в тексте между двумя знаками пробела. Словоформа - словоупотребление, находящееся вне предложения или текста. Лексема (слово) - несколько словоформ, имеющих одно и тоже лексическое значение. Предложение — цепочка словоупотреблений между двумя знаками конца предложения. Текст — линейная последовательность предложений.

Количественные характеристики Абсолютная частота употребления словоформы - сумма зафиксированных в тексте словоупотреблений словоформы. Абсолютная частота употребления лексемы (слова) – сумма зафиксированных в тексте словоупотреблений всех словоформ лексемы. Пример: Скоро придет весна. Весной легче дышится. Приходи, весна! Всего в тексте 8 словоупотреблений, 7 словоформ, 5 лексем. Словоформы "весна" и "весной" относятся к лексеме "весна". Словоформы "придет" и "приходи" относятся к лексеме "приходить". Частота словоформы "весна" = 2.

Количественные характеристики Относительная частота употребления лексемы (слова) – сумма зафиксированных в тексте словоупотреблений всех словоформ лексемы, поделенная на общее число словоупотреблений в тексте. Относительная частота позволяет оценить вероятность появления определенной словоформы среди словоупотреблений. Пример: Скоро придет весна. Весной легче дышится. Приходи, весна! Относительная частота лексемы "весна" = 3/8=0, 375 Относительная частота может исчисляться в процентах: 0, 375 х 100%=37, 5%

ВОПРОСЫ ТЕСТА Дан фрагмент текста: «Если созданная модель повторяет поведение объекта мо делирования, то есть входная и выходная информация модели повторяет аналогичную информацию объекта моделирования, то модель функци онирует хорошо, адекватно. » В тексте содержится: а. 24 словоупотребления, 17 лексем б. 17 словоупотреблений, 12 лексем в. 24 словоупотребления, 16 лексем г. 20 словоупотреблений, 16 лексем

ВОПРОСЫ ТЕСТА Дан фрагмент текста: «Если созданная модель повторяет поведение объекта моделирования, то есть входная и выходная информация модели повторяет аналогичную информацию объекта моделирования, то модель функционирует хорошо, адекватно. » В тексте содержится: а. 24 словоупотребления, 17 лексем б. 17 словоупотреблений, 12 лексем в. 24 словоупотребления, 16 лексем г. 20 словоупотреблений, 16 лексем

Этапы обработки текста 1. Разбиение текста на предложения и слова. 2. Анализ (определение характеристик) отдельных слов (морфологический анализ). 3. Синтаксический анализ предложений. 4. Семантический анализ всего текста.

Анализ отдельных слов: Морфемный (морфологический) анализ Вход: текстовое представление слова Выход: основная словоформа и грамматические характеристики слова Часть речи Грамматические признаки Существительное Род, число, падеж, склонение Прилагательное Род, число, падеж Глагол Время, лицо, число, спряжение, вид Местоимение Число, лицо

Подходы 1. Четкая морфология (на основе словарей) 2. Нечеткая морфология (на основе правил словообразования) 3. Вероятностный подход (оценка вероятности словоформы на основе большого количества текстов)

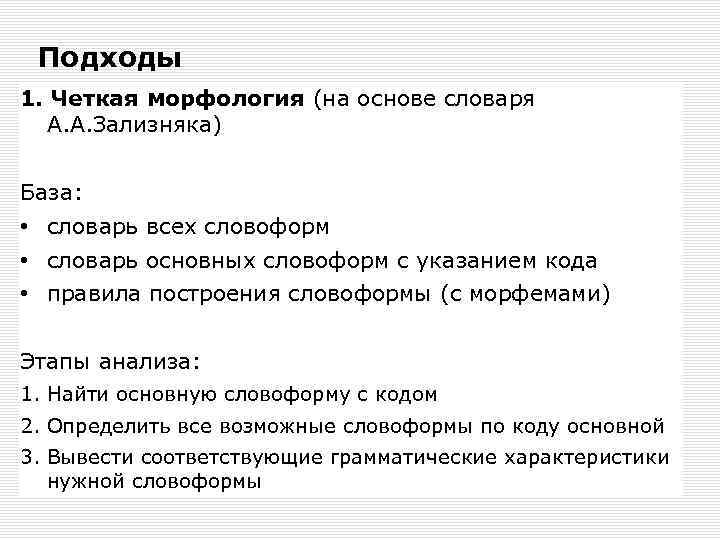

Подходы 1. Четкая морфология (на основе словаря А. А. Зализняка) База: • словарь всех словоформ • словарь основных словоформ с указанием кода • правила построения словоформы (с морфемами) Этапы анализа: 1. Найти основную словоформу с кодом 2. Определить все возможные словоформы по коду основной 3. Вывести соответствующие грамматические характеристики нужной словоформы

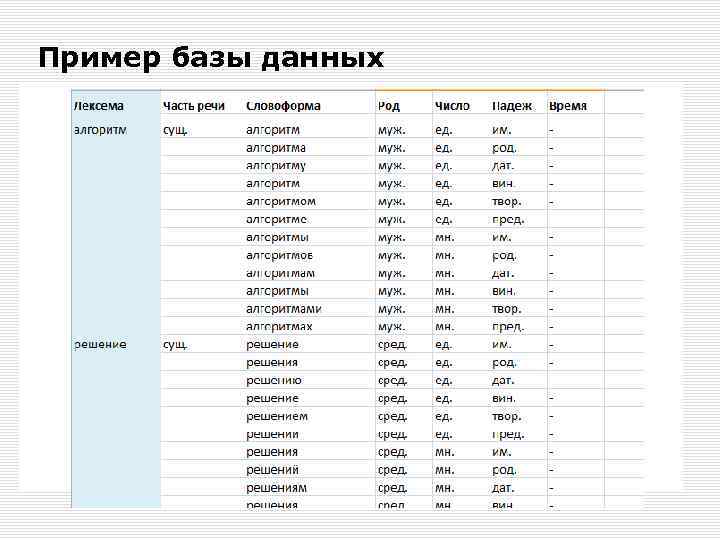

Пример базы данных

Недостаток четкого подхода - возможность ввода словоформы, отсутствующей в словарях (в результате опечатки, ошибки, употребления имени собственного, узкоспециальных слов и т. д. )

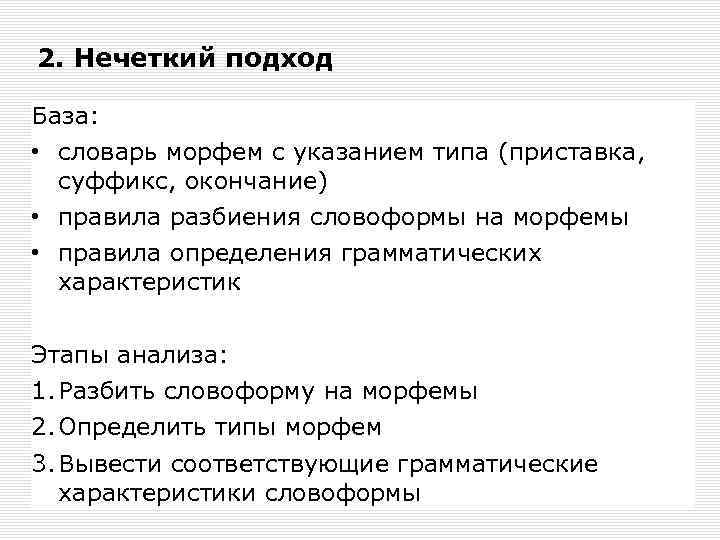

2. Нечеткий подход База: • словарь морфем с указанием типа (приставка, суффикс, окончание) • правила разбиения словоформы на морфемы • правила определения грамматических характеристик Этапы анализа: 1. Разбить словоформу на морфемы 2. Определить типы морфем 3. Вывести соответствующие грамматические характеристики словоформы

Пример словаря морфем

Недостатки нечеткого подхода Для формирования правил разбиения словоформ на морфемы используются: А) деревья решений и индуктивная логика либо Б) экспертная система диагностирующего типа Требуются очень сложные алгоритмы, построение которых трудно автоматизировать.

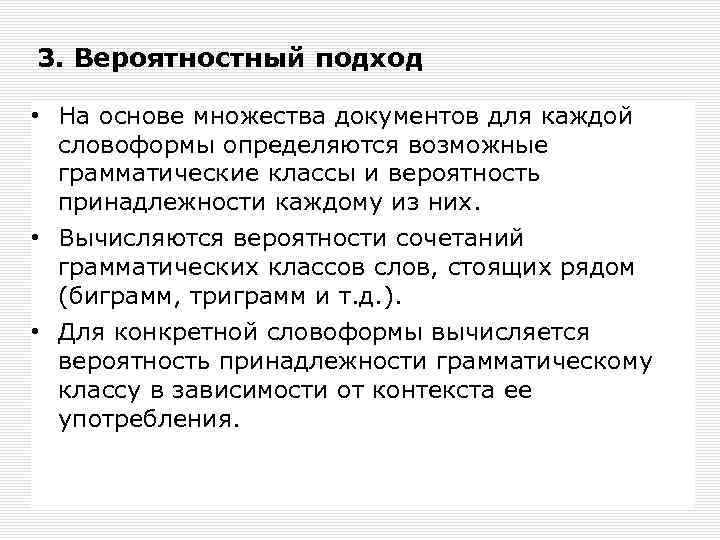

3. Вероятностный подход • На основе множества документов для каждой словоформы определяются возможные грамматические классы и вероятность принадлежности каждому из них. • Вычисляются вероятности сочетаний грамматических классов слов, стоящих рядом (биграмм, триграмм и т. д. ). • Для конкретной словоформы вычисляется вероятность принадлежности грамматическому классу в зависимости от контекста ее употребления.

Недостатки вероятностного подхода • Хорошо работает только для языков с фиксированным порядком слов; • Для вычисления вероятностей требуется большой размеченный корпус.

Проблема: морфологическая омонимия - ситуация, когда одна словоформа может быть разобрана несколькими способами. Варианты: Одна лексема — несколько словоформ Одна словоформа — несколько лексем Снятие омонимии - это однозначное определение грамматической формы слова при наличии нескольких вариантов

Проблема: морфологическая омонимия Примеры: теории единственное число, родительный падеж единственное число, дательный падеж единственное число, предложный падеж множественное число, именительный падеж множественное число, винительный падеж спали Спать — несов. вид, изьяв. накл. , прош. время, мн. число. Спадать — сов. вид, изьяв. накл. , прош. время, мн. число. Палить — сов. вид, повел. накл. , ед. число. , 2 -е лицо

Пример морфологического анализа Причастный стих заменился концертом, напоминавшим оперу. Прил. , муж. р. , ед. ч. Сущ. , муж. р. , ед. ч. , им. пад Глаг. , прош. вр. , соверш. в Сущ. , муж. р. , ед. ч. , тв. пад Прич. , прош. вр. , тв. пад Сущ. , жен. р. , ед. ч. , вин. пад К вечеру бриз стих, чтобы к ночи сменить направление.

Автоматизированное снятие омонимии Вероятностный метод: автоматическое обучение по большому числу текстов. • На большом количестве размеченных текстов со снятой омонимией подсчитывается частота встречаемости для всех имеющихся в тексте комбинаций из n последовательно идущих слов. • При этом в расчет принимаются только часть речи и лексические параметры. • Предполагается, что первые n-1 слово в n- грамме определяют вероятность появления n- го слова. • Зная первые n-1 слово можно выбрать наиболее вероятный вариант последнего.

Стемминг — это процесс нахождения основы слова для заданного исходного слова. Основа слова - — неизменяемая часть слова, которая выражает его лексическое значение. Основа слова необязательно совпадает с морфологическим корнем слова. Применяется в поиcковых системах для обобщения поискового запроса пользователя. Конкретные реализации стемматизации называются алгоритм стемматизации или стеммер.

Стемминг Стеммер Портера — алгоритм стемминга, опубликованный Мартином Портером в 1980 году. Оригинальная версия стеммера была предназначена для английского языка. Алгоритм не использует базы основ слов. Применяя последовательно ряд правил, отсекает окончания и суффиксы, основываясь на особенностях языка, в связи с чем работает быстро, но не всегда безошибочно. http: //snowball. tartarus. org

ВОПРОСЫ ТЕСТА Постоянная необходимость составления сложного алгоритма разбиения на морфемы возникает при подходе к морфологическому анализу: а. На основе словарей б. На основе правил в. На основе вычисления вероятностей г. Ни в одном из подходов

ВОПРОСЫ ТЕСТА Постоянная необходимость составления сложного алгоритма разбиения на морфемы возникает при подходе к морфологическому анализу: а. На основе словарей б. На основе правил в. На основе вычисления вероятностей г. Ни в одном из подходов

Задачи синтаксического анализа - для прикладных задач: формальное описание синтаксической структуры; - для лингвистики: развитие теории синтаксиса (изучение связи между синтаксической зависимостью и линейным расположением слов, исследование синтаксической омонимии) Синтаксический анализ – уровень исследования языка, на котором: 1. Структура предложения рассматривается вне зависимости от остального текста. 2. Слова считаются неразложимыми единицами.

Определение частей речи или других лексических классов (POS – Part Of Speech) - каждому слову текста присваивается маркер. - текст с маркерами называется размеченным. POS-алгоритмы: а) основанные на правилах (составленных вручную и сохраненных в базе данных) Правило описывает, в каких случаях слову присваивается та или иная разметка. б) стохастические. На тренировочном корпусе определяются вероятности разметки слова в зависимости от контекста (левого и правого окружения). __________________ Jurafsky D. , Martin J. Speech and Language Processing (1999)

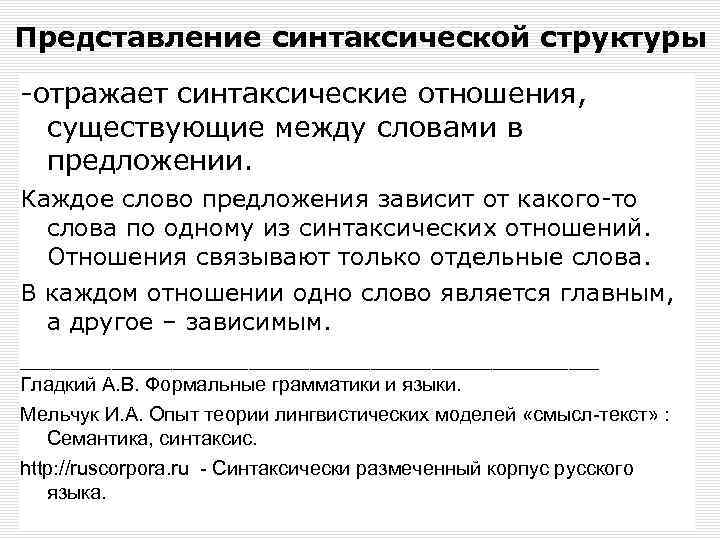

Представление синтаксической структуры -отражает синтаксические отношения, существующие между словами в предложении. Каждое слово предложения зависит от какого-то слова по одному из синтаксических отношений. Отношения связывают только отдельные слова. В каждом отношении одно слово является главным, а другое – зависимым. ___________________ Гладкий А. В. Формальные грамматики и языки. Мельчук И. А. Опыт теории лингвистических моделей «смысл текст» : Семантика, синтаксис. http: //ruscorpora. ru Синтаксически размеченный корпус русского языка.

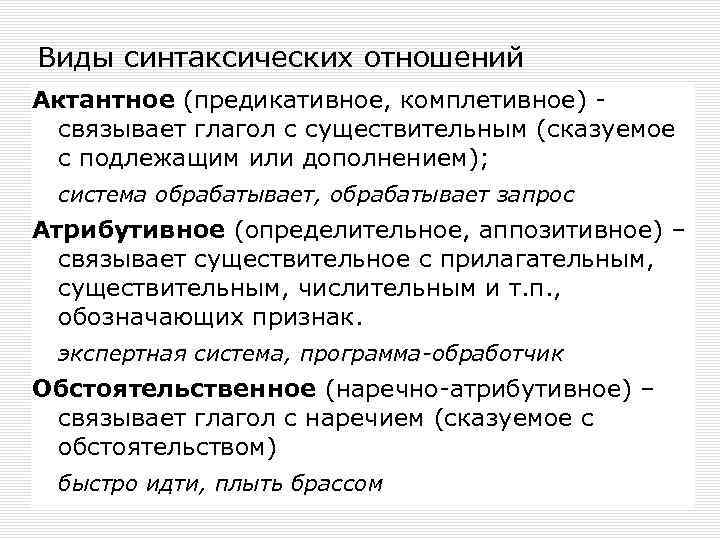

Виды синтаксических отношений Актантное (предикативное, комплетивное) - связывает глагол с существительным (сказуемое с подлежащим или дополнением); система обрабатывает, обрабатывает запрос Атрибутивное (определительное, аппозитивное) – связывает существительное с прилагательным, существительным, числительным и т. п. , обозначающих признак. экспертная система, программа-обработчик Обстоятельственное (наречно-атрибутивное) – связывает глагол с наречием (сказуемое с обстоятельством) быстро идти, плыть брассом

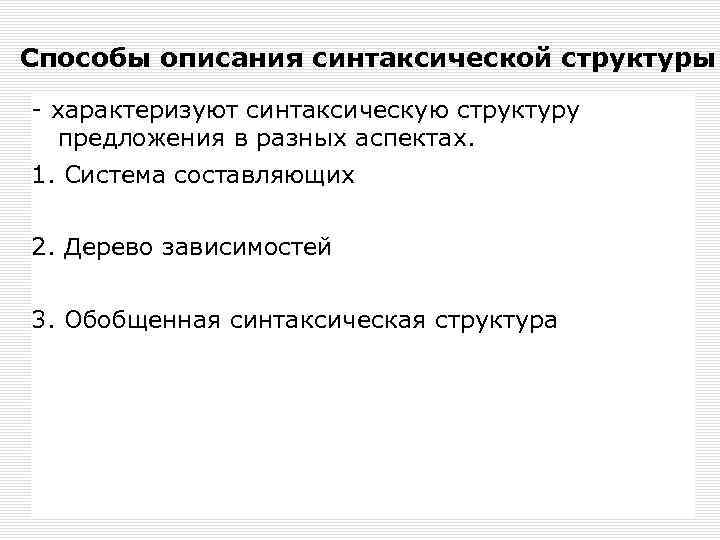

Способы описания синтаксической структуры - характеризуют синтаксическую структуру предложения в разных аспектах. 1. Система составляющих 2. Дерево зависимостей 3. Обобщенная синтаксическая структура

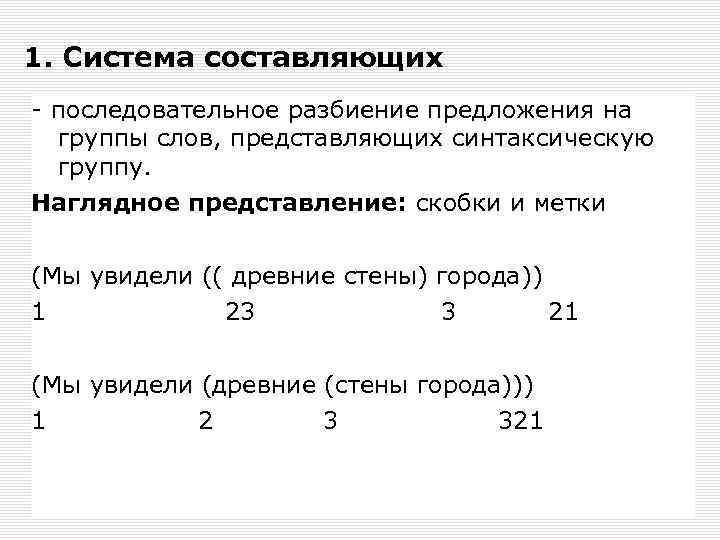

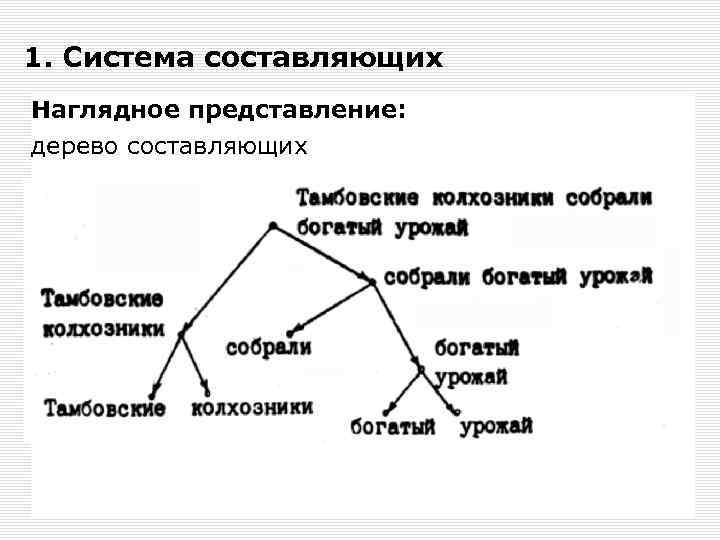

1. Система составляющих - последовательное разбиение предложения на группы слов, представляющих синтаксическую группу. Наглядное представление: скобки и метки (Мы увидели (( древние стены) города)) 1 23 3 21 (Мы увидели (древние (стены города))) 1 2 321

1. Система составляющих Наглядное представление: дерево составляющих

имостей цепочки можно изобразить в виде последовательности образующих ее точе 2. Деревья зависимостей Для всякой пары слов предложения, для которой существует синтаксическая зависимость, на рисунке проводится дуга. При этом одно слово является главным ( «хозяином» ), а другое – зависимым ( «слугой» ).

2. Деревья зависимостей

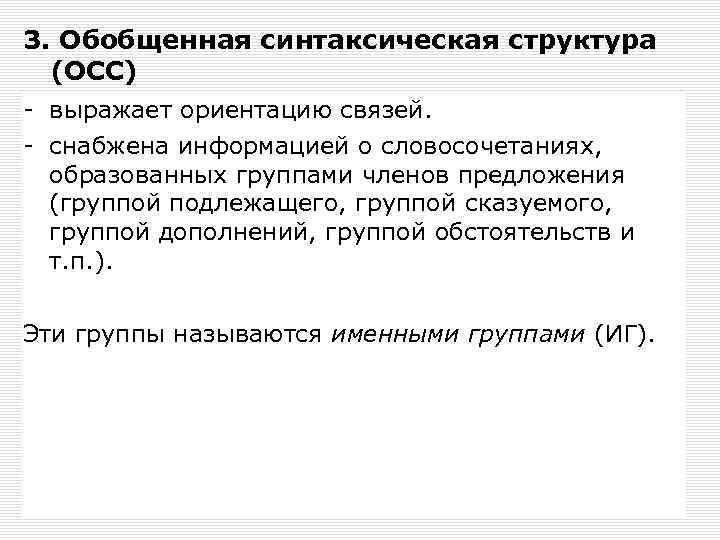

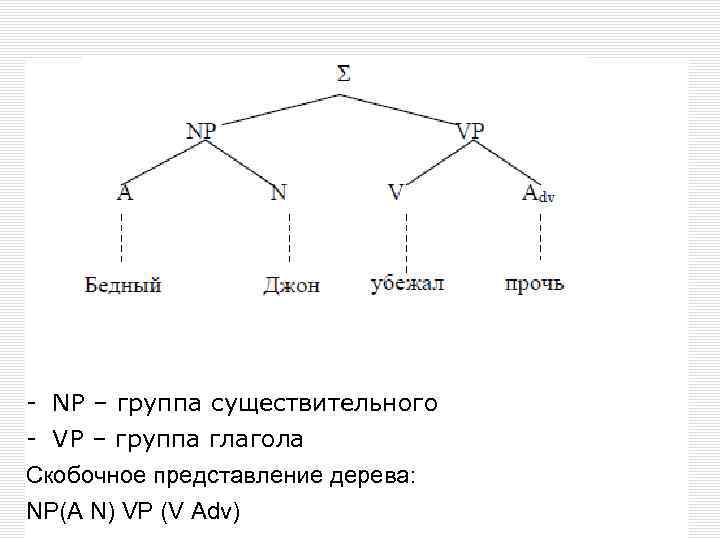

3. Обобщенная синтаксическая структура (ОСС) - выражает ориентацию связей. - снабжена информацией о словосочетаниях, образованных группами членов предложения (группой подлежащего, группой сказуемого, группой дополнений, группой обстоятельств и т. п. ). Эти группы называются именными группами (ИГ).

- NP – группа существительного - VP – группа глагола Скобочное представление дерева: NP(A N) VP (V Adv)

Виды синтаксического анализа 1. Основанный на формальных грамматиках (составленных вручную и сохраненных в базе данных). Как правило, используются КС-грамматики. 2. Стохастический (вероятностный). На тренировочном корпусе определяются вероятности той или иной синтаксической структуры. На новом тексте вычисляется суммарная вероятность по имеющимся фрагментам структуры. Этапы: a. Создание банка деревьев (Пример: Penn Treebank Project) b. Вывод грамматики по банку деревьев

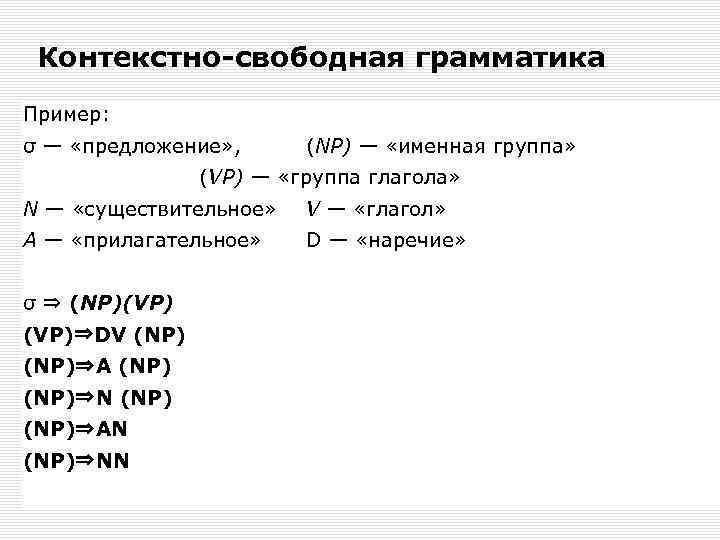

Контекстно-свободная грамматика Пример: σ — «предложение» , (NP) — «именная группа» (VP) — «группа глагола» N — «существительное» V — «глагол» A — «прилагательное» D — «наречие» σ ⇒ (NP)(VP)⇒DV (NP)⇒A (NP)⇒N (NP)⇒AN (NP)⇒NN

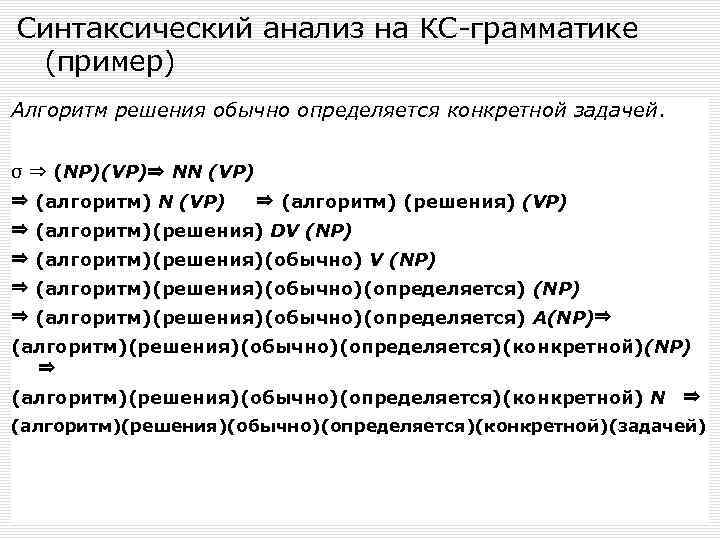

Синтаксический анализ на КС-грамматике (пример) Алгоритм решения обычно определяется конкретной задачей. σ ⇒ (NP)(VP)⇒ NN (VP) ⇒ (алгоритм) (решения) (VP) ⇒ (алгоритм)(решения) DV (NP) ⇒ (алгоритм)(решения)(обычно)(определяется) A(NP)⇒ (алгоритм)(решения)(обычно)(определяется)(конкретной)(NP) ⇒ (алгоритм)(решения)(обычно)(определяется)(конкретной) N ⇒ (алгоритм)(решения)(обычно)(определяется)(конкретной)(задачей)

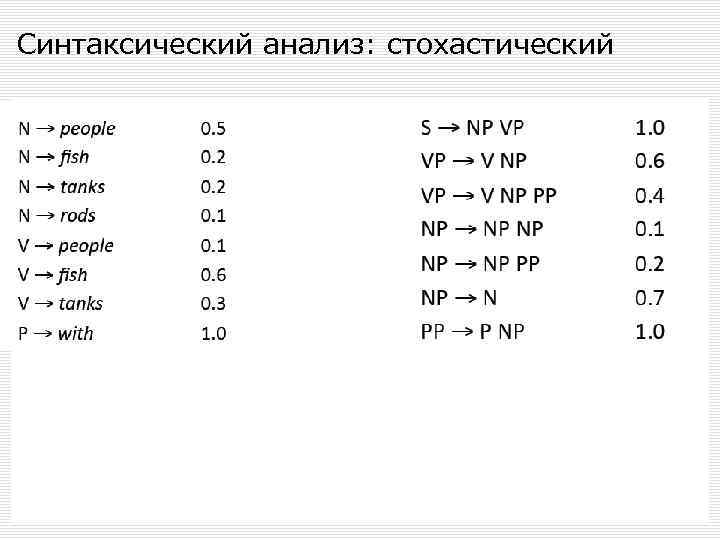

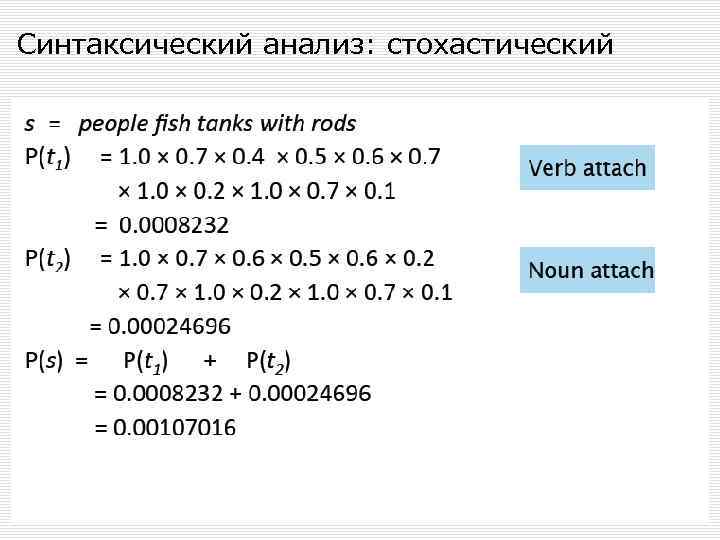

Синтаксический анализ: стохастический

Синтаксический анализ: стохастический

Синтаксический анализ: стохастический

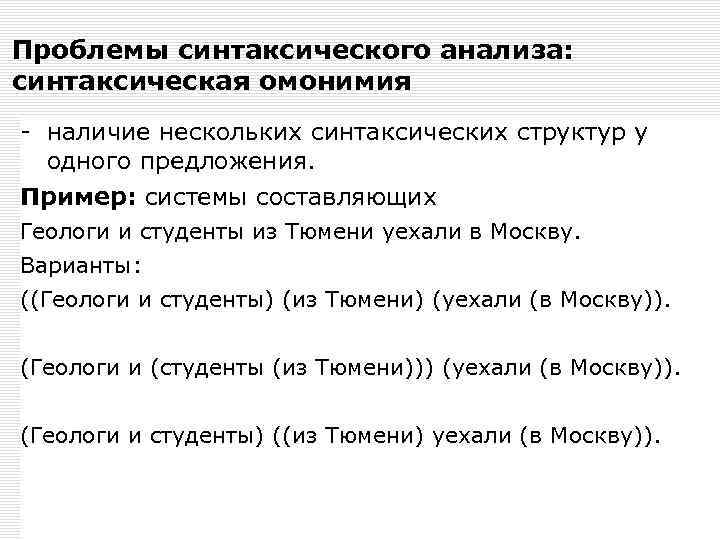

Проблемы синтаксического анализа: синтаксическая омонимия - наличие нескольких синтаксических структур у одного предложения. Пример: системы составляющих Геологи и студенты из Тюмени уехали в Москву. Варианты: ((Геологи и студенты) (из Тюмени) (уехали (в Москву)). (Геологи и (студенты (из Тюмени))) (уехали (в Москву)). (Геологи и студенты) ((из Тюмени) уехали (в Москву)).

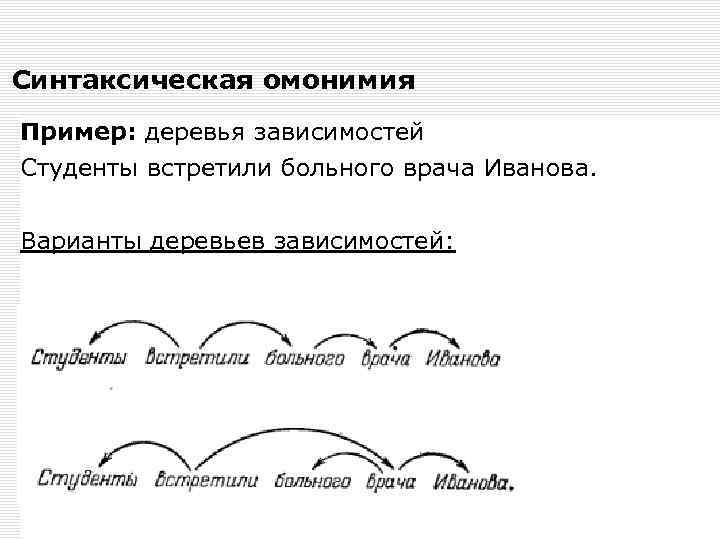

Синтаксическая омонимия Пример: деревья зависимостей Студенты встретили больного врача Иванова. Варианты деревьев зависимостей:

База знаний для синтаксического анализа 1. Знания о морфологических характеристиках словоформ (из результатов морфологического анализа) 2. Знания о синтаксических отношениях (на основе правил соответствия морфологических характеристик словоформ) 3. Знания о порядке слов в предложении 4. Знания о пунктуации

ВОПРОСЫ ТЕСТА Набор правил подстановки именных и глагольных групп реализуется в следующем виде формальной грамматики: а. Контекстно-свободная б. Цепочечная в. Непосредственных составляющих г. Зависимостей

ВОПРОСЫ ТЕСТА Набор правил подстановки именных и глагольных групп реализуется в следующем виде формальной грамматики: а. Контекстно-свободная б. Цепочечная в. Непосредственных составляющих г. Зависимостей

Представления синтаксического дерева Табличное: Скобочное: NP(A N) VP (V NP(PP(P NP(A N) Графическое:

ВОПРОСЫ ТЕСТА Дано предложение: “Построение лингвистических процессоров является важной задачей компьютерной лингвистики”. Какое синтаксическое дерево соответствует этому предложению? Обозначения: А – прилагательное, N существительное, V – глагол, NP именная группа, VP глагольная группа. а. VP (N NP(A N)) VP (V NP(NP(A N))) б. NP (A N) NP (V NP(NP(N A) NP(A N))) в. NP (N NP(A N)) VP (V NP(NP(A N))) г. NP (N (A N)) VP (V NP(NP(A N) NP))

ВОПРОСЫ ТЕСТА Дано предложение: “Построение лингвистических процессоров является важной задачей компьютерной лингвистики”. Какое синтаксическое дерево соответствует этому предложению? Обозначения: А – прилагательное, N существительное, V – глагол, NP именная группа, VP глагольная группа. а. VP (N NP(A N)) VP (V NP(NP(A N))) б. NP (A N) NP (V NP(NP(N A) NP(A N))) в. NP (N NP(A N)) VP (V NP(NP(A N))) г. NP (N (A N)) VP (V NP(NP(A N) NP))

Смысловое описание текста Семантика – система правил истолкования отдельных языковых конструкций. Семантика определяет смысловое значение предложений языка.

Смысловое описание текста - основополагающим элементом является ключевое понятие или термин текста; - представляется в виде семантической сети; - позволяет извлечь данные следующего содержания: • • • Определение объектов, входящих в объем понятия. Определение содержания понятия. Определение логических отношений между понятиями. Определение понятий по связывающим их отношениям. Определение свойств понятия. Определение сходства и различий между понятиями. Все типы отношений можно разбить на классифицирующие и предикатные.

Смысловое описание текста Кореференция - информации о том, в каких случаях речь идет об одном и том же объекте, а в каких — о разных. Формы выражения кореференции: синонимия слов и словосочетаний, использование местоимений, родовидовых обозначений, анафоры. Контекст термина– (семантическое поле), понятия, в сочетании с которыми используется термин.

Лингвистические модели Модель «семантик предпочтения» (Уилкс). Модель концептуальных зависимостей (Шенк). Модель СМЫСЛ -ТЕКСТ (Жолковский, Мельчук). Требования к моделям: Смысл представляется в терминах «атомов» смысла, с тем чтобы вскрывать смысловые сходства и различия между словами. Синонимичные фразы должны получать идентичные; семантические представления. Смысловое описание типа «объект – предикат – объект» называется объектно-предикатная система.

Подходы к построению семантической сети текста • Синтаксически ориентированный смысловой анализ на основе детального синтаксического разбора предложения - связанные понятия ( «атомы смысла» ) вычленяются только на основе синтаксических правил в пределах отдельного предложения. - позволяет достоверно выявить так называемые предикатные или сказуемостные отношения • Семантически ориентированный смысловой анализ на основе использования базы знаний - связанные понятия вычленяются с помощью базы знаний - позволяет установить отношения типа «род-вид» , «частьцелое» , «объект-свойство» , тождественности и многие другие • Гибридный – на основе синтаксического разбора, но с использованием базы знаний.

Синтаксически ориентированный подход Смысловая связь между понятиями предложения (именными группами) в общем случае может быть описана глаголом (предикатом), актантами (аргументами) которого выступают данные понятия. Словарь моделей управления глаголов для каждого из глаголов должно быть указано, какими падежами и с какими предлогами он может управлять.

Векторная модель семантики – это представление каждого документа коллекции в качестве точки в многомерном пространстве (вектора в векторном пространстве). Близко лежащие друг к другу точки соответствуют семантически схожим документам. . - является основой для решения многих задач информационного поиска: поиск документа по запросу, классификация документов, кластеризация документов. Сопоставление текстов. Документ в векторной модели рассматривается как неупорядоченное множество термов. Термами в информационном поиске называют слова, из которых состоит текст.

Пример векторной модели Пусть имеется документ, который содержит некоторое множество терминов (их порядок в наборе не важен): “научный, исследовательский, проект, научный, исследовательский” Тогда ему соответствует вектор X, где первый элемент соответствует числу вхождений в документ термина “научный”, второй – “исследовательский”, третий – “проект”: X={3, 2, 1}

Методы взвешивания термов Для полного определения векторной модели необходимо указать, каким именно образом будет отыскиваться вес терма в документе. Существует несколько стандартных способов задания функции взвешивания: • булевский вес — равен 1, если терм встречается в документе и 0 в противном случае; • TF (term frequency, частота терма) — вес определяется как функция от количества вхождений терма в документе; • TF-IDF (term frequency - inverse document frequency, частота терма - обратная частота документа) — вес определяется как произведение функции от количества вхождений терма в документ и функции от величины, обратной количеству документов коллекции, в которых встречается этот терм. • PMI (Pointwise Mutual Information) – взаимная встречаемость термов

Векторная модель на TF Термы: слова battle, soldier, fall, clown Документы: У. Шекспир As You Like It, Twelfth Night, Julius Caesar, Henry V Tfi=fi где fi- абсолютная частота слова в документе

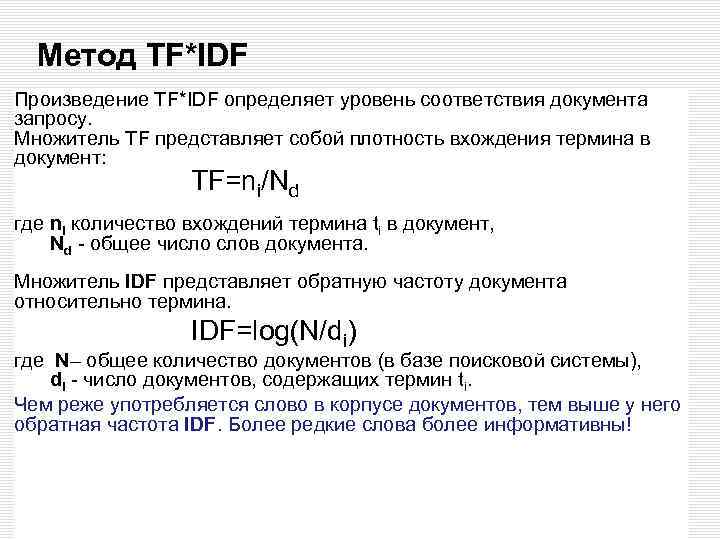

Метод TF*IDF Произведение TF*IDF определяет уровень соответствия документа запросу. Множитель TF представляет собой плотность вхождения термина в документ: TF=ni/Nd где ni количество вхождений термина ti в документ, Nd общее число слов документа. Множитель IDF представляет обратную частоту документа относительно термина. IDF=log(N/di) где N– общее количество документов (в базе поисковой системы), di число документов, содержащих термин ti. Чем реже употребляется слово в корпусе документов, тем выше у него обратная частота IDF. Более редкие слова более информативны!

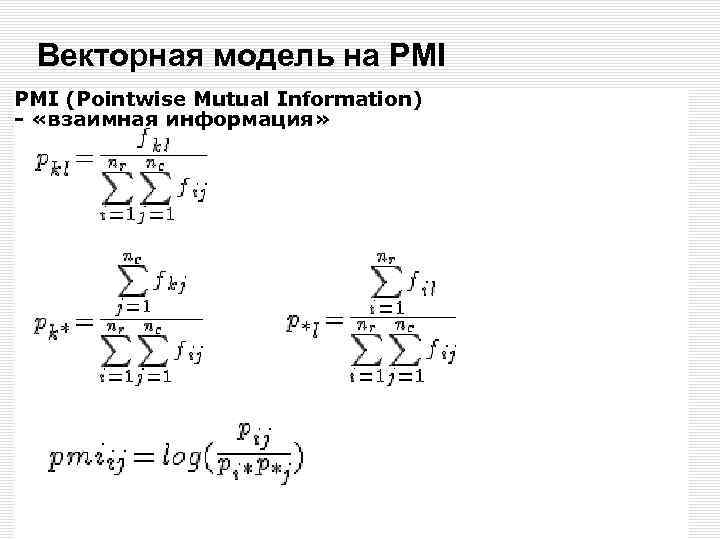

Векторная модель на PMI (Pointwise Mutual Information) - «взаимная информация»

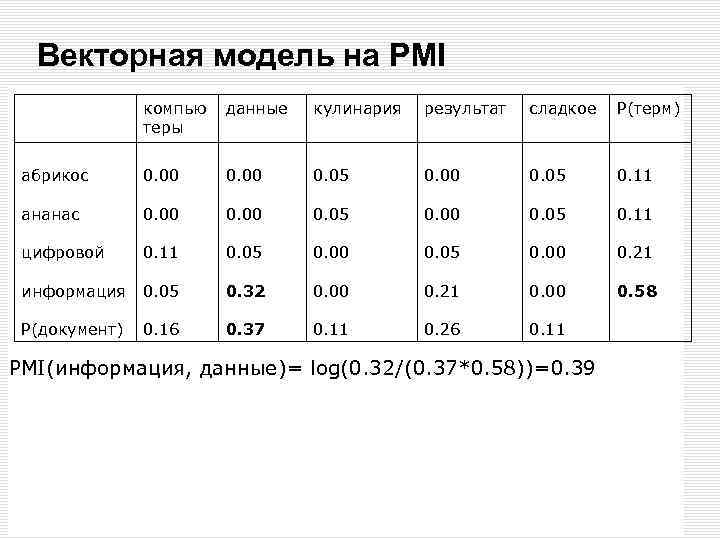

Векторная модель на PMI компью теры данные кулинария результат сладкое P(терм) абрикос 0. 00 0. 05 0. 11 ананас 0. 00 0. 05 0. 11 цифровой 0. 11 0. 05 0. 00 0. 21 информация 0. 05 0. 32 0. 00 0. 21 0. 00 0. 58 P(документ) 0. 16 0. 37 0. 11 0. 26 0. 11 PMI(информация, данные)= log(0. 32/(0. 37*0. 58))=0. 39

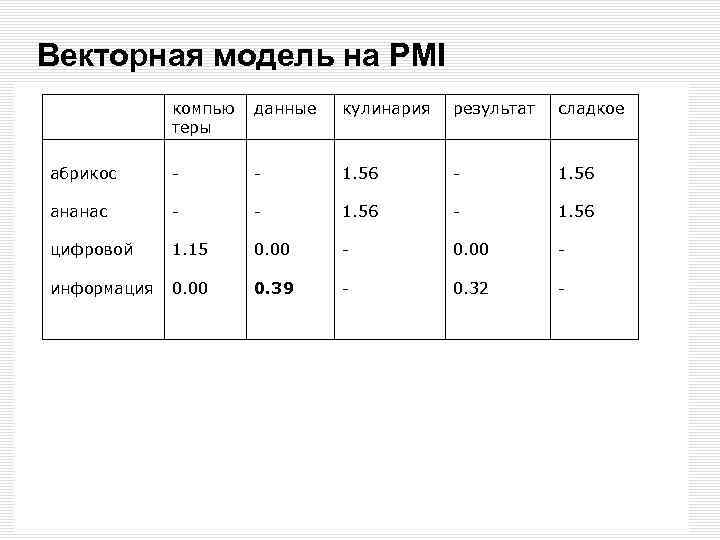

Векторная модель на PMI компью теры данные кулинария результат сладкое абрикос - - 1. 56 ананас - - 1. 56 цифровой 1. 15 0. 00 - информация 0. 00 0. 39 - 0. 32 -

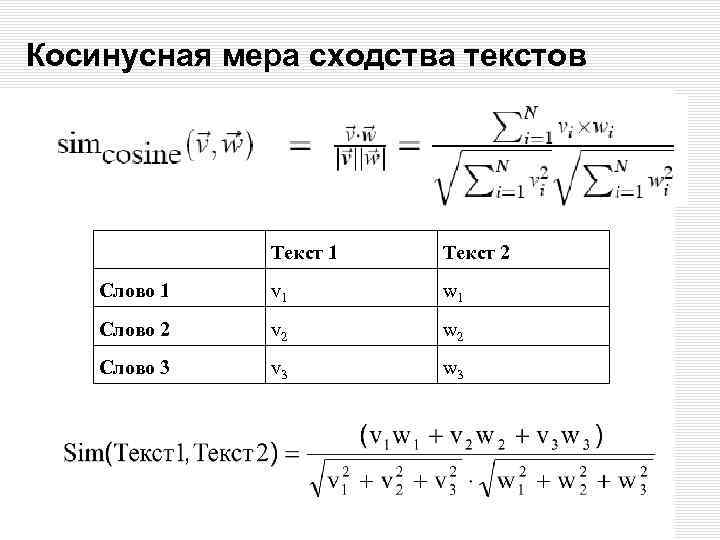

Косинусная мера сходства текстов Текст 1 Текст 2 Слово 1 v 1 w 1 Слово 2 v 2 w 2 Слово 3 v 3 w 3

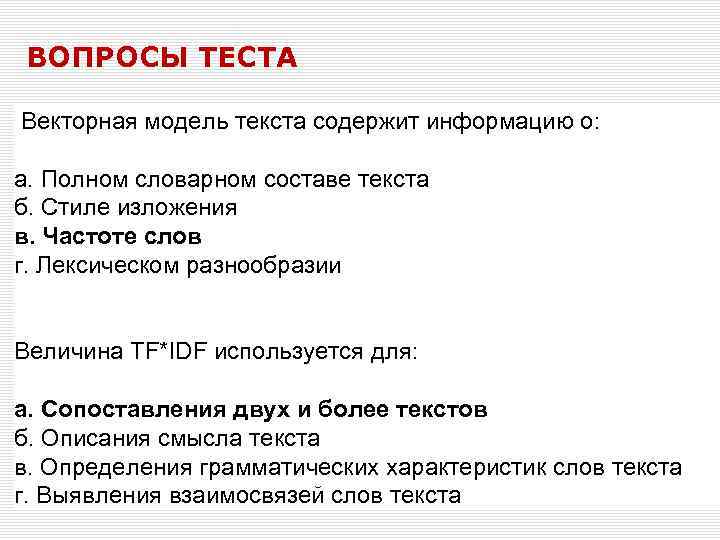

ВОПРОСЫ ТЕСТА Векторная модель текста содержит информацию о: а. Полном словарном составе текста б. Стиле изложения в. Частоте слов г. Лексическом разнообразии Величина TF*IDF используется для: а. Сопоставления двух и более текстов б. Описания смысла текста в. Определения грамматических характеристик слов текста г. Выявления взаимосвязей слов текста

ВОПРОСЫ ТЕСТА Векторная модель текста содержит информацию о: а. Полном словарном составе текста б. Стиле изложения в. Частоте слов г. Лексическом разнообразии Величина TF*IDF используется для: а. Сопоставления двух и более текстов б. Описания смысла текста в. Определения грамматических характеристик слов текста г. Выявления взаимосвязей слов текста

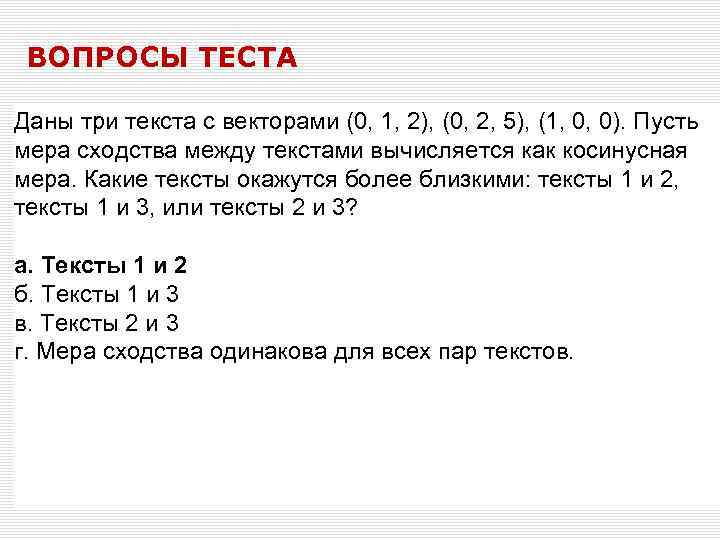

ВОПРОСЫ ТЕСТА Даны три текста с векторами (0, 1, 2), (0, 2, 5), (1, 0, 0). Пусть мера сходства между текстами вычисляется как косинусная мера. Какие тексты окажутся более близкими: тексты 1 и 2, тексты 1 и 3, или тексты 2 и 3? а. Тексты 1 и 2 б. Тексты 1 и 3 в. Тексты 2 и 3 г. Мера сходства одинакова для всех пар текстов.

ВОПРОСЫ ТЕСТА Даны три текста с векторами (0, 1, 2), (0, 2, 5), (1, 0, 0). Пусть мера сходства между текстами вычисляется как косинусная мера. Какие тексты окажутся более близкими: тексты 1 и 2, тексты 1 и 3, или тексты 2 и 3? а. Тексты 1 и 2 б. Тексты 1 и 3 в. Тексты 2 и 3 г. Мера сходства одинакова для всех пар текстов.

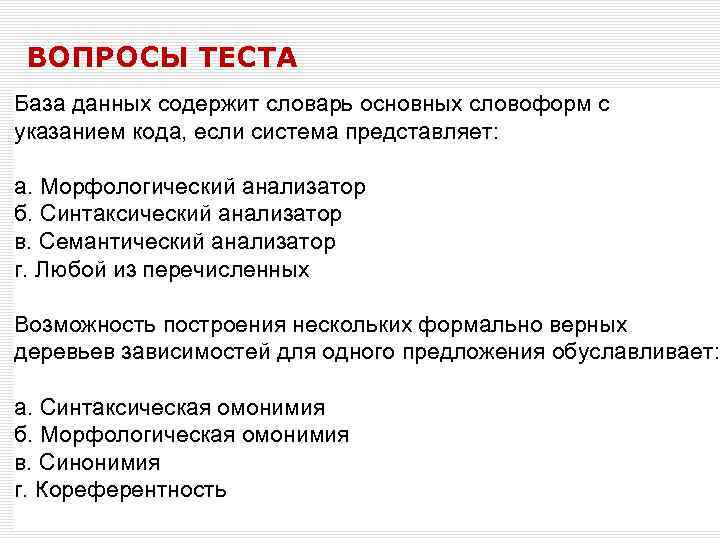

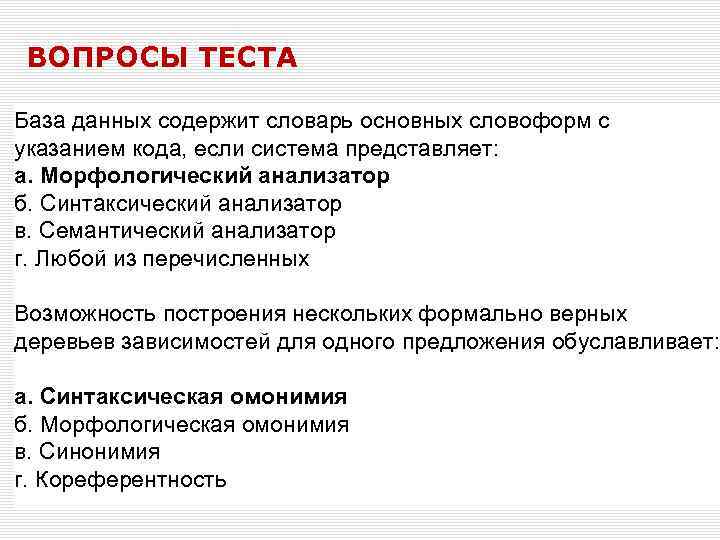

ВОПРОСЫ ТЕСТА База данных содержит словарь основных словоформ с указанием кода, если система представляет: а. Морфологический анализатор б. Синтаксический анализатор в. Семантический анализатор г. Любой из перечисленных Возможность построения нескольких формально верных деревьев зависимостей для одного предложения обуславливает: а. Синтаксическая омонимия б. Морфологическая омонимия в. Синонимия г. Кореферентность

ВОПРОСЫ ТЕСТА База данных содержит словарь основных словоформ с указанием кода, если система представляет: а. Морфологический анализатор б. Синтаксический анализатор в. Семантический анализатор г. Любой из перечисленных Возможность построения нескольких формально верных деревьев зависимостей для одного предложения обуславливает: а. Синтаксическая омонимия б. Морфологическая омонимия в. Синонимия г. Кореферентность

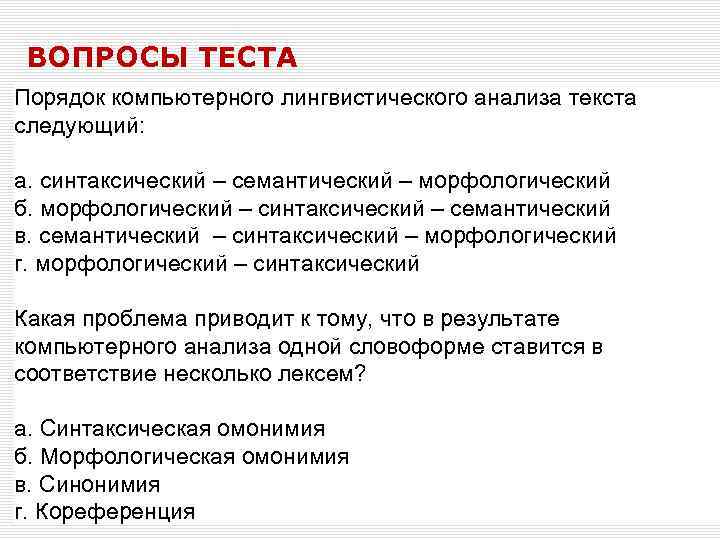

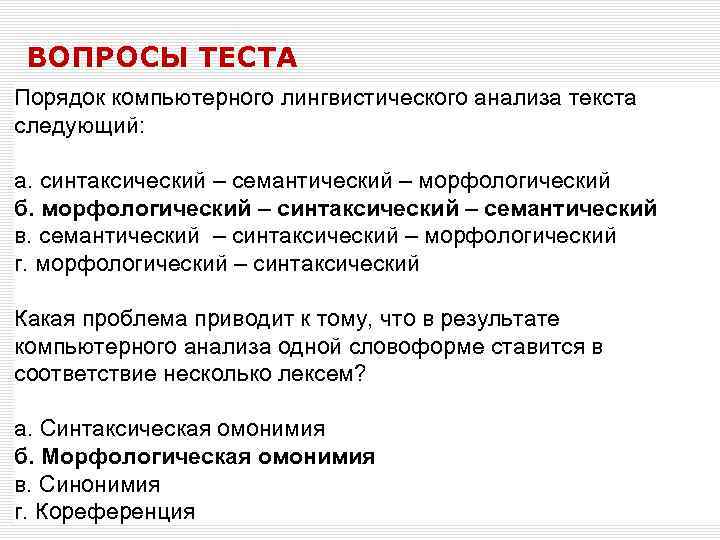

ВОПРОСЫ ТЕСТА Порядок компьютерного лингвистического анализа текста следующий: а. синтаксический – семантический – морфологический б. морфологический – синтаксический – семантический в. семантический – синтаксический – морфологический г. морфологический – синтаксический Какая проблема приводит к тому, что в результате компьютерного анализа одной словоформе ставится в соответствие несколько лексем? а. Синтаксическая омонимия б. Морфологическая омонимия в. Синонимия г. Кореференция

ВОПРОСЫ ТЕСТА Порядок компьютерного лингвистического анализа текста следующий: а. синтаксический – семантический – морфологический б. морфологический – синтаксический – семантический в. семантический – синтаксический – морфологический г. морфологический – синтаксический Какая проблема приводит к тому, что в результате компьютерного анализа одной словоформе ставится в соответствие несколько лексем? а. Синтаксическая омонимия б. Морфологическая омонимия в. Синонимия г. Кореференция

Классификация документов — одна из задач информационного поиска, заключающаяся в отнесении документа к одной из нескольких категорий на основании содержания документа. Классификация может осуществляться 1. полностью вручную, 2. автоматически с помощью созданного вручную набора правил, 3. автоматически с применением методов машинного обучения (пример: наивный байесовский подход).

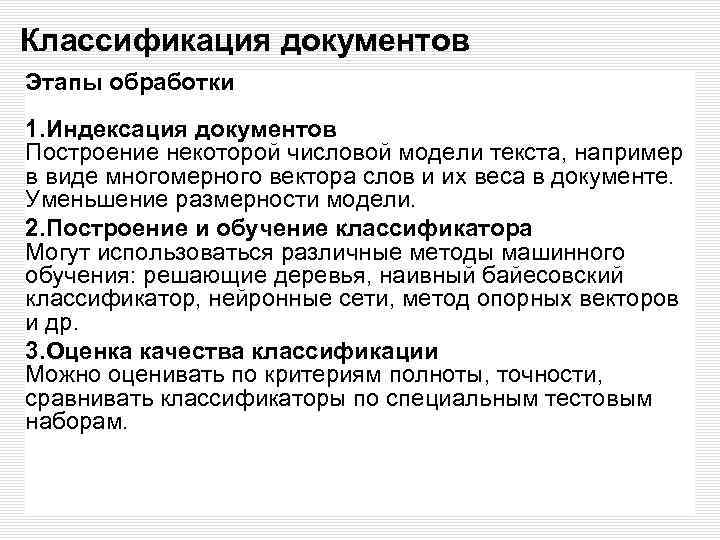

Классификация документов Этапы обработки 1. Индексация документов Построение некоторой числовой модели текста, например в виде многомерного вектора слов и их веса в документе. Уменьшение размерности модели. 2. Построение и обучение классификатора Могут использоваться различные методы машинного обучения: решающие деревья, наивный байесовский классификатор, нейронные сети, метод опорных векторов и др. 3. Оценка качества классификации Можно оценивать по критериям полноты, точности, сравнивать классификаторы по специальным тестовым наборам.

Наивный Байесовский подход • Nc – количество документов для каждой группы • N – количество документов для всех групп • P(c) – вероятность группы • count (w, c) – число раз, когда слово w встречается в документе группы с • count (c) – число слов во всех документах данной группы с • V – объем словаря всех документов (число уникальных) слов

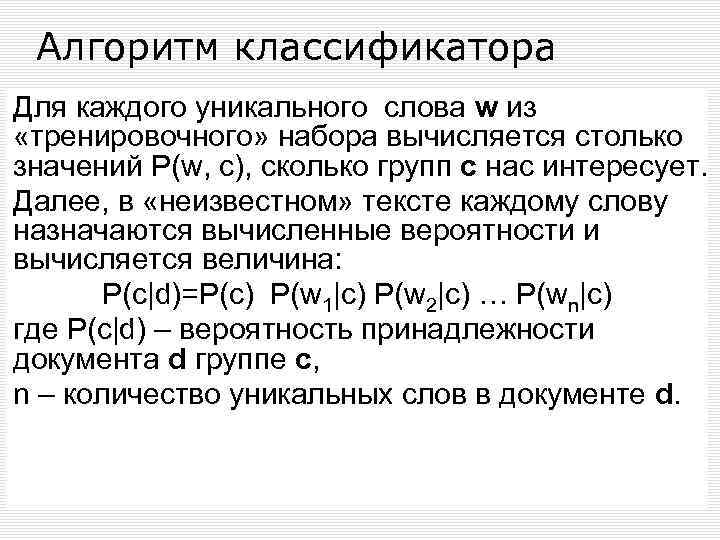

Алгоритм классификатора Для каждого уникального слова w из «тренировочного» набора вычисляется столько значений P(w, c), сколько групп c нас интересует. Далее, в «неизвестном» тексте каждому слову назначаются вычисленные вероятности и вычисляется величина: P(c|d)=P(c) P(w 1|c) P(w 2|c) … P(wn|c) где P(c|d) – вероятность принадлежности документа d группе с, n – количество уникальных слов в документе d.

Пример работы классификатора Doc Chinese Beijing Chinese c Chinese Shanghai c d 3 Chinese Macao c d 4 Неизв. текст d 1 d 2 Трен. выборка Words Class Tokyo Japan Chinese j d 5 Chinese Tokyo Japan ? Выбор класса для d 5: P(c|d)=P(c) P(w 1|c) P(w 2|c) … P(wn|c) P(c|d 5) Условные вероятности P(Chinese|c) = (5+1) / (8+6) = 6/14 = 3/7 P(Tokyo|c) = (0+1) / (8+6) = 1/14 P(Japan|c) = P(Chinese|j) = (0+1) / (8+6) = 1/14 P(Tokyo|j) = (1+1) / (3+6) = 2/9 P(Japan|j) = (1+1) / (3+6) = 2/9 P(j|d 5) 3/4 * (3/7)3 * 1/14 ≈ 0. 0003 1/4 * (2/9)3 * 2/9 ≈ 0. 0001

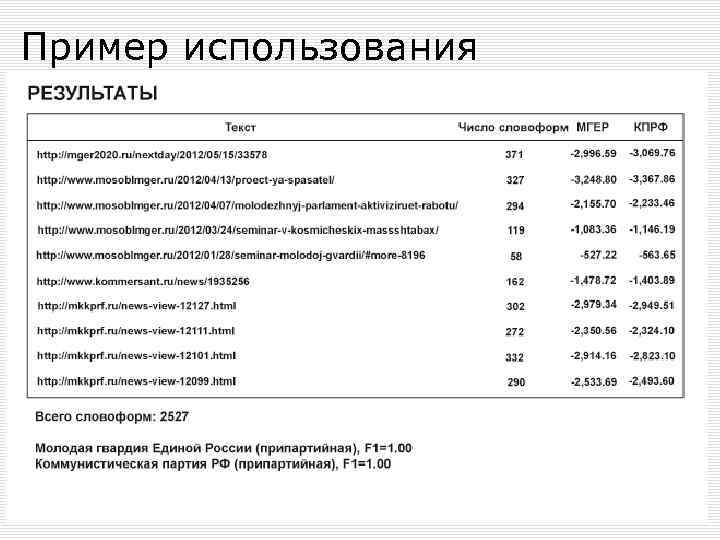

Пример использования Определение признаков политического сообщества по текстам сообщений в форумах и группах социальных сетей Вход: Данные о сообществе (название, тип, ресурсы и т. д. ) Тексты, авторами которых являются представители сообществ Тексты для анализа Выход: Список текстов, отнесенных к тому или иному сообществу.

Пример использования

ВОПРОСЫ ТЕСТА Документы Text 1 и Text 2 необходимо отнести к одному из классов: Класс А и Класс В. В результате подсчета вероятностей байесовский классификатор выдал следующие значения: P(A|Text 1) = 0. 0003 P(A|Text 2) = 0. 0004 P(B|Text 1) = 0. 0001 P(B|Text 2) = 0. 0003 Какой следует вывод о принадлежности документов к классам? а. Text 1 принадлежит к классу А, Text 2 принадлежит к классу B б. Text 1 принадлежит к классу B, Text 2 принадлежит к классу A в. Оба текста принадлежат классу А г. Оба текста принадлежат классу В

ВОПРОСЫ ТЕСТА Документы Text 1 и Text 2 необходимо отнести к одному из классов: Класс А и Класс В. В результате подсчета вероятностей байесовский классификатор выдал следующие значения: P(A|Text 1) = 0. 0003 P(A|Text 2) = 0. 0004 P(B|Text 1) = 0. 0001 P(B|Text 2) = 0. 0003 Какой следует вывод о принадлежности документов к классам? а. Text 1 принадлежит к классу А, Text 2 принадлежит к классу B б. Text 1 принадлежит к классу B, Text 2 принадлежит к классу A в. Оба текста принадлежат классу А г. Оба текста принадлежат классу В

Sentiment-анализ: термин Opinion extraction Opinion mining Sentiment mining Subjectivity analysis Анализ мнений Анализ тональности

Sentiment-анализ численный анализ мнений, настроений, субъективности, оценок, отношения, эмоций и т. д, которые выражены в текстовом виде. классификация документов на основе мнений мнение определяется путем подсчета слов или конструкций из слов, каждое из которых заранее отнесено к одному из лексиконов: положительному (позитивное мнение) либо отрицательному (негативное мнение).

Sentiment-анализ: применения Фильм: является ли этот отзыв положительным или отрицательным? Продукт: что люди думают о новом i. Phone? Общественное мнение: каково доверие потребителей? Политика: что люди думают по поводу кандидата или проблемы? Прогноз: предсказать исход выборов или тенденции рынка.

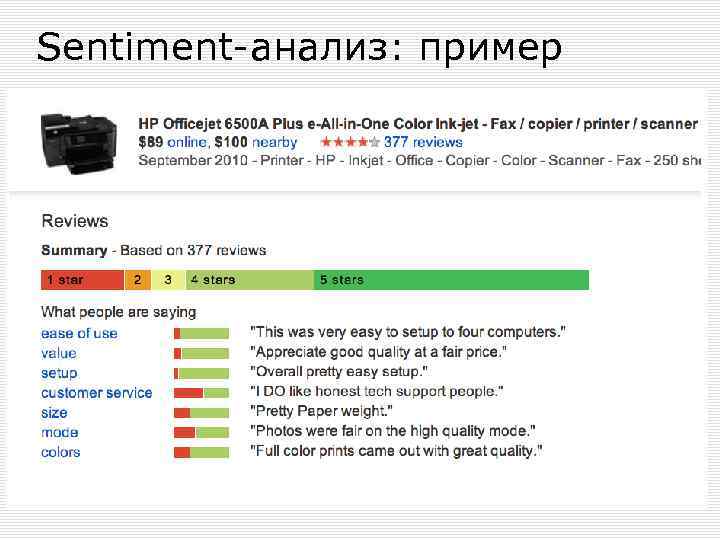

Sentiment-анализ: пример

ВОПРОСЫ ТЕСТА Дан текст оценочного содержания, в котором произведен подсчет слов положительного и отрицательного лексикона. По какому признаку компьютерная программа может определить тональность текста: а. Относительная частота слов положительного лексикона б. Суммарная частота слов положительного и отрицательного лексиконов в. Относительная частота слов отрицательного лексикона г. Разница частот слов положительного и отрицательного лексиконов

ВОПРОСЫ ТЕСТА Дан текст оценочного содержания, в котором произведен подсчет слов положительного и отрицательного лексикона. По какому признаку компьютерная программа может определить тональность текста: а. Относительная частота слов положительного лексикона б. Суммарная частота слов положительного и отрицательного лексиконов в. Относительная частота слов отрицательного лексикона г. Разница частот слов положительного и отрицательного лексиконов

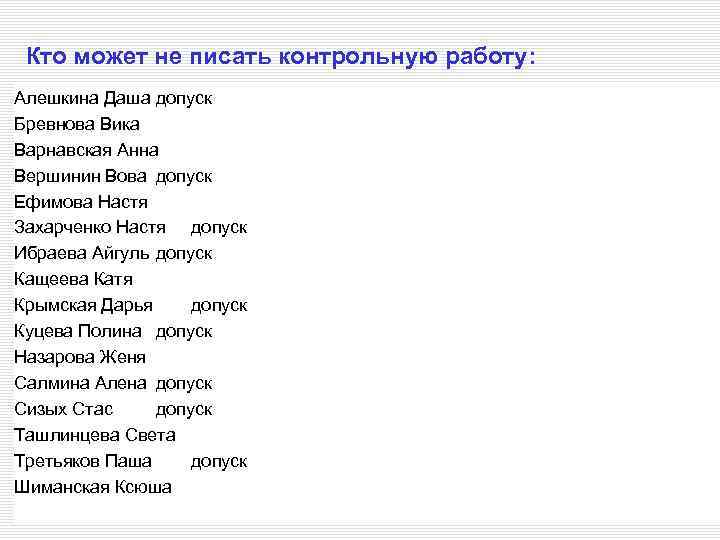

Кто может не писать контрольную работу: Алешкина Даша допуск Бревнова Вика Варнавская Анна Вершинин Вова допуск Ефимова Настя Захарченко Настя допуск Ибраева Айгуль допуск Кащеева Катя Крымская Дарья допуск Куцева Полина допуск Назарова Женя Салмина Алена допуск Сизых Стас допуск Ташлинцева Света Третьяков Паша допуск Шиманская Ксюша

обзор.ppt