Inf-Chim-02-2012-o.pptx

- Количество слайдов: 94

Информационные технологии и Информатика Ст. препод кафедры ВМ № 2 ИФП СФУ Наталья Александровна Лукьяновыа nata 00 sfu@gmail. com

Информационные технологии и Информатика Ст. препод кафедры ВМ № 2 ИФП СФУ Наталья Александровна Лукьяновыа nata 00 sfu@gmail. com

Информатика Лекция 2 Информация, ее виды и свойства Информатика — наука о способах получения, накоплении, хранении, преобразовании, передаче и использовании информации. 2/87

Информатика Лекция 2 Информация, ее виды и свойства Информатика — наука о способах получения, накоплении, хранении, преобразовании, передаче и использовании информации. 2/87

Информатика Лекция 2 Классификация информации Информация отношению к по источнику отношению к или конечному приемнику результату по ее изменчивости по стадии ее использования по ее полноте по доступу к ней входная исходная Постоянная первичная Избыточная открытая выходная промежу точная Переменная вторична я Достаточная закрытая внутренняя Результи рующая Смешанная Недостаточная 3/87

Информатика Лекция 2 Классификация информации Информация отношению к по источнику отношению к или конечному приемнику результату по ее изменчивости по стадии ее использования по ее полноте по доступу к ней входная исходная Постоянная первичная Избыточная открытая выходная промежу точная Переменная вторична я Достаточная закрытая внутренняя Результи рующая Смешанная Недостаточная 3/87

Информатика Лекция 2 Формы представления информации ØСообщение - информация, фиксированная в определенной форме. ØСигнал можно характеризовать как средство перенесения информации в пространстве и времени. ØКодирование - построение сигнала по определенным правилам. 4/87

Информатика Лекция 2 Формы представления информации ØСообщение - информация, фиксированная в определенной форме. ØСигнал можно характеризовать как средство перенесения информации в пространстве и времени. ØКодирование - построение сигнала по определенным правилам. 4/87

Информатика Лекция 2 Информационный элемент Первичным и неделимым элементом информации следует считать двоичное событие: Øутверждение или отрицание, Øналичие или отсутствие, Øединица или нуль, Øимпульс или пауза. Событие не имеет геометрических измерений и представляется точкой ДА НЕТ 5/87

Информатика Лекция 2 Информационный элемент Первичным и неделимым элементом информации следует считать двоичное событие: Øутверждение или отрицание, Øналичие или отсутствие, Øединица или нуль, Øимпульс или пауза. Событие не имеет геометрических измерений и представляется точкой ДА НЕТ 5/87

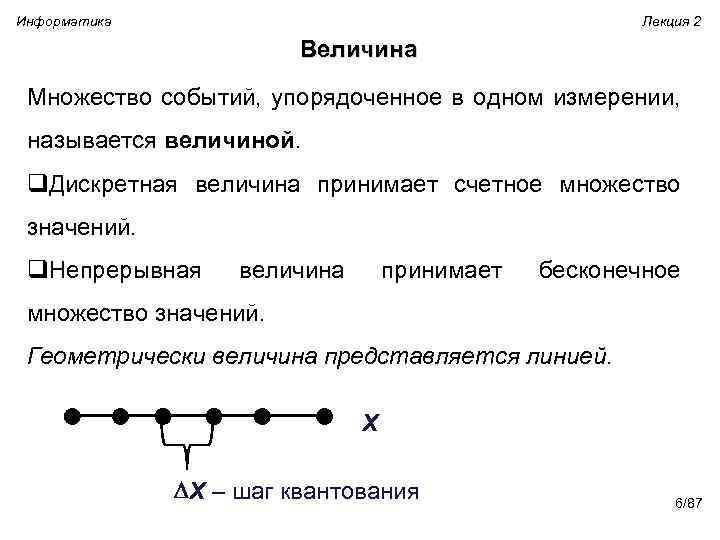

Информатика Лекция 2 Величина Множество событий, упорядоченное в одном измерении, называется величиной. q. Дискретная величина принимает счетное множество значений. q. Непрерывная величина принимает бесконечное множество значений. Геометрически величина представляется линией. X X – шаг квантования 6/87

Информатика Лекция 2 Величина Множество событий, упорядоченное в одном измерении, называется величиной. q. Дискретная величина принимает счетное множество значений. q. Непрерывная величина принимает бесконечное множество значений. Геометрически величина представляется линией. X X – шаг квантования 6/87

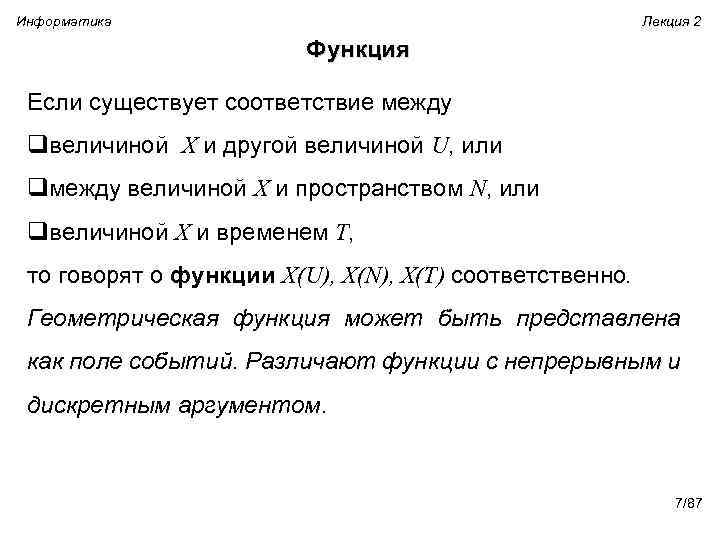

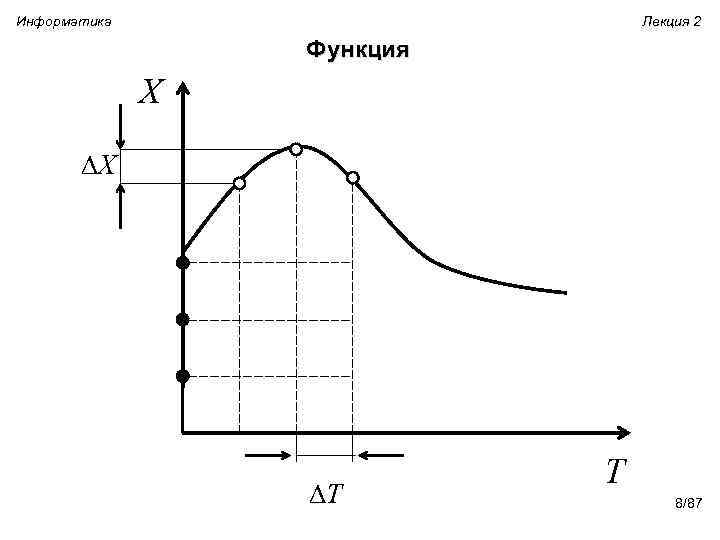

Информатика Лекция 2 Функция Если существует соответствие между qвеличиной X и другой величиной U, или qмежду величиной X и пространством N, или qвеличиной X и временем T, то говорят о функции X(U), X(N), X(T) соответственно. Геометрическая функция может быть представлена как поле событий. Различают функции с непрерывным и дискретным аргументом. 7/87

Информатика Лекция 2 Функция Если существует соответствие между qвеличиной X и другой величиной U, или qмежду величиной X и пространством N, или qвеличиной X и временем T, то говорят о функции X(U), X(N), X(T) соответственно. Геометрическая функция может быть представлена как поле событий. Различают функции с непрерывным и дискретным аргументом. 7/87

Информатика Лекция 2 Функция X X T T 8/87

Информатика Лекция 2 Функция X X T T 8/87

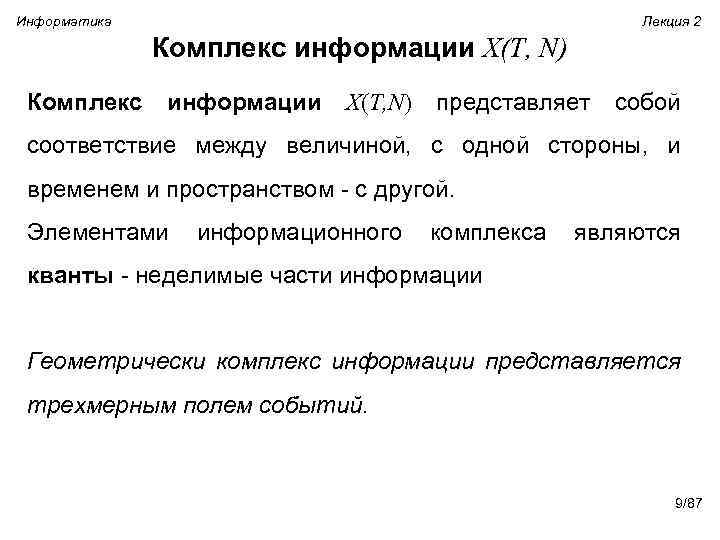

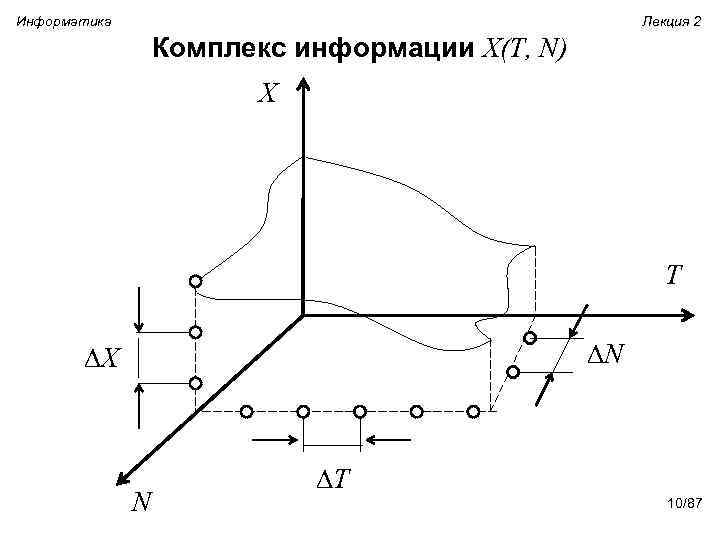

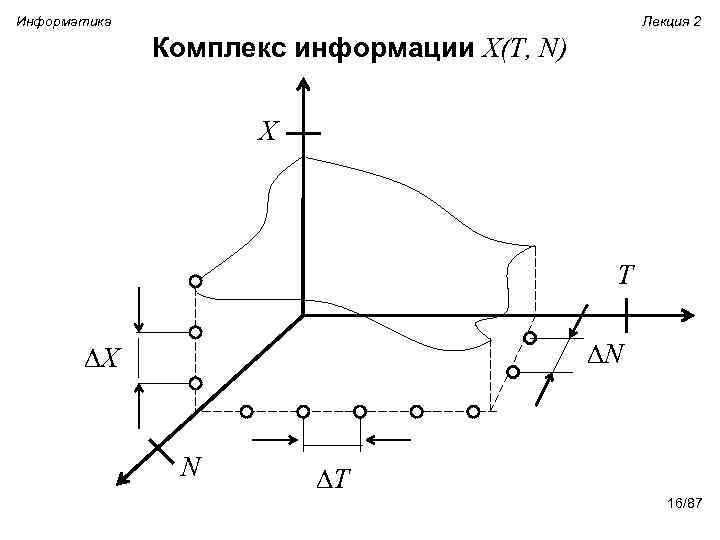

Информатика Лекция 2 Комплекс информации X(T, N) представляет собой соответствие между величиной, с одной стороны, и временем и пространством - с другой. Элементами информационного комплекса являются кванты - неделимые части информации Геометрически комплекс информации представляется трехмерным полем событий. 9/87

Информатика Лекция 2 Комплекс информации X(T, N) представляет собой соответствие между величиной, с одной стороны, и временем и пространством - с другой. Элементами информационного комплекса являются кванты - неделимые части информации Геометрически комплекс информации представляется трехмерным полем событий. 9/87

Информатика Лекция 2 Комплекс информации X(T, N) X T N X N T 10/87

Информатика Лекция 2 Комплекс информации X(T, N) X T N X N T 10/87

Информатика Лекция 2 Модели информации Информация описывается моделями с различной мерностью: Øсобытие представляет собой нульмерную информацию; Øвеличина - одномерную информацию; Øфункция – двухмерную информацию; Øкомплекс – трехмерную информацию. 11/87

Информатика Лекция 2 Модели информации Информация описывается моделями с различной мерностью: Øсобытие представляет собой нульмерную информацию; Øвеличина - одномерную информацию; Øфункция – двухмерную информацию; Øкомплекс – трехмерную информацию. 11/87

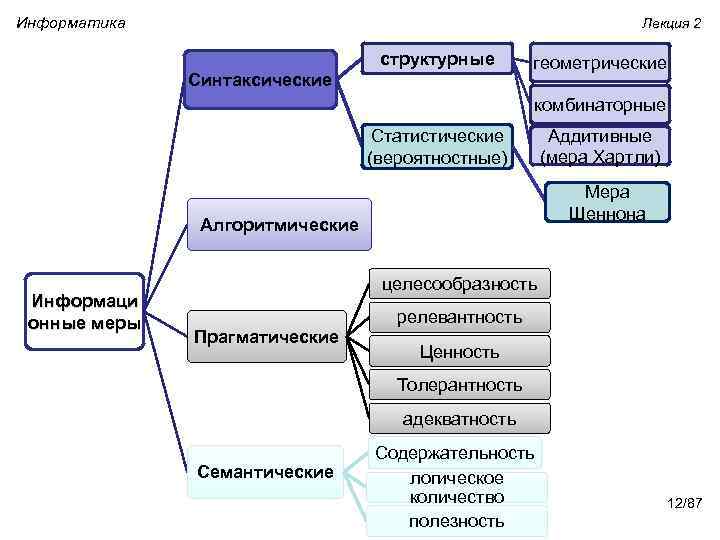

Информатика Лекция 2 структурные Синтаксические геометрические комбинаторные Статистические (вероятностные) Аддитивные (мера Хартли) Мера Шеннона Алгоритмические Информаци онные меры целесообразность Прагматические релевантность Ценность Толерантность адекватность Семантические Содержательность логическое количество полезность 12/87

Информатика Лекция 2 структурные Синтаксические геометрические комбинаторные Статистические (вероятностные) Аддитивные (мера Хартли) Мера Шеннона Алгоритмические Информаци онные меры целесообразность Прагматические релевантность Ценность Толерантность адекватность Семантические Содержательность логическое количество полезность 12/87

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход При использовании структурных мер информации учитывается только дискретное строение сообщения, количество содержащихся в нем информационных элементов, связей между ними. Структурные информационные меры (объемный подход) геометрические комбинаторные Аддитивные (мера Хартли) 13/87

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход При использовании структурных мер информации учитывается только дискретное строение сообщения, количество содержащихся в нем информационных элементов, связей между ними. Структурные информационные меры (объемный подход) геометрические комбинаторные Аддитивные (мера Хартли) 13/87

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход: геометрическая мера. Геометрическая мера предполагает измерение параметра геометрической модели информационного сообщения (длины, площади, объема и т. п) в дискретных единицах (в количестве квантов). 14/87

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход: геометрическая мера. Геометрическая мера предполагает измерение параметра геометрической модели информационного сообщения (длины, площади, объема и т. п) в дискретных единицах (в количестве квантов). 14/87

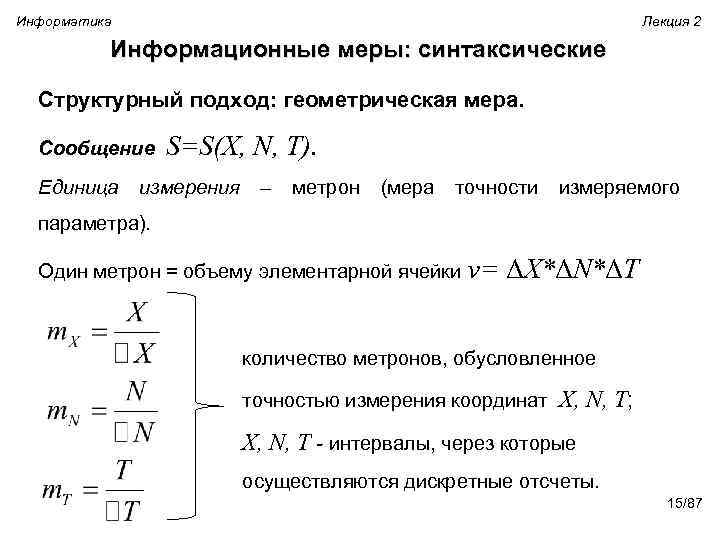

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход: геометрическая мера. Сообщение Единица S=S(X, N, T). измерения – метрон (мера точности измеряемого параметра). Один метрон = объему элементарной ячейки v= ΔX*ΔN*ΔT количество метронов, обусловленное точностью измерения координат X, N, T; X, N, T - интервалы, через которые осуществляются дискретные отсчеты. 15/87

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход: геометрическая мера. Сообщение Единица S=S(X, N, T). измерения – метрон (мера точности измеряемого параметра). Один метрон = объему элементарной ячейки v= ΔX*ΔN*ΔT количество метронов, обусловленное точностью измерения координат X, N, T; X, N, T - интервалы, через которые осуществляются дискретные отсчеты. 15/87

Информатика Лекция 2 Комплекс информации X(T, N) X T N X N T 16/87

Информатика Лекция 2 Комплекс информации X(T, N) X T N X N T 16/87

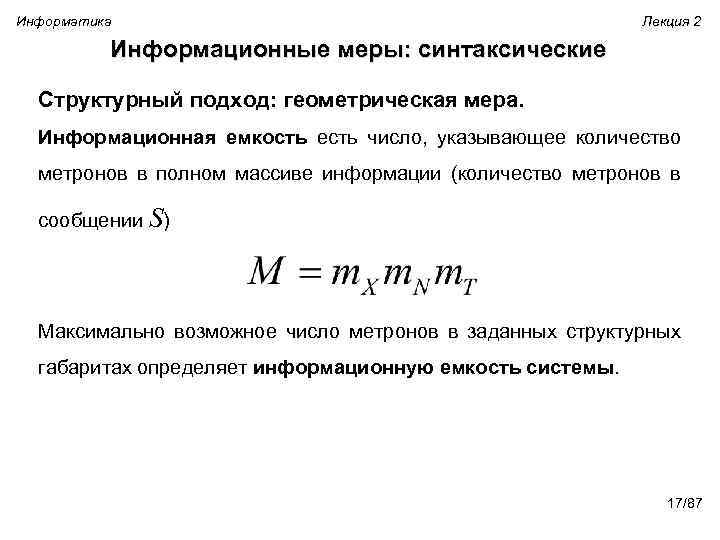

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход: геометрическая мера. Информационная емкость есть число, указывающее количество метронов в полном массиве информации (количество метронов в сообщении S) Максимально возможное число метронов в заданных структурных габаритах определяет информационную емкость системы. 17/87

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход: геометрическая мера. Информационная емкость есть число, указывающее количество метронов в полном массиве информации (количество метронов в сообщении S) Максимально возможное число метронов в заданных структурных габаритах определяет информационную емкость системы. 17/87

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход: геометрическая мера. Сообщение 555555444443333 Информационный элемент – 1 символ сообщения. Объем сообщения (количество метронов): Mисх=15. Кодирование повторений 5(6)4(5)3(4). Mкод=12. Эффект кодирования Mисх –Mкод=3 M(компьютеризация)= M(555555444443333) 18/87

Информатика Лекция 2 Информационные меры: синтаксические Структурный подход: геометрическая мера. Сообщение 555555444443333 Информационный элемент – 1 символ сообщения. Объем сообщения (количество метронов): Mисх=15. Кодирование повторений 5(6)4(5)3(4). Mкод=12. Эффект кодирования Mисх –Mкод=3 M(компьютеризация)= M(555555444443333) 18/87

Информатика Лекция 2 Информационные меры: синтаксические Комбинаторная мера оценивает возможность представления информации при помощи различных комбинаций информационных элементов в заданном объеме. Комбинаторика посвященный элементов – раздел решению некоторого задач дискретной выбора множества в и математики, расположения соответствии с заданными правилами. В комбинаторной мере количество информации определяется как число комбинаций элементов (символов). 19/87

Информатика Лекция 2 Информационные меры: синтаксические Комбинаторная мера оценивает возможность представления информации при помощи различных комбинаций информационных элементов в заданном объеме. Комбинаторика посвященный элементов – раздел решению некоторого задач дискретной выбора множества в и математики, расположения соответствии с заданными правилами. В комбинаторной мере количество информации определяется как число комбинаций элементов (символов). 19/87

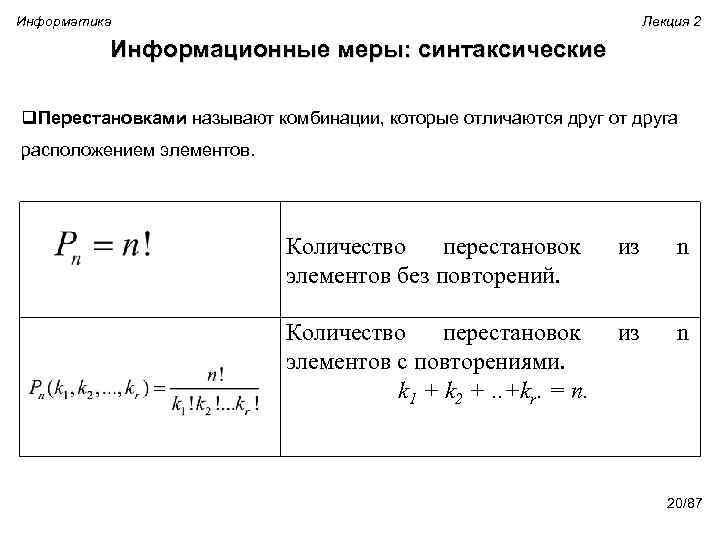

Информатика Лекция 2 Информационные меры: синтаксические q. Перестановками называют комбинации, которые отличаются друг от друга расположением элементов. Количество перестановок элементов без повторений. из n Количество перестановок элементов с повторениями. k 1 + k 2 +. . +kr. = n. из n 20/87

Информатика Лекция 2 Информационные меры: синтаксические q. Перестановками называют комбинации, которые отличаются друг от друга расположением элементов. Количество перестановок элементов без повторений. из n Количество перестановок элементов с повторениями. k 1 + k 2 +. . +kr. = n. из n 20/87

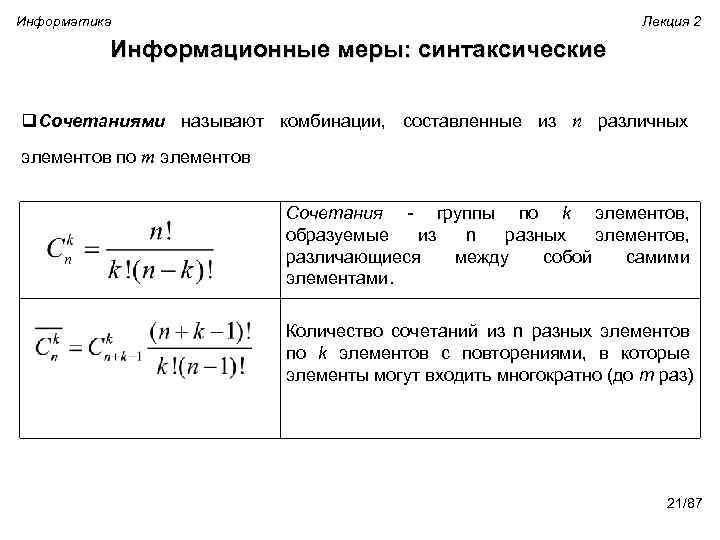

Информатика Лекция 2 Информационные меры: синтаксические q. Сочетаниями называют комбинации, составленные из n различных элементов по m элементов Сочетания - группы по k элементов, образуемые из n разных элементов, различающиеся между собой самими элементами. Количество сочетаний из n разных элементов по k элементов с повторениями, в которые элементы могут входить многократно (до m раз) 21/87

Информатика Лекция 2 Информационные меры: синтаксические q. Сочетаниями называют комбинации, составленные из n различных элементов по m элементов Сочетания - группы по k элементов, образуемые из n разных элементов, различающиеся между собой самими элементами. Количество сочетаний из n разных элементов по k элементов с повторениями, в которые элементы могут входить многократно (до m раз) 21/87

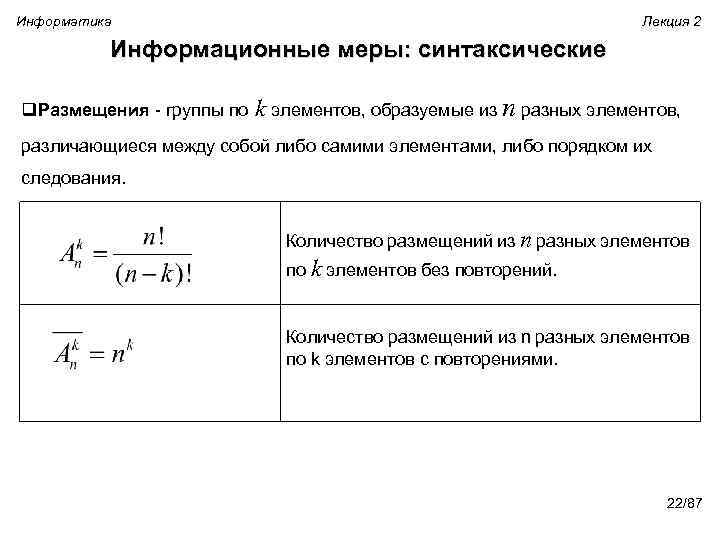

Информатика Лекция 2 Информационные меры: синтаксические q. Размещения - группы по k элементов, образуемые из n разных элементов, различающиеся между собой либо самими элементами, либо порядком их следования. Количество размещений из n разных элементов по k элементов без повторений. Количество размещений из n разных элементов по k элементов с повторениями. 22/87

Информатика Лекция 2 Информационные меры: синтаксические q. Размещения - группы по k элементов, образуемые из n разных элементов, различающиеся между собой либо самими элементами, либо порядком их следования. Количество размещений из n разных элементов по k элементов без повторений. Количество размещений из n разных элементов по k элементов с повторениями. 22/87

Информатика Лекция 2 Информационные меры: синтаксические Единицей измерения информации в комбинаторной мере является число комбинаций информационных элементов. Определение количества информации в комбинаторной мере определение количества возможных или существующих комбинаций, т. е. оценка структурного разнообразия информационного устройства. 23/87

Информатика Лекция 2 Информационные меры: синтаксические Единицей измерения информации в комбинаторной мере является число комбинаций информационных элементов. Определение количества информации в комбинаторной мере определение количества возможных или существующих комбинаций, т. е. оценка структурного разнообразия информационного устройства. 23/87

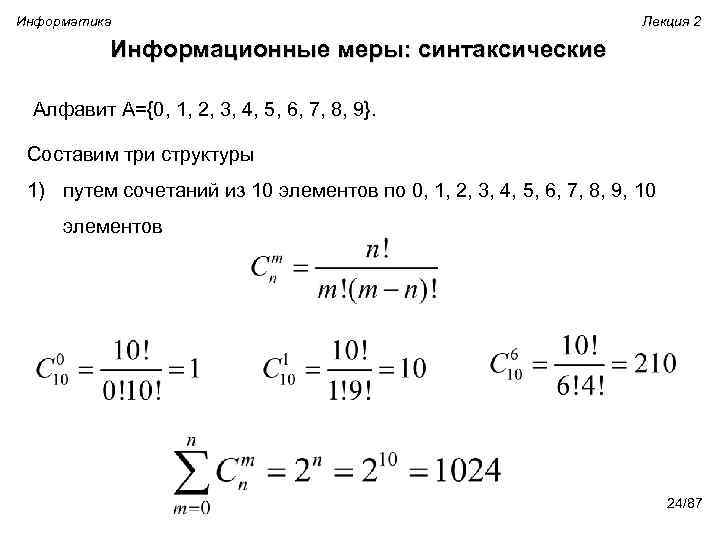

Информатика Лекция 2 Информационные меры: синтаксические Алфавит A={0, 1, 2, 3, 4, 5, 6, 7, 8, 9}. Составим три структуры 1) путем сочетаний из 10 элементов по 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10 элементов 24/87

Информатика Лекция 2 Информационные меры: синтаксические Алфавит A={0, 1, 2, 3, 4, 5, 6, 7, 8, 9}. Составим три структуры 1) путем сочетаний из 10 элементов по 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10 элементов 24/87

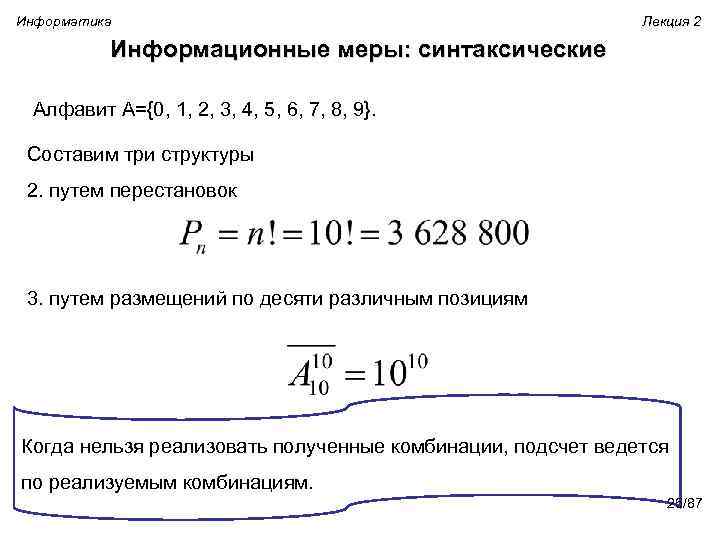

Информатика Лекция 2 Информационные меры: синтаксические Алфавит A={0, 1, 2, 3, 4, 5, 6, 7, 8, 9}. Составим три структуры 2. путем перестановок 3. путем размещений по десяти различным позициям Когда нельзя реализовать полученные комбинации, подсчет ведется по реализуемым комбинациям. 25/87

Информатика Лекция 2 Информационные меры: синтаксические Алфавит A={0, 1, 2, 3, 4, 5, 6, 7, 8, 9}. Составим три структуры 2. путем перестановок 3. путем размещений по десяти различным позициям Когда нельзя реализовать полученные комбинации, подсчет ведется по реализуемым комбинациям. 25/87

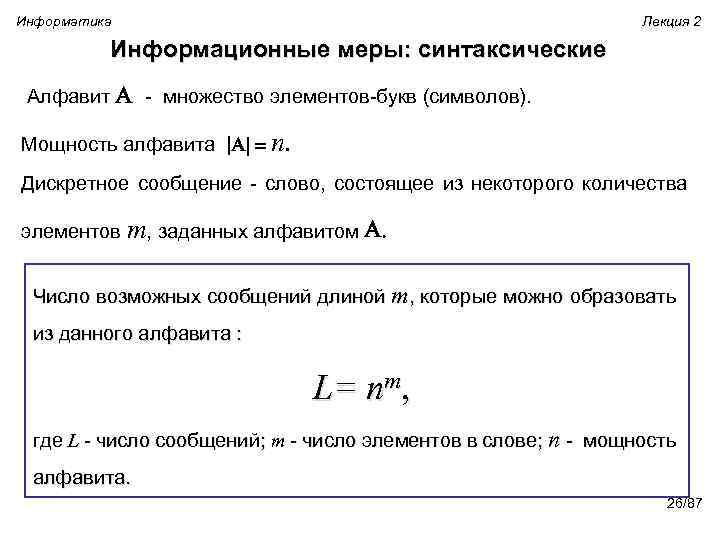

Информатика Лекция 2 Информационные меры: синтаксические Алфавит A - множество элементов-букв (символов). Мощность алфавита |A| = n. Дискретное сообщение - слово, состоящее из некоторого количества элементов m, заданных алфавитом A. Число возможных сообщений длиной m, которые можно образовать из данного алфавита : L= nm, где L - число сообщений; m - число элементов в слове; n - мощность алфавита. 26/87

Информатика Лекция 2 Информационные меры: синтаксические Алфавит A - множество элементов-букв (символов). Мощность алфавита |A| = n. Дискретное сообщение - слово, состоящее из некоторого количества элементов m, заданных алфавитом A. Число возможных сообщений длиной m, которые можно образовать из данного алфавита : L= nm, где L - число сообщений; m - число элементов в слове; n - мощность алфавита. 26/87

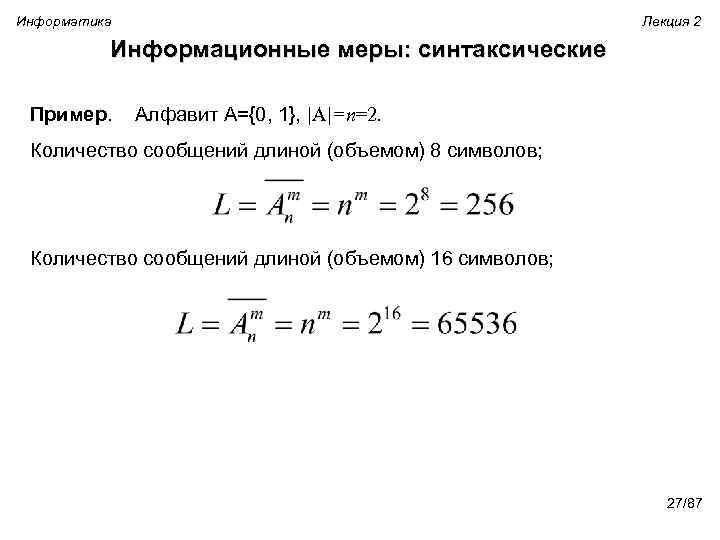

Информатика Лекция 2 Информационные меры: синтаксические Пример. Алфавит A={0, 1}, |A|=n=2. Количество сообщений длиной (объемом) 8 символов; Количество сообщений длиной (объемом) 16 символов; 27/87

Информатика Лекция 2 Информационные меры: синтаксические Пример. Алфавит A={0, 1}, |A|=n=2. Количество сообщений длиной (объемом) 8 символов; Количество сообщений длиной (объемом) 16 символов; 27/87

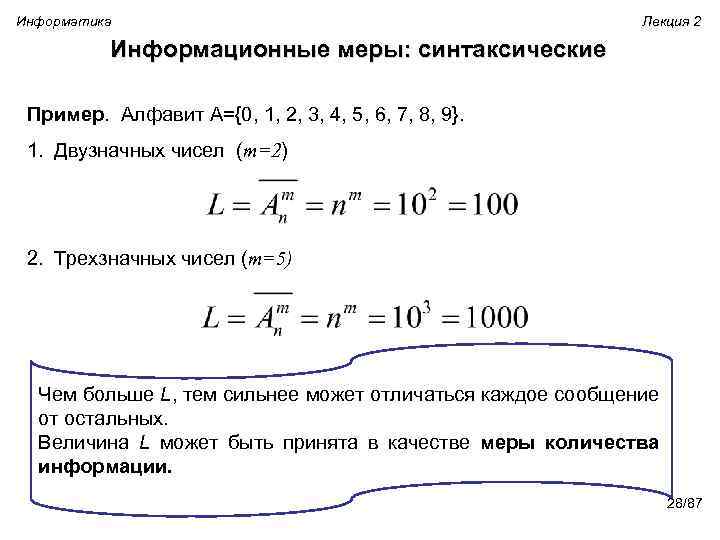

Информатика Лекция 2 Информационные меры: синтаксические Пример. Алфавит A={0, 1, 2, 3, 4, 5, 6, 7, 8, 9}. 1. Двузначных чисел (m=2) 2. Трехзначных чисел (m=5) Чем больше L, тем сильнее может отличаться каждое сообщение от остальных. Величина L может быть принята в качестве меры количества информации. 28/87

Информатика Лекция 2 Информационные меры: синтаксические Пример. Алфавит A={0, 1, 2, 3, 4, 5, 6, 7, 8, 9}. 1. Двузначных чисел (m=2) 2. Трехзначных чисел (m=5) Чем больше L, тем сильнее может отличаться каждое сообщение от остальных. Величина L может быть принята в качестве меры количества информации. 28/87

Информатика Лекция 2 Информационные меры: синтаксические Комбинаторная мера является развитием геометрической меры, так как помимо длины сообщения учитывает объем исходного алфавита и правила, по которым из его символов строятся сообщения. Особенностью комбинаторной меры является то, что ею измеряется информация не конкретного сообщения, а всего множества сообщений, которые могут быть получены. 29/87

Информатика Лекция 2 Информационные меры: синтаксические Комбинаторная мера является развитием геометрической меры, так как помимо длины сообщения учитывает объем исходного алфавита и правила, по которым из его символов строятся сообщения. Особенностью комбинаторной меры является то, что ею измеряется информация не конкретного сообщения, а всего множества сообщений, которые могут быть получены. 29/87

Информатика Лекция 2 Информационные меры: синтаксические Комбинаторная мера. Зависимость количества информации L от длины сообщения нелинейна, т. к. число размещений из n элементов по m является степенью. . При L =1 информация равна нулю, поскольку заранее известен характер сообщения (т. е. сообщение есть, а информация равна нулю); 30/87

Информатика Лекция 2 Информационные меры: синтаксические Комбинаторная мера. Зависимость количества информации L от длины сообщения нелинейна, т. к. число размещений из n элементов по m является степенью. . При L =1 информация равна нулю, поскольку заранее известен характер сообщения (т. е. сообщение есть, а информация равна нулю); 30/87

Информатика Лекция 2 Информационные меры: синтаксические Комбинаторная мера. Не выполняется условие линейного сложения количества информации, т. е. условие аддитивности Если, например, первый источник характеризуется L 1 различными сообщениями, а второй – L 2, то общее число различных сообщений для двух источников определяется произведением L=L 1 L 2 Для k источников общее число возможных различных сообщений равно L=L 1 L 2 … Lk 31/87

Информатика Лекция 2 Информационные меры: синтаксические Комбинаторная мера. Не выполняется условие линейного сложения количества информации, т. е. условие аддитивности Если, например, первый источник характеризуется L 1 различными сообщениями, а второй – L 2, то общее число различных сообщений для двух источников определяется произведением L=L 1 L 2 Для k источников общее число возможных различных сообщений равно L=L 1 L 2 … Lk 31/87

Информатика Лекция 2 Информационные меры: синтаксические Мера Хартли(аддитивная мера) Ральф Винтон Лайон Хартли (англ. Ralph Vinton Lyon Hartley, родился 30 ноября 1888 в Ели, штате Невада, умер 1 мая 1970). Американский учёный-электронщик. Он предложил генератор Хартли, преобразование Хартли и сделал вклад в теорию информации, введя в 1928 логарифмическую меру информации, которая называется информации. хартлиевским количеством 32/87

Информатика Лекция 2 Информационные меры: синтаксические Мера Хартли(аддитивная мера) Ральф Винтон Лайон Хартли (англ. Ralph Vinton Lyon Hartley, родился 30 ноября 1888 в Ели, штате Невада, умер 1 мая 1970). Американский учёный-электронщик. Он предложил генератор Хартли, преобразование Хартли и сделал вклад в теорию информации, введя в 1928 логарифмическую меру информации, которая называется информации. хартлиевским количеством 32/87

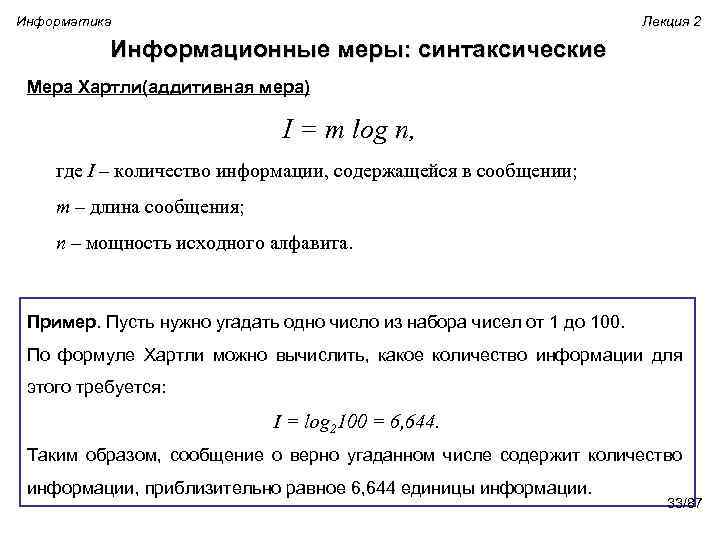

Информатика Лекция 2 Информационные меры: синтаксические Мера Хартли(аддитивная мера) I = m log n, где I – количество информации, содержащейся в сообщении; m – длина сообщения; n – мощность исходного алфавита. Пример. Пусть нужно угадать одно число из набора чисел от 1 до 100. По формуле Хартли можно вычислить, какое количество информации для этого требуется: I = log 2100 = 6, 644. Таким образом, сообщение о верно угаданном числе содержит количество информации, приблизительно равное 6, 644 единицы информации. 33/87

Информатика Лекция 2 Информационные меры: синтаксические Мера Хартли(аддитивная мера) I = m log n, где I – количество информации, содержащейся в сообщении; m – длина сообщения; n – мощность исходного алфавита. Пример. Пусть нужно угадать одно число из набора чисел от 1 до 100. По формуле Хартли можно вычислить, какое количество информации для этого требуется: I = log 2100 = 6, 644. Таким образом, сообщение о верно угаданном числе содержит количество информации, приблизительно равное 6, 644 единицы информации. 33/87

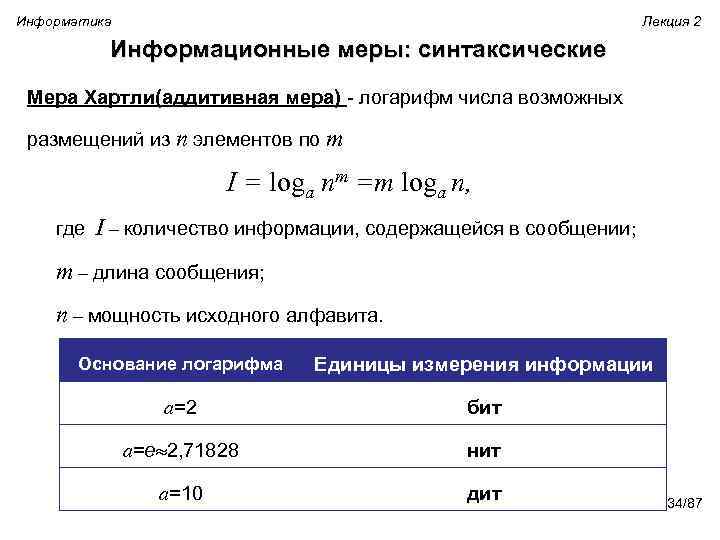

Информатика Лекция 2 Информационные меры: синтаксические Мера Хартли(аддитивная мера) - логарифм числа возможных размещений из n элементов по m I = loga nm =m loga n, где I – количество информации, содержащейся в сообщении; m – длина сообщения; n – мощность исходного алфавита. Основание логарифма Единицы измерения информации a=2 бит a=e 2, 71828 нит a=10 дит 34/87

Информатика Лекция 2 Информационные меры: синтаксические Мера Хартли(аддитивная мера) - логарифм числа возможных размещений из n элементов по m I = loga nm =m loga n, где I – количество информации, содержащейся в сообщении; m – длина сообщения; n – мощность исходного алфавита. Основание логарифма Единицы измерения информации a=2 бит a=e 2, 71828 нит a=10 дит 34/87

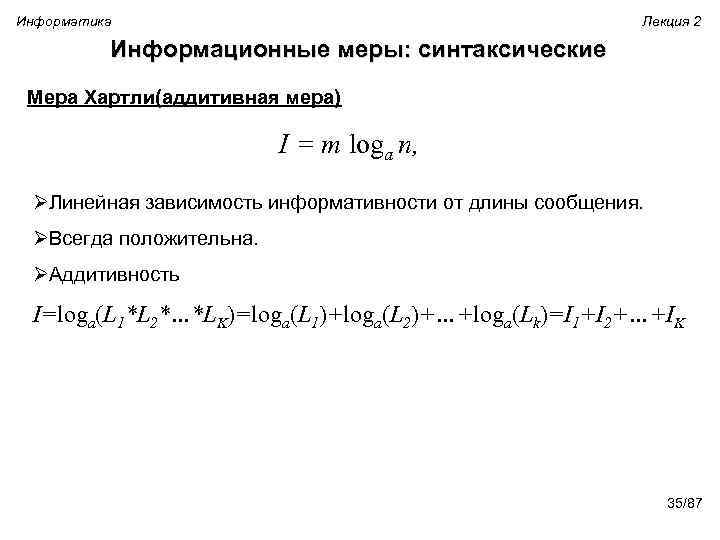

Информатика Лекция 2 Информационные меры: синтаксические Мера Хартли(аддитивная мера) I = m loga n, ØЛинейная зависимость информативности от длины сообщения. ØВсегда положительна. ØАддитивность I=loga(L 1*L 2*…*LK)=loga(L 1)+loga(L 2)+…+loga(Lk)=I 1+I 2+…+IK 35/87

Информатика Лекция 2 Информационные меры: синтаксические Мера Хартли(аддитивная мера) I = m loga n, ØЛинейная зависимость информативности от длины сообщения. ØВсегда положительна. ØАддитивность I=loga(L 1*L 2*…*LK)=loga(L 1)+loga(L 2)+…+loga(Lk)=I 1+I 2+…+IK 35/87

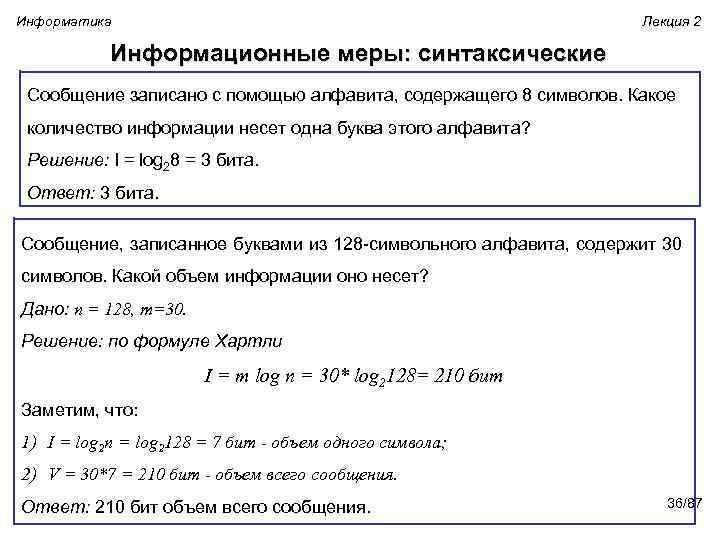

Информатика Лекция 2 Информационные меры: синтаксические Сообщение записано с помощью алфавита, содержащего 8 символов. Какое количество информации несет одна буква этого алфавита? Решение: I = log 28 = 3 бита. Ответ: 3 бита. Сообщение, записанное буквами из 128 -символьного алфавита, содержит 30 символов. Какой объем информации оно несет? Дано: n = 128, m=30. Решение: по формуле Хартли I = m log n = 30* log 2128= 210 бит Заметим, что: 1) I = log 2 n = log 2128 = 7 бит - объем одного символа; 2) V = 30*7 = 210 бит - объем всего сообщения. Ответ: 210 бит объем всего сообщения. 36/87

Информатика Лекция 2 Информационные меры: синтаксические Сообщение записано с помощью алфавита, содержащего 8 символов. Какое количество информации несет одна буква этого алфавита? Решение: I = log 28 = 3 бита. Ответ: 3 бита. Сообщение, записанное буквами из 128 -символьного алфавита, содержит 30 символов. Какой объем информации оно несет? Дано: n = 128, m=30. Решение: по формуле Хартли I = m log n = 30* log 2128= 210 бит Заметим, что: 1) I = log 2 n = log 2128 = 7 бит - объем одного символа; 2) V = 30*7 = 210 бит - объем всего сообщения. Ответ: 210 бит объем всего сообщения. 36/87

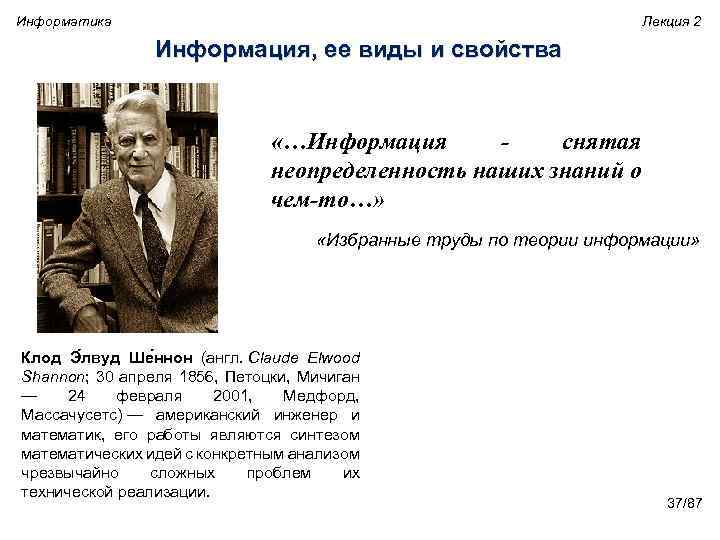

Информатика Лекция 2 Информация, ее виды и свойства «…Информация снятая неопределенность наших знаний о чем-то…» «Избранные труды по теории информации» Клод Э лвуд Ше ннон (англ. Claude Elwood Shannon; 30 апреля 1856, Петоцки, Мичиган — 24 февраля 2001, Медфорд, Массачусетс) — американский инженер и математик, его работы являются синтезом математических идей с конкретным анализом чрезвычайно сложных проблем их технической реализации. 37/87

Информатика Лекция 2 Информация, ее виды и свойства «…Информация снятая неопределенность наших знаний о чем-то…» «Избранные труды по теории информации» Клод Э лвуд Ше ннон (англ. Claude Elwood Shannon; 30 апреля 1856, Петоцки, Мичиган — 24 февраля 2001, Медфорд, Массачусетс) — американский инженер и математик, его работы являются синтезом математических идей с конкретным анализом чрезвычайно сложных проблем их технической реализации. 37/87

Информатика Лекция 2 Информационные меры: синтаксические Статистическая мера информации. Количество информации – мера уменьшения неопределенности. Получение информации (ее увеличение) одновременно означает увеличения знания, что, в свою очередь означает уменьшение незнания или информационной неопределенности. 38/87

Информатика Лекция 2 Информационные меры: синтаксические Статистическая мера информации. Количество информации – мера уменьшения неопределенности. Получение информации (ее увеличение) одновременно означает увеличения знания, что, в свою очередь означает уменьшение незнания или информационной неопределенности. 38/87

Информатика Лекция 2 Информационные меры: синтаксические Первичным и неделимым элементом информации следует считать двоичное событие: Øутверждение или отрицание, Øналичие или отсутствие, Øединица или нуль, Øимпульс или пауза. За единицу количества информации было предложено принять «количество информации, передаваемое при одном выборе между равновероятными альтернативами» . Эта наименьшая единица информации называется бит. 39/87

Информатика Лекция 2 Информационные меры: синтаксические Первичным и неделимым элементом информации следует считать двоичное событие: Øутверждение или отрицание, Øналичие или отсутствие, Øединица или нуль, Øимпульс или пауза. За единицу количества информации было предложено принять «количество информации, передаваемое при одном выборе между равновероятными альтернативами» . Эта наименьшая единица информации называется бит. 39/87

Информатика Лекция 2 Информационные меры: синтаксические Возможные события Произошедшее событие Сообщение, уменьшающее неопределённость знания в два раза, несёт 1 бит информации. 40/87

Информатика Лекция 2 Информационные меры: синтаксические Возможные события Произошедшее событие Сообщение, уменьшающее неопределённость знания в два раза, несёт 1 бит информации. 40/87

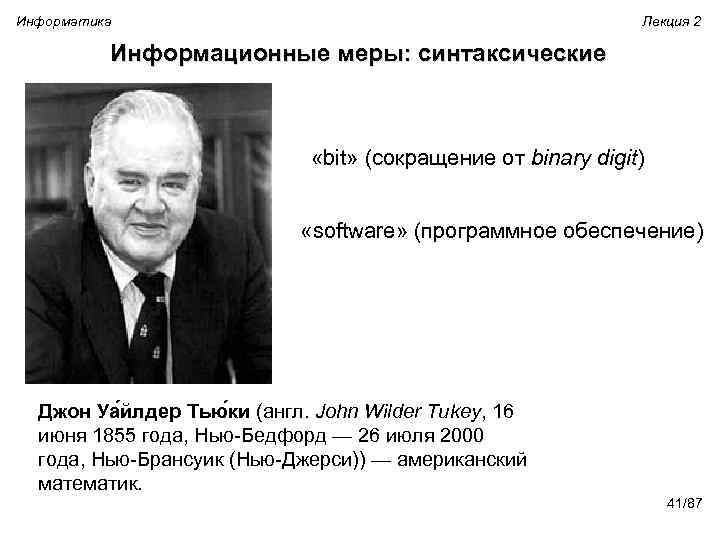

Информатика Лекция 2 Информационные меры: синтаксические «bit» (сокращение от binary digit) «software» (программное обеспечение) Джон Уа йлдер Тью ки (англ. John Wilder Tukey, 16 июня 1855 года, Нью-Бедфорд — 26 июля 2000 года, Нью-Брансуик (Нью-Джерси)) — американский математик. 41/87

Информатика Лекция 2 Информационные меры: синтаксические «bit» (сокращение от binary digit) «software» (программное обеспечение) Джон Уа йлдер Тью ки (англ. John Wilder Tukey, 16 июня 1855 года, Нью-Бедфорд — 26 июля 2000 года, Нью-Брансуик (Нью-Джерси)) — американский математик. 41/87

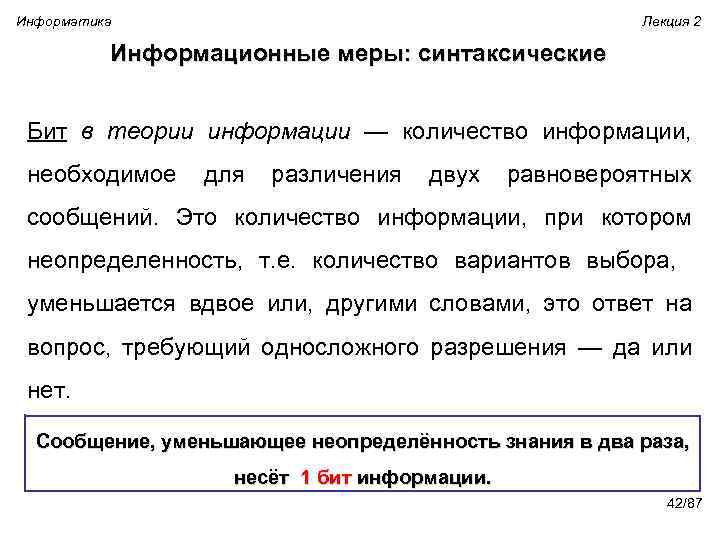

Информатика Лекция 2 Информационные меры: синтаксические Бит в теории информации — количество информации, необходимое для различения двух равновероятных сообщений. Это количество информации, при котором неопределенность, т. е. количество вариантов выбора, уменьшается вдвое или, другими словами, это ответ на вопрос, требующий односложного разрешения — да или нет. Сообщение, уменьшающее неопределённость знания в два раза, несёт 1 бит информации. 42/87

Информатика Лекция 2 Информационные меры: синтаксические Бит в теории информации — количество информации, необходимое для различения двух равновероятных сообщений. Это количество информации, при котором неопределенность, т. е. количество вариантов выбора, уменьшается вдвое или, другими словами, это ответ на вопрос, требующий односложного разрешения — да или нет. Сообщение, уменьшающее неопределённость знания в два раза, несёт 1 бит информации. 42/87

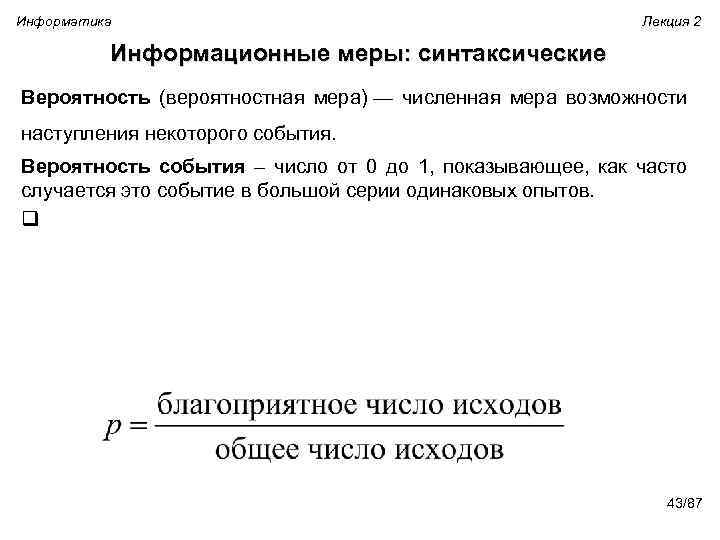

Информатика Лекция 2 Информационные меры: синтаксические Вероятность (вероятностная мера) — численная мера возможности наступления некоторого события. Вероятность события – число от 0 до 1, показывающее, как часто случается это событие в большой серии одинаковых опытов. q 43/87

Информатика Лекция 2 Информационные меры: синтаксические Вероятность (вероятностная мера) — численная мера возможности наступления некоторого события. Вероятность события – число от 0 до 1, показывающее, как часто случается это событие в большой серии одинаковых опытов. q 43/87

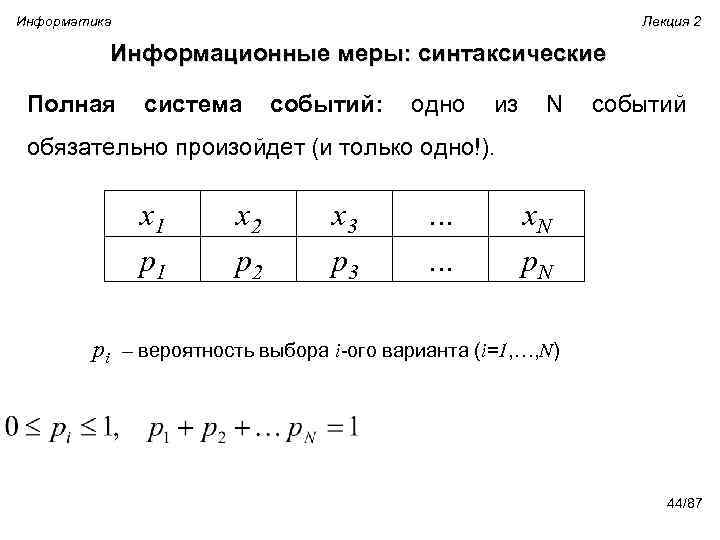

Информатика Лекция 2 Информационные меры: синтаксические Полная система событий: одно из N событий обязательно произойдет (и только одно!). x 1 p 1 x 2 p 2 x 3 p 3 … … x. N pi – вероятность выбора i-ого варианта (i=1, …, N) 44/87

Информатика Лекция 2 Информационные меры: синтаксические Полная система событий: одно из N событий обязательно произойдет (и только одно!). x 1 p 1 x 2 p 2 x 3 p 3 … … x. N pi – вероятность выбора i-ого варианта (i=1, …, N) 44/87

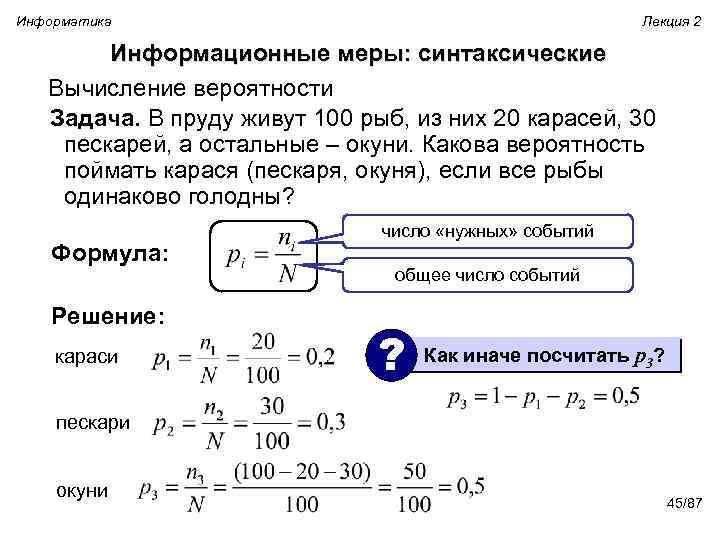

Информатика Лекция 2 Информационные меры: синтаксические Вычисление вероятности Задача. В пруду живут 100 рыб, из них 20 карасей, 30 пескарей, а остальные – окуни. Какова вероятность поймать карася (пескаря, окуня), если все рыбы одинаково голодны? Формула: Решение: караси число «нужных» событий общее число событий ? Как иначе посчитать p 3? пескари окуни 45/87

Информатика Лекция 2 Информационные меры: синтаксические Вычисление вероятности Задача. В пруду живут 100 рыб, из них 20 карасей, 30 пескарей, а остальные – окуни. Какова вероятность поймать карася (пескаря, окуня), если все рыбы одинаково голодны? Формула: Решение: караси число «нужных» событий общее число событий ? Как иначе посчитать p 3? пескари окуни 45/87

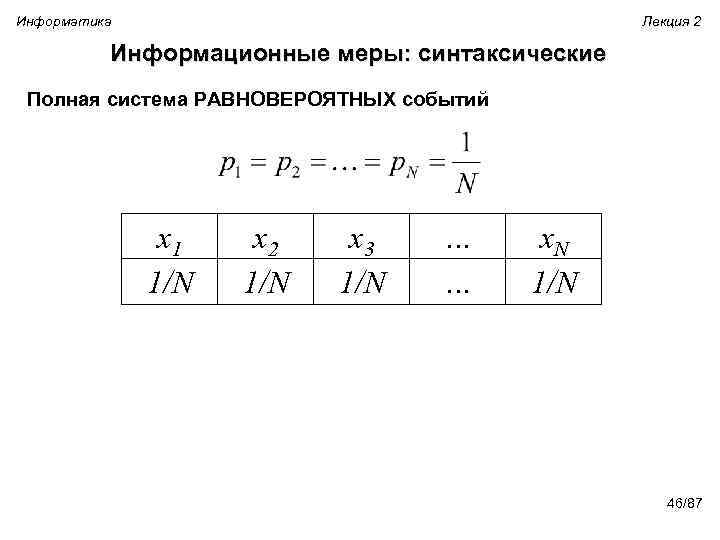

Информатика Лекция 2 Информационные меры: синтаксические Полная система РАВНОВЕРОЯТНЫХ событий x 1 1/N x 2 1/N x 3 1/N … … x. N 1/N 46/87

Информатика Лекция 2 Информационные меры: синтаксические Полная система РАВНОВЕРОЯТНЫХ событий x 1 1/N x 2 1/N x 3 1/N … … x. N 1/N 46/87

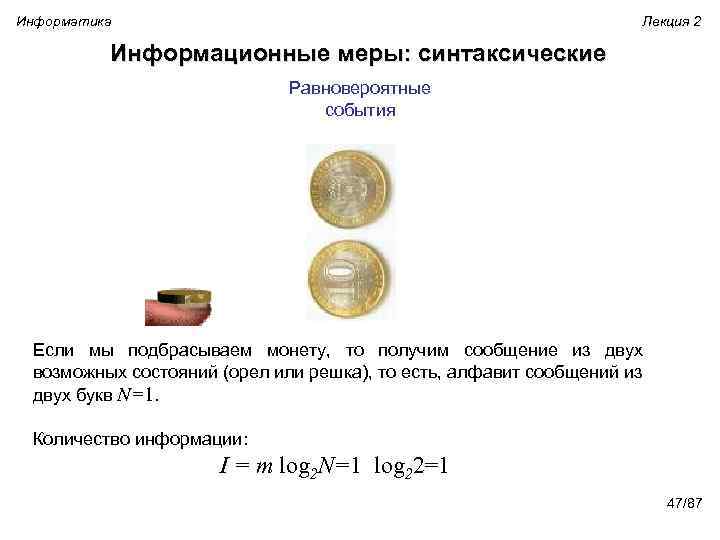

Информатика Лекция 2 Информационные меры: синтаксические Равновероятные события Если мы подбрасываем монету, то получим сообщение из двух возможных состояний (орел или решка), то есть, алфавит сообщений из двух букв N=1. Количество информации: I = m log 2 N=1 log 22=1 47/87

Информатика Лекция 2 Информационные меры: синтаксические Равновероятные события Если мы подбрасываем монету, то получим сообщение из двух возможных состояний (орел или решка), то есть, алфавит сообщений из двух букв N=1. Количество информации: I = m log 2 N=1 log 22=1 47/87

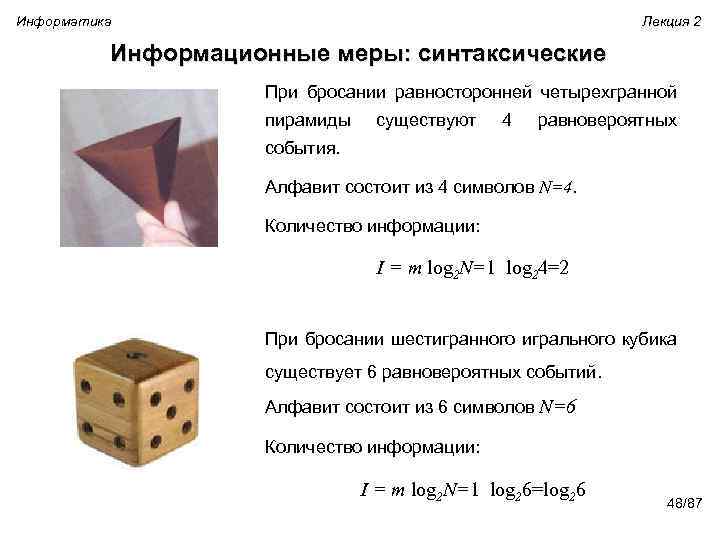

Информатика Лекция 2 Информационные меры: синтаксические При бросании равносторонней четырехгранной пирамиды существуют 4 равновероятных события. Алфавит состоит из 4 символов N=4. Количество информации: I = m log 2 N=1 log 24=2 При бросании шестигранного игрального кубика существует 6 равновероятных событий. Алфавит состоит из 6 символов N=6 Количество информации: I = m log 2 N=1 log 26=log 26 48/87

Информатика Лекция 2 Информационные меры: синтаксические При бросании равносторонней четырехгранной пирамиды существуют 4 равновероятных события. Алфавит состоит из 4 символов N=4. Количество информации: I = m log 2 N=1 log 24=2 При бросании шестигранного игрального кубика существует 6 равновероятных событий. Алфавит состоит из 6 символов N=6 Количество информации: I = m log 2 N=1 log 26=log 26 48/87

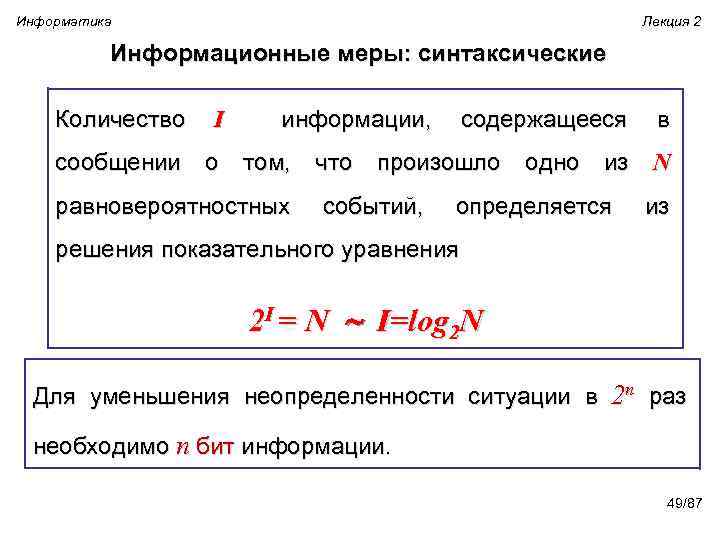

Информатика Лекция 2 Информационные меры: синтаксические Количество I информации, содержащееся в сообщении о том, что произошло одно из N равновероятностных событий, определяется из решения показательного уравнения 2 I = N I=log 2 N Для уменьшения неопределенности ситуации в 2 n раз необходимо n бит информации. 49/87

Информатика Лекция 2 Информационные меры: синтаксические Количество I информации, содержащееся в сообщении о том, что произошло одно из N равновероятностных событий, определяется из решения показательного уравнения 2 I = N I=log 2 N Для уменьшения неопределенности ситуации в 2 n раз необходимо n бит информации. 49/87

Информатика Лекция 2 Информационные меры: синтаксические ØЕсли известно количество информации I, то количество возможных событий N легко определить. Например, если I = 5, то N = 2 I = 32. ØЕсли известно количество возможных событий N, то для определения количества информации нужно решить показательное уравнение относительно I. Например, в соревнованиях участвуют 4 команды. Сообщение о том, что победила 3 команда уменьшает первоначальную неопределенность в 4 раза, (4=22) и несет 2 бита информации. Или имеется 4 равновероятных исхода N=4, N = 2 I =4=22 , то I = 2. 50/87

Информатика Лекция 2 Информационные меры: синтаксические ØЕсли известно количество информации I, то количество возможных событий N легко определить. Например, если I = 5, то N = 2 I = 32. ØЕсли известно количество возможных событий N, то для определения количества информации нужно решить показательное уравнение относительно I. Например, в соревнованиях участвуют 4 команды. Сообщение о том, что победила 3 команда уменьшает первоначальную неопределенность в 4 раза, (4=22) и несет 2 бита информации. Или имеется 4 равновероятных исхода N=4, N = 2 I =4=22 , то I = 2. 50/87

Информатика Лекция 2 Информационные меры: синтаксические Задача. В рулетке общее количество лунок равно 128. Какое количество информации мы получим в зрительном сообщении об остановке шарика в одной из лунок. Дано: N = 128 i-? Решение: 2 i = N 2 i = 128 27 = 128 i = 7 бит Ответ: i = 7 бит 51/87

Информатика Лекция 2 Информационные меры: синтаксические Задача. В рулетке общее количество лунок равно 128. Какое количество информации мы получим в зрительном сообщении об остановке шарика в одной из лунок. Дано: N = 128 i-? Решение: 2 i = N 2 i = 128 27 = 128 i = 7 бит Ответ: i = 7 бит 51/87

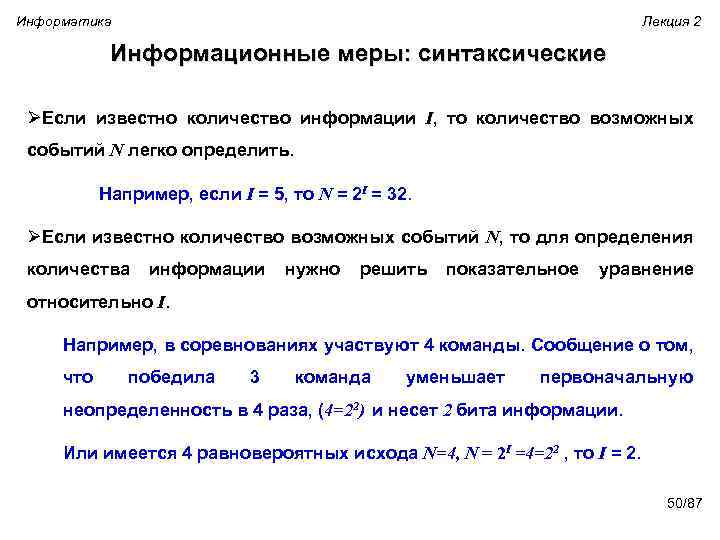

Информатика Лекция 2 Метод двоичного поиска Вопрос второго Кол-во возможных Ответ событий первого (неопределенность знаний) Полученное количество Информации 32 Число больше 16? Да 16 1 бит Число больше 24? Да 8 1 бит Число больше 28? Да 4 1 бит Число больше 30? Нет 2 1 бит Число 30? Да 1 1 бит Для того чтобы угадать число из интервала от 1 до 32 потребовалось 5 вопросов. Количество информации, необходимое для определения одного из 32 чисел, составило 5 бит. 52/87

Информатика Лекция 2 Метод двоичного поиска Вопрос второго Кол-во возможных Ответ событий первого (неопределенность знаний) Полученное количество Информации 32 Число больше 16? Да 16 1 бит Число больше 24? Да 8 1 бит Число больше 28? Да 4 1 бит Число больше 30? Нет 2 1 бит Число 30? Да 1 1 бит Для того чтобы угадать число из интервала от 1 до 32 потребовалось 5 вопросов. Количество информации, необходимое для определения одного из 32 чисел, составило 5 бит. 52/87

Информатика Лекция 2 Информационные меры: синтаксические Количество вариантов 2 4 8 16 Количество бит информации 1 2 3 4 32 64 5 6 128 256 512 1024 7 8 9 10 6 вариантов – между 4 (2 бита) и 8 (3 бита) Ответ: количество информации между 2 и 3 битами 53/87

Информатика Лекция 2 Информационные меры: синтаксические Количество вариантов 2 4 8 16 Количество бит информации 1 2 3 4 32 64 5 6 128 256 512 1024 7 8 9 10 6 вариантов – между 4 (2 бита) и 8 (3 бита) Ответ: количество информации между 2 и 3 битами 53/87

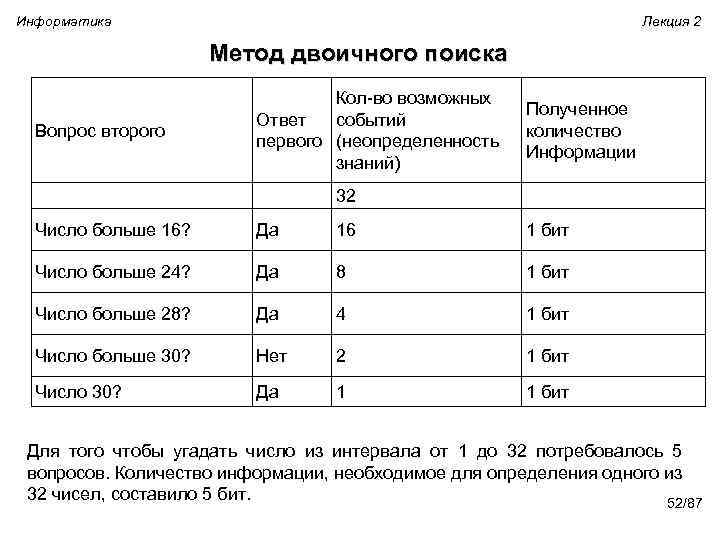

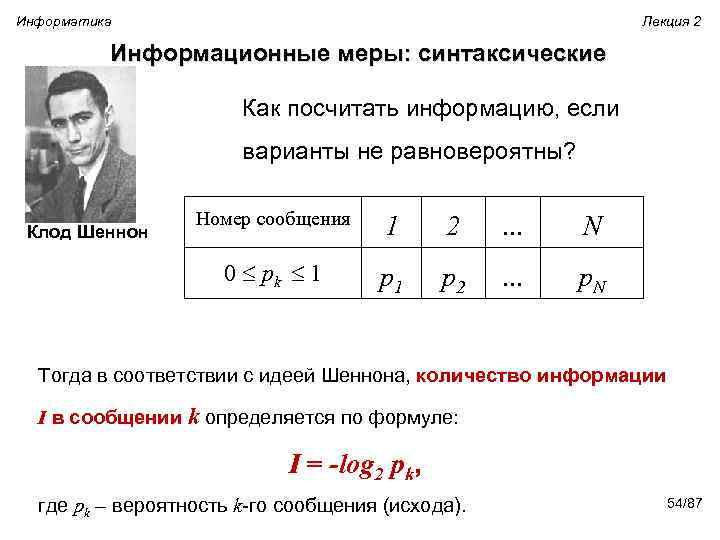

Информатика Лекция 2 Информационные меры: синтаксические Как посчитать информацию, если варианты не равновероятны? Номер сообщения 1 2 … N 0 pk 1 Клод Шеннон p 1 p 2 … p. N Тогда в соответствии с идеей Шеннона, количество информации I в сообщении k определяется по формуле: I = -log 2 pk, где pk – вероятность k-го сообщения (исхода). 54/87

Информатика Лекция 2 Информационные меры: синтаксические Как посчитать информацию, если варианты не равновероятны? Номер сообщения 1 2 … N 0 pk 1 Клод Шеннон p 1 p 2 … p. N Тогда в соответствии с идеей Шеннона, количество информации I в сообщении k определяется по формуле: I = -log 2 pk, где pk – вероятность k-го сообщения (исхода). 54/87

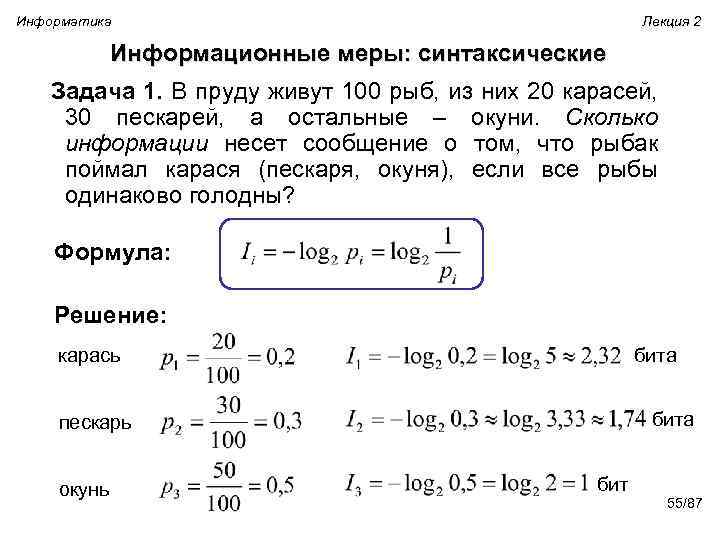

Информатика Лекция 2 Информационные меры: синтаксические Задача 1. В пруду живут 100 рыб, из них 20 карасей, 30 пескарей, а остальные – окуни. Сколько информации несет сообщение о том, что рыбак поймал карася (пескаря, окуня), если все рыбы одинаково голодны? Формула: Решение: бита карась бита пескарь окунь бит 55/87

Информатика Лекция 2 Информационные меры: синтаксические Задача 1. В пруду живут 100 рыб, из них 20 карасей, 30 пескарей, а остальные – окуни. Сколько информации несет сообщение о том, что рыбак поймал карася (пескаря, окуня), если все рыбы одинаково голодны? Формула: Решение: бита карась бита пескарь окунь бит 55/87

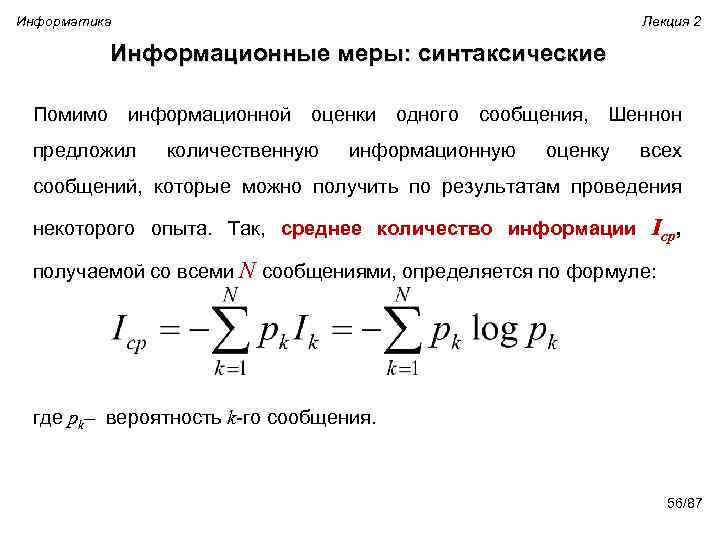

Информатика Лекция 2 Информационные меры: синтаксические Помимо информационной оценки одного сообщения, Шеннон предложил количественную информационную оценку всех сообщений, которые можно получить по результатам проведения некоторого опыта. Так, среднее количество информации Iср, получаемой со всеми N сообщениями, определяется по формуле: где pk– вероятность k-го сообщения. 56/87

Информатика Лекция 2 Информационные меры: синтаксические Помимо информационной оценки одного сообщения, Шеннон предложил количественную информационную оценку всех сообщений, которые можно получить по результатам проведения некоторого опыта. Так, среднее количество информации Iср, получаемой со всеми N сообщениями, определяется по формуле: где pk– вероятность k-го сообщения. 56/87

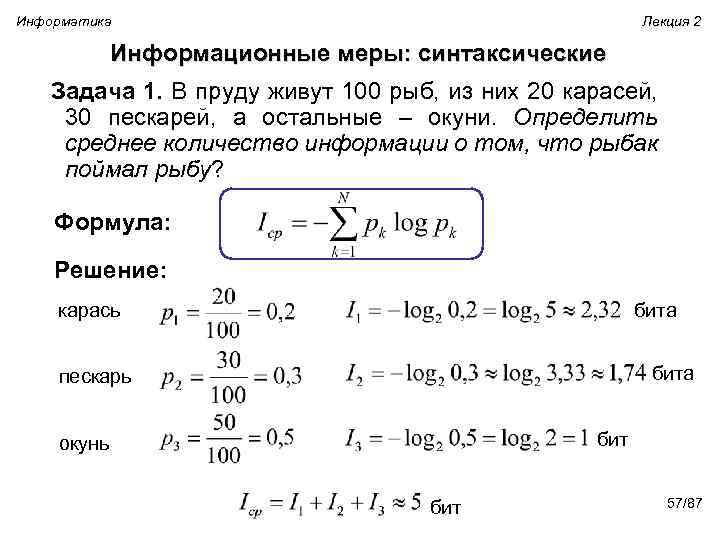

Информатика Лекция 2 Информационные меры: синтаксические Задача 1. В пруду живут 100 рыб, из них 20 карасей, 30 пескарей, а остальные – окуни. Определить среднее количество информации о том, что рыбак поймал рыбу? Формула: Решение: бита карась бита пескарь бит окунь бит 57/87

Информатика Лекция 2 Информационные меры: синтаксические Задача 1. В пруду живут 100 рыб, из них 20 карасей, 30 пескарей, а остальные – окуни. Определить среднее количество информации о том, что рыбак поймал рыбу? Формула: Решение: бита карась бита пескарь бит окунь бит 57/87

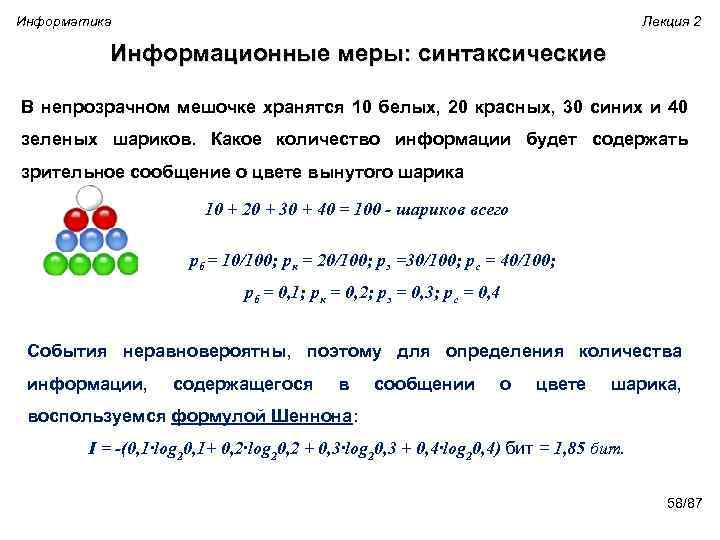

Информатика Лекция 2 Информационные меры: синтаксические В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика 10 + 20 + 30 + 40 = 100 - шариков всего pб = 10/100; pк = 20/100; pз =30/100; pс = 40/100; pб = 0, 1; pк = 0, 2; pз = 0, 3; pс = 0, 4 События неравновероятны, поэтому для определения количества информации, содержащегося в сообщении о цвете шарика, воспользуемся формулой Шеннона: I = -(0, 1·log 20, 1+ 0, 2·log 20, 2 + 0, 3·log 20, 3 + 0, 4·log 20, 4) бит = 1, 85 бит. 58/87

Информатика Лекция 2 Информационные меры: синтаксические В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика 10 + 20 + 30 + 40 = 100 - шариков всего pб = 10/100; pк = 20/100; pз =30/100; pс = 40/100; pб = 0, 1; pк = 0, 2; pз = 0, 3; pс = 0, 4 События неравновероятны, поэтому для определения количества информации, содержащегося в сообщении о цвете шарика, воспользуемся формулой Шеннона: I = -(0, 1·log 20, 1+ 0, 2·log 20, 2 + 0, 3·log 20, 3 + 0, 4·log 20, 4) бит = 1, 85 бит. 58/87

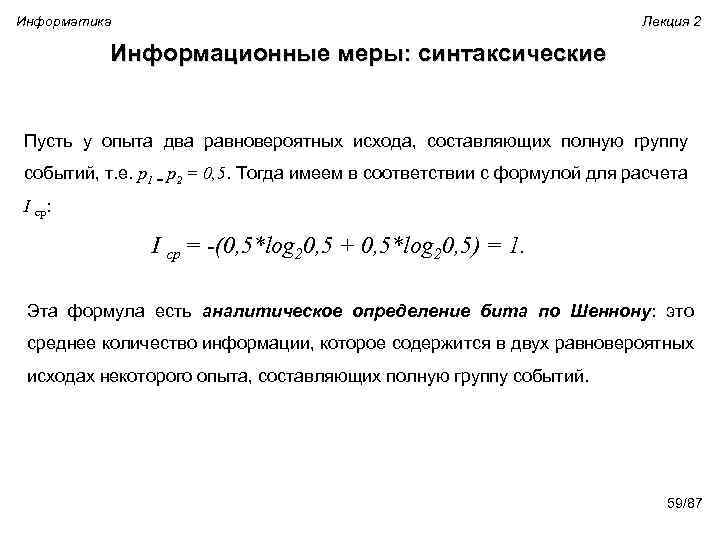

Информатика Лекция 2 Информационные меры: синтаксические Пусть у опыта два равновероятных исхода, составляющих полную группу событий, т. е. p 1 = p 2 = 0, 5. Тогда имеем в соответствии с формулой для расчета I ср: I ср = -(0, 5*log 20, 5 + 0, 5*log 20, 5) = 1. Эта формула есть аналитическое определение бита по Шеннону: это среднее количество информации, которое содержится в двух равновероятных исходах некоторого опыта, составляющих полную группу событий. 59/87

Информатика Лекция 2 Информационные меры: синтаксические Пусть у опыта два равновероятных исхода, составляющих полную группу событий, т. е. p 1 = p 2 = 0, 5. Тогда имеем в соответствии с формулой для расчета I ср: I ср = -(0, 5*log 20, 5 + 0, 5*log 20, 5) = 1. Эта формула есть аналитическое определение бита по Шеннону: это среднее количество информации, которое содержится в двух равновероятных исходах некоторого опыта, составляющих полную группу событий. 59/87

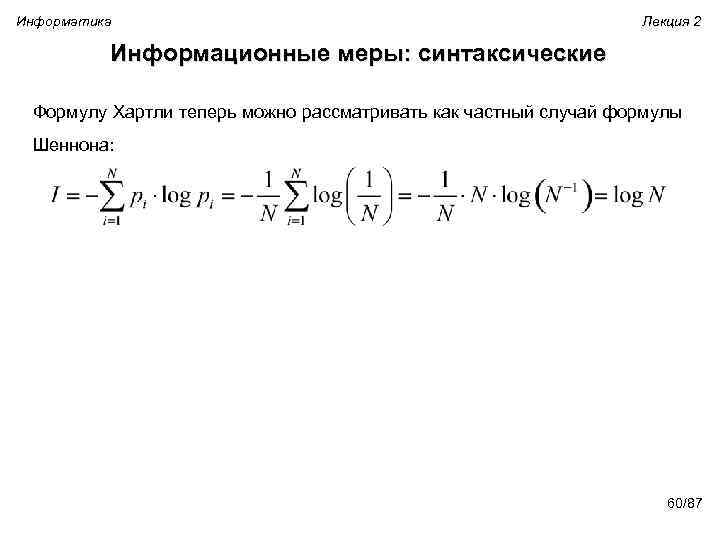

Информатика Лекция 2 Информационные меры: синтаксические Формулу Хартли теперь можно рассматривать как частный случай формулы Шеннона: 60/87

Информатика Лекция 2 Информационные меры: синтаксические Формулу Хартли теперь можно рассматривать как частный случай формулы Шеннона: 60/87

Информатика Лекция 2 Информационные меры: синтаксические незнание получение информации незнание Неопределенность – недостаток знаний (незнание). n при получении информации знания увеличиваются, неопределенность уменьшается n чем больше получено информации, тем больше уменьшается неопределенность n информация – мера уменьшения неопределенности ? Как измерить неопределенность? 61/87

Информатика Лекция 2 Информационные меры: синтаксические незнание получение информации незнание Неопределенность – недостаток знаний (незнание). n при получении информации знания увеличиваются, неопределенность уменьшается n чем больше получено информации, тем больше уменьшается неопределенность n информация – мера уменьшения неопределенности ? Как измерить неопределенность? 61/87

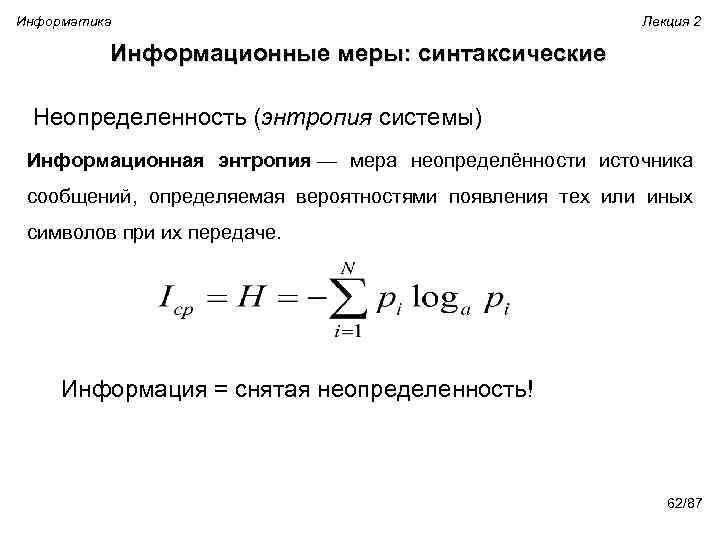

Информатика Лекция 2 Информационные меры: синтаксические Неопределенность (энтропия системы) Информационная энтропия — мера неопределённости источника сообщений, определяемая вероятностями появления тех или иных символов при их передаче. Информация = снятая неопределенность! 62/87

Информатика Лекция 2 Информационные меры: синтаксические Неопределенность (энтропия системы) Информационная энтропия — мера неопределённости источника сообщений, определяемая вероятностями появления тех или иных символов при их передаче. Информация = снятая неопределенность! 62/87

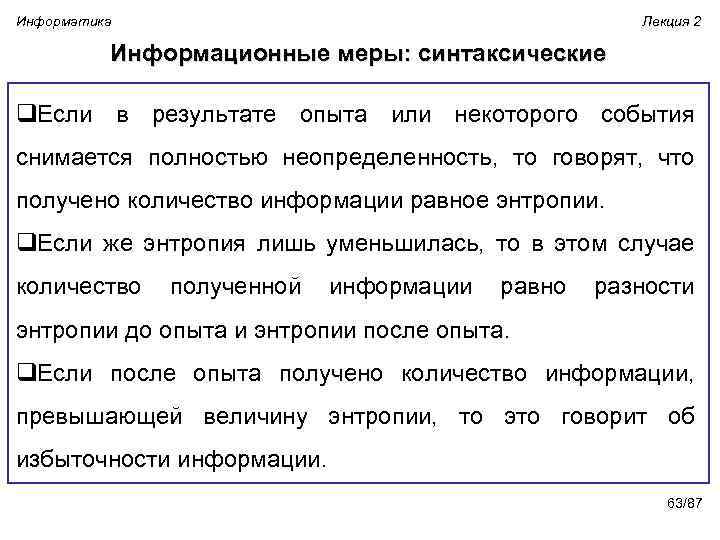

Информатика Лекция 2 Информационные меры: синтаксические q. Если в результате опыта или некоторого события снимается полностью неопределенность, то говорят, что получено количество информации равное энтропии. q. Если же энтропия лишь уменьшилась, то в этом случае количество полученной информации равно разности энтропии до опыта и энтропии после опыта. q. Если после опыта получено количество информации, превышающей величину энтропии, то это говорит об избыточности информации. 63/87

Информатика Лекция 2 Информационные меры: синтаксические q. Если в результате опыта или некоторого события снимается полностью неопределенность, то говорят, что получено количество информации равное энтропии. q. Если же энтропия лишь уменьшилась, то в этом случае количество полученной информации равно разности энтропии до опыта и энтропии после опыта. q. Если после опыта получено количество информации, превышающей величину энтропии, то это говорит об избыточности информации. 63/87

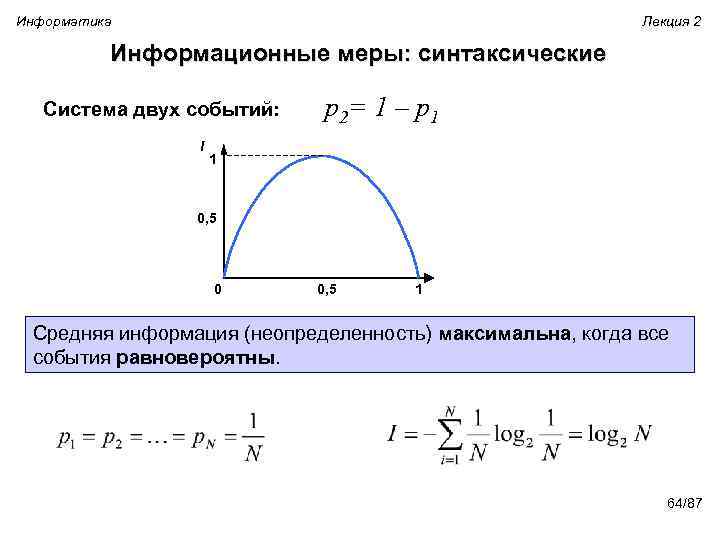

Информатика Лекция 2 Информационные меры: синтаксические Система двух событий: I p 2= 1 – p 1 1 0, 5 0 0, 5 1 Средняя информация (неопределенность) максимальна, когда все события равновероятны. 64/87

Информатика Лекция 2 Информационные меры: синтаксические Система двух событий: I p 2= 1 – p 1 1 0, 5 0 0, 5 1 Средняя информация (неопределенность) максимальна, когда все события равновероятны. 64/87

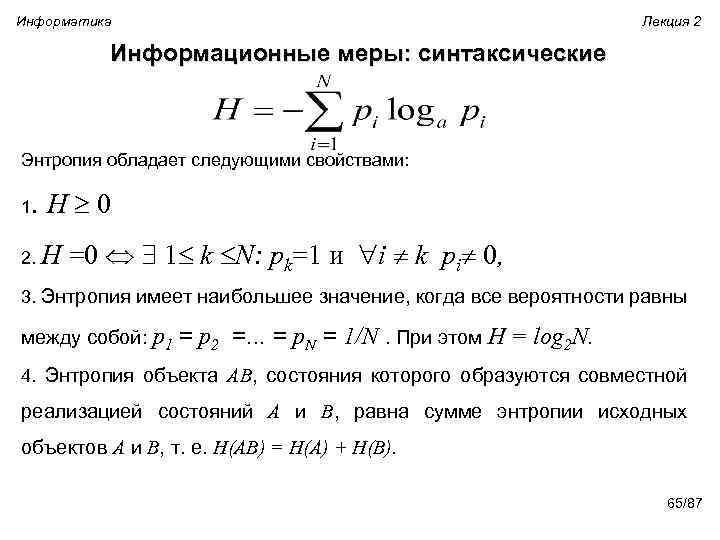

Информатика Лекция 2 Информационные меры: синтаксические Энтропия обладает следующими свойствами: 1. H 0 2. H =0 1 k N: pk=1 и i k pi 0, 3. Энтропия имеет наибольшее значение, когда все вероятности равны между собой: р1 = р2 =. . . = р. N = 1/N. При этом H = log 2 N. 4. Энтропия объекта АВ, состояния которого образуются совместной реализацией состояний А и В, равна сумме энтропии исходных объектов А и В, т. е. Н(АВ) = Н(А) + Н(В). 65/87

Информатика Лекция 2 Информационные меры: синтаксические Энтропия обладает следующими свойствами: 1. H 0 2. H =0 1 k N: pk=1 и i k pi 0, 3. Энтропия имеет наибольшее значение, когда все вероятности равны между собой: р1 = р2 =. . . = р. N = 1/N. При этом H = log 2 N. 4. Энтропия объекта АВ, состояния которого образуются совместной реализацией состояний А и В, равна сумме энтропии исходных объектов А и В, т. е. Н(АВ) = Н(А) + Н(В). 65/87

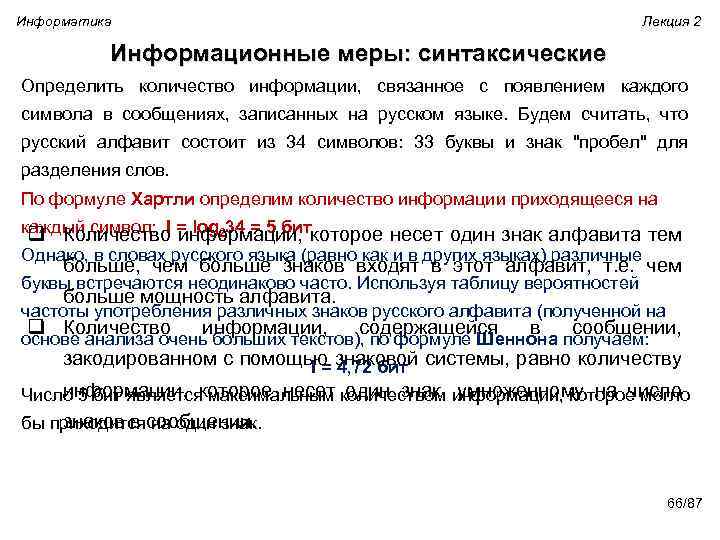

Информатика Лекция 2 Информационные меры: синтаксические Определить количество информации, связанное с появлением каждого символа в сообщениях, записанных на русском языке. Будем считать, что русский алфавит состоит из 34 символов: 33 буквы и знак "пробел" для разделения слов. По формуле Хартли определим количество информации приходящееся на каждый символ: I = log 234 = 5 бит q Количество информации, которое несет один знак алфавита тем Однако, в словах русского языка (равно как и в других языках) различные больше, чем больше знаков входят в этот алфавит, т. е. чем буквы встречаются неодинаково часто. Используя таблицу вероятностей больше мощность алфавита. частоты употребления различных знаков русского алфавита (полученной на q Количество информации, содержащейся в сообщении, основе анализа очень больших текстов), по формуле Шеннона получаем: закодированном с помощью знаковой системы, равно количеству I = 4, 72 бит информации, которое несет один знак, умноженному на число Число 5 бит является максимальным количеством информации, которое могло знаков в сообщении. бы приходится на один знак. 66/87

Информатика Лекция 2 Информационные меры: синтаксические Определить количество информации, связанное с появлением каждого символа в сообщениях, записанных на русском языке. Будем считать, что русский алфавит состоит из 34 символов: 33 буквы и знак "пробел" для разделения слов. По формуле Хартли определим количество информации приходящееся на каждый символ: I = log 234 = 5 бит q Количество информации, которое несет один знак алфавита тем Однако, в словах русского языка (равно как и в других языках) различные больше, чем больше знаков входят в этот алфавит, т. е. чем буквы встречаются неодинаково часто. Используя таблицу вероятностей больше мощность алфавита. частоты употребления различных знаков русского алфавита (полученной на q Количество информации, содержащейся в сообщении, основе анализа очень больших текстов), по формуле Шеннона получаем: закодированном с помощью знаковой системы, равно количеству I = 4, 72 бит информации, которое несет один знак, умноженному на число Число 5 бит является максимальным количеством информации, которое могло знаков в сообщении. бы приходится на один знак. 66/87

Информатика Лекция 2 Информационные меры: синтаксические Вася Пупкин сдал сессию со следующими оценками: 45535 Сколько информации получили в этом сообщении родители? Алфавитный подход: n возможны 4 разные оценки: 2, 3, 4 и 5 (мощность алфавита 4) n каждая оценка несет 2 бита информации (основание log равно 2) Ответ: 5· 2 бит = 10 бит ! Содержание информации не учитывается! 67/87

Информатика Лекция 2 Информационные меры: синтаксические Вася Пупкин сдал сессию со следующими оценками: 45535 Сколько информации получили в этом сообщении родители? Алфавитный подход: n возможны 4 разные оценки: 2, 3, 4 и 5 (мощность алфавита 4) n каждая оценка несет 2 бита информации (основание log равно 2) Ответ: 5· 2 бит = 10 бит ! Содержание информации не учитывается! 67/87

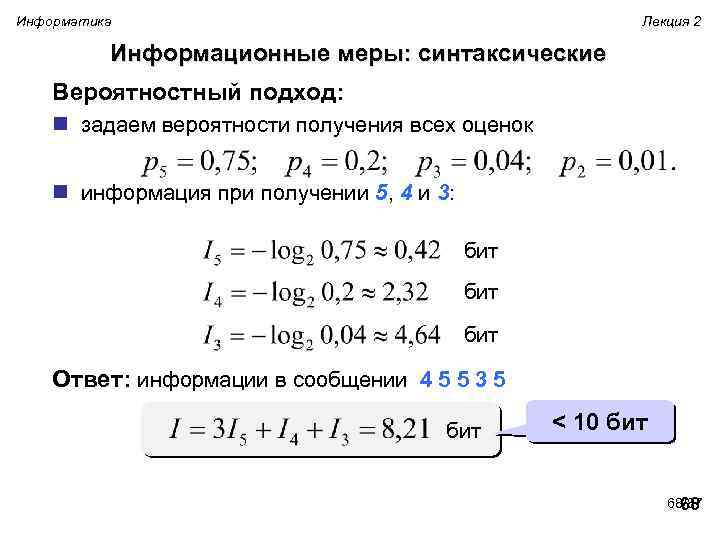

Информатика Лекция 2 Информационные меры: синтаксические Вероятностный подход: n задаем вероятности получения всех оценок n информация при получении 5, 4 и 3: бит бит Ответ: информации в сообщении 4 5 5 3 5 бит < 10 бит 68/87 68

Информатика Лекция 2 Информационные меры: синтаксические Вероятностный подход: n задаем вероятности получения всех оценок n информация при получении 5, 4 и 3: бит бит Ответ: информации в сообщении 4 5 5 3 5 бит < 10 бит 68/87 68

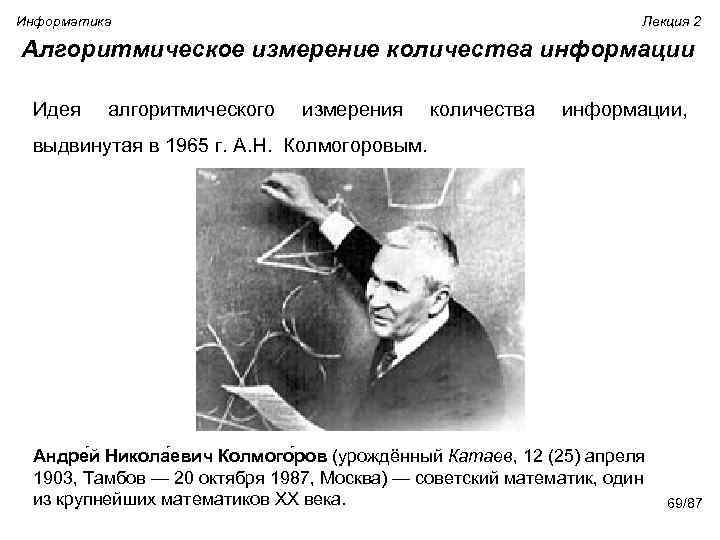

Информатика Лекция 2 Алгоритмическое измерение количества информации Идея алгоритмического измерения количества информации, выдвинутая в 1965 г. А. Н. Колмогоровым. Андре й Никола евич Колмого ров (урождённый Катаев, 12 (25) апреля 1903, Тамбов — 20 октября 1987, Москва) — советский математик, один из крупнейших математиков ХХ века. 69/87

Информатика Лекция 2 Алгоритмическое измерение количества информации Идея алгоритмического измерения количества информации, выдвинутая в 1965 г. А. Н. Колмогоровым. Андре й Никола евич Колмого ров (урождённый Катаев, 12 (25) апреля 1903, Тамбов — 20 октября 1987, Москва) — советский математик, один из крупнейших математиков ХХ века. 69/87

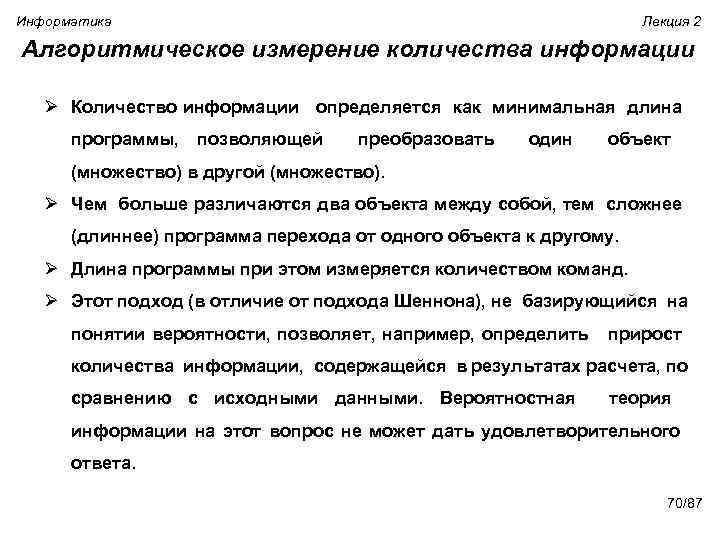

Информатика Лекция 2 Алгоритмическое измерение количества информации Ø Количество информации определяется как минимальная длина программы, позволяющей преобразовать один объект (множество) в другой (множество). Ø Чем больше различаются два объекта между собой, тем сложнее (длиннее) программа перехода от одного объекта к другому. Ø Длина программы при этом измеряется количеством команд. Ø Этот подход (в отличие от подхода Шеннона), не базирующийся на понятии вероятности, позволяет, например, определить прирост количества информации, содержащейся в результатах расчета, по сравнению с исходными данными. Вероятностная теория информации на этот вопрос не может дать удовлетворительного ответа. 70/87

Информатика Лекция 2 Алгоритмическое измерение количества информации Ø Количество информации определяется как минимальная длина программы, позволяющей преобразовать один объект (множество) в другой (множество). Ø Чем больше различаются два объекта между собой, тем сложнее (длиннее) программа перехода от одного объекта к другому. Ø Длина программы при этом измеряется количеством команд. Ø Этот подход (в отличие от подхода Шеннона), не базирующийся на понятии вероятности, позволяет, например, определить прирост количества информации, содержащейся в результатах расчета, по сравнению с исходными данными. Вероятностная теория информации на этот вопрос не может дать удовлетворительного ответа. 70/87

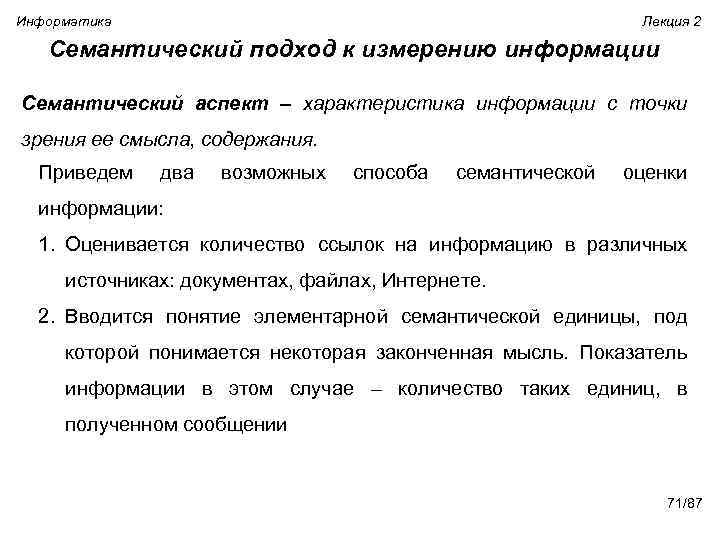

Информатика Лекция 2 Семантический подход к измерению информации Семантический аспект – характеристика информации с точки зрения ее смысла, содержания. Приведем два возможных способа семантической оценки информации: 1. Оценивается количество ссылок на информацию в различных источниках: документах, файлах, Интернете. 2. Вводится понятие элементарной семантической единицы, под которой понимается некоторая законченная мысль. Показатель информации в этом случае – количество таких единиц, в полученном сообщении 71/87

Информатика Лекция 2 Семантический подход к измерению информации Семантический аспект – характеристика информации с точки зрения ее смысла, содержания. Приведем два возможных способа семантической оценки информации: 1. Оценивается количество ссылок на информацию в различных источниках: документах, файлах, Интернете. 2. Вводится понятие элементарной семантической единицы, под которой понимается некоторая законченная мысль. Показатель информации в этом случае – количество таких единиц, в полученном сообщении 71/87

Информатика Лекция 2 Семантический подход к измерению информации Истинность информации(логическое количество) Эта мера оценивает информацию с позиций ее соответствия отображаемому источнику информации, т. е. реальному миру. Пусть r(mess) – функция, оценивающая истинность сообщения mess как соответствие его реальному положению вещей: 0 ≤ r(mess) ≤ 1, причем üпри r(mess) = 1 сообщение истинно, üа при r(mess) = 0 сообщение ложно. Например, r( «данная лекция посвящена информатике» ) = 1, r( «данная лекция длится 5 минут» ) = 0. 72/87

Информатика Лекция 2 Семантический подход к измерению информации Истинность информации(логическое количество) Эта мера оценивает информацию с позиций ее соответствия отображаемому источнику информации, т. е. реальному миру. Пусть r(mess) – функция, оценивающая истинность сообщения mess как соответствие его реальному положению вещей: 0 ≤ r(mess) ≤ 1, причем üпри r(mess) = 1 сообщение истинно, üа при r(mess) = 0 сообщение ложно. Например, r( «данная лекция посвящена информатике» ) = 1, r( «данная лекция длится 5 минут» ) = 0. 72/87

Информатика Лекция 2 Семантический подход к измерению информации Истинность информации(логическое количество) Оценить истинность сложного сообщения можно, разбив его на простые. Например, сообщение mess: «данная лекция посвящена информатике и длится 5 минут» можно представить как два простых сообщения mess 1 и mess 2: mess 1 - «данная лекция посвящена информатике » , mess 2 - «данная лекция длится 5 минут» . Тогда можно предложить рассчитывать истинность сложного сообщения как среднее арифметическое значение истинностей сообщений, его составляющих (что называют - «истинно лишь наполовину» ). В таком случае имеем: r(mess) = Ѕ (r(mess 1) + r(mess 2)) = Ѕ (1 + 0) = 0, 5. 73/87

Информатика Лекция 2 Семантический подход к измерению информации Истинность информации(логическое количество) Оценить истинность сложного сообщения можно, разбив его на простые. Например, сообщение mess: «данная лекция посвящена информатике и длится 5 минут» можно представить как два простых сообщения mess 1 и mess 2: mess 1 - «данная лекция посвящена информатике » , mess 2 - «данная лекция длится 5 минут» . Тогда можно предложить рассчитывать истинность сложного сообщения как среднее арифметическое значение истинностей сообщений, его составляющих (что называют - «истинно лишь наполовину» ). В таком случае имеем: r(mess) = Ѕ (r(mess 1) + r(mess 2)) = Ѕ (1 + 0) = 0, 5. 73/87

Информатика Лекция 2 Семантический подход к измерению информации Полезность информации (тезаурус) Для измерения смыслового содержания информации, т. е. ее количества на семантическом уровне, наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие тезаурус пользователя. Тезаурус - это совокупность сведений, которыми располагает Тезаурус пользователь или система. 74/87

Информатика Лекция 2 Семантический подход к измерению информации Полезность информации (тезаурус) Для измерения смыслового содержания информации, т. е. ее количества на семантическом уровне, наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие тезаурус пользователя. Тезаурус - это совокупность сведений, которыми располагает Тезаурус пользователь или система. 74/87

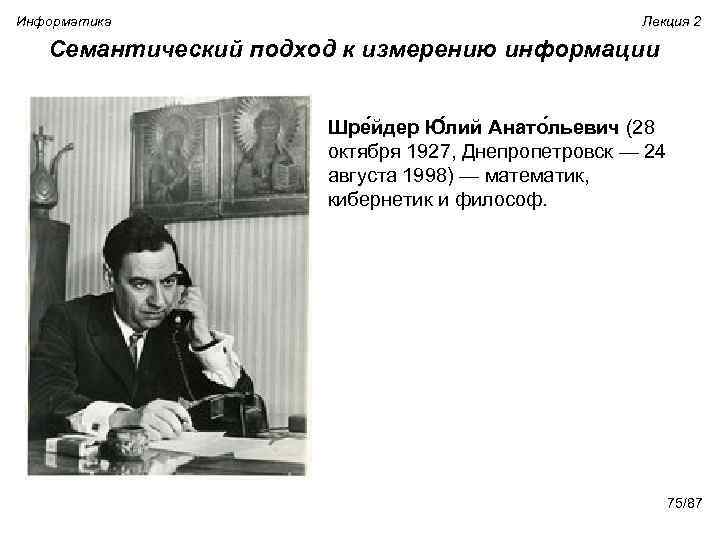

Информатика Лекция 2 Семантический подход к измерению информации Шре йдер Ю лий Анато льевич (28 октября 1927, Днепропетровск — 24 августа 1998) — математик, кибернетик и философ. 75/87

Информатика Лекция 2 Семантический подход к измерению информации Шре йдер Ю лий Анато льевич (28 октября 1927, Днепропетровск — 24 августа 1998) — математик, кибернетик и философ. 75/87

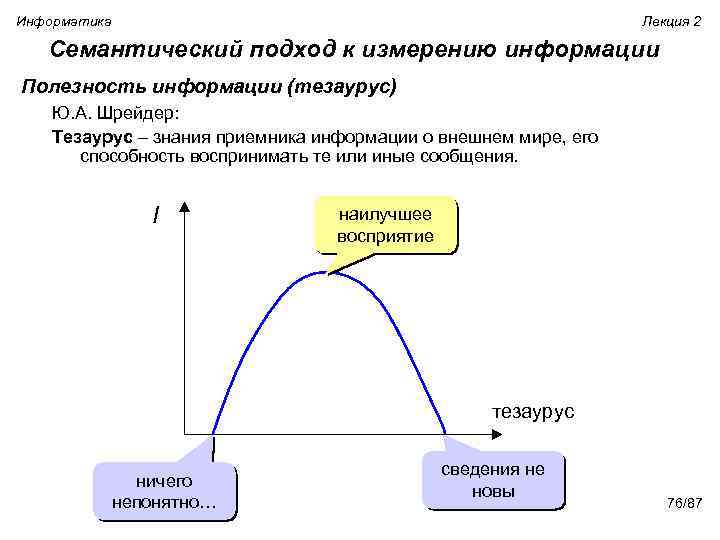

Информатика Лекция 2 Семантический подход к измерению информации Полезность информации (тезаурус) Ю. А. Шрейдер: Тезаурус – знания приемника информации о внешнем мире, его способность воспринимать те или иные сообщения. I наилучшее восприятие тезаурус ничего непонятно… сведения не новы 76/87

Информатика Лекция 2 Семантический подход к измерению информации Полезность информации (тезаурус) Ю. А. Шрейдер: Тезаурус – знания приемника информации о внешнем мире, его способность воспринимать те или иные сообщения. I наилучшее восприятие тезаурус ничего непонятно… сведения не новы 76/87

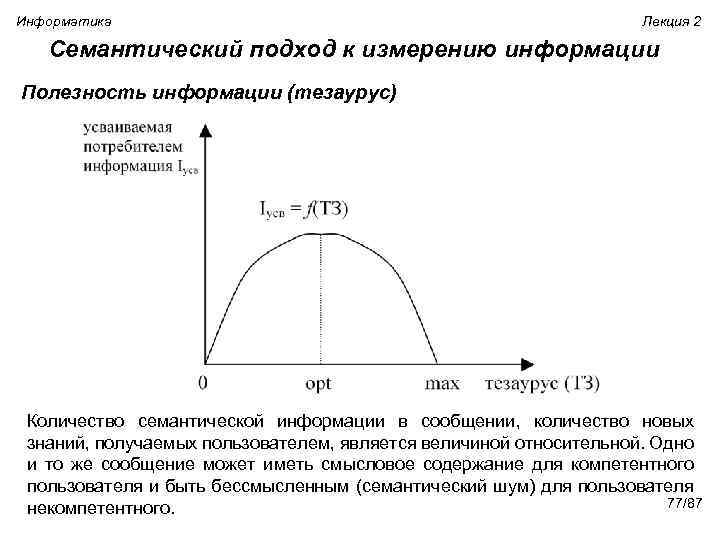

Информатика Лекция 2 Семантический подход к измерению информации Полезность информации (тезаурус) Количество семантической информации в сообщении, количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным (семантический шум) для пользователя 77/87 некомпетентного.

Информатика Лекция 2 Семантический подход к измерению информации Полезность информации (тезаурус) Количество семантической информации в сообщении, количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным (семантический шум) для пользователя 77/87 некомпетентного.

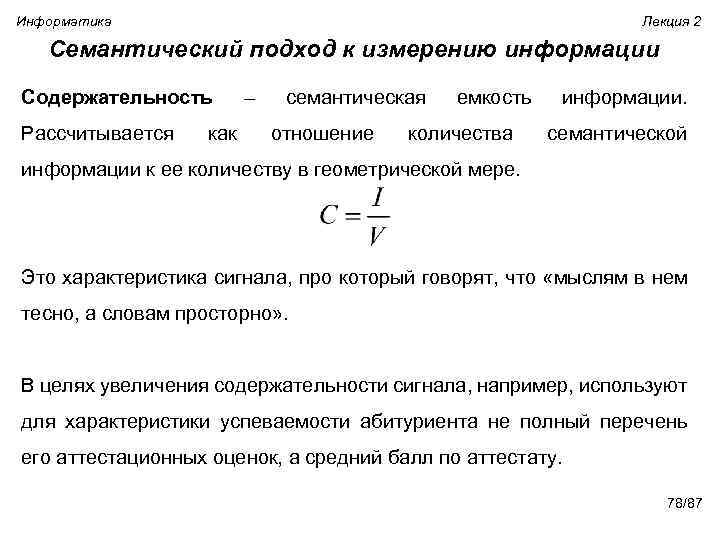

Информатика Лекция 2 Семантический подход к измерению информации Содержательность Рассчитывается как – семантическая отношение емкость количества информации. семантической информации к ее количеству в геометрической мере. Это характеристика сигнала, про который говорят, что «мыслям в нем тесно, а словам просторно» . В целях увеличения содержательности сигнала, например, используют для характеристики успеваемости абитуриента не полный перечень его аттестационных оценок, а средний балл по аттестату. 78/87

Информатика Лекция 2 Семантический подход к измерению информации Содержательность Рассчитывается как – семантическая отношение емкость количества информации. семантической информации к ее количеству в геометрической мере. Это характеристика сигнала, про который говорят, что «мыслям в нем тесно, а словам просторно» . В целях увеличения содержательности сигнала, например, используют для характеристики успеваемости абитуриента не полный перечень его аттестационных оценок, а средний балл по аттестату. 78/87

Информатика Лекция 2 Прагматический подход к измерению информации Прагматический аспект – характеристика с точки зрения полезности, пригодности для решения задач. При этом оценка может быть субъективной, отражая точку зрения получателя информации (интерпретатора). Если получатель, хотя и понял поступившую информацию, но не счел ее полезной, важной, то возникает прагматический шум и информация отсеивается. Проблемы прагматического отбора изучает прагматика – раздел семиотики, науки о знаках и знаковых системах. Исследования в этой области важны для проектирования информационно – поисковых систем: систем машинного распознавания образов, машинного перевода и других. 79/87

Информатика Лекция 2 Прагматический подход к измерению информации Прагматический аспект – характеристика с точки зрения полезности, пригодности для решения задач. При этом оценка может быть субъективной, отражая точку зрения получателя информации (интерпретатора). Если получатель, хотя и понял поступившую информацию, но не счел ее полезной, важной, то возникает прагматический шум и информация отсеивается. Проблемы прагматического отбора изучает прагматика – раздел семиотики, науки о знаках и знаковых системах. Исследования в этой области важны для проектирования информационно – поисковых систем: систем машинного распознавания образов, машинного перевода и других. 79/87

Информатика Прагматический подход к измерению информации Лекция 2 Прагматическая система показателей рассматривается с точки зрения определения содержания и количества информации, необходимой для решения задач и технологии обработки. В систему включаются следующие показатели: qважность, значимость, полнота информации, для решения задач. Важность информации всецело определяется необходимостью и достаточностью для решения конкретных задач. 80/87

Информатика Прагматический подход к измерению информации Лекция 2 Прагматическая система показателей рассматривается с точки зрения определения содержания и количества информации, необходимой для решения задач и технологии обработки. В систему включаются следующие показатели: qважность, значимость, полнота информации, для решения задач. Важность информации всецело определяется необходимостью и достаточностью для решения конкретных задач. 80/87

Информатика Прагматический подход к измерению информации qадекватность - соответствие текущему Лекция 2 состоянию соответствующих объектов или процессов. Под адекватностью информации понимается “…степень ее соответствия действительному состоянию тех реалий, которые отображает оцениваемая информация”. Определение адекватности осуществляется по двум параметрам: объективностью получения информации о предмете, процессе или явлении и продолжительностью интервала времени между моментом получения информации и текущим моментом, т. е. до момента оценивания ее адекватности. qтолерантность поступающей информации. Толерантность показатель удобства восприятия и использования информации для решаемых задач. 81/87

Информатика Прагматический подход к измерению информации qадекватность - соответствие текущему Лекция 2 состоянию соответствующих объектов или процессов. Под адекватностью информации понимается “…степень ее соответствия действительному состоянию тех реалий, которые отображает оцениваемая информация”. Определение адекватности осуществляется по двум параметрам: объективностью получения информации о предмете, процессе или явлении и продолжительностью интервала времени между моментом получения информации и текущим моментом, т. е. до момента оценивания ее адекватности. qтолерантность поступающей информации. Толерантность показатель удобства восприятия и использования информации для решаемых задач. 81/87

Информатика Лекция 2 Прагматический подход к измерению информации qрелевантность информации, поступающей для обеспечения решаемых задач. Релевантность - соответствие содержания информации потребностям решаемой задачи. Количественно релевантность определяется коэффициентом где Nr - количество релевантной информации, No - общее количество информации. Проблема заключается в сложности, а порою и невозможности, определения количества релевантной информации. 82/87

Информатика Лекция 2 Прагматический подход к измерению информации qрелевантность информации, поступающей для обеспечения решаемых задач. Релевантность - соответствие содержания информации потребностям решаемой задачи. Количественно релевантность определяется коэффициентом где Nr - количество релевантной информации, No - общее количество информации. Проблема заключается в сложности, а порою и невозможности, определения количества релевантной информации. 82/87

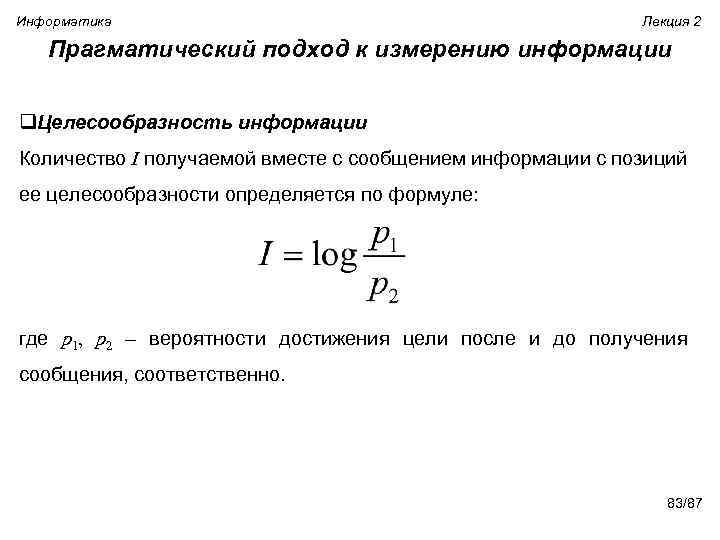

Информатика Лекция 2 Прагматический подход к измерению информации q. Целесообразность информации Количество I получаемой вместе с сообщением информации с позиций ее целесообразности определяется по формуле: где p 1, p 2 – вероятности достижения цели после и до получения сообщения, соответственно. 83/87

Информатика Лекция 2 Прагматический подход к измерению информации q. Целесообразность информации Количество I получаемой вместе с сообщением информации с позиций ее целесообразности определяется по формуле: где p 1, p 2 – вероятности достижения цели после и до получения сообщения, соответственно. 83/87

Информатика Лекция 2 Прагматический подход к измерению информации Целесообразность информации 1. Пусть вероятность p 2 сдачи экзамена по информатике до получения сообщения (подсказки от соседа) оценивается студентом со значением 0, 2. После того, как ему удалось получить подсказку, вероятность сдачи увеличилась: p 1 = 0, 8. Определить количество информации, содержащейся в подсказке, с точки зрения ее целесообразности. В соответствии с приведенной формулой имеем: I = log 2(0, 8/0, 2) = log 24 = 2. 84/87

Информатика Лекция 2 Прагматический подход к измерению информации Целесообразность информации 1. Пусть вероятность p 2 сдачи экзамена по информатике до получения сообщения (подсказки от соседа) оценивается студентом со значением 0, 2. После того, как ему удалось получить подсказку, вероятность сдачи увеличилась: p 1 = 0, 8. Определить количество информации, содержащейся в подсказке, с точки зрения ее целесообразности. В соответствии с приведенной формулой имеем: I = log 2(0, 8/0, 2) = log 24 = 2. 84/87

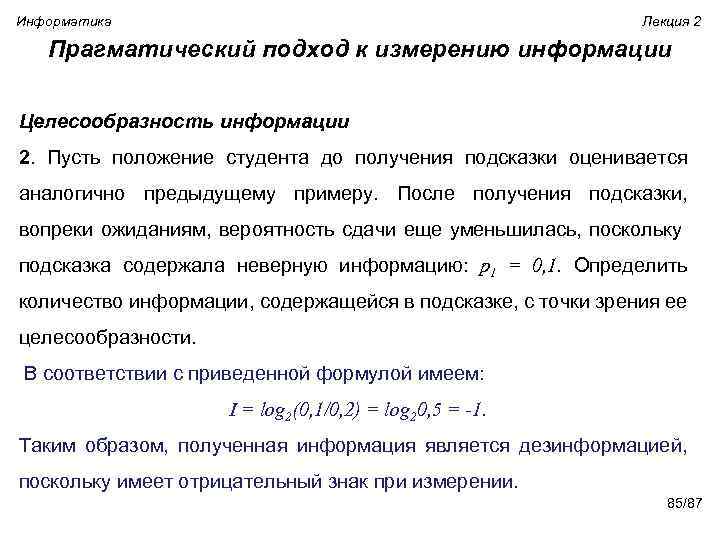

Информатика Лекция 2 Прагматический подход к измерению информации Целесообразность информации 2. Пусть положение студента до получения подсказки оценивается аналогично предыдущему примеру. После получения подсказки, вопреки ожиданиям, вероятность сдачи еще уменьшилась, поскольку подсказка содержала неверную информацию: p 1 = 0, 1. Определить количество информации, содержащейся в подсказке, с точки зрения ее целесообразности. В соответствии с приведенной формулой имеем: I = log 2(0, 1/0, 2) = log 20, 5 = -1. Таким образом, полученная информация является дезинформацией, поскольку имеет отрицательный знак при измерении. 85/87

Информатика Лекция 2 Прагматический подход к измерению информации Целесообразность информации 2. Пусть положение студента до получения подсказки оценивается аналогично предыдущему примеру. После получения подсказки, вопреки ожиданиям, вероятность сдачи еще уменьшилась, поскольку подсказка содержала неверную информацию: p 1 = 0, 1. Определить количество информации, содержащейся в подсказке, с точки зрения ее целесообразности. В соответствии с приведенной формулой имеем: I = log 2(0, 1/0, 2) = log 20, 5 = -1. Таким образом, полученная информация является дезинформацией, поскольку имеет отрицательный знак при измерении. 85/87

Информатика Лекция 2 Измерение информации Источник информации Физический фильтр Семантический фильтр Прагматический фильтр Потребитель информации 86/87

Информатика Лекция 2 Измерение информации Источник информации Физический фильтр Семантический фильтр Прагматический фильтр Потребитель информации 86/87

Информатика Лекция 2 Чтобы жить эффективно, надо жить с адекватной информацией. Но рберт Ви нер 87/87

Информатика Лекция 2 Чтобы жить эффективно, надо жить с адекватной информацией. Но рберт Ви нер 87/87

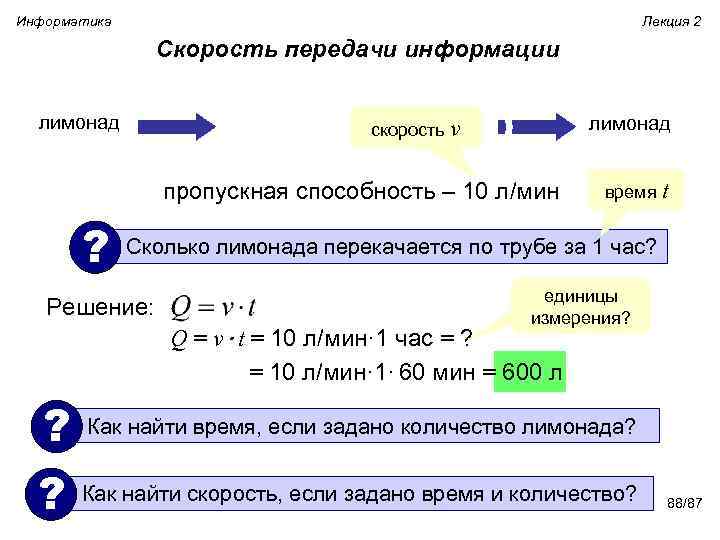

Информатика Лекция 2 Скорость передачи информации лимонад скорость v пропускная способность – 10 л/мин время t ? Сколько лимонада перекачается по трубе за 1 час? Решение: единицы измерения? Q = v·t = 10 л/мин· 1 час = ? = 10 л/мин· 1· 60 мин = 600 л ? Как найти время, если задано количество лимонада? ? Как найти скорость, если задано время и количество? 88/87

Информатика Лекция 2 Скорость передачи информации лимонад скорость v пропускная способность – 10 л/мин время t ? Сколько лимонада перекачается по трубе за 1 час? Решение: единицы измерения? Q = v·t = 10 л/мин· 1 час = ? = 10 л/мин· 1· 60 мин = 600 л ? Как найти время, если задано количество лимонада? ? Как найти скорость, если задано время и количество? 88/87

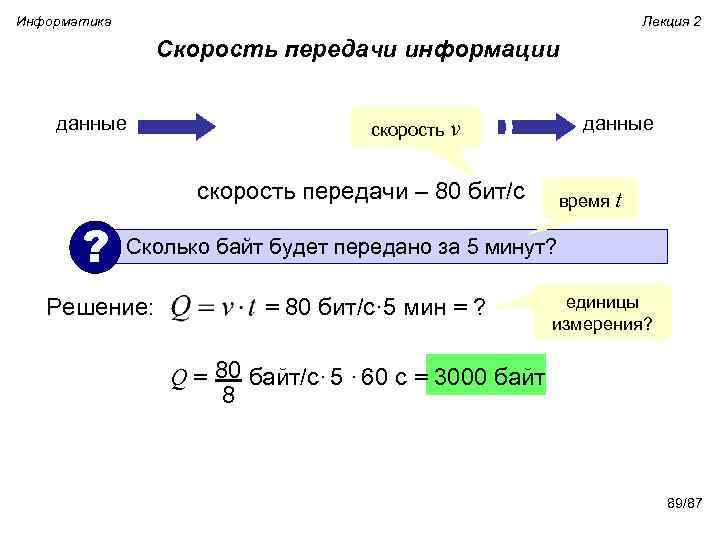

Информатика Лекция 2 Скорость передачи информации данные скорость v скорость передачи – 80 бит/с время t ? Сколько байт будет передано за 5 минут? Решение: = 80 бит/с· 5 мин = ? единицы измерения? 80 Q = байт/с· 5 · 60 с = 3000 байт 8 89/87

Информатика Лекция 2 Скорость передачи информации данные скорость v скорость передачи – 80 бит/с время t ? Сколько байт будет передано за 5 минут? Решение: = 80 бит/с· 5 мин = ? единицы измерения? 80 Q = байт/с· 5 · 60 с = 3000 байт 8 89/87

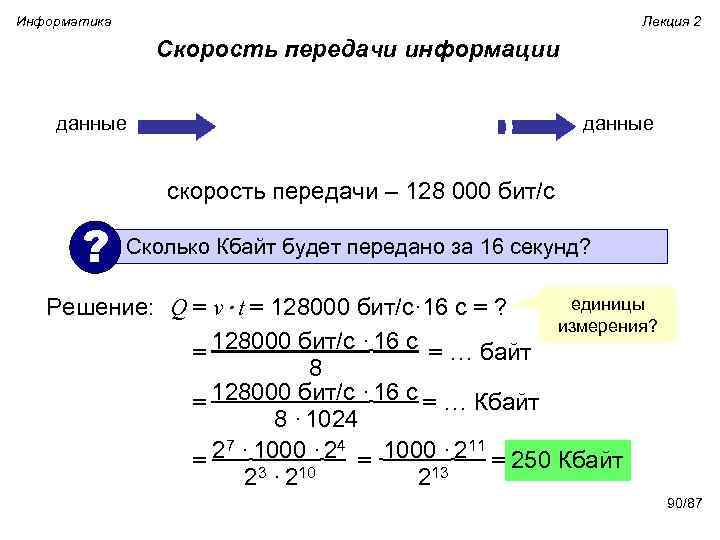

Информатика Лекция 2 Скорость передачи информации данные скорость передачи – 128 000 бит/с ? Сколько Кбайт будет передано за 16 секунд? единицы Решение: Q = v·t = 128000 бит/с· 16 с = ? измерения? = 128000 бит/с · 16 с = … байт 8 128000 бит/с · 16 с = = … Кбайт 8 · 1024 27 · 1000 · 24 1000 · 211 = 250 Кбайт = = 213 23 · 210 90/87

Информатика Лекция 2 Скорость передачи информации данные скорость передачи – 128 000 бит/с ? Сколько Кбайт будет передано за 16 секунд? единицы Решение: Q = v·t = 128000 бит/с· 16 с = ? измерения? = 128000 бит/с · 16 с = … байт 8 128000 бит/с · 16 с = = … Кбайт 8 · 1024 27 · 1000 · 24 1000 · 211 = 250 Кбайт = = 213 23 · 210 90/87

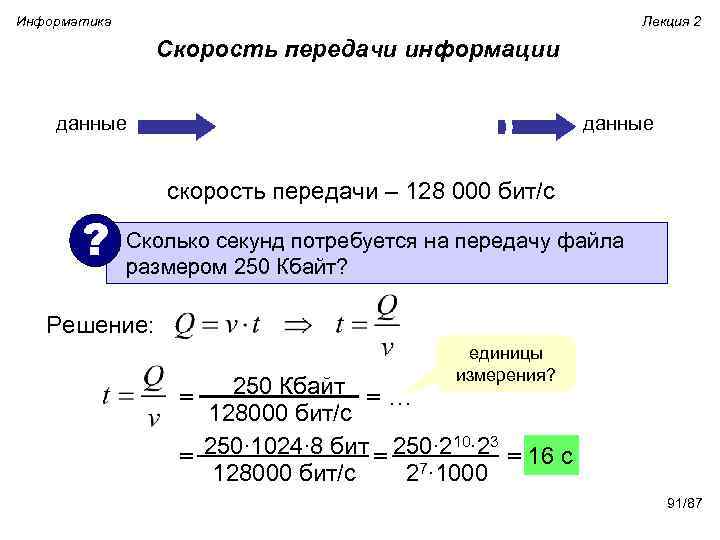

Информатика Лекция 2 Скорость передачи информации данные скорость передачи – 128 000 бит/с ? Сколько секунд потребуется на передачу файла размером 250 Кбайт? Решение: единицы измерения? 250 Кбайт = = … 128000 бит/с 250∙ 1024∙ 8 бит 250∙ 210∙ 23 = 16 c = = 7 128000 бит/с 2 ∙ 1000 91/87

Информатика Лекция 2 Скорость передачи информации данные скорость передачи – 128 000 бит/с ? Сколько секунд потребуется на передачу файла размером 250 Кбайт? Решение: единицы измерения? 250 Кбайт = = … 128000 бит/с 250∙ 1024∙ 8 бит 250∙ 210∙ 23 = 16 c = = 7 128000 бит/с 2 ∙ 1000 91/87

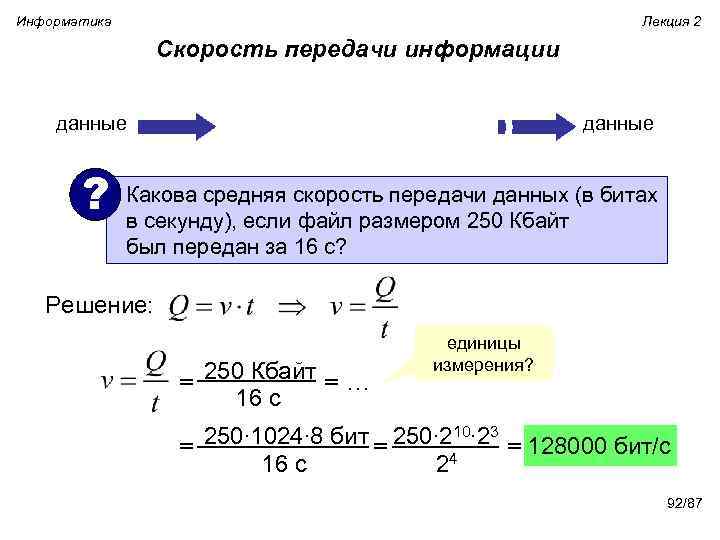

Информатика Лекция 2 Скорость передачи информации данные ? Какова средняя скорость передачи данных (в битах в секунду), если файл размером 250 Кбайт был передан за 16 с? Решение: 250 Кбайт = = … 16 с единицы измерения? 250∙ 1024∙ 8 бит 250∙ 210∙ 23 = 128000 бит/c = = 24 16 с 92/87

Информатика Лекция 2 Скорость передачи информации данные ? Какова средняя скорость передачи данных (в битах в секунду), если файл размером 250 Кбайт был передан за 16 с? Решение: 250 Кбайт = = … 16 с единицы измерения? 250∙ 1024∙ 8 бит 250∙ 210∙ 23 = 128000 бит/c = = 24 16 с 92/87

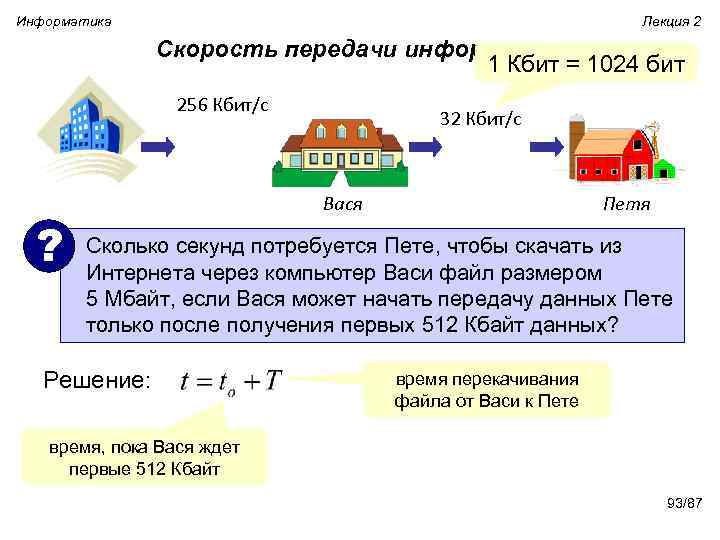

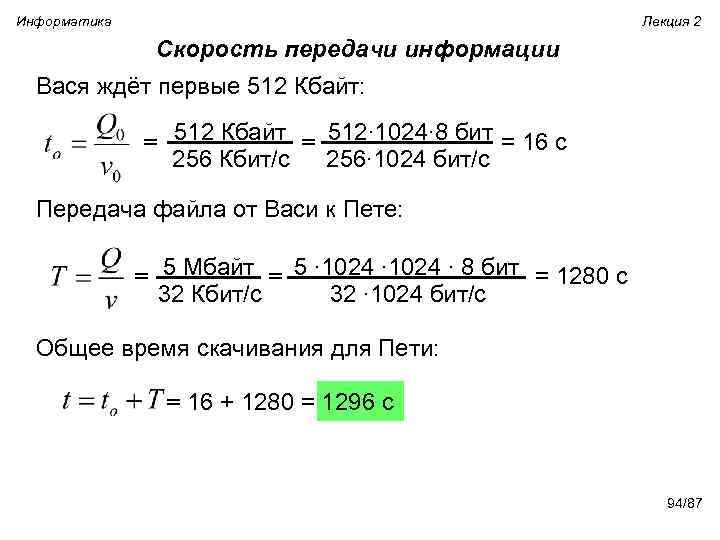

Информатика Лекция 2 Скорость передачи информации 1 Кбит = 1024 бит 256 Кбит/с 32 Кбит/с Вася Петя ? Сколько секунд потребуется Пете, чтобы скачать из Интернета через компьютер Васи файл размером 5 Мбайт, если Вася может начать передачу данных Пете только после получения первых 512 Кбайт данных? Решение: время перекачивания файла от Васи к Пете время, пока Вася ждет первые 512 Кбайт 93/87

Информатика Лекция 2 Скорость передачи информации 1 Кбит = 1024 бит 256 Кбит/с 32 Кбит/с Вася Петя ? Сколько секунд потребуется Пете, чтобы скачать из Интернета через компьютер Васи файл размером 5 Мбайт, если Вася может начать передачу данных Пете только после получения первых 512 Кбайт данных? Решение: время перекачивания файла от Васи к Пете время, пока Вася ждет первые 512 Кбайт 93/87

Информатика Лекция 2 Скорость передачи информации Вася ждёт первые 512 Кбайт: 512 Кбайт 512∙ 1024∙ 8 бит = = 16 с 256 Кбит/с 256∙ 1024 бит/с Передача файла от Васи к Пете: 5 Мбайт 5 ∙ 1024 ∙ 8 бит = = 1280 с 32 Кбит/с 32 ∙ 1024 бит/с Общее время скачивания для Пети: = 16 + 1280 = 1296 с 94/87

Информатика Лекция 2 Скорость передачи информации Вася ждёт первые 512 Кбайт: 512 Кбайт 512∙ 1024∙ 8 бит = = 16 с 256 Кбит/с 256∙ 1024 бит/с Передача файла от Васи к Пете: 5 Мбайт 5 ∙ 1024 ∙ 8 бит = = 1280 с 32 Кбит/с 32 ∙ 1024 бит/с Общее время скачивания для Пети: = 16 + 1280 = 1296 с 94/87