1c06d97270898331e40871d4edc36845.ppt

- Количество слайдов: 16

INFN-GRID-WP 4: Computing Fabric & Mass Storage Attivita’ 2003 (CNAF, Genova, Lecce, LNL, Padova, Napoli, Roma 1) GM, Bologna, 8 aprile 2003 1

WP Breakdown Fabric Design – l’attivita’ del 2003 e’ focalizzata sulle tecniche di storage di una farm con un numero elevato di nodi. L’utilizzo di NFS in questi casi e’ di difficile realizzazione e fornisce prestazioni modeste. Ci sono vari approcci possibilie. Il piu interessante per noi e’ quello legato alla possibilita’ di SAN a basso costo associate ad un file system condiviso da tutta la farm. Quindi l’attivita’ del 2003 e’ cosi articolata § Commodity Storage Area Network (SAN) § Cluster file systems Fabric Management – L’attivita 2003 continua il programma concordato con wp 4 -edg. § Installation Task o Transizione LCFG->LCFGng->EDG wp 4 tools GM, Bologna, 8 aprile 2003 2

Fabric Management: Installation Task The INFN efforts in WP 4 has been spent during the review period as follows: v INFN Legnaro (E. Ferro and C. Aifitimiei): – LCFGng deployment and support: maintenance of the existing documentation for Red Hat 6. 2 server, add of the installation guide for Red Hat 7. 3 (thanks to WP 6 collaboration), support for deployment on the testbed (bug fixes and some improvements). 1 PM. – [WP 4 I-16] Automated installation infrastructure: Design. Almost complete, announced to mailing lists, waiting for comments. 0. 6 PM. – [WP 4 I-17] Automated installation infrastructure: installation server. Started implementation only of basic functionalities (DHCP configuration). 0. 2 PM v INFN CNAF (A. Chierici ): – Generic support to CNAF-Tier 1 staff for the installation problem with LCFG. – Feedback to WP 4/WP 6 on the deployment of the new LCFGng installation system. – Development, in conjunction with WP 1 staff, of 2 new LCFGng objects: jssrbconfig and uiconfig. GM, Bologna, 8 aprile 2003 3

Fabric Design v L’attivita del 2003 e’ si compone di due argomenti strettamente correlati tra loro: – commodity SAN (o presunte) § gigaethernet (con migrazione a 10 Geth se possibile) § Infiniband – Cluster File Systems da poter utilizzare con una commodity SAN e dove quindi e’ immaginabile un file system condiviso tra tutti i nodi di calcolo e disk server – Partecipanti: § Genova § LNL § Napoli GM, Bologna, 8 aprile 2003 4

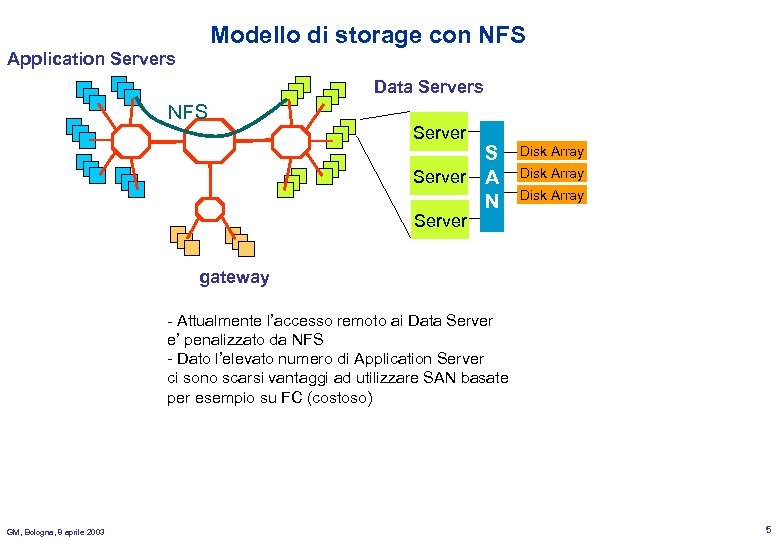

Modello di storage con NFS Application Servers Data Servers NFS Server A N Disk Array Server gateway - Attualmente l’accesso remoto ai Data Server e’ penalizzato da NFS - Dato l’elevato numero di Application Server ci sono scarsi vantaggi ad utilizzare SAN basate per esempio su FC (costoso) GM, Bologna, 8 aprile 2003 5

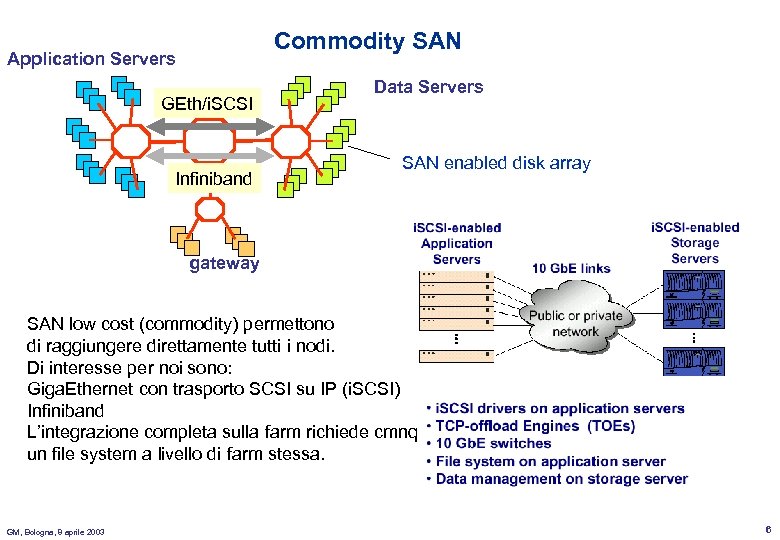

Commodity SAN Application Servers GEth/i. SCSI Infiniband Data Servers SAN enabled disk array gateway SAN low cost (commodity) permettono di raggiungere direttamente tutti i nodi. Di interesse per noi sono: Giga. Ethernet con trasporto SCSI su IP (i. SCSI) Infiniband L’integrazione completa sulla farm richiede cmnq un file system a livello di farm stessa. GM, Bologna, 8 aprile 2003 6

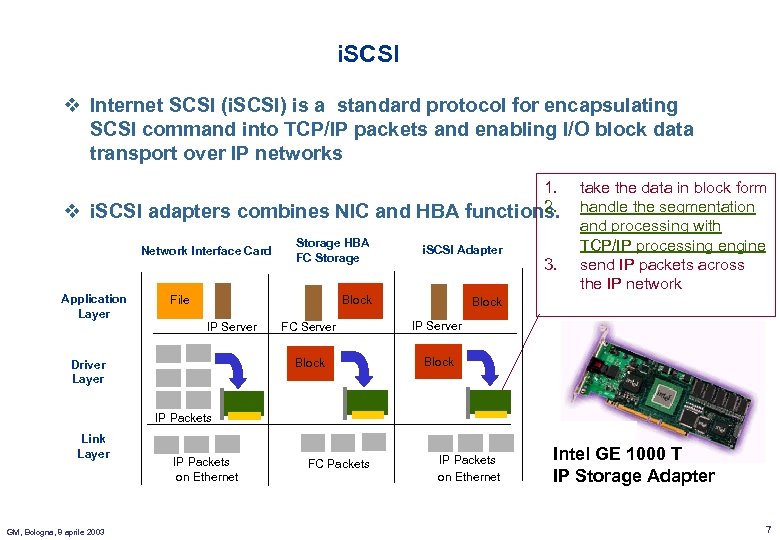

i. SCSI v Internet SCSI (i. SCSI) is a standard protocol for encapsulating SCSI command into TCP/IP packets and enabling I/O block data transport over IP networks v 1. take the data in block form 2. i. SCSI adapters combines NIC and HBA functions. handle the segmentation and processing with Storage HBA TCP/IP processing engine i. SCSI Adapter Network Interface Card FC Storage 3. send IP packets across the IP network Application Layer File Block Driver Layer FC Server IP Server Block IP Packets Link Layer GM, Bologna, 8 aprile 2003 IP Packets on Ethernet FC Packets IP Packets on Ethernet Intel GE 1000 T IP Storage Adapter 7

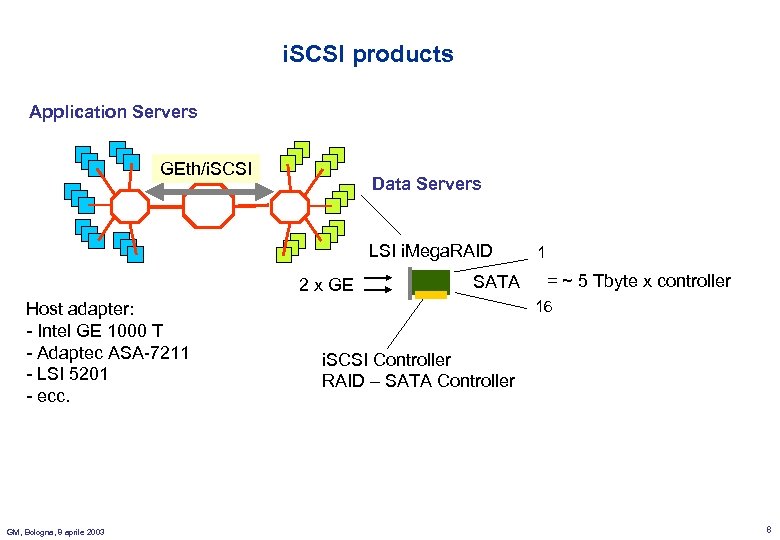

i. SCSI products Application Servers GEth/i. SCSI Data Servers LSI i. Mega. RAID 2 x GE Host adapter: - Intel GE 1000 T - Adaptec ASA-7211 - LSI 5201 - ecc. GM, Bologna, 8 aprile 2003 SATA 1 = ~ 5 Tbyte x controller 16 i. SCSI Controller RAID – SATA Controller 8

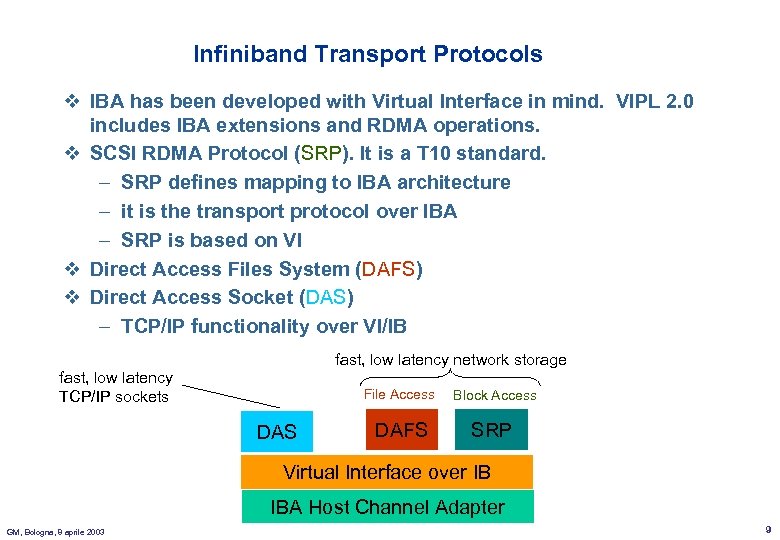

Infiniband Transport Protocols v IBA has been developed with Virtual Interface in mind. VIPL 2. 0 includes IBA extensions and RDMA operations. v SCSI RDMA Protocol (SRP). It is a T 10 standard. – SRP defines mapping to IBA architecture – it is the transport protocol over IBA – SRP is based on VI v Direct Access Files System (DAFS) v Direct Access Socket (DAS) – TCP/IP functionality over VI/IB fast, low latency network storage fast, low latency TCP/IP sockets File Access DAS Block Access DAFS SRP Virtual Interface over IB IBA Host Channel Adapter GM, Bologna, 8 aprile 2003 9

LNL Infiniband Test Bed v All the hardware has been provided by Infiniswitch (1 switch + 4 HCA) v All the hardware is up and running v First p 2 p measurements have been performed v Software – Virtual Interface Library (VIPL) as provided by Infiniswitch § Send/Receive over reliable connections § RDMA over reliable connections – Sourceforge has a infiniband project over Linux § VIPL source is available. Compiled and works! § Performance as the infiniswitch VIPL (probably they are the same code) v Results – Round trip time small buffers ~ 40 msec (latency 20 msec) – P 2 P ~ 80% link saturation GM, Bologna, 8 aprile 2003 10

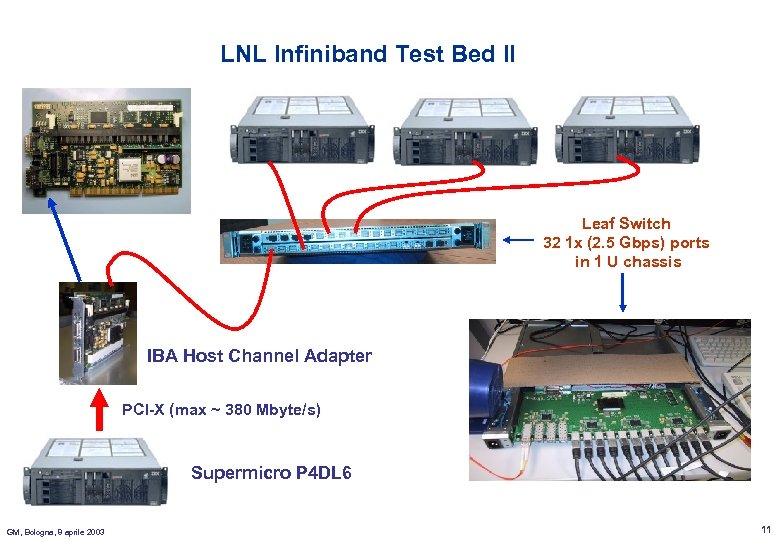

LNL Infiniband Test Bed II Leaf Switch 32 1 x (2. 5 Gbps) ports in 1 U chassis IBA Host Channel Adapter PCI-X (max ~ 380 Mbyte/s) Supermicro P 4 DL 6 GM, Bologna, 8 aprile 2003 11

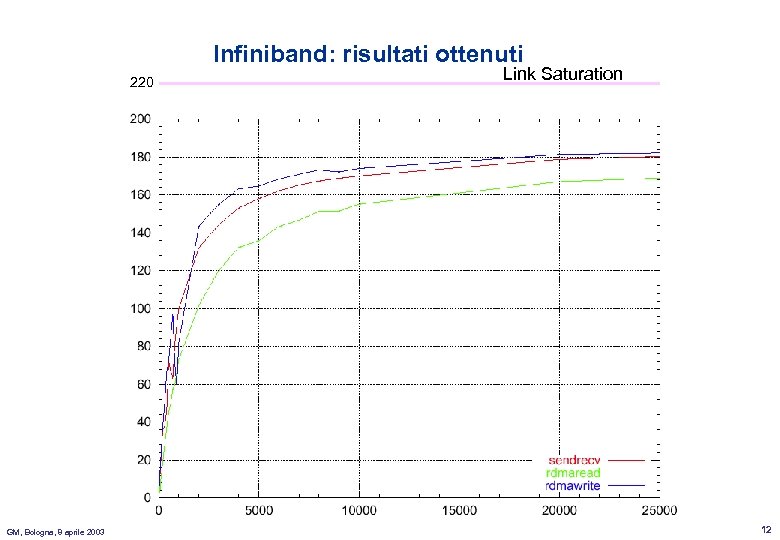

Infiniband: risultati ottenuti 220 GM, Bologna, 8 aprile 2003 Link Saturation 12

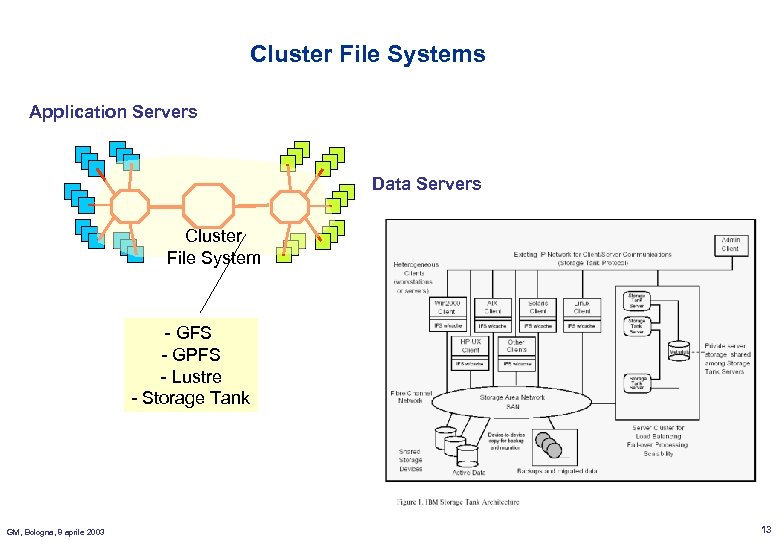

Cluster File Systems Application Servers Data Servers Cluster File System - GFS - GPFS - Lustre - Storage Tank GM, Bologna, 8 aprile 2003 13

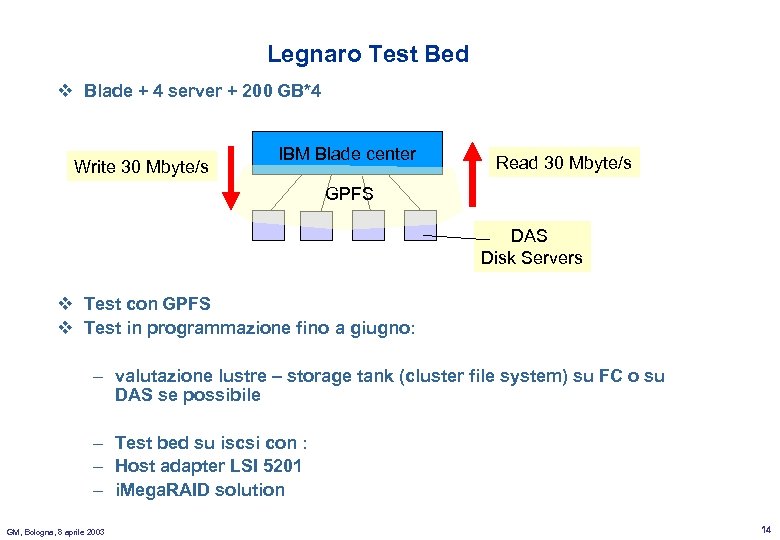

Legnaro Test Bed v Blade + 4 server + 200 GB*4 Write 30 Mbyte/s IBM Blade center Read 30 Mbyte/s GPFS DAS Disk Servers v Test con GPFS v Test in programmazione fino a giugno: – valutazione lustre – storage tank (cluster file system) su FC o su DAS se possibile – Test bed su iscsi con : – Host adapter LSI 5201 – i. Mega. RAID solution GM, Bologna, 8 aprile 2003 14

Napoli test bed v La proposta e’ di equipaggiare la farm di FIRB (16 macchine) con una rete Myrinet a 2 Gbps v Durante il setup di FIRB la farm viene utilizzata anche per fare I test sui cluster file system v A test finiti Myrinet rimane a FIRB abilitando la farm al calcolo parallelo (con MPI) ad alta velocita. v Myrinet, essendo l’unico link per cluster commerciale a 2 Gbps, permette il test dei cluster file system ad alta velocita’. GM, Bologna, 8 aprile 2003 15

Genova test bed v Viene potenziata la loro Farm Gethernet aumentando il numero di nodi (+ 15 PC) v L’attivita’ continua su: – Protocollo Gamma § in produzione su applicativi paralleli, portato su MPI – DRAID § Progetto completato § Test di scalabilita’ GM, Bologna, 8 aprile 2003 16

1c06d97270898331e40871d4edc36845.ppt