ч.3 СПИиВТ.pptx

- Количество слайдов: 71

Энергосберегающие технологии, используемые в компьютерах В 2008 г. число используемых во всем мире ПК превысило 1 миллиард и по прогнозам специалистов к 2014 г. это число удвоится. Ещё в 2007 г. в США 60 % компьютеров оставлялись включенными на ночь. Если корпоративная Америка насчитывала на это время около 100 млн компьютеров, значит 60 млн из них оставались включенными, это приводило к потерям около $2 млрд за год.

Сейчас в мире около 14 млрд гаджетов (смартфонов, планшетов). Энергия, которую они потребляют в год – 613 млрд к. Вт • ч, т. е. почти в 2 раза больше, чем производят все российские ГЭС (155 млрд) и АЭС (177 млрд). Количество мобильных устройств растет огромными темпами. В 2013 г. продажа смартфонов выросла на 50%, планшетов – на 125%. Подсчитано, что к 2050 г. гаджетов в мире будет аж 500 млрд! Даже если 5% от их числа будут использоваться в России, вся наша энергетика станет работать только на их подзарядку.

Они ежегодно потребляют электроэнергии на многие млрд долларов. Чтобы произвести всё это электричество, требуется выбросить в атмосферу сотни млн тонн углекислого газа. Как известно, многие миллиарды долларов в год пропадают в пустую из-за потерь электроэнергии за счет неэффективных источников питания личных и домашних электронных приборов, многие из которых продолжают использовать энергию даже тогда, когда они выключены, но не отсоединены от сети: «вокруг нас находятся настоящие электронные вампиры, которые высасывают электричество день и ночь» .

Согласно отчёту Минэкономразвития России, суммарный дефицит энергетических мощностей в России в 2010 году составил 14 ГВт, а стоимость электроэнергии в ближайшее десятилетие будет только расти. Этот факт наряду с глобальным экономическим кризисом заставляет производителей в сфере ИТ пересматривать один из пунктов эффективности ведения бизнеса – его энергоемкость. «… энергоемкость экономики России в 2, 3 раза выше, чем в среднем в мире. Около 40 – 45 % текущего объёма потребления энергии – это потенциал энергосбережения в нашей стране» (из выступления В. В. Путина на совещании).

Из-за удорожания электроэнергии и ужесточения экологических стандартов на энергетическое и радиационное загрязнение среды на самых емких рынках развитых стран, сегодня все производители переходят на технологии уменьшения потребления электроэнергии в ПК и периферии, особенно в моменты простоя и ожидания. Это касается и мониторов и принтеров и всяческой другой бытовой техники. Уровень энергопотребления становится важным фактором при покупке аппаратуры. Все большее число потребителей приобретает продукцию, совместимую со стандартом Energy Star.

В 2007 году компании Intel и Google вместе с фондом WWF (фонд дикой природы) дали старт инициативе Climate Savers Computing (CSCI), объединяющей отдельных пользователей, компании и экологические организации, которых беспокоят проблемы охраны окружающей среды. Эта инициатива направлена на стимулирование разработки, развёртывание и внедрение интеллектуальных технологий, способных повысить не только эффективность энергосбережения компьютера, но и сократить его энергопотребление в неактивном состоянии.

Целью данной инициативы является увеличение эффективности использования энергии компьютером на 50 %, что будет означать общее снижение расходов, связанных с приобретением энергоносителей, ориентировочно на 5, 5 млрд. долларов США. На протяжении многих лет корпорация Intel является лидером полупроводниковой отрасли по инновациям и производительности, что проявляется не только в разработке новых технологий, но и в решении сложных глобальных экологических проблем.

Эффективность использования энергии и экономия ресурсов становятся первоочередными задачами в борьбе с изменениями климата. Корпорация Intel концентрирует свои усилия для достижения лидерства по целому ряду направлений. Эффективность использования энергии стала ключевым приоритетом при проектировании передовых процессоров и вычислительных платформ. Инновационные технологии Intel активно применяются в решениях, обеспечивающих эффективное энергопотребление и безопасную производственную деятельность, а также сотрудничество, направленное на защиту окружающей среды.

За 30 лет количество энергии, потребляемой в расчёте на один транзистор, снизилось почти в миллион раз. Переход от одноядерных к многоядерным технологиям полностью изменил привычный стиль работы компьютеров и обеспечил высокую энергосберегающую производительность всех платформ Intel.

Выдающимся достижением Intel явилась 45 -нм производственная технология с применением диэлектрика на основе гафния с высоким коэффициентом диэлектрической проницаемости – nigh-k, а также металлического затвора транзистора, что обеспечило эффективное энергопотребление по сравнению с технологиям предыдущих поколений (30%-ное снижение затрат энергии на переключение транзистора). Процессоры с микроархитектурой Sandy Bridge и 22 -нм техпроцессом построены на транзисторах с трехмерной структурой затвора (Tri Gate), что позволяет уменьшить энергопотребление до 50 %.

Intel Speed Step – это энергосберегающая технология Intel, в основе которой лежит динамическое изменение частоты и энергопотребления процессора в зависимости от используемого источника питания. Впервые была использована в процессорах mobile Pentium III. По этой технологии процессоры могут автоматически уменьшать частоту и напряжение питания при простое или малой нагрузке, снижая, таким образом, своё энергопотребление. Как только нагрузка возрастает, частота и напряжение автоматически поднимаются до своих нормальных значений.

Intel Halt State – энергосберегающая технология, в результате которой отключаются некоторые блоки процессора во время их бездействия. Традиционно, компьютер с интеловским процессором может находиться либо в активном состоянии S 0 (обычный рабочий режим), либо в одном из четырех состояний «сна» S 1–S 4. В состоянии S 1 все процессорные кэши сброшены и процессор прекратил выполнение инструкций. Однако поддерживается питание процессора и оперативной памяти, а устройства, которые не обозначены как включенные, могут быть отключены. Состояние S 2 – это еще более глубокое состояние «сна» , когда процессор отключен.

Состояние S 3 (другое название – Suspend to RAM (STR) или режим ожидания – Stanby) – это состояние, в котором на оперативную память (ОЗУ) продолжает подаваться питание и она остается практически единственным компонентом, потребляющим энергию. Состояние S 4 известно как гибернация (Hibernation). В этом состоянии всё содержимое оперативной памяти сохраняется в энергонезависимой памяти (например, на жестком диске или SSD).

Одно из нововведений в процессоре Haswell – это позволяющие снизить совокупное энергопотребление процессора новые состояния энергопотребления, которые называются S 0 ix. Состояния S 0 ix (S 0 i 1, S 0 i 2, S 0 i 3, S 0 i 4) аналогичны состояниям S 1, S 2, S 3 и S 4 в смысле энергопотребления, но отличаются от них тем, что для перехода системы в активное состояние S 0 требуется гораздо меньше времени. К примеру, для перехода из состояния S 0 в состояние S 0 i 3 требуется 450 мкс, а для обратного перехода – 3, 1 мс.

Управление питанием и технология Turbo Boost в процессорах с микроархитектурой Sandy Bridge осуществляется с помощью блока управления питанием PCU (Power Control Unit), входящего в состав системного агента. Этот блок представляет собой программируемый микроконтроллер, который собирает информацию о температуре и потребляемом токе различных узлов процессора и имеет возможность интерактивно управлять их частотой и напряжением питания. Силами PCU реализуются как энергосберегающие функции, так и турбо-режим, который в Sandy Bridge получил дальнейшее развитие.

Все функциональные модули, составляющие процессоры Sandy Bridge, разделены в нём на три домена, использующие независимые схемы тактования частоты и подключения питания. Первый и основной домен объединяет процессорные ядра и L 3 кэш, которые работают на единой частоте и напряжении. Второй домен – это графическое ядро, которое использует собственную частоту. Третий домен – это системный агент.

Такое разделение позволило инженерам реализовать работу технологий Enhanced Intel Speed Step и Turbo Boost одновременно и независимо для графического и процессорных ядер. Подобный подход уже был применен в мобильных процессорах Arrandale, однако там он работал по-простому, через драйвер. В Sandy Bridge уже реализовано полностью аппаратное решение, которое управляет частотами вычислительных и графических ядер взаимосвязано, учитывая их текущее потребление.

Это позволяет получить более серьёзный реализуемый через турбо-режим разгон процессорных ядер во время простоя графического ядра и наоборот – существенный разгон графического ядра во время неполной загрузки вычислительных ядер. Агрессивность турбо-режима в Sandy Bridge нетрудно оценить потому, что частота процессора может увеличиваться на четыре шага относительно номинальной частоты, а вариация в частоте графического ядра может достигать и шестисеми шагов.

Однако это далеко не все нововведения в технологии Turbo Boost. Преимущество её новой реализации заключается ещё и в том, что PCU получил возможность управлять частотами более интеллектуально ориентируясь на реальные температуры процессорных составляющих, а не только на их энергопотребление. Это означает, что в тех случаях, когда процессор работает в благоприятных температурных условиях, его энергопотреблению разрешается выходить за границу, задаваемую TDP (термопакет).

При типичной повседневной работе процессорная нагрузка носит скачкообразный характер. Большинство времени процессор проводит в энергосберегающих состояниях, а высокая производительность требуется лишь в небольшие промежутки времени. За такие промежутки нагрев процессора не успевает достигнуть сколь-нибудь серьёзных величин – сказывается инерционность, обеспечиваемая теплопроводностью кулера. Управляющий частотами в Sandy Bridge блок PCU справедливо считает, что ничего страшного не произойдёт, если в такие моменты процессор будет разогнан сильнее, чем в теории может позволить величина расчётного тепловыделения. Когда же температура процессора начнёт приближаться к критическим значениям, частота будет снижена до безопасных значений. Максимальная продолжительность работы в состоянии «за гранью TDP» аппаратно ограничена 25 секундами.

Сегодня в США и в Европе широко пропагандируется способ энергосбережения, называемый ecobutton и представляющий собой большую круглую зелёную кнопку, нажатие которой переводит компьютер в режим энергосбережения (hibernating). Все последние версии Windows имеют энергосберегающие функции и умеют мгновенно «усыплять» и «будить» компьютер. Другое дело – что большая зелёная кнопка заметней, а её создатели рекомендуют нажимать на неё, даже уходя на короткий перекур.

Энергосберегающие функции сетевого фильтра Green Power MDP 900 от Monster Cable позволяют экономить существенное количество энергии, когда подключенные приборы уходят в режим standby. Наиболее полезно это устройство в сочетании с настольным компьютером. Когда компьютер переключается в спящий режим, MDP 900 автоматически отключает от сети все периферийные устройства, такие как принтер или монитор, а когда компьютер выходит из спящего режима, подключая их обратно.

Мощная современная видеокарта под полной нагрузкой требует столько же энергии, сколько остальные комплектующие ПК вместе взятые: от 110 до 270 Вт. Поэтому производители приступили к выпуску интеллектуальных видеокарт с управлением потребления электроэнергии в зависимости от нагрузки.

Ресурсосберегающие технологии, применяемые в серверах Серверы – это компьютеры, выполняющие служебные функции в компьютерной сети. Рынок серверов в настоящее время можно сегментировать на домашние и корпоративные серверы.

Корпоративные серверы в свою очередь можно классифицировать по сферам применения: • федеральные и муниципальные структуры; • крупные предприятия; • средние и малые предприятия; • центры обработки данных (ЦОД). Последний сектор специфичен тем, что практически весь компьютерный парк составляют серверы.

Важное значение в настоящее время приобретает бурно развивающийся сегмент серверов для домашних сетей. Если эта тенденция сохранится, то вскоре парк домашних серверов превысит в количественном отношении парк корпоративных серверов. Это вызвано, во-первых, резким ростом среднего числа компьютеров, приходящихся на одну семью, а вовторых, значительным расширением функций домашних информационных сетей. Так, если ещё недавно домашняя сеть лишь обеспечивала подключение всех компьютеров в квартире к интернету, то теперь её функции всё чаще дополняются решением задач, связанных с автономным копированием информации на домашний компьютер, видеонаблюдением за объектом, управлением охранной сигнализацией, управлением компонентами, входящими в состав «Умного дома» и т. д.

С учётом того, что, в отличие от рабочих мест, серверы обычно работают непрерывно в режиме 24 х7 х365, во многих случаях энергопотребление серверного компонента составляет более половины общего энергопотребления информационной системы. Особенно это ощутимо в бурно развивающемся секторе домашних компьютерных сетей, где суммарное рабочее время персональных мест может значительно уступать времени работы сервера. Таким образом, внедрение энергосберегающих технологий в серверный компонент информационных систем постепенно выходит на первый план.

Для повышения эффективности энергосбережения, снижения затрат в эксплуатации основным подходом является консолидация серверов с использованием технологий визуализации и блейд-серверных технологий. Блейд-серверы Набирающие популярность блейд-серверы – это воистину серверы XXI века (их первые модели были разработаны в 2001 г. ), преимущество которых изготовители описывают с помощью правила « 1234» . Оно звучит так: по сравнению с обычными серверами при сравнимой производительности блейд-серверы занимают в два раза меньше места, потребляют в три раза меньше энергии и обходятся в четыре раза дешевле.

По определению аналитической компании IDC блейдсервер – это модульная одноплатная компьютерная система, включающая процессор и память. Платы или лезвия (blade – лезвие) вставляются в специальное шасси с объединительной панелью, обеспечивающей им подключение к сети и подачу электропитания. За счёт общего использования таких компонентов, как источники питания, сетевые карты, диски и блоки охлаждения, блейдсерверы обеспечивают более высокую плотность размещения вычислительной мощности в стойке по сравнению с обычными тонкими серверами.

Практически все Blade-решения имеют собственные интеллектуальные системы управления питанием и охлаждением, что позволяет оптимизировать затраты на них в зависимости от потребностей. Помимо значительной экономии электроэнергии (до 20%), ограничения тепловыделения и потребности в системе охлаждения (т. е. сокращения долгосрочных расходов на эксплуатацию), данный подход существенно экономит время ИТ-персонала и, таким образом, снижает совокупную стоимость владения.

Виртуализация серверов – возможность одному компьютеру выполнять работу нескольких. Выигрыш достигается за счет более эффективного использования вычислительных ресурсов; уменьшения количества оборудования при увеличении производительности, снижения расходов на поддержку ИТ; снижение энергозатрат.

На сегодняшний день в общей виртуализационных средств выделяется три слоя: • виртуализация вычислительных сред центрального процессора, включая операционной системы); • виртуализация хранилищ данных; • виртуализация сетей. структуре основных (ресурсов ОЗУ, и В общем случае комплекс средств виртуализации вычислительных сред (или виртуализации ПО) можно представить в виде нескольких основных технологических подходов, которые приведены в таблице.

Вид виртуализации Виртуальные машины Виртуальные контейнеры Виртуальные приложения Виртуализация представлений Описание Назначение Возможность запуска нескольких ОС, в том числе разнородных, на одном компьютере Повышение эффективности использования ресурсов центрального процессора Создание нескольких однородных изолированных операционных сред на базе одного экземпляра ОС Создание дополнительного операционного окружения вокруг отдельного приложения внутри ОС Отделение бизнеслогики от пользовательского интерфейса Повышение серверы эффективности использования ресурсов центрального процессора Parallels, Oracle Повышение ПК независимости приложения от версии ОС и уровня изоляции между приложениями Microsoft, VMware, Symantec Реализация идеи терминального доступа с использованием тонкого клиента Где Пример реализации применяется (поставщики) ПК, серверы VMware, Microsoft, Citrix, Oracle, Red Hat, Parallels и др. ПК и другое Citrix, Microsoft и др. клиентское оборудование

Далее мы сосредоточим внимание на технологиях виртуализации преимущественно в контексте задачи консолидации серверов. Основным методом здесь является механизм виртуальных машин. Предпосылки использования виртуализации в данном случае вполне очевидны: до недавнего времени информационные системы были организованы так, что для работы каждого отдельного ИТ или бизнес-сервиса (электронная почта, Web-сайт, бухгалтерская система и пр. ) требовался отдельный физический сервер, загрузка процессора в котором составляла 3– 10 %, в то время как оптимальный уровень – от 40 до 60 %. Средства виртуализации позволяют использовать один виртуальный сервер вместо пяти-шести физических.

Посмотрим чего это стоит клиенту и что он от этого выигрывает. При переходе от физической инфраструктуры к виртуальной капитальные (разовые) затраты составляют: Оборудование. Скорее всего придётся покупать новую технику. Прямой выигрыш тут может быть только в том случае, если удастся удачно утилизировать освободившееся старое оборудование. Программное обеспечение. К уже имеющемуся ПО (ОС, приложения) нужно будет покупать ПО виртуализации. Услуги по реализации проекта. Понятно, что сам проект потребует дополнительных затрат человеческих ресурсов. Но тут нужно отметить важный момент: выполнение такого проекта в целом может быть по силам и имеющемуся ИТ-персоналу, т. е. его можно реализовать поэтапно в рамках текущих бюджетов.

По текущим (эксплуатационным) затратам можно ожидать снижения расходов по всем статьям – аренда помещений, стоимость электроэнергии, администрирование, техническое обслуживание, модификация старых и развёртывание новых ИТсервисов. Кроме того, могут быть получены качественно новые преимущества с точки зрения как ИТ (оптимизация ИТ-инфраструктуры в целом за счёт гибкой балансировки нагрузок, повышение надежности и доступности), так и бизнеса (быстрая реализация требований пользователей).

Какой эффект будет в результате? В общем случае он видится скорее положительным, но более точно можно говорить только применительно к конкретным проектам. Вполне определённо можно сказать одно: успех проекта напрямую зависит от правильности общей методики его реализации, квалификации исполнителей, решимости руководства компании и ИТ-подразделений и т. д.

Ресурсосберегающие технологии, применяемые в ЦОДах Объёмы информации в современном мире растут чуть ли не экспоненциальными темпами. По крайней мере аналитики IDC предрекали по итогам 2011 года 44 -кратный рост использования данных в глобальном масштабе. В итоге общий объём информации, с которым имеют дело компании и частные пользователи во всём мире, может превысить 32 зеттабайт (1 Зб = 1 млрд. Тб, 1021).

В такой ситуации для множества руководителей естественным выбором становится оптимизация подсистемы хранения информации, выделение такой подсистемы в собственный центр обработки данных либо использование услуг внешних ЦОДов.

Централизация хранения и обработки информации находится в русле ещё одной зримой тенденции последних нескольких лет – перехода к модели использования ИТ в виде услуг (в том числе в виде облачных сервисов). Хранение и обработка данных в качестве услуги, предоставляемой на коммерческой основе, становится полноправной отраслью ИТ-бизнеса. ЦОД как коммерческое предприятие обязан быть выгодным – и для своего владельца, и для клиентов.

Мировому рынку самих ЦОДов и предоставляемым ими услугам эксперты отмеряют лет тридцать. Сегодня это вполне зрелый рынок во всём его спектре. Спрос на ЦОДы продолжает уверенно расти, что связано с влиянием на него самых разных областей экономики. Лет пятнадцать назад стало возможным говорить о создании и эксплуатации ЦОДов как о рынке и в нашей стране.

Примечательным для России стал 2006 г. , когда в строительстве ЦОДов начали активно применяться стандарты и создавать объекты высшей категории. В это же время наметилась и сегментация рынка ЦОДов: он разделился на корпоративные и коммерческие ЦОДы, а коммерческие, в свою очередь, разделились на комплексы разных категорий. Начался рост потребности в высоконадёжных комплексах, способных обеспечивать работу по критерию 24 х7 х365. Первыми такие требования к ЦОДам предъявили компании телекомовского и финансового сегментов, для которых критична каждая минута прерывания бизнеса.

Структурно ЦОД состоит из вычислительного или ИТ-оборудования (серверы, системы хранения, сетевое оборудование и т. д. ) и инженерной инфраструктуры (системы охлаждения и кондиционирования, системы энергообеспечения, шкафы с кабель-каналами, распределительные панели, системы освещения, системы безопасности и т. д. ).

Главная тенденция в развитии ЦОДов – переход от экстенсивного наращивания вычислительных мощностей к их оптимизации и увеличению эффективности использования ресурсов. Но в то же время в силу централизации растёт и мощность ЦОДов и серверных. А значит, заметно увеличивается спрос на энергосберегающие технологии. В Европе и Соединённых Штатах уже сейчас стоимость ресурсов, потребляемых ЦОДом в течение нескольких лет, сравнилась со стоимостью всего оборудования: и вскоре таким же будет положение дел и в России.

В этой ситуации решающее значение приобретает эффективное управление электропитанием ЦОДа. Ведь повышение КПД системы всего на несколько процентов приводит к миллионной экономии в масштабах нескольких лет. При создании нового и модернизации старого серверного хозяйства останавливаются на выборе Blade-систем как на наиболее современном и перспективном решении для стандартизации серверов в организации (ЦОДе).

К преимуществам использования блейд-серверов можно отнести следующие: • уменьшение занимаемого объема; • уменьшение энергопотребления и выделяемого тепла; • уменьшение стоимости и повышение надежности системы питания и охлаждения; • повышение удобства управления системой; • высокая масштабируемость; • высокая гибкость; • сокращение количества коммутационных проводов. Блейд-серверы стали предпочтительным и наиболее часто запрашиваемым решением для виртуализации и консолидации серверных приложений.

Современная инженерная инфраструктура ЦОДа с позиции заказчика должна отвечать очень разным и изменяющимся потребностям. Главными качественными характеристиками инфраструктуры, определяющими конкурентные преимущества, являются: модульность, масштабируемость, адаптивность, энергоэффективность, надёжность и управляемость её оборудования.

Задачи автоматизации управления инженерной инфраструктурой ЦОДа сегодня наиболее актуальны. Непрерывность предоставления ИТ-сервисов – основная задача инженерной инфраструктуры ЦОДа. Задача системы управления состоит в том, чтобы обеспечивать алгоритмы и механизмы управления достаточной надёжности, с тем чтобы в режиме реального времени поддерживать непрерывность энергообеспечения, кондиционирования, охлаждения вне зависимости от влияния внешних факторов. Это необходимый минимум.

Другая задача заключается в управлении доступностью инфраструктурных компонентов внутри гермозоны. Особенно важно это для крупных (и тем более территориально распределённых) объектов, где планирование распределения инфраструктурных ресурсов тоже решается с помощью (специализированных) систем автоматизации. Для поддержки виртуализации ИТ-ресурсов инженерная инфраструктура должна быть максимально адаптированной и способной реагировать на изменения инфраструктурных параметров в режиме реального времени. Это перекликается с задачами управления инженерной инфраструктурой.

Идёт процесс интеллектуализации управления инженерной инфраструктурой. В ближайшие 5– 7 лет тема развития ПО управления инженерной инфраструктурой ЦОДов будет на слуху. Для оценки энергоэффективности ЦОДов используется показатель Power Usage Effectiveness (PUE). Он определяется как отношение энергопотребления всего ЦОДа к энергопотреблению его ИТ-оборудования: PUE = энергопотребление ИТ-оборудования энергопотребление инфраструктуры энергопотребление ИТ-оборудования. + /

Хотя показатель PUE широко распространён для описания того, как ЦОД использует электропитание, нужно осторожно подходить к интерпретации полученных с его помощью результатов. Следует всегда помнить, что PUE наиболее полезен для отслеживания влияния изменений, вносимых в инфраструктуру, и менее полезен для оценки улучшений, происходящих за счёт сокращения энергопотребления ИТ-оборудования ЦОДа, поскольку сокращение энергопотребления оборудования приведёт к увеличению PUE.

Рассмотрим способы повышения эффективности множества ЦОДов, которые созданы много лет назад (20– 30 лет назад). Ведь именно их использует большинство предприятий, университетов и госучереждений. Используемые раньше мэйнфреймы и мини-компьютеры, как правило, уступили место множеству серверов и дисковых систем, которые добавлялись год за годом по мере роста потребностей.

Энергопотребление таких ЦОДов постоянно росло за счёт добавления нового оборудования. У большинства зрелых (старых) центров значение PUE находится в диапазоне от 3. 0 до 5. 0. В среднем у современных ЦОДов показатель эффективности приближается к двойке, т. е. на каждый ватт, потребляемый серверами, приходится ещё один ватт, который расходует инженерная инфраструктура.

Для повышения эффективности ЦОДов, которые созданы много лет назад, необходимо провести следующие мероприятия. Первый шаг состоит в примерном подсчёте потребляемой энергии вашим оборудованием по трём категориям: ИТ-оборудование (серверы, системы хранения); другое оборудование (системы охлаждения и потери энергии от распределения питания); освещение. Каким бы ни были ваши результаты, с их помощью вы сможете понять, куда уходит львиная доля электроэнергии, и построить несколько стратегий энергосбережения.

После этого можно провести первый уровень апгрейта, который не требует высоких капитальных затрат, вносит минимум нарушений в работу ЦОДа и быстро окупается. Для большинства несовременных ЦОДов наиболее продуктивными является следующие четыре шага: 1) создайте горячие и холодные проходы за счёт перегруппировки ваших стоек с оборудованием так, чтобы в одном ряду друг против друга стояли холодные передние панели, а в другом – горячие задние части с отверстиями для вентиляции;

2) поднимите температуру воды в холодильных установках (как правило, с 55 до 58 градусов). Это нужно делать постепенно, чтобы не вызвать проблем у оборудования; 3) поднимите температуру воздуха в вашем ЦОДе (на 3– 5 градусов). Это также следует делать постепенно, по одному градусу за один раз; 4) найдите и выключите неиспользованное оборудование.

Второй этап усовершенствования вашего ЦОДа требует больше усилий, вызывает больше нарушений в работе, подразумевает некоторые, хоть и небольшие, инвестиции, но окупается меньше чем за год. В этот этап входят четыре усовершенствования: 1) виртуализация серверов – повышение эффективности при меньшем количестве машин; 2) консолидация памяти – аналогично виртуализации серверов этот метод подразумевает использование единого массива памяти для поддержки множества заказчиков или бизнес-функций;

3) оптимизация хранения – установка ПО, позволяющего выключать низкоприоритетные устройства хранения (третьего уровня и предназначенные для резервного копирования), когда они не используются; 4) мониторинг старения систем хранения. Когда они долго работают, растёт число операций поиска на дисках, возрастает торможение шпинделя и возникают другие нарушения, которые приводят к росту энергопотребления и уменьшению надёжности. Большинство экспертов считают, что трёхлетний цикл обновления дисковых накопителей сокращает энергопотребление на 10 %.

И наконец настало время для рассмотрения возможностей для обновления оборудования. Замена нескольких старых пожирателей электричества на один новый виртуализированный сервер или консолидированную систему памяти должна быть включена в список периодических работ, требующих капитальных затрат. Такой подход позволяет распределить расходы по времени и свести к минимуму нарушения в работе ЦОДа.

Сегодня крупные серверные вендоры в качестве примера успешного построения ЦОДов часто приводят проекты консолидации собственной корпоративной инфраструктуры таких центров, позволяющие существенно повысить отдачу от инвестиций в ИТ и снизить расходы на эксплуатацию ЦОДов. В 2010 году Microsoft опубликовало статью, в которой почётный инженер корпорации Дилипп Бхандаркар рассказал об опыте создания новых корпоративных мега ЦОДов в Чикаго и Дублине мощностью 60 и 27 МВт соответственно, оптимизированных для сокращения энергопотребления.

При разработке спецификаций серверов для этих ЦОДов ставка делалась на процессоры с пониженным потреблением мощности, из конфигурации которых были исключены лишние компоненты (например, приводы компакт-дисков и неиспользуемые слоты расширения) и в которых использовались более эффективные блоки питания и трансформаторы. Кроме того, вопреки промышленным стандартам при проектировании ЦОДов была на несколько градусов увеличена максимально допустимая температура серверного оборудования. При проектировании обоих ЦОДов инженеры Microsoft постарались получить максимальную вычислительную мощность, несмотря на ограниченные ресурсы энергообеспечения. В результате показатель энергоэффективности новых ЦОДов (PUE) составил 1, 2 (у ЦОДов Microsoft предыдущего поколения он равнялся 1, 6).

На основании опыта эксплуатации чикагского ЦОДа инженеры Microsoft пришли к выводу, что применение стандартных контейнеров с водяным охлаждением для размещения ИТ-оборудования не является оптимальным решением, поскольку снижается максимально допустимая температура серверов и эффективность воздушного охлаждения. Поэтому они предложили размещать серверы под навесом. Естественное воздушное охлаждение вполне может использоваться в большинстве регионов мира, за исключением тропиков, характеризующихся жарким климатом и высокой влажностью воздуха. Отказ от водяного охлаждения не только значительно снизит затраты на построение инфраструктуры и сроки развёртывания ЦОДа, но доведёт показатель PUE до 1, 05.

Управление неоднородной виртуально-физической ИТ-инфраструктурой Одна из ключевых идей (и преимуществ) виртуализации – переход от статической структуры дата-центров с использованием исключительно физических серверов к динамической организации на базе смешанной виртуальнофизической инфраструктуры. Важно отметить, что применение средств виртуализации не отменяет (по крайней мере в видимой перспективе) необходимости в физических серверах (один компьютер – одна ОС). Причина тому вполне очевидна: наряду с достоинствами (гибкость управления, оптимизация нагрузок) виртуальные машины (ВМ) имеют и недостатки по сравнению с автономными ОС (некоторые ограничения в использовании ресурсов, снижение производительности, возможные проблемы с совместимостью).

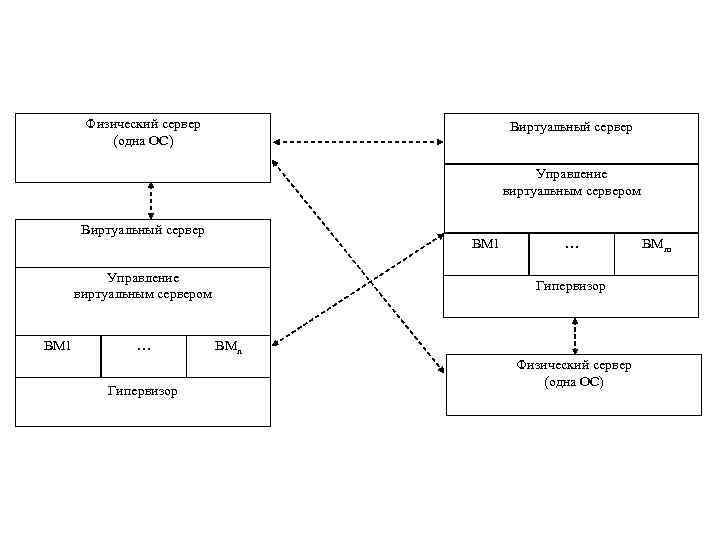

Физический сервер (одна ОС) Виртуальный сервер Управление виртуальным сервером Виртуальный сервер ВМ 1 Управление виртуальным сервером ВМ 1 … Гипервизор ВМn Физический сервер (одна ОС) ВМm

Посмотрев на структуры такого динамического дата-центра, легко оценить значимость задачи управления всей этой сложной системой. До сих пор обсуждение проблем виртуализации сводилось преимущественно к теме среды функционирования ВМ (в частности, гипервизоров). Однако следует чётко понимать: гипервизоры – это хотя и базовый, но всего лишь один из компонентов ПО виртуализации. Второй компонент, но сегодня он по сути выходит на первый план – это средства управления.

В свою очередь ПО управления включает две основные категории инструментов: • средства управления виртуальными машинами внутри отдельного сервера; • средства управления системой виртуальных и физических серверов в целом. Тут стоит обратить внимание на то, что если первая категория инструментов довольно жёстко связана с конкретным гипервизором и соответственно обычно поставляется самим его производителем, то вторая представляет собой сферу пересечения интересов как поставщиков виртуальных сред, так и независимых разработчиков.

Сложность задачи управления динамической ИТинфраструктурой легко себе представить, если учесть, что речь идёт о сугубо неоднородной системе, которая имеет дело с несколькими группами поставщиков (оборудования, ОС, приложений, ПО виртуализации), причём в каждой такой группе есть своя неоднородность (например, могут использоваться виртуальные среды разных разработчиков).

ч.3 СПИиВТ.pptx