47ecc6ec5b90a91949ab30688d09a9e9.ppt

- Количество слайдов: 13

Distributed analysis challenge test: en el Tier 2 Español de ATLAS S. González de la Hoz IFIC – Institut de Física Corpuscular de València VI Reunión presencial del Tier 2 Español Distribuido de ATLAS Barcelona, 27 -Noviembre-2008

Resumen reunión de análisis 20 -Nov por EVO (asistentes Pablo, Jordi, Santi) o Índice: Objetivos n Herramientas usadas en los test y resultados de dichos test n Expansión a otras “clouds” n http: //indico. cern. ch/conference. Display. py? conf. Id=45718 Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 2

Objetivos o Validación de los centros y de la “cloud” a la hora de hacer análisis de datos n Los trabajos de Monte Carlo son diferentes a los de análisis. o o Un sitio puede estar funcionando bastante bien con los trabajos de MC pero podría tener un rendimiento pobre para los de análisis Identificar los puntos conflictivos y los cuellos de botellas en el centro y/o “cloud”. Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 3

Herramientas utilizadas o Utilizan Ganga n n o Enviar trabajos a los diferentes centros Monitorizar el estado de dichos trabajos permitiéndoles hacer un informe cuando ellos acaben Código real de análisis utilizados por los físicos n Primeras semanas mismos trabajos a todo el mundo o o Ganga LCG backend n o Munon Analysis algorithm y mismos Datasets WMS (CE) Poxis I/O y “Copy” mode Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 4

Los tests o Identificación de la aplicación(es) para correr los tests n Primer test con un algoritmo de análisis común (muones) o n n n Futuros tests con algoritmos de análisis usados por los físicos de los centros Replicar los datasets en la “cloud” Preparar los trabajos de análisis y hacer pequeños tests de validación Enviar los trabajos al WMS o Decidir colas donde correrán los trabajos y prioridades n n Actualmente los trabajos se envían al Ganga LCG backend (en el futuro funcionará corriendo sobre Panda ANALY_*queues) o n No tenemos colas dedicadas exclusivamente al análisis. ¿Y si están llenas las colas? Los trabajos de Ganga recogen estadística El output de los trabajos (correrán con el rol de usuario, caso real ) se copiarán en el ATLASUSERDISK spacetoken? ? ? Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 5

Resultados de los tests http: //indico. cern. ch/get. File. py/access? contrib. Id=0&res. Id=0&material. Id=slides&conf. Id=45718 o o Empezaron a correr estos tests en las clouds IT y DE hace un mes 2 -5 usuarios enviaron un análisis de muones sobre AODs tanto a la nube IT como DE. n n o 200 trabajos enviados por usuario, en total 1000 por centro Los trabajos leían directamente los datos del SE usando poxis I/0 Ellos produjeron una serie de métricas: n De rendimiento: o n Éxito/fallo rate, CPU/Walltime, Sucesos por segundo Clasificación de errores o Diferentes errores I/O Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 6

Resultado de los tests: o Los Tier 2 saturaron su network a 1 Gb. n n n o o Si asumimos 0. 2 MB por suceso, a 1 Gb de conexión se puede sacar “stream” a 640 HZ. Con 200 CPUs, se observó y se esperaba ~3 Hz. 15 HZ hubiera sido lo deseado En el IFIC, nuestros dos servidores de disco cada uno a 1 Gb y nuestros trabajadores cada uno también a 1 Gb. (Switch cisco 4500) Descubrieron en un Tier 2 y switch que funcionaba mal Encontraron un fallo en athena Twiki: https: //twiki. cern. ch/twiki/bin/view/Main/Ganga. Site. Tests Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 7

Expansión a otras “clouds” o Participación activa de la gente en la “cloud” n Contacto de la Cloud o o n Contactos de los centros o n n n Les dice a Johannes y Danniel los centros listos para testear Coordinación de los centros antes y después de los tests. Los tests y los plots se producen de forma centralizada pero para ello, para digerir toda la información se necesitan expertos en cada centro, sobre todo para entender posibles errores. Estar en el Tierof. ATLAS (ganga utiliza este fichero al igual que dq 2) Espacio en disco algunos GB Objetivos o o Inicialmente una eficiencia del 80% con una media de 15 Hz por trabajo Ideal: 95% con una media de 20 Hz Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 8

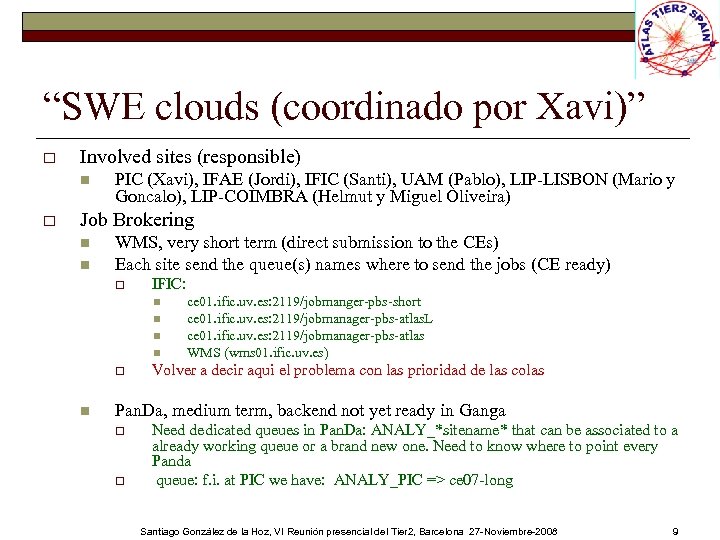

“SWE clouds (coordinado por Xavi)” o Involved sites (responsible) n o PIC (Xavi), IFAE (Jordi), IFIC (Santi), UAM (Pablo), LIP-LISBON (Mario y Goncalo), LIP-COIMBRA (Helmut y Miguel Oliveira) Job Brokering n n WMS, very short term (direct submission to the CEs) Each site send the queue(s) names where to send the jobs (CE ready) o IFIC: n n o n ce 01. ific. uv. es: 2119/jobmanger-pbs-short ce 01. ific. uv. es: 2119/jobmanager-pbs-atlas. L ce 01. ific. uv. es: 2119/jobmanager-pbs-atlas WMS (wms 01. ific. uv. es) Volver a decir aqui el problema con las prioridad de las colas Pan. Da, medium term, backend not yet ready in Ganga o o Need dedicated queues in Pan. Da: ANALY_*sitename* that can be associated to a already working queue or a brand new one. Need to know where to point every Panda queue: f. i. at PIC we have: ANALY_PIC => ce 07 -long Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 9

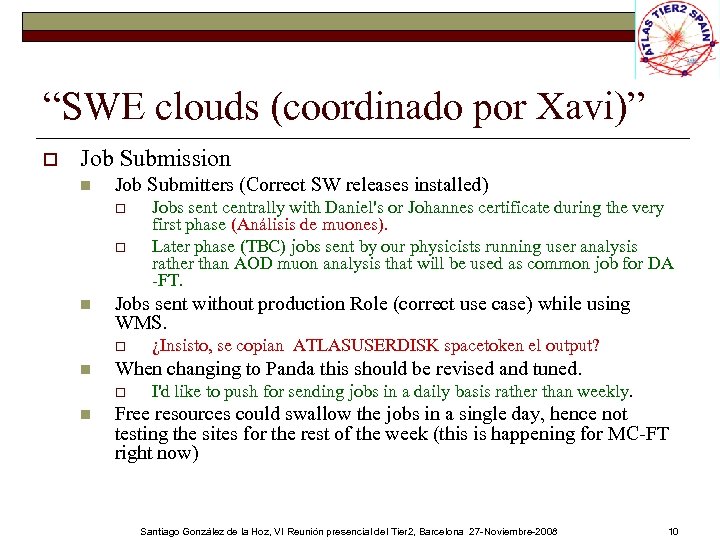

“SWE clouds (coordinado por Xavi)” o Job Submission n Job Submitters (Correct SW releases installed) o o n Jobs sent without production Role (correct use case) while using WMS. o n ¿Insisto, se copian ATLASUSERDISK spacetoken el output? When changing to Panda this should be revised and tuned. o n Jobs sent centrally with Daniel's or Johannes certificate during the very first phase (Análisis de muones). Later phase (TBC) jobs sent by our physicists running user analysis rather than AOD muon analysis that will be used as common job for DA -FT. I'd like to push for sending jobs in a daily basis rather than weekly. Free resources could swallow the jobs in a single day, hence not testing the sites for the rest of the week (this is happening for MC-FT right now) Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 10

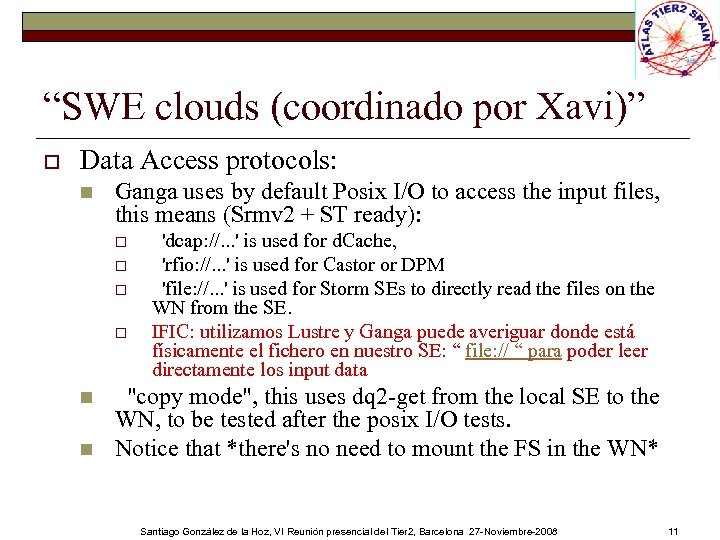

“SWE clouds (coordinado por Xavi)” o Data Access protocols: n Ganga uses by default Posix I/O to access the input files, this means (Srmv 2 + ST ready): o o n n 'dcap: //. . . ' is used for d. Cache, 'rfio: //. . . ' is used for Castor or DPM 'file: //. . . ' is used for Storm SEs to directly read the files on the WN from the SE. IFIC: utilizamos Lustre y Ganga puede averiguar donde está físicamente el fichero en nuestro SE: “ file: // “ para poder leer directamente los input data "copy mode", this uses dq 2 -get from the local SE to the WN, to be tested after the posix I/O tests. Notice that *there's no need to mount the FS in the WN* Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 11

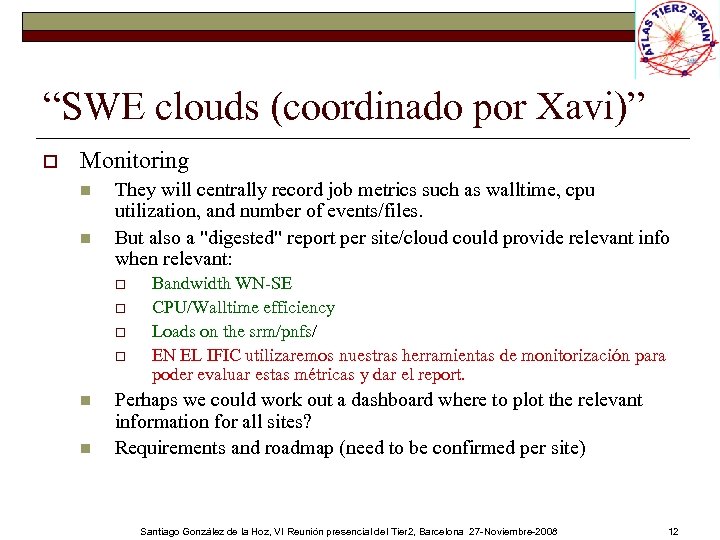

“SWE clouds (coordinado por Xavi)” o Monitoring n n They will centrally record job metrics such as walltime, cpu utilization, and number of events/files. But also a "digested" report per site/cloud could provide relevant info when relevant: o o n n Bandwidth WN-SE CPU/Walltime efficiency Loads on the srm/pnfs/ EN EL IFIC utilizaremos nuestras herramientas de monitorización para poder evaluar estas métricas y dar el report. Perhaps we could work out a dashboard where to plot the relevant information for all sites? Requirements and roadmap (need to be confirmed per site) Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 12

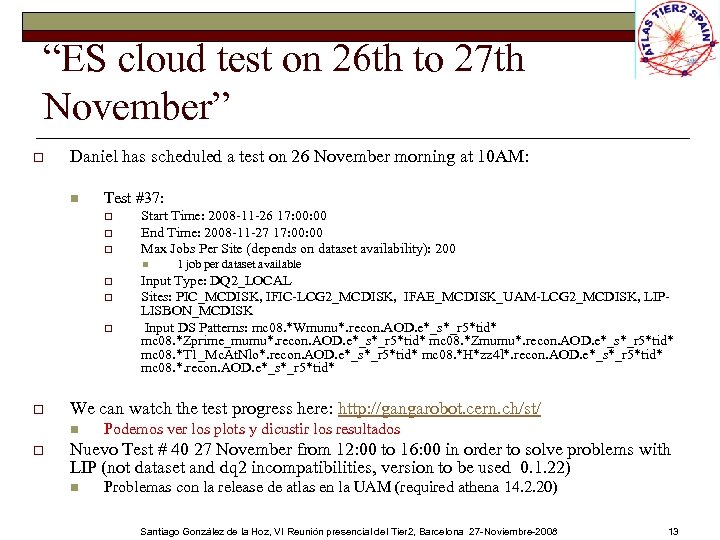

“ES cloud test on 26 th to 27 th November” o Daniel has scheduled a test on 26 November morning at 10 AM: n Test #37: o o o Start Time: 2008 -11 -26 17: 00 End Time: 2008 -11 -27 17: 00 Max Jobs Per Site (depends on dataset availability): 200 n o o Input Type: DQ 2_LOCAL Sites: PIC_MCDISK, IFIC-LCG 2_MCDISK, IFAE_MCDISK_UAM-LCG 2_MCDISK, LIPLISBON_MCDISK Input DS Patterns: mc 08. *Wmunu*. recon. AOD. e*_s*_r 5*tid* mc 08. *Zprime_mumu*. recon. AOD. e*_s*_r 5*tid* mc 08. *Zmumu*. recon. AOD. e*_s*_r 5*tid* mc 08. *T 1_Mc. At. Nlo*. recon. AOD. e*_s*_r 5*tid* mc 08. *H*zz 4 l*. recon. AOD. e*_s*_r 5*tid* mc 08. *. recon. AOD. e*_s*_r 5*tid* We can watch the test progress here: http: //gangarobot. cern. ch/st/ n o 1 job per dataset available Podemos ver los plots y dicustir los resultados Nuevo Test # 40 27 November from 12: 00 to 16: 00 in order to solve problems with LIP (not dataset and dq 2 incompatibilities, version to be used 0. 1. 22) n Problemas con la release de atlas en la UAM (required athena 14. 2. 20) Santiago González de la Hoz, VI Reunión presencial del Tier 2, Barcelona 27 -Noviembre-2008 13

47ecc6ec5b90a91949ab30688d09a9e9.ppt