Презентация Data Mining.ppt

- Количество слайдов: 34

Data Mining 1

Data Mining 1

Определение Gartner Group Data Mining (DM)− это процесс, цель которого − обнаружить новые значимые корреляции, образцы и тенденции в результате просеивания большого объема хранимых данных с использованием методик распознавания образцов плюс применение статистических и математических методов. 2

Определение Gartner Group Data Mining (DM)− это процесс, цель которого − обнаружить новые значимые корреляции, образцы и тенденции в результате просеивания большого объема хранимых данных с использованием методик распознавания образцов плюс применение статистических и математических методов. 2

Важное положение Data Mining Нетривиальность (нестандартность и неочевидность) разыскиваемых алгоритмов (шаблонов). Это означает, что найденные шаблоны должны отражать неочевидные, неожиданные регулярности в данных, составляющие так называемые скрытые знания (hidden knowledge). Иными словами, средства DM отличаются от инструментов статистической обработки данных тем, что вместо проверки заранее предполагаемых пользователями взаимозависимостей они на основании имеющихся данных способны находить такие взаимозависимости самостоятельно и строить гипотезы об их характере. 3

Важное положение Data Mining Нетривиальность (нестандартность и неочевидность) разыскиваемых алгоритмов (шаблонов). Это означает, что найденные шаблоны должны отражать неочевидные, неожиданные регулярности в данных, составляющие так называемые скрытые знания (hidden knowledge). Иными словами, средства DM отличаются от инструментов статистической обработки данных тем, что вместо проверки заранее предполагаемых пользователями взаимозависимостей они на основании имеющихся данных способны находить такие взаимозависимости самостоятельно и строить гипотезы об их характере. 3

Системы для визуализации многомерных данных Алгоритмы ограниченного перебора Предметноориентированные аналитические системы Статистические пакеты Data Mining Нейронные сети Системы рассуждений на основе аналогич – ных случаев Генетические алгоритмы Эволюционное программирование Деревья решений

Системы для визуализации многомерных данных Алгоритмы ограниченного перебора Предметноориентированные аналитические системы Статистические пакеты Data Mining Нейронные сети Системы рассуждений на основе аналогич – ных случаев Генетические алгоритмы Эволюционное программирование Деревья решений

5

5

Предметно-ориентированные аналитические системы очень разнообразны. Наиболее широкий подкласс таких систем, получивший распространение в области исследования финансовых рынков, носит название «технический анализ» . «Технический анализ» представляет собой совокупность нескольких десятков методов прогноза динамики цен и выбора оптимальной структуры инвестиционного портфеля, основанных на различных эмпирических моделях динамики рынка. Эти методы часто используют несложный статистический аппарат, но максимально учитывают сложившуюся в своей области специфику (профессиональный язык, системы различных индексов и пр. ). 6

Предметно-ориентированные аналитические системы очень разнообразны. Наиболее широкий подкласс таких систем, получивший распространение в области исследования финансовых рынков, носит название «технический анализ» . «Технический анализ» представляет собой совокупность нескольких десятков методов прогноза динамики цен и выбора оптимальной структуры инвестиционного портфеля, основанных на различных эмпирических моделях динамики рынка. Эти методы часто используют несложный статистический аппарат, но максимально учитывают сложившуюся в своей области специфику (профессиональный язык, системы различных индексов и пр. ). 6

7

7

Последние версии почти всех известных статистических пакетов включают наряду с традиционными статистическими методами также элементы Data Mining. Но основное внимание в них уделяется все же классическим методикам — корреляционному, регрессионному, факторному анализу и др. 8

Последние версии почти всех известных статистических пакетов включают наряду с традиционными статистическими методами также элементы Data Mining. Но основное внимание в них уделяется все же классическим методикам — корреляционному, регрессионному, факторному анализу и др. 8

Недостатки статистических пакетов: • требование к специальной подготовке пользователя; • мощные современные статистические пакеты являются слишком «тяжеловесными» для массового применения в финансах и бизнесе; • часто эти системы весьма дороги (от $1000 до $15000); • большинство методов, входящих в состав пакетов, опираются на статистическую парадигму, которая базируется на усредненных характеристиках выборки. А эти характеристики при исследовании реальных сложных феноменов часто являются фиктивными величинами. 9

Недостатки статистических пакетов: • требование к специальной подготовке пользователя; • мощные современные статистические пакеты являются слишком «тяжеловесными» для массового применения в финансах и бизнесе; • часто эти системы весьма дороги (от $1000 до $15000); • большинство методов, входящих в состав пакетов, опираются на статистическую парадигму, которая базируется на усредненных характеристиках выборки. А эти характеристики при исследовании реальных сложных феноменов часто являются фиктивными величинами. 9

10

10

Обычно под нейронными сетями понимается набор нейронов, соединенных друг с другом каналами обмена информацией для их совместной работы. Когда применяют нейронные сети, встает вопрос выбора конкретной архитектуры сети. Размер и структура сети должны соответствовать существу исследуемого явления. Поскольку на начальном этапе анализа природа явления обычно известна плохо, выбор архитектуры является непростой задачей и часто связан с длительным процессом «проб и ошибок» .

Обычно под нейронными сетями понимается набор нейронов, соединенных друг с другом каналами обмена информацией для их совместной работы. Когда применяют нейронные сети, встает вопрос выбора конкретной архитектуры сети. Размер и структура сети должны соответствовать существу исследуемого явления. Поскольку на начальном этапе анализа природа явления обычно известна плохо, выбор архитектуры является непростой задачей и часто связан с длительным процессом «проб и ошибок» .

Построенная сеть подвергается процессу так называемого обучения. На этом этапе нейроны сети итеративно обрабатывают входные данные и корректируют свои веса так, чтобы сеть наилучшим образом прогнозировала данные, на которых выполняется «обучение» . После обучения на имеющихся данных сеть готова к работе и может использоваться для построения прогнозов. Иногда нейронные сети выдают прогноз очень высокого качества, однако они представляют собой типичный пример нетеоретического подхода к исследованию. При таком подходе сосредотачиваются исключительно на фактическом результате, в данном случае на точности прогнозов и их прикладной ценности, а не на сути механизмов, лежащих в основе явления или соответствии полученных результатов какой-либо имеющейся теории. 12

Построенная сеть подвергается процессу так называемого обучения. На этом этапе нейроны сети итеративно обрабатывают входные данные и корректируют свои веса так, чтобы сеть наилучшим образом прогнозировала данные, на которых выполняется «обучение» . После обучения на имеющихся данных сеть готова к работе и может использоваться для построения прогнозов. Иногда нейронные сети выдают прогноз очень высокого качества, однако они представляют собой типичный пример нетеоретического подхода к исследованию. При таком подходе сосредотачиваются исключительно на фактическом результате, в данном случае на точности прогнозов и их прикладной ценности, а не на сути механизмов, лежащих в основе явления или соответствии полученных результатов какой-либо имеющейся теории. 12

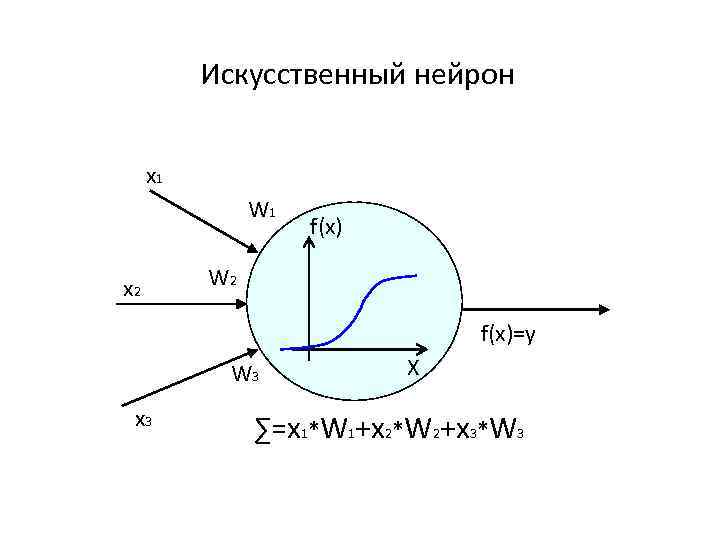

Искусственный нейрон имитирует в первом приближении свойства биологического нейрона. На вход искусственного нейрона поступает некоторое множество сигналов (x 1, x 2 , x 3), каждый из которых является выходом другого нейрона. Каждый вход умножается на соответствующий вес (W 1, W 2, W 3), аналогичный синаптической силе, и все произведения суммируются, определяя уровень активации нейрона. На следующем слайде представлена модель, реализующая эту идею. 13

Искусственный нейрон имитирует в первом приближении свойства биологического нейрона. На вход искусственного нейрона поступает некоторое множество сигналов (x 1, x 2 , x 3), каждый из которых является выходом другого нейрона. Каждый вход умножается на соответствующий вес (W 1, W 2, W 3), аналогичный синаптической силе, и все произведения суммируются, определяя уровень активации нейрона. На следующем слайде представлена модель, реализующая эту идею. 13

Искусственный нейрон x 1 W 1 x 2 f(x) W 2 f(x)=y W 3 x 3 X ∑=x 1*W 1+x 2*W 2+x 3*W 3

Искусственный нейрон x 1 W 1 x 2 f(x) W 2 f(x)=y W 3 x 3 X ∑=x 1*W 1+x 2*W 2+x 3*W 3

15

15

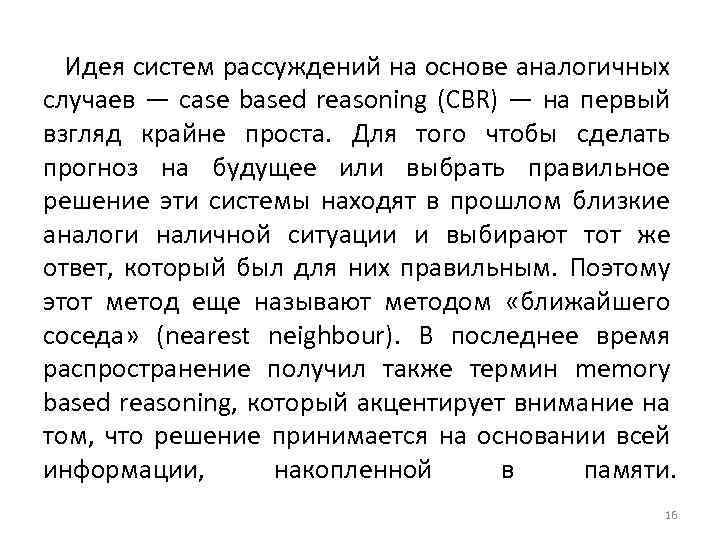

Идея систем рассуждений на основе аналогичных случаев — case based reasoning (CBR) — на первый взгляд крайне проста. Для того чтобы сделать прогноз на будущее или выбрать правильное решение эти системы находят в прошлом близкие аналоги наличной ситуации и выбирают тот же ответ, который был для них правильным. Поэтому этот метод еще называют методом «ближайшего соседа» (nearest neighbour). В последнее время распространение получил также термин memory based reasoning, который акцентирует внимание на том, что решение принимается на основании всей информации, накопленной в памяти. 16

Идея систем рассуждений на основе аналогичных случаев — case based reasoning (CBR) — на первый взгляд крайне проста. Для того чтобы сделать прогноз на будущее или выбрать правильное решение эти системы находят в прошлом близкие аналоги наличной ситуации и выбирают тот же ответ, который был для них правильным. Поэтому этот метод еще называют методом «ближайшего соседа» (nearest neighbour). В последнее время распространение получил также термин memory based reasoning, который акцентирует внимание на том, что решение принимается на основании всей информации, накопленной в памяти. 16

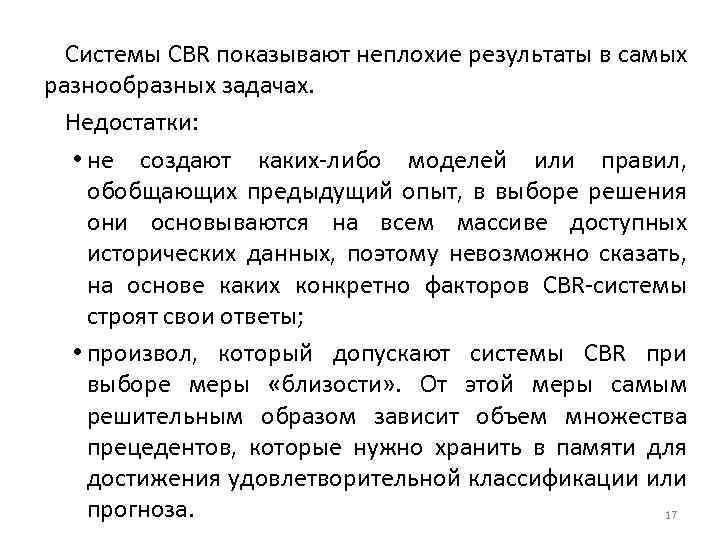

Системы CBR показывают неплохие результаты в самых разнообразных задачах. Недостатки: • не создают каких-либо моделей или правил, обобщающих предыдущий опыт, в выборе решения они основываются на всем массиве доступных исторических данных, поэтому невозможно сказать, на основе каких конкретно факторов CBR-системы строят свои ответы; • произвол, который допускают системы CBR при выборе меры «близости» . От этой меры самым решительным образом зависит объем множества прецедентов, которые нужно хранить в памяти для достижения удовлетворительной классификации или прогноза. 17

Системы CBR показывают неплохие результаты в самых разнообразных задачах. Недостатки: • не создают каких-либо моделей или правил, обобщающих предыдущий опыт, в выборе решения они основываются на всем массиве доступных исторических данных, поэтому невозможно сказать, на основе каких конкретно факторов CBR-системы строят свои ответы; • произвол, который допускают системы CBR при выборе меры «близости» . От этой меры самым решительным образом зависит объем множества прецедентов, которые нужно хранить в памяти для достижения удовлетворительной классификации или прогноза. 17

18

18

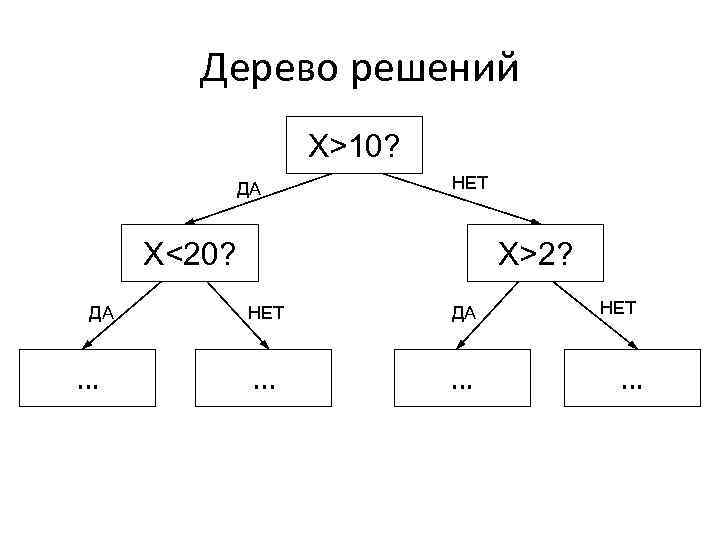

Деревья решений (decision trees) являются одним из наиболее популярных подходов к решению задач Data Mining. Они создают иерархическую структуру, классифицирующие правила типа «ЕСЛИ. . . ТО. . . » (if…then), имеющую вид дерева. Для принятия решения, к какому классу отнести некоторый объект или ситуацию, требуется ответить на вопросы, стоящие в узлах этого дерева. 19

Деревья решений (decision trees) являются одним из наиболее популярных подходов к решению задач Data Mining. Они создают иерархическую структуру, классифицирующие правила типа «ЕСЛИ. . . ТО. . . » (if…then), имеющую вид дерева. Для принятия решения, к какому классу отнести некоторый объект или ситуацию, требуется ответить на вопросы, стоящие в узлах этого дерева. 19

Дерево решений X>10? ДА НЕТ X<20? ДА … X>2? НЕТ ДА . . . … НЕТ …

Дерево решений X>10? ДА НЕТ X<20? ДА … X>2? НЕТ ДА . . . … НЕТ …

Популярность подхода связана с наглядностью и понятностью. Но деревья решений принципиально не способны находить «лучшие» (наиболее полные и точные) правила в данных. Они реализуют наивный принцип последовательного просмотра признаков и «цепляют» фактически осколки настоящих закономерностей, создавая лишь иллюзию логического вывода. 21

Популярность подхода связана с наглядностью и понятностью. Но деревья решений принципиально не способны находить «лучшие» (наиболее полные и точные) правила в данных. Они реализуют наивный принцип последовательного просмотра признаков и «цепляют» фактически осколки настоящих закономерностей, создавая лишь иллюзию логического вывода. 21

22

22

В данное время эволюционное программирование является наиболее молодой и одной из многообещающих технологий Data Mining. Основная идея метода состоит в формировании гипотез о зависимости целевой переменной от других переменных в виде автоматически синтезируемых специальным модулем программ на внутреннем языке программирования. Использование универсального языка программирования теоретически позволяет выразить любую зависимость, причем вид этой зависимости заранее не известен. 23

В данное время эволюционное программирование является наиболее молодой и одной из многообещающих технологий Data Mining. Основная идея метода состоит в формировании гипотез о зависимости целевой переменной от других переменных в виде автоматически синтезируемых специальным модулем программ на внутреннем языке программирования. Использование универсального языка программирования теоретически позволяет выразить любую зависимость, причем вид этой зависимости заранее не известен. 23

Процесс производства внутренних программ организуется как эволюция в пространстве программ, в некотором роде напоминающая генетические алгоритмы. Когда система находит перспективную гипотезу, описывающую исследуемую зависимость достаточно хорошо по целому ряду критериев, в работу включается механизм так называемых "обобщенных преобразований" (GT-search). С помощью этого механизма в "хорошую" программу вводятся незначительные модификации, не ухудшающие ее качество, и производится отбор лучшей дочерней программы. К новой популяции затем опять применяются механизмы синтеза новых программ, 24 и этот процесс рекурсивно повторяется.

Процесс производства внутренних программ организуется как эволюция в пространстве программ, в некотором роде напоминающая генетические алгоритмы. Когда система находит перспективную гипотезу, описывающую исследуемую зависимость достаточно хорошо по целому ряду критериев, в работу включается механизм так называемых "обобщенных преобразований" (GT-search). С помощью этого механизма в "хорошую" программу вводятся незначительные модификации, не ухудшающие ее качество, и производится отбор лучшей дочерней программы. К новой популяции затем опять применяются механизмы синтеза новых программ, 24 и этот процесс рекурсивно повторяется.

Процесс производства внутренних Таким образом, система создает некоторое число программ генетических линий программ, конкурирующих друг с другом по точности, статистической значимости и Перспективная простоте выражения зависимости. гипотеза Механизмы синтеза Отбор Механизм «Обобщенных преобразова – ний » Незначительные модификации

Процесс производства внутренних Таким образом, система создает некоторое число программ генетических линий программ, конкурирующих друг с другом по точности, статистической значимости и Перспективная простоте выражения зависимости. гипотеза Механизмы синтеза Отбор Механизм «Обобщенных преобразова – ний » Незначительные модификации

26

26

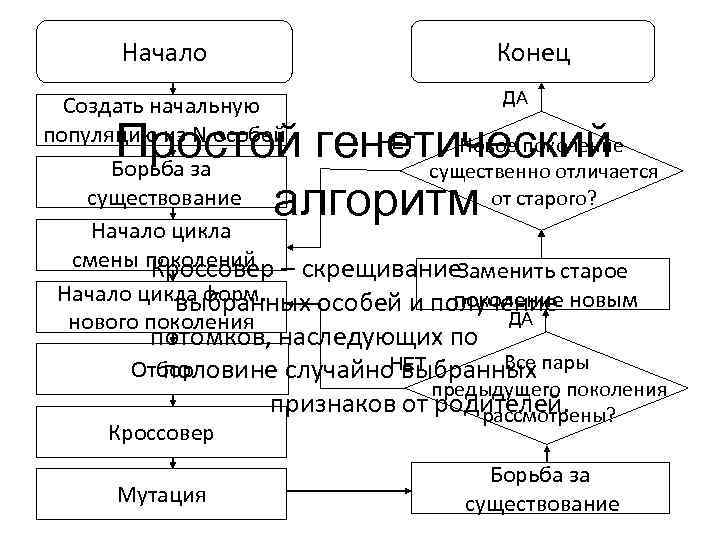

Первый шаг при построении генетических алгоритмов - это кодировка исходных логических закономерностей в базе данных, которые именуют хромосомами. Далее для реализации концепции отбора вводится способ сопоставления различных хромосом. Популяция обрабатывается с помощью процедур репродукции, изменчивости (мутаций), генетической композиции. В ходе работы процедур на каждой стадии эволюции получаются популяции со все более совершенными индивидуумами. Генетические алгоритмы удобны тем, что их легко распараллеливать. 27

Первый шаг при построении генетических алгоритмов - это кодировка исходных логических закономерностей в базе данных, которые именуют хромосомами. Далее для реализации концепции отбора вводится способ сопоставления различных хромосом. Популяция обрабатывается с помощью процедур репродукции, изменчивости (мутаций), генетической композиции. В ходе работы процедур на каждой стадии эволюции получаются популяции со все более совершенными индивидуумами. Генетические алгоритмы удобны тем, что их легко распараллеливать. 27

Недостатки генетических алгоритмов: • критерий отбора хромосом и используемые процедуры являются эвристическими и далеко не гарантируют нахождения "лучшего" решения; • как и в реальной жизни, эволюцию может "заклинить" на какой-либо непродуктивной ветви. (И, наоборот, можно привести примеры, как два неперспективных родителя, которые будут исключены из эволюции генетическим алгоритмом, оказываются способными произвести высокоэффективного потомка. Это особенно становится заметно при решении высокоразмерных задач со сложными внутренними связями. ) 28

Недостатки генетических алгоритмов: • критерий отбора хромосом и используемые процедуры являются эвристическими и далеко не гарантируют нахождения "лучшего" решения; • как и в реальной жизни, эволюцию может "заклинить" на какой-либо непродуктивной ветви. (И, наоборот, можно привести примеры, как два неперспективных родителя, которые будут исключены из эволюции генетическим алгоритмом, оказываются способными произвести высокоэффективного потомка. Это особенно становится заметно при решении высокоразмерных задач со сложными внутренними связями. ) 28

Начало Конец ДА Создать начальную популяцию из N особей НЕТ Новое поколение Борьба за существенно отличается существование от старого? Начало цикла смены поколений Кроссовер – скрещивание Заменить старое Начало цикла форм. поколение новым выбранных особей и получение ДА нового поколения Простой генетический алгоритм потомков, наследующих по Все пары НЕТ Отбор половине случайно выбранных предыдущего поколения признаков от родителей. рассмотрены? Кроссовер Мутация Борьба за существование

Начало Конец ДА Создать начальную популяцию из N особей НЕТ Новое поколение Борьба за существенно отличается существование от старого? Начало цикла смены поколений Кроссовер – скрещивание Заменить старое Начало цикла форм. поколение новым выбранных особей и получение ДА нового поколения Простой генетический алгоритм потомков, наследующих по Все пары НЕТ Отбор половине случайно выбранных предыдущего поколения признаков от родителей. рассмотрены? Кроссовер Мутация Борьба за существование

30

30

Алгоритмы ограниченного перебора были предложены в середине 60 -х годов М. М. Бонгардом для поиска логических закономерностей в данных. Эти алгоритмы вычисляют частоты комбинаций простых логических событий в подгруппах данных. Примеры простых логических событий: X = a; X < a; X > a; a < X < b и др. , где X - какой либо параметр, "a" и "b" - константы. Ограничением служит длина комбинации простых логических событий (у М. Бонгарда она была равна 3). На основании анализа вычисленных частот делается заключение о полезности той или иной комбинации для установления ассоциации в данных, для классификации, прогнозирования и пр. 31

Алгоритмы ограниченного перебора были предложены в середине 60 -х годов М. М. Бонгардом для поиска логических закономерностей в данных. Эти алгоритмы вычисляют частоты комбинаций простых логических событий в подгруппах данных. Примеры простых логических событий: X = a; X < a; X > a; a < X < b и др. , где X - какой либо параметр, "a" и "b" - константы. Ограничением служит длина комбинации простых логических событий (у М. Бонгарда она была равна 3). На основании анализа вычисленных частот делается заключение о полезности той или иной комбинации для установления ассоциации в данных, для классификации, прогнозирования и пр. 31

32

32

В той или иной мере средства для графического отображения данных поддерживаются всеми системами Data Mining. Вместе с тем, весьма внушительную долю рынка занимают системы, специализирующиеся исключительно на этой функции. Примером здесь может служить программа Data. Miner 3 D словацкой фирмы Dimension 5 (5 -е измерение). В подобных системах основное внимание сконцентрировано на дружелюбности пользовательского интерфейса, позволяющего ассоциировать с анализируемыми показателями различные параметры диаграммы рассеивания объектов (записей) базы данных. К таким параметрам относятся цвет, форма, ориентация относительно собственной оси, размеры и другие свойства графических элементов изображения. Кроме того, системы визуализации данных снабжены удобными средствами для масштабирования и вращения изображений. Стоимость систем визуализации может достигать нескольких сотен долларов. 33

В той или иной мере средства для графического отображения данных поддерживаются всеми системами Data Mining. Вместе с тем, весьма внушительную долю рынка занимают системы, специализирующиеся исключительно на этой функции. Примером здесь может служить программа Data. Miner 3 D словацкой фирмы Dimension 5 (5 -е измерение). В подобных системах основное внимание сконцентрировано на дружелюбности пользовательского интерфейса, позволяющего ассоциировать с анализируемыми показателями различные параметры диаграммы рассеивания объектов (записей) базы данных. К таким параметрам относятся цвет, форма, ориентация относительно собственной оси, размеры и другие свойства графических элементов изображения. Кроме того, системы визуализации данных снабжены удобными средствами для масштабирования и вращения изображений. Стоимость систем визуализации может достигать нескольких сотен долларов. 33

Источники: https: //sites. google. com/site/upravlenieznaniami/tehnologiiupravlenia-znaniami/data-mining http: //www. arshinov 74. ru/files/10. pdf http: //gendocs. ru/v 21458/? cc=1&page=6#513006 http: //www. uran. donetsk. ua/~masters/2006/fvti/ichernov/diss/i ndex. htm#gr_per http: //lc. kubagro. ru/aidos 04/1. 3. 6. htm 34

Источники: https: //sites. google. com/site/upravlenieznaniami/tehnologiiupravlenia-znaniami/data-mining http: //www. arshinov 74. ru/files/10. pdf http: //gendocs. ru/v 21458/? cc=1&page=6#513006 http: //www. uran. donetsk. ua/~masters/2006/fvti/ichernov/diss/i ndex. htm#gr_per http: //lc. kubagro. ru/aidos 04/1. 3. 6. htm 34