ДАННЫЕ И ИНФОРМАЦИЯ

ДАННЫЕ И ИНФОРМАЦИЯ

Данные и информация Данные – зарегистрированные каким-либо способом сигналы. Информация – это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые воспринимают информационные системы (живые организмы, управляющие машины, технические системы и др. )

Данные и информация Данные – зарегистрированные каким-либо способом сигналы. Информация – это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые воспринимают информационные системы (живые организмы, управляющие машины, технические системы и др. )

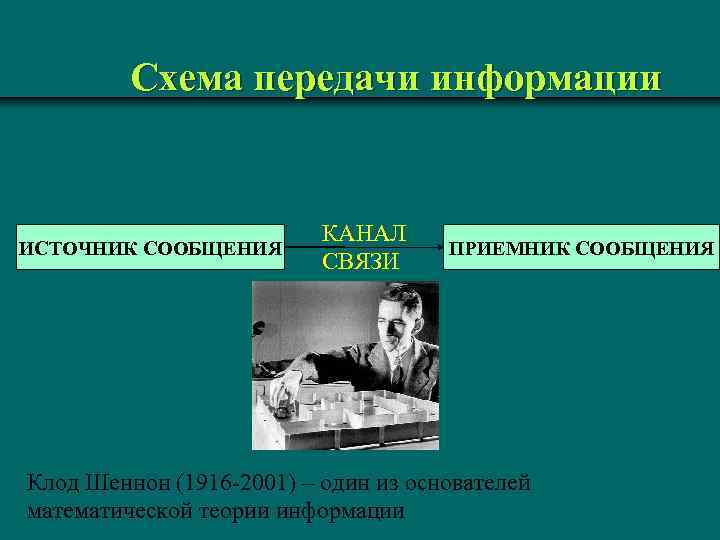

Схема передачи информации ИСТОЧНИК СООБЩЕНИЯ КАНАЛ СВЯЗИ ПРИЕМНИК СООБЩЕНИЯ Клод Шеннон (1916 -2001) – один из основателей математической теории информации

Схема передачи информации ИСТОЧНИК СООБЩЕНИЯ КАНАЛ СВЯЗИ ПРИЕМНИК СООБЩЕНИЯ Клод Шеннон (1916 -2001) – один из основателей математической теории информации

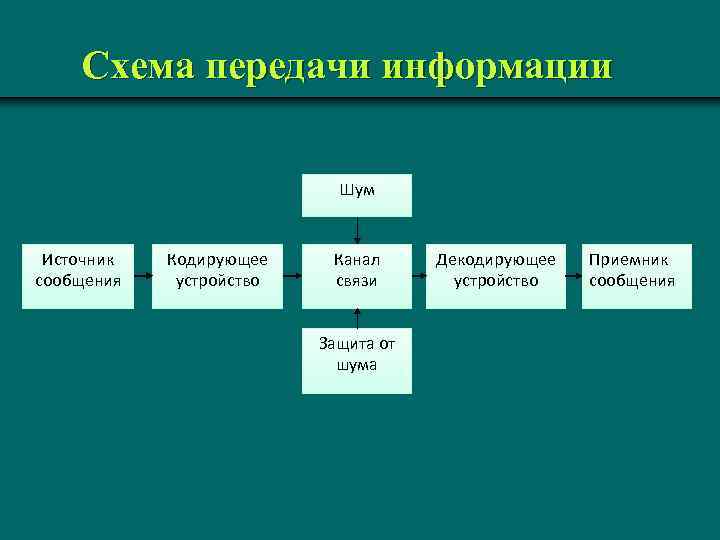

Схема передачи информации Шум Источник сообщения Кодирующее устройство Канал связи Защита от шума Декодирующее устройство Приемник сообщения

Схема передачи информации Шум Источник сообщения Кодирующее устройство Канал связи Защита от шума Декодирующее устройство Приемник сообщения

Свойства информации v объективность и субъективность; v полнота; v достоверность; v доступность; v полезность; v актуальность.

Свойства информации v объективность и субъективность; v полнота; v достоверность; v доступность; v полезность; v актуальность.

Количественное определение информации. Ø Информацию, содержащуюся в сообщении, можно количественно определить по тому насколько она была новой, неожиданной, т. е. ранее неизвестной. Сколько информации поступает приеме 1 символа алфавита?

Количественное определение информации. Ø Информацию, содержащуюся в сообщении, можно количественно определить по тому насколько она была новой, неожиданной, т. е. ранее неизвестной. Сколько информации поступает приеме 1 символа алфавита?

Мера информации Объемный подход 21, XXI, «двадцать один» , 10101 21 – объем данных 2 дит; 10101 – объем данных 5 бит. Подходы к определению количества информации: • объемный; • энтропийный или статистический; • алгоритмический. Производные единицы измерения в двоичной системе счисления Ø 1 байт = 8 бит Ø 1 Килобайт (Кбайт) = 1024 байт = 210 байт Ø 1 Мегабайт (Мбайт) = 1024 Кбайт = 220 байт Ø 1 Гигабайт (Гбайт) = 1024 Мбайт = 230 байт Ø 1 Терабайт (Тбайт) = 1024 Гбайт = 240 байт Ø 1 Петабайт (Пбайт) = 1024 Тбайт = 250 байт Bit – binary digit (введено в 1946 г. Д. Тьюки для обозначения двоичного разряда)

Мера информации Объемный подход 21, XXI, «двадцать один» , 10101 21 – объем данных 2 дит; 10101 – объем данных 5 бит. Подходы к определению количества информации: • объемный; • энтропийный или статистический; • алгоритмический. Производные единицы измерения в двоичной системе счисления Ø 1 байт = 8 бит Ø 1 Килобайт (Кбайт) = 1024 байт = 210 байт Ø 1 Мегабайт (Мбайт) = 1024 Кбайт = 220 байт Ø 1 Гигабайт (Гбайт) = 1024 Мбайт = 230 байт Ø 1 Терабайт (Тбайт) = 1024 Гбайт = 240 байт Ø 1 Петабайт (Пбайт) = 1024 Тбайт = 250 байт Bit – binary digit (введено в 1946 г. Д. Тьюки для обозначения двоичного разряда)

Энтропийный подход Количеством информации называют числовую характеристику сигнала, отражающую ту степень неопределенности (неполноту знаний), которая исчезает после получения сообщения в виде данного сигнала. Эту меру неопределенности в теории информации называют энтропией.

Энтропийный подход Количеством информации называют числовую характеристику сигнала, отражающую ту степень неопределенности (неполноту знаний), которая исчезает после получения сообщения в виде данного сигнала. Эту меру неопределенности в теории информации называют энтропией.

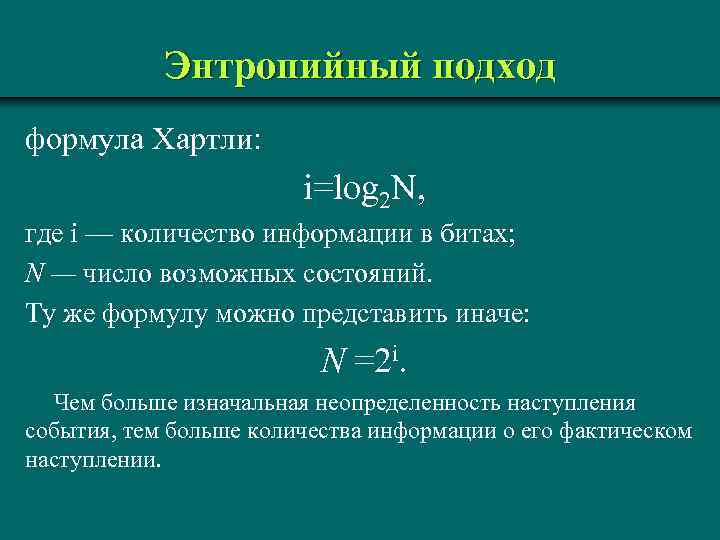

Энтропийный подход формула Хартли: i=log 2 N, где i — количество информации в битах; N — число возможных состояний. Ту же формулу можно представить иначе: N =2 i. Чем больше изначальная неопределенность наступления события, тем больше количества информации о его фактическом наступлении.

Энтропийный подход формула Хартли: i=log 2 N, где i — количество информации в битах; N — число возможных состояний. Ту же формулу можно представить иначе: N =2 i. Чем больше изначальная неопределенность наступления события, тем больше количества информации о его фактическом наступлении.

Понятие количества информации Формула Шеннона: Ø где pi – вероятность того, что именно i-е сообщение выделено из заданного множества сообщений N.

Понятие количества информации Формула Шеннона: Ø где pi – вероятность того, что именно i-е сообщение выделено из заданного множества сообщений N.

Понятие количества информации Пример. Пусть в непрозрачном мешке находится 10 шаров, из которых один черный и девять белых, тогда вероятность вытащить наугад белый шар равна p 1=0, 9, вероятность достать черный шар p 2=0, 1. Вынимая из мешка наугад один из шаров, получаем количество информации по формуле Шеннона: Если p 1=p 2=…=pi=…=p. N, то pi=1/N

Понятие количества информации Пример. Пусть в непрозрачном мешке находится 10 шаров, из которых один черный и девять белых, тогда вероятность вытащить наугад белый шар равна p 1=0, 9, вероятность достать черный шар p 2=0, 1. Вынимая из мешка наугад один из шаров, получаем количество информации по формуле Шеннона: Если p 1=p 2=…=pi=…=p. N, то pi=1/N