Л2_данные информация энтропия.ppt

- Количество слайдов: 8

Данные Данными называют информацию, когда делают акцент на том, что она поступает в качестве входных параметров некоторого алгоритма обработки. Данные – от слова “дано”, так же как в записи условия задачи мы записываем “дано” и “найти”. Этот термин часто употребляется, когда речь идет о компьютерных системах. Одни и те же данные, записанные в компьютерной памяти, могут быть отображены в зависимости от выбранной программы обработки или как графическая информация, или как символьная, или как звуковая, или как числовая. Данные – это любые зарегистрированные сигналы. Слово “информация” чаще используется в более узком смысле, чем просто все, что отражается в материальном объекте в результате воздействия на него другого материального объекта. Предполагается, что получение информации дает получившему ее возможность принимать решения, действовать, осуществлять выбор или пополнить (и/или реструктурировать) свою систему знаний. Если полученные данные не приводят ни к чему из перечисленного, то с субъективной точки зрения считается, что для получателя они информации не несут, хотя и занимают определенный объем его памяти.

Данные Данными называют информацию, когда делают акцент на том, что она поступает в качестве входных параметров некоторого алгоритма обработки. Данные – от слова “дано”, так же как в записи условия задачи мы записываем “дано” и “найти”. Этот термин часто употребляется, когда речь идет о компьютерных системах. Одни и те же данные, записанные в компьютерной памяти, могут быть отображены в зависимости от выбранной программы обработки или как графическая информация, или как символьная, или как звуковая, или как числовая. Данные – это любые зарегистрированные сигналы. Слово “информация” чаще используется в более узком смысле, чем просто все, что отражается в материальном объекте в результате воздействия на него другого материального объекта. Предполагается, что получение информации дает получившему ее возможность принимать решения, действовать, осуществлять выбор или пополнить (и/или реструктурировать) свою систему знаний. Если полученные данные не приводят ни к чему из перечисленного, то с субъективной точки зрения считается, что для получателя они информации не несут, хотя и занимают определенный объем его памяти.

Данные Говоря об информации и ее свойствах, обычно имеют в виду один из трех аспектов: • Технический - точность, надежность, скорость передачи сигналов, объем, занимаемый в памяти зарегистрированными сигналами, способы регистрации сигналов. В этом аспекте информация = данные, и никак не учитывается ее полезность для получателя или ее смысловое содержание. Это информация в самом широком общем для всей материи смысле, информация в аспекте восприятия, хранения, передачи. • Прагматический - насколько эффективно информация влияет на поведение получателя. В этом аспекте говорят о полезности и ценности информации. В определенных случаях ценность информации становится отрицательной, а сама информация становится дезинформацией. Это информация в аспекте управления поведением. • Семантический - передача смысла с помощью кодов. Семантической называется информация, активизирующая образы, уже имеющиеся в тезаурусе получателя (узнаваемая) или вносящая изменения в его тезаурус (систему знаний). Это информация в аспекте знаний.

Данные Говоря об информации и ее свойствах, обычно имеют в виду один из трех аспектов: • Технический - точность, надежность, скорость передачи сигналов, объем, занимаемый в памяти зарегистрированными сигналами, способы регистрации сигналов. В этом аспекте информация = данные, и никак не учитывается ее полезность для получателя или ее смысловое содержание. Это информация в самом широком общем для всей материи смысле, информация в аспекте восприятия, хранения, передачи. • Прагматический - насколько эффективно информация влияет на поведение получателя. В этом аспекте говорят о полезности и ценности информации. В определенных случаях ценность информации становится отрицательной, а сама информация становится дезинформацией. Это информация в аспекте управления поведением. • Семантический - передача смысла с помощью кодов. Семантической называется информация, активизирующая образы, уже имеющиеся в тезаурусе получателя (узнаваемая) или вносящая изменения в его тезаурус (систему знаний). Это информация в аспекте знаний.

Неопределенность, количество информации и энтропия Получение информации - необходимое условие для снятия неопределенности. Неопределенность возникает в ситуации выбора. Задача, которая решается в ходе снятия неопределенности – уменьшение количества рассматриваемых вариантов (уменьшение разнообразия), и в итоге выбор одного соответствующего ситуации варианта из числа возможных. Снятие неопределенности дает возможность принимать обоснованные решения и действовать. В этом управляющая роль информации. Представьте, что вы зашли в магазин и попросили продать вам жевательную резинку. Продавщица, у которой, скажем, 16 сортов жевательной резинки, находится в состоянии неопределенности. Она не может выполнить вашу просьбу без получения дополнительной информации. Если вы уточнили, скажем, - «Orbit» , и из 16 первоначальных вариантов продавщица рассматривает теперь только 8, вы уменьшили ее неопределенность в два раза (забегая вперед, скажем, что уменьшение неопределенности вдвое соответствует получению 1 бита информации). Если вы, просто указали пальцем на витрине, - «вот эту!» , то неопределенность была снята полностью. Опять же, забегая вперед, скажем, что этим жестом в данном примере вы сообщили продавщице 4 бита информации.

Неопределенность, количество информации и энтропия Получение информации - необходимое условие для снятия неопределенности. Неопределенность возникает в ситуации выбора. Задача, которая решается в ходе снятия неопределенности – уменьшение количества рассматриваемых вариантов (уменьшение разнообразия), и в итоге выбор одного соответствующего ситуации варианта из числа возможных. Снятие неопределенности дает возможность принимать обоснованные решения и действовать. В этом управляющая роль информации. Представьте, что вы зашли в магазин и попросили продать вам жевательную резинку. Продавщица, у которой, скажем, 16 сортов жевательной резинки, находится в состоянии неопределенности. Она не может выполнить вашу просьбу без получения дополнительной информации. Если вы уточнили, скажем, - «Orbit» , и из 16 первоначальных вариантов продавщица рассматривает теперь только 8, вы уменьшили ее неопределенность в два раза (забегая вперед, скажем, что уменьшение неопределенности вдвое соответствует получению 1 бита информации). Если вы, просто указали пальцем на витрине, - «вот эту!» , то неопределенность была снята полностью. Опять же, забегая вперед, скажем, что этим жестом в данном примере вы сообщили продавщице 4 бита информации.

Неопределенность, количество информации и энтропия Ситуация максимальной неопределенности предполагает наличие нескольких равновероятных альтернатив (вариантов), т. е. ни один из вариантов не является более предпочтительным. Причем, чем больше равновероятных вариантов наблюдается, тем больше неопределенность, тем сложнее сделать однозначный выбор и тем больше информации требуется для этого получить. Для N вариантов эта ситуация описывается следующим распределением вероятностей: {1/N, … 1/N}. Минимальная неопределенность равна 0, т. е. эта ситуация полной определенности, означающая что выбор сделан, и вся необходимая информация получена. Распределение вероятностей для ситуации полной определенности выглядит так: {1, 0, … 0}. Величина, характеризующая количество неопределенности в теории информации обозначается символом H и имеет название энтропия, точнее информационная энтропия. Энтропия (H) – мера неопределенности, выраженная в битах. Так же энтропию можно рассматривать как меру равномерности распределения случайной величины.

Неопределенность, количество информации и энтропия Ситуация максимальной неопределенности предполагает наличие нескольких равновероятных альтернатив (вариантов), т. е. ни один из вариантов не является более предпочтительным. Причем, чем больше равновероятных вариантов наблюдается, тем больше неопределенность, тем сложнее сделать однозначный выбор и тем больше информации требуется для этого получить. Для N вариантов эта ситуация описывается следующим распределением вероятностей: {1/N, … 1/N}. Минимальная неопределенность равна 0, т. е. эта ситуация полной определенности, означающая что выбор сделан, и вся необходимая информация получена. Распределение вероятностей для ситуации полной определенности выглядит так: {1, 0, … 0}. Величина, характеризующая количество неопределенности в теории информации обозначается символом H и имеет название энтропия, точнее информационная энтропия. Энтропия (H) – мера неопределенности, выраженная в битах. Так же энтропию можно рассматривать как меру равномерности распределения случайной величины.

Неопределенность, количество информации и энтропия Количество информации I и энтропия H характеризуют одну и ту же ситуацию, но с качественно противоположенных сторон. I – это количество информации, которое требуется для снятия неопределенности H. Когда неопределенность снята полностью, количество полученной информации I равно изначально существовавшей неопределенности H. При частичном снятии неопределенности, полученное количество информации и оставшаяся неснятой неопределенность составляют в сумме исходную неопределенность. Ht + It = H. По этой причине, формулы для расчета энтропии H являются и формулами для расчета количества информации I, т. е. когда речь идет о полном снятии неопределенности, H в них может заменяться на I. В общем случае, энтропия H и количество получаемой в результате снятия неопределенности информации I зависят от исходного количества рассматриваемых вариантов N и априорных вероятностей реализации каждого из них P: {p 0, p 1, …p N-1}, т. е. H=F(N, P). Расчет энтропии в этом случае производится по формуле Шеннона. (1)

Неопределенность, количество информации и энтропия Количество информации I и энтропия H характеризуют одну и ту же ситуацию, но с качественно противоположенных сторон. I – это количество информации, которое требуется для снятия неопределенности H. Когда неопределенность снята полностью, количество полученной информации I равно изначально существовавшей неопределенности H. При частичном снятии неопределенности, полученное количество информации и оставшаяся неснятой неопределенность составляют в сумме исходную неопределенность. Ht + It = H. По этой причине, формулы для расчета энтропии H являются и формулами для расчета количества информации I, т. е. когда речь идет о полном снятии неопределенности, H в них может заменяться на I. В общем случае, энтропия H и количество получаемой в результате снятия неопределенности информации I зависят от исходного количества рассматриваемых вариантов N и априорных вероятностей реализации каждого из них P: {p 0, p 1, …p N-1}, т. е. H=F(N, P). Расчет энтропии в этом случае производится по формуле Шеннона. (1)

Формула Хартли – частный случай формулы Шеннона для равновероятных альтернатив. Подставив в формулу (1) вместо pi его (в равновероятном случае не зависящее от i) значение получим: (2) Из нее явно следует, что чем больше количество альтернатив (N), тем больше неопределенность (H). Эти величины связаны в формуле (2) не линейно, а через двоичный логарифм. Логарифмирование по основанию 2 и приводит количество вариантов к единицам измерения информации – битам. Заметьте, что энтропия будет являться целым числом лишь в том случае, если N является степенью числа 2, т. е. если N принадлежит ряду: {1, 2, 4, 8, 16, 32, 64, 128, 256, 512, 1024, 2048…}. Для решения обратных задач, когда известна неопределенность (H) или полученное в результате ее снятия количество информации (I) и нужно определить какое количество равновероятных альтернатив соответствует возникновению этой неопределенности, используют обратную формулу Хартли, которая выводится в соответствии с определением логарифма и выглядит еще проще: (3)

Формула Хартли – частный случай формулы Шеннона для равновероятных альтернатив. Подставив в формулу (1) вместо pi его (в равновероятном случае не зависящее от i) значение получим: (2) Из нее явно следует, что чем больше количество альтернатив (N), тем больше неопределенность (H). Эти величины связаны в формуле (2) не линейно, а через двоичный логарифм. Логарифмирование по основанию 2 и приводит количество вариантов к единицам измерения информации – битам. Заметьте, что энтропия будет являться целым числом лишь в том случае, если N является степенью числа 2, т. е. если N принадлежит ряду: {1, 2, 4, 8, 16, 32, 64, 128, 256, 512, 1024, 2048…}. Для решения обратных задач, когда известна неопределенность (H) или полученное в результате ее снятия количество информации (I) и нужно определить какое количество равновероятных альтернатив соответствует возникновению этой неопределенности, используют обратную формулу Хартли, которая выводится в соответствии с определением логарифма и выглядит еще проще: (3)

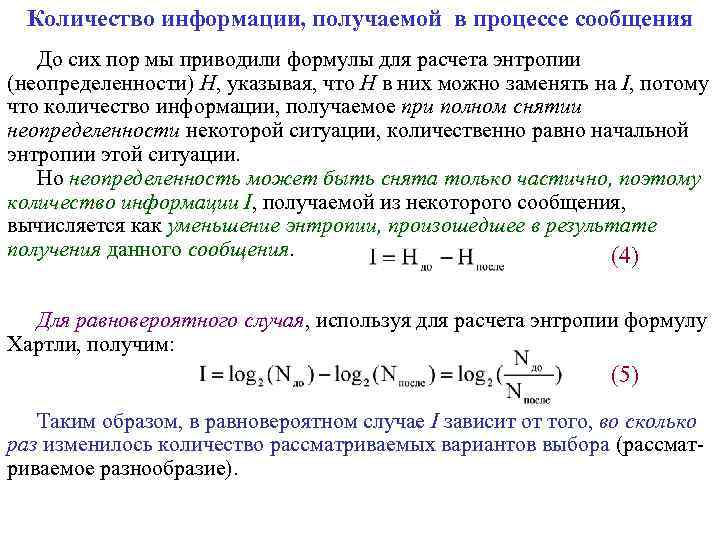

Количество информации, получаемой в процессе сообщения До сих пор мы приводили формулы для расчета энтропии (неопределенности) H, указывая, что H в них можно заменять на I, потому что количество информации, получаемое при полном снятии неопределенности некоторой ситуации, количественно равно начальной энтропии этой ситуации. Но неопределенность может быть снята только частично, поэтому количество информации I, получаемой из некоторого сообщения, вычисляется как уменьшение энтропии, произошедшее в результате получения данного сообщения. (4) Для равновероятного случая, используя для расчета энтропии формулу Хартли, получим: (5) Таким образом, в равновероятном случае I зависит от того, во сколько раз изменилось количество рассматриваемых вариантов выбора (рассматриваемое разнообразие).

Количество информации, получаемой в процессе сообщения До сих пор мы приводили формулы для расчета энтропии (неопределенности) H, указывая, что H в них можно заменять на I, потому что количество информации, получаемое при полном снятии неопределенности некоторой ситуации, количественно равно начальной энтропии этой ситуации. Но неопределенность может быть снята только частично, поэтому количество информации I, получаемой из некоторого сообщения, вычисляется как уменьшение энтропии, произошедшее в результате получения данного сообщения. (4) Для равновероятного случая, используя для расчета энтропии формулу Хартли, получим: (5) Таким образом, в равновероятном случае I зависит от того, во сколько раз изменилось количество рассматриваемых вариантов выбора (рассматриваемое разнообразие).

Количество информации, получаемой в процессе сообщения Исходя из (5) можно вывести следующее: Если , то - полное снятие неопределенности, количество полученной в сообщении информации равно неопределенности, которая существовала до получения сообщения. Если , то неопределенность не изменилась, следовательно, информации получено не было. Если , то => , если , => . Т. е. количество полученной информации будет положительной величиной, если в результате получения сообщения количество рассматриваемых альтернатив уменьшилось, и отрицательной, если увеличилось.

Количество информации, получаемой в процессе сообщения Исходя из (5) можно вывести следующее: Если , то - полное снятие неопределенности, количество полученной в сообщении информации равно неопределенности, которая существовала до получения сообщения. Если , то неопределенность не изменилась, следовательно, информации получено не было. Если , то => , если , => . Т. е. количество полученной информации будет положительной величиной, если в результате получения сообщения количество рассматриваемых альтернатив уменьшилось, и отрицательной, если увеличилось.