4d2542266c48e2b4407e418e5511efc3.ppt

- Количество слайдов: 15

Cross. Grid WP 4 Testbed ACK Cyfronet AGH Piotr Nyczyk

Plan Testbed w Cyfronecie Elementy składowe Konfiguracja sprzętowa klastra Architektura programowa System instalacji/konfiguracji LCFG Etapy instalacji Obecny stan prac Najbliższe zadania

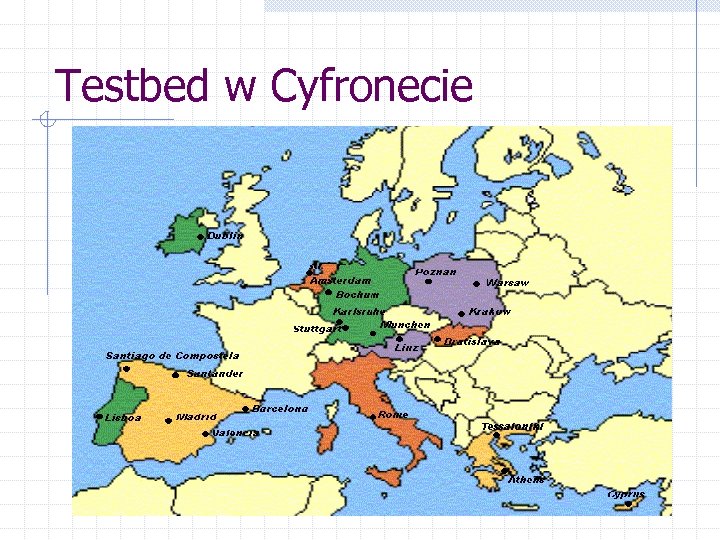

Testbed w Cyfronecie Platforma sprzętowa do obliczeń w środowisku cluster-computing/grid-computing Udział w Cross. Grid Test/Development/ Production Testbed wraz z innymi uczestnikami projektu Udział w eksperymentach Atlas, Alice, LHCb oraz Belle Integracja z European Data. Grid (EDG) Udział w projekcie LHC Computing Grid (Tier 2? )

Elementy składowe Klaster obliczeniowy oparty o platformę sprzętową Intel (system LINUX) Oprogramowanie zgodne z EDG System certyfikatów Grid Security Infrastructure (GSI) – krajowe centrum autoryzacji w Poznaniu Rejestracja użytkowników, wsparcie techniczne

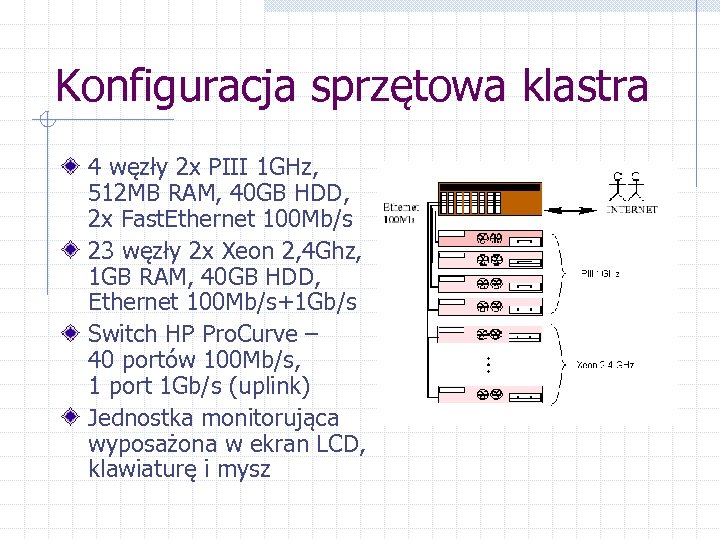

Konfiguracja sprzętowa klastra 4 węzły 2 x PIII 1 GHz, 512 MB RAM, 40 GB HDD, 2 x Fast. Ethernet 100 Mb/s 23 węzły 2 x Xeon 2, 4 Ghz, 1 GB RAM, 40 GB HDD, Ethernet 100 Mb/s+1 Gb/s Switch HP Pro. Curve – 40 portów 100 Mb/s, 1 port 1 Gb/s (uplink) Jednostka monitorująca wyposażona w ekran LCD, klawiaturę i mysz

Konfiguracja sprzętowa (2) Warstwa sieciowa: n n Fast. Ethernet 100 Mb/s Wydzielona podsieć IP Wszystkie węzły w jednej podsieci fizycznej Wszystkie węzły dostępne poprzez publiczne adresy IP (konieczne m. in. ze względu na MPICH-G 2 – zgridowane środowisko wykonywania aplikacji równoległych)

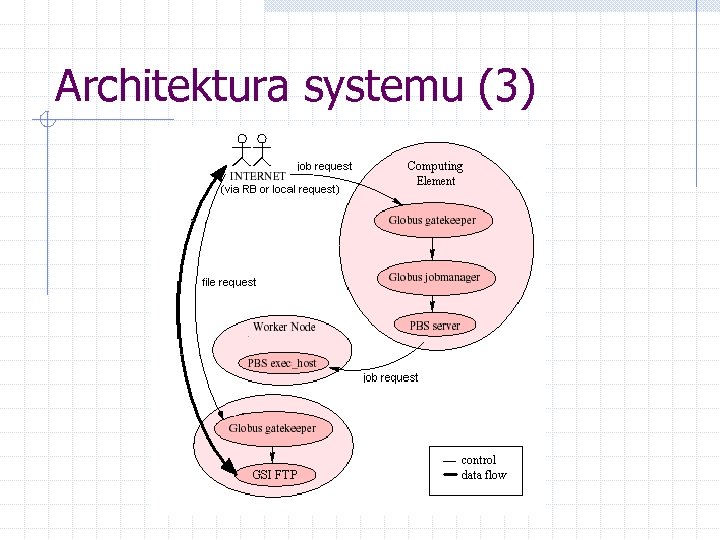

Architektura systemu (1) Oprogramowanie EDG oparte o Globus Toolkit Funkcje rozdzielone na poszczególne węzły Komponenty lokalne: n Computing Element (CE) – „brama” (gatekeeper) udostępniająca usługi obliczeniowe w środowisku gridowym, zawiera serwer systemu kolejkowego (Open. PBS) n User Interface (UI) – komputer przeznaczony dla użytkowników – interfejs środowiska gridowego n Storage Element (SE) – „brama” udostępniająca lokalne zasoby pamięci masowej n LCFG Server – serwer instalacji/konfiguracji klastra n Worker Nodes (WN) – maszyny skonfigurowane do wykonywania aplikacji obliczeniowych

Architektura systemu (2) Komponenty zewnętrzne (centralne): n n Resource Broker (RB) – system centralny rozdzielający zadania obliczeniowe na poszczególne ośrodki Replica Catalogue (RC) – system kontrolujący fizyczne rozmieszczenie logicznych plików w środowisku gridowym (LFN PFN mapping) Certificate Authority (CA) – po jednym na każdy kraj, centra wydające certyfikaty GSI dla użytkowników i maszyn Virtual Organisation (VO) Server – baza danych użytkowników należących do Wirtualnej Organizacji

Architektura systemu (3)

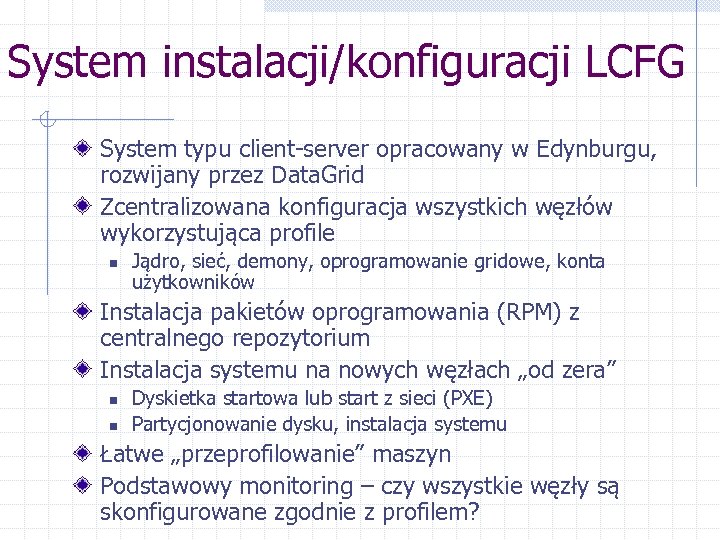

System instalacji/konfiguracji LCFG System typu client-server opracowany w Edynburgu, rozwijany przez Data. Grid Zcentralizowana konfiguracja wszystkich węzłów wykorzystująca profile n Jądro, sieć, demony, oprogramowanie gridowe, konta użytkowników Instalacja pakietów oprogramowania (RPM) z centralnego repozytorium Instalacja systemu na nowych węzłach „od zera” n n Dyskietka startowa lub start z sieci (PXE) Partycjonowanie dysku, instalacja systemu Łatwe „przeprofilowanie” maszyn Podstawowy monitoring – czy wszystkie węzły są skonfigurowane zgodnie z profilem?

Etapy instalacji (1) Czerwiec/Lipiec 2002: n n n Próbna instalacja systemu LCFG oraz EDG v. 1. 2. 0 na czterech maszynach Lokalne testy wysyłania żądań i transferu plików Stworzenie polityki kopii bezpieczeństwa (repozytoria pakietów, profile konfiguracji)

Etapy instalacji (2) Wrzesień/Październik 2002: n n n Instalacja docelowa systemu LCFG oraz EDG v. 1. 2. 2 na czterech węzłach (CE, SE, WN, LCFG) Wystawienie certyfikatów dla maszyn Rejestracja testbed’u w RB w LIP Instalacja UI na osobnym komputerze PC Stworzenie środowiska dla użytkowników – procedura wystawiania certyfikatów Przeprowadzenie testów poprawności instalacji – wykonywanie zadań za pośrednictwem RB

Etapy instalacji (3) Listopad 2002: n n n Instalacja oprogramowania eksperymentu Atlas (we współpracy z IFJ) Wykonanie testowej produkcji – symulacja Atlas (wykonana przez ekipę z IFJ; akceptacja przez CERN) Instalacja 23 nowych węzłów wyposażonych w procesory Xeon 2, 4 GHz oraz jednostki monitorującej Dostosowanie oprogramowania do nowych warunków sprzętowych Wydzielenie osobnej podsieci na klaster

Obecny stan prac (29. 11. 2002) Działające 27 maszyn: n n n 4 węzły specjalizowane: CE, SE, UI, LCFG 19 węzłów obliczeniowych (WN) 38 procesorów 4 węzły zarezerwowane na potrzeby wdrażania nowego oprogramowania (LCFGng, EDG 1. 3. 1, lokalny RB/RC) lub dodatkowy UI Przetestowane i poprawnie działające komponenty gridowe – EDG 1. 2. 2 Prosty monitoring wykorzystania procesorów (xpbsmon, skrypty wykorzystujące ssh) Rozpoczęte prace nad uruchomieniem symulacji Atlas w środowisku gridowym

Najbliższe zadania Rozpoczęcie produkcji – symulacja Atlas Instalacja systemu pamięci masowej – macierz dyskowa typu NAS, 640 GB Opracowanie monitoringu klastra: n n Wykorzystania procesorów Temperatury poszczególnych elementów Próby z nowym oprogramowaniem: n n n LCFGng – następca LCFG EDG v. 1. 3. x Lokalny Resource Broker

4d2542266c48e2b4407e418e5511efc3.ppt