Modul_1_Lektsia_1_Osnovnye_ponyatia_informatik.ppt

- Количество слайдов: 35

Адекватность информации – это определенный уровень соответствия создаваемого с помощью полученной информации образа реальному объекту, процессу, явлению и т. п. Формы адекватности информации Синтаксическая адекватность Основы информатики Семантическая (смысловая) адекватность Прагматическая адекватность 1

Адекватность информации – это определенный уровень соответствия создаваемого с помощью полученной информации образа реальному объекту, процессу, явлению и т. п. Формы адекватности информации Синтаксическая адекватность Основы информатики Семантическая (смысловая) адекватность Прагматическая адекватность 1

Измерение информации Меры информации Синтаксическая мера Семантическая мера Объем данных VД Количество информации Iβ(α) Основы информатики Прагматическая мера Количество Информации IC = C * VД 2

Измерение информации Меры информации Синтаксическая мера Семантическая мера Объем данных VД Количество информации Iβ(α) Основы информатики Прагматическая мера Количество Информации IC = C * VД 2

Синтаксическая мера информации Объем данных VД Объем данных в сообщении измеряется количеством символов (разрядов) в этом сообщении. Например: § в двоичной системе счисления единица измерения – бит (bit - binary digit - двоичный разряд); § в десятичной системе счисления единица измерения – дит (десятичный разряд). Основы информатики 3

Синтаксическая мера информации Объем данных VД Объем данных в сообщении измеряется количеством символов (разрядов) в этом сообщении. Например: § в двоичной системе счисления единица измерения – бит (bit - binary digit - двоичный разряд); § в десятичной системе счисления единица измерения – дит (десятичный разряд). Основы информатики 3

КОЛИЧЕСТВО ИНФОРМАЦИИ 44

КОЛИЧЕСТВО ИНФОРМАЦИИ 44

Синтаксическая мера информации Количество информации I Количество информации на синтаксическом уровне определяют с помощью понятия неопределенности состояния системы (энтропии системы). Iβ(α) = H(α) – H (α) α – априорные (предварительные) сведения о системе; H(α) – энтропия системы, мера недостающей информации о системе; β – сообщение, дополнительные сведения о системе; H ( ) – неопределенность состояния системы после получения сообщения ; Iβ(α) – количество информации о системе, полученной в сообщении . Если H ( ) = 0, то Iβ(α) = H(α) Основы информатики 5

Синтаксическая мера информации Количество информации I Количество информации на синтаксическом уровне определяют с помощью понятия неопределенности состояния системы (энтропии системы). Iβ(α) = H(α) – H (α) α – априорные (предварительные) сведения о системе; H(α) – энтропия системы, мера недостающей информации о системе; β – сообщение, дополнительные сведения о системе; H ( ) – неопределенность состояния системы после получения сообщения ; Iβ(α) – количество информации о системе, полученной в сообщении . Если H ( ) = 0, то Iβ(α) = H(α) Основы информатики 5

Формула Хартли В 1928 г. американский инженер Р. Хартли предложил научный подход к оценке сообщений. Предложенная им формула имела следующий вид: I = log 2 K , К - количество равновероятных событий; I - количество бит в сообщении, такое, что любое из К событий произошло. Тогда K=2 I. 6 6

Формула Хартли В 1928 г. американский инженер Р. Хартли предложил научный подход к оценке сообщений. Предложенная им формула имела следующий вид: I = log 2 K , К - количество равновероятных событий; I - количество бит в сообщении, такое, что любое из К событий произошло. Тогда K=2 I. 6 6

Формула Хартли Иногда формулу Хартли записывают так: I = log 2 K = log 2 (1 / р) = - log 2 р т. к. каждое из К событий имеет равновероятный исход р = 1 / К, то К = 1 / р. 7 7

Формула Хартли Иногда формулу Хартли записывают так: I = log 2 K = log 2 (1 / р) = - log 2 р т. к. каждое из К событий имеет равновероятный исход р = 1 / К, то К = 1 / р. 7 7

Задача Шарик находится в одной из трех урн: А, В или С. Определить сколько бит информации содержит сообщение о том, что он находится в урне В. 8 8

Задача Шарик находится в одной из трех урн: А, В или С. Определить сколько бит информации содержит сообщение о том, что он находится в урне В. 8 8

Решение Такое сообщение содержит I = log 2 3 = 1, 585 бита информации. 9 9

Решение Такое сообщение содержит I = log 2 3 = 1, 585 бита информации. 9 9

Формула Шеннона В 1948 г. американский инженер и математик К. Шеннон предложил формулу для вычисления количества информации для событий с различными вероятностями. 10 10

Формула Шеннона В 1948 г. американский инженер и математик К. Шеннон предложил формулу для вычисления количества информации для событий с различными вероятностями. 10 10

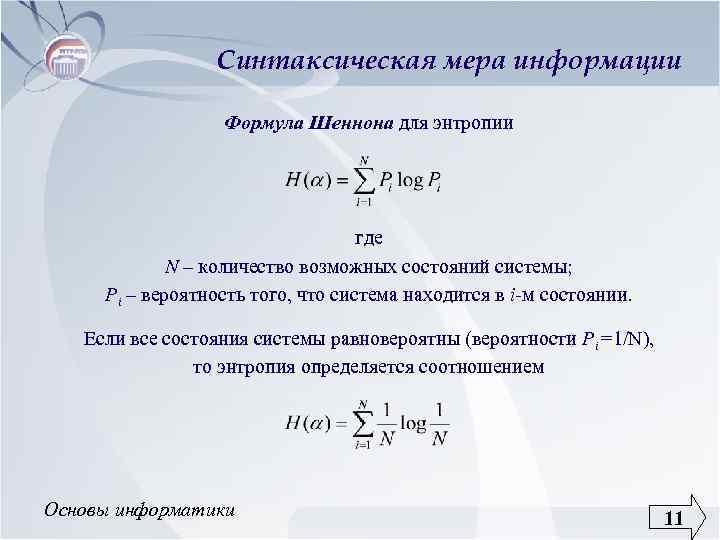

Синтаксическая мера информации Формула Шеннона для энтропии где N – количество возможных состояний системы; Pi – вероятность того, что система находится в i-м состоянии. Если все состояния системы равновероятны (вероятности Pi =1/N), то энтропия определяется соотношением Основы информатики 11

Синтаксическая мера информации Формула Шеннона для энтропии где N – количество возможных состояний системы; Pi – вероятность того, что система находится в i-м состоянии. Если все состояния системы равновероятны (вероятности Pi =1/N), то энтропия определяется соотношением Основы информатики 11

Формула Шеннона Если I - количество информации, К - количество возможных событий, рi - вероятности отдельных событий, то количество информации для событий с различными вероятностями можно определить по формуле: I = - ∑ рi log 2 рi, где i принимает значения от 1 до К. 12 12

Формула Шеннона Если I - количество информации, К - количество возможных событий, рi - вероятности отдельных событий, то количество информации для событий с различными вероятностями можно определить по формуле: I = - ∑ рi log 2 рi, где i принимает значения от 1 до К. 12 12

Формула Шеннона Формулу Хартли теперь можно рассматривать как частный случай формулы Шеннона: I = - ∑ 1 / К ∙log 2 (1 / К) = I = log 2 К. При равновероятных событиях получаемое количество информации максимально. 13 13

Формула Шеннона Формулу Хартли теперь можно рассматривать как частный случай формулы Шеннона: I = - ∑ 1 / К ∙log 2 (1 / К) = I = log 2 К. При равновероятных событиях получаемое количество информации максимально. 13 13

Задача • В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика? • Так количество шариков различных цветов неодинаково, то вероятности зрительных сообщений о цвете вынутого из мешочка шарика также различаются и равны количеству шариков данного цвета, деленному на общее количество шариков: рб = 0, 1; pк = 0, 2; рс = 0, 3; рз = 0, 4. I = - (0, 1·log 2 0, 1 + 0, 2·log 2 0, 2 + 0, 3·log 2 0, 3 + 0, 4·log 2 0, 4) битов. • 14 14

Задача • В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика? • Так количество шариков различных цветов неодинаково, то вероятности зрительных сообщений о цвете вынутого из мешочка шарика также различаются и равны количеству шариков данного цвета, деленному на общее количество шариков: рб = 0, 1; pк = 0, 2; рс = 0, 3; рз = 0, 4. I = - (0, 1·log 2 0, 1 + 0, 2·log 2 0, 2 + 0, 3·log 2 0, 3 + 0, 4·log 2 0, 4) битов. • 14 14

Синтаксическая мера информации Информация в компьютере кодируется числовыми кодами в той или иной системе счисления. Одно и то же количество разрядов в разных системах счисления может передать разное число состояний отображаемого объекта: N = mn где N – число всевозможных отображаемых состояний системы; m – основание системы счисления (разнообразие символов, применяемых в алфавите); n – число разрядов (символов) в сообщении. Например: N = 28 = 256 – в одном байте (8 разрядов или битов) можно закодировать 256 различных символов N = 216 = 65536 – в двух байтах (16 разрядов) Основы информатики 15

Синтаксическая мера информации Информация в компьютере кодируется числовыми кодами в той или иной системе счисления. Одно и то же количество разрядов в разных системах счисления может передать разное число состояний отображаемого объекта: N = mn где N – число всевозможных отображаемых состояний системы; m – основание системы счисления (разнообразие символов, применяемых в алфавите); n – число разрядов (символов) в сообщении. Например: N = 28 = 256 – в одном байте (8 разрядов или битов) можно закодировать 256 различных символов N = 216 = 65536 – в двух байтах (16 разрядов) Основы информатики 15

Синтаксическая мера информации Коэффициент (степень) информативности (лаконичность) сообщения определяется отношением количества информации к объему данных Y = I / VД , причем 0

Синтаксическая мера информации Коэффициент (степень) информативности (лаконичность) сообщения определяется отношением количества информации к объему данных Y = I / VД , причем 0

Бит Информацию можно измерять в битах, т. е. в количестве двоичных разрядов. англ. bit (binary digit) – двоичный знак. 17 17

Бит Информацию можно измерять в битах, т. е. в количестве двоичных разрядов. англ. bit (binary digit) – двоичный знак. 17 17

Бит Количество информации, которое можно получить при ответе на вопрос типа “да/нет” (включено/выключено, true/false, 0/1), если эти состояния равновероятны, называется “бит”. 0 18 1 18

Бит Количество информации, которое можно получить при ответе на вопрос типа “да/нет” (включено/выключено, true/false, 0/1), если эти состояния равновероятны, называется “бит”. 0 18 1 18

Бит 1 битом можно закодировать 2 значения (1, 0) 19 19

Бит 1 битом можно закодировать 2 значения (1, 0) 19 19

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 20 20

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 20 20

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 3 битами – 8 значений (000, 001, 010, 100, 011, 101, 110, 111) 21 21

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 3 битами – 8 значений (000, 001, 010, 100, 011, 101, 110, 111) 21 21

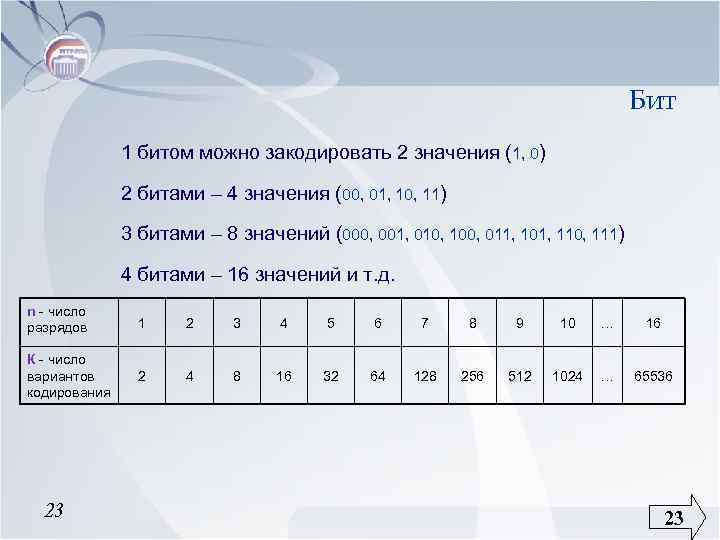

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 3 битами – 8 значений (000, 001, 010, 100, 011, 101, 110, 111) 4 битами – 16 значений и т. д. 22 22

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 3 битами – 8 значений (000, 001, 010, 100, 011, 101, 110, 111) 4 битами – 16 значений и т. д. 22 22

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 3 битами – 8 значений (000, 001, 010, 100, 011, 101, 110, 111) 4 битами – 16 значений и т. д. n - число разрядов 1 2 3 4 5 6 7 8 9 10 … 16 К - число вариантов кодирования 2 4 8 16 32 64 128 256 512 1024 … 65536 23 23

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 3 битами – 8 значений (000, 001, 010, 100, 011, 101, 110, 111) 4 битами – 16 значений и т. д. n - число разрядов 1 2 3 4 5 6 7 8 9 10 … 16 К - число вариантов кодирования 2 4 8 16 32 64 128 256 512 1024 … 65536 23 23

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 3 битами – 8 значений (000, 001, 010, 100, 011, 101, 110, 111) 4 битами – 16 значений и т. д. n - число разрядов 1 2 3 4 5 6 7 8 9 10 … 16 К - число вариантов кодирования 2 4 8 16 32 64 128 256 512 1024 … 65536 К = 2 n 24 24

Бит 1 битом можно закодировать 2 значения (1, 0) 2 битами – 4 значения (00, 01, 10, 11) 3 битами – 8 значений (000, 001, 010, 100, 011, 101, 110, 111) 4 битами – 16 значений и т. д. n - число разрядов 1 2 3 4 5 6 7 8 9 10 … 16 К - число вариантов кодирования 2 4 8 16 32 64 128 256 512 1024 … 65536 К = 2 n 24 24

Байт Группа из 8 бит называется байтом От англ. byte (binary term) – двоичный элемент На основании 1 байта, можно получить 256 различных комбинаций. 25 25

Байт Группа из 8 бит называется байтом От англ. byte (binary term) – двоичный элемент На основании 1 байта, можно получить 256 различных комбинаций. 25 25

Байт 0 25 5 26 0 0 0 0 7 -ой 6 -ой 5 -ый 4 -ый 3 -ий 2 -ой 1 -ый 0 -ой 1 1 1 1 7 -ой 6 -ой 5 -ый 4 -ый 3 -ий 2 -ой 1 -ый 0 -ой mi n max 26

Байт 0 25 5 26 0 0 0 0 7 -ой 6 -ой 5 -ый 4 -ый 3 -ий 2 -ой 1 -ый 0 -ой 1 1 1 1 7 -ой 6 -ой 5 -ый 4 -ый 3 -ий 2 -ой 1 -ый 0 -ой mi n max 26

• • Сообщения, записанные с помощью символов ASCII, используют алфавит из 256 символов. Сообщения, записанные по системе UNICODE, используют алфавит из 65 536 символов. Основы информатики 27

• • Сообщения, записанные с помощью символов ASCII, используют алфавит из 256 символов. Сообщения, записанные по системе UNICODE, используют алфавит из 65 536 символов. Основы информатики 27

Байт § 1 Kb (кило) = 210 b = 1 024 b § 1 Mb (мега) = 210 Kb = 220 b = 1 048 576 b § 1 Gb (гига) = 210 Mb = 230 b = 1 073 741 824 b § 1 Tb (тера) = 210 Gb = 240 b = 1 099 511 627 776 b 28 28

Байт § 1 Kb (кило) = 210 b = 1 024 b § 1 Mb (мега) = 210 Kb = 220 b = 1 048 576 b § 1 Gb (гига) = 210 Mb = 230 b = 1 073 741 824 b § 1 Tb (тера) = 210 Gb = 240 b = 1 099 511 627 776 b 28 28

Задача Размер текстового файла (Vд) 640 Kb. Файл содержит книгу, которая набрана в среднем по 32 строки на странице и по 64 символа в строке. Сколько страниц в книге: 160, 320, 540, 640, 1280 ? страница страница 32 32 32 64 64 64 1 символ = 1 b I= 0 1 2 3 4 5 6 7 8 9 10 N= 1 2 4 8 16 32 64 128 256 512 1024 1. Символов на 1 стр. = 32*64 = 25*26=211 2. Памяти на 1 стр. = 211 b 3. Всего = 640 Kb = 10*64*210 b = 10*26*210 b = 1 4. Кол-во стр. = 10*216 b / 211 b = 10*25 = 320 29

Задача Размер текстового файла (Vд) 640 Kb. Файл содержит книгу, которая набрана в среднем по 32 строки на странице и по 64 символа в строке. Сколько страниц в книге: 160, 320, 540, 640, 1280 ? страница страница 32 32 32 64 64 64 1 символ = 1 b I= 0 1 2 3 4 5 6 7 8 9 10 N= 1 2 4 8 16 32 64 128 256 512 1024 1. Символов на 1 стр. = 32*64 = 25*26=211 2. Памяти на 1 стр. = 211 b 3. Всего = 640 Kb = 10*64*210 b = 10*26*210 b = 1 4. Кол-во стр. = 10*216 b / 211 b = 10*25 = 320 29

Семантическая мера информации § Тезаурус – это совокупность сведений, которыми располагает пользователь или система. Зависимость количества семантической информации, воспринимаемой потребителем, от его тезауруса IС = f (SР) IС = max IС – количество семантической информации SР – тезаурус пользователя § при SР = 0 пользователь не воспринимает, не понимает поступающую информацию; § при Sp пользователь всё знает и поступающая информация ему не нужна. § при Sp = Sp opt поступающая информация понятна пользователю и несет ему ранее не известные (отсутствующие в его тезаурусе) сведения. Основы информатики 30

Семантическая мера информации § Тезаурус – это совокупность сведений, которыми располагает пользователь или система. Зависимость количества семантической информации, воспринимаемой потребителем, от его тезауруса IС = f (SР) IС = max IС – количество семантической информации SР – тезаурус пользователя § при SР = 0 пользователь не воспринимает, не понимает поступающую информацию; § при Sp пользователь всё знает и поступающая информация ему не нужна. § при Sp = Sp opt поступающая информация понятна пользователю и несет ему ранее не известные (отсутствующие в его тезаурусе) сведения. Основы информатики 30

Семантическая мера информации Коэффициент содержательности C – есть отношение количества семантической информации к ее объему: C = IС / V Д Основы информатики 31

Семантическая мера информации Коэффициент содержательности C – есть отношение количества семантической информации к ее объему: C = IС / V Д Основы информатики 31

Прагматическая мера информации определяет полезность информации (ценность) для достижения пользователем поставленной цели. величина относительная, обусловленная особенностями использования этой информации в той или иной системе. измеряется в тех же самых единицах (или близких к ним), в которых измеряется целевая функция. Основы информатики 32

Прагматическая мера информации определяет полезность информации (ценность) для достижения пользователем поставленной цели. величина относительная, обусловленная особенностями использования этой информации в той или иной системе. измеряется в тех же самых единицах (или близких к ним), в которых измеряется целевая функция. Основы информатики 32

Прагматическая мера информации Пример В экономической системе прагматические свойства (ценность) информации можно определить приростом экономического эффекта функционирования, достигнутым благодаря использованию этой информации для управления системой: IП (y) = П(y/ ) - П(y), где IП ( ) – ценность информационного сообщения для системы управления y; П( ) – априорный экономический эффект функционирования системы управления y; П( / ) – ожидаемый эффект функционирования системы y при условии, что для управления будет использована информация, содержащаяся в сообщении . Основы информатики 33

Прагматическая мера информации Пример В экономической системе прагматические свойства (ценность) информации можно определить приростом экономического эффекта функционирования, достигнутым благодаря использованию этой информации для управления системой: IП (y) = П(y/ ) - П(y), где IП ( ) – ценность информационного сообщения для системы управления y; П( ) – априорный экономический эффект функционирования системы управления y; П( / ) – ожидаемый эффект функционирования системы y при условии, что для управления будет использована информация, содержащаяся в сообщении . Основы информатики 33

Единицы измерения информации и примеры Мера информации Единицы измерения Примеры (для компьютерной области) Синтаксическая: шенноновский подход Степень уменьшения неопределенности Вероятность события компьютерный подход Единицы представления информации Бит, байт, Кбайт и т. д. Семантическая Тезаурус Экономические показатели Прагматическая Ценность использования Пакет прикладных программ, персональный компьютер, компьютерные сети и т. д. Рентабельность, производительность, коэффициент амортизации и т. д. Емкость памяти, производительность компьютера, скорость передачи данных Денежное выражение Время обработки информации и принятия решений 34

Единицы измерения информации и примеры Мера информации Единицы измерения Примеры (для компьютерной области) Синтаксическая: шенноновский подход Степень уменьшения неопределенности Вероятность события компьютерный подход Единицы представления информации Бит, байт, Кбайт и т. д. Семантическая Тезаурус Экономические показатели Прагматическая Ценность использования Пакет прикладных программ, персональный компьютер, компьютерные сети и т. д. Рентабельность, производительность, коэффициент амортизации и т. д. Емкость памяти, производительность компьютера, скорость передачи данных Денежное выражение Время обработки информации и принятия решений 34

Основы информатики 35

Основы информатики 35