А. В. Цыганов 2011 Про Internet

А. В. Цыганов 2011 Про Internet

65% startup компаний приходится на создание поисковых систем

65% startup компаний приходится на создание поисковых систем

Виды поиска в WWW поиск по известным адресам Тематические каталоги Поисковые машины Специализированный поиск в базах данных (резервирование, поиск справочной информации о людях, организациях …) Wikipedia, ar. Xiv, Math World, Planet Math, Science World, Physics. org, The Math Forum, S. O. S. Mathematics, www. springerlink. com, www. iop. org и. т. д.

Виды поиска в WWW поиск по известным адресам Тематические каталоги Поисковые машины Специализированный поиск в базах данных (резервирование, поиск справочной информации о людях, организациях …) Wikipedia, ar. Xiv, Math World, Planet Math, Science World, Physics. org, The Math Forum, S. O. S. Mathematics, www. springerlink. com, www. iop. org и. т. д.

Критерии профессионального поиска: ü контроль полноты охвата ресурсов; ü контроль достоверности информации, полученной из Сети (точность); ü высокая скорость проведения поиска; ü удобство, понятность и пр. субъективные критерии

Критерии профессионального поиска: ü контроль полноты охвата ресурсов; ü контроль достоверности информации, полученной из Сети (точность); ü высокая скорость проведения поиска; ü удобство, понятность и пр. субъективные критерии

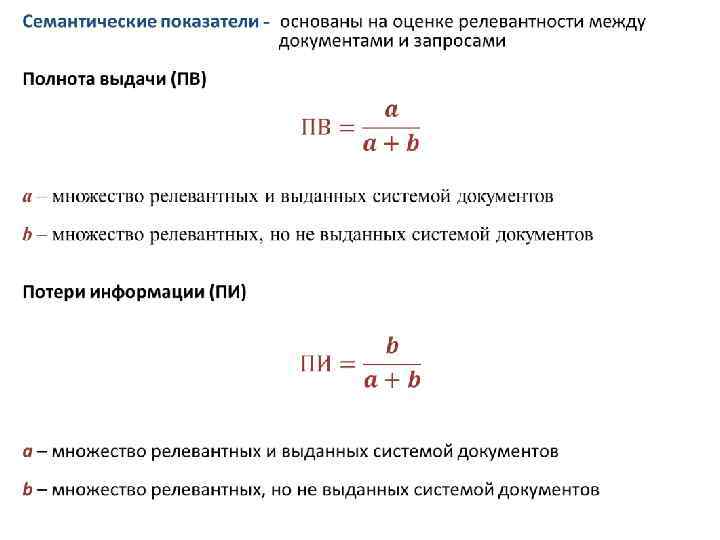

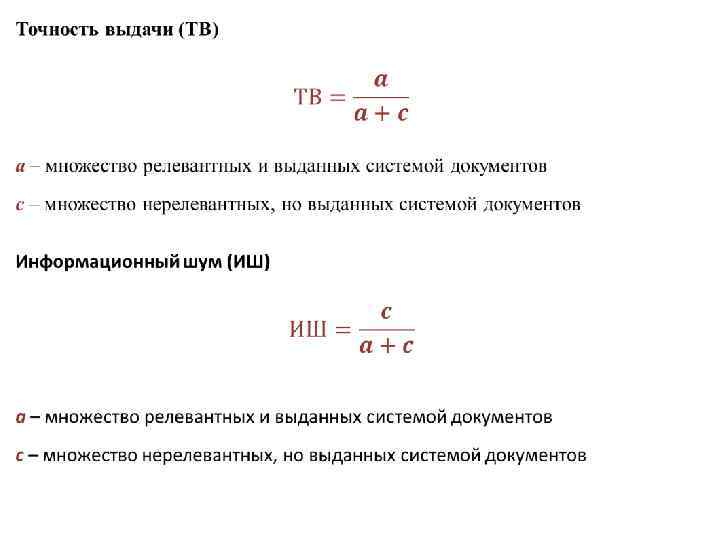

Релева нтность (relevant) - степень соответствия запроса и найденного, уместность результата. Это субъективное понятие, поскольку результаты поиска, уместные для одного пользователя, могут быть неуместными для другого. Релевантным называется документ или страница в интернете, которая формально соответствует сути сделанного через поисковую систему запроса. При оценке релевантности информации, найденной в интернете, оценивается • полнота информации, означающая, что ничего из имеющегося в интернете не потеряно • точность, показывающая, что не найдено ничего лишнего из имеющейся в сети информации.

Релева нтность (relevant) - степень соответствия запроса и найденного, уместность результата. Это субъективное понятие, поскольку результаты поиска, уместные для одного пользователя, могут быть неуместными для другого. Релевантным называется документ или страница в интернете, которая формально соответствует сути сделанного через поисковую систему запроса. При оценке релевантности информации, найденной в интернете, оценивается • полнота информации, означающая, что ничего из имеющегося в интернете не потеряно • точность, показывающая, что не найдено ничего лишнего из имеющейся в сети информации.

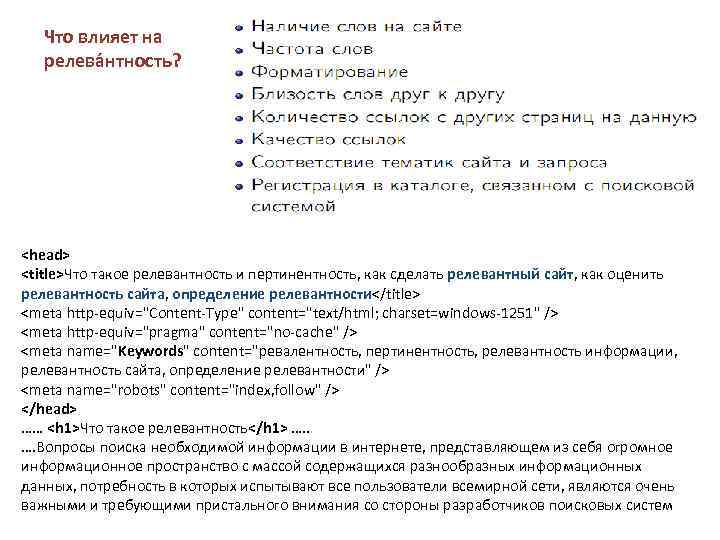

Что влияет на релева нтность?

Что влияет на релева нтность?

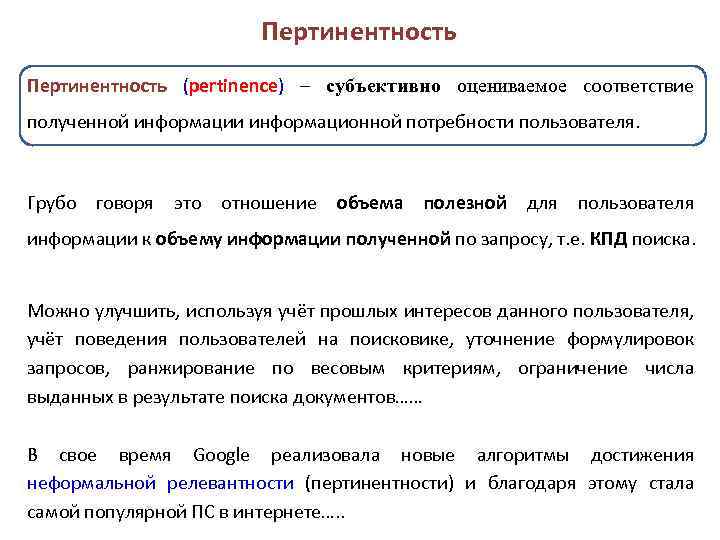

Пертинентность (рertinence) – субъективно оцениваемое соответствие полученной информации информационной потребности пользователя. Грубо говоря это отношение объема полезной для пользователя информации к объему информации полученной по запросу, т. е. КПД поиска. Можно улучшить, используя учёт прошлых интересов данного пользователя, учёт поведения пользователей на поисковике, уточнение формулировок запросов, ранжирование по весовым критериям, ограничение числа выданных в результате поиска документов…… В свое время Google реализовала новые алгоритмы достижения неформальной релевантности (пертинентности) и благодаря этому стала самой популярной ПС в интернете…. .

Пертинентность (рertinence) – субъективно оцениваемое соответствие полученной информации информационной потребности пользователя. Грубо говоря это отношение объема полезной для пользователя информации к объему информации полученной по запросу, т. е. КПД поиска. Можно улучшить, используя учёт прошлых интересов данного пользователя, учёт поведения пользователей на поисковике, уточнение формулировок запросов, ранжирование по весовым критериям, ограничение числа выданных в результате поиска документов…… В свое время Google реализовала новые алгоритмы достижения неформальной релевантности (пертинентности) и благодаря этому стала самой популярной ПС в интернете…. .

При создании сайтов, кроме решения важных вопросов дизайна сайта и его наполненности, необходимо оценивать релевантность и пертинентность сайта, с точки зрения отношения к нему существующих поисковых систем.

При создании сайтов, кроме решения важных вопросов дизайна сайта и его наполненности, необходимо оценивать релевантность и пертинентность сайта, с точки зрения отношения к нему существующих поисковых систем.

Алгоритм + Структура данных = Поисковая система Как и любая программа, поисковая система оперирует со структурами данных и исполняет алгоритм. В настоящее время есть четыре класса поисковых алгоритмов. Три алгоритма из четырех требуют «индексирования» , предварительной обработки документов, при котором создаются вспомогательный файл, сиречь «индекс» , призванный упростить и ускорить сам поиск. Это алгоритмы инвертированных файлов, суффиксных деревьев и сигнатур. Четвертый класс алгоритмов прямого поиска не требует индексирования.

Алгоритм + Структура данных = Поисковая система Как и любая программа, поисковая система оперирует со структурами данных и исполняет алгоритм. В настоящее время есть четыре класса поисковых алгоритмов. Три алгоритма из четырех требуют «индексирования» , предварительной обработки документов, при котором создаются вспомогательный файл, сиречь «индекс» , призванный упростить и ускорить сам поиск. Это алгоритмы инвертированных файлов, суффиксных деревьев и сигнатур. Четвертый класс алгоритмов прямого поиска не требует индексирования.

Анатомия поисковой системы Любая поисковая система содержит три базовых части: • Робот - краулер, спайдер, индексатор …. . Извлечение и накопление данных документов. • Базы данных - обработка полученных данных и создание данных, пригодных для поиска. • Клиент – обработка запросов (поиск по созданным). Существует масса других частей, однако их назначение заключается главным образом именно в эффективной поддержке этих трёх базовых.

Анатомия поисковой системы Любая поисковая система содержит три базовых части: • Робот - краулер, спайдер, индексатор …. . Извлечение и накопление данных документов. • Базы данных - обработка полученных данных и создание данных, пригодных для поиска. • Клиент – обработка запросов (поиск по созданным). Существует масса других частей, однако их назначение заключается главным образом именно в эффективной поддержке этих трёх базовых.

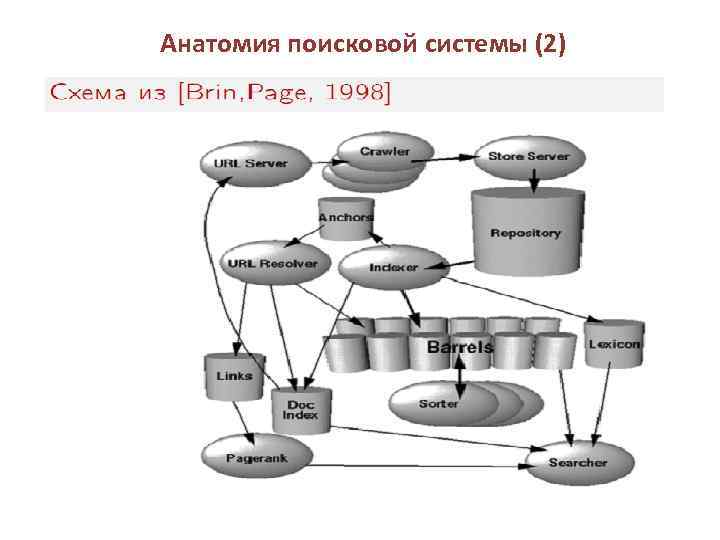

Анатомия поисковой системы (2)

Анатомия поисковой системы (2)

Анатомия поисковой системы (3)

Анатомия поисковой системы (3)

«Паук» (spider) Web spider или Web scraper – это разновидности программных роботов или агентов (в терминологии, предложенной Аланом Кеем (Alan Kay) в начале 1980 -х годов). Программный агент должен действовать в качестве посредника (proxy) между пользователем и компьютерным миром. Такой агент может иметь определённую цель и должен работать над достижением этой цели в отведённой ему области. Цель может состоять в сборе информации или в понимании структуры какоголибо Web-сайта и его полезности. Такие пауки автоматически извлекают данные из Web-сайта ( например HTML-код документа) и передают их другим приложениям, которые индексируют контент этого Web-сайта с целью формирования наилучшего набора поисковых терминов.

«Паук» (spider) Web spider или Web scraper – это разновидности программных роботов или агентов (в терминологии, предложенной Аланом Кеем (Alan Kay) в начале 1980 -х годов). Программный агент должен действовать в качестве посредника (proxy) между пользователем и компьютерным миром. Такой агент может иметь определённую цель и должен работать над достижением этой цели в отведённой ему области. Цель может состоять в сборе информации или в понимании структуры какоголибо Web-сайта и его полезности. Такие пауки автоматически извлекают данные из Web-сайта ( например HTML-код документа) и передают их другим приложениям, которые индексируют контент этого Web-сайта с целью формирования наилучшего набора поисковых терминов.

"Web-скребок" (Web scraper) – это агент, который действует аналогично Web -паукам, но более интересен с юридической точки зрения. Scraper – это разновидность паука, которая нацелена на работу с определённым Интернет-контентом, например, с данными о стоимости продуктов или услуг. Один из вариантов применения scraperагентов – конкурентное ценообразование, т. е. выявление существующих на рынке цен на определённую категорию товаров с целью установления соответствующих цен на собственную продукцию. Кроме того, scraper способен объединять данные из нескольких источников в Интернете и предоставлять эту итоговую информацию пользователю и т. д.

"Web-скребок" (Web scraper) – это агент, который действует аналогично Web -паукам, но более интересен с юридической точки зрения. Scraper – это разновидность паука, которая нацелена на работу с определённым Интернет-контентом, например, с данными о стоимости продуктов или услуг. Один из вариантов применения scraperагентов – конкурентное ценообразование, т. е. выявление существующих на рынке цен на определённую категорию товаров с целью установления соответствующих цен на собственную продукцию. Кроме того, scraper способен объединять данные из нескольких источников в Интернете и предоставлять эту итоговую информацию пользователю и т. д.

Глаза и ноги паука Основными органами зрения и перемещения Web-паука в Интернете является HTTP – ориентированный на сообщения протокол, с помощью которого клиент подключается к серверу и посылает запросы. В ответ на эти запросы сервер генерирует отклик. Каждый запрос или отклик состоит из заголовка и тела. Заголовок содержит информацию о состоянии и описание содержимого тела. Протокол HTTP поддерживает запросы трех основных типов. § Запрос типа HEAD запрашивает информацию об активах определенного сервера. § Запрос типа GET запрашивает сам актив, например, файл или изображение. § Запрос типа POST разрешает клиенту взаимодействовать с сервером через Web-страницу (обычно через Web-форму).

Глаза и ноги паука Основными органами зрения и перемещения Web-паука в Интернете является HTTP – ориентированный на сообщения протокол, с помощью которого клиент подключается к серверу и посылает запросы. В ответ на эти запросы сервер генерирует отклик. Каждый запрос или отклик состоит из заголовка и тела. Заголовок содержит информацию о состоянии и описание содержимого тела. Протокол HTTP поддерживает запросы трех основных типов. § Запрос типа HEAD запрашивает информацию об активах определенного сервера. § Запрос типа GET запрашивает сам актив, например, файл или изображение. § Запрос типа POST разрешает клиенту взаимодействовать с сервером через Web-страницу (обычно через Web-форму).

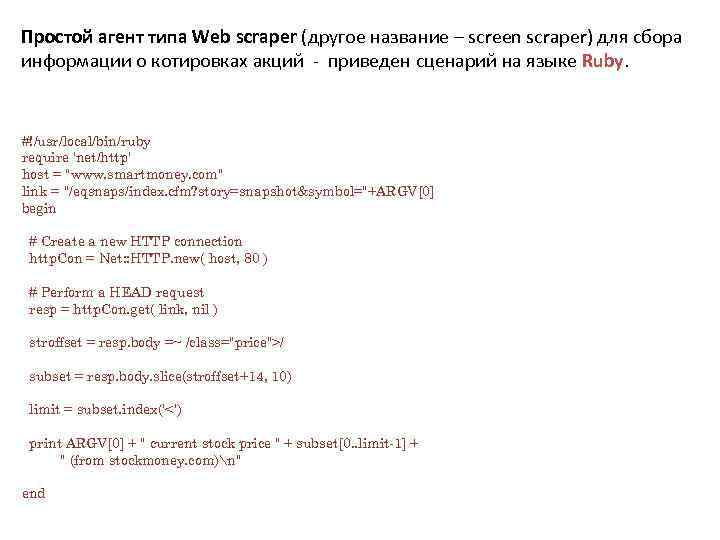

Простой агент типа Web scraper (другое название – screen scraper) для сбора информации о котировках акций - приведен сценарий на языке Ruby. #!/usr/local/bin/ruby require 'net/http' host = "www. smartmoney. com" link = "/eqsnaps/index. cfm? story=snapshot&symbol="+ARGV[0] begin # Create a new HTTP connection http. Con = Net: : HTTP. new( host, 80 ) # Perform a HEAD request resp = http. Con. get( link, nil ) stroffset = resp. body =~ /class="price">/ subset = resp. body. slice(stroffset+14, 10) limit = subset. index('<') print ARGV[0] + " current stock price " + subset[0. . limit-1] + " (from stockmoney. com)n" end

Простой агент типа Web scraper (другое название – screen scraper) для сбора информации о котировках акций - приведен сценарий на языке Ruby. #!/usr/local/bin/ruby require 'net/http' host = "www. smartmoney. com" link = "/eqsnaps/index. cfm? story=snapshot&symbol="+ARGV[0] begin # Create a new HTTP connection http. Con = Net: : HTTP. new( host, 80 ) # Perform a HEAD request resp = http. Con. get( link, nil ) stroffset = resp. body =~ /class="price">/ subset = resp. body. slice(stroffset+14, 10) limit = subset. index('<') print ARGV[0] + " current stock price " + subset[0. . limit-1] + " (from stockmoney. com)n" end

«Червяк» (crawler) • Программа, способная найти на web-странице все ссылки на другие страницы. • Ее задача – определить, куда дальше должен «ползти» «паук» , руководствуясь ссылками или заранее заданным списком адресов. Каждую найденную ссылку в документе crawler должен проверить на правильность, с точки зрения интернет-имени сервера. Для этих целей используется стандартный механизм DNS – однако если рассматриваемая страница содержит массу ссылок на другие страницы и при этом первичный сервер зоны, в которой располагаются данные страницы в данный момент по каким-либо причинам не доступен, то возникают огромные потери времени на попытках установления соответствия - в итоге ваша страничка не индексируется!!!!

«Червяк» (crawler) • Программа, способная найти на web-странице все ссылки на другие страницы. • Ее задача – определить, куда дальше должен «ползти» «паук» , руководствуясь ссылками или заранее заданным списком адресов. Каждую найденную ссылку в документе crawler должен проверить на правильность, с точки зрения интернет-имени сервера. Для этих целей используется стандартный механизм DNS – однако если рассматриваемая страница содержит массу ссылок на другие страницы и при этом первичный сервер зоны, в которой располагаются данные страницы в данный момент по каким-либо причинам не доступен, то возникают огромные потери времени на попытках установления соответствия - в итоге ваша страничка не индексируется!!!!

Web-пауки и краулеры минимизируют порождаемую ими нагрузку на Интернет с помощью набора политик. Чтобы представить масштабы проблемы, необходимо учесть, что Google индексирует более 8 млрд. Web-страниц. Поиск в Интернете весьма дорог, как с точки зрения пропускной способности, необходимой для передачи Webконтента индексатору, так и с точки зрения вычислительных затрат на индексирование результатов. Политики поведения определяют, какие страницы Web-краулер должен вводить в индексатор и как часто Web-краулер должен возвращаться на какой-либо Webсайт для повторной проверки, а также т. н. "политику вежливости". Web-серверы могут запрещать работу краулеров с помощью стандартного файла robot. txt, который сообщает краулерам о том, что можно, а что нельзя просматривать на данном сервере + такие директивы как Disallow, Allow, Useragent, Crawl-delay и другие.

Web-пауки и краулеры минимизируют порождаемую ими нагрузку на Интернет с помощью набора политик. Чтобы представить масштабы проблемы, необходимо учесть, что Google индексирует более 8 млрд. Web-страниц. Поиск в Интернете весьма дорог, как с точки зрения пропускной способности, необходимой для передачи Webконтента индексатору, так и с точки зрения вычислительных затрат на индексирование результатов. Политики поведения определяют, какие страницы Web-краулер должен вводить в индексатор и как часто Web-краулер должен возвращаться на какой-либо Webсайт для повторной проверки, а также т. н. "политику вежливости". Web-серверы могут запрещать работу краулеров с помощью стандартного файла robot. txt, который сообщает краулерам о том, что можно, а что нельзя просматривать на данном сервере + такие директивы как Disallow, Allow, Useragent, Crawl-delay и другие.

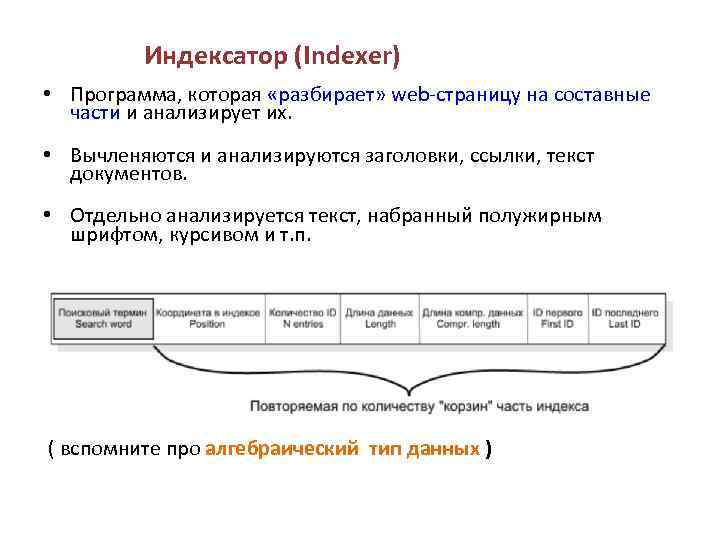

Индексатор (Indexer) • Программа, которая «разбирает» web-страницу на составные части и анализирует их. • Вычленяются и анализируются заголовки, ссылки, текст документов. • Отдельно анализируется текст, набранный полужирным шрифтом, курсивом и т. п. ( вспомните про алгебраический тип данных )

Индексатор (Indexer) • Программа, которая «разбирает» web-страницу на составные части и анализирует их. • Вычленяются и анализируются заголовки, ссылки, текст документов. • Отдельно анализируется текст, набранный полужирным шрифтом, курсивом и т. п. ( вспомните про алгебраический тип данных )

База данных (database) • Хранилище всех данных, которые поисковая система загружает и анализирует. • Требует огромных ресурсов как для хранения, так и для последующей обработки. В 2008 году 63, 272 Machines 126, 544 Processors 253, 088 GHz Proccessing ability 126, 544 GB Memory 5, 062 TB Hard Drive Space Data center Google in US

База данных (database) • Хранилище всех данных, которые поисковая система загружает и анализирует. • Требует огромных ресурсов как для хранения, так и для последующей обработки. В 2008 году 63, 272 Machines 126, 544 Processors 253, 088 GHz Proccessing ability 126, 544 GB Memory 5, 062 TB Hard Drive Space Data center Google in US

Система выдачи результатов поиска (Search Engine Results Engine - клиент)

Система выдачи результатов поиска (Search Engine Results Engine - клиент)

Индексация и индекс • Процесс загрузки информации из интернета и предварительного анализа ее поисковой машиной называют индексацией. • База данных ПС, в которой храниться вся информация – это и есть индекс , грубо говоря.

Индексация и индекс • Процесс загрузки информации из интернета и предварительного анализа ее поисковой машиной называют индексацией. • База данных ПС, в которой храниться вся информация – это и есть индекс , грубо говоря.

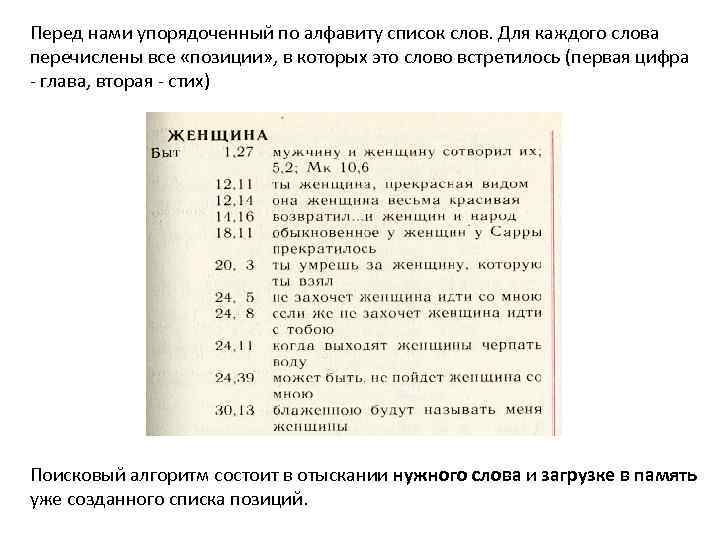

Перед нами упорядоченный по алфавиту список слов. Для каждого слова перечислены все «позиции» , в которых это слово встретилось (первая цифра - глава, вторая - стих) Поисковый алгоритм состоит в отыскании нужного слова и загрузке в память уже созданного списка позиций.

Перед нами упорядоченный по алфавиту список слов. Для каждого слова перечислены все «позиции» , в которых это слово встретилось (первая цифра - глава, вторая - стих) Поисковый алгоритм состоит в отыскании нужного слова и загрузке в память уже созданного списка позиций.

Вопрос, что индексировать • волк или волка или волку. • ЗАмок или за. МОК ( ударение) • Большие/маленькие буквы - General Motors • Пунктуация - C. Ш. А. или США (сокращение, аббревиатура). • Числа (в каком формате? ) 3/12/91, Март 12, 1991 55 В. С, В-55 • Как обрабатывать синонимы и омонимы, индексировать эквивалентные слова или расширять/уточнять запрос? • Классы эквивалентности: автомашина и автомобиль опушка – край леса или меховая обшивка одежды?

Вопрос, что индексировать • волк или волка или волку. • ЗАмок или за. МОК ( ударение) • Большие/маленькие буквы - General Motors • Пунктуация - C. Ш. А. или США (сокращение, аббревиатура). • Числа (в каком формате? ) 3/12/91, Март 12, 1991 55 В. С, В-55 • Как обрабатывать синонимы и омонимы, индексировать эквивалентные слова или расширять/уточнять запрос? • Классы эквивалентности: автомашина и автомобиль опушка – край леса или меховая обшивка одежды?

Пример - выделение корня • Сокращаем слова к их корню до их индексирования -языковая зависимость -например, бегун, побег, пробежка все сокращаются к бег. Для примера, слова бегун и бегунок предполагаются относящимися к слову бег Так корни бег совпадают с корнем бег. "алгоритм стемминга", от слова стем - "корень".

Пример - выделение корня • Сокращаем слова к их корню до их индексирования -языковая зависимость -например, бегун, побег, пробежка все сокращаются к бег. Для примера, слова бегун и бегунок предполагаются относящимися к слову бег Так корни бег совпадают с корнем бег. "алгоритм стемминга", от слова стем - "корень".

Пример - алгоритм Портера • Алгоритм не использует словарь слов и их корней, а лишь, применяя последовательно ряд правил, отсекает окончания и суффиксы, основываясь на особенностях языка, в связи с чем работает быстро, но не всегда безошибочно (не отсекает приставки!). • Соглашения + 5 -фазное сокращение – фазы применяют последовательно – каждая фаза состоит из набора команд – пример соглашения: из правил в составной команде, выбираем применимое к самому длинному суффиксу. • Типичные правила Портера – Прилагательное существительное – Множественное число единичное число The Porter Stemming Algorithm — Project «Snowball» - специальный язык для работы со строками Стеммер Портера для русского языка: Russian stemming algorithm

Пример - алгоритм Портера • Алгоритм не использует словарь слов и их корней, а лишь, применяя последовательно ряд правил, отсекает окончания и суффиксы, основываясь на особенностях языка, в связи с чем работает быстро, но не всегда безошибочно (не отсекает приставки!). • Соглашения + 5 -фазное сокращение – фазы применяют последовательно – каждая фаза состоит из набора команд – пример соглашения: из правил в составной команде, выбираем применимое к самому длинному суффиксу. • Типичные правила Портера – Прилагательное существительное – Множественное число единичное число The Porter Stemming Algorithm — Project «Snowball» - специальный язык для работы со строками Стеммер Портера для русского языка: Russian stemming algorithm

![Суффиксы имен существительных. ан-(-ян-), -анин(-янин), -ач, -ени[j-э], -ет-, -еств-(-ств-), -есть, -ец, -изм, -изн-, -ик(-ник), Суффиксы имен существительных. ан-(-ян-), -анин(-янин), -ач, -ени[j-э], -ет-, -еств-(-ств-), -есть, -ец, -изм, -изн-, -ик(-ник),](https://present5.com/presentation/17018524_177001826/image-30.jpg) Суффиксы имен существительных. ан-(-ян-), -анин(-янин), -ач, -ени[j-э], -ет-, -еств-(-ств-), -есть, -ец, -изм, -изн-, -ик(-ник), -ин, -ист, -итель(-тель), их -иц-(-ниц-), -к-, -лк, -льник, -льщик(-льщиц-), -ни[j-э], -от-, -ость, ун, -чик(-чиц-, -щик); Суффиксы прилагательных. -ал-(-ел-), -ан-(-ян-), -аст-(-ат-), -ев-(-ов-, -[j]-), -еват-(-оват-), -ен-, -енн-(-онн-), -енск-(-инск-), -ив-(-лив-, -чив-), ин- ист-, -ит- (-овит-), -к-, -л-, -н-(-шн-), -тельн-, -уч-(-юч-, -яч-), -чат-; Суффиксы глаголов. -а(ть) (-я(ть), -ка(ть)), -е(ть), -ева(ть) -ова(ть)), -и(ть), -нича(ть), -ну(ть), -ствова(ть), -ся; Суффиксы наречий. -а, -е, -и, -жды, -либо, нибудь, -о, -то, -учи(-ючи). Суффиксы местоимений. -либо, -нибудь, -то. Суффиксы субъективной оценки - алфавитный указатель А - -а(ть), -ал-, -анин, -аст-, -ач Е --е(ть), -ев-, -ева(ть), -еват-, -ел-, -ени[j-э], -енн-, -енск-, -ет-, -еств-, -есть, -ец И - -ив-, изм, -изн-, -ик, -ин-, -инск-, -ист, -ит-, -итель, -и(ть), -их-, -иц- Ж -жды К -, -ка(ть) Л-, -либо, -лив-, -лк-, -льник, -льщиц- Н-, -нибудь, -ни[j-э], -ник, -ниц-, -нича(ть), -ну(ть) О ов-, -ова(ть), -оват-, -овит-, -онн-, -от-, -ость С -ств-, -ствова(ть), -ся Т -тель, -тельн-, -то У -ун, -уч-, -учи Ч -чат-, -чив-, -чик, -чиц- Ш -шн- Щ -щик- Ю -юч-, -ючи Я -я(ть), -ян-, -янин, -яч-

Суффиксы имен существительных. ан-(-ян-), -анин(-янин), -ач, -ени[j-э], -ет-, -еств-(-ств-), -есть, -ец, -изм, -изн-, -ик(-ник), -ин, -ист, -итель(-тель), их -иц-(-ниц-), -к-, -лк, -льник, -льщик(-льщиц-), -ни[j-э], -от-, -ость, ун, -чик(-чиц-, -щик); Суффиксы прилагательных. -ал-(-ел-), -ан-(-ян-), -аст-(-ат-), -ев-(-ов-, -[j]-), -еват-(-оват-), -ен-, -енн-(-онн-), -енск-(-инск-), -ив-(-лив-, -чив-), ин- ист-, -ит- (-овит-), -к-, -л-, -н-(-шн-), -тельн-, -уч-(-юч-, -яч-), -чат-; Суффиксы глаголов. -а(ть) (-я(ть), -ка(ть)), -е(ть), -ева(ть) -ова(ть)), -и(ть), -нича(ть), -ну(ть), -ствова(ть), -ся; Суффиксы наречий. -а, -е, -и, -жды, -либо, нибудь, -о, -то, -учи(-ючи). Суффиксы местоимений. -либо, -нибудь, -то. Суффиксы субъективной оценки - алфавитный указатель А - -а(ть), -ал-, -анин, -аст-, -ач Е --е(ть), -ев-, -ева(ть), -еват-, -ел-, -ени[j-э], -енн-, -енск-, -ет-, -еств-, -есть, -ец И - -ив-, изм, -изн-, -ик, -ин-, -инск-, -ист, -ит-, -итель, -и(ть), -их-, -иц- Ж -жды К -, -ка(ть) Л-, -либо, -лив-, -лк-, -льник, -льщиц- Н-, -нибудь, -ни[j-э], -ник, -ниц-, -нича(ть), -ну(ть) О ов-, -ова(ть), -оват-, -овит-, -онн-, -от-, -ость С -ств-, -ствова(ть), -ся Т -тель, -тельн-, -то У -ун, -уч-, -учи Ч -чат-, -чив-, -чик, -чиц- Ш -шн- Щ -щик- Ю -юч-, -ючи Я -я(ть), -ян-, -янин, -яч-

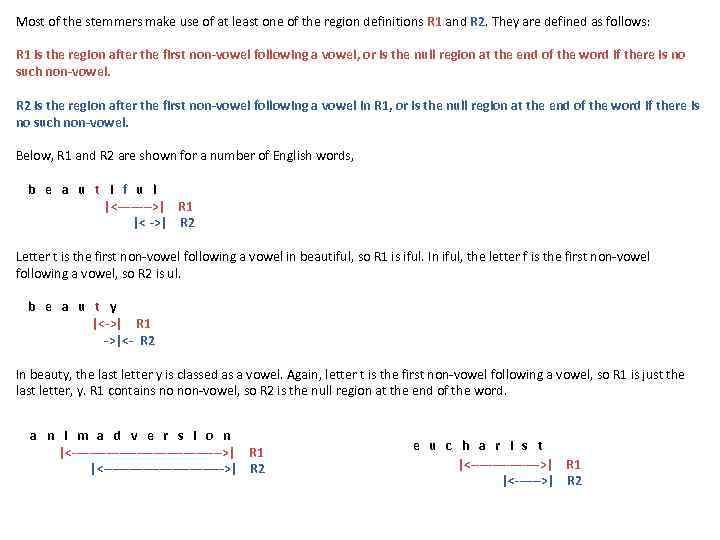

Most of the stemmers make use of at least one of the region definitions R 1 and R 2. They are defined as follows: R 1 is the region after the first non-vowel following a vowel, or is the null region at the end of the word if there is no such non-vowel. R 2 is the region after the first non-vowel following a vowel in R 1, or is the null region at the end of the word if there is no such non-vowel. Below, R 1 and R 2 are shown for a number of English words, b e a u t i f u l |<---->| R 1 |< ->| R 2 Letter t is the first non-vowel following a vowel in beautiful, so R 1 is iful. In iful, the letter f is the first non-vowel following a vowel, so R 2 is ul. b e a u t y |<->| R 1 ->|<- R 2 In beauty, the last letter y is classed as a vowel. Again, letter t is the first non-vowel following a vowel, so R 1 is just the last letter, y. R 1 contains no non-vowel, so R 2 is the null region at the end of the word. a n i m a d v e r s i o n |<------------------>| R 1 |<-------------->| R 2 e u c h a r i s t |<-------->| R 1 |<------>| R 2

Most of the stemmers make use of at least one of the region definitions R 1 and R 2. They are defined as follows: R 1 is the region after the first non-vowel following a vowel, or is the null region at the end of the word if there is no such non-vowel. R 2 is the region after the first non-vowel following a vowel in R 1, or is the null region at the end of the word if there is no such non-vowel. Below, R 1 and R 2 are shown for a number of English words, b e a u t i f u l |<---->| R 1 |< ->| R 2 Letter t is the first non-vowel following a vowel in beautiful, so R 1 is iful. In iful, the letter f is the first non-vowel following a vowel, so R 2 is ul. b e a u t y |<->| R 1 ->|<- R 2 In beauty, the last letter y is classed as a vowel. Again, letter t is the first non-vowel following a vowel, so R 1 is just the last letter, y. R 1 contains no non-vowel, so R 2 is the null region at the end of the word. a n i m a d v e r s i o n |<------------------>| R 1 |<-------------->| R 2 e u c h a r i s t |<-------->| R 1 |<------>| R 2

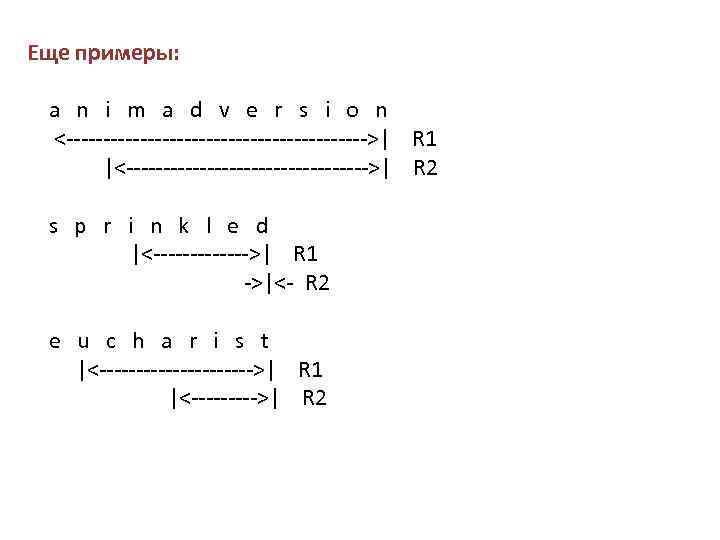

Еще примеры: a n i m a d v e r s i o n <--------------------->| R 1 |<----------------->| R 2 s p r i n k l e d |<------->| R 1 ->|<- R 2 e u c h a r i s t |<----------->| R 1 |<----->| R 2

Еще примеры: a n i m a d v e r s i o n <--------------------->| R 1 |<----------------->| R 2 s p r i n k l e d |<------->| R 1 ->|<- R 2 e u c h a r i s t |<----------->| R 1 |<----->| R 2

Механизмы и алгоритмы поиска Каждая поисковая система использует свой алгоритм поиска и его детали представляют собой ноу-хау разработчиков поисковика. (есть классификация алгоритмов и систем) Алгоритм поиска – метод, руководствуясь которым поисковая система принимает решение, включать или не включать ссылку на web-страницу в результаты поиска.

Механизмы и алгоритмы поиска Каждая поисковая система использует свой алгоритм поиска и его детали представляют собой ноу-хау разработчиков поисковика. (есть классификация алгоритмов и систем) Алгоритм поиска – метод, руководствуясь которым поисковая система принимает решение, включать или не включать ссылку на web-страницу в результаты поиска.

ПC осуществляет отбор на основании постоянно меняющихся критериев - например: • Title (заголовок): Имеется ли ключевое слово в заголовке? • Domain/URL (Домен/адрес): Имеется ли ключевое слово в имени домена / в адресе страницы? • Style (стиль): (STRONG или B), Курсив (EM или I), Заголовки HEAD. • Density (плотность): Количество ключевых слов относительно всего текста страницы называется плотностью ключевого слова. • Meta. Information (мета данные): - мета ключевые слова (meta keywords) и мета описания (meta description). • Outbound Links (ссылки наружу): Какие ссылки есть на странице и содержит ли они и ключевое слово? • Inbound Links (внешние ссылки): Имеются ли в Интернет ссылки на данный сайт? Каков текст ссылки? «внестраничный» критерий (автор страницы не всегда может им управлять). • Insite Links (ссылки внутри страницы): Какие ссылки на страницы данного сайта содержит эта страница?

ПC осуществляет отбор на основании постоянно меняющихся критериев - например: • Title (заголовок): Имеется ли ключевое слово в заголовке? • Domain/URL (Домен/адрес): Имеется ли ключевое слово в имени домена / в адресе страницы? • Style (стиль): (STRONG или B), Курсив (EM или I), Заголовки HEAD. • Density (плотность): Количество ключевых слов относительно всего текста страницы называется плотностью ключевого слова. • Meta. Information (мета данные): - мета ключевые слова (meta keywords) и мета описания (meta description). • Outbound Links (ссылки наружу): Какие ссылки есть на странице и содержит ли они и ключевое слово? • Inbound Links (внешние ссылки): Имеются ли в Интернет ссылки на данный сайт? Каков текст ссылки? «внестраничный» критерий (автор страницы не всегда может им управлять). • Insite Links (ссылки внутри страницы): Какие ссылки на страницы данного сайта содержит эта страница?

Закономерности поиска • Правило Парето • Правило S • Законы Зипфа-Мандельброта • Закономерность Брэдфорда • Закономерность Хипса

Закономерности поиска • Правило Парето • Правило S • Законы Зипфа-Мандельброта • Закономерность Брэдфорда • Закономерность Хипса

Правило Парето 80/20 Анализируя общественные процессы, Парето рассматривал социальную среду как пирамиду. В результате кропотливых исследований ученый сформулировал математическую зависимость между величиной дохода и количеством получающих его лиц. Ученый в 1906 году установил, что 80 процентов земли в Италии принадлежит лишь 20 процентам ее жителей. Парето пришел к выводу, что параметры полученного им распределения примерно одинаковы и не различаются принципиально в разных странах и в разное время. Вильфредо Парето

Правило Парето 80/20 Анализируя общественные процессы, Парето рассматривал социальную среду как пирамиду. В результате кропотливых исследований ученый сформулировал математическую зависимость между величиной дохода и количеством получающих его лиц. Ученый в 1906 году установил, что 80 процентов земли в Италии принадлежит лишь 20 процентам ее жителей. Парето пришел к выводу, что параметры полученного им распределения примерно одинаковы и не различаются принципиально в разных странах и в разное время. Вильфредо Парето

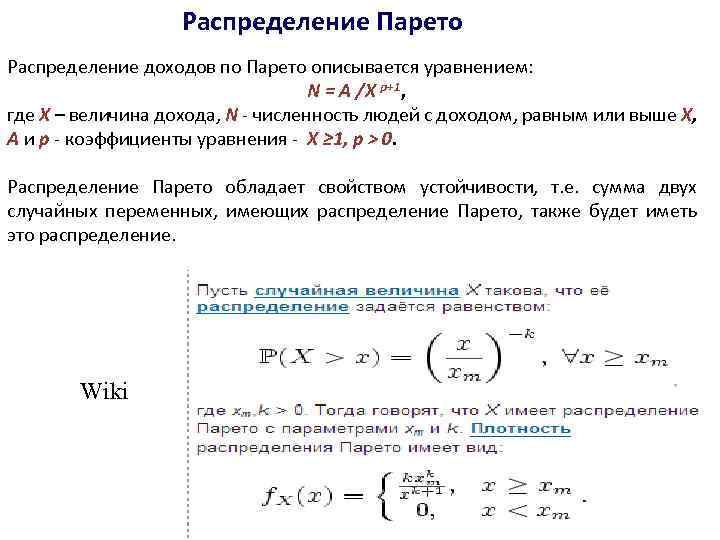

Распределение Парето Распределение доходов по Парето описывается уравнением: N = A /Х p+1, где Х – величина дохода, N - численность людей с доходом, равным или выше Х, A и p - коэффициенты уравнения - Х ≥ 1, p > 0. Распределение Парето обладает свойством устойчивости, т. е. сумма двух случайных переменных, имеющих распределение Парето, также будет иметь это распределение. Wiki

Распределение Парето Распределение доходов по Парето описывается уравнением: N = A /Х p+1, где Х – величина дохода, N - численность людей с доходом, равным или выше Х, A и p - коэффициенты уравнения - Х ≥ 1, p > 0. Распределение Парето обладает свойством устойчивости, т. е. сумма двух случайных переменных, имеющих распределение Парето, также будет иметь это распределение. Wiki

При информационном поиске достаточно определить 20% необходимых ключевых слов, позволяющих найти 80% требуемых документов. 80% посещений Web-сайта приходится лишь на 20% его Web-страниц. При создании (программировании) необходимо учитывать то, что наиболее сложным функциональным возможностям системы, на реализацию которых ушло > 80% трудозатрат будут использоваться не более, чем 20% пользователей данной системы. Если предположить, что идеальная система имеет 100% необходимых функций, а систему, которая реализует 90% функций можно создать за 10 человеко-лет, то для доведения функциональности системы до уровня 95% потребуется еще не менее 10 -ти человеко-лет. Таким образом, цена последних 5 -ти процентов равна цене всей системы, работающей с функциональностью 90%.

При информационном поиске достаточно определить 20% необходимых ключевых слов, позволяющих найти 80% требуемых документов. 80% посещений Web-сайта приходится лишь на 20% его Web-страниц. При создании (программировании) необходимо учитывать то, что наиболее сложным функциональным возможностям системы, на реализацию которых ушло > 80% трудозатрат будут использоваться не более, чем 20% пользователей данной системы. Если предположить, что идеальная система имеет 100% необходимых функций, а систему, которая реализует 90% функций можно создать за 10 человеко-лет, то для доведения функциональности системы до уровня 95% потребуется еще не менее 10 -ти человеко-лет. Таким образом, цена последних 5 -ти процентов равна цене всей системы, работающей с функциональностью 90%.

О переходе количества в качество Если система достигла 99% своей идеальной функциональности, то дальнейшие попытки ее совершенствования ведут, в лучшем случае, к повышению качества сопровождения реализованных уже функций, и, если изобразить график, отмечая по оси абсцисс затраченные ресурсы на развитие системы, а по оси ординат - уровень функциональности, то график будет иметь вид кривой, у которой в начале наблюдается резкий подъем, и которая стабилизируется – распределение Парето.

О переходе количества в качество Если система достигла 99% своей идеальной функциональности, то дальнейшие попытки ее совершенствования ведут, в лучшем случае, к повышению качества сопровождения реализованных уже функций, и, если изобразить график, отмечая по оси абсцисс затраченные ресурсы на развитие системы, а по оси ординат - уровень функциональности, то график будет иметь вид кривой, у которой в начале наблюдается резкий подъем, и которая стабилизируется – распределение Парето.

Буква S технологического прогресса В реальной жизни бывают случаи, когда после длительного процесса стабилизации происходит резкий взлет этой кривой выше уровня 100%, т. е. график принимает вид перевернутой буквы S. Этот феномен обычно бывает связан с появлением новых подходов и взглядов на ставшие уже традиционными устоявшиеся процессы.

Буква S технологического прогресса В реальной жизни бывают случаи, когда после длительного процесса стабилизации происходит резкий взлет этой кривой выше уровня 100%, т. е. график принимает вид перевернутой буквы S. Этот феномен обычно бывает связан с появлением новых подходов и взглядов на ставшие уже традиционными устоявшиеся процессы.

Законы Зипфа (Ципфа) – Мандельброта • Зипф заметил, что длинные слова встречаются в текстах любого языка реже, чем короткие. • Это по всей видимости связано с природой человека и вообще любого живого существа. • На основе этого наблюдения Зипф вывел два закона.

Законы Зипфа (Ципфа) – Мандельброта • Зипф заметил, что длинные слова встречаются в текстах любого языка реже, чем короткие. • Это по всей видимости связано с природой человека и вообще любого живого существа. • На основе этого наблюдения Зипф вывел два закона.

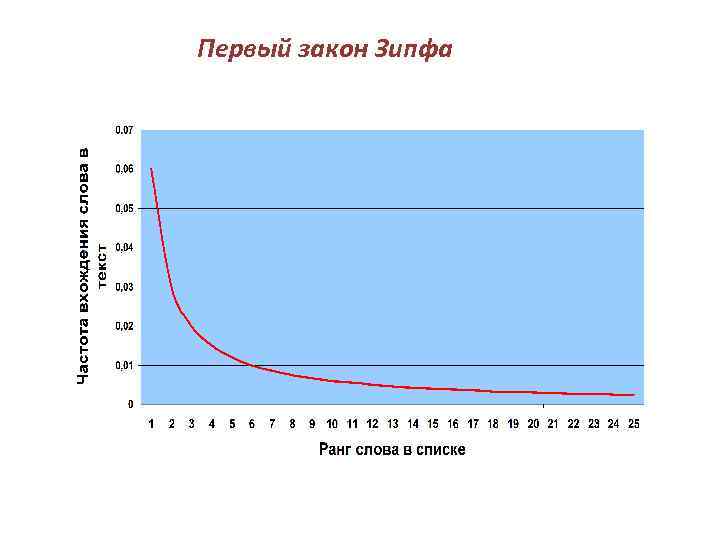

Первый закон Зипфа • Первый закон связывает частоту появления (вхождения) того или иного слова с рангом этой частоты. • Наиболее часто встречающимся словам присваивается ранг, равный единице. • Тем словам, что встречаются реже – ранг, равный двойке и т. п. • Зипф обнаружил, что произведение частоты вхождения слова и его ранга является постоянной величиной. • Такая зависимость обычно отображается гиперболой. • Значение константы Зипфа для разных языков различно, но внутри одной языковой группы оно остается неизменным. Для русского и украинского языков коэффициенты Зипфа составляют приблизительно 0, 06 -0, 07.

Первый закон Зипфа • Первый закон связывает частоту появления (вхождения) того или иного слова с рангом этой частоты. • Наиболее часто встречающимся словам присваивается ранг, равный единице. • Тем словам, что встречаются реже – ранг, равный двойке и т. п. • Зипф обнаружил, что произведение частоты вхождения слова и его ранга является постоянной величиной. • Такая зависимость обычно отображается гиперболой. • Значение константы Зипфа для разных языков различно, но внутри одной языковой группы оно остается неизменным. Для русского и украинского языков коэффициенты Зипфа составляют приблизительно 0, 06 -0, 07.

Первый закон Зипфа

Первый закон Зипфа

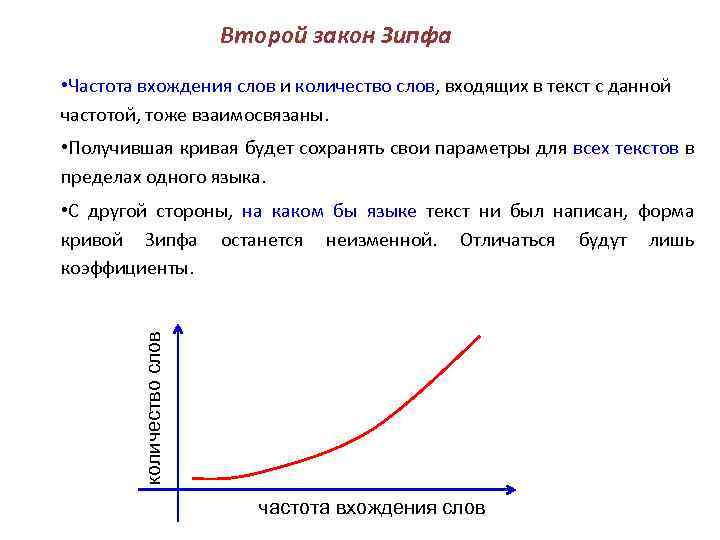

Второй закон Зипфа • Частота вхождения слов и количество слов, входящих в текст с данной частотой, тоже взаимосвязаны. • Получившая кривая будет сохранять свои параметры для всех текстов в пределах одного языка. количество слов • С другой стороны, на каком бы языке текст ни был написан, форма кривой Зипфа останется неизменной. Отличаться будут лишь коэффициенты. частота вхождения слов

Второй закон Зипфа • Частота вхождения слов и количество слов, входящих в текст с данной частотой, тоже взаимосвязаны. • Получившая кривая будет сохранять свои параметры для всех текстов в пределах одного языка. количество слов • С другой стороны, на каком бы языке текст ни был написан, форма кривой Зипфа останется неизменной. Отличаться будут лишь коэффициенты. частота вхождения слов

Следствия законов Зипфа • Законы Зипфа универсальны. Они применимы не только к текстам. • В аналогичную форму выливается, например, зависимость между количеством городов и числом проживающих в них жителей. • Характеристики популярности ресурсов интернета отвечают законам Зипфа. • В законах Зипфа отражается «человеческое» происхождение объектов – т. е. можно отличать искусственное от природного – например распределение кратеров на Луне. • Известный математик Бенуа Мандельброт математическим путём пришёл к аналогичной первому закону Зипфа зависимости f*re = c , где e - близкая к единице переменная величина, которая может изменяться в зависимости от свойств текста и языка

Следствия законов Зипфа • Законы Зипфа универсальны. Они применимы не только к текстам. • В аналогичную форму выливается, например, зависимость между количеством городов и числом проживающих в них жителей. • Характеристики популярности ресурсов интернета отвечают законам Зипфа. • В законах Зипфа отражается «человеческое» происхождение объектов – т. е. можно отличать искусственное от природного – например распределение кратеров на Луне. • Известный математик Бенуа Мандельброт математическим путём пришёл к аналогичной первому закону Зипфа зависимости f*re = c , где e - близкая к единице переменная величина, которая может изменяться в зависимости от свойств текста и языка

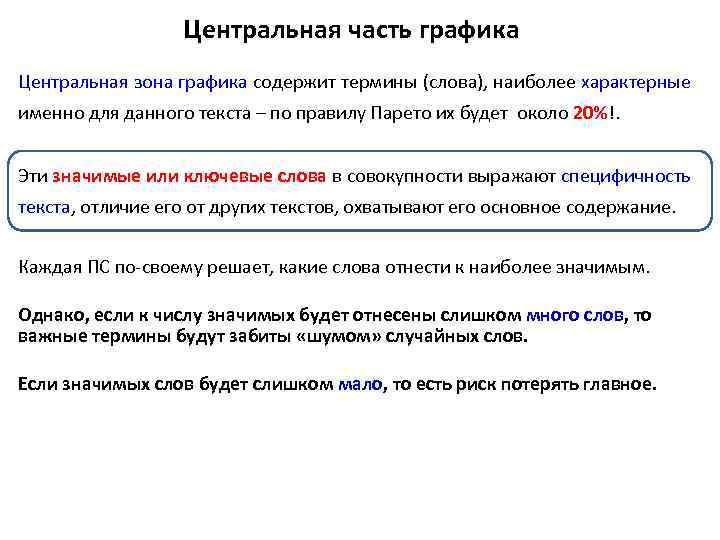

Как ПС используют законы Зипфа • Из анализа графика можно предположить, что наиболее значимые для текста слова лежат в средней части графика.

Как ПС используют законы Зипфа • Из анализа графика можно предположить, что наиболее значимые для текста слова лежат в средней части графика.

Центральная часть графика Центральная зона графика содержит термины (слова), наиболее характерные именно для данного текста – по правилу Парето их будет около 20%!. Эти значимые или ключевые слова в совокупности выражают специфичность текста, отличие его от других текстов, охватывают его основное содержание. Каждая ПС по-своему решает, какие слова отнести к наиболее значимым. Однако, если к числу значимых будет отнесены слишком много слов, то важные термины будут забиты «шумом» случайных слов. Если значимых слов будет слишком мало, то есть риск потерять главное.

Центральная часть графика Центральная зона графика содержит термины (слова), наиболее характерные именно для данного текста – по правилу Парето их будет около 20%!. Эти значимые или ключевые слова в совокупности выражают специфичность текста, отличие его от других текстов, охватывают его основное содержание. Каждая ПС по-своему решает, какие слова отнести к наиболее значимым. Однако, если к числу значимых будет отнесены слишком много слов, то важные термины будут забиты «шумом» случайных слов. Если значимых слов будет слишком мало, то есть риск потерять главное.

Стоп-слова Для того, чтобы безошибочно сузить диапазон значимых слов, создается словарь «бесполезных» слов или «стоп-слов» . Словарь этих слов ( «стоп-лист» ) содержит, например, артикли и предлоги, частицы и личные местоимения (а, без, более, был, была, были, было, быть, вам, вас, весь, вот, всего, всех, вы, где, даже, для, до, его, ее, если, есть, ещё, же, за, здесь, и, из-за, или, им, их, к, как-то, когда, кто, либо, мне, может, мы, надо, наш, него, неё, нет, них, но, ну, о, об, однако, он, она, они, оно, от, очень, под, при, с, со, также, такой, там, тем, того, тоже, той, только, том, ты, у, уже, хотя, чего, чей, чем, чтобы, чьё, чья, эта, эти, это, я), а также целый ряд других слов. Их конкретный перечень может состоять от нескольких сот до нескольких тысяч слов и различен для разных поисковых машин. . Для уменьшения размера индекса поисковой системы стоп-слова не включаются в индекс и не учитываются при поиске.

Стоп-слова Для того, чтобы безошибочно сузить диапазон значимых слов, создается словарь «бесполезных» слов или «стоп-слов» . Словарь этих слов ( «стоп-лист» ) содержит, например, артикли и предлоги, частицы и личные местоимения (а, без, более, был, была, были, было, быть, вам, вас, весь, вот, всего, всех, вы, где, даже, для, до, его, ее, если, есть, ещё, же, за, здесь, и, из-за, или, им, их, к, как-то, когда, кто, либо, мне, может, мы, надо, наш, него, неё, нет, них, но, ну, о, об, однако, он, она, они, оно, от, очень, под, при, с, со, также, такой, там, тем, того, тоже, той, только, том, ты, у, уже, хотя, чего, чей, чем, чтобы, чьё, чья, эта, эти, это, я), а также целый ряд других слов. Их конкретный перечень может состоять от нескольких сот до нескольких тысяч слов и различен для разных поисковых машин. . Для уменьшения размера индекса поисковой системы стоп-слова не включаются в индекс и не учитываются при поиске.

Весовой коэффициент При определении значимых слов применяется и т. н. «весовой коэффициент» . • Часто встречаемое на всех сайтах слово - имеет весовой коэффициент, близкий к нулю. • Слово встречаемое редко на всех сайтах- может иметь весьма высокий коэффициент. Параметр, определяющий «весовой коэффициент» , называется инверсная частота термина. ПС может вычислять «весовой коэффициент» с учетом местоположения слова внутри документа, взаимного расположения разных слов, морфологических особенностей и т. п. Необходимо например для того, чтобы ПС могла игнорировать некоторые часто встречающиеся слова - прайс, сайт, Интернет, и т. д

Весовой коэффициент При определении значимых слов применяется и т. н. «весовой коэффициент» . • Часто встречаемое на всех сайтах слово - имеет весовой коэффициент, близкий к нулю. • Слово встречаемое редко на всех сайтах- может иметь весьма высокий коэффициент. Параметр, определяющий «весовой коэффициент» , называется инверсная частота термина. ПС может вычислять «весовой коэффициент» с учетом местоположения слова внутри документа, взаимного расположения разных слов, морфологических особенностей и т. п. Необходимо например для того, чтобы ПС могла игнорировать некоторые часто встречающиеся слова - прайс, сайт, Интернет, и т. д

Модели информационного поиска Все многообразие моделей традиционного информационного поиска (IR) принято делить на три вида: • теоретико-множественные (булевская, нечётких множеств, расширенная булевская), • алгебраические (векторная, обобщённая векторная, латентносемантическая, нейросетевая) • вероятностные.

Модели информационного поиска Все многообразие моделей традиционного информационного поиска (IR) принято делить на три вида: • теоретико-множественные (булевская, нечётких множеств, расширенная булевская), • алгебраические (векторная, обобщённая векторная, латентносемантическая, нейросетевая) • вероятностные.

Большинство поисковых систем функционируют безо всяких математических моделей, так как их разработчики не ставят перед собой задачу реализовывать абстрактную модель. Как только речь заходит о повышении качества поиска, о большом объёме информации, о потоке пользовательских запросов, кроме эмпирически проставленных коэффициентов полезным оказывается оперировать какимнибудь пусть и несложным теоретическим аппаратом. Модель поиска – это некоторое упрощение реальности, на основании которого получается формула (сама по себе никому не нужная), позволяющая программе принять решение: какой документ считать найденным и как его ранжировать. После принятия модели входящие в эмпирические формулы коэффициенты приобретают физический смысл и становятся понятней.

Большинство поисковых систем функционируют безо всяких математических моделей, так как их разработчики не ставят перед собой задачу реализовывать абстрактную модель. Как только речь заходит о повышении качества поиска, о большом объёме информации, о потоке пользовательских запросов, кроме эмпирически проставленных коэффициентов полезным оказывается оперировать какимнибудь пусть и несложным теоретическим аппаратом. Модель поиска – это некоторое упрощение реальности, на основании которого получается формула (сама по себе никому не нужная), позволяющая программе принять решение: какой документ считать найденным и как его ранжировать. После принятия модели входящие в эмпирические формулы коэффициенты приобретают физический смысл и становятся понятней.

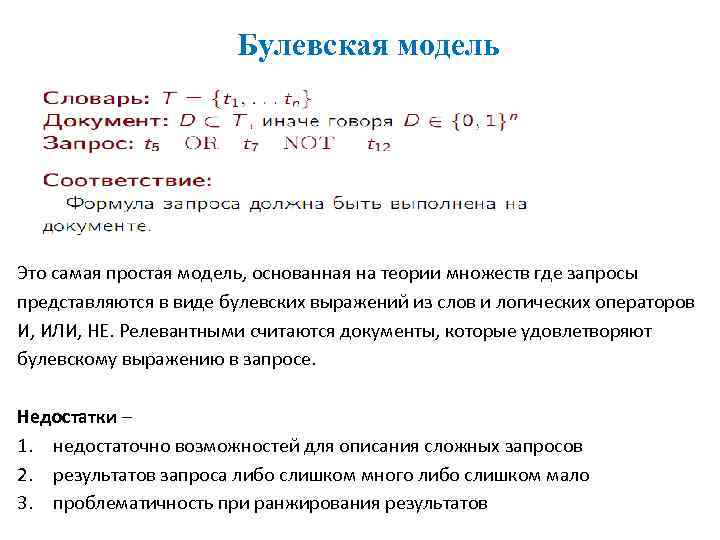

Булевская модель Это самая простая модель, основанная на теории множеств где запросы представляются в виде булевских выражений из слов и логических операторов И, ИЛИ, НЕ. Релевантными считаются документы, которые удовлетворяют булевскому выражению в запросе. Недостатки – 1. недостаточно возможностей для описания сложных запросов 2. результатов запроса либо слишком много либо слишком мало 3. проблематичность при ранжирования результатов

Булевская модель Это самая простая модель, основанная на теории множеств где запросы представляются в виде булевских выражений из слов и логических операторов И, ИЛИ, НЕ. Релевантными считаются документы, которые удовлетворяют булевскому выражению в запросе. Недостатки – 1. недостаточно возможностей для описания сложных запросов 2. результатов запроса либо слишком много либо слишком мало 3. проблематичность при ранжирования результатов

Булевская модель Матрица документ-термин C(d, t) показывает какие встречаются слова t и в каких документах d C(d, t) 1 1 1 0 1 Запрос: q = a И ( b ИЛИ (НЕ c) ) 0 1 1 0 0 1 53

Булевская модель Матрица документ-термин C(d, t) показывает какие встречаются слова t и в каких документах d C(d, t) 1 1 1 0 1 Запрос: q = a И ( b ИЛИ (НЕ c) ) 0 1 1 0 0 1 53

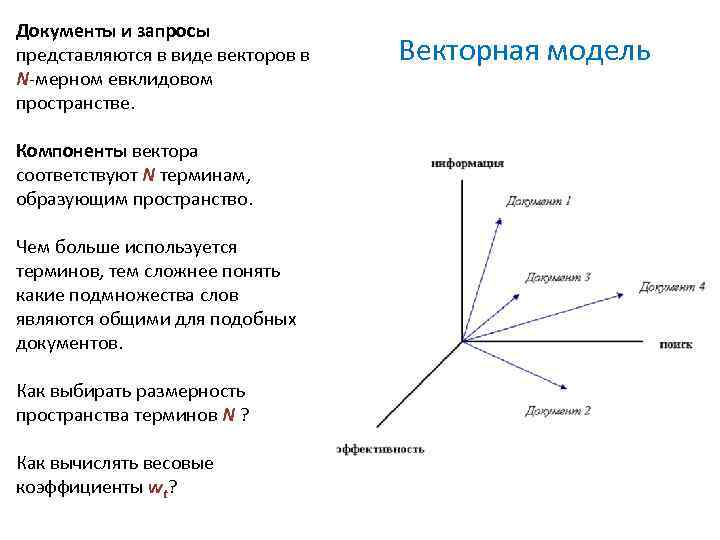

Документы и запросы представляются в виде векторов в N-мерном евклидовом пространстве. Компоненты вектора соответствуют N терминам, образующим пространство. Чем больше используется терминов, тем сложнее понять какие подмножества слов являются общими для подобных документов. Как выбирать размерность пространства терминов N ? Как вычислять весовые коэффициенты wt? Векторная модель

Документы и запросы представляются в виде векторов в N-мерном евклидовом пространстве. Компоненты вектора соответствуют N терминам, образующим пространство. Чем больше используется терминов, тем сложнее понять какие подмножества слов являются общими для подобных документов. Как выбирать размерность пространства терминов N ? Как вычислять весовые коэффициенты wt? Векторная модель

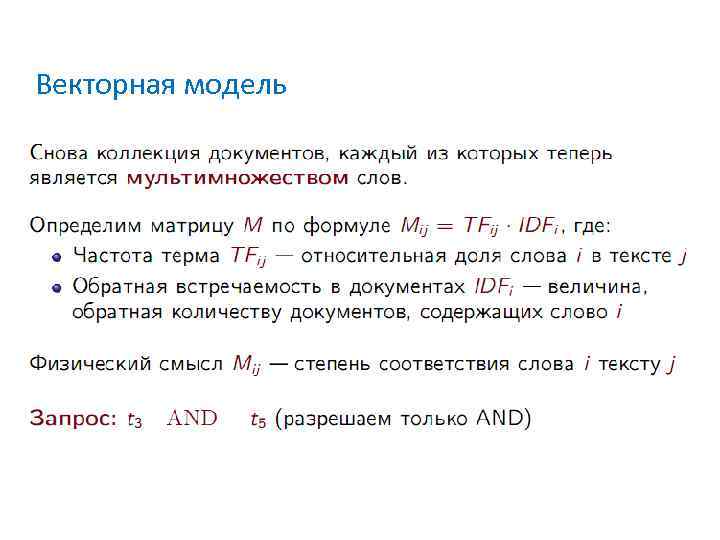

Векторная модель

Векторная модель

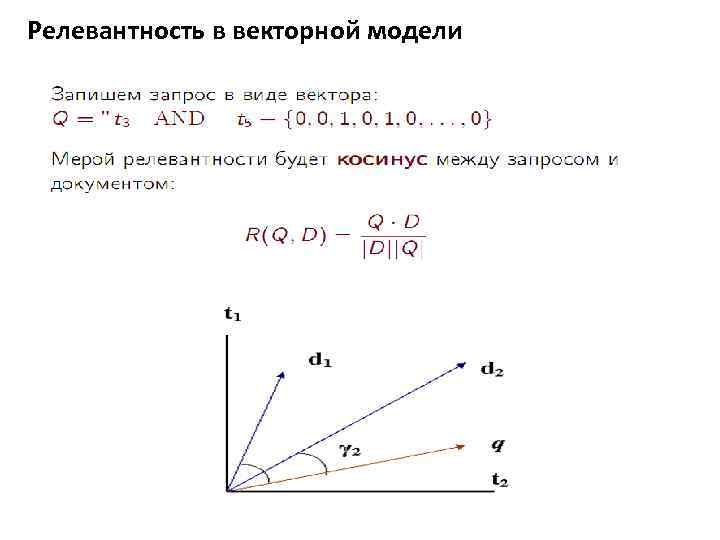

Релевантность в векторной модели

Релевантность в векторной модели

Достоинства: 1. Учет весов повышает эффективность поиска 2. Позволяет оценить степень соответствия документа запросу 3. Косинусная метрика удобна при ранжировании Недостатки 1. Нет достаточного теоретического обоснования для построения пространства терминов 2. Поскольку термины не являются независимыми друг от друга, то они не могут быть полностью ортогональными Пример • В каких из русских сказок есть слово волк, но нет упоминания медведя и поросенка?

Достоинства: 1. Учет весов повышает эффективность поиска 2. Позволяет оценить степень соответствия документа запросу 3. Косинусная метрика удобна при ранжировании Недостатки 1. Нет достаточного теоретического обоснования для построения пространства терминов 2. Поскольку термины не являются независимыми друг от друга, то они не могут быть полностью ортогональными Пример • В каких из русских сказок есть слово волк, но нет упоминания медведя и поросенка?

Вектор слово-документной встречаемости медведь волк поросенок мышь бабушка Три поросенка Красная Шапочка 0 Колобок Теремок 0 1 1 0 0 1 0, если слова нет в документе, 1 если есть 1 0

Вектор слово-документной встречаемости медведь волк поросенок мышь бабушка Три поросенка Красная Шапочка 0 Колобок Теремок 0 1 1 0 0 1 0, если слова нет в документе, 1 если есть 1 0

Итак мы имеем вектора из 0/1 для каждого слова размерности равной количеству документов. Запрос: В каких из русских сказок есть слово волк, но нет упоминания медведя и поросенка? Ответ: возьмем вектора для медведя (дополнение), волка и поросенка(дополнение) и выполним между ними побитное умножение 1100&1111&0111 = 0100 – второй документ!

Итак мы имеем вектора из 0/1 для каждого слова размерности равной количеству документов. Запрос: В каких из русских сказок есть слово волк, но нет упоминания медведя и поросенка? Ответ: возьмем вектора для медведя (дополнение), волка и поросенка(дополнение) и выполним между ними побитное умножение 1100&1111&0111 = 0100 – второй документ!

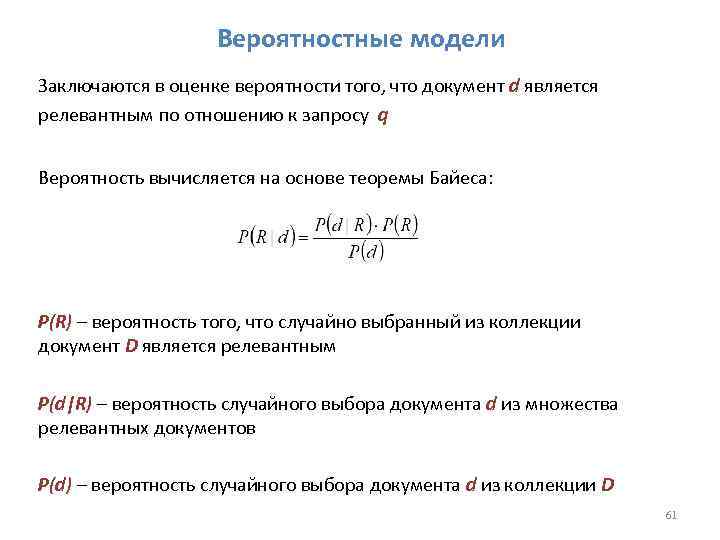

Вероятностные модели Заключаются в оценке вероятности того, что документ d является релевантным по отношению к запросу q Вероятность вычисляется на основе теоремы Байеса: P(R) – вероятность того, что случайно выбранный из коллекции документ D является релевантным P(d|R) – вероятность случайного выбора документа d из множества релевантных документов P(d) – вероятность случайного выбора документа d из коллекции D 61

Вероятностные модели Заключаются в оценке вероятности того, что документ d является релевантным по отношению к запросу q Вероятность вычисляется на основе теоремы Байеса: P(R) – вероятность того, что случайно выбранный из коллекции документ D является релевантным P(d|R) – вероятность случайного выбора документа d из множества релевантных документов P(d) – вероятность случайного выбора документа d из коллекции D 61

Google Page Rank

Google Page Rank

Все его используют, но мало кто знает, как он работает и как его вычисляют. Поиск среди миллиардов существующих и миллионов создаваемых каждый день страниц, задача более сложная, чем вы можете сразу представить. Page. Rank, только один из сотен факторов, используемых Google для улучшения качества поиска. Но как он работает, и какие факторы на него влияют, а какие нет, и, что мы знаем о Page. Rank?

Все его используют, но мало кто знает, как он работает и как его вычисляют. Поиск среди миллиардов существующих и миллионов создаваемых каждый день страниц, задача более сложная, чем вы можете сразу представить. Page. Rank, только один из сотен факторов, используемых Google для улучшения качества поиска. Но как он работает, и какие факторы на него влияют, а какие нет, и, что мы знаем о Page. Rank?

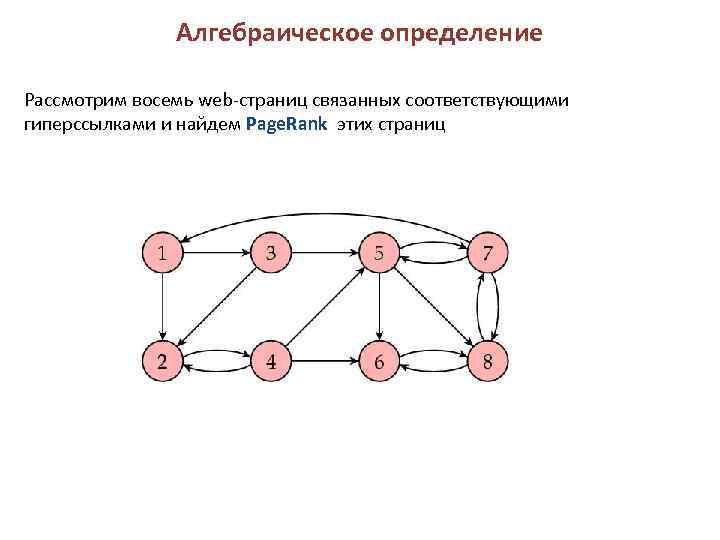

Алгебраическое определение Рассмотрим восемь web-страниц связанных соответствующими гиперссылками и найдем Page. Rank этих страниц

Алгебраическое определение Рассмотрим восемь web-страниц связанных соответствующими гиперссылками и найдем Page. Rank этих страниц

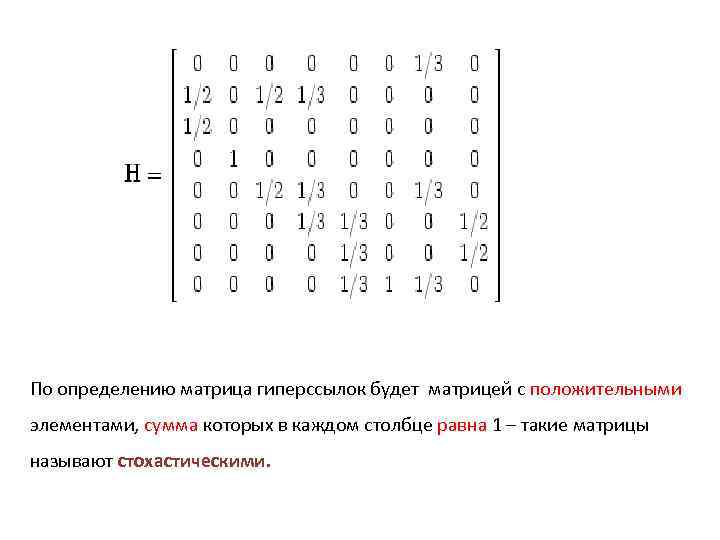

По определению матрица гиперссылок будет матрицей с положительными элементами, сумма которых в каждом столбце равна 1 – такие матрицы называют стохастическими.

По определению матрица гиперссылок будет матрицей с положительными элементами, сумма которых в каждом столбце равна 1 – такие матрицы называют стохастическими.

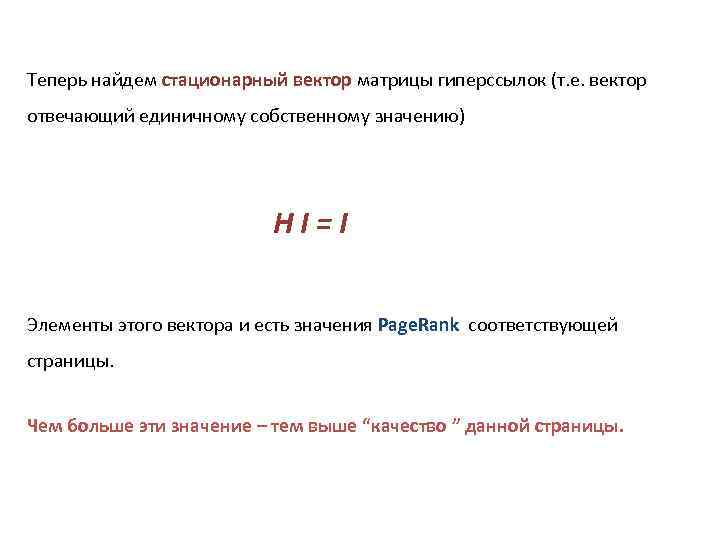

Теперь найдем стационарный вектор матрицы гиперссылок (т. е. вектор отвечающий единичному собственному значению) H I = I Элементы этого вектора и есть значения Page. Rank соответствующей страницы. Чем больше эти значение – тем выше “качество ” данной страницы.

Теперь найдем стационарный вектор матрицы гиперссылок (т. е. вектор отвечающий единичному собственному значению) H I = I Элементы этого вектора и есть значения Page. Rank соответствующей страницы. Чем больше эти значение – тем выше “качество ” данной страницы.

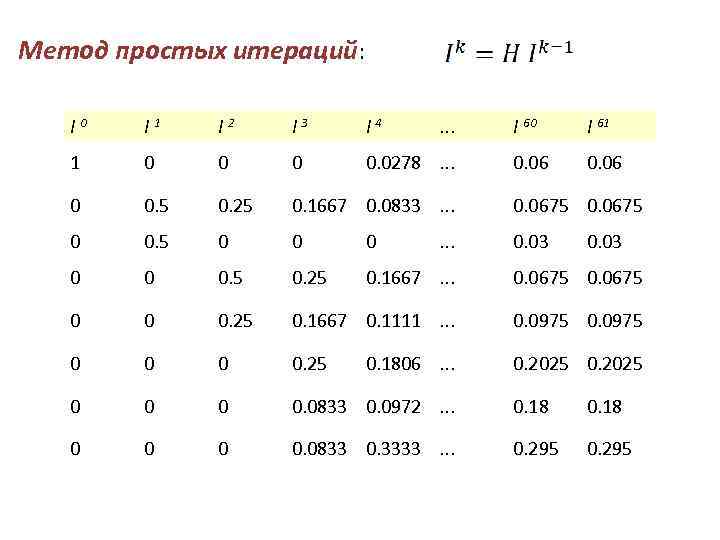

Метод простых итераций: I 0 I 1 I 2 I 3 I 4 . . . 1 0 0. 0278. . . 0 0. 5 0. 25 0. 1667 0. 0833. . . 0. 0675 0 0. 03 0 0 0. 5 0. 25 0. 1667. . . 0. 0675 0 0 0. 25 0. 1667 0. 1111. . . 0. 0975 0 0. 25 0. 2025 0 0. 0833 0. 0972. . . 0. 18 0 0. 0833 0. 3333. . . 0. 295 . . . 0. 1806. . . I 60 I 61 0. 06 0. 03

Метод простых итераций: I 0 I 1 I 2 I 3 I 4 . . . 1 0 0. 0278. . . 0 0. 5 0. 25 0. 1667 0. 0833. . . 0. 0675 0 0. 03 0 0 0. 5 0. 25 0. 1667. . . 0. 0675 0 0 0. 25 0. 1667 0. 1111. . . 0. 0975 0 0. 25 0. 2025 0 0. 0833 0. 0972. . . 0. 18 0 0. 0833 0. 3333. . . 0. 295 . . . 0. 1806. . . I 60 I 61 0. 06 0. 03

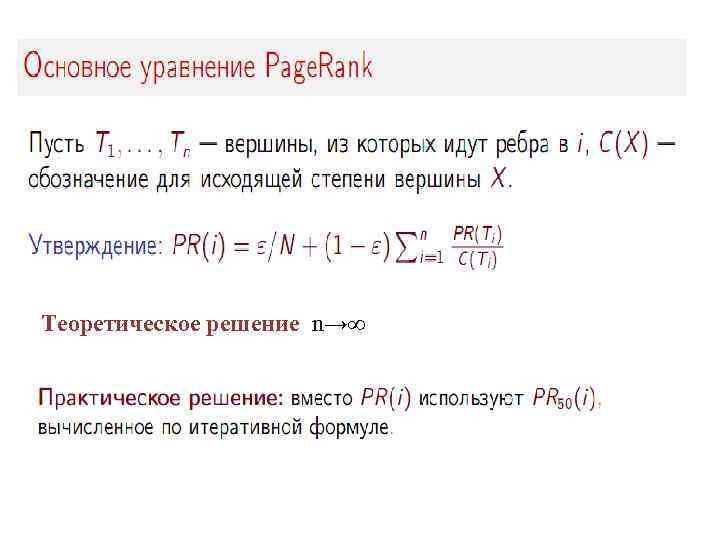

Теоретическое решение n→∞

Теоретическое решение n→∞

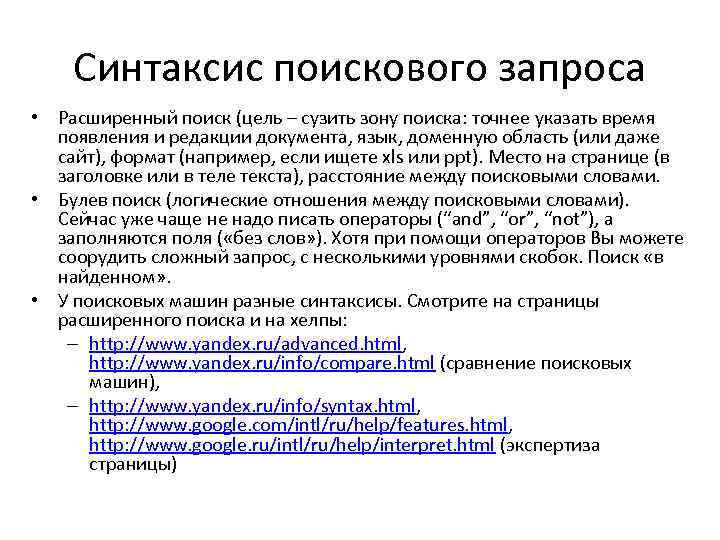

Синтаксис поискового запроса • Расширенный поиск (цель – сузить зону поиска: точнее указать время появления и редакции документа, язык, доменную область (или даже сайт), формат (например, если ищете xls или ppt). Место на странице (в заголовке или в теле текста), расстояние между поисковыми словами. • Булев поиск (логические отношения между поисковыми словами). Сейчас уже чаще не надо писать операторы (“and”, “or”, “not”), а заполняются поля ( «без слов» ). Хотя при помощи операторов Вы можете соорудить сложный запрос, с несколькими уровнями скобок. Поиск «в найденном» . • У поисковых машин разные синтаксисы. Смотрите на страницы расширенного поиска и на хелпы: – http: //www. yandex. ru/advanced. html, http: //www. yandex. ru/info/compare. html (сравнение поисковых машин), – http: //www. yandex. ru/info/syntax. html, http: //www. google. com/intl/ru/help/features. html, http: //www. google. ru/intl/ru/help/interpret. html (экспертиза страницы)

Синтаксис поискового запроса • Расширенный поиск (цель – сузить зону поиска: точнее указать время появления и редакции документа, язык, доменную область (или даже сайт), формат (например, если ищете xls или ppt). Место на странице (в заголовке или в теле текста), расстояние между поисковыми словами. • Булев поиск (логические отношения между поисковыми словами). Сейчас уже чаще не надо писать операторы (“and”, “or”, “not”), а заполняются поля ( «без слов» ). Хотя при помощи операторов Вы можете соорудить сложный запрос, с несколькими уровнями скобок. Поиск «в найденном» . • У поисковых машин разные синтаксисы. Смотрите на страницы расширенного поиска и на хелпы: – http: //www. yandex. ru/advanced. html, http: //www. yandex. ru/info/compare. html (сравнение поисковых машин), – http: //www. yandex. ru/info/syntax. html, http: //www. google. com/intl/ru/help/features. html, http: //www. google. ru/intl/ru/help/interpret. html (экспертиза страницы)

Для примера: советы по поиску в Яндексе http: //www. yandex. ru/ya_detail. html • Проверяйте орфографию • Используйте синонимы • Ищите больше, чем по одному слову • Не пишите большими буквами • Найти похожие документы Если один из найденных документов ближе к искомой теме, чем остальные, нажмите на ссылку "найти похожие документы". Ссылка расположена под краткими описаниями найденных документов. Яndex проанализирует страницу и найдет документы, похожие на тот, что вы указали. • Используйте знаки "+" и "-" "путеводитель по парижу -агентство -тур". • Попробуйте использовать язык запросов • Искать без морфологии • Поиск картинок и фотографий Была еще полезная вещь – трункация: подстановка вместо неизвестных или любых символов искомого слова (допустим, окончаний) специальных символов (чаще всего – «? » = «один любой символ» и «*» = «любое количество символов» ). Но с реализацией русской морфологии – исчезла?

Для примера: советы по поиску в Яндексе http: //www. yandex. ru/ya_detail. html • Проверяйте орфографию • Используйте синонимы • Ищите больше, чем по одному слову • Не пишите большими буквами • Найти похожие документы Если один из найденных документов ближе к искомой теме, чем остальные, нажмите на ссылку "найти похожие документы". Ссылка расположена под краткими описаниями найденных документов. Яndex проанализирует страницу и найдет документы, похожие на тот, что вы указали. • Используйте знаки "+" и "-" "путеводитель по парижу -агентство -тур". • Попробуйте использовать язык запросов • Искать без морфологии • Поиск картинок и фотографий Была еще полезная вещь – трункация: подстановка вместо неизвестных или любых символов искомого слова (допустим, окончаний) специальных символов (чаще всего – «? » = «один любой символ» и «*» = «любое количество символов» ). Но с реализацией русской морфологии – исчезла?

Примеры фишек Google: • Неспециализированные для ученых: подсказки правописания, калькулятор, поиск карт, картинок, товаров, определений, синонимов и т. п. Ansvers – платные вопросы • Специализированные для ученых: – http: //books. google. com/ и http: //print. google. com/ - поиск и покупка книг, бумажных и электронных, с возможностью частичного предварительного ознакомления. – http: //scholar. google. com/ - поиск только внутри «официального» научного Интернета (журналы и библиотеки с репутацией, кто кого цитирует). – Groups - группы новостей (сетевые конференции, телеконференции). Т. е. тематические обсуждения в Интернете (форумы). – News – новости (события), о которых (в т. ч. и давно) писали разные авторы и ресурсы. • Высокая степень персонализации: Google desktop (ну очень медленно индексирует!), история поисков, настройка панели виджетов, можно пытаться агрегировать новостные ленты (http: //www. google. com/reader/) и т. п. – www. google. com/alerts - можно заказать (ежедневные) оповещения электронной почтой: например, с новостями на определенную тему или, допустим, заставить Гугл регулярно проводить интересующий Вас сложный поиск. Учитывать ли (как и при рассылках) рекламу, замусоривание ящика…

Примеры фишек Google: • Неспециализированные для ученых: подсказки правописания, калькулятор, поиск карт, картинок, товаров, определений, синонимов и т. п. Ansvers – платные вопросы • Специализированные для ученых: – http: //books. google. com/ и http: //print. google. com/ - поиск и покупка книг, бумажных и электронных, с возможностью частичного предварительного ознакомления. – http: //scholar. google. com/ - поиск только внутри «официального» научного Интернета (журналы и библиотеки с репутацией, кто кого цитирует). – Groups - группы новостей (сетевые конференции, телеконференции). Т. е. тематические обсуждения в Интернете (форумы). – News – новости (события), о которых (в т. ч. и давно) писали разные авторы и ресурсы. • Высокая степень персонализации: Google desktop (ну очень медленно индексирует!), история поисков, настройка панели виджетов, можно пытаться агрегировать новостные ленты (http: //www. google. com/reader/) и т. п. – www. google. com/alerts - можно заказать (ежедневные) оповещения электронной почтой: например, с новостями на определенную тему или, допустим, заставить Гугл регулярно проводить интересующий Вас сложный поиск. Учитывать ли (как и при рассылках) рекламу, замусоривание ящика…

«Видимый» и «невидимый» (неиндексированный) Интернет Кузнецов С. Как вести бизнес-разведку в «невидимом» интернете http: //www. rususa. com/news. asp-nid-21056 -catid-2 • базы данных (в т. ч. библиографические записи) и прочие неформаты • страницы глубокой вложенности • ответы на динамическую информацию (т. е. все, где пользователь что-то должен ввести, простыми поисковиками не индексируется) • с момента прошедшего индексирования (как правило, несколько месяцев) • соотношения между сайтами и т. д. Если чего не нашли в Интернете, это не означает, что этого там нет или не было

«Видимый» и «невидимый» (неиндексированный) Интернет Кузнецов С. Как вести бизнес-разведку в «невидимом» интернете http: //www. rususa. com/news. asp-nid-21056 -catid-2 • базы данных (в т. ч. библиографические записи) и прочие неформаты • страницы глубокой вложенности • ответы на динамическую информацию (т. е. все, где пользователь что-то должен ввести, простыми поисковиками не индексируется) • с момента прошедшего индексирования (как правило, несколько месяцев) • соотношения между сайтами и т. д. Если чего не нашли в Интернете, это не означает, что этого там нет или не было

• Презентация «Conducting Online Research» - http: //owl. english. purdue. edu/owl/resource/558/1. • Сайт в целом: http: //owl. english. purdue. edu/sitemap/ - много по academic writing, очень полезно также для изучения «функционального английского» . • Порядка 750 презентаций – – – – The Writing Process Professional, Technical, and Job Search Writing General Academic Writing Research and Citation Grammar and Mechanics English as a Second Language (ESL) Internet Literacy Writing in the Social Sciences Writing in Engineering Literary Analysis and Criticism Creative Writing Teaching Writing Tutoring Writing

• Презентация «Conducting Online Research» - http: //owl. english. purdue. edu/owl/resource/558/1. • Сайт в целом: http: //owl. english. purdue. edu/sitemap/ - много по academic writing, очень полезно также для изучения «функционального английского» . • Порядка 750 презентаций – – – – The Writing Process Professional, Technical, and Job Search Writing General Academic Writing Research and Citation Grammar and Mechanics English as a Second Language (ESL) Internet Literacy Writing in the Social Sciences Writing in Engineering Literary Analysis and Criticism Creative Writing Teaching Writing Tutoring Writing

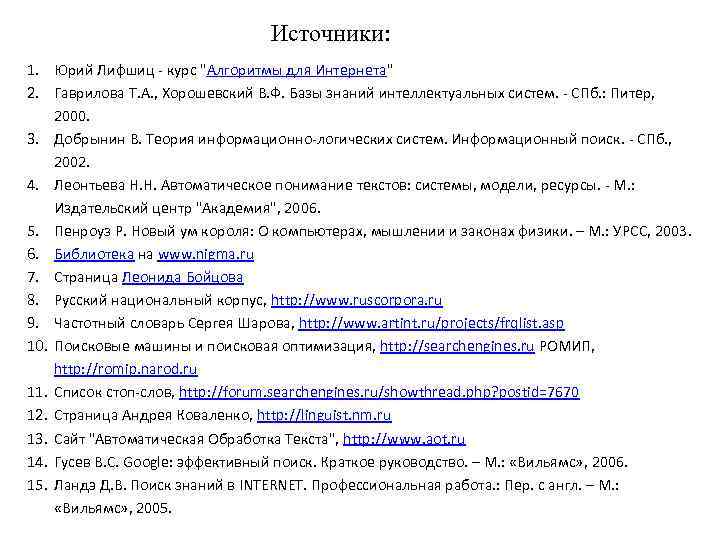

Источники: 1. Юрий Лифшиц - курс "Алгоритмы для Интернета" 2. Гаврилова Т. А. , Хорошевский В. Ф. Базы знаний интеллектуальных систем. - СПб. : Питер, 2000. 3. Добрынин В. Теория информационно-логических систем. Информационный поиск. - СПб. , 2002. 4. Леонтьева Н. Н. Автоматическое понимание текстов: системы, модели, ресурсы. - М. : Издательский центр "Академия", 2006. 5. Пенроуз Р. Новый ум короля: О компьютерах, мышлении и законах физики. – М. : УРСС, 2003. 6. Библиотека на www. nigma. ru 7. Страница Леонида Бойцова 8. Русский национальный корпус, http: //www. ruscorpora. ru 9. Частотный словарь Сергея Шарова, http: //www. artint. ru/projects/frqlist. asp 10. Поисковые машины и поисковая оптимизация, http: //searchengines. ru РОМИП, http: //romip. narod. ru 11. Список стоп-слов, http: //forum. searchengines. ru/showthread. php? postid=7670 12. Страница Андрея Коваленко, http: //linguist. nm. ru 13. Cайт "Автоматическая Обработка Текста", http: //www. aot. ru 14. Гусев В. С. Google: эффективный поиск. Краткое руководство. – М. : «Вильямс» , 2006. 15. Ландэ Д. В. Поиск знаний в INTERNET. Профессиональная работа. : Пер. с англ. – М. : «Вильямс» , 2005.

Источники: 1. Юрий Лифшиц - курс "Алгоритмы для Интернета" 2. Гаврилова Т. А. , Хорошевский В. Ф. Базы знаний интеллектуальных систем. - СПб. : Питер, 2000. 3. Добрынин В. Теория информационно-логических систем. Информационный поиск. - СПб. , 2002. 4. Леонтьева Н. Н. Автоматическое понимание текстов: системы, модели, ресурсы. - М. : Издательский центр "Академия", 2006. 5. Пенроуз Р. Новый ум короля: О компьютерах, мышлении и законах физики. – М. : УРСС, 2003. 6. Библиотека на www. nigma. ru 7. Страница Леонида Бойцова 8. Русский национальный корпус, http: //www. ruscorpora. ru 9. Частотный словарь Сергея Шарова, http: //www. artint. ru/projects/frqlist. asp 10. Поисковые машины и поисковая оптимизация, http: //searchengines. ru РОМИП, http: //romip. narod. ru 11. Список стоп-слов, http: //forum. searchengines. ru/showthread. php? postid=7670 12. Страница Андрея Коваленко, http: //linguist. nm. ru 13. Cайт "Автоматическая Обработка Текста", http: //www. aot. ru 14. Гусев В. С. Google: эффективный поиск. Краткое руководство. – М. : «Вильямс» , 2006. 15. Ландэ Д. В. Поиск знаний в INTERNET. Профессиональная работа. : Пер. с англ. – М. : «Вильямс» , 2005.

Поиско вая оптимиза ция (англ. search engine optimization, SEO) — комплекс мер для поднятия позиций сайта в результатах выдачи поисковых систем по определенным запросам пользователей. Обычно, чем выше позиция сайта в результатах поиска, тем больше заинтересованных посетителей переходит на него с поисковых систем. При анализе эффективности поисковой оптимизации оценивается стоимость целевого посетителя с учетом времени вывода сайта на указанные позиции и Конверсия сайта, на который привлекаются целевые посетители. Бе лая оптимиза ция или естественная оптимизация — поисковая оптимизация (подстройка кода, текста и других параметров сайта под алгоритмы поисковых систем с целью поднятия его позиций в выдаче) без применения запрещённых и недобросовестных методов. Это комплекс мер по повышению посещаемости веб-сайта, основанный на анализе поведения целевых посетителей. Естественная оптимизация относится к комплексу мероприятий интернет-маркетинга.

Поиско вая оптимиза ция (англ. search engine optimization, SEO) — комплекс мер для поднятия позиций сайта в результатах выдачи поисковых систем по определенным запросам пользователей. Обычно, чем выше позиция сайта в результатах поиска, тем больше заинтересованных посетителей переходит на него с поисковых систем. При анализе эффективности поисковой оптимизации оценивается стоимость целевого посетителя с учетом времени вывода сайта на указанные позиции и Конверсия сайта, на который привлекаются целевые посетители. Бе лая оптимиза ция или естественная оптимизация — поисковая оптимизация (подстройка кода, текста и других параметров сайта под алгоритмы поисковых систем с целью поднятия его позиций в выдаче) без применения запрещённых и недобросовестных методов. Это комплекс мер по повышению посещаемости веб-сайта, основанный на анализе поведения целевых посетителей. Естественная оптимизация относится к комплексу мероприятий интернет-маркетинга.

Чёрная оптимизация — поисковая оптимизация (подстройка кода, текста и других параметров сайта под алгоритмы поисковых систем с целью поднятия его позиций в выдаче) с применением запрещённых и недобросовестных методов. К чёрной оптимизации относится использование дорвеев — страниц и ресурсов, созданных (зачастую автоматически) специально для роботов поисковых систем. В теории человек не должен читать текст, который размещен на дорвее, так как он представляет собой бессмысленный набор ключевых слов, используемых в возможных поисковых запросах. Как правило, дорвеи рассчитаны на привлечение с поисковых систем посетителей, использующих в поиске любые поисковые запросы. Другой способ черной оптимизации — клоакинг: пользователю отдается одна страница, читабельная, а поисковому роботу — другая, оптимизированная под какиелибо запросы. Похожий способ — немедленная замена текста на странице сразу же после индексации этой страницы поисковой системой. Также к чёрным методам SEO можно отнести использование скрытого текста на страницах сайта. Для пользователей данный текст не виден, однако поисковые роботы легко его индексируют. Обычно в скрытом тексте содержатся ключевые слова для придания «веса» оптимизируемой странице. Еще одним способом черной оптимизации являются «однопиксельные ссылки» . Использование графических изображений-ссылок размером 1*1 пиксель (то есть фактически невидимых посетителю) также воспринимается поисковыми системами как попытка обмана и может привести к бану сайта.

Чёрная оптимизация — поисковая оптимизация (подстройка кода, текста и других параметров сайта под алгоритмы поисковых систем с целью поднятия его позиций в выдаче) с применением запрещённых и недобросовестных методов. К чёрной оптимизации относится использование дорвеев — страниц и ресурсов, созданных (зачастую автоматически) специально для роботов поисковых систем. В теории человек не должен читать текст, который размещен на дорвее, так как он представляет собой бессмысленный набор ключевых слов, используемых в возможных поисковых запросах. Как правило, дорвеи рассчитаны на привлечение с поисковых систем посетителей, использующих в поиске любые поисковые запросы. Другой способ черной оптимизации — клоакинг: пользователю отдается одна страница, читабельная, а поисковому роботу — другая, оптимизированная под какиелибо запросы. Похожий способ — немедленная замена текста на странице сразу же после индексации этой страницы поисковой системой. Также к чёрным методам SEO можно отнести использование скрытого текста на страницах сайта. Для пользователей данный текст не виден, однако поисковые роботы легко его индексируют. Обычно в скрытом тексте содержатся ключевые слова для придания «веса» оптимизируемой странице. Еще одним способом черной оптимизации являются «однопиксельные ссылки» . Использование графических изображений-ссылок размером 1*1 пиксель (то есть фактически невидимых посетителю) также воспринимается поисковыми системами как попытка обмана и может привести к бану сайта.