LS_2_2tema_-_13_02_14_2.ppt

- Количество слайдов: 11

3. Теория информации § Г. Хелд. Технологии передачи данных. § Случайность характера информации § Показатели качества систем передачи § Количество информации. Энтропия. Избыточность источника. Rev. 1. 01 / 06. 02. 20 13 Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

3. Теория информации § Г. Хелд. Технологии передачи данных. § Случайность характера информации § Показатели качества систем передачи § Количество информации. Энтропия. Избыточность источника. Rev. 1. 01 / 06. 02. 20 13 Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Передача данных в электросвязи Техника передачи информации с каждым годом приобретает все большее значение, являлась одним из основных компонентов современных систем управления, в том числе и автоматизированного. Она находит применение в системах магистральной, дорожной, отделенческой и станционной технологической связи, в системах связи с подвижными объектами (поездная, станционная, ремонтно-оперативная радиосвязь, системы громкоговорящего оповещения и индуктивной связи), в системах многоканальной связи, нефте- и газопроводах и т. Д. Если бы передаваемое сообщение было детерминированным, т. е. заранее известным с полной достоверностью, то передача его не имела бы никакого смысла. Такое детерминированное сообщение не содержит информации. Поэтому сообщение следует рассматривать как случайные события (или случайные величины, случайные функции). Случайный характер сообщений сигналов, а также помех обусловил важнейшие значения математической теории вероятности в построении теории связи. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Передача данных в электросвязи Техника передачи информации с каждым годом приобретает все большее значение, являлась одним из основных компонентов современных систем управления, в том числе и автоматизированного. Она находит применение в системах магистральной, дорожной, отделенческой и станционной технологической связи, в системах связи с подвижными объектами (поездная, станционная, ремонтно-оперативная радиосвязь, системы громкоговорящего оповещения и индуктивной связи), в системах многоканальной связи, нефте- и газопроводах и т. Д. Если бы передаваемое сообщение было детерминированным, т. е. заранее известным с полной достоверностью, то передача его не имела бы никакого смысла. Такое детерминированное сообщение не содержит информации. Поэтому сообщение следует рассматривать как случайные события (или случайные величины, случайные функции). Случайный характер сообщений сигналов, а также помех обусловил важнейшие значения математической теории вероятности в построении теории связи. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Случайный характер сообщений Вероятностные свойства сигналов и сообщения, а также среды, в которой передается сигнал, позволяют определить количество передаваемой информации и ее потери. Чтобы сравнивать между собой различные источники сообщения и различные каналы связи, необходимо ввести некоторую количественную меру, позволяющую оценивать содержащуюся в сообщении и переносимую сигналом информацию. Строгие методы количественного определения информации были предложены Шенноном в 1948 г. и привели к построению теории информации, являющейся математической основой теории связи и кодирования, информатики, основ теории ВС и ряда смежных отраслей науки и техники. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Случайный характер сообщений Вероятностные свойства сигналов и сообщения, а также среды, в которой передается сигнал, позволяют определить количество передаваемой информации и ее потери. Чтобы сравнивать между собой различные источники сообщения и различные каналы связи, необходимо ввести некоторую количественную меру, позволяющую оценивать содержащуюся в сообщении и переносимую сигналом информацию. Строгие методы количественного определения информации были предложены Шенноном в 1948 г. и привели к построению теории информации, являющейся математической основой теории связи и кодирования, информатики, основ теории ВС и ряда смежных отраслей науки и техники. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Символ как вид сигнала Особым видом сигнала в системе передач информации являются символы. СИМВОЛЫ - элемент из заданного множества n элементов. Они отличаются от сигнала естественного происхождения и создаются самоорганизующими системами и предназначаются для передачи и хранения информации. Виды символов: 1) входящие в организованную систему(знаки дорожного движения, музыка, речь, языки естественные и искусственные); 2) внесистемные - созданные временно, для небольших количеств людей(языки жестов и поз). АЛФАВИТ - упорядоченный список различимых символов, из которых путем комбинации строятся сообщение данного языка). СЛОВО (машинное) – единицы, имеющие фиксированную длину, например, 16 или 32 двоичного разряда. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Символ как вид сигнала Особым видом сигнала в системе передач информации являются символы. СИМВОЛЫ - элемент из заданного множества n элементов. Они отличаются от сигнала естественного происхождения и создаются самоорганизующими системами и предназначаются для передачи и хранения информации. Виды символов: 1) входящие в организованную систему(знаки дорожного движения, музыка, речь, языки естественные и искусственные); 2) внесистемные - созданные временно, для небольших количеств людей(языки жестов и поз). АЛФАВИТ - упорядоченный список различимых символов, из которых путем комбинации строятся сообщение данного языка). СЛОВО (машинное) – единицы, имеющие фиксированную длину, например, 16 или 32 двоичного разряда. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Показатели качества передачи СКОРОСТЬ движения информации приеме, передаче и обработки определяется числом единиц информации, отнесенным к единице времени: бит/сек; операции/мкс; знаков/с и т. д. Также косвенно - мера информации характеризуется временем передачи, обработки информации для конкретного оборудования. Для единицы количества информации выбирается информация, содержащаяся в некотором элементарном сообщении. Такое сообщение образуется в результате выбора одного состояния элемента из принятого набора символов равновероятных и независимых состояний, т. е. из заданного множества n элементов, например если n=2, то символ называется двоичным. Таким образом, сообщению соответствует максимальное количество информации, приходящее на один символ алфавита. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Показатели качества передачи СКОРОСТЬ движения информации приеме, передаче и обработки определяется числом единиц информации, отнесенным к единице времени: бит/сек; операции/мкс; знаков/с и т. д. Также косвенно - мера информации характеризуется временем передачи, обработки информации для конкретного оборудования. Для единицы количества информации выбирается информация, содержащаяся в некотором элементарном сообщении. Такое сообщение образуется в результате выбора одного состояния элемента из принятого набора символов равновероятных и независимых состояний, т. е. из заданного множества n элементов, например если n=2, то символ называется двоичным. Таким образом, сообщению соответствует максимальное количество информации, приходящее на один символ алфавита. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

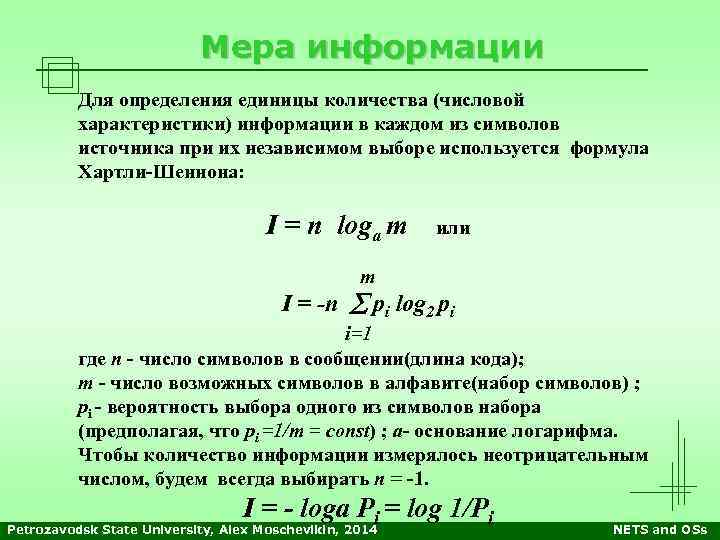

Мера информации Для определения единицы количества (числовой характеристики) информации в каждом из символов источника при их независимом выборе используется формула Хартли-Шеннона: I = n loga m или m I = -n pi log 2 pi i=1 где n - число символов в сообщении(длина кода); m - число возможных символов в алфавите(набор символов) ; pi - вероятность выбора одного из символов набора (предполагая, что pi =1/m = const) ; a- основание логарифма. Чтобы количество информации измерялось неотрицательным числом, будем всегда выбирать n = -1. I = - logа Pi = log 1/Pi Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Мера информации Для определения единицы количества (числовой характеристики) информации в каждом из символов источника при их независимом выборе используется формула Хартли-Шеннона: I = n loga m или m I = -n pi log 2 pi i=1 где n - число символов в сообщении(длина кода); m - число возможных символов в алфавите(набор символов) ; pi - вероятность выбора одного из символов набора (предполагая, что pi =1/m = const) ; a- основание логарифма. Чтобы количество информации измерялось неотрицательным числом, будем всегда выбирать n = -1. I = - logа Pi = log 1/Pi Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

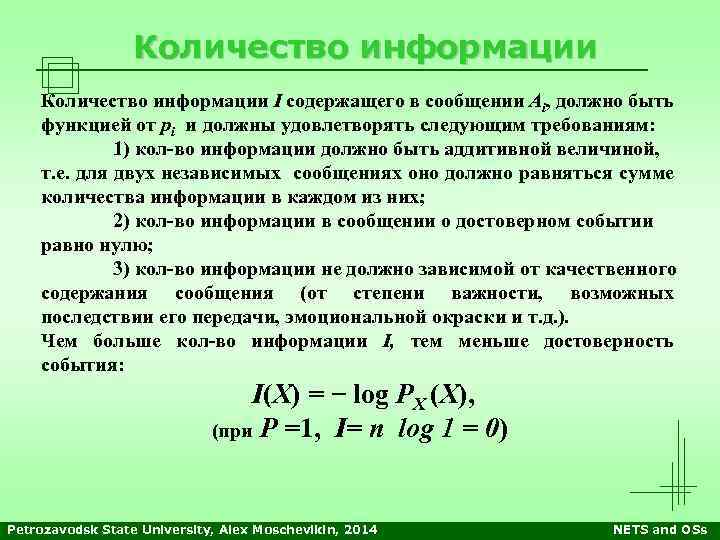

Количество информации I содержащего в сообщении Ai, должно быть функцией от pi и должны удовлетворять следующим требованиям: 1) кол-во информации должно быть аддитивной величиной, т. е. для двух независимых сообщениях оно должно равняться сумме количества информации в каждом из них; 2) кол-во информации в сообщении о достоверном событии равно нулю; 3) кол-во информации не должно зависимой от качественного содержания сообщения (от степени важности, возможных последствии его передачи, эмоциональной окраски и т. д. ). Чем больше кол-во информации I, тем меньше достоверность события: I(X) = − log PX (X), (при Р =1, I= n log 1 = 0) Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Количество информации I содержащего в сообщении Ai, должно быть функцией от pi и должны удовлетворять следующим требованиям: 1) кол-во информации должно быть аддитивной величиной, т. е. для двух независимых сообщениях оно должно равняться сумме количества информации в каждом из них; 2) кол-во информации в сообщении о достоверном событии равно нулю; 3) кол-во информации не должно зависимой от качественного содержания сообщения (от степени важности, возможных последствии его передачи, эмоциональной окраски и т. д. ). Чем больше кол-во информации I, тем меньше достоверность события: I(X) = − log PX (X), (при Р =1, I= n log 1 = 0) Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

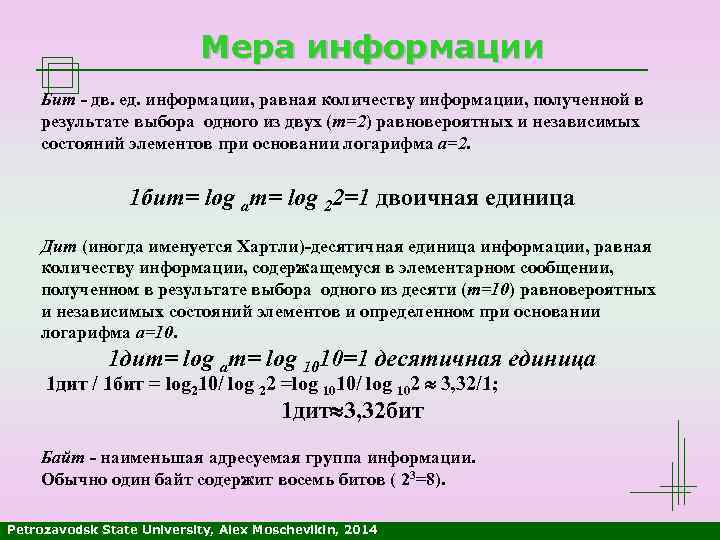

Мера информации Бит - дв. ед. информации, равная количеству информации, полученной в результате выбора одного из двух (m=2) равновероятных и независимых состояний элементов при основании логарифма a=2. 1 бит= log am= log 22=1 двоичная единица Дит (иногда именуется Хартли)-десятичная единица информации, равная количеству информации, содержащемуся в элементарном сообщении, полученном в результате выбора одного из десяти (m=10) равновероятных и независимых состояний элементов и определенном при основании логарифма a=10. 1 дит= log am= log 1010=1 десятичная единица 1 дит / 1 бит = log 210/ log 22 =log 1010/ log 102 3, 32/1; 1 дит 3, 32 бит Байт - наименьшая адресуемая группа информации. Обычно один байт содержит восемь битов ( 23=8). Petrozavodsk State University, Alex Moschevikin, 2014

Мера информации Бит - дв. ед. информации, равная количеству информации, полученной в результате выбора одного из двух (m=2) равновероятных и независимых состояний элементов при основании логарифма a=2. 1 бит= log am= log 22=1 двоичная единица Дит (иногда именуется Хартли)-десятичная единица информации, равная количеству информации, содержащемуся в элементарном сообщении, полученном в результате выбора одного из десяти (m=10) равновероятных и независимых состояний элементов и определенном при основании логарифма a=10. 1 дит= log am= log 1010=1 десятичная единица 1 дит / 1 бит = log 210/ log 22 =log 1010/ log 102 3, 32/1; 1 дит 3, 32 бит Байт - наименьшая адресуемая группа информации. Обычно один байт содержит восемь битов ( 23=8). Petrozavodsk State University, Alex Moschevikin, 2014

![ЭНТРОПИЯ ИСТОЧНИКА Среднее количество информации Н(А) [бит/символ], содержащегося в сообщении А, приходящееся на 1 ЭНТРОПИЯ ИСТОЧНИКА Среднее количество информации Н(А) [бит/символ], содержащегося в сообщении А, приходящееся на 1](https://present5.com/presentation/160921410_329432471/image-9.jpg) ЭНТРОПИЯ ИСТОЧНИКА Среднее количество информации Н(А) [бит/символ], содержащегося в сообщении А, приходящееся на 1 символ, выдаваемый дискретным источником независимых сообщений с объемом алфавита К, - есть математическое ожидание А, т. е. кол-во информации в одном случайно выбранном символе (знаке) аi : Н(А)= ИЗБЫТОЧНОСТЬ ДИСКРЕТНОГО ИСТОЧНИКА ῤu = Избыточность определяет статистическую связность между символами (память) и степень неравновероятности отдельных символов. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

ЭНТРОПИЯ ИСТОЧНИКА Среднее количество информации Н(А) [бит/символ], содержащегося в сообщении А, приходящееся на 1 символ, выдаваемый дискретным источником независимых сообщений с объемом алфавита К, - есть математическое ожидание А, т. е. кол-во информации в одном случайно выбранном символе (знаке) аi : Н(А)= ИЗБЫТОЧНОСТЬ ДИСКРЕТНОГО ИСТОЧНИКА ῤu = Избыточность определяет статистическую связность между символами (память) и степень неравновероятности отдельных символов. Petrozavodsk State University, Alex Moschevikin, 2014 NETS and OSs

Вопросы Presentation_ID © 2003 Cisco Systems, Inc. All rights reserved. 10

Вопросы Presentation_ID © 2003 Cisco Systems, Inc. All rights reserved. 10

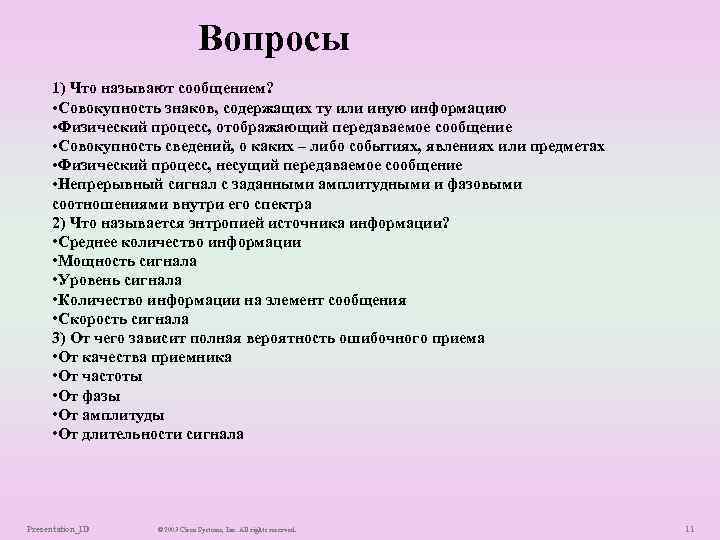

Вопросы 1) Что называют сообщением? • Совокупность знаков, содержащих ту или иную информацию • Физический процесс, отображающий передаваемое сообщение • Совокупность сведений, о каких – либо событиях, явлениях или предметах • Физический процесс, несущий передаваемое сообщение • Непрерывный сигнал с заданными амплитудными и фазовыми соотношениями внутри его спектра 2) Что называется энтропией источника информации? • Среднее количество информации • Мощность сигнала • Уровень сигнала • Количество информации на элемент сообщения • Скорость сигнала 3) От чего зависит полная вероятность ошибочного приема • От качества приемника • От частоты • От фазы • От амплитуды • От длительности сигнала Presentation_ID © 2003 Cisco Systems, Inc. All rights reserved. 11

Вопросы 1) Что называют сообщением? • Совокупность знаков, содержащих ту или иную информацию • Физический процесс, отображающий передаваемое сообщение • Совокупность сведений, о каких – либо событиях, явлениях или предметах • Физический процесс, несущий передаваемое сообщение • Непрерывный сигнал с заданными амплитудными и фазовыми соотношениями внутри его спектра 2) Что называется энтропией источника информации? • Среднее количество информации • Мощность сигнала • Уровень сигнала • Количество информации на элемент сообщения • Скорость сигнала 3) От чего зависит полная вероятность ошибочного приема • От качества приемника • От частоты • От фазы • От амплитуды • От длительности сигнала Presentation_ID © 2003 Cisco Systems, Inc. All rights reserved. 11