lek_2.ppt

- Количество слайдов: 36

2. 1. 2 Предпосылки метода наименьших квадратов Переменная Y является СВ, напрямую связанной со случайными отклонениями i. Это означает, что свойства оценок коэффициентов регрессии, а следовательно, и качество построенной регрессии существенно зависят от свойств случайной составляющей. 1

2. 1. 2 Предпосылки метода наименьших квадратов Переменная Y является СВ, напрямую связанной со случайными отклонениями i. Это означает, что свойства оценок коэффициентов регрессии, а следовательно, и качество построенной регрессии существенно зависят от свойств случайной составляющей. 1

Условия Гаусса-Маркова 1. Математическое ожидание случайного отклонения равно нулю: M( i ) = 0 для всех наблюдений. Данное условие означает, что случайное отклонение в среднем не оказывает влияния на зависимую переменную. 2

Условия Гаусса-Маркова 1. Математическое ожидание случайного отклонения равно нулю: M( i ) = 0 для всех наблюдений. Данное условие означает, что случайное отклонение в среднем не оказывает влияния на зависимую переменную. 2

В каждом конкретном наблюдении случайный член может быть либо положительным, либо отрицательным, но он не должен иметь систематического смещения. 3

В каждом конкретном наблюдении случайный член может быть либо положительным, либо отрицательным, но он не должен иметь систематического смещения. 3

2. Дисперсия случайных отклонений i постоянна: D( i )=D( j )= 2 для любых наблюдений i и j. Это значит, что в каждом конкретном наблюдении не должно быть некой априорной причины, вызывающей большую ошибку (отклонение). 4

2. Дисперсия случайных отклонений i постоянна: D( i )=D( j )= 2 для любых наблюдений i и j. Это значит, что в каждом конкретном наблюдении не должно быть некой априорной причины, вызывающей большую ошибку (отклонение). 4

Выполнимость данной предпосылки называется гомоскедастичностью (постоянством дисперсии отклонений). Невыполнимость данной предпосылки называется гетероскедастичностью. Данную предпосылку можно переписать в форме: M( i 2)= 2. 5

Выполнимость данной предпосылки называется гомоскедастичностью (постоянством дисперсии отклонений). Невыполнимость данной предпосылки называется гетероскедастичностью. Данную предпосылку можно переписать в форме: M( i 2)= 2. 5

3. Случайные отклонения i и j являются независимыми друг от друга для i j. Выполнимость данной предпосылки предполагает, что отсутствует систематическая связь между любыми случайными отклонениями. То есть величина и знак любого случайного отклонения не должны быть причинами величины и знака любого другого отклонения. 6

3. Случайные отклонения i и j являются независимыми друг от друга для i j. Выполнимость данной предпосылки предполагает, что отсутствует систематическая связь между любыми случайными отклонениями. То есть величина и знак любого случайного отклонения не должны быть причинами величины и знака любого другого отклонения. 6

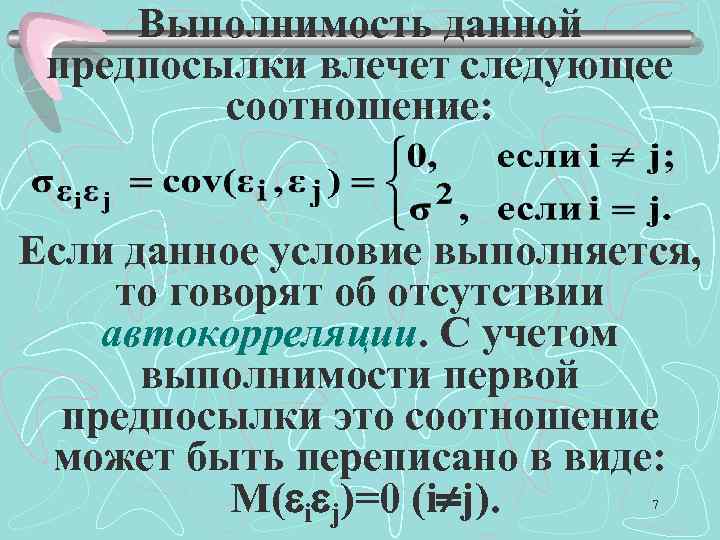

Выполнимость данной предпосылки влечет следующее соотношение: Если данное условие выполняется, то говорят об отсутствии автокорреляции. С учетом выполнимости первой предпосылки это соотношение может быть переписано в виде: M( i j)=0 (i j). 7

Выполнимость данной предпосылки влечет следующее соотношение: Если данное условие выполняется, то говорят об отсутствии автокорреляции. С учетом выполнимости первой предпосылки это соотношение может быть переписано в виде: M( i j)=0 (i j). 7

4. Случайное отклонение должно быть независимо от объясняющих переменных. 5. Модель является линейной относительно параметров. 8

4. Случайное отклонение должно быть независимо от объясняющих переменных. 5. Модель является линейной относительно параметров. 8

Теорема Гаусса-Маркова Если предпосылки 1 -5 выполнены, то оценки, полученные по МНК, обладают следующими свойствами: 1. Оценки являются несмещенными, т. е. М(b 0)= 0, М(b 1)= 1. 9

Теорема Гаусса-Маркова Если предпосылки 1 -5 выполнены, то оценки, полученные по МНК, обладают следующими свойствами: 1. Оценки являются несмещенными, т. е. М(b 0)= 0, М(b 1)= 1. 9

2. Оценки состоятельны, так как дисперсия оценок параметров при возрастании числа n наблюдений стремится к нулю. Другими словами, при увеличении объема выборки надежность оценок увеличивается (b 0 наверняка близко к 0, b 1 – близко к 1). 10

2. Оценки состоятельны, так как дисперсия оценок параметров при возрастании числа n наблюдений стремится к нулю. Другими словами, при увеличении объема выборки надежность оценок увеличивается (b 0 наверняка близко к 0, b 1 – близко к 1). 10

3. Оценки эффективны, т. е. они имеют наименьшую дисперсию по сравнению с любыми другими оценками данных параметров. В англоязычной литературе такие оценки называют BLUE (Best Linear Unbiased Estimators) – наилучшие линейные несмещенные оценки. 11

3. Оценки эффективны, т. е. они имеют наименьшую дисперсию по сравнению с любыми другими оценками данных параметров. В англоязычной литературе такие оценки называют BLUE (Best Linear Unbiased Estimators) – наилучшие линейные несмещенные оценки. 11

Если выполнены предпосылки 1 -5, то говорят о классической линейной регрессионной модели. Наряду с выполнимостью указанных предпосылок при построении классических линейных регрессионных моделей делаются еще некоторые предположения: 12

Если выполнены предпосылки 1 -5, то говорят о классической линейной регрессионной модели. Наряду с выполнимостью указанных предпосылок при построении классических линейных регрессионных моделей делаются еще некоторые предположения: 12

ü объясняющие переменные не являются СВ; üслучайные отклонения имеют нормальное распределение; üчисло наблюдений существенно больше числа объясняющих переменных; üотсутствуют ошибки спецификации. 13

ü объясняющие переменные не являются СВ; üслучайные отклонения имеют нормальное распределение; üчисло наблюдений существенно больше числа объясняющих переменных; üотсутствуют ошибки спецификации. 13

Если предпосылки 2 и 3 нарушены, т. е. дисперсия отклонений непостоянна и (или) значения i, j связаны друг с другом, то свойства несмещенности и состоятельности сохраняются, но свойство эффективности – нет. 14

Если предпосылки 2 и 3 нарушены, т. е. дисперсия отклонений непостоянна и (или) значения i, j связаны друг с другом, то свойства несмещенности и состоятельности сохраняются, но свойство эффективности – нет. 14

2. 1. 3 Анализ точности определения оценок коэффициентов регрессии В силу случайного отбора элементов в выборку случайными являются также оценки b 1 и b 0 коэффициентов 1 и 0 теоретического уравнения регрессии. 15

2. 1. 3 Анализ точности определения оценок коэффициентов регрессии В силу случайного отбора элементов в выборку случайными являются также оценки b 1 и b 0 коэффициентов 1 и 0 теоретического уравнения регрессии. 15

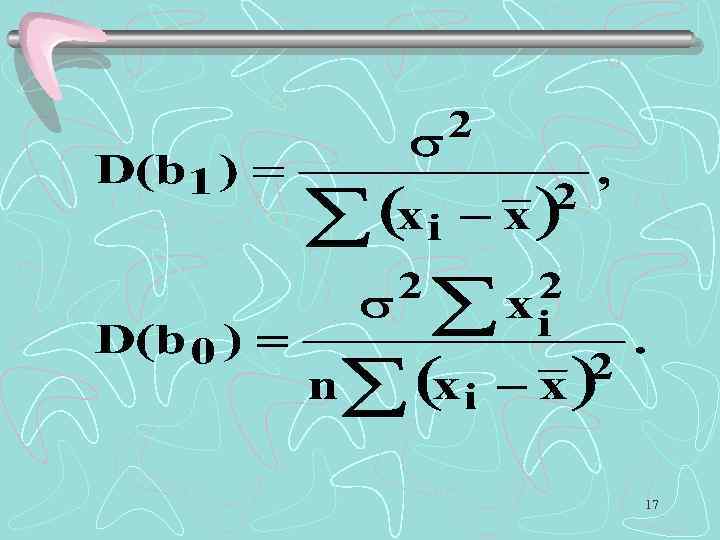

Надежность получаемых оценок 2 тесно связана с дисперсией случайных отклонений i. Формулы связи дисперсий коэффициентов D(b 0) и D(b 1) с дисперсией случайных 2 : отклонений 16

Надежность получаемых оценок 2 тесно связана с дисперсией случайных отклонений i. Формулы связи дисперсий коэффициентов D(b 0) и D(b 1) с дисперсией случайных 2 : отклонений 16

17

17

Выводы: ü Дисперсии b 0 и b 1 прямо пропорциональны дисперсии случайного отклонения. Следовательно, чем больше фактор случайности, тем менее точными будут оценки. 18

Выводы: ü Дисперсии b 0 и b 1 прямо пропорциональны дисперсии случайного отклонения. Следовательно, чем больше фактор случайности, тем менее точными будут оценки. 18

ü Чем больше число n наблюдений, тем меньше дисперсии оценок. Это вполне логично, так как чем большим числом данных мы располагаем, тем вероятнее получение более точных оценок. 19

ü Чем больше число n наблюдений, тем меньше дисперсии оценок. Это вполне логично, так как чем большим числом данных мы располагаем, тем вероятнее получение более точных оценок. 19

ü Чем больше дисперсия (разброс значений ) объясняющей переменной, тем меньше дисперсия оценок коэффициентов. Другими словами, чем шире область изменений объясняющей переменной, тем точнее будут оценки (тем меньше доля случайности в их определении). 20

ü Чем больше дисперсия (разброс значений ) объясняющей переменной, тем меньше дисперсия оценок коэффициентов. Другими словами, чем шире область изменений объясняющей переменной, тем точнее будут оценки (тем меньше доля случайности в их определении). 20

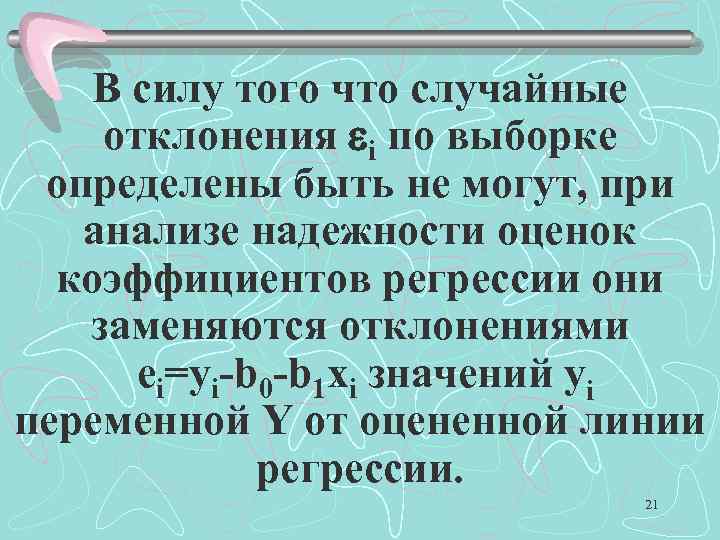

В силу того что случайные отклонения i по выборке определены быть не могут, при анализе надежности оценок коэффициентов регрессии они заменяются отклонениями ei=yi-b 0 -b 1 xi значений yi переменной Y от оцененной линии регрессии. 21

В силу того что случайные отклонения i по выборке определены быть не могут, при анализе надежности оценок коэффициентов регрессии они заменяются отклонениями ei=yi-b 0 -b 1 xi значений yi переменной Y от оцененной линии регрессии. 21

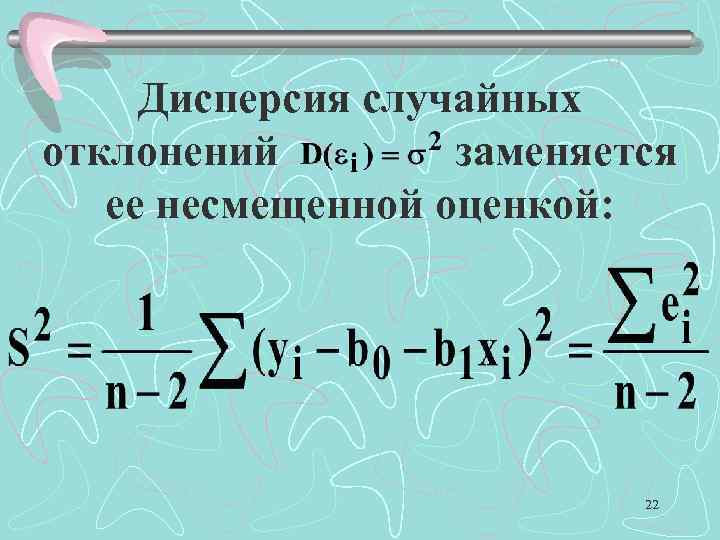

Дисперсия случайных отклонений заменяется ее несмещенной оценкой: 22

Дисперсия случайных отклонений заменяется ее несмещенной оценкой: 22

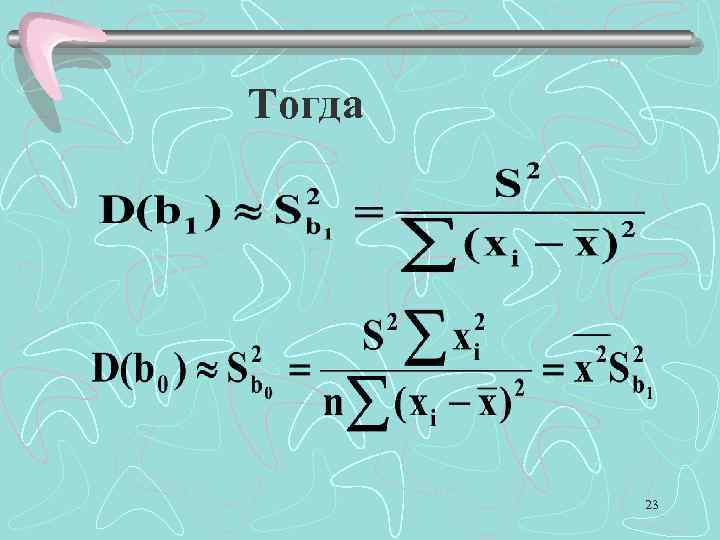

Тогда 23

Тогда 23

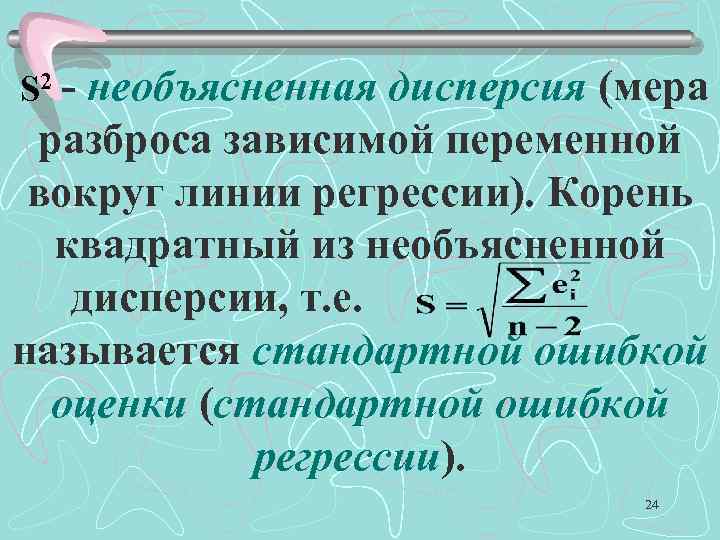

S 2 - необъясненная дисперсия (мера разброса зависимой переменной вокруг линии регрессии). Корень квадратный из необъясненной дисперсии, т. е. . называется стандартной ошибкой оценки (стандартной ошибкой регрессии). 24

S 2 - необъясненная дисперсия (мера разброса зависимой переменной вокруг линии регрессии). Корень квадратный из необъясненной дисперсии, т. е. . называется стандартной ошибкой оценки (стандартной ошибкой регрессии). 24

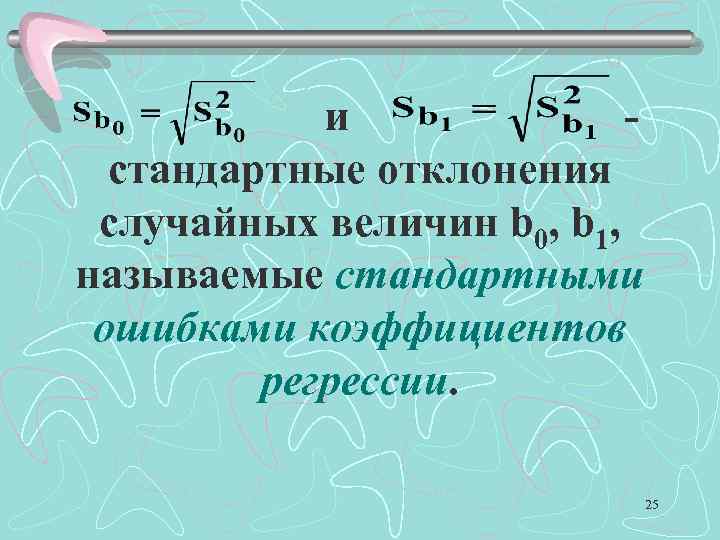

и - стандартные отклонения случайных величин b 0, b 1, называемые стандартными ошибками коэффициентов регрессии. 25

и - стандартные отклонения случайных величин b 0, b 1, называемые стандартными ошибками коэффициентов регрессии. 25

2. 1. 4 Проверка гипотез относительно коэффициентов линейного уравнения регрессии При проведении статистического анализа возникает необходимость сравнения эмпирических коэффициентов регрессии b 0 и b 1 c теоретически ожидаемыми значениями этих коэффициентов. Данный анализ осуществляется по схеме статистической проверки гипотез. 26

2. 1. 4 Проверка гипотез относительно коэффициентов линейного уравнения регрессии При проведении статистического анализа возникает необходимость сравнения эмпирических коэффициентов регрессии b 0 и b 1 c теоретически ожидаемыми значениями этих коэффициентов. Данный анализ осуществляется по схеме статистической проверки гипотез. 26

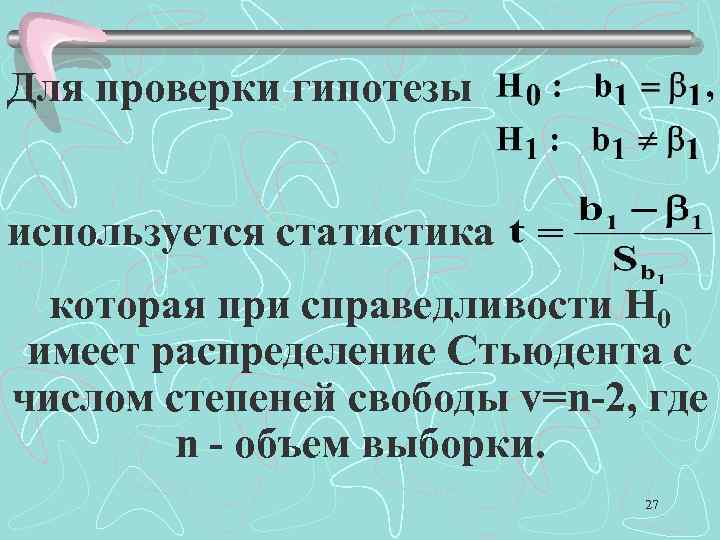

Для проверки гипотезы используется статистика которая при справедливости H 0 имеет распределение Стьюдента с числом степеней свободы v=n-2, где n - объем выборки. 27

Для проверки гипотезы используется статистика которая при справедливости H 0 имеет распределение Стьюдента с числом степеней свободы v=n-2, где n - объем выборки. 27

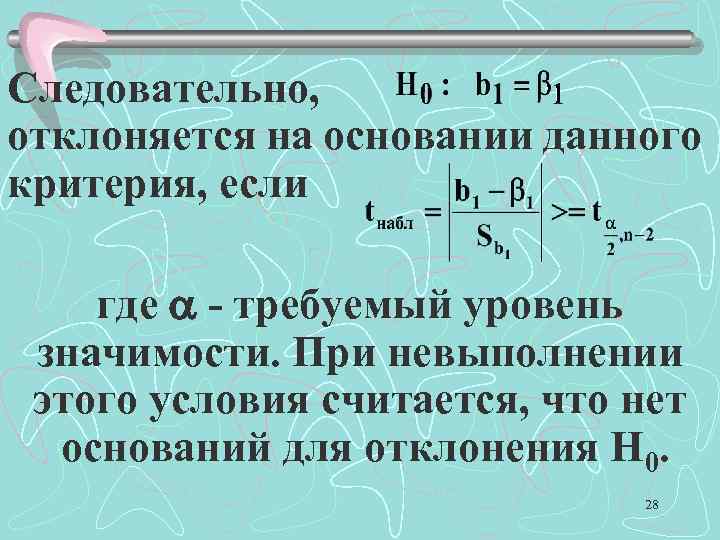

Следовательно, отклоняется на основании данного критерия, если где - требуемый уровень значимости. При невыполнении этого условия считается, что нет оснований для отклонения Н 0. 28

Следовательно, отклоняется на основании данного критерия, если где - требуемый уровень значимости. При невыполнении этого условия считается, что нет оснований для отклонения Н 0. 28

Наиболее важной на начальном этапе статистического анализа построенной модели является задача установления наличия линейной зависимости между X и Y. Эта проблема может быть решена по той же схеме: 29

Наиболее важной на начальном этапе статистического анализа построенной модели является задача установления наличия линейной зависимости между X и Y. Эта проблема может быть решена по той же схеме: 29

Гипотеза в такой постановке называется гипотезой о статистической значимости коэффициента регрессии. Если Н 0 принимается, есть основания считать, что величина Y не зависит от X. В этом случае говорят, что коэффициент b 1 статистически незначим (он слишком близок к нулю). 30

Гипотеза в такой постановке называется гипотезой о статистической значимости коэффициента регрессии. Если Н 0 принимается, есть основания считать, что величина Y не зависит от X. В этом случае говорят, что коэффициент b 1 статистически незначим (он слишком близок к нулю). 30

При отклонении Н 0 коэффициент b 1 считается статистически значимым, что указывает на наличие определенной линейной зависимости между Y и X. 31

При отклонении Н 0 коэффициент b 1 считается статистически значимым, что указывает на наличие определенной линейной зависимости между Y и X. 31

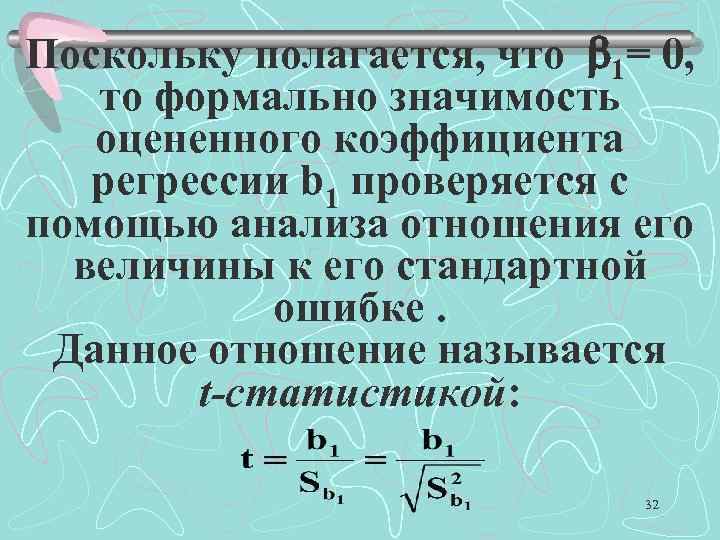

Поскольку полагается, что 1= 0, то формально значимость оцененного коэффициента регрессии b 1 проверяется с помощью анализа отношения его величины к его стандартной ошибке. Данное отношение называется t-статистикой: 32

Поскольку полагается, что 1= 0, то формально значимость оцененного коэффициента регрессии b 1 проверяется с помощью анализа отношения его величины к его стандартной ошибке. Данное отношение называется t-статистикой: 32

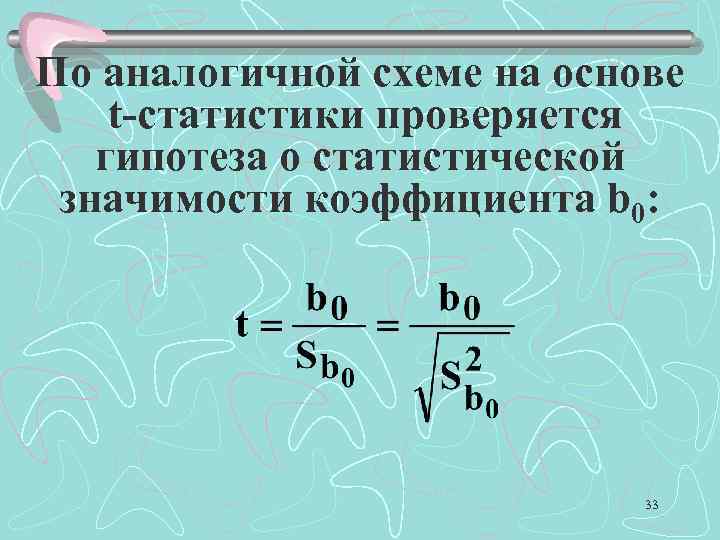

По аналогичной схеме на основе t-статистики проверяется гипотеза о статистической значимости коэффициента b 0: 33

По аналогичной схеме на основе t-статистики проверяется гипотеза о статистической значимости коэффициента b 0: 33

Для парной регрессий более важным является анализ статистической значимости коэффициента b 1, так как именно в нем скрыто влияние объясняющей переменной X на зависимую переменную Y. 34

Для парной регрессий более важным является анализ статистической значимости коэффициента b 1, так как именно в нем скрыто влияние объясняющей переменной X на зависимую переменную Y. 34

При оценке значимости коэффициента линейной регрессии на начальном этапе можно использовать следующее «грубое» правило, позволяющее не прибегать к таблицам. Если стандартная ошибка коэффициента больше его модуля (|t| 1), то коэффициент не может быть признан значимым. 35

При оценке значимости коэффициента линейной регрессии на начальном этапе можно использовать следующее «грубое» правило, позволяющее не прибегать к таблицам. Если стандартная ошибка коэффициента больше его модуля (|t| 1), то коэффициент не может быть признан значимым. 35

Если 1<|t| 2, то найденная оценка может рассматриваться как относительно (слабо) значимая. Если 2<|t| 3, то это свидетельствует о значимой линейной связи между X и У. Наконец, если |t| >3, то это почти гарантия наличия линейной связи. 36

Если 1<|t| 2, то найденная оценка может рассматриваться как относительно (слабо) значимая. Если 2<|t| 3, то это свидетельствует о значимой линейной связи между X и У. Наконец, если |t| >3, то это почти гарантия наличия линейной связи. 36