1 YARN Yet Another Resource Negotiator «ещё один ресурсный посредник»

1 YARN Yet Another Resource Negotiator «ещё один ресурсный посредник»

2 Введение YARN (Yet Another Resource Negotiator — «ещё один ресурсный посредник» ) — модуль, отвечающий за управление ресурсами кластеров и планирование заданий. Если в предыдущих выпусках эта функция была интегрирована в модуль Map. Reduce, где была реализована единым компонентом (Job. Tracker), то в YARN функционирует логически самостоятельный демон — планировщик ресурсов (Resource. Manager), абстрагирующий все вычислительные ресурсы кластера и управляющий их предоставлением приложениям распределённой обработки. Работать под управлением YARN могут как Map. Reduce-программы, так и любые другие распределённые приложения, поддерживающие соответствующие программные интерфейсы; YARN обеспечивает возможность параллельного выполнения нескольких различных задач в рамках кластера и их изоляцию. Разработчику распределённого приложения необходимо реализовать специальный класс управления приложением (Application. Master), который отвечает за координацию заданий в рамках тех ресурсов, которые предоставит планировщик ресурсов; планировщик ресурсов же отвечает за создание экземпляров класса управления приложением и взаимодействия с ним через соответствующий сетевой протокол.

2 Введение YARN (Yet Another Resource Negotiator — «ещё один ресурсный посредник» ) — модуль, отвечающий за управление ресурсами кластеров и планирование заданий. Если в предыдущих выпусках эта функция была интегрирована в модуль Map. Reduce, где была реализована единым компонентом (Job. Tracker), то в YARN функционирует логически самостоятельный демон — планировщик ресурсов (Resource. Manager), абстрагирующий все вычислительные ресурсы кластера и управляющий их предоставлением приложениям распределённой обработки. Работать под управлением YARN могут как Map. Reduce-программы, так и любые другие распределённые приложения, поддерживающие соответствующие программные интерфейсы; YARN обеспечивает возможность параллельного выполнения нескольких различных задач в рамках кластера и их изоляцию. Разработчику распределённого приложения необходимо реализовать специальный класс управления приложением (Application. Master), который отвечает за координацию заданий в рамках тех ресурсов, которые предоставит планировщик ресурсов; планировщик ресурсов же отвечает за создание экземпляров класса управления приложением и взаимодействия с ним через соответствующий сетевой протокол.

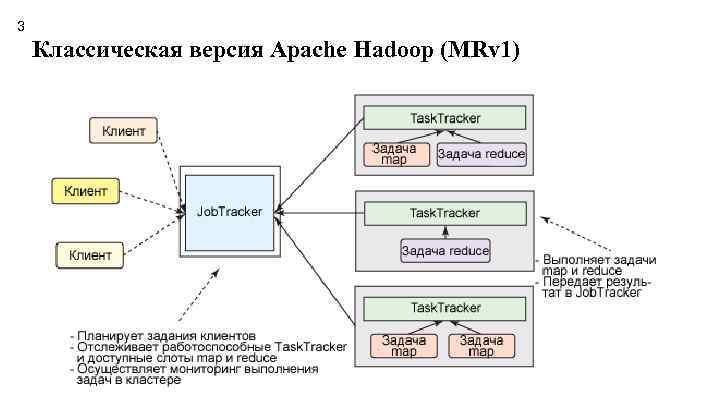

3 Классическая версия Apache Hadoop (MRv 1)

3 Классическая версия Apache Hadoop (MRv 1)

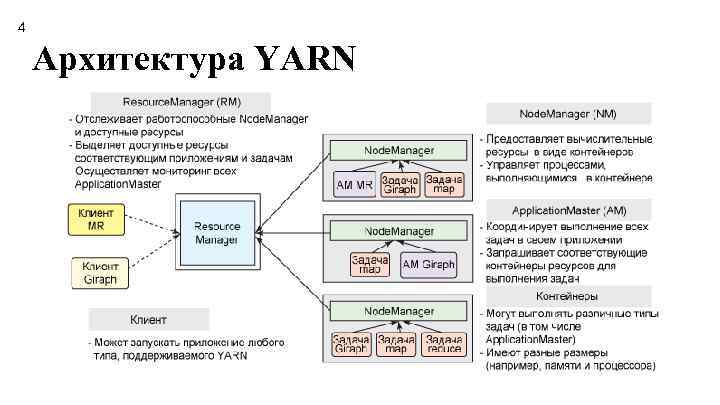

4 Архитектура YARN

4 Архитектура YARN

5 Один кластер для выполнения любого распределенного приложения Для Resource. Manager, Node. Manager и контейнера не важен тип приложения или задачи. Весь специфичный для конкретной инфраструктуры код приложения помещается в его Application. Master, чтобы YARN мог поддерживать любую распределенную инфраструктуру, если кто-то реализует для нее соответствующий Application. Master. Этот универсальный подход позволяет выполнять в кластере Hadoop YARN самые разные рабочие нагрузки. Представьте себе, что в вашем центре данных есть один кластер Hadoop, который может выполнять Map. Reduce, Giraph, Storm, Spark, Tez/Impala, MPI и многое другое.

5 Один кластер для выполнения любого распределенного приложения Для Resource. Manager, Node. Manager и контейнера не важен тип приложения или задачи. Весь специфичный для конкретной инфраструктуры код приложения помещается в его Application. Master, чтобы YARN мог поддерживать любую распределенную инфраструктуру, если кто-то реализует для нее соответствующий Application. Master. Этот универсальный подход позволяет выполнять в кластере Hadoop YARN самые разные рабочие нагрузки. Представьте себе, что в вашем центре данных есть один кластер Hadoop, который может выполнять Map. Reduce, Giraph, Storm, Spark, Tez/Impala, MPI и многое другое.

6 Подход с одним кластером обеспечивает ряд очевидных преимуществ, включая: Более эффективное использование кластера, поскольку ресурсы, не используемые одной инфраструктурой, может использовать другая. Более низкие эксплуатационные расходы, поскольку выполняются управление и настройка только одного кластера. Уменьшение движения данных, поскольку нет необходимости перемещать их между Hadoop YARN и системами, работающими на других кластерах машин.

6 Подход с одним кластером обеспечивает ряд очевидных преимуществ, включая: Более эффективное использование кластера, поскольку ресурсы, не используемые одной инфраструктурой, может использовать другая. Более низкие эксплуатационные расходы, поскольку выполняются управление и настройка только одного кластера. Уменьшение движения данных, поскольку нет необходимости перемещать их между Hadoop YARN и системами, работающими на других кластерах машин.

7 Интересные факты и возможности Уберизация (uberization) – это возможность выполнять все задачи задания Map. Reduce в виртуальной машине процесса Application. Master, если это достаточно небольшое задание. Она позволяет избежать накладных расходов на запросы контейнеров из Resource. Manager и команды процессам Node. Manager на запуск небольших задач. Двоичная совместимость или совместимость на уровне исходных кодов заданий Map. Reduce, написанных для MRv 1 (MAPREDUCE-5108). Высокая готовность Resource. Manager (YARN-149). Эта работа продолжается и уже выполнена некоторыми поставщиками. Восстановление приложения после перезапуска Resource. Manager (YARN-128). Resource. Manager хранит информацию о выполняющихся приложениях и завершенных задачах в HDFS. После перезапуска Resource. Manager воссоздает состояние приложений и выполняет только незавершенные задачи. Эта работа близка к завершению и активно тестируется сообществом. Она уже выполнена некоторыми поставщиками. Упрощенные управление и доступ к журналам пользователей. Журналы, генерируемые приложениями, не остаются на отдельных ведомых узлах (как в MRv 1), а перемещаются в центральное хранилище, например в HDFS. Затем их можно использовать при отладке или ретроспективном анализе для выявления проблем производительности. Новый внешний вид Web-интерфейса.

7 Интересные факты и возможности Уберизация (uberization) – это возможность выполнять все задачи задания Map. Reduce в виртуальной машине процесса Application. Master, если это достаточно небольшое задание. Она позволяет избежать накладных расходов на запросы контейнеров из Resource. Manager и команды процессам Node. Manager на запуск небольших задач. Двоичная совместимость или совместимость на уровне исходных кодов заданий Map. Reduce, написанных для MRv 1 (MAPREDUCE-5108). Высокая готовность Resource. Manager (YARN-149). Эта работа продолжается и уже выполнена некоторыми поставщиками. Восстановление приложения после перезапуска Resource. Manager (YARN-128). Resource. Manager хранит информацию о выполняющихся приложениях и завершенных задачах в HDFS. После перезапуска Resource. Manager воссоздает состояние приложений и выполняет только незавершенные задачи. Эта работа близка к завершению и активно тестируется сообществом. Она уже выполнена некоторыми поставщиками. Упрощенные управление и доступ к журналам пользователей. Журналы, генерируемые приложениями, не остаются на отдельных ведомых узлах (как в MRv 1), а перемещаются в центральное хранилище, например в HDFS. Затем их можно использовать при отладке или ретроспективном анализе для выявления проблем производительности. Новый внешний вид Web-интерфейса.

8 Заключение YARN предлагает очевидные преимущества в масштабируемости, эффективности и гибкости по сравнению с классическим механизмом Map. Reduce в первой версии Hadoop. Выигрыш от использования YARN получают как маленькие, так и большие кластеры. Для конечного пользователя (разработчика, а не администратора) эти изменения почти незаметны, поскольку новый механизм позволяет выполнять немодифицированные задания Map. Reduce, используя те же саме программные интерфейсы Map. Reduce и интерфейсы CLI.

8 Заключение YARN предлагает очевидные преимущества в масштабируемости, эффективности и гибкости по сравнению с классическим механизмом Map. Reduce в первой версии Hadoop. Выигрыш от использования YARN получают как маленькие, так и большие кластеры. Для конечного пользователя (разработчика, а не администратора) эти изменения почти незаметны, поскольку новый механизм позволяет выполнять немодифицированные задания Map. Reduce, используя те же саме программные интерфейсы Map. Reduce и интерфейсы CLI.