8403e6bd352358ba12a3462bdaad65b8.ppt

- Количество слайдов: 29

הרצאה מספר 9 שיטות חיפוש - חלק א' 1

הרצאה מספר 9 שיטות חיפוש - חלק א' 1

שיטות חיפוש נפוצות • • השיטה הבוליאנית ה vector-space model שיטות הסתברותיות שיטות נוספות – שילוב שתי השיטות הראשונות – Latent semantic indexing –… 2

שיטות חיפוש נפוצות • • השיטה הבוליאנית ה vector-space model שיטות הסתברותיות שיטות נוספות – שילוב שתי השיטות הראשונות – Latent semantic indexing –… 2

השיטה הבוליאנית “Boolean search commands have been used by professionals for searching through traditional databases for years. Despite this, they are overkill for the average web user. ” Danny Sullivan, http: //searchenginewatch. com/facts/boolean. html • האופרטורים הבסיסיים AND – OR – NOT – 3

השיטה הבוליאנית “Boolean search commands have been used by professionals for searching through traditional databases for years. Despite this, they are overkill for the average web user. ” Danny Sullivan, http: //searchenginewatch. com/facts/boolean. html • האופרטורים הבסיסיים AND – OR – NOT – 3

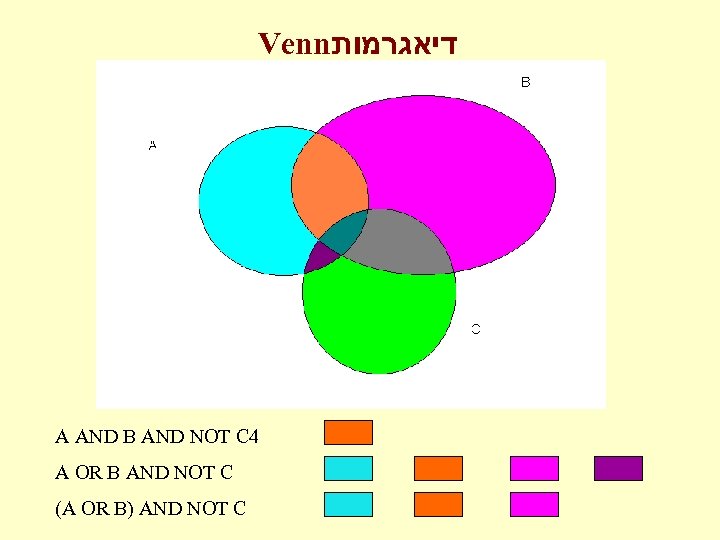

Venn דיאגרמות A AND B AND NOT C 4 A OR B AND NOT C (A OR B) AND NOT C

Venn דיאגרמות A AND B AND NOT C 4 A OR B AND NOT C (A OR B) AND NOT C

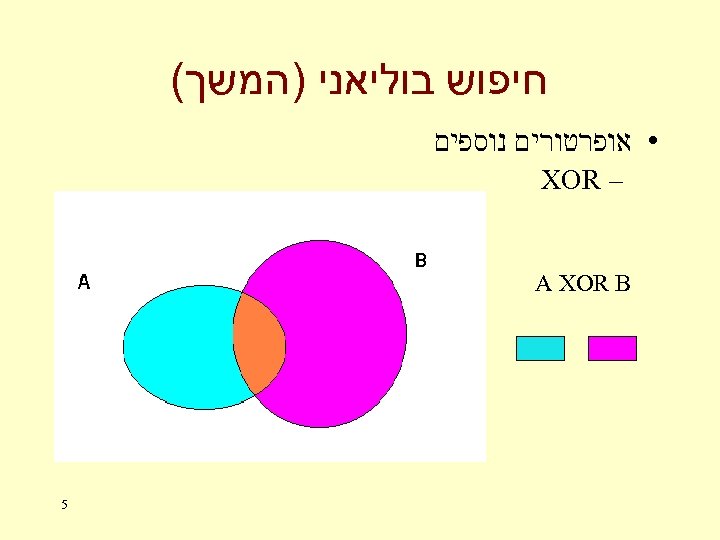

חיפוש בוליאני )המשך( • אופרטורים נוספים – XOR A XOR B 5

חיפוש בוליאני )המשך( • אופרטורים נוספים – XOR A XOR B 5

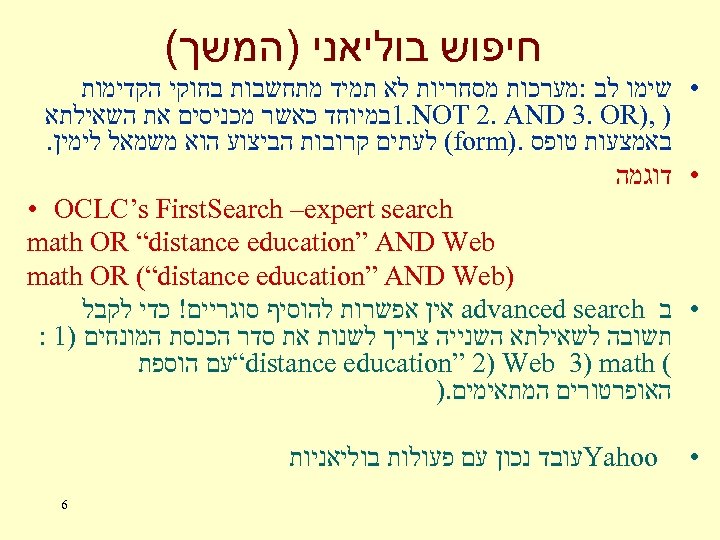

חיפוש בוליאני )המשך( • שימו לב : מערכות מסחריות לא תמיד מתחשבות בחוקי הקדימות ) , ) 1. NOT 2. AND 3. OR במיוחד כאשר מכניסים את השאילתא באמצעות טופס. ) (form לעתים קרובות הביצוע הוא משמאל לימין. • דוגמה • OCLC’s First. Search –expert search math OR “distance education” AND Web ) math OR (“distance education” AND Web • ב advanced search אין אפשרות להוסיף סוגריים! כדי לקבל תשובה לשאילתא השנייה צריך לשנות את סדר הכנסת המונחים )1 : ( “distance education” 2) Web 3) math עם הוספת האופרטורים המתאימים. ) • Yahoo עובד נכון עם פעולות בוליאניות 6

חיפוש בוליאני )המשך( • שימו לב : מערכות מסחריות לא תמיד מתחשבות בחוקי הקדימות ) , ) 1. NOT 2. AND 3. OR במיוחד כאשר מכניסים את השאילתא באמצעות טופס. ) (form לעתים קרובות הביצוע הוא משמאל לימין. • דוגמה • OCLC’s First. Search –expert search math OR “distance education” AND Web ) math OR (“distance education” AND Web • ב advanced search אין אפשרות להוסיף סוגריים! כדי לקבל תשובה לשאילתא השנייה צריך לשנות את סדר הכנסת המונחים )1 : ( “distance education” 2) Web 3) math עם הוספת האופרטורים המתאימים. ) • Yahoo עובד נכון עם פעולות בוליאניות 6

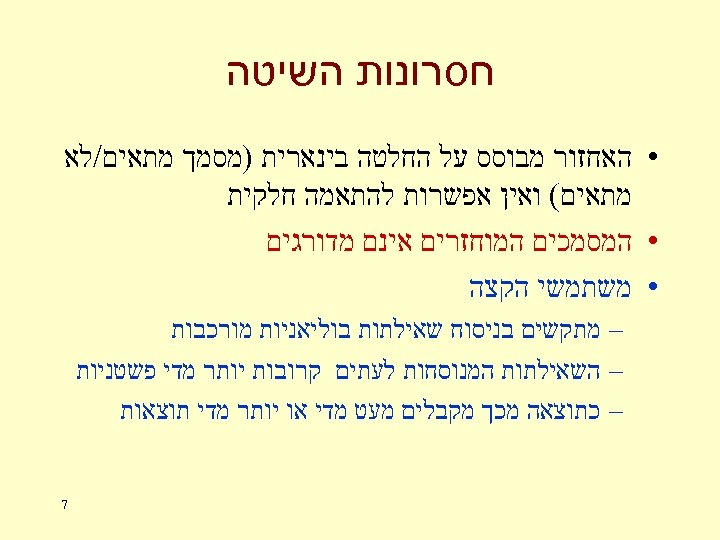

חסרונות השיטה • האחזור מבוסס על החלטה בינארית )מסמך מתאים/לא מתאים( ואין אפשרות להתאמה חלקית • המסמכים המוחזרים אינם מדורגים • משתמשי הקצה – מתקשים בניסוח שאילתות בוליאניות מורכבות – השאילתות המנוסחות לעתים קרובות יותר מדי פשטניות – כתוצאה מכך מקבלים מעט מדי או יותר מדי תוצאות 7

חסרונות השיטה • האחזור מבוסס על החלטה בינארית )מסמך מתאים/לא מתאים( ואין אפשרות להתאמה חלקית • המסמכים המוחזרים אינם מדורגים • משתמשי הקצה – מתקשים בניסוח שאילתות בוליאניות מורכבות – השאילתות המנוסחות לעתים קרובות יותר מדי פשטניות – כתוצאה מכך מקבלים מעט מדי או יותר מדי תוצאות 7

ה vector space model • • • • בשיטה זו ניתן לתת משקלות למונחים השיטה מבוססת על חישובי דמיון ) (similarity בין השאילתה למסמכים במאגר השיטה מאפשרת להחזיר מסמכים עם התאמה חלקית תוצאות החיפוש מדורגות לפי דרגת הדמיון בשיטה זו כל מסמך וכל שאילתה מיוצגים על ידי וקטור הוא סדרה של ערכים: וקטור באורך v=(v 1, v 2, v 3, …. vn) – n ניתן לייחס לוקטור גם משמעות גיאומטרית – במקרה זה הערכים vi הם קואורדינטות במרחב n ממדי 8

ה vector space model • • • • בשיטה זו ניתן לתת משקלות למונחים השיטה מבוססת על חישובי דמיון ) (similarity בין השאילתה למסמכים במאגר השיטה מאפשרת להחזיר מסמכים עם התאמה חלקית תוצאות החיפוש מדורגות לפי דרגת הדמיון בשיטה זו כל מסמך וכל שאילתה מיוצגים על ידי וקטור הוא סדרה של ערכים: וקטור באורך v=(v 1, v 2, v 3, …. vn) – n ניתן לייחס לוקטור גם משמעות גיאומטרית – במקרה זה הערכים vi הם קואורדינטות במרחב n ממדי 8

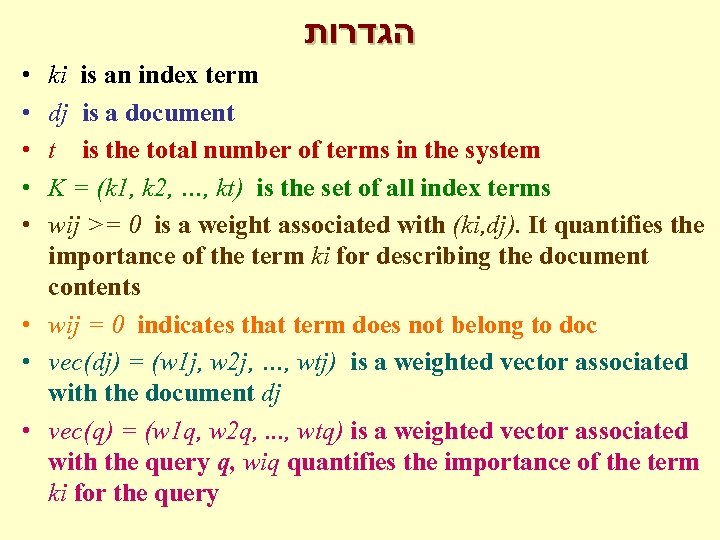

הגדרות • • • ki is an index term dj is a document t is the total number of terms in the system K = (k 1, k 2, …, kt) is the set of all index terms wij >= 0 is a weight associated with (ki, dj). It quantifies the importance of the term ki for describing the document contents • wij = 0 indicates that term does not belong to doc • vec(dj) = (w 1 j, w 2 j, …, wtj) is a weighted vector associated with the document dj • vec(q) = (w 1 q, w 2 q, . . . , wtq) is a weighted vector associated with the query q, wiq quantifies the importance of the term ki for the query

הגדרות • • • ki is an index term dj is a document t is the total number of terms in the system K = (k 1, k 2, …, kt) is the set of all index terms wij >= 0 is a weight associated with (ki, dj). It quantifies the importance of the term ki for describing the document contents • wij = 0 indicates that term does not belong to doc • vec(dj) = (w 1 j, w 2 j, …, wtj) is a weighted vector associated with the document dj • vec(q) = (w 1 q, w 2 q, . . . , wtq) is a weighted vector associated with the query q, wiq quantifies the importance of the term ki for the query

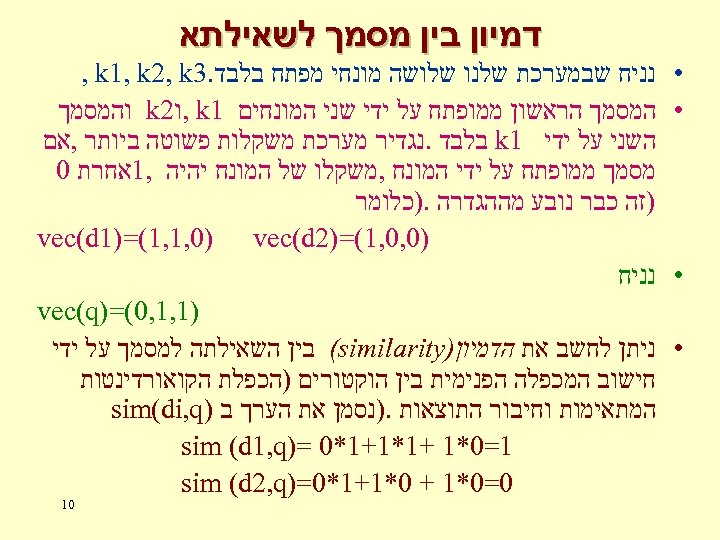

דמיון בין מסמך לשאילתא • • נניח שבמערכת שלנו שלושה מונחי מפתח בלבד. 3 , k 1, k 2, k המסמך הראשון ממופתח על ידי שני המונחים 1 , k ו 2 k והמסמך השני על ידי 1 k בלבד. נגדיר מערכת משקלות פשוטה ביותר , אם מסמך ממופתח על ידי המונח , משקלו של המונח יהיה , 1אחרת 0 )זה כבר נובע מההגדרה. )כלומר )0, 0, 1(=)2 vec(d 1)=(1, 1, 0) vec(d נניח )1, 1, 0(=) vec(q ניתן לחשב את הדמיון) (similarity בין השאילתה למסמך על ידי חישוב המכפלה הפנימית בין הוקטורים )הכפלת הקואורדינטות המתאימות וחיבור התוצאות. )נסמן את הערך ב ) sim(di, q 1=0*1 +1*1+1*0 =) sim (d 1, q 0=0*1 + 0*1+1*0=) sim (d 2, q 01

דמיון בין מסמך לשאילתא • • נניח שבמערכת שלנו שלושה מונחי מפתח בלבד. 3 , k 1, k 2, k המסמך הראשון ממופתח על ידי שני המונחים 1 , k ו 2 k והמסמך השני על ידי 1 k בלבד. נגדיר מערכת משקלות פשוטה ביותר , אם מסמך ממופתח על ידי המונח , משקלו של המונח יהיה , 1אחרת 0 )זה כבר נובע מההגדרה. )כלומר )0, 0, 1(=)2 vec(d 1)=(1, 1, 0) vec(d נניח )1, 1, 0(=) vec(q ניתן לחשב את הדמיון) (similarity בין השאילתה למסמך על ידי חישוב המכפלה הפנימית בין הוקטורים )הכפלת הקואורדינטות המתאימות וחיבור התוצאות. )נסמן את הערך ב ) sim(di, q 1=0*1 +1*1+1*0 =) sim (d 1, q 0=0*1 + 0*1+1*0=) sim (d 2, q 01

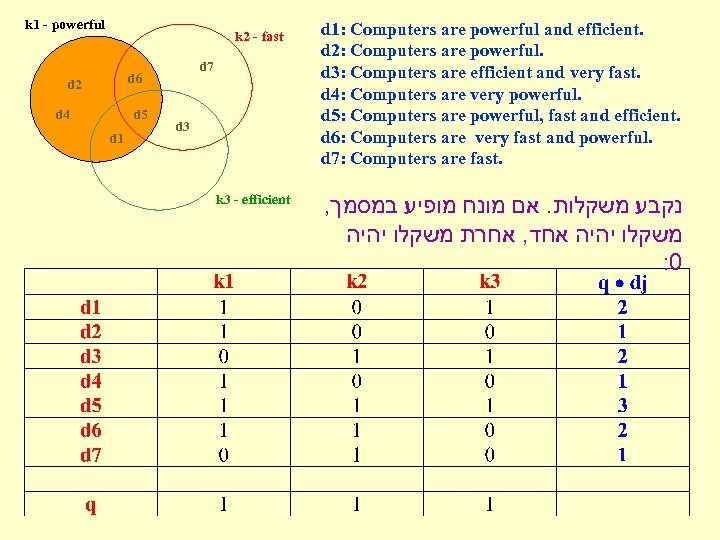

k 1 - powerful k 2 - fast d 7 d 6 d 2 d 4 d 5 d 1 d 3 k 3 - efficient d 1: Computers are powerful and efficient. d 2: Computers are powerful. d 3: Computers are efficient and very fast. d 4: Computers are very powerful. d 5: Computers are powerful, fast and efficient. d 6: Computers are very fast and powerful. d 7: Computers are fast. , נקבע משקלות. אם מונח מופיע במסמך משקלו יהיה אחד, אחרת משקלו יהיה : 0

k 1 - powerful k 2 - fast d 7 d 6 d 2 d 4 d 5 d 1 d 3 k 3 - efficient d 1: Computers are powerful and efficient. d 2: Computers are powerful. d 3: Computers are efficient and very fast. d 4: Computers are very powerful. d 5: Computers are powerful, fast and efficient. d 6: Computers are very fast and powerful. d 7: Computers are fast. , נקבע משקלות. אם מונח מופיע במסמך משקלו יהיה אחד, אחרת משקלו יהיה : 0

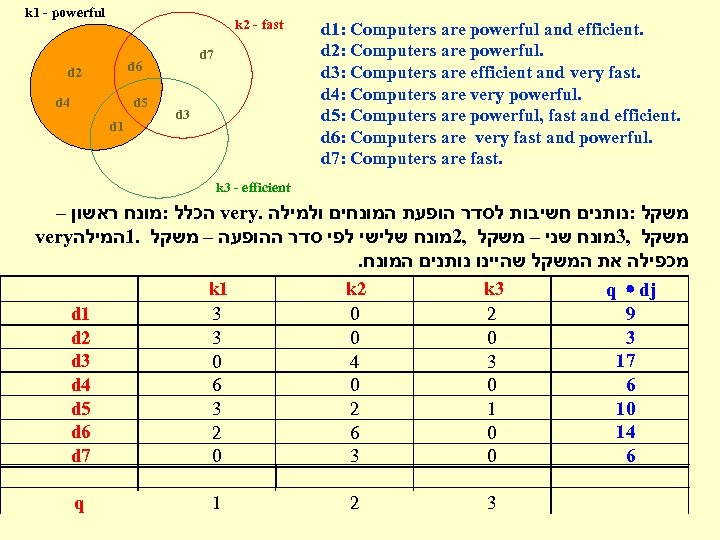

k 1 - powerful k 2 - fast d 7 d 6 d 2 d 4 d 5 d 1 d 3 d 1: Computers are powerful and efficient. d 2: Computers are powerful. d 3: Computers are efficient and very fast. d 4: Computers are very powerful. d 5: Computers are powerful, fast and efficient. d 6: Computers are very fast and powerful. d 7: Computers are fast. k 3 - efficient – הכלל : מונח ראשון very. משקל : נותנים חשיבות לסדר הופעת המונחים ולמילה very משקל , 3מונח שני – משקל , 2מונח שלישי לפי סדר ההופעה – משקל. 1המילה . מכפילה את המשקל שהיינו נותנים המונח d 1 d 2 d 3 d 4 d 5 d 6 d 7 k 1 3 3 0 6 3 2 0 k 2 0 0 4 0 2 6 3 k 3 2 0 3 0 1 0 0 q 1 2 3 q · dj 9 3 17 6 10 14 6

k 1 - powerful k 2 - fast d 7 d 6 d 2 d 4 d 5 d 1 d 3 d 1: Computers are powerful and efficient. d 2: Computers are powerful. d 3: Computers are efficient and very fast. d 4: Computers are very powerful. d 5: Computers are powerful, fast and efficient. d 6: Computers are very fast and powerful. d 7: Computers are fast. k 3 - efficient – הכלל : מונח ראשון very. משקל : נותנים חשיבות לסדר הופעת המונחים ולמילה very משקל , 3מונח שני – משקל , 2מונח שלישי לפי סדר ההופעה – משקל. 1המילה . מכפילה את המשקל שהיינו נותנים המונח d 1 d 2 d 3 d 4 d 5 d 6 d 7 k 1 3 3 0 6 3 2 0 k 2 0 0 4 0 2 6 3 k 3 2 0 3 0 1 0 0 q 1 2 3 q · dj 9 3 17 6 10 14 6

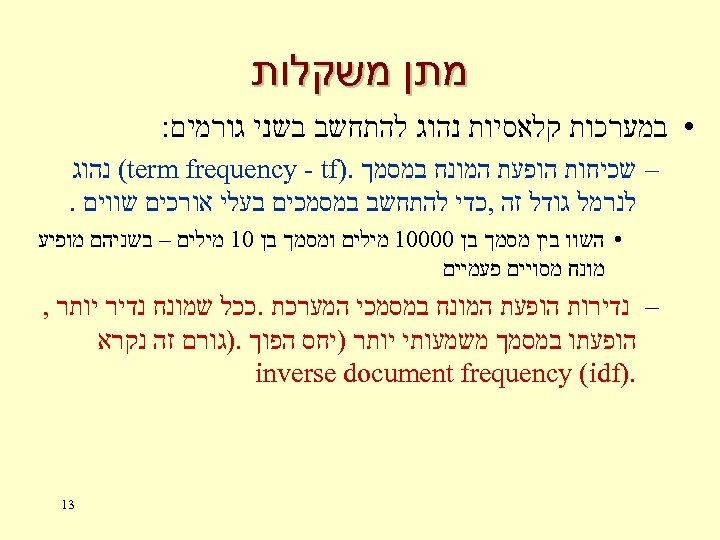

מתן משקלות • במערכות קלאסיות נהוג להתחשב בשני גורמים: – שכיחות הופעת המונח במסמך. ) (term frequency - tf נהוג לנרמל גודל זה , כדי להתחשב במסמכים בעלי אורכים שווים. • השוו בין מסמך בן 00001 מילים ומסמך בן 01 מילים – בשניהם מופיע מונח מסויים פעמיים – נדירות הופעת המונח במסמכי המערכת. ככל שמונח נדיר יותר , הופעתו במסמך משמעותי יותר )יחס הפוך. )גורם זה נקרא . ) inverse document frequency (idf 31

מתן משקלות • במערכות קלאסיות נהוג להתחשב בשני גורמים: – שכיחות הופעת המונח במסמך. ) (term frequency - tf נהוג לנרמל גודל זה , כדי להתחשב במסמכים בעלי אורכים שווים. • השוו בין מסמך בן 00001 מילים ומסמך בן 01 מילים – בשניהם מופיע מונח מסויים פעמיים – נדירות הופעת המונח במסמכי המערכת. ככל שמונח נדיר יותר , הופעתו במסמך משמעותי יותר )יחס הפוך. )גורם זה נקרא . ) inverse document frequency (idf 31

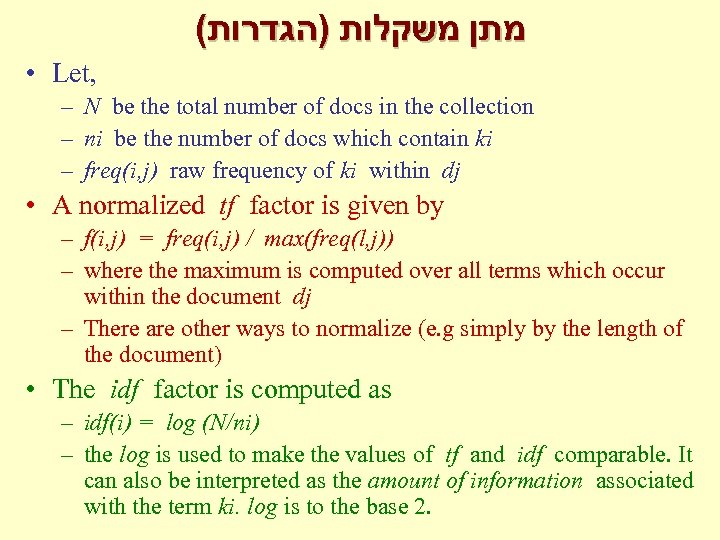

( מתן משקלות )הגדרות • Let, – N be the total number of docs in the collection – ni be the number of docs which contain ki – freq(i, j) raw frequency of ki within dj • A normalized tf factor is given by – f(i, j) = freq(i, j) / max(freq(l, j)) – where the maximum is computed over all terms which occur within the document dj – There are other ways to normalize (e. g simply by the length of the document) • The idf factor is computed as – idf(i) = log (N/ni) – the log is used to make the values of tf and idf comparable. It can also be interpreted as the amount of information associated with the term ki. log is to the base 2.

( מתן משקלות )הגדרות • Let, – N be the total number of docs in the collection – ni be the number of docs which contain ki – freq(i, j) raw frequency of ki within dj • A normalized tf factor is given by – f(i, j) = freq(i, j) / max(freq(l, j)) – where the maximum is computed over all terms which occur within the document dj – There are other ways to normalize (e. g simply by the length of the document) • The idf factor is computed as – idf(i) = log (N/ni) – the log is used to make the values of tf and idf comparable. It can also be interpreted as the amount of information associated with the term ki. log is to the base 2.

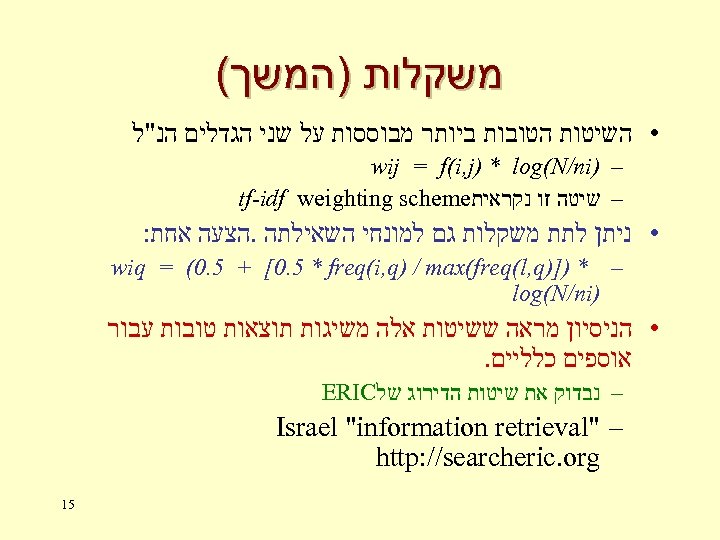

משקלות )המשך( • השיטות הטובות ביותר מבוססות על שני הגדלים הנ"ל – ) wij = f(i, j) * log(N/ni – שיטה זו נקראית tf-idf weighting scheme • ניתן לתת משקלות גם למונחי השאילתה. הצעה אחת: – * )]) wiq = (0. 5 + [0. 5 * freq(i, q) / max(freq(l, q ) log(N/ni • הניסיון מראה ששיטות אלה משיגות תוצאות טובות עבור אוספים כלליים. – נבדוק את שיטות הדירוג של ERIC – " Israel "information retrieval http: //searcheric. org 51

משקלות )המשך( • השיטות הטובות ביותר מבוססות על שני הגדלים הנ"ל – ) wij = f(i, j) * log(N/ni – שיטה זו נקראית tf-idf weighting scheme • ניתן לתת משקלות גם למונחי השאילתה. הצעה אחת: – * )]) wiq = (0. 5 + [0. 5 * freq(i, q) / max(freq(l, q ) log(N/ni • הניסיון מראה ששיטות אלה משיגות תוצאות טובות עבור אוספים כלליים. – נבדוק את שיטות הדירוג של ERIC – " Israel "information retrieval http: //searcheric. org 51

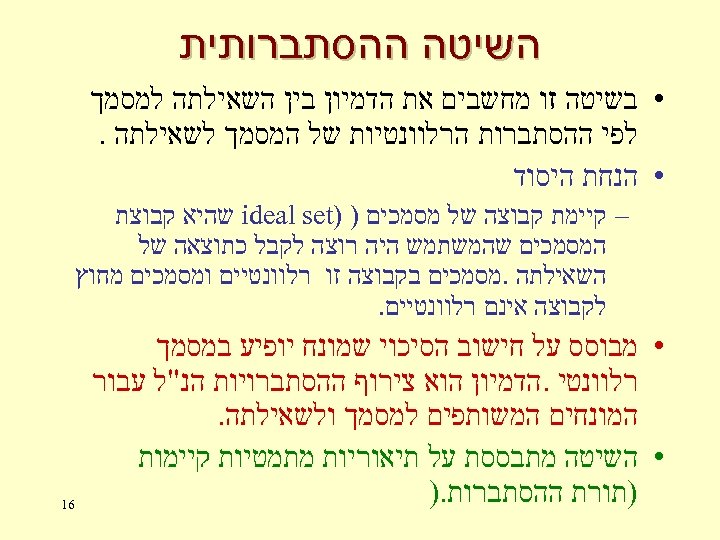

השיטה ההסתברותית • בשיטה זו מחשבים את הדמיון בין השאילתה למסמך לפי ההסתברות הרלוונטיות של המסמך לשאילתה. • הנחת היסוד – קיימת קבוצה של מסמכים ) ) ideal set שהיא קבוצת המסמכים שהמשתמש היה רוצה לקבל כתוצאה של השאילתה. מסמכים בקבוצה זו רלוונטיים ומסמכים מחוץ לקבוצה אינם רלוונטיים. • מבוסס על חישוב הסיכוי שמונח יופיע במסמך רלוונטי. הדמיון הוא צירוף ההסתברויות הנ"ל עבור המונחים המשותפים למסמך ולשאילתה. • השיטה מתבססת על תיאוריות מתמטיות קיימות )תורת ההסתברות. ) 61

השיטה ההסתברותית • בשיטה זו מחשבים את הדמיון בין השאילתה למסמך לפי ההסתברות הרלוונטיות של המסמך לשאילתה. • הנחת היסוד – קיימת קבוצה של מסמכים ) ) ideal set שהיא קבוצת המסמכים שהמשתמש היה רוצה לקבל כתוצאה של השאילתה. מסמכים בקבוצה זו רלוונטיים ומסמכים מחוץ לקבוצה אינם רלוונטיים. • מבוסס על חישוב הסיכוי שמונח יופיע במסמך רלוונטי. הדמיון הוא צירוף ההסתברויות הנ"ל עבור המונחים המשותפים למסמך ולשאילתה. • השיטה מתבססת על תיאוריות מתמטיות קיימות )תורת ההסתברות. ) 61

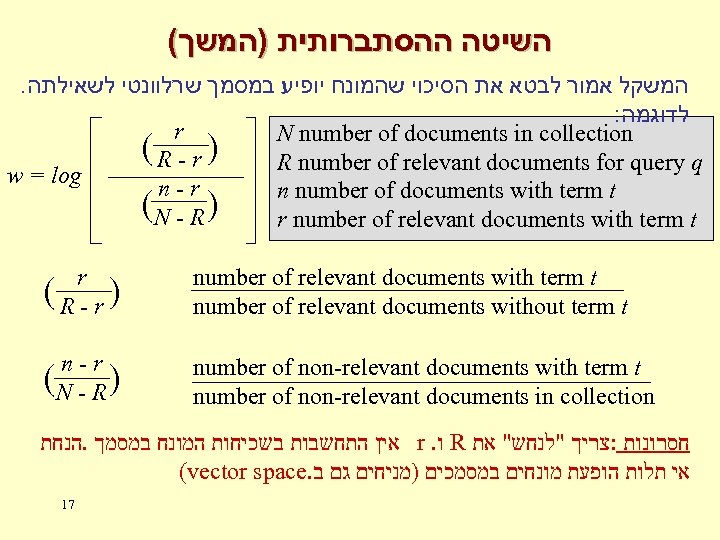

( השיטה ההסתברותית )המשך . המשקל אמור לבטא את הסיכוי שהמונח יופיע במסמך שרלוונטי לשאילתה : לדוגמה r N number of documents in collection (R - r) R number of relevant documents for query q w = log n-r n number of documents with term t (N - R ) r number of relevant documents with term t r (R - r) number of relevant documents with term t number of relevant documents without term t n-r (N - R ) number of non-relevant documents with term t number of non-relevant documents in collection אין התחשבות בשכיחות המונח במסמך. הנחת r. ו R חסרונות : צריך "לנחש" את (vector space. אי תלות הופעת מונחים במסמכים )מניחים גם ב 17

( השיטה ההסתברותית )המשך . המשקל אמור לבטא את הסיכוי שהמונח יופיע במסמך שרלוונטי לשאילתה : לדוגמה r N number of documents in collection (R - r) R number of relevant documents for query q w = log n-r n number of documents with term t (N - R ) r number of relevant documents with term t r (R - r) number of relevant documents with term t number of relevant documents without term t n-r (N - R ) number of non-relevant documents with term t number of non-relevant documents in collection אין התחשבות בשכיחות המונח במסמך. הנחת r. ו R חסרונות : צריך "לנחש" את (vector space. אי תלות הופעת מונחים במסמכים )מניחים גם ב 17

- NLP עיבוד שפה טבעית . • המשתמש מנסח את השאילתה שלו בשפה טבעית • מעודדים את המשתמש לתת תיאור מפורט • אחת הבעיות – זיהוי שלילה (sentence – טיפול בשאילתות המורכבות מקטעי משפטים בלבד fragments). Web: askjeeves • דוגמה לשירות כזה ב http: //www. askjeeves. com Tell me about UN resolutions against Iraq Who killed Rabin? What countries in Europe are not members of the EU? Google: ננסה את השאילתות המקבילות ב "UN resolutions" "against Iraq“ Rabin killed countries Europe not members EU 18

- NLP עיבוד שפה טבעית . • המשתמש מנסח את השאילתה שלו בשפה טבעית • מעודדים את המשתמש לתת תיאור מפורט • אחת הבעיות – זיהוי שלילה (sentence – טיפול בשאילתות המורכבות מקטעי משפטים בלבד fragments). Web: askjeeves • דוגמה לשירות כזה ב http: //www. askjeeves. com Tell me about UN resolutions against Iraq Who killed Rabin? What countries in Europe are not members of the EU? Google: ננסה את השאילתות המקבילות ב "UN resolutions" "against Iraq“ Rabin killed countries Europe not members EU 18

שיטות נוספות • שילוב בשיטה הבוליאנית עם ה vector space – מדרגים את התוצאות שהתקבלו באחזור הבוליאני • latent semantic indexing – מנסה למפתח מושגים ) (concepts במקום מונחי מפתח 91

שיטות נוספות • שילוב בשיטה הבוליאנית עם ה vector space – מדרגים את התוצאות שהתקבלו באחזור הבוליאני • latent semantic indexing – מנסה למפתח מושגים ) (concepts במקום מונחי מפתח 91

דירוג התוצאות term frequency inverse document frequency מיקום המונח במסמך קרבה בין המונחים hypertext קשרי 20 • • •

דירוג התוצאות term frequency inverse document frequency מיקום המונח במסמך קרבה בין המונחים hypertext קשרי 20 • • •

שיטות לדירוג התוצאות )המשך( • שכיחות המונח בטקסט – ב Web מנסים לנצל את הגורם הזה לרעה. התופעה נקראת , spamming מנועי החיפוש לנסים להלחם בה. – יש יתרון למסמכים ארוכים על פני מסמכים קצרים )על בעיה זו ניתן להתגבר על ידי נירמול) – ישנם סוגי מסמכים )חוזים לדוגמה( בהם שיטה זו לא תעבוד. למרות זאת , הניסיון מראה , שהשיטה בדרך כלל עובדת כאשר מתעלמים מהמונחים השכיחים ביותר. 12

שיטות לדירוג התוצאות )המשך( • שכיחות המונח בטקסט – ב Web מנסים לנצל את הגורם הזה לרעה. התופעה נקראת , spamming מנועי החיפוש לנסים להלחם בה. – יש יתרון למסמכים ארוכים על פני מסמכים קצרים )על בעיה זו ניתן להתגבר על ידי נירמול) – ישנם סוגי מסמכים )חוזים לדוגמה( בהם שיטה זו לא תעבוד. למרות זאת , הניסיון מראה , שהשיטה בדרך כלל עובדת כאשר מתעלמים מהמונחים השכיחים ביותר. 12

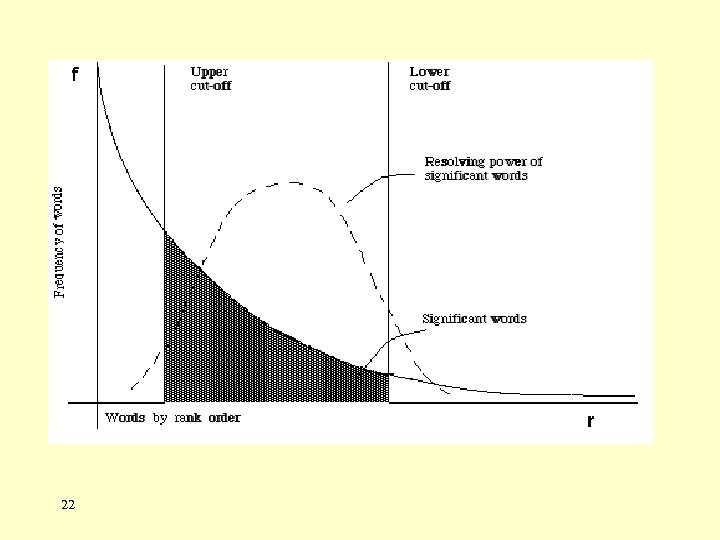

22

22

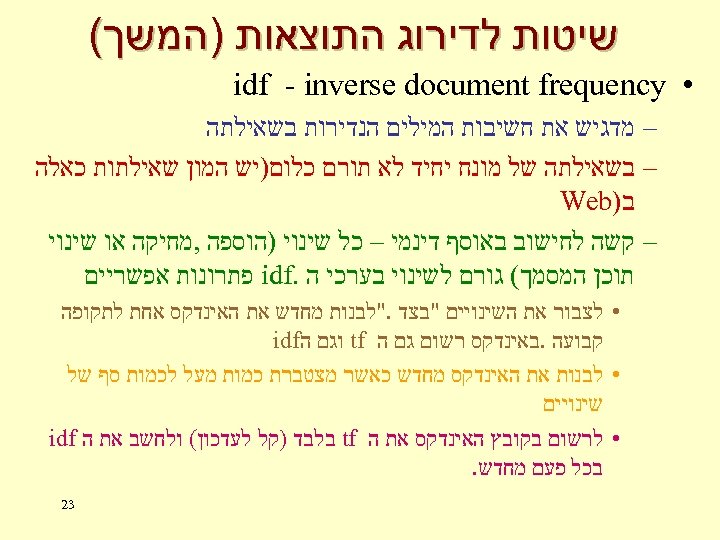

שיטות לדירוג התוצאות )המשך( • idf - inverse document frequency – מדגיש את חשיבות המילים הנדירות בשאילתה – בשאילתה של מונח יחיד לא תורם כלום)יש המון שאילתות כאלה ב) Web – קשה לחישוב באוסף דינמי – כל שינוי )הוספה , מחיקה או שינוי תוכן המסמך( גורם לשינוי בערכי ה. idf פתרונות אפשריים • לצבור את השינויים "בצד. "לבנות מחדש את האינדקס אחת לתקופה קבועה. באינדקס רשום גם ה tf וגם ה idf • לבנות את האינדקס מחדש כאשר מצטברת כמות מעל לכמות סף של שינויים • לרשום בקובץ האינדקס את ה tf בלבד )קל לעדכון( ולחשב את ה idf בכל פעם מחדש. 32

שיטות לדירוג התוצאות )המשך( • idf - inverse document frequency – מדגיש את חשיבות המילים הנדירות בשאילתה – בשאילתה של מונח יחיד לא תורם כלום)יש המון שאילתות כאלה ב) Web – קשה לחישוב באוסף דינמי – כל שינוי )הוספה , מחיקה או שינוי תוכן המסמך( גורם לשינוי בערכי ה. idf פתרונות אפשריים • לצבור את השינויים "בצד. "לבנות מחדש את האינדקס אחת לתקופה קבועה. באינדקס רשום גם ה tf וגם ה idf • לבנות את האינדקס מחדש כאשר מצטברת כמות מעל לכמות סף של שינויים • לרשום בקובץ האינדקס את ה tf בלבד )קל לעדכון( ולחשב את ה idf בכל פעם מחדש. 32

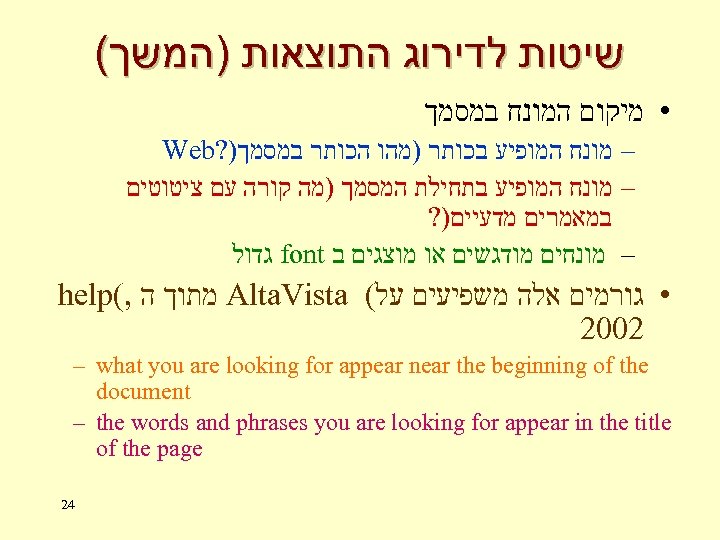

שיטות לדירוג התוצאות )המשך( • מיקום המונח במסמך – מונח המופיע בכותר )מהו הכותר במסמך)? Web – מונח המופיע בתחילת המסמך )מה קורה עם ציטוטים במאמרים מדעיים)? – מונחים מודגשים או מוצגים ב font גדול • גורמים אלה משפיעים על( Alta. Vista מתוך ה , ( help 2002 – what you are looking for appear near the beginning of the document – the words and phrases you are looking for appear in the title of the page 42

שיטות לדירוג התוצאות )המשך( • מיקום המונח במסמך – מונח המופיע בכותר )מהו הכותר במסמך)? Web – מונח המופיע בתחילת המסמך )מה קורה עם ציטוטים במאמרים מדעיים)? – מונחים מודגשים או מוצגים ב font גדול • גורמים אלה משפיעים על( Alta. Vista מתוך ה , ( help 2002 – what you are looking for appear near the beginning of the document – the words and phrases you are looking for appear in the title of the page 42

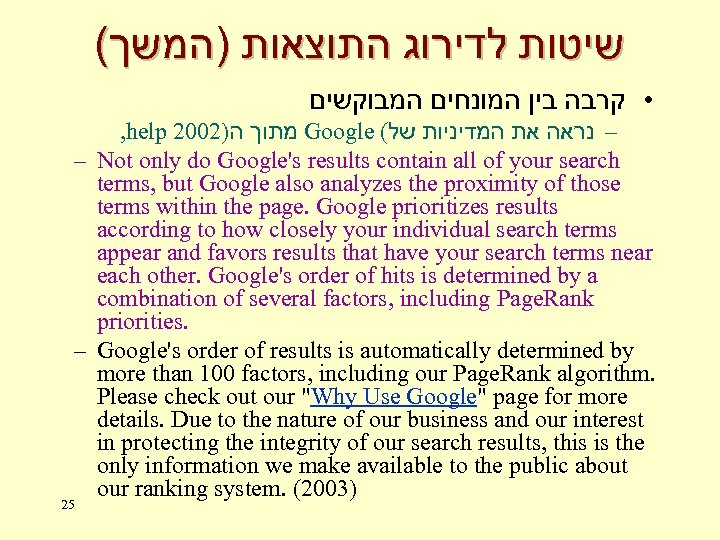

( שיטות לדירוג התוצאות )המשך • קרבה בין המונחים המבוקשים , help 2002) מתוך ה Google ( – נראה את המדיניות של – Not only do Google's results contain all of your search terms, but Google also analyzes the proximity of those terms within the page. Google prioritizes results according to how closely your individual search terms appear and favors results that have your search terms near each other. Google's order of hits is determined by a combination of several factors, including Page. Rank priorities. – Google's order of results is automatically determined by more than 100 factors, including our Page. Rank algorithm. Please check out our "Why Use Google" page for more details. Due to the nature of our business and our interest in protecting the integrity of our search results, this is the only information we make available to the public about our ranking system. (2003) 25

( שיטות לדירוג התוצאות )המשך • קרבה בין המונחים המבוקשים , help 2002) מתוך ה Google ( – נראה את המדיניות של – Not only do Google's results contain all of your search terms, but Google also analyzes the proximity of those terms within the page. Google prioritizes results according to how closely your individual search terms appear and favors results that have your search terms near each other. Google's order of hits is determined by a combination of several factors, including Page. Rank priorities. – Google's order of results is automatically determined by more than 100 factors, including our Page. Rank algorithm. Please check out our "Why Use Google" page for more details. Due to the nature of our business and our interest in protecting the integrity of our search results, this is the only information we make available to the public about our ranking system. (2003) 25

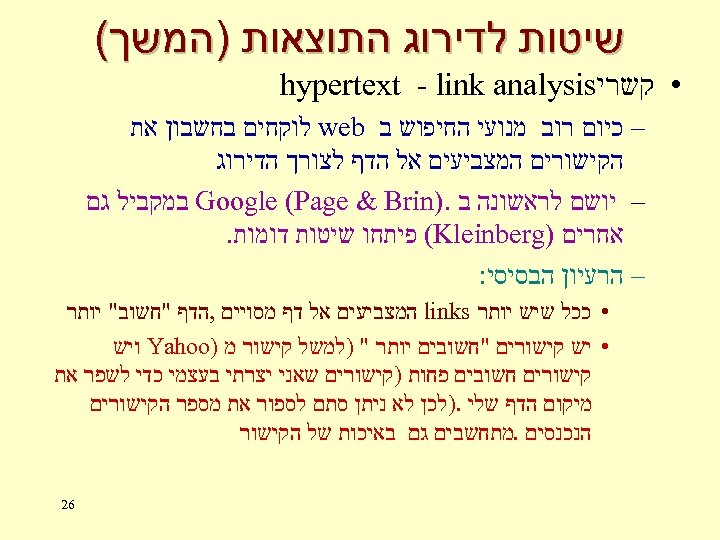

שיטות לדירוג התוצאות )המשך( • קשרי hypertext - link analysis – כיום רוב מנועי החיפוש ב web לוקחים בחשבון את הקישורים המצביעים אל הדף לצורך הדירוג – יושם לראשונה ב. ) Google (Page & Brin במקביל גם אחרים ) (Kleinberg פיתחו שיטות דומות. – הרעיון הבסיסי: • ככל שיש יותר links המצביעים אל דף מסויים , הדף "חשוב" יותר • יש קישורים "חשובים יותר " )למשל קישור מ ) Yahoo ויש קישורים חשובים פחות )קישורים שאני יצרתי בעצמי כדי לשפר את מיקום הדף שלי. )לכן לא ניתן סתם לספור את מספר הקישורים הנכנסים. מתחשבים גם באיכות של הקישור 62

שיטות לדירוג התוצאות )המשך( • קשרי hypertext - link analysis – כיום רוב מנועי החיפוש ב web לוקחים בחשבון את הקישורים המצביעים אל הדף לצורך הדירוג – יושם לראשונה ב. ) Google (Page & Brin במקביל גם אחרים ) (Kleinberg פיתחו שיטות דומות. – הרעיון הבסיסי: • ככל שיש יותר links המצביעים אל דף מסויים , הדף "חשוב" יותר • יש קישורים "חשובים יותר " )למשל קישור מ ) Yahoo ויש קישורים חשובים פחות )קישורים שאני יצרתי בעצמי כדי לשפר את מיקום הדף שלי. )לכן לא ניתן סתם לספור את מספר הקישורים הנכנסים. מתחשבים גם באיכות של הקישור 62

( שיטות לדירוג התוצאות )המשך ? על הנושא Alta. Vista ו Google • מה אומרים • Google's order of hits is determined by a combination of several factors, including Page. Rank priorities. (2002) • Alta. Vista: pages that have lots of links to other pages with related content are likely to be useful reference points for you (2002) • ניתן למצוא שני תחומים בהם כבר בעבר נעשה שימוש בכלים דומים ל ניתוח קישורים (citation analysis) – ביבליומטריקה (social networks) – רשתות חברתיות • לכל כלי יש את המתכון הסודי שלו לדירוג מסמכים – יש כאלה שבנוסף לגורמים שהזכרנו לעיל , מתחשבים גם meta tags במידע ה נמצא ב 27

( שיטות לדירוג התוצאות )המשך ? על הנושא Alta. Vista ו Google • מה אומרים • Google's order of hits is determined by a combination of several factors, including Page. Rank priorities. (2002) • Alta. Vista: pages that have lots of links to other pages with related content are likely to be useful reference points for you (2002) • ניתן למצוא שני תחומים בהם כבר בעבר נעשה שימוש בכלים דומים ל ניתוח קישורים (citation analysis) – ביבליומטריקה (social networks) – רשתות חברתיות • לכל כלי יש את המתכון הסודי שלו לדירוג מסמכים – יש כאלה שבנוסף לגורמים שהזכרנו לעיל , מתחשבים גם meta tags במידע ה נמצא ב 27

שיטות להצגת תוצאות האחזור • Ranking • Short summary – ב Web בדרך כלל כמה שורות ראשונות של המסמך או מה שמופיע בתגית. ) description (metatag • Zoning – הצגת הקטע הרלוונטי מתוך המסמך . Google משתמש בשיטה זו. • Highlighting – מילות החיפוש מודגשות במסמך המאוחזר. למשל ב cached copy של. Google 82

שיטות להצגת תוצאות האחזור • Ranking • Short summary – ב Web בדרך כלל כמה שורות ראשונות של המסמך או מה שמופיע בתגית. ) description (metatag • Zoning – הצגת הקטע הרלוונטי מתוך המסמך . Google משתמש בשיטה זו. • Highlighting – מילות החיפוש מודגשות במסמך המאוחזר. למשל ב cached copy של. Google 82

שיטות להצגת תוצאות האחזור ( )המשך • Vocabulary browse Win. Spirs דרך Sociological Abstracts – למשל ב • Iterative search and search history log – search within results (e. g. in Google) – search history in ABI/INFORM for currrent session. Also in First. Search • Canned query (e. g. WOS) – שמירת שאילתה החוזרת על עצמה 29

שיטות להצגת תוצאות האחזור ( )המשך • Vocabulary browse Win. Spirs דרך Sociological Abstracts – למשל ב • Iterative search and search history log – search within results (e. g. in Google) – search history in ABI/INFORM for currrent session. Also in First. Search • Canned query (e. g. WOS) – שמירת שאילתה החוזרת על עצמה 29