Структура курса Основные понятия и определения эконометрики. Эконометрическое

ekonometrika_presentation.ppt

- Количество слайдов: 383

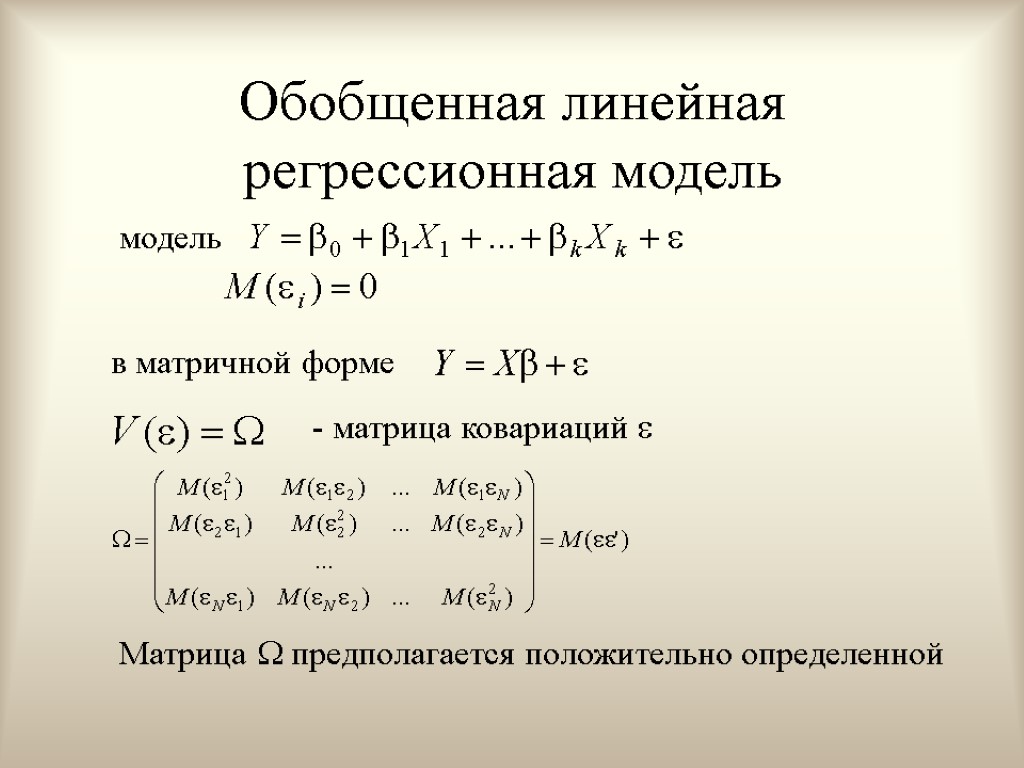

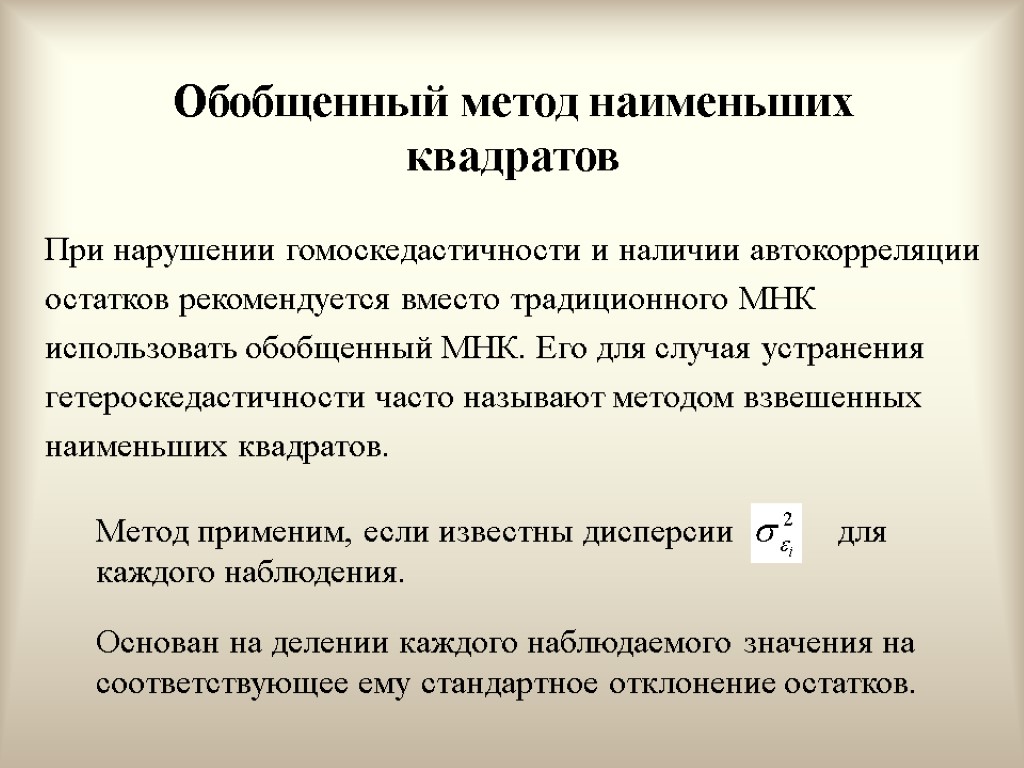

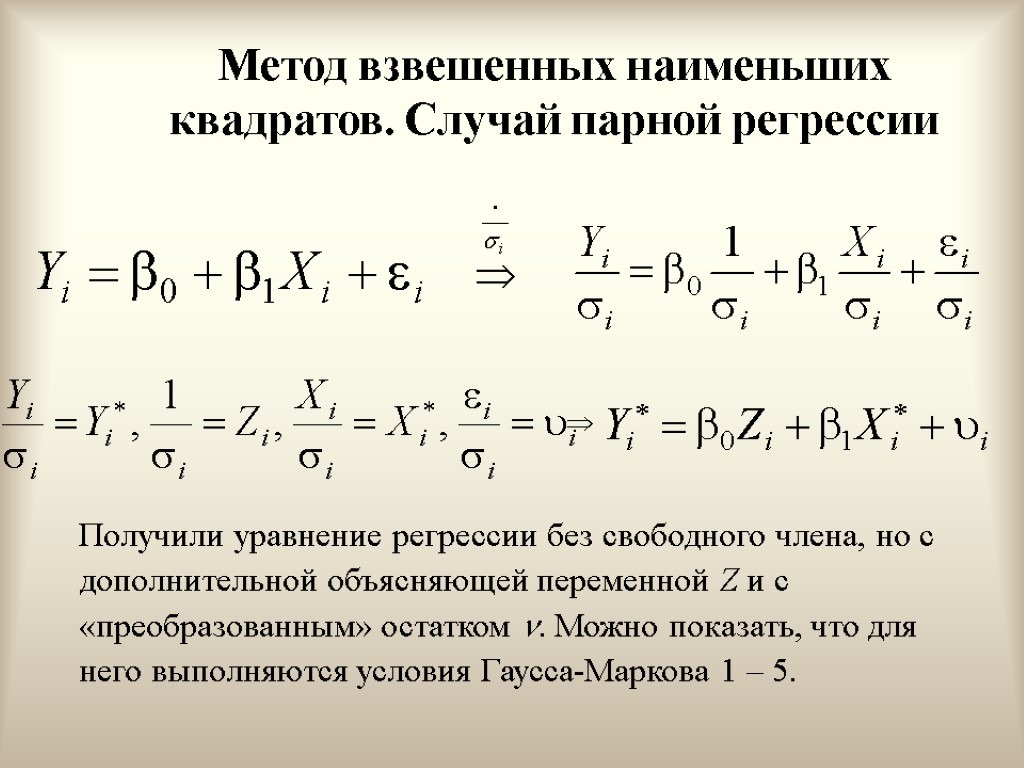

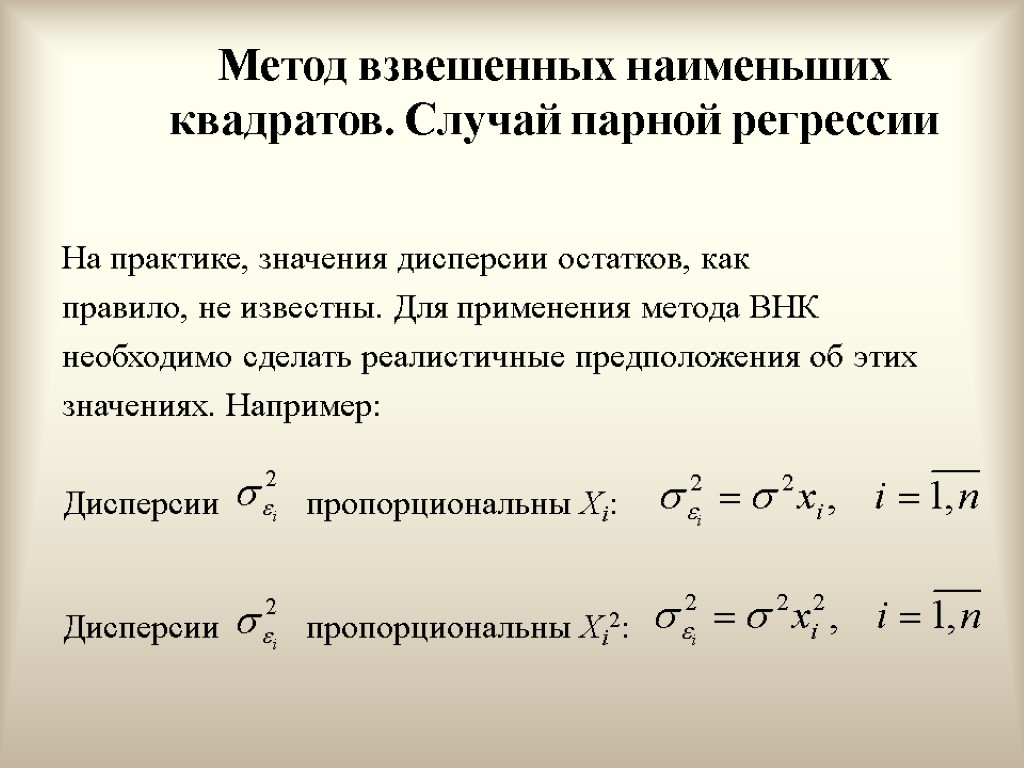

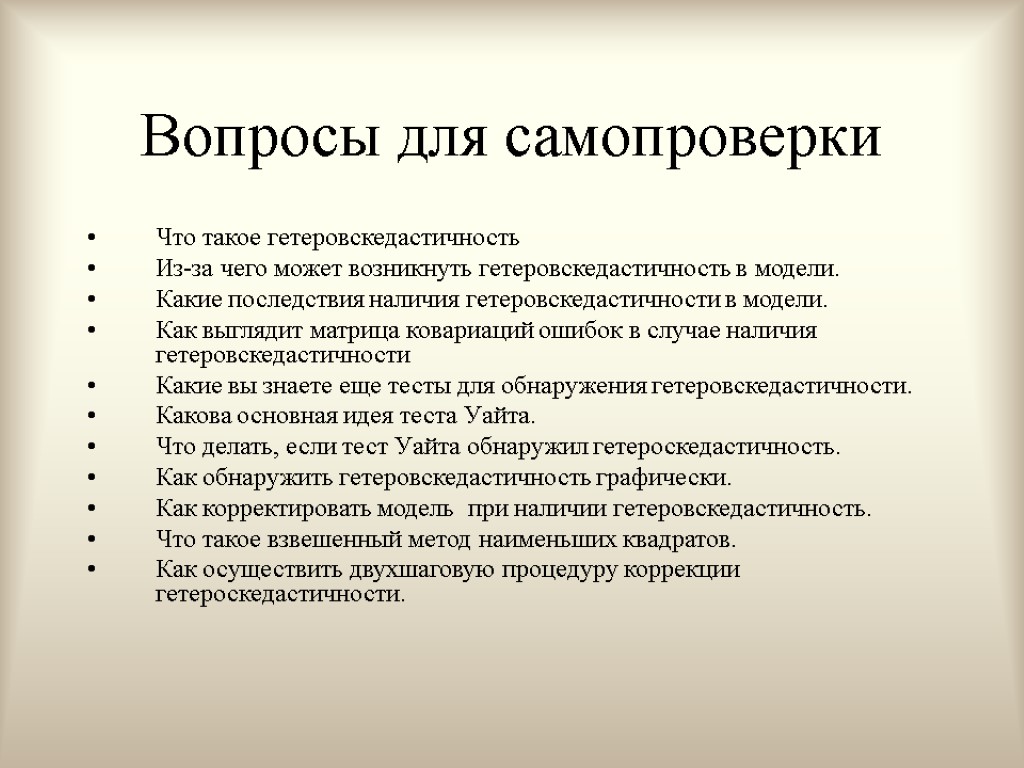

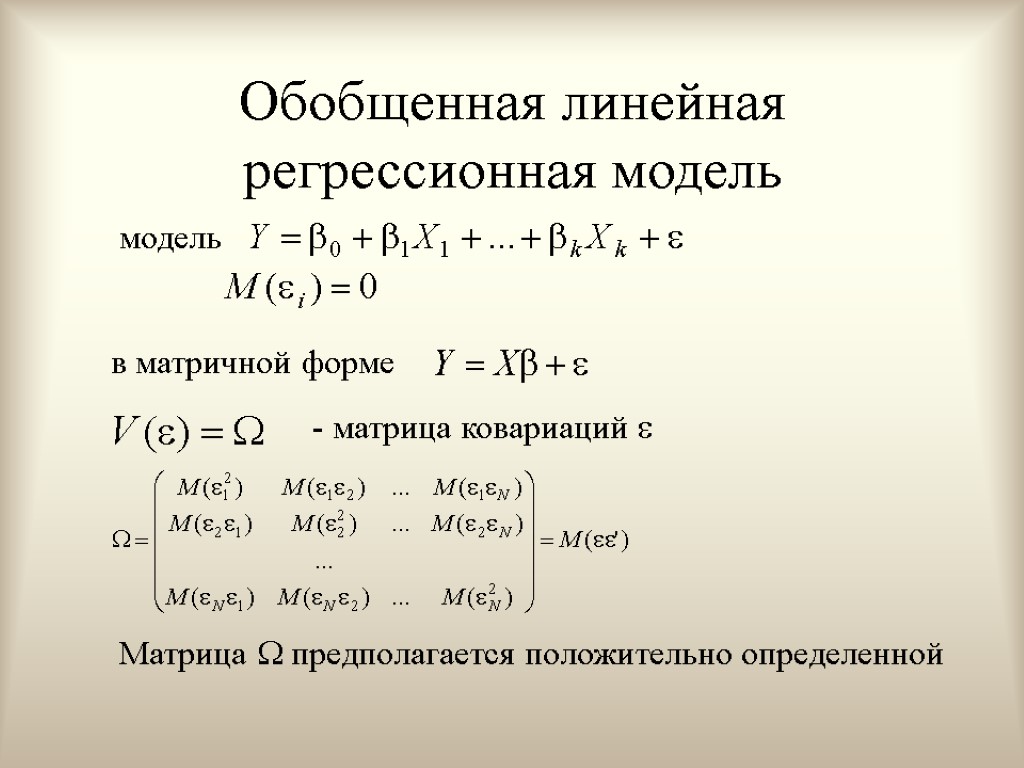

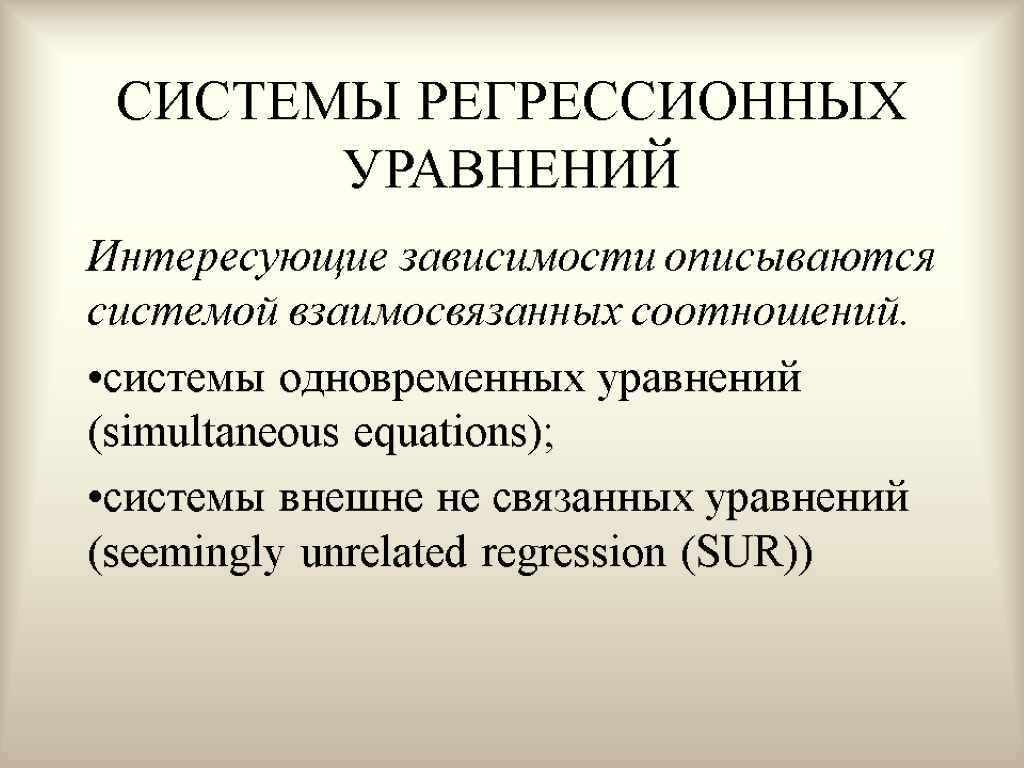

Структура курса Основные понятия и определения эконометрики. Эконометрическое моделирование. Парная линейная регрессионная модель. Множественная линейная регрессионная модель. Статистические свойства МНК-оценок МЛРМ. Проверка гипотез относительно возможных значений коэффициентов МЛРМ. Мультиколлинеарность. Ошибки спецификации. Процедуры отбора регрессоров. Обобщенный метод наименьших квадратов Гетероскедастичность. Автокорреляция Прогнозирование при помощи МЛРМ. Временные ряды Системы одновременных уравнений

Структура курса Основные понятия и определения эконометрики. Эконометрическое моделирование. Парная линейная регрессионная модель. Множественная линейная регрессионная модель. Статистические свойства МНК-оценок МЛРМ. Проверка гипотез относительно возможных значений коэффициентов МЛРМ. Мультиколлинеарность. Ошибки спецификации. Процедуры отбора регрессоров. Обобщенный метод наименьших квадратов Гетероскедастичность. Автокорреляция Прогнозирование при помощи МЛРМ. Временные ряды Системы одновременных уравнений

Необходимые требования и навыки Операции с векторами и матрицами. Дифференциальное и интегральное исчисление. Случайные величины. Функция распределения, закон распределения случайной величины Математическое ожидание, дисперсия, моменты распределения, ассиметрия, эксцесс. Нормальное распределение. Предельные теоремы и закон больших чисел. Статистическое оценивание неизвестных параметров. Точные и интервальные оценки. Состоятельность, эффективность, несмещенность оценок. Проверка статистических гипотез. Дисперсионный анализ.

Необходимые требования и навыки Операции с векторами и матрицами. Дифференциальное и интегральное исчисление. Случайные величины. Функция распределения, закон распределения случайной величины Математическое ожидание, дисперсия, моменты распределения, ассиметрия, эксцесс. Нормальное распределение. Предельные теоремы и закон больших чисел. Статистическое оценивание неизвестных параметров. Точные и интервальные оценки. Состоятельность, эффективность, несмещенность оценок. Проверка статистических гипотез. Дисперсионный анализ.

Литература Магнус Я. Р., Катышев П. К., Пересецкий А. А. Эконометрика. Начальный курс. (любое издание). Доугерти К. Введение в эконометрику. Москва, 2001. Эконометрика. Под ред. И. И. Елисеевой. Москва. Финансы и статистика, 2001. Практикум по эконометрике. Под ред. И. И. Елисеевой. Москва, финансы и статистика, 2001 Айвазян С. А., Мхитарян В. С. Прикладная статистика и основы эконометрики. Москва, Ю ЮНИТИ (любое издание). Кремер Н. Ш., Путко Б. А. Эконометрика. М. ЮНИТИ, 2002

Литература Магнус Я. Р., Катышев П. К., Пересецкий А. А. Эконометрика. Начальный курс. (любое издание). Доугерти К. Введение в эконометрику. Москва, 2001. Эконометрика. Под ред. И. И. Елисеевой. Москва. Финансы и статистика, 2001. Практикум по эконометрике. Под ред. И. И. Елисеевой. Москва, финансы и статистика, 2001 Айвазян С. А., Мхитарян В. С. Прикладная статистика и основы эконометрики. Москва, Ю ЮНИТИ (любое издание). Кремер Н. Ш., Путко Б. А. Эконометрика. М. ЮНИТИ, 2002

Тема 1. Эконометрическое моделирование Возникновение эконометрики как науки Определение эконометрики Прикладные цели эконометрики Этапы эконометрического моделирования

Тема 1. Эконометрическое моделирование Возникновение эконометрики как науки Определение эконометрики Прикладные цели эконометрики Этапы эконометрического моделирования

История эконометрики как науки 1910, Австро-Венгрия – бухгалтер П. Цьемпа ввел термин «эконометрика» Цьемпа считал, что если к данным бухгалтерского учета применить методы алгебры и геометрии, то будет получено новое, более глубокое представление о результатах хозяйственной деятельности.

История эконометрики как науки 1910, Австро-Венгрия – бухгалтер П. Цьемпа ввел термин «эконометрика» Цьемпа считал, что если к данным бухгалтерского учета применить методы алгебры и геометрии, то будет получено новое, более глубокое представление о результатах хозяйственной деятельности.

Современное определение эконометрики Эконометрика – научная дисциплина, объединяющая совокупность теоретических результатов, приемов, методов и моделей, предназначенных для того, чтобы на базе экономической теории; экономической статистики; математико-статистического инструментария придавать конкретное количественное выражение общим (качественным) закономерностям, обусловленным экономической теорией. (С. А. Айвазян, В. С. Мхитарян. Прикладная статистика и основы эконометрики.)

Современное определение эконометрики Эконометрика – научная дисциплина, объединяющая совокупность теоретических результатов, приемов, методов и моделей, предназначенных для того, чтобы на базе экономической теории; экономической статистики; математико-статистического инструментария придавать конкретное количественное выражение общим (качественным) закономерностям, обусловленным экономической теорией. (С. А. Айвазян, В. С. Мхитарян. Прикладная статистика и основы эконометрики.)

Прикладные цели эконометрики вывод экономических законов; формулировка экономических моделей, основываясь на экономической теории и эмпирических данных; оценка неизвестных величин (параметров) в этих моделях; прогнозирование и оценка точности прогноза; выработка рекомендаций по экономической политике.

Прикладные цели эконометрики вывод экономических законов; формулировка экономических моделей, основываясь на экономической теории и эмпирических данных; оценка неизвестных величин (параметров) в этих моделях; прогнозирование и оценка точности прогноза; выработка рекомендаций по экономической политике.

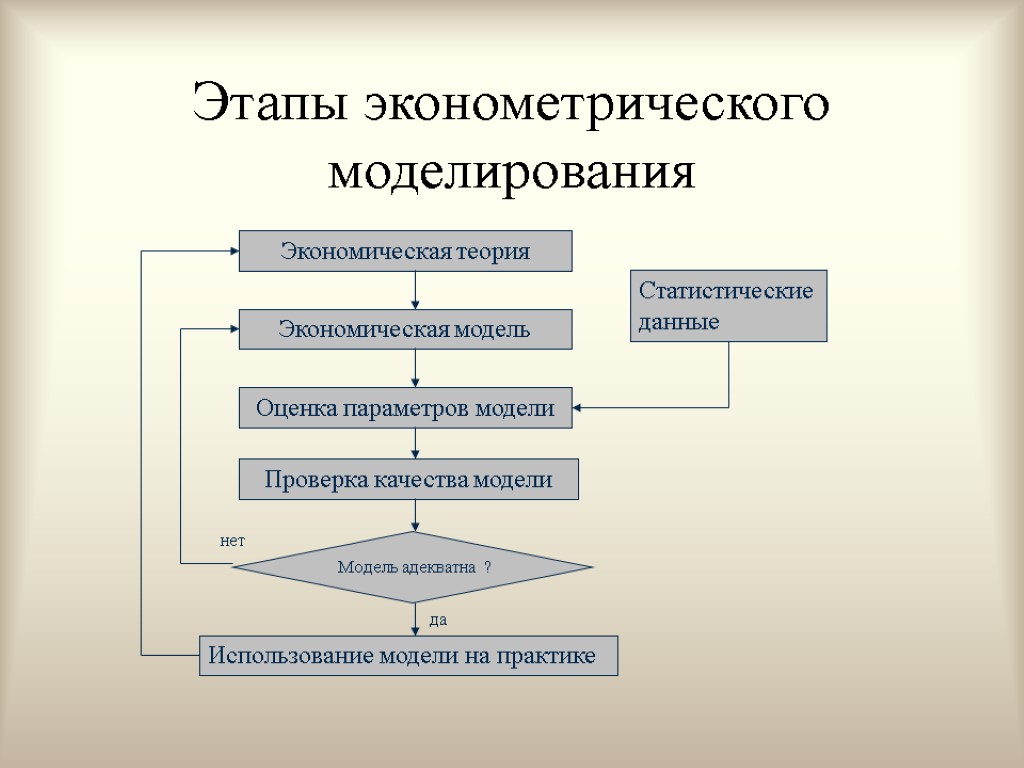

Этапы эконометрического моделирования Осознание того факта, что в экономике многие переменные связаны между собой Группировка отдельных соотношений в модель Сбор данных Идентификация Верификация

Этапы эконометрического моделирования Осознание того факта, что в экономике многие переменные связаны между собой Группировка отдельных соотношений в модель Сбор данных Идентификация Верификация

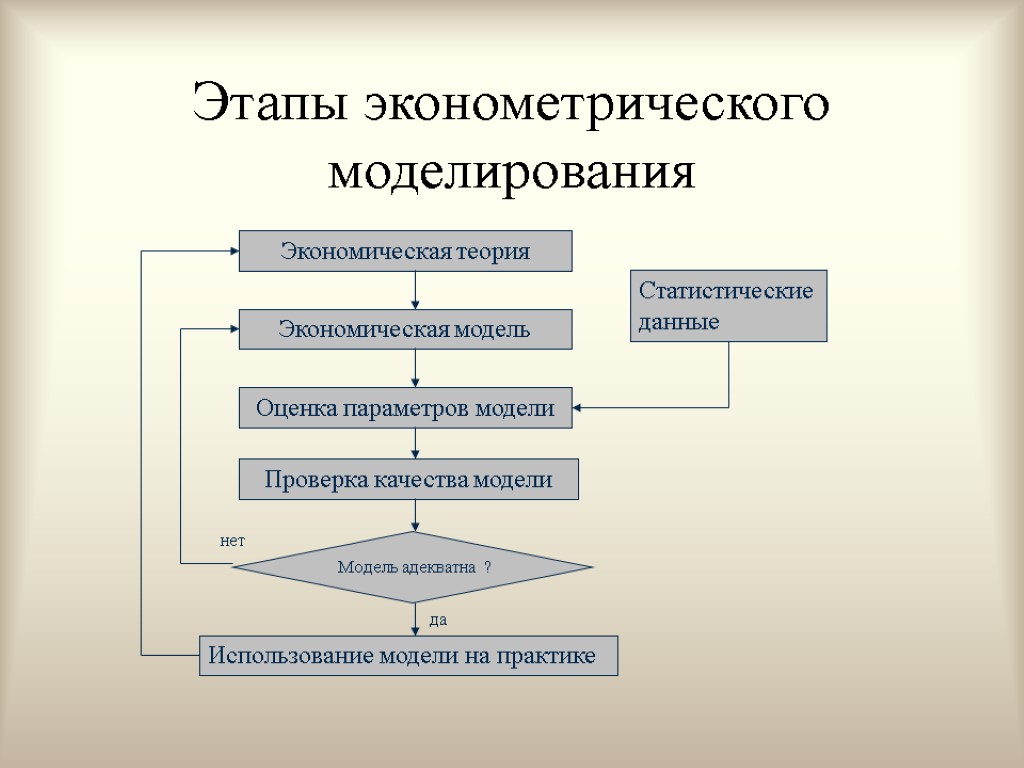

Этапы эконометрического моделирования

Этапы эконометрического моделирования

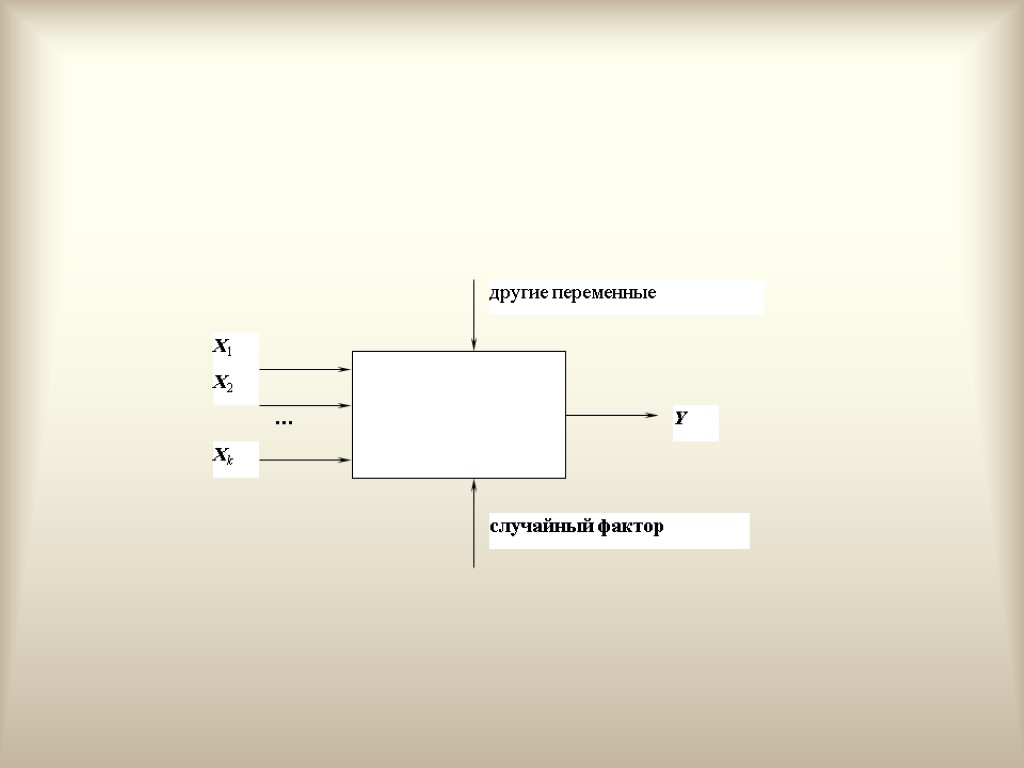

1. Переменные модели Переменную, процесс формирования значений которой нас по каким-то причинам интересует, будем обозначать Y и называть зависимой или объясняемой. Переменные, которые, как мы предполагаем, оказывают влияние на переменную Y, будем обозначать Xj и называть независимыми или объясняющими.

1. Переменные модели Переменную, процесс формирования значений которой нас по каким-то причинам интересует, будем обозначать Y и называть зависимой или объясняемой. Переменные, которые, как мы предполагаем, оказывают влияние на переменную Y, будем обозначать Xj и называть независимыми или объясняющими.

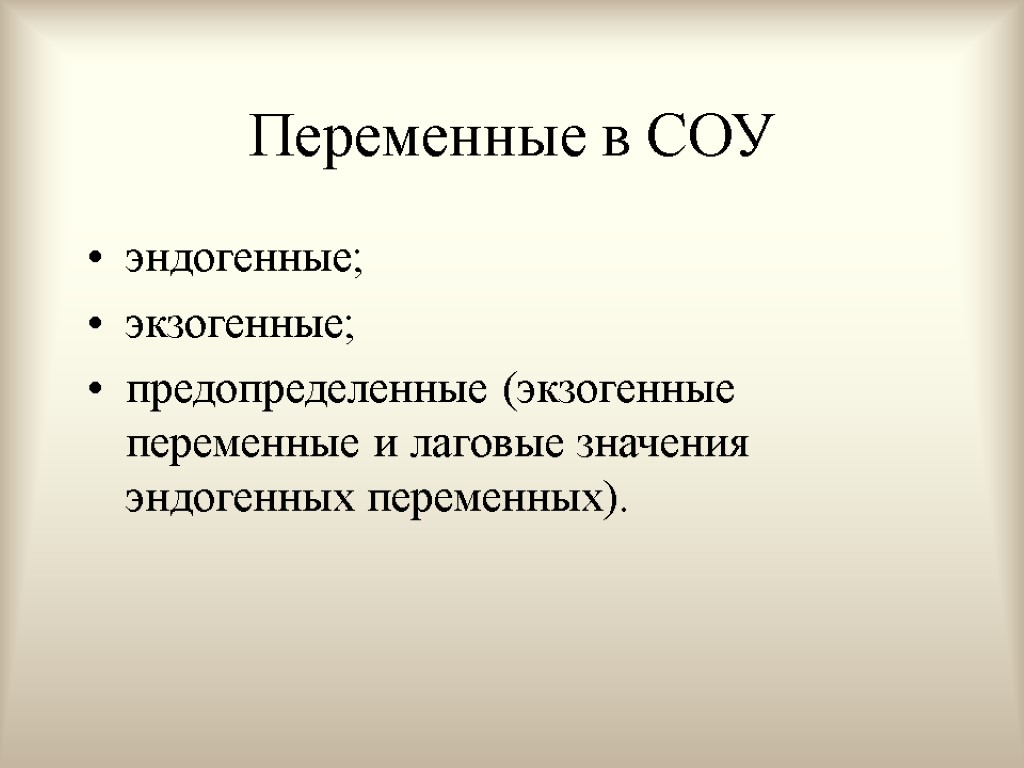

Другая классификация переменных Переменные, значения которых объясняются в рамках нашей модели, называются эндогенными. Переменные, значения которых нашей моделью не объясняются, являются для нее внешними, ничего о том, как формируются эти значения, мы не знаем, называются экзогенными

Другая классификация переменных Переменные, значения которых объясняются в рамках нашей модели, называются эндогенными. Переменные, значения которых нашей моделью не объясняются, являются для нее внешними, ничего о том, как формируются эти значения, мы не знаем, называются экзогенными

2. Спецификация модели определение цели моделирования; определения списка экзогенных и эндогенных переменных; определение форм зависимостей между переменными; формулировка априорных ограничений на случайную составляющую, что важно для свойств оценок и выбора метода оценивания; формулировка априорных ограничений на коэффициенты

2. Спецификация модели определение цели моделирования; определения списка экзогенных и эндогенных переменных; определение форм зависимостей между переменными; формулировка априорных ограничений на случайную составляющую, что важно для свойств оценок и выбора метода оценивания; формулировка априорных ограничений на коэффициенты

Виды эконометрических моделей Модели временных рядов. Регрессионные модели с одним уравнением. Системы одновременных уравнений.

Виды эконометрических моделей Модели временных рядов. Регрессионные модели с одним уравнением. Системы одновременных уравнений.

Модели временных рядов. Такие модели объясняют поведение переменной, меняющейся с течением времени, исходя только из ее предыдущих значений. К этому классу относятся модели тренда, сезонности, тренда и сезонности (аддитивная и мультипликативная формы) и др.

Модели временных рядов. Такие модели объясняют поведение переменной, меняющейся с течением времени, исходя только из ее предыдущих значений. К этому классу относятся модели тренда, сезонности, тренда и сезонности (аддитивная и мультипликативная формы) и др.

Регрессионные модели с одним уравнением. В таких моделях зависимая (объясняемая) переменная представляется в виде функции от независимых (объясняющих) переменных и параметров. В зависимости от вида функции модели бывают линейными и нелинейными.

Регрессионные модели с одним уравнением. В таких моделях зависимая (объясняемая) переменная представляется в виде функции от независимых (объясняющих) переменных и параметров. В зависимости от вида функции модели бывают линейными и нелинейными.

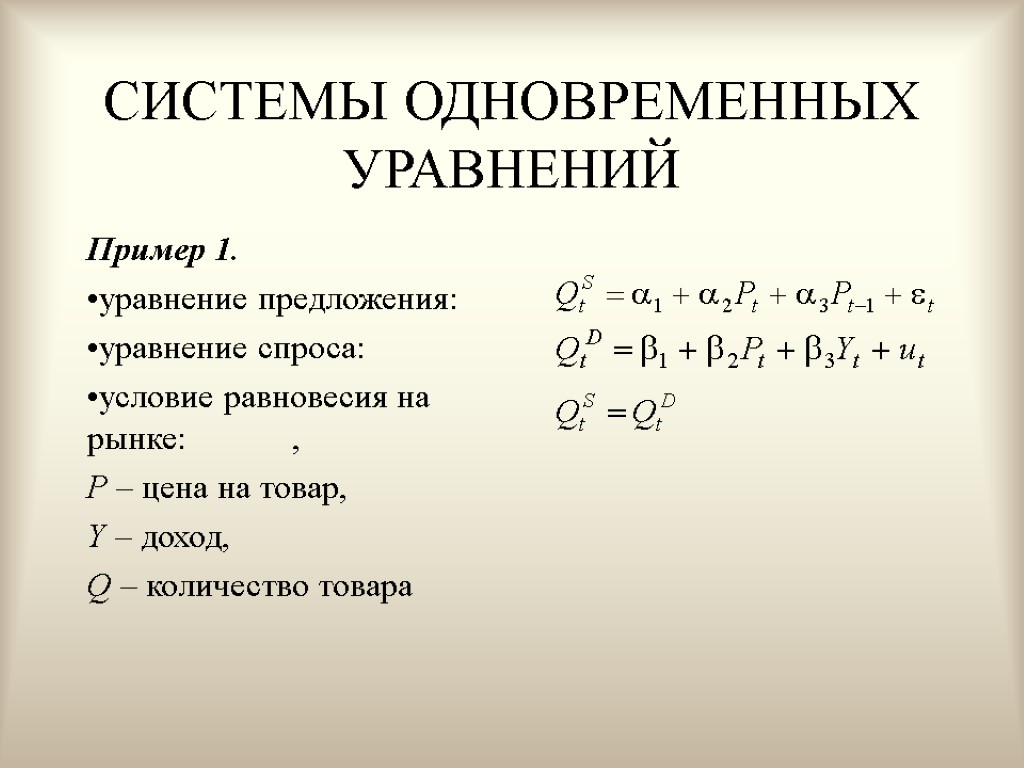

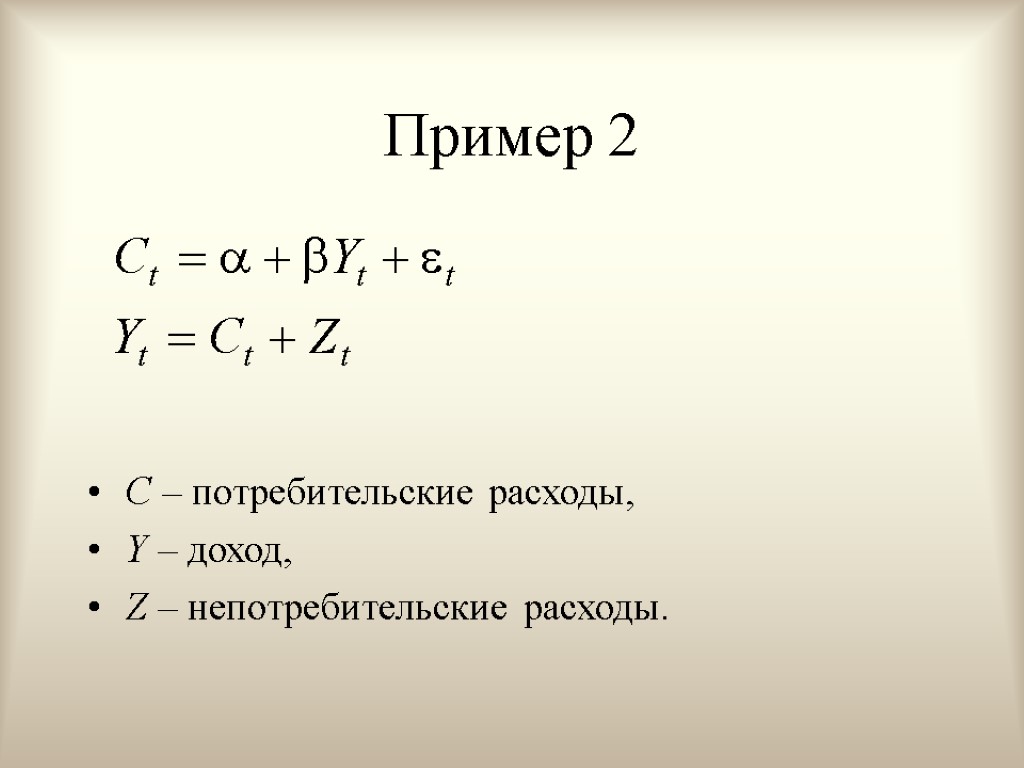

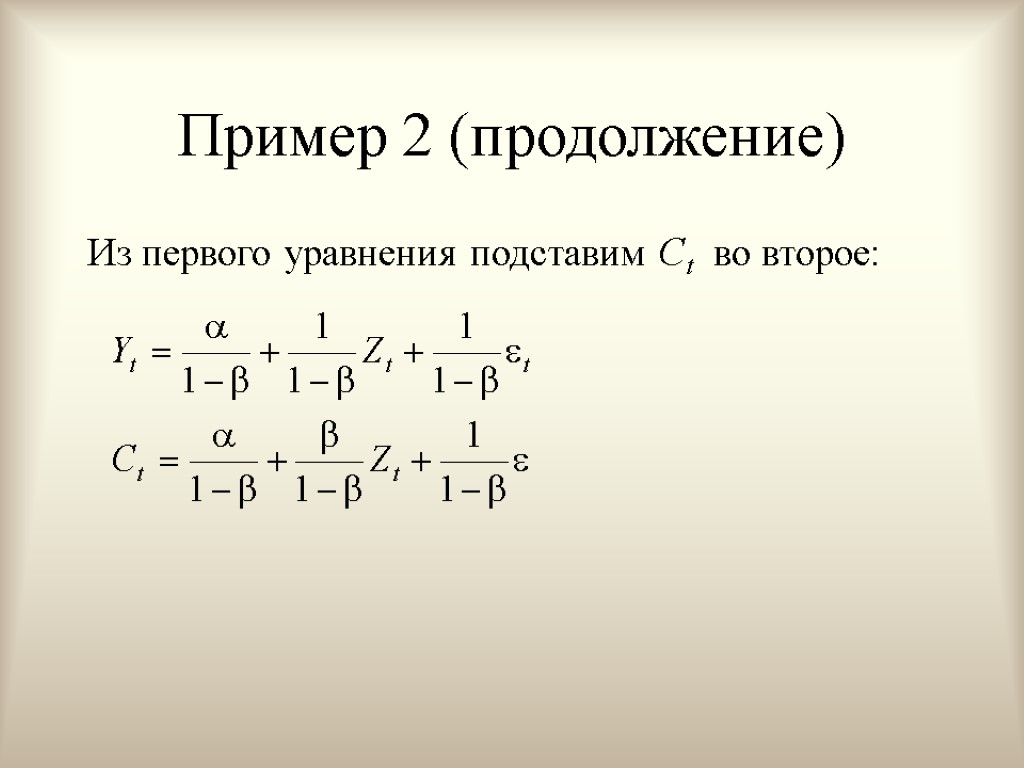

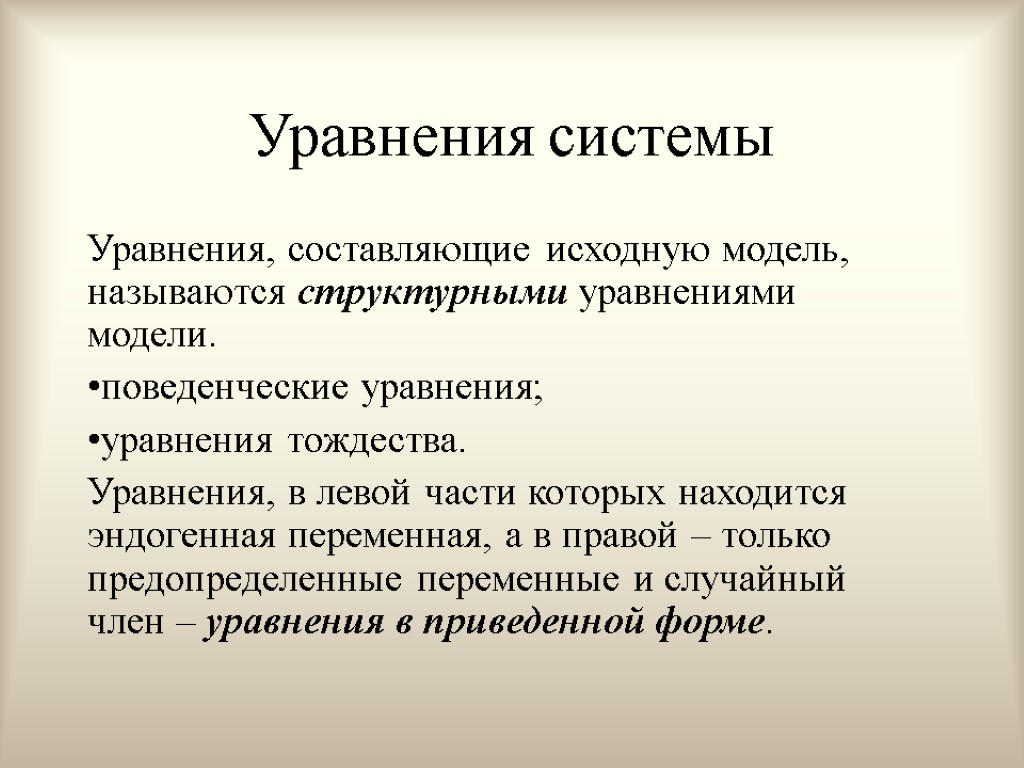

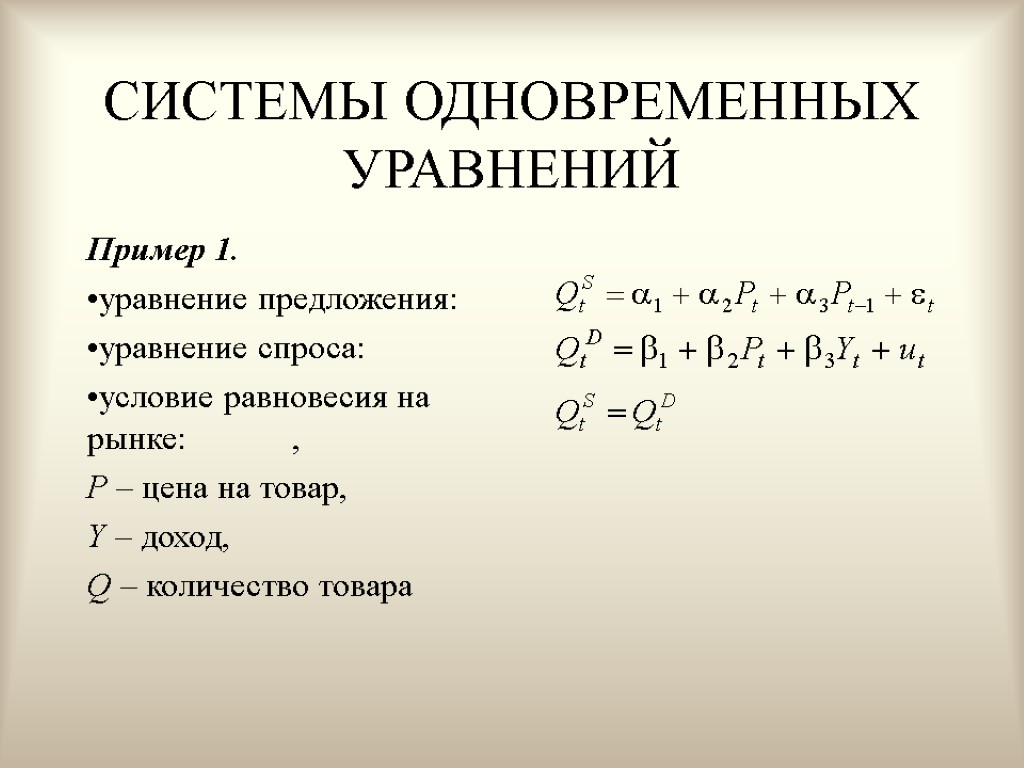

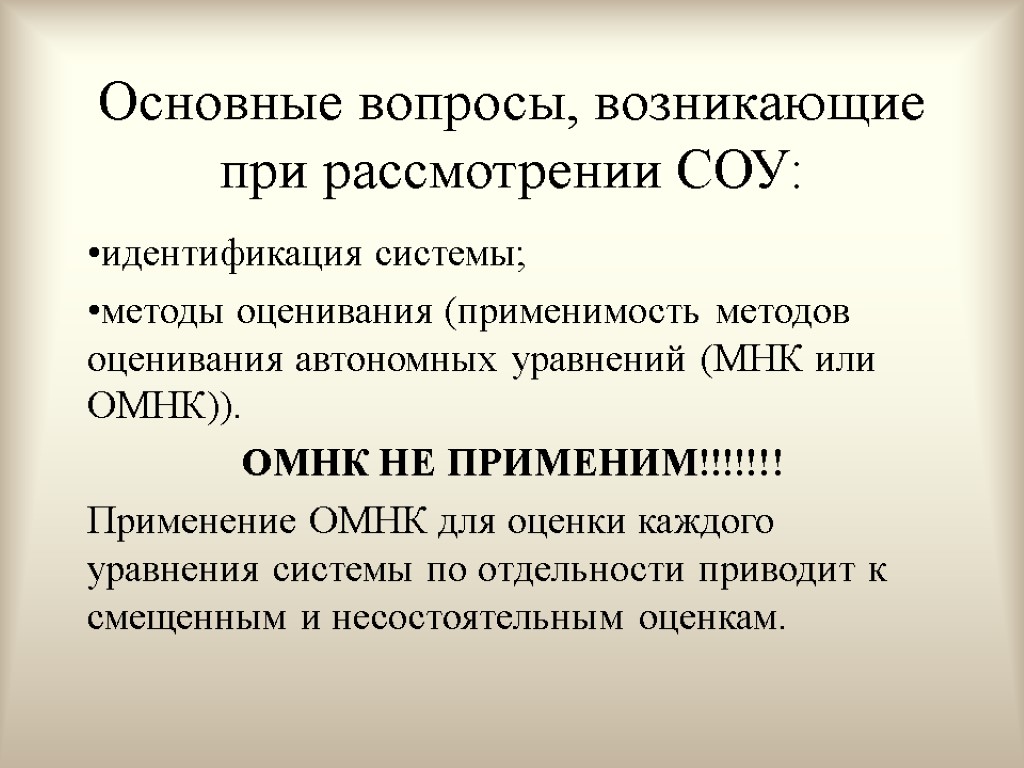

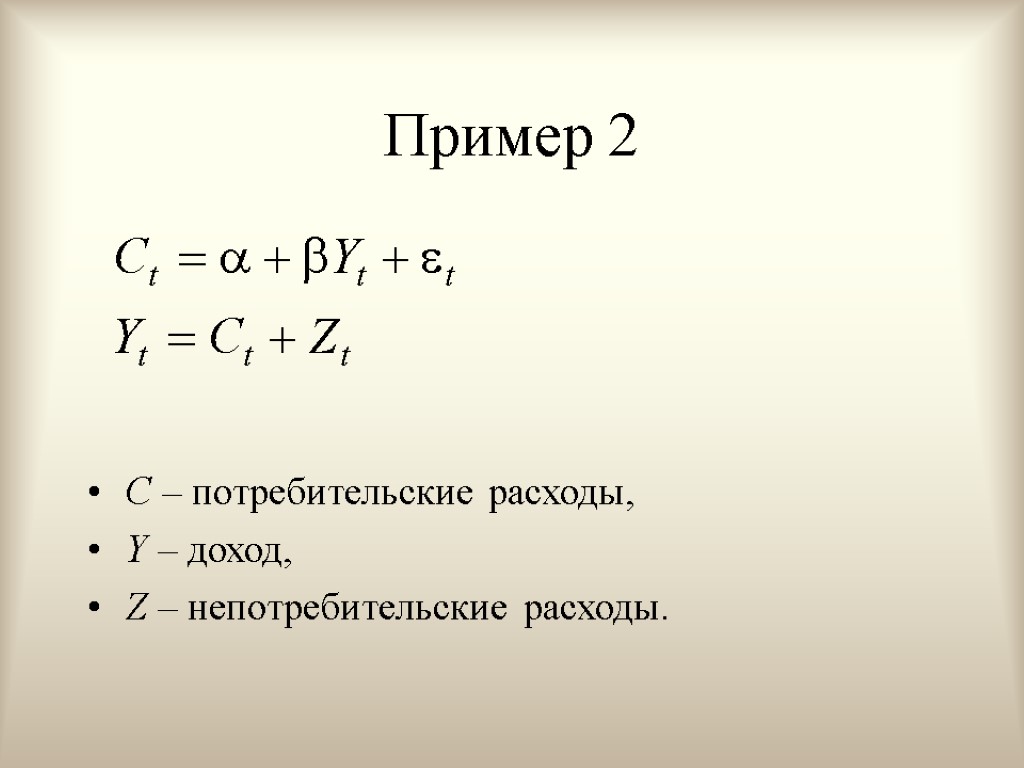

Системы одновременных уравнений. Ситуация экономическая, поведение экономического объекта описывается системой уравнений. Системы состоят из уравнений и тождеств, которые могут содержать в себе объясняемые переменные из других уравнений (поэтому вводят понятия экзогенных и эндогенных переменных).

Системы одновременных уравнений. Ситуация экономическая, поведение экономического объекта описывается системой уравнений. Системы состоят из уравнений и тождеств, которые могут содержать в себе объясняемые переменные из других уравнений (поэтому вводят понятия экзогенных и эндогенных переменных).

3. Сбор данных. cross-sectional data – пространственные данные – набор сведений по разным экономическим объектам в один и тот же момент времени; time-series data – временные ряды – наблюдение одного экономического параметра в разные периоды или моменты времени. Эти данные естественным образом упорядочены во времени. panel data – панельные данные – набор сведений по разным экономическим объектам за несколько периодов времени (данные переписи населения).

3. Сбор данных. cross-sectional data – пространственные данные – набор сведений по разным экономическим объектам в один и тот же момент времени; time-series data – временные ряды – наблюдение одного экономического параметра в разные периоды или моменты времени. Эти данные естественным образом упорядочены во времени. panel data – панельные данные – набор сведений по разным экономическим объектам за несколько периодов времени (данные переписи населения).

4. Идентификация. Идентификация модели – статистический анализ модели и, прежде всего – статистическое оценивание параметров. Выбор метода оценивания сюда тоже входит. Зависит от особенностей модели.

4. Идентификация. Идентификация модели – статистический анализ модели и, прежде всего – статистическое оценивание параметров. Выбор метода оценивания сюда тоже входит. Зависит от особенностей модели.

5. Верификация. Верификация модели – сопоставление реальных и модельных данных, проверка оцененной модели с тем, чтобы прийти к выводу о достаточной реалистичности получаемой с ее помощью картины объекта, либо признать необходимость оценки другой спецификации модели.

5. Верификация. Верификация модели – сопоставление реальных и модельных данных, проверка оцененной модели с тем, чтобы прийти к выводу о достаточной реалистичности получаемой с ее помощью картины объекта, либо признать необходимость оценки другой спецификации модели.

Вопросы для самопроверки Кто первый ввел в употребление термин «Эконометрика». В каком году был основан журнал «Eсonometrics». Каких вы знаете лауреатов нобелевской премии по экономике за достижения в эконометрических методах. На каких «трех китах» базируется современная экономическая теория. Приведите определение эконометрики, отражающее современный взгляд на эту науку. Каковы прикладные цели эконометрики. Перечислите основные этапы эконометрического моделирования. Что входит в спецификацию модели. Что происходит на этапе идентификации модели. Какие основные типы экономических данных вы знаете. Основные типы эконометрических моделей. Как происходит верификация модели

Вопросы для самопроверки Кто первый ввел в употребление термин «Эконометрика». В каком году был основан журнал «Eсonometrics». Каких вы знаете лауреатов нобелевской премии по экономике за достижения в эконометрических методах. На каких «трех китах» базируется современная экономическая теория. Приведите определение эконометрики, отражающее современный взгляд на эту науку. Каковы прикладные цели эконометрики. Перечислите основные этапы эконометрического моделирования. Что входит в спецификацию модели. Что происходит на этапе идентификации модели. Какие основные типы экономических данных вы знаете. Основные типы эконометрических моделей. Как происходит верификация модели

Тема 2. Парная линейная регрессионная модель ПЛРМ

Тема 2. Парная линейная регрессионная модель ПЛРМ

Две переменные X и Y могут быть связаны функциональной зависимостью (т.е. существует функция f что Y = f(X), значения переменной Y полностью определяются значениями переменной X) статистической зависимостью независимы.

Две переменные X и Y могут быть связаны функциональной зависимостью (т.е. существует функция f что Y = f(X), значения переменной Y полностью определяются значениями переменной X) статистической зависимостью независимы.

Статистическая зависимость Если при изменении X меняется закон распределения случайной величины Y, то говорят, что величины (X,Y) связаны статистической зависимостью. Статистическая зависимость называется корреляционной, если при изменении X меняется математическое ожидание случайной величины Y.

Статистическая зависимость Если при изменении X меняется закон распределения случайной величины Y, то говорят, что величины (X,Y) связаны статистической зависимостью. Статистическая зависимость называется корреляционной, если при изменении X меняется математическое ожидание случайной величины Y.

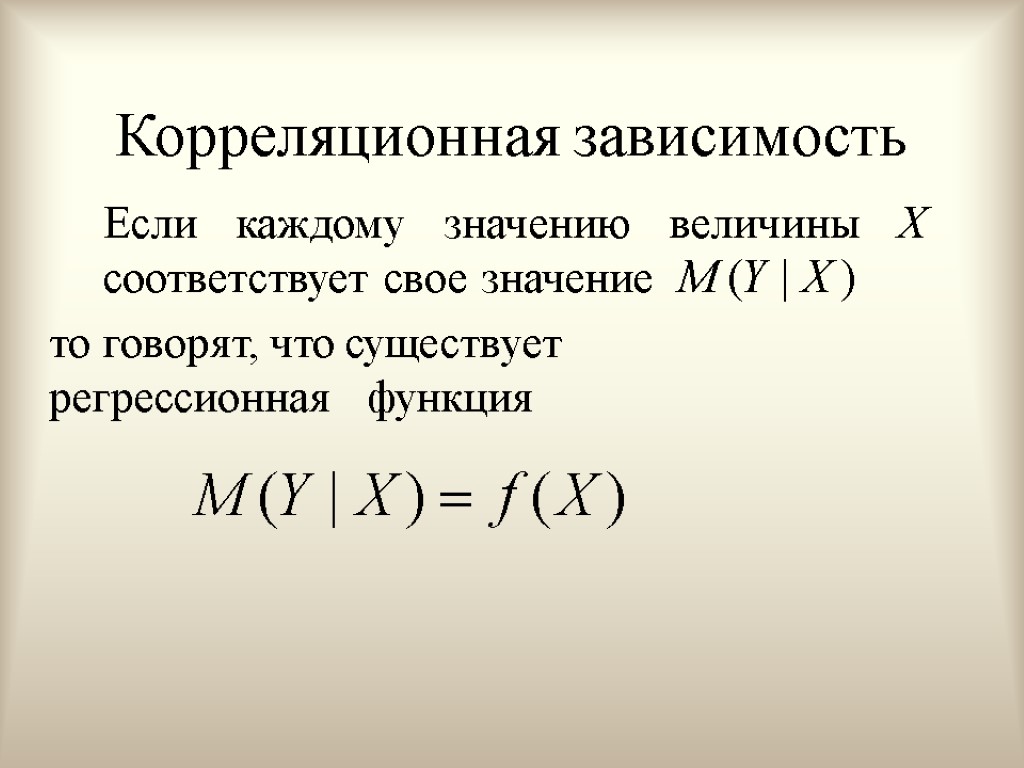

Корреляционная зависимость Если каждому значению величины X соответствует свое значение то говорят, что существует регрессионная функция

Корреляционная зависимость Если каждому значению величины X соответствует свое значение то говорят, что существует регрессионная функция

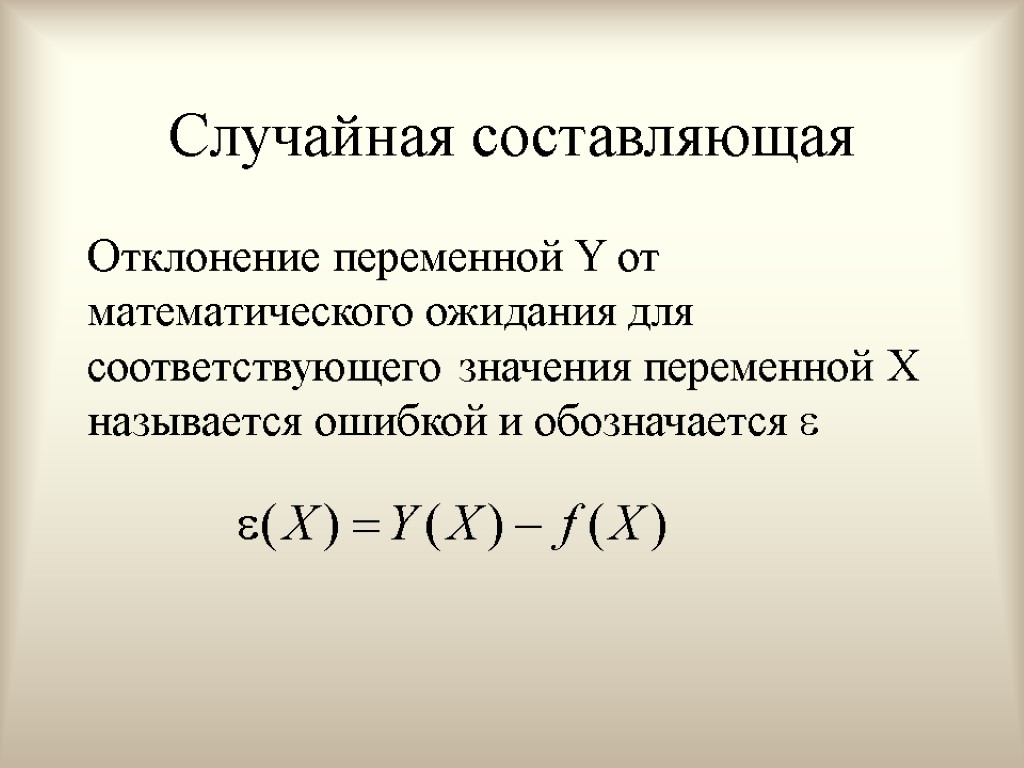

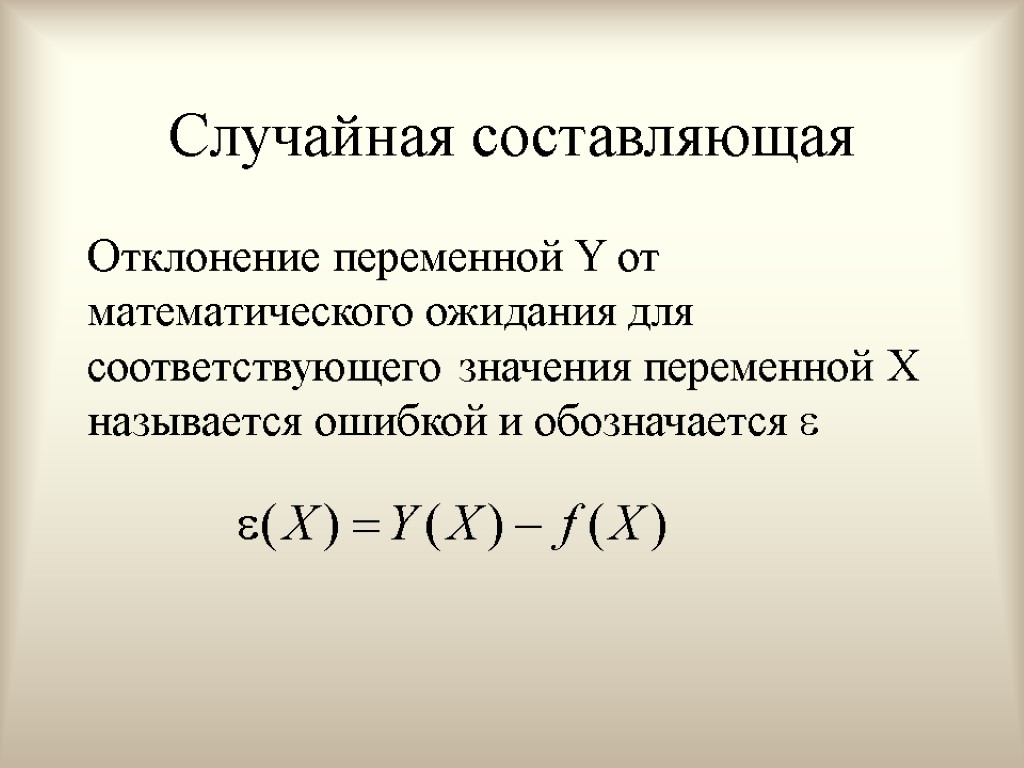

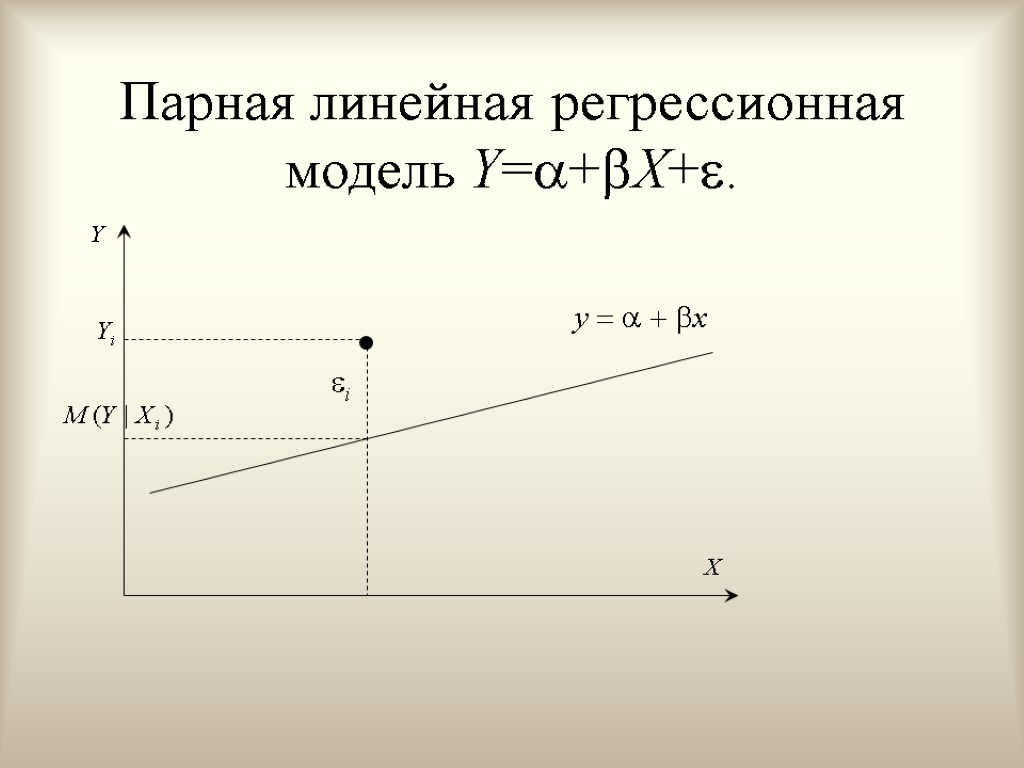

Случайная составляющая Отклонение переменной Y от математического ожидания для соответствующего значения переменной X называется ошибкой и обозначается

Случайная составляющая Отклонение переменной Y от математического ожидания для соответствующего значения переменной X называется ошибкой и обозначается

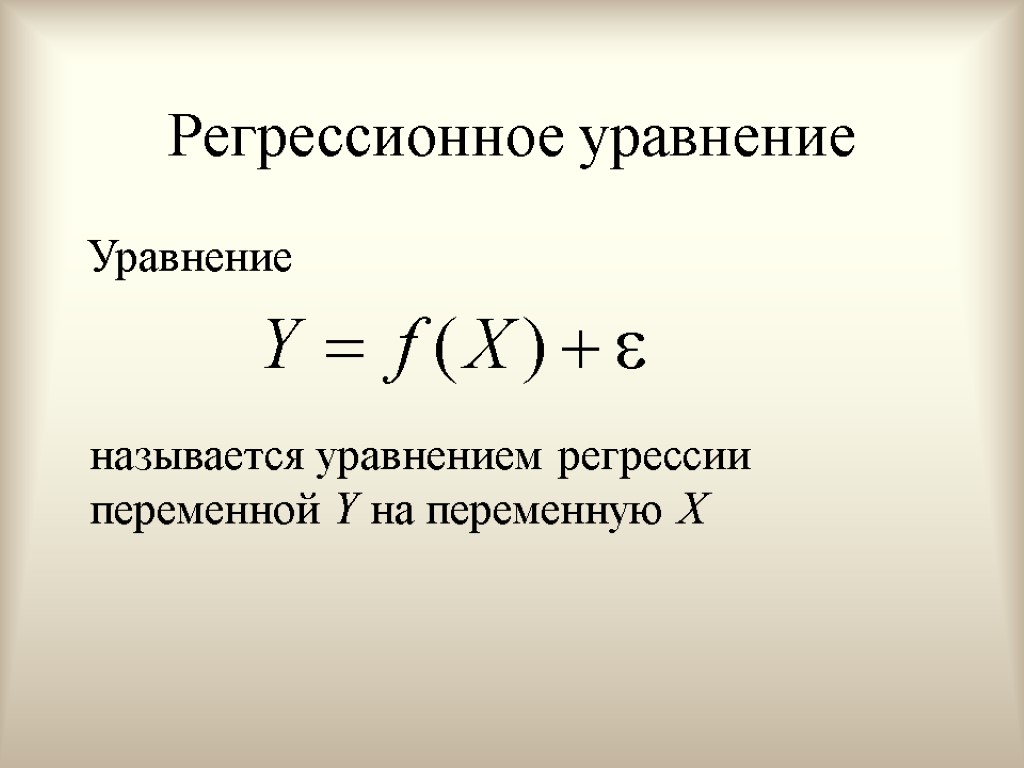

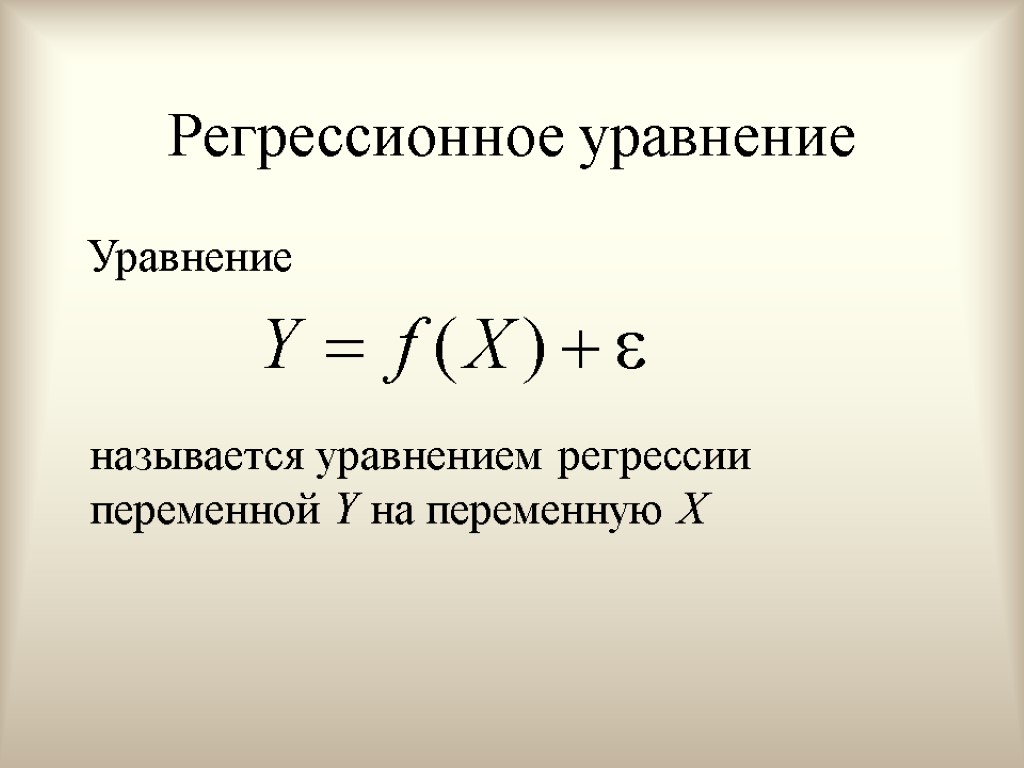

Регрессионное уравнение Уравнение называется уравнением регрессии переменной Y на переменную X

Регрессионное уравнение Уравнение называется уравнением регрессии переменной Y на переменную X

Экономический смысл невключение объясняющих переменных в уравнение. На самом деле на переменную Y влияет не только переменная X, но и ряд других переменных, которые не учтены в нашей модели по следующим причинам: мы знаем, что другая переменная влияет, но не модем ее учесть, потому как не знаем, как измерить (психологический фактор, например); существуют факторы, которые мы знаем, как измерить, но влияние их на Y так слабо, что их не стоит учитывать; существенные переменные, но из-за отсутствия опыта или знаний мы их таковыми не считаем.

Экономический смысл невключение объясняющих переменных в уравнение. На самом деле на переменную Y влияет не только переменная X, но и ряд других переменных, которые не учтены в нашей модели по следующим причинам: мы знаем, что другая переменная влияет, но не модем ее учесть, потому как не знаем, как измерить (психологический фактор, например); существуют факторы, которые мы знаем, как измерить, но влияние их на Y так слабо, что их не стоит учитывать; существенные переменные, но из-за отсутствия опыта или знаний мы их таковыми не считаем.

Экономический смысл (продолжение) Неправильная функциональная спецификация. Функциональное соотношение между Y и Х может быть определено неправильно. Например, мы предположили линейную зависимость, а она может быть более сложной. Ошибки наблюдений (занижение реального уровня доходов). В этом случае наблюдаемые значения не будут соответствовать точному соотношению, и существующее расхождение будет вносить свой вклад в остаточный член.

Экономический смысл (продолжение) Неправильная функциональная спецификация. Функциональное соотношение между Y и Х может быть определено неправильно. Например, мы предположили линейную зависимость, а она может быть более сложной. Ошибки наблюдений (занижение реального уровня доходов). В этом случае наблюдаемые значения не будут соответствовать точному соотношению, и существующее расхождение будет вносить свой вклад в остаточный член.

Способы определения регрессионной функции f(X) параметрический – предполагаем, что вид регрессионной функции известен, неизвестны параметры функции непараметрический – предполагаем, что вид регрессионной функции неизвестен и мы составляем алгоритм расчета значений функции в каждой точке

Способы определения регрессионной функции f(X) параметрический – предполагаем, что вид регрессионной функции известен, неизвестны параметры функции непараметрический – предполагаем, что вид регрессионной функции неизвестен и мы составляем алгоритм расчета значений функции в каждой точке

Выбор вида f(X) экономическая теория опыт, интуиция исследователя эмпирический анализ данных

Выбор вида f(X) экономическая теория опыт, интуиция исследователя эмпирический анализ данных

Эмпирический анализ данных В парном случае материал наблюдений представляет собой набор пар чисел: .

Эмпирический анализ данных В парном случае материал наблюдений представляет собой набор пар чисел: .

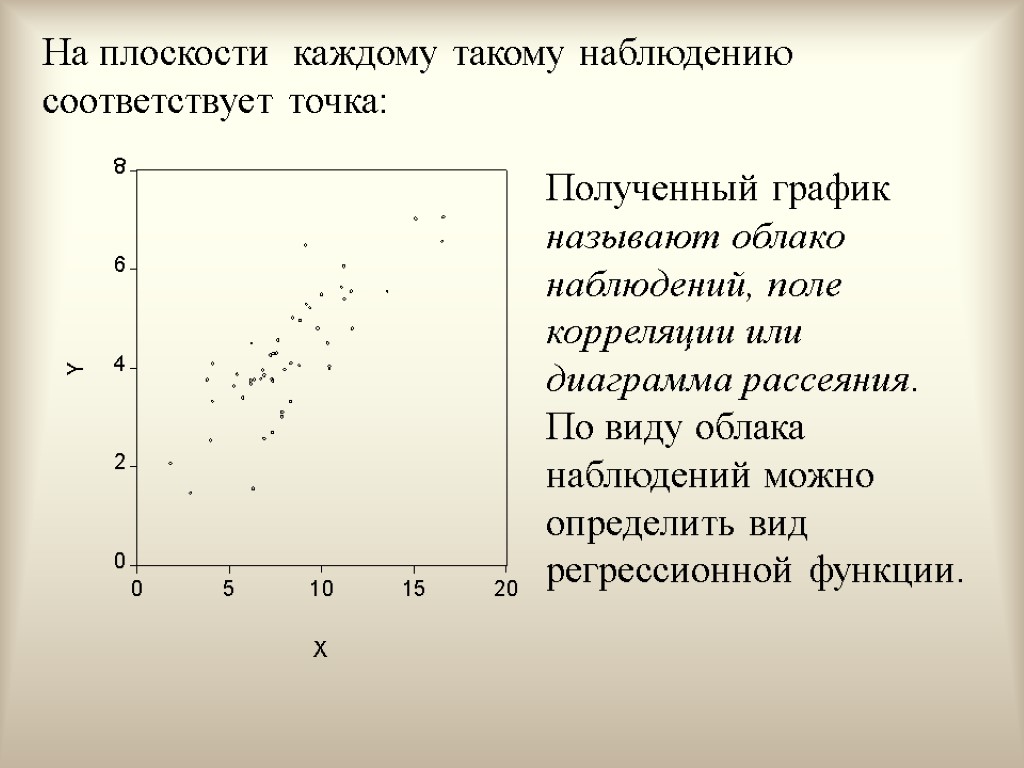

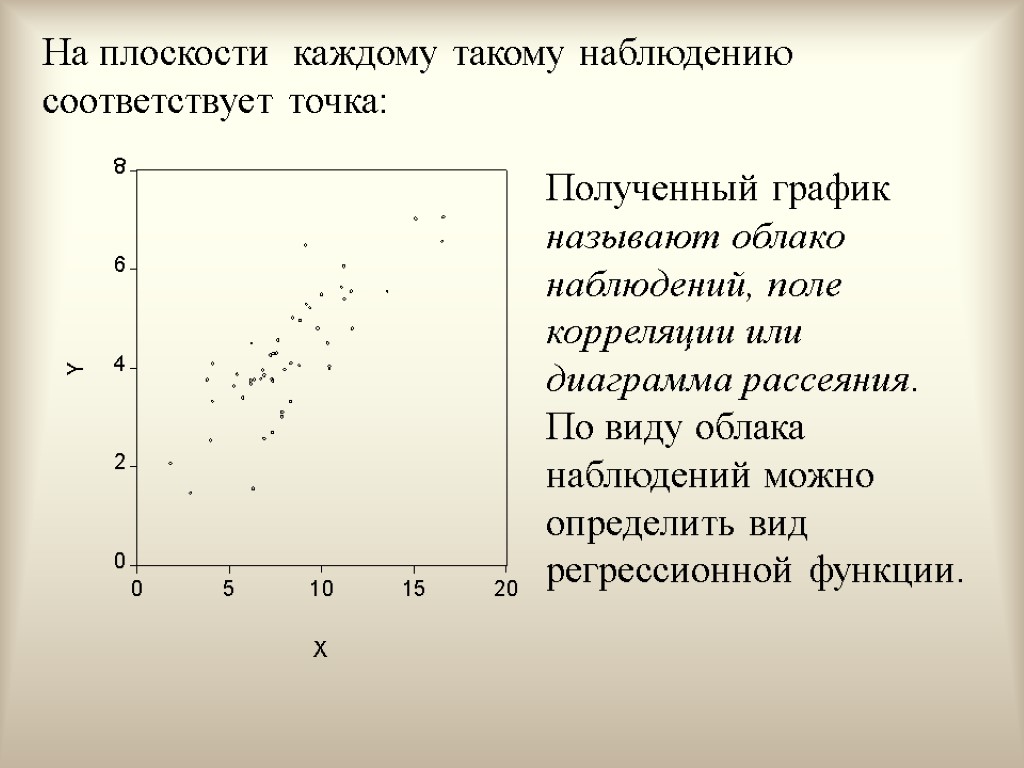

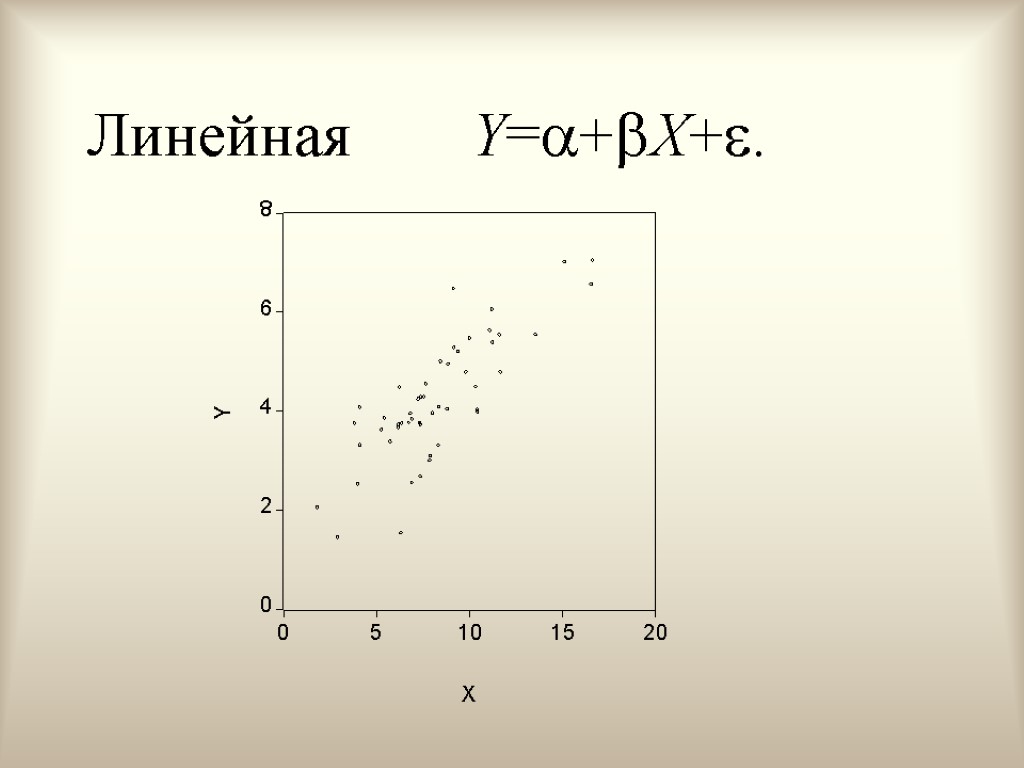

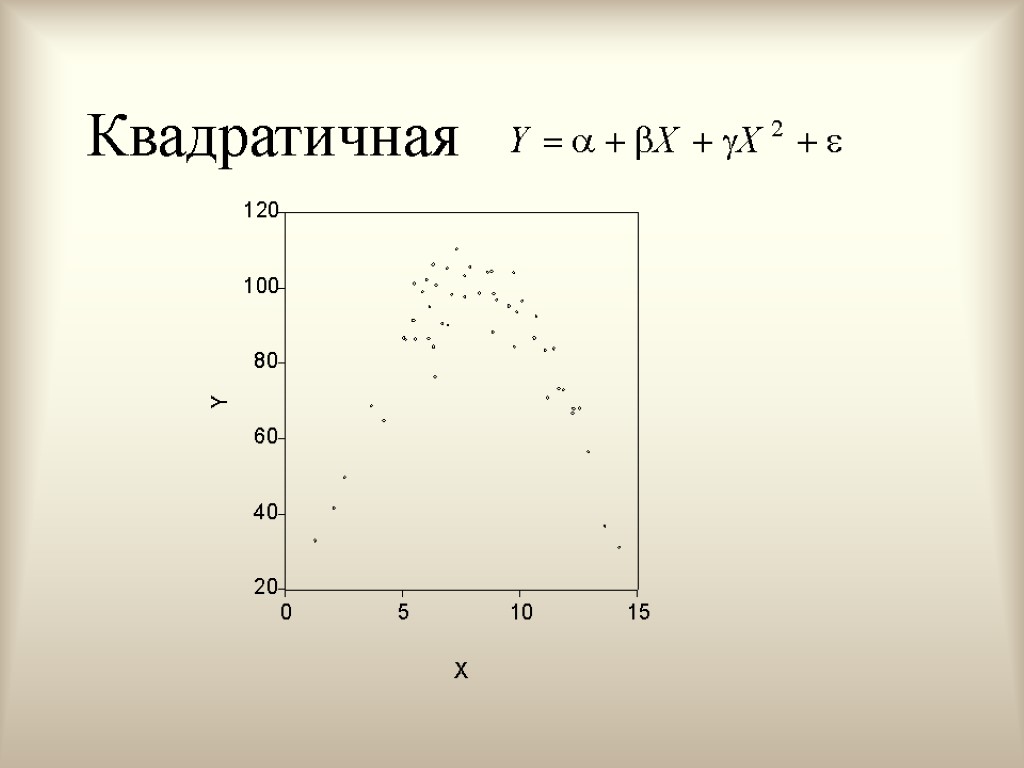

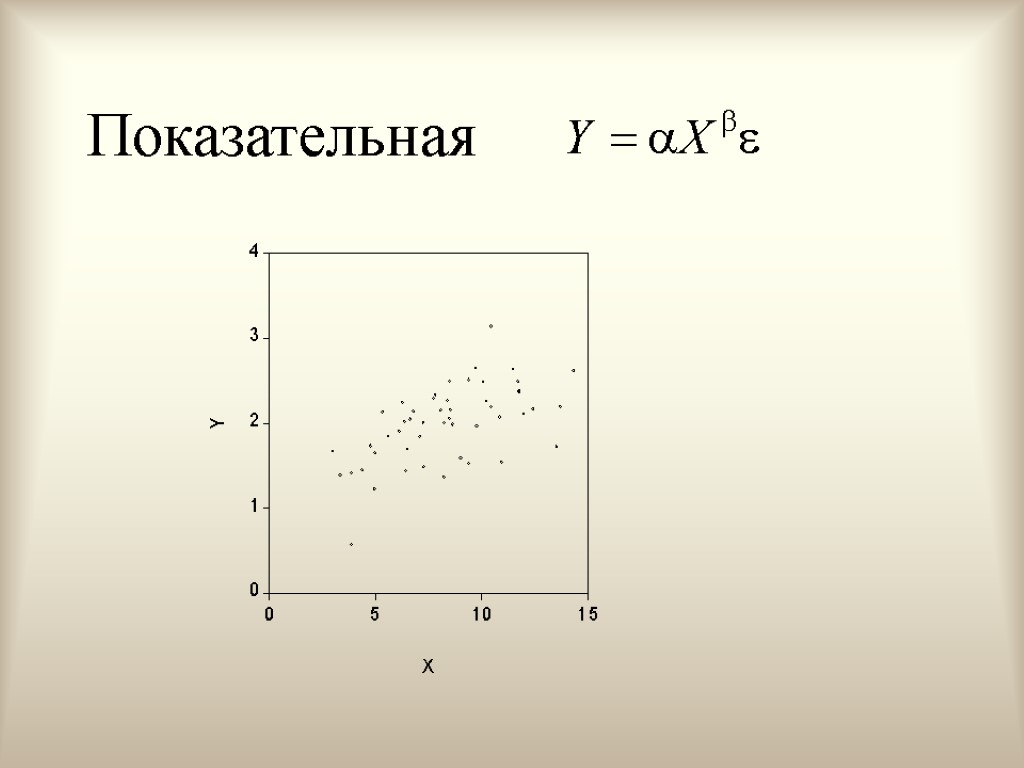

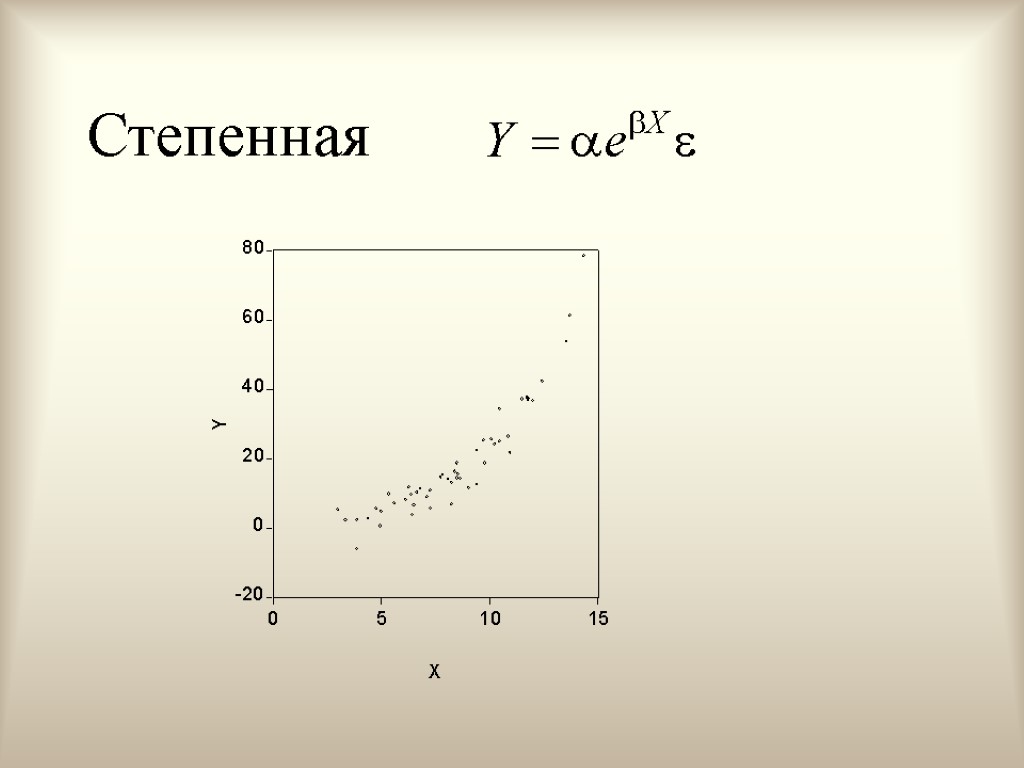

На плоскости каждому такому наблюдению соответствует точка: Полученный график называют облако наблюдений, поле корреляции или диаграмма рассеяния. По виду облака наблюдений можно определить вид регрессионной функции.

На плоскости каждому такому наблюдению соответствует точка: Полученный график называют облако наблюдений, поле корреляции или диаграмма рассеяния. По виду облака наблюдений можно определить вид регрессионной функции.

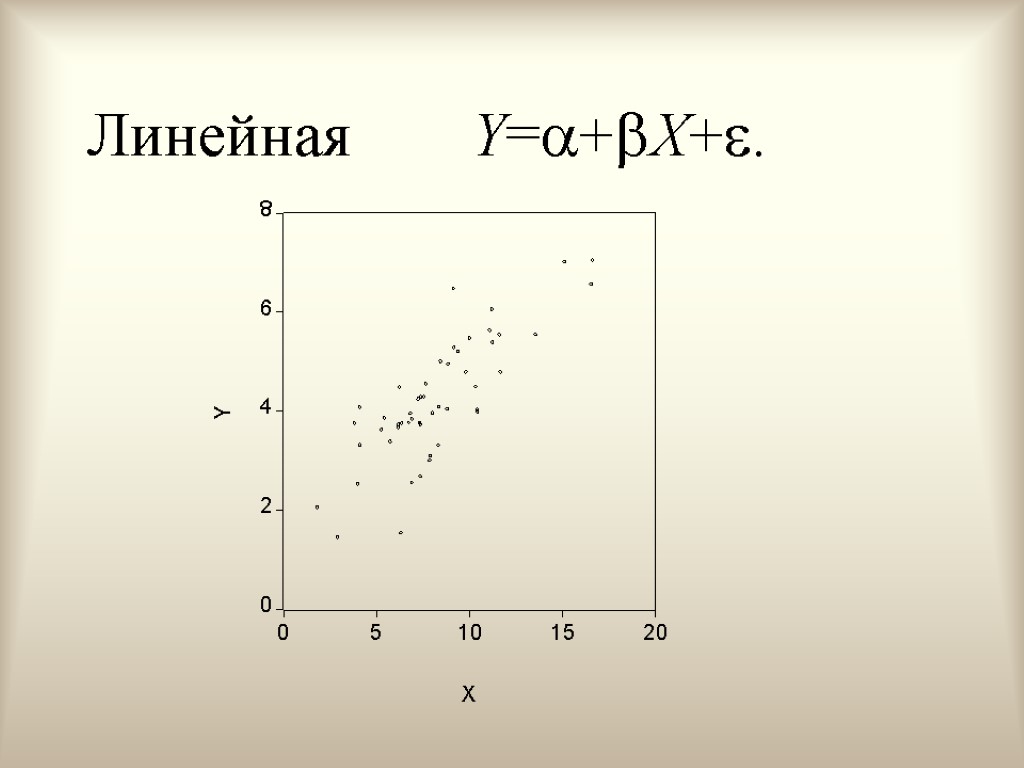

Линейная Y=+X+.

Линейная Y=+X+.

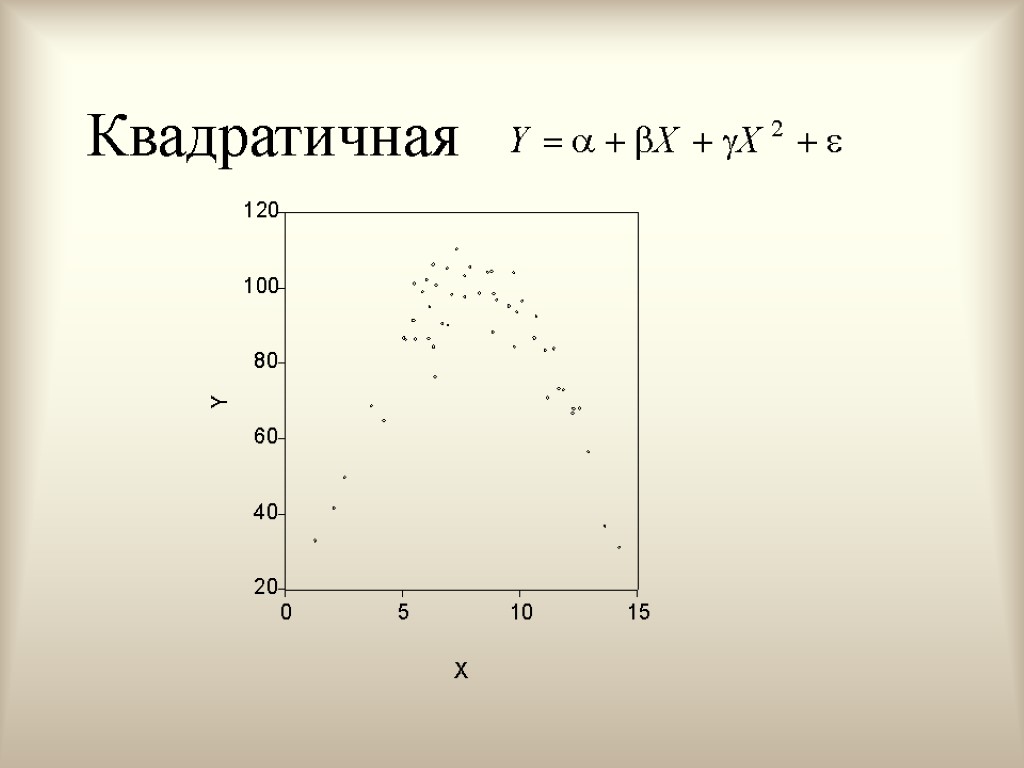

Квадратичная

Квадратичная

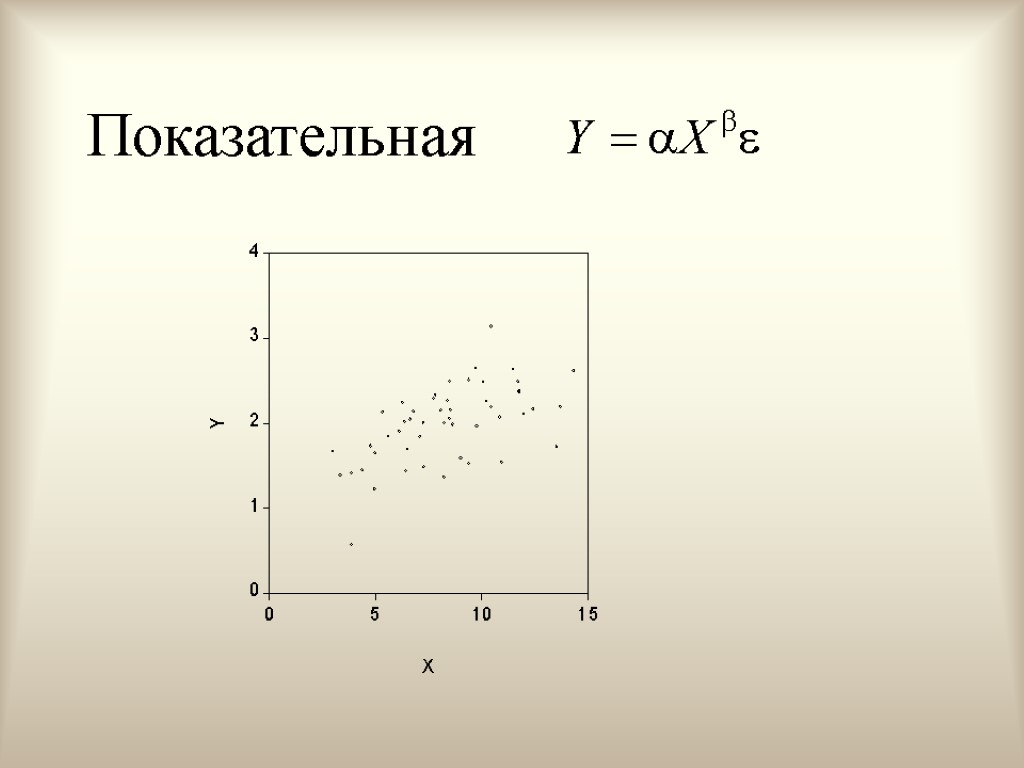

Показательная

Показательная

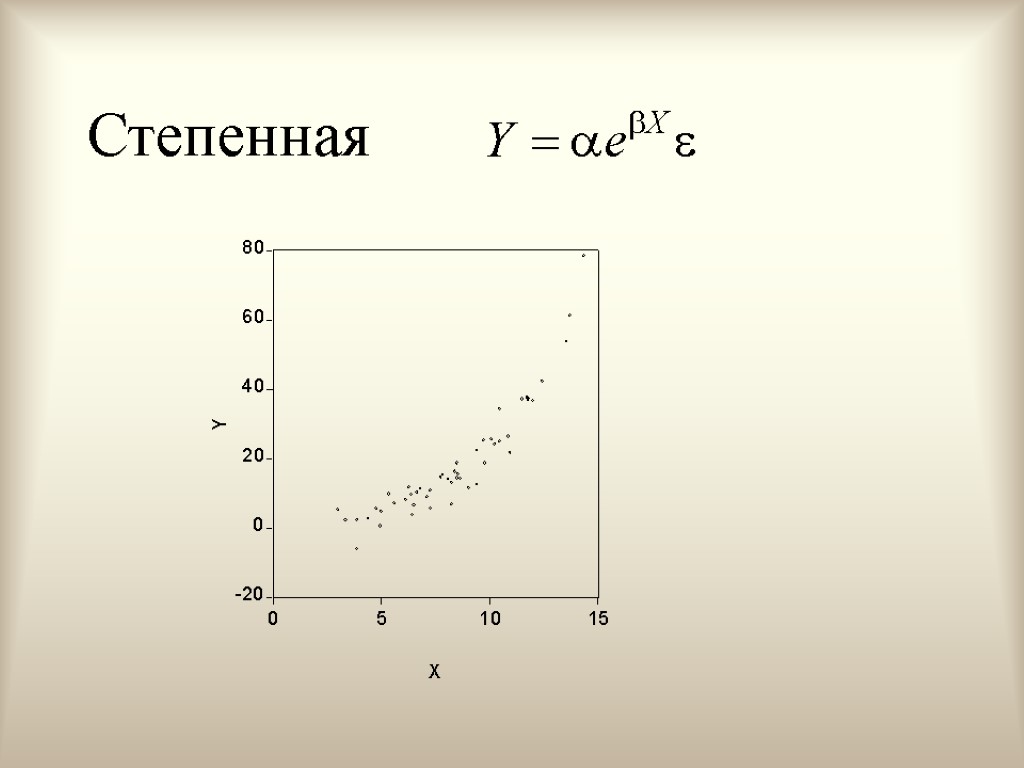

Степенная

Степенная

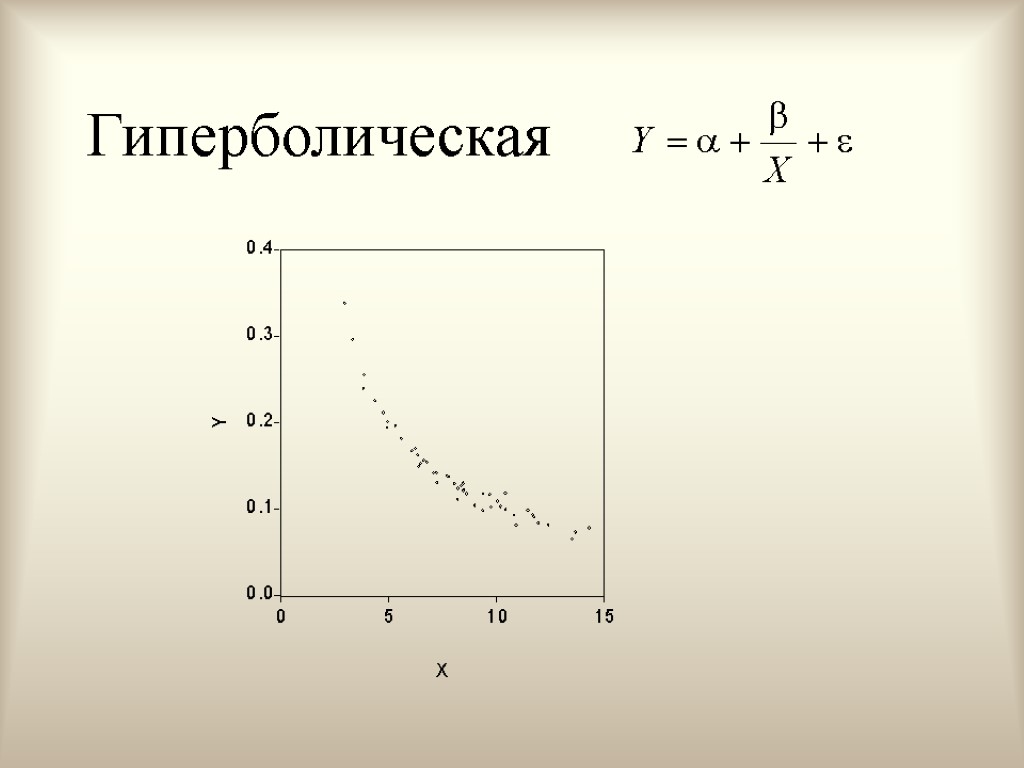

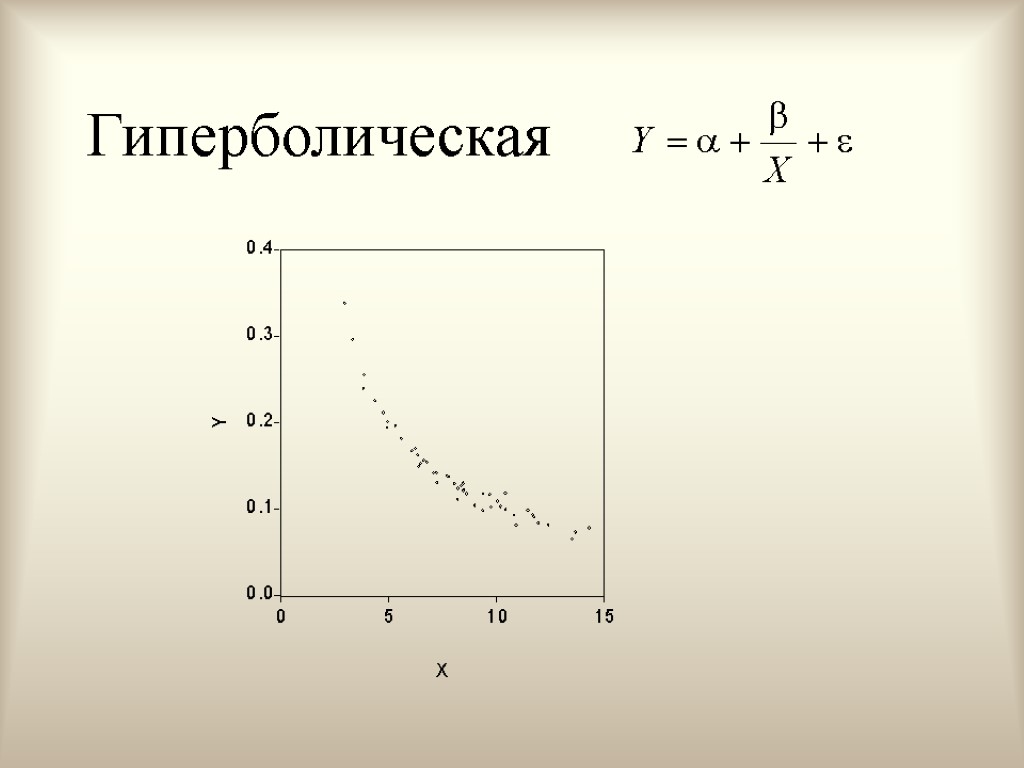

Гиперболическая

Гиперболическая

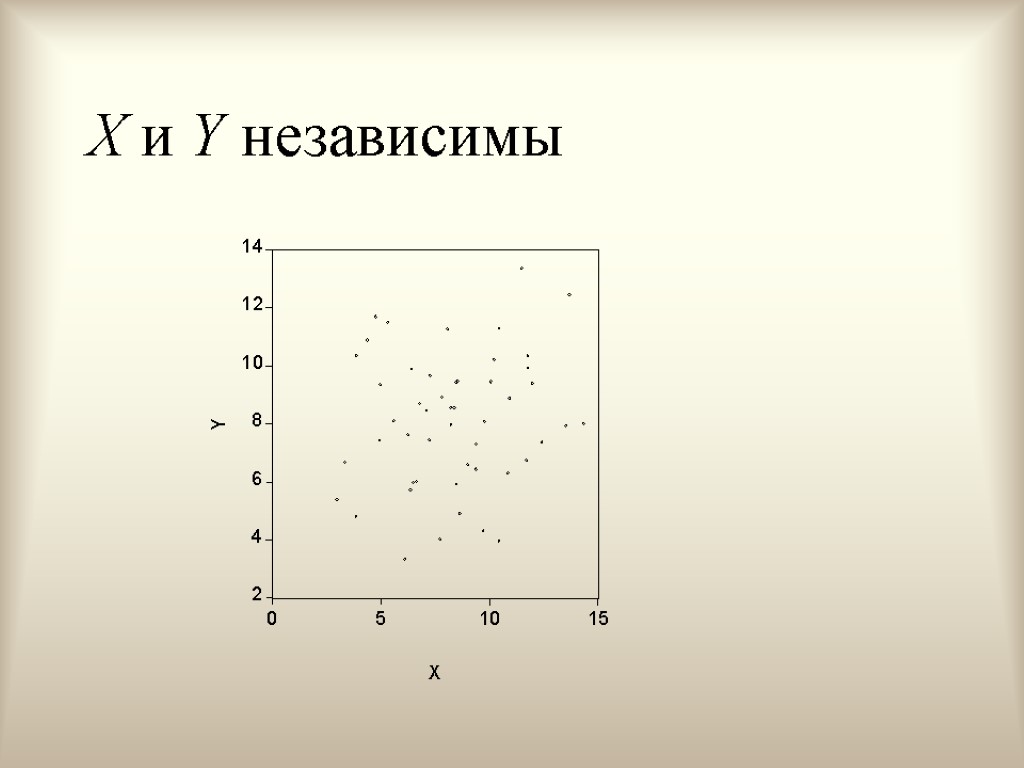

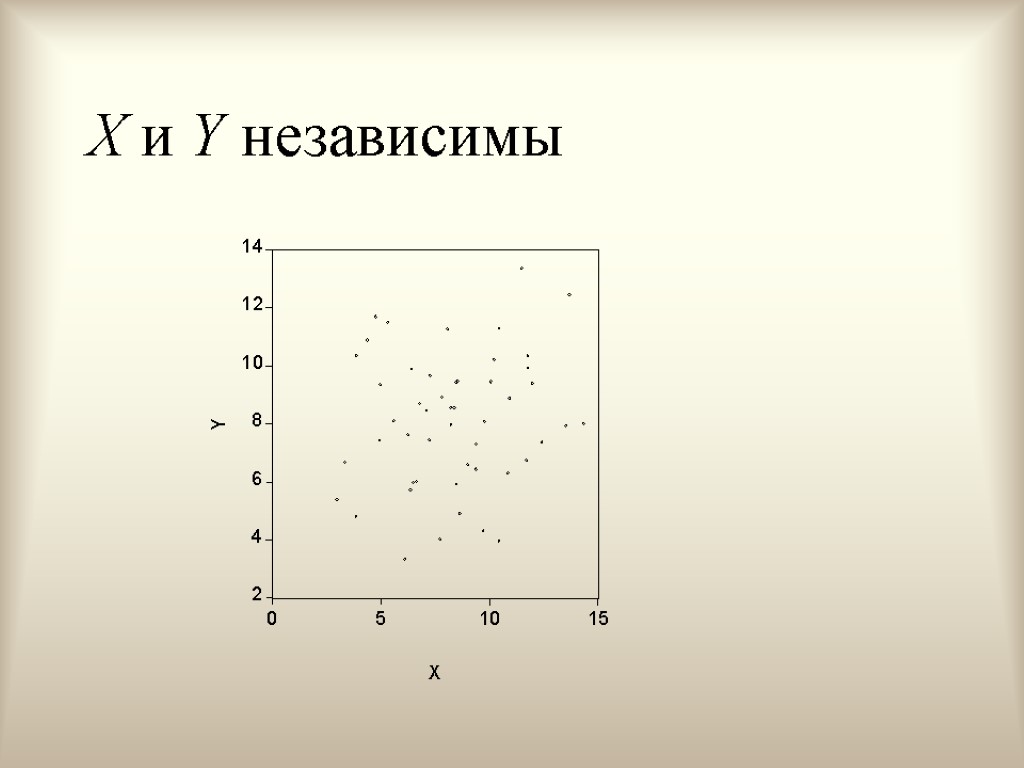

X и Y независимы

X и Y независимы

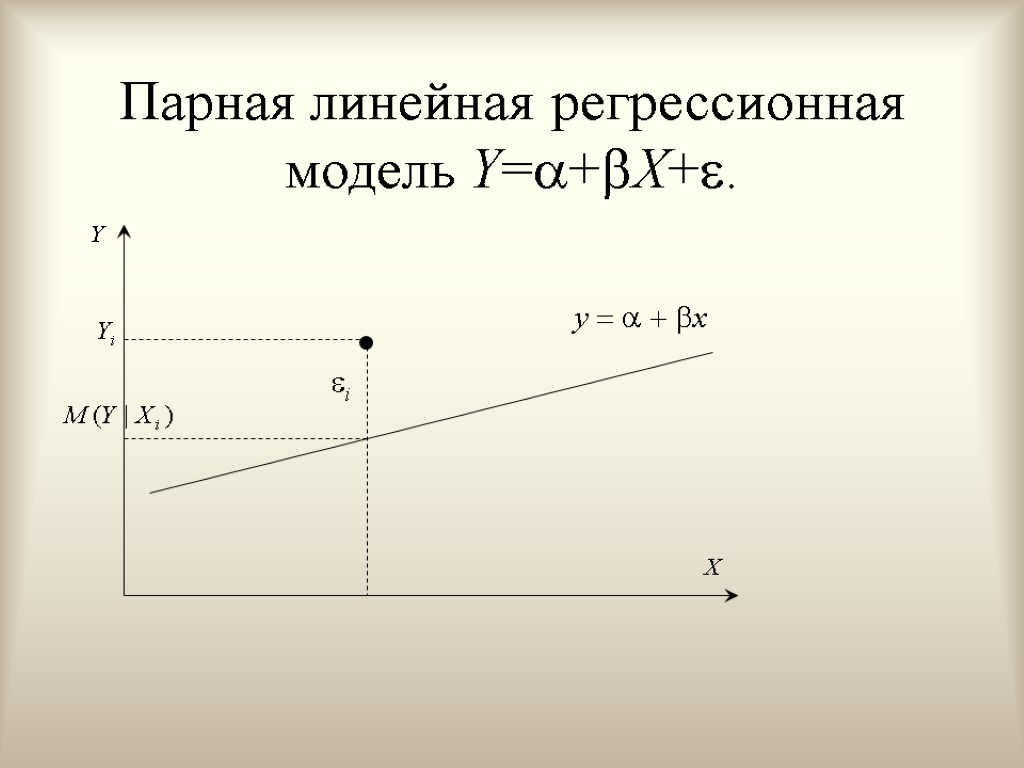

Парная линейная регрессионная модель Y=+X+.

Парная линейная регрессионная модель Y=+X+.

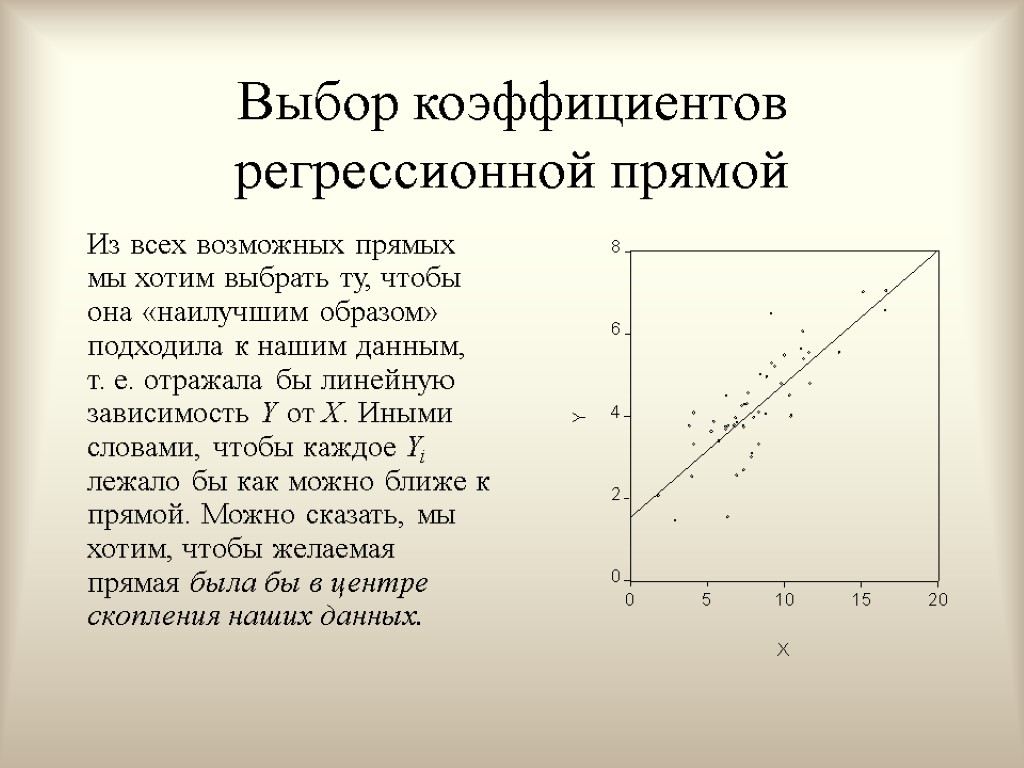

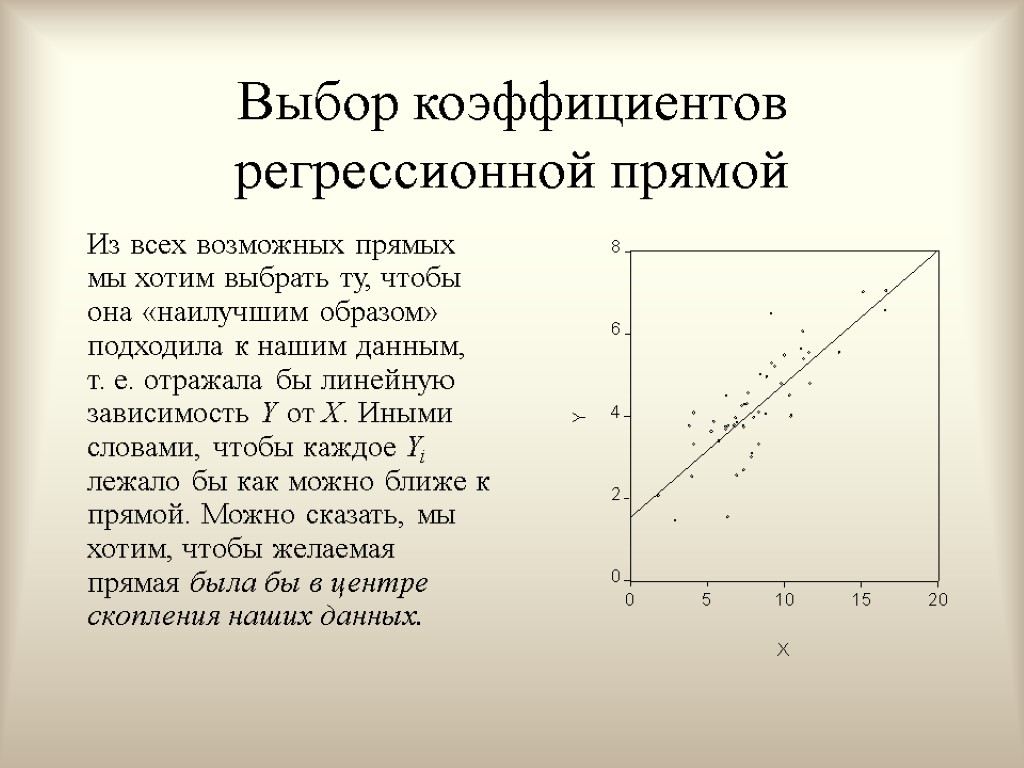

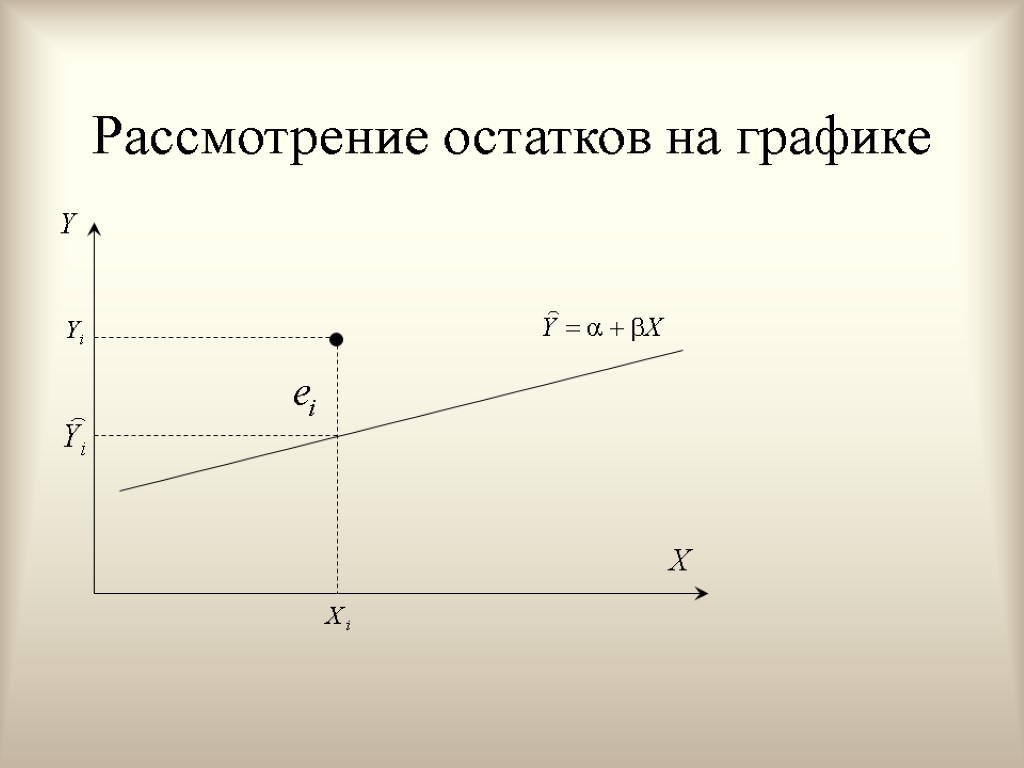

Выбор коэффициентов регрессионной прямой Из всех возможных прямых мы хотим выбрать ту, чтобы она «наилучшим образом» подходила к нашим данным, т. е. отражала бы линейную зависимость Y от X. Иными словами, чтобы каждое Yi лежало бы как можно ближе к прямой. Можно сказать, мы хотим, чтобы желаемая прямая была бы в центре скопления наших данных.

Выбор коэффициентов регрессионной прямой Из всех возможных прямых мы хотим выбрать ту, чтобы она «наилучшим образом» подходила к нашим данным, т. е. отражала бы линейную зависимость Y от X. Иными словами, чтобы каждое Yi лежало бы как можно ближе к прямой. Можно сказать, мы хотим, чтобы желаемая прямая была бы в центре скопления наших данных.

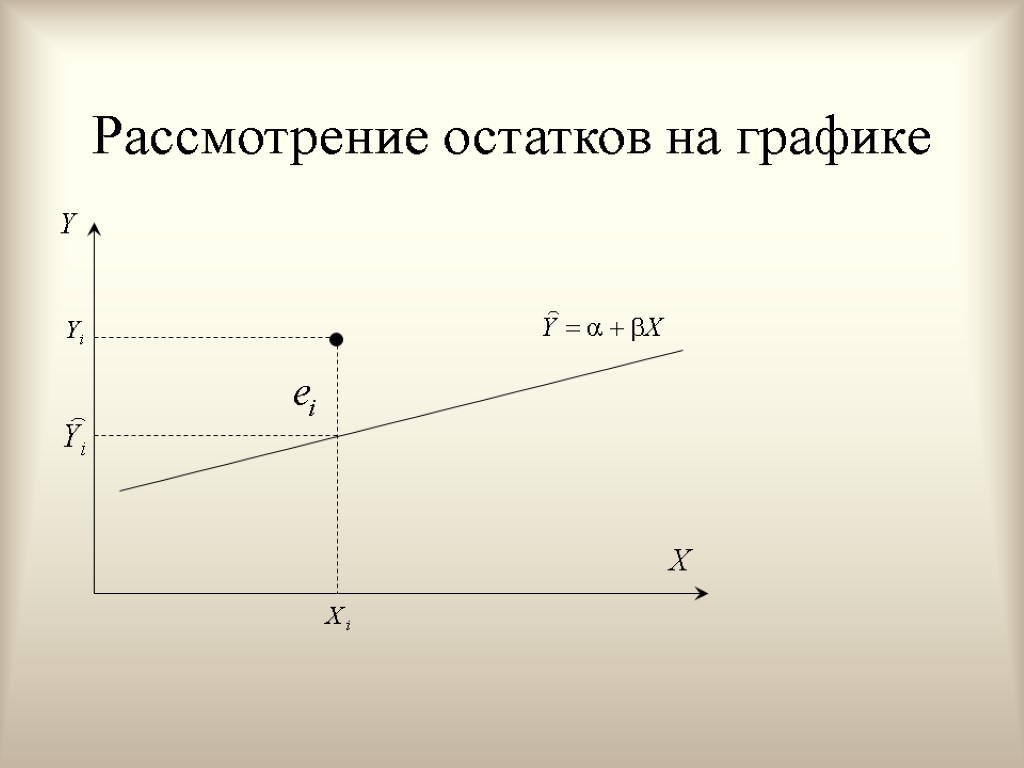

Рассмотрение остатков на графике

Рассмотрение остатков на графике

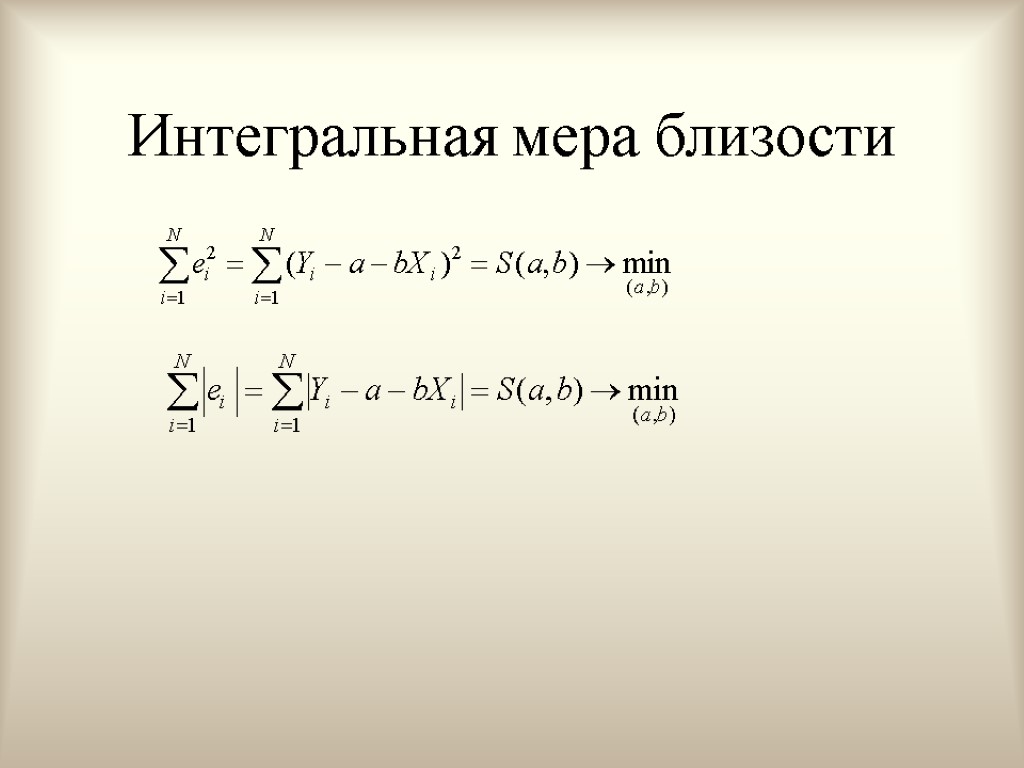

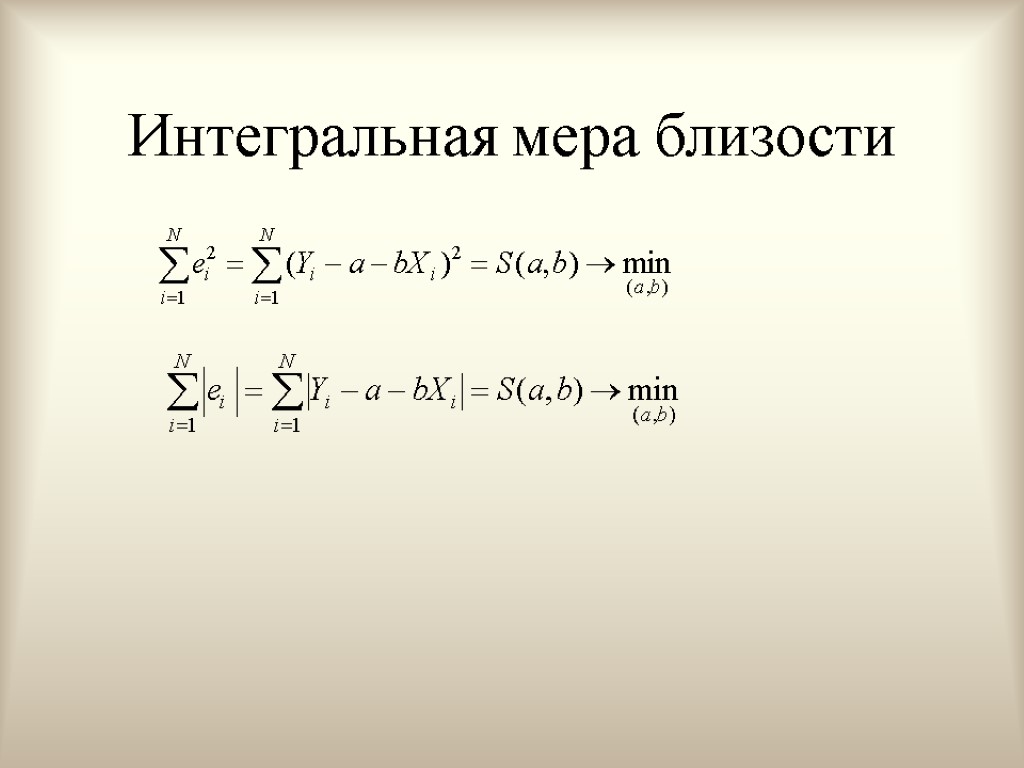

Интегральная мера близости

Интегральная мера близости

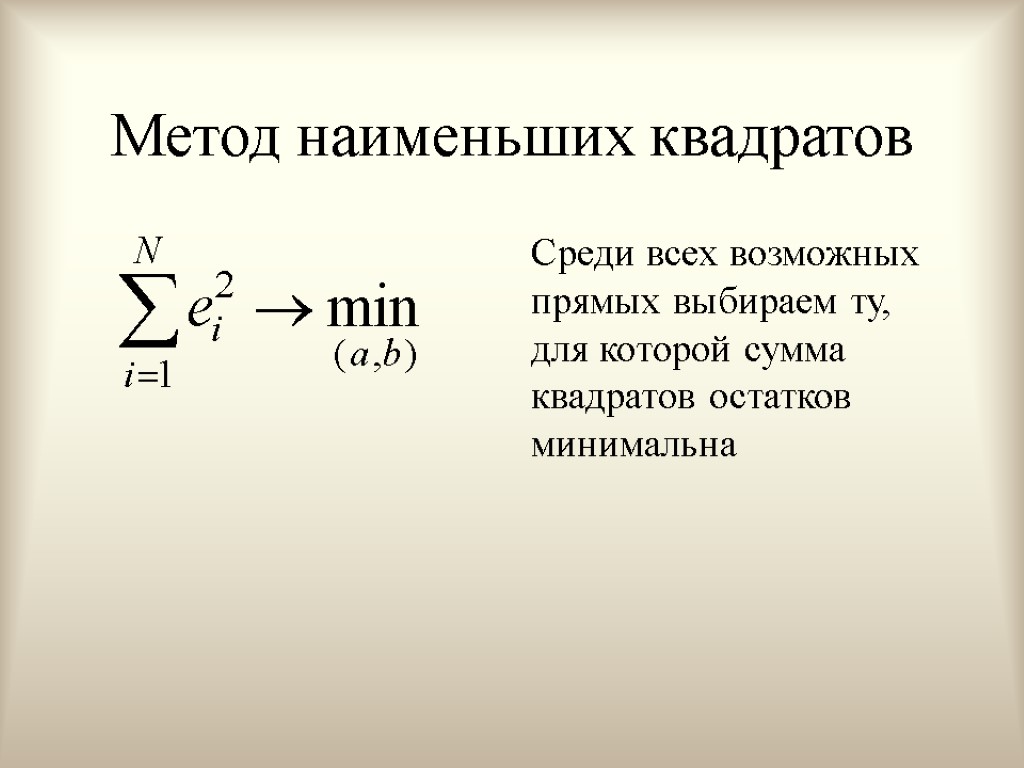

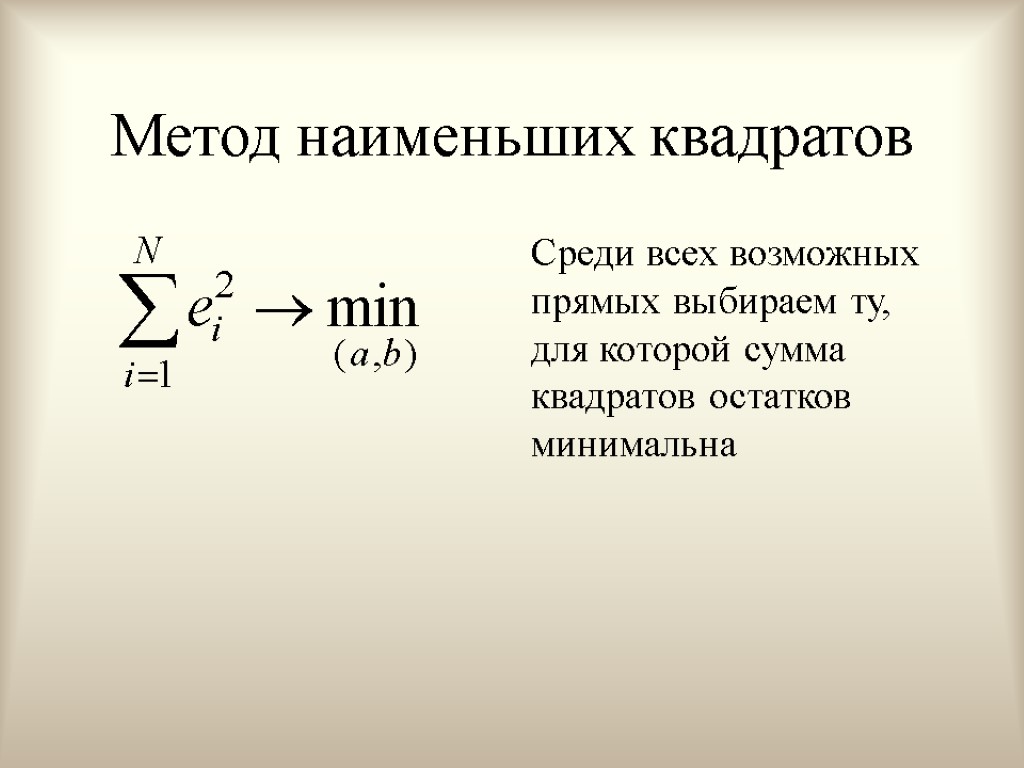

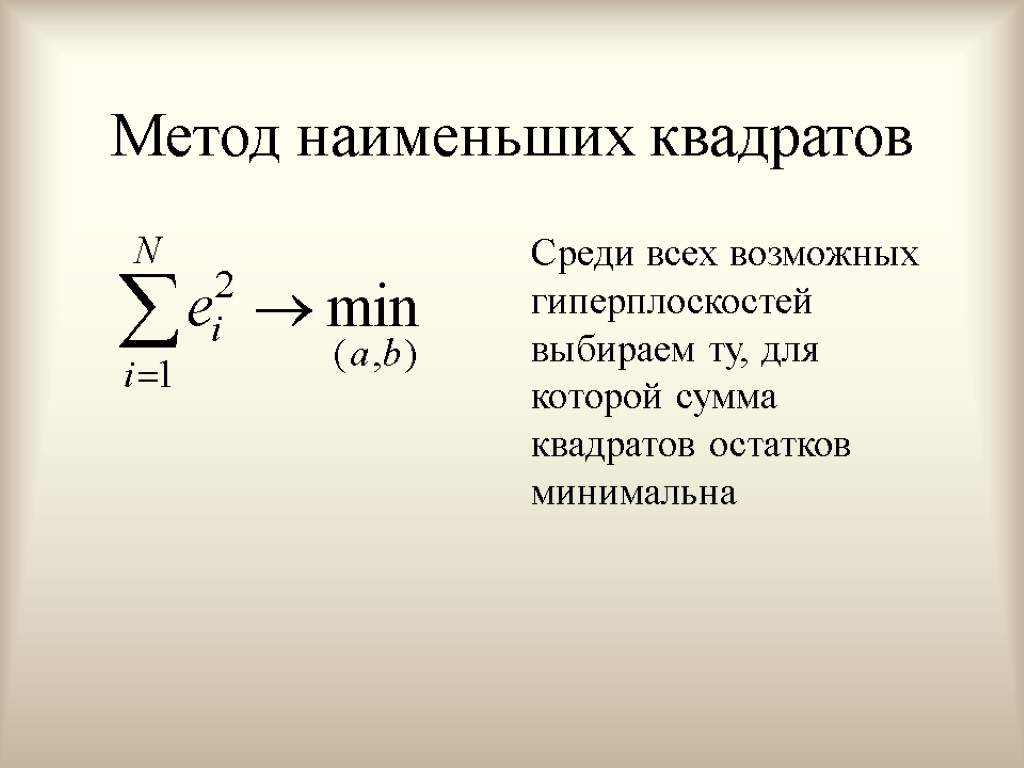

Метод наименьших квадратов Среди всех возможных прямых выбираем ту, для которой сумма квадратов остатков минимальна

Метод наименьших квадратов Среди всех возможных прямых выбираем ту, для которой сумма квадратов остатков минимальна

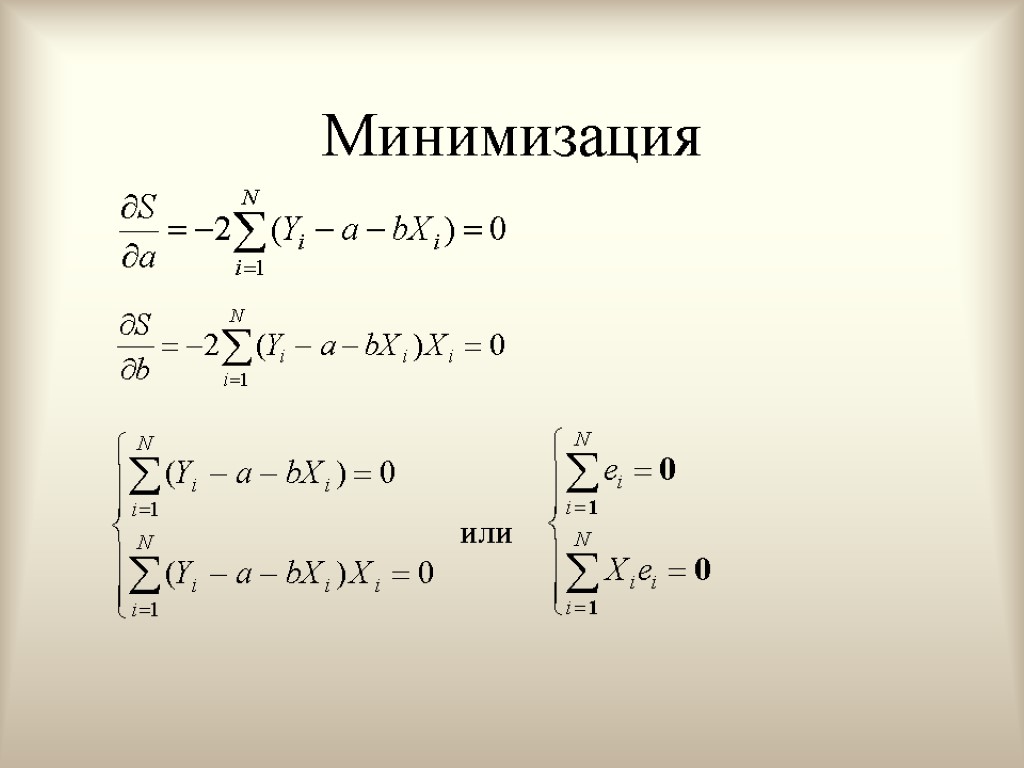

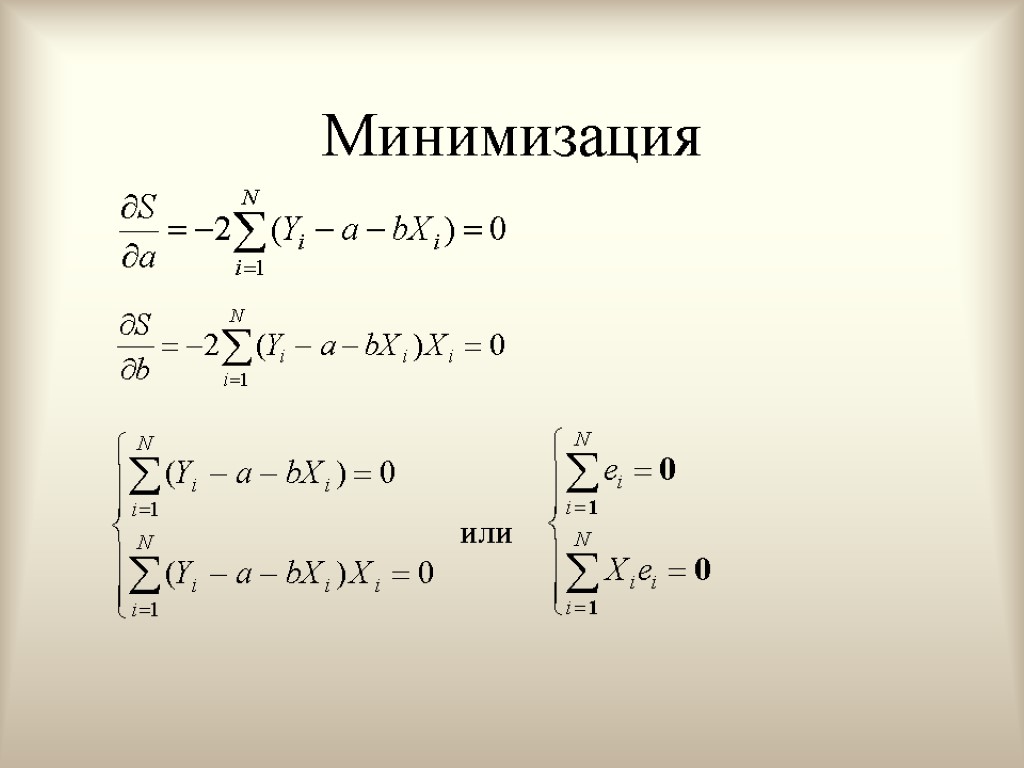

Минимизация или

Минимизация или

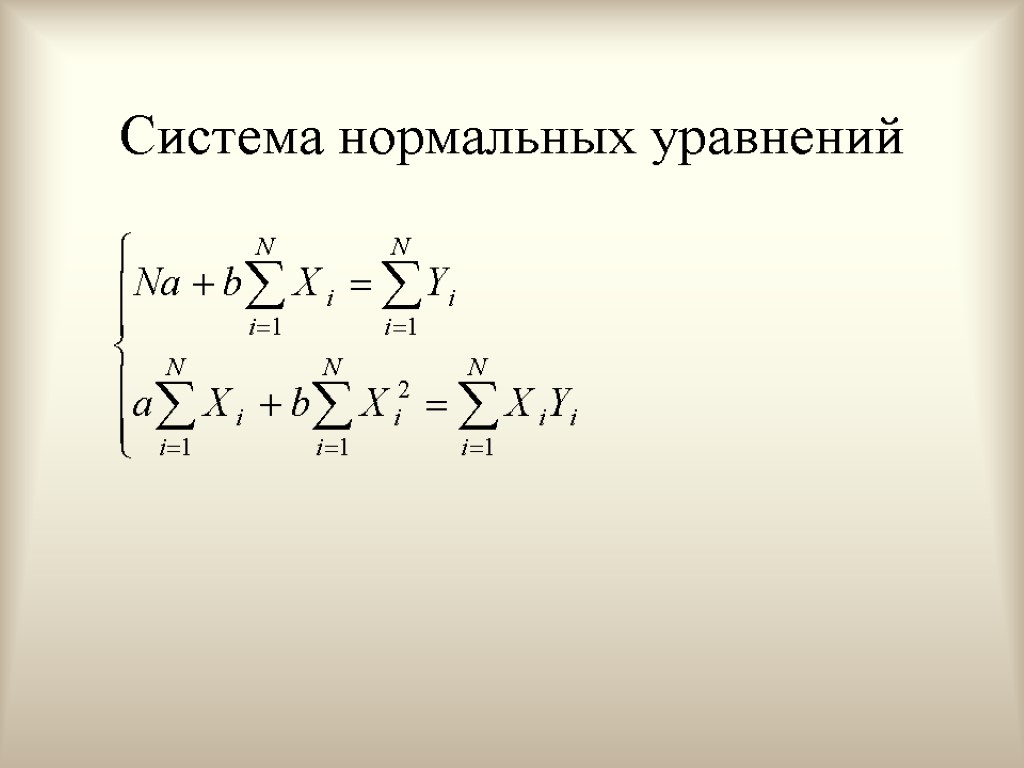

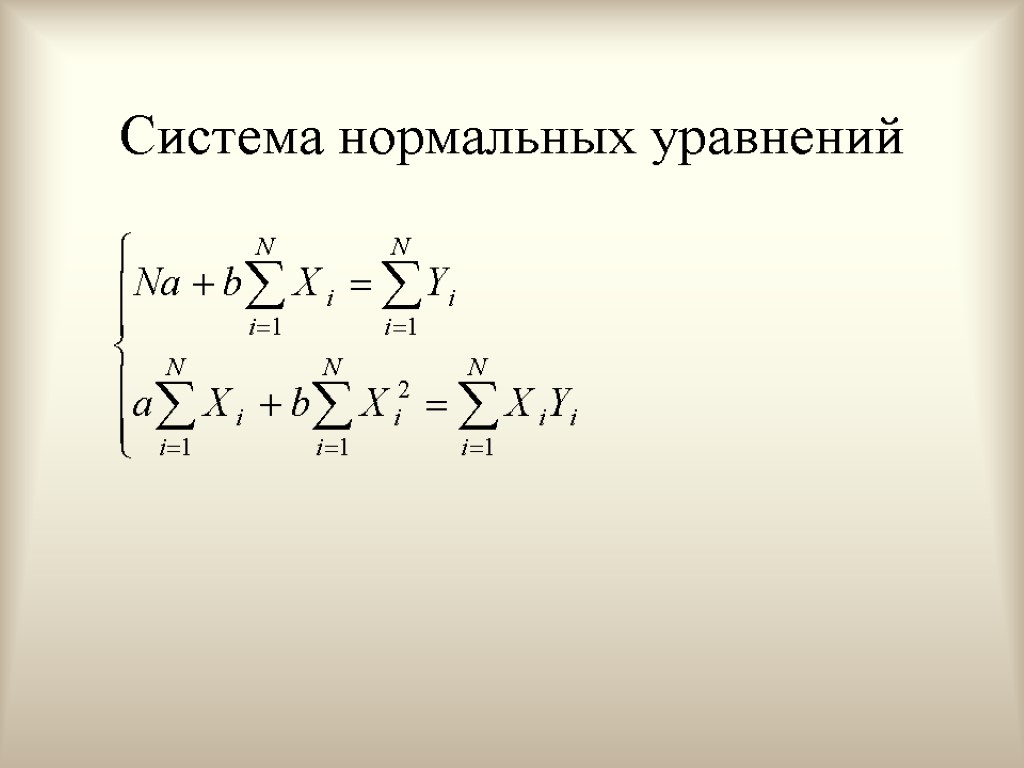

Система нормальных уравнений

Система нормальных уравнений

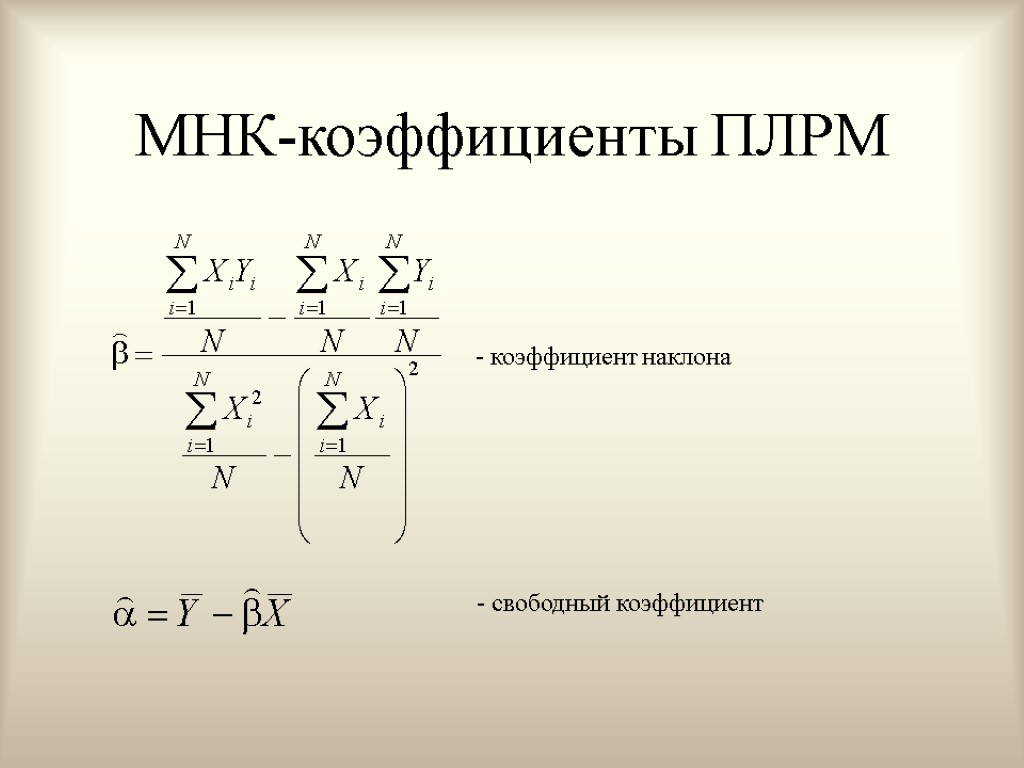

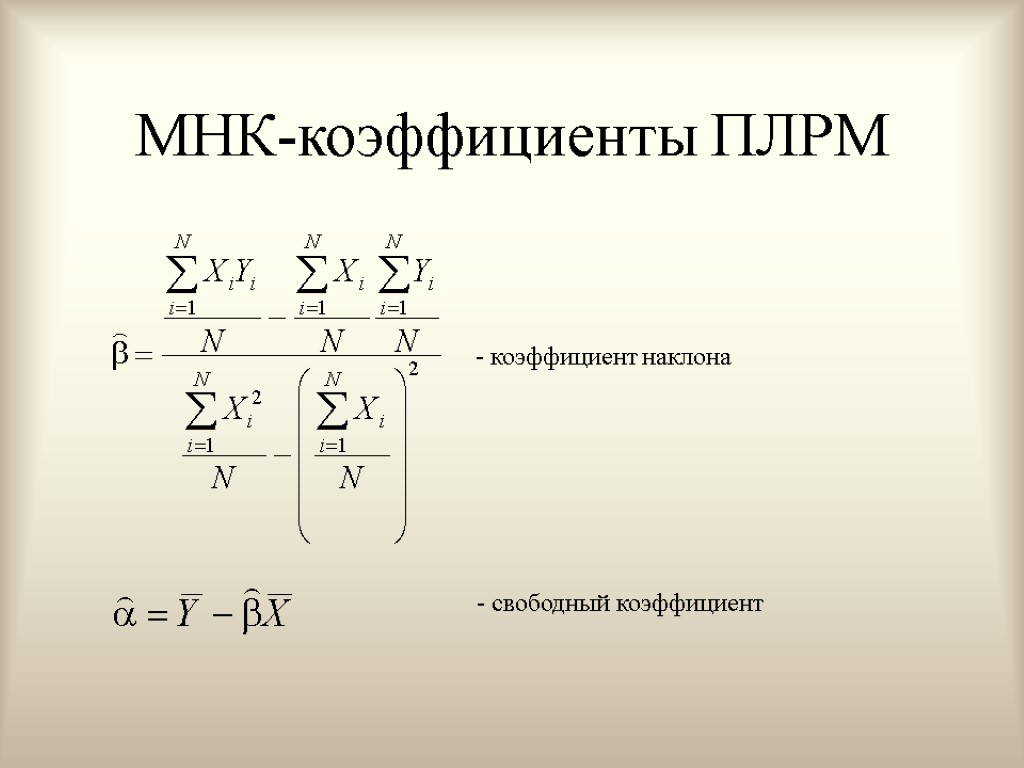

МНК-коэффициенты ПЛРМ - коэффициент наклона - свободный коэффициент

МНК-коэффициенты ПЛРМ - коэффициент наклона - свободный коэффициент

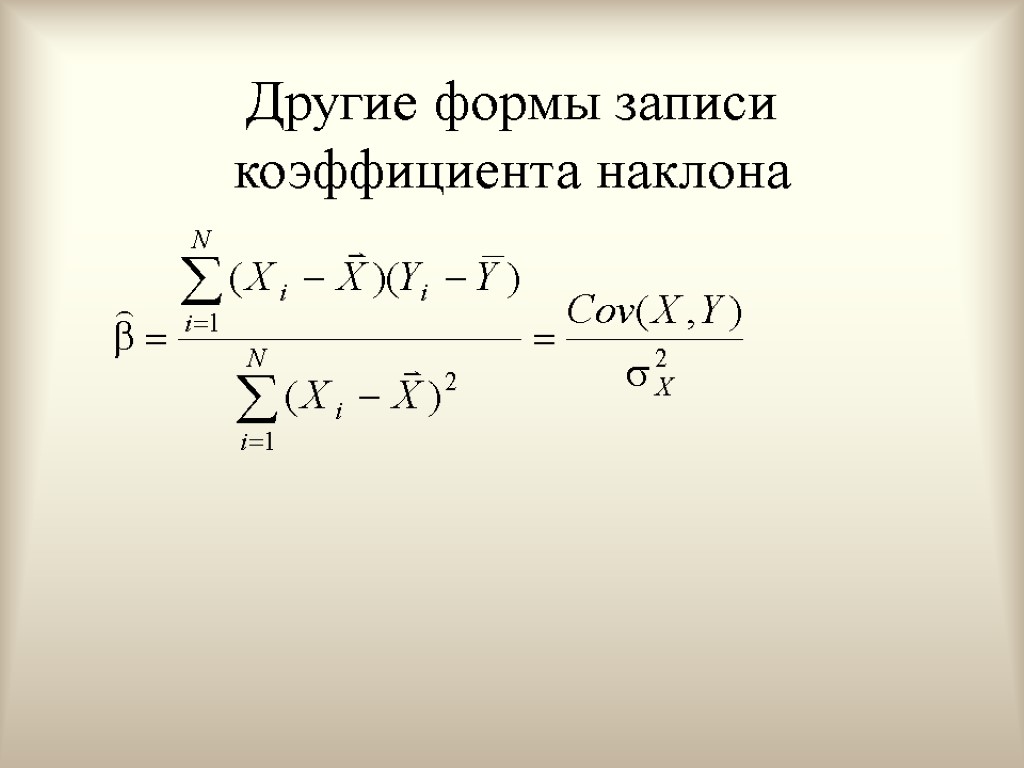

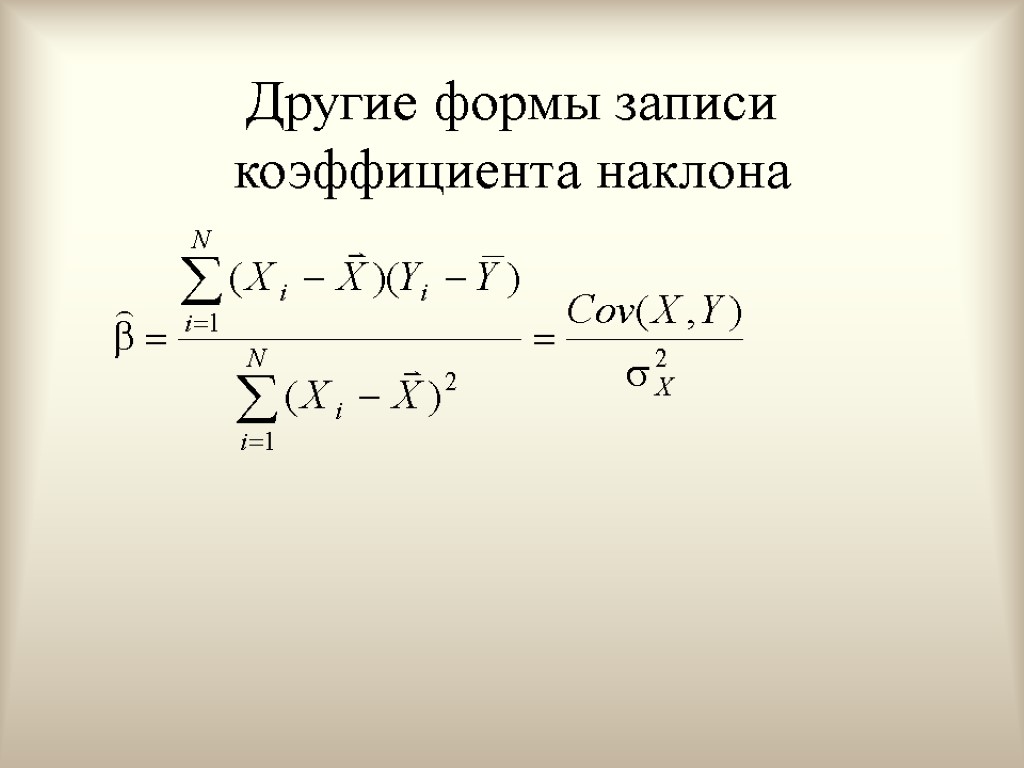

Другие формы записи коэффициента наклона

Другие формы записи коэффициента наклона

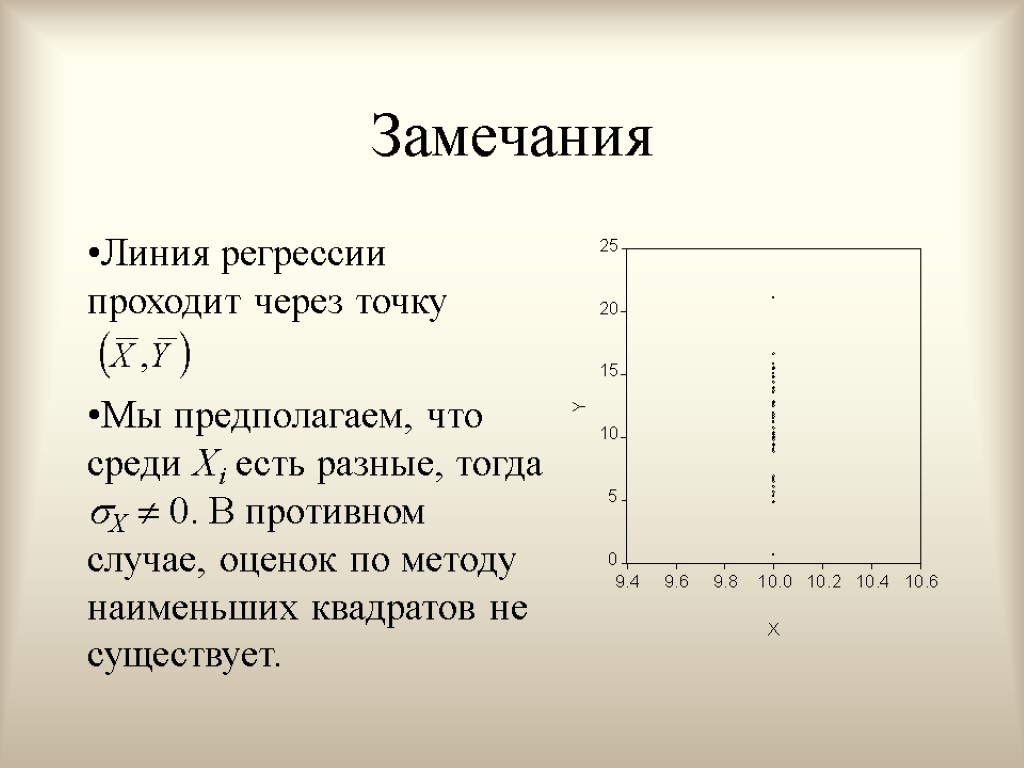

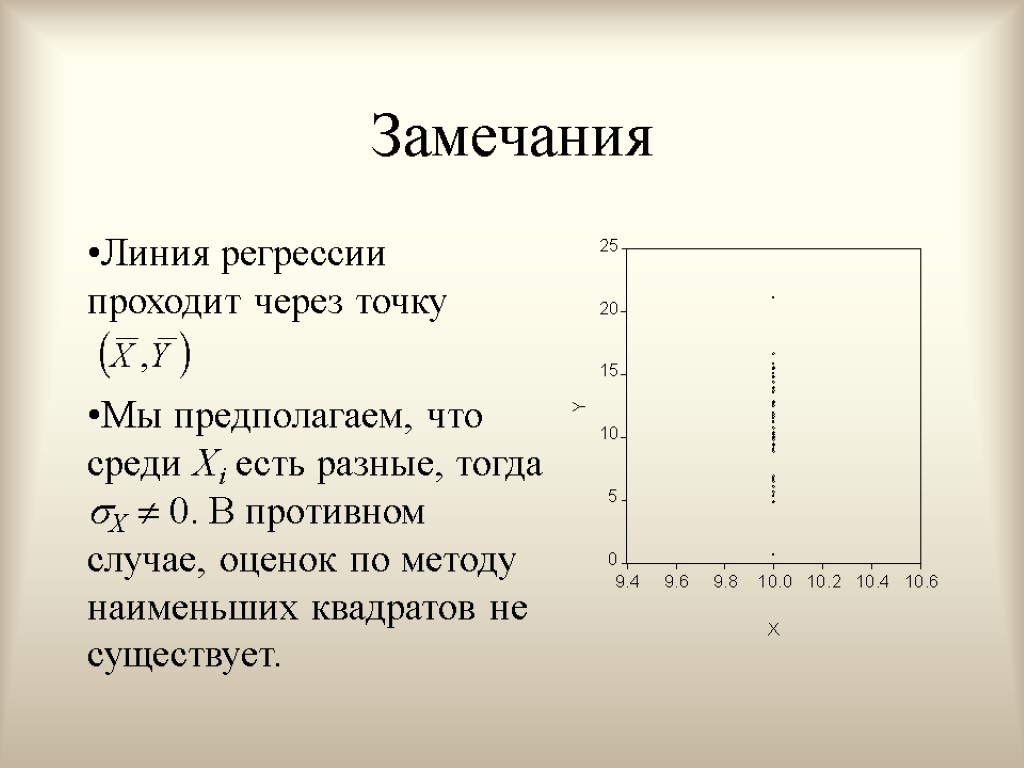

Замечания Линия регрессии проходит через точку Мы предполагаем, что среди Xi есть разные, тогда X 0. В противном случае, оценок по методу наименьших квадратов не существует.

Замечания Линия регрессии проходит через точку Мы предполагаем, что среди Xi есть разные, тогда X 0. В противном случае, оценок по методу наименьших квадратов не существует.

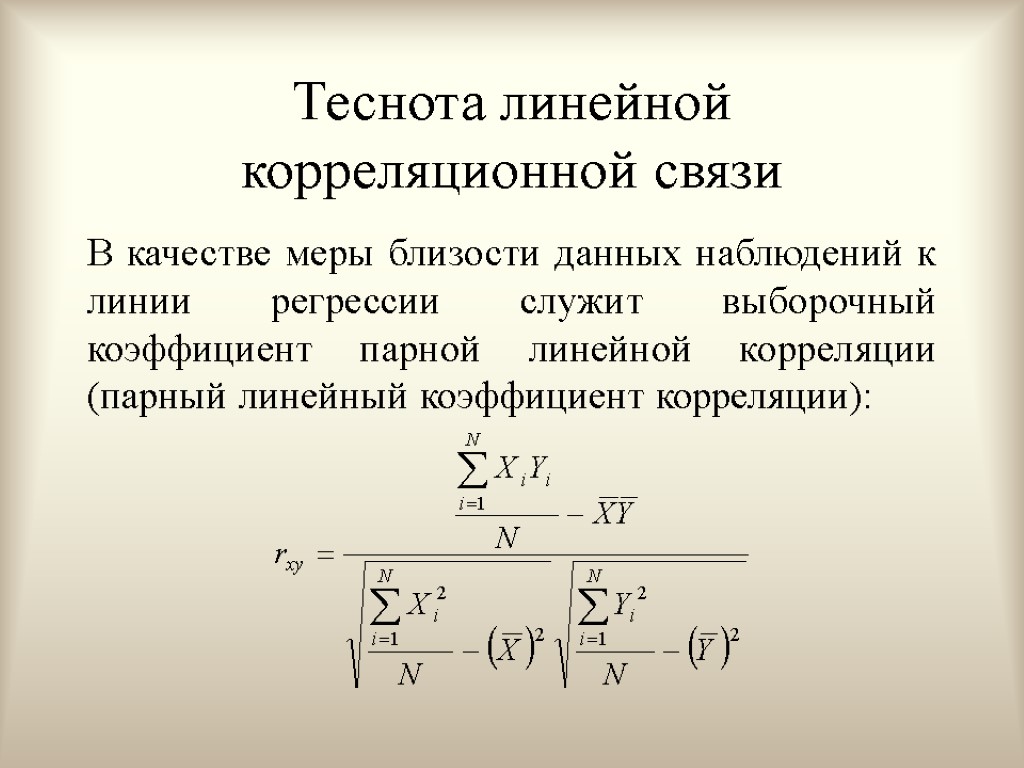

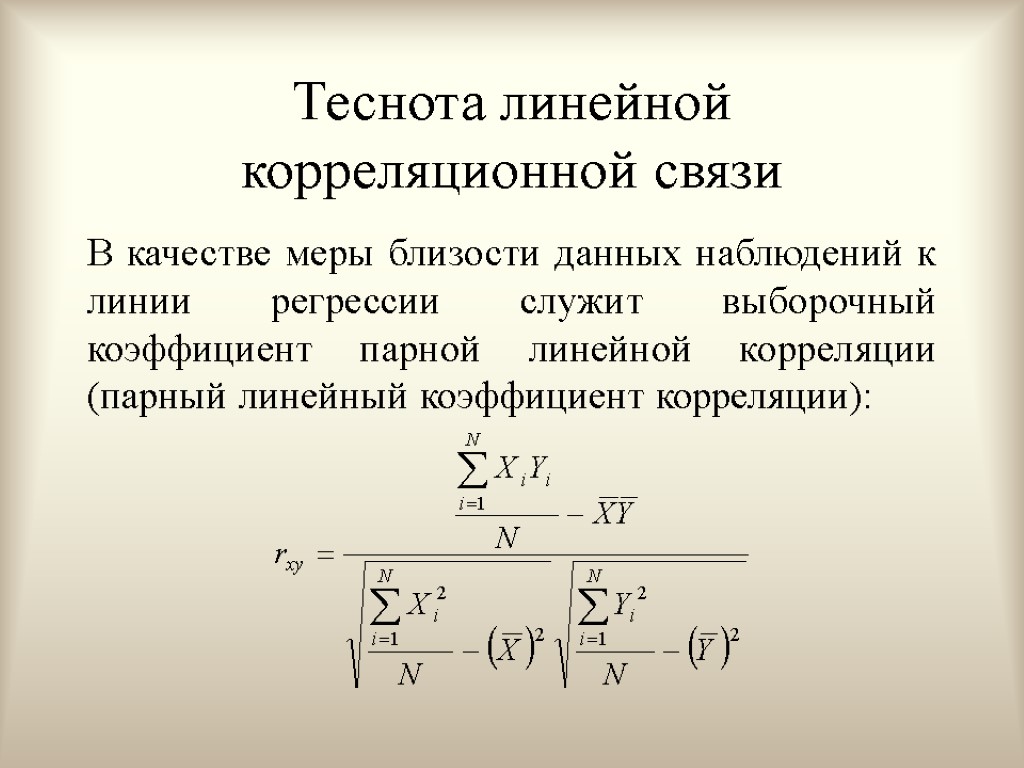

Теснота линейной корреляционной связи В качестве меры близости данных наблюдений к линии регрессии служит выборочный коэффициент парной линейной корреляции (парный линейный коэффициент корреляции):

Теснота линейной корреляционной связи В качестве меры близости данных наблюдений к линии регрессии служит выборочный коэффициент парной линейной корреляции (парный линейный коэффициент корреляции):

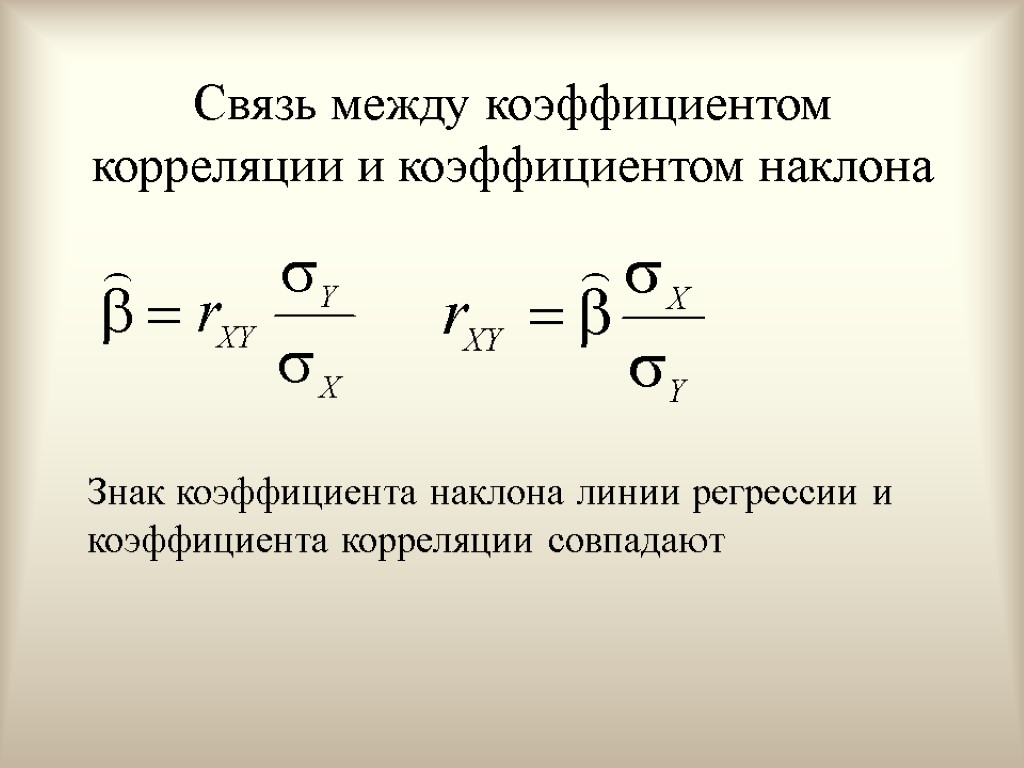

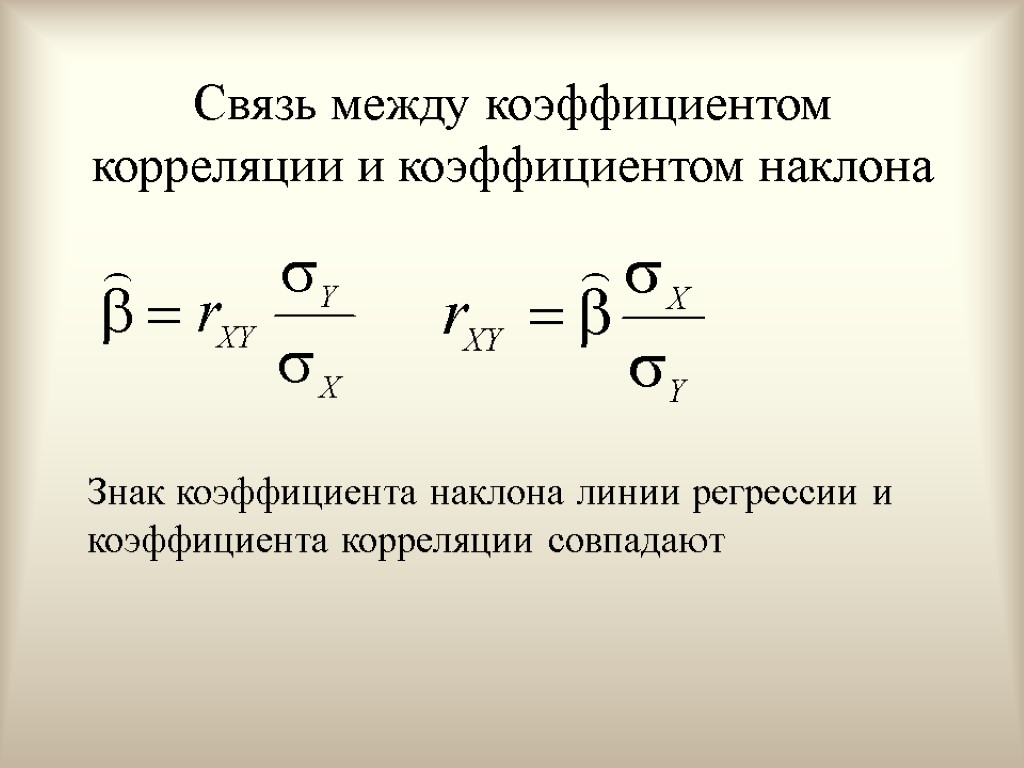

Связь между коэффициентом корреляции и коэффициентом наклона Знак коэффициента наклона линии регрессии и коэффициента корреляции совпадают

Связь между коэффициентом корреляции и коэффициентом наклона Знак коэффициента наклона линии регрессии и коэффициента корреляции совпадают

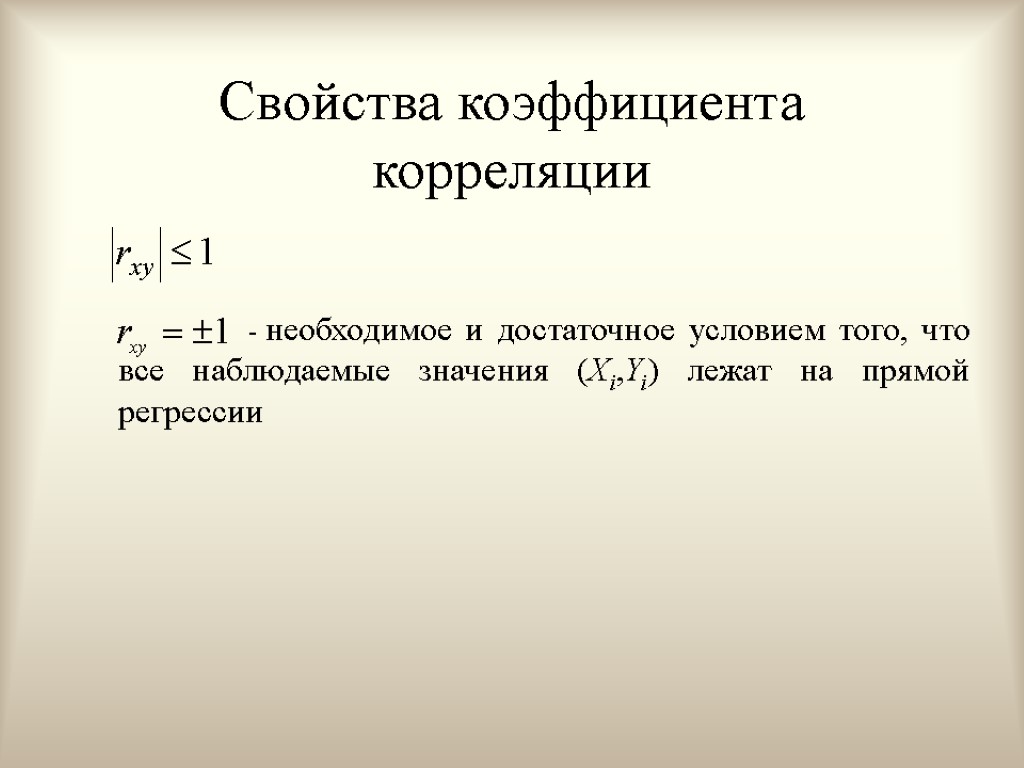

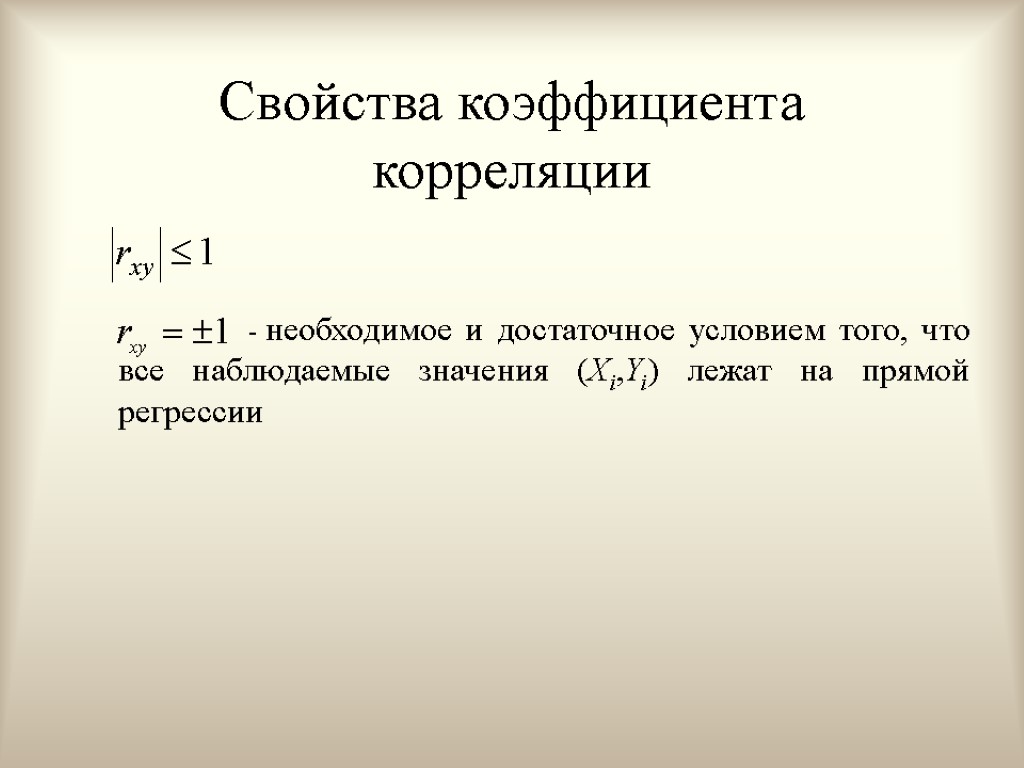

Свойства коэффициента корреляции Если - необходимое и достаточное условием того, что все наблюдаемые значения (Xi,Yi) лежат на прямой регрессии

Свойства коэффициента корреляции Если - необходимое и достаточное условием того, что все наблюдаемые значения (Xi,Yi) лежат на прямой регрессии

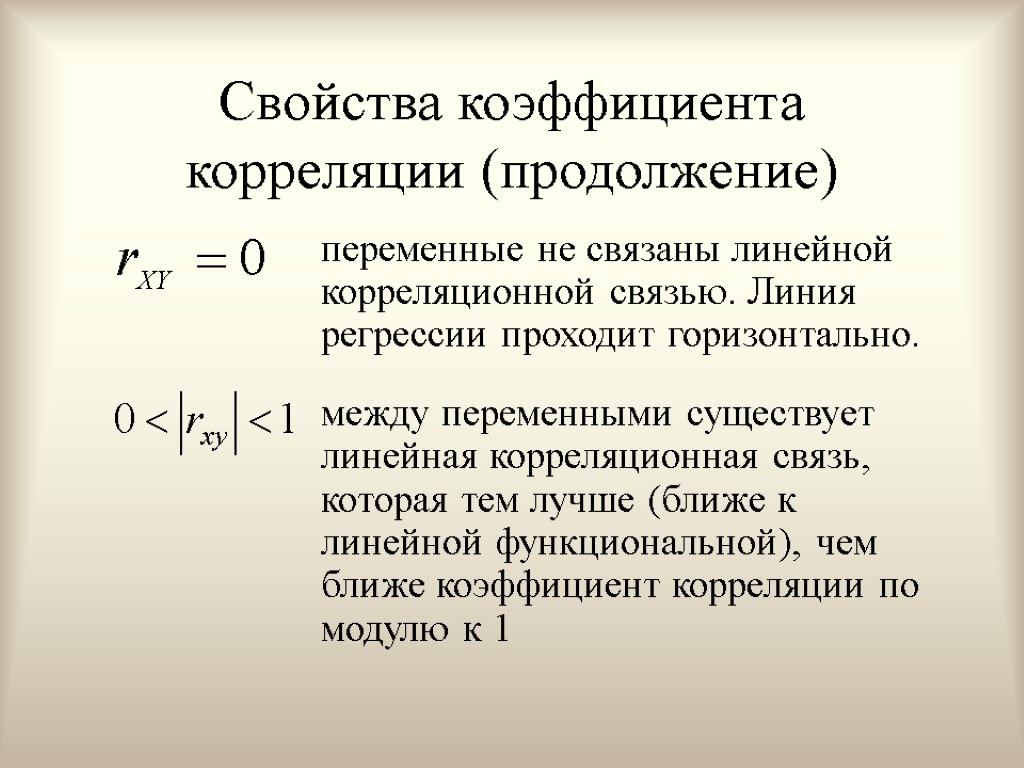

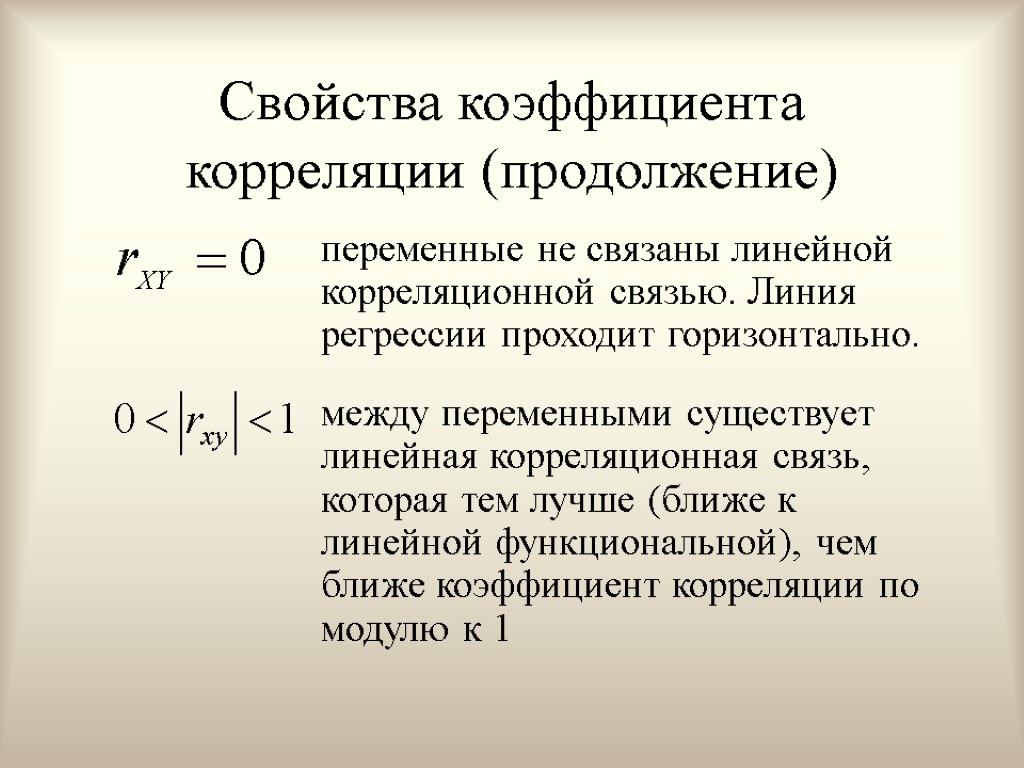

Свойства коэффициента корреляции (продолжение) переменные не связаны линейной корреляционной связью. Линия регрессии проходит горизонтально. между переменными существует линейная корреляционная связь, которая тем лучше (ближе к линейной функциональной), чем ближе коэффициент корреляции по модулю к 1

Свойства коэффициента корреляции (продолжение) переменные не связаны линейной корреляционной связью. Линия регрессии проходит горизонтально. между переменными существует линейная корреляционная связь, которая тем лучше (ближе к линейной функциональной), чем ближе коэффициент корреляции по модулю к 1

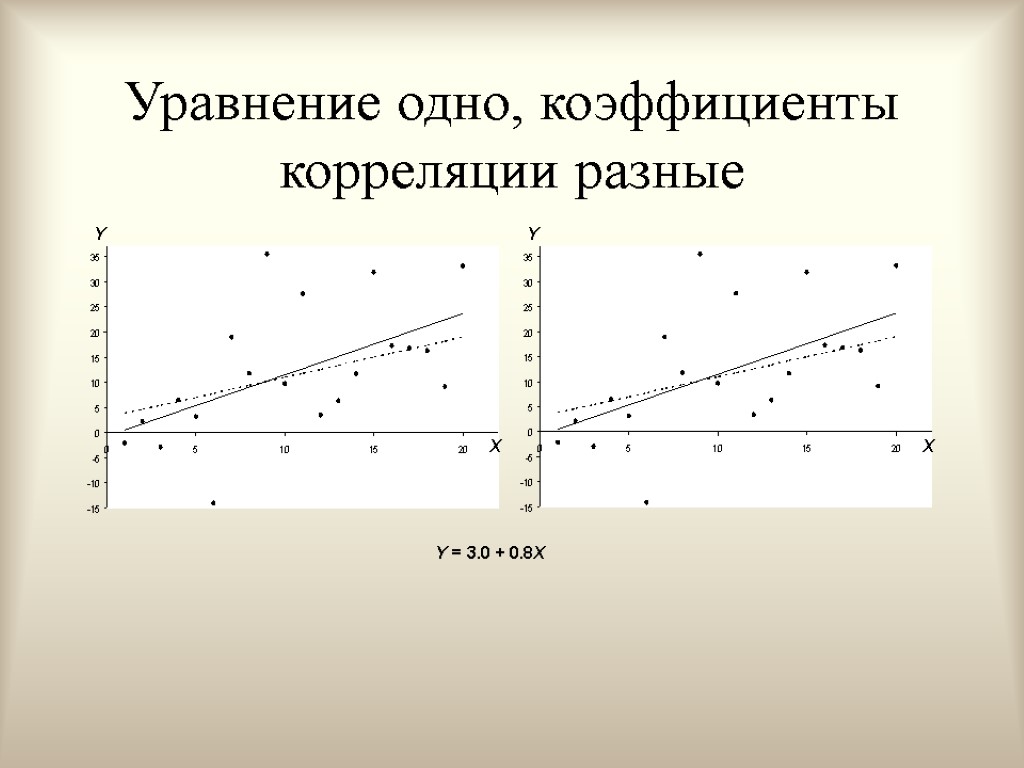

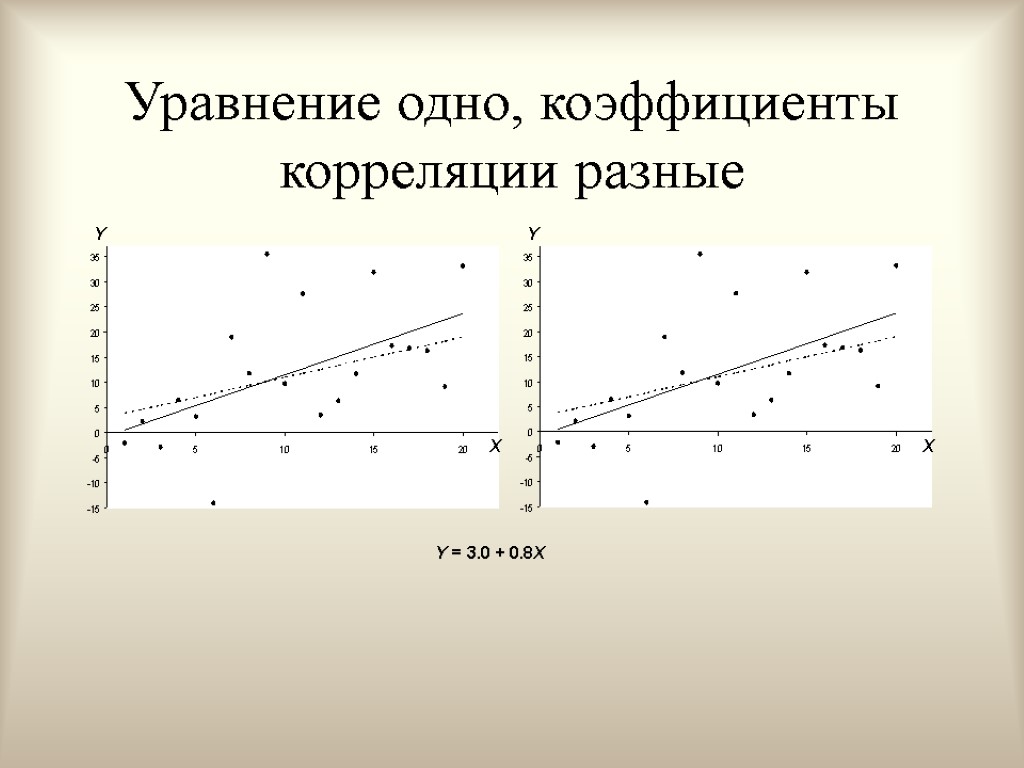

Уравнение одно, коэффициенты корреляции разные

Уравнение одно, коэффициенты корреляции разные

Вопросы для самопроверки Что такое функциональная зависимость между переменными. Что такое статистическая зависимость. Что такое корреляционная зависимость. Дайте определение независимых переменных. Что такое линия регрессии. Какова основная идея метода наименьших квадратов. Какие меры близости точек к линии регрессии вы знаете. Почему мы называем расчетные коэффициенты линии регрессии «статистическими оценками». Как выбрать функциональную форму линии регрессии. Форы записи МНК коэффициента наклона ергрессионной прямой. В чем заключается экономический смысл случайной составляющей регрессионного уравнения. Для чего нужен коэффициент корреляции. Как связан коэффициент корреляции и коэффициент наклона линии регрессии. Перечислите свойства коэффициента корреляции. В каком случае линии регрессии по методу наименьших квадратов не существует.

Вопросы для самопроверки Что такое функциональная зависимость между переменными. Что такое статистическая зависимость. Что такое корреляционная зависимость. Дайте определение независимых переменных. Что такое линия регрессии. Какова основная идея метода наименьших квадратов. Какие меры близости точек к линии регрессии вы знаете. Почему мы называем расчетные коэффициенты линии регрессии «статистическими оценками». Как выбрать функциональную форму линии регрессии. Форы записи МНК коэффициента наклона ергрессионной прямой. В чем заключается экономический смысл случайной составляющей регрессионного уравнения. Для чего нужен коэффициент корреляции. Как связан коэффициент корреляции и коэффициент наклона линии регрессии. Перечислите свойства коэффициента корреляции. В каком случае линии регрессии по методу наименьших квадратов не существует.

Множественная линейная регрессионная модель

Множественная линейная регрессионная модель

Темы лекции Множественная линейная регрессионная модель Метод наименьших квадратов оценки коэффициентов МЛРМ. Матричное выражение МНК-оценок коэффициентов МЛРМ.

Темы лекции Множественная линейная регрессионная модель Метод наименьших квадратов оценки коэффициентов МЛРМ. Матричное выражение МНК-оценок коэффициентов МЛРМ.

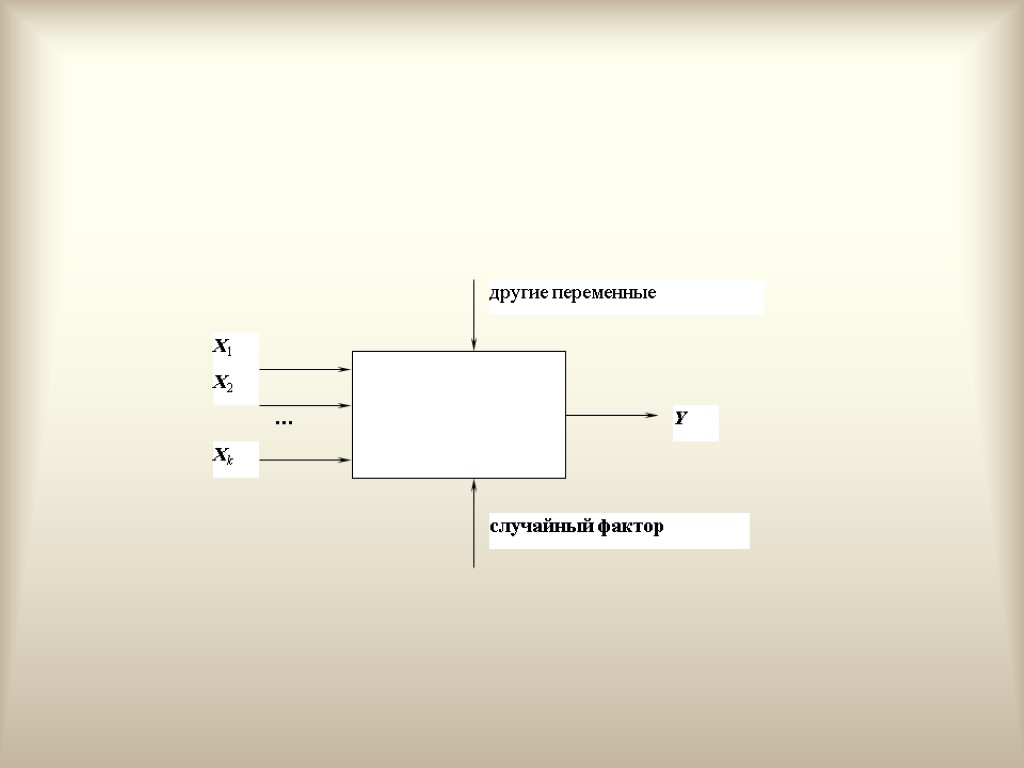

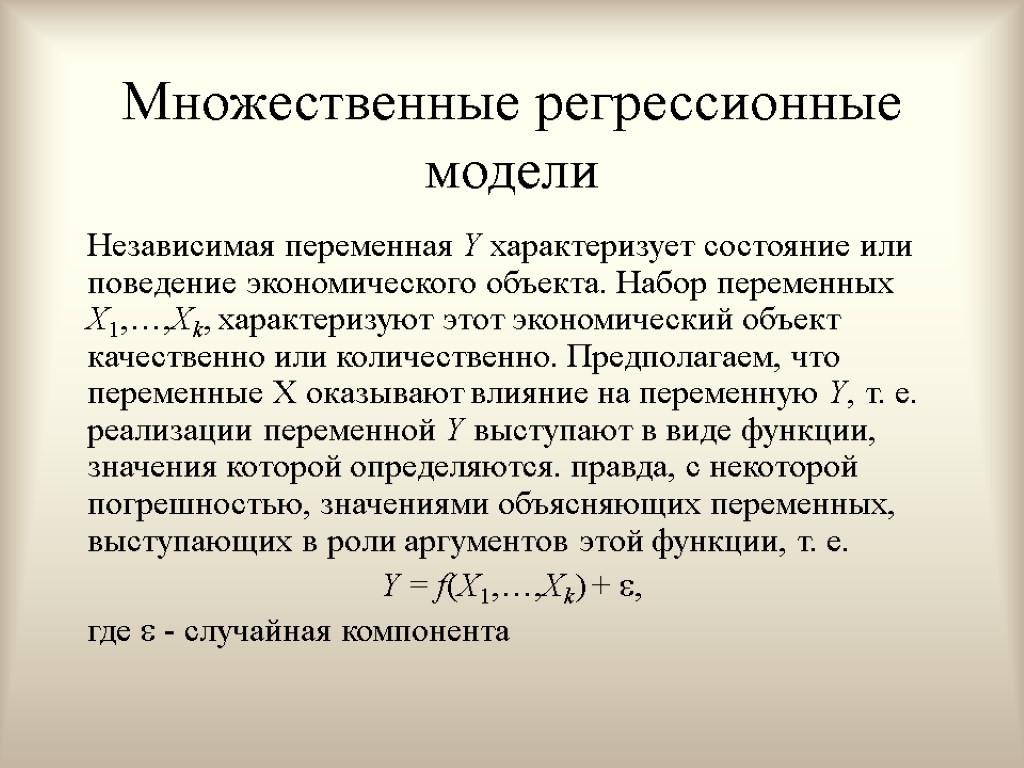

Множественные регрессионные модели Независимая переменная Y характеризует состояние или поведение экономического объекта. Набор переменных X1,…,Xk, характеризуют этот экономический объект качественно или количественно. Предполагаем, что переменные X оказывают влияние на переменную Y, т. е. реализации переменной Y выступают в виде функции, значения которой определяются. правда, с некоторой погрешностью, значениями объясняющих переменных, выступающих в роли аргументов этой функции, т. е. Y = f(X1,…,Xk) + , где - случайная компонента

Множественные регрессионные модели Независимая переменная Y характеризует состояние или поведение экономического объекта. Набор переменных X1,…,Xk, характеризуют этот экономический объект качественно или количественно. Предполагаем, что переменные X оказывают влияние на переменную Y, т. е. реализации переменной Y выступают в виде функции, значения которой определяются. правда, с некоторой погрешностью, значениями объясняющих переменных, выступающих в роли аргументов этой функции, т. е. Y = f(X1,…,Xk) + , где - случайная компонента

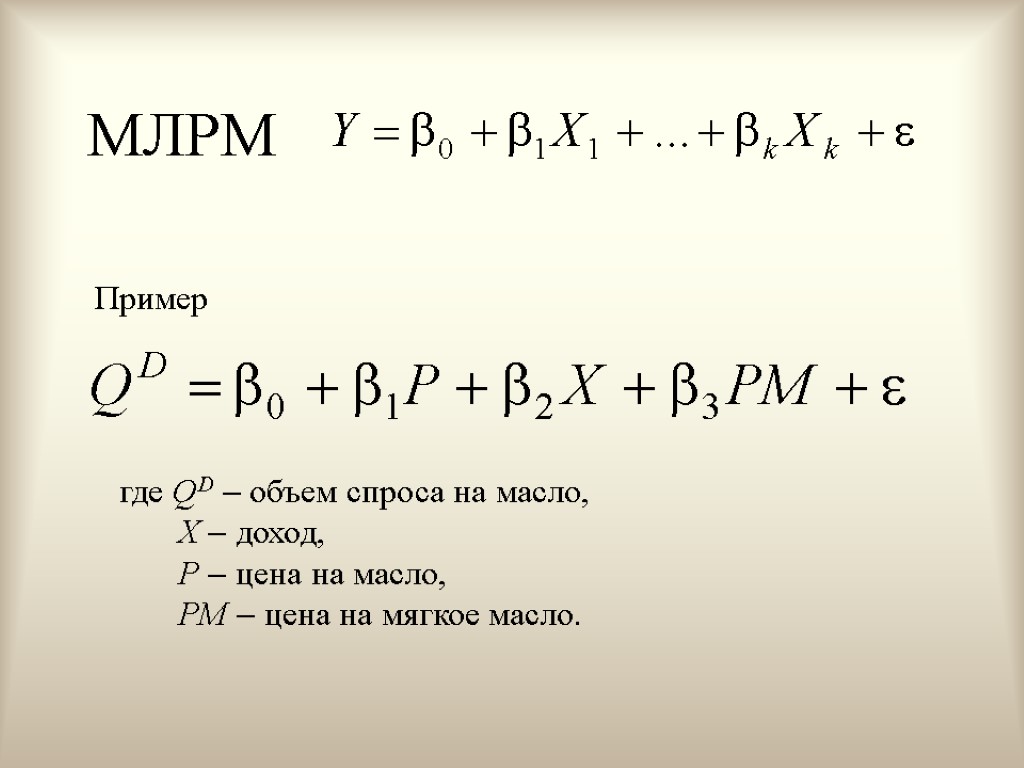

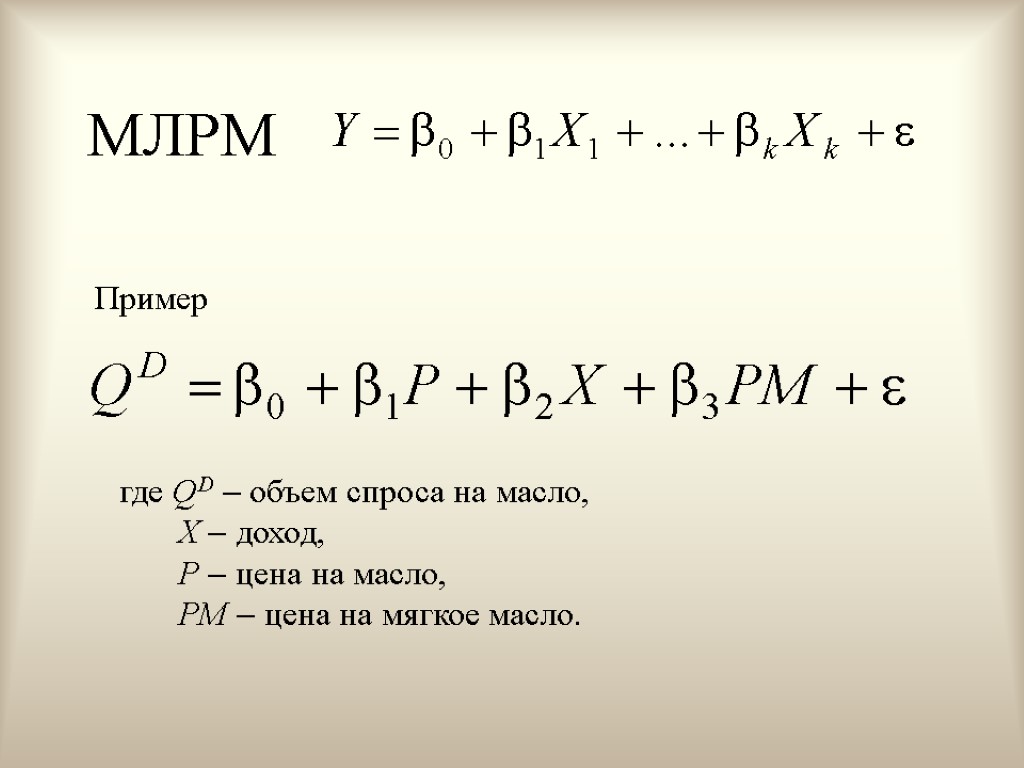

МЛРМ где QD объем спроса на масло, Х доход, P цена на масло, PM цена на мягкое масло. Пример

МЛРМ где QD объем спроса на масло, Х доход, P цена на масло, PM цена на мягкое масло. Пример

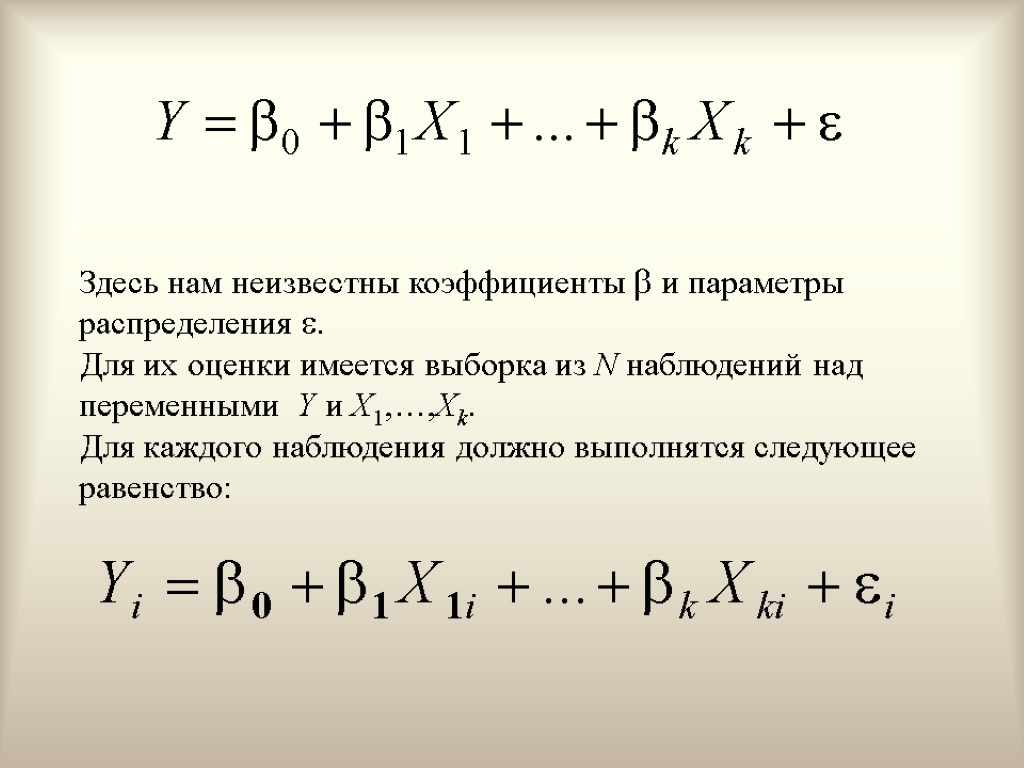

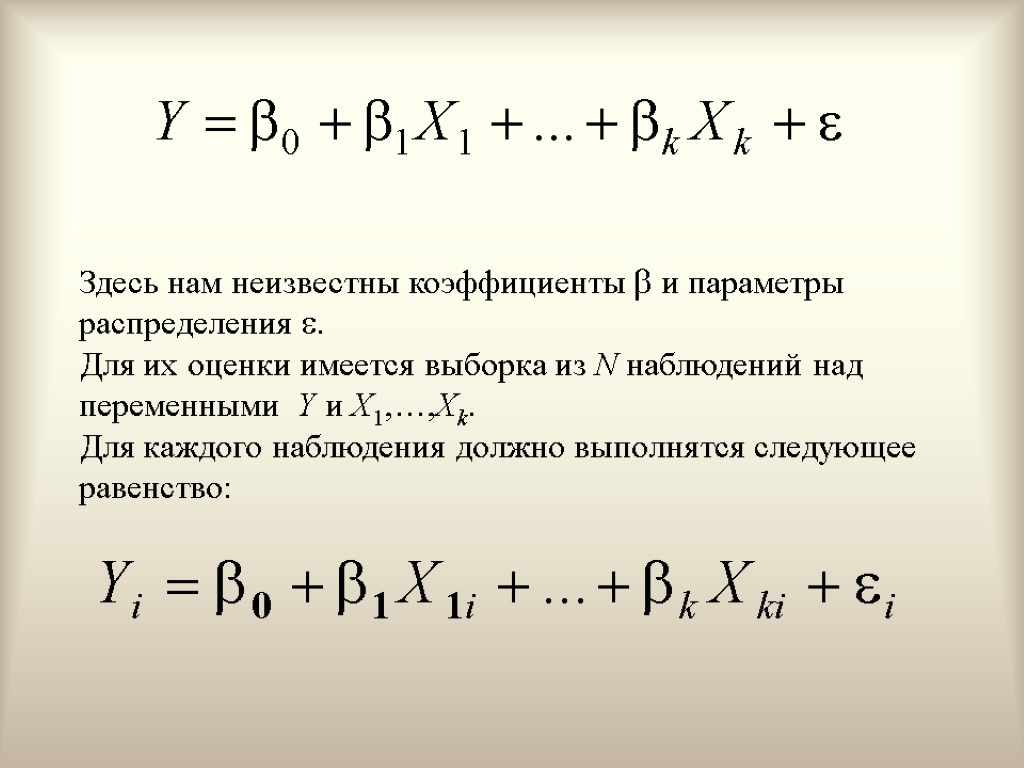

Здесь нам неизвестны коэффициенты и параметры распределения . Для их оценки имеется выборка из N наблюдений над переменными Y и X1,…,Xk. Для каждого наблюдения должно выполнятся следующее равенство:

Здесь нам неизвестны коэффициенты и параметры распределения . Для их оценки имеется выборка из N наблюдений над переменными Y и X1,…,Xk. Для каждого наблюдения должно выполнятся следующее равенство:

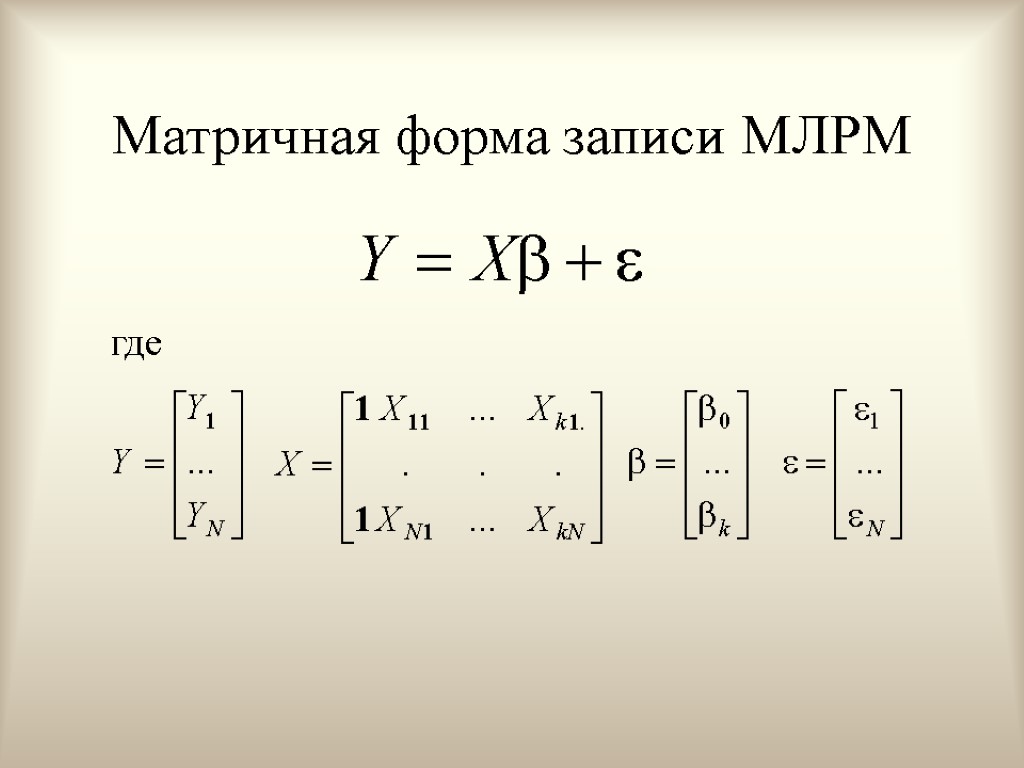

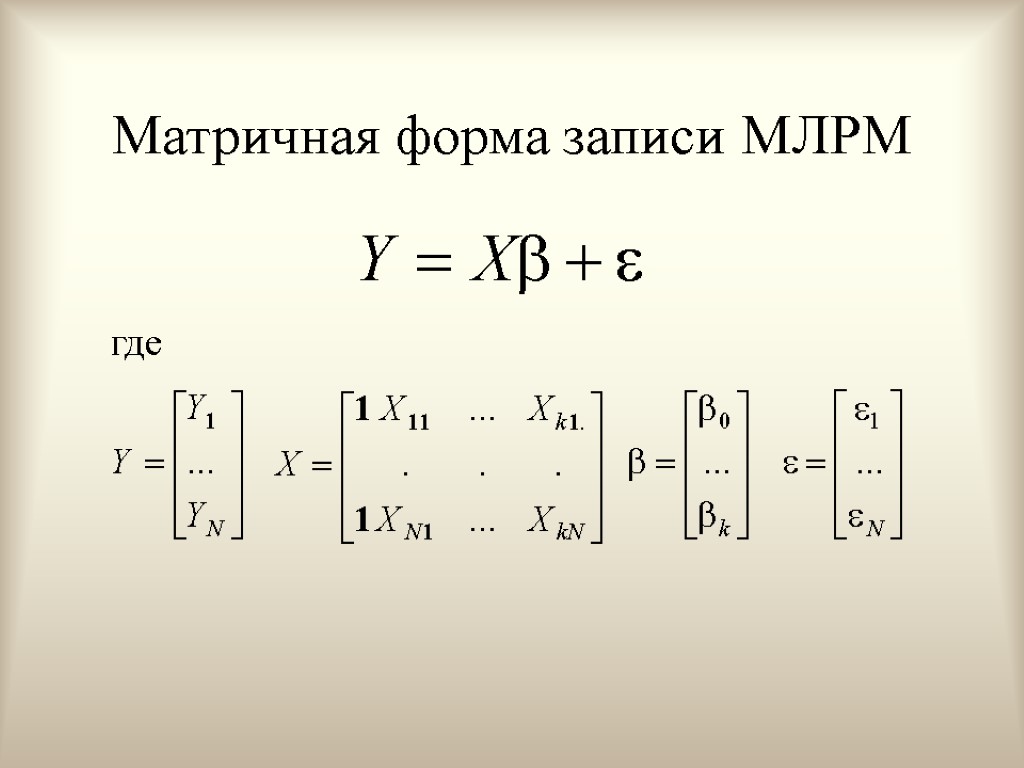

Матричная форма записи МЛРМ где

Матричная форма записи МЛРМ где

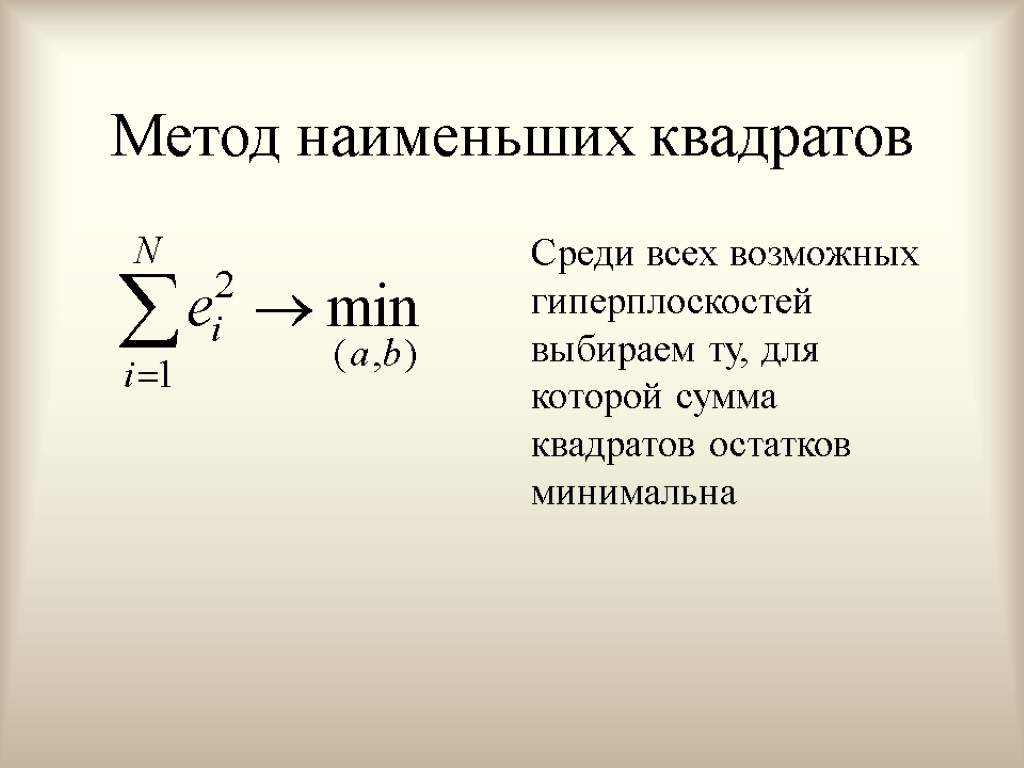

Метод наименьших квадратов Среди всех возможных гиперплоскостей выбираем ту, для которой сумма квадратов остатков минимальна

Метод наименьших квадратов Среди всех возможных гиперплоскостей выбираем ту, для которой сумма квадратов остатков минимальна

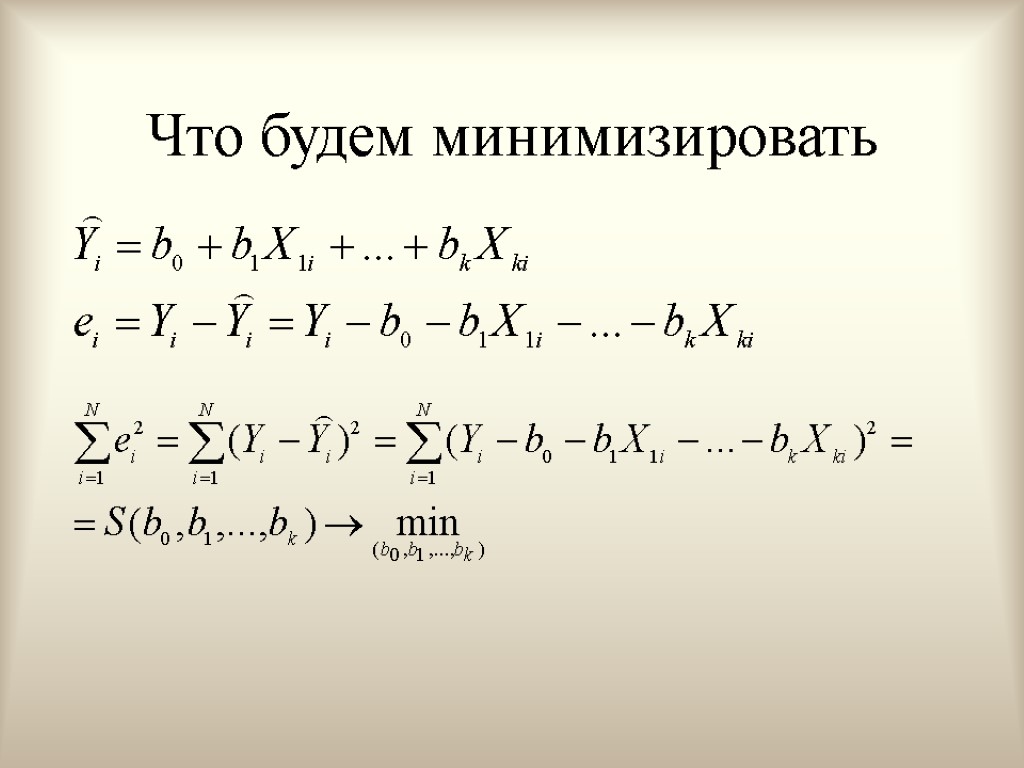

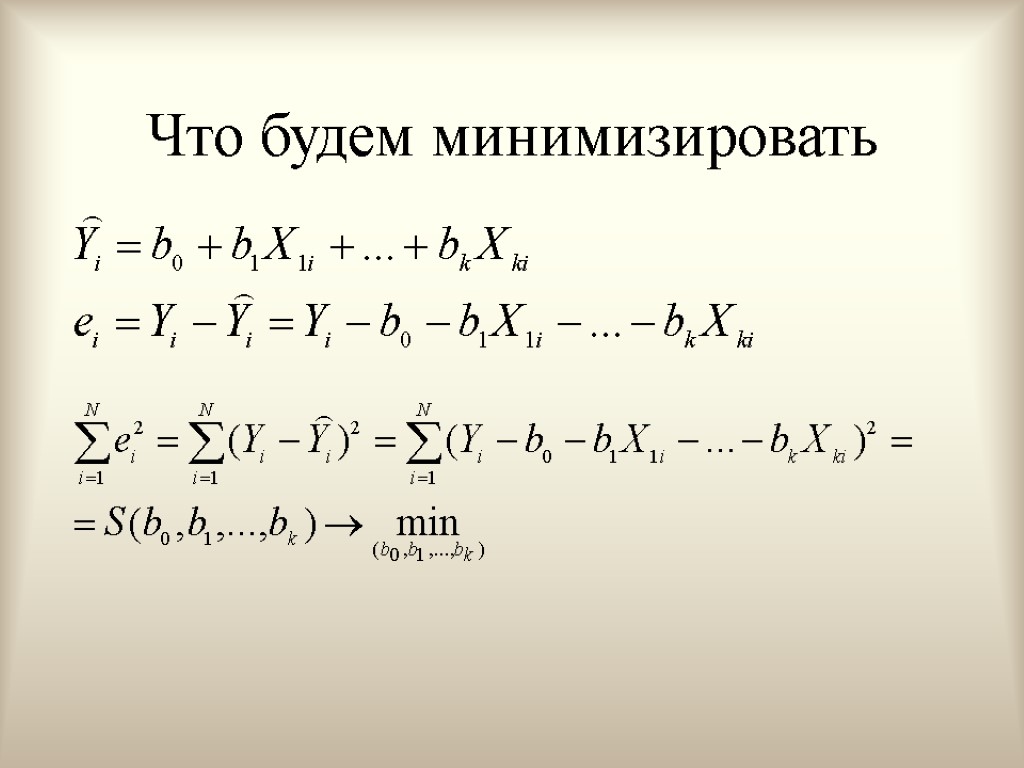

Что будем минимизировать

Что будем минимизировать

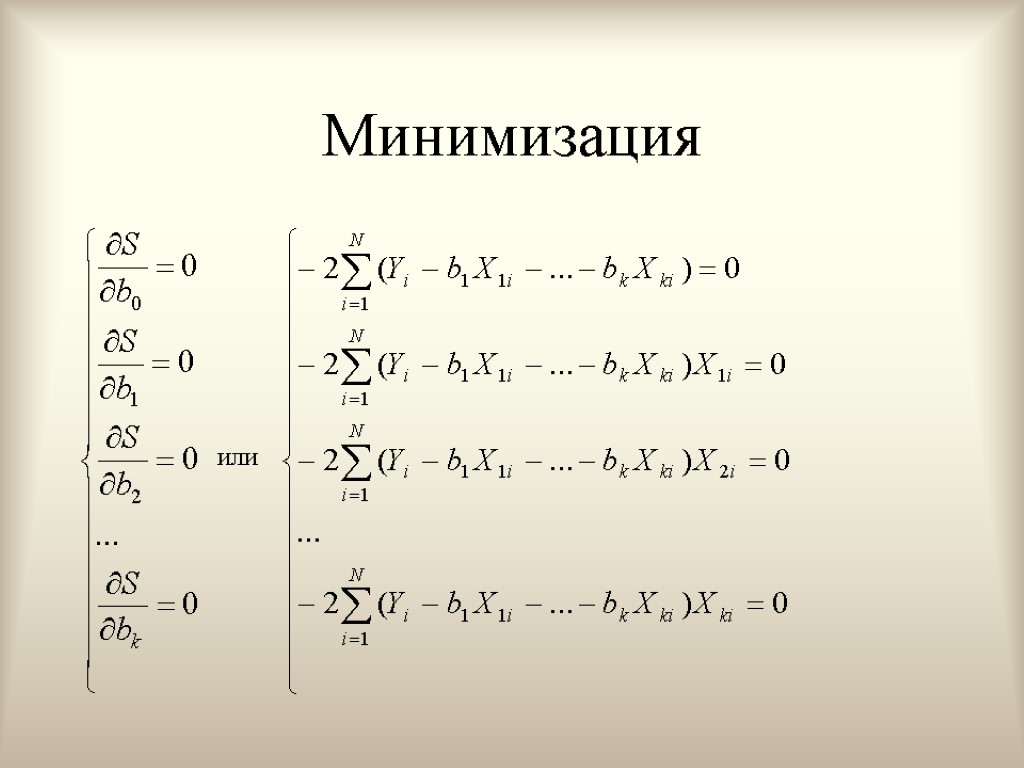

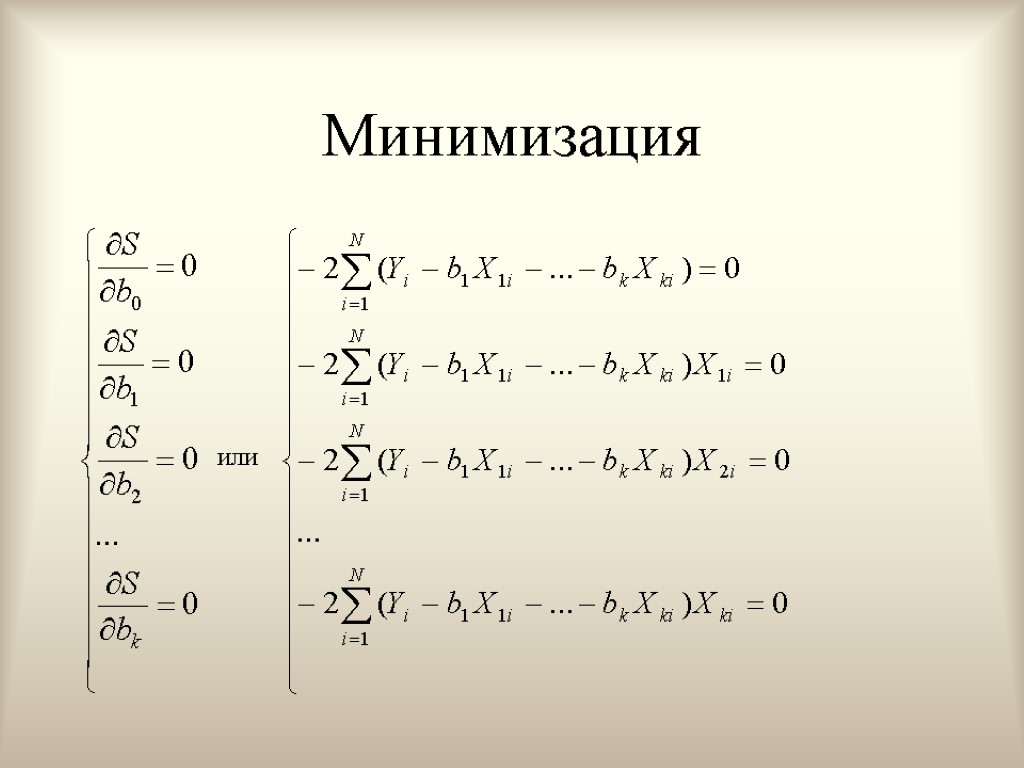

Минимизация или

Минимизация или

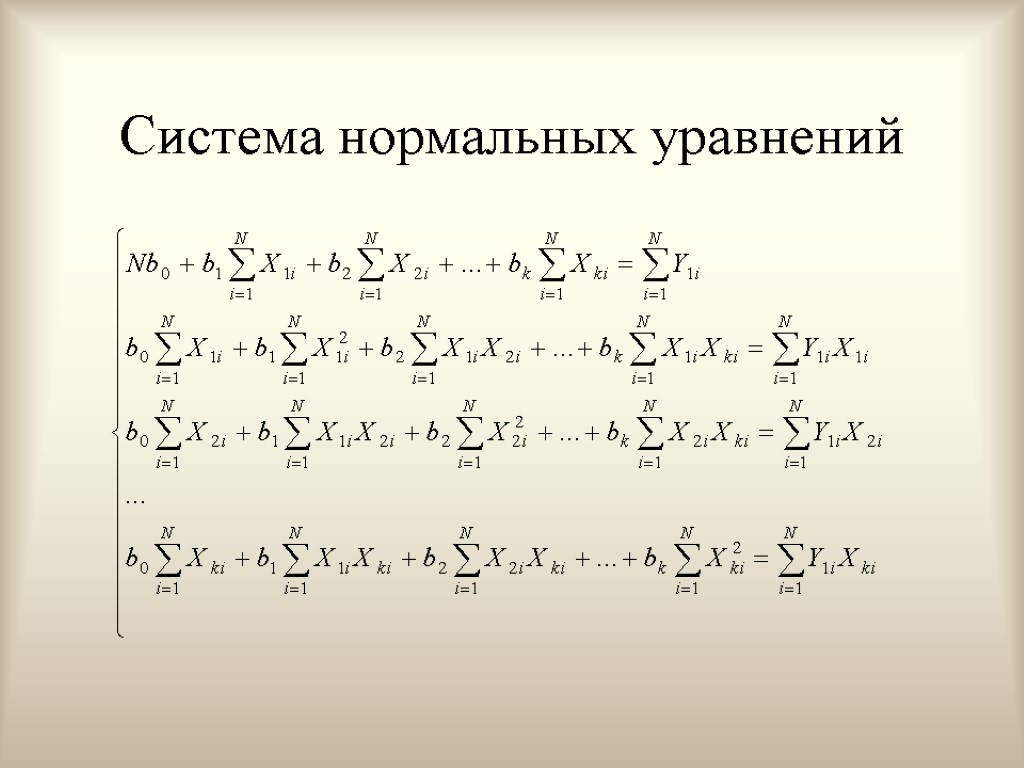

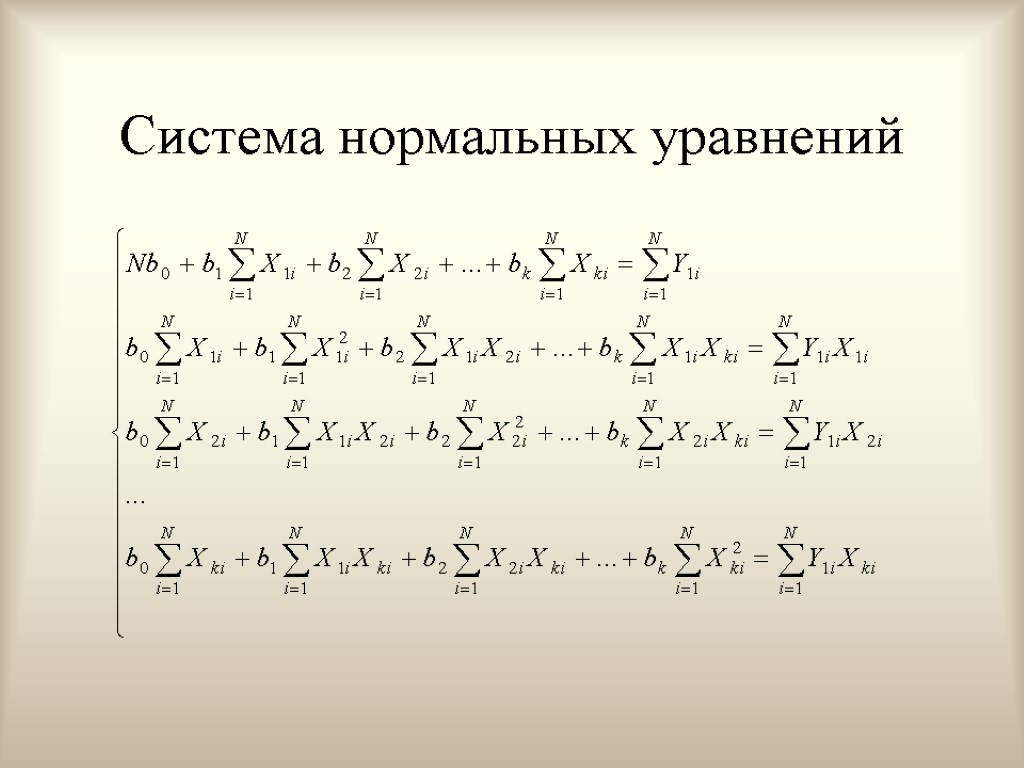

Система нормальных уравнений

Система нормальных уравнений

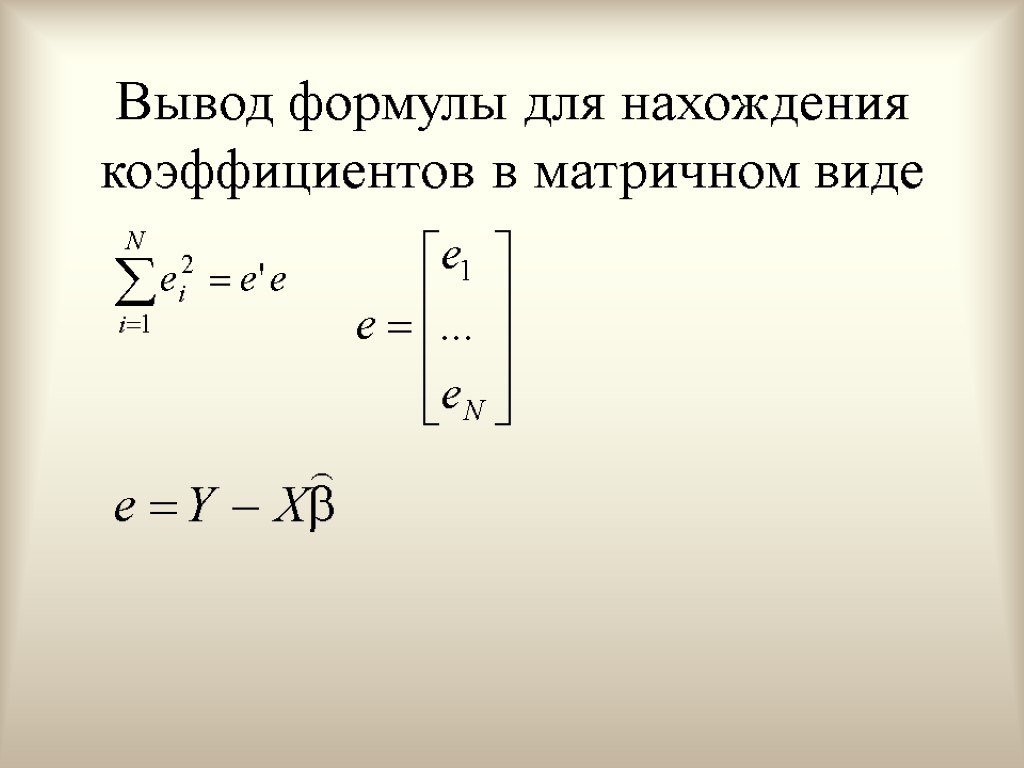

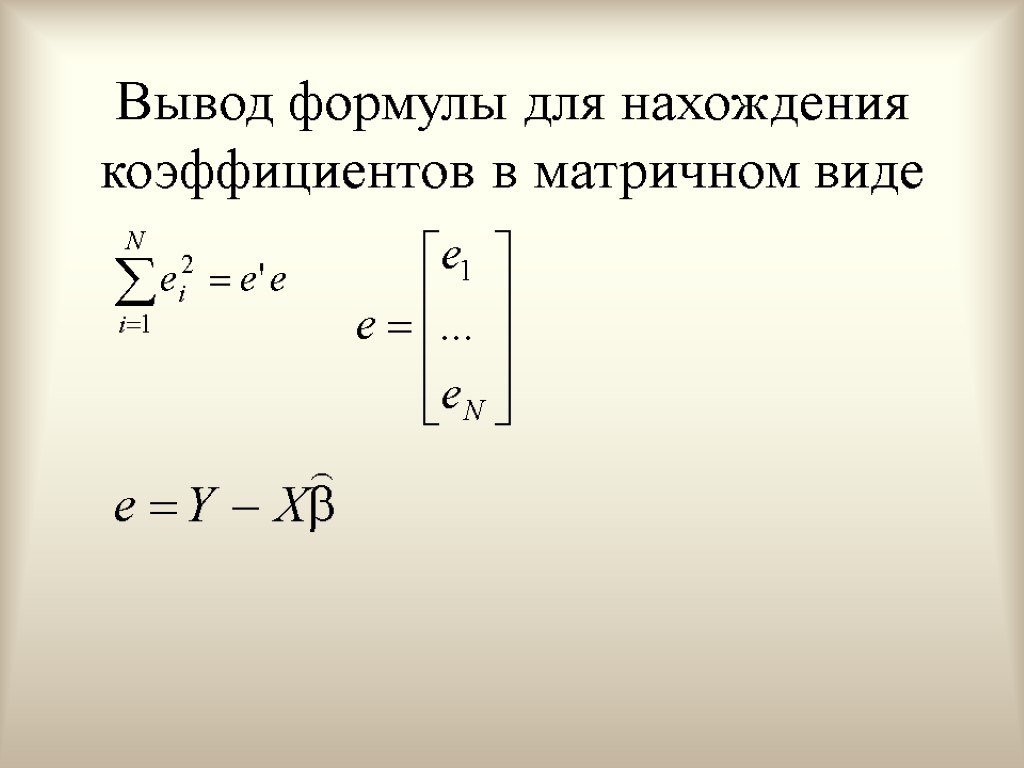

Вывод формулы для нахождения коэффициентов в матричном виде

Вывод формулы для нахождения коэффициентов в матричном виде

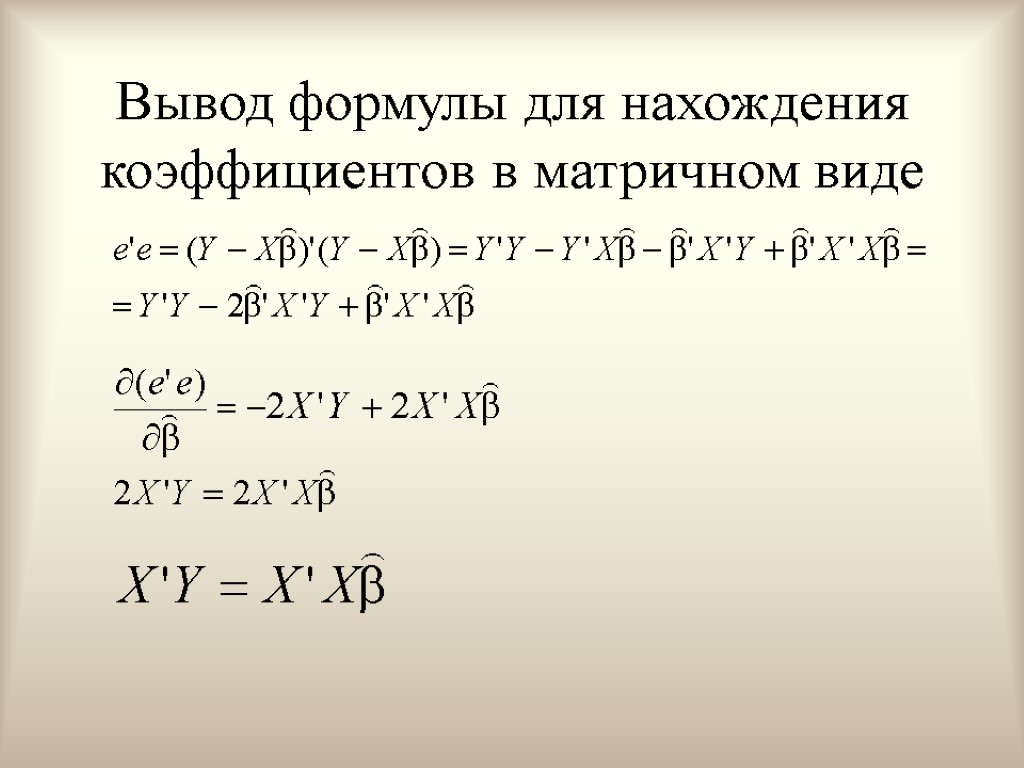

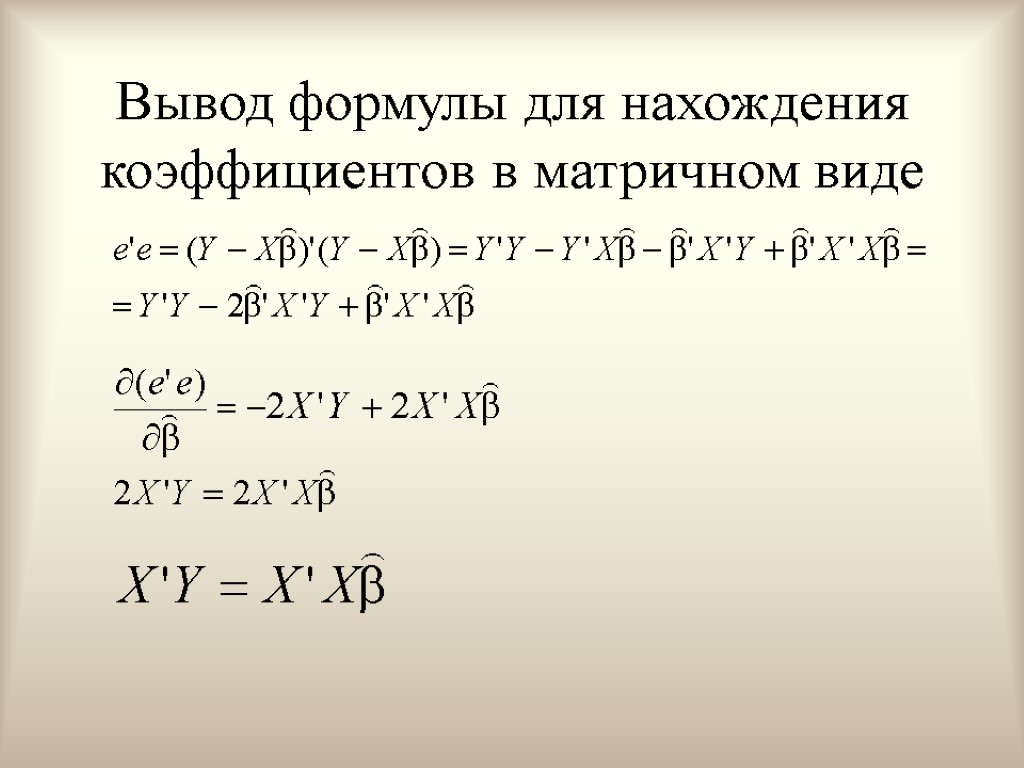

Вывод формулы для нахождения коэффициентов в матричном виде

Вывод формулы для нахождения коэффициентов в матричном виде

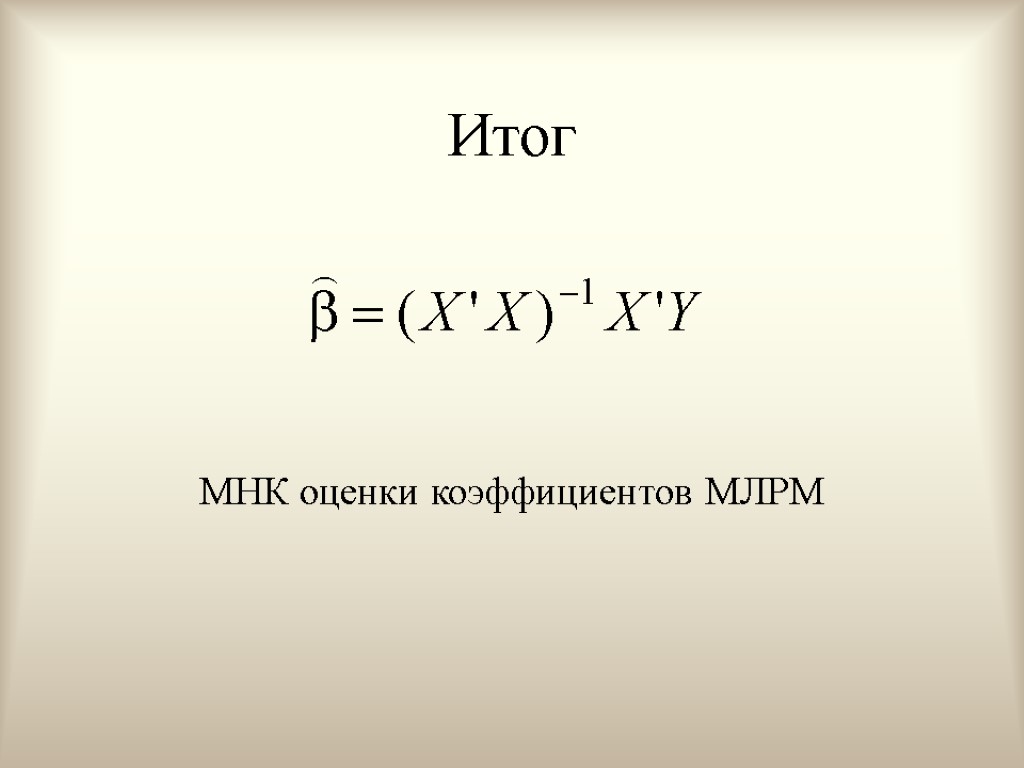

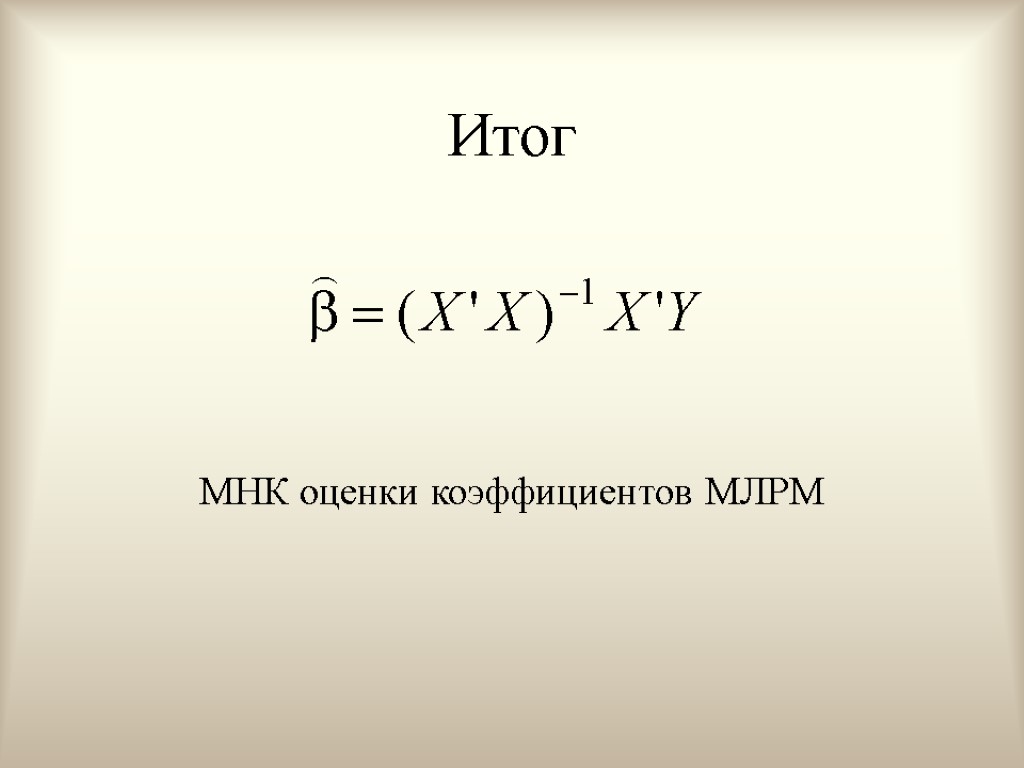

Итог МНК оценки коэффициентов МЛРМ

Итог МНК оценки коэффициентов МЛРМ

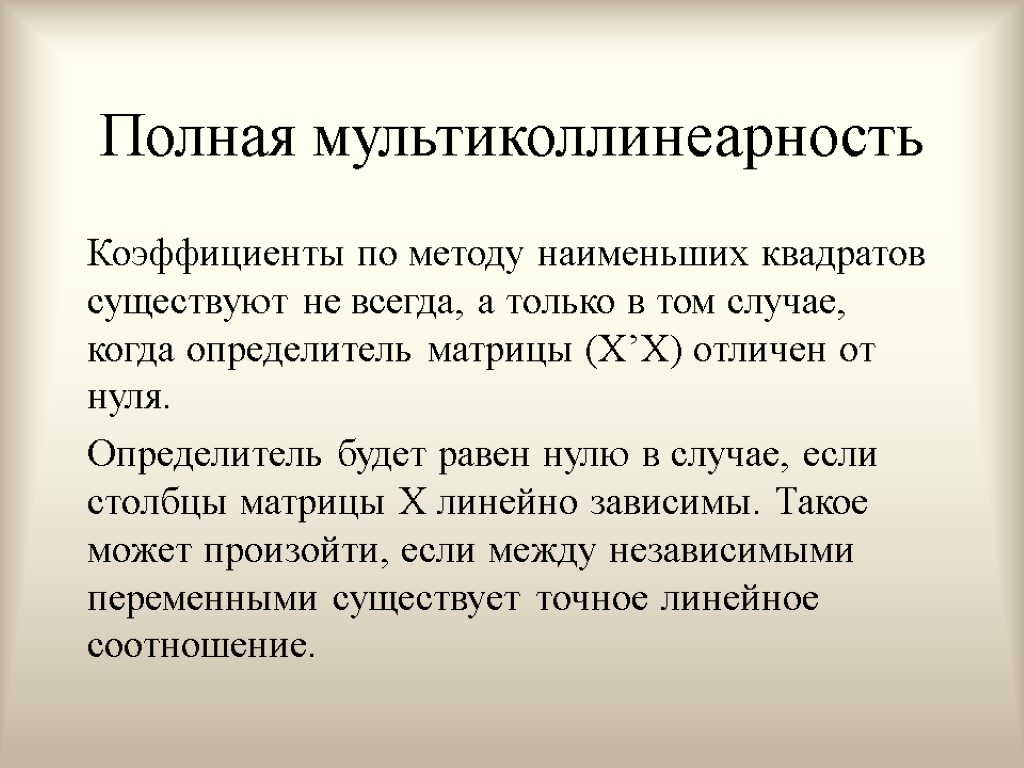

Полная мультиколлинеарность Коэффициенты по методу наименьших квадратов существуют не всегда, а только в том случае, когда определитель матрицы (X’X) отличен от нуля. Определитель будет равен нулю в случае, если столбцы матрицы X линейно зависимы. Такое может произойти, если между независимыми переменными существует точное линейное соотношение.

Полная мультиколлинеарность Коэффициенты по методу наименьших квадратов существуют не всегда, а только в том случае, когда определитель матрицы (X’X) отличен от нуля. Определитель будет равен нулю в случае, если столбцы матрицы X линейно зависимы. Такое может произойти, если между независимыми переменными существует точное линейное соотношение.

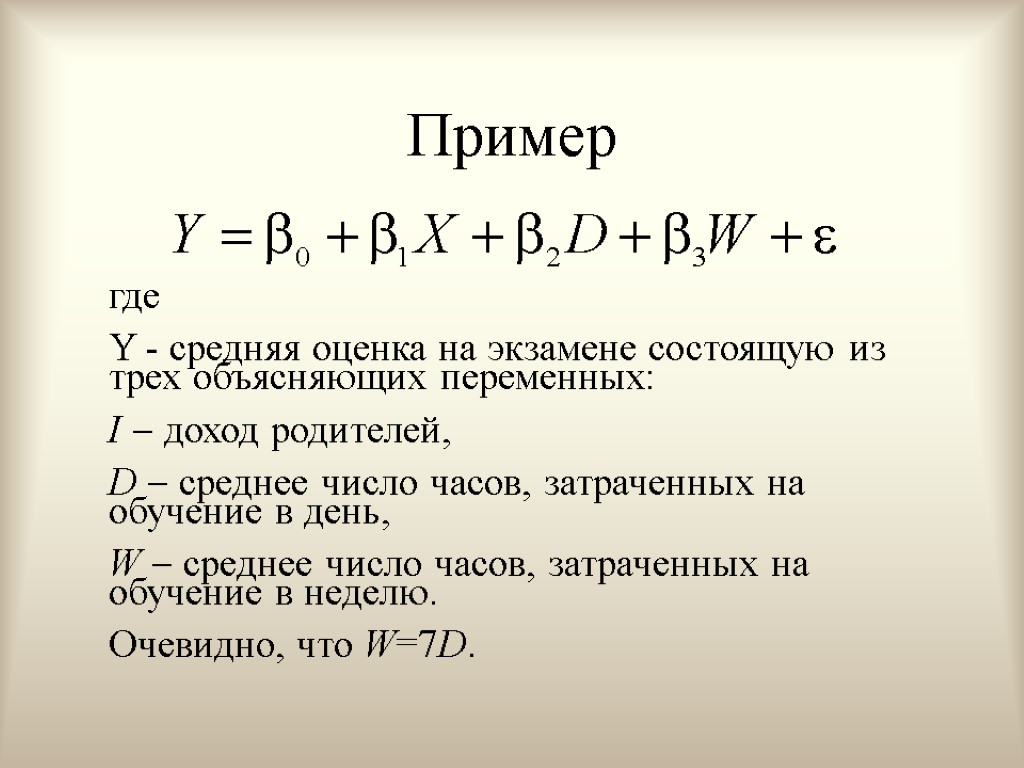

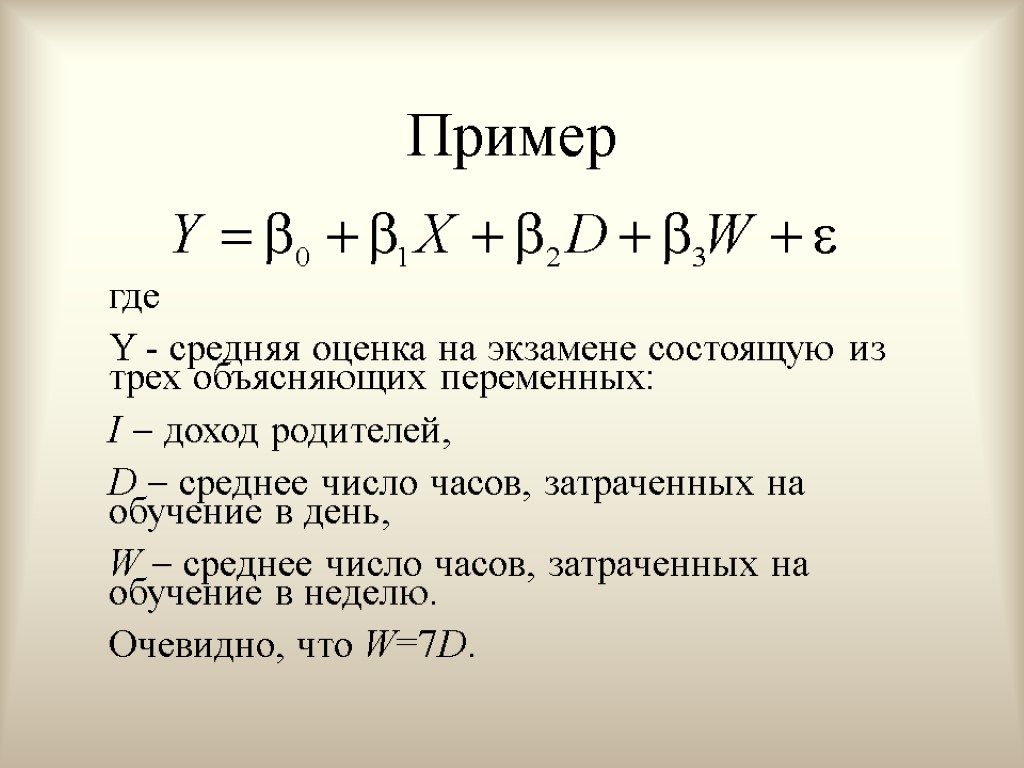

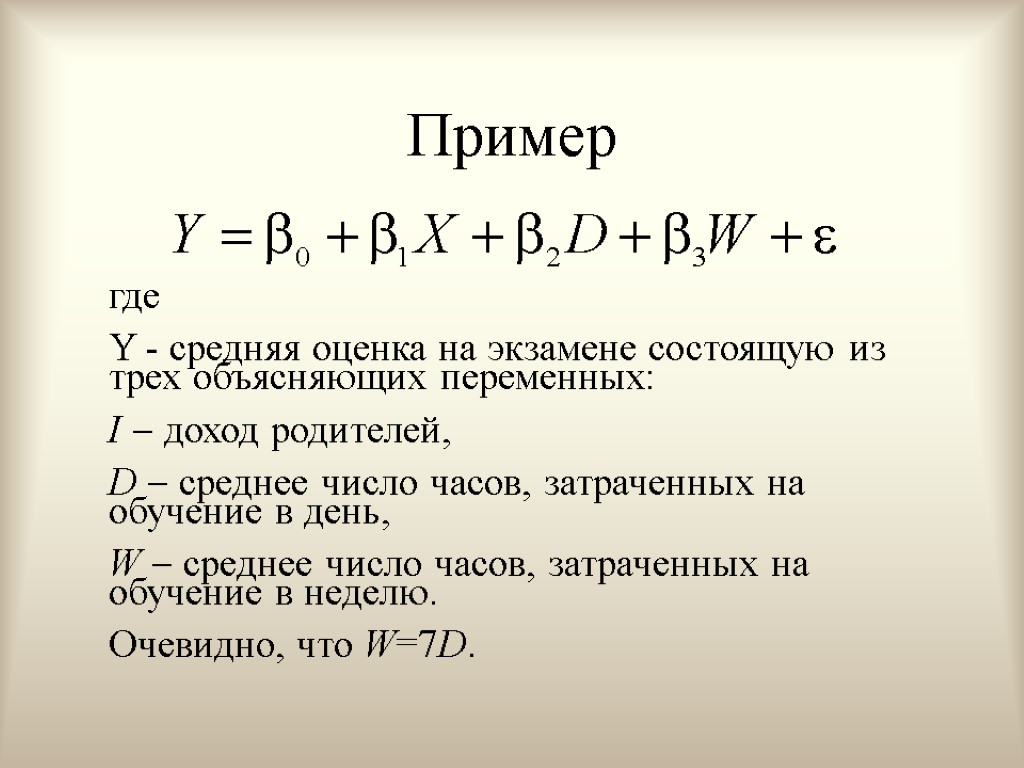

Пример где Y - средняя оценка на экзамене состоящую из трех объясняющих переменных: I доход родителей, D среднее число часов, затраченных на обучение в день, W среднее число часов, затраченных на обучение в неделю. Очевидно, что W=7D.

Пример где Y - средняя оценка на экзамене состоящую из трех объясняющих переменных: I доход родителей, D среднее число часов, затраченных на обучение в день, W среднее число часов, затраченных на обучение в неделю. Очевидно, что W=7D.

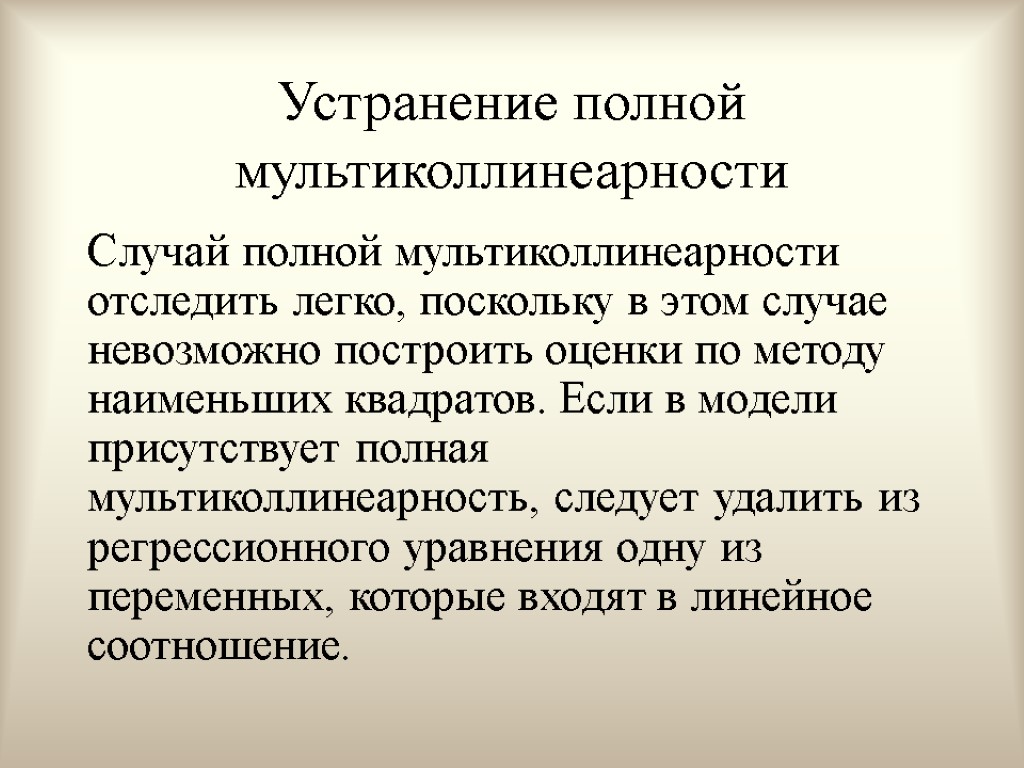

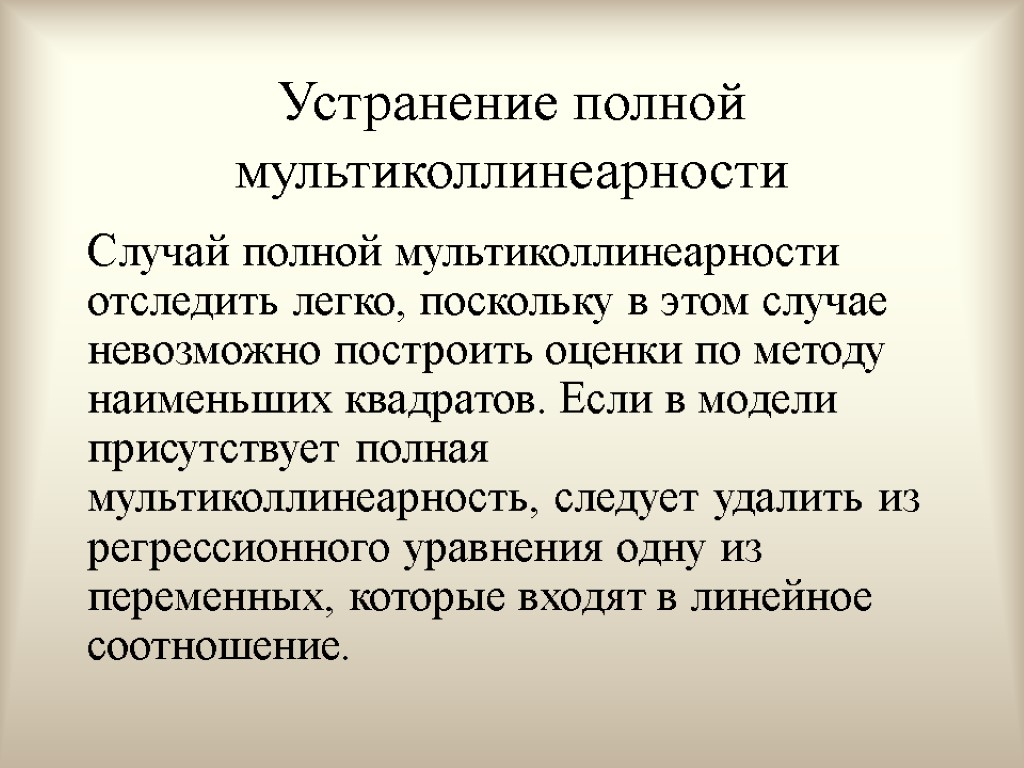

Устранение полной мультиколлинеарности Случай полной мультиколлинеарности отследить легко, поскольку в этом случае невозможно построить оценки по методу наименьших квадратов. Если в модели присутствует полная мультиколлинеарность, следует удалить из регрессионного уравнения одну из переменных, которые входят в линейное соотношение.

Устранение полной мультиколлинеарности Случай полной мультиколлинеарности отследить легко, поскольку в этом случае невозможно построить оценки по методу наименьших квадратов. Если в модели присутствует полная мультиколлинеарность, следует удалить из регрессионного уравнения одну из переменных, которые входят в линейное соотношение.

Вопросы для самопроверки Система нормальных уравнений для нахождения коэффициентов по МНК. В каком случае линии регрессии по методу наименьших квадратов не существует Приведите примет модели, в которой присутствует полная мультиколлинеарность. Укажите размерности матриц, участвующих в формуле МНК-коэффициентов. .Как устранить проблему полной мультиколлинеарности. Выведите систему нормальных уравнений. Выведите матричную формулу МНК коэффициентов. Приведите пример ситуации, когда линейной зависимости между объясняющими переменными нет, а коэффииценты МЛРМ не существуют. Как влияют выбросы на результаты оценивания. Как исследовать устойчивость результатов оценивания.

Вопросы для самопроверки Система нормальных уравнений для нахождения коэффициентов по МНК. В каком случае линии регрессии по методу наименьших квадратов не существует Приведите примет модели, в которой присутствует полная мультиколлинеарность. Укажите размерности матриц, участвующих в формуле МНК-коэффициентов. .Как устранить проблему полной мультиколлинеарности. Выведите систему нормальных уравнений. Выведите матричную формулу МНК коэффициентов. Приведите пример ситуации, когда линейной зависимости между объясняющими переменными нет, а коэффииценты МЛРМ не существуют. Как влияют выбросы на результаты оценивания. Как исследовать устойчивость результатов оценивания.

Тема 4. Оценка качества подгонки линии регрессии к имеющимся данным

Тема 4. Оценка качества подгонки линии регрессии к имеющимся данным

Темы лекции. Коэффициент детерминации. Свойства коэффициента детерминации. Скорректированный коэффициент детерминации. Свойства скорректированного коэффициента детерминации.

Темы лекции. Коэффициент детерминации. Свойства коэффициента детерминации. Скорректированный коэффициент детерминации. Свойства скорректированного коэффициента детерминации.

Насколько хорошо нам удалось объяснить изменение переменной Y нашей моделью. Разложим вариацию Y на две части. Насколько наше уравнение объясняет вариацию Y и какова часть Y, которую мы не можем объяснить нашим уравнением.

Насколько хорошо нам удалось объяснить изменение переменной Y нашей моделью. Разложим вариацию Y на две части. Насколько наше уравнение объясняет вариацию Y и какова часть Y, которую мы не можем объяснить нашим уравнением.

Разложение отклонения от среднего

Разложение отклонения от среднего

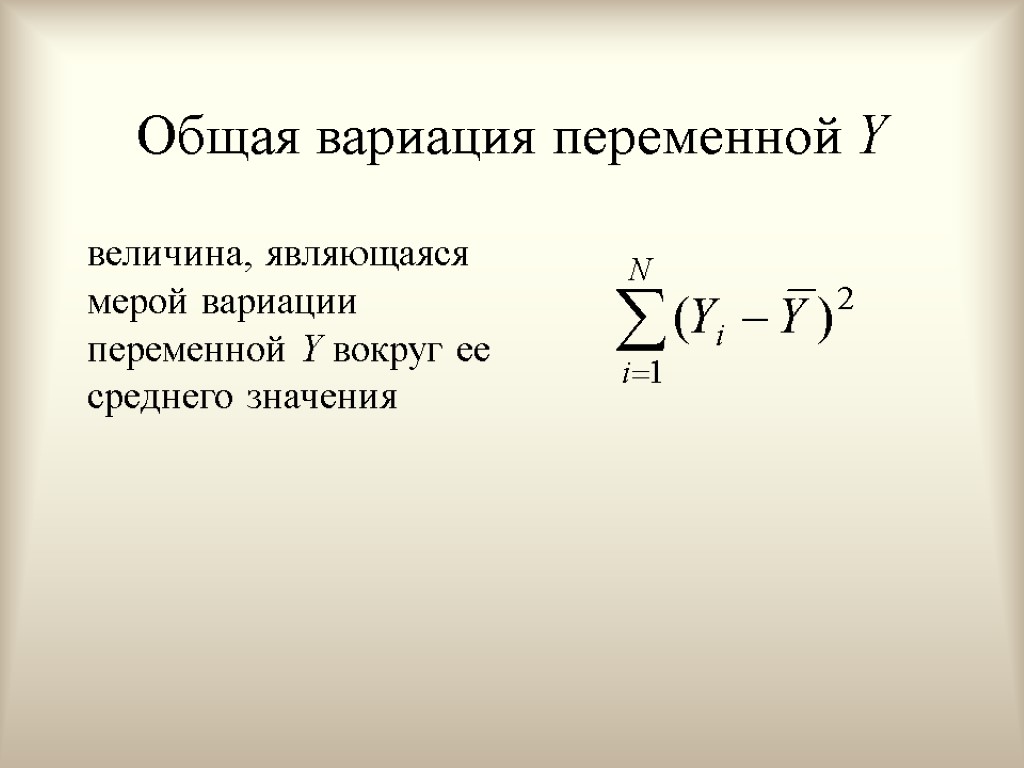

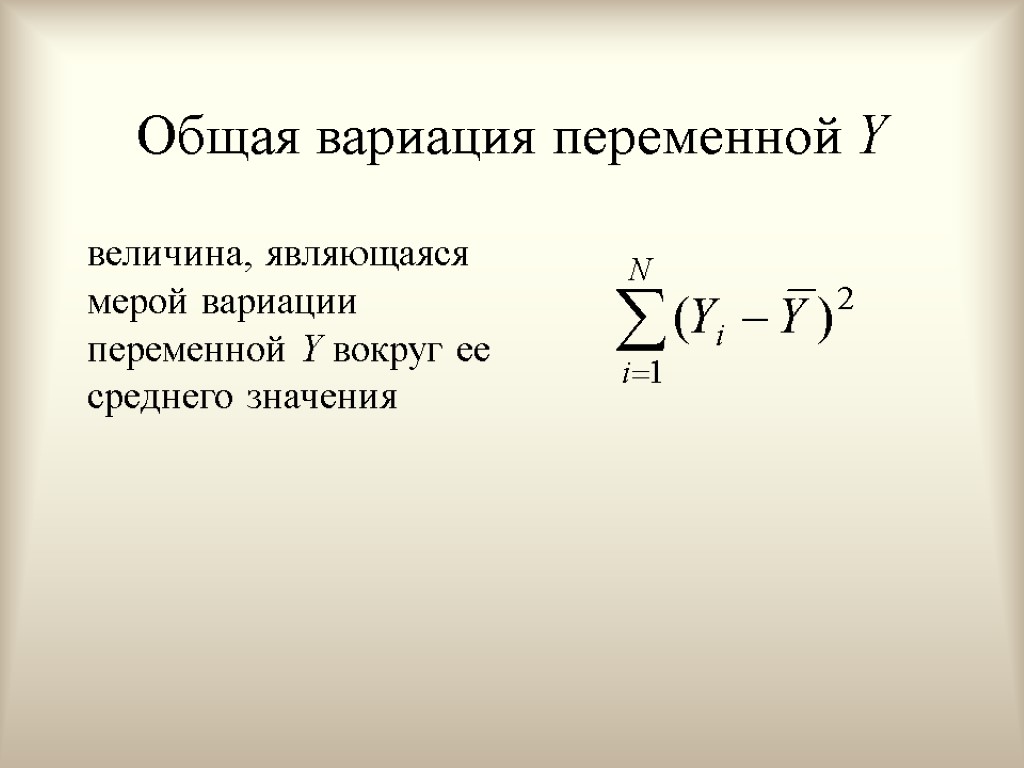

Общая вариация переменной Y величина, являющаяся мерой вариации переменной Y вокруг ее среднего значения

Общая вариация переменной Y величина, являющаяся мерой вариации переменной Y вокруг ее среднего значения

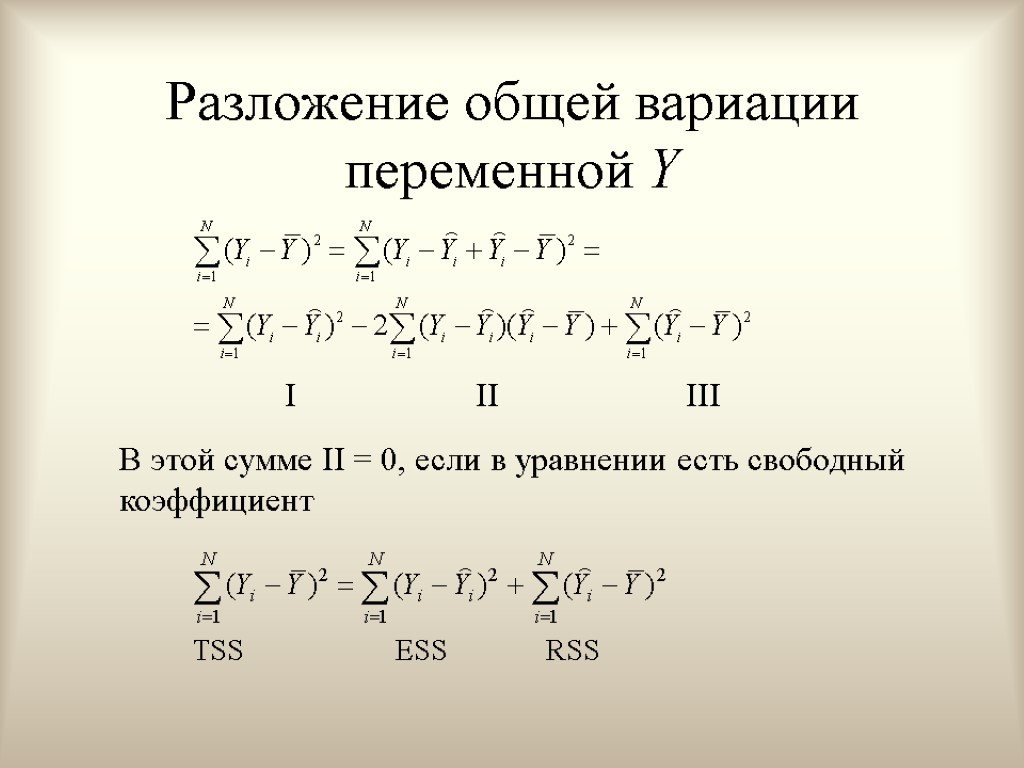

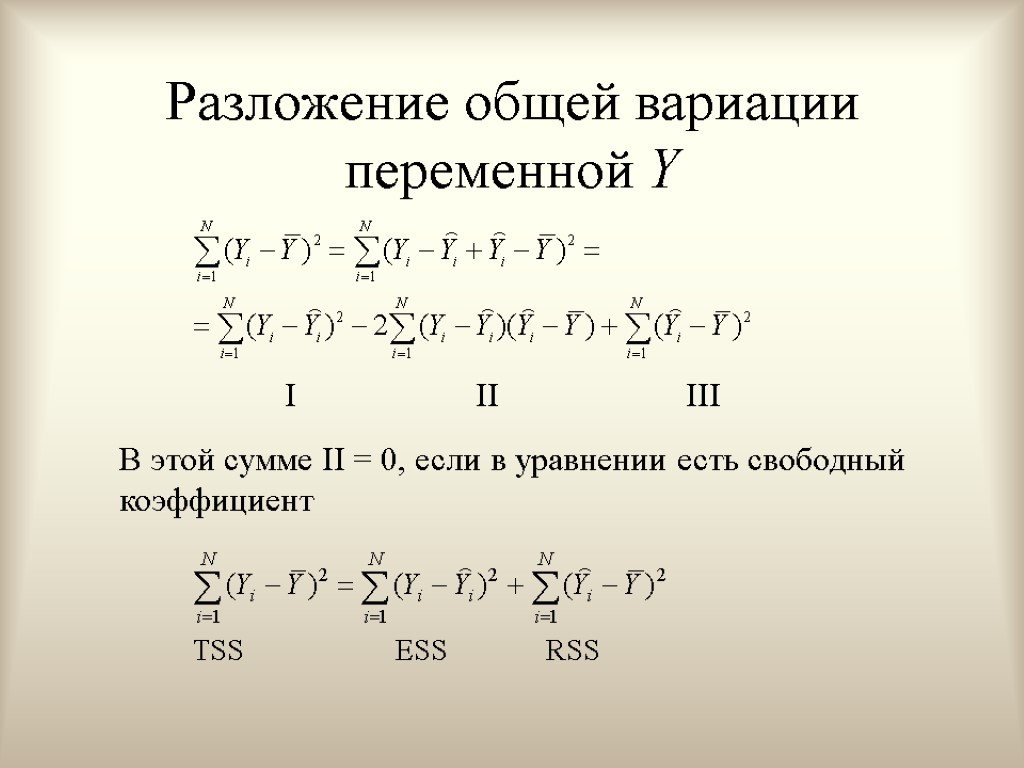

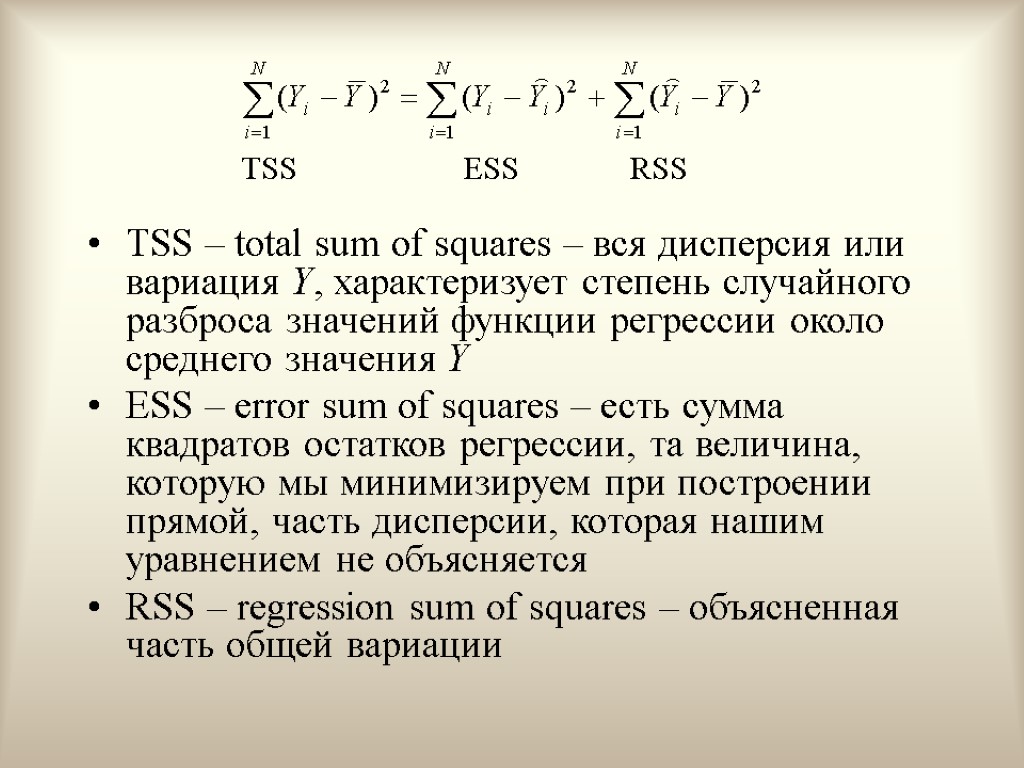

Разложение общей вариации переменной Y В этой сумме II = 0, если в уравнении есть свободный коэффициент I II III

Разложение общей вариации переменной Y В этой сумме II = 0, если в уравнении есть свободный коэффициент I II III

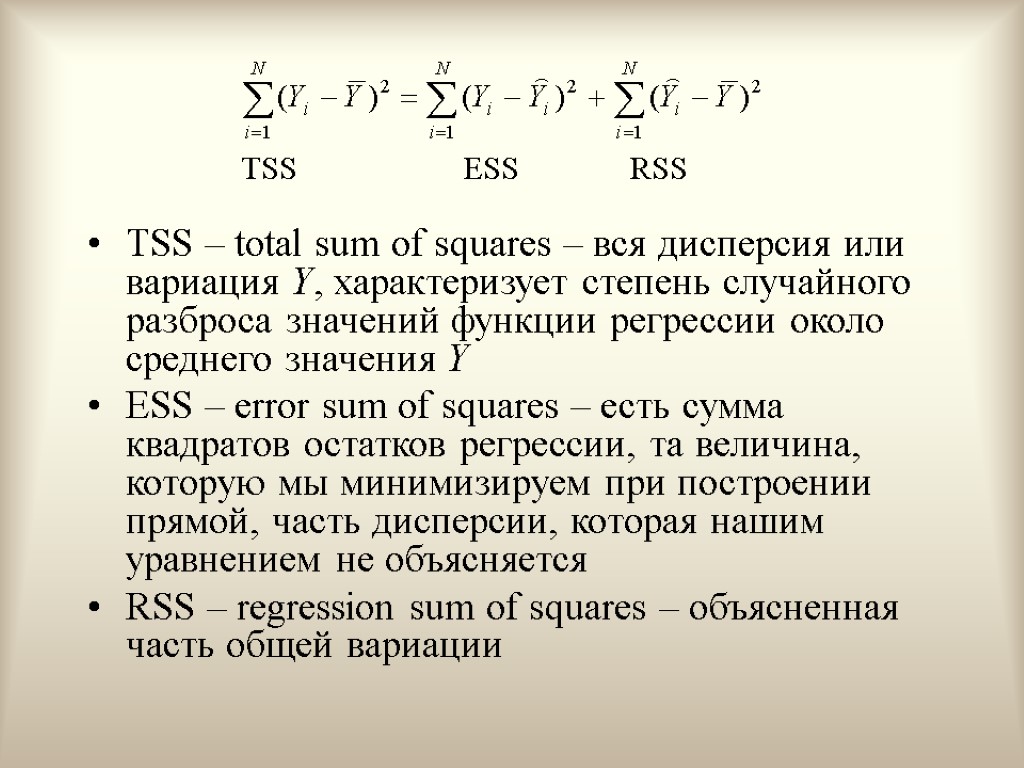

TSS – total sum of squares – вся дисперсия или вариация Y, характеризует степень случайного разброса значений функции регрессии около среднего значения Y ESS – error sum of squares – есть сумма квадратов остатков регрессии, та величина, которую мы минимизируем при построении прямой, часть дисперсии, которая нашим уравнением не объясняется RSS – regression sum of squares – объясненная часть общей вариации

TSS – total sum of squares – вся дисперсия или вариация Y, характеризует степень случайного разброса значений функции регрессии около среднего значения Y ESS – error sum of squares – есть сумма квадратов остатков регрессии, та величина, которую мы минимизируем при построении прямой, часть дисперсии, которая нашим уравнением не объясняется RSS – regression sum of squares – объясненная часть общей вариации

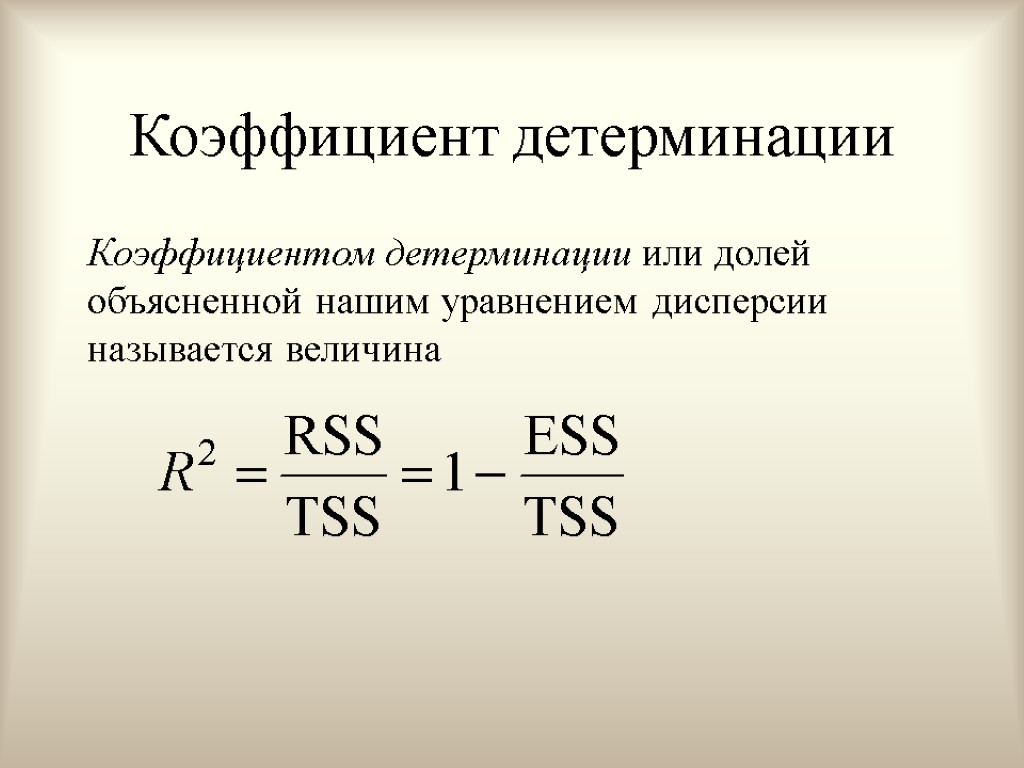

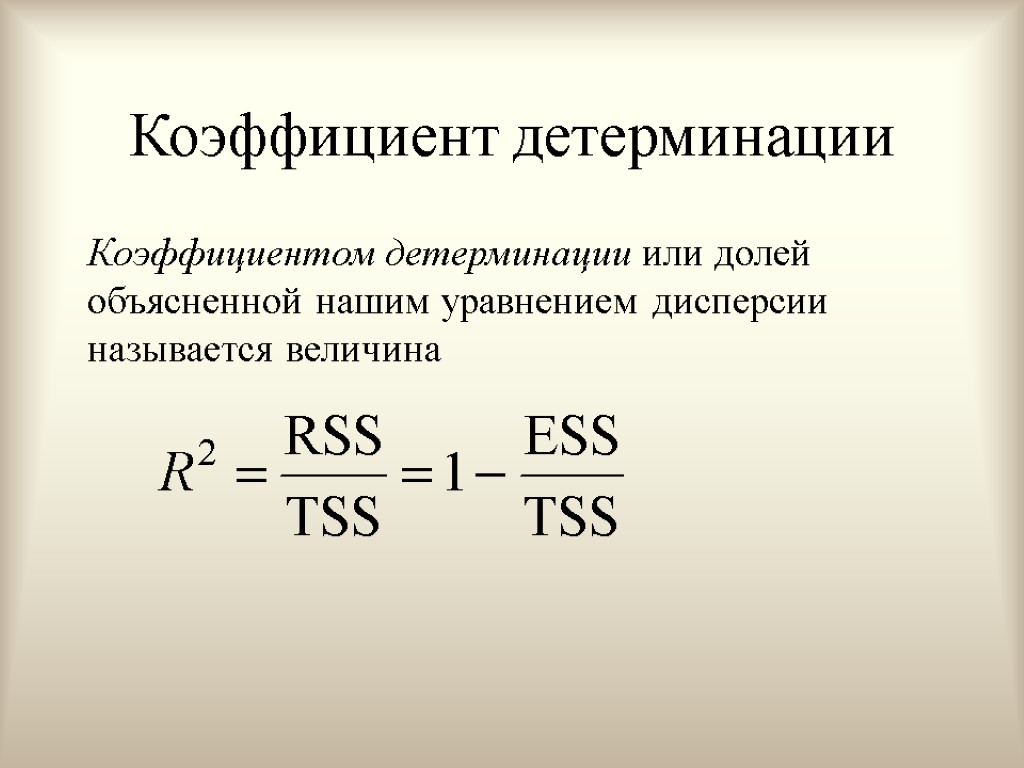

Коэффициент детерминации Коэффициентом детерминации или долей объясненной нашим уравнением дисперсии называется величина

Коэффициент детерминации Коэффициентом детерминации или долей объясненной нашим уравнением дисперсии называется величина

Свойства коэффициента детерминации в силу определения;

Свойства коэффициента детерминации в силу определения;

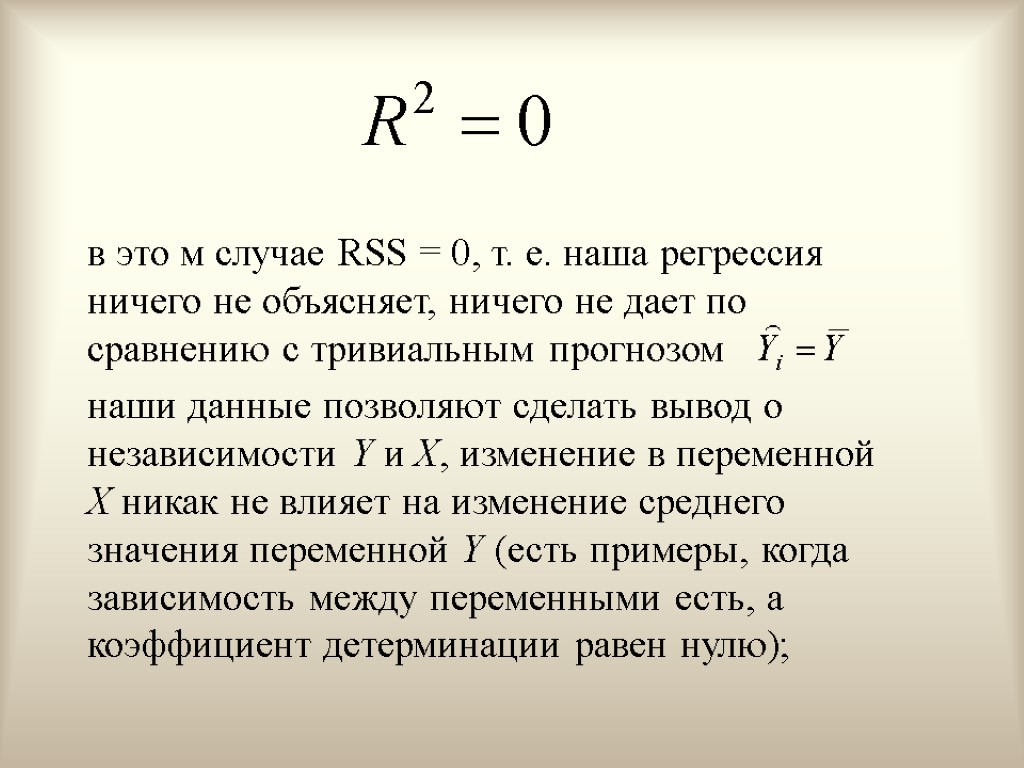

в это м случае RSS = 0, т. е. наша регрессия ничего не объясняет, ничего не дает по сравнению с тривиальным прогнозом наши данные позволяют сделать вывод о независимости Y и X, изменение в переменной X никак не влияет на изменение среднего значения переменной Y (есть примеры, когда зависимость между переменными есть, а коэффициент детерминации равен нулю);

в это м случае RSS = 0, т. е. наша регрессия ничего не объясняет, ничего не дает по сравнению с тривиальным прогнозом наши данные позволяют сделать вывод о независимости Y и X, изменение в переменной X никак не влияет на изменение среднего значения переменной Y (есть примеры, когда зависимость между переменными есть, а коэффициент детерминации равен нулю);

в этом случае чем ближе R2 к 1, тем лучше качество подгонки кривой к нашим данным, тем точнее аппроксимирует Y

в этом случае чем ближе R2 к 1, тем лучше качество подгонки кривой к нашим данным, тем точнее аппроксимирует Y

в этом случае все точки (Xi, Yi) лежат на одной прямой (ESS = 0). Тогда на основании наших данных можно сделать вывод о наличии функциональной, а именно, линейной, зависимости между переменными Y и X. Изменение переменной Y полностью объясняется изменением переменной X

в этом случае все точки (Xi, Yi) лежат на одной прямой (ESS = 0). Тогда на основании наших данных можно сделать вывод о наличии функциональной, а именно, линейной, зависимости между переменными Y и X. Изменение переменной Y полностью объясняется изменением переменной X

Недостаток коэффициента детерминации R2, вообще говоря, возрастает при добавлении еще одного регрессора, поэтому для выбора между несколькими регрессионными уравнениями не следует полагаться только на R2

Недостаток коэффициента детерминации R2, вообще говоря, возрастает при добавлении еще одного регрессора, поэтому для выбора между несколькими регрессионными уравнениями не следует полагаться только на R2

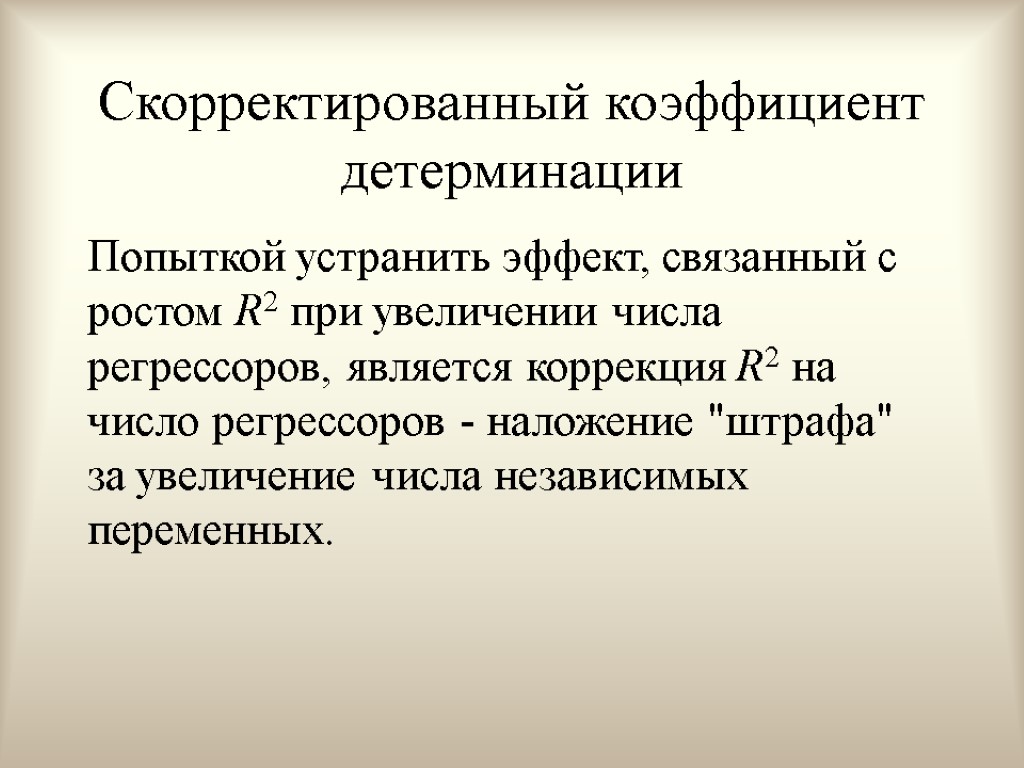

Скорректированный коэффициент детерминации Попыткой устранить эффект, связанный с ростом R2 при увеличении числа регрессоров, является коррекция R2 на число регрессоров - наложение "штрафа" за увеличение числа независимых переменных.

Скорректированный коэффициент детерминации Попыткой устранить эффект, связанный с ростом R2 при увеличении числа регрессоров, является коррекция R2 на число регрессоров - наложение "штрафа" за увеличение числа независимых переменных.

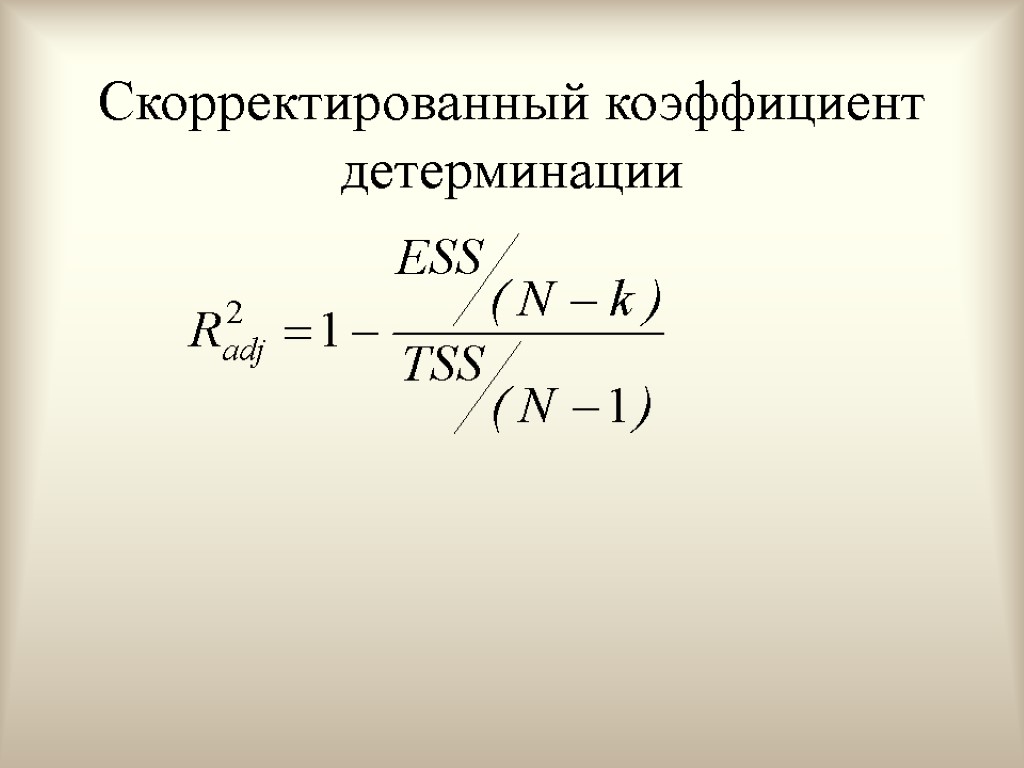

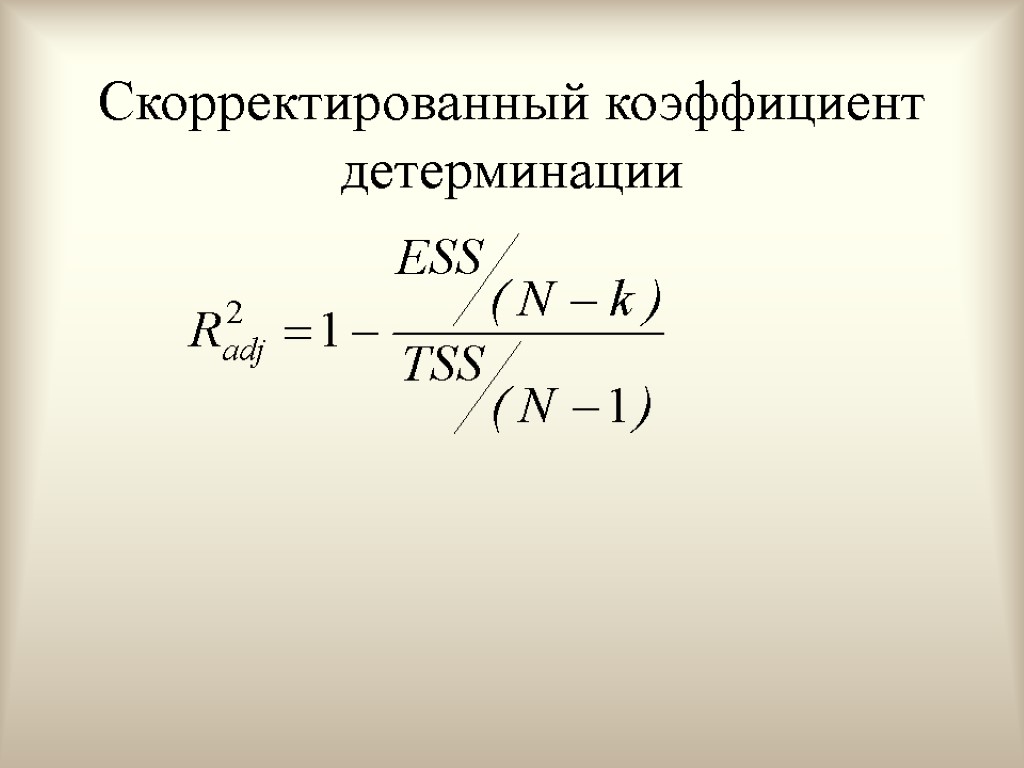

Скорректированный коэффициент детерминации

Скорректированный коэффициент детерминации

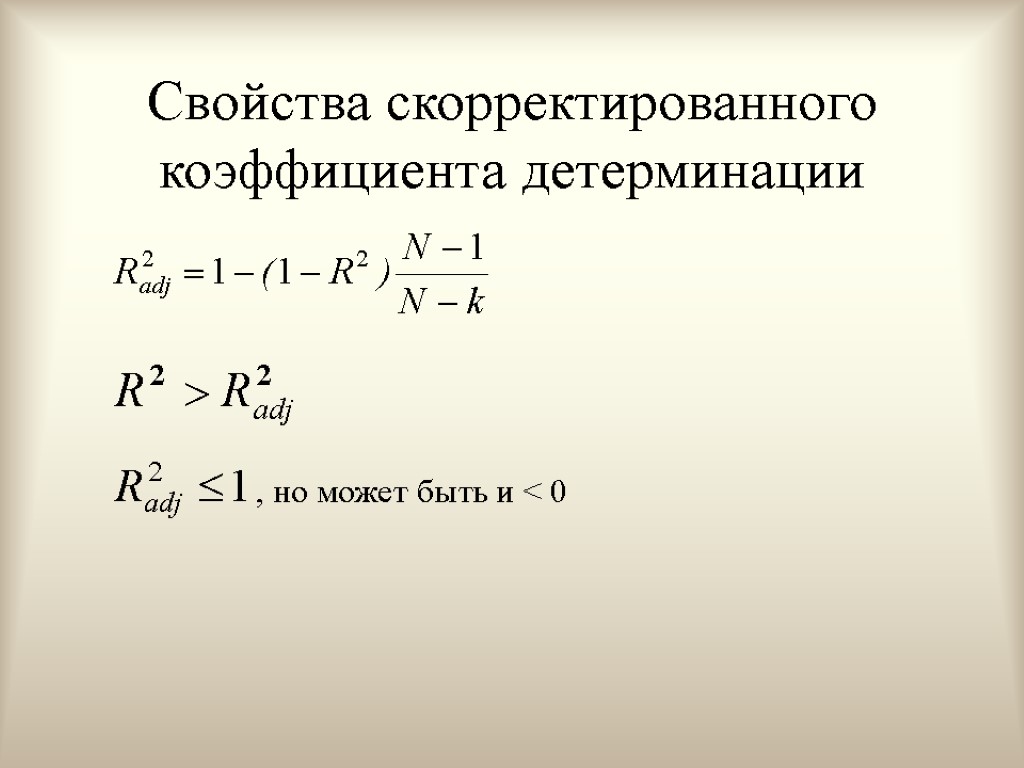

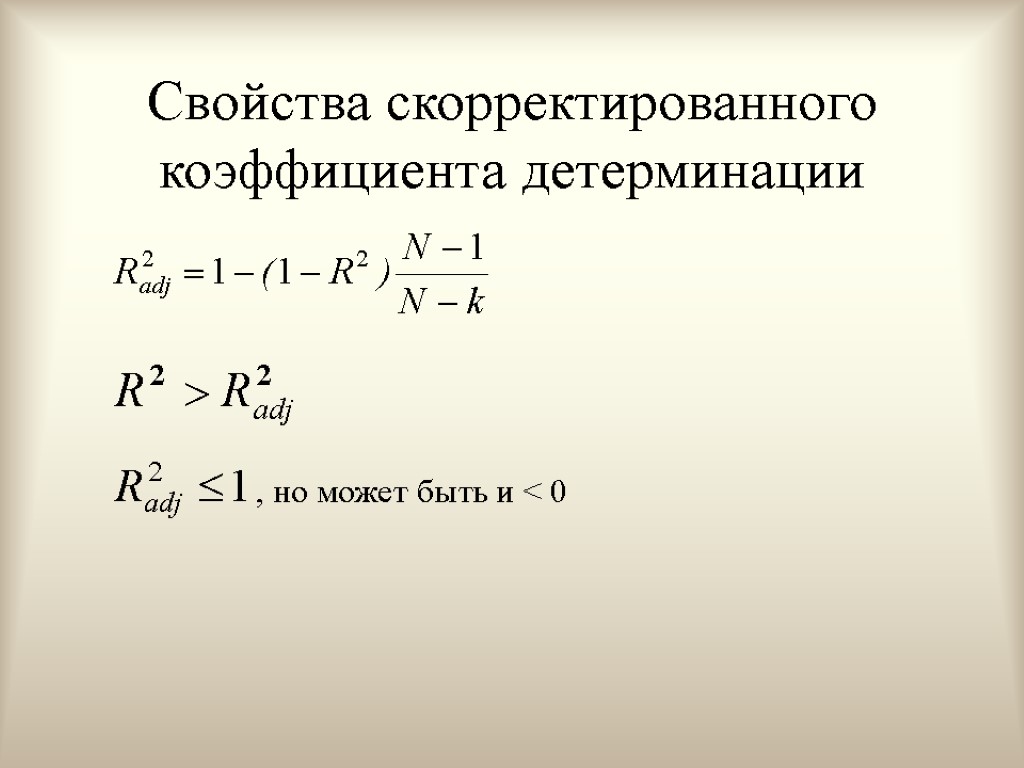

Свойства скорректированного коэффициента детерминации , но может быть и < 0

Свойства скорректированного коэффициента детерминации , но может быть и < 0

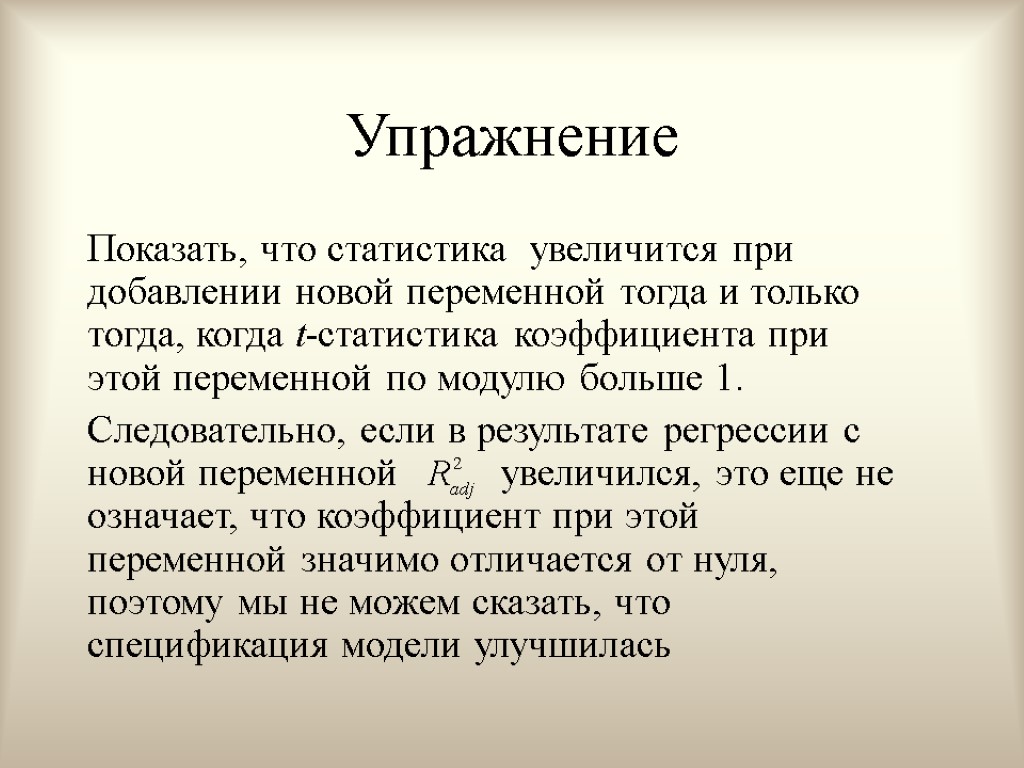

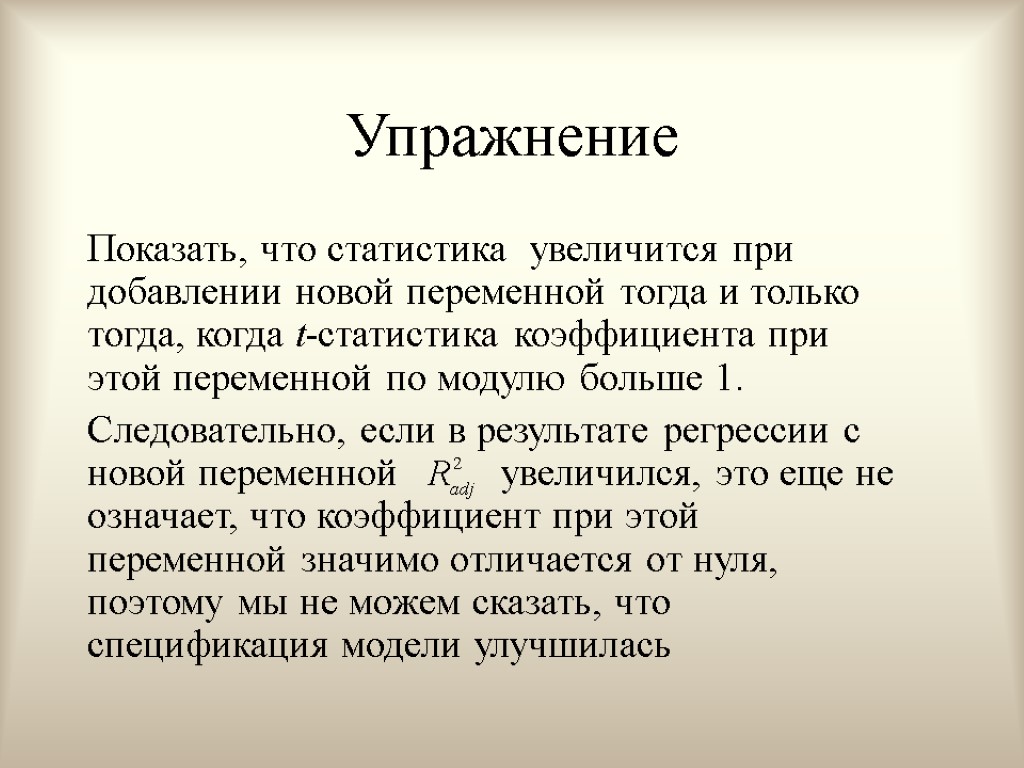

Упражнение Показать, что статистика увеличится при добавлении новой переменной тогда и только тогда, когда t-статистика коэффициента при этой переменной по модулю больше 1. Следовательно, если в результате регрессии с новой переменной увеличился, это еще не означает, что коэффициент при этой переменной значимо отличается от нуля, поэтому мы не можем сказать, что спецификация модели улучшилась

Упражнение Показать, что статистика увеличится при добавлении новой переменной тогда и только тогда, когда t-статистика коэффициента при этой переменной по модулю больше 1. Следовательно, если в результате регрессии с новой переменной увеличился, это еще не означает, что коэффициент при этой переменной значимо отличается от нуля, поэтому мы не можем сказать, что спецификация модели улучшилась

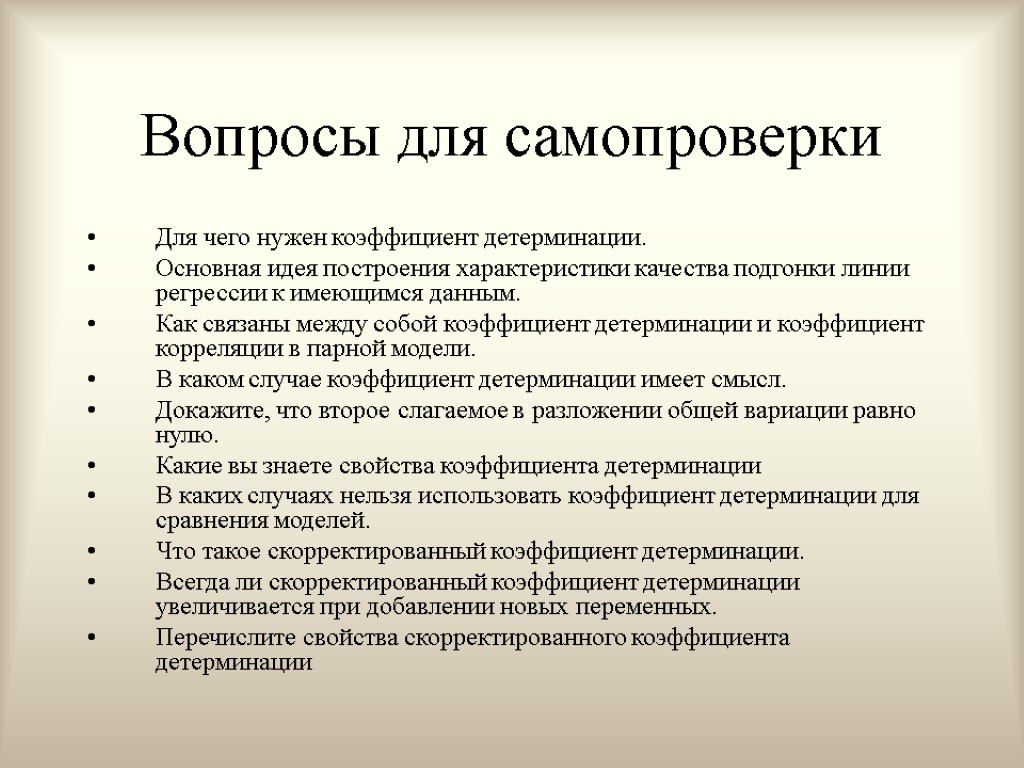

Вопросы для самопроверки Для чего нужен коэффициент детерминации. Основная идея построения характеристики качества подгонки линии регрессии к имеющимся данным. Как связаны между собой коэффициент детерминации и коэффициент корреляции в парной модели. В каком случае коэффициент детерминации имеет смысл. Докажите, что второе слагаемое в разложении общей вариации равно нулю. Какие вы знаете свойства коэффициента детерминации В каких случаях нельзя использовать коэффициент детерминации для сравнения моделей. Что такое скорректированный коэффициент детерминации. Всегда ли скорректированный коэффициент детерминации увеличивается при добавлении новых переменных. Перечислите свойства скорректированного коэффициента детерминации

Вопросы для самопроверки Для чего нужен коэффициент детерминации. Основная идея построения характеристики качества подгонки линии регрессии к имеющимся данным. Как связаны между собой коэффициент детерминации и коэффициент корреляции в парной модели. В каком случае коэффициент детерминации имеет смысл. Докажите, что второе слагаемое в разложении общей вариации равно нулю. Какие вы знаете свойства коэффициента детерминации В каких случаях нельзя использовать коэффициент детерминации для сравнения моделей. Что такое скорректированный коэффициент детерминации. Всегда ли скорректированный коэффициент детерминации увеличивается при добавлении новых переменных. Перечислите свойства скорректированного коэффициента детерминации

Тема 4. Нелинейные модели

Тема 4. Нелинейные модели

Темы лекции Нелинейная регрессия Преобразования переменных Экономическая интерпретация регрессионной модели

Темы лекции Нелинейная регрессия Преобразования переменных Экономическая интерпретация регрессионной модели

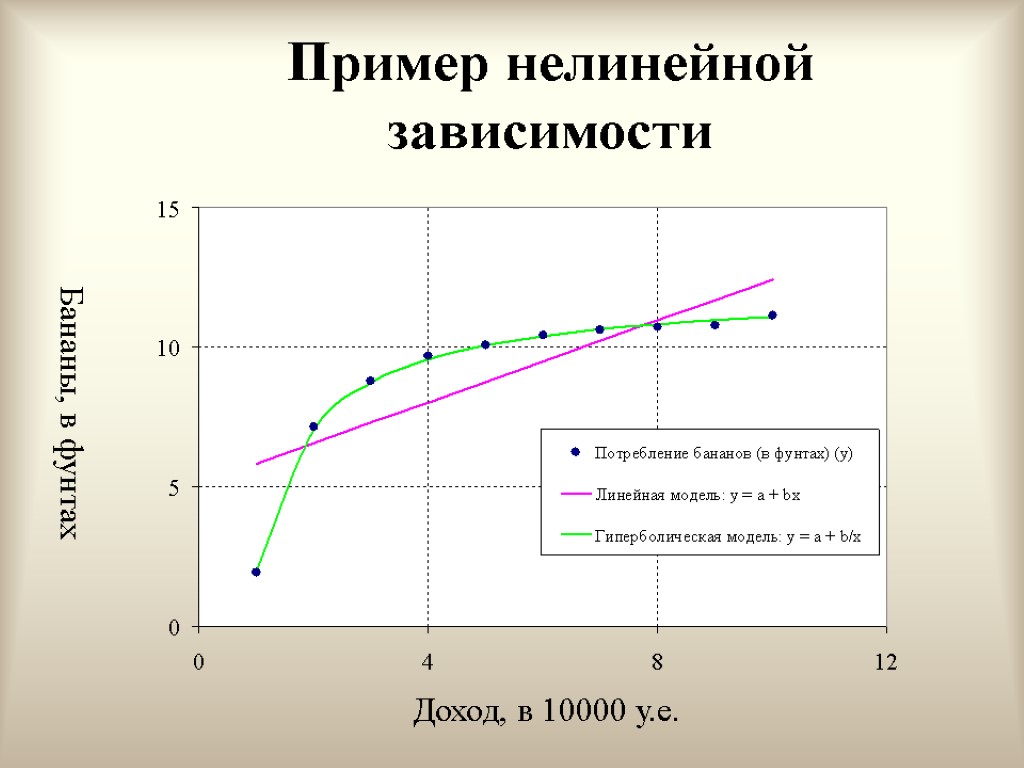

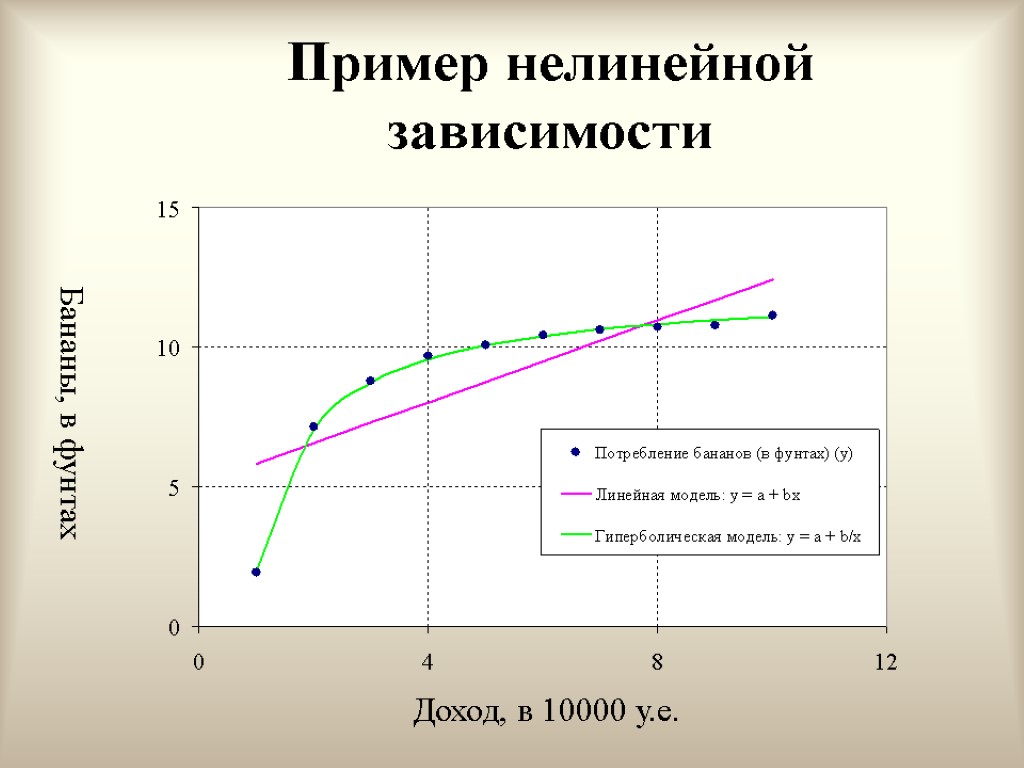

Пример нелинейной зависимости Бананы, в фунтах Доход, в 10000 у.е.

Пример нелинейной зависимости Бананы, в фунтах Доход, в 10000 у.е.

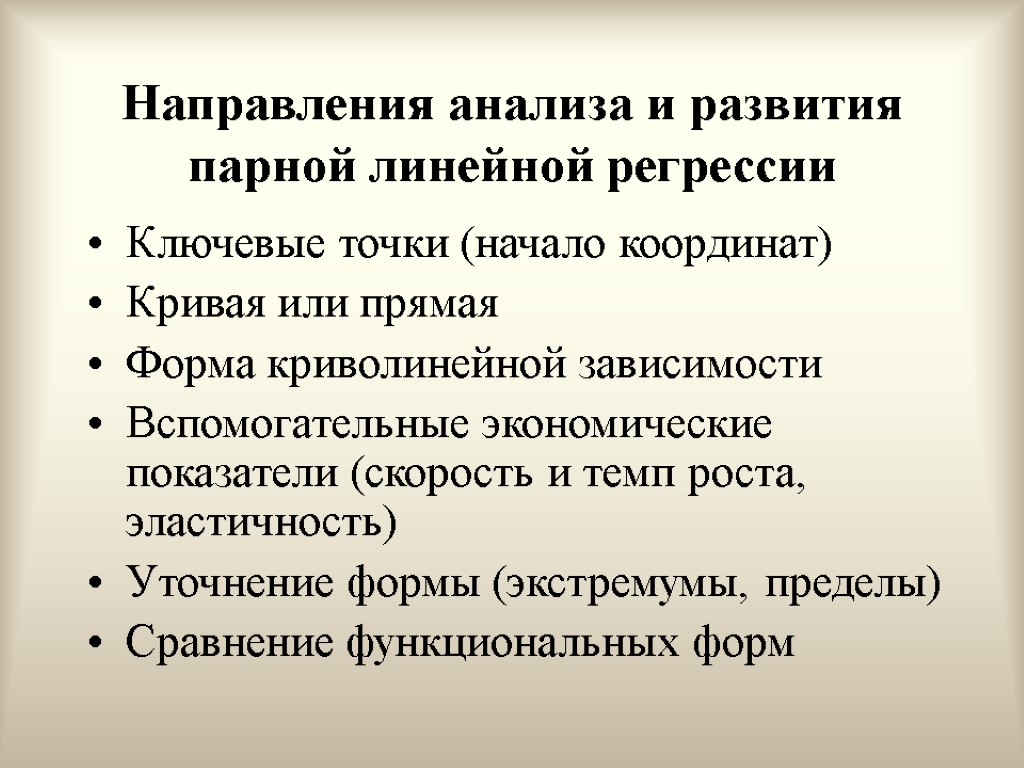

Направления анализа и развития парной линейной регрессии Ключевые точки (начало координат) Кривая или прямая Форма криволинейной зависимости Вспомогательные экономические показатели (скорость и темп роста, эластичность) Уточнение формы (экстремумы, пределы) Сравнение функциональных форм

Направления анализа и развития парной линейной регрессии Ключевые точки (начало координат) Кривая или прямая Форма криволинейной зависимости Вспомогательные экономические показатели (скорость и темп роста, эластичность) Уточнение формы (экстремумы, пределы) Сравнение функциональных форм

Этапы построения модели 1. Выбор теоретических предпосылок 2. Формализация предпосылок 3. Построение математической модели 4. Анализ построенной модели

Этапы построения модели 1. Выбор теоретических предпосылок 2. Формализация предпосылок 3. Построение математической модели 4. Анализ построенной модели

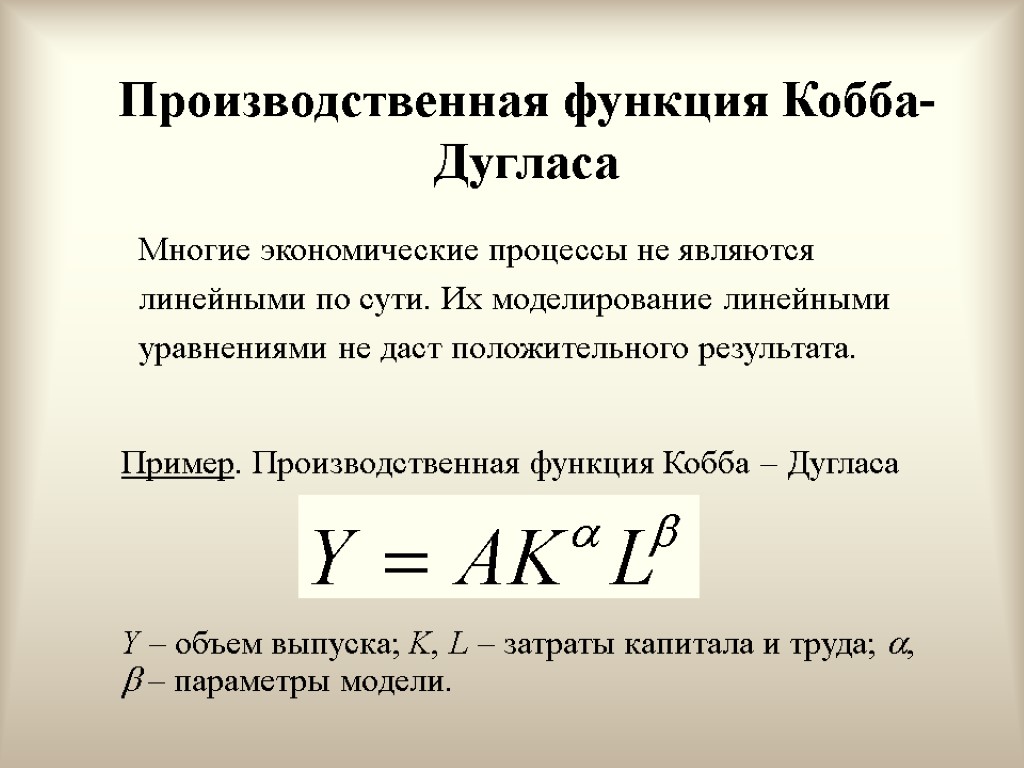

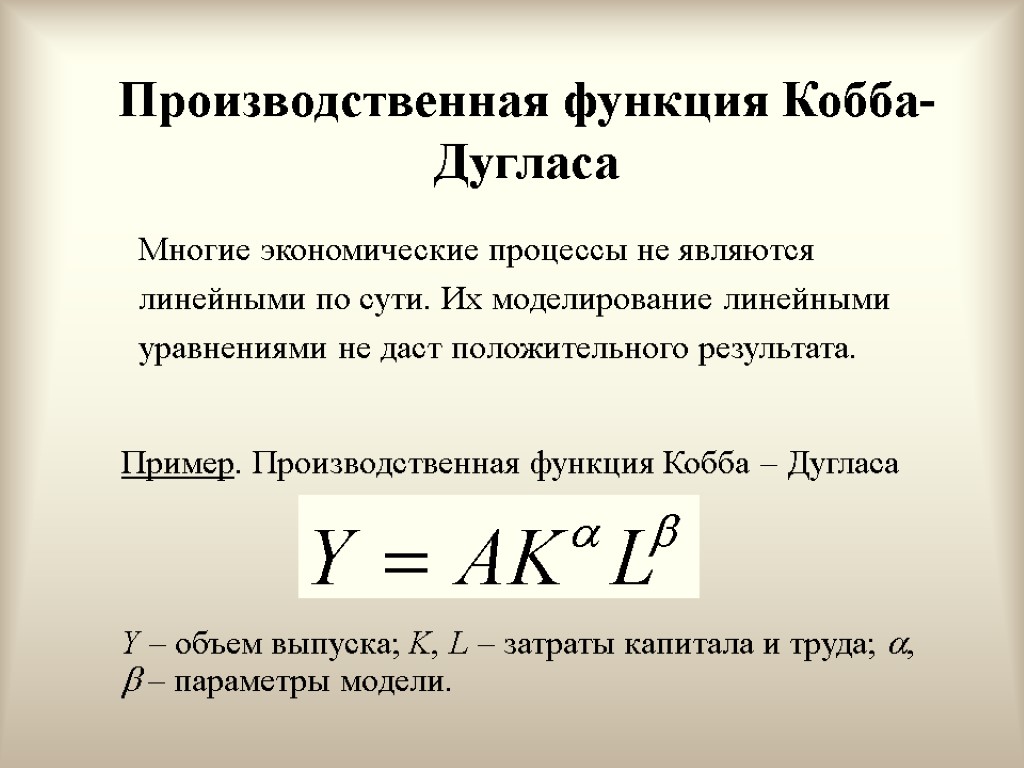

Производственная функция Кобба-Дугласа Многие экономические процессы не являются линейными по сути. Их моделирование линейными уравнениями не даст положительного результата. Пример. Производственная функция Кобба – Дугласа Y – объем выпуска; K, L – затраты капитала и труда; , – параметры модели.

Производственная функция Кобба-Дугласа Многие экономические процессы не являются линейными по сути. Их моделирование линейными уравнениями не даст положительного результата. Пример. Производственная функция Кобба – Дугласа Y – объем выпуска; K, L – затраты капитала и труда; , – параметры модели.

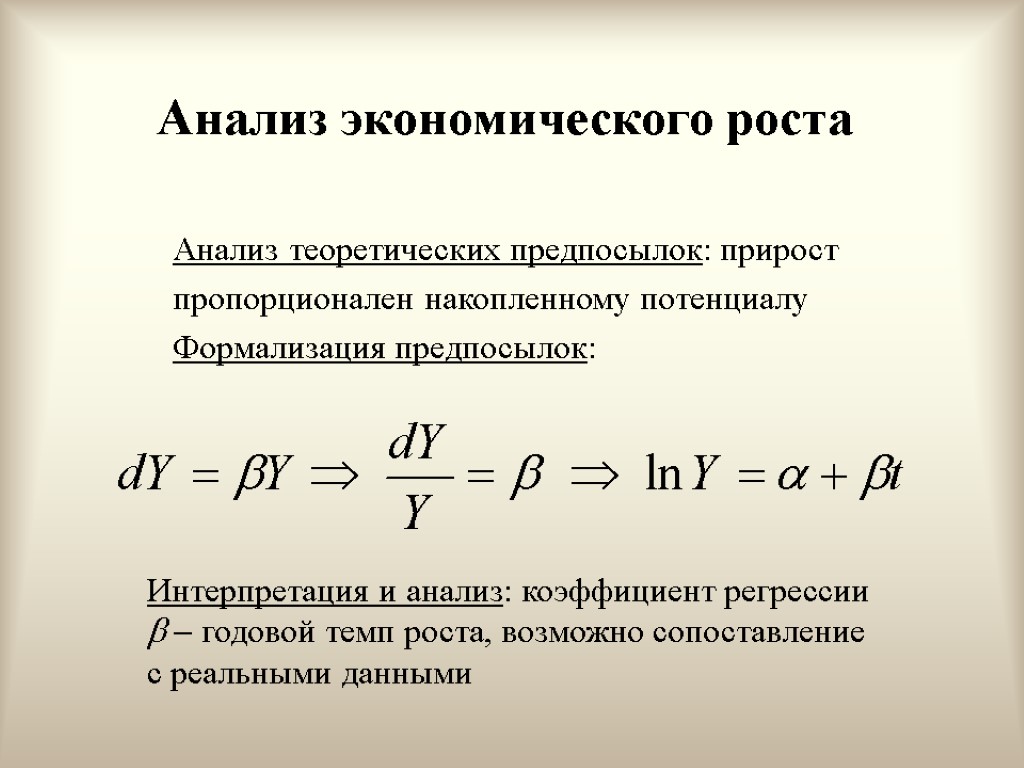

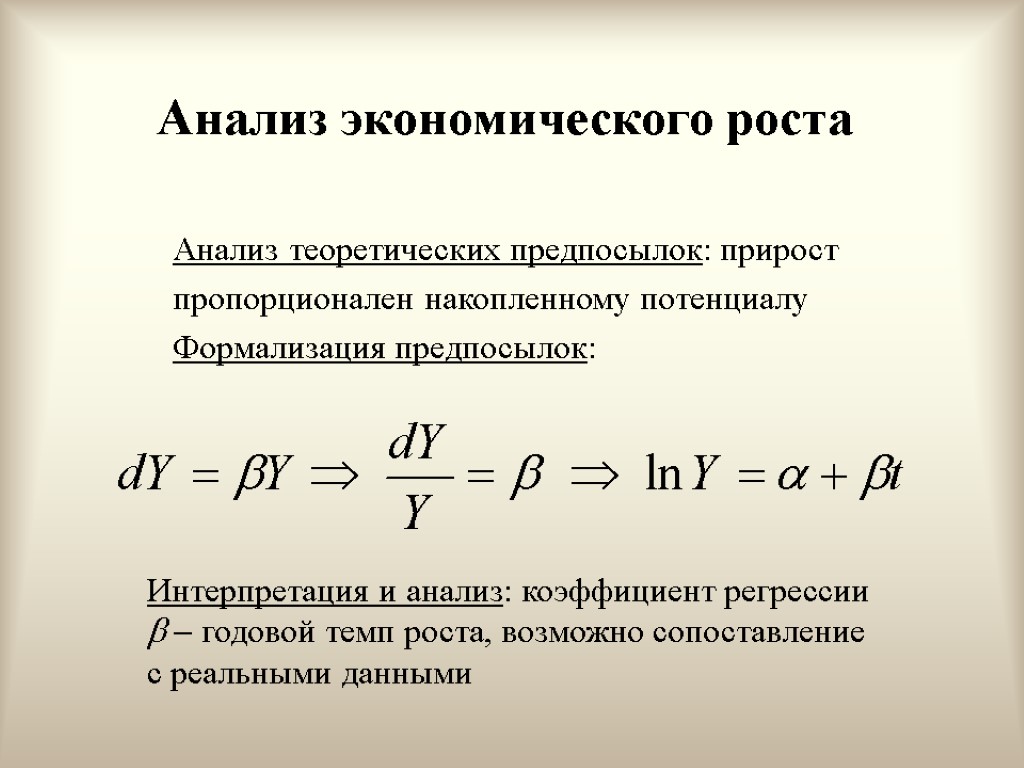

Анализ экономического роста Анализ теоретических предпосылок: прирост пропорционален накопленному потенциалу Формализация предпосылок: Интерпретация и анализ: коэффициент регрессии годовой темп роста, возможно сопоставление с реальными данными

Анализ экономического роста Анализ теоретических предпосылок: прирост пропорционален накопленному потенциалу Формализация предпосылок: Интерпретация и анализ: коэффициент регрессии годовой темп роста, возможно сопоставление с реальными данными

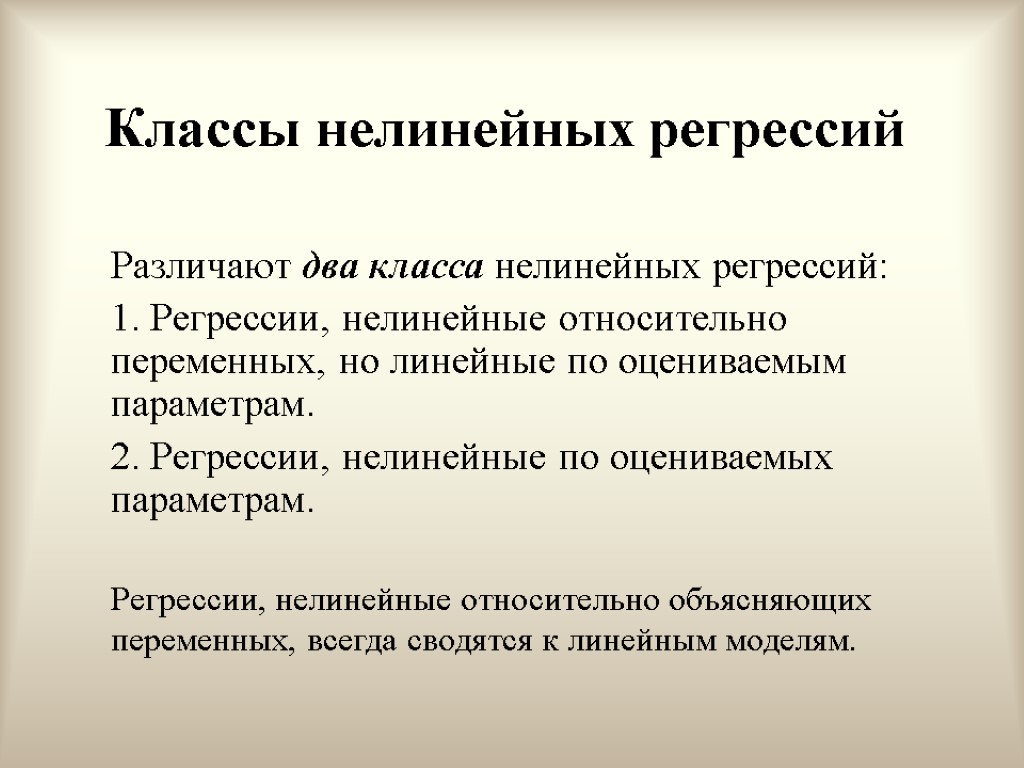

Классы нелинейных регрессий Различают два класса нелинейных регрессий: 1. Регрессии, нелинейные относительно переменных, но линейные по оцениваемым параметрам. 2. Регрессии, нелинейные по оцениваемых параметрам. Регрессии, нелинейные относительно объясняющих переменных, всегда сводятся к линейным моделям.

Классы нелинейных регрессий Различают два класса нелинейных регрессий: 1. Регрессии, нелинейные относительно переменных, но линейные по оцениваемым параметрам. 2. Регрессии, нелинейные по оцениваемых параметрам. Регрессии, нелинейные относительно объясняющих переменных, всегда сводятся к линейным моделям.

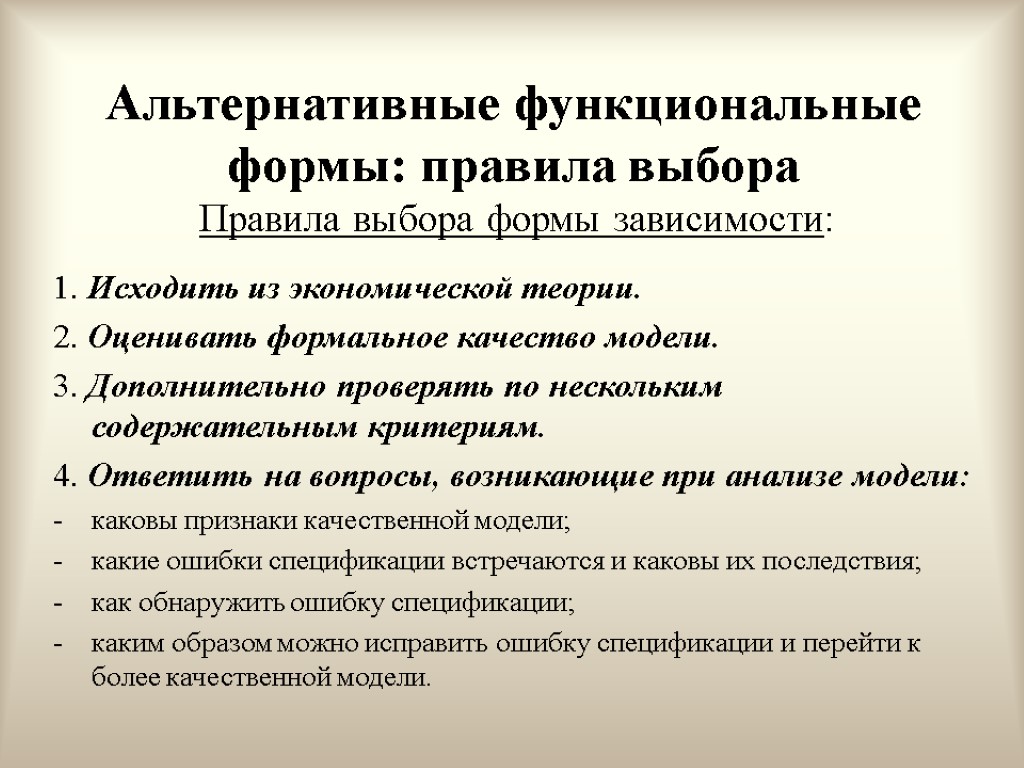

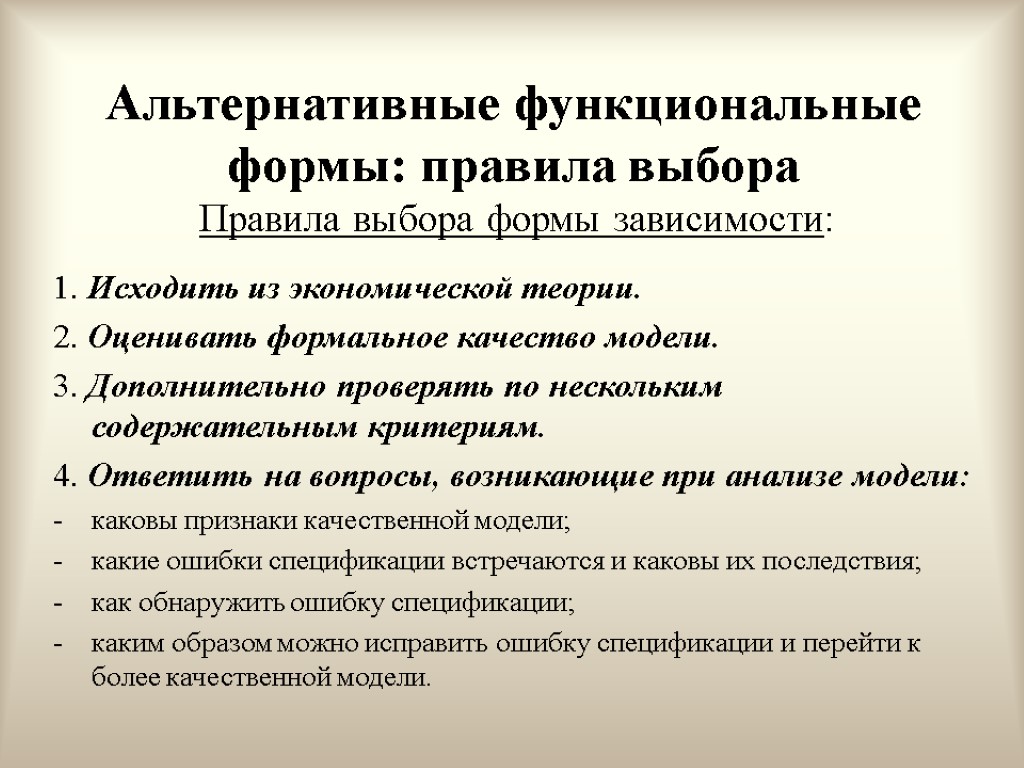

Альтернативные функциональные формы: правила выбора Правила выбора формы зависимости: 1. Исходить из экономической теории. 2. Оценивать формальное качество модели. 3. Дополнительно проверять по нескольким содержательным критериям. 4. Ответить на вопросы, возникающие при анализе модели: каковы признаки качественной модели; какие ошибки спецификации встречаются и каковы их последствия; как обнаружить ошибку спецификации; каким образом можно исправить ошибку спецификации и перейти к более качественной модели.

Альтернативные функциональные формы: правила выбора Правила выбора формы зависимости: 1. Исходить из экономической теории. 2. Оценивать формальное качество модели. 3. Дополнительно проверять по нескольким содержательным критериям. 4. Ответить на вопросы, возникающие при анализе модели: каковы признаки качественной модели; какие ошибки спецификации встречаются и каковы их последствия; как обнаружить ошибку спецификации; каким образом можно исправить ошибку спецификации и перейти к более качественной модели.

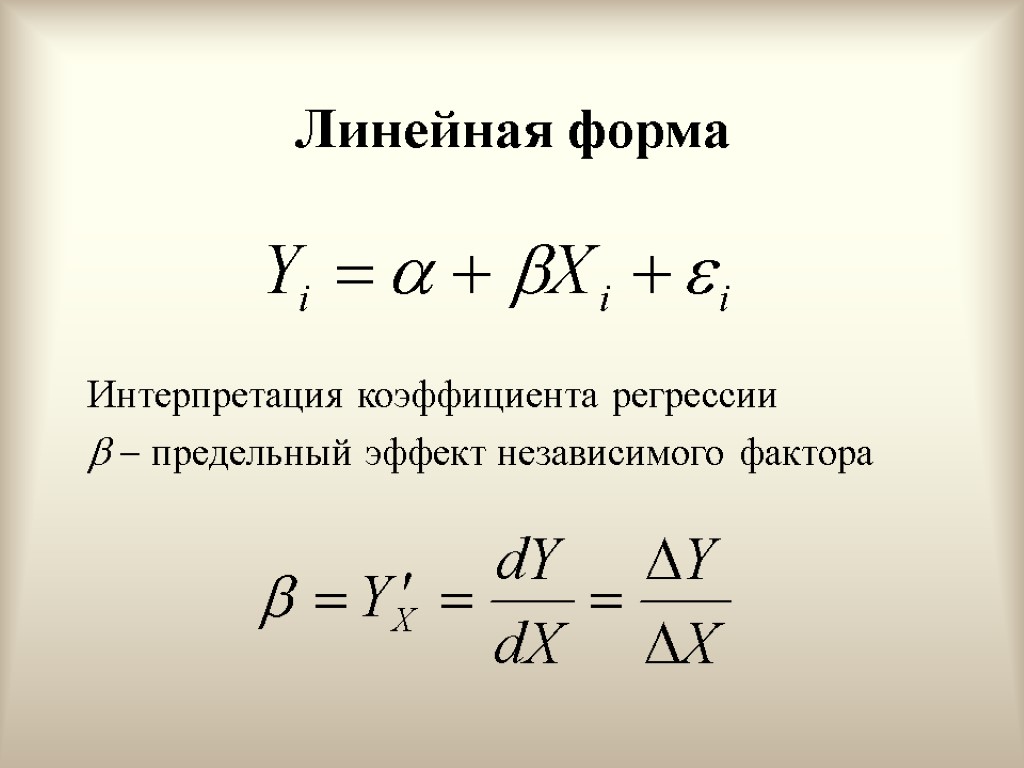

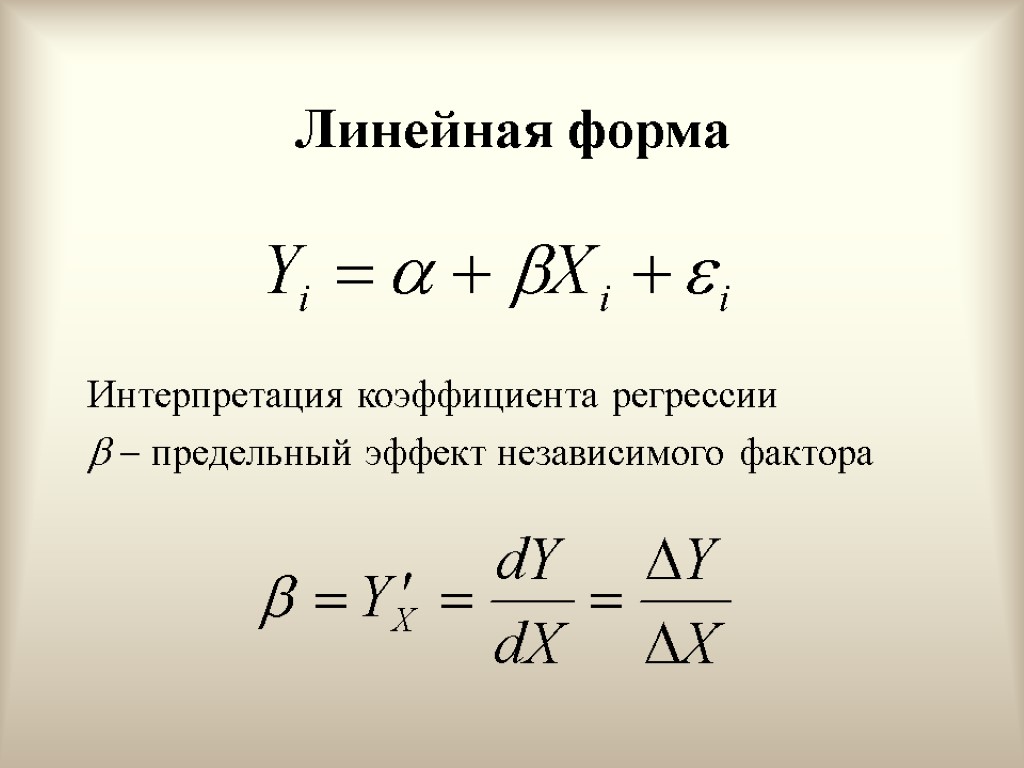

Линейная форма Интерпретация коэффициента регрессии предельный эффект независимого фактора

Линейная форма Интерпретация коэффициента регрессии предельный эффект независимого фактора

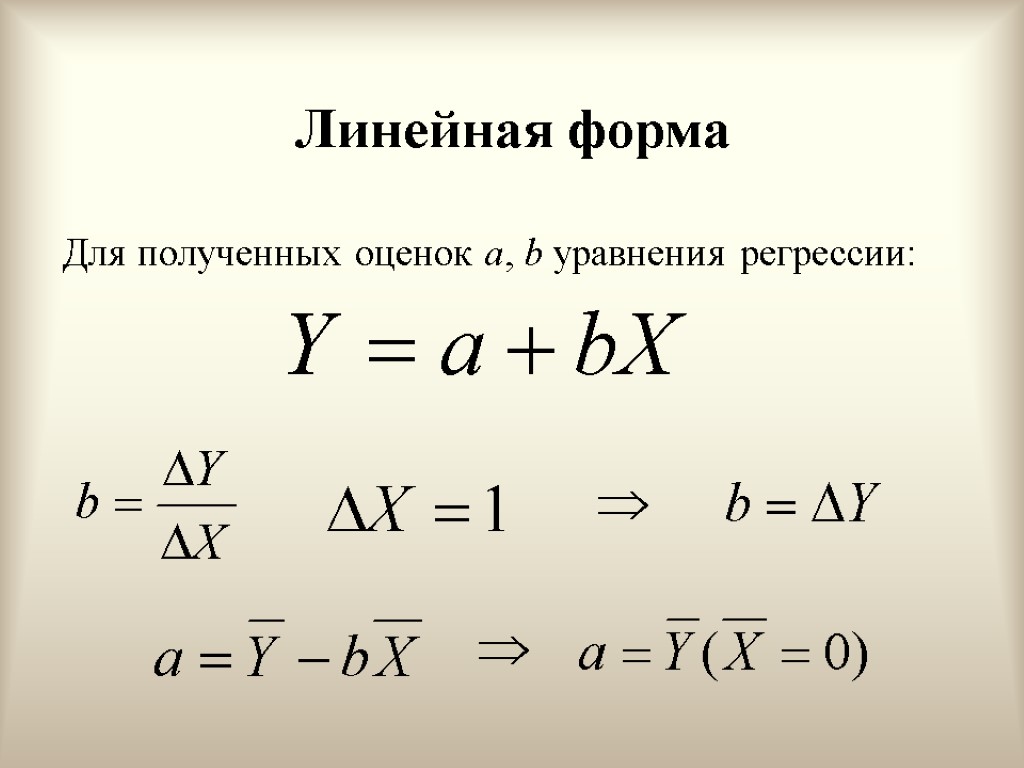

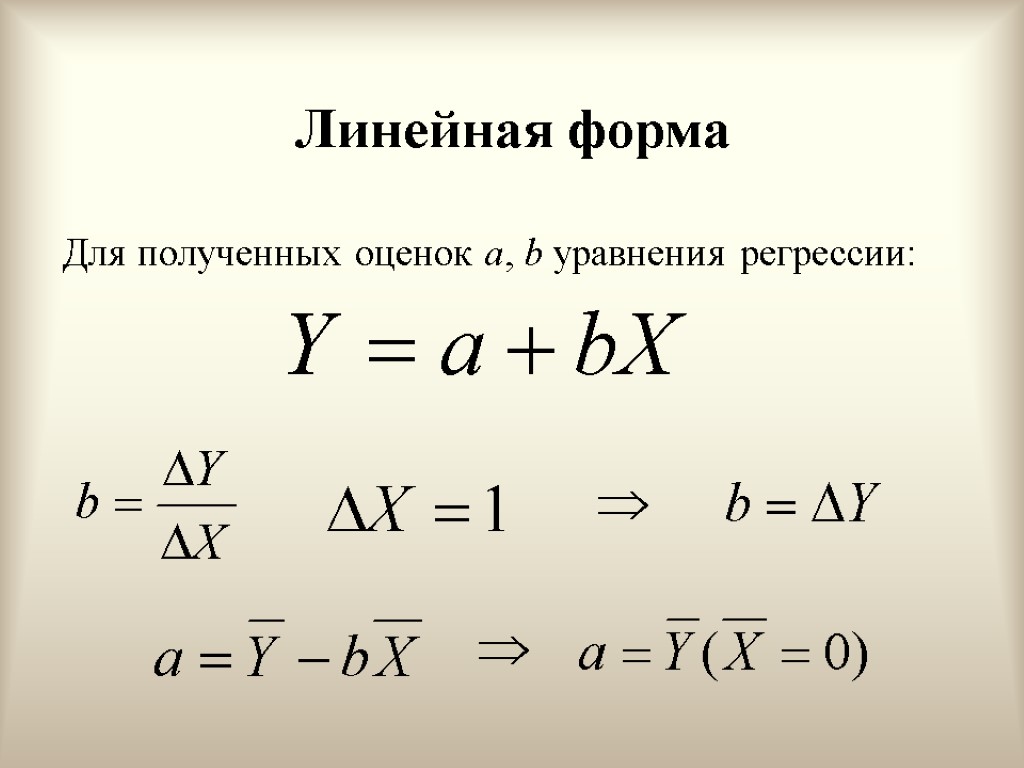

Линейная форма Для полученных оценок a, b уравнения регрессии:

Линейная форма Для полученных оценок a, b уравнения регрессии:

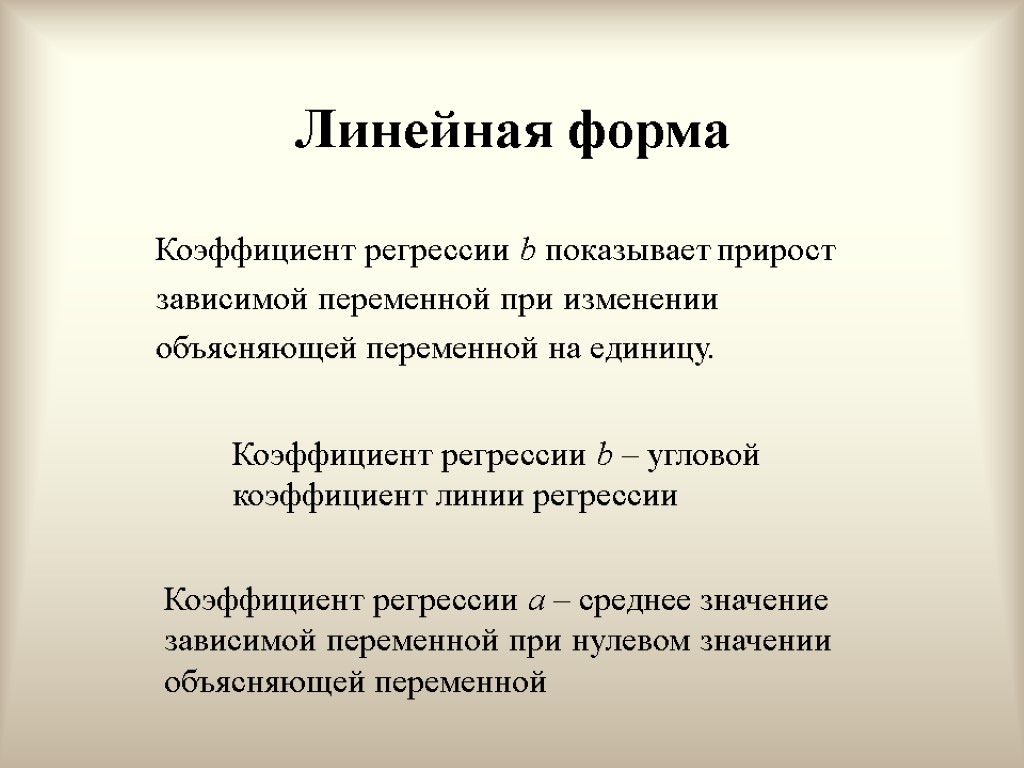

Линейная форма Коэффициент регрессии b показывает прирост зависимой переменной при изменении объясняющей переменной на единицу. Коэффициент регрессии b – угловой коэффициент линии регрессии Коэффициент регрессии a – среднее значение зависимой переменной при нулевом значении объясняющей переменной

Линейная форма Коэффициент регрессии b показывает прирост зависимой переменной при изменении объясняющей переменной на единицу. Коэффициент регрессии b – угловой коэффициент линии регрессии Коэффициент регрессии a – среднее значение зависимой переменной при нулевом значении объясняющей переменной

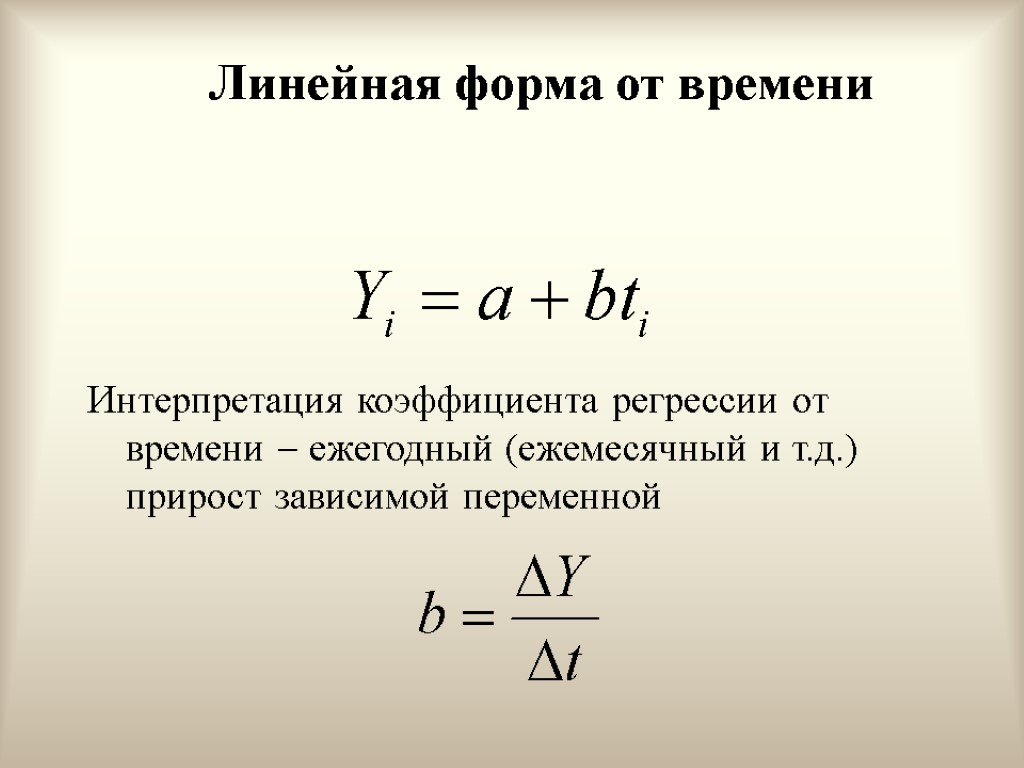

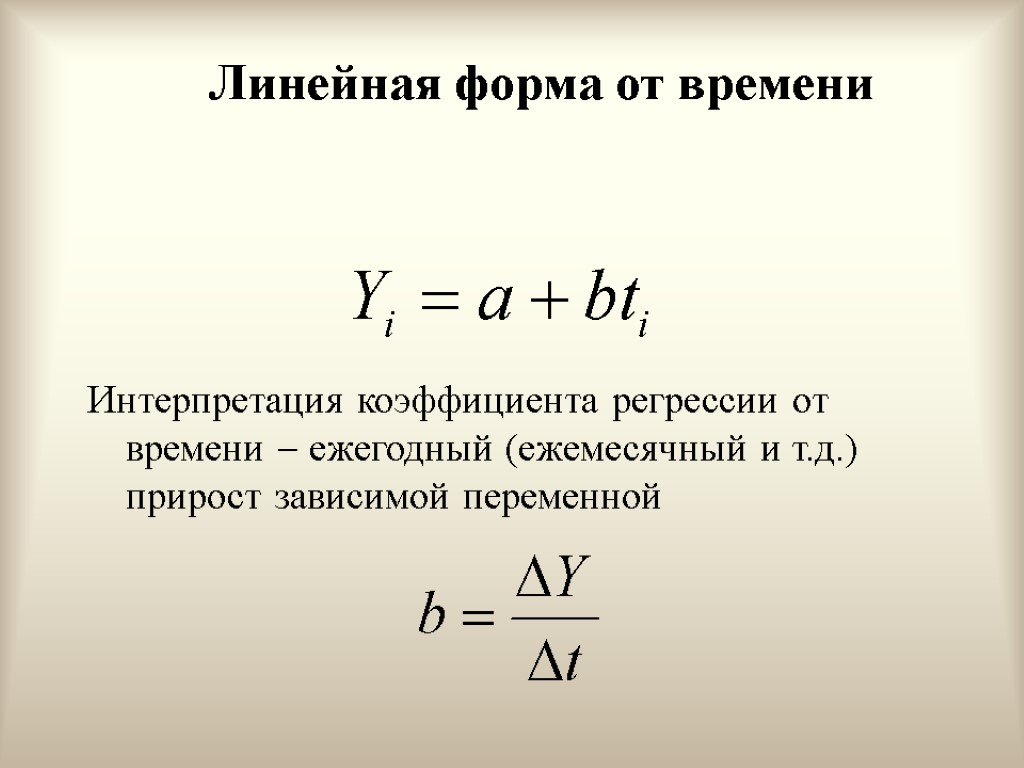

Линейная форма от времени Интерпретация коэффициента регрессии от времени ежегодный (ежемесячный и т.д.) прирост зависимой переменной

Линейная форма от времени Интерпретация коэффициента регрессии от времени ежегодный (ежемесячный и т.д.) прирост зависимой переменной

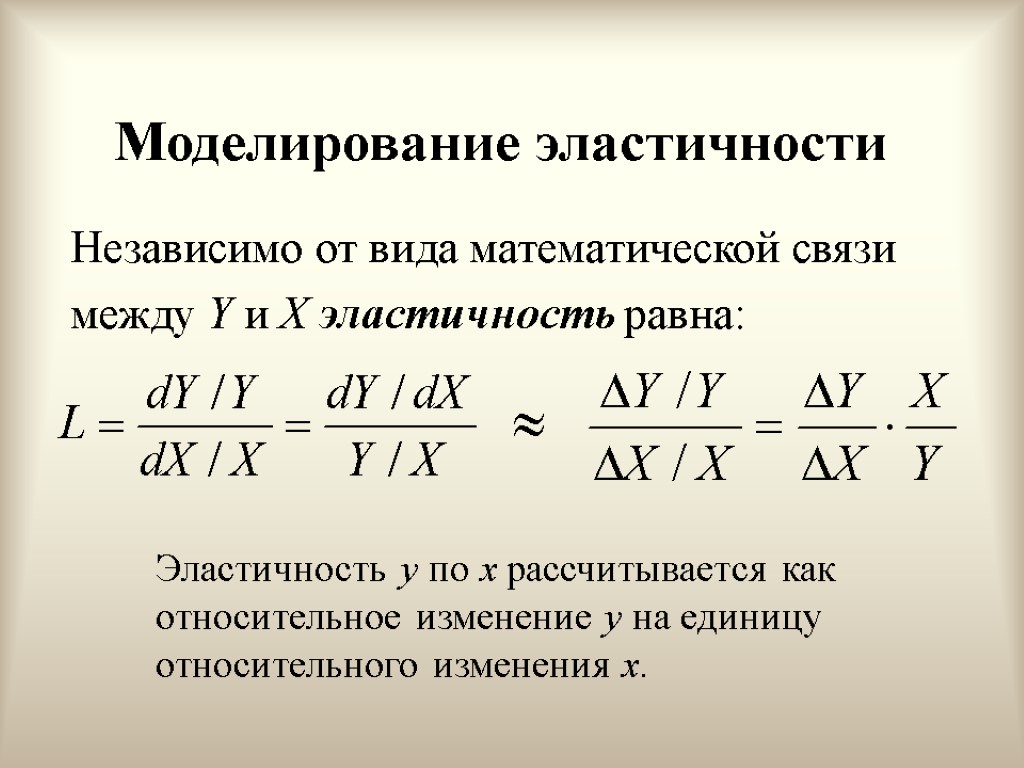

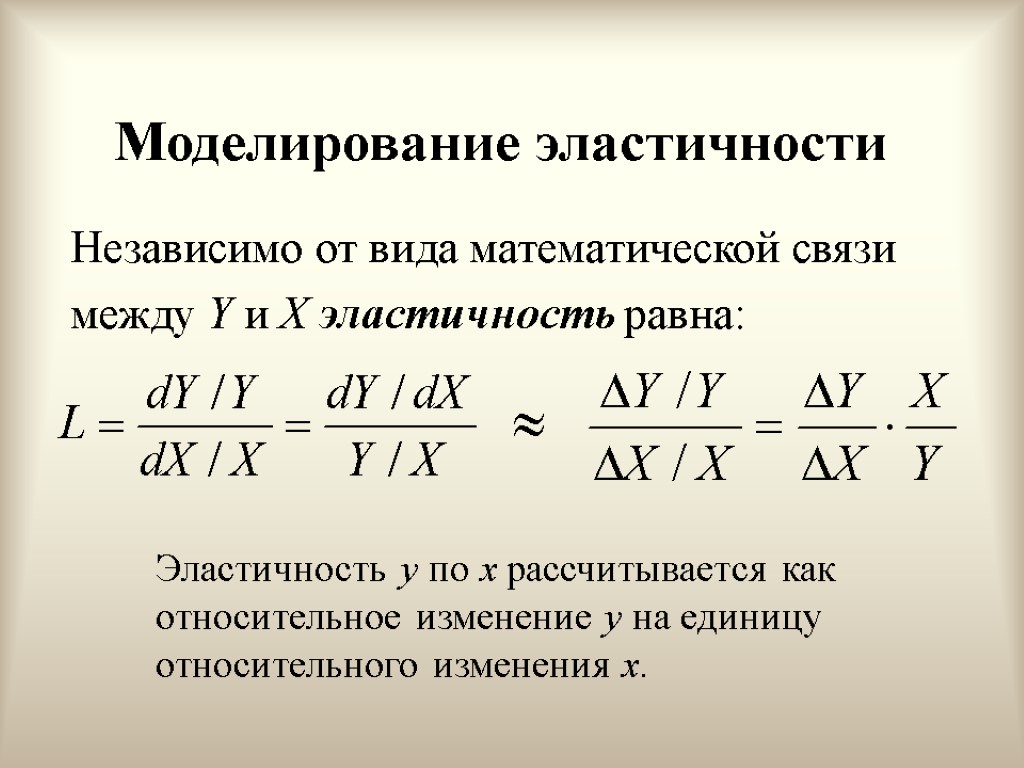

Моделирование эластичности Независимо от вида математической связи между Y и X эластичность равна: Эластичность y по x рассчитывается как относительное изменение y на единицу относительного изменения x.

Моделирование эластичности Независимо от вида математической связи между Y и X эластичность равна: Эластичность y по x рассчитывается как относительное изменение y на единицу относительного изменения x.

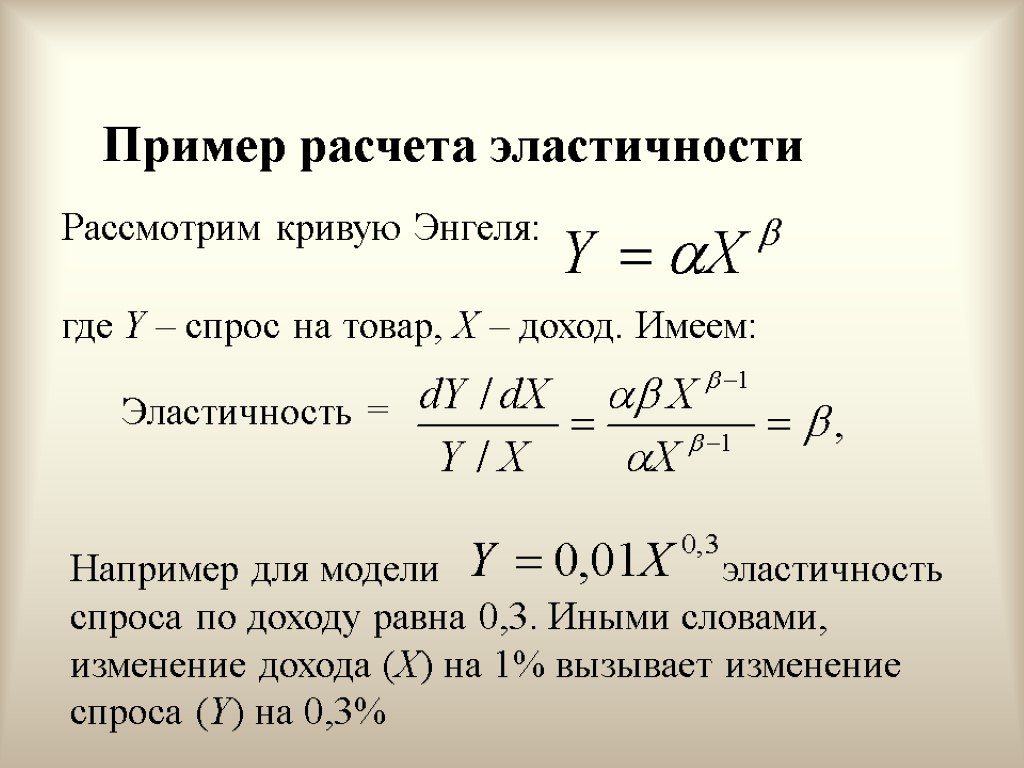

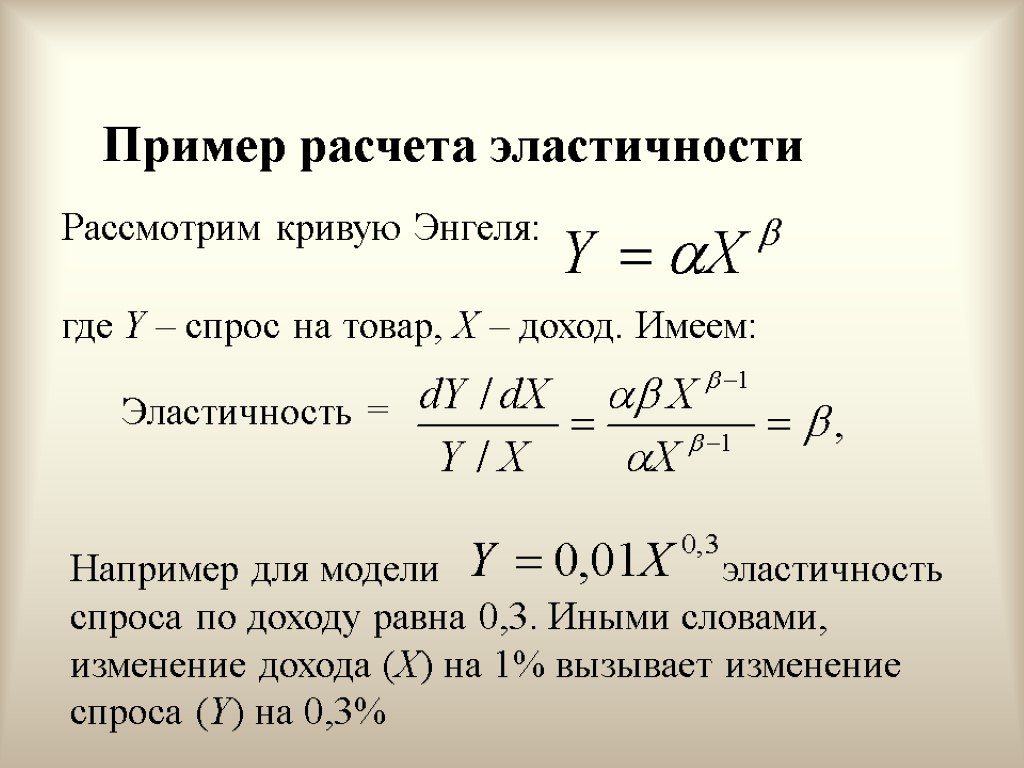

Пример расчета эластичности Рассмотрим кривую Энгеля: где Y – спрос на товар, X – доход. Имеем: Эластичность = Например для модели эластичность спроса по доходу равна 0,3. Иными словами, изменение дохода (X) на 1% вызывает изменение спроса (Y) на 0,3%

Пример расчета эластичности Рассмотрим кривую Энгеля: где Y – спрос на товар, X – доход. Имеем: Эластичность = Например для модели эластичность спроса по доходу равна 0,3. Иными словами, изменение дохода (X) на 1% вызывает изменение спроса (Y) на 0,3%

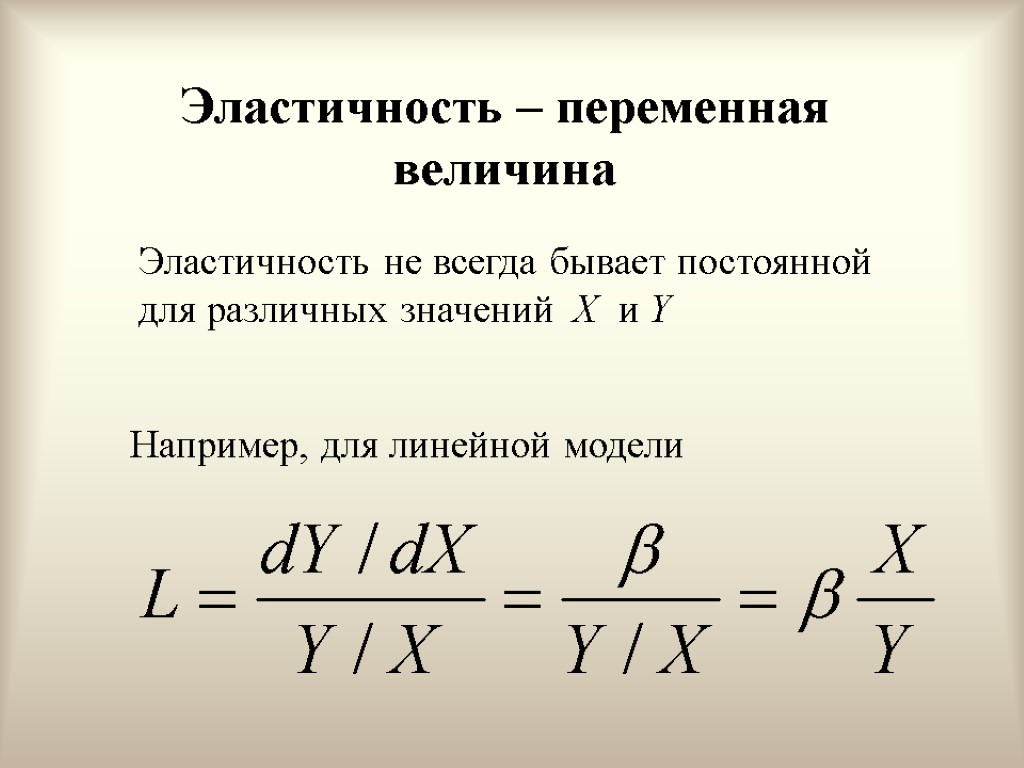

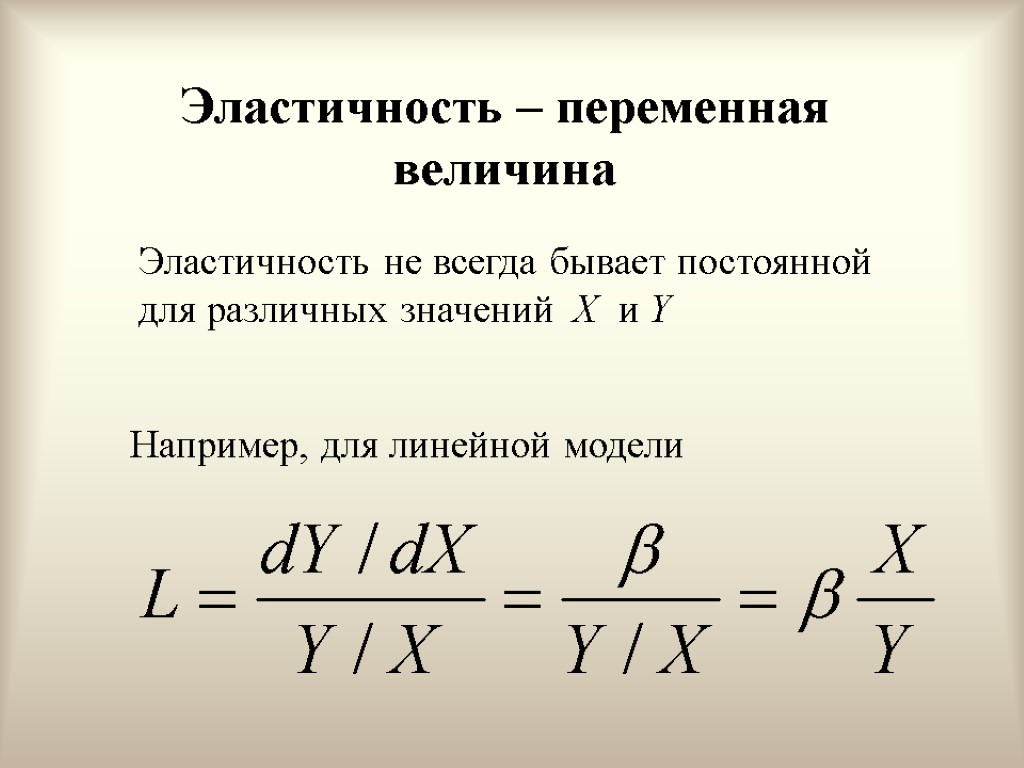

Эластичность – переменная величина Например, для линейной модели Эластичность не всегда бывает постоянной для различных значений X и Y

Эластичность – переменная величина Например, для линейной модели Эластичность не всегда бывает постоянной для различных значений X и Y

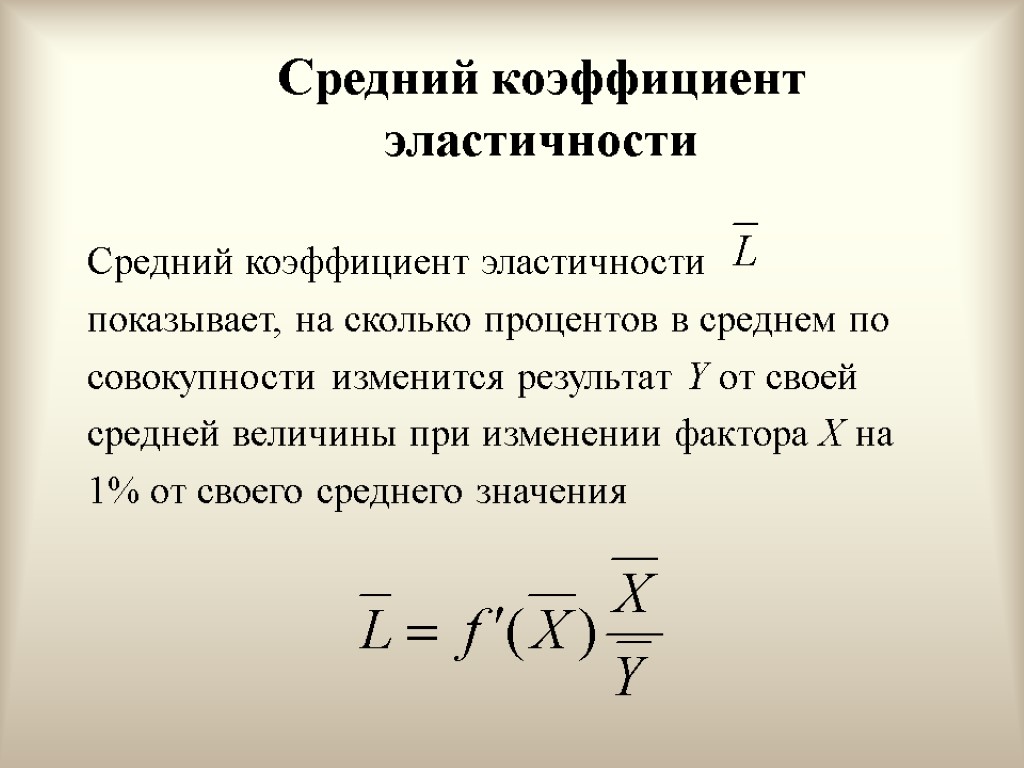

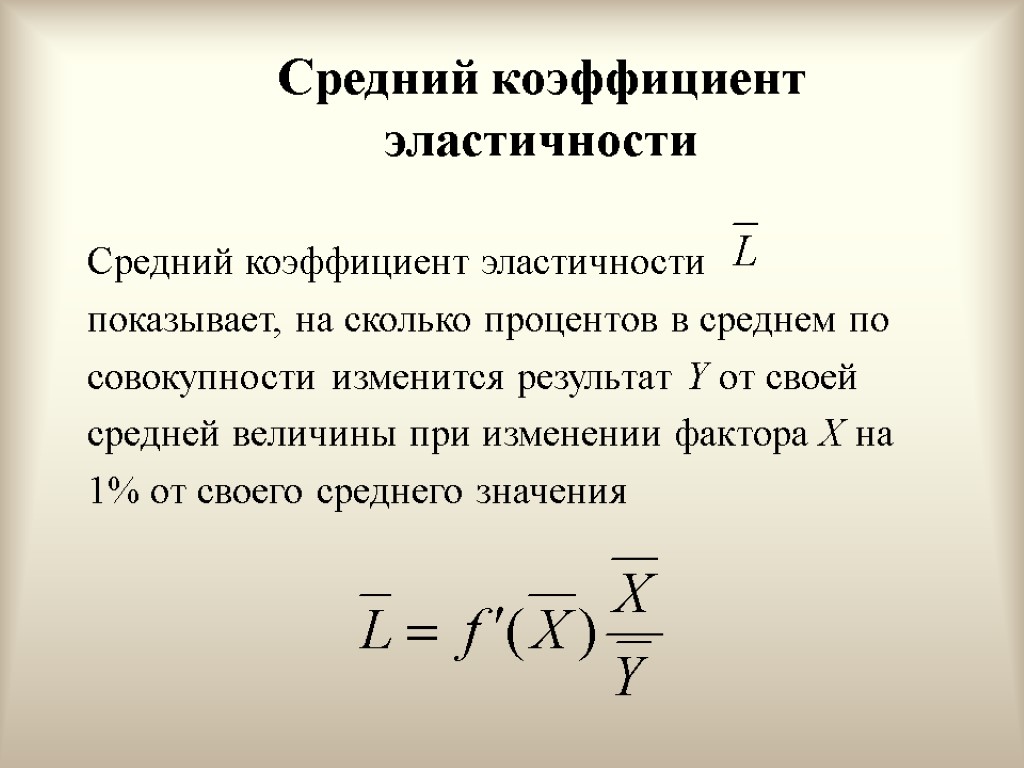

Средний коэффициент эластичности Средний коэффициент эластичности показывает, на сколько процентов в среднем по совокупности изменится результат Y от своей средней величины при изменении фактора X на 1% от своего среднего значения

Средний коэффициент эластичности Средний коэффициент эластичности показывает, на сколько процентов в среднем по совокупности изменится результат Y от своей средней величины при изменении фактора X на 1% от своего среднего значения

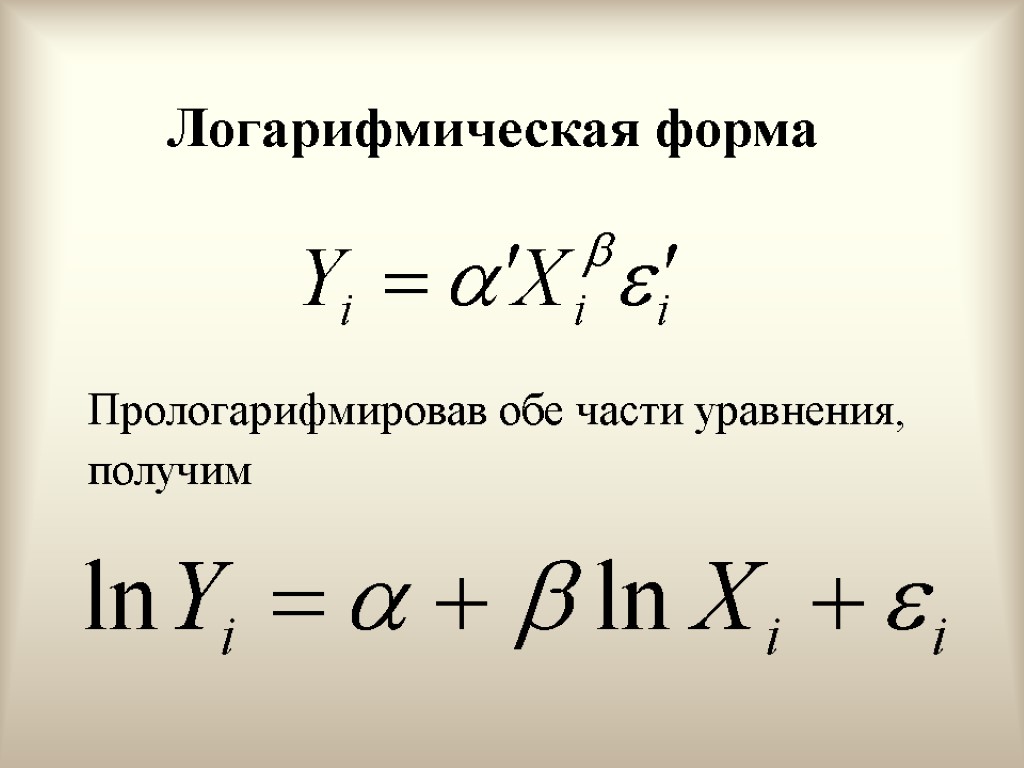

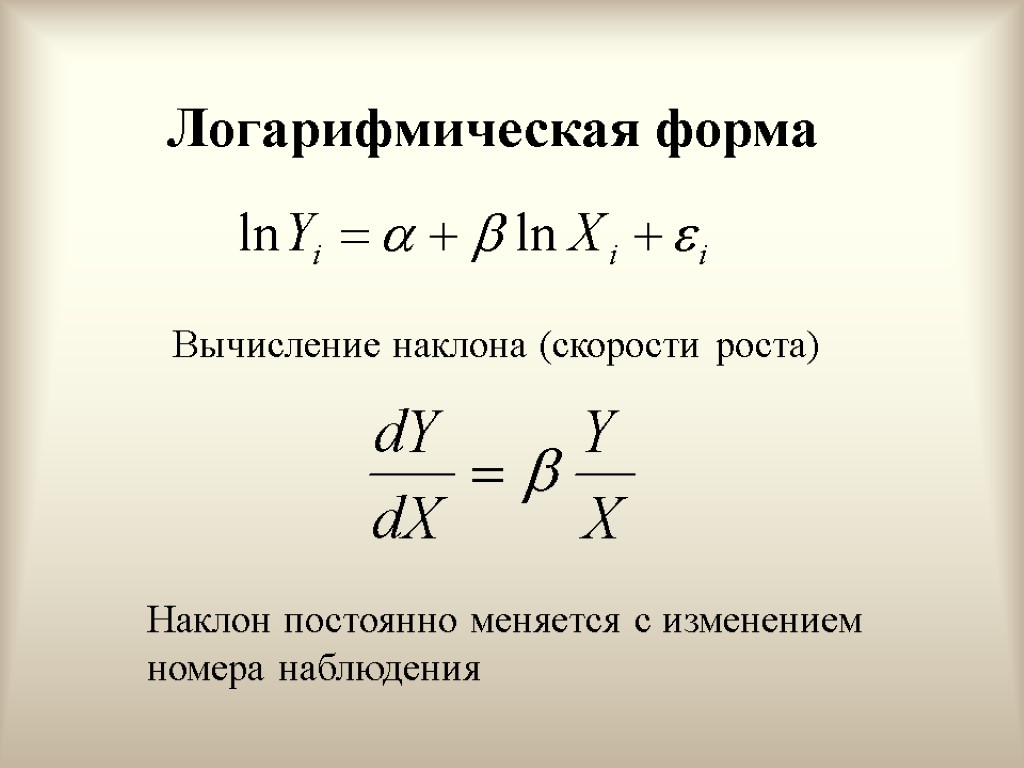

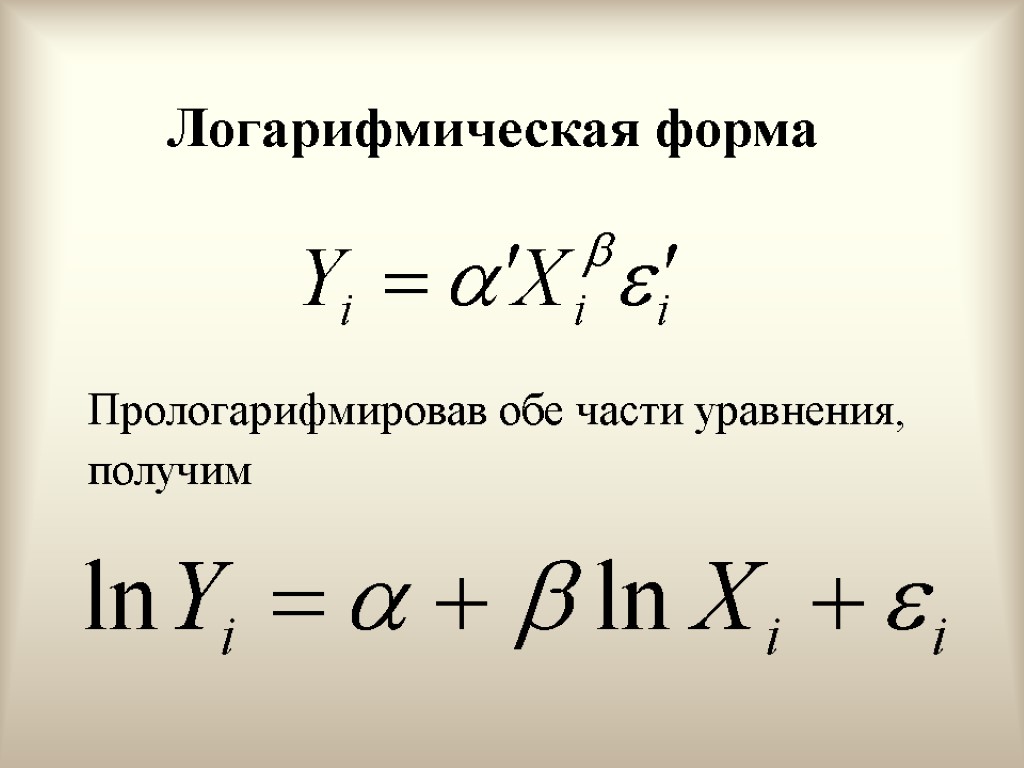

Логарифмическая форма Прологарифмировав обе части уравнения, получим

Логарифмическая форма Прологарифмировав обе части уравнения, получим

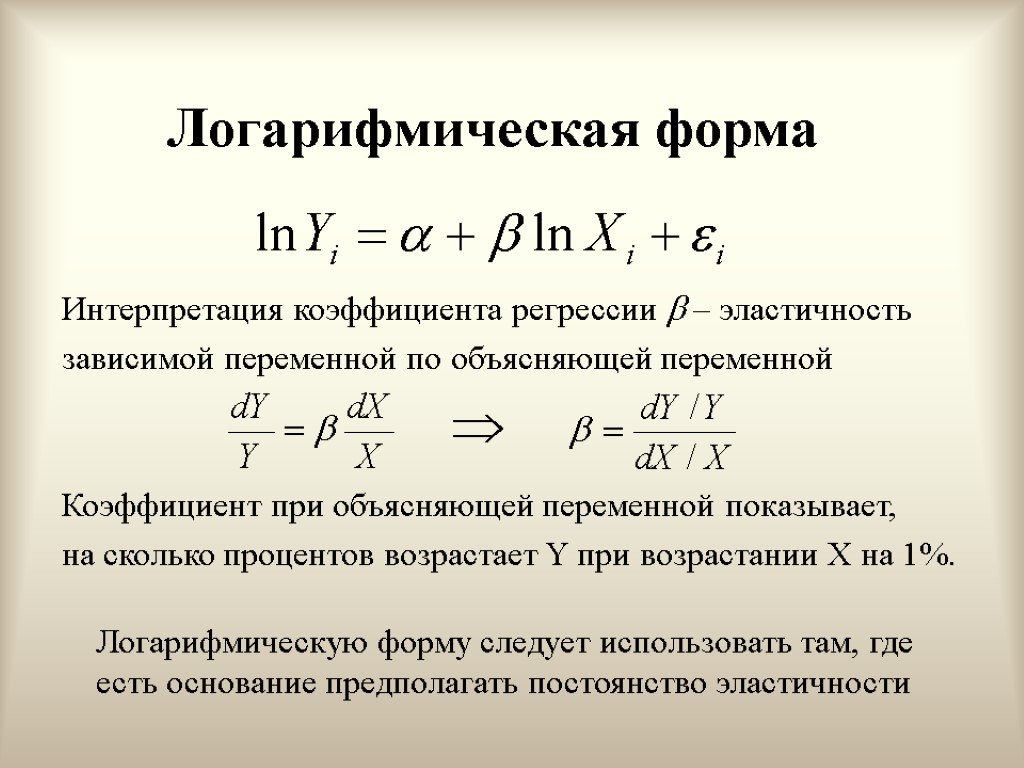

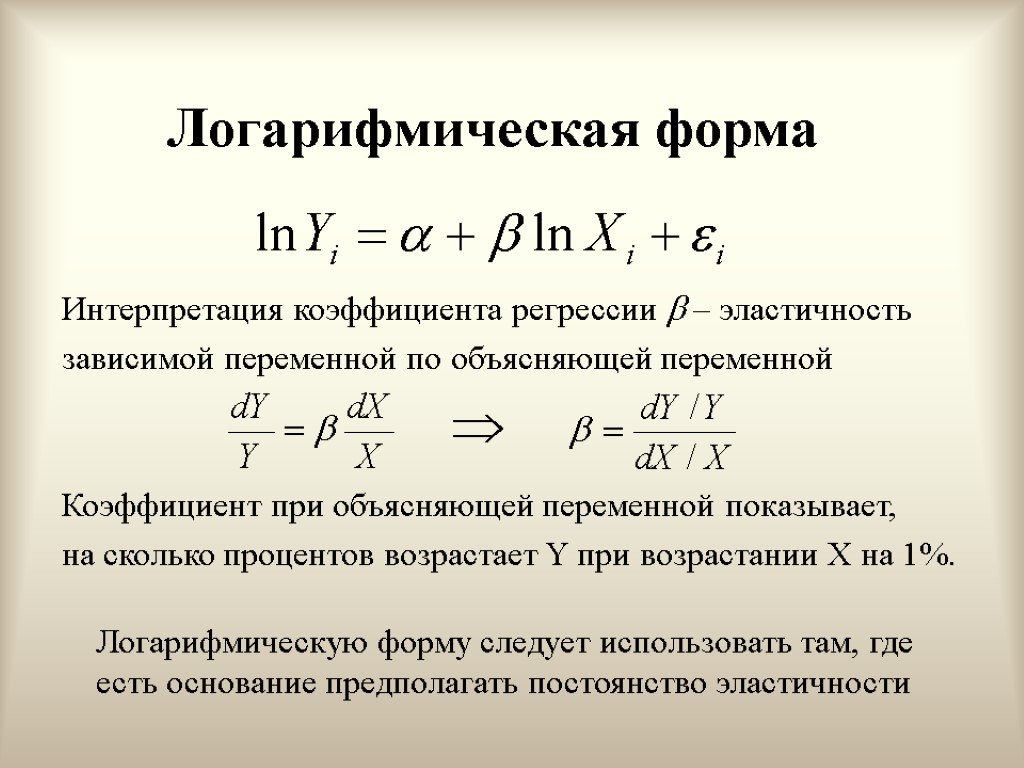

Логарифмическая форма Интерпретация коэффициента регрессии – эластичность зависимой переменной по объясняющей переменной Коэффициент при объясняющей переменной показывает, на сколько процентов возрастает Y при возрастании X на 1%. Логарифмическую форму следует использовать там, где есть основание предполагать постоянство эластичности

Логарифмическая форма Интерпретация коэффициента регрессии – эластичность зависимой переменной по объясняющей переменной Коэффициент при объясняющей переменной показывает, на сколько процентов возрастает Y при возрастании X на 1%. Логарифмическую форму следует использовать там, где есть основание предполагать постоянство эластичности

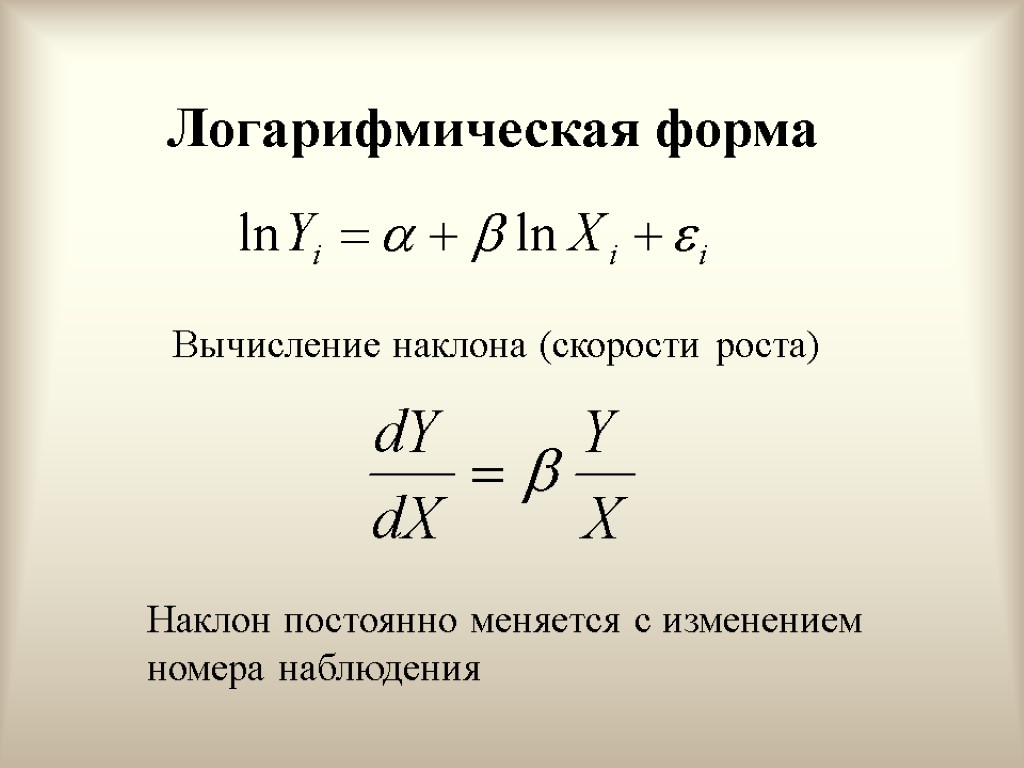

Логарифмическая форма Вычисление наклона (скорости роста) Наклон постоянно меняется с изменением номера наблюдения

Логарифмическая форма Вычисление наклона (скорости роста) Наклон постоянно меняется с изменением номера наблюдения

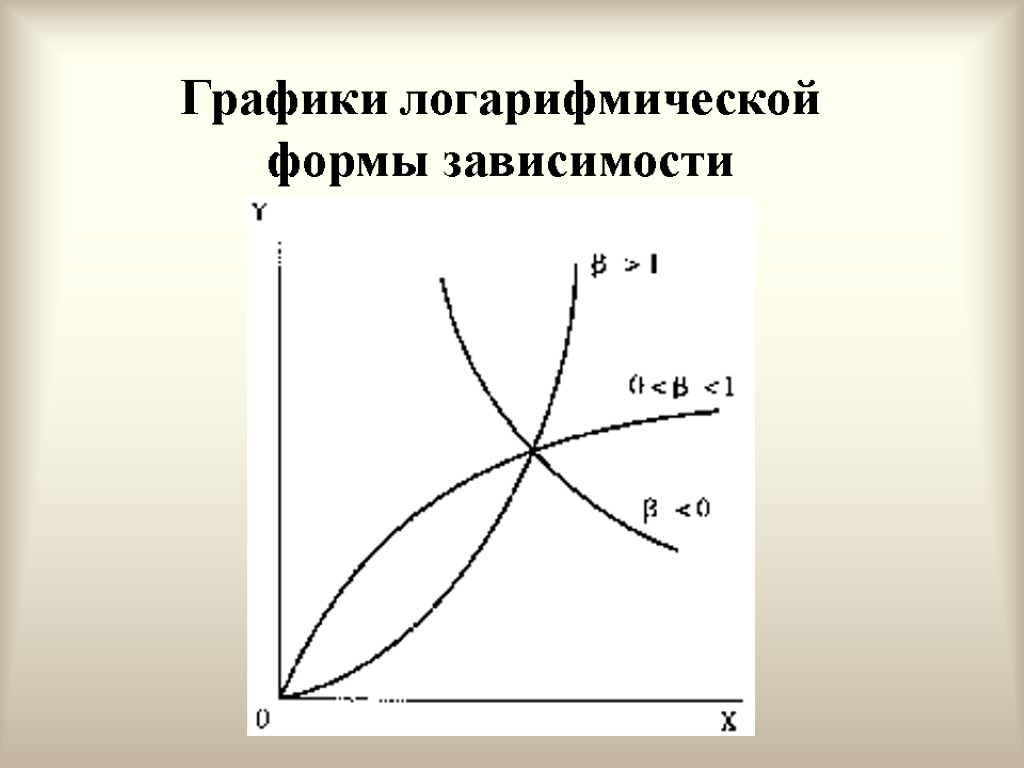

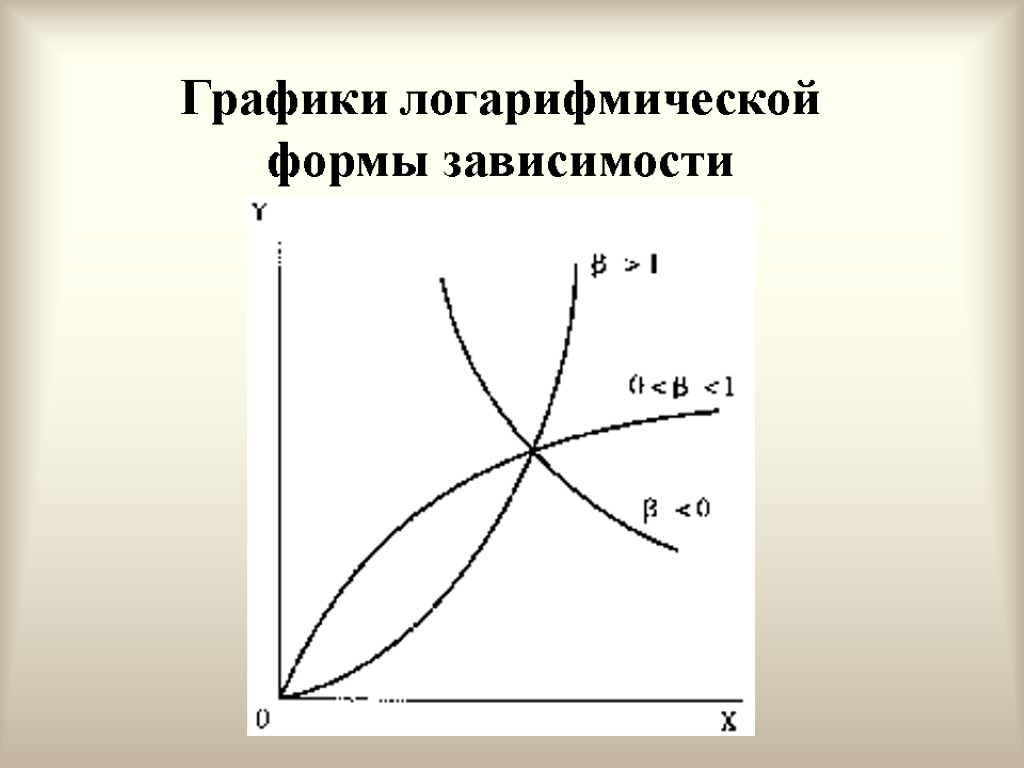

Графики логарифмической формы зависимости

Графики логарифмической формы зависимости

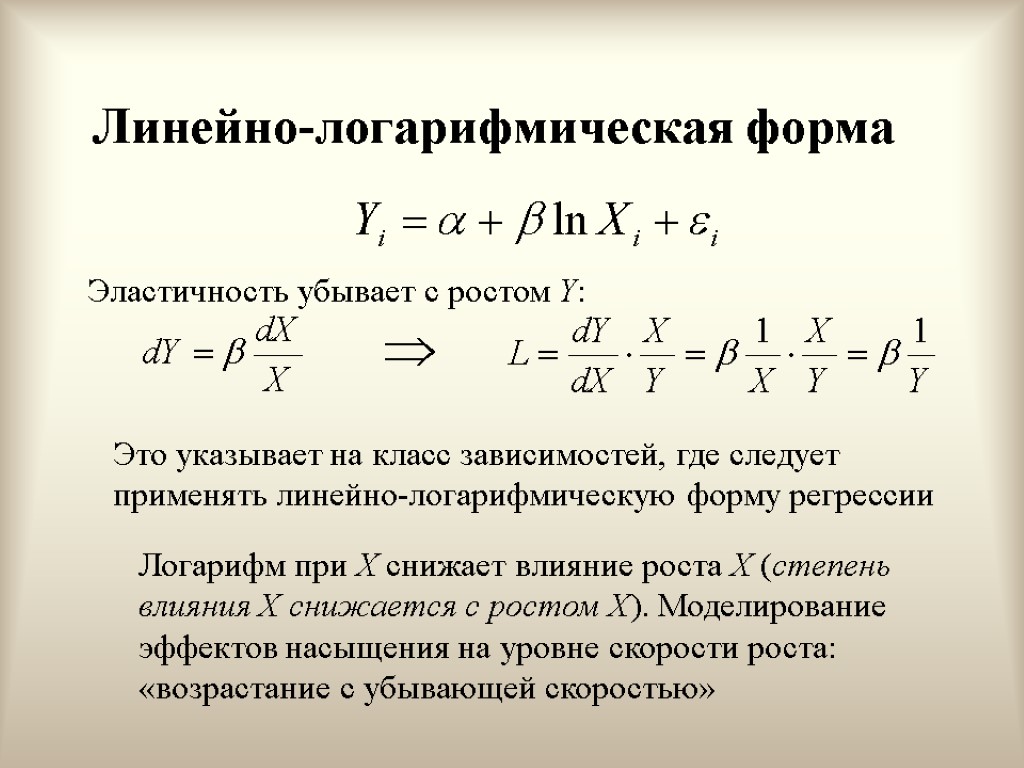

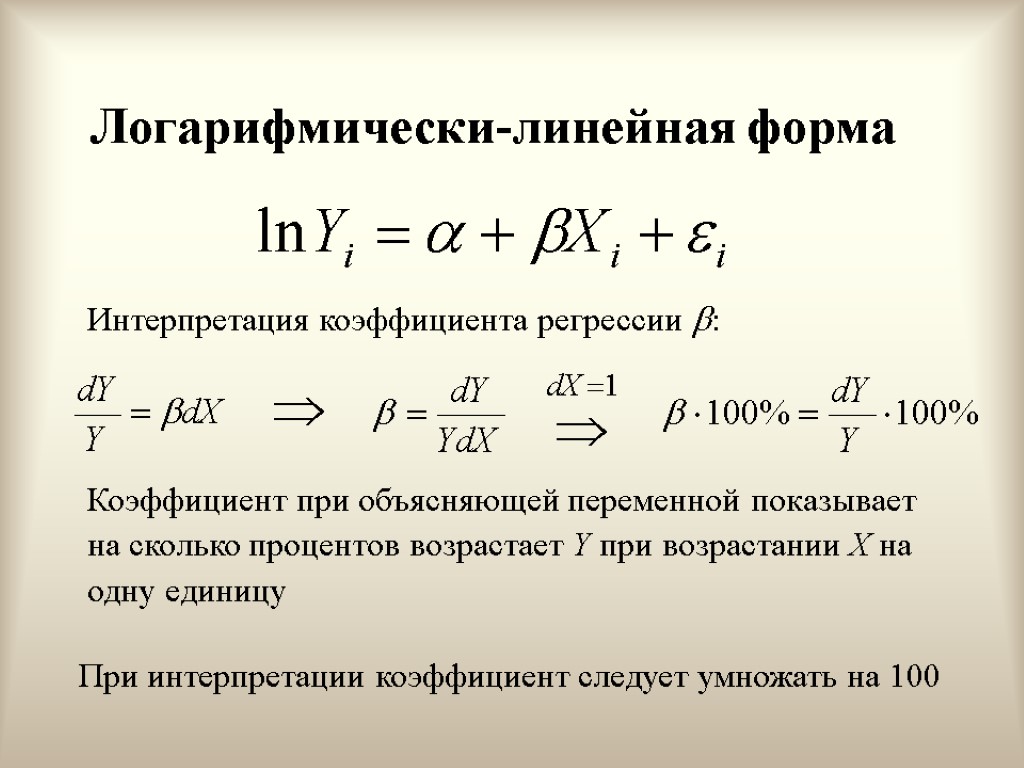

Полулогарифмические формы 1. Линейно-логарифмическая форма (логарифм при объясняющей переменной) 2. Логарифмически-линейная форма (логарифм при зависимой переменной)

Полулогарифмические формы 1. Линейно-логарифмическая форма (логарифм при объясняющей переменной) 2. Логарифмически-линейная форма (логарифм при зависимой переменной)

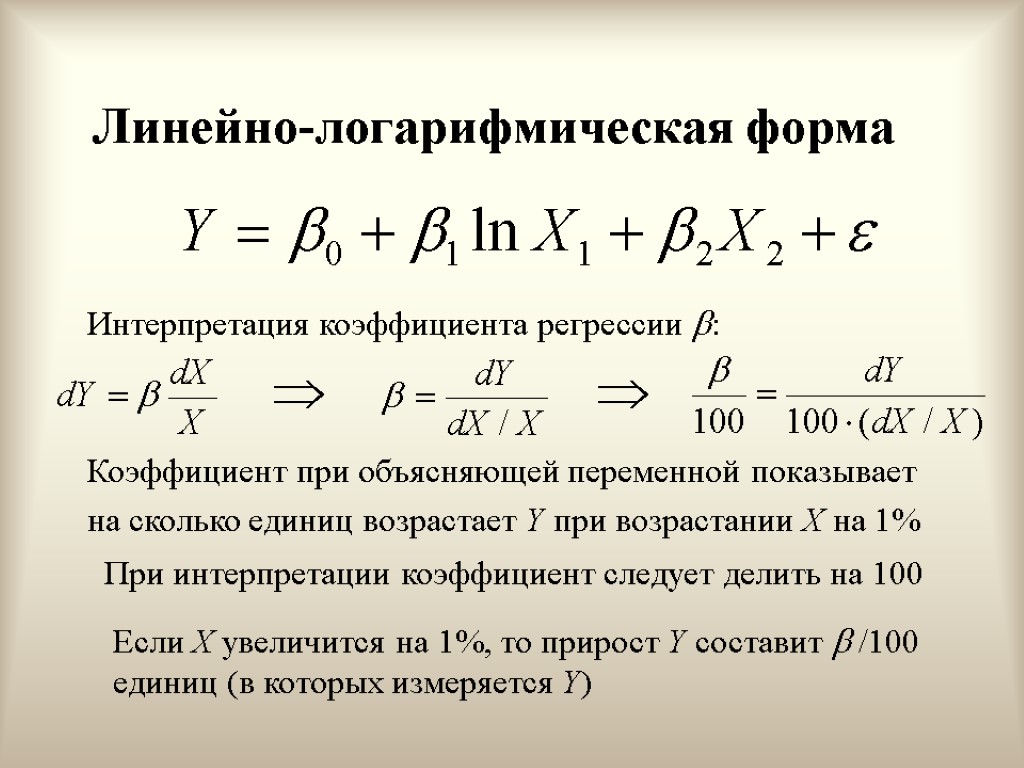

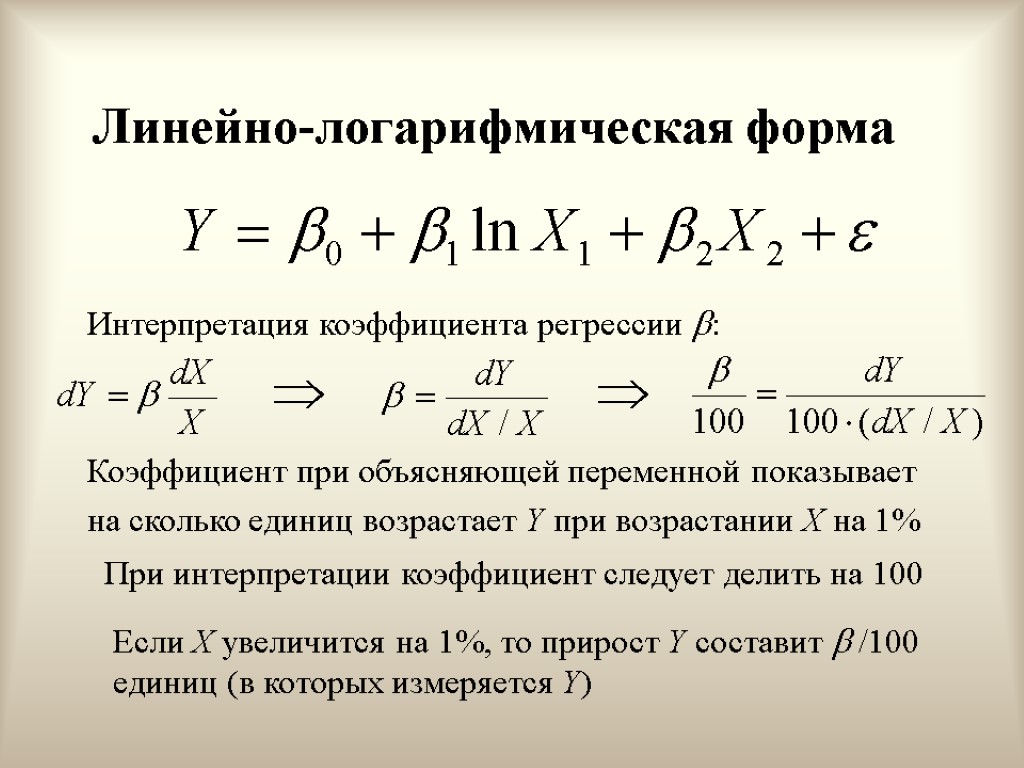

Линейно-логарифмическая форма Интерпретация коэффициента регрессии : Коэффициент при объясняющей переменной показывает на сколько единиц возрастает Y при возрастании X на 1% При интерпретации коэффициент следует делить на 100 Если X увеличится на 1%, то прирост Y составит /100 единиц (в которых измеряется Y)

Линейно-логарифмическая форма Интерпретация коэффициента регрессии : Коэффициент при объясняющей переменной показывает на сколько единиц возрастает Y при возрастании X на 1% При интерпретации коэффициент следует делить на 100 Если X увеличится на 1%, то прирост Y составит /100 единиц (в которых измеряется Y)

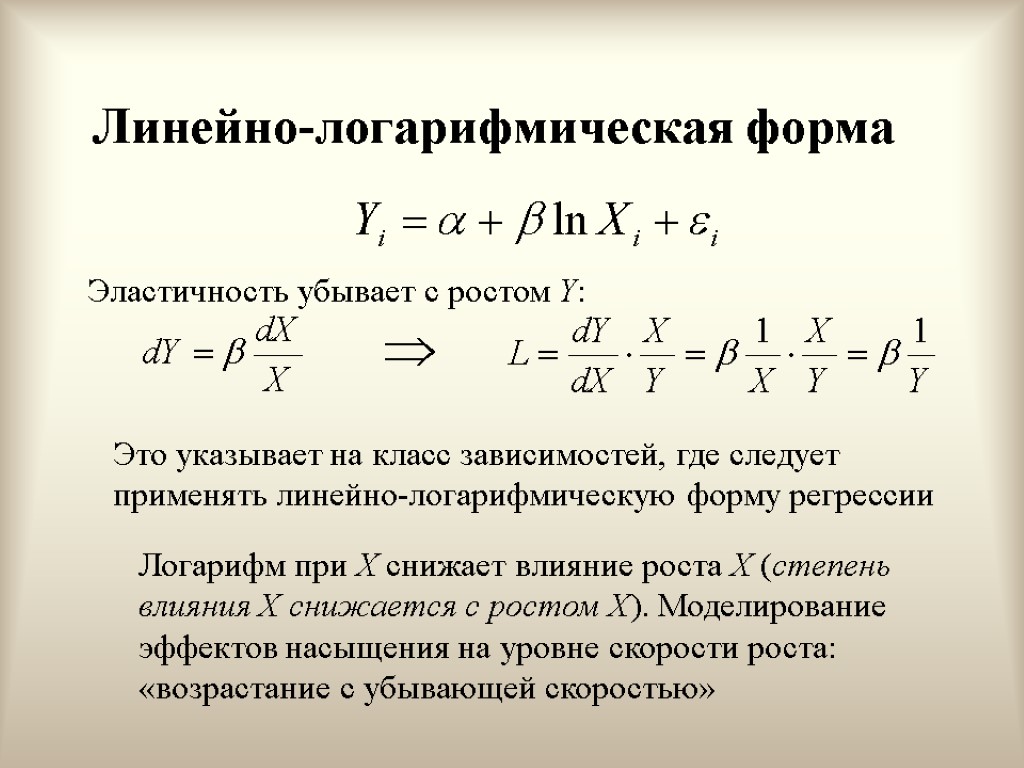

Линейно-логарифмическая форма Эластичность убывает с ростом Y: Это указывает на класс зависимостей, где следует применять линейно-логарифмическую форму регрессии Логарифм при X снижает влияние роста X (степень влияния X снижается с ростом X). Моделирование эффектов насыщения на уровне скорости роста: «возрастание с убывающей скоростью»

Линейно-логарифмическая форма Эластичность убывает с ростом Y: Это указывает на класс зависимостей, где следует применять линейно-логарифмическую форму регрессии Логарифм при X снижает влияние роста X (степень влияния X снижается с ростом X). Моделирование эффектов насыщения на уровне скорости роста: «возрастание с убывающей скоростью»

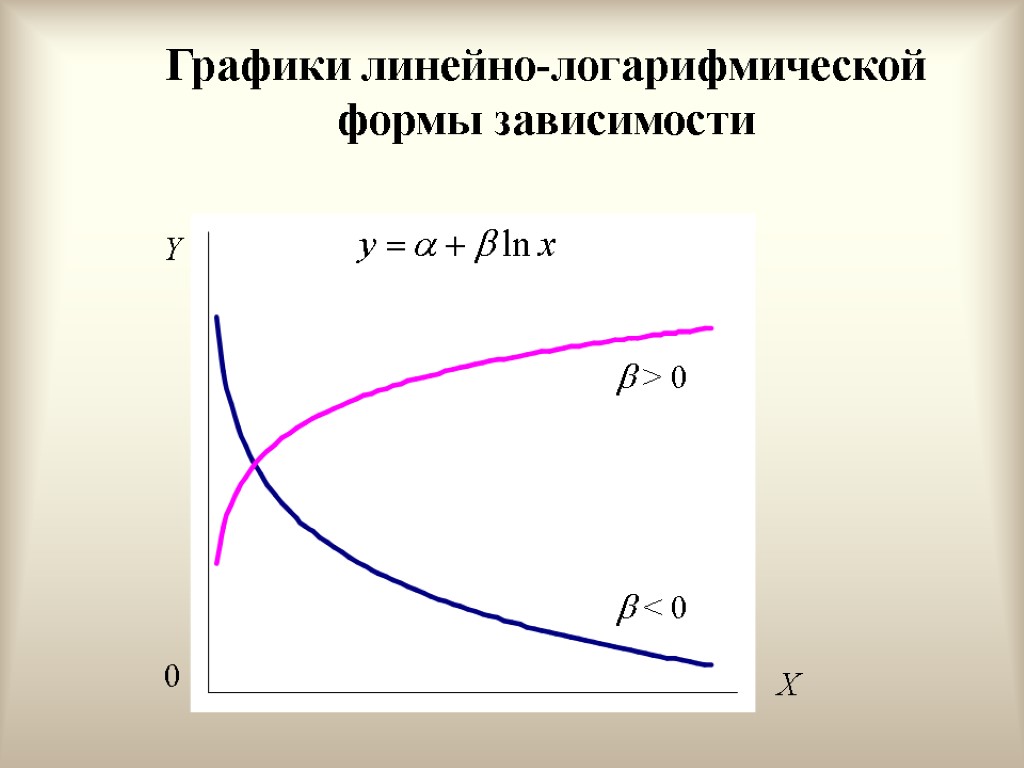

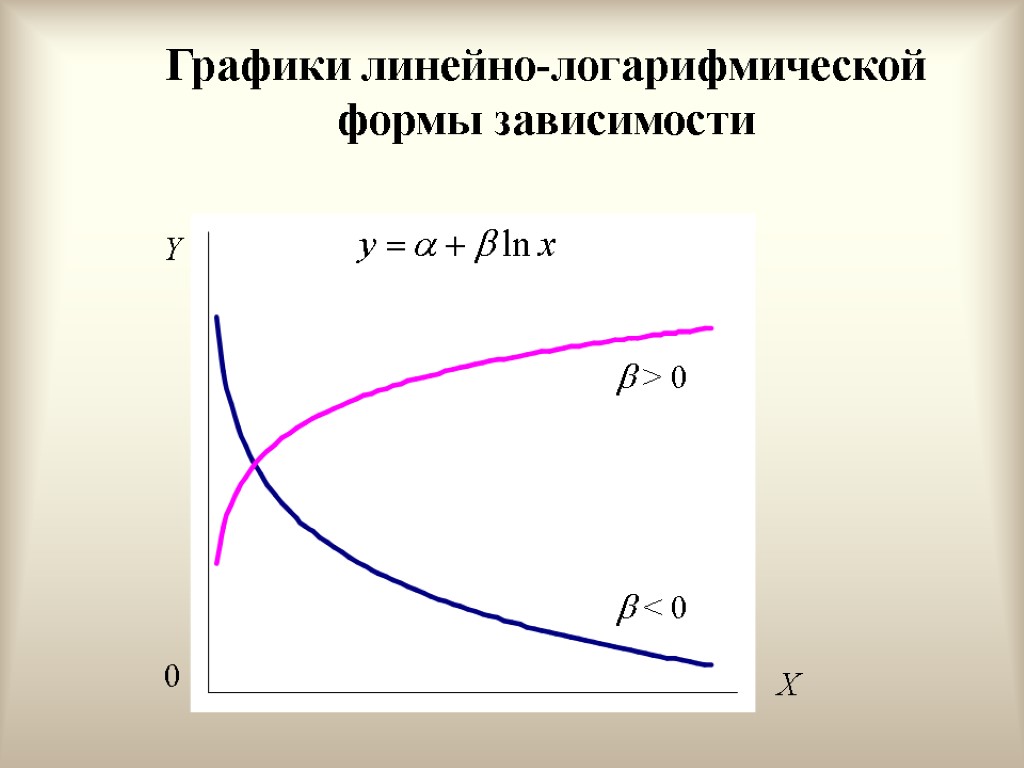

Графики линейно-логарифмической формы зависимости 0 X Y > 0 < 0

Графики линейно-логарифмической формы зависимости 0 X Y > 0 < 0

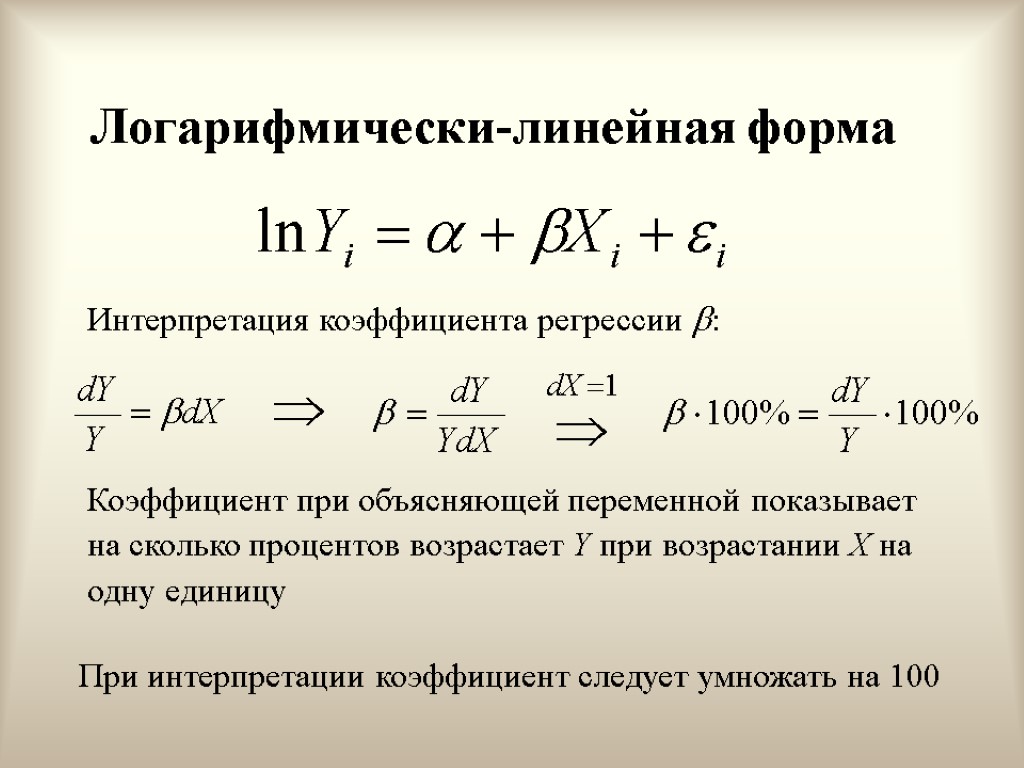

Логарифмически-линейная форма Интерпретация коэффициента регрессии : Коэффициент при объясняющей переменной показывает на сколько процентов возрастает Y при возрастании X на одну единицу При интерпретации коэффициент следует умножать на 100

Логарифмически-линейная форма Интерпретация коэффициента регрессии : Коэффициент при объясняющей переменной показывает на сколько процентов возрастает Y при возрастании X на одну единицу При интерпретации коэффициент следует умножать на 100

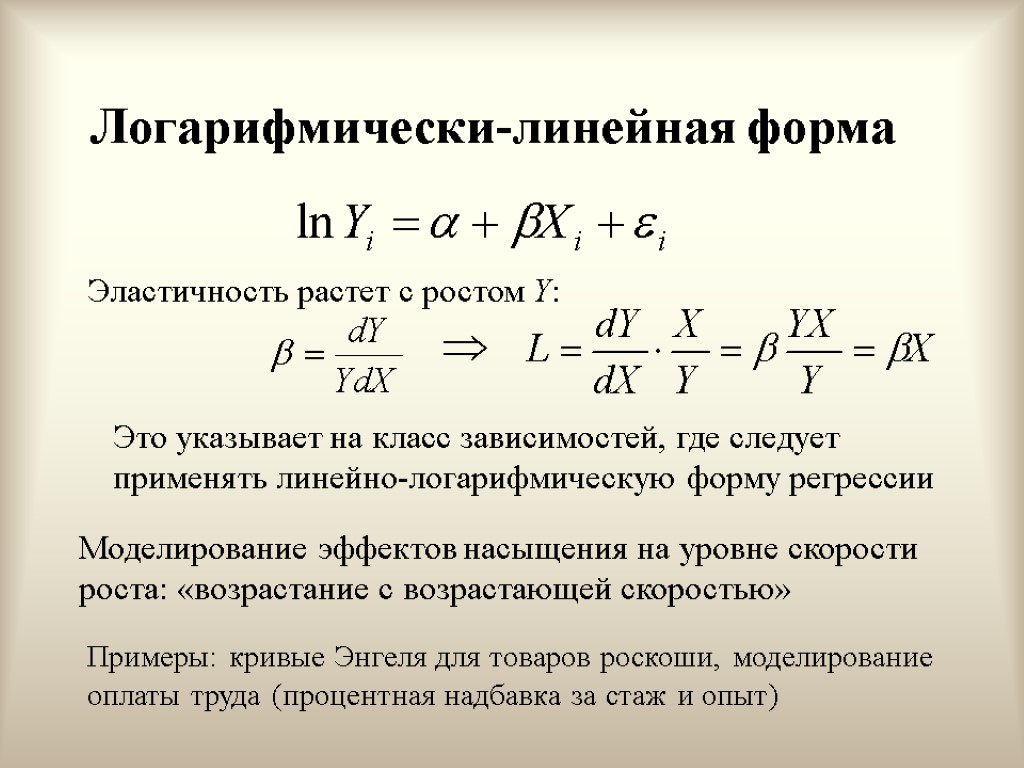

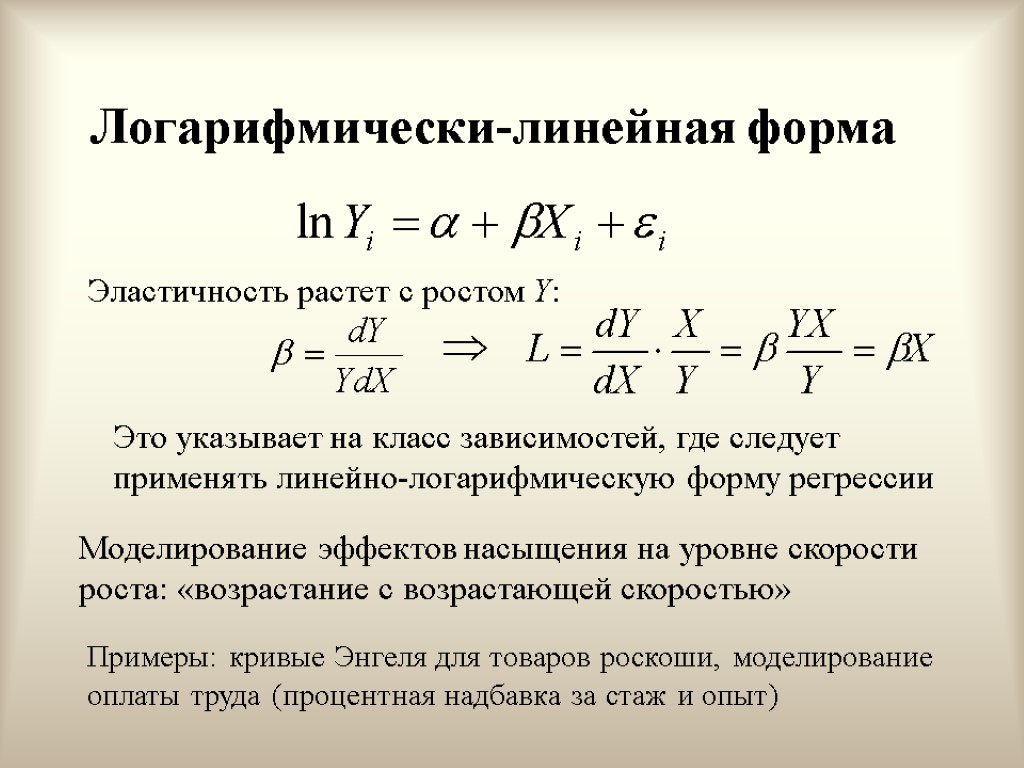

Логарифмически-линейная форма Эластичность растет с ростом Y: Это указывает на класс зависимостей, где следует применять линейно-логарифмическую форму регрессии Моделирование эффектов насыщения на уровне скорости роста: «возрастание с возрастающей скоростью» Примеры: кривые Энгеля для товаров роскоши, моделирование оплаты труда (процентная надбавка за стаж и опыт)

Логарифмически-линейная форма Эластичность растет с ростом Y: Это указывает на класс зависимостей, где следует применять линейно-логарифмическую форму регрессии Моделирование эффектов насыщения на уровне скорости роста: «возрастание с возрастающей скоростью» Примеры: кривые Энгеля для товаров роскоши, моделирование оплаты труда (процентная надбавка за стаж и опыт)

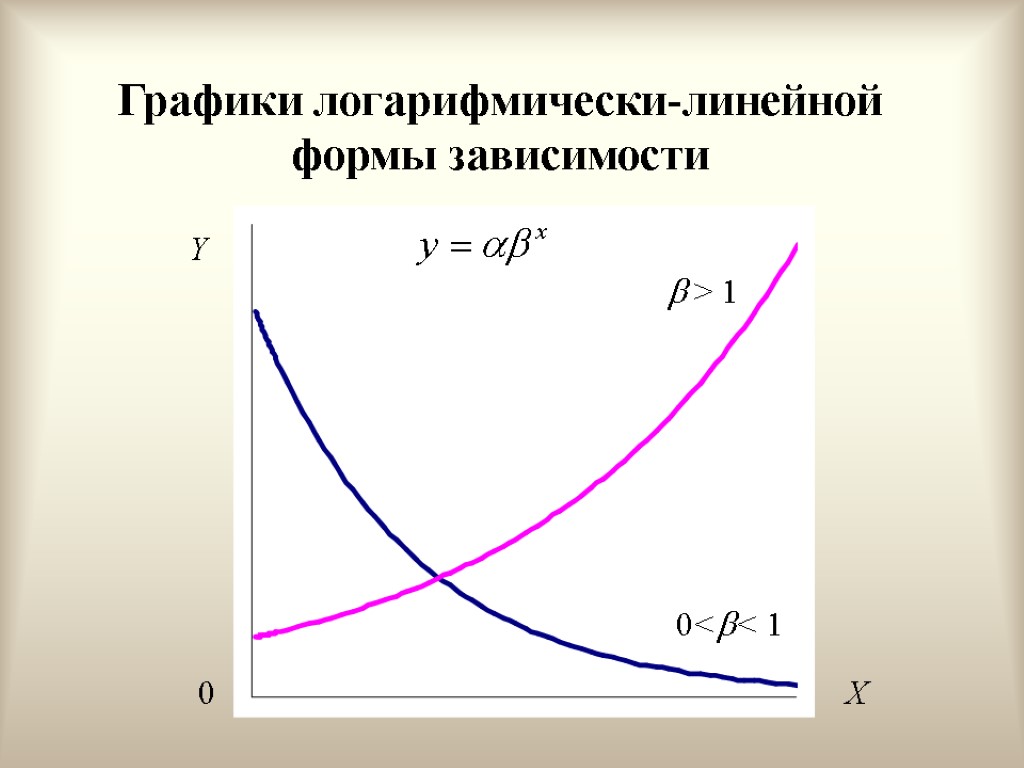

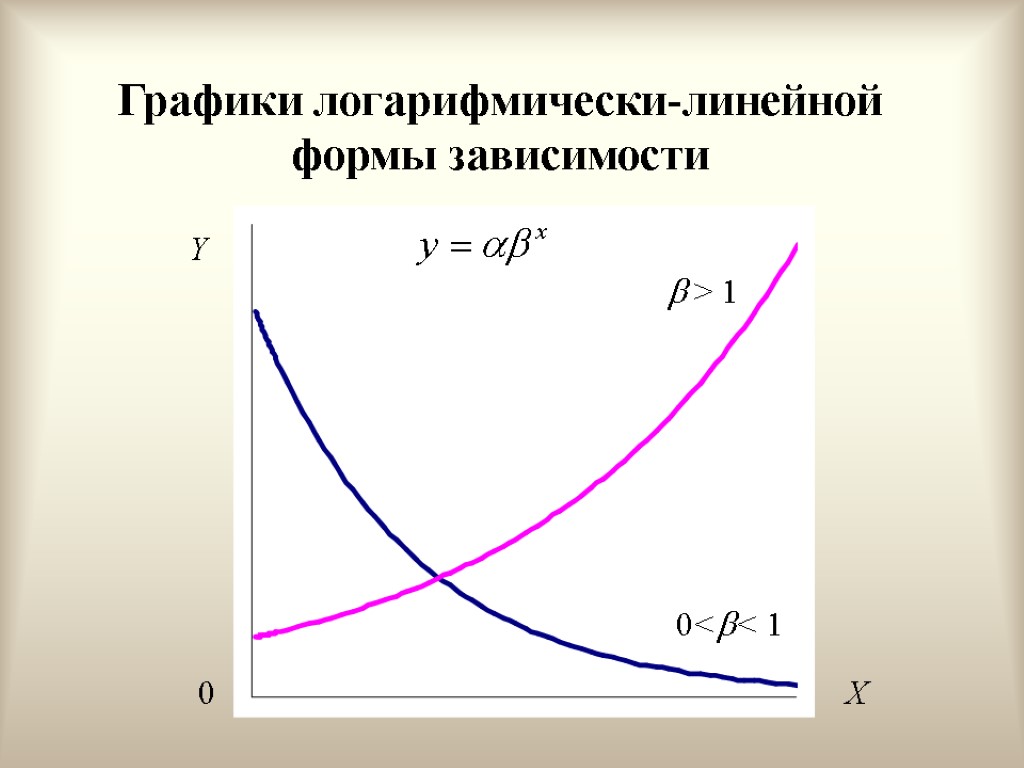

Графики логарифмически-линейной формы зависимости Y > 1 0<< 1 X 0

Графики логарифмически-линейной формы зависимости Y > 1 0<< 1 X 0

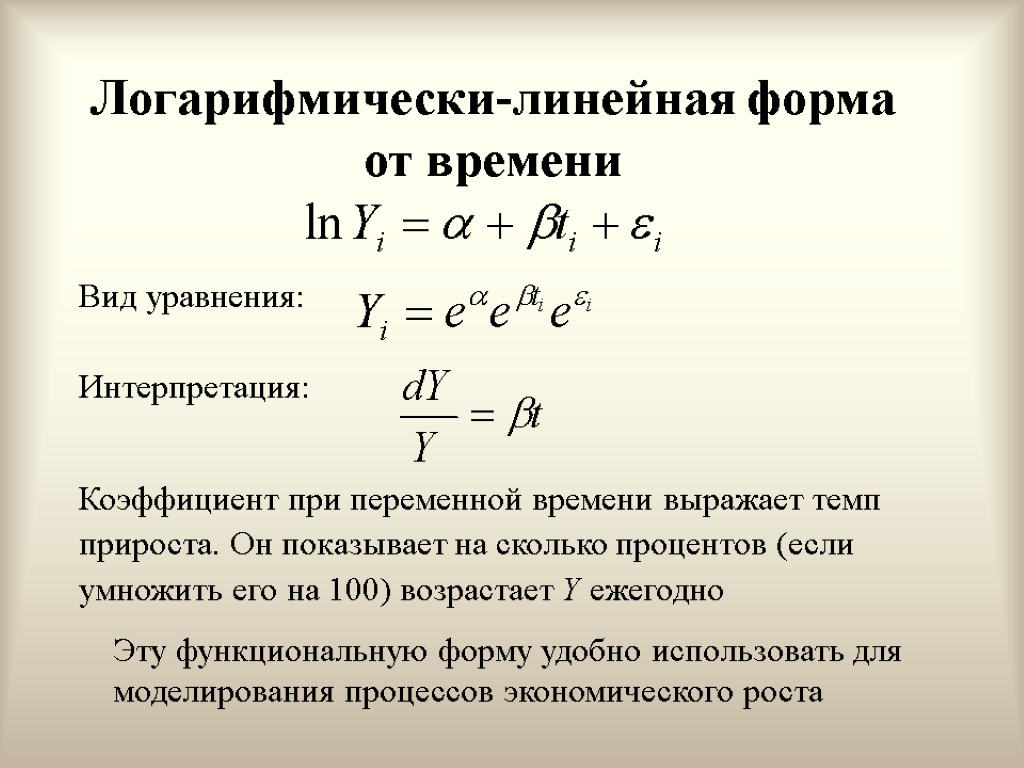

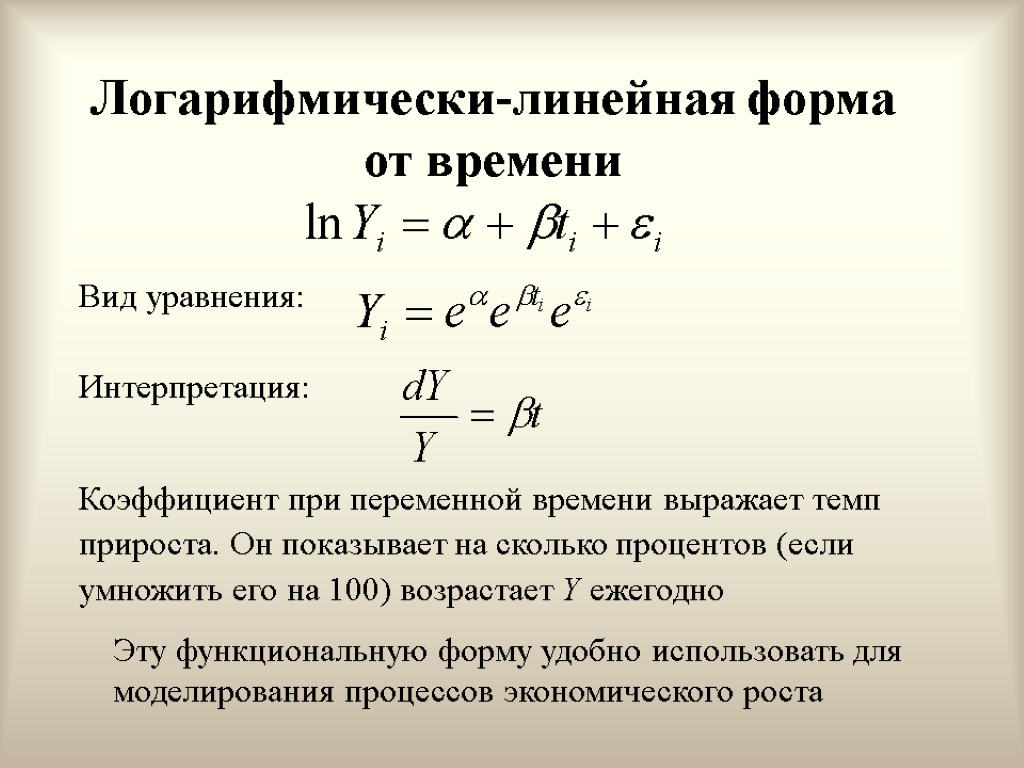

Логарифмически-линейная форма от времени Вид уравнения: Интерпретация: Коэффициент при переменной времени выражает темп прироста. Он показывает на сколько процентов (если умножить его на 100) возрастает Y ежегодно Эту функциональную форму удобно использовать для моделирования процессов экономического роста

Логарифмически-линейная форма от времени Вид уравнения: Интерпретация: Коэффициент при переменной времени выражает темп прироста. Он показывает на сколько процентов (если умножить его на 100) возрастает Y ежегодно Эту функциональную форму удобно использовать для моделирования процессов экономического роста

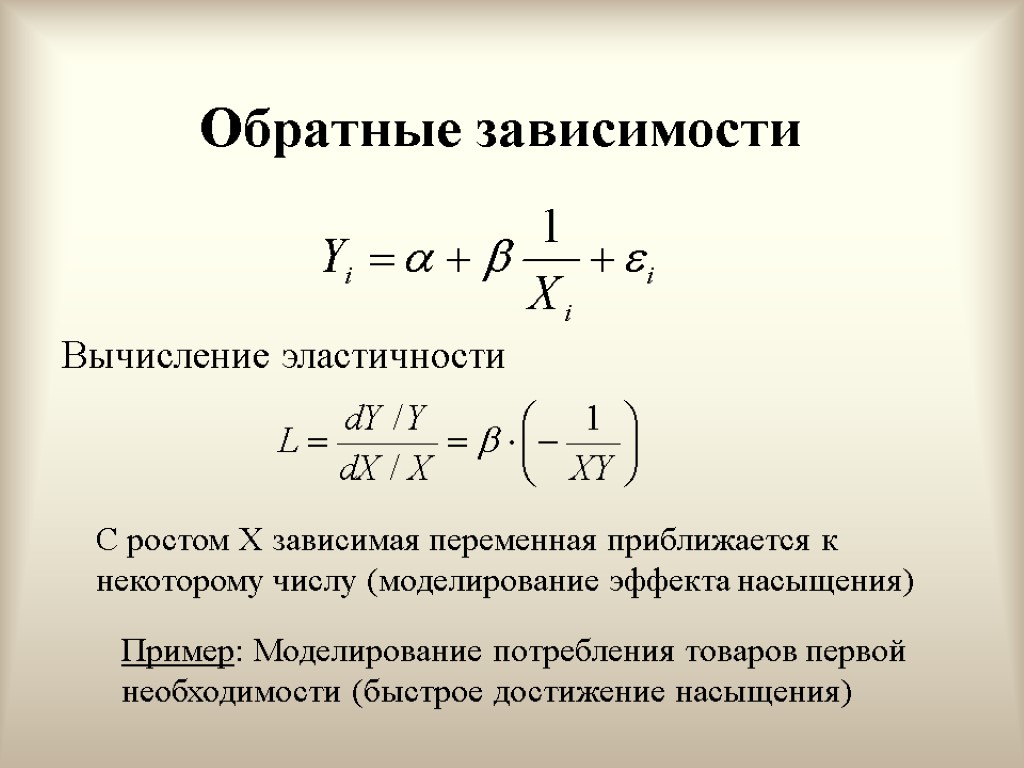

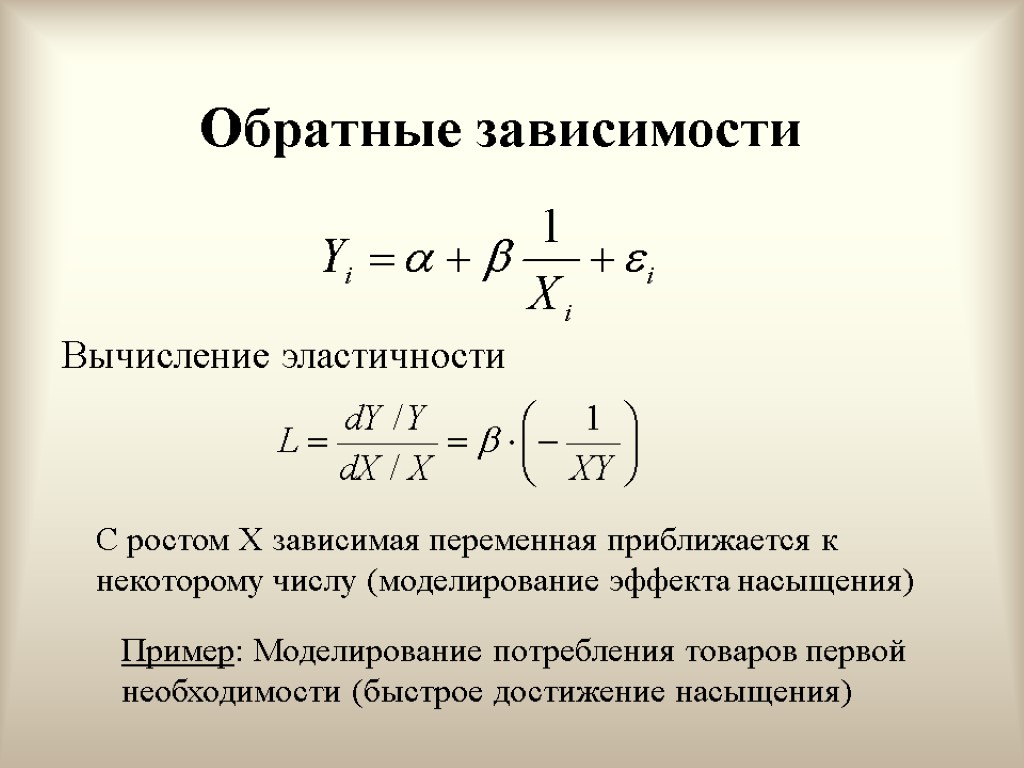

Обратные зависимости Вычисление эластичности С ростом X зависимая переменная приближается к некоторому числу (моделирование эффекта насыщения) Пример: Моделирование потребления товаров первой необходимости (быстрое достижение насыщения)

Обратные зависимости Вычисление эластичности С ростом X зависимая переменная приближается к некоторому числу (моделирование эффекта насыщения) Пример: Моделирование потребления товаров первой необходимости (быстрое достижение насыщения)

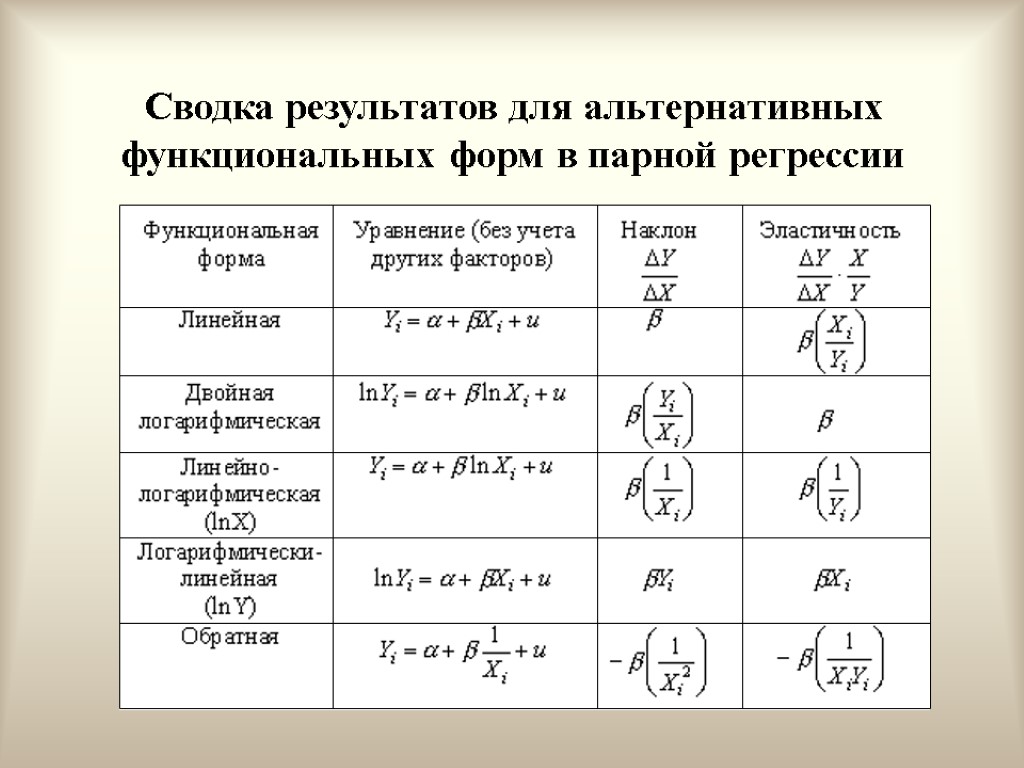

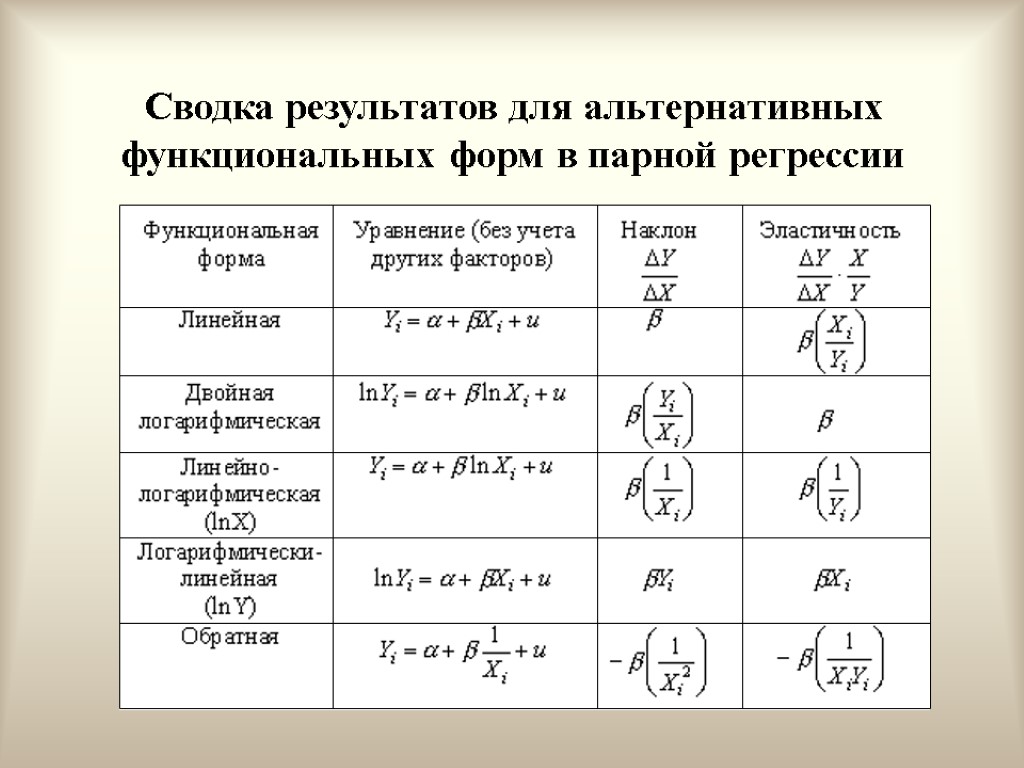

Сводка результатов для альтернативных функциональных форм в парной регрессии

Сводка результатов для альтернативных функциональных форм в парной регрессии

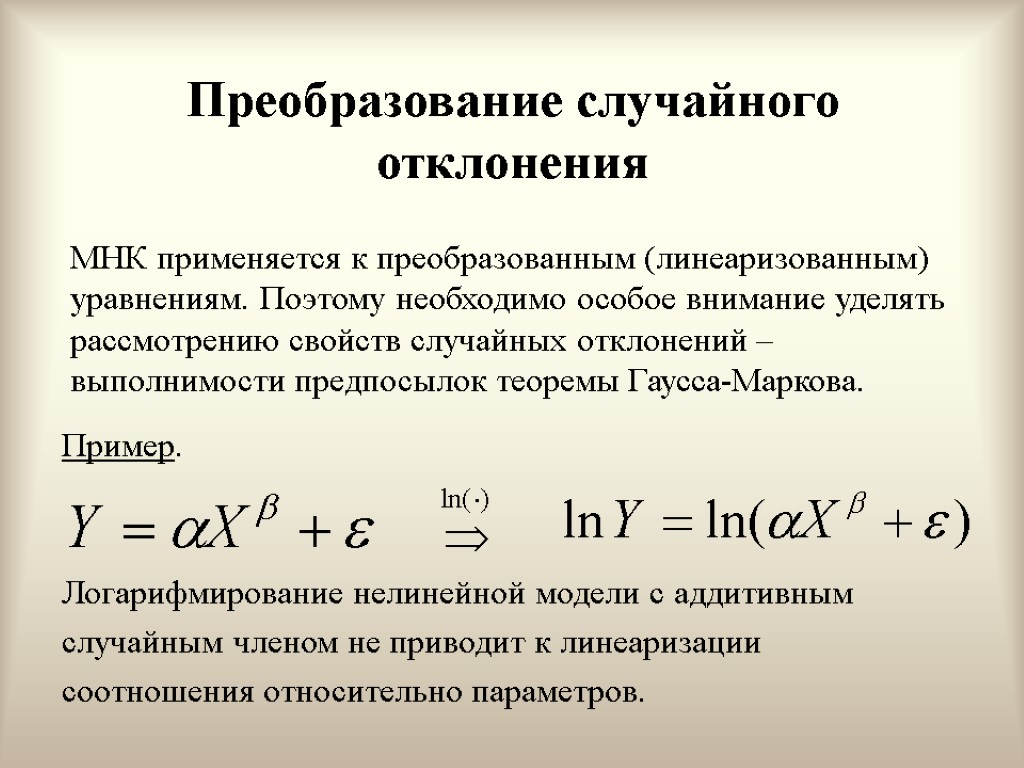

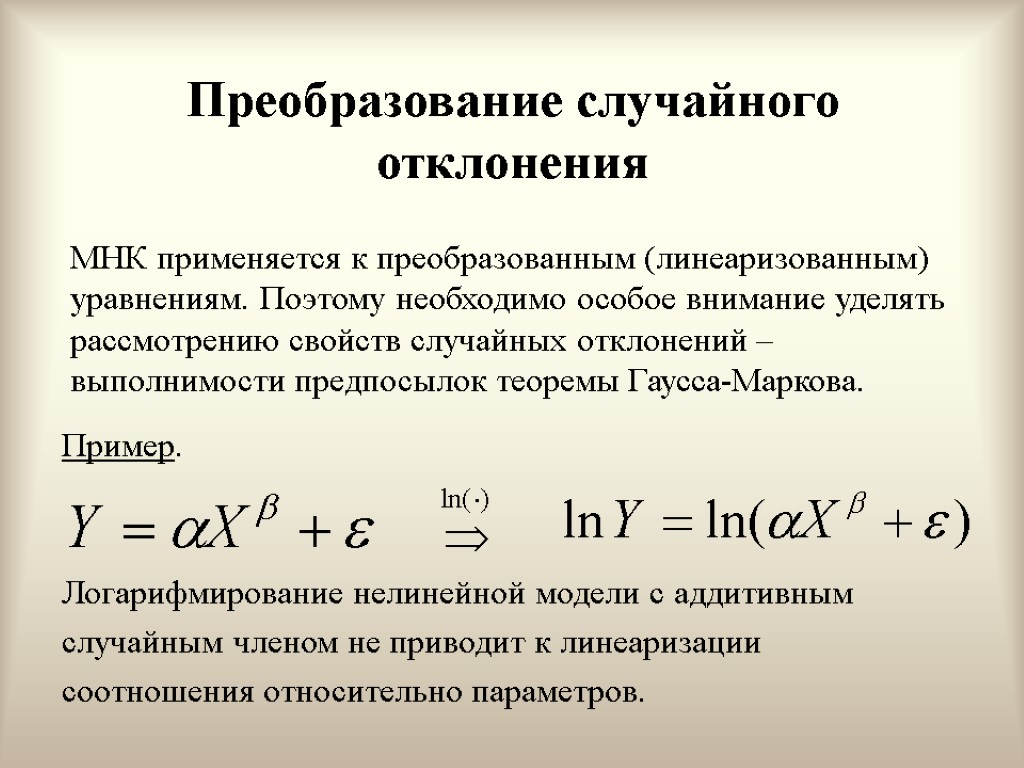

Преобразование случайного отклонения Пример. Логарифмирование нелинейной модели с аддитивным случайным членом не приводит к линеаризации соотношения относительно параметров. МНК применяется к преобразованным (линеаризованным) уравнениям. Поэтому необходимо особое внимание уделять рассмотрению свойств случайных отклонений – выполнимости предпосылок теоремы Гаусса-Маркова.

Преобразование случайного отклонения Пример. Логарифмирование нелинейной модели с аддитивным случайным членом не приводит к линеаризации соотношения относительно параметров. МНК применяется к преобразованным (линеаризованным) уравнениям. Поэтому необходимо особое внимание уделять рассмотрению свойств случайных отклонений – выполнимости предпосылок теоремы Гаусса-Маркова.

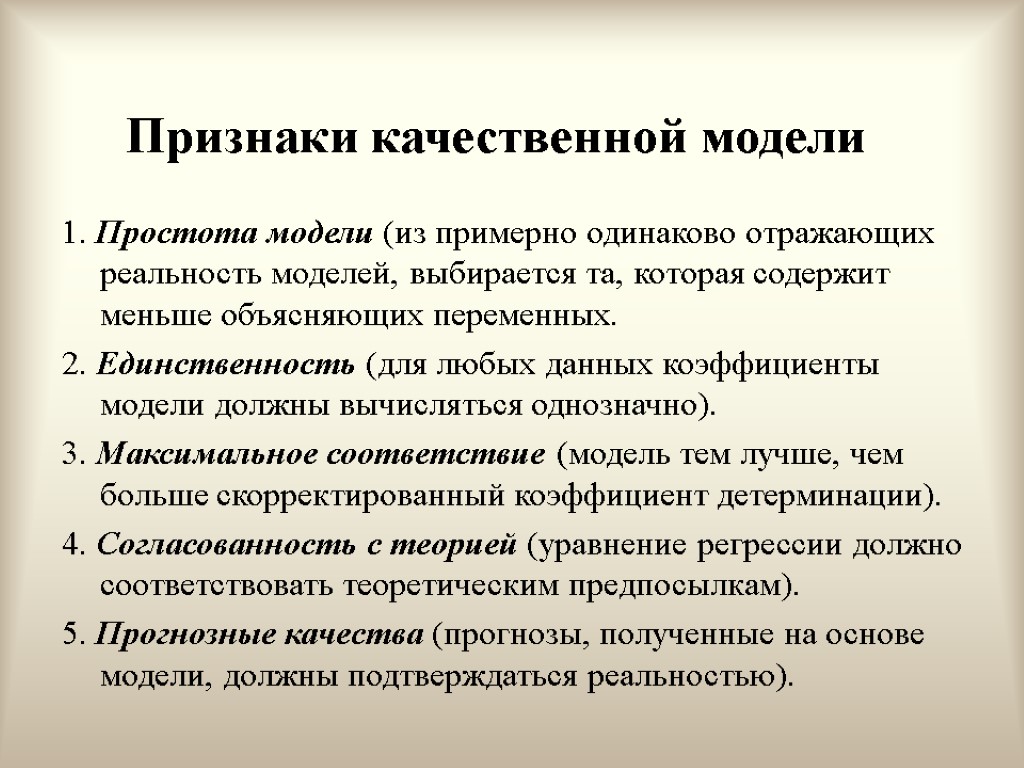

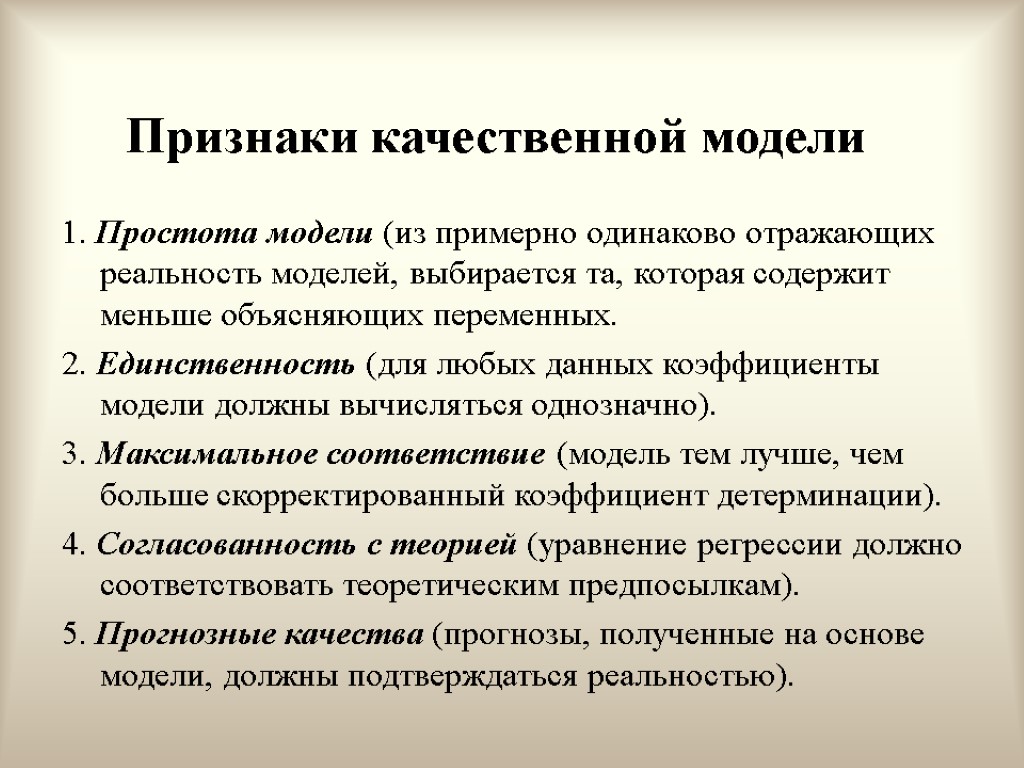

Признаки качественной модели 1. Простота модели (из примерно одинаково отражающих реальность моделей, выбирается та, которая содержит меньше объясняющих переменных. 2. Единственность (для любых данных коэффициенты модели должны вычисляться однозначно). 3. Максимальное соответствие (модель тем лучше, чем больше скорректированный коэффициент детерминации). 4. Согласованность с теорией (уравнение регрессии должно соответствовать теоретическим предпосылкам). 5. Прогнозные качества (прогнозы, полученные на основе модели, должны подтверждаться реальностью).

Признаки качественной модели 1. Простота модели (из примерно одинаково отражающих реальность моделей, выбирается та, которая содержит меньше объясняющих переменных. 2. Единственность (для любых данных коэффициенты модели должны вычисляться однозначно). 3. Максимальное соответствие (модель тем лучше, чем больше скорректированный коэффициент детерминации). 4. Согласованность с теорией (уравнение регрессии должно соответствовать теоретическим предпосылкам). 5. Прогнозные качества (прогнозы, полученные на основе модели, должны подтверждаться реальностью).

Сравнение различных моделей 1. Содержательный анализ 2. Формальный анализ: Метод Зарембки Преобразование Бокса-Кокса

Сравнение различных моделей 1. Содержательный анализ 2. Формальный анализ: Метод Зарембки Преобразование Бокса-Кокса

Метод Зарембки Применим для выбора из двух форм (несравнимых непосредственно), в одной из которых зависимая переменная входит с логарифмом, а в другой – нет Метод позволяет сравнить линейную и логарифмическую регрессии и оценить значимость наблюдаемых различий

Метод Зарембки Применим для выбора из двух форм (несравнимых непосредственно), в одной из которых зависимая переменная входит с логарифмом, а в другой – нет Метод позволяет сравнить линейную и логарифмическую регрессии и оценить значимость наблюдаемых различий

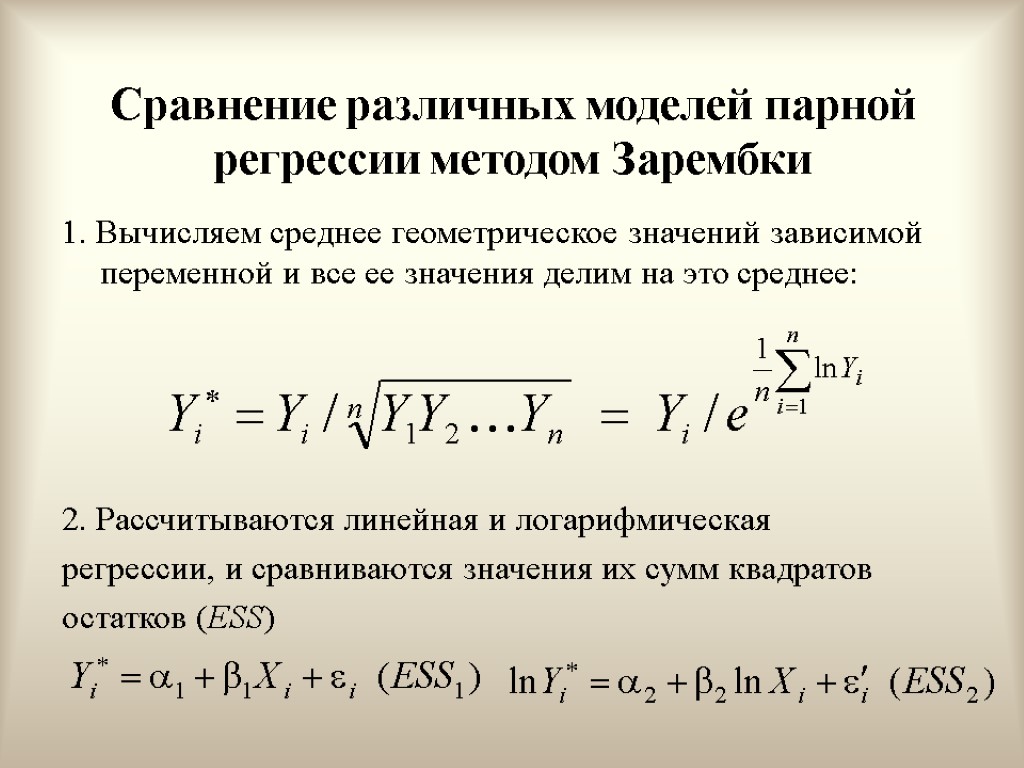

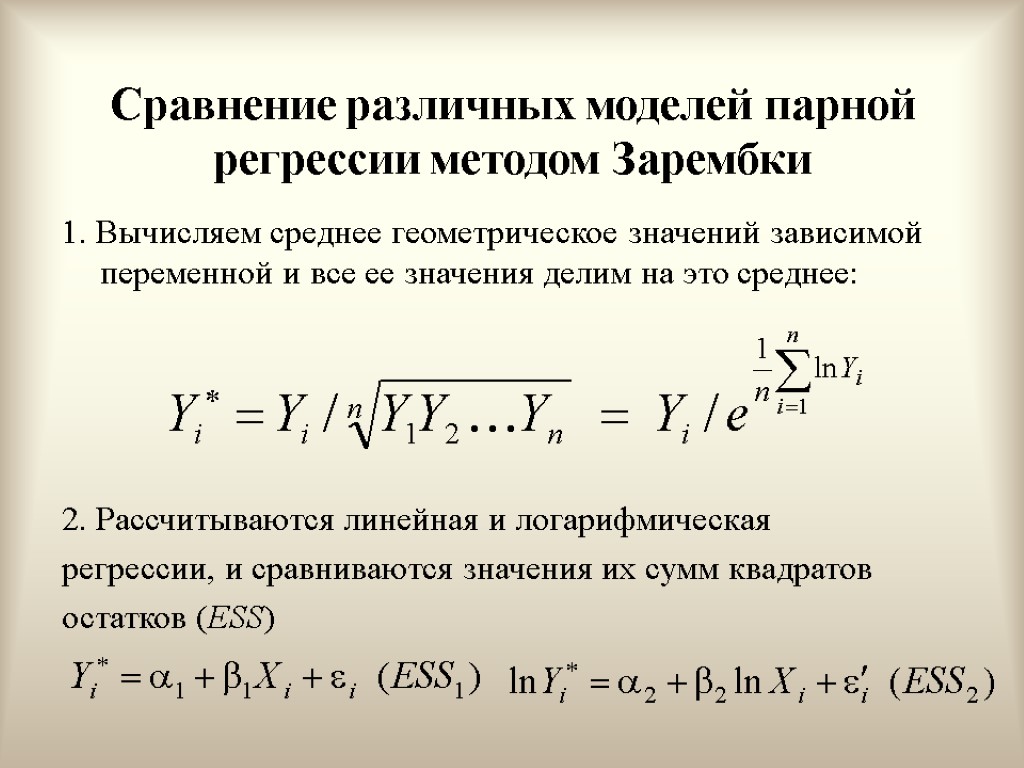

Сравнение различных моделей парной регрессии методом Зарембки 1. Вычисляем среднее геометрическое значений зависимой переменной и все ее значения делим на это среднее: 2. Рассчитываются линейная и логарифмическая регрессии, и сравниваются значения их сумм квадратов остатков (ESS)

Сравнение различных моделей парной регрессии методом Зарембки 1. Вычисляем среднее геометрическое значений зависимой переменной и все ее значения делим на это среднее: 2. Рассчитываются линейная и логарифмическая регрессии, и сравниваются значения их сумм квадратов остатков (ESS)

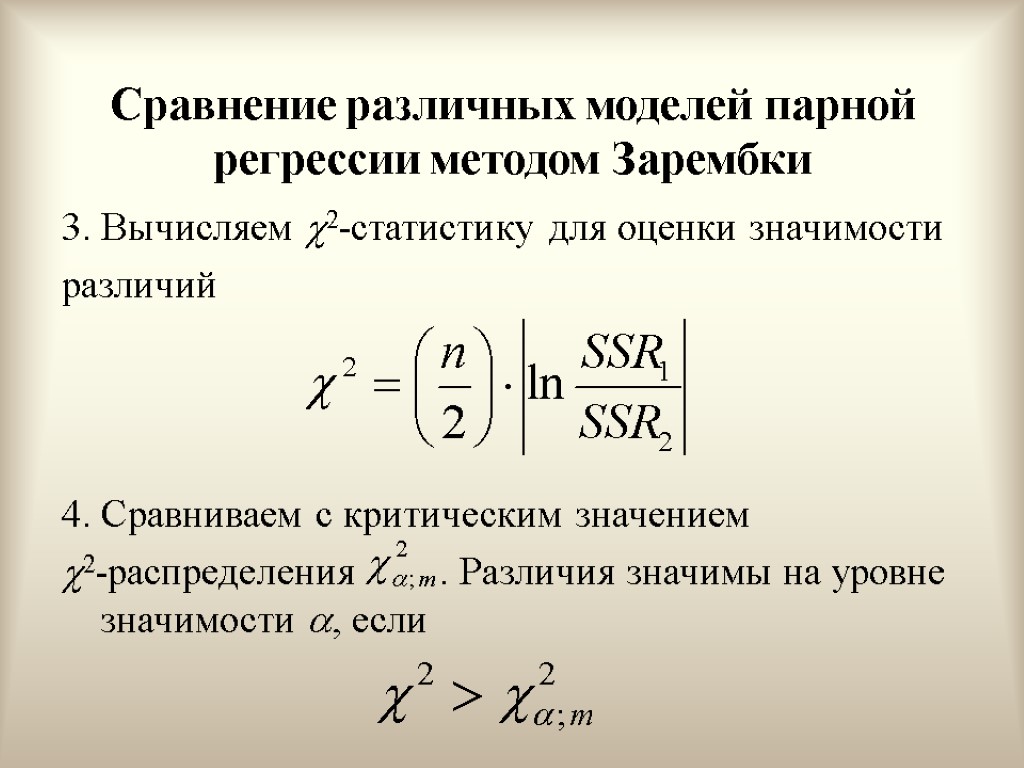

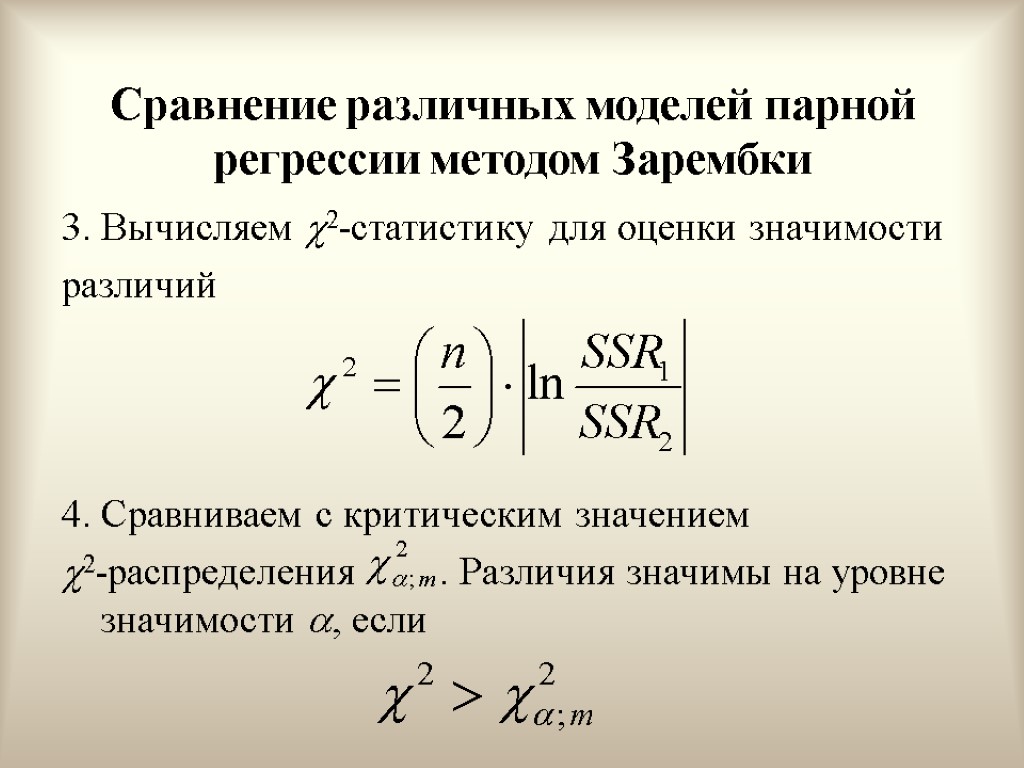

Сравнение различных моделей парной регрессии методом Зарембки 3. Вычисляем 2-статистику для оценки значимости различий 4. Сравниваем с критическим значением 2-распределения . Различия значимы на уровне значимости , если

Сравнение различных моделей парной регрессии методом Зарембки 3. Вычисляем 2-статистику для оценки значимости различий 4. Сравниваем с критическим значением 2-распределения . Различия значимы на уровне значимости , если

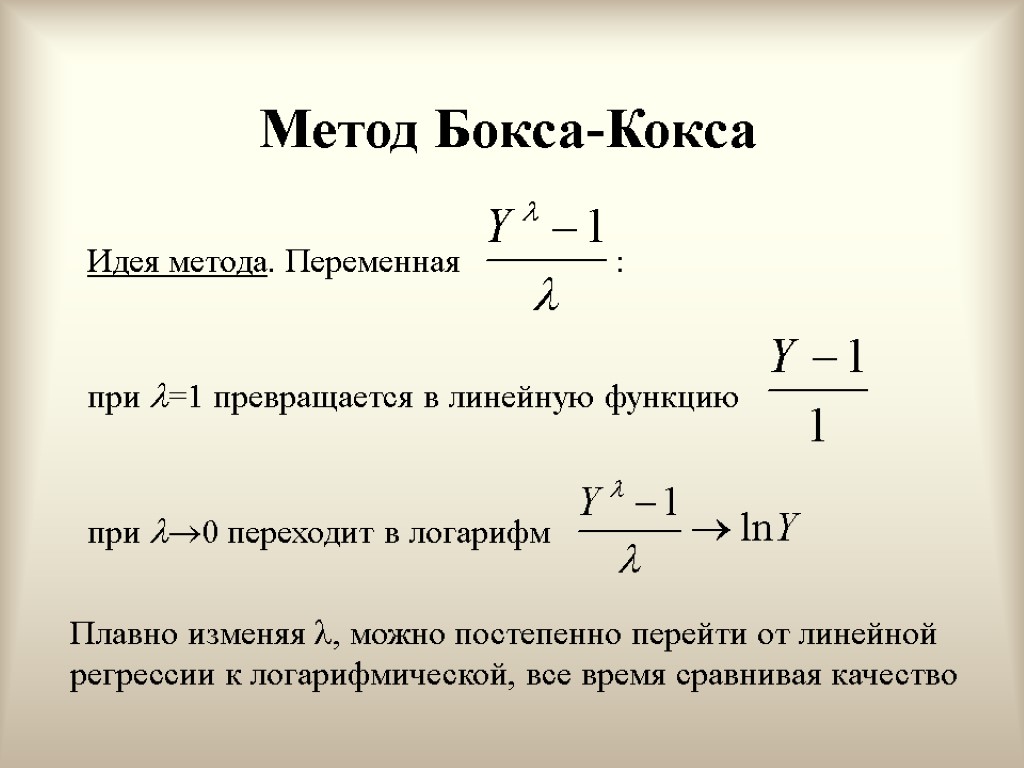

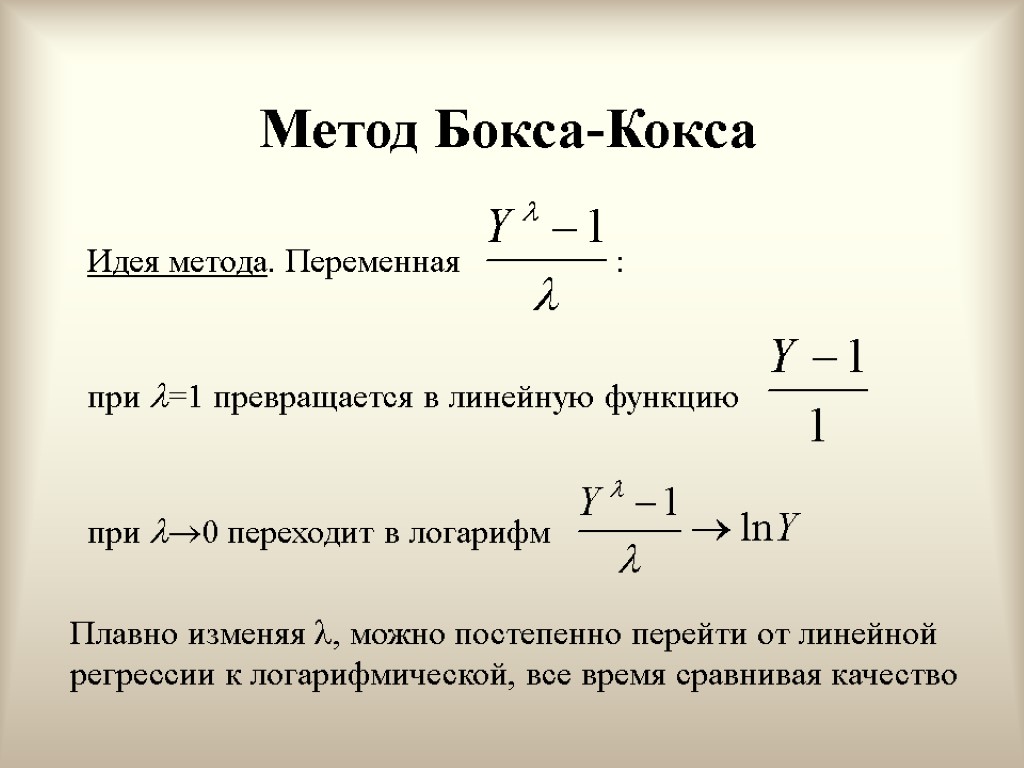

Метод Бокса-Кокса Идея метода. Переменная : при =1 превращается в линейную функцию при 0 переходит в логарифм Плавно изменяя , можно постепенно перейти от линейной регрессии к логарифмической, все время сравнивая качество

Метод Бокса-Кокса Идея метода. Переменная : при =1 превращается в линейную функцию при 0 переходит в логарифм Плавно изменяя , можно постепенно перейти от линейной регрессии к логарифмической, все время сравнивая качество

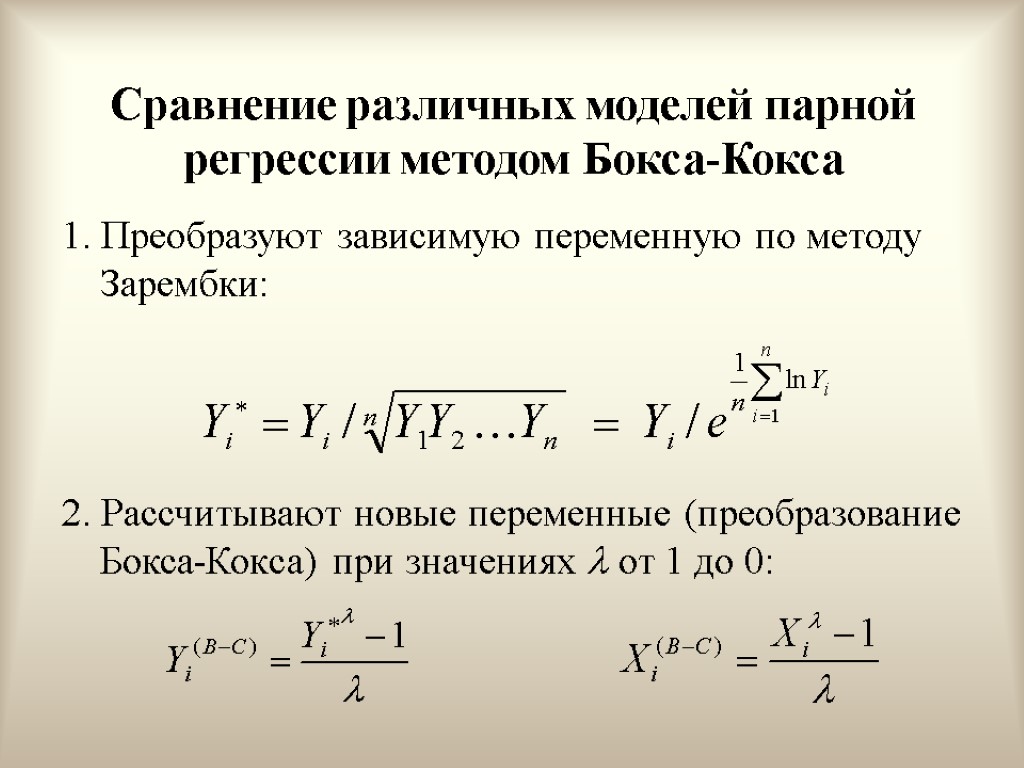

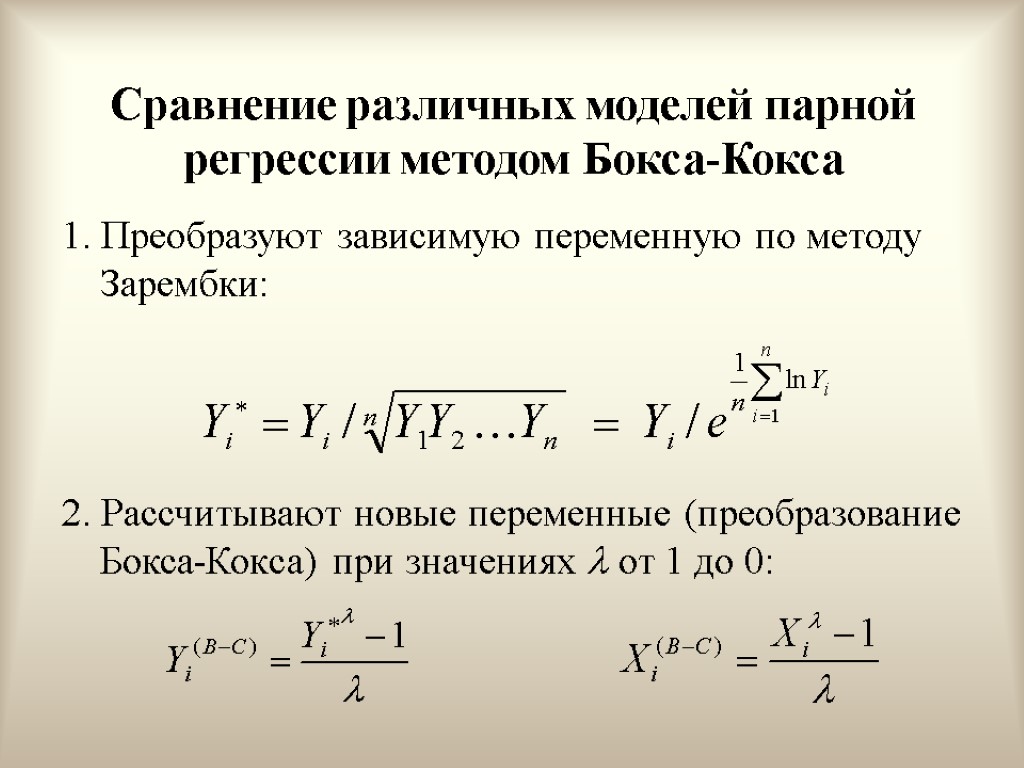

Сравнение различных моделей парной регрессии методом Бокса-Кокса 1. Преобразуют зависимую переменную по методу Зарембки: 2. Рассчитывают новые переменные (преобразование Бокса-Кокса) при значениях от 1 до 0:

Сравнение различных моделей парной регрессии методом Бокса-Кокса 1. Преобразуют зависимую переменную по методу Зарембки: 2. Рассчитывают новые переменные (преобразование Бокса-Кокса) при значениях от 1 до 0:

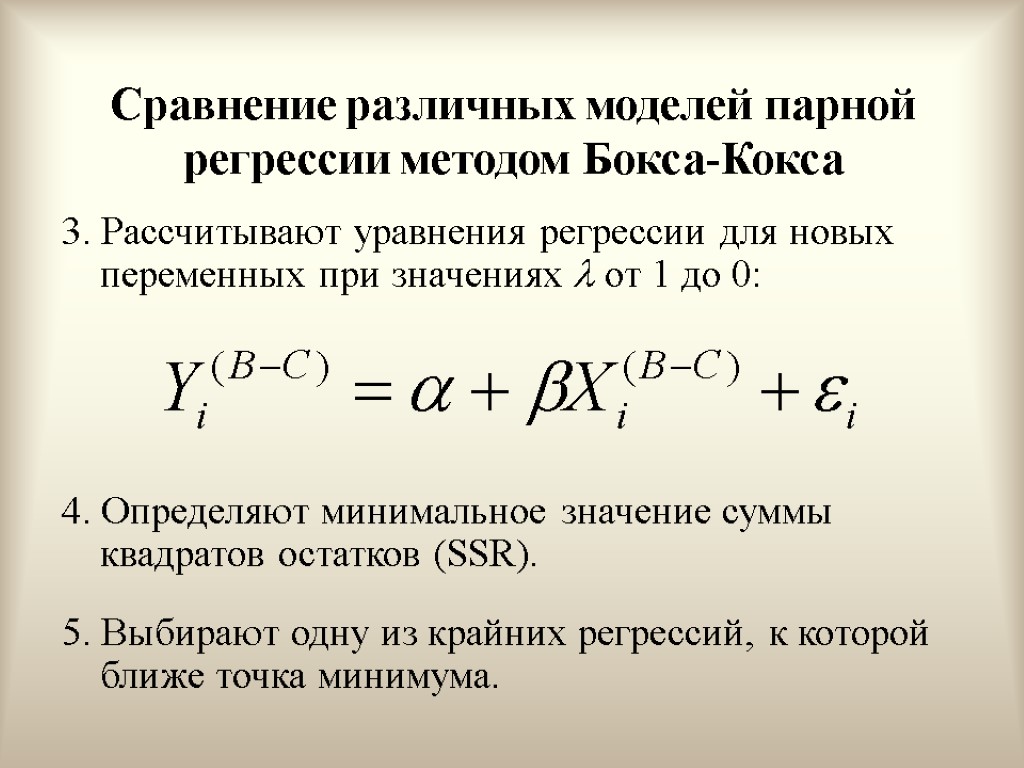

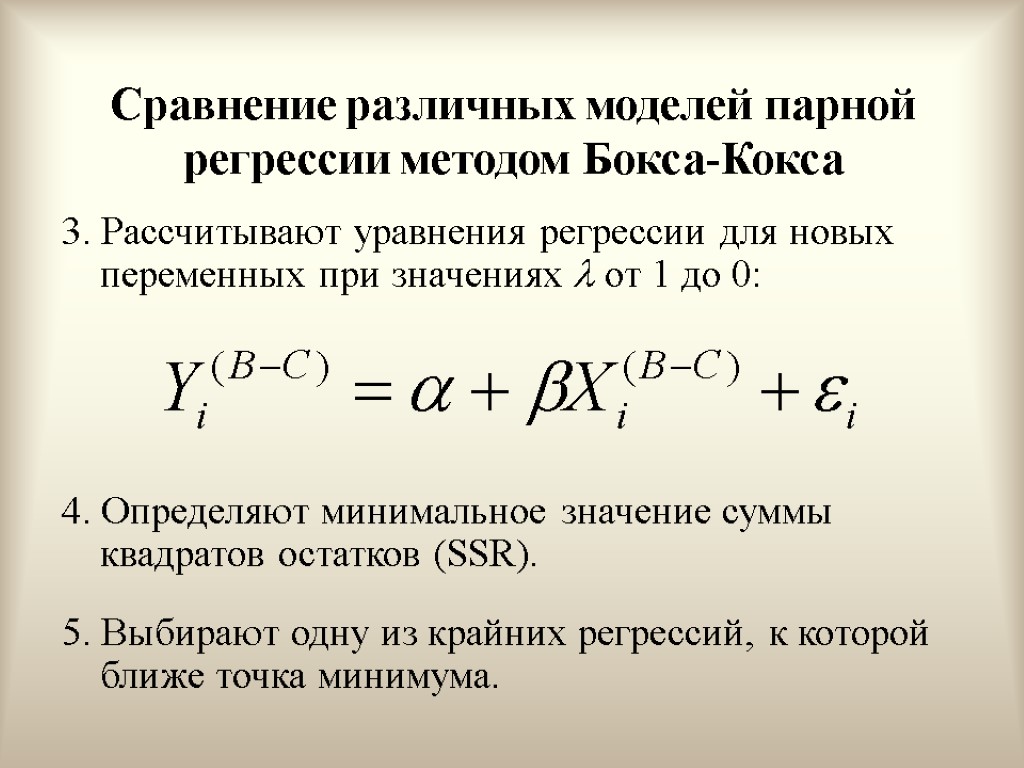

Сравнение различных моделей парной регрессии методом Бокса-Кокса 3. Рассчитывают уравнения регрессии для новых переменных при значениях от 1 до 0: 4. Определяют минимальное значение суммы квадратов остатков (SSR). 5. Выбирают одну из крайних регрессий, к которой ближе точка минимума.

Сравнение различных моделей парной регрессии методом Бокса-Кокса 3. Рассчитывают уравнения регрессии для новых переменных при значениях от 1 до 0: 4. Определяют минимальное значение суммы квадратов остатков (SSR). 5. Выбирают одну из крайних регрессий, к которой ближе точка минимума.

Вопросы для самопроверки Какие вы знаете виды нелинейных моделей. Какие вы знаете нелинейные методы оценивания. Как определять эластичность. Что такое предельные эффекты переменных. Основные способы линеаризации моделей. Какие вы знаете типы производственных функций. Как выбрать между линейной и логарифмической моделями. Экономический смысл коэффициентов линейной модели. Экономический смысл коэффициентов логарифмической модели Экономический смысл коэффициентов полулогарифмической модели.

Вопросы для самопроверки Какие вы знаете виды нелинейных моделей. Какие вы знаете нелинейные методы оценивания. Как определять эластичность. Что такое предельные эффекты переменных. Основные способы линеаризации моделей. Какие вы знаете типы производственных функций. Как выбрать между линейной и логарифмической моделями. Экономический смысл коэффициентов линейной модели. Экономический смысл коэффициентов логарифмической модели Экономический смысл коэффициентов полулогарифмической модели.

Тема 6. Статистические свойства МНК-оценок

Тема 6. Статистические свойства МНК-оценок

Темы лекции Условия Гаусса-Маркова Статистические свойства МНК-оценок. Распределение МНК-коэффициентов Оценка параметров распределения МНК-коэффициентов

Темы лекции Условия Гаусса-Маркова Статистические свойства МНК-оценок. Распределение МНК-коэффициентов Оценка параметров распределения МНК-коэффициентов

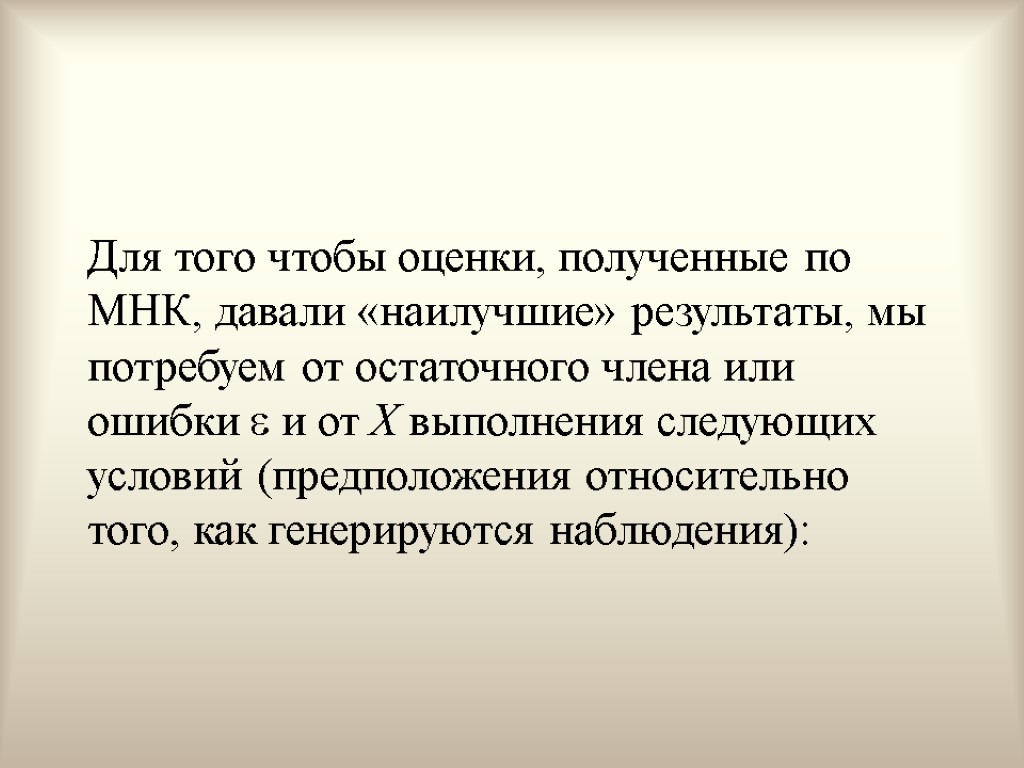

Для того чтобы оценки, полученные по МНК, давали «наилучшие» результаты, мы потребуем от остаточного члена или ошибки и от X выполнения следующих условий (предположения относительно того, как генерируются наблюдения):

Для того чтобы оценки, полученные по МНК, давали «наилучшие» результаты, мы потребуем от остаточного члена или ошибки и от X выполнения следующих условий (предположения относительно того, как генерируются наблюдения):

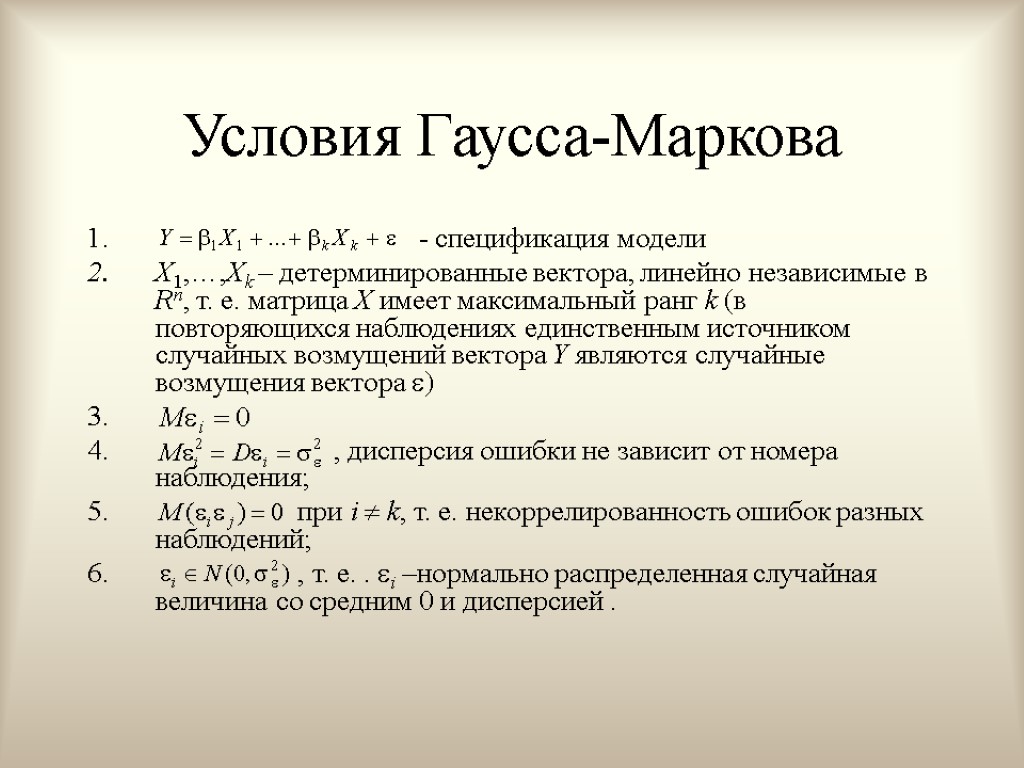

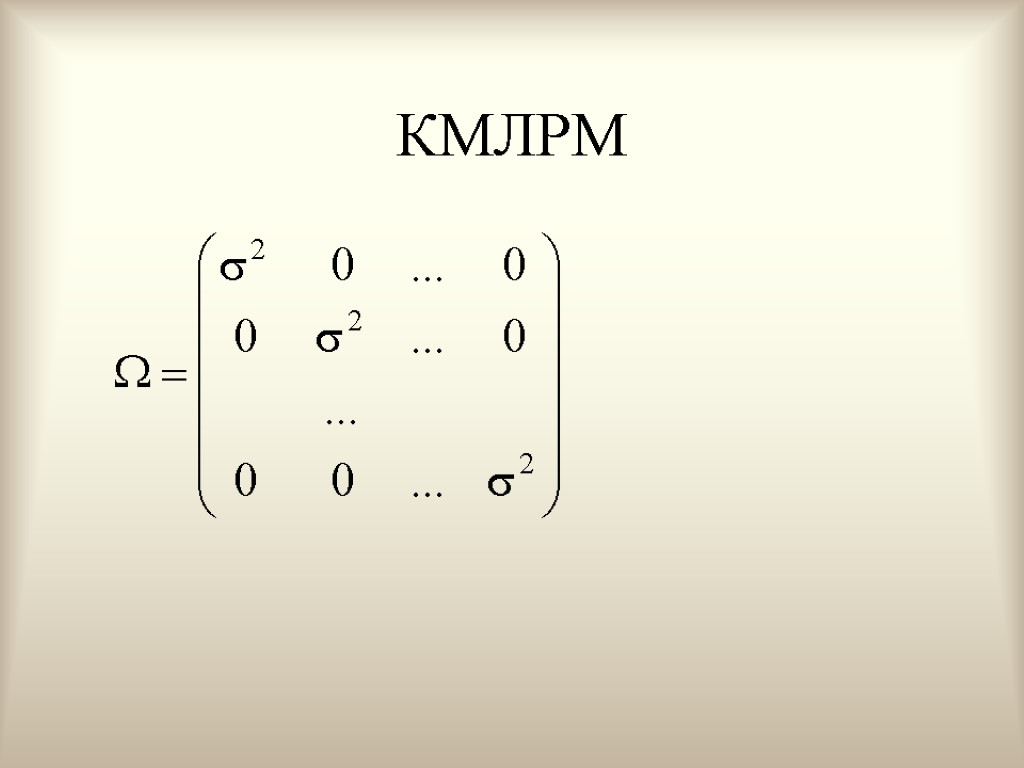

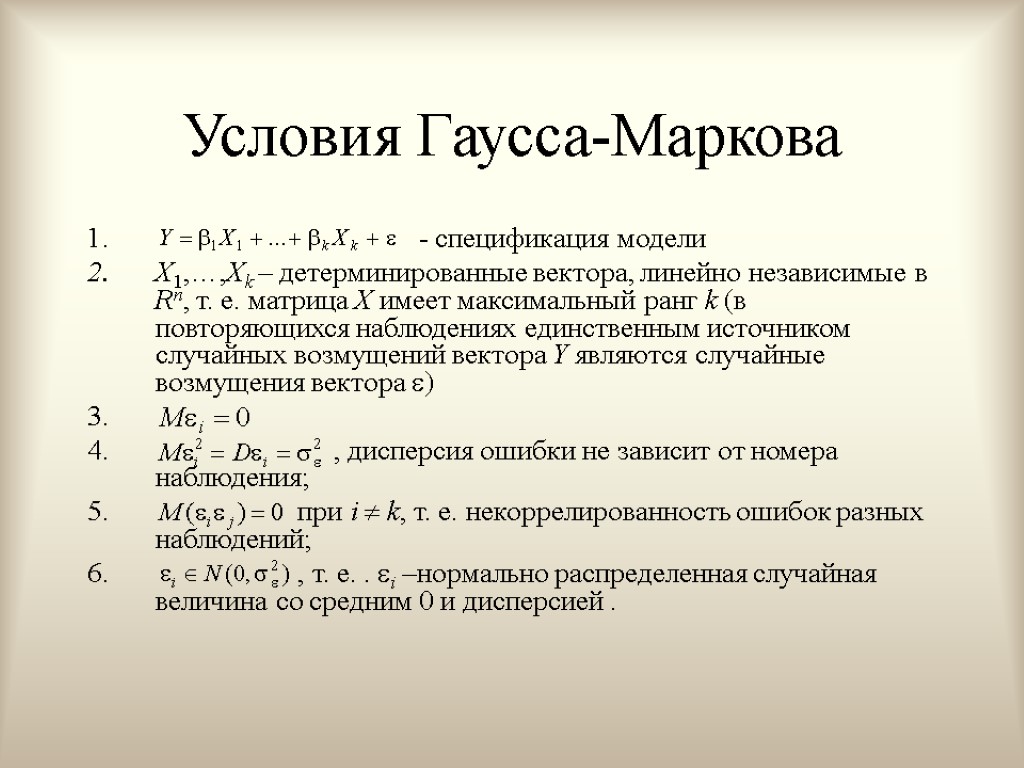

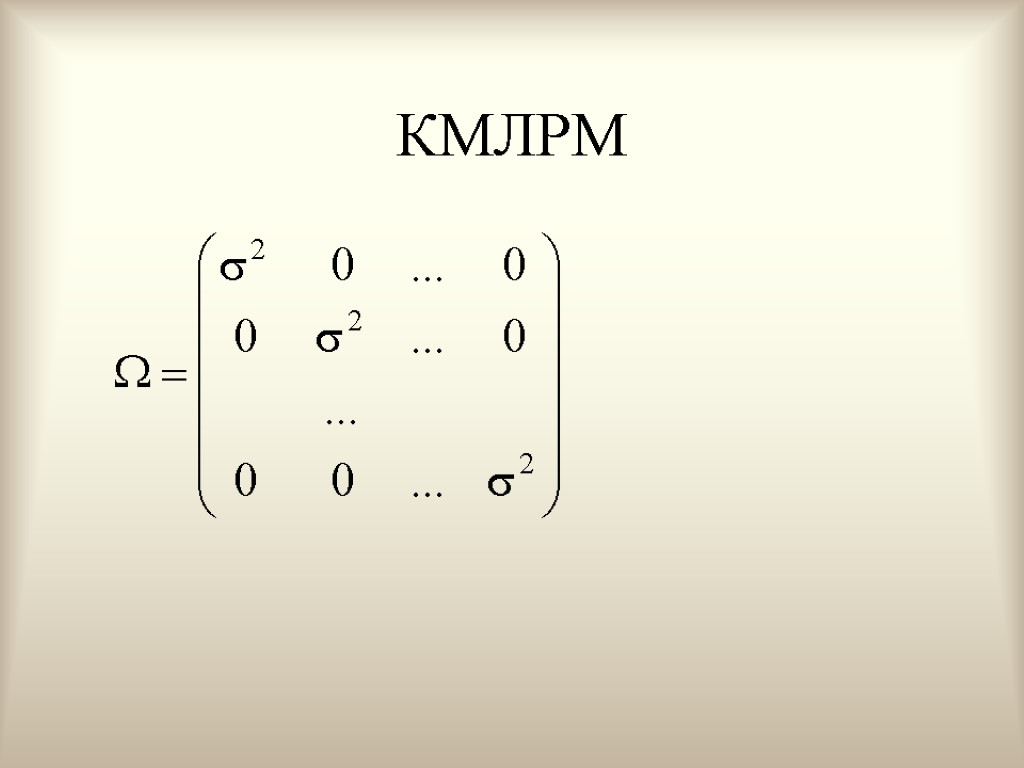

Условия Гаусса-Маркова - спецификация модели X1,…,Xk – детерминированные вектора, линейно независимые в Rn, т. е. матрица X имеет максимальный ранг k (в повторяющихся наблюдениях единственным источником случайных возмущений вектора Y являются случайные возмущения вектора ) , дисперсия ошибки не зависит от номера наблюдения; при i k, т. е. некоррелированность ошибок разных наблюдений; , т. е. . i –нормально распределенная случайная величина со средним 0 и дисперсией .

Условия Гаусса-Маркова - спецификация модели X1,…,Xk – детерминированные вектора, линейно независимые в Rn, т. е. матрица X имеет максимальный ранг k (в повторяющихся наблюдениях единственным источником случайных возмущений вектора Y являются случайные возмущения вектора ) , дисперсия ошибки не зависит от номера наблюдения; при i k, т. е. некоррелированность ошибок разных наблюдений; , т. е. . i –нормально распределенная случайная величина со средним 0 и дисперсией .

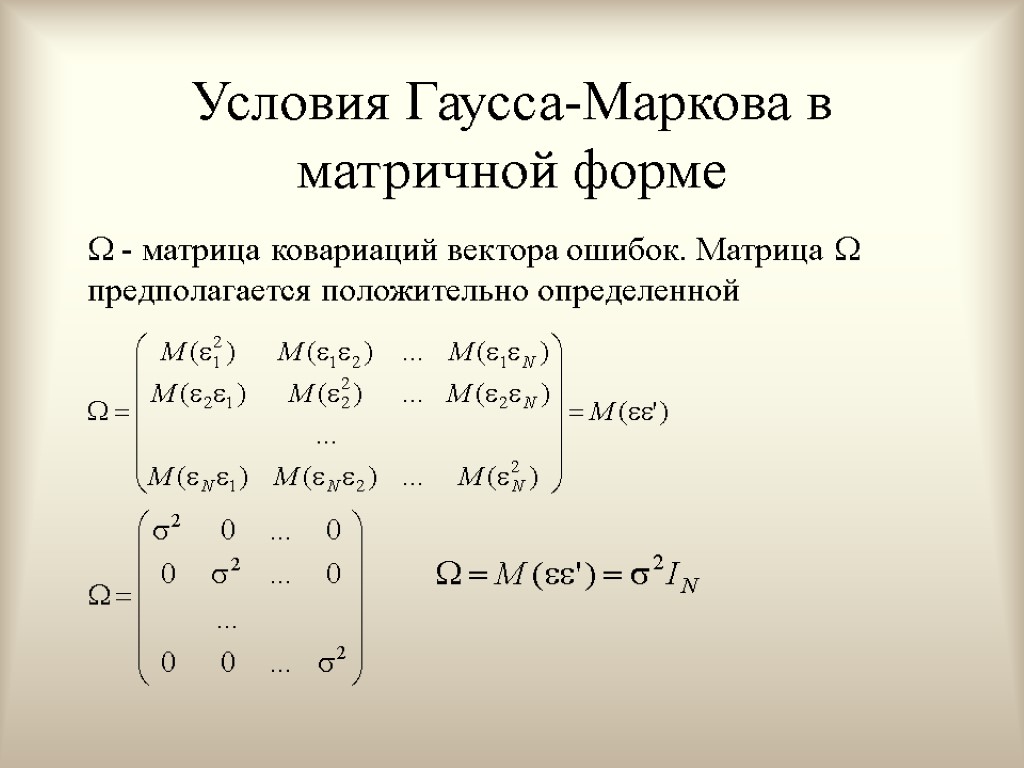

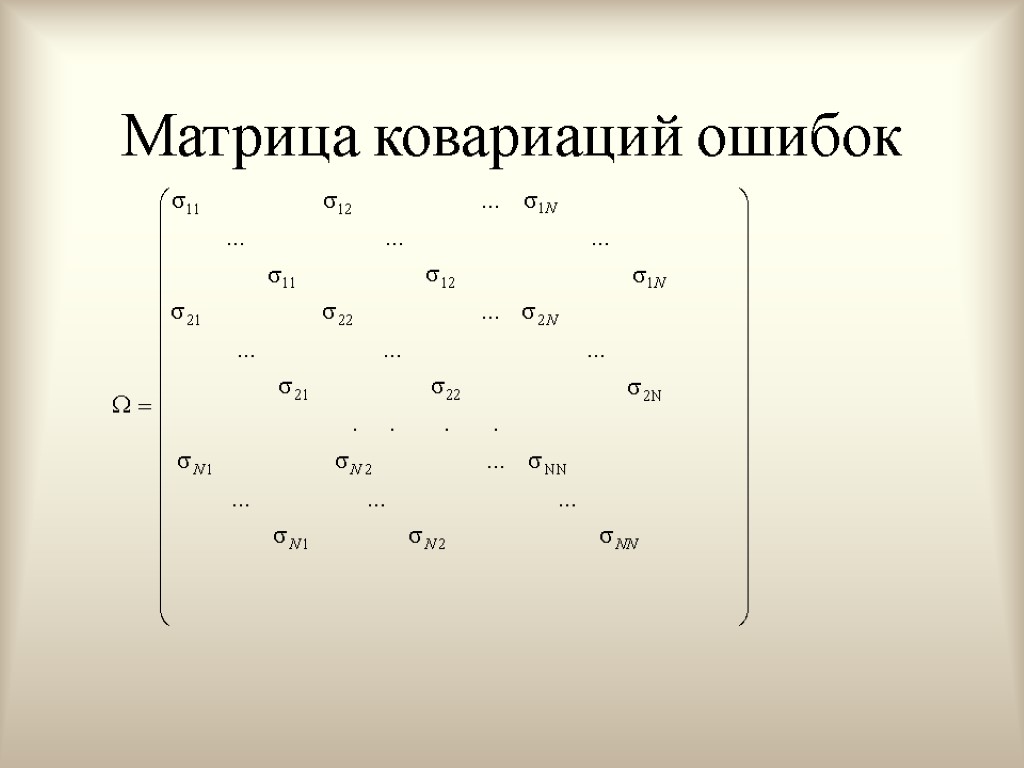

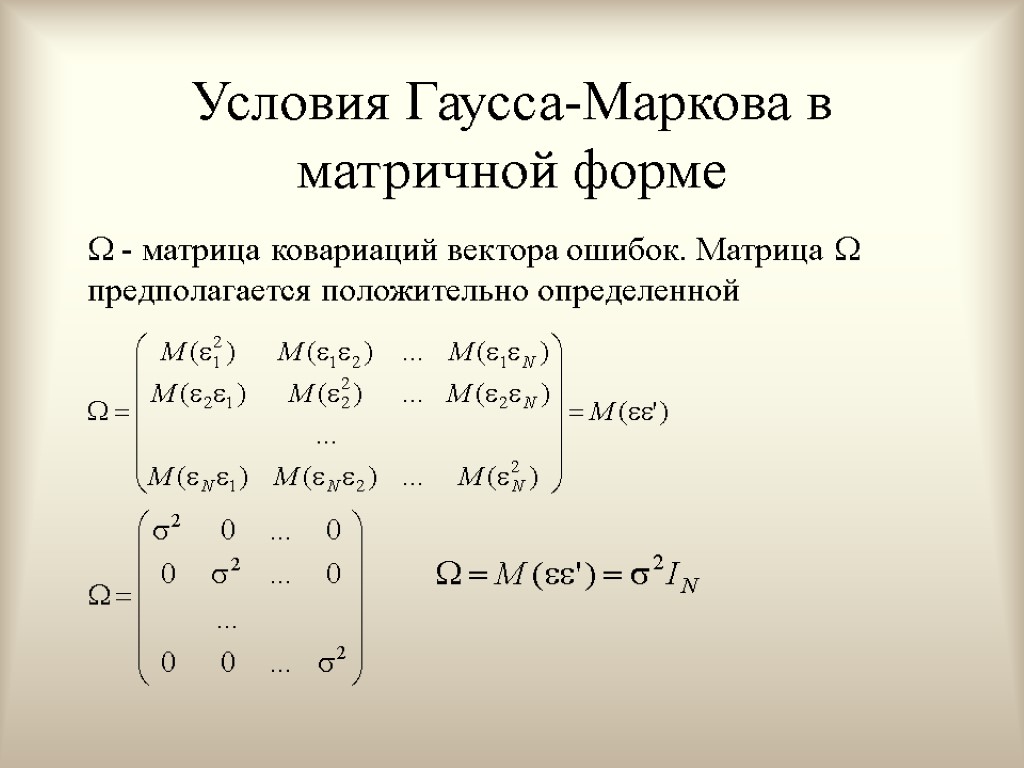

Условия Гаусса-Маркова в матричной форме - матрица ковариаций вектора ошибок. Матрица предполагается положительно определенной

Условия Гаусса-Маркова в матричной форме - матрица ковариаций вектора ошибок. Матрица предполагается положительно определенной

Интерпретация условий (условие 1) Спецификация модели отражает наше представление о механизме зависимости Y и X и выбор объясняющих переменных X.

Интерпретация условий (условие 1) Спецификация модели отражает наше представление о механизме зависимости Y и X и выбор объясняющих переменных X.

Интерпретация условий (условие 2) Хj – детерминированные константы, т. е. значения Хj в каждом наблюдении считается экзогенным, полностью определяемым внешними причинами. Такое предположение подразумевает то, что переменная Х полностью контролируется исследователем, который может изменять ее значение в целях эксперимента.

Интерпретация условий (условие 2) Хj – детерминированные константы, т. е. значения Хj в каждом наблюдении считается экзогенным, полностью определяемым внешними причинами. Такое предположение подразумевает то, что переменная Х полностью контролируется исследователем, который может изменять ее значение в целях эксперимента.

Интерпретация условий (условие 3) Это условие состоит в том, что математическое ожидание случайного члена равно нулю в любом наблюдении. Иногда случайный член бывает положительным, иногда отрицательным, но он не должен иметь смещения ни в одном возможном направлении. Если в уравнение включается постоянный член, то бывает разумным предположить, что первое условие выполняется автоматически, т. к. роль константы и состоит в определении любой систематической составляющей в Y, которую не учитывают объясняющие переменные (если спецификация модели выбрана правильно)

Интерпретация условий (условие 3) Это условие состоит в том, что математическое ожидание случайного члена равно нулю в любом наблюдении. Иногда случайный член бывает положительным, иногда отрицательным, но он не должен иметь смещения ни в одном возможном направлении. Если в уравнение включается постоянный член, то бывает разумным предположить, что первое условие выполняется автоматически, т. к. роль константы и состоит в определении любой систематической составляющей в Y, которую не учитывают объясняющие переменные (если спецификация модели выбрана правильно)

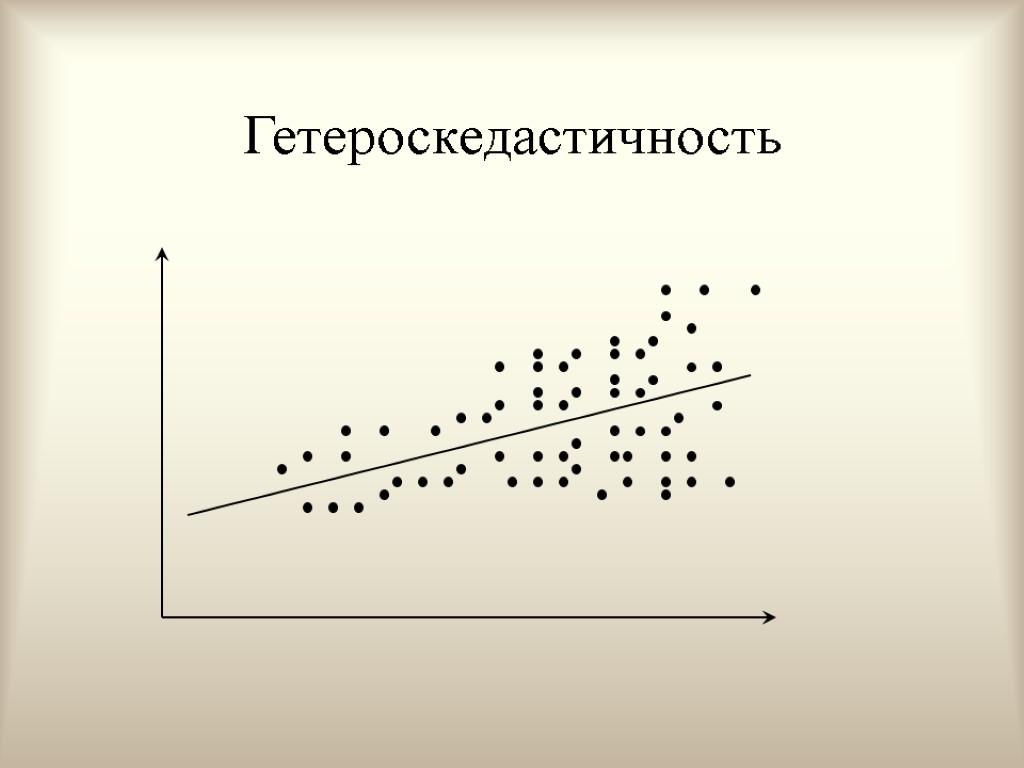

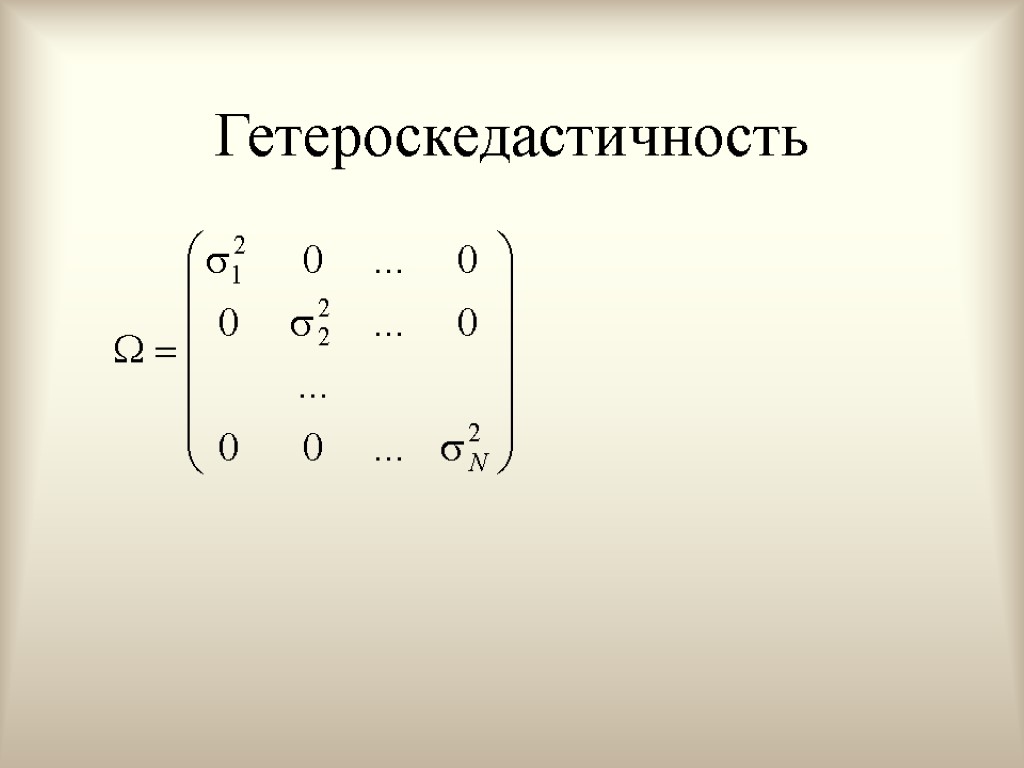

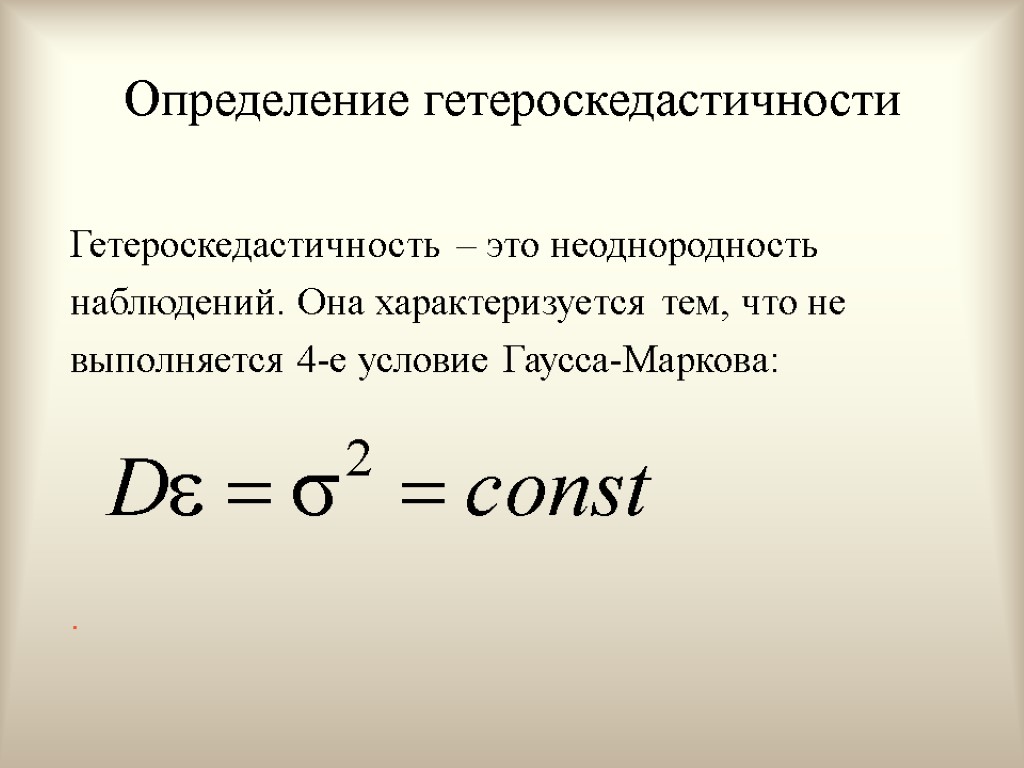

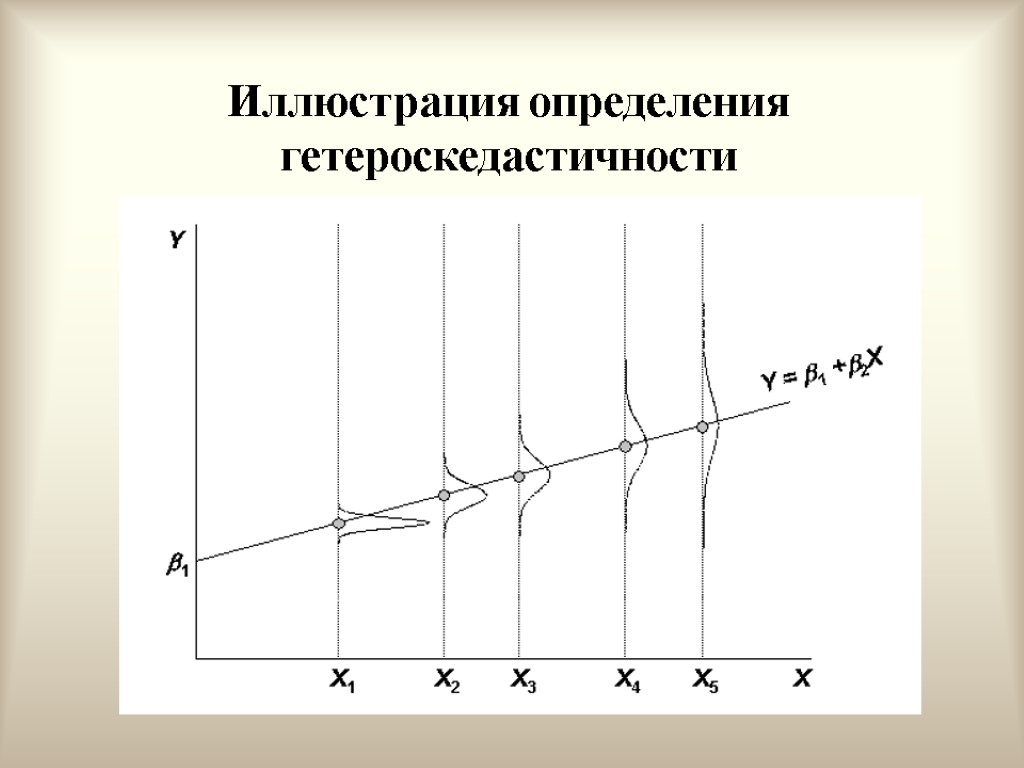

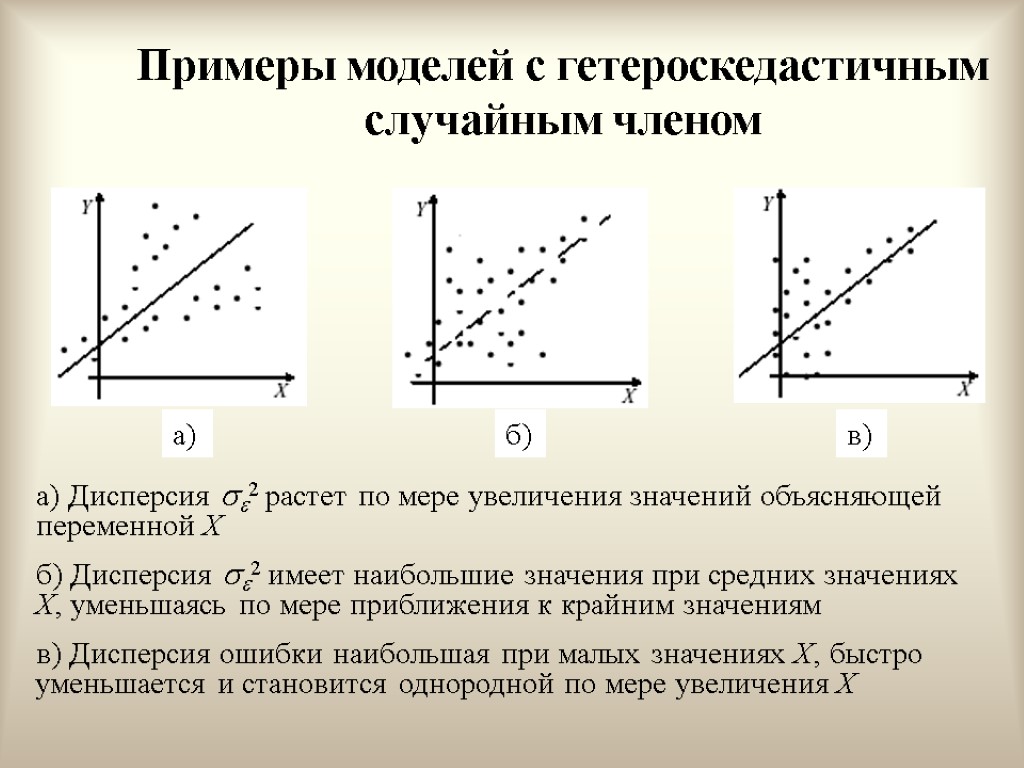

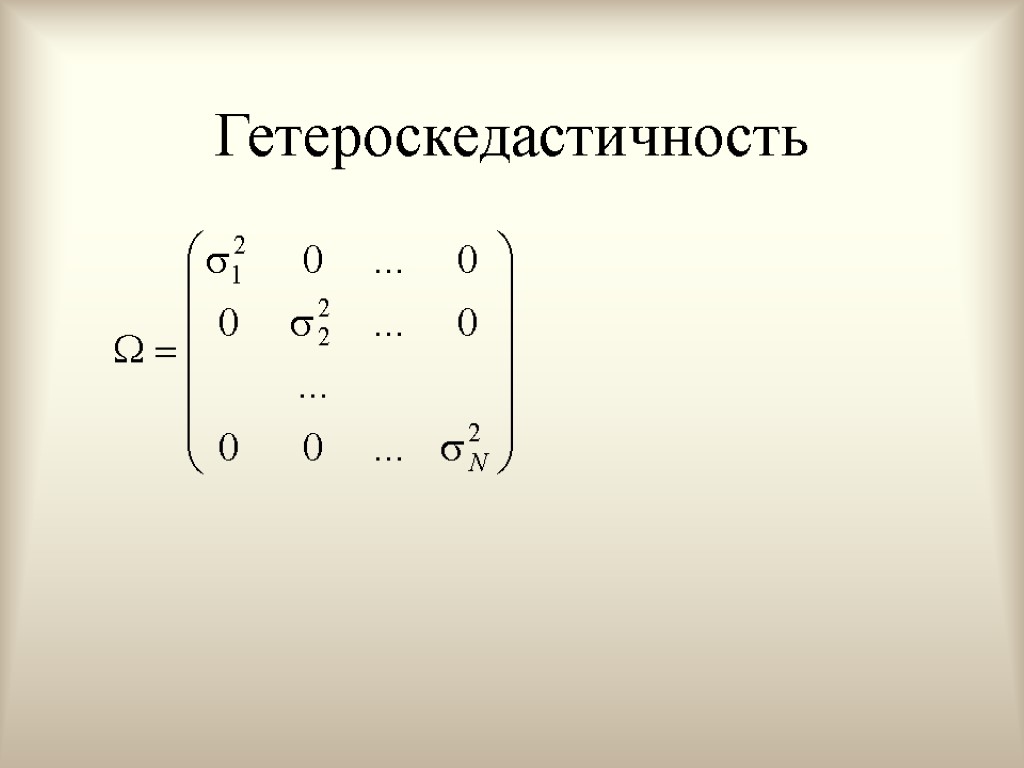

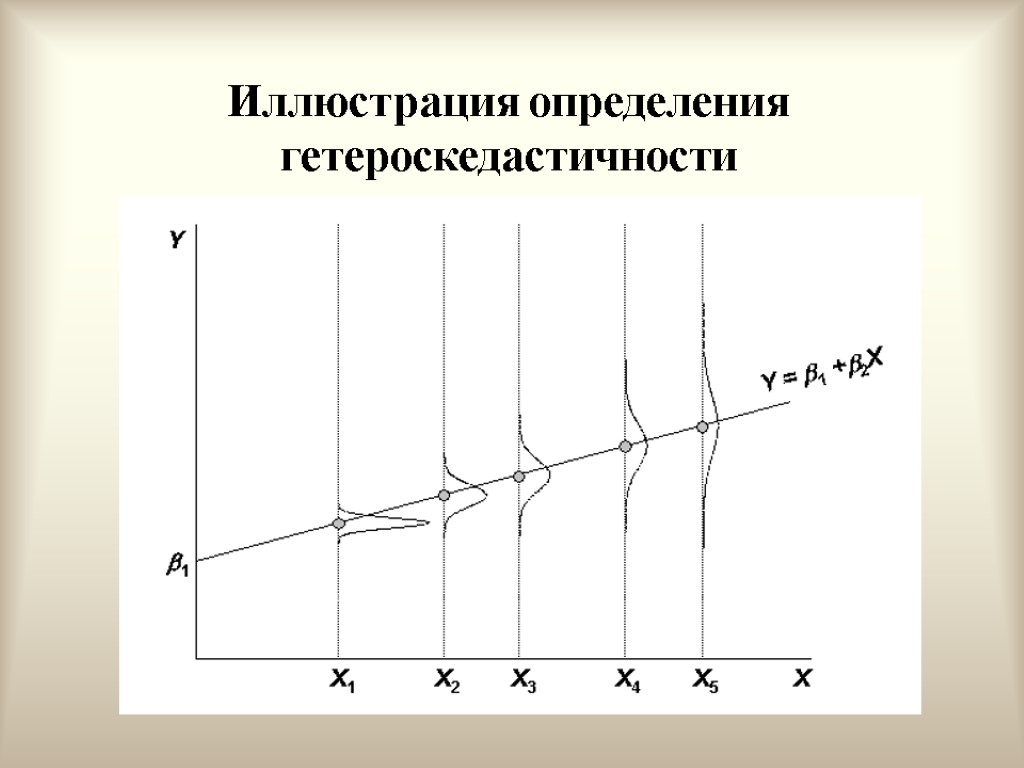

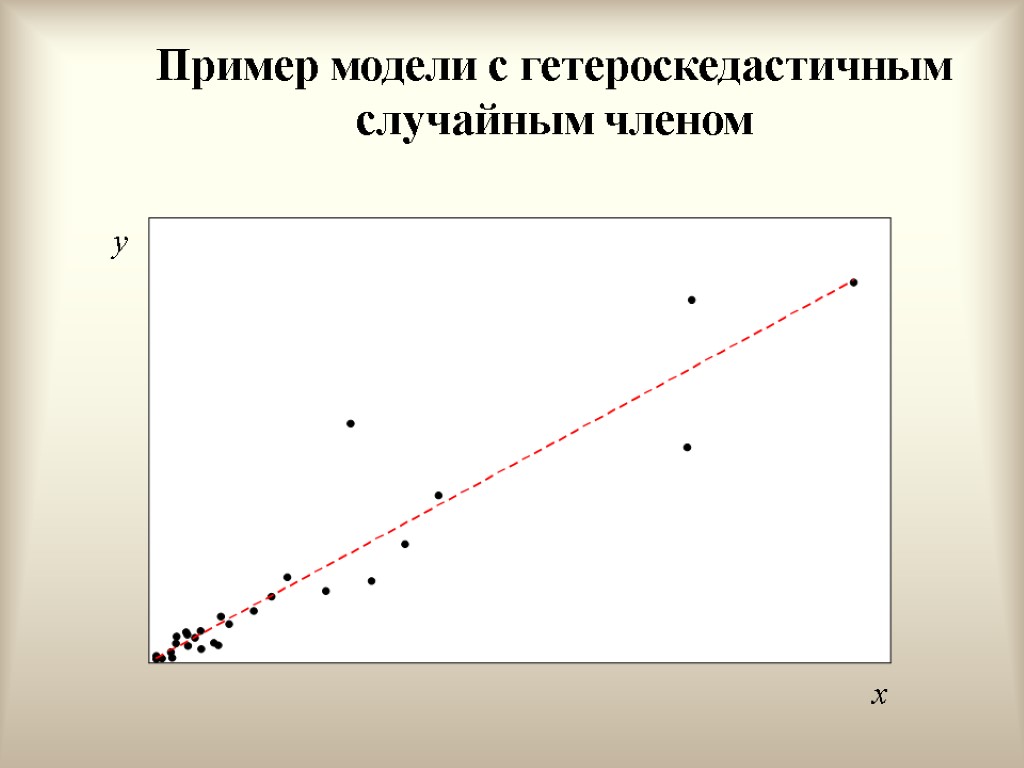

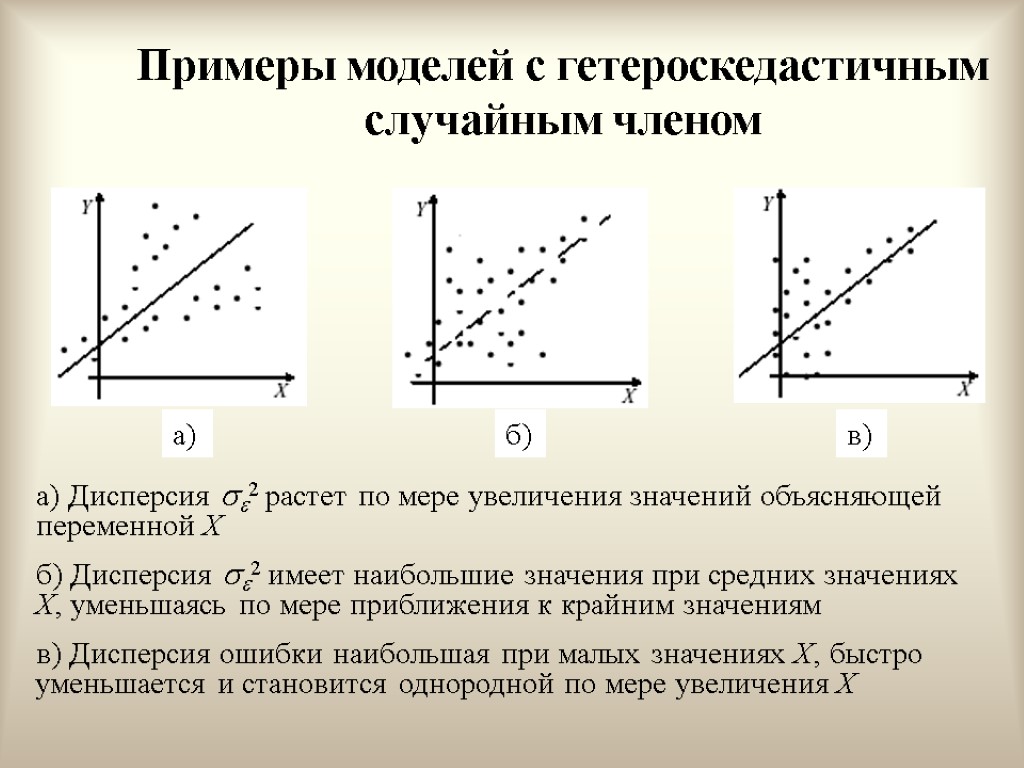

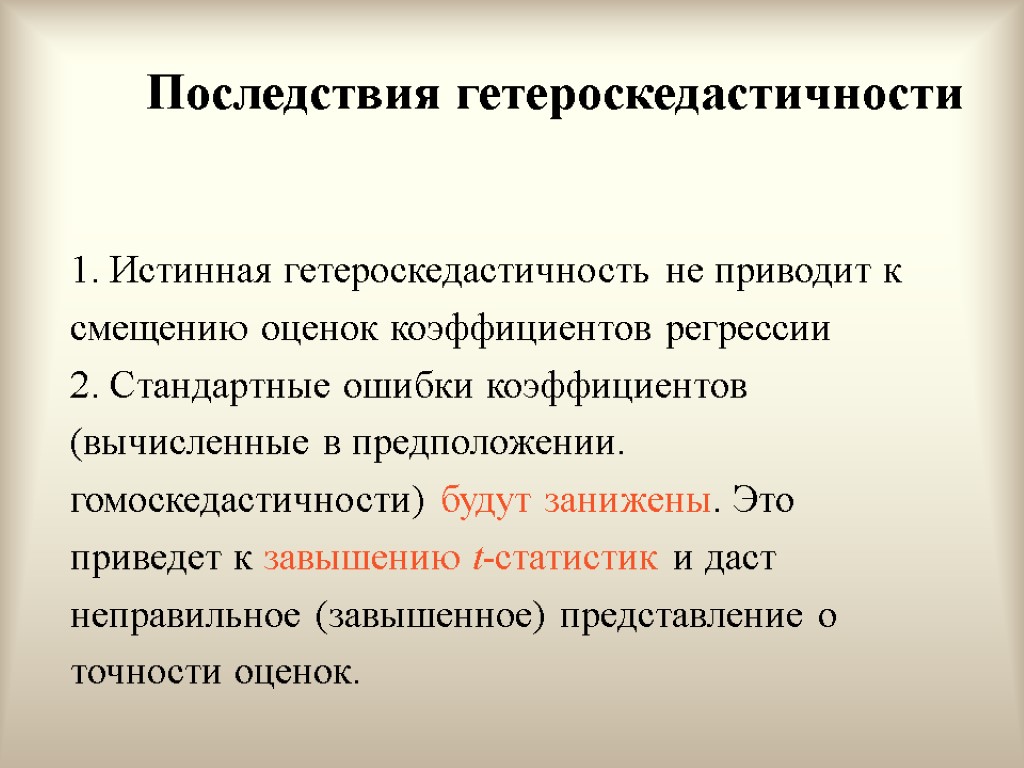

Интерпретация условий (условие 4) Иногда случайный член будет больше, иногда меньше, но не должно быть априорной причины для того, чтобы он порождал большую ошибку в одних наблюдениях, чем в других. Условие независимости ошибок от номера наблюдения называют гомоскедастичностью. Случай, когда условие гомоскедастичности нарушается, называется гетероскедастичностью.

Интерпретация условий (условие 4) Иногда случайный член будет больше, иногда меньше, но не должно быть априорной причины для того, чтобы он порождал большую ошибку в одних наблюдениях, чем в других. Условие независимости ошибок от номера наблюдения называют гомоскедастичностью. Случай, когда условие гомоскедастичности нарушается, называется гетероскедастичностью.

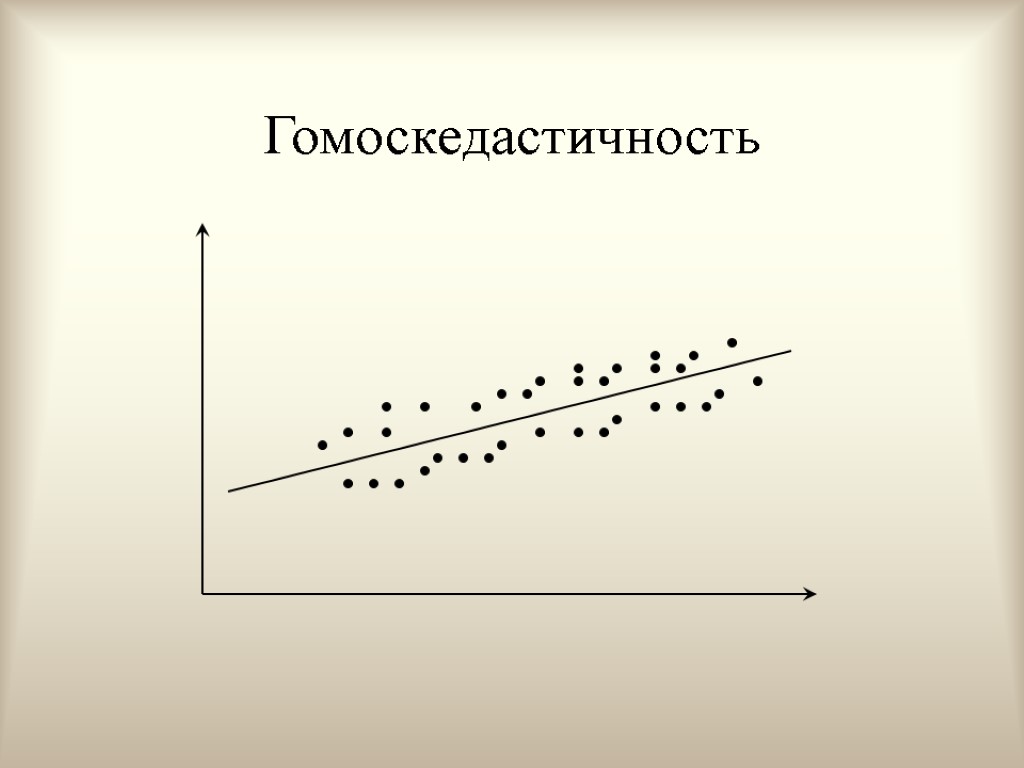

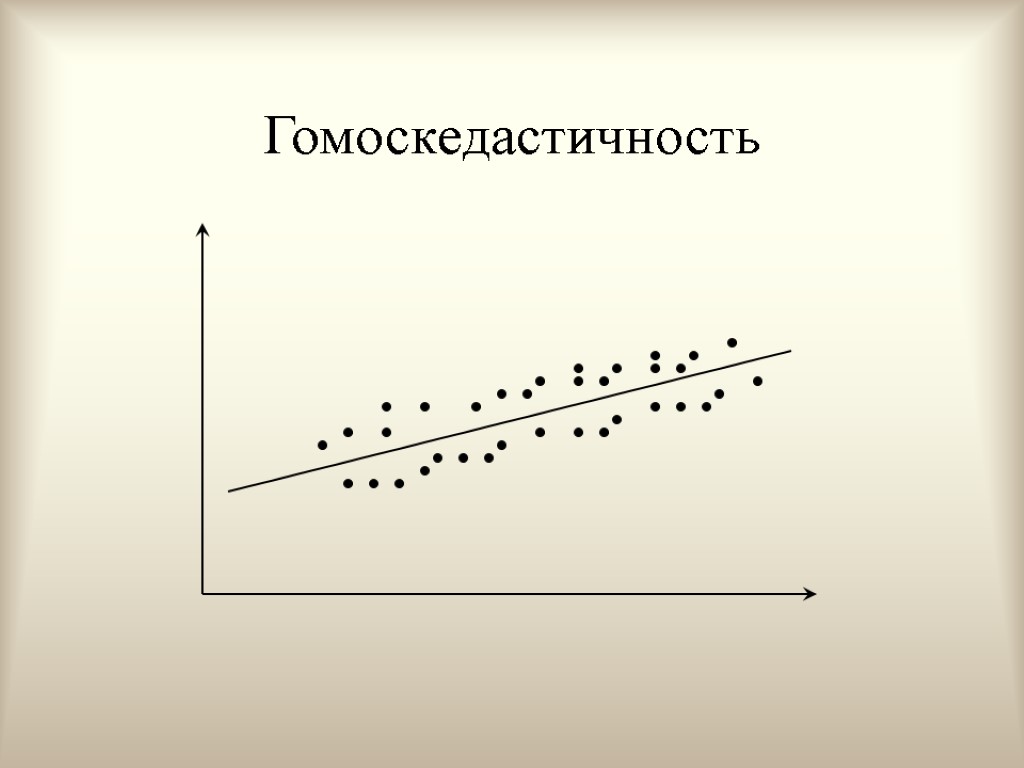

Гомоскедастичность

Гомоскедастичность

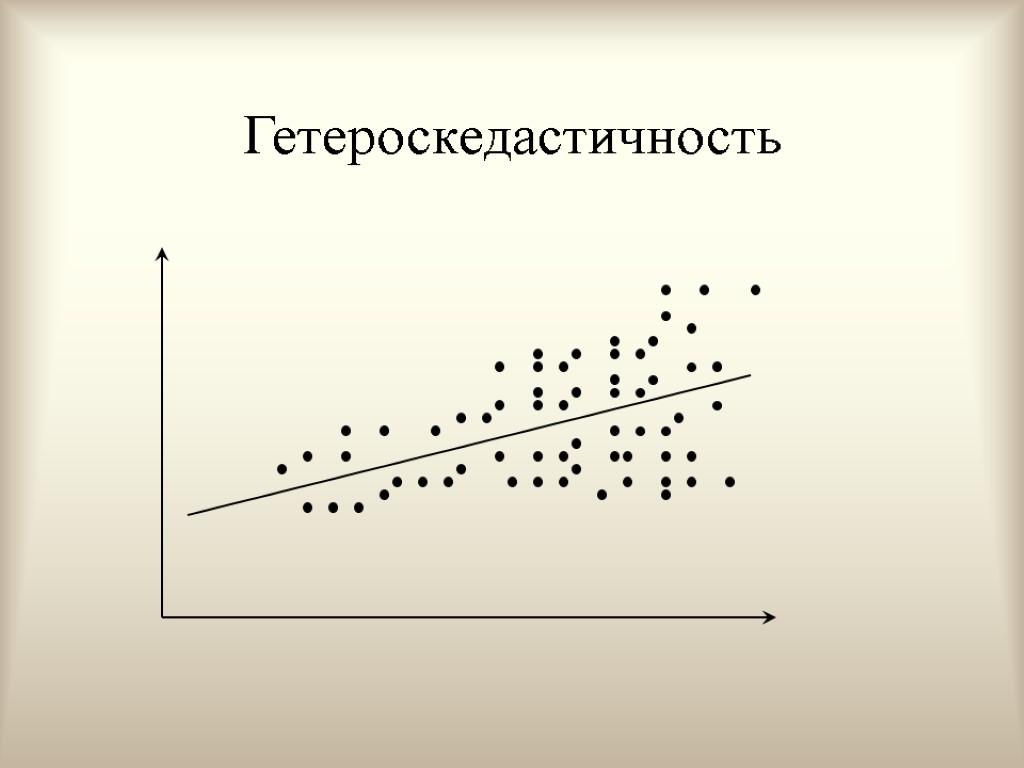

Гетероскедастичность

Гетероскедастичность

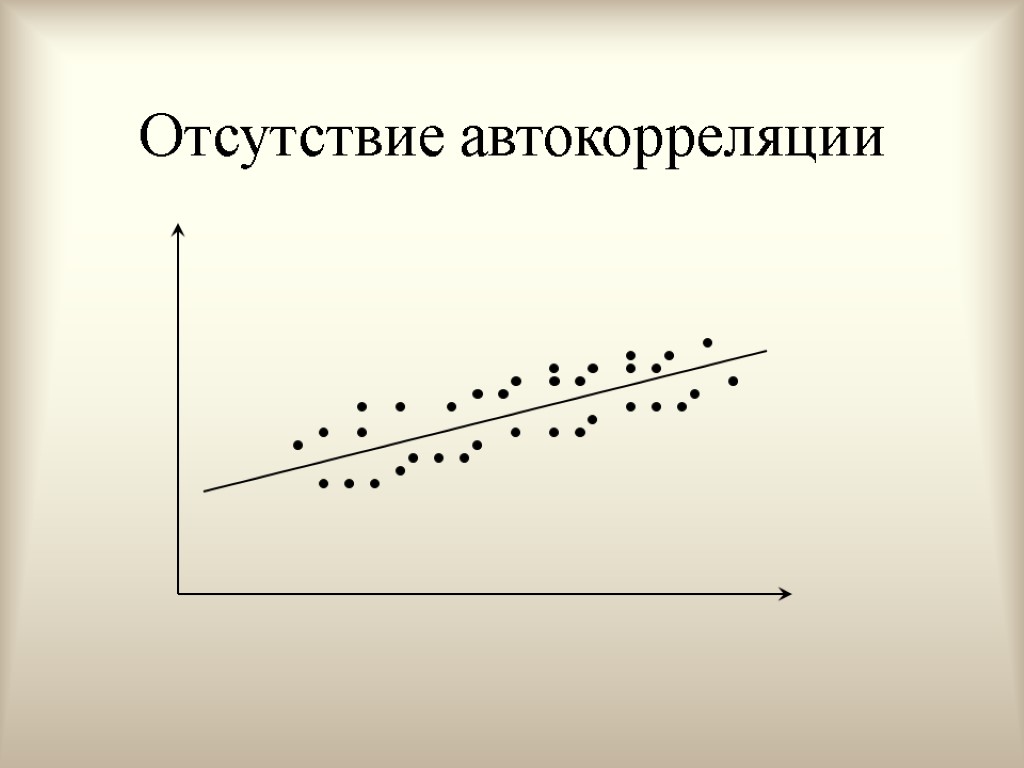

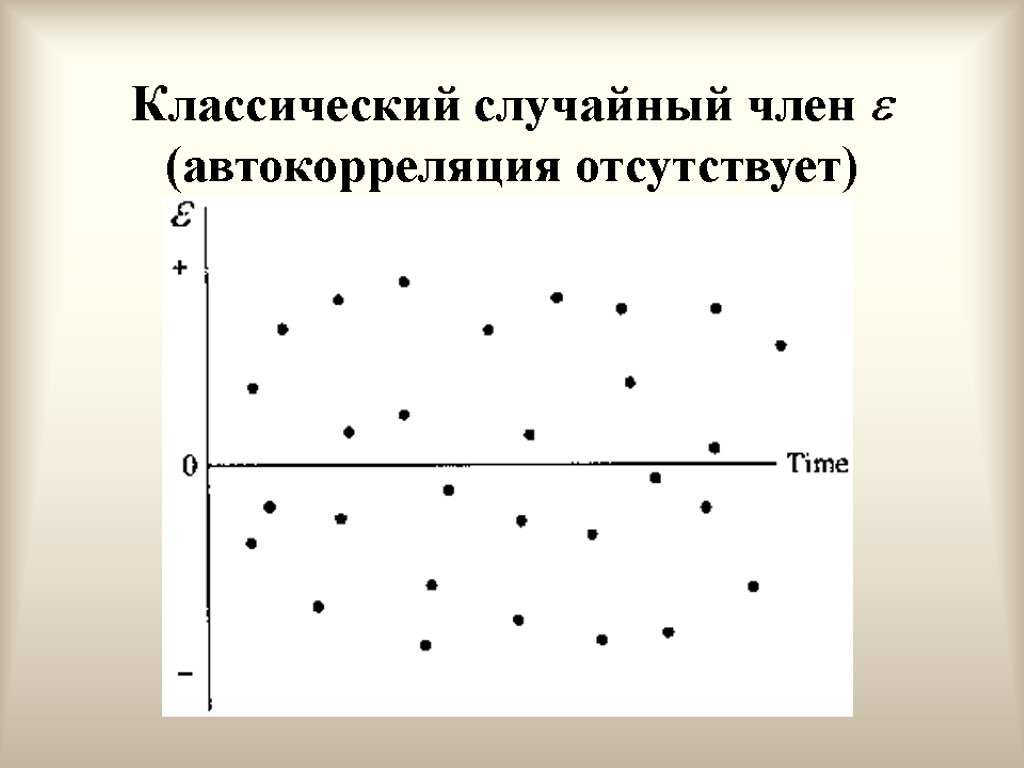

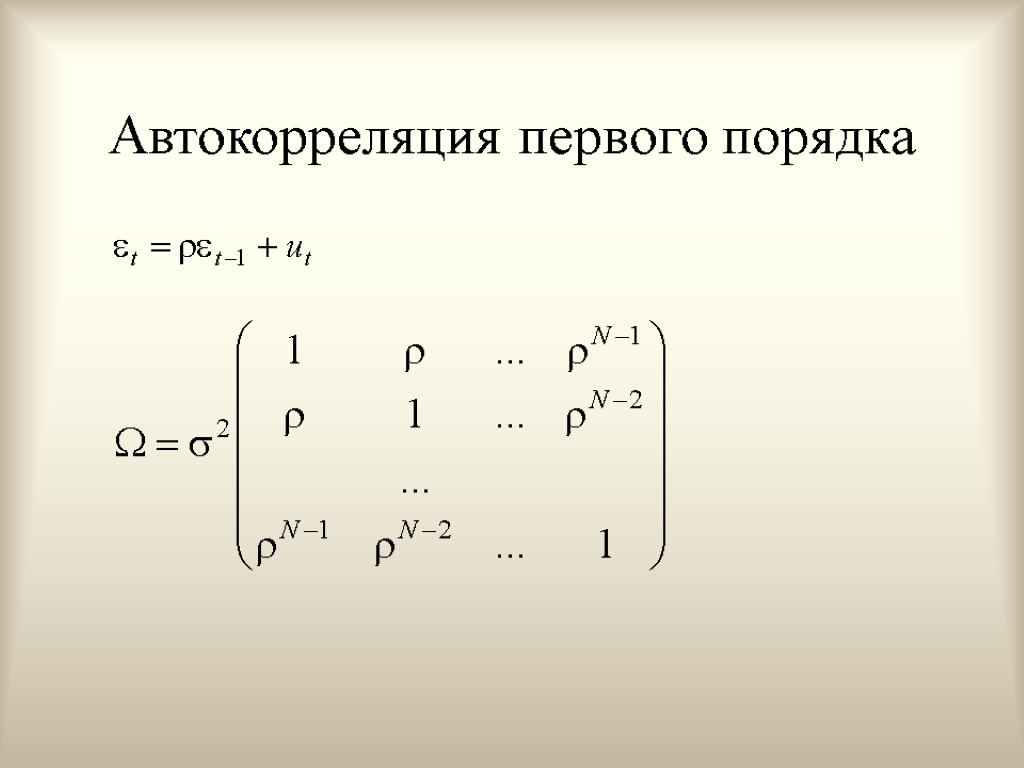

Интерпретация условий (условие 5) Условие указывает на некоррелированность ошибок для разных наблюдений. Условие предполагает отсутствие систематической связи между значениями случайного члена в любых двух наблюдениях.

Интерпретация условий (условие 5) Условие указывает на некоррелированность ошибок для разных наблюдений. Условие предполагает отсутствие систематической связи между значениями случайного члена в любых двух наблюдениях.

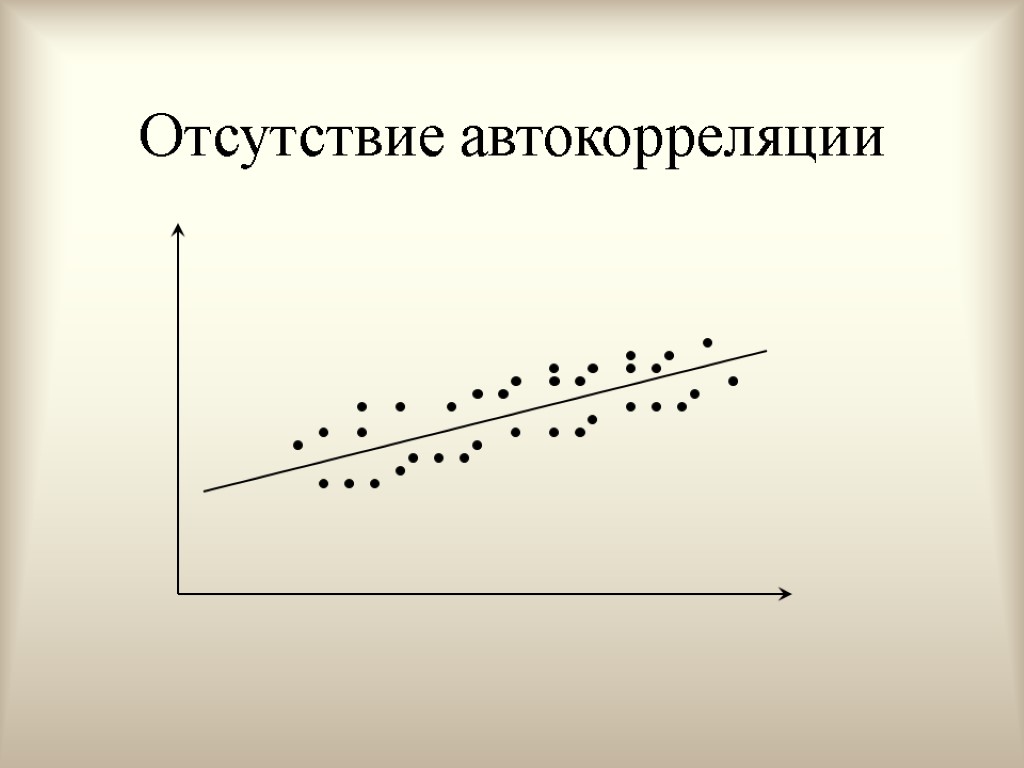

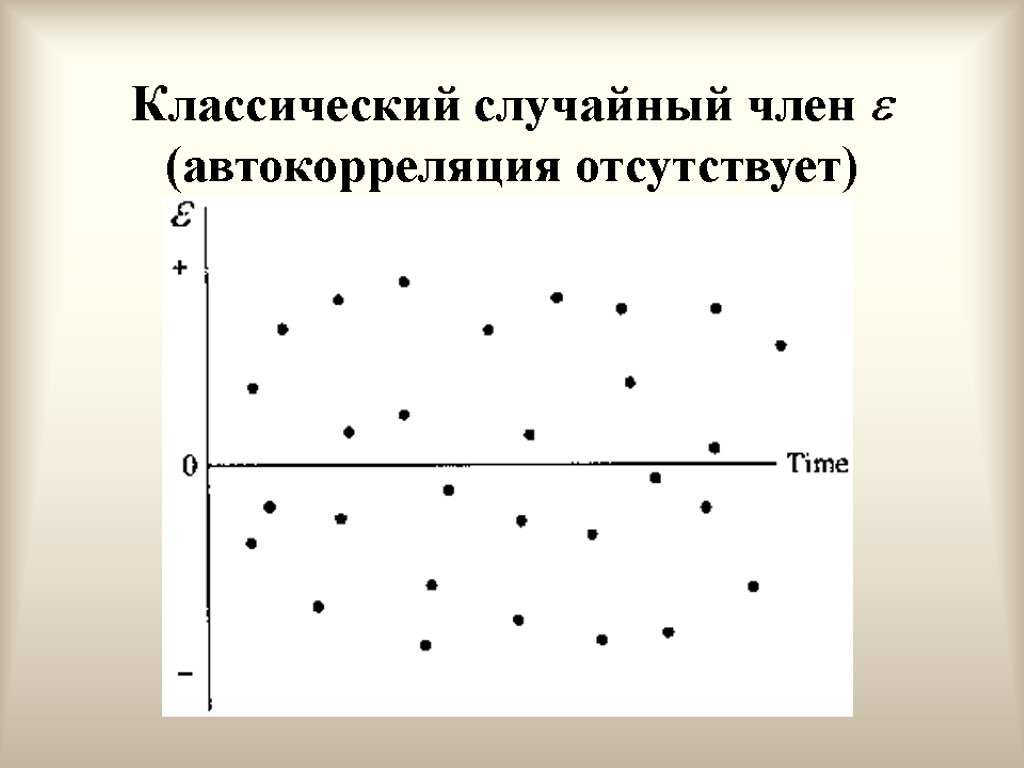

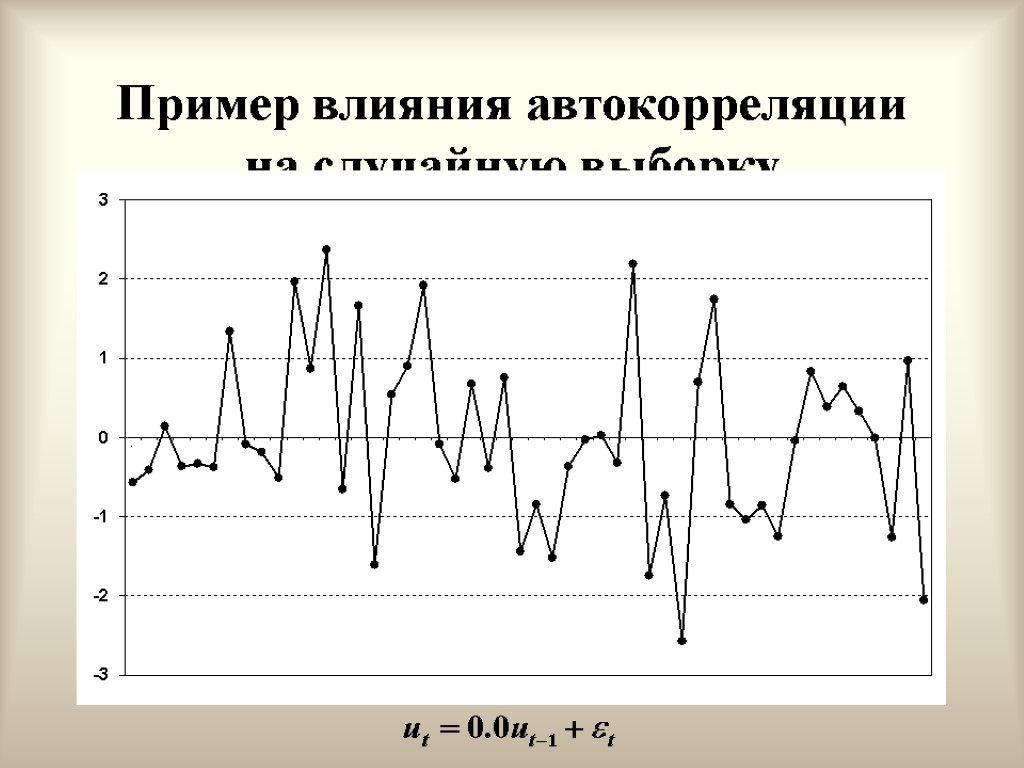

Отсутствие автокорреляции

Отсутствие автокорреляции

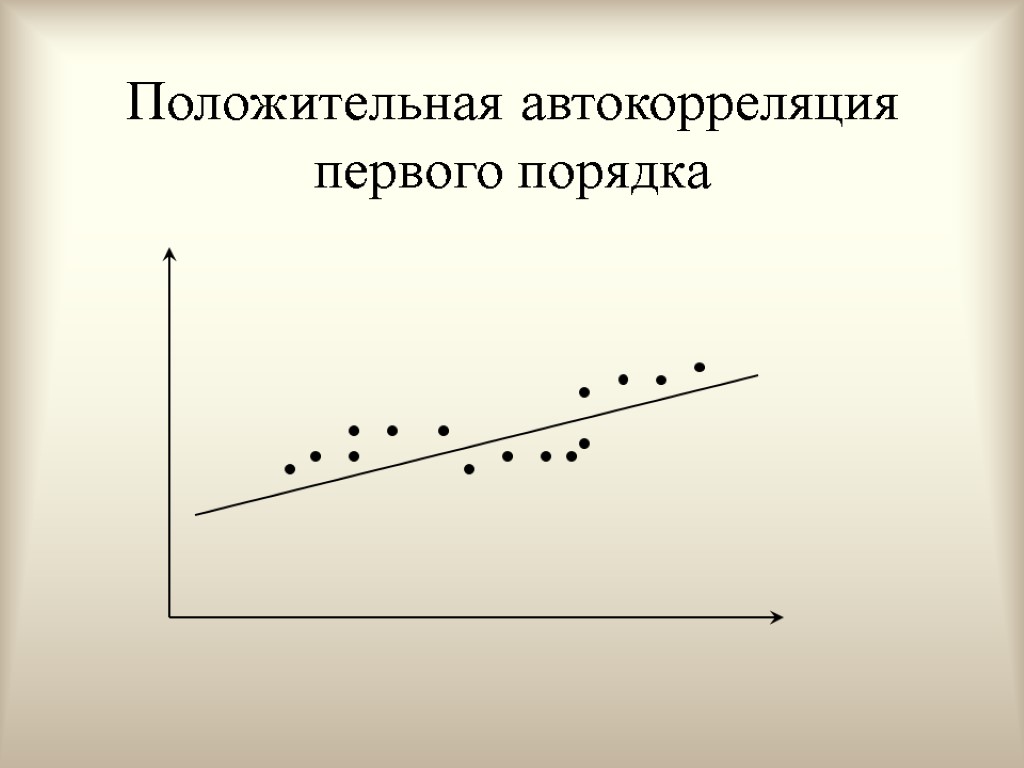

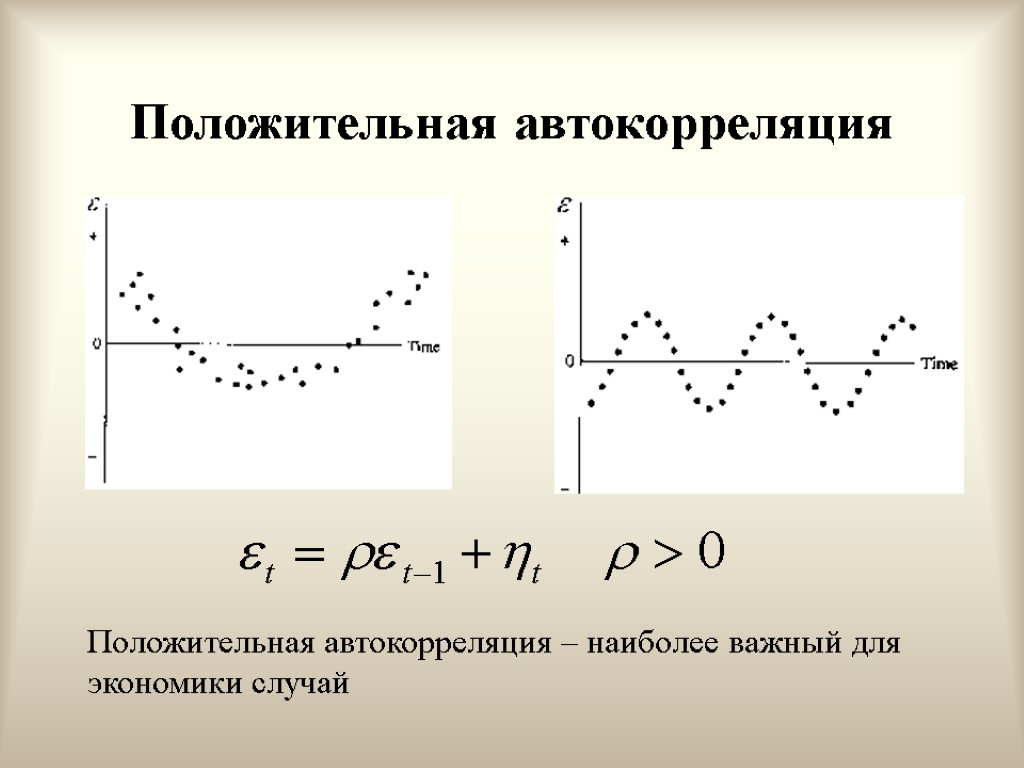

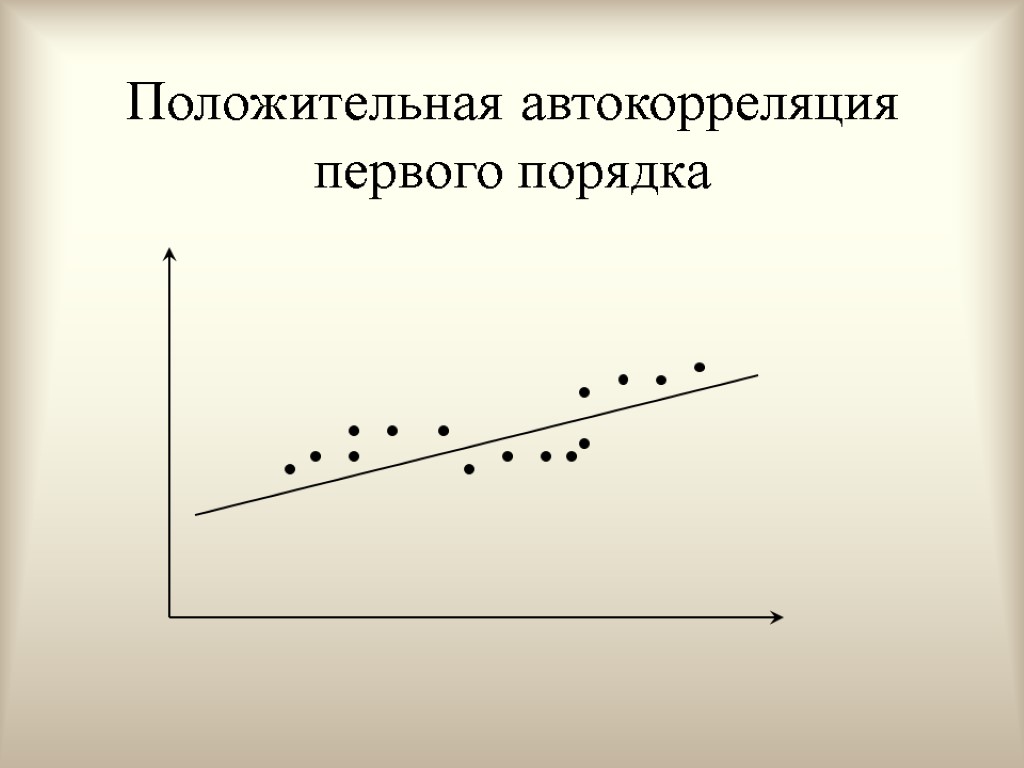

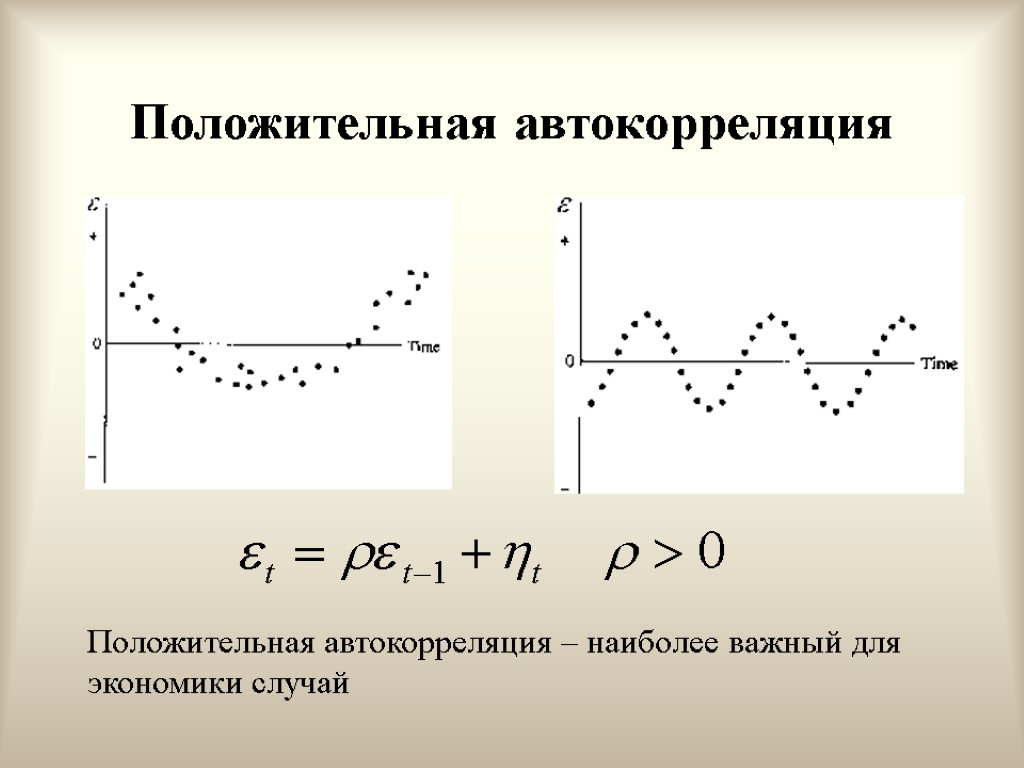

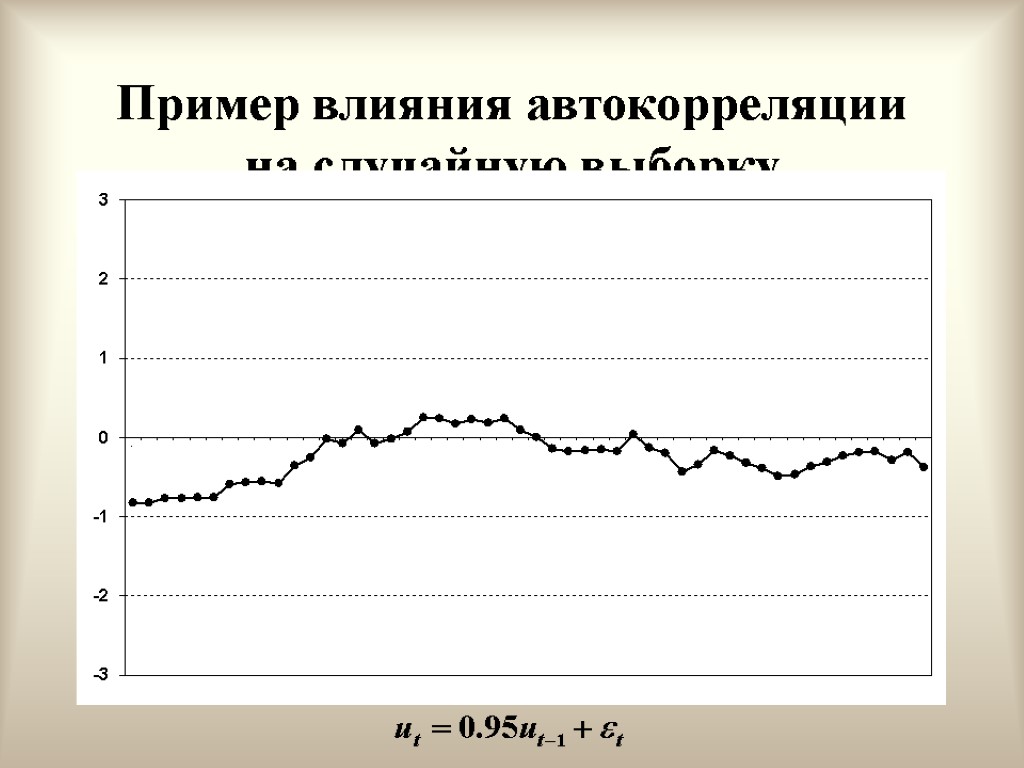

Положительная автокорреляция первого порядка

Положительная автокорреляция первого порядка

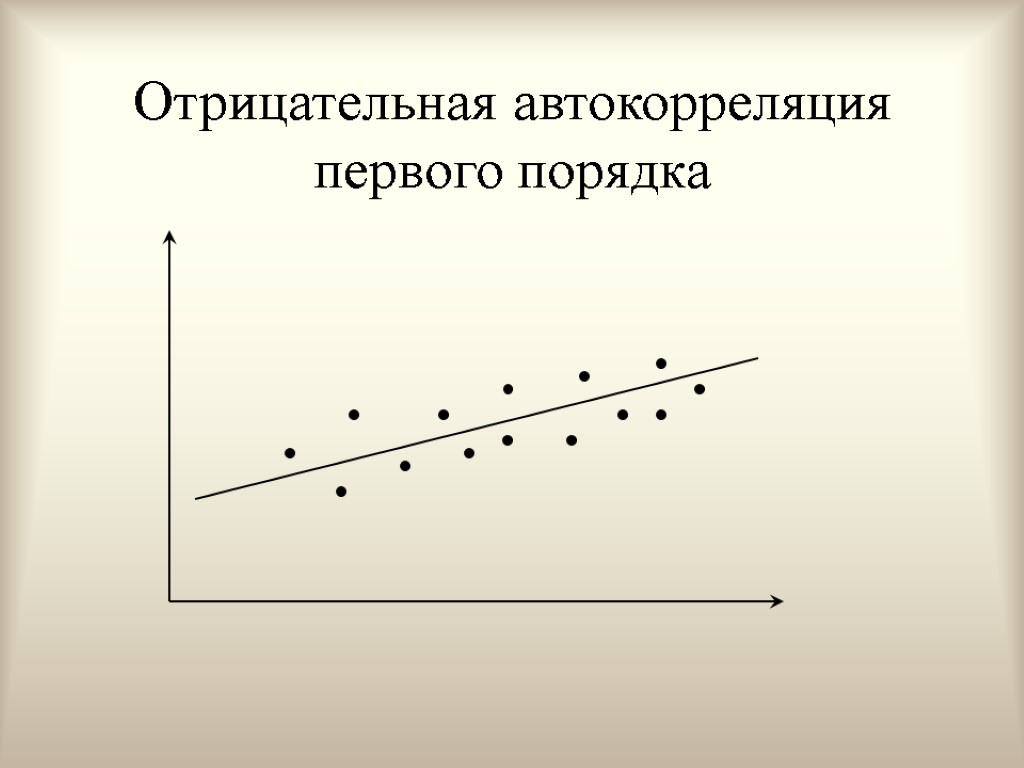

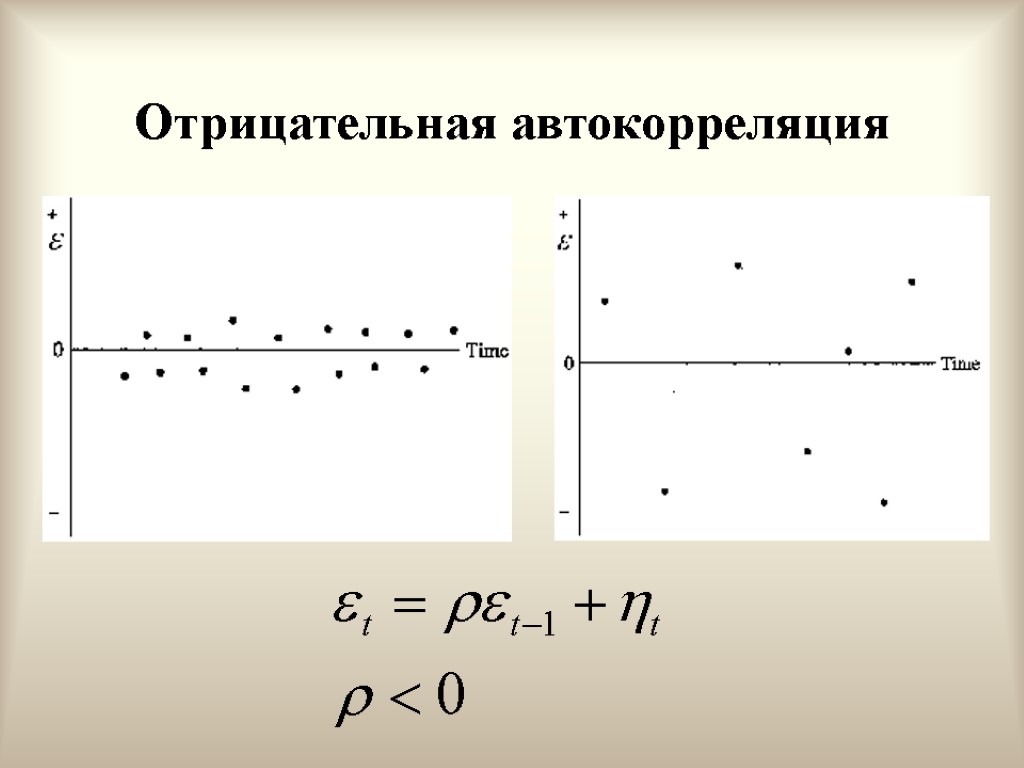

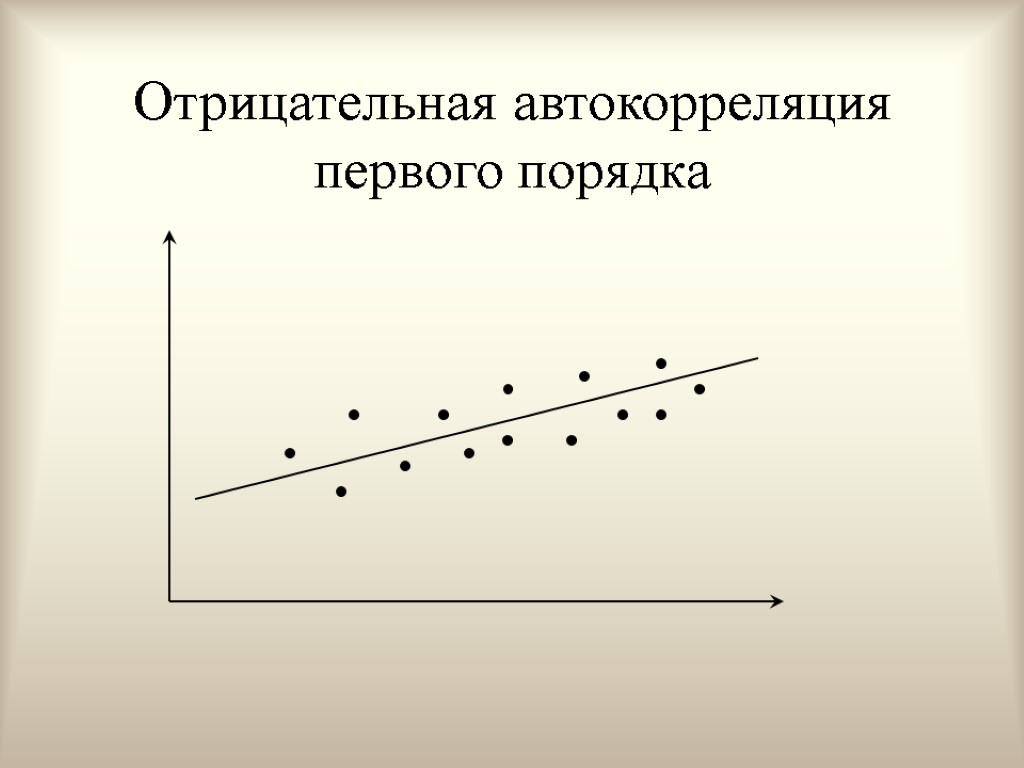

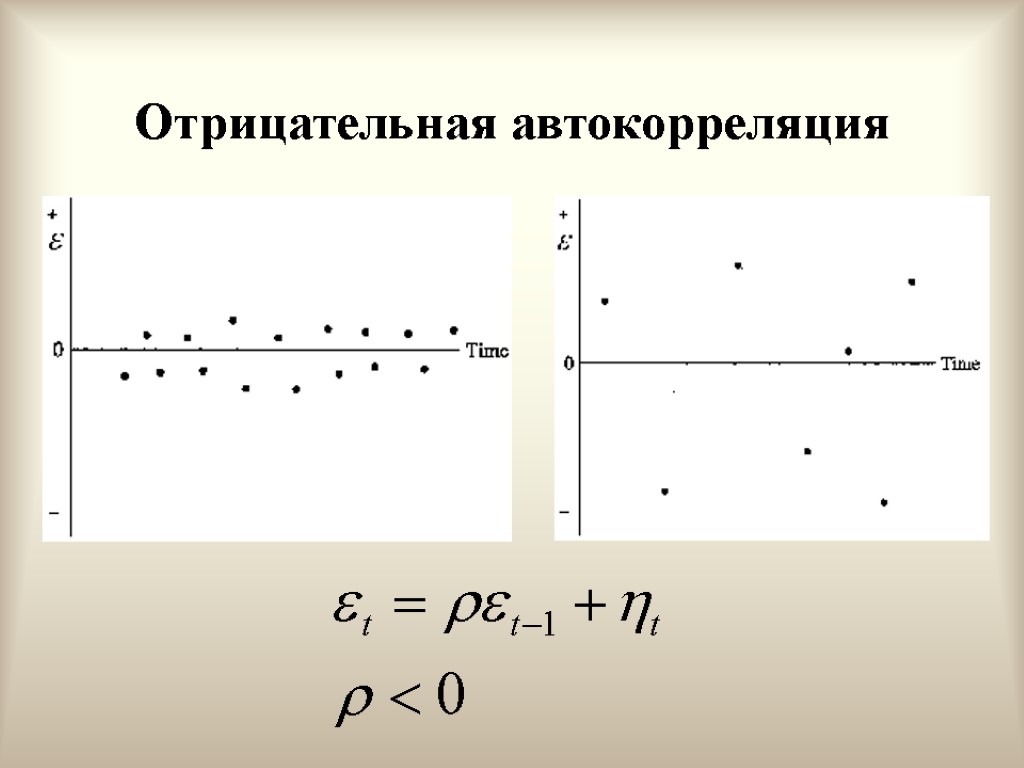

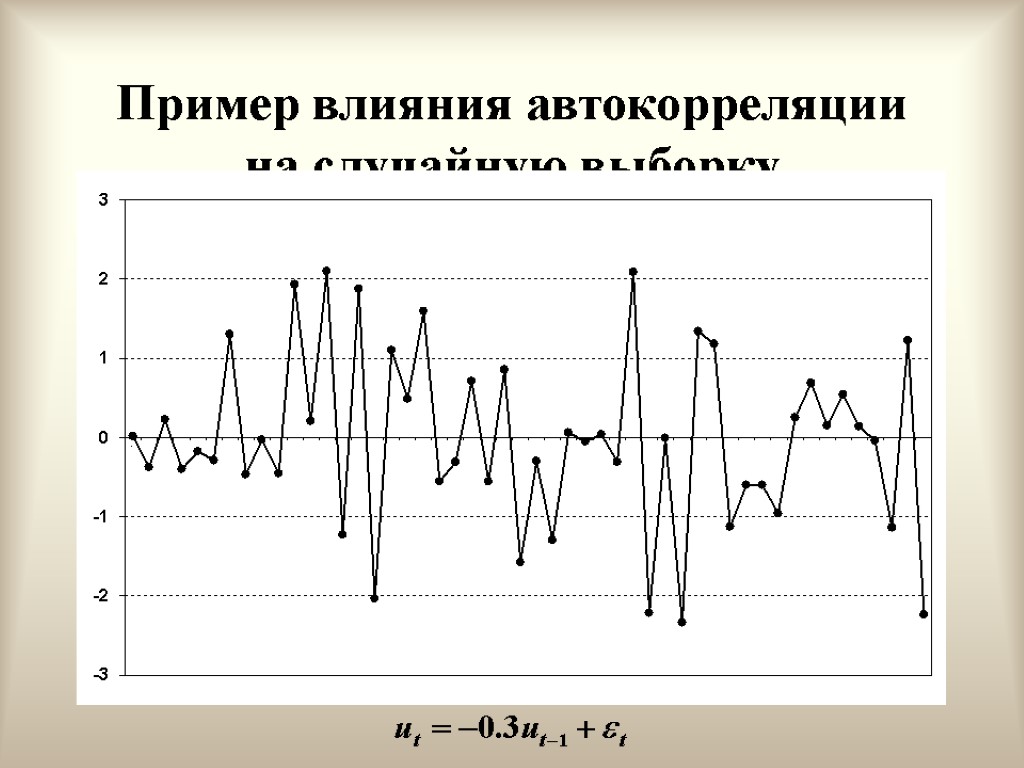

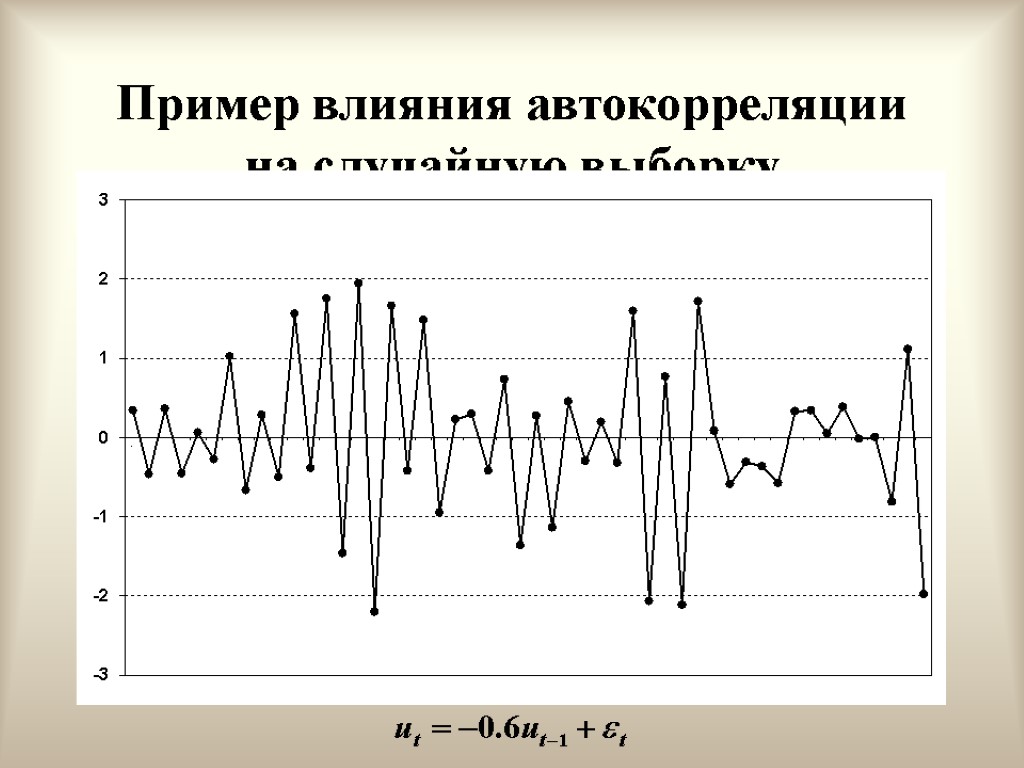

Отрицательная автокорреляция первого порядка

Отрицательная автокорреляция первого порядка

Интерпретация условий (условие 6) Нормальность ошибок Ошибки являются суммарным влиянием переменных, невключенных в регрессионное уравнение. Отсюда, как следует из центральной предельной теоремы Ляпунова, при выполнении определенных условий i будут иметь почти нормальное распределение. Отметим, что в случае КЛРМ условие 5 эквивалентно условию статистической независимости ошибок для разных наблюдений. Действительно, если две нормально распределенные величины не коррелированны, то они независимы. В общем случае это не выполняется.

Интерпретация условий (условие 6) Нормальность ошибок Ошибки являются суммарным влиянием переменных, невключенных в регрессионное уравнение. Отсюда, как следует из центральной предельной теоремы Ляпунова, при выполнении определенных условий i будут иметь почти нормальное распределение. Отметим, что в случае КЛРМ условие 5 эквивалентно условию статистической независимости ошибок для разных наблюдений. Действительно, если две нормально распределенные величины не коррелированны, то они независимы. В общем случае это не выполняется.

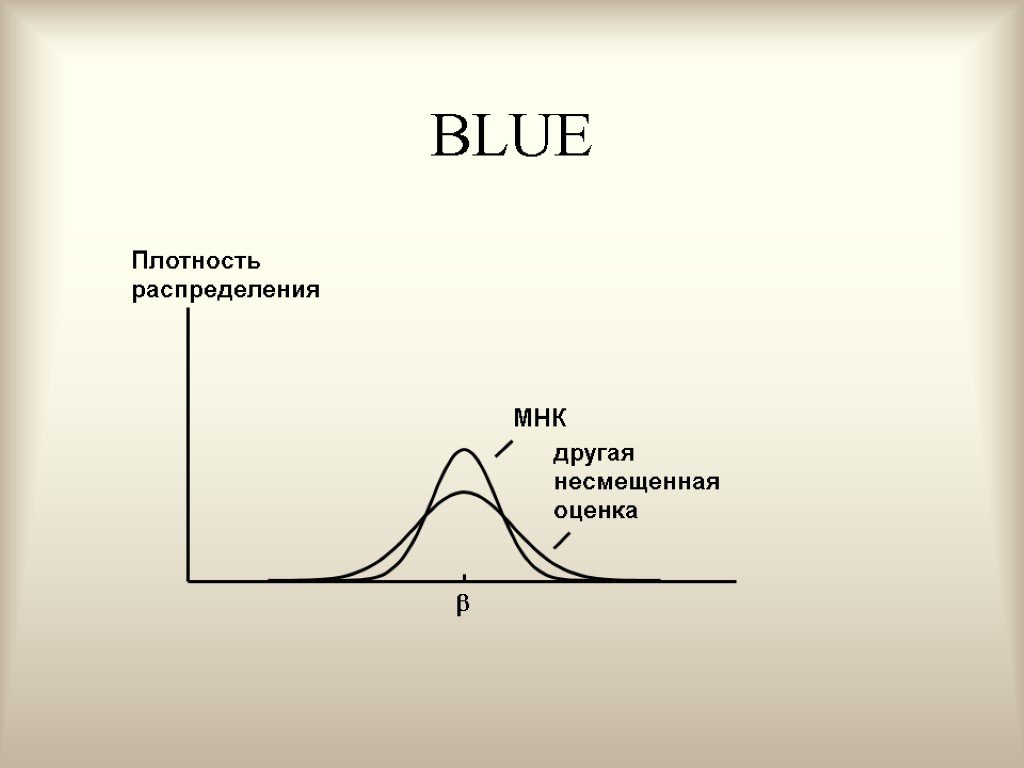

Теорема Гаусса - Маркова В условиях 1-5 МНК-оценки МЛРМ представляют собой наилучшие линейные несмещенные оценки, т. е. в классе линейных несмещенных оценок МНК-оценки обладают наименьшей дисперсией. Best Linear Unbaised Estimation (BLUE)

Теорема Гаусса - Маркова В условиях 1-5 МНК-оценки МЛРМ представляют собой наилучшие линейные несмещенные оценки, т. е. в классе линейных несмещенных оценок МНК-оценки обладают наименьшей дисперсией. Best Linear Unbaised Estimation (BLUE)

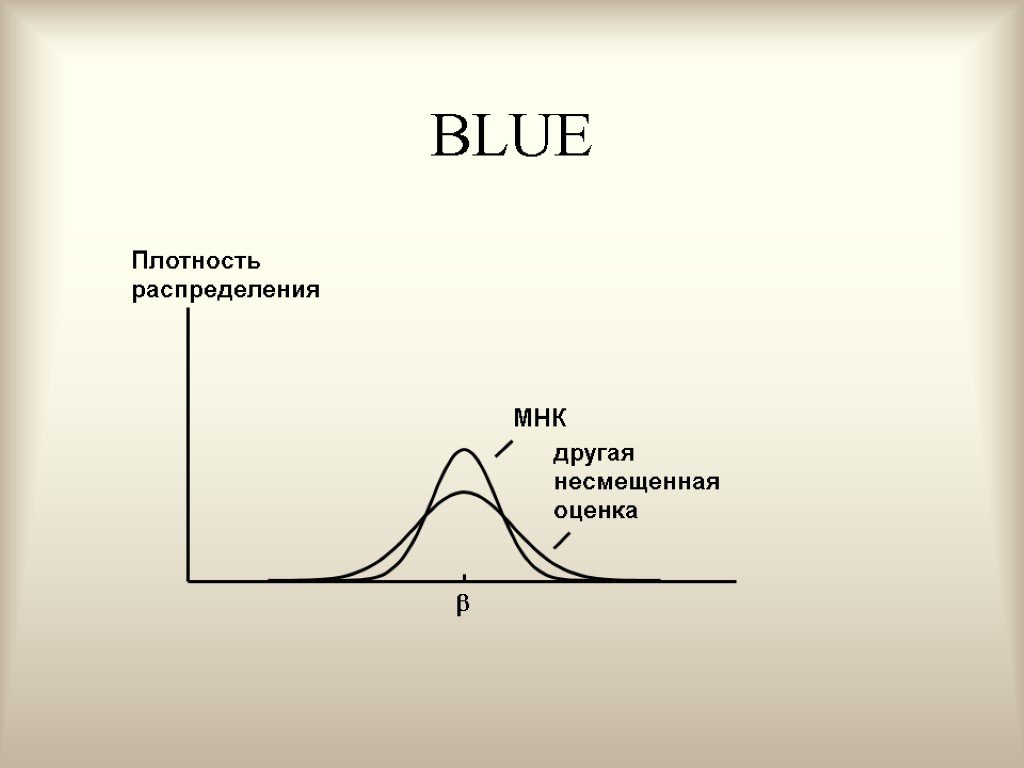

BLUE

BLUE

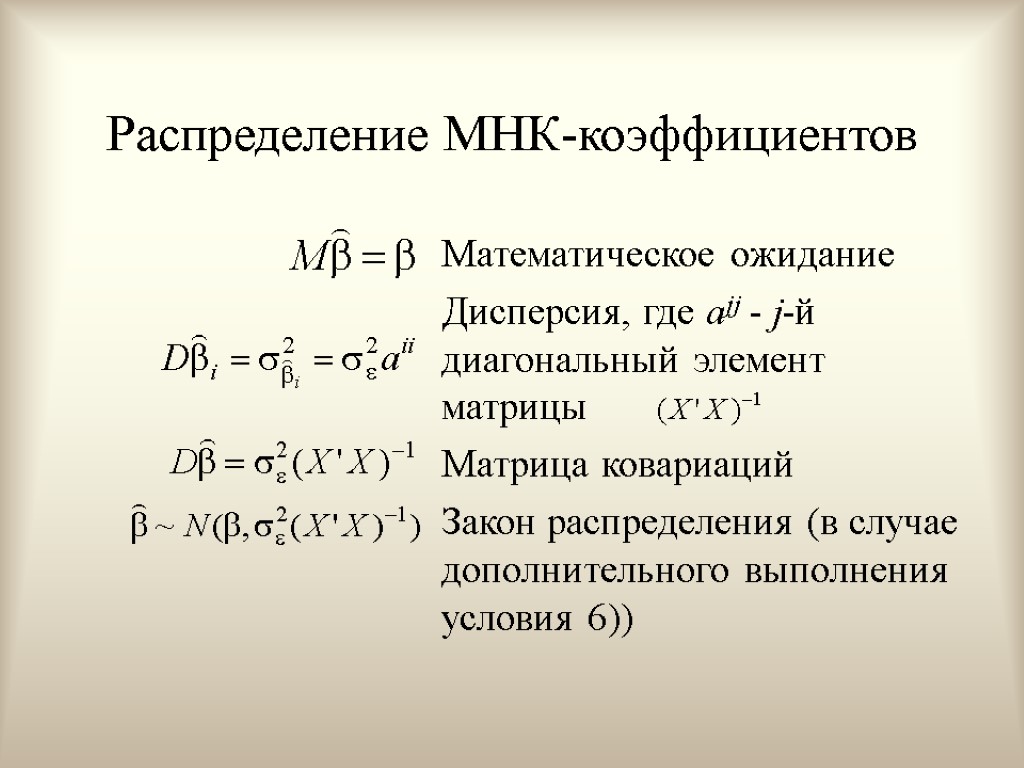

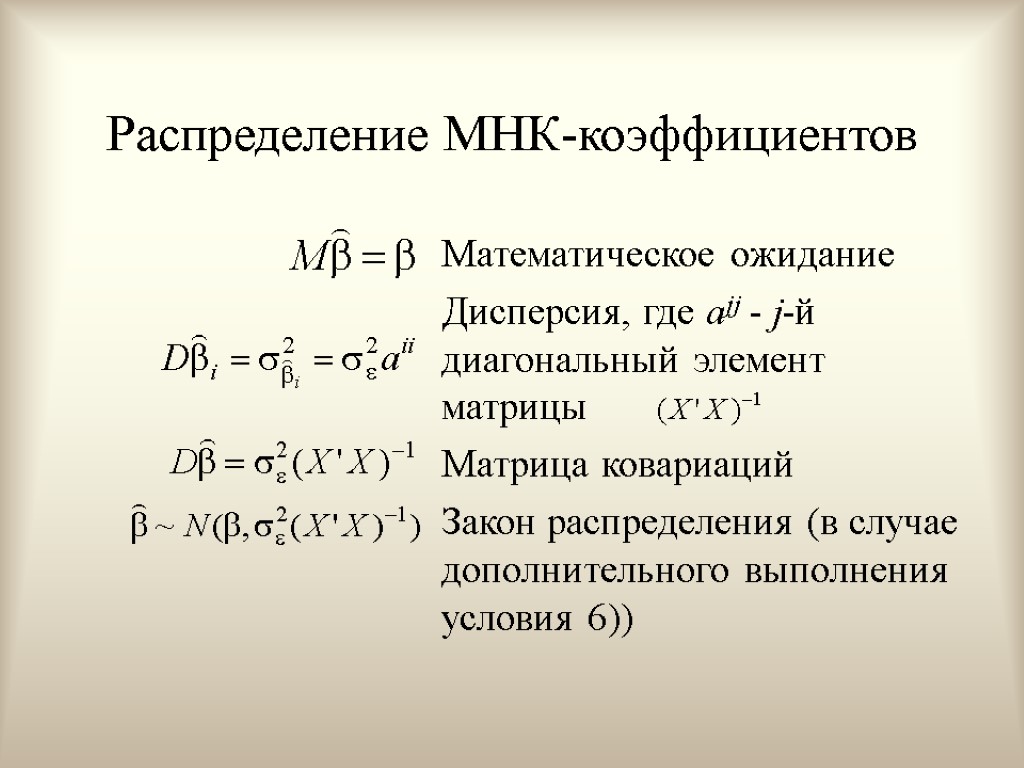

Распределение МНК-коэффициентов Математическое ожидание Дисперсия, где ajj - j-й диагональный элемент матрицы Матрица ковариаций Закон распределения (в случае дополнительного выполнения условия 6))

Распределение МНК-коэффициентов Математическое ожидание Дисперсия, где ajj - j-й диагональный элемент матрицы Матрица ковариаций Закон распределения (в случае дополнительного выполнения условия 6))

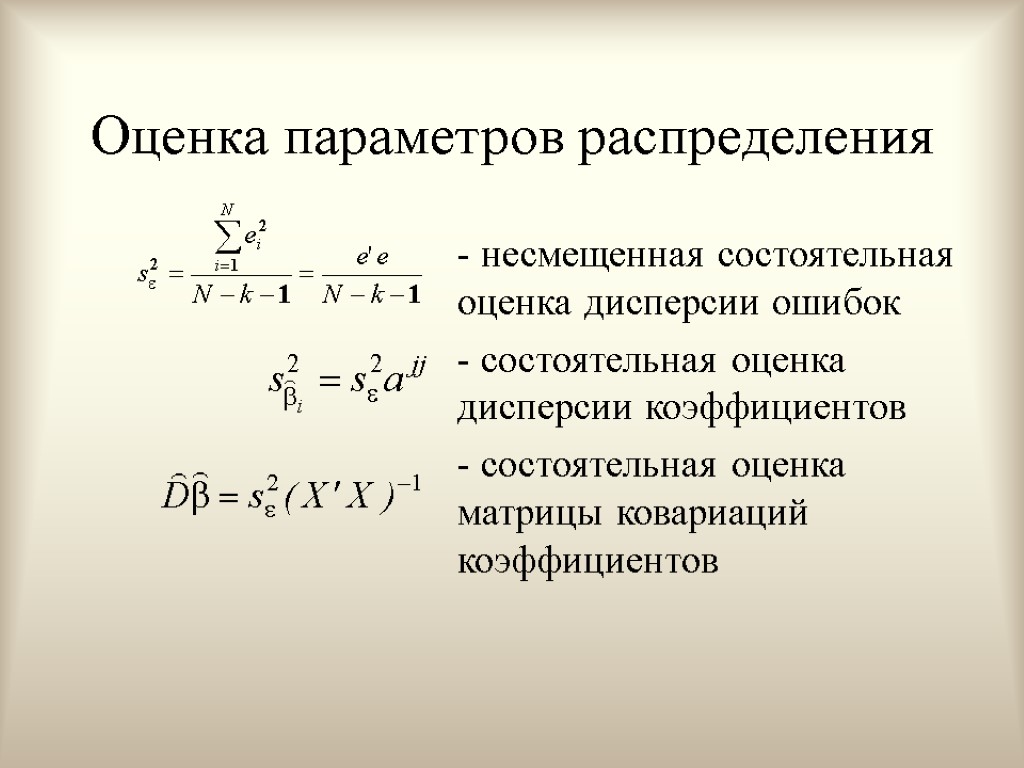

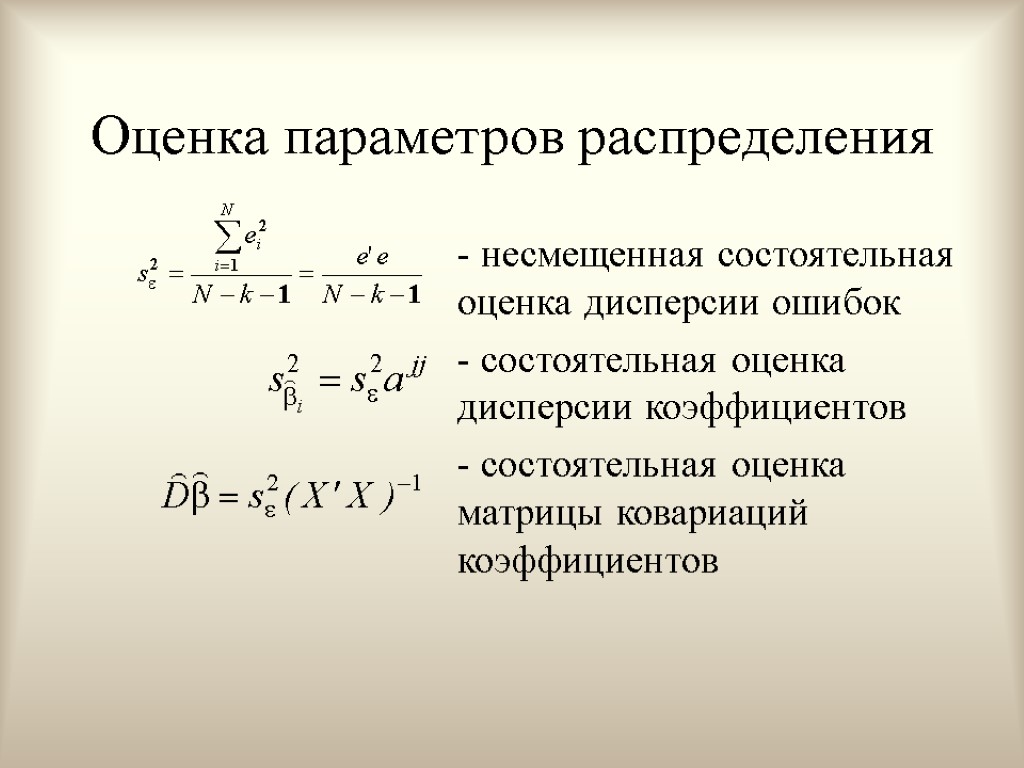

Оценка параметров распределения - несмещенная состоятельная оценка дисперсии ошибок - состоятельная оценка дисперсии коэффициентов - состоятельная оценка матрицы ковариаций коэффициентов

Оценка параметров распределения - несмещенная состоятельная оценка дисперсии ошибок - состоятельная оценка дисперсии коэффициентов - состоятельная оценка матрицы ковариаций коэффициентов

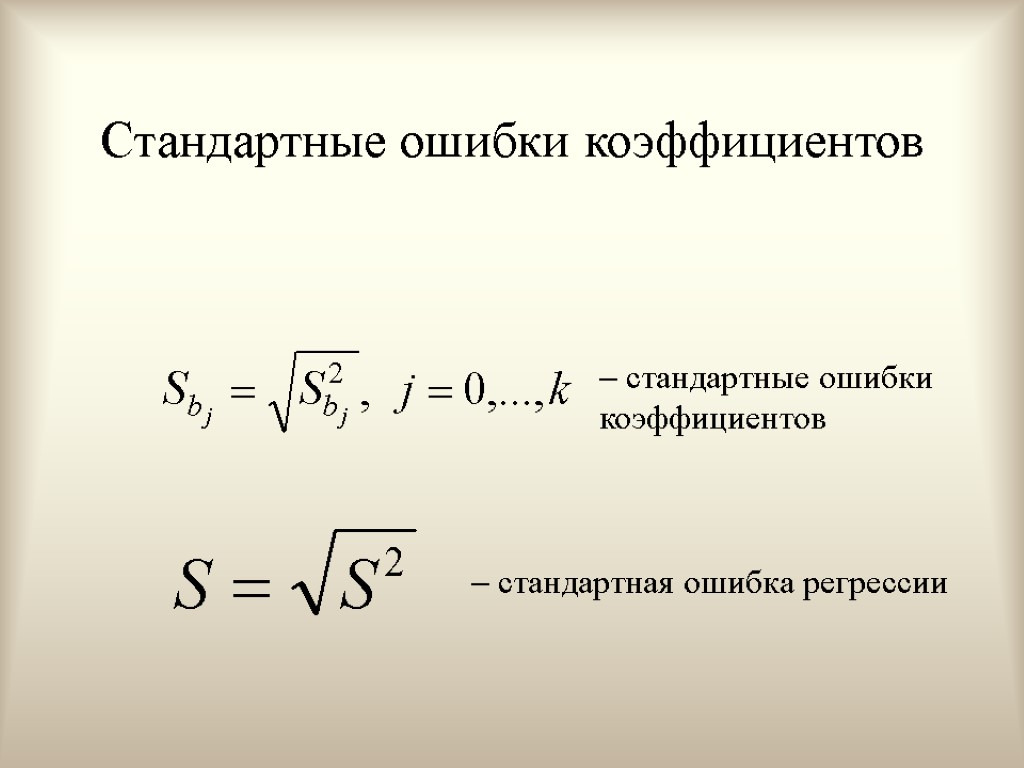

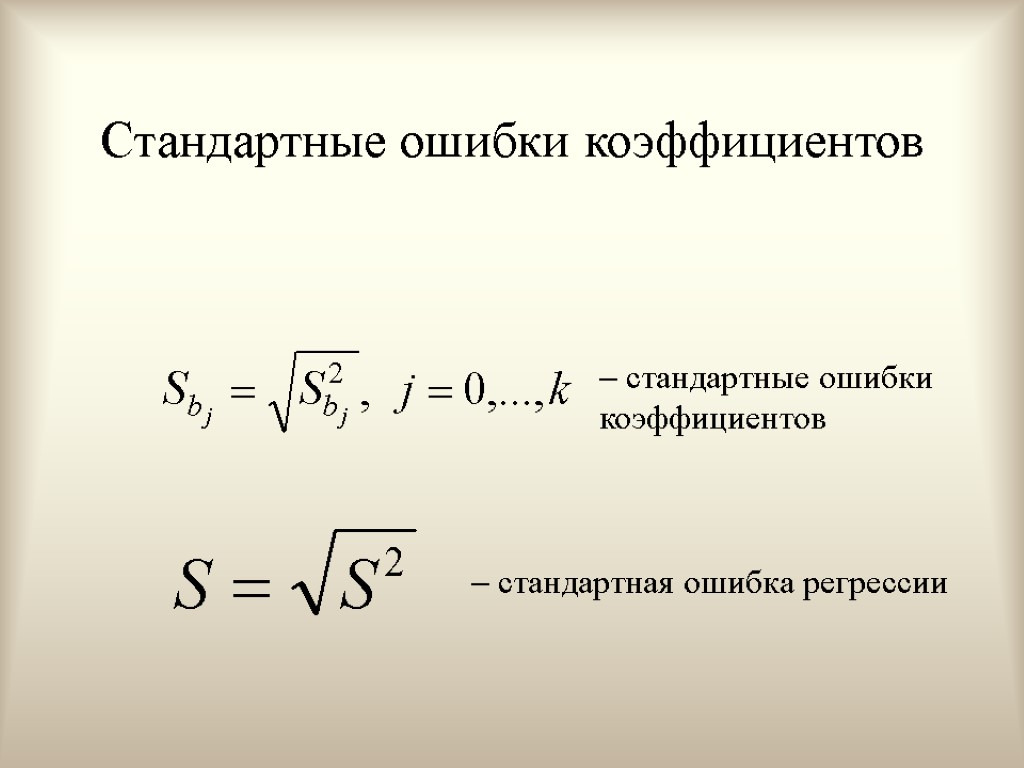

Стандартные ошибки коэффициентов стандартная ошибка регрессии стандартные ошибки коэффициентов

Стандартные ошибки коэффициентов стандартная ошибка регрессии стандартные ошибки коэффициентов

Вопросы для повторения Какие вы знаете свойства статистических оценок. Какие свойства относятся к асимптотическим свойствам оценок. Перечислите условия Гаусса-Маркова. Каков содержательный смысл условия гомоскедастичночти. Каков содержательный смысл условия отсутствия автокорреляции ошибок. Какие условия Гаусса Маркова используются при доказательстве несмещенности МНК-коэффициентов. Какие условия Гаусса Маркова используются при доказательстве эффективности МНК-коэффициентов. Что произойдет, если математическое ожидание ошибки уравненяи будет отлично от нуля. Где используется предположение о нормальности ошибок. Что такое стандартная ошибка регрессии, стандартная ошибка коэффициента. Согласны ли вы с тем, что несмещенная оценка всегда лучше, чем смещенная. Сформулируйте теорему Гаусса-Маркова

Вопросы для повторения Какие вы знаете свойства статистических оценок. Какие свойства относятся к асимптотическим свойствам оценок. Перечислите условия Гаусса-Маркова. Каков содержательный смысл условия гомоскедастичночти. Каков содержательный смысл условия отсутствия автокорреляции ошибок. Какие условия Гаусса Маркова используются при доказательстве несмещенности МНК-коэффициентов. Какие условия Гаусса Маркова используются при доказательстве эффективности МНК-коэффициентов. Что произойдет, если математическое ожидание ошибки уравненяи будет отлично от нуля. Где используется предположение о нормальности ошибок. Что такое стандартная ошибка регрессии, стандартная ошибка коэффициента. Согласны ли вы с тем, что несмещенная оценка всегда лучше, чем смещенная. Сформулируйте теорему Гаусса-Маркова

Тема 7. Проверка гипотез относительно возможных значений коэффициентов МЛРМ

Тема 7. Проверка гипотез относительно возможных значений коэффициентов МЛРМ

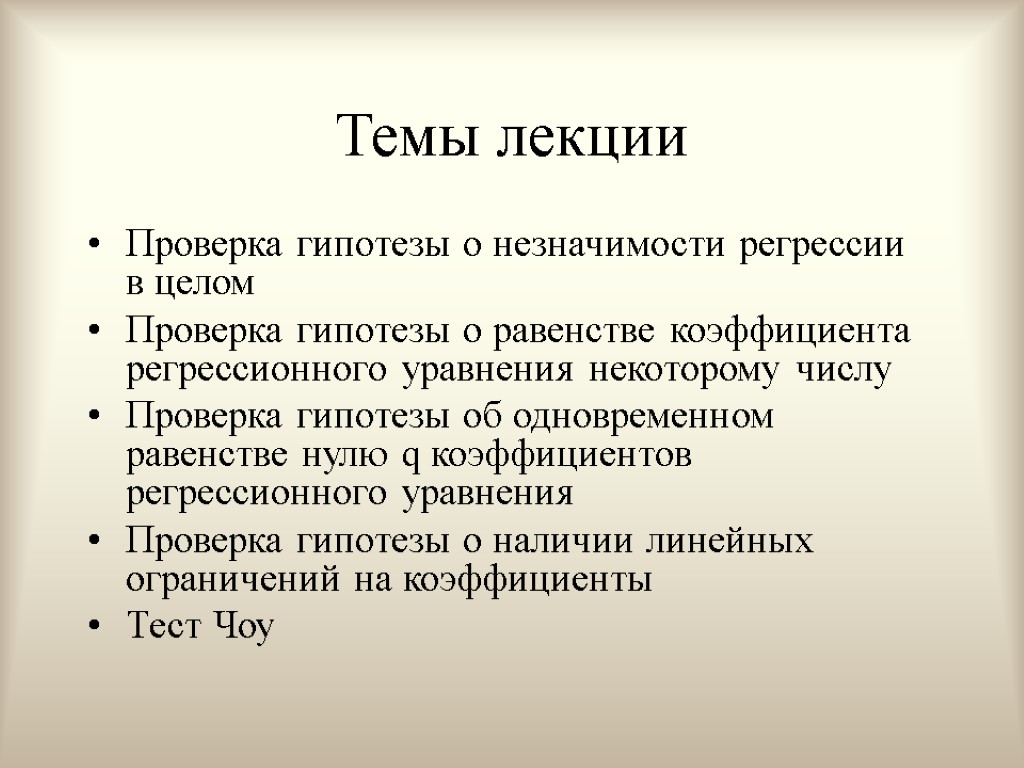

Темы лекции Проверка гипотезы о незначимости регрессии в целом Проверка гипотезы о равенстве коэффициента регрессионного уравнения некоторому числу Проверка гипотезы об одновременном равенстве нулю q коэффициентов регрессионного уравнения Проверка гипотезы о наличии линейных ограничений на коэффициенты Тест Чоу

Темы лекции Проверка гипотезы о незначимости регрессии в целом Проверка гипотезы о равенстве коэффициента регрессионного уравнения некоторому числу Проверка гипотезы об одновременном равенстве нулю q коэффициентов регрессионного уравнения Проверка гипотезы о наличии линейных ограничений на коэффициенты Тест Чоу

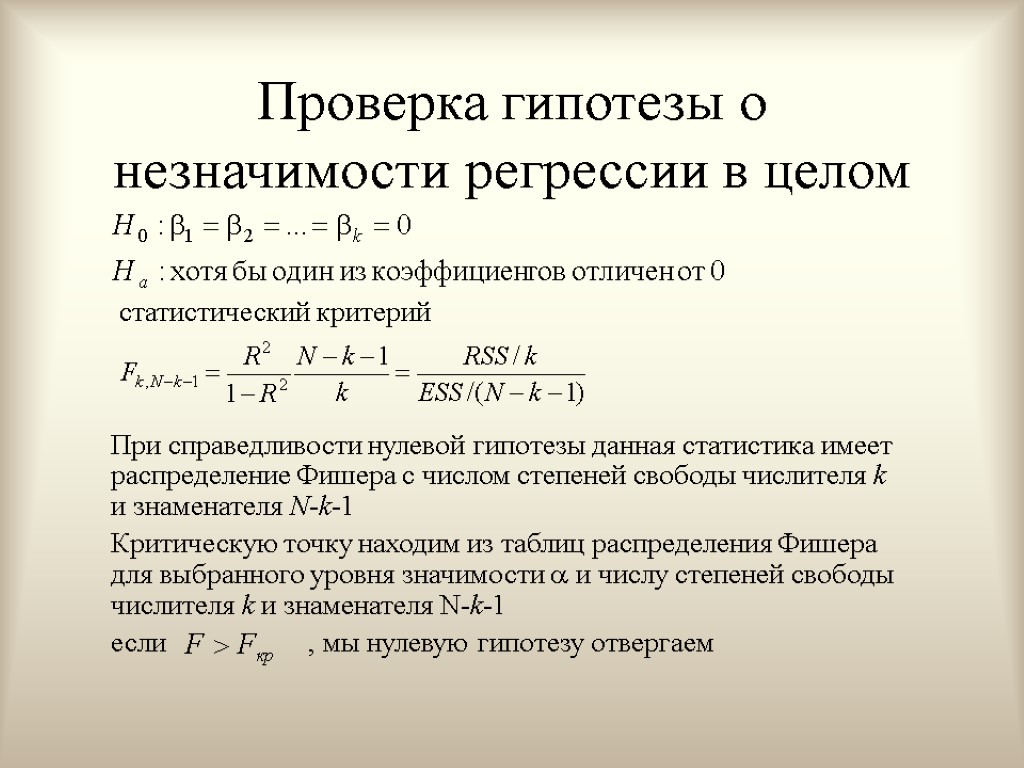

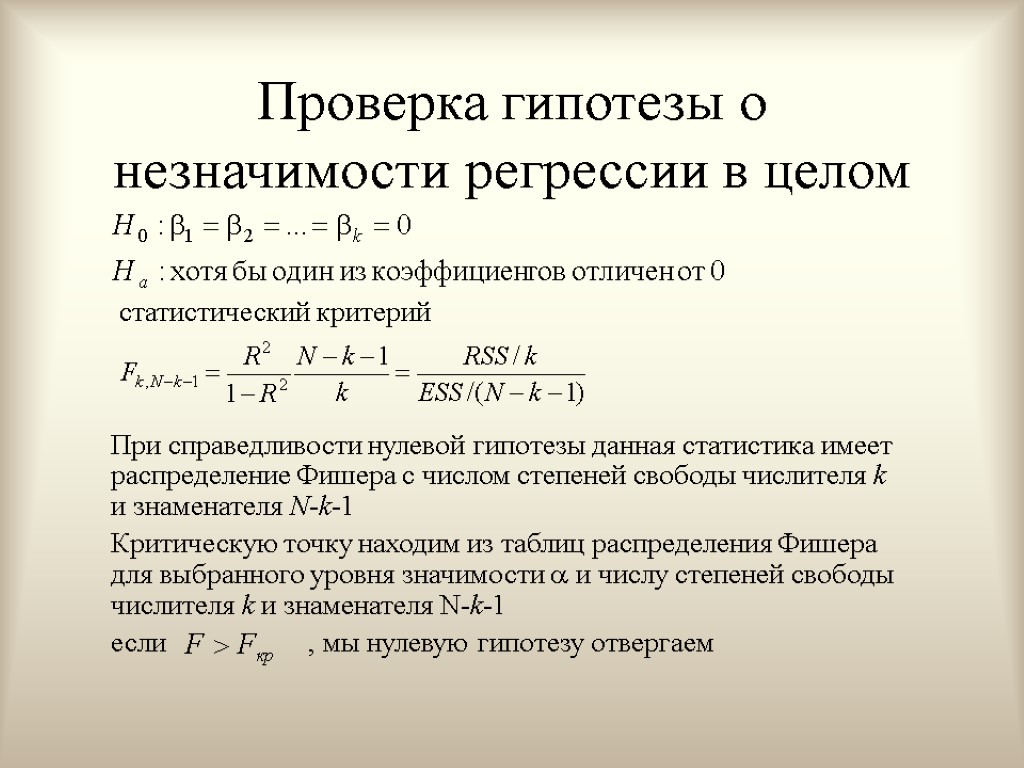

Проверка гипотезы о незначимости регрессии в целом статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Фишера с числом степеней свободы числителя k и знаменателя N-k-1 Критическую точку находим из таблиц распределения Фишера для выбранного уровня значимости и числу степеней свободы числителя k и знаменателя N-k-1 если , мы нулевую гипотезу отвергаем

Проверка гипотезы о незначимости регрессии в целом статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Фишера с числом степеней свободы числителя k и знаменателя N-k-1 Критическую точку находим из таблиц распределения Фишера для выбранного уровня значимости и числу степеней свободы числителя k и знаменателя N-k-1 если , мы нулевую гипотезу отвергаем

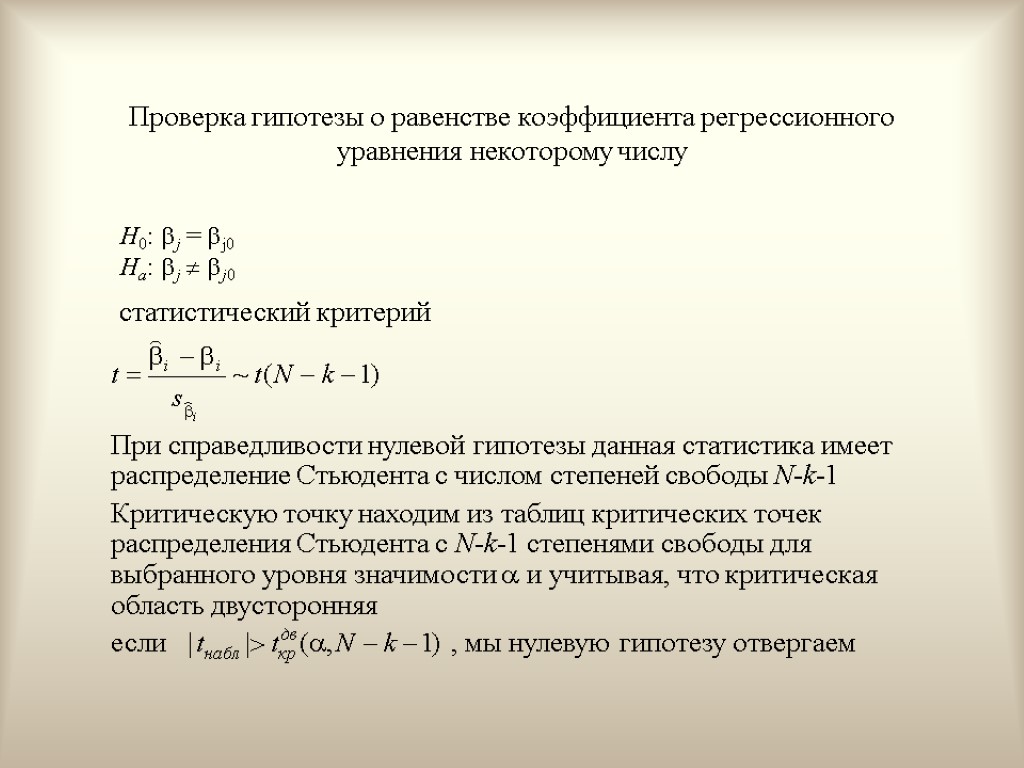

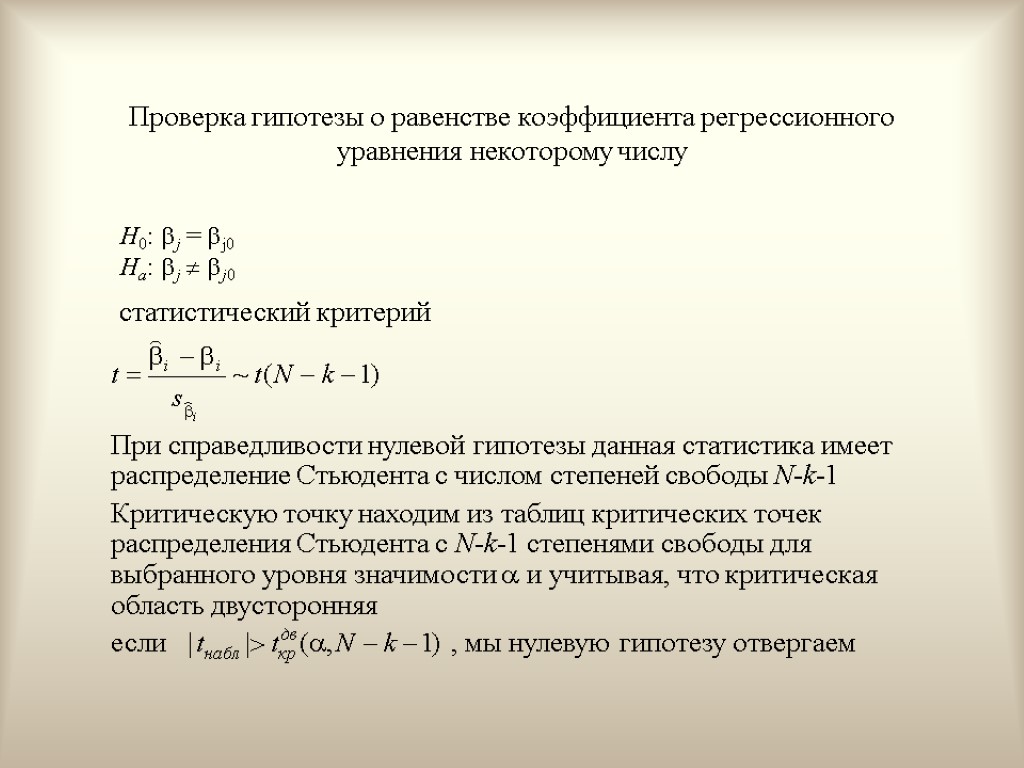

Проверка гипотезы о равенстве коэффициента регрессионного уравнения некоторому числу статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Стьюдента с числом степеней свободы N-k-1 Критическую точку находим из таблиц критических точек распределения Стьюдента с N-k-1 степенями свободы для выбранного уровня значимости и учитывая, что критическая область двусторонняя если , мы нулевую гипотезу отвергаем H0: j = j0 Hа: j j0

Проверка гипотезы о равенстве коэффициента регрессионного уравнения некоторому числу статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Стьюдента с числом степеней свободы N-k-1 Критическую точку находим из таблиц критических точек распределения Стьюдента с N-k-1 степенями свободы для выбранного уровня значимости и учитывая, что критическая область двусторонняя если , мы нулевую гипотезу отвергаем H0: j = j0 Hа: j j0

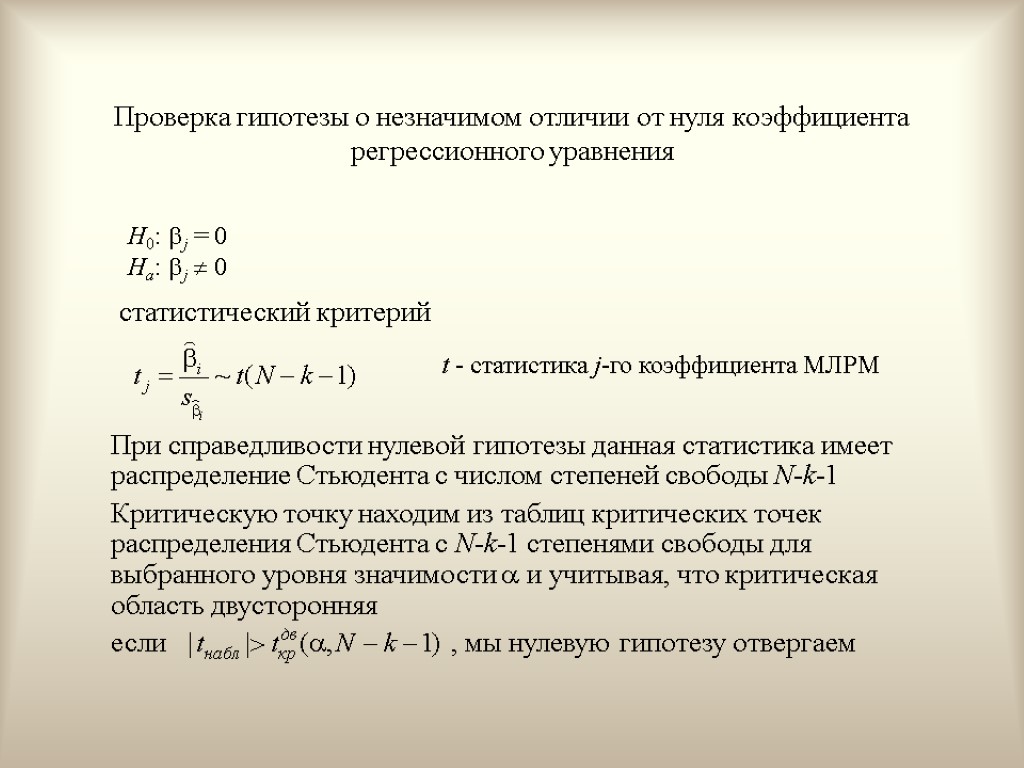

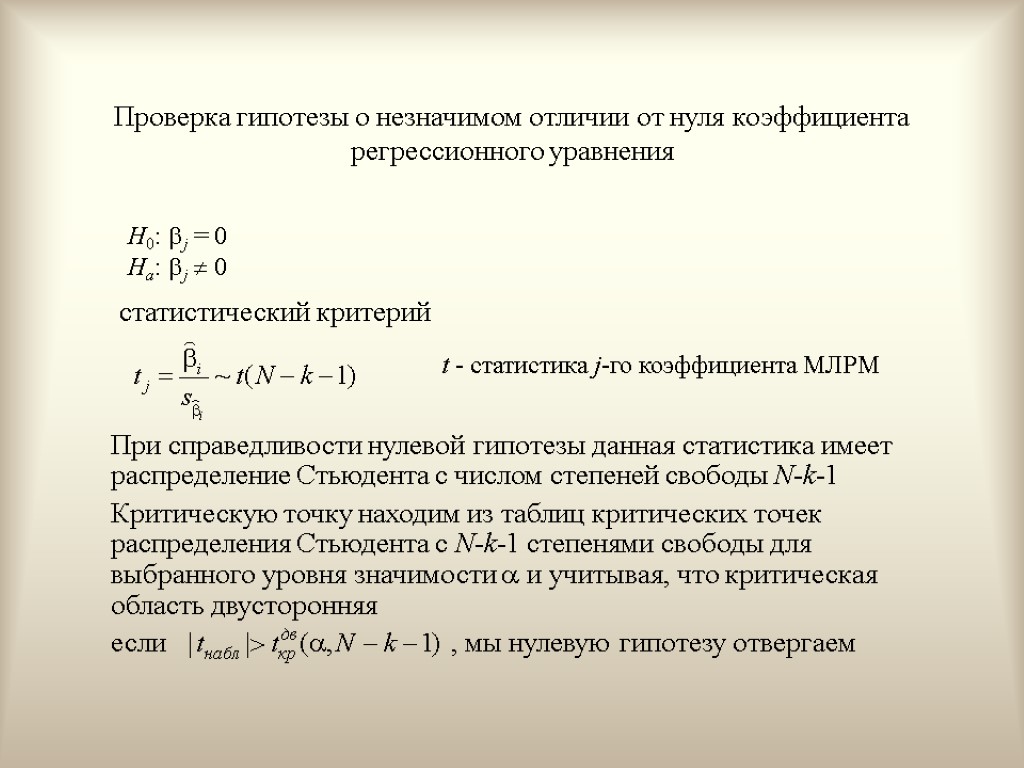

Проверка гипотезы о незначимом отличии от нуля коэффициента регрессионного уравнения статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Стьюдента с числом степеней свободы N-k-1 Критическую точку находим из таблиц критических точек распределения Стьюдента с N-k-1 степенями свободы для выбранного уровня значимости и учитывая, что критическая область двусторонняя если , мы нулевую гипотезу отвергаем H0: j = 0 Hа: j 0 t - статистика j-го коэффициента МЛРМ

Проверка гипотезы о незначимом отличии от нуля коэффициента регрессионного уравнения статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Стьюдента с числом степеней свободы N-k-1 Критическую точку находим из таблиц критических точек распределения Стьюдента с N-k-1 степенями свободы для выбранного уровня значимости и учитывая, что критическая область двусторонняя если , мы нулевую гипотезу отвергаем H0: j = 0 Hа: j 0 t - статистика j-го коэффициента МЛРМ

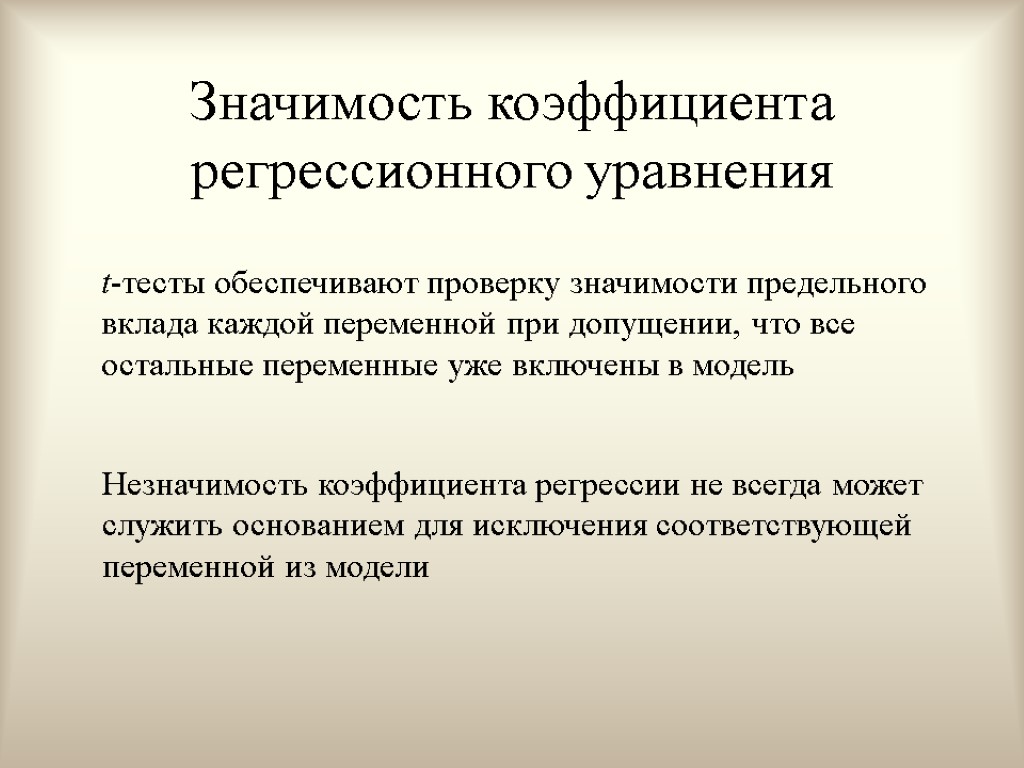

Значимость коэффициента регрессионного уравнения t-тесты обеспечивают проверку значимости предельного вклада каждой переменной при допущении, что все остальные переменные уже включены в модель Незначимость коэффициента регрессии не всегда может служить основанием для исключения соответствующей переменной из модели

Значимость коэффициента регрессионного уравнения t-тесты обеспечивают проверку значимости предельного вклада каждой переменной при допущении, что все остальные переменные уже включены в модель Незначимость коэффициента регрессии не всегда может служить основанием для исключения соответствующей переменной из модели

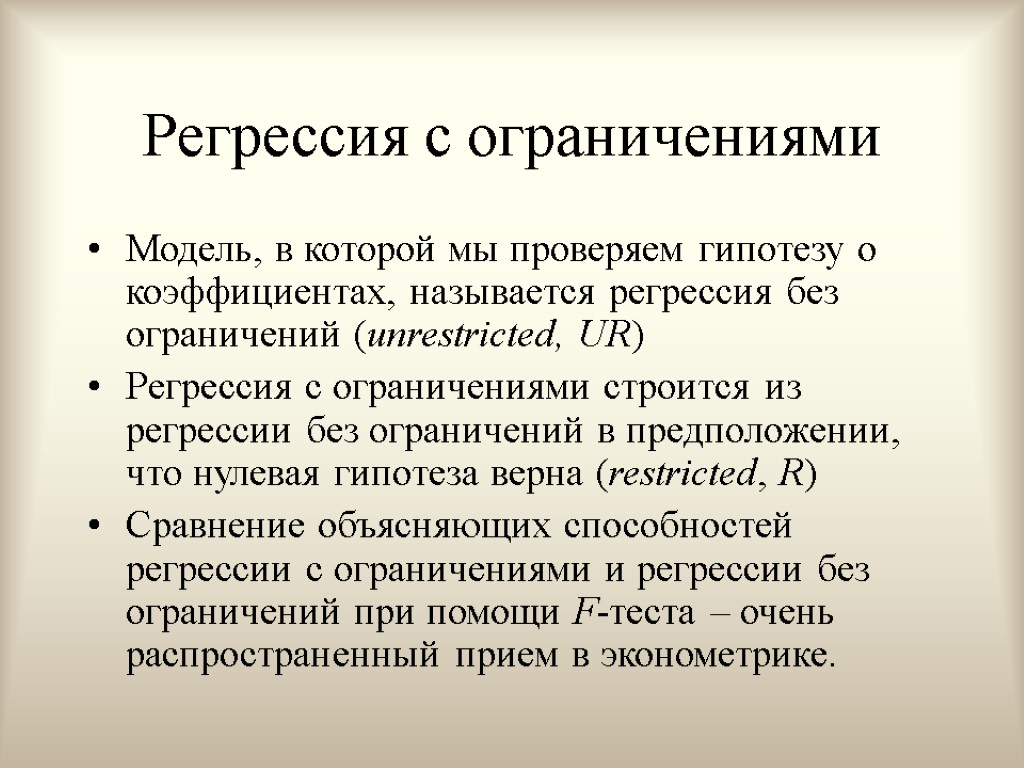

Регрессия с ограничениями Модель, в которой мы проверяем гипотезу о коэффициентах, называется регрессия без ограничений (unrestricted, UR) Регрессия с ограничениями строится из регрессии без ограничений в предположении, что нулевая гипотеза верна (restricted, R) Сравнение объясняющих способностей регрессии с ограничениями и регрессии без ограничений при помощи F-теста – очень распространенный прием в эконометрике.

Регрессия с ограничениями Модель, в которой мы проверяем гипотезу о коэффициентах, называется регрессия без ограничений (unrestricted, UR) Регрессия с ограничениями строится из регрессии без ограничений в предположении, что нулевая гипотеза верна (restricted, R) Сравнение объясняющих способностей регрессии с ограничениями и регрессии без ограничений при помощи F-теста – очень распространенный прием в эконометрике.

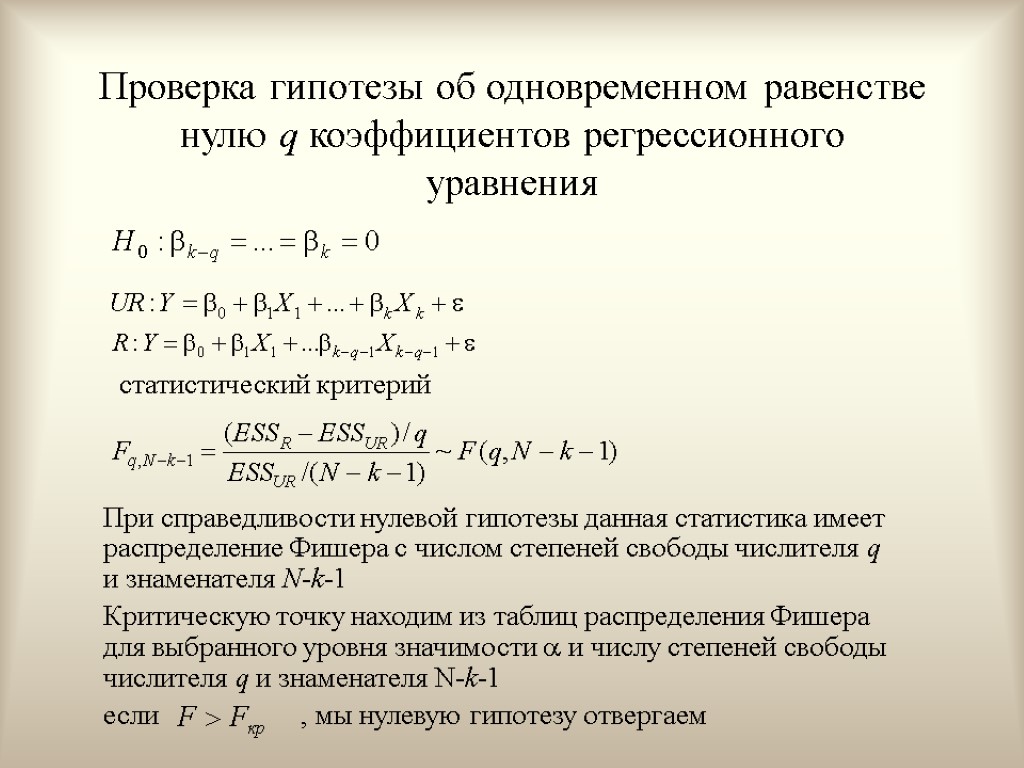

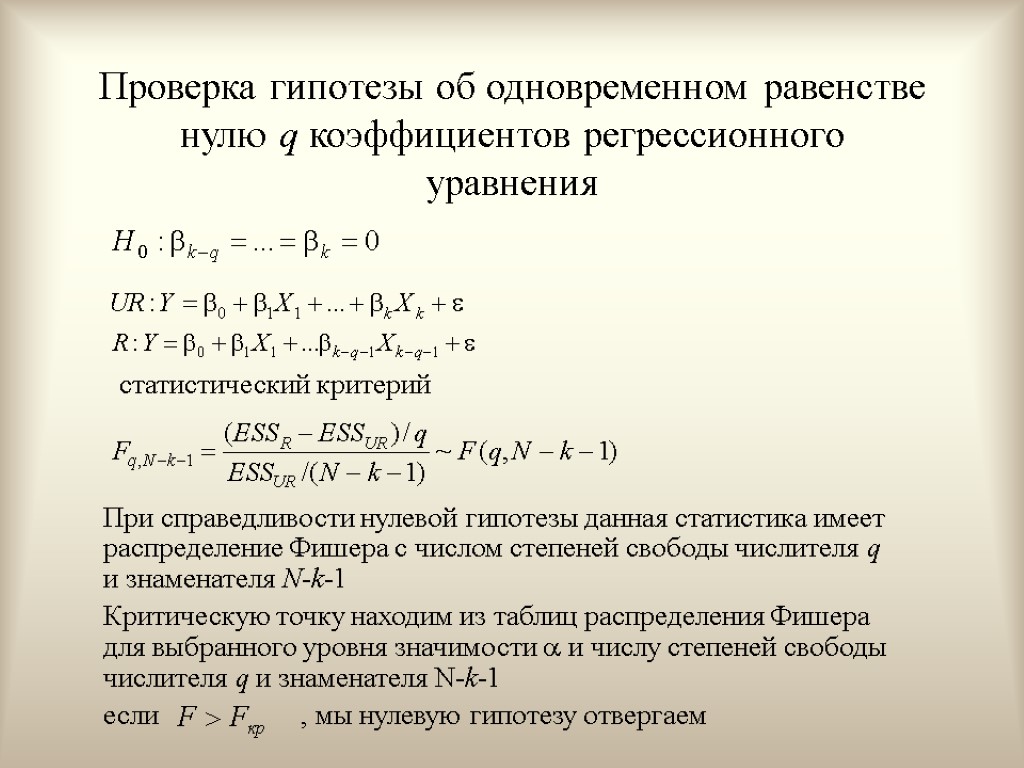

Проверка гипотезы об одновременном равенстве нулю q коэффициентов регрессионного уравнения статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Фишера с числом степеней свободы числителя q и знаменателя N-k-1 Критическую точку находим из таблиц распределения Фишера для выбранного уровня значимости и числу степеней свободы числителя q и знаменателя N-k-1 если , мы нулевую гипотезу отвергаем

Проверка гипотезы об одновременном равенстве нулю q коэффициентов регрессионного уравнения статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Фишера с числом степеней свободы числителя q и знаменателя N-k-1 Критическую точку находим из таблиц распределения Фишера для выбранного уровня значимости и числу степеней свободы числителя q и знаменателя N-k-1 если , мы нулевую гипотезу отвергаем

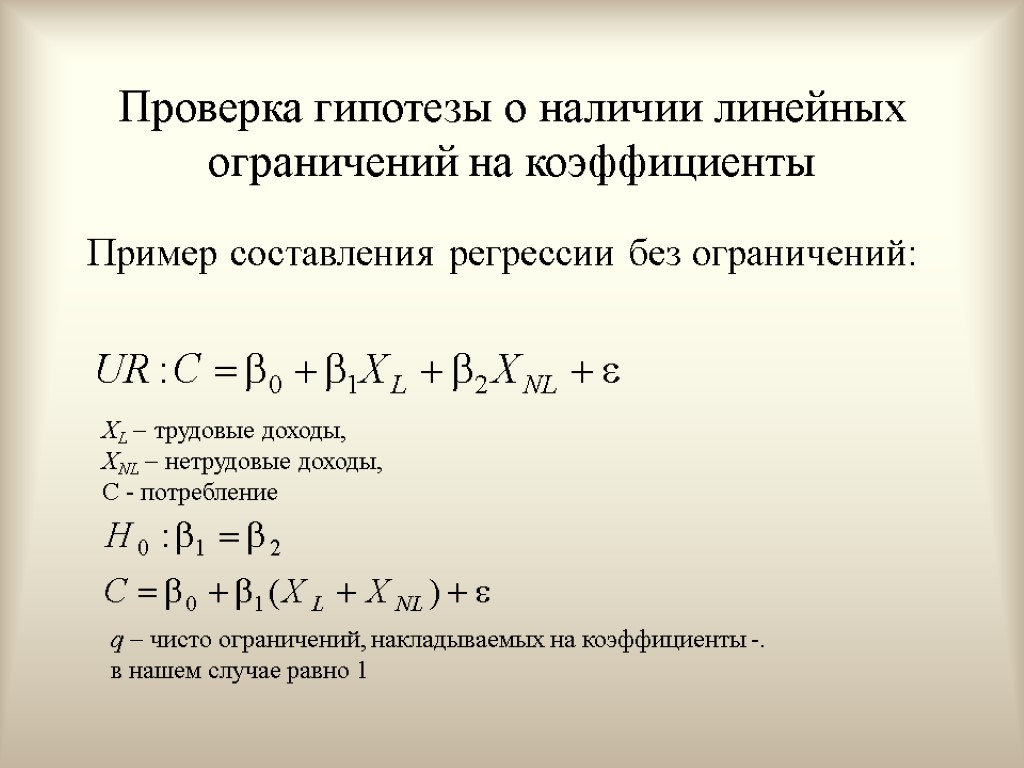

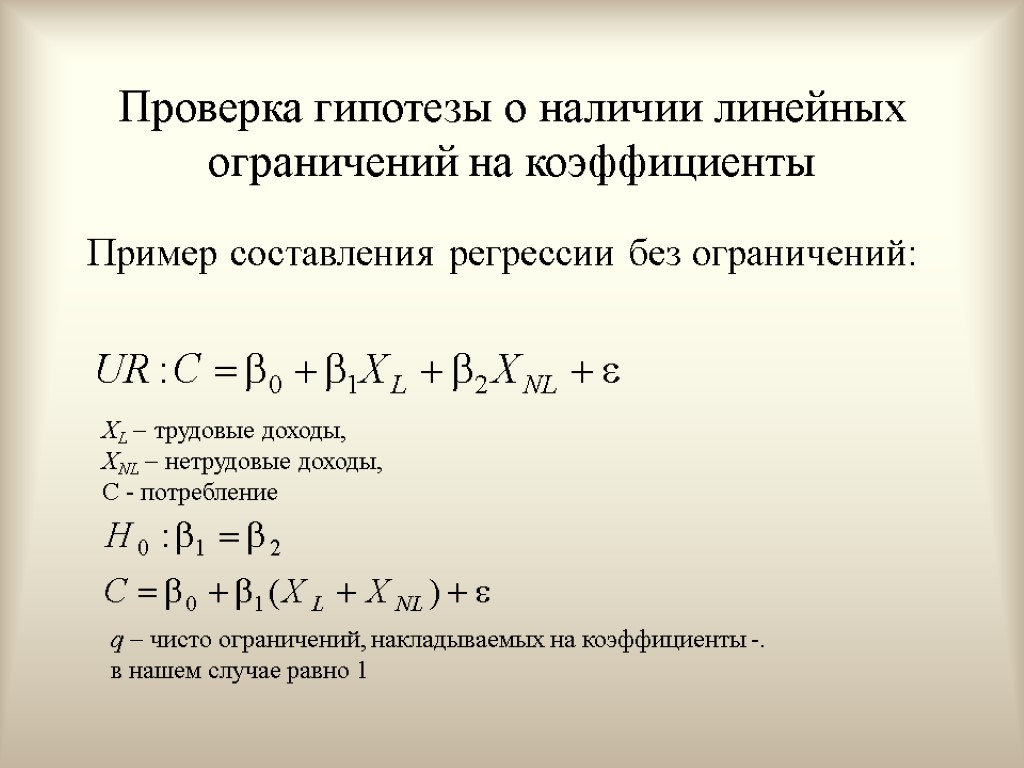

Проверка гипотезы о наличии линейных ограничений на коэффициенты Пример составления регрессии без ограничений: XL трудовые доходы, XNL нетрудовые доходы, С - потребление q чисто ограничений, накладываемых на коэффициенты -. в нашем случае равно 1

Проверка гипотезы о наличии линейных ограничений на коэффициенты Пример составления регрессии без ограничений: XL трудовые доходы, XNL нетрудовые доходы, С - потребление q чисто ограничений, накладываемых на коэффициенты -. в нашем случае равно 1

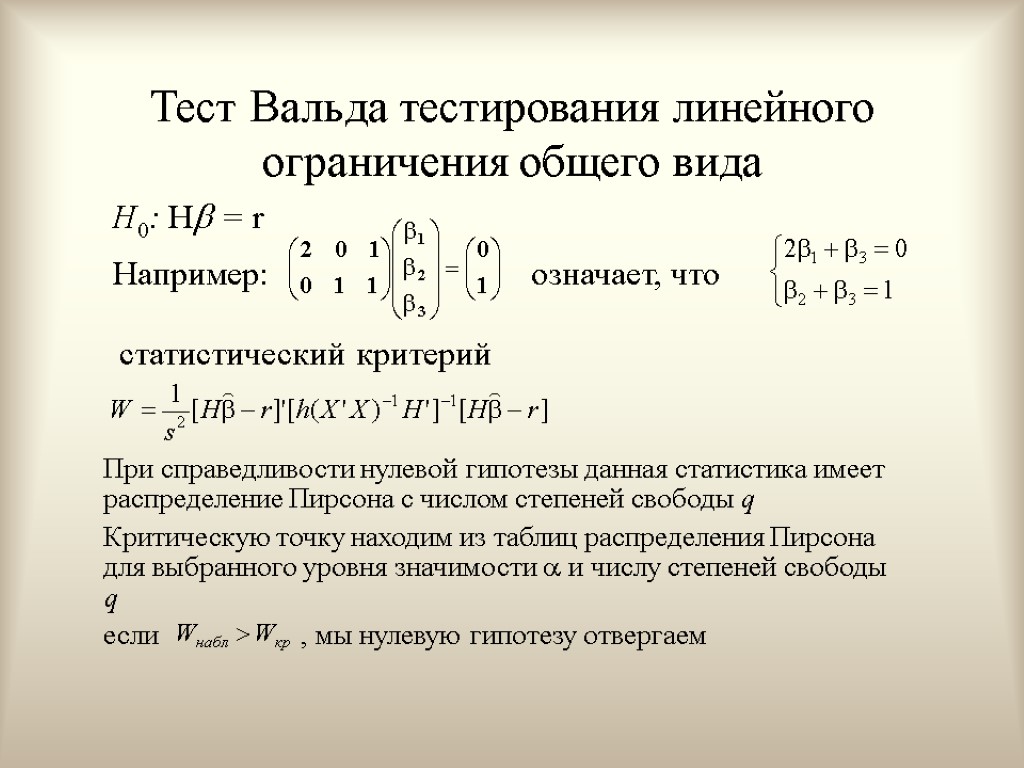

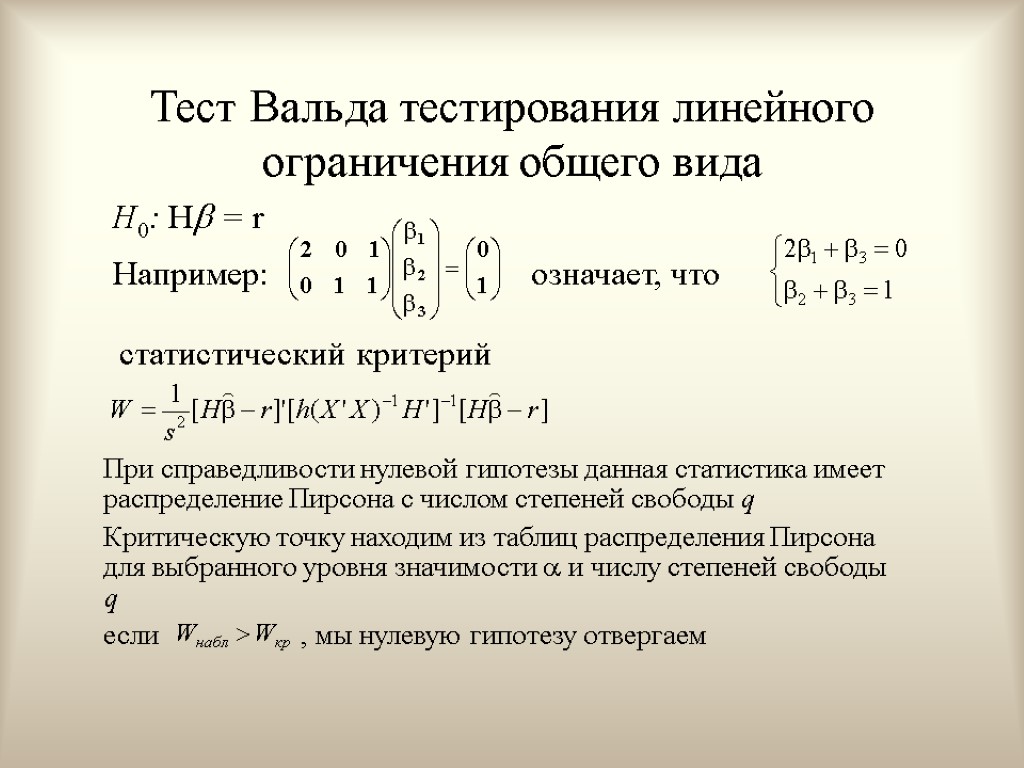

Тест Вальда тестирования линейного ограничения общего вида H0: H = r Например: означает, что статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Пирсона с числом степеней свободы q Критическую точку находим из таблиц распределения Пирсона для выбранного уровня значимости и числу степеней свободы q если , мы нулевую гипотезу отвергаем

Тест Вальда тестирования линейного ограничения общего вида H0: H = r Например: означает, что статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Пирсона с числом степеней свободы q Критическую точку находим из таблиц распределения Пирсона для выбранного уровня значимости и числу степеней свободы q если , мы нулевую гипотезу отвергаем

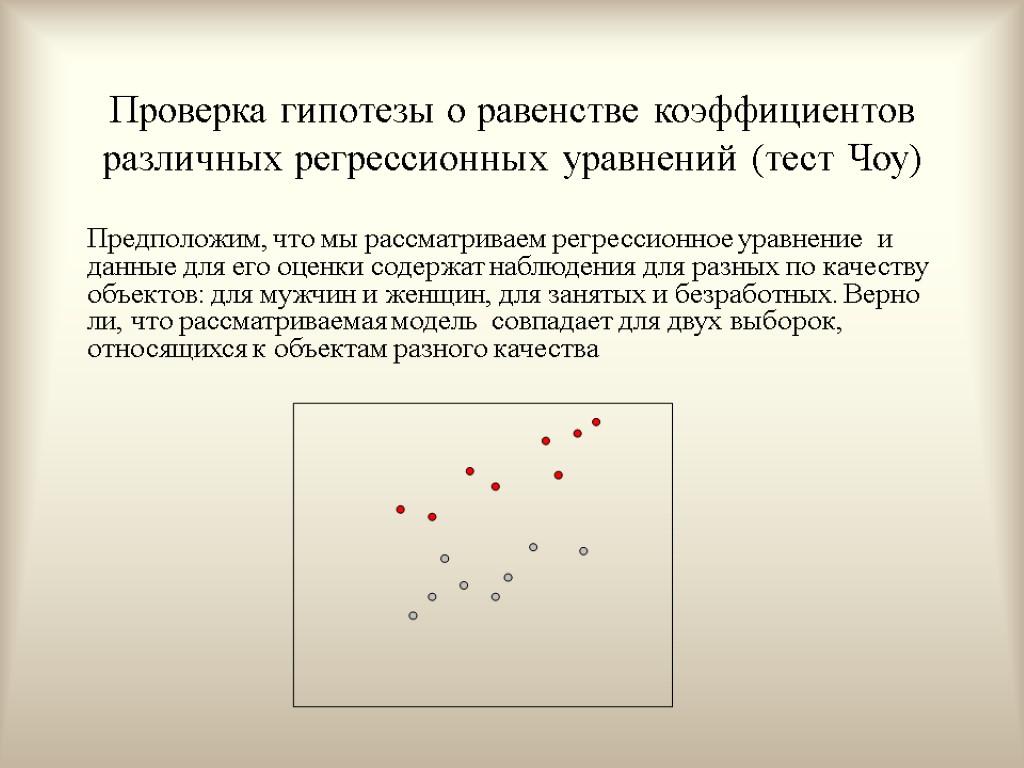

Проверка гипотезы о равенстве коэффициентов различных регрессионных уравнений (тест Чоу) Предположим, что мы рассматриваем регрессионное уравнение и данные для его оценки содержат наблюдения для разных по качеству объектов: для мужчин и женщин, для занятых и безработных. Верно ли, что рассматриваемая модель совпадает для двух выборок, относящихся к объектам разного качества

Проверка гипотезы о равенстве коэффициентов различных регрессионных уравнений (тест Чоу) Предположим, что мы рассматриваем регрессионное уравнение и данные для его оценки содержат наблюдения для разных по качеству объектов: для мужчин и женщин, для занятых и безработных. Верно ли, что рассматриваемая модель совпадает для двух выборок, относящихся к объектам разного качества

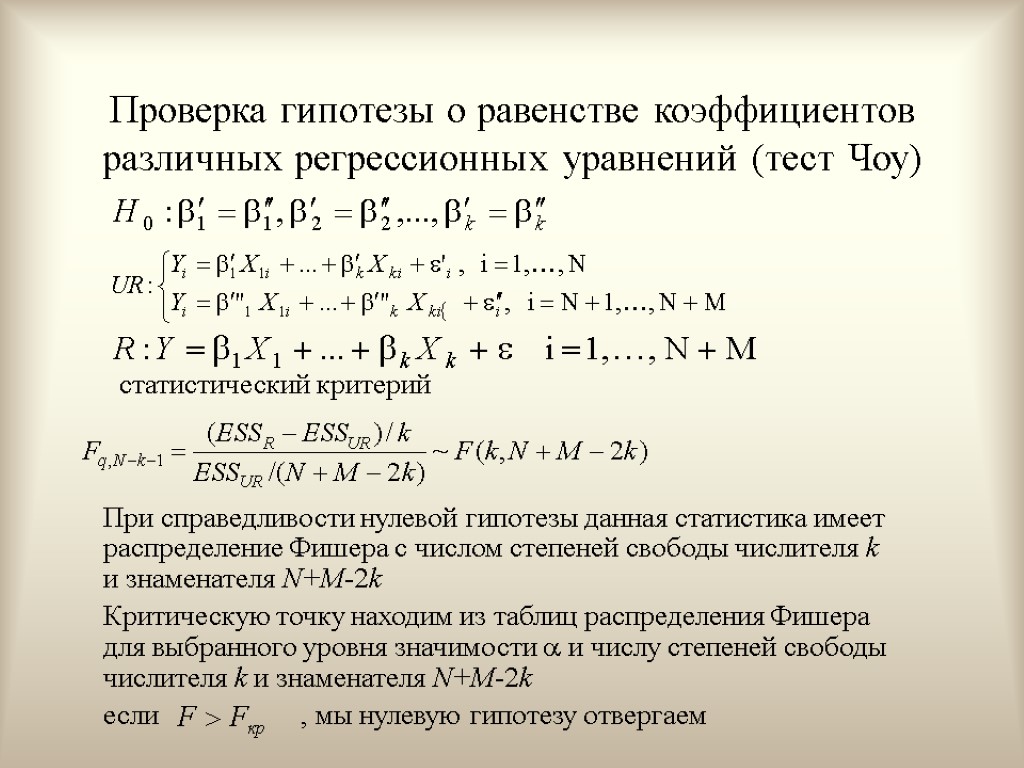

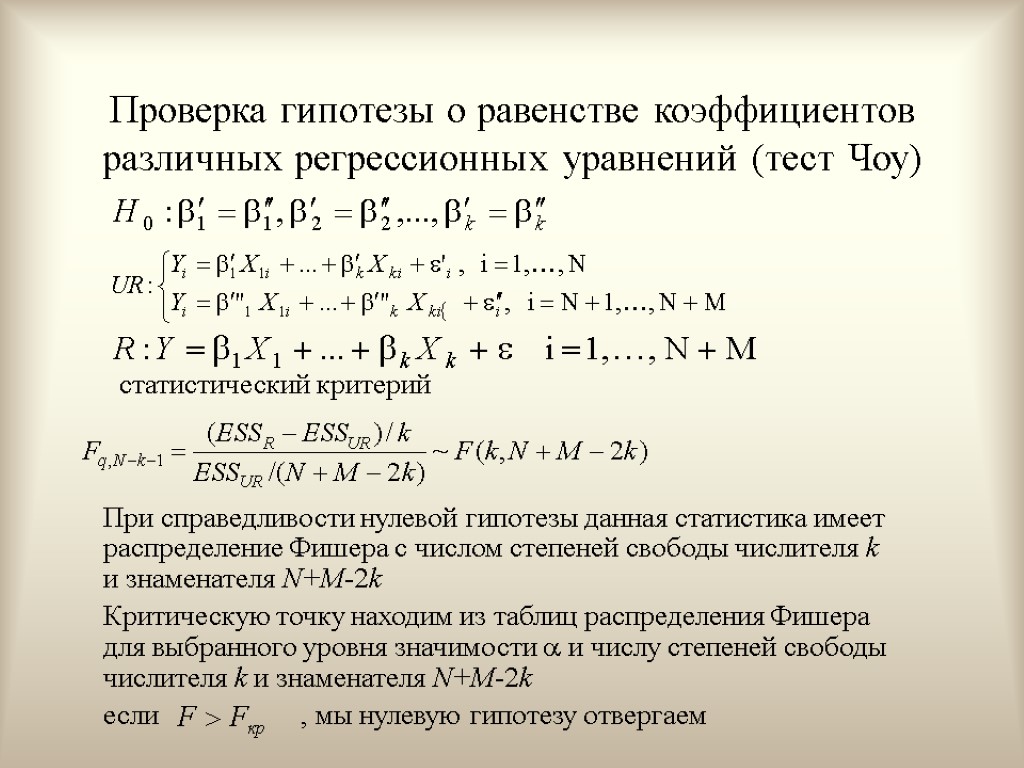

Проверка гипотезы о равенстве коэффициентов различных регрессионных уравнений (тест Чоу) статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Фишера с числом степеней свободы числителя k и знаменателя N+M-2k Критическую точку находим из таблиц распределения Фишера для выбранного уровня значимости и числу степеней свободы числителя k и знаменателя N+M-2k если , мы нулевую гипотезу отвергаем

Проверка гипотезы о равенстве коэффициентов различных регрессионных уравнений (тест Чоу) статистический критерий При справедливости нулевой гипотезы данная статистика имеет распределение Фишера с числом степеней свободы числителя k и знаменателя N+M-2k Критическую точку находим из таблиц распределения Фишера для выбранного уровня значимости и числу степеней свободы числителя k и знаменателя N+M-2k если , мы нулевую гипотезу отвергаем

Вопросы для самопроверки Как проверить значимость регрессии в целом. В чем заключается содержательный смысл гипотезы о равенстве коэффициента уравнения нулю. Как провести односторонний тест на равенство коэффициента нулю. В чем смысл доверительного интервала коэффициента. Как проверить гипотезу о равенстве коэффициента уравнения нулю при помощи доверительного интервала.. Как связаны между собой F и t статистика в парной модели. Как проверить гипотезу о равенстве коэффициента уравнения некоторому числу. Какова основная идея F-теста на улучшение качества оценивания. Приведите пример построения регрессии с ограничениями. Как формулируется гипотеза о наличие линейных ограничений на коэффициенты. Как провести тест Вальда. Для чего нужен тест Чоу.

Вопросы для самопроверки Как проверить значимость регрессии в целом. В чем заключается содержательный смысл гипотезы о равенстве коэффициента уравнения нулю. Как провести односторонний тест на равенство коэффициента нулю. В чем смысл доверительного интервала коэффициента. Как проверить гипотезу о равенстве коэффициента уравнения нулю при помощи доверительного интервала.. Как связаны между собой F и t статистика в парной модели. Как проверить гипотезу о равенстве коэффициента уравнения некоторому числу. Какова основная идея F-теста на улучшение качества оценивания. Приведите пример построения регрессии с ограничениями. Как формулируется гипотеза о наличие линейных ограничений на коэффициенты. Как провести тест Вальда. Для чего нужен тест Чоу.

Тема 8. Мультиколлинеарность

Тема 8. Мультиколлинеарность

Содержание лекции Понятие мультиколлинеарности Последствия мультиколлинеарности Обнаружение мультиколлинерности Коррекция мультиколлинеарности

Содержание лекции Понятие мультиколлинеарности Последствия мультиколлинеарности Обнаружение мультиколлинерности Коррекция мультиколлинеарности

Полная мультиколлинеарность Коэффициенты по методу наименьших квадратов существуют не всегда, а только в том случае, когда определитель матрицы (X’X) отличен от нуля. Определитель будет равен нулю в случае, если столбцы матрицы X линейно зависимы. Такое может произойти, если между независимыми переменными существует точное линейное соотношение.

Полная мультиколлинеарность Коэффициенты по методу наименьших квадратов существуют не всегда, а только в том случае, когда определитель матрицы (X’X) отличен от нуля. Определитель будет равен нулю в случае, если столбцы матрицы X линейно зависимы. Такое может произойти, если между независимыми переменными существует точное линейное соотношение.

Пример где Y - средняя оценка на экзамене состоящую из трех объясняющих переменных: I доход родителей, D среднее число часов, затраченных на обучение в день, W среднее число часов, затраченных на обучение в неделю. Очевидно, что W=7D.

Пример где Y - средняя оценка на экзамене состоящую из трех объясняющих переменных: I доход родителей, D среднее число часов, затраченных на обучение в день, W среднее число часов, затраченных на обучение в неделю. Очевидно, что W=7D.

Устранение полной мультиколлинеарности Случай полной мультиколлинеарности отследить легко, поскольку в этом случае невозможно построить оценки по методу наименьших квадратов. Если в модели присутствует полная мультиколлинеарность, следует удалить из регрессионного уравнения одну из переменных, которые входят в линейное соотношение.

Устранение полной мультиколлинеарности Случай полной мультиколлинеарности отследить легко, поскольку в этом случае невозможно построить оценки по методу наименьших квадратов. Если в модели присутствует полная мультиколлинеарность, следует удалить из регрессионного уравнения одну из переменных, которые входят в линейное соотношение.

Мультиколлинеарность Мультиколлинеарность – это проблема, когда тесная корреляционная зависимость между регрессорами ведет к получению ненадежных оценок регрессии

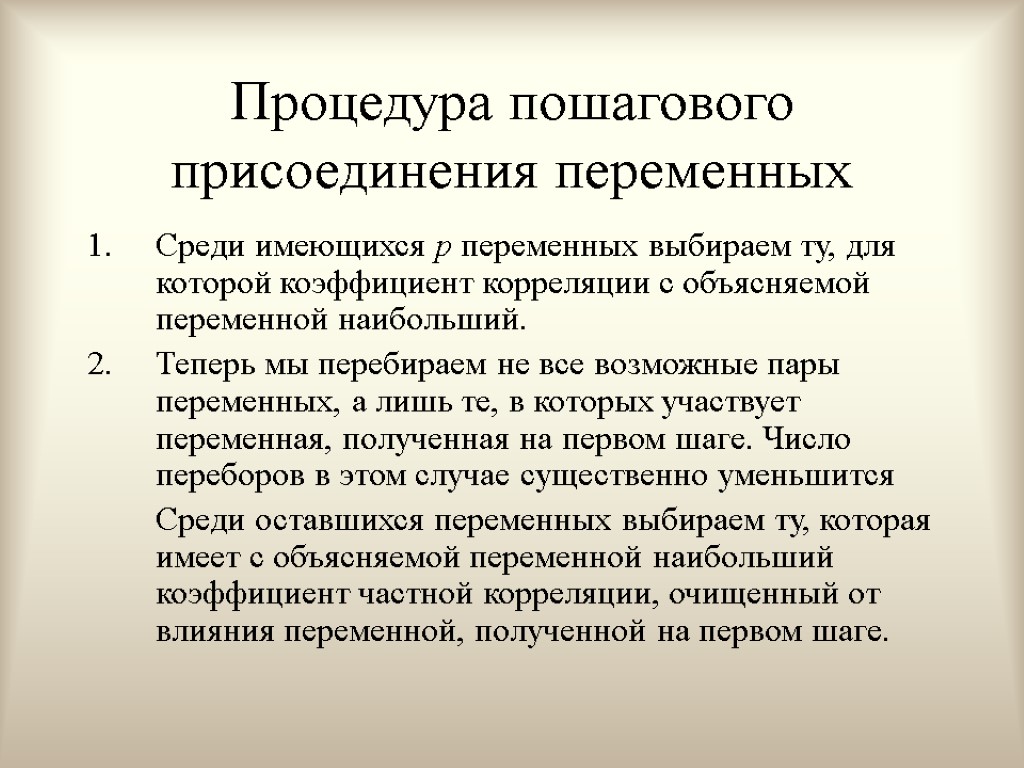

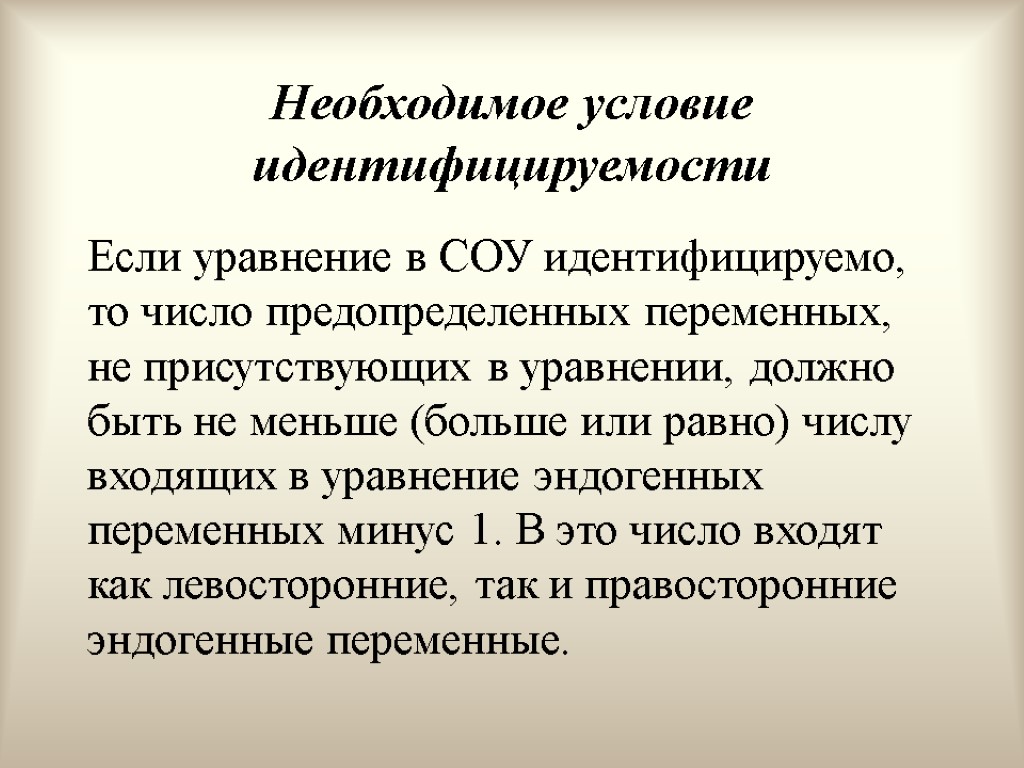

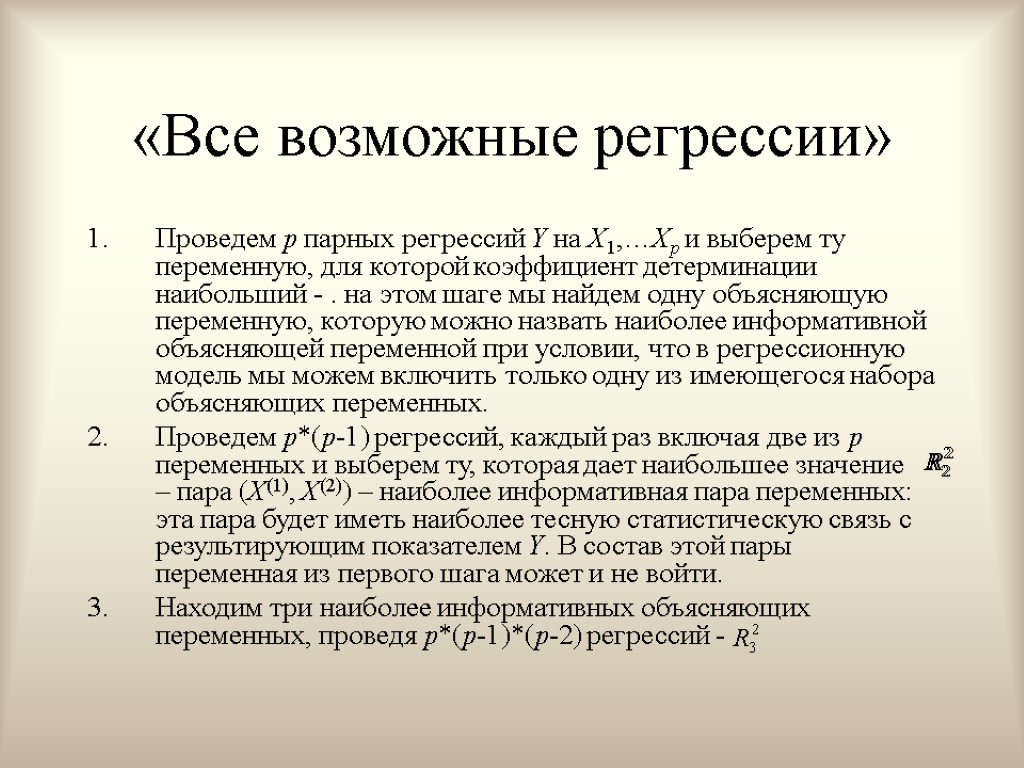

Мультиколлинеарность Мультиколлинеарность – это проблема, когда тесная корреляционная зависимость между регрессорами ведет к получению ненадежных оценок регрессии